運転支援システム、運転支援方法、及び、プログラム

【課題】比較的軽い処理で運転者の支援を行う運転支援システムを提供する。

【解決手段】 運転支援システム1は、動領域抽出によって、領域分割(撮影画像を画像要素に分割する処理)と、視差情報の抽出(視差マップの生成処理)とを行うため、ブロックマッチングを用いる方法に比べて、処理負荷を抑えることができる。また、右画像と左画像の同一画像要素を特定し、視差を算出する場合には、精細なカメラの校正と画像の補正が必要であるが、本運転支援システム1では、これらは不要である。さらに、本運転支援システム1によれば、動きや形の変化を推定するため、他の移動体に相当する画像要素の多様な動きや、形の変化にも対応できる。

【解決手段】 運転支援システム1は、動領域抽出によって、領域分割(撮影画像を画像要素に分割する処理)と、視差情報の抽出(視差マップの生成処理)とを行うため、ブロックマッチングを用いる方法に比べて、処理負荷を抑えることができる。また、右画像と左画像の同一画像要素を特定し、視差を算出する場合には、精細なカメラの校正と画像の補正が必要であるが、本運転支援システム1では、これらは不要である。さらに、本運転支援システム1によれば、動きや形の変化を推定するため、他の移動体に相当する画像要素の多様な動きや、形の変化にも対応できる。

【発明の詳細な説明】

【技術分野】

【0001】

本発明は、移動体の運転を支援する運転支援システムに関する。

【背景技術】

【0002】

例えば、特許文献1に、ステレオ画像に基づいて障害物までの距離を計算し、計算された距離に基づいて、自動車などの運転を支援するシステムが提案されている。

【0003】

また、例えば、非特許文献1では、アフィン動き推定を用いた動領域抽出アルゴリズムが提案されている。このアルゴリズムの特徴は、領域分割とそれぞれの領域に対応する動きモデルを同時に求めることである。

【先行技術文献】

【特許文献】

【0004】

【特許文献1】特開2011−131740

【非特許文献1】J. M. Odobez, P. Bouthemy, “ Direct Incremental Model-Based Image Motion Segmentation for Video Analysis ”, Signal Processing, 66, pp. 143-155, 1998.

【発明の概要】

【発明が解決しようとする課題】

【0005】

本発明は、比較的軽い処理で運転者の支援を行う運転支援システムを提供する。

【課題を解決するための手段】

【0006】

本発明に係る運転支援システムは、移動体に設定された第1の撮影位置から、前記移動体の外の被写体を複数のタイミングで撮影する第1の撮影手段と、前記移動体に設定された第2の撮影位置から、前記被写体を複数のタイミングで撮影する第2の撮影手段と、前記第1の撮影手段により撮影された複数の撮影画像と、前記第2の撮影手段により撮影された複数の撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、各画像要素の動きによって分割する動き分割手段と、前記第1の撮影手段により撮影された撮影画像と、前記第2の撮影手段により撮影された撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、前記第1の撮影位置及び前記第2の撮影位置の視差による撮影画像上の視差によって分割する視差分割手段と、前記動き分割手段による分割結果と前記視差分割手段による分割結果を用いて物体に対応する画像要素に分類する要素分類手段と、前記要素分類手段による分類結果と、前記視差分割手段により抽出された視差情報とに基づいて、前記移動体の運転を支援する運転支援手段とを有する。

【0007】

好適には、前記視差分割手段は、前記分割手段による分類結果に基づいて、同じ分類の画像要素の視差情報を抽出する。

【0008】

好適には、入力される複数の撮影画像に基づいて、撮影画像に含まれる画像要素を、それぞれの画像要素の変位により分割する動領域抽出処理装置を有し、前記動き分割手段は、前記動領域抽出処理装置に対して、複数のタイミングで撮影された複数の撮影画像を入力して、画像要素を動きによって分割させ、前記視差分割手段は、前記動領域抽出処理装置に対して、前記第1の撮影手段及び前記第2の撮影手段により略同時に撮影された撮影画像を入力して、画像要素を視差によって分割させる。

【0009】

好適には、前記移動体は、路面上を走行するものであり、前記要素分類手段による分類結果に基づいて、撮影画像上の路面に相当する画像要素の動きと比較して、撮影画像の他の画像要素を他の移動体として特定する移動体特定手段をさらに有し、前記運転支援手段は、前記移動体特定手段により特定された他の移動体と、前記視差分割手段により抽出された他の移動体の視差情報とに基づいて、他の移動体の接近に関する警告、他の移動体の接近に対する自動回避処理、又は、他の移動体との距離が既定の範囲となるように移動速度を制御する速度調整処理を行う。

【0010】

好適には、前記移動体は、路面上を走行するものであり、前記視差分割手段は、前記第1の撮影手段により撮影された撮影画像と、前記第2の撮影手段により撮影された撮影画像とに基づいて、前記第1の撮影位置及び前記第2の撮影位置の視差による動きモデルを視差モデルとして抽出し、路面の視差モデルに基づいて、路面以外の画像要素を特定する移動体特定手段をさらに有し、前記運転支援手段は、前記移動体特定手段により特定された他の移動体と、前記視差分割手段により抽出された他の移動体の視差情報とに基づいて、他の移動体の接近に関する警告、他の移動体の接近に対する自動回避処理、又は、他の移動体との距離が既定の範囲となるように移動速度を制御する速度調整処理を行う。

【0011】

本発明に係る運転支援方法は、第1の撮影位置及び第2の撮影位置から、被写体を撮影する撮影ステップと、前記第1の撮影位置から撮影された複数の撮影画像と、前記第2の撮影位置から撮影された複数の撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、各画像要素の動きによって分割する動き分割ステップと、前記第1の撮影位置から撮影された撮影画像と、前記第2の撮影位置から撮影された撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、前記第1の撮影位置及び前記第2の撮影位置の視差による撮影画像上の視差情報によって分割する視差分割ステップと、前記動き分割ステップによる分割結果と前記視差分割ステップによる分割結果を用いて物体に対応する画像要素に分類する要素分類ステップと、前記要素分類ステップによる分類結果と、前記視差分割ステップにより得られた視差情報とに基づいて、前記移動体の運転を支援する運転支援ステップとを有する。

【0012】

本発明に係るプログラムは、第1の撮影位置から撮影された複数の撮影画像と、第2の撮影位置から撮影された複数の撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、各画像要素の動きによって分割する動き分割ステップと、前記第1の撮影位置から撮影された撮影画像と、前記第2の撮影位置から撮影された撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、前記第1の撮影位置及び前記第2の撮影位置の視差による撮影画像上の視差情報によって分割する視差分割ステップと、前記動き分割ステップによる分割結果と前記視差分割ステップによる分割結果を用いて物体に対応する画像要素に分類する要素分類ステップと、前記要素分類ステップによる分類結果と、前記視差分割ステップにより得られた視差情報とに基づいて、前記移動体の運転を支援するための情報を生成する運転支援ステップとを有するコンピュータに実行させる。

【発明の効果】

【0013】

本発明によれば、より軽い処理で運転者の支援を行うことができる。

【図面の簡単な説明】

【0014】

【図1】運転支援システム1の概要を例示する図である。

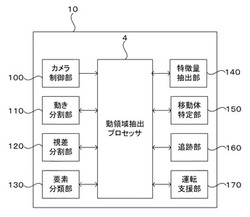

【図2】情報処理装置10の機能構成を例示する図である。

【図3】動領域抽出プロセッサ4の機能ブロック図である。

【図4】運転支援処理の全体動作(S10)を説明するフローチャートである。

【図5】アフィン動きモデル推定処理をより詳細に説明するフローチャートである。

【図6】境界更新処理(又は新領域検出処理)をより詳細に説明するフローチャートである。

【図7】ラベルマップ推定処理をより詳細に説明するフローチャートである。

【図8】変形例における動領域抽出プロセッサ5の機能ブロック図である。

【図9】本実施形態の動領域抽出プロセッサ5の特徴を説明する図である。

【図10】(A)は、実施形態の繰り返し計算を説明し、(B)は、変形例の繰り返し計算を説明する図である。

【図11】共通化した評価指標を説明する図である。

【図12】領域抽出結果を例示する図である。

【図13】アフィン動きモデルを説明する図である。

【図14】エネルギー関数を例示する図である。

【発明を実施するための形態】

【0015】

次に、図を参照して、本発明の実施形態を説明する。

図1は、運転支援システム1の概要を例示する図である。

図1に例示するように、運転支援システム1は、移動体に設置され、情報処理装置10と、複数のカメラ20とを含む。ここで、移動体とは、移動する物体であり、自動車や電車などの車両、航空機などの飛行体、又は、船舶などである。本例では、自動車の車体9に運転支援システム1が設置された形態を具体例として説明する。

情報処理装置10は、後述する動領域抽出プロセッサ4がインストールされたコンピュータ装置である。本例の情報処理装置10は、さらに、画像の表示処理及び入力受付処理を行うタッチパネルと、警告音などを出力するスピーカとを有し、運転者と対面する位置に設置されている。

複数のカメラ20は、互いに異なる撮影位置から被写体を同時に撮影するカメラであり、例えば、動画像を撮影するビデオカメラである。本例の2台のカメラ20は、自動車のダッシュボード上のフロントガラス近傍に左右に並べて設置されたビデオカメラである。

【0016】

図2は、情報処理装置10の機能構成を例示する図である。

図2に例示するように、情報処理装置10は、カメラ制御部100、動き分割部110、視差分割部120、要素分類部130、特徴量抽出部140、移動体特定部150、追跡部160、運転支援部170、及び、動領域抽出プロセッサ4を有する。

カメラ制御部100は、2台のカメラ20を制御して、同時に撮影された動画像を動領域抽出プロセッサ4に出力させる。

【0017】

動き分割部110は、動領域抽出プロセッサ4に対して、複数の撮影画像を入力して、入力された撮影画像を、画像要素それぞれの変位によって分割する。

より具体的には、動き分割部110は、同じカメラ20により異なるタイミングで撮影された複数の撮影画像に基づいて、これらの撮影画像に含まれる画像要素を、画像要素それぞれの動きによって分類する。本例の動き分割部110は、動領域抽出プロセッサ4に対して、同一のカメラ20により連続して撮影された2つの撮影画像に基づいて、ラベルマップ(領域ラベリングの結果)を生成させる。

【0018】

視差分割部120は、複数のカメラ20により同時に撮影された複数の撮影画像に基づいて、撮影画像を、画像要素それぞれの変位(すなわち、視差に基づく変位)によって分割する。視差に基づく変位は、カメラから被写体までの距離に応じて変化するため、視差分割部120は、複数のカメラ20により同時に撮影された複数の撮影画像に基づいて、これらの撮影画像に含まれる画像要素を、画像要素それぞれまでの距離によって分類することになる。本例の視差分割部120は、動領域抽出プロセッサ4に対して、2台のカメラ20により同時に撮影された2つの撮影画像に基づいて、ラベルマップ(以下、「視差マップ」という)を生成させる。

なお、視差情報の抽出は、上記の方法に限定されるものではなく、例えば、視差分割部120は、要素分類部110により分類された画像要素の変位量をそれぞれ算出し、算出された変位量を視差情報としてもよい。

【0019】

要素分類部130は、動き分割部110による分割結果と、視差分割部120による分割結果とに基づいて、撮影画像において、物体に相当する画像領域を特定する。本例の要素分類部130は、被写体の動きによって分類された画像要素と、視差によって分類された画像要素(視差マップ)とに基づいて、撮影画像中のそれぞれの物体に相当する画像領域を特定する。すなわち、要素分類部130は、被写体中の物体の動きによって分類された画像要素と、被写体中の各物体までの距離によって分類された画像要素とを用いて、物体に相当する画像領域を特定する。

【0020】

特徴量抽出部140は、撮影画像に含まれる画像要素の特徴量を抽出する。ここで、画像要素の特徴量とは、画像要素の位置、距離、大きさ、領域を囲む長方形のアスペクト比、輝度勾配に関する値、エッジに関する値などである。例えば、特徴量抽出部140は、要素分類部130により物体として特定された画像領域について、動領域抽出プロセッサ4による演算結果の一部(輝度勾配行列など)を特徴量として取得する。

【0021】

移動体特定部150は、要素分類部130による分類結果と、特徴量抽出部140により抽出された特徴量とに基づいて、路面や(例えば建物や街路樹などの)背景に相当する画像領域と、これら以外の物体(例えば、他の移動体)に相当する画像領域を特定する。例えば、移動体特定部150は、要素分類部130により物体として特定された画像領域の形、大きさ、及び位置に基づいて、他の移動体を特定する。また、移動体特定部150は、撮影画像上の路面に相当する画像要素と同じラベルが付された画素を既定以上に含む画像要素を、路面と判断し、これら以外の画像領域を他の移動体として判断してもよい。

【0022】

追跡部160は、移動体特定部150により特定された物体に相当する画像領域を、動きモデルに基づいて追跡する。本例の追跡部160は、動領域抽出プロセッサ4により得られる予測ラベルマップに基づいて、物体に相当する画像要素の移動先を追跡する。

【0023】

運転支援部170は、視差分割部120により抽出された視差情報(視差マップなど)と、移動体特定部150の特定結果と、追跡部160の追跡結果に基づいて、自動車の運転を支援する。例えば、運転支援部170は、視差分割部120により生成された視差マップと、移動体特定部150の特定結果と、追跡部160の追跡結果に基づいて、路面以外の画像要素の視差と接近の速さが既定値以上となった場合に、障害物との衝突の危険性が高いものと判断して、その旨の警告音を出力させる。また、運転支援部170は、さらに、追跡部160による追跡結果に基づいて、他の移動体の移動方向を予測して、障害物の接近を評価してもよい。また、運転支援部170は、緊急ブレーキの自動制御、又は、他の移動体を追尾するように速度を制御する速度自動制御を行ってもよい。

【0024】

図3は、動領域抽出プロセッサ4の機能構成を例示する図である。

図3に例示するように、動領域抽出プロセッサ4は、画像メモリ400と、輝度勾配演算部410と、動きモデル計算部420と、領域ラベリング部430と、ラベルマップメモリ440と、2つの動きモデルメモリ450と、2つの領域テーブルレジスタ460と、ラベルマップ推定部470と、制御部480とで構成されている。

画像メモリ400は、4フレームの画像データを保存するために、4つの画像メモリを含む。動きモデルメモリ450は2つ存在する。すなわち、動領域抽出プロセッサ4には、画像メモリ400として、前後フレーム2枚が2つずつ存在する。これはスループットを向上させるため、1フレームの画像を小さなブロック画像に分割し、ブロック画像単位で処理を行う画面分割手法を取り入れて、ブロック画像単位でフレームパイプライン処理を行っていることによる。それゆえ、動きモデルメモリ450、及び、領域テーブルレジスタ460もそれぞれ2つずつ存在する。

なお、動領域抽出プロセッサ4の外部には、推定マップ600と、領域テーブルメモリ610とが設けられている。

【0025】

輝度勾配演算部410A及び410Bは、輝度勾配の算出と、動き精度評価指標の算出とを行う論理ブロックである。

動きモデル計算部420は、動きモデル推定を行う論理ブロックである。

領域ラベリング部430は、領域ラベリングを行う論理ブロックである。

【0026】

ラベルマップメモリ440は、ラベルマップを保存するためのメモリである。

動きモデルメモリ450は、動きモデルを保存するためのメモリである。

領域テーブルレジスタ460は、領域テーブルを保持するレジスタである。

【0027】

ラベルマップ推定部470は、ラベルマップ予測を行う論理ロジックである。

制御部480は、他の構成を制御するコントローラーである。

【0028】

図4は、運転支援処理の全体動作(S10)を説明するフローチャートである。

図5は、アフィン動きモデル推定処理をより詳細に説明するフローチャートである。

図6は、境界更新処理(又は新領域検出処理)をより詳細に説明するフローチャートである。

図7は、ラベルマップ推定処理をより詳細に説明するフローチャートである。

【0029】

図4に示すように、情報処理装置10は、2台のカメラ20から入力された動画像データに関して、動画像を構成する連続フレーム毎に、S100〜S190の処理を実行する。なお、2台のカメラ20から入力される動画像データを、便宜上、右動画像データと、左動画像データと呼ぶ。

ステップ100(S100)において、動領域抽出プロセッサ4は、左動画像データについて、アフィン動きモデル推定処理を行う。より具体的には、アフィン動きモデルθとは、図13の式(1)のように、6つのパラメータの組み合わせで動き場全体を表現できる。平行移動・回転・発散収縮を基本とした様々な動きを表現でき、座標(x, y)におけるx,y 軸方向の動きベクトル(u, v)は式(1)のように書ける。

動画像からアフィン動きモデルを推定するには、動領域抽出プロセッサ4は、画面の各画素から計算される時空間輝度勾配Ix, Iy, Itを用いて,輝度勾配行列G,Gsを計算する。そして逆行列G-1を計算し、アフィン動きモデルθ= G-1 ・Gsを計算する。

動領域抽出では、アフィン動きモデル推定の精度を向上させるためPSMアルゴリズム(本実施形態)又はRMRアルゴリズム(後述する変形例)を採用している。PSMアルゴリズムでは動きモデル推定をする際、図5又は図6の4つの繰り返し計算を行い、推定精度を向上させている。各繰り返しは、図9に示されているように、階層ピラミッド単位、階層単位、階層フレーム単位、最下層画素単位と入れ子構造の繰り返し計算を行う。階層フレーム単位の繰り返しは、動きモデルを足し込んでいき精度を向上させる。階層単位の繰り返しは、画像の大きな動きに対応させるために上位の低解像度画像での推定結果を下位の画像で利用する。

階層ピラミッド単位の繰り返しは、アフィン動きモデル推定の際の外れ値を、ロバスト推定器であるM-estimatorを用いて画素単位で重みの評価指標qiによって重みwiを計算し、推定精度を向上させている。

【0030】

ステップ120(S120)において、動領域抽出プロセッサ4は、左動画像データについて、境界更新処理を行う。より具体的には、動領域抽出プロセッサ4は、予測マップe~と動きモデルθの二つから最適な境界を持つラベルマップeに更新する。更新には、図14のエネルギー関数U(e, o, e~) を最小化し、最適なラベルマップを推定する。oは画像と動きモデルから計算される観測値(オブザベーション)であり、動きモデルによって計算される動きの信頼性を表す。

このステップも、アフィン動きモデル推定処理と同様に、繰り返し処理を行いラベルマップの推定結果を向上させている。ただし、階層ピラミッド単位の繰り返し処理は除く。

【0031】

ステップ140(S140)において、動領域抽出プロセッサ4は、左動画像データについて、新領域検出処理を行う。より具体的には、動領域抽出プロセッサ4は、それぞれの領域において、推定された動きモデルが当てはまらない領域を検出する。具体的には、それぞれの領域に対して動きモデルが適合する”static ”領域、適合しない”mobile ”領域に分割する。これには領域更新ステップで用いたようなエネルギー最小化を行う。またこのステップも境界更新ステップと同様な繰り返し処理を行うことによって推定結果を向上させている。

【0032】

ステップ160(S160)において、動領域抽出プロセッサ4は、左動画像データについて、ラベルマップ予測処理を行う。より具体的には、動領域抽出プロセッサ4は、ラベルマップe(t)と動きモデルθの二つから、時刻t+1におけるラベルマップを予測する。具体的には、各画素の移動先を動きモデルによって計算し、ラベルを移動させる。そして時刻t+1では、予測マップe~(t+1)を用いてアフィン動きモデル推定を行う。

【0033】

ステップ170(S170)において、動領域抽出プロセッサ4は、視差マップを生成する。より具体的には、動領域抽出プロセッサ4(視差分割部120)は、左動画像データを時刻tのデータ、右動画像データを時刻t+1のデータとみなして、上記S100〜S140の処理と同等の処理を行い、視差による動きを示すラベルマッピングを行う。なお、本ステップは、便宜上、S160の処理と並行して記載してあるが、実際には、他のステップと並行してもよいし、S100〜S160のいずれかに直列的に挿入されてもよい。

【0034】

ステップ180(S180)において、移動体特定部150は、動領域抽出プロセッサ4により生成された領域マップ及び視差マップに基づいて要素分類部130により分類された画像領域と、特徴量抽出部140により抽出された特徴量とに基づいて、他の移動体に相当する画像要素を特定する。より具体的には、要素分類部130は、動領域抽出プロセッサ4により生成された領域マップ(動き分割部110による分割結果)と、動領域抽出プロセッサ4により生成された視差マップ(視差分割部120による分割結果)とに基づいて、画像領域を分類し、特徴量抽出部140は、分類された画像領域の特徴量を抽出する。移動体特定部150は、路面の動きモデルと、各画像領域の動きモデルとを比較して、路面に相当する画像領域以外の画像領域を特定し、路面以外の画像領域それぞれについて、特徴量に基づいて、他の移動体に相当する画像領域であるか否かを判断する。

ステップ190(S190)において、運転支援部170は、移動体特定部150による特定結果と、視差ラベルとに基づいて、運転支援を行う。例えば、運転支援部170は、他の移動体に相当する画像領域の視差ラベルから、この移動体が既定距離以上離れていると判断できる場合に、平常状態である旨を情報処理装置10のタッチパネルに表示させ、この移動体が既定距離よりも近いと判断した場合に、この移動体に相当する画像要素のラベルマップを参照して、この移動体の移動状態(接近中なのか、離れて行っているのか)をタッチパネルに表示させる。

なお、図12(A)は、路面マップを例示し、図12(B)は、視差マップを例示する。視差マップによれば、横断歩道やセンターラインなどの路面表示物も、路面として評価できる。視差マップと路面マップによって、路面表示物の抽出も可能になる。

【0035】

以上説明したように、本実施形態の運転支援システム1によれば、1回の動領域抽出によって、領域分割(撮影画像を画像要素に分割する処理)と、視差情報の抽出(視差マップの生成処理)とを同時に行うため、処理負荷を抑えることができる。例えば、ステレオ画像をブロックマッチングして、右画像と左画像の同一画像要素を特定し、視差を算出する場合には、本実施形態の方法に比べて、格段に演算量が大きい。そして、視差を用いて物体に相当する領域に分割する処理を別途行う必要がある。また、ブロックマッチングを行う方法では、右動画像と左動画像をできるだけ一致させるために、精細なカメラの校正と画像の補正が必要であるが、本実施形態では、これらは不要である。

また、本実施形態によれば、動領域抽出に基づく動き分割と追跡により動きや形の変化を推定するため、他の移動体に相当する画像要素の多様な動きや、形の変化にも対応できる。さらに、これらの処理過程で得られる情報を特徴量とすれば、一般には演算量の大きい他の手段で別途特徴量を抽出することなく、移動体の特定が可能である。つまり、システムを構成する複数の処理の間で動領域抽出を共通の処理とすることで、高速で面積の小さい実装が可能である。

【0036】

[変形例1]

次に、上記実施形態の変形例を説明する。変形例として、より効率化した動領域抽出プロセッサ5を例示する。

図8は、変形例における動領域抽出プロセッサ5の機能ブロック図である。

図8に例示するように、動領域抽出プロセッサ5は、画像メモリ500と、共通演算部510と、動きモデル計算部520と、領域ラベリング部530と、ラベルマップメモリ540と、動きモデルメモリ550と、領域テーブルレジスタ560と、ラベルマップ推定部570と、制御部580とで構成されている。

なお、動領域抽出プロセッサ5の外部には、推定マップ600と、領域テーブルメモリ610とが設けられている。

【0037】

画像メモリ500は、前後2フレームの画像データを保存するために、第1画像メモリ500Aと、第2画像メモリ500Bとを含む。

共通演算部510は、動きモデル推定処理と領域ラベリング処理とで共通の演算を行う論理ブロックである。より具体的には、共通演算部510は、輝度勾配の算出と、動き精度評価指標の算出とを行う。

動きモデル計算部520は、動きモデル推定を行う論理ブロックである。

領域ラベリング部530は、領域ラベリングを行う論理ブロックである。

【0038】

ラベルマップメモリ540は、ラベルマップを保存するためのメモリである。

動きモデルメモリ550は、動きモデルを保存するためのメモリである。

領域テーブルレジスタ560は、領域テーブルを保持するレジスタである。

【0039】

ラベルマップ推定部570は、ラベルマップ予測を行う論理ロジックである。

制御部580は、他の構成を制御するコントローラーである。

【0040】

上記実施形態の動領域抽出プロセッサ4は、動領域抽出処理各ステップを階層ピラミッド単位で逐次処理する必要があった。そして、スループットを向上させるために、画面分割手法とフレームパイプライン手法を取り入れた。しかし、フレームパイプライン手法により、画像メモリ400及び動きモデルメモリ450をチップ内部に前後2フレーム分持つ必要があるためにチップ面積の増加に繋がった。また、動きモデル推定ステップと領域ラべリングステップにおいて、輝度勾配、動きの精度評価指標といった類似した計算を行うが、別々の演算器で処理を行っていることもハードウェア規模の増加に繋がっている。

【0041】

一方で、本変形例の動領域抽出プロセッサ5は、図9に示すように、動きモデル推定処理と領域ラベリング処理との間の連携強化、画素単位のパイプライン処理の実現、及び、要素処理(輝度勾配の算出など)の共通化と簡単化、によって、上記実施形態と比較して、アーキテクチャの50%削減、及び、4.2倍のスループットを実現している。

すなわち、上記実施形態の動領域抽出プロセッサ4は、最終的な動きモデル推定の結果を用いて領域ラベリングを行い、処理が逐次的に行われていた。一方、本変形例の動領域抽出プロセッサ5は、下記の2つの改良点によって、動きモデルとラベルマップの交換が階層フレーム単位の繰り返しで可能となり、各ステップ処理が緊密な連携をとれるようになった。さらに、本変形例の動領域抽出各ステップ処理で、階層フレーム単位の1回前の繰り返し計算の推定結果を利用することで、ステップ単位での並列計算が実現できる。

改良点の1つ目は、動きモデル推定にRMRアルゴリズムを採用した。比較例で用いられるPSMアルゴリズムは、動きモデル計算及び重み計算を、階層ピラミッド単位で繰り返し計算する。それに対し、本実施形態のRMRアルゴリズムは、図9(A)のように、動きモデル計算及び重み計算を、階層フレーム単位で繰り返し計算する。さらに階層フレーム単位で1回前の繰り返し計算結果を用いることで、動きモデル計算及び重み計算を並列に計算することが可能となる。また、本変形例では、重み計算に関して、動き精度評価指標qiを領域ラベリングステップの動き精度評価指標と共通化しεiとした。

改良点の2つ目は、動きモデルと領域ラベリング間で頻繁な処理結果の交換を行う点である。動きモデル推定ステップでRMRアルゴリズムを採用することによって、領域ラベリングと同様な繰り返し処理を行うようになる。そこに注目して、図9(A)のように、階層フレーム単位の処理を、動きモデル推定処理、境界更新処理、新領域検出処理の順で処理していき、その結果を次の階層フレーム単位の繰り返し計算の時に利用する。その後、階層単位の繰り返し処理を行い(図9(A)中の3)、また同様に階層フレーム単位の繰り返し計算を行う。この階層フレーム単位の繰り返し計算を、各ステップに渡って一度に実行することによって、最新の動きモデルと最新のラベルマップを利用できる。したがって、本変形例のアルゴリズムは、図9に示すように、実施形態のアルゴリズムより、頻繁に処理結果を交換するアルゴリズムとなる。

【0042】

また、上記実施形態のアルゴリズムの境界更新は、更新対象の1画素に対し複数ラベルのエネルギー計算を行う必要がある。複数ラベルのエネルギー計算には、各ラベルの示す動きに従って移動した画素と、その周囲の画素値が必要であり、同時読み出しが極めて困難である。それゆえ、1画素1サイクルのパイプライン処理が困難である。さらに、境界更新と新領域検出が独立に行われるため、1画素あたり最低2サイクル必要である。

そこで、本変形例の動領域抽出プロセッサ5では、図9(B)に示すように、境界更新の候補ラベル数を削減し、境界更新と新領域検出を統合した。

以下で、動領域抽出全体での画素単位のパイプライン処理を実現するにあたり必要なアルゴリズム最適化について述べる。

まず、本変形例の動領域抽出プロセッサ5では、領域ラベリングステップにおいて、1画素の処理は境界更新か新領域検出のどちらかのみ行う、という処理の二者択一化を行った。上記実施形態のアルゴリズムでは、境界更新処理を境界のみで行い、新領域検出処理を全画素で行っていた。本変形例のアルゴリズムでは、境界更新処理を境界のみで行い、新領域検出処理をそれ以外(境界以外)の画素で行う。こうすることで、同じラスタスキャン中に2ステップの処理を同時に行うことができ、処理を統合できる。

さらに、本変形例では、境界更新ステップにおける参照ラベルを、注目画素のラベルと、周囲に存在するラベルの2つに制限した。言い換えると、更新後なりうるラベルが、”元のラベル”か、”周りにあるラベル”かの2種類に制限した。本変形例の動領域抽出プロセッサ5は、ラベルが3種類以上ある場合に、例えば、ラベル番号の若い物を2つ選択する。この変更によって、境界検出が新領域検出と同様な処理を行うことになる。新領域検出に関しては、上記実施形態と変わらず、”static”と ”mobile”のラベル2種類である。ラベル決定法に関しては、エネルギー計算対象のラベルは”static”のみとなる。

【0043】

また、上記実施形態の動領域抽出アルゴリズムは、各ステップにおいて類似した計算が存在し、それを逐次的に何度も計算させていた。本変形例のアルゴリズムは、類似した計算を共通化させ、演算器を共有させるために、共通化と簡単化を行った。

輝度勾配計算(輝度勾配演算部410による計算)は,動きモデル推定の輝度勾配行列G,Gsの計算に必要であり、また動きモデル推定の重みwiの計算、境界更新のエネルギー関数U1、新領域検出のエネルギー関数U1で必要になる動きの精度評価指標に必要となる。これらは、共通の計算を行っており、本変形例では、処理の内容を共通化し、演算部(共通演算部510)を動きモデル計算部520(アフィン動きモデル推定処理)と領域ラベリング部530(領域更新・新領域検出処理)とに共用させる。

動き精度評価指標は、動きモデル推定の重み計算、領域ラベリングのエネルギー関数U1において必要である。動領域抽出処理全体で画素単位のパイプライン処理を実現するために、動きモデル推定の重み計算と、領域ラベリングの動きの精度評価指標計算とを共通化し、計算回路を一つにする。具体的には、図11に示すように、演算式を簡単化し共通化し、共通演算部510により計算させることとした。また、重み計算時の閾値はCを、動き精度評価指標が共通化されたことからηに置き換わる。また境界更新のエネルギー関数を新領域検出のエネルギー更新と共通とした。

【0044】

以上説明したように、本変形例の動領域抽出プロセッサ5によれば、上記実施形態と比較して、画像メモリ及び動きモデルメモリが50%となる。また、アフィン動きモデル推定処理、領域更新処理、及び新領域検出処理の共通演算である輝度勾配計算と動き精度評価指標計算が共通化され、動きモデル推定処理及び領域ラベリング処理が並列に画素パイプライン処理を行う。さらに、境界更新処理及び新領域検出処理が一つの論理ブロックに統合される。

より詳細には、本変形例の動領域抽出プロセッサ5は、動きモデル推定及び領域ラベリングの繰り返し計算を、階層フレームごとに交互に計算することによって、動きモデルとラベルマップの情報交換が緊密になり、分割結果収束までの繰り返し回数が削減できる。また、同じ画像の動領域抽出処理に対し、図10に示すように、動きモデル推定及び領域ラベリングの処理を階層フレーム単位で反復させて計算させることができるようになった。さらに動領域抽出処理全体で見たときに画素単位のパイプライン処理が可能になり、図10(B)に示すように、動きモデル推定及び領域ラベリングを並列に計算させることができるようになった。結果、画面分割とフレームパイプライン手法を用いずにスループットを向上させることができ、内部の画像メモリ、及び、動きモデルメモリを50%に削減することができる。また、各ステップの要素処理エネルギー計算を簡単化・共通化し、これらのロジックに関して、比較例のアーキテクチャの50%削減した。比較例と本実施形態とで同精度の領域抽出結果を得る場合、本実施形態の動領域抽出プロセッサ5は、比較例と比較して、4.2倍のスループットを達成できる。

【符号の説明】

【0045】

1 運転支援システム

10 情報処理装置

100 カメラ制御部

110 動き分割部

120 視差分割部

130 要素分類部

140 特徴量抽出部

150 移動体特定部

160 追跡部

170 運転支援部

20 カメラ

4,5 動領域抽出プロセッサ

400,500 画像メモリ

410 輝度勾配演算部

510 共通演算部

420,520 動きモデル計算部

430,530 領域ラベリング部

440,540 ラベルマップメモリ

450,550 動きモデルメモリ

460,560 領域テーブルレジスタ

470,570 ラベルマップ推定部

480,580 制御部

【技術分野】

【0001】

本発明は、移動体の運転を支援する運転支援システムに関する。

【背景技術】

【0002】

例えば、特許文献1に、ステレオ画像に基づいて障害物までの距離を計算し、計算された距離に基づいて、自動車などの運転を支援するシステムが提案されている。

【0003】

また、例えば、非特許文献1では、アフィン動き推定を用いた動領域抽出アルゴリズムが提案されている。このアルゴリズムの特徴は、領域分割とそれぞれの領域に対応する動きモデルを同時に求めることである。

【先行技術文献】

【特許文献】

【0004】

【特許文献1】特開2011−131740

【非特許文献1】J. M. Odobez, P. Bouthemy, “ Direct Incremental Model-Based Image Motion Segmentation for Video Analysis ”, Signal Processing, 66, pp. 143-155, 1998.

【発明の概要】

【発明が解決しようとする課題】

【0005】

本発明は、比較的軽い処理で運転者の支援を行う運転支援システムを提供する。

【課題を解決するための手段】

【0006】

本発明に係る運転支援システムは、移動体に設定された第1の撮影位置から、前記移動体の外の被写体を複数のタイミングで撮影する第1の撮影手段と、前記移動体に設定された第2の撮影位置から、前記被写体を複数のタイミングで撮影する第2の撮影手段と、前記第1の撮影手段により撮影された複数の撮影画像と、前記第2の撮影手段により撮影された複数の撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、各画像要素の動きによって分割する動き分割手段と、前記第1の撮影手段により撮影された撮影画像と、前記第2の撮影手段により撮影された撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、前記第1の撮影位置及び前記第2の撮影位置の視差による撮影画像上の視差によって分割する視差分割手段と、前記動き分割手段による分割結果と前記視差分割手段による分割結果を用いて物体に対応する画像要素に分類する要素分類手段と、前記要素分類手段による分類結果と、前記視差分割手段により抽出された視差情報とに基づいて、前記移動体の運転を支援する運転支援手段とを有する。

【0007】

好適には、前記視差分割手段は、前記分割手段による分類結果に基づいて、同じ分類の画像要素の視差情報を抽出する。

【0008】

好適には、入力される複数の撮影画像に基づいて、撮影画像に含まれる画像要素を、それぞれの画像要素の変位により分割する動領域抽出処理装置を有し、前記動き分割手段は、前記動領域抽出処理装置に対して、複数のタイミングで撮影された複数の撮影画像を入力して、画像要素を動きによって分割させ、前記視差分割手段は、前記動領域抽出処理装置に対して、前記第1の撮影手段及び前記第2の撮影手段により略同時に撮影された撮影画像を入力して、画像要素を視差によって分割させる。

【0009】

好適には、前記移動体は、路面上を走行するものであり、前記要素分類手段による分類結果に基づいて、撮影画像上の路面に相当する画像要素の動きと比較して、撮影画像の他の画像要素を他の移動体として特定する移動体特定手段をさらに有し、前記運転支援手段は、前記移動体特定手段により特定された他の移動体と、前記視差分割手段により抽出された他の移動体の視差情報とに基づいて、他の移動体の接近に関する警告、他の移動体の接近に対する自動回避処理、又は、他の移動体との距離が既定の範囲となるように移動速度を制御する速度調整処理を行う。

【0010】

好適には、前記移動体は、路面上を走行するものであり、前記視差分割手段は、前記第1の撮影手段により撮影された撮影画像と、前記第2の撮影手段により撮影された撮影画像とに基づいて、前記第1の撮影位置及び前記第2の撮影位置の視差による動きモデルを視差モデルとして抽出し、路面の視差モデルに基づいて、路面以外の画像要素を特定する移動体特定手段をさらに有し、前記運転支援手段は、前記移動体特定手段により特定された他の移動体と、前記視差分割手段により抽出された他の移動体の視差情報とに基づいて、他の移動体の接近に関する警告、他の移動体の接近に対する自動回避処理、又は、他の移動体との距離が既定の範囲となるように移動速度を制御する速度調整処理を行う。

【0011】

本発明に係る運転支援方法は、第1の撮影位置及び第2の撮影位置から、被写体を撮影する撮影ステップと、前記第1の撮影位置から撮影された複数の撮影画像と、前記第2の撮影位置から撮影された複数の撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、各画像要素の動きによって分割する動き分割ステップと、前記第1の撮影位置から撮影された撮影画像と、前記第2の撮影位置から撮影された撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、前記第1の撮影位置及び前記第2の撮影位置の視差による撮影画像上の視差情報によって分割する視差分割ステップと、前記動き分割ステップによる分割結果と前記視差分割ステップによる分割結果を用いて物体に対応する画像要素に分類する要素分類ステップと、前記要素分類ステップによる分類結果と、前記視差分割ステップにより得られた視差情報とに基づいて、前記移動体の運転を支援する運転支援ステップとを有する。

【0012】

本発明に係るプログラムは、第1の撮影位置から撮影された複数の撮影画像と、第2の撮影位置から撮影された複数の撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、各画像要素の動きによって分割する動き分割ステップと、前記第1の撮影位置から撮影された撮影画像と、前記第2の撮影位置から撮影された撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、前記第1の撮影位置及び前記第2の撮影位置の視差による撮影画像上の視差情報によって分割する視差分割ステップと、前記動き分割ステップによる分割結果と前記視差分割ステップによる分割結果を用いて物体に対応する画像要素に分類する要素分類ステップと、前記要素分類ステップによる分類結果と、前記視差分割ステップにより得られた視差情報とに基づいて、前記移動体の運転を支援するための情報を生成する運転支援ステップとを有するコンピュータに実行させる。

【発明の効果】

【0013】

本発明によれば、より軽い処理で運転者の支援を行うことができる。

【図面の簡単な説明】

【0014】

【図1】運転支援システム1の概要を例示する図である。

【図2】情報処理装置10の機能構成を例示する図である。

【図3】動領域抽出プロセッサ4の機能ブロック図である。

【図4】運転支援処理の全体動作(S10)を説明するフローチャートである。

【図5】アフィン動きモデル推定処理をより詳細に説明するフローチャートである。

【図6】境界更新処理(又は新領域検出処理)をより詳細に説明するフローチャートである。

【図7】ラベルマップ推定処理をより詳細に説明するフローチャートである。

【図8】変形例における動領域抽出プロセッサ5の機能ブロック図である。

【図9】本実施形態の動領域抽出プロセッサ5の特徴を説明する図である。

【図10】(A)は、実施形態の繰り返し計算を説明し、(B)は、変形例の繰り返し計算を説明する図である。

【図11】共通化した評価指標を説明する図である。

【図12】領域抽出結果を例示する図である。

【図13】アフィン動きモデルを説明する図である。

【図14】エネルギー関数を例示する図である。

【発明を実施するための形態】

【0015】

次に、図を参照して、本発明の実施形態を説明する。

図1は、運転支援システム1の概要を例示する図である。

図1に例示するように、運転支援システム1は、移動体に設置され、情報処理装置10と、複数のカメラ20とを含む。ここで、移動体とは、移動する物体であり、自動車や電車などの車両、航空機などの飛行体、又は、船舶などである。本例では、自動車の車体9に運転支援システム1が設置された形態を具体例として説明する。

情報処理装置10は、後述する動領域抽出プロセッサ4がインストールされたコンピュータ装置である。本例の情報処理装置10は、さらに、画像の表示処理及び入力受付処理を行うタッチパネルと、警告音などを出力するスピーカとを有し、運転者と対面する位置に設置されている。

複数のカメラ20は、互いに異なる撮影位置から被写体を同時に撮影するカメラであり、例えば、動画像を撮影するビデオカメラである。本例の2台のカメラ20は、自動車のダッシュボード上のフロントガラス近傍に左右に並べて設置されたビデオカメラである。

【0016】

図2は、情報処理装置10の機能構成を例示する図である。

図2に例示するように、情報処理装置10は、カメラ制御部100、動き分割部110、視差分割部120、要素分類部130、特徴量抽出部140、移動体特定部150、追跡部160、運転支援部170、及び、動領域抽出プロセッサ4を有する。

カメラ制御部100は、2台のカメラ20を制御して、同時に撮影された動画像を動領域抽出プロセッサ4に出力させる。

【0017】

動き分割部110は、動領域抽出プロセッサ4に対して、複数の撮影画像を入力して、入力された撮影画像を、画像要素それぞれの変位によって分割する。

より具体的には、動き分割部110は、同じカメラ20により異なるタイミングで撮影された複数の撮影画像に基づいて、これらの撮影画像に含まれる画像要素を、画像要素それぞれの動きによって分類する。本例の動き分割部110は、動領域抽出プロセッサ4に対して、同一のカメラ20により連続して撮影された2つの撮影画像に基づいて、ラベルマップ(領域ラベリングの結果)を生成させる。

【0018】

視差分割部120は、複数のカメラ20により同時に撮影された複数の撮影画像に基づいて、撮影画像を、画像要素それぞれの変位(すなわち、視差に基づく変位)によって分割する。視差に基づく変位は、カメラから被写体までの距離に応じて変化するため、視差分割部120は、複数のカメラ20により同時に撮影された複数の撮影画像に基づいて、これらの撮影画像に含まれる画像要素を、画像要素それぞれまでの距離によって分類することになる。本例の視差分割部120は、動領域抽出プロセッサ4に対して、2台のカメラ20により同時に撮影された2つの撮影画像に基づいて、ラベルマップ(以下、「視差マップ」という)を生成させる。

なお、視差情報の抽出は、上記の方法に限定されるものではなく、例えば、視差分割部120は、要素分類部110により分類された画像要素の変位量をそれぞれ算出し、算出された変位量を視差情報としてもよい。

【0019】

要素分類部130は、動き分割部110による分割結果と、視差分割部120による分割結果とに基づいて、撮影画像において、物体に相当する画像領域を特定する。本例の要素分類部130は、被写体の動きによって分類された画像要素と、視差によって分類された画像要素(視差マップ)とに基づいて、撮影画像中のそれぞれの物体に相当する画像領域を特定する。すなわち、要素分類部130は、被写体中の物体の動きによって分類された画像要素と、被写体中の各物体までの距離によって分類された画像要素とを用いて、物体に相当する画像領域を特定する。

【0020】

特徴量抽出部140は、撮影画像に含まれる画像要素の特徴量を抽出する。ここで、画像要素の特徴量とは、画像要素の位置、距離、大きさ、領域を囲む長方形のアスペクト比、輝度勾配に関する値、エッジに関する値などである。例えば、特徴量抽出部140は、要素分類部130により物体として特定された画像領域について、動領域抽出プロセッサ4による演算結果の一部(輝度勾配行列など)を特徴量として取得する。

【0021】

移動体特定部150は、要素分類部130による分類結果と、特徴量抽出部140により抽出された特徴量とに基づいて、路面や(例えば建物や街路樹などの)背景に相当する画像領域と、これら以外の物体(例えば、他の移動体)に相当する画像領域を特定する。例えば、移動体特定部150は、要素分類部130により物体として特定された画像領域の形、大きさ、及び位置に基づいて、他の移動体を特定する。また、移動体特定部150は、撮影画像上の路面に相当する画像要素と同じラベルが付された画素を既定以上に含む画像要素を、路面と判断し、これら以外の画像領域を他の移動体として判断してもよい。

【0022】

追跡部160は、移動体特定部150により特定された物体に相当する画像領域を、動きモデルに基づいて追跡する。本例の追跡部160は、動領域抽出プロセッサ4により得られる予測ラベルマップに基づいて、物体に相当する画像要素の移動先を追跡する。

【0023】

運転支援部170は、視差分割部120により抽出された視差情報(視差マップなど)と、移動体特定部150の特定結果と、追跡部160の追跡結果に基づいて、自動車の運転を支援する。例えば、運転支援部170は、視差分割部120により生成された視差マップと、移動体特定部150の特定結果と、追跡部160の追跡結果に基づいて、路面以外の画像要素の視差と接近の速さが既定値以上となった場合に、障害物との衝突の危険性が高いものと判断して、その旨の警告音を出力させる。また、運転支援部170は、さらに、追跡部160による追跡結果に基づいて、他の移動体の移動方向を予測して、障害物の接近を評価してもよい。また、運転支援部170は、緊急ブレーキの自動制御、又は、他の移動体を追尾するように速度を制御する速度自動制御を行ってもよい。

【0024】

図3は、動領域抽出プロセッサ4の機能構成を例示する図である。

図3に例示するように、動領域抽出プロセッサ4は、画像メモリ400と、輝度勾配演算部410と、動きモデル計算部420と、領域ラベリング部430と、ラベルマップメモリ440と、2つの動きモデルメモリ450と、2つの領域テーブルレジスタ460と、ラベルマップ推定部470と、制御部480とで構成されている。

画像メモリ400は、4フレームの画像データを保存するために、4つの画像メモリを含む。動きモデルメモリ450は2つ存在する。すなわち、動領域抽出プロセッサ4には、画像メモリ400として、前後フレーム2枚が2つずつ存在する。これはスループットを向上させるため、1フレームの画像を小さなブロック画像に分割し、ブロック画像単位で処理を行う画面分割手法を取り入れて、ブロック画像単位でフレームパイプライン処理を行っていることによる。それゆえ、動きモデルメモリ450、及び、領域テーブルレジスタ460もそれぞれ2つずつ存在する。

なお、動領域抽出プロセッサ4の外部には、推定マップ600と、領域テーブルメモリ610とが設けられている。

【0025】

輝度勾配演算部410A及び410Bは、輝度勾配の算出と、動き精度評価指標の算出とを行う論理ブロックである。

動きモデル計算部420は、動きモデル推定を行う論理ブロックである。

領域ラベリング部430は、領域ラベリングを行う論理ブロックである。

【0026】

ラベルマップメモリ440は、ラベルマップを保存するためのメモリである。

動きモデルメモリ450は、動きモデルを保存するためのメモリである。

領域テーブルレジスタ460は、領域テーブルを保持するレジスタである。

【0027】

ラベルマップ推定部470は、ラベルマップ予測を行う論理ロジックである。

制御部480は、他の構成を制御するコントローラーである。

【0028】

図4は、運転支援処理の全体動作(S10)を説明するフローチャートである。

図5は、アフィン動きモデル推定処理をより詳細に説明するフローチャートである。

図6は、境界更新処理(又は新領域検出処理)をより詳細に説明するフローチャートである。

図7は、ラベルマップ推定処理をより詳細に説明するフローチャートである。

【0029】

図4に示すように、情報処理装置10は、2台のカメラ20から入力された動画像データに関して、動画像を構成する連続フレーム毎に、S100〜S190の処理を実行する。なお、2台のカメラ20から入力される動画像データを、便宜上、右動画像データと、左動画像データと呼ぶ。

ステップ100(S100)において、動領域抽出プロセッサ4は、左動画像データについて、アフィン動きモデル推定処理を行う。より具体的には、アフィン動きモデルθとは、図13の式(1)のように、6つのパラメータの組み合わせで動き場全体を表現できる。平行移動・回転・発散収縮を基本とした様々な動きを表現でき、座標(x, y)におけるx,y 軸方向の動きベクトル(u, v)は式(1)のように書ける。

動画像からアフィン動きモデルを推定するには、動領域抽出プロセッサ4は、画面の各画素から計算される時空間輝度勾配Ix, Iy, Itを用いて,輝度勾配行列G,Gsを計算する。そして逆行列G-1を計算し、アフィン動きモデルθ= G-1 ・Gsを計算する。

動領域抽出では、アフィン動きモデル推定の精度を向上させるためPSMアルゴリズム(本実施形態)又はRMRアルゴリズム(後述する変形例)を採用している。PSMアルゴリズムでは動きモデル推定をする際、図5又は図6の4つの繰り返し計算を行い、推定精度を向上させている。各繰り返しは、図9に示されているように、階層ピラミッド単位、階層単位、階層フレーム単位、最下層画素単位と入れ子構造の繰り返し計算を行う。階層フレーム単位の繰り返しは、動きモデルを足し込んでいき精度を向上させる。階層単位の繰り返しは、画像の大きな動きに対応させるために上位の低解像度画像での推定結果を下位の画像で利用する。

階層ピラミッド単位の繰り返しは、アフィン動きモデル推定の際の外れ値を、ロバスト推定器であるM-estimatorを用いて画素単位で重みの評価指標qiによって重みwiを計算し、推定精度を向上させている。

【0030】

ステップ120(S120)において、動領域抽出プロセッサ4は、左動画像データについて、境界更新処理を行う。より具体的には、動領域抽出プロセッサ4は、予測マップe~と動きモデルθの二つから最適な境界を持つラベルマップeに更新する。更新には、図14のエネルギー関数U(e, o, e~) を最小化し、最適なラベルマップを推定する。oは画像と動きモデルから計算される観測値(オブザベーション)であり、動きモデルによって計算される動きの信頼性を表す。

このステップも、アフィン動きモデル推定処理と同様に、繰り返し処理を行いラベルマップの推定結果を向上させている。ただし、階層ピラミッド単位の繰り返し処理は除く。

【0031】

ステップ140(S140)において、動領域抽出プロセッサ4は、左動画像データについて、新領域検出処理を行う。より具体的には、動領域抽出プロセッサ4は、それぞれの領域において、推定された動きモデルが当てはまらない領域を検出する。具体的には、それぞれの領域に対して動きモデルが適合する”static ”領域、適合しない”mobile ”領域に分割する。これには領域更新ステップで用いたようなエネルギー最小化を行う。またこのステップも境界更新ステップと同様な繰り返し処理を行うことによって推定結果を向上させている。

【0032】

ステップ160(S160)において、動領域抽出プロセッサ4は、左動画像データについて、ラベルマップ予測処理を行う。より具体的には、動領域抽出プロセッサ4は、ラベルマップe(t)と動きモデルθの二つから、時刻t+1におけるラベルマップを予測する。具体的には、各画素の移動先を動きモデルによって計算し、ラベルを移動させる。そして時刻t+1では、予測マップe~(t+1)を用いてアフィン動きモデル推定を行う。

【0033】

ステップ170(S170)において、動領域抽出プロセッサ4は、視差マップを生成する。より具体的には、動領域抽出プロセッサ4(視差分割部120)は、左動画像データを時刻tのデータ、右動画像データを時刻t+1のデータとみなして、上記S100〜S140の処理と同等の処理を行い、視差による動きを示すラベルマッピングを行う。なお、本ステップは、便宜上、S160の処理と並行して記載してあるが、実際には、他のステップと並行してもよいし、S100〜S160のいずれかに直列的に挿入されてもよい。

【0034】

ステップ180(S180)において、移動体特定部150は、動領域抽出プロセッサ4により生成された領域マップ及び視差マップに基づいて要素分類部130により分類された画像領域と、特徴量抽出部140により抽出された特徴量とに基づいて、他の移動体に相当する画像要素を特定する。より具体的には、要素分類部130は、動領域抽出プロセッサ4により生成された領域マップ(動き分割部110による分割結果)と、動領域抽出プロセッサ4により生成された視差マップ(視差分割部120による分割結果)とに基づいて、画像領域を分類し、特徴量抽出部140は、分類された画像領域の特徴量を抽出する。移動体特定部150は、路面の動きモデルと、各画像領域の動きモデルとを比較して、路面に相当する画像領域以外の画像領域を特定し、路面以外の画像領域それぞれについて、特徴量に基づいて、他の移動体に相当する画像領域であるか否かを判断する。

ステップ190(S190)において、運転支援部170は、移動体特定部150による特定結果と、視差ラベルとに基づいて、運転支援を行う。例えば、運転支援部170は、他の移動体に相当する画像領域の視差ラベルから、この移動体が既定距離以上離れていると判断できる場合に、平常状態である旨を情報処理装置10のタッチパネルに表示させ、この移動体が既定距離よりも近いと判断した場合に、この移動体に相当する画像要素のラベルマップを参照して、この移動体の移動状態(接近中なのか、離れて行っているのか)をタッチパネルに表示させる。

なお、図12(A)は、路面マップを例示し、図12(B)は、視差マップを例示する。視差マップによれば、横断歩道やセンターラインなどの路面表示物も、路面として評価できる。視差マップと路面マップによって、路面表示物の抽出も可能になる。

【0035】

以上説明したように、本実施形態の運転支援システム1によれば、1回の動領域抽出によって、領域分割(撮影画像を画像要素に分割する処理)と、視差情報の抽出(視差マップの生成処理)とを同時に行うため、処理負荷を抑えることができる。例えば、ステレオ画像をブロックマッチングして、右画像と左画像の同一画像要素を特定し、視差を算出する場合には、本実施形態の方法に比べて、格段に演算量が大きい。そして、視差を用いて物体に相当する領域に分割する処理を別途行う必要がある。また、ブロックマッチングを行う方法では、右動画像と左動画像をできるだけ一致させるために、精細なカメラの校正と画像の補正が必要であるが、本実施形態では、これらは不要である。

また、本実施形態によれば、動領域抽出に基づく動き分割と追跡により動きや形の変化を推定するため、他の移動体に相当する画像要素の多様な動きや、形の変化にも対応できる。さらに、これらの処理過程で得られる情報を特徴量とすれば、一般には演算量の大きい他の手段で別途特徴量を抽出することなく、移動体の特定が可能である。つまり、システムを構成する複数の処理の間で動領域抽出を共通の処理とすることで、高速で面積の小さい実装が可能である。

【0036】

[変形例1]

次に、上記実施形態の変形例を説明する。変形例として、より効率化した動領域抽出プロセッサ5を例示する。

図8は、変形例における動領域抽出プロセッサ5の機能ブロック図である。

図8に例示するように、動領域抽出プロセッサ5は、画像メモリ500と、共通演算部510と、動きモデル計算部520と、領域ラベリング部530と、ラベルマップメモリ540と、動きモデルメモリ550と、領域テーブルレジスタ560と、ラベルマップ推定部570と、制御部580とで構成されている。

なお、動領域抽出プロセッサ5の外部には、推定マップ600と、領域テーブルメモリ610とが設けられている。

【0037】

画像メモリ500は、前後2フレームの画像データを保存するために、第1画像メモリ500Aと、第2画像メモリ500Bとを含む。

共通演算部510は、動きモデル推定処理と領域ラベリング処理とで共通の演算を行う論理ブロックである。より具体的には、共通演算部510は、輝度勾配の算出と、動き精度評価指標の算出とを行う。

動きモデル計算部520は、動きモデル推定を行う論理ブロックである。

領域ラベリング部530は、領域ラベリングを行う論理ブロックである。

【0038】

ラベルマップメモリ540は、ラベルマップを保存するためのメモリである。

動きモデルメモリ550は、動きモデルを保存するためのメモリである。

領域テーブルレジスタ560は、領域テーブルを保持するレジスタである。

【0039】

ラベルマップ推定部570は、ラベルマップ予測を行う論理ロジックである。

制御部580は、他の構成を制御するコントローラーである。

【0040】

上記実施形態の動領域抽出プロセッサ4は、動領域抽出処理各ステップを階層ピラミッド単位で逐次処理する必要があった。そして、スループットを向上させるために、画面分割手法とフレームパイプライン手法を取り入れた。しかし、フレームパイプライン手法により、画像メモリ400及び動きモデルメモリ450をチップ内部に前後2フレーム分持つ必要があるためにチップ面積の増加に繋がった。また、動きモデル推定ステップと領域ラべリングステップにおいて、輝度勾配、動きの精度評価指標といった類似した計算を行うが、別々の演算器で処理を行っていることもハードウェア規模の増加に繋がっている。

【0041】

一方で、本変形例の動領域抽出プロセッサ5は、図9に示すように、動きモデル推定処理と領域ラベリング処理との間の連携強化、画素単位のパイプライン処理の実現、及び、要素処理(輝度勾配の算出など)の共通化と簡単化、によって、上記実施形態と比較して、アーキテクチャの50%削減、及び、4.2倍のスループットを実現している。

すなわち、上記実施形態の動領域抽出プロセッサ4は、最終的な動きモデル推定の結果を用いて領域ラベリングを行い、処理が逐次的に行われていた。一方、本変形例の動領域抽出プロセッサ5は、下記の2つの改良点によって、動きモデルとラベルマップの交換が階層フレーム単位の繰り返しで可能となり、各ステップ処理が緊密な連携をとれるようになった。さらに、本変形例の動領域抽出各ステップ処理で、階層フレーム単位の1回前の繰り返し計算の推定結果を利用することで、ステップ単位での並列計算が実現できる。

改良点の1つ目は、動きモデル推定にRMRアルゴリズムを採用した。比較例で用いられるPSMアルゴリズムは、動きモデル計算及び重み計算を、階層ピラミッド単位で繰り返し計算する。それに対し、本実施形態のRMRアルゴリズムは、図9(A)のように、動きモデル計算及び重み計算を、階層フレーム単位で繰り返し計算する。さらに階層フレーム単位で1回前の繰り返し計算結果を用いることで、動きモデル計算及び重み計算を並列に計算することが可能となる。また、本変形例では、重み計算に関して、動き精度評価指標qiを領域ラベリングステップの動き精度評価指標と共通化しεiとした。

改良点の2つ目は、動きモデルと領域ラベリング間で頻繁な処理結果の交換を行う点である。動きモデル推定ステップでRMRアルゴリズムを採用することによって、領域ラベリングと同様な繰り返し処理を行うようになる。そこに注目して、図9(A)のように、階層フレーム単位の処理を、動きモデル推定処理、境界更新処理、新領域検出処理の順で処理していき、その結果を次の階層フレーム単位の繰り返し計算の時に利用する。その後、階層単位の繰り返し処理を行い(図9(A)中の3)、また同様に階層フレーム単位の繰り返し計算を行う。この階層フレーム単位の繰り返し計算を、各ステップに渡って一度に実行することによって、最新の動きモデルと最新のラベルマップを利用できる。したがって、本変形例のアルゴリズムは、図9に示すように、実施形態のアルゴリズムより、頻繁に処理結果を交換するアルゴリズムとなる。

【0042】

また、上記実施形態のアルゴリズムの境界更新は、更新対象の1画素に対し複数ラベルのエネルギー計算を行う必要がある。複数ラベルのエネルギー計算には、各ラベルの示す動きに従って移動した画素と、その周囲の画素値が必要であり、同時読み出しが極めて困難である。それゆえ、1画素1サイクルのパイプライン処理が困難である。さらに、境界更新と新領域検出が独立に行われるため、1画素あたり最低2サイクル必要である。

そこで、本変形例の動領域抽出プロセッサ5では、図9(B)に示すように、境界更新の候補ラベル数を削減し、境界更新と新領域検出を統合した。

以下で、動領域抽出全体での画素単位のパイプライン処理を実現するにあたり必要なアルゴリズム最適化について述べる。

まず、本変形例の動領域抽出プロセッサ5では、領域ラベリングステップにおいて、1画素の処理は境界更新か新領域検出のどちらかのみ行う、という処理の二者択一化を行った。上記実施形態のアルゴリズムでは、境界更新処理を境界のみで行い、新領域検出処理を全画素で行っていた。本変形例のアルゴリズムでは、境界更新処理を境界のみで行い、新領域検出処理をそれ以外(境界以外)の画素で行う。こうすることで、同じラスタスキャン中に2ステップの処理を同時に行うことができ、処理を統合できる。

さらに、本変形例では、境界更新ステップにおける参照ラベルを、注目画素のラベルと、周囲に存在するラベルの2つに制限した。言い換えると、更新後なりうるラベルが、”元のラベル”か、”周りにあるラベル”かの2種類に制限した。本変形例の動領域抽出プロセッサ5は、ラベルが3種類以上ある場合に、例えば、ラベル番号の若い物を2つ選択する。この変更によって、境界検出が新領域検出と同様な処理を行うことになる。新領域検出に関しては、上記実施形態と変わらず、”static”と ”mobile”のラベル2種類である。ラベル決定法に関しては、エネルギー計算対象のラベルは”static”のみとなる。

【0043】

また、上記実施形態の動領域抽出アルゴリズムは、各ステップにおいて類似した計算が存在し、それを逐次的に何度も計算させていた。本変形例のアルゴリズムは、類似した計算を共通化させ、演算器を共有させるために、共通化と簡単化を行った。

輝度勾配計算(輝度勾配演算部410による計算)は,動きモデル推定の輝度勾配行列G,Gsの計算に必要であり、また動きモデル推定の重みwiの計算、境界更新のエネルギー関数U1、新領域検出のエネルギー関数U1で必要になる動きの精度評価指標に必要となる。これらは、共通の計算を行っており、本変形例では、処理の内容を共通化し、演算部(共通演算部510)を動きモデル計算部520(アフィン動きモデル推定処理)と領域ラベリング部530(領域更新・新領域検出処理)とに共用させる。

動き精度評価指標は、動きモデル推定の重み計算、領域ラベリングのエネルギー関数U1において必要である。動領域抽出処理全体で画素単位のパイプライン処理を実現するために、動きモデル推定の重み計算と、領域ラベリングの動きの精度評価指標計算とを共通化し、計算回路を一つにする。具体的には、図11に示すように、演算式を簡単化し共通化し、共通演算部510により計算させることとした。また、重み計算時の閾値はCを、動き精度評価指標が共通化されたことからηに置き換わる。また境界更新のエネルギー関数を新領域検出のエネルギー更新と共通とした。

【0044】

以上説明したように、本変形例の動領域抽出プロセッサ5によれば、上記実施形態と比較して、画像メモリ及び動きモデルメモリが50%となる。また、アフィン動きモデル推定処理、領域更新処理、及び新領域検出処理の共通演算である輝度勾配計算と動き精度評価指標計算が共通化され、動きモデル推定処理及び領域ラベリング処理が並列に画素パイプライン処理を行う。さらに、境界更新処理及び新領域検出処理が一つの論理ブロックに統合される。

より詳細には、本変形例の動領域抽出プロセッサ5は、動きモデル推定及び領域ラベリングの繰り返し計算を、階層フレームごとに交互に計算することによって、動きモデルとラベルマップの情報交換が緊密になり、分割結果収束までの繰り返し回数が削減できる。また、同じ画像の動領域抽出処理に対し、図10に示すように、動きモデル推定及び領域ラベリングの処理を階層フレーム単位で反復させて計算させることができるようになった。さらに動領域抽出処理全体で見たときに画素単位のパイプライン処理が可能になり、図10(B)に示すように、動きモデル推定及び領域ラベリングを並列に計算させることができるようになった。結果、画面分割とフレームパイプライン手法を用いずにスループットを向上させることができ、内部の画像メモリ、及び、動きモデルメモリを50%に削減することができる。また、各ステップの要素処理エネルギー計算を簡単化・共通化し、これらのロジックに関して、比較例のアーキテクチャの50%削減した。比較例と本実施形態とで同精度の領域抽出結果を得る場合、本実施形態の動領域抽出プロセッサ5は、比較例と比較して、4.2倍のスループットを達成できる。

【符号の説明】

【0045】

1 運転支援システム

10 情報処理装置

100 カメラ制御部

110 動き分割部

120 視差分割部

130 要素分類部

140 特徴量抽出部

150 移動体特定部

160 追跡部

170 運転支援部

20 カメラ

4,5 動領域抽出プロセッサ

400,500 画像メモリ

410 輝度勾配演算部

510 共通演算部

420,520 動きモデル計算部

430,530 領域ラベリング部

440,540 ラベルマップメモリ

450,550 動きモデルメモリ

460,560 領域テーブルレジスタ

470,570 ラベルマップ推定部

480,580 制御部

【特許請求の範囲】

【請求項1】

移動体に設定された第1の撮影位置から、前記移動体の外の被写体を複数のタイミングで撮影する第1の撮影手段と、

前記移動体に設定された第2の撮影位置から、前記被写体を複数のタイミングで撮影する第2の撮影手段と、

前記第1の撮影手段により撮影された複数の撮影画像と、前記第2の撮影手段により撮影された複数の撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、各画像要素の動きによって分割する動き分割手段と、

前記第1の撮影手段により撮影された撮影画像と、前記第2の撮影手段により撮影された撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、前記第1の撮影位置及び前記第2の撮影位置の視差による撮影画像上の視差によって分割する視差分割手段と、

前記動き分割手段による分割結果と前記視差分割手段による分割結果を用いて物体に対応する画像要素に分類する要素分類手段と、

前記要素分類手段による分類結果と、前記視差分割手段により抽出された視差情報とに基づいて、前記移動体の運転を支援する運転支援手段と

を有する運転支援システム。

【請求項2】

前記視差分割手段は、前記要素分割手段による分類結果に基づいて、同じ分類の画像要素の視差情報を抽出する

請求項1に記載の運転支援システム。

【請求項3】

入力される複数の撮影画像に基づいて、撮影画像に含まれる画像要素を、それぞれの画像要素の変位により分割する動領域抽出処理装置

を有し、

前記動き分割手段は、前記動領域抽出処理装置に対して、複数のタイミングで撮影された複数の撮影画像を入力して、画像要素を動きによって分割させ、

前記視差分割手段は、前記動領域抽出処理装置に対して、前記第1の撮影手段及び前記第2の撮影手段により略同時に撮影された撮影画像を入力して、画像要素を視差によって分割させる

請求項1に記載の運転支援システム。

【請求項4】

前記移動体は、路面上を走行するものであり、

前記要素分類手段による分類結果に基づいて、撮影画像上の路面に相当する画像要素の動きと比較して、撮影画像の他の画像要素を他の移動体として特定する移動体特定手段

をさらに有し、

前記運転支援手段は、前記移動体特定手段により特定された他の移動体と、前記視差分割手段により抽出された他の移動体の視差情報とに基づいて、他の移動体の接近に関する警告、他の移動体の接近に対する自動回避処理、又は、他の移動体との距離が既定の範囲となるように移動速度を制御する速度調整処理を行う

請求項1に記載の運転支援システム。

【請求項5】

前記移動体は、路面上を走行するものであり、

前記視差分割手段は、前記第1の撮影手段により撮影された撮影画像と、前記第2の撮影手段により撮影された撮影画像とに基づいて、前記第1の撮影位置及び前記第2の撮影位置の視差による動きモデルを視差モデルとして抽出し、

路面の視差モデルに基づいて、路面以外の画像要素を特定する移動体特定手段

をさらに有し、

前記運転支援手段は、前記移動体特定手段により特定された他の移動体と、前記視差分割手段により抽出された他の移動体の視差情報とに基づいて、他の移動体の接近に関する警告、他の移動体の接近に対する自動回避処理、又は、他の移動体との距離が既定の範囲となるように移動速度を制御する速度調整処理を行う

請求項1に記載の運転支援システム。

【請求項6】

第1の撮影位置及び第2の撮影位置から、被写体を撮影する撮影ステップと、

前記第1の撮影位置から撮影された複数の撮影画像と、前記第2の撮影位置から撮影された複数の撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、各画像要素の動きによって分割する動き分割ステップと、

前記第1の撮影位置から撮影された撮影画像と、前記第2の撮影位置から撮影された撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、前記第1の撮影位置及び前記第2の撮影位置の視差による撮影画像上の視差情報によって分割する視差分割ステップと、

前記動き分割ステップによる分割結果と前記視差分割ステップによる分割結果を用いて物体に対応する画像要素に分類する要素分類ステップと、

前記要素分類ステップによる分類結果と、前記視差分割ステップにより得られた視差情報とに基づいて、前記移動体の運転を支援する運転支援ステップと

を有する運転支援方法。

【請求項7】

第1の撮影位置から撮影された複数の撮影画像と、第2の撮影位置から撮影された複数の撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、各画像要素の動きによって分割する動き分割ステップと、

前記第1の撮影位置から撮影された撮影画像と、前記第2の撮影位置から撮影された撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、前記第1の撮影位置及び前記第2の撮影位置の視差による撮影画像上の視差情報によって分割する視差分割ステップと、

前記動き分割ステップによる分割結果と前記視差分割ステップによる分割結果を用いて物体に対応する画像要素に分類する要素分類ステップと、

前記要素分類ステップによる分類結果と、前記視差分割ステップにより得られた視差情報とに基づいて、前記移動体の運転を支援するための情報を生成する運転支援ステップと

をコンピュータに実行させるプログラム。

【請求項1】

移動体に設定された第1の撮影位置から、前記移動体の外の被写体を複数のタイミングで撮影する第1の撮影手段と、

前記移動体に設定された第2の撮影位置から、前記被写体を複数のタイミングで撮影する第2の撮影手段と、

前記第1の撮影手段により撮影された複数の撮影画像と、前記第2の撮影手段により撮影された複数の撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、各画像要素の動きによって分割する動き分割手段と、

前記第1の撮影手段により撮影された撮影画像と、前記第2の撮影手段により撮影された撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、前記第1の撮影位置及び前記第2の撮影位置の視差による撮影画像上の視差によって分割する視差分割手段と、

前記動き分割手段による分割結果と前記視差分割手段による分割結果を用いて物体に対応する画像要素に分類する要素分類手段と、

前記要素分類手段による分類結果と、前記視差分割手段により抽出された視差情報とに基づいて、前記移動体の運転を支援する運転支援手段と

を有する運転支援システム。

【請求項2】

前記視差分割手段は、前記要素分割手段による分類結果に基づいて、同じ分類の画像要素の視差情報を抽出する

請求項1に記載の運転支援システム。

【請求項3】

入力される複数の撮影画像に基づいて、撮影画像に含まれる画像要素を、それぞれの画像要素の変位により分割する動領域抽出処理装置

を有し、

前記動き分割手段は、前記動領域抽出処理装置に対して、複数のタイミングで撮影された複数の撮影画像を入力して、画像要素を動きによって分割させ、

前記視差分割手段は、前記動領域抽出処理装置に対して、前記第1の撮影手段及び前記第2の撮影手段により略同時に撮影された撮影画像を入力して、画像要素を視差によって分割させる

請求項1に記載の運転支援システム。

【請求項4】

前記移動体は、路面上を走行するものであり、

前記要素分類手段による分類結果に基づいて、撮影画像上の路面に相当する画像要素の動きと比較して、撮影画像の他の画像要素を他の移動体として特定する移動体特定手段

をさらに有し、

前記運転支援手段は、前記移動体特定手段により特定された他の移動体と、前記視差分割手段により抽出された他の移動体の視差情報とに基づいて、他の移動体の接近に関する警告、他の移動体の接近に対する自動回避処理、又は、他の移動体との距離が既定の範囲となるように移動速度を制御する速度調整処理を行う

請求項1に記載の運転支援システム。

【請求項5】

前記移動体は、路面上を走行するものであり、

前記視差分割手段は、前記第1の撮影手段により撮影された撮影画像と、前記第2の撮影手段により撮影された撮影画像とに基づいて、前記第1の撮影位置及び前記第2の撮影位置の視差による動きモデルを視差モデルとして抽出し、

路面の視差モデルに基づいて、路面以外の画像要素を特定する移動体特定手段

をさらに有し、

前記運転支援手段は、前記移動体特定手段により特定された他の移動体と、前記視差分割手段により抽出された他の移動体の視差情報とに基づいて、他の移動体の接近に関する警告、他の移動体の接近に対する自動回避処理、又は、他の移動体との距離が既定の範囲となるように移動速度を制御する速度調整処理を行う

請求項1に記載の運転支援システム。

【請求項6】

第1の撮影位置及び第2の撮影位置から、被写体を撮影する撮影ステップと、

前記第1の撮影位置から撮影された複数の撮影画像と、前記第2の撮影位置から撮影された複数の撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、各画像要素の動きによって分割する動き分割ステップと、

前記第1の撮影位置から撮影された撮影画像と、前記第2の撮影位置から撮影された撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、前記第1の撮影位置及び前記第2の撮影位置の視差による撮影画像上の視差情報によって分割する視差分割ステップと、

前記動き分割ステップによる分割結果と前記視差分割ステップによる分割結果を用いて物体に対応する画像要素に分類する要素分類ステップと、

前記要素分類ステップによる分類結果と、前記視差分割ステップにより得られた視差情報とに基づいて、前記移動体の運転を支援する運転支援ステップと

を有する運転支援方法。

【請求項7】

第1の撮影位置から撮影された複数の撮影画像と、第2の撮影位置から撮影された複数の撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、各画像要素の動きによって分割する動き分割ステップと、

前記第1の撮影位置から撮影された撮影画像と、前記第2の撮影位置から撮影された撮影画像とに基づいて、それぞれの撮影画像に含まれる画像要素を、前記第1の撮影位置及び前記第2の撮影位置の視差による撮影画像上の視差情報によって分割する視差分割ステップと、

前記動き分割ステップによる分割結果と前記視差分割ステップによる分割結果を用いて物体に対応する画像要素に分類する要素分類ステップと、

前記要素分類ステップによる分類結果と、前記視差分割ステップにより得られた視差情報とに基づいて、前記移動体の運転を支援するための情報を生成する運転支援ステップと

をコンピュータに実行させるプログラム。

【図1】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図13】

【図14】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図13】

【図14】

【公開番号】特開2013−105392(P2013−105392A)

【公開日】平成25年5月30日(2013.5.30)

【国際特許分類】

【出願番号】特願2011−249916(P2011−249916)

【出願日】平成23年11月15日(2011.11.15)

【出願人】(504160781)国立大学法人金沢大学 (282)

【Fターム(参考)】

【公開日】平成25年5月30日(2013.5.30)

【国際特許分類】

【出願日】平成23年11月15日(2011.11.15)

【出願人】(504160781)国立大学法人金沢大学 (282)

【Fターム(参考)】

[ Back to top ]