オブジェクト追跡装置、方法、及びプログラム

【課題】オブジェクトを追跡する際に、オブジェクトの位置推定の精度を向上させる。

【解決手段】位置予測手段14は、2以上のフレーム画像間のオブジェクトの動きに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測する。位置マップ生成手段15は、予測された位置の周辺の複数の位置とオブジェクトの存在確率を示す値との対応関係を位置マップとして生成する。特徴量計算手段16は、予測された位置の近傍の複数の位置のそれぞれでオブジェクトらしさを示す特徴量を計算し、アピアランスマップを生成する。位置推定手段17は、位置マップとアピアランスマップとを組み合わせ、処理対象のフレーム画像におけるオブジェクトの位置を推定する。

【解決手段】位置予測手段14は、2以上のフレーム画像間のオブジェクトの動きに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測する。位置マップ生成手段15は、予測された位置の周辺の複数の位置とオブジェクトの存在確率を示す値との対応関係を位置マップとして生成する。特徴量計算手段16は、予測された位置の近傍の複数の位置のそれぞれでオブジェクトらしさを示す特徴量を計算し、アピアランスマップを生成する。位置推定手段17は、位置マップとアピアランスマップとを組み合わせ、処理対象のフレーム画像におけるオブジェクトの位置を推定する。

【発明の詳細な説明】

【技術分野】

【0001】

本発明は、オブジェクト追跡装置、方法、及びプログラムに関し、更に詳しくは、動画像を構成する複数のフレーム画像間でオブジェクトを追跡するオブジェクト追跡装置、方法、及びプログラムに関する。

【背景技術】

【0002】

従来、動画像を構成する複数のフレーム画像間でオブジェクトを追跡する技術として、いくつかの手法が知られている(例えば特許文献1、2)。特許文献1では、あるフレーム(時刻)におけるオブジェクトの位置情報に基づいて、線形予測を用いて次フレームにおけるオブジェクトの予測位置を算出し、その予測位置に基づいて、次フレームにおけるオブジェクトの探索範囲を設定する。その後、設定された探索範囲について、フレーム間の差分画像が所定の条件を満たすか否かを画素ごとに判断することでオブジェクト候補画像を生成し、そのオブジェクト候補画像の中から、抽出条件に基づいて追跡対象のオブジェクトを追跡する。

【0003】

特許文献2では、所定間隔おきのフレーム画像(静止画データ)中から人間の顔を探索し、あるフレーム画像において人間の顔が検出できたとき、そのフレーム画像の前後で顔を追跡する。顔の追跡では、検出済みのフレーム画像におけるオブジェクトの位置に基づいてオブジェクトの探索範囲を設定し、探索範囲内で顔の検出を行う。探索範囲は、例えば検出済みのフレーム画像が1つしかない場合には、そのフレーム画像におけるオブジェクトの位置と、オブジェクトの変動予測量とに基づいて設定する。複数のフレーム画像においてオブジェクトが検出済みの場合には、検出済みの複数のフレーム画像におけるオブジェクトの位置に基づいて対象フレームにおけるオブジェクトの位置を予測し、その予測位置と変動予測量とに基づいて探索範囲を設定する。

【先行技術文献】

【特許文献】

【0004】

【特許文献1】特開2006−195525号公報

【特許文献2】特開2005−99953号公報

【発明の概要】

【発明が解決しようとする課題】

【0005】

特許文献1及び2では、探索範囲内で画素値に基づいてオブジェクトらしさ(アピアランス特徴)を算出し、オブジェクトの検出を行っている。アピアランス特徴を用いたオブジェクトの検出は、通常の場合では有効であるものの、照明の変動やオブジェクトに重なりが生じたときにはアピアランス誤差が生じ、オブジェクトをうまく検出できないことがある。一方、オブジェクトの動きに基づく位置予測は、照明の変動やオブジェクトに重なりが生じたときでも、安定的に予測可能である。しかしながら、いったん位置誤差が生じると、オブジェクト追跡を追跡している間にその誤差が累積され、予測精度が低下する。

【0006】

本発明は、上記に鑑み、オブジェクトを追跡する際に、オブジェクトの位置推定の精度を向上させることができるオブジェクト追跡装置、方法、及びプログラムを提供することを目的とする。

【課題を解決するための手段】

【0007】

上記目的を達成するために、本発明は、動画像を構成する複数のフレーム画像に含まれるオブジェクトを複数のフレーム画像間で追跡するオブジェクト追跡装置において、2以上のフレーム画像間のオブジェクトの動きに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測する位置予測手段と、フレーム画像中の前記予測された位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、各位置と前記決定した値との対応関係を位置マップとして生成する位置マップ生成手段と、前記処理対象のフレーム画像に基づいて、前記位置予測手段が予測した位置の近傍の複数の位置のそれぞれでオブジェクトらしさを示す特徴量を計算し、各位置と前記特徴量との対応関係をアピアランスマップとして生成する特徴量計算手段と、前記位置マップと前記アピアランスマップとを組み合わせ、該組み合わせたマップに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を推定する位置推定手段とを備えたことを特徴とするオブジェクト追跡装置を提供する。

【0008】

ここで、オブジェクトの動きに基づく位置の予測には、例えば動きベクトルを用いた位置の予測や、オブジェクトの運動特性を利用した位置の予測などを用いることができる。オブジェクトの存在確率を表す値は、例えばオブジェクトの存在確率が高いほど大きな値となる。オブジェクトらしさを示す特徴量は、例えばオブジェクトらしさが高いほど大きな値となる。

【0009】

本発明では、前記位置予測手段が、相互に異なる2以上の手法で前記処理対象のフレーム画像におけるオブジェクトの位置を予測するものであり、前記位置マップ生成手段が、前記2以上の手法のそれぞれについて前記予測された位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、該2以上の手法のそれぞれについて決定した値を組み合わせ、各位置と前記組み合わせた値との対応関係を位置マップとして生成する構成を採用できる。

【0010】

上記の場合、前記位置マップ生成手段は、2以上の手法のそれぞれについて複数の位置に対して決定した値のうち、前記フレーム画像の同一の位置に対して決定した値を重み付け加算することで前記決定した値を組み合わせるものとすることができる。

【0011】

本発明では、前記位置予測手段が、前記フレーム画像を縮小する画像縮小手段と、前記処理対象のフレーム画像を縮小した画像と、前記処理対象のフレーム画像とは異なる時刻のフレーム画像を縮小した画像とに基づいて動きベクトルを計算する動きベクトル計算手段と、前記処理対象のフレーム画像とは異なる時刻のフレーム画像におけるオブジェクトの位置と、前記動きベクトルとに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を予測する動き位置予測手段とを含む構成を採用できる。

【0012】

本発明では、前記位置予測手段が、前記処理対象のフレーム画像とは異なる2以上の時刻のフレーム画像におけるオブジェクトの位置に基づいてオブジェクトの運動特性を測定する運動特性測定手段と、前記測定された運動特性と、前記処理対象のフレーム画像とは異なる2以上の時刻のうちの少なくとも一方のフレーム画像におけるオブジェクトの位置とに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を予測する運動位置予測手段とを更に含む構成を採用することもできる。

【0013】

前記位置推定手段は、フレーム画像の同一の位置に対応する位置マップの値とアピアランスマップの値とを乗算し、該乗算した値が最大となるフレーム画像の位置をオブジェクトの位置として推定してもよい。このとき、乗算は重み付けを伴っていてもよい。

【0014】

前記特徴量計算手段は、前記フレーム画像における、前記位置予測手段が予測した位置の近傍の複数の位置のそれぞれから所定範囲内の画素の画素値ヒストグラムを求め、該求めた画素値ヒストグラムと追跡対象のオブジェクトの画素値ヒストグラムとの類似度を前記特徴量として算出するものであってよい。

【0015】

前記特徴量計算手段は、前記所定範囲を複数のブロックに分割した分割ブロックごとに画素値ヒストグラムを求め、該求めた画素値ヒストグラムと前記追跡対象のオブジェクトの画素値ヒストグラムとを前記分割ブロックごとに算出し、該分割ブロックごとに求めた類似度を組み合わせたものを前記特徴量として算出してもよい。

【0016】

本発明のオブジェクト追跡装置は、前記フレーム画像からオブジェクトを検出するオブジェクト検出手段を更に備える構成でもよい。

【0017】

本発明は、また、動画像を構成する複数のフレーム画像に含まれるオブジェクトを複数のフレーム画像間で追跡するオブジェクト追跡方法において、2以上のフレーム画像間のオブジェクトの動きに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測するステップと、フレーム画像中の前記予測された位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、各位置と前記決定した値との対応関係を位置マップとして生成するステップと、前記処理対象のフレーム画像に基づいて、前記位置予測手段が予測した位置の近傍の複数の位置のそれぞれでオブジェクトらしさを示す特徴量を計算し、各位置と前記特徴量との対応関係をアピアランスマップとして生成するステップと、前記位置マップと前記アピアランスマップとを組み合わせ、該組み合わせたマップに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を推定するステップとを有することを特徴とするオブジェクト追跡方法を提供する。

【0018】

更に本発明は、コンピュータに、動画像を構成する複数のフレーム画像に含まれるオブジェクトを複数のフレーム画像間で追跡する処理を実行させるプログラムであって、前記コンピュータに、2以上のフレーム画像間のオブジェクトの動きに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測するステップと、フレーム画像中の前記予測された位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、各位置と前記決定した値との対応関係を位置マップとして生成するステップと、前記処理対象のフレーム画像に基づいて、前記位置予測手段が予測した位置の近傍の複数の位置のそれぞれでオブジェクトらしさを示す特徴量を計算し、各位置と前記特徴量との対応関係をアピアランスマップとして生成するステップと、前記位置マップと前記アピアランスマップとを組み合わせ、該組み合わせたマップに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を推定するステップとを実行させるためのプログラムを提供する。

【発明の効果】

【0019】

本発明オブジェクト追跡装置、方法、及びプログラムでは、オブジェクトの動きに基づいてオブジェクトの位置を予測し、その予測した位置の周辺に位置マップを生成する。また、予測された位置の周辺でオブジェクトらしさを示す特徴量を計算してアピアランスマップを生成し、双方のマップを組み合わせてオブジェクトの位置を推定する。本発明では、オブジェクトの動きに基づく位置予測と、特徴量に基づく位置予測とを組み合わせてオブジェクトの位置を推定しているため、何れか一方を単独で用いる場合に比して、位置推定の精度を向上できる。

【図面の簡単な説明】

【0020】

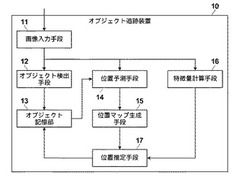

【図1】本発明の一実施形態のオブジェクト追跡装置を示すブロック図。

【図2】2つの手法でオブジェクトの位置を予測する位置予測手段の構成例を示すブロック図。

【図3】位置予測手段が2つの手法でオブジェクトの位置を予測する場合の位置マップ生成手段の構成例を示すブロック図。

【図4】(a)〜(c)は、動き位置マップ、運動位置マップ、及び両者を組み合わせた位置マップを例示する図。

【図5】特徴量計算手段が特徴量を計算する際の関心領域(ROI:Region Of Interest)を例示する図。

【図6】位置の補正を例示する図。

【図7】動作手順を示すフローチャート。

【図8】オブジェクト追跡装置が実現可能であるハードウェアの構成例を示すブロック図。

【発明を実施するための形態】

【0021】

以下、図面を参照し、本発明の実施の形態を詳細に説明する。図1は、本発明の一実施形態のオブジェクト追跡装置を示す。オブジェクト追跡装置10は、画像入力手段11、オブジェクト検出手段12、オブジェクト記憶部13、位置予測手段14、位置マップ生成手段15、特徴量計算手段16、及び位置推定手段17を備える。オブジェクト追跡装置10内の各部の機能はコンピュータが所定のプログラムに従って処理を実行することで実現可能である。

【0022】

画像入力手段11は、動画像を構成する複数のフレーム画像を順次に入力する。画像入力手段11は、例えば撮像装置からフレーム画像を順次に入力する。あるいは画像入力手段11は、撮像装置を用いて撮影された動画像を記憶装置(図示せず)から読み出してもよい。フレームレートは、例えば毎秒30フレームである。画像入力手段11は、入力されたフレーム画像をオブジェクト検出手段12、位置予測手段14、及び特徴量計算手段16に与える。

【0023】

オブジェクト検出手段12は、フレーム画像からオブジェクトを検出する。オブジェクト検出手段12は、例えばフレーム画像から人物の頭部や顔などのオブジェクトを検出する。オブジェクト検出手段12は、検出したオブジェクトの情報をオブジェクト記憶部13に記憶する。オブジェクト検出手段12は、例えば新たにオブジェクトを検出すると、そのオブジェクトにIDを割り当て、IDと、検出したオブジェクトの位置と、オブジェクトの特徴とをオブジェクト記憶部13に記憶する。なお、オブジェクト追跡装置10は、内部にオブジェクト検出手段12及びオブジェクト記憶部13を有している必要はなく、これらはオブジェクト追跡装置10の外部にあってもよい。

【0024】

位置予測手段14は、2以上のフレーム画像間のオブジェクトの動きに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測する。位置予測手段14は、予測したオブジェクトの位置を位置マップ生成手段15と特徴量計算手段16とに出力する。ここで、フレーム画像間のオブジェクトの動きに基づく位置の予測とは、ある時刻のフレーム画像から別の時刻のフレーム画像にかけて、オブジェクトが画像内をどのように動くかに基づいてオブジェクトの位置を予測することを指すものとする。オブジェクトの位置は、例えばオブジェクトを任意の形状の図形で囲んだときのその図形の中心位置や重心位置とすることができる。あるいはオブジェクトの任意の代表点、例えば人物における2つの目の中間地点の位置をオブジェクトの位置として定義してもよい。

【0025】

位置マップ生成手段15は、予測されたオブジェクトの位置を位置予測手段14から受け取る。位置マップ生成手段15は、フレーム画像中の予測された位置を含む複数の位置に対してオブジェクト存在確率(オブジェクトがその位置に存在する確からしさ)を表す値を決定する。位置マップ生成手段15は、各位置と、各位置に対して決定した値との対応関係を位置マップとして生成する。位置マップ生成手段15は、例えば予測されたオブジェクトの位置を中心とし、横方向及び縦方向にそれぞれ所定の距離だけ離れた位置までの各画素に対応した各位置に対してオブジェクトの存在確率を表わす値を決定し、位置マップを生成する。オブジェクト存在確率を表わす値は、例えば予測されたオブジェクトの位置が最大で、その位置から離れるに従って値が減少していくものとする。

【0026】

特徴量計算手段16は、位置予測手段14から予測されたオブジェクトの位置を受け取る。特徴量計算手段16は、処理対象のフレーム画像に基づいて、オブジェクトが存在する位置として予測された位置の近傍の複数の位置のそれぞれでオブジェクトらしさを示す特徴量を計算する。特徴量計算手段16は、各位置と、各位置に対して計算した特徴量との対応関係をアピアランスマップとして生成する。特徴量計算手段16は、例えば位置予測手段14で予測されたオブジェクトの位置を中心とし、横方向及び縦方向にそれぞれ所定の距離だけ離れた位置までの各画素に対応した位置に対して特徴量を計算する。特徴量計算手段16は、各位置と各位置に対して計算された特徴量との対応関係をアピアランスマップとして生成する。特徴量を計算する範囲(アピアランスマップを生成する範囲)は、位置マップが生成された範囲と同じでよい。

【0027】

位置推定手段17は、位置マップ生成手段15から位置マップを受け取り、特徴量計算手段16からアピアランスマップを受け取る。位置推定手段17は、位置マップとアピアランスマップとを組み合わせ、その組み合わせたマップに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を推定する。位置推定手段17は、例えばフレーム画像の同一の位置に対応する位置マップの値とアピアランスマップの値(特徴量)とを乗算し、乗算した値が最大となるフレーム画像の位置をオブジェクトの位置として推定する。位置推定手段17は、乗算に際して重み付けを行ってもよい。位置推定手段17は、推定したオブジェクトの位置をオブジェクト記憶部13に記憶する。位置予測手段14、位置マップ生成手段15、特徴量計算手段16、及び位置推定手段17が処理を繰り返し実行することで、複数のフレーム画像にわたってオブジェクトが追跡される。

【0028】

位置予測手段14は、互いに異なる2以上の手法で処理対象のフレーム画像におけるオブジェクトの位置を予測することができる。例えば位置予測手段14は、動きベクトルに基づいてオブジェクトの位置を予測すると共に、過去のオブジェクトの運動特性に基づいて最新のオブジェクトの位置を予測してもよい。その場合、位置予測手段14は、動きベクトルに基づくオブジェクトの予測位置と、運動特性に基づくオブジェクトの予測位置とを位置マップ生成手段15に出力することができる。

【0029】

位置マップ生成手段15は、位置予測手段14にて2以上の手法でオブジェクトの位置が予測された場合は、2以上の手法のそれぞれについて予測された位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、それら2以上の手法のそれぞれについて決定した値を組み合わせて位置マップを生成すればよい。位置マップ生成手段15は、例えば、2以上の手法のそれぞれについて複数の位置に対して決定した値のうち、フレーム画像の同一の位置に対して決定した値を重み付け加算し、各位置と重み付け加算された値との対応関係を位置マップとして生成してもよい。

【0030】

図2は、2つの手法でオブジェクトの位置を予測する位置予測手段の構成例を示す。位置予測手段14は、画像縮小手段41、動きベクトル生成手段42、動き位置予測手段43、運動特性算出手段44、及び運動位置予測手段45を有する。画像縮小手段41、動きベクトル生成手段42、及び動き位置予測手段43は、動きベクトルに基づく手法でオブジェクトの位置を予測する部分に相当する。運動特性算出手段44及び運動位置予測手段45は、運動特性に基づく手法でオブジェクトの位置を予測する部分に相当する。

【0031】

画像縮小手段41は、フレーム画像を縮小する。画像縮小手段41は、例えばフレーム画像を1/2、1/4、或いは1/8の解像度の画像に縮小(低解像度化)する。画像縮小の手法は特に問わない。例えば画像縮小手段41は、所定の割合で画素を間引くことで、フレーム画像を低解像度の画像に変換する。

【0032】

動きベクトル生成手段42は、処理対象画像のフレーム画像と、そのフレーム画像とは異なる時刻のフレーム画像とに基づいて動きベクトルを計算する。その際、動きベクトル生成手段42は、フレーム画像のそのものではなく、画像縮小手段41にて低解像度の画像に変換されたフレーム画像に基づいて動きベクトルを計算する。低解像度化した画像を用いて動きベクトルを生成することで、元のフレーム画像を用いる場合に比して、動きベクトル生成の処理に要する時間を短縮できる。

【0033】

動きベクトル生成手段42が動きベクトルの生成に際して参照する、処理対象のフレーム画像とは異なる時刻のフレーム画像は、例えば処理対象のフレーム画像の1時刻前のフレーム画像とすることができる。処理対象のフレーム画像の1時刻前のフレーム画像では、オブジェクトの位置が既知であるとする。つまり、処理対象のフレーム画像の1時刻前のフレーム画像におけるオブジェクトの位置は、オブジェクト記憶部13(図1)に記憶済みであるとする。

【0034】

動き位置予測手段43は、動きベクトルを動きベクトル生成手段42から受け取ると共に、オブジェクト記憶部13から、例えば処理対象のフレーム画像の1時刻前のフレーム画像におけるオブジェクトの位置を取得する。動き位置予測手段43は、1時刻前のフレーム画像におけるオブジェクトの位置を動きベクトルに従って移動した位置を、処理対象フレームにおけるオブジェクトの予測位置とする。その際、動き位置予測手段43は解像度変換を行い、低解像度化されたフレーム画像から生成された動きベクトルを用いて、元のフレーム画像の解像度でオブジェクトの位置を予測する。

【0035】

運動特性算出手段44は、処理対象のフレーム画像とは異なる2以上の時刻のフレーム画像におけるオブジェクトの位置に基づいて、オブジェクトの運動特性を測定する。運動特性算出手段44は、例えば処理対象のフレーム画像の時刻を時刻tとして、時刻t−2のフレーム画像と時刻t−1のフレーム画像とに基づいて、オブジェクトの運動特性を測定する。運動特性算出手段44は、例えばオブジェクトが時刻t−2から時刻t−1にかけて、フレーム画像内をどの方向にどれだけ移動したかを測定する。

【0036】

運動位置予測手段45は、測定された運動特性と、処理対象のフレーム画像とは異なる2以上の時刻のうちの少なくとも一方のフレーム画像におけるオブジェクトの位置とに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測する。例えば、運動位置予測手段45は、時刻t−2から時刻t−1までにおけるオブジェクトの運動特性と、時刻t−1でのオブジェクトの位置とに基づいて、時刻tでのオブジェクトの位置を予測する。例えば運動特性算出手段44にて、時刻t−2から時刻t−1にかけてオブジェクトがある方向にある距離だけ移動した旨の運動特性が測定されていた場合、運動位置予測手段45は、時刻t−1におけるオブジェクトの位置からある方向にある距離だけ移動した位置を、時刻tにおけるオブジェクトの位置として予測する。

【0037】

運動特性算出手段44は、例えば時刻t−2から時刻t−1にかけてのオブジェクトの変位(t−2,t−1)を、運動特性として求める。時刻t−2から時刻t−1までの時間と、時刻t−1から時刻tまでの時間とで、オブジェクトの運動に変化がないとすれば、時刻tにおけるオブジェクトの位置は、時刻t−1におけるオブジェクトの位置と、オブジェクトの変位(t−2,t−1)とから予測することが可能である。運動特性算出手段44は、時刻t−3以前の時刻までさかのぼって運動特性を測定してもよい。その場合、測定された運動特性の変化に基づいて、時刻t−1から時刻tにかけてのオブジェクトの運動特性を予測し、予測した運動特性と過去のオブジェクトの位置とから処理対象のフレーム画像におけるオブジェクトの位置を予測してもよい。

【0038】

図3は、位置予測手段14が2つの手法でオブジェクトの位置を予測する場合の位置マップ生成手段の構成例を示す。位置マップ生成手段15は、動き位置マップ生成手段51と、運動位置マップ生成手段52と、加算器53とを有する。動き位置マップ生成手段51は、動き位置予測手段43から動きベクトルに基づいて予測されたオブジェクトの位置を受け取る。動き位置マップ生成手段51は、動きベクトルに基づいて予測されたオブジェクトの位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、各位置と、各位置に対して決定した値との対応関係を動き位置マップとして生成する。

【0039】

運動位置マップ生成手段52は、運動位置予測手段45からオブジェクトの運動特性に基づいて予測されたオブジェクトの位置を受け取る。運動位置マップ生成手段52は、オブジェクトの運動特性に基づいて予測されたオブジェクトの位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、各位置と、各位置に対して決定した値との対応関係を動き位置マップとして生成する。加算器53は、動き位置マップと運動位置マップとを入力する。加算器53は、フレーム画像の同一の位置に対して、動き位置マップ生成手段51で決定された値と運動位置マップ生成手段52で決定された値とを重み付け加算する。

【0040】

図4(a)〜(c)は、動き位置マップ、運動位置マップ、及び両者を組み合わせた位置マップを示す。動き位置マップ生成手段51は、例えば動きベクトルに基づいて予測されたオブジェクトの位置を中心とする横9×縦5の領域範囲内の各位置に対して、オブジェクト存在確率を表す値を決定する(図4(a))。運動位置マップでは、中心に近いほど値が高く、周辺部になるほど値が低くなるようになっている。図4(a)に示される領域の範囲外の各位置については、値なし、或いは値0とする。

【0041】

運動位置マップ生成手段52も、同様に、例えばオブジェクトの運動特性に基づいて予測されたオブジェクトの位置を中心とする横9×縦5の領域範囲内の各位置に対して、オブジェクト存在確率を表す値を決定する(図4(b))。オブジェクトの運動特性に基づいて予測されたオブジェクトの位置は、動きベクトルに基づいて予測されたオブジェクトの位置に対して、紙面向って左側、及び上方向にそれぞれ1画素分ずつずれているものとする。図4(b)において点線で表わされる部分は、動き位置マップのみが生成されている部分に該当する。

【0042】

加算器53は、例えば運動位置マップに所定の重みwを乗じた上で、動き位置マップと運動位置マップとを加算する。例えば運動特性に基づく位置の予測の精度が動きベクトルに基づく位置予測の精度よりも高いことが期待できる場合には、重みwを1より大きな値に設定して重み付け加算する。具体的にw=3として、動き位置マップ(図4(a))と、w×運動位置マップ(図4(b))とを加算すると、図4(c)に示す位置マップが得られる。なお、図4(c)では双方の位置マップに値がある部分のみ加算される例を示しているが、何れか一方に値がある部分については他方を0として加算を行ってもよい。

【0043】

次いで、特徴量計算手段16について説明する。図5は、特徴量計算手段16が特徴量を計算する際の関心領域(ROI:Region Of Interest)を示す。ここではオブジェクトとして人物を考える。ROI601は、人物の頭部(顔)に対応したROIであり、ROI602は、人物の背中(体)に対応したROI602である。ROI601は、左右に2分割(ROI601a、601b)されている。また、ROI602も、左右に2分割(ROI602a、602b)されている。ROI601及び602は、オブジェクトの位置に対して所定の位置関係にある。

【0044】

特徴量計算手段16は、特徴量計算を行うべきフレーム画像中の位置に基づいて、処理対象のフレーム画像におけるROI601の領域を決定する。つまり、フレーム画像中のどの画素領域をROI601とするかを決定する。特徴量計算手段16は、処理対象のフレーム画像におけるROI601内の画素値のヒストグラムを求める。その際、特徴量計算手段16は、ROI601aとROI601bとで、別々に画素値ヒストグラムを求める。オブジェクト検出に際して、オブジェクト検出手段12は、検出したオブジェクトのROI601a、601bに相当する領域内の画素値ヒストグラムを求め、それをオブジェクトの特徴としてオブジェクト記憶部13に記憶している。特徴量計算手段16は、ROI601aとROI601bとについて、それぞれ処理対象のフレーム画像から求めた画素値ヒストグラムと、オブジェクト記憶部13に記憶済みの画素値ヒストグラムとの類似度を計算する。

【0045】

また、特徴量計算手段16は、特徴量計算を行うべきフレーム画像中の位置に基づいて、処理対象のフレーム画像におけるROI602の領域を決定する。特徴量計算手段16は、処理対象のフレーム画像におけるROI602内の画素値のヒストグラムを求める。その際、特徴量計算手段16は、ROI602aとROI602bとで、別々に画素値ヒストグラムを求める。オブジェクト検出に際して、オブジェクト検出手段12は、検出したオブジェクトのROI602a、602bに相当する領域内の画素値ヒストグラムを求め、それをオブジェクトの特徴としてオブジェクト記憶部13に記憶している。特徴量計算手段16は、ROI602aとROI602bとについて、それぞれ処理対象のフレーム画像から求めた画素値ヒストグラムと、オブジェクト記憶部13に記憶済みの画素値ヒストグラムとの類似度を計算する。

【0046】

ROIを2分割し、それぞれについてヒストグラムを求めることで、ROIに形状情報を持たせることができる。ROI601は、人物の頭部と背景とを区別するために使用される。つまり、人物の頭部がROI601内にある場合、その領域の画素値ヒストグラムは人物の頭部に特有の分布を示すため、背景と頭部とを区別することが可能となる。一方、ROI602は、人と人とを区別するために使用される。例えば2人の人物が追跡対象のオブジェクトとなっているとき、2人の人物が着ている服の色が異なれば、ROI602における画素値ヒストグラムは異なる分布となり、2人の人物の識別が可能となる。

【0047】

ここで、一般に、撮影装置などを用いて取得された画像は、3次元空間を2次元空間に投影した画像である。例えば廊下のような奥行きのある空間を、天井など高いことろから撮影した画像を考えると、人物であるオブジェクトは、カメラから遠い位置にいるほど小さなサイズで検出され、カメラから近い位置では大きなサイズで検出される。また、オブジェクトの位置がカメラから遠いときは、オブジェクトが撮影画像中の上の方の領域で検出され、オブジェクトの位置がカメラに近いときは、オブジェクトが撮影画像中の下の方の領域で検出される。従って、オブジェクトのサイズは、フレーム画像中の位置に依存して変化する。

【0048】

特徴量計算手段16は、フレーム画像中の位置に応じてROI601、602のサイズを変更し、ヒストグラム計算を行う。例えばフレーム画像中の上の方の位置に対しては、ROI601、602のサイズを大きく設定し、フレーム画像中の下の方の位置に対しては、ROI601、602のサイズを小さく設定する。オブジェクトの上下移動に対して、ROI601、602のサイズを適切に設定することで、オブジェクトらしさを適切に計算することができる。画像位置に応じたROIサイズの変更には、例えば特開2009−245207号公報に記載された技術を用いることができる。

【0049】

運動位置予測手段45が行う運動特性に基づく位置の予測においても、撮影される3次元空間とフレーム画像における2次元空間との関係に基づいて、位置の補正を行うことができる。図6は、位置の補正を示す。時刻t−2におけるオブジェクトの位置をP(t−1)とし、時刻t−1におけるオブジェクトの位置をP(t−1)とする。時刻t−2から時刻t−1までの間のオブジェクトの変位に基づいて単純に時刻tにおけるオブジェクトの位置を予測すると、同図中に点線で示す矢印の位置がオブジェクトの予測位置となる。しかしながら、移動速度が一定であるとした場合、オブジェクトがフレーム画像の上方に移動するほど、一定期間での縦方向の変位量は減少する。そこで、運動位置予測手段45は、同図中に示す、位置に応じた補正を行った後の位置を、オブジェクトの予測位置とする。

【0050】

また、位置マップ生成手段15が位置マップを生成する範囲は、撮影される3次元空間とフレーム画像における2次元空間との関係に基づいて決定することができる。例えばオブジェクトが3次元空間を一定の速度で任意の方向に移動したときに、フレーム画像におけるオブジェクトの縦方向の変位量が横方向の変位量よりも少なければ、位置マップにおける縦方向の位置の数は、横方向の位置の数よりも少なくすることができる。

【0051】

続いてオブジェクト追跡の動作手順を説明する。図7に、動作手順を示す。オブジェクトの追跡の前の段階で、オブジェクト検出手段12によりオブジェクトが既に検出されており、1時刻前のフレーム画像におけるオブジェクトの位置がオブジェクト記憶部13に記憶されているものとする。画像入力手段11は、処理対象のフレーム画像を入力する(ステップS1)。位置予測手段14は、2以上のフレーム画像間のオブジェクトの動きに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測する(ステップS2)。

【0052】

位置予測手段14は、ステップS2では、例えば処理対象のフレーム画像とその1時刻前のフレーム画像とに基づいて動きベクトルを計算し、動きベクトルと1時刻前のフレーム画像におけるオブジェクトの位置に基づいてオブジェクトの位置を予測する。これに代えて、又は加えて、位置予測手段14は、例えば処理対象のフレーム画像の2時刻前と1時刻前のフレーム画像に基づいてオブジェクトの運動特性を測定し、測定した運動特性と1時刻前のフレーム画像におけるオブジェクトの位置とに基づいてオブジェクトの位置を予測する。

【0053】

位置マップ生成手段15は、位置予測手段14で予測されたフレーム画像中の位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、各位置と決定した値との対応関係を位置マップとして生成する(ステップS3)。位置マップ生成手段15は、位置予測手段14にて例えば動きベクトルと運動特性とに基づいてそれぞれオブジェクトの位置が予測されているときは、それぞれに対してオブジェクト存在確率を表す値を決定し、決定した値を組み合わせることで位置マップを生成してもよい。

【0054】

特徴量計算手段16は、処理対象のフレーム画像に基づいて、位置予測手段14が予測した位置の近傍の複数の位置のそれぞれでオブジェクトらしさを示す特徴量を計算し、各位置と特徴量との対応関係をアピアランスマップとして生成する(ステップS4)。位置推定手段17は、位置マップとアピアランスマップとを組み合わせ、その組み合わせたマップに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を推定する(ステップS5)。位置推定手段17は、例えばフレーム画像の同一の位置に対応する位置マップの値とアピアランスマップの値とを組み合わせ、組み合わせた値が最大となるフレーム画像の位置をオブジェクトの位置として推定する。

【0055】

本実施形態では、オブジェクトの動きに基づいてオブジェクトの位置を予測し、その予測した位置の周辺に位置マップを生成する。また、予測された位置の周辺でオブジェクトらしさを示す特徴量を計算してアピアランスマップを生成し、双方のマップを組み合わせてオブジェクトの位置を推定する。アピアランス特徴を用いたオブジェクトの検出は、通常の場合では有効であるものの、照明の変動やオブジェクトに重なりが生じたときにはアピアランス誤差が生じ、オブジェクトをうまく検出できないことがある。一方、オブジェクトの動きに基づく位置予測は、照明の変動やオブジェクトに重なりが生じたときでも安定的に予測可能であるものの、いったん位置誤差が生じると、オブジェクト追跡を追跡している間にその誤差が累積され、予測精度が低下する。本実施形態では、オブジェクトの動きに基づく位置予測と、特徴量に基づく位置予測とを組み合わせてオブジェクトの位置を推定しているため、何れか一方を単独で用いる場合に比して、位置推定の精度を向上できる。

【0056】

また、本実施形態では、動きベクトルに基づく位置マップと、運動特性に基づく位置マップとを組み合わせて位置マップを生成している。動きベクトルの算出では、計算時間短縮のために低解像度画像が用いられる場合が多い。動きベクトルに基づく位置の予測では、低解像度で予測された位置を高解像度における位置に直す必要があるため、論理誤差が生じ得る。例えば動きベクトルを元のフレーム画像を1/8に縮小した低解像度画像を用いて計算する場合、理論上4ピクセルの誤差が発生する。本実施形態では、動きベクトルに基づく位置の予測と、運動特性に基づく位置の予測とを組み合わせているため、動きベクトルの算出に低解像度画像を用いて計算時間を短縮しつつも、オブジェクトの動きに基づく位置の予測精度を向上できる。

【0057】

図8に、本発明のオブジェクト追跡装置が実現可能であるハードウェアの構成例を示す。コンピュータ100は、CPU(Central Processing Unit)101、RAM(Radom Access Memory)102、ROM(Read Only Memory)103、ハードディスク装置104、キーボード105、マウス106、ディスプレイ107、及び外部インタフェース108を有する。コンピュータ100において、各要素は、バス109を介して相互に接続される。

【0058】

CPU101は、コンピュータ全体の動作を司る。RAM102は、CPUによる各種プログラムの実行時にワークエリアなどとして用いられる。ROM103は、各種制御プログラムなどを格納している。ハードディスク装置104は、補助記憶装置であり、例えばコンピュータ100をオブジェクト追跡装置10(図1)として機能させるために必要なプログラムなどを格納する。また、ハードディスク装置104は、処理対象の動画像データを格納していてもよい。

【0059】

キーボード105及びマウス106は、入力装置であり、ユーザが各種情報やコンピュータに対する指示などを入力するために用いられる。ディスプレイ107は、各種画像や情報を表示する。外部インタフェース108は、外部に接続された装置との間で情報のやり取りを行う。外部インタフェース108には、例えばカメラ110を接続することができる。カメラ110で撮影された動画像は、外部インタフェース108を介してコンピュータ100に入力される。

【0060】

ハードディスク装置104が格納するプログラムは、CPU101によって読み出され、RAM102上に展開される。CPU101が、読み出したプログラムに従って動作することで、コンピュータ100内に、図1に示す各手段が論理的に構成される。また、CPU101によって、図7に示す一連の処理が実行される。ディスプレイ107には、処理結果、例えば図7のステップS5で推定されたオブジェクトの位置などが表示される。

【0061】

以上、本発明をその好適な実施形態に基づいて説明したが、本発明のオブジェクト追跡装置、方法、及びプログラムは、上記実施形態にのみ限定されるものではなく、上記実施形態の構成から種々の修正及び変更を施したものも、本発明の範囲に含まれる。

【符号の説明】

【0062】

10:オブジェクト追跡装置

11:画像入力手段

12:オブジェクト検出手段

13:オブジェクト記憶部

14:位置予測手段

15:位置マップ生成手段

16:特徴量計算手段

17:位置推定手段

41:画像縮小手段

42:動きベクトル生成手段

43:動き位置予測手段

44:運動特性算出手段

45:運動位置予測手段

51:動き位置マップ生成手段

52:運動位置マップ生成手段

53:加算器

601、602:ROI

【技術分野】

【0001】

本発明は、オブジェクト追跡装置、方法、及びプログラムに関し、更に詳しくは、動画像を構成する複数のフレーム画像間でオブジェクトを追跡するオブジェクト追跡装置、方法、及びプログラムに関する。

【背景技術】

【0002】

従来、動画像を構成する複数のフレーム画像間でオブジェクトを追跡する技術として、いくつかの手法が知られている(例えば特許文献1、2)。特許文献1では、あるフレーム(時刻)におけるオブジェクトの位置情報に基づいて、線形予測を用いて次フレームにおけるオブジェクトの予測位置を算出し、その予測位置に基づいて、次フレームにおけるオブジェクトの探索範囲を設定する。その後、設定された探索範囲について、フレーム間の差分画像が所定の条件を満たすか否かを画素ごとに判断することでオブジェクト候補画像を生成し、そのオブジェクト候補画像の中から、抽出条件に基づいて追跡対象のオブジェクトを追跡する。

【0003】

特許文献2では、所定間隔おきのフレーム画像(静止画データ)中から人間の顔を探索し、あるフレーム画像において人間の顔が検出できたとき、そのフレーム画像の前後で顔を追跡する。顔の追跡では、検出済みのフレーム画像におけるオブジェクトの位置に基づいてオブジェクトの探索範囲を設定し、探索範囲内で顔の検出を行う。探索範囲は、例えば検出済みのフレーム画像が1つしかない場合には、そのフレーム画像におけるオブジェクトの位置と、オブジェクトの変動予測量とに基づいて設定する。複数のフレーム画像においてオブジェクトが検出済みの場合には、検出済みの複数のフレーム画像におけるオブジェクトの位置に基づいて対象フレームにおけるオブジェクトの位置を予測し、その予測位置と変動予測量とに基づいて探索範囲を設定する。

【先行技術文献】

【特許文献】

【0004】

【特許文献1】特開2006−195525号公報

【特許文献2】特開2005−99953号公報

【発明の概要】

【発明が解決しようとする課題】

【0005】

特許文献1及び2では、探索範囲内で画素値に基づいてオブジェクトらしさ(アピアランス特徴)を算出し、オブジェクトの検出を行っている。アピアランス特徴を用いたオブジェクトの検出は、通常の場合では有効であるものの、照明の変動やオブジェクトに重なりが生じたときにはアピアランス誤差が生じ、オブジェクトをうまく検出できないことがある。一方、オブジェクトの動きに基づく位置予測は、照明の変動やオブジェクトに重なりが生じたときでも、安定的に予測可能である。しかしながら、いったん位置誤差が生じると、オブジェクト追跡を追跡している間にその誤差が累積され、予測精度が低下する。

【0006】

本発明は、上記に鑑み、オブジェクトを追跡する際に、オブジェクトの位置推定の精度を向上させることができるオブジェクト追跡装置、方法、及びプログラムを提供することを目的とする。

【課題を解決するための手段】

【0007】

上記目的を達成するために、本発明は、動画像を構成する複数のフレーム画像に含まれるオブジェクトを複数のフレーム画像間で追跡するオブジェクト追跡装置において、2以上のフレーム画像間のオブジェクトの動きに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測する位置予測手段と、フレーム画像中の前記予測された位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、各位置と前記決定した値との対応関係を位置マップとして生成する位置マップ生成手段と、前記処理対象のフレーム画像に基づいて、前記位置予測手段が予測した位置の近傍の複数の位置のそれぞれでオブジェクトらしさを示す特徴量を計算し、各位置と前記特徴量との対応関係をアピアランスマップとして生成する特徴量計算手段と、前記位置マップと前記アピアランスマップとを組み合わせ、該組み合わせたマップに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を推定する位置推定手段とを備えたことを特徴とするオブジェクト追跡装置を提供する。

【0008】

ここで、オブジェクトの動きに基づく位置の予測には、例えば動きベクトルを用いた位置の予測や、オブジェクトの運動特性を利用した位置の予測などを用いることができる。オブジェクトの存在確率を表す値は、例えばオブジェクトの存在確率が高いほど大きな値となる。オブジェクトらしさを示す特徴量は、例えばオブジェクトらしさが高いほど大きな値となる。

【0009】

本発明では、前記位置予測手段が、相互に異なる2以上の手法で前記処理対象のフレーム画像におけるオブジェクトの位置を予測するものであり、前記位置マップ生成手段が、前記2以上の手法のそれぞれについて前記予測された位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、該2以上の手法のそれぞれについて決定した値を組み合わせ、各位置と前記組み合わせた値との対応関係を位置マップとして生成する構成を採用できる。

【0010】

上記の場合、前記位置マップ生成手段は、2以上の手法のそれぞれについて複数の位置に対して決定した値のうち、前記フレーム画像の同一の位置に対して決定した値を重み付け加算することで前記決定した値を組み合わせるものとすることができる。

【0011】

本発明では、前記位置予測手段が、前記フレーム画像を縮小する画像縮小手段と、前記処理対象のフレーム画像を縮小した画像と、前記処理対象のフレーム画像とは異なる時刻のフレーム画像を縮小した画像とに基づいて動きベクトルを計算する動きベクトル計算手段と、前記処理対象のフレーム画像とは異なる時刻のフレーム画像におけるオブジェクトの位置と、前記動きベクトルとに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を予測する動き位置予測手段とを含む構成を採用できる。

【0012】

本発明では、前記位置予測手段が、前記処理対象のフレーム画像とは異なる2以上の時刻のフレーム画像におけるオブジェクトの位置に基づいてオブジェクトの運動特性を測定する運動特性測定手段と、前記測定された運動特性と、前記処理対象のフレーム画像とは異なる2以上の時刻のうちの少なくとも一方のフレーム画像におけるオブジェクトの位置とに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を予測する運動位置予測手段とを更に含む構成を採用することもできる。

【0013】

前記位置推定手段は、フレーム画像の同一の位置に対応する位置マップの値とアピアランスマップの値とを乗算し、該乗算した値が最大となるフレーム画像の位置をオブジェクトの位置として推定してもよい。このとき、乗算は重み付けを伴っていてもよい。

【0014】

前記特徴量計算手段は、前記フレーム画像における、前記位置予測手段が予測した位置の近傍の複数の位置のそれぞれから所定範囲内の画素の画素値ヒストグラムを求め、該求めた画素値ヒストグラムと追跡対象のオブジェクトの画素値ヒストグラムとの類似度を前記特徴量として算出するものであってよい。

【0015】

前記特徴量計算手段は、前記所定範囲を複数のブロックに分割した分割ブロックごとに画素値ヒストグラムを求め、該求めた画素値ヒストグラムと前記追跡対象のオブジェクトの画素値ヒストグラムとを前記分割ブロックごとに算出し、該分割ブロックごとに求めた類似度を組み合わせたものを前記特徴量として算出してもよい。

【0016】

本発明のオブジェクト追跡装置は、前記フレーム画像からオブジェクトを検出するオブジェクト検出手段を更に備える構成でもよい。

【0017】

本発明は、また、動画像を構成する複数のフレーム画像に含まれるオブジェクトを複数のフレーム画像間で追跡するオブジェクト追跡方法において、2以上のフレーム画像間のオブジェクトの動きに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測するステップと、フレーム画像中の前記予測された位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、各位置と前記決定した値との対応関係を位置マップとして生成するステップと、前記処理対象のフレーム画像に基づいて、前記位置予測手段が予測した位置の近傍の複数の位置のそれぞれでオブジェクトらしさを示す特徴量を計算し、各位置と前記特徴量との対応関係をアピアランスマップとして生成するステップと、前記位置マップと前記アピアランスマップとを組み合わせ、該組み合わせたマップに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を推定するステップとを有することを特徴とするオブジェクト追跡方法を提供する。

【0018】

更に本発明は、コンピュータに、動画像を構成する複数のフレーム画像に含まれるオブジェクトを複数のフレーム画像間で追跡する処理を実行させるプログラムであって、前記コンピュータに、2以上のフレーム画像間のオブジェクトの動きに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測するステップと、フレーム画像中の前記予測された位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、各位置と前記決定した値との対応関係を位置マップとして生成するステップと、前記処理対象のフレーム画像に基づいて、前記位置予測手段が予測した位置の近傍の複数の位置のそれぞれでオブジェクトらしさを示す特徴量を計算し、各位置と前記特徴量との対応関係をアピアランスマップとして生成するステップと、前記位置マップと前記アピアランスマップとを組み合わせ、該組み合わせたマップに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を推定するステップとを実行させるためのプログラムを提供する。

【発明の効果】

【0019】

本発明オブジェクト追跡装置、方法、及びプログラムでは、オブジェクトの動きに基づいてオブジェクトの位置を予測し、その予測した位置の周辺に位置マップを生成する。また、予測された位置の周辺でオブジェクトらしさを示す特徴量を計算してアピアランスマップを生成し、双方のマップを組み合わせてオブジェクトの位置を推定する。本発明では、オブジェクトの動きに基づく位置予測と、特徴量に基づく位置予測とを組み合わせてオブジェクトの位置を推定しているため、何れか一方を単独で用いる場合に比して、位置推定の精度を向上できる。

【図面の簡単な説明】

【0020】

【図1】本発明の一実施形態のオブジェクト追跡装置を示すブロック図。

【図2】2つの手法でオブジェクトの位置を予測する位置予測手段の構成例を示すブロック図。

【図3】位置予測手段が2つの手法でオブジェクトの位置を予測する場合の位置マップ生成手段の構成例を示すブロック図。

【図4】(a)〜(c)は、動き位置マップ、運動位置マップ、及び両者を組み合わせた位置マップを例示する図。

【図5】特徴量計算手段が特徴量を計算する際の関心領域(ROI:Region Of Interest)を例示する図。

【図6】位置の補正を例示する図。

【図7】動作手順を示すフローチャート。

【図8】オブジェクト追跡装置が実現可能であるハードウェアの構成例を示すブロック図。

【発明を実施するための形態】

【0021】

以下、図面を参照し、本発明の実施の形態を詳細に説明する。図1は、本発明の一実施形態のオブジェクト追跡装置を示す。オブジェクト追跡装置10は、画像入力手段11、オブジェクト検出手段12、オブジェクト記憶部13、位置予測手段14、位置マップ生成手段15、特徴量計算手段16、及び位置推定手段17を備える。オブジェクト追跡装置10内の各部の機能はコンピュータが所定のプログラムに従って処理を実行することで実現可能である。

【0022】

画像入力手段11は、動画像を構成する複数のフレーム画像を順次に入力する。画像入力手段11は、例えば撮像装置からフレーム画像を順次に入力する。あるいは画像入力手段11は、撮像装置を用いて撮影された動画像を記憶装置(図示せず)から読み出してもよい。フレームレートは、例えば毎秒30フレームである。画像入力手段11は、入力されたフレーム画像をオブジェクト検出手段12、位置予測手段14、及び特徴量計算手段16に与える。

【0023】

オブジェクト検出手段12は、フレーム画像からオブジェクトを検出する。オブジェクト検出手段12は、例えばフレーム画像から人物の頭部や顔などのオブジェクトを検出する。オブジェクト検出手段12は、検出したオブジェクトの情報をオブジェクト記憶部13に記憶する。オブジェクト検出手段12は、例えば新たにオブジェクトを検出すると、そのオブジェクトにIDを割り当て、IDと、検出したオブジェクトの位置と、オブジェクトの特徴とをオブジェクト記憶部13に記憶する。なお、オブジェクト追跡装置10は、内部にオブジェクト検出手段12及びオブジェクト記憶部13を有している必要はなく、これらはオブジェクト追跡装置10の外部にあってもよい。

【0024】

位置予測手段14は、2以上のフレーム画像間のオブジェクトの動きに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測する。位置予測手段14は、予測したオブジェクトの位置を位置マップ生成手段15と特徴量計算手段16とに出力する。ここで、フレーム画像間のオブジェクトの動きに基づく位置の予測とは、ある時刻のフレーム画像から別の時刻のフレーム画像にかけて、オブジェクトが画像内をどのように動くかに基づいてオブジェクトの位置を予測することを指すものとする。オブジェクトの位置は、例えばオブジェクトを任意の形状の図形で囲んだときのその図形の中心位置や重心位置とすることができる。あるいはオブジェクトの任意の代表点、例えば人物における2つの目の中間地点の位置をオブジェクトの位置として定義してもよい。

【0025】

位置マップ生成手段15は、予測されたオブジェクトの位置を位置予測手段14から受け取る。位置マップ生成手段15は、フレーム画像中の予測された位置を含む複数の位置に対してオブジェクト存在確率(オブジェクトがその位置に存在する確からしさ)を表す値を決定する。位置マップ生成手段15は、各位置と、各位置に対して決定した値との対応関係を位置マップとして生成する。位置マップ生成手段15は、例えば予測されたオブジェクトの位置を中心とし、横方向及び縦方向にそれぞれ所定の距離だけ離れた位置までの各画素に対応した各位置に対してオブジェクトの存在確率を表わす値を決定し、位置マップを生成する。オブジェクト存在確率を表わす値は、例えば予測されたオブジェクトの位置が最大で、その位置から離れるに従って値が減少していくものとする。

【0026】

特徴量計算手段16は、位置予測手段14から予測されたオブジェクトの位置を受け取る。特徴量計算手段16は、処理対象のフレーム画像に基づいて、オブジェクトが存在する位置として予測された位置の近傍の複数の位置のそれぞれでオブジェクトらしさを示す特徴量を計算する。特徴量計算手段16は、各位置と、各位置に対して計算した特徴量との対応関係をアピアランスマップとして生成する。特徴量計算手段16は、例えば位置予測手段14で予測されたオブジェクトの位置を中心とし、横方向及び縦方向にそれぞれ所定の距離だけ離れた位置までの各画素に対応した位置に対して特徴量を計算する。特徴量計算手段16は、各位置と各位置に対して計算された特徴量との対応関係をアピアランスマップとして生成する。特徴量を計算する範囲(アピアランスマップを生成する範囲)は、位置マップが生成された範囲と同じでよい。

【0027】

位置推定手段17は、位置マップ生成手段15から位置マップを受け取り、特徴量計算手段16からアピアランスマップを受け取る。位置推定手段17は、位置マップとアピアランスマップとを組み合わせ、その組み合わせたマップに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を推定する。位置推定手段17は、例えばフレーム画像の同一の位置に対応する位置マップの値とアピアランスマップの値(特徴量)とを乗算し、乗算した値が最大となるフレーム画像の位置をオブジェクトの位置として推定する。位置推定手段17は、乗算に際して重み付けを行ってもよい。位置推定手段17は、推定したオブジェクトの位置をオブジェクト記憶部13に記憶する。位置予測手段14、位置マップ生成手段15、特徴量計算手段16、及び位置推定手段17が処理を繰り返し実行することで、複数のフレーム画像にわたってオブジェクトが追跡される。

【0028】

位置予測手段14は、互いに異なる2以上の手法で処理対象のフレーム画像におけるオブジェクトの位置を予測することができる。例えば位置予測手段14は、動きベクトルに基づいてオブジェクトの位置を予測すると共に、過去のオブジェクトの運動特性に基づいて最新のオブジェクトの位置を予測してもよい。その場合、位置予測手段14は、動きベクトルに基づくオブジェクトの予測位置と、運動特性に基づくオブジェクトの予測位置とを位置マップ生成手段15に出力することができる。

【0029】

位置マップ生成手段15は、位置予測手段14にて2以上の手法でオブジェクトの位置が予測された場合は、2以上の手法のそれぞれについて予測された位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、それら2以上の手法のそれぞれについて決定した値を組み合わせて位置マップを生成すればよい。位置マップ生成手段15は、例えば、2以上の手法のそれぞれについて複数の位置に対して決定した値のうち、フレーム画像の同一の位置に対して決定した値を重み付け加算し、各位置と重み付け加算された値との対応関係を位置マップとして生成してもよい。

【0030】

図2は、2つの手法でオブジェクトの位置を予測する位置予測手段の構成例を示す。位置予測手段14は、画像縮小手段41、動きベクトル生成手段42、動き位置予測手段43、運動特性算出手段44、及び運動位置予測手段45を有する。画像縮小手段41、動きベクトル生成手段42、及び動き位置予測手段43は、動きベクトルに基づく手法でオブジェクトの位置を予測する部分に相当する。運動特性算出手段44及び運動位置予測手段45は、運動特性に基づく手法でオブジェクトの位置を予測する部分に相当する。

【0031】

画像縮小手段41は、フレーム画像を縮小する。画像縮小手段41は、例えばフレーム画像を1/2、1/4、或いは1/8の解像度の画像に縮小(低解像度化)する。画像縮小の手法は特に問わない。例えば画像縮小手段41は、所定の割合で画素を間引くことで、フレーム画像を低解像度の画像に変換する。

【0032】

動きベクトル生成手段42は、処理対象画像のフレーム画像と、そのフレーム画像とは異なる時刻のフレーム画像とに基づいて動きベクトルを計算する。その際、動きベクトル生成手段42は、フレーム画像のそのものではなく、画像縮小手段41にて低解像度の画像に変換されたフレーム画像に基づいて動きベクトルを計算する。低解像度化した画像を用いて動きベクトルを生成することで、元のフレーム画像を用いる場合に比して、動きベクトル生成の処理に要する時間を短縮できる。

【0033】

動きベクトル生成手段42が動きベクトルの生成に際して参照する、処理対象のフレーム画像とは異なる時刻のフレーム画像は、例えば処理対象のフレーム画像の1時刻前のフレーム画像とすることができる。処理対象のフレーム画像の1時刻前のフレーム画像では、オブジェクトの位置が既知であるとする。つまり、処理対象のフレーム画像の1時刻前のフレーム画像におけるオブジェクトの位置は、オブジェクト記憶部13(図1)に記憶済みであるとする。

【0034】

動き位置予測手段43は、動きベクトルを動きベクトル生成手段42から受け取ると共に、オブジェクト記憶部13から、例えば処理対象のフレーム画像の1時刻前のフレーム画像におけるオブジェクトの位置を取得する。動き位置予測手段43は、1時刻前のフレーム画像におけるオブジェクトの位置を動きベクトルに従って移動した位置を、処理対象フレームにおけるオブジェクトの予測位置とする。その際、動き位置予測手段43は解像度変換を行い、低解像度化されたフレーム画像から生成された動きベクトルを用いて、元のフレーム画像の解像度でオブジェクトの位置を予測する。

【0035】

運動特性算出手段44は、処理対象のフレーム画像とは異なる2以上の時刻のフレーム画像におけるオブジェクトの位置に基づいて、オブジェクトの運動特性を測定する。運動特性算出手段44は、例えば処理対象のフレーム画像の時刻を時刻tとして、時刻t−2のフレーム画像と時刻t−1のフレーム画像とに基づいて、オブジェクトの運動特性を測定する。運動特性算出手段44は、例えばオブジェクトが時刻t−2から時刻t−1にかけて、フレーム画像内をどの方向にどれだけ移動したかを測定する。

【0036】

運動位置予測手段45は、測定された運動特性と、処理対象のフレーム画像とは異なる2以上の時刻のうちの少なくとも一方のフレーム画像におけるオブジェクトの位置とに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測する。例えば、運動位置予測手段45は、時刻t−2から時刻t−1までにおけるオブジェクトの運動特性と、時刻t−1でのオブジェクトの位置とに基づいて、時刻tでのオブジェクトの位置を予測する。例えば運動特性算出手段44にて、時刻t−2から時刻t−1にかけてオブジェクトがある方向にある距離だけ移動した旨の運動特性が測定されていた場合、運動位置予測手段45は、時刻t−1におけるオブジェクトの位置からある方向にある距離だけ移動した位置を、時刻tにおけるオブジェクトの位置として予測する。

【0037】

運動特性算出手段44は、例えば時刻t−2から時刻t−1にかけてのオブジェクトの変位(t−2,t−1)を、運動特性として求める。時刻t−2から時刻t−1までの時間と、時刻t−1から時刻tまでの時間とで、オブジェクトの運動に変化がないとすれば、時刻tにおけるオブジェクトの位置は、時刻t−1におけるオブジェクトの位置と、オブジェクトの変位(t−2,t−1)とから予測することが可能である。運動特性算出手段44は、時刻t−3以前の時刻までさかのぼって運動特性を測定してもよい。その場合、測定された運動特性の変化に基づいて、時刻t−1から時刻tにかけてのオブジェクトの運動特性を予測し、予測した運動特性と過去のオブジェクトの位置とから処理対象のフレーム画像におけるオブジェクトの位置を予測してもよい。

【0038】

図3は、位置予測手段14が2つの手法でオブジェクトの位置を予測する場合の位置マップ生成手段の構成例を示す。位置マップ生成手段15は、動き位置マップ生成手段51と、運動位置マップ生成手段52と、加算器53とを有する。動き位置マップ生成手段51は、動き位置予測手段43から動きベクトルに基づいて予測されたオブジェクトの位置を受け取る。動き位置マップ生成手段51は、動きベクトルに基づいて予測されたオブジェクトの位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、各位置と、各位置に対して決定した値との対応関係を動き位置マップとして生成する。

【0039】

運動位置マップ生成手段52は、運動位置予測手段45からオブジェクトの運動特性に基づいて予測されたオブジェクトの位置を受け取る。運動位置マップ生成手段52は、オブジェクトの運動特性に基づいて予測されたオブジェクトの位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、各位置と、各位置に対して決定した値との対応関係を動き位置マップとして生成する。加算器53は、動き位置マップと運動位置マップとを入力する。加算器53は、フレーム画像の同一の位置に対して、動き位置マップ生成手段51で決定された値と運動位置マップ生成手段52で決定された値とを重み付け加算する。

【0040】

図4(a)〜(c)は、動き位置マップ、運動位置マップ、及び両者を組み合わせた位置マップを示す。動き位置マップ生成手段51は、例えば動きベクトルに基づいて予測されたオブジェクトの位置を中心とする横9×縦5の領域範囲内の各位置に対して、オブジェクト存在確率を表す値を決定する(図4(a))。運動位置マップでは、中心に近いほど値が高く、周辺部になるほど値が低くなるようになっている。図4(a)に示される領域の範囲外の各位置については、値なし、或いは値0とする。

【0041】

運動位置マップ生成手段52も、同様に、例えばオブジェクトの運動特性に基づいて予測されたオブジェクトの位置を中心とする横9×縦5の領域範囲内の各位置に対して、オブジェクト存在確率を表す値を決定する(図4(b))。オブジェクトの運動特性に基づいて予測されたオブジェクトの位置は、動きベクトルに基づいて予測されたオブジェクトの位置に対して、紙面向って左側、及び上方向にそれぞれ1画素分ずつずれているものとする。図4(b)において点線で表わされる部分は、動き位置マップのみが生成されている部分に該当する。

【0042】

加算器53は、例えば運動位置マップに所定の重みwを乗じた上で、動き位置マップと運動位置マップとを加算する。例えば運動特性に基づく位置の予測の精度が動きベクトルに基づく位置予測の精度よりも高いことが期待できる場合には、重みwを1より大きな値に設定して重み付け加算する。具体的にw=3として、動き位置マップ(図4(a))と、w×運動位置マップ(図4(b))とを加算すると、図4(c)に示す位置マップが得られる。なお、図4(c)では双方の位置マップに値がある部分のみ加算される例を示しているが、何れか一方に値がある部分については他方を0として加算を行ってもよい。

【0043】

次いで、特徴量計算手段16について説明する。図5は、特徴量計算手段16が特徴量を計算する際の関心領域(ROI:Region Of Interest)を示す。ここではオブジェクトとして人物を考える。ROI601は、人物の頭部(顔)に対応したROIであり、ROI602は、人物の背中(体)に対応したROI602である。ROI601は、左右に2分割(ROI601a、601b)されている。また、ROI602も、左右に2分割(ROI602a、602b)されている。ROI601及び602は、オブジェクトの位置に対して所定の位置関係にある。

【0044】

特徴量計算手段16は、特徴量計算を行うべきフレーム画像中の位置に基づいて、処理対象のフレーム画像におけるROI601の領域を決定する。つまり、フレーム画像中のどの画素領域をROI601とするかを決定する。特徴量計算手段16は、処理対象のフレーム画像におけるROI601内の画素値のヒストグラムを求める。その際、特徴量計算手段16は、ROI601aとROI601bとで、別々に画素値ヒストグラムを求める。オブジェクト検出に際して、オブジェクト検出手段12は、検出したオブジェクトのROI601a、601bに相当する領域内の画素値ヒストグラムを求め、それをオブジェクトの特徴としてオブジェクト記憶部13に記憶している。特徴量計算手段16は、ROI601aとROI601bとについて、それぞれ処理対象のフレーム画像から求めた画素値ヒストグラムと、オブジェクト記憶部13に記憶済みの画素値ヒストグラムとの類似度を計算する。

【0045】

また、特徴量計算手段16は、特徴量計算を行うべきフレーム画像中の位置に基づいて、処理対象のフレーム画像におけるROI602の領域を決定する。特徴量計算手段16は、処理対象のフレーム画像におけるROI602内の画素値のヒストグラムを求める。その際、特徴量計算手段16は、ROI602aとROI602bとで、別々に画素値ヒストグラムを求める。オブジェクト検出に際して、オブジェクト検出手段12は、検出したオブジェクトのROI602a、602bに相当する領域内の画素値ヒストグラムを求め、それをオブジェクトの特徴としてオブジェクト記憶部13に記憶している。特徴量計算手段16は、ROI602aとROI602bとについて、それぞれ処理対象のフレーム画像から求めた画素値ヒストグラムと、オブジェクト記憶部13に記憶済みの画素値ヒストグラムとの類似度を計算する。

【0046】

ROIを2分割し、それぞれについてヒストグラムを求めることで、ROIに形状情報を持たせることができる。ROI601は、人物の頭部と背景とを区別するために使用される。つまり、人物の頭部がROI601内にある場合、その領域の画素値ヒストグラムは人物の頭部に特有の分布を示すため、背景と頭部とを区別することが可能となる。一方、ROI602は、人と人とを区別するために使用される。例えば2人の人物が追跡対象のオブジェクトとなっているとき、2人の人物が着ている服の色が異なれば、ROI602における画素値ヒストグラムは異なる分布となり、2人の人物の識別が可能となる。

【0047】

ここで、一般に、撮影装置などを用いて取得された画像は、3次元空間を2次元空間に投影した画像である。例えば廊下のような奥行きのある空間を、天井など高いことろから撮影した画像を考えると、人物であるオブジェクトは、カメラから遠い位置にいるほど小さなサイズで検出され、カメラから近い位置では大きなサイズで検出される。また、オブジェクトの位置がカメラから遠いときは、オブジェクトが撮影画像中の上の方の領域で検出され、オブジェクトの位置がカメラに近いときは、オブジェクトが撮影画像中の下の方の領域で検出される。従って、オブジェクトのサイズは、フレーム画像中の位置に依存して変化する。

【0048】

特徴量計算手段16は、フレーム画像中の位置に応じてROI601、602のサイズを変更し、ヒストグラム計算を行う。例えばフレーム画像中の上の方の位置に対しては、ROI601、602のサイズを大きく設定し、フレーム画像中の下の方の位置に対しては、ROI601、602のサイズを小さく設定する。オブジェクトの上下移動に対して、ROI601、602のサイズを適切に設定することで、オブジェクトらしさを適切に計算することができる。画像位置に応じたROIサイズの変更には、例えば特開2009−245207号公報に記載された技術を用いることができる。

【0049】

運動位置予測手段45が行う運動特性に基づく位置の予測においても、撮影される3次元空間とフレーム画像における2次元空間との関係に基づいて、位置の補正を行うことができる。図6は、位置の補正を示す。時刻t−2におけるオブジェクトの位置をP(t−1)とし、時刻t−1におけるオブジェクトの位置をP(t−1)とする。時刻t−2から時刻t−1までの間のオブジェクトの変位に基づいて単純に時刻tにおけるオブジェクトの位置を予測すると、同図中に点線で示す矢印の位置がオブジェクトの予測位置となる。しかしながら、移動速度が一定であるとした場合、オブジェクトがフレーム画像の上方に移動するほど、一定期間での縦方向の変位量は減少する。そこで、運動位置予測手段45は、同図中に示す、位置に応じた補正を行った後の位置を、オブジェクトの予測位置とする。

【0050】

また、位置マップ生成手段15が位置マップを生成する範囲は、撮影される3次元空間とフレーム画像における2次元空間との関係に基づいて決定することができる。例えばオブジェクトが3次元空間を一定の速度で任意の方向に移動したときに、フレーム画像におけるオブジェクトの縦方向の変位量が横方向の変位量よりも少なければ、位置マップにおける縦方向の位置の数は、横方向の位置の数よりも少なくすることができる。

【0051】

続いてオブジェクト追跡の動作手順を説明する。図7に、動作手順を示す。オブジェクトの追跡の前の段階で、オブジェクト検出手段12によりオブジェクトが既に検出されており、1時刻前のフレーム画像におけるオブジェクトの位置がオブジェクト記憶部13に記憶されているものとする。画像入力手段11は、処理対象のフレーム画像を入力する(ステップS1)。位置予測手段14は、2以上のフレーム画像間のオブジェクトの動きに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測する(ステップS2)。

【0052】

位置予測手段14は、ステップS2では、例えば処理対象のフレーム画像とその1時刻前のフレーム画像とに基づいて動きベクトルを計算し、動きベクトルと1時刻前のフレーム画像におけるオブジェクトの位置に基づいてオブジェクトの位置を予測する。これに代えて、又は加えて、位置予測手段14は、例えば処理対象のフレーム画像の2時刻前と1時刻前のフレーム画像に基づいてオブジェクトの運動特性を測定し、測定した運動特性と1時刻前のフレーム画像におけるオブジェクトの位置とに基づいてオブジェクトの位置を予測する。

【0053】

位置マップ生成手段15は、位置予測手段14で予測されたフレーム画像中の位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、各位置と決定した値との対応関係を位置マップとして生成する(ステップS3)。位置マップ生成手段15は、位置予測手段14にて例えば動きベクトルと運動特性とに基づいてそれぞれオブジェクトの位置が予測されているときは、それぞれに対してオブジェクト存在確率を表す値を決定し、決定した値を組み合わせることで位置マップを生成してもよい。

【0054】

特徴量計算手段16は、処理対象のフレーム画像に基づいて、位置予測手段14が予測した位置の近傍の複数の位置のそれぞれでオブジェクトらしさを示す特徴量を計算し、各位置と特徴量との対応関係をアピアランスマップとして生成する(ステップS4)。位置推定手段17は、位置マップとアピアランスマップとを組み合わせ、その組み合わせたマップに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を推定する(ステップS5)。位置推定手段17は、例えばフレーム画像の同一の位置に対応する位置マップの値とアピアランスマップの値とを組み合わせ、組み合わせた値が最大となるフレーム画像の位置をオブジェクトの位置として推定する。

【0055】

本実施形態では、オブジェクトの動きに基づいてオブジェクトの位置を予測し、その予測した位置の周辺に位置マップを生成する。また、予測された位置の周辺でオブジェクトらしさを示す特徴量を計算してアピアランスマップを生成し、双方のマップを組み合わせてオブジェクトの位置を推定する。アピアランス特徴を用いたオブジェクトの検出は、通常の場合では有効であるものの、照明の変動やオブジェクトに重なりが生じたときにはアピアランス誤差が生じ、オブジェクトをうまく検出できないことがある。一方、オブジェクトの動きに基づく位置予測は、照明の変動やオブジェクトに重なりが生じたときでも安定的に予測可能であるものの、いったん位置誤差が生じると、オブジェクト追跡を追跡している間にその誤差が累積され、予測精度が低下する。本実施形態では、オブジェクトの動きに基づく位置予測と、特徴量に基づく位置予測とを組み合わせてオブジェクトの位置を推定しているため、何れか一方を単独で用いる場合に比して、位置推定の精度を向上できる。

【0056】

また、本実施形態では、動きベクトルに基づく位置マップと、運動特性に基づく位置マップとを組み合わせて位置マップを生成している。動きベクトルの算出では、計算時間短縮のために低解像度画像が用いられる場合が多い。動きベクトルに基づく位置の予測では、低解像度で予測された位置を高解像度における位置に直す必要があるため、論理誤差が生じ得る。例えば動きベクトルを元のフレーム画像を1/8に縮小した低解像度画像を用いて計算する場合、理論上4ピクセルの誤差が発生する。本実施形態では、動きベクトルに基づく位置の予測と、運動特性に基づく位置の予測とを組み合わせているため、動きベクトルの算出に低解像度画像を用いて計算時間を短縮しつつも、オブジェクトの動きに基づく位置の予測精度を向上できる。

【0057】

図8に、本発明のオブジェクト追跡装置が実現可能であるハードウェアの構成例を示す。コンピュータ100は、CPU(Central Processing Unit)101、RAM(Radom Access Memory)102、ROM(Read Only Memory)103、ハードディスク装置104、キーボード105、マウス106、ディスプレイ107、及び外部インタフェース108を有する。コンピュータ100において、各要素は、バス109を介して相互に接続される。

【0058】

CPU101は、コンピュータ全体の動作を司る。RAM102は、CPUによる各種プログラムの実行時にワークエリアなどとして用いられる。ROM103は、各種制御プログラムなどを格納している。ハードディスク装置104は、補助記憶装置であり、例えばコンピュータ100をオブジェクト追跡装置10(図1)として機能させるために必要なプログラムなどを格納する。また、ハードディスク装置104は、処理対象の動画像データを格納していてもよい。

【0059】

キーボード105及びマウス106は、入力装置であり、ユーザが各種情報やコンピュータに対する指示などを入力するために用いられる。ディスプレイ107は、各種画像や情報を表示する。外部インタフェース108は、外部に接続された装置との間で情報のやり取りを行う。外部インタフェース108には、例えばカメラ110を接続することができる。カメラ110で撮影された動画像は、外部インタフェース108を介してコンピュータ100に入力される。

【0060】

ハードディスク装置104が格納するプログラムは、CPU101によって読み出され、RAM102上に展開される。CPU101が、読み出したプログラムに従って動作することで、コンピュータ100内に、図1に示す各手段が論理的に構成される。また、CPU101によって、図7に示す一連の処理が実行される。ディスプレイ107には、処理結果、例えば図7のステップS5で推定されたオブジェクトの位置などが表示される。

【0061】

以上、本発明をその好適な実施形態に基づいて説明したが、本発明のオブジェクト追跡装置、方法、及びプログラムは、上記実施形態にのみ限定されるものではなく、上記実施形態の構成から種々の修正及び変更を施したものも、本発明の範囲に含まれる。

【符号の説明】

【0062】

10:オブジェクト追跡装置

11:画像入力手段

12:オブジェクト検出手段

13:オブジェクト記憶部

14:位置予測手段

15:位置マップ生成手段

16:特徴量計算手段

17:位置推定手段

41:画像縮小手段

42:動きベクトル生成手段

43:動き位置予測手段

44:運動特性算出手段

45:運動位置予測手段

51:動き位置マップ生成手段

52:運動位置マップ生成手段

53:加算器

601、602:ROI

【特許請求の範囲】

【請求項1】

動画像を構成する複数のフレーム画像に含まれるオブジェクトを複数のフレーム画像間で追跡するオブジェクト追跡装置において、

2以上のフレーム画像間のオブジェクトの動きに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測する位置予測手段と、

フレーム画像中の前記予測された位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、各位置と前記決定した値との対応関係を位置マップとして生成する位置マップ生成手段と、

前記処理対象のフレーム画像に基づいて、前記位置予測手段が予測した位置の近傍の複数の位置のそれぞれでオブジェクトらしさを示す特徴量を計算し、各位置と前記特徴量との対応関係をアピアランスマップとして生成する特徴量計算手段と、

前記位置マップと前記アピアランスマップとを組み合わせ、該組み合わせたマップに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を推定する位置推定手段とを備えたことを特徴とするオブジェクト追跡装置。

【請求項2】

前記位置予測手段が、相互に異なる2以上の手法で前記処理対象のフレーム画像におけるオブジェクトの位置を予測するものであり、

前記位置マップ生成手段が、前記2以上の手法のそれぞれについて前記予測された位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、該2以上の手法のそれぞれについて決定した値を組み合わせ、各位置と前記組み合わせた値との対応関係を位置マップとして生成するものであることを特徴とする請求項1に記載のオブジェクト追跡装置。

【請求項3】

前記位置マップ生成手段が、2以上の手法のそれぞれについて複数の位置に対して決定した値のうち、前記フレーム画像の同一の位置に対して決定した値を重み付け加算することで前記決定した値を組み合わせるものであることを特徴とする請求項2に記載のオブジェクト追跡装置。

【請求項4】

前記位置予測手段が、

前記フレーム画像を縮小する画像縮小手段と、

前記処理対象のフレーム画像を縮小した画像と、前記処理対象のフレーム画像とは異なる時刻のフレーム画像を縮小した画像とに基づいて動きベクトルを計算する動きベクトル計算手段と、

前記処理対象のフレーム画像とは異なる時刻のフレーム画像におけるオブジェクトの位置と、前記動きベクトルとに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を予測する動き位置予測手段とを含むものであることを特徴とする請求項2又は3に記載のオブジェクト追跡装置。

【請求項5】

前記位置予測手段が、

前記処理対象のフレーム画像とは異なる2以上の時刻のフレーム画像におけるオブジェクトの位置に基づいてオブジェクトの運動特性を測定する運動特性測定手段と、

前記測定された運動特性と、前記処理対象のフレーム画像とは異なる2以上の時刻のうちの少なくとも一方のフレーム画像におけるオブジェクトの位置とに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を予測する運動位置予測手段とを更に含むものであることを特徴とする請求項4に記載のオブジェクト追跡装置。

【請求項6】

前記位置推定手段が、フレーム画像の同一の位置に対応する位置マップの値とアピアランスマップの値とを乗算し、該乗算した値が最大となるフレーム画像の位置をオブジェクトの位置として推定するものであることを特徴とする請求項1から5何れかに記載のオブジェクト追跡装置。

【請求項7】

前記特徴量計算手段が、前記フレーム画像における、前記位置予測手段が予測した位置の近傍の複数の位置のそれぞれから所定範囲内の画素の画素値ヒストグラムを求め、該求めた画素値ヒストグラムと追跡対象のオブジェクトの画素値ヒストグラムとの類似度を前記特徴量として算出するものであることを特徴とする、請求項1から6何れかに記載のオブジェクト追跡装置。

【請求項8】

前記特徴量計算手段が、前記所定範囲を複数のブロックに分割した分割ブロックごとに画素値ヒストグラムを求め、該求めた画素値ヒストグラムと前記追跡対象のオブジェクトの画素値ヒストグラムとを前記分割ブロックごとに算出し、該分割ブロックごとに求めた類似度を組み合わせたものを前記特徴量として算出するものであることを特徴とする請求項7に記載のオブジェクト追跡装置。

【請求項9】

前記フレーム画像からオブジェクトを検出するオブジェクト検出手段を更に備えることを特徴とする請求項1から8何れかに記載のオブジェクト追跡装置。

【請求項10】

動画像を構成する複数のフレーム画像に含まれるオブジェクトを複数のフレーム画像間で追跡するオブジェクト追跡方法において、

2以上のフレーム画像間のオブジェクトの動きに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測するステップと、

フレーム画像中の前記予測された位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、各位置と前記決定した値との対応関係を位置マップとして生成するステップと、

前記処理対象のフレーム画像に基づいて、前記位置予測手段が予測した位置の近傍の複数の位置のそれぞれでオブジェクトらしさを示す特徴量を計算し、各位置と前記特徴量との対応関係をアピアランスマップとして生成するステップと、

前記位置マップと前記アピアランスマップとを組み合わせ、該組み合わせたマップに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を推定するステップとを有することを特徴とするオブジェクト追跡方法。

【請求項11】

コンピュータに、動画像を構成する複数のフレーム画像に含まれるオブジェクトを複数のフレーム画像間で追跡する処理を実行させるプログラムであって、前記コンピュータに、

2以上のフレーム画像間のオブジェクトの動きに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測するステップと、

フレーム画像中の前記予測された位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、各位置と前記決定した値との対応関係を位置マップとして生成するステップと、

前記処理対象のフレーム画像に基づいて、前記位置予測手段が予測した位置の近傍の複数の位置のそれぞれでオブジェクトらしさを示す特徴量を計算し、各位置と前記特徴量との対応関係をアピアランスマップとして生成するステップと、

前記位置マップと前記アピアランスマップとを組み合わせ、該組み合わせたマップに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を推定するステップとを実行させるためのプログラム。

【請求項1】

動画像を構成する複数のフレーム画像に含まれるオブジェクトを複数のフレーム画像間で追跡するオブジェクト追跡装置において、

2以上のフレーム画像間のオブジェクトの動きに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測する位置予測手段と、

フレーム画像中の前記予測された位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、各位置と前記決定した値との対応関係を位置マップとして生成する位置マップ生成手段と、

前記処理対象のフレーム画像に基づいて、前記位置予測手段が予測した位置の近傍の複数の位置のそれぞれでオブジェクトらしさを示す特徴量を計算し、各位置と前記特徴量との対応関係をアピアランスマップとして生成する特徴量計算手段と、

前記位置マップと前記アピアランスマップとを組み合わせ、該組み合わせたマップに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を推定する位置推定手段とを備えたことを特徴とするオブジェクト追跡装置。

【請求項2】

前記位置予測手段が、相互に異なる2以上の手法で前記処理対象のフレーム画像におけるオブジェクトの位置を予測するものであり、

前記位置マップ生成手段が、前記2以上の手法のそれぞれについて前記予測された位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、該2以上の手法のそれぞれについて決定した値を組み合わせ、各位置と前記組み合わせた値との対応関係を位置マップとして生成するものであることを特徴とする請求項1に記載のオブジェクト追跡装置。

【請求項3】

前記位置マップ生成手段が、2以上の手法のそれぞれについて複数の位置に対して決定した値のうち、前記フレーム画像の同一の位置に対して決定した値を重み付け加算することで前記決定した値を組み合わせるものであることを特徴とする請求項2に記載のオブジェクト追跡装置。

【請求項4】

前記位置予測手段が、

前記フレーム画像を縮小する画像縮小手段と、

前記処理対象のフレーム画像を縮小した画像と、前記処理対象のフレーム画像とは異なる時刻のフレーム画像を縮小した画像とに基づいて動きベクトルを計算する動きベクトル計算手段と、

前記処理対象のフレーム画像とは異なる時刻のフレーム画像におけるオブジェクトの位置と、前記動きベクトルとに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を予測する動き位置予測手段とを含むものであることを特徴とする請求項2又は3に記載のオブジェクト追跡装置。

【請求項5】

前記位置予測手段が、

前記処理対象のフレーム画像とは異なる2以上の時刻のフレーム画像におけるオブジェクトの位置に基づいてオブジェクトの運動特性を測定する運動特性測定手段と、

前記測定された運動特性と、前記処理対象のフレーム画像とは異なる2以上の時刻のうちの少なくとも一方のフレーム画像におけるオブジェクトの位置とに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を予測する運動位置予測手段とを更に含むものであることを特徴とする請求項4に記載のオブジェクト追跡装置。

【請求項6】

前記位置推定手段が、フレーム画像の同一の位置に対応する位置マップの値とアピアランスマップの値とを乗算し、該乗算した値が最大となるフレーム画像の位置をオブジェクトの位置として推定するものであることを特徴とする請求項1から5何れかに記載のオブジェクト追跡装置。

【請求項7】

前記特徴量計算手段が、前記フレーム画像における、前記位置予測手段が予測した位置の近傍の複数の位置のそれぞれから所定範囲内の画素の画素値ヒストグラムを求め、該求めた画素値ヒストグラムと追跡対象のオブジェクトの画素値ヒストグラムとの類似度を前記特徴量として算出するものであることを特徴とする、請求項1から6何れかに記載のオブジェクト追跡装置。

【請求項8】

前記特徴量計算手段が、前記所定範囲を複数のブロックに分割した分割ブロックごとに画素値ヒストグラムを求め、該求めた画素値ヒストグラムと前記追跡対象のオブジェクトの画素値ヒストグラムとを前記分割ブロックごとに算出し、該分割ブロックごとに求めた類似度を組み合わせたものを前記特徴量として算出するものであることを特徴とする請求項7に記載のオブジェクト追跡装置。

【請求項9】

前記フレーム画像からオブジェクトを検出するオブジェクト検出手段を更に備えることを特徴とする請求項1から8何れかに記載のオブジェクト追跡装置。

【請求項10】

動画像を構成する複数のフレーム画像に含まれるオブジェクトを複数のフレーム画像間で追跡するオブジェクト追跡方法において、

2以上のフレーム画像間のオブジェクトの動きに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測するステップと、

フレーム画像中の前記予測された位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、各位置と前記決定した値との対応関係を位置マップとして生成するステップと、

前記処理対象のフレーム画像に基づいて、前記位置予測手段が予測した位置の近傍の複数の位置のそれぞれでオブジェクトらしさを示す特徴量を計算し、各位置と前記特徴量との対応関係をアピアランスマップとして生成するステップと、

前記位置マップと前記アピアランスマップとを組み合わせ、該組み合わせたマップに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を推定するステップとを有することを特徴とするオブジェクト追跡方法。

【請求項11】

コンピュータに、動画像を構成する複数のフレーム画像に含まれるオブジェクトを複数のフレーム画像間で追跡する処理を実行させるプログラムであって、前記コンピュータに、

2以上のフレーム画像間のオブジェクトの動きに基づいて、処理対象のフレーム画像におけるオブジェクトの位置を予測するステップと、

フレーム画像中の前記予測された位置を含む複数の位置に対してオブジェクト存在確率を表す値を決定し、各位置と前記決定した値との対応関係を位置マップとして生成するステップと、

前記処理対象のフレーム画像に基づいて、前記位置予測手段が予測した位置の近傍の複数の位置のそれぞれでオブジェクトらしさを示す特徴量を計算し、各位置と前記特徴量との対応関係をアピアランスマップとして生成するステップと、

前記位置マップと前記アピアランスマップとを組み合わせ、該組み合わせたマップに基づいて、前記処理対象のフレーム画像におけるオブジェクトの位置を推定するステップとを実行させるためのプログラム。

【図1】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【公開番号】特開2012−181710(P2012−181710A)

【公開日】平成24年9月20日(2012.9.20)

【国際特許分類】

【出願番号】特願2011−44610(P2011−44610)

【出願日】平成23年3月2日(2011.3.2)

【出願人】(306037311)富士フイルム株式会社 (25,513)

【Fターム(参考)】

【公開日】平成24年9月20日(2012.9.20)

【国際特許分類】

【出願日】平成23年3月2日(2011.3.2)

【出願人】(306037311)富士フイルム株式会社 (25,513)

【Fターム(参考)】

[ Back to top ]