サウンドを利用したソーシャルネットワークサービス提供装置及びその方法

【課題】サウンドを利用した、ソーシャルネットワークサービス提供装置、及び、その方法を、開示する。

【解決手段】ソーシャルネットワークサービス提供装置は、ユーザ端末から、サウンドを受信するサウンド受信部と、前記受信されたサウンドから、特徴値を抽出する特徴値抽出部と、前記抽出された特徴値同士がマッチしたサウンドを送信したユーザ同士を、グループ化して、グループ情報を生成するグループ情報生成部とを、備える。

【解決手段】ソーシャルネットワークサービス提供装置は、ユーザ端末から、サウンドを受信するサウンド受信部と、前記受信されたサウンドから、特徴値を抽出する特徴値抽出部と、前記抽出された特徴値同士がマッチしたサウンドを送信したユーザ同士を、グループ化して、グループ情報を生成するグループ情報生成部とを、備える。

【発明の詳細な説明】

【技術分野】

【0001】

本発明は、ユーザが入力するサウンドを用いて前記ユーザにソーシャルネットワークサービス(SNS:Social Network Service)を提供する、サウンドを利用したソーシャルネットワークサービス提供装置及びその方法に関する。

【背景技術】

【0002】

現在、ネットワークを介して、ソーシャルネットワークサービス提供者からツイッター(twitter)、フェイスブック(facebook)、ミートゥデイ(me2day)等のような多様なソーシャルネットワークサービスが、提供される。

【0003】

ソーシャルネットワークサービスは、インターネット上で、友人、先後輩、同僚などの知人との人脈関係を強化して新しい人脈を築いて幅広い人的ネットワークを形成できるようにするサービスである。このようなソーシャルネットワークサービスを提供する方法として、大韓民国公開特許第10−2011−0016349「ソーシャルネットワークサービスの提供方法及び装置」がある。

【0004】

しかし、今日、個人の表現の欲求が高まるにつれて、このようなソーシャルネットワークサービスの提供方法では、他の人達とより多彩な情報の共有を求めているユーザを満足させることは、困難である。

【0005】

例えば、特定の映画を鑑賞したユーザが映画に対する感想を共有しようとする場合などが挙げられる。この場合、従来のソーシャルネットワークサービスの利用者は、映画に対する自分の感想を、仮想掲示板等を介して他の人と共有したり、映画について対話が行われているチャットルームなどに入場して、他の人々と感想を共有してきた。しかし、仮想掲示板を介して他の人と感想を共有する場合、一般的に、仮想掲示板を見る人は映画に特別な関心を持っていない場合が多いため、ユーザは、自分が掲示した感想に対する他の人の反応から満足感を十分に得られなかった。

【0006】

一方、ユーザが映画に対するチャットルームに入場して感想を他の人と共有しようとする場合、当該ユーザは、まず映画に対するチャットルームを検索しなければならないという不便を受忍しなければならないだけでなく、チャットルームを検索するために適したキーワードを選ぶという困難を受忍しなければならなかった。一例として、従来のソーシャルネットワークサービスでは、ユーザが特定の時間または特定の場所で公演された演劇に対する感想を他の人と共有しようとしている場合に、当該ユーザに対して当該特定の時間または特定の場所で公演された演劇を見たユーザを推薦することが難しかった。

【0007】

したがって、ユーザに対してより満足感を提供することができ、ユーザがより容易にソーシャルネットワークサービスを利用できる方法が求められている。

【発明の概要】

【発明が解決しようとする課題】

【0008】

本発明の課題は、サウンドを用いてソーシャルネットワークサービスを提供することによって、ユーザがより容易に他のユーザと情報を共有できるソーシャルネットワークサービス提供装置及びその方法を提供することである。

【0009】

また、本発明の課題は、ユーザが特定のイベントを他のユーザと共有できるだけでなく、ユーザが特定の時間に同じサウンドを聞いている他のユーザまたは特定の場所にいる他のユーザと情報を共有できるソーシャルネットワークサービス提供装置及びその方法を提供することである。

【課題を解決するための手段】

【0010】

本発明の一態様によるソーシャルネットワークサービス提供装置は、ユーザ端末からサウンドを受信するサウンド受信部と、前記受信されるサウンドから特徴値を抽出する特徴値抽出部と、前記抽出された特徴値にマッチする特徴値を有するサウンドを送信するユーザ同士をグループ化してグループ情報を生成するグループ情報生成部とを、備える。

【0011】

また、前記特徴値抽出部によって抽出された特徴値をデータベースに格納されたサウンドの特徴値と比較してマッチする特徴値を有するサウンドのメタ情報を検索するメタ情報検索部をさらに備え、前記グループ情報生成部は、前記検索されたメタ情報にマッチングされるメタ情報を有するサウンドを送信するユーザ同士をグループ化して前記グループ情報を生成してもよい。

【0012】

また、前記抽出された特徴値にマッチングされる前記メタ情報が検索されない場合、前記ユーザ端末から前記受信されたサウンドに対するメタ情報を登録するメタ情報登録部をさらに備えてもよい。

【0013】

また、前記グループ情報生成部は、前記サウンドが入力される時間に基づいて、各サウンドを送信したユーザ同士をグループ化して、前記グループ情報を生成したり、前記ユーザ端末の位置情報に基づいて 各サウンドを送信したユーザ同士をグループ化して、前記グループ情報を生成してもよい。

【0014】

また、本発明の他の態様によるソーシャルネットワークサービス提供装置は、サウンドが入力されるサウンド入力部と、前記入力されるサウンドをソーシャルネットワークサービス提供サーバに送信するサウンド送信部と、前記送信されたサウンドから抽出された特徴値にマッチする特徴値を有するサウンドを前記ソーシャルネットワークサービス提供サーバに送信したユーザ同士をグループ化することによって生成されたグループ情報を前記ソーシャルネットワークサービス提供サーバから受信して表示するグループ情報表示部とを備えてもよい。

【0015】

また、本発明の他の態様によるソーシャルネットワークサービスを提供する方法は、ユーザ端末からサウンドを受信するステップと、前記受信されるサウンドから特徴値を抽出するステップと、前記抽出された特徴値にマッチする特徴値を有するサウンドを送信するユーザをグループ化してグループ情報を生成するステップと、前記生成されたグループ情報を前記ユーザ端末に送信するステップとを含んでもよい。

【発明の効果】

【0016】

本発明によれば、ユーザ端末から入力されるサウンドから特徴値を抽出して、前記抽出された特徴値にマッチングされるサウンドを送信するユーザをグループ化することによって、ユーザが、より容易に他のユーザと情報を共有することができる。

【0017】

また、サウンドが入力される時間または場所に基づいてユーザをグループ化することによって、ユーザ間で特定イベントを共有できるだけでなく、特定の時間に同じサウンドを聞いているユーザ間または特定の場所にいるユーザ間で情報を共有することができる。

【図面の簡単な説明】

【0018】

【図1】本発明の一実施形態において、サウンドを利用したソーシャルネットワークサービス提供システムを示す概念図である。

【図2】本発明の一実施形態において、サウンドを利用したソーシャルネットワークサービス提供装置を説明するためのブロック図である。

【図3】本発明の一実施形態において、サウンドを用いてユーザにソーシャルネットワークサービスを提供する一例を示す例示図である。

【図4】本発明の一実施形態において、サウンドを用いてユーザにソーシャルネットワークサービスを提供する一例を示す例示図である。

【図5】本発明の一実施形態において、ソーシャルネットワークサービスを提供する方法を示すフローチャートである。

【図6】本発明の他の実施形態において、ソーシャルネットワークサービスを提供する方法を示すフローチャートである。

【発明を実施するための形態】

【0019】

以下、本発明の実施形態を添付する図面を参照しながら詳細に説明する。

【0020】

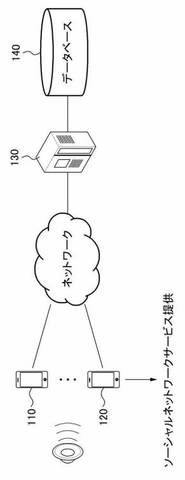

図1は、本発明の一実施形態による、サウンドを利用したソーシャルネットワークサービス提供システムを示す概念図である。図1を参照すれば、ソーシャルネットワークサービス提供システムは、複数のユーザ端末110,120、ソーシャルネットワークサービス提供サーバ130、及びデータベース140を、備えている。

【0021】

それぞれのユーザ端末110,120は、ネットワークを介して、ユーザが入力するサウンドを、ソーシャルネットワークサービス提供サーバ130へ送信する。ユーザ端末110,120は、ユーザがソーシャルネットワークサービス提供サーバからソーシャルネットワークサービスなどのような多様なサービスの提供を受ける装置であり、スマートフォンなどの携帯端末やデスクトップコンピュータなどのように、ネットワークの機能を備えて、サウンドを入力できる装置として実現されてもよい。

【0022】

ソーシャルネットワークサービス提供サーバ130は、ユーザが送信したサウンドに基づいて、当該ユーザと、当該サウンドにマッチングされるサウンドを送信した他のユーザをグループ化して、グループ情報を生成し、このグループ情報を、再びネットワークを介してユーザ端末110,120へ送信する。

【0023】

ここで、一実施形態として、ソーシャルネットワークサービス提供サーバ130は、各ユーザ端末から送信されるそれぞれのサウンドから特徴値を抽出して、これを比較して、相互にマッチングされるサウンドを入力した複数のユーザ同士を一つのグループにグループ化することによって、グループ情報を生成してもよい。

【0024】

一方、他の実施形態として、ソーシャルネットワークサービス提供サーバ130は、各ユーザ端末から送信されるそれぞれのサウンドから特徴値を抽出して、これをデータベース140に格納されたサウンドの特徴値と比較して、前者にマッチする特徴値を有するサウンドのメタ情報を検索し、検索されたメタ情報に基づいて、グループ情報を生成してもよい。

【0025】

図2は、本発明の一実施形態において、サウンドを利用したソーシャルネットワークサービス提供装置を説明するためのブロック図である。以下、図2を参照して本発明に係るソーシャルネットワークサービス提供装置をより詳細に説明する。

【0026】

ユーザ端末110は、サウンド入力部210、サウンド送信部220、及びグループ情報表示部230を、備えてもよい。

【0027】

サウンド入力部210には、ユーザがソーシャルネットワークサービス提供サーバ130に送信しようとするサウンドが、入力される。これのために、サウンド入力部210は、マイクなどのようなサウンド入力装置によって実現され、ユーザ端末110の一側面に備えられてもよい。

【0028】

サウンド送信部220は、サウンド入力部210を介して入力されるサウンドを、無線通信網、移動通信網などのネットワークを介して、ソーシャルネットワークサービス提供サーバ130へ送信する。

【0029】

グループ情報表示部230は、ソーシャルネットワークサービス提供サーバ130から、ネットワークを介してグループ情報を受信して、これを表示する。ソーシャルネットワークサービス提供サーバ130は、ユーザ端末110から送信されるサウンドから特徴値を抽出し、当該特徴値にマッチする特徴値を有するサウンドを当該ソーシャルネットワークサービス提供サーバ130へ送信したユーザを前記ユーザ端末110を操作しているユーザとグループ化することによって、グループ情報を生成してもよい。また、データベース140に格納された複数のサウンドのうち、当該特徴値にマッチする特徴値を有するサウンドのメタ情報を検索し、検索されたメタ情報に該当するサウンドを送信した他のユーザを前記ユーザ端末110を操作しているユーザとグループ化することによって、グループ情報を生成してもよい。

【0030】

グループ情報表示部230は、一例として、ユーザ端末110にアプリケーションの形態でインストールされ、ソーシャルネットワークサービス提供サーバ130から受信したグループ情報を所定の形態で表示することによって、ユーザにソーシャルネットワークサービスを提供してもよい。

【0031】

一方、本発明の一実施形態に係るソーシャルネットワークサービス提供サーバ130は、サウンド受信部240、特徴値抽出部250、及びグループ情報生成部260を、備えてもよい。

【0032】

サウンド受信部240は、ユーザ端末110からネットワークを介して送信されたサウンドを、受信する。

【0033】

特徴値抽出部250は、サウンド受信部240で受信されるサウンドから、特徴値(fingerprint)を抽出する。

【0034】

グループ情報生成部260は、特徴値抽出部250で抽出された特徴値にマッチする特徴値を有するサウンドを送信した他のユーザを前記ユーザ端末110を操作しているユーザとグループ化して、グループ情報を生成する。ここで、グループ情報生成部260は、サウンドが入力される時間に基づいてユーザをグループ化してグループ情報を生成してもよく、ユーザ端末110の位置情報に基づいてユーザをグループ化してグループ情報を生成してもよい。

【0035】

例えば、グループ情報生成部260が、サウンドが入力される時間に基づいてグループ情報を生成する場合、グループ情報生成部260は、所定の時間の間にサウンド受信部240で受信される各サウンドから抽出された特徴値同士を比較して、相互にマッチした特徴値を含むサウンドを送信したユーザ同士をグループ化して、グループ情報を生成してもよい。この場合、ソーシャルネットワークサービス提供サーバ130は、特定の時間内にサウンドを送信するユーザをグループ化できるため、ユーザが特定の時間に公演中の特定の演劇を鑑賞している間に、当該演劇を鑑賞している他のユーザと当該演劇に対する感想を共有しようとする場合にも、当該演劇のサウンドを入力することによって、容易に、他のユーザと、当該演劇に対する感想を共有することができる。

【0036】

また、グループ情報生成部260がユーザ端末110の位置情報に基づいてグループ情報を生成する場合、ソーシャルネットワークサービス提供サーバ130は、サウンド受信部240によってサウンドが受信されるときに、該当ユーザ端末110の位置情報をGPS(Global Positioning System)等を用いて検出し、位置情報と特徴値が一致するサウンドを送信したユーザをグループ化して、グループ情報を生成してもよい。この場合、ソーシャルネットワークサービス提供サーバ130は、特定位置でサウンドを送信するユーザをグループ化できるため、ユーザが特定映画の鑑賞中に当該映画に対する感想を他のユーザと共有しようとする場合にも、同じ映画館で当該映画を鑑賞する他のユーザと感想を共有することができる。

【0037】

一方、他の実施形態として、ソーシャルネットワークサービス提供サーバ130は、サウンド受信部240、特徴値抽出部250、及びグループ情報生成部260の他に、メタ情報検索部270、及びメタ情報登録部280を、さらに備えてもよい。

【0038】

この場合、メタ情報検索部270は、特徴値抽出部250で抽出された特徴値をデータベース140に格納されたサウンドの特徴値と比較してマッチングされるメタ情報を検索する。ここで、メタ情報は、サウンドに関する情報を含む情報であり、例えば、サウンドが映画に対するサウンドである場合、映画の題名、映画を上映する劇場に関する情報などをも含んでもよい。

【0039】

メタ情報検索部270において、抽出された特徴値にマッチングされるメタ情報が検索されない場合、メタ情報登録部280は、ユーザ端末110にサウンドに対するメタ情報登録要請を送信し、受信されるサウンドに対するメタ情報の登録を受けて、データベース140に格納してもよい。したがって、データベース140に登録されていなかったサウンドをユーザが入力しても、当該サウンドに対するメタ情報を登録することによって、他のユーザが当該サウンドのメタ情報にマッチングされるメタ情報を有するサウンドを送信する際に、ユーザが他のユーザと情報を共有できるようにしてもよい。

【0040】

グループ情報生成部260は、メタ情報検索部270で検索されたメタ情報にマッチングされるメタ情報を有するサウンドを送信したユーザを前記ユーザ端末110を操作しているユーザとグループ化して、グループ情報を生成する。ここでも、グループ情報生成部260は、サウンドが入力される時間に基づいてユーザをグループ化してグループ情報を生成したり、ユーザ端末の位置情報に基づいてユーザをグループ化してグループ情報を生成することによって、特定の時間に同じサウンドを聞いているユーザまたは特定の場所にいるユーザ同士で情報を共有できるようにしてもよい。

【0041】

例えば、第1ユーザが特定映画の上映時間のうち10分から12分に該当するサウンドをソーシャルネットワークサービス提供サーバ130に送信して、第2ユーザが映画の11分から13分に該当するサウンドをソーシャルネットワークサービス提供サーバ130に送信する場合、ソーシャルネットワークサービス提供サーバ130は、映画の11分から12分に該当するサウンドの特徴値を用いて第1ユーザと第2ユーザをグループ化できる。しかしながら、第1ユーザが特定映画の上映時間のうち10分から11分に該当するサウンドをソーシャルネットワークサービス提供サーバ130に送信して、第2ユーザが映画の12分から13分に該当するサウンドをソーシャルネットワークサービス提供サーバ130に送信する場合、第1ユーザが送信したサウンドから抽出される特徴値と第2ユーザが送信したサウンドから抽出される特徴値とがマッチしない可能性がある。この場合、メタ情報検索部270は、データベース140に格納されたサウンドと第1ユーザが送信したサウンドの特徴値とを比較してマッチングされるメタ情報を検索することによって、第1ユーザが送信したサウンドがどんな映画のサウンドに該当するかを検出してもよい。したがって、グループ情報生成部270は、ユーザが送信したサウンドの特徴値と他のユーザが送信したサウンドの特徴値とが相互にマッチングされなくても、当該ユーザを、当該ユーザが送信したサウンドのメタ情報とマッチングされるメタ情報を有するサウンドを送信した他のユーザとグループ化して、グループ情報を生成することができる。

【0042】

図3及び図4は、本発明の一実施形態において、サウンドを用いてユーザにソーシャルネットワークサービスを提供する一例を示す例示図である。

【0043】

ユーザがOXコンサートに行って現在OXコンサートに来た人々と感想を共有しようとする場合、ユーザは、図3に示すように、ユーザ端末110を用いてソーシャルネットワークサービス提供サーバ130にサウンドを送信してもよい。この場合、ソーシャルネットワークサービス提供サーバ130は、ユーザ端末110からサウンドを受信して、当該サウンドから特徴値を抽出する。そして、抽出された特徴値にその特徴量がマッチングされるサウンドを送信した他のユーザを、前記ユーザ端末110を操作しているユーザとグループ化して、グループ情報を生成する。ここで、ソーシャルネットワークサービス提供サーバ130は、サウンドが入力される時間やユーザ端末の位置情報などに基づいてユーザをグループ化して、グループ情報を生成することによって、図4に示すように、或るユーザが当該グループ情報を用いて現在OXコンサートに来た他の人々と感想を共有できるようにしてもよい。一方、ソーシャルネットワークサービス提供サーバ130は、サウンドから抽出された特徴値をデータベースに格納されたサウンドの特徴値と比較してマッチングされるメタ情報を検索し、メタ情報にマッチングされるメタ情報が検索されるユーザをグループ化することによってグループ情報を生成してもよい。この場合、ソーシャルネットワークサービス提供サーバ130は、メタ情報に基づいてユーザをグループ化するため、現在OXコンサートにあるユーザとだけではなく、OXコンサートを開く歌手のファン達や、OXコンサートの入場券を購入しようとする人々とも、対話をしたり情報を共有できるようにしてもよい。したがって、ユーザは、より容易に、自分と共通する関心分野を有する人々と情報を共有することができ、より緊密な共感を形成することができる。

【0044】

図5は、本発明の一実施形態において、ソーシャルネットワークサービスを提供する方法を示すフローチャートである。

【0045】

本発明の一実施形態に係るソーシャルネットワークサービス提供サーバ130は、複数のユーザ端末110からネットワークを介してサウンドを受信し(S510)、サウンドから特徴値を抽出する(S520)。そして、抽出された特徴値同士がマッチングされるサウンドを送信したユーザ同士をグループ化して、グループ情報を生成し(S530)、このグループ情報をユーザ端末に送信する。ここで、グループ情報は、サウンドが入力される時間、及び/またはユーザ端末の位置情報に基づいて、生成されてもよい。したがって、本発明に係るソーシャルネットワークサービス提供装置は、特定の時間及び/または特定の場所でサウンドを送信するユーザ同士をグループ化できるため、ユーザがサウンドを用いて、より容易に他のユーザと情報を共有できる一方、特定の時間に同じサウンドを聞いている他のユーザまたは特定の場所にいる他のユーザと、情報を共有することができる。

【0046】

図6は、本発明の他の実施形態において、ソーシャルネットワークサービスを提供する方法を示すフローチャートである。

【0047】

本発明の他の実施形態に係るソーシャルネットワークサービス提供サーバ130は、複数のユーザ端末からネットワークを介してサウンドを受信し(S610)、サウンドから特徴値を抽出する(S620)。そして、抽出された特徴値を予め格納されたサウンドの特徴値と比較してマッチングされるメタ情報を検索する(S630)。

【0048】

ここで、ソーシャルネットワークサービス提供サーバ130は、抽出された特徴値にマッチングされるメタ情報が検索されるかを判断し(S640)、検索されない場合、ユーザ端末110にサウンドに対するメタ情報登録要請を送信してユーザからメタ情報の入力を受けて登録する(S660)。そして、同一のメタ情報が検索されるユーザをグループ化してグループ情報を生成し(S650)、これをユーザ端末110に送信する。したがって、ソーシャルネットワークサービス提供サーバ130は、データベース140に登録されていないサウンドを或るユーザが入力した場合、当該サウンドを登録することによって、他のユーザが当該サウンドにマッチングされるサウンドを送信する際に、前者が後者と情報を共有できるようにしてもよく、或るユーザが送信したサウンドの特徴値と他のユーザが送信したサウンドの特徴値とがマッチしなくても、ユーザが送信したサウンドのメタ情報とマッチングされるメタ情報が検索されるユーザをグループ化することにより、ユーザにソーシャルネットワークサービスを提供してもよい。

【0049】

本発明に係るソーシャルネットワークサービス提供方法は、多様なコンピュータ手段によって行うことができるプログラム命令形態で実現され、コンピュータ読み出し可能媒体に記録してもよい。前記記録媒体は、プログラム命令、データファイル、データ構造などを単独または組み合わせたものを含んでもよい。前記記録媒体及びプログラム命令は、本発明の目的のために特別に設計して構成されたものでもよく、コンピュータソフトウェア分野の技術を有する当業者にとって公知のものであり使用可能なものであってもよい。コンピュータ読取可能な記録媒体の例としては、ハードディスク、フロッピー(登録商標)ディスク及び磁気テープのような磁気媒体、CD−ROM、DVDのような光記録媒体、フロプティカルディスクのような磁気−光媒体、及びROM、RAM、フラッシュメモリなどのようなプログラム命令を保存して実行するように特別に構成されたハードウェア装置を含んでもよい。プログラム命令の例としては、コンパイラによって生成されるような機械語コードだけでなく、インタプリタなどを用いてコンピュータによって実行され得る高級言語コードを含む。上述のハードウェア装置は、本発明の動作を行うために1つ以上のソフトウェアモジュールとして作動するように構成してもよく、その逆も同様である。

【0050】

上述したように本発明を限定された実施形態と図面によって説明したが、本発明は、上記の実施形態に限定されることなく、本発明が属する分野における通常の知識を有する者であれば、このような実施形態から多様な修正及び変形が可能である。

【0051】

したがって、本発明の範囲は、開示された実施形態に限定されて定められるものではなく、特許請求の範囲及び特許請求の範囲と均等なものなどによって定められるものである。

【符号の説明】

【0052】

110、120:ユーザ端末

130:ソーシャルネットワークサービス提供サーバ

140:データベース

【技術分野】

【0001】

本発明は、ユーザが入力するサウンドを用いて前記ユーザにソーシャルネットワークサービス(SNS:Social Network Service)を提供する、サウンドを利用したソーシャルネットワークサービス提供装置及びその方法に関する。

【背景技術】

【0002】

現在、ネットワークを介して、ソーシャルネットワークサービス提供者からツイッター(twitter)、フェイスブック(facebook)、ミートゥデイ(me2day)等のような多様なソーシャルネットワークサービスが、提供される。

【0003】

ソーシャルネットワークサービスは、インターネット上で、友人、先後輩、同僚などの知人との人脈関係を強化して新しい人脈を築いて幅広い人的ネットワークを形成できるようにするサービスである。このようなソーシャルネットワークサービスを提供する方法として、大韓民国公開特許第10−2011−0016349「ソーシャルネットワークサービスの提供方法及び装置」がある。

【0004】

しかし、今日、個人の表現の欲求が高まるにつれて、このようなソーシャルネットワークサービスの提供方法では、他の人達とより多彩な情報の共有を求めているユーザを満足させることは、困難である。

【0005】

例えば、特定の映画を鑑賞したユーザが映画に対する感想を共有しようとする場合などが挙げられる。この場合、従来のソーシャルネットワークサービスの利用者は、映画に対する自分の感想を、仮想掲示板等を介して他の人と共有したり、映画について対話が行われているチャットルームなどに入場して、他の人々と感想を共有してきた。しかし、仮想掲示板を介して他の人と感想を共有する場合、一般的に、仮想掲示板を見る人は映画に特別な関心を持っていない場合が多いため、ユーザは、自分が掲示した感想に対する他の人の反応から満足感を十分に得られなかった。

【0006】

一方、ユーザが映画に対するチャットルームに入場して感想を他の人と共有しようとする場合、当該ユーザは、まず映画に対するチャットルームを検索しなければならないという不便を受忍しなければならないだけでなく、チャットルームを検索するために適したキーワードを選ぶという困難を受忍しなければならなかった。一例として、従来のソーシャルネットワークサービスでは、ユーザが特定の時間または特定の場所で公演された演劇に対する感想を他の人と共有しようとしている場合に、当該ユーザに対して当該特定の時間または特定の場所で公演された演劇を見たユーザを推薦することが難しかった。

【0007】

したがって、ユーザに対してより満足感を提供することができ、ユーザがより容易にソーシャルネットワークサービスを利用できる方法が求められている。

【発明の概要】

【発明が解決しようとする課題】

【0008】

本発明の課題は、サウンドを用いてソーシャルネットワークサービスを提供することによって、ユーザがより容易に他のユーザと情報を共有できるソーシャルネットワークサービス提供装置及びその方法を提供することである。

【0009】

また、本発明の課題は、ユーザが特定のイベントを他のユーザと共有できるだけでなく、ユーザが特定の時間に同じサウンドを聞いている他のユーザまたは特定の場所にいる他のユーザと情報を共有できるソーシャルネットワークサービス提供装置及びその方法を提供することである。

【課題を解決するための手段】

【0010】

本発明の一態様によるソーシャルネットワークサービス提供装置は、ユーザ端末からサウンドを受信するサウンド受信部と、前記受信されるサウンドから特徴値を抽出する特徴値抽出部と、前記抽出された特徴値にマッチする特徴値を有するサウンドを送信するユーザ同士をグループ化してグループ情報を生成するグループ情報生成部とを、備える。

【0011】

また、前記特徴値抽出部によって抽出された特徴値をデータベースに格納されたサウンドの特徴値と比較してマッチする特徴値を有するサウンドのメタ情報を検索するメタ情報検索部をさらに備え、前記グループ情報生成部は、前記検索されたメタ情報にマッチングされるメタ情報を有するサウンドを送信するユーザ同士をグループ化して前記グループ情報を生成してもよい。

【0012】

また、前記抽出された特徴値にマッチングされる前記メタ情報が検索されない場合、前記ユーザ端末から前記受信されたサウンドに対するメタ情報を登録するメタ情報登録部をさらに備えてもよい。

【0013】

また、前記グループ情報生成部は、前記サウンドが入力される時間に基づいて、各サウンドを送信したユーザ同士をグループ化して、前記グループ情報を生成したり、前記ユーザ端末の位置情報に基づいて 各サウンドを送信したユーザ同士をグループ化して、前記グループ情報を生成してもよい。

【0014】

また、本発明の他の態様によるソーシャルネットワークサービス提供装置は、サウンドが入力されるサウンド入力部と、前記入力されるサウンドをソーシャルネットワークサービス提供サーバに送信するサウンド送信部と、前記送信されたサウンドから抽出された特徴値にマッチする特徴値を有するサウンドを前記ソーシャルネットワークサービス提供サーバに送信したユーザ同士をグループ化することによって生成されたグループ情報を前記ソーシャルネットワークサービス提供サーバから受信して表示するグループ情報表示部とを備えてもよい。

【0015】

また、本発明の他の態様によるソーシャルネットワークサービスを提供する方法は、ユーザ端末からサウンドを受信するステップと、前記受信されるサウンドから特徴値を抽出するステップと、前記抽出された特徴値にマッチする特徴値を有するサウンドを送信するユーザをグループ化してグループ情報を生成するステップと、前記生成されたグループ情報を前記ユーザ端末に送信するステップとを含んでもよい。

【発明の効果】

【0016】

本発明によれば、ユーザ端末から入力されるサウンドから特徴値を抽出して、前記抽出された特徴値にマッチングされるサウンドを送信するユーザをグループ化することによって、ユーザが、より容易に他のユーザと情報を共有することができる。

【0017】

また、サウンドが入力される時間または場所に基づいてユーザをグループ化することによって、ユーザ間で特定イベントを共有できるだけでなく、特定の時間に同じサウンドを聞いているユーザ間または特定の場所にいるユーザ間で情報を共有することができる。

【図面の簡単な説明】

【0018】

【図1】本発明の一実施形態において、サウンドを利用したソーシャルネットワークサービス提供システムを示す概念図である。

【図2】本発明の一実施形態において、サウンドを利用したソーシャルネットワークサービス提供装置を説明するためのブロック図である。

【図3】本発明の一実施形態において、サウンドを用いてユーザにソーシャルネットワークサービスを提供する一例を示す例示図である。

【図4】本発明の一実施形態において、サウンドを用いてユーザにソーシャルネットワークサービスを提供する一例を示す例示図である。

【図5】本発明の一実施形態において、ソーシャルネットワークサービスを提供する方法を示すフローチャートである。

【図6】本発明の他の実施形態において、ソーシャルネットワークサービスを提供する方法を示すフローチャートである。

【発明を実施するための形態】

【0019】

以下、本発明の実施形態を添付する図面を参照しながら詳細に説明する。

【0020】

図1は、本発明の一実施形態による、サウンドを利用したソーシャルネットワークサービス提供システムを示す概念図である。図1を参照すれば、ソーシャルネットワークサービス提供システムは、複数のユーザ端末110,120、ソーシャルネットワークサービス提供サーバ130、及びデータベース140を、備えている。

【0021】

それぞれのユーザ端末110,120は、ネットワークを介して、ユーザが入力するサウンドを、ソーシャルネットワークサービス提供サーバ130へ送信する。ユーザ端末110,120は、ユーザがソーシャルネットワークサービス提供サーバからソーシャルネットワークサービスなどのような多様なサービスの提供を受ける装置であり、スマートフォンなどの携帯端末やデスクトップコンピュータなどのように、ネットワークの機能を備えて、サウンドを入力できる装置として実現されてもよい。

【0022】

ソーシャルネットワークサービス提供サーバ130は、ユーザが送信したサウンドに基づいて、当該ユーザと、当該サウンドにマッチングされるサウンドを送信した他のユーザをグループ化して、グループ情報を生成し、このグループ情報を、再びネットワークを介してユーザ端末110,120へ送信する。

【0023】

ここで、一実施形態として、ソーシャルネットワークサービス提供サーバ130は、各ユーザ端末から送信されるそれぞれのサウンドから特徴値を抽出して、これを比較して、相互にマッチングされるサウンドを入力した複数のユーザ同士を一つのグループにグループ化することによって、グループ情報を生成してもよい。

【0024】

一方、他の実施形態として、ソーシャルネットワークサービス提供サーバ130は、各ユーザ端末から送信されるそれぞれのサウンドから特徴値を抽出して、これをデータベース140に格納されたサウンドの特徴値と比較して、前者にマッチする特徴値を有するサウンドのメタ情報を検索し、検索されたメタ情報に基づいて、グループ情報を生成してもよい。

【0025】

図2は、本発明の一実施形態において、サウンドを利用したソーシャルネットワークサービス提供装置を説明するためのブロック図である。以下、図2を参照して本発明に係るソーシャルネットワークサービス提供装置をより詳細に説明する。

【0026】

ユーザ端末110は、サウンド入力部210、サウンド送信部220、及びグループ情報表示部230を、備えてもよい。

【0027】

サウンド入力部210には、ユーザがソーシャルネットワークサービス提供サーバ130に送信しようとするサウンドが、入力される。これのために、サウンド入力部210は、マイクなどのようなサウンド入力装置によって実現され、ユーザ端末110の一側面に備えられてもよい。

【0028】

サウンド送信部220は、サウンド入力部210を介して入力されるサウンドを、無線通信網、移動通信網などのネットワークを介して、ソーシャルネットワークサービス提供サーバ130へ送信する。

【0029】

グループ情報表示部230は、ソーシャルネットワークサービス提供サーバ130から、ネットワークを介してグループ情報を受信して、これを表示する。ソーシャルネットワークサービス提供サーバ130は、ユーザ端末110から送信されるサウンドから特徴値を抽出し、当該特徴値にマッチする特徴値を有するサウンドを当該ソーシャルネットワークサービス提供サーバ130へ送信したユーザを前記ユーザ端末110を操作しているユーザとグループ化することによって、グループ情報を生成してもよい。また、データベース140に格納された複数のサウンドのうち、当該特徴値にマッチする特徴値を有するサウンドのメタ情報を検索し、検索されたメタ情報に該当するサウンドを送信した他のユーザを前記ユーザ端末110を操作しているユーザとグループ化することによって、グループ情報を生成してもよい。

【0030】

グループ情報表示部230は、一例として、ユーザ端末110にアプリケーションの形態でインストールされ、ソーシャルネットワークサービス提供サーバ130から受信したグループ情報を所定の形態で表示することによって、ユーザにソーシャルネットワークサービスを提供してもよい。

【0031】

一方、本発明の一実施形態に係るソーシャルネットワークサービス提供サーバ130は、サウンド受信部240、特徴値抽出部250、及びグループ情報生成部260を、備えてもよい。

【0032】

サウンド受信部240は、ユーザ端末110からネットワークを介して送信されたサウンドを、受信する。

【0033】

特徴値抽出部250は、サウンド受信部240で受信されるサウンドから、特徴値(fingerprint)を抽出する。

【0034】

グループ情報生成部260は、特徴値抽出部250で抽出された特徴値にマッチする特徴値を有するサウンドを送信した他のユーザを前記ユーザ端末110を操作しているユーザとグループ化して、グループ情報を生成する。ここで、グループ情報生成部260は、サウンドが入力される時間に基づいてユーザをグループ化してグループ情報を生成してもよく、ユーザ端末110の位置情報に基づいてユーザをグループ化してグループ情報を生成してもよい。

【0035】

例えば、グループ情報生成部260が、サウンドが入力される時間に基づいてグループ情報を生成する場合、グループ情報生成部260は、所定の時間の間にサウンド受信部240で受信される各サウンドから抽出された特徴値同士を比較して、相互にマッチした特徴値を含むサウンドを送信したユーザ同士をグループ化して、グループ情報を生成してもよい。この場合、ソーシャルネットワークサービス提供サーバ130は、特定の時間内にサウンドを送信するユーザをグループ化できるため、ユーザが特定の時間に公演中の特定の演劇を鑑賞している間に、当該演劇を鑑賞している他のユーザと当該演劇に対する感想を共有しようとする場合にも、当該演劇のサウンドを入力することによって、容易に、他のユーザと、当該演劇に対する感想を共有することができる。

【0036】

また、グループ情報生成部260がユーザ端末110の位置情報に基づいてグループ情報を生成する場合、ソーシャルネットワークサービス提供サーバ130は、サウンド受信部240によってサウンドが受信されるときに、該当ユーザ端末110の位置情報をGPS(Global Positioning System)等を用いて検出し、位置情報と特徴値が一致するサウンドを送信したユーザをグループ化して、グループ情報を生成してもよい。この場合、ソーシャルネットワークサービス提供サーバ130は、特定位置でサウンドを送信するユーザをグループ化できるため、ユーザが特定映画の鑑賞中に当該映画に対する感想を他のユーザと共有しようとする場合にも、同じ映画館で当該映画を鑑賞する他のユーザと感想を共有することができる。

【0037】

一方、他の実施形態として、ソーシャルネットワークサービス提供サーバ130は、サウンド受信部240、特徴値抽出部250、及びグループ情報生成部260の他に、メタ情報検索部270、及びメタ情報登録部280を、さらに備えてもよい。

【0038】

この場合、メタ情報検索部270は、特徴値抽出部250で抽出された特徴値をデータベース140に格納されたサウンドの特徴値と比較してマッチングされるメタ情報を検索する。ここで、メタ情報は、サウンドに関する情報を含む情報であり、例えば、サウンドが映画に対するサウンドである場合、映画の題名、映画を上映する劇場に関する情報などをも含んでもよい。

【0039】

メタ情報検索部270において、抽出された特徴値にマッチングされるメタ情報が検索されない場合、メタ情報登録部280は、ユーザ端末110にサウンドに対するメタ情報登録要請を送信し、受信されるサウンドに対するメタ情報の登録を受けて、データベース140に格納してもよい。したがって、データベース140に登録されていなかったサウンドをユーザが入力しても、当該サウンドに対するメタ情報を登録することによって、他のユーザが当該サウンドのメタ情報にマッチングされるメタ情報を有するサウンドを送信する際に、ユーザが他のユーザと情報を共有できるようにしてもよい。

【0040】

グループ情報生成部260は、メタ情報検索部270で検索されたメタ情報にマッチングされるメタ情報を有するサウンドを送信したユーザを前記ユーザ端末110を操作しているユーザとグループ化して、グループ情報を生成する。ここでも、グループ情報生成部260は、サウンドが入力される時間に基づいてユーザをグループ化してグループ情報を生成したり、ユーザ端末の位置情報に基づいてユーザをグループ化してグループ情報を生成することによって、特定の時間に同じサウンドを聞いているユーザまたは特定の場所にいるユーザ同士で情報を共有できるようにしてもよい。

【0041】

例えば、第1ユーザが特定映画の上映時間のうち10分から12分に該当するサウンドをソーシャルネットワークサービス提供サーバ130に送信して、第2ユーザが映画の11分から13分に該当するサウンドをソーシャルネットワークサービス提供サーバ130に送信する場合、ソーシャルネットワークサービス提供サーバ130は、映画の11分から12分に該当するサウンドの特徴値を用いて第1ユーザと第2ユーザをグループ化できる。しかしながら、第1ユーザが特定映画の上映時間のうち10分から11分に該当するサウンドをソーシャルネットワークサービス提供サーバ130に送信して、第2ユーザが映画の12分から13分に該当するサウンドをソーシャルネットワークサービス提供サーバ130に送信する場合、第1ユーザが送信したサウンドから抽出される特徴値と第2ユーザが送信したサウンドから抽出される特徴値とがマッチしない可能性がある。この場合、メタ情報検索部270は、データベース140に格納されたサウンドと第1ユーザが送信したサウンドの特徴値とを比較してマッチングされるメタ情報を検索することによって、第1ユーザが送信したサウンドがどんな映画のサウンドに該当するかを検出してもよい。したがって、グループ情報生成部270は、ユーザが送信したサウンドの特徴値と他のユーザが送信したサウンドの特徴値とが相互にマッチングされなくても、当該ユーザを、当該ユーザが送信したサウンドのメタ情報とマッチングされるメタ情報を有するサウンドを送信した他のユーザとグループ化して、グループ情報を生成することができる。

【0042】

図3及び図4は、本発明の一実施形態において、サウンドを用いてユーザにソーシャルネットワークサービスを提供する一例を示す例示図である。

【0043】

ユーザがOXコンサートに行って現在OXコンサートに来た人々と感想を共有しようとする場合、ユーザは、図3に示すように、ユーザ端末110を用いてソーシャルネットワークサービス提供サーバ130にサウンドを送信してもよい。この場合、ソーシャルネットワークサービス提供サーバ130は、ユーザ端末110からサウンドを受信して、当該サウンドから特徴値を抽出する。そして、抽出された特徴値にその特徴量がマッチングされるサウンドを送信した他のユーザを、前記ユーザ端末110を操作しているユーザとグループ化して、グループ情報を生成する。ここで、ソーシャルネットワークサービス提供サーバ130は、サウンドが入力される時間やユーザ端末の位置情報などに基づいてユーザをグループ化して、グループ情報を生成することによって、図4に示すように、或るユーザが当該グループ情報を用いて現在OXコンサートに来た他の人々と感想を共有できるようにしてもよい。一方、ソーシャルネットワークサービス提供サーバ130は、サウンドから抽出された特徴値をデータベースに格納されたサウンドの特徴値と比較してマッチングされるメタ情報を検索し、メタ情報にマッチングされるメタ情報が検索されるユーザをグループ化することによってグループ情報を生成してもよい。この場合、ソーシャルネットワークサービス提供サーバ130は、メタ情報に基づいてユーザをグループ化するため、現在OXコンサートにあるユーザとだけではなく、OXコンサートを開く歌手のファン達や、OXコンサートの入場券を購入しようとする人々とも、対話をしたり情報を共有できるようにしてもよい。したがって、ユーザは、より容易に、自分と共通する関心分野を有する人々と情報を共有することができ、より緊密な共感を形成することができる。

【0044】

図5は、本発明の一実施形態において、ソーシャルネットワークサービスを提供する方法を示すフローチャートである。

【0045】

本発明の一実施形態に係るソーシャルネットワークサービス提供サーバ130は、複数のユーザ端末110からネットワークを介してサウンドを受信し(S510)、サウンドから特徴値を抽出する(S520)。そして、抽出された特徴値同士がマッチングされるサウンドを送信したユーザ同士をグループ化して、グループ情報を生成し(S530)、このグループ情報をユーザ端末に送信する。ここで、グループ情報は、サウンドが入力される時間、及び/またはユーザ端末の位置情報に基づいて、生成されてもよい。したがって、本発明に係るソーシャルネットワークサービス提供装置は、特定の時間及び/または特定の場所でサウンドを送信するユーザ同士をグループ化できるため、ユーザがサウンドを用いて、より容易に他のユーザと情報を共有できる一方、特定の時間に同じサウンドを聞いている他のユーザまたは特定の場所にいる他のユーザと、情報を共有することができる。

【0046】

図6は、本発明の他の実施形態において、ソーシャルネットワークサービスを提供する方法を示すフローチャートである。

【0047】

本発明の他の実施形態に係るソーシャルネットワークサービス提供サーバ130は、複数のユーザ端末からネットワークを介してサウンドを受信し(S610)、サウンドから特徴値を抽出する(S620)。そして、抽出された特徴値を予め格納されたサウンドの特徴値と比較してマッチングされるメタ情報を検索する(S630)。

【0048】

ここで、ソーシャルネットワークサービス提供サーバ130は、抽出された特徴値にマッチングされるメタ情報が検索されるかを判断し(S640)、検索されない場合、ユーザ端末110にサウンドに対するメタ情報登録要請を送信してユーザからメタ情報の入力を受けて登録する(S660)。そして、同一のメタ情報が検索されるユーザをグループ化してグループ情報を生成し(S650)、これをユーザ端末110に送信する。したがって、ソーシャルネットワークサービス提供サーバ130は、データベース140に登録されていないサウンドを或るユーザが入力した場合、当該サウンドを登録することによって、他のユーザが当該サウンドにマッチングされるサウンドを送信する際に、前者が後者と情報を共有できるようにしてもよく、或るユーザが送信したサウンドの特徴値と他のユーザが送信したサウンドの特徴値とがマッチしなくても、ユーザが送信したサウンドのメタ情報とマッチングされるメタ情報が検索されるユーザをグループ化することにより、ユーザにソーシャルネットワークサービスを提供してもよい。

【0049】

本発明に係るソーシャルネットワークサービス提供方法は、多様なコンピュータ手段によって行うことができるプログラム命令形態で実現され、コンピュータ読み出し可能媒体に記録してもよい。前記記録媒体は、プログラム命令、データファイル、データ構造などを単独または組み合わせたものを含んでもよい。前記記録媒体及びプログラム命令は、本発明の目的のために特別に設計して構成されたものでもよく、コンピュータソフトウェア分野の技術を有する当業者にとって公知のものであり使用可能なものであってもよい。コンピュータ読取可能な記録媒体の例としては、ハードディスク、フロッピー(登録商標)ディスク及び磁気テープのような磁気媒体、CD−ROM、DVDのような光記録媒体、フロプティカルディスクのような磁気−光媒体、及びROM、RAM、フラッシュメモリなどのようなプログラム命令を保存して実行するように特別に構成されたハードウェア装置を含んでもよい。プログラム命令の例としては、コンパイラによって生成されるような機械語コードだけでなく、インタプリタなどを用いてコンピュータによって実行され得る高級言語コードを含む。上述のハードウェア装置は、本発明の動作を行うために1つ以上のソフトウェアモジュールとして作動するように構成してもよく、その逆も同様である。

【0050】

上述したように本発明を限定された実施形態と図面によって説明したが、本発明は、上記の実施形態に限定されることなく、本発明が属する分野における通常の知識を有する者であれば、このような実施形態から多様な修正及び変形が可能である。

【0051】

したがって、本発明の範囲は、開示された実施形態に限定されて定められるものではなく、特許請求の範囲及び特許請求の範囲と均等なものなどによって定められるものである。

【符号の説明】

【0052】

110、120:ユーザ端末

130:ソーシャルネットワークサービス提供サーバ

140:データベース

【特許請求の範囲】

【請求項1】

ソーシャルネットワークサービス提供装置であって、

ユーザ端末からサウンドを受信するサウンド受信部と、

前記受信されるサウンドから特徴値を抽出する特徴値抽出部と、

前記抽出された特徴値同士がマッチするサウンドを送信するユーザ同士をグループ化してグループ情報を生成するグループ情報生成部と、

を備えることを特徴とするソーシャルネットワークサービス提供装置。

【請求項2】

前記特徴値抽出部によって抽出された特徴値をデータベースに格納されたサウンドの特徴値と比較してマッチングされるメタ情報を検索するメタ情報検索部をさらに備え、

前記グループ情報生成部は、

前記検索されたメタ情報にマッチングされるメタ情報が検索されるユーザをグループ化して、前記グループ情報を生成することを特徴とする請求項1に記載のソーシャルネットワークサービス提供装置。

【請求項3】

前記抽出された特徴値にマッチングされる前記メタ情報が検索されない場合に、前記ユーザ端末から送信された前記サウンドに対するメタ情報が登録されるメタ情報登録部を

さらに備えることを特徴とする請求項2に記載のソーシャルネットワークサービス提供装置。

【請求項4】

前記グループ情報生成部は、

前記サウンドが入力される時間に基づいて、各サウンドを送信したユーザ同士をグループ化して、前記グループ情報を生成する

ことを特徴とする請求項1乃至3のいずれかに記載のソーシャルネットワークサービス提供装置。

【請求項5】

前記グループ情報生成部は、

前記ユーザ端末の位置情報に基づいて、各サウンドを送信したユーザ同士をグループ化して、前記グループ情報を生成する

ことを特徴とする請求項3に記載のソーシャルネットワークサービス提供装置。

【請求項6】

ソーシャルネットワークサービス提供装置であって、

サウンドが入力されるサウンド入力部と、

前記入力されるサウンドをソーシャルネットワークサービス提供サーバに送信するサウンド送信部と、

前記送信されるサウンドから抽出された特徴値同士がマッチングされるサウンドを前記ソーシャルネットワークサービス提供サーバに送信したユーザ同士をグループ化することによって生成されたグループ情報を、前記ソーシャルネットワークサービス提供サーバから受信して表示するグループ情報表示部と、

を備えることを特徴とするソーシャルネットワークサービス提供装置。

【請求項7】

前記グループ情報は、

前記抽出された特徴値をデータベースに格納されたサウンドの特徴値と比較してマッチングされるメタ情報を検索し、前記検索されたメタ情報にマッチングされるメタ情報が検索されるユーザをグループ化することによって生成される

ことを特徴とする請求項6に記載のソーシャルネットワークサービス提供装置。

【請求項8】

前記グループ情報は、

前記サウンドが入力される時間に基づいて前記サウンドを送信したユーザ同士をグループ化することによって生成されたり、前記ユーザ端末の位置情報に基づいて前記サウンドを送信したユーザ同士をグループ化することによって生成される

ことを特徴とする請求項6に記載のソーシャルネットワークサービス提供装置。

【請求項9】

ソーシャルネットワークサービスを提供する方法において、

ユーザ端末からサウンドを受信するステップと、

前記受信されるサウンドから特徴値を抽出するステップと、

前記抽出された特徴値同士がマッチングされるサウンドを送信したユーザ同士をグループ化してグループ情報を生成するステップと、

前記生成されたグループ情報を前記ユーザ端末に送信するステップと、

を含むことを特徴とするソーシャルネットワークサービス提供方法。

【請求項10】

前記特徴値を抽出するステップ以後に、

前記抽出された特徴値を予め格納されたサウンドの特徴値と比較してマッチングされるメタ情報を検索するステップをさらに含み、

前記グループ情報を生成するステップは、

前記検索されたメタ情報にマッチングされるメタ情報が、検索されるユーザをグループ化して前記グループ情報を生成するステップであることを特徴とする請求項9に記載のソーシャルネットワークサービス提供方法。

【請求項11】

前記メタ情報を検索するステップ以後に、

前記抽出された特徴値にマッチングされる前記メタ情報が検索されない場合、前記ユーザ端末によって、前記受信されるサウンドに対するメタ情報が登録されるステップをさらに含む

ことを特徴とする請求項10に記載のソーシャルネットワークサービス提供方法。

【請求項12】

前記グループ情報を生成するステップは、

前記サウンドが入力される時間に基づいて前記サウンドを送信したユーザ同士をグループ化して前記グループ情報を生成したり、前記ユーザ端末の位置情報に基づいて前記サウンドを送信したユーザ同士をグループ化して前記グループ情報を生成するステップである

ことを特徴とする請求項9乃至11のうちいずれかに記載のソーシャルネットワークサービス提供方法。

【請求項13】

請求項9乃至12のうちいずれか1項のソーシャルネットワークサービス提供方法を実行するためのプログラムが記録されているコンピュータで読み出し可能な記録媒体。

【請求項1】

ソーシャルネットワークサービス提供装置であって、

ユーザ端末からサウンドを受信するサウンド受信部と、

前記受信されるサウンドから特徴値を抽出する特徴値抽出部と、

前記抽出された特徴値同士がマッチするサウンドを送信するユーザ同士をグループ化してグループ情報を生成するグループ情報生成部と、

を備えることを特徴とするソーシャルネットワークサービス提供装置。

【請求項2】

前記特徴値抽出部によって抽出された特徴値をデータベースに格納されたサウンドの特徴値と比較してマッチングされるメタ情報を検索するメタ情報検索部をさらに備え、

前記グループ情報生成部は、

前記検索されたメタ情報にマッチングされるメタ情報が検索されるユーザをグループ化して、前記グループ情報を生成することを特徴とする請求項1に記載のソーシャルネットワークサービス提供装置。

【請求項3】

前記抽出された特徴値にマッチングされる前記メタ情報が検索されない場合に、前記ユーザ端末から送信された前記サウンドに対するメタ情報が登録されるメタ情報登録部を

さらに備えることを特徴とする請求項2に記載のソーシャルネットワークサービス提供装置。

【請求項4】

前記グループ情報生成部は、

前記サウンドが入力される時間に基づいて、各サウンドを送信したユーザ同士をグループ化して、前記グループ情報を生成する

ことを特徴とする請求項1乃至3のいずれかに記載のソーシャルネットワークサービス提供装置。

【請求項5】

前記グループ情報生成部は、

前記ユーザ端末の位置情報に基づいて、各サウンドを送信したユーザ同士をグループ化して、前記グループ情報を生成する

ことを特徴とする請求項3に記載のソーシャルネットワークサービス提供装置。

【請求項6】

ソーシャルネットワークサービス提供装置であって、

サウンドが入力されるサウンド入力部と、

前記入力されるサウンドをソーシャルネットワークサービス提供サーバに送信するサウンド送信部と、

前記送信されるサウンドから抽出された特徴値同士がマッチングされるサウンドを前記ソーシャルネットワークサービス提供サーバに送信したユーザ同士をグループ化することによって生成されたグループ情報を、前記ソーシャルネットワークサービス提供サーバから受信して表示するグループ情報表示部と、

を備えることを特徴とするソーシャルネットワークサービス提供装置。

【請求項7】

前記グループ情報は、

前記抽出された特徴値をデータベースに格納されたサウンドの特徴値と比較してマッチングされるメタ情報を検索し、前記検索されたメタ情報にマッチングされるメタ情報が検索されるユーザをグループ化することによって生成される

ことを特徴とする請求項6に記載のソーシャルネットワークサービス提供装置。

【請求項8】

前記グループ情報は、

前記サウンドが入力される時間に基づいて前記サウンドを送信したユーザ同士をグループ化することによって生成されたり、前記ユーザ端末の位置情報に基づいて前記サウンドを送信したユーザ同士をグループ化することによって生成される

ことを特徴とする請求項6に記載のソーシャルネットワークサービス提供装置。

【請求項9】

ソーシャルネットワークサービスを提供する方法において、

ユーザ端末からサウンドを受信するステップと、

前記受信されるサウンドから特徴値を抽出するステップと、

前記抽出された特徴値同士がマッチングされるサウンドを送信したユーザ同士をグループ化してグループ情報を生成するステップと、

前記生成されたグループ情報を前記ユーザ端末に送信するステップと、

を含むことを特徴とするソーシャルネットワークサービス提供方法。

【請求項10】

前記特徴値を抽出するステップ以後に、

前記抽出された特徴値を予め格納されたサウンドの特徴値と比較してマッチングされるメタ情報を検索するステップをさらに含み、

前記グループ情報を生成するステップは、

前記検索されたメタ情報にマッチングされるメタ情報が、検索されるユーザをグループ化して前記グループ情報を生成するステップであることを特徴とする請求項9に記載のソーシャルネットワークサービス提供方法。

【請求項11】

前記メタ情報を検索するステップ以後に、

前記抽出された特徴値にマッチングされる前記メタ情報が検索されない場合、前記ユーザ端末によって、前記受信されるサウンドに対するメタ情報が登録されるステップをさらに含む

ことを特徴とする請求項10に記載のソーシャルネットワークサービス提供方法。

【請求項12】

前記グループ情報を生成するステップは、

前記サウンドが入力される時間に基づいて前記サウンドを送信したユーザ同士をグループ化して前記グループ情報を生成したり、前記ユーザ端末の位置情報に基づいて前記サウンドを送信したユーザ同士をグループ化して前記グループ情報を生成するステップである

ことを特徴とする請求項9乃至11のうちいずれかに記載のソーシャルネットワークサービス提供方法。

【請求項13】

請求項9乃至12のうちいずれか1項のソーシャルネットワークサービス提供方法を実行するためのプログラムが記録されているコンピュータで読み出し可能な記録媒体。

【図1】

【図2】

【図3】

【図4】

【図5】

【図6】

【図2】

【図3】

【図4】

【図5】

【図6】

【公開番号】特開2013−33470(P2013−33470A)

【公開日】平成25年2月14日(2013.2.14)

【国際特許分類】

【出願番号】特願2012−160771(P2012−160771)

【出願日】平成24年7月19日(2012.7.19)

【公序良俗違反の表示】

(特許庁注:以下のものは登録商標)

1.TWITTER

2.FACEBOOK

【出願人】(505205812)エヌエイチエヌ コーポレーション (408)

【Fターム(参考)】

【公開日】平成25年2月14日(2013.2.14)

【国際特許分類】

【出願日】平成24年7月19日(2012.7.19)

【公序良俗違反の表示】

(特許庁注:以下のものは登録商標)

1.TWITTER

2.FACEBOOK

【出願人】(505205812)エヌエイチエヌ コーポレーション (408)

【Fターム(参考)】

[ Back to top ]