ビデオ画像内でのオブジェクトトラッキング

本発明は、それぞれのマッチング特徴のスケーリングと分散を考慮に入れる、ビデオフレーム内でオブジェクトを追跡するためのオブジェクトトラッキング方法及びシステムを提供する。これは、オブジェクト間の一致を決定するために可能な限り多くのマッチング特徴を使用することができ、このようにして決定されるマッチングの精度を高めることを確実にする一方で、マッチング特徴の選択でのある程度の自由度に備える。オブジェクト間の閉塞を考慮に入れるために並列マッチング手法が使用され、発見的規則が利用される。

【発明の詳細な説明】

【技術分野】

【0001】

本発明はフレームごとにビデオ画像の中で検出されるオブジェクトを追跡する方法及びシステムに関する。

【背景技術】

【0002】

自動ビデオトラッキングアプリケーションは当技術分野において公知である。一般的にこのようなアプリケーションはビデオフレームを入力として受信し、多くの場合バックグラウンド除去技法を使用して、移動するオブジェクト等の画像内の関心のあるオブジェクトを検出するために動作する。単一の入力フレーム内でオブジェクトを検出すると、このようなアプリケーションは、検出されたオブジェクトの特性を使用してフレームごとに検出されたオブジェクトを追跡するために動作する。将来の入力フレームでオブジェクトを検出し、前記検出されたオブジェクトの特性を決定することにより、前記決定された特性をマッチングして、トラックを生じさせるために過去に検出されたオブジェクトとの将来検出されるオブジェクトのマッチングが可能である。前記を表す例の従来の技術のトラッキングアプリケーションは、Zhou Qらの「ビデオから移動するオブジェクトを追跡し、分類すること」会議録、PETSに関する第2回IEEE国際ワークショップ、2001年米国ハワイ、カウアイの中に説明されている。

【0003】

しかしながら、特性を使用するマッチングは、他の特徴が雑音により影響を受けやすい一方、いくつかの特徴がオブジェクトに対してより永続的であるためにいくつかの問題を提起する。また、異なる特徴は通常異なる分散のある異なる範囲内で値をとる。ユークリッド距離マッチング測度は、距離測度を支配するためにより大きなスケールと分散を有する次元を可能にするであろうため、これらの要因を考慮しない。

【発明の開示】

【0004】

本発明はそれぞれのマッチング特徴のスケーリングと分散を考慮に入れる、ビデオフレーム内でオブジェクトを追跡するためのオブジェクトトラッキング方法とシステムの提供により前記に対処する。これは、オブジェクト間で一致を決定するために可能な限り多くのマッチング特徴を使用することができ、このようにして決定されるマッチングの精度を高めることを確実にする一方で、マッチング特徴の選択である程度の自由度に備える。

【0005】

前記を鑑みて、第1の態様から、本発明は、

シーケンスの過去のビデオ画像で検出されたオブジェクトに関する1つまたは複数のオブジェクトモデルを記憶する段階であって、前記オブジェクトモデルが検出されたオブジェクトの特性の値とそれらの値の分散を備える段階と、

処理されるシーケンスの追加のビデオ画像を受信する段階と、

前記受信されたビデオ画像内で1または複数のオブジェクトを検出する段階と、

前記検出されたオブジェクトの特性を決定する段階と、

前記特性の少なくとも前記分散を考慮に入れる距離関数を使用して、前記それぞれの特性に基づいて各検出されたオブジェクトと各オブジェクトモデルの間で距離測度を計算する段階と、

前記計算された距離測度に基づいて前記オブジェクトモデルに前記検出されたオブジェクトをマッチングする段階と、

前記オブジェクトのトラックを提供するために、前記オブジェクトモデルを、それにマッチングされた前記それぞれの検出されたオブジェクトの特性を使用して更新する段階と、

を備える、ビデオ画像のシーケンス内でオブジェクトを追跡するための方法を提供する。

【0006】

特性の分散を考慮に入れる距離関数を使用することにより、他と比較されるときに前記一致する特性のいくつかのより大きなスケールと分散が補償されるため、一致を実行するために使用できるのと同じくらい多くの異なるマッチング特徴を使用する能力だけではなく、特徴の選択における柔軟度も与えられる。

【0007】

好ましい実施形態では、距離測度はスケーリングされたユークリッド距離である。これは、リアルタイム演算に適したコンピュータ的に安価なプロセスにより高次元データを処理できるという利点を提供する。好ましくは、距離関数は、オブジェクトモデルlと検出されたオブジェクトkについて以下の形をとり、

【数3】

【0008】

この場合指数iはオブジェクトモデルのN個の特徴すべてを通り、

【数4】

【0009】

は各特長の分散の対応する成分である。

【0010】

代替実施形態では、距離測度は、特徴のスケーリングと分散だけではなく、共分散行列に基づいた他の特徴の変分も考慮に入れるマハラノビスの距離である。したがって、相関する特徴がある場合、それらの寄与は適切に加重される。

【0011】

好ましくは、受信されるフレームについて記憶されているオブジェクトモデルの特性の値を予測する段階がさらに含まれ、前記計算段階は特性の予測値をオブジェクトモデルからの特徴値として使用する。この入信フレームとともに使用するためのオブジェクトモデルごとに特性の値を予測するために予測を使用することにより、オブジェクトモデルの検出されたオブジェクトに対するマッチングの精度を高めることができる。

【0012】

好ましい実施形態では、オブジェクトモデルが検出されたオブジェクトにマッチングされない場合、そのオブジェクトの特性値の分散が増加する。これは、それが追跡者が突然のまたは予想外の動きを経験する可能性がある失われたオブジェクトを回復するのを支援するという利点を提供する。

【0013】

好ましくは、オブジェクトモデルが受信された画像の検出されたオブジェクトにマッチングされない場合、更新段階は特性値を所定数の過去の画像で同じオブジェクトについて検出されたそれぞれの個別の値の平均で更新することを備える。これはオブジェクトの再取得(re-acquiring)を容易にするために予測モデルを変更することにより予測誤差(errors)の場合の補償に備える。

【0014】

さらに、好ましくはオブジェクトモデルが受信された画像の検出されたオブジェクトにマッチングされない場合、オブジェクトが別のオブジェクトと重なっていないかどうかを判断するために試験が実行され、重複が検出されるとオブジェクトは閉塞済みと見なされる。これは、最終的にはオブジェクトが失われたことを確認することにつながるであろうルーチンが開始される代わりに、オブジェクトが閉塞している場合には、追跡技法がこれをそのようなものとして認識し、オブジェクトトラックをただちに除去しないという点でオブジェクトのトラックにある程度の柔軟性を与える。

【0015】

さらに、該方法は好ましくは、各オブジェクトが追跡される連続ビデオ画像数をカウントすることと、オブジェクトが所定数の連続フレームの間追跡されると追跡が発生したことを示す追跡信号を出力することとをさらに備える。これにより瞬間的なオブジェクトの動きを無視することができる。

【0016】

さらに、オブジェクトモデルが受信された画像の検出されたオブジェクトにマッチングされない場合、好ましくはオブジェクトモデルがマッチングされない連続フレーム数のカウントが増分され、該方法は、前記カウントが所定数を超えるとオブジェクトモデルを削除することをさらに備える。これにより、背景と融合してしまった静止オブジェクト及び視界を離れてしまったオブジェクトを、このようなオブジェクトに関係する記憶されているオブジェクトモデルを取り除くことによって無視できるようにし、このようにして技法の計算効率を維持し、リアルタイム機能に貢献する。

【0017】

最後に、検出されたオブジェクトがオブジェクトモデルにマッチングされない場合、好ましくは新しいオブジェクトモデルが検出されたオブジェクトに対応して記憶される。これにより、新しいオブジェクトは画像キャプチャ装置の視界に入り、以後追跡されることが可能になる。

【0018】

第2の態様から、本発明は、

シーケンスの過去のビデオ画像で検出されたオブジェクトに関係する、検出されたオブジェクトの特性の値とそれらの値の分散を備える1または複数のオブジェクトモデルを記憶するための記憶手段と、

処理されるシーケンスの追加のビデオ画像を受信するための手段と、

使用時に、

受信されたビデオ画像の中の1または複数のオブジェクトを検出し、

前記検出されたオブジェクトの特性を決定し、

該特性の少なくとも分散を考慮に入れる距離関数を使用してそれぞれの特性に基づいて各検出されたオブジェクトと各オブジェクトモデルの間の距離測度を計算し、

前記計算された距離測度に基づいてオブジェクトモデルに検出されたオブジェクトをマッチングし、

記憶されたオブジェクトモデルを、それにマッチングされたそれぞれの検出されたオブジェクトの特性を使用して更新するように

構成された、使用中の処理手段と、

を備える、ビデオ画像のシーケンス内のオブジェクトを追跡するためのシステムも提供する。

【0019】

第2の態様の中では、第1の態様に関して前述されたのと同じ利点と同じ追加の特徴と利点が得られる。

【0020】

第3の態様から、本発明は、コンピュータシステム上での実行時に、プログラムまたはプログラムのセットにより前記コンピュータシステムが第1の態様の方法を実行するように構成されるコンピュータプログラムまたはプログラムのセットも提供する。さらに、追加の態様から、第3の態様に従ってコンピュータプログラムまたはプログラムのセットを記憶するコンピュータ読み取り可能記憶媒体も提供される。コンピュータ読み取り可能記憶媒体は、限定されない例として、磁気ディスク、DVD、ソリッドステートメモリ、光ディスク、光磁気ディスク等のどれかのような当技術分野において公知の適切なデータ記憶装置または媒体であってよい。

【0021】

本発明の追加の特徴及び利点は、例証としてのみ提示されているその実施形態の以下の説明から、及び添付図面を参照することにより明らかになるであろう

【発明を実施するための最良の形態】

【0022】

本発明の実施形態は、ここで図及び示されている実施形態の動作の例に関して説明される。

【0023】

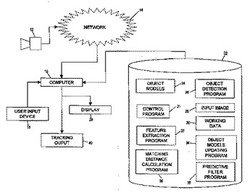

図1は、本発明の実施形態を提供する例のシステムアーキテクチャを描く。さらに詳細には、本発明は概して入力された画像の中でオブジェクトを追跡するための画像処理技法に関するため、本発明はおもにコンピュータ上で実行されるソフトウェアとして具現化される。したがって、本発明のシステムアーキテクチャは、当技術分野において周知であるように汎用コンピュータ16を備える。コンピュータ16は、コンピュータによって生成される出力画像がユーザに表示されてよいディスプレイ20を備え、さらにキーボード、マウス等の多様なユーザ入力装置18を備えている。汎用コンピュータ16は、プログラム、及び本発明の実施形態により生成されるデータが記憶されるハードディスク、メモリ、光ディスク等のデータ記憶媒体22も備えている。出力インタフェース40はさらにコンピュータ16によって提供され出力インタフェース40から、コンピュータによって画像内で追跡されるオブジェクトに関係するトラッキングデータが、このようなデータを利用してよい他の装置に出力されてよい。

【0024】

データ記憶媒体22上には、記憶されているオブジェクトモデル(テンプレート)に対応するデータ24、入力画像に対応するデータ28、及び画像データ、計算結果、及び本発明の動作中に中間記憶装置として使用される他のデータ構造または変数等の作業データに対応するデータ30が記憶されている。さらに、データ記憶媒体22には、制御プログラム31、特徴抽出プログラム32、マッチング距離計算プログラム36、オブジェクト検出プログラム26、オブジェクトモデル更新プログラム34、及び予測フィルタプログラム38等のプログラムの形をとる実行可能なプログラムコードが記憶されている。これらのプログラムのそれぞれの動作は後述される。

【0025】

実施形態の動作を容易にするために、コンピュータ16は、カメラ等の画像キャプチャ装置12から画像を受信するように構成されている。画像キャプチャ装置12はコンピュータ16に直接的に接続されてよい、あるいは代わりにインターネット等のネットワークを介してコンピュータ16に論理的に接続されてよい。画像キャプチャ装置12は、オブジェクトが検出され、追跡されなければならない場面の連続ビデオ画像を提供するように構成され、前記ビデオ画像は、特定の輝度特性とクロミナンス特性を有するために特定の値を取るピクチャエレメント(ピクセル)から構成されている。画像キャプチャ装置12から出力されるピクセルのために使用されるカラーモデルは、RGB、YUV等当技術分野において公知のものであってよい。

【0026】

動作中、汎用コンピュータ16はネットワークを介して、または直接的に画像キャプチャ装置12から画像を受信し、受信された画像の中のオブジェクトを追跡するために受信された入力画像を処理するように制御プログラム31の総合的な制御下でデータ記憶媒体22に記憶されている多様なプログラムを実行する。本実施形態の動作のさらに詳細な説明は図2と図3に関してここで行われる。

【0027】

図2に関して、ステップ2.2で新しいビデオ画像が画像キャプチャ装置12から受信され、該装置から受信されるビデオシーケンスの一部を形成する。この説明のために、過去の画像が受信された、及びオブジェクトがその中で過去に検出され、追跡されたと仮定する。シーケンスの第1の画像が受信されるときの起動動作の簡単な説明が以下に示される。

【0028】

ステップ2.2に続いて、実行される第1の処理は、関心のあるオブジェクト(おもに移動するオブジェクト)が入力画像内で検出される必要がある、「セグメンテーション」として一般的に知られているプロセスである。「人の集団を追跡すること(Tracking Groups of People)」、コンピュータビジョンと画像の理解、80、42−56、2000、McKennaらによって、あるいは「リアルタイムのロバストなバックグランド除去技法及び陰影検出のための統計的な手法(A Statistical Approach for Real−time Robust Background Subtraction and Shadow Detection)」、IEEE ICCV’99 FRAME_RATEワークショップでHorprasetらによって説明されているもの等のすでに公知のセグメンテーション手順が使用されてよい。しかしながら、代わりに、及び好ましくはこれとともに同時に出願され、英国出願第0326374.4号からの優先権を主張する本出願人の同時係属国際特許出願に説明されるようなオブジェクト検出技法も使用されてよい。どちらの技法が利用されようとも、ステップ2.4ではオブジェクト検出は、推定上個々のオブジェクトに属しているすべてのピクセルをそれぞれのブロブにリンクするためにオブジェクト検出プログラム26によって実行される。

【0029】

次に以下のステップの目的は、オブジェクトを表現するそれぞれのブロブを、検出されたオブジェクトの特徴ベクトルを時間的なテンプレート(オブジェクトモデル)と比較することにより場面内でのそれらの動きを通して時間的に追跡することである。オブジェクトテンプレートの内容は後述される。

【0030】

本実施形態では、各検出されたオブジェクト(候補ブロブ)の速度、形状、及び色を説明する5つの重要な特徴の集合が使用されている。つまり、

速度v=その中心軌跡(px、py)での(vx、vy)

含まれているサイズ、またはピクセル数(s)

ブロブに最も適合する楕円(r)の長軸対短軸の比率−楕円のこの比率はその境界ボックスの縦横比よりオブジェクトをよく記述する。

楕円の主軸の向き(θ)及び

ブロブの凝集ピクセルの色共分散行列の主要な固有ベクトルを使用する有力な色の表現(cp)

ステップ2.6では、特徴抽出プログラム32が、前記に概略されたように、オブジェクトマッチング特性を検出するために動作する。つまり(p’kx、p’ky)を中心とするフレームt+1の中の候補ブロブkについて、特徴ベクトルBk(t+1)=(v’k、s’k、r’k、θ’k、c’p)が検出される。それぞれの特徴ベクトルが本入力フレームt+1の中の検出されたオブジェクトごとに求められることに留意せよ。候補ブロブkの速度は、以下のように計算される。

【0031】

v’k=(p’kx、p’ky)T−(p’lx、p’ly)T

rとθを求めるための楕円の適合は、Fitzgibbon,A.W及びFisher,R.B.、「円錐フィッティングのバイヤーガイド(A buyer’s guide to conic fitting)」、会議録、第5回英国マシンビジョン会議、バーミンガム、513−522ページ(1995年)に説明されるように実行されてよい。cを求める方法の説明については、Zhou Q.及びAggarwal,J.K.、「ビデオから移動するオブジェクトを追跡し、分類すること(Tracking and classifying moving objects from video)」、会議録、追跡と監視の性能評価に関する第2回IEEE国際ワークショップ(PETS2001年)、米国、ハワイ、カウアイ(2001年12月)を参照されたい。

【0032】

検出されたオブジェクトの特徴ベクトルを計算すると、記憶されているオブジェクトテンプレートにより表現される追跡されているオブジェクトに検出されたオブジェクトをマッチングすることを開始できる。さらに詳細には、及び図3に図示されているように、入力画像により表現されている場面の中で過去に追跡されたことのある関心のある各オブジェクトは、永続的な特性の時間テンプレートによってモデリングされる。任意の時間tで、追跡されたオブジェクト/(plx、ply)を中心とするそれぞれに特徴のテンプレートを有する。

【0033】

Ml(t)=(vl、sl、vl、θl、cp)

それらのオブジェクトモデル(またはテンプレート)は、オブジェクトモデル領域24の中のデータ記憶媒体22に記憶されている。

【0034】

特徴ベクトルBk(t+1)=(v’k、s’k、r’k、θ’k、c’p)と、(p’kx、p’ky)を中心とするフレームt+1の中の候補ブロブkを有するテンプレートMlをマッチングする前に、カルマンフィルタが、それぞれ

【数5】

【0035】

のその新しい速度、サイズ、縦横比、向きを予測することによりテンプレートを更新するために使用される。ここでは、

【数6】

【0036】

がすでに予測され、記憶されていると仮定される。さらに、記憶されているオブジェクトモデルも平均

【数7】

【0037】

と分散vl(t)ベクトルを含む。つまりこれらの値は、フレームt+1の中の候補ブロブkがテンプレートと一致することが判明すると必ず更新される。したがって、ステップ2.8で、入力画像内のあらゆる検出されたオブジェクトに関して記憶されているオブジェクトテンプレートごとにマッチング距離の順序付きリストを生成するFOR処理ループを開始するマッチング距離計算プログラム36が起動される。さらに詳細には、ステップ2.8の第1の反復時に、最初に記憶されているオブジェクトテンプレートが選択され、その特徴ベクトルが取り出される。次に、ステップ2.10では、あらゆる検出されたオブジェクトの特徴ベクトルを通るために動作する第2のネスト化されたFOR処理ループが開始され、ステップ2.12に従って各集合を処理する。ステップ2.12では、それぞれのマッチング特徴を比較することによって本オブジェクトテンプレートと処理されている本検出されたオブジェクトの間でマッチング距離値が計算されてその間のマッチング距離を求める。ステップ2.12で適用されるマッチング関数の追加の詳細は次に示される。

【0038】

明らかに、他が雑音の影響をより受けやすい一方、あるオブジェクトについていくつかの特徴はより永続的である。また、異なる特徴は通常異なる分散を有する異なる範囲内で値を取る。ユークリッド距離は、距離測度を支配するためにより大きなスケールと分散を有する次元を可能にするであろうため、これらの要因を考慮しない。

【0039】

この問題に立ち向かう1つの方法は、特徴のスケーリングと分散だけではなく、共分散行列に基づく他の特徴の変分も考慮に入れるマハラノビスの距離メトリックを使用することである。したがって、相関する特徴がある場合、それらの貢献は適切に加重される。代替実施形態では、このような距離メトリックが利用されてよい。

【0040】

しかしながら、高次元データでは、共分散行列は不可逆となる場合がある。さらに行列反転はコンピュータ的に高価なプロセスであり、リアルタイム演算に適していない。したがって本実施形態では、テンプレート

【数8】

【0041】

と候補ブロブkの間の、方程式(2)に示されているスケーリングされたユークリッド距離が採用される。異種データセットの場合、これが妥当な距離定義であり、

【数9】

【0042】

ここでは、xliとykiは、それぞれテンプレート

【数10】

【0043】

と特徴ベクトルBkのスカラー要素であり、

【数11】

【0044】

は分散ベクトルvl(t)の対応する成分であり、指数iはテンプレートのすべての特徴を通る。方程式(2)が特徴の間に相関がないケースでマハラノビスの距離によって出されるのと同じ結果であり、そのために共分散行列が対角行列になることに留意せよ。したがって、方程式(2)は、特徴が無相関であると仮定することによって簡略化を表現する。この公式化の1つの例外が色である。これは色距離

【数12】

【0045】

を計算し、(xli−yki)の代わりにこれを使用することにより処理される。対応する分散σliは

【数13】

【0046】

の分散である。

【0047】

ステップ2.12に続いて、ステップ2.14では、検出されたオブジェクトのすべてが処理されている本オブジェクトテンプレートと対照してマッチングされたかどうか、つまり内側FORループが完了したかどうかの判断が実行される。マッチングされていない場合には、次に検出されたオブジェクトが選択され、内側FORループが繰り返される。マッチングされた場合には、処理はS2.16に進む。

【0048】

ステップ2.16ではこの処理の状態は、あらゆる検出されたオブジェクトを、現在処理中の記憶されているオブジェクトテンプレートにマッチングするマッチング距離のリストが得られたが、このリストが順序付けられておらず、距離測度値が妥当であるかどうかを判断するためにチェックもされていないということである。これに鑑みて、ステップ2.16では、リスト中の距離値に閾値が適用され、閾値を上回るそれらの値はリストから取り除かれる。10というTHR値が実際に機能することが判明したが、他の値も有効でなければならない。閾値化演算に続き、ステップ2.18では、結果として生じる閾値化されたリストが、標準ソートルーチンを使用して距離値をマッチングすることにより順序付けられる。

【0049】

次に、ステップ2.20は記憶されているオブジェクトテンプレートのすべてが処理されたかどうか、つまり外側FORループが終了したかどうかをチェックする。処理されていない場合、次のオブジェクトテンプレートが選択され、外側FORループと内側FORループが繰り返される。処理されている場合、処理はS.2.22に進む。

【0050】

処理のこの段階で、作業データ領域30の中に、記憶されているオブジェクトモデルごとに1つマッチング距離のそれぞれの順序付きリストを記憶した。これらの順序付きリストを使用すると、記憶されているオブジェクトモデルに検出されたモデルをマッチングすることは可能であり、これは次に実行される。

【0051】

さらに詳細には、ステップ2.22では、順に、それぞれの記憶されているオブジェクトテンプレートに対して処理ステップを実行するために再び動作する第2のFOR処理ループが開始される。特に、ステップ2.24で第1に、処理されているオブジェクトモデルが使用可能な一致を有するかどうかを判断するための評価が実行される。一致は、本オブジェクトモデルの順序付きリストの中の最低のマッチング距離値を与えた検出されたオブジェクトとなされる。過去に実行された閾値化ステップのために、本オブジェクトモデルの順序付きリストの中にマッチング距離値がない場合には一致は利用できない。

【0052】

ステップ2.24の評価が真で戻ると、つまりテンプレート予測

【数14】

【0053】

分散ベクトルvl(t)及びBk(t+1)を手段として本オブジェクトlがフレームt+1の中の候補ブロブkによってマッチングされると、処理はステップ2.26に進み、本オブジェクトモデルIのための更新が実行される。特に、本オブジェクトのためのオブジェクトテンプレートは、平均と分散

【数15】

【0054】

だけではなくM1(t+1)=Bk(t+1)も得るためにオブジェクトモデル更新プログラム34によって更新される。これらのベクトルは、オブジェクトがマッチングした最新の対応するL個のブロブ、またはL個のフレーム(例えばL=50)の時間ウィンドウを使用して計算される。追跡されているオブジェクトごとのテンプレートはそれぞれ次のフレームの中に(主要な色を除く)各特徴の予想値を予測する関連カルマンフィルタの集合を有する。ステップ2.28では、オブジェクトモデルのためのカルマンフィルタKFl(t)も、予測フィルタプログラム38を使用してマッチングされた検出されたオブジェクトの値を入れることによって更新され、次の入力フレームと使用するためのオブジェクトモデルの特徴の予測値

【数16】

【0055】

が求められ、記憶される。さらに、ステップ2.30では、オブジェクトが追跡されたフレーム数を表す「TK_counts」カウンタ値が1で増分され、オブジェクトのトラックが前の数個のフレームで一時的に失われた場合に設定された可能性がある「MS_counts」がステップ2.32でゼロに設定される。次にFORループは、記憶されたオブジェクトテンプレートのすべてが処理されたかどうかに関する評価で終了し、処理されていた場合には、処理は(後述される)ステップ2.56に進む。記憶されたオブジェクトテンプレートのすべてが処理されていなかった場合には、s.2.22のFORループが処理される次の記憶されたオブジェクトテンプレートで再開される。

【0056】

ステップ2.24に戻り、ここで、利用可能な一致があるかどうかの評価がマイナスを返すケースを考える。この場合、前述されたように、オブジェクトテンプレートの距離測度のリストに適用された閾値化のために、リスト内にはマッチング距離はない。つまり検出されたオブジェクトは閾値距離の中でオブジェクトテンプレートに一致しない。この場合、最初に処理はステップ2.36の評価に進み、本オブジェクトテンプレートのためのTK_countsが、それが、20等の値を取ることがある所定の値MIN_SEEN未満であるかどうかを判断するために評価される。TK_countsがMIN_SEEN未満である場合には、処理はステップ2.54に進み、本オブジェクトテンプレートはオブジェクトモデル記憶装置24から削除される。次に処理は、図上別のステップとして示されているが、現実には前述されたものと同一であるステップ2.34に進む。MIN_SEEN閾値のこの使用は、瞬間的なオブジェクトの移動と、一時的にセグメント化されてよいが、事実上追跡される適切なオブジェクトに対応していないアーチファクトブロブを無視するためである。

【0057】

ステップ2.36の評価が、TK_countsがMIN_SEEN閾値を超えることを示すと、ステップ2.38で閉塞があるかどうかの試験が次に実行される。本実施形態では、オブジェクトが場面に入る/場面からである領域に関する特別な経験則は使用されない。オブジェクトは画像の真中でただ出現する、あるいは消えるだけであるため、位置の規則は必要ない。したがって閉塞を取り扱うためには、経験則の使用は必須である。結果として、実施形態の中で、オブジェクトが検出されたオブジェクトとの一致を見つけることができないたびに、ステップ2.38で閉塞に関する試験が実行される。本オブジェクトの境界ボックスが何らかの他のオブジェクトの境界ボックスと重複する場合、ステップ2.40で評価によって決定されるように、ステップ2.42で両方のオブジェクトも「閉塞済み」と記される。次に処理は後述されるステップ2.48に進む。

【0058】

ステップ2.40に戻ると、閉塞試験が重複する他のテンプレートがない、つまり本オブジェクトが閉塞していないことを示すと、オブジェクトのトラッキングが失われたという結果が出される。したがって、処理は、ある特定のオブジェクトモデルのトラッキングが成功しなかった入力フレームの数のカウントを保つためにMS_countsカウンタが増分されるs.2.48に進む。ステップ2.50では、このカウントは、5等の値を取ってよい閾値MAX_LOSTに比較される。この評価が、カウンタが閾値以上であると示すと、オブジェクトのトラッキングが回復できないほど失われたという結論が出されるため、処理は、前記に説明されたように本オブジェクトモデルが削除されるステップ2.54に進む。

【0059】

しかしながら、ステップ2.50の評価が、カウンタがMAX_LOST未満であることを示すと、処理はステップ2.52に進み、オブジェクトモデルの分散値が、方程式(3)に従って調整される。

【数17】

【0060】

ここではδ=0.05が優れた選択である。分散のこの増加は、追跡者が予想外または突然の動きを経験した失われたオブジェクトを回復するのを支援する。

【0061】

ステップ2.52に続き、処理はステップ2.44に進む。このステップ2.44に、本オブジェクトモデルが閉塞されていると記されるステップ2.42から到達できることにも留意せよ。マッチングの誤差(error)は単に予測誤差(error)のために発生する可能性があるため、ステップ2.44では予測モデルは失われた追跡の考えられる回復を容易にするために変更される。したがって、MAX_LOST期間内では、特徴のテンプレートを更新するためにカルマンフィルタは使用されず、代わりにステップ2.44で、

【数18】

【0062】

のように記載する、特徴ごとに最後の50の正しい予測の平均が使用される。さらに、オブジェクトが閉塞されていると記されると、同じ更新が実行される。これは、最後の数個のフレーム内の小さな異常な動きが除去されるため、閉塞されたオブジェクトが平均化されたテンプレート予測を使用してさらによく追跡されるためである。位置の予測も閉塞ブロブ内で制約される。

【0063】

ステップ2.44に続き、処理はすでに説明されたステップ2.34の評価に進む。

【0064】

いったんステップ2.34の評価が、s.2.22で開始された処理ループに従ってあらゆるオブジェクトテンプレートが処理されたことを示すと、処理の現在の状態は、あらゆる記憶されてたオブジェクトモデルが、MAX_LOST期間内以外にマッチングされていない、閉塞済みと記されている検出されたオブジェクトとマッチングされたか、あるいは(MIN_SEEN期間内で検出された一致なしのために、あるいはオブジェクトが再取得されることなく超えられたMAX_LOST期間のためのどちらかで)オブジェクトモデル記憶装置24から削除されている。しかしながら、通常は現在のフレームの中で始めて画像場面内に表示されたばかりの新しいオブジェクトであるために、記憶されているオブジェクトモデルにマッチングされたことがない検出されたオブジェクトがまだ画像内にある可能性がある(例えば、側部から画像視界に歩いて入ってくる人物)。これらの不一致検出済みオブジェクトを考慮に入れるために、新しいオブジェクトモデルがインスタンス化され、オブジェクトモデル記憶装置に記憶されなければならない。

【0065】

これを達成するために、(いったんそれが、あらゆるオブジェクトテンプレートがs.2.22で開始した処理ループに従って処理されたことを示すと)ステップ2.34に続いて、処理はステップ2.56に進み、追加のFOR処理ループが開始され、今回は検出されたオブジェクトを処理する。処理ループ内では、実行される第1のステップは、処理中の本検出済みオブジェクトがオブジェクトモデルにマッチングされたかどうかをチェックする評価であるステップ2.58のものである。これが当てはまると、つまり本オブジェクトがマッチングされた場合には、検出されたオブジェクトに新しいオブジェクトモデルを作成する必要はないため、処理はステップ2.62に進む。ステップ2.62はステップ2.56で開始したFORループによってすべての検出されたオブジェクトが処理されたかどうかを判断し、処理されなかった場合には次に検出されたオブジェクトを処理するために処理をステップ2.56に戻す、あるいはすべての検出されたオブジェクトが処理されている場合はFORを終了する。

【0066】

しかしながら、本検出されたオブジェクトが記憶されているオブジェクトモデルとマッチングされなかった場合、新しいオブジェクトモデルがステップ2.60でインスタンス化され、記憶されなければならず、検出されたオブジェクトの特徴値をその初期値として取る。つまり、フレームt+1内の本検出されたオブジェクトkの場合、新しいオブジェクトテンプレートMk(t+1)がBk(t+1)から作成される。新しいオブジェクトのための初期の分散ベクトルvk(t+1)の選択はある程度の検討を必要とするが、適切な値はすでに場面内にある非常に類似したオブジェクトからコピーできる、あるいは設計のオプションとして正しく追跡されるオブジェクトの従来の統計的な分析によって得られる典型的な値から取ることができるかのどちらかである。新しいオブジェクトモデルはオブジェクトモデル記憶装置24に記憶されるため、次の入力画像が受信されると、突き合わせるために使用できる。

【0067】

ステップ2.60に続き、ステップ2.62のループ評価が前述されたように実行され、いったん検出されたオブジェクトのすべてがループによって処理されると、処理はステップ2.64に進むことができる。処理のこの段階で、記憶されているオブジェクトモデルのすべてが、MAX_LOST期間内に閉塞または失われた、あるいは削除されたと記された検出されたオブジェクトにマッチングされ、検出されたオブジェクトのすべては記憶されているオブジェクトモデルにマッチングされたか、あるいはその点で作成された新しいオブジェクトモデルを有していた。したがって、この時点で、検出されたオブジェクトと記憶されているオブジェクトモデルの間で検出された一致を示す、及び画像内で追跡されたオブジェクトの位置を示すトラッキングデータを出力することが可能である。したがって、ステップ2.64では、TK_countsカウンタがMIN_SEEN閾値を上回る記憶されているオブジェクトテンプレートごとに検出された一致を示すトラッキング出力が提供される。前述されたように、MIN_SEEN閾値を使用すると、あらゆる短い瞬間的なオブジェクト移動を無視できるようになり、実際のオブジェクトに対応しないアーチファクトの一時的にセグメント化されたブロブも補償される。さらに、確かめたように、MIN_SEEN期間内にそれらが関係するオブジェクトのトラッキングが失われる(つまり、オブジェクトモデルがマッチングされない)と、オブジェクトモデルは削除される。もちろん、起動時には、記憶されているテンプレートはない。したがって、当初、検出されるすべてのオブジェクトは新しいオブジェクトであり、新しいテンプレートを作成するために図2(b)に従って処理される。

【0068】

実施形態の中では、図4と図5に示されているように、出力トラッキング情報が、画像の中のそれぞれの追跡されるオブジェクトの回りに目に見える境界ボックスを置くために画像を操作するために使用される。図4と図5は、時間的に分離されている約40フレームであるビデオシーケンスからの2つのフレームである(図5が後のフレームである)。これらの画像内では、オブジェクト参照番号を備えた境界ボックスが追跡されたオブジェクトの回りに置かれたことがわかり、図4を図5に比較することにより、場面の中のオブジェクトが、それらが(各画像内で同じ参照番号を有する各オブジェクトの回りの境界ボックスによってここで示されている)場面全体で移動するにつれて追跡されることが分かる。さらに、図5は、オブジェクト956として追跡される人の集団がオブジェクト787として追跡されるトラックによって閉塞されるが、各オブジェクトが依然として無事に追跡されているときに閉塞を処理する本発明の実施形態の能力を描いている。

【0069】

画像上に可視出力を提供することにより、オブジェクトが追跡されていることを単に示すだけではなく、本実施形態によって提供されるトラッキング情報も、オブジェクト分類アプリケーション等の追加のアプリケーションで利用されてよい。さらに、トラッキング情報は、それを利用してよい他のシステムにコンピュータ16(図1を参照されたい)のトラッキング出力40で出力されてよい。例えば、トラッキング情報は、オブジェクトが移動するときに装置が画像の中のある特定のオブジェクトに向けられたままであることを確実にするために、カメラや武器等の装置を制御するための装置ポインティングシステムに対する入力として使用されてよい。トラッキング情報の他の使用は当業者に明らかになるであろう。

【0070】

文脈上明らかに他の意味に解すべきではない場合、説明全体及び請求項では、ワード「備える」「備えている」等は排他的または包括的な意味とは対照的に含めた意味で解釈されなければならない。つまり、「含むが、限定されない」の意味である。

【図面の簡単な説明】

【0071】

【図1】本発明によるコンピュータシステムを描くシステムブロック図である。

【図2(a)】本発明の実施形態のトラッキング方法及びシステムの動作を描く流れ図である。

【図2(b)】本発明の実施形態のトラッキング方法及びシステムの動作を描く流れ図である。

【図3】本発明の実施形態で使用される検出されたオブジェクトブロブにマッチングされているオブジェクトテンプレートの概念を描く図である。

【図4】本発明の実施形態により実行されるトラッキングを示すビデオシーケンスのフレームである。

【図5】本発明により実行されるオブジェクトのトラッキングを再び描く、図4のフレームを含むビデオシーケンスの後のフレームである。

【技術分野】

【0001】

本発明はフレームごとにビデオ画像の中で検出されるオブジェクトを追跡する方法及びシステムに関する。

【背景技術】

【0002】

自動ビデオトラッキングアプリケーションは当技術分野において公知である。一般的にこのようなアプリケーションはビデオフレームを入力として受信し、多くの場合バックグラウンド除去技法を使用して、移動するオブジェクト等の画像内の関心のあるオブジェクトを検出するために動作する。単一の入力フレーム内でオブジェクトを検出すると、このようなアプリケーションは、検出されたオブジェクトの特性を使用してフレームごとに検出されたオブジェクトを追跡するために動作する。将来の入力フレームでオブジェクトを検出し、前記検出されたオブジェクトの特性を決定することにより、前記決定された特性をマッチングして、トラックを生じさせるために過去に検出されたオブジェクトとの将来検出されるオブジェクトのマッチングが可能である。前記を表す例の従来の技術のトラッキングアプリケーションは、Zhou Qらの「ビデオから移動するオブジェクトを追跡し、分類すること」会議録、PETSに関する第2回IEEE国際ワークショップ、2001年米国ハワイ、カウアイの中に説明されている。

【0003】

しかしながら、特性を使用するマッチングは、他の特徴が雑音により影響を受けやすい一方、いくつかの特徴がオブジェクトに対してより永続的であるためにいくつかの問題を提起する。また、異なる特徴は通常異なる分散のある異なる範囲内で値をとる。ユークリッド距離マッチング測度は、距離測度を支配するためにより大きなスケールと分散を有する次元を可能にするであろうため、これらの要因を考慮しない。

【発明の開示】

【0004】

本発明はそれぞれのマッチング特徴のスケーリングと分散を考慮に入れる、ビデオフレーム内でオブジェクトを追跡するためのオブジェクトトラッキング方法とシステムの提供により前記に対処する。これは、オブジェクト間で一致を決定するために可能な限り多くのマッチング特徴を使用することができ、このようにして決定されるマッチングの精度を高めることを確実にする一方で、マッチング特徴の選択である程度の自由度に備える。

【0005】

前記を鑑みて、第1の態様から、本発明は、

シーケンスの過去のビデオ画像で検出されたオブジェクトに関する1つまたは複数のオブジェクトモデルを記憶する段階であって、前記オブジェクトモデルが検出されたオブジェクトの特性の値とそれらの値の分散を備える段階と、

処理されるシーケンスの追加のビデオ画像を受信する段階と、

前記受信されたビデオ画像内で1または複数のオブジェクトを検出する段階と、

前記検出されたオブジェクトの特性を決定する段階と、

前記特性の少なくとも前記分散を考慮に入れる距離関数を使用して、前記それぞれの特性に基づいて各検出されたオブジェクトと各オブジェクトモデルの間で距離測度を計算する段階と、

前記計算された距離測度に基づいて前記オブジェクトモデルに前記検出されたオブジェクトをマッチングする段階と、

前記オブジェクトのトラックを提供するために、前記オブジェクトモデルを、それにマッチングされた前記それぞれの検出されたオブジェクトの特性を使用して更新する段階と、

を備える、ビデオ画像のシーケンス内でオブジェクトを追跡するための方法を提供する。

【0006】

特性の分散を考慮に入れる距離関数を使用することにより、他と比較されるときに前記一致する特性のいくつかのより大きなスケールと分散が補償されるため、一致を実行するために使用できるのと同じくらい多くの異なるマッチング特徴を使用する能力だけではなく、特徴の選択における柔軟度も与えられる。

【0007】

好ましい実施形態では、距離測度はスケーリングされたユークリッド距離である。これは、リアルタイム演算に適したコンピュータ的に安価なプロセスにより高次元データを処理できるという利点を提供する。好ましくは、距離関数は、オブジェクトモデルlと検出されたオブジェクトkについて以下の形をとり、

【数3】

【0008】

この場合指数iはオブジェクトモデルのN個の特徴すべてを通り、

【数4】

【0009】

は各特長の分散の対応する成分である。

【0010】

代替実施形態では、距離測度は、特徴のスケーリングと分散だけではなく、共分散行列に基づいた他の特徴の変分も考慮に入れるマハラノビスの距離である。したがって、相関する特徴がある場合、それらの寄与は適切に加重される。

【0011】

好ましくは、受信されるフレームについて記憶されているオブジェクトモデルの特性の値を予測する段階がさらに含まれ、前記計算段階は特性の予測値をオブジェクトモデルからの特徴値として使用する。この入信フレームとともに使用するためのオブジェクトモデルごとに特性の値を予測するために予測を使用することにより、オブジェクトモデルの検出されたオブジェクトに対するマッチングの精度を高めることができる。

【0012】

好ましい実施形態では、オブジェクトモデルが検出されたオブジェクトにマッチングされない場合、そのオブジェクトの特性値の分散が増加する。これは、それが追跡者が突然のまたは予想外の動きを経験する可能性がある失われたオブジェクトを回復するのを支援するという利点を提供する。

【0013】

好ましくは、オブジェクトモデルが受信された画像の検出されたオブジェクトにマッチングされない場合、更新段階は特性値を所定数の過去の画像で同じオブジェクトについて検出されたそれぞれの個別の値の平均で更新することを備える。これはオブジェクトの再取得(re-acquiring)を容易にするために予測モデルを変更することにより予測誤差(errors)の場合の補償に備える。

【0014】

さらに、好ましくはオブジェクトモデルが受信された画像の検出されたオブジェクトにマッチングされない場合、オブジェクトが別のオブジェクトと重なっていないかどうかを判断するために試験が実行され、重複が検出されるとオブジェクトは閉塞済みと見なされる。これは、最終的にはオブジェクトが失われたことを確認することにつながるであろうルーチンが開始される代わりに、オブジェクトが閉塞している場合には、追跡技法がこれをそのようなものとして認識し、オブジェクトトラックをただちに除去しないという点でオブジェクトのトラックにある程度の柔軟性を与える。

【0015】

さらに、該方法は好ましくは、各オブジェクトが追跡される連続ビデオ画像数をカウントすることと、オブジェクトが所定数の連続フレームの間追跡されると追跡が発生したことを示す追跡信号を出力することとをさらに備える。これにより瞬間的なオブジェクトの動きを無視することができる。

【0016】

さらに、オブジェクトモデルが受信された画像の検出されたオブジェクトにマッチングされない場合、好ましくはオブジェクトモデルがマッチングされない連続フレーム数のカウントが増分され、該方法は、前記カウントが所定数を超えるとオブジェクトモデルを削除することをさらに備える。これにより、背景と融合してしまった静止オブジェクト及び視界を離れてしまったオブジェクトを、このようなオブジェクトに関係する記憶されているオブジェクトモデルを取り除くことによって無視できるようにし、このようにして技法の計算効率を維持し、リアルタイム機能に貢献する。

【0017】

最後に、検出されたオブジェクトがオブジェクトモデルにマッチングされない場合、好ましくは新しいオブジェクトモデルが検出されたオブジェクトに対応して記憶される。これにより、新しいオブジェクトは画像キャプチャ装置の視界に入り、以後追跡されることが可能になる。

【0018】

第2の態様から、本発明は、

シーケンスの過去のビデオ画像で検出されたオブジェクトに関係する、検出されたオブジェクトの特性の値とそれらの値の分散を備える1または複数のオブジェクトモデルを記憶するための記憶手段と、

処理されるシーケンスの追加のビデオ画像を受信するための手段と、

使用時に、

受信されたビデオ画像の中の1または複数のオブジェクトを検出し、

前記検出されたオブジェクトの特性を決定し、

該特性の少なくとも分散を考慮に入れる距離関数を使用してそれぞれの特性に基づいて各検出されたオブジェクトと各オブジェクトモデルの間の距離測度を計算し、

前記計算された距離測度に基づいてオブジェクトモデルに検出されたオブジェクトをマッチングし、

記憶されたオブジェクトモデルを、それにマッチングされたそれぞれの検出されたオブジェクトの特性を使用して更新するように

構成された、使用中の処理手段と、

を備える、ビデオ画像のシーケンス内のオブジェクトを追跡するためのシステムも提供する。

【0019】

第2の態様の中では、第1の態様に関して前述されたのと同じ利点と同じ追加の特徴と利点が得られる。

【0020】

第3の態様から、本発明は、コンピュータシステム上での実行時に、プログラムまたはプログラムのセットにより前記コンピュータシステムが第1の態様の方法を実行するように構成されるコンピュータプログラムまたはプログラムのセットも提供する。さらに、追加の態様から、第3の態様に従ってコンピュータプログラムまたはプログラムのセットを記憶するコンピュータ読み取り可能記憶媒体も提供される。コンピュータ読み取り可能記憶媒体は、限定されない例として、磁気ディスク、DVD、ソリッドステートメモリ、光ディスク、光磁気ディスク等のどれかのような当技術分野において公知の適切なデータ記憶装置または媒体であってよい。

【0021】

本発明の追加の特徴及び利点は、例証としてのみ提示されているその実施形態の以下の説明から、及び添付図面を参照することにより明らかになるであろう

【発明を実施するための最良の形態】

【0022】

本発明の実施形態は、ここで図及び示されている実施形態の動作の例に関して説明される。

【0023】

図1は、本発明の実施形態を提供する例のシステムアーキテクチャを描く。さらに詳細には、本発明は概して入力された画像の中でオブジェクトを追跡するための画像処理技法に関するため、本発明はおもにコンピュータ上で実行されるソフトウェアとして具現化される。したがって、本発明のシステムアーキテクチャは、当技術分野において周知であるように汎用コンピュータ16を備える。コンピュータ16は、コンピュータによって生成される出力画像がユーザに表示されてよいディスプレイ20を備え、さらにキーボード、マウス等の多様なユーザ入力装置18を備えている。汎用コンピュータ16は、プログラム、及び本発明の実施形態により生成されるデータが記憶されるハードディスク、メモリ、光ディスク等のデータ記憶媒体22も備えている。出力インタフェース40はさらにコンピュータ16によって提供され出力インタフェース40から、コンピュータによって画像内で追跡されるオブジェクトに関係するトラッキングデータが、このようなデータを利用してよい他の装置に出力されてよい。

【0024】

データ記憶媒体22上には、記憶されているオブジェクトモデル(テンプレート)に対応するデータ24、入力画像に対応するデータ28、及び画像データ、計算結果、及び本発明の動作中に中間記憶装置として使用される他のデータ構造または変数等の作業データに対応するデータ30が記憶されている。さらに、データ記憶媒体22には、制御プログラム31、特徴抽出プログラム32、マッチング距離計算プログラム36、オブジェクト検出プログラム26、オブジェクトモデル更新プログラム34、及び予測フィルタプログラム38等のプログラムの形をとる実行可能なプログラムコードが記憶されている。これらのプログラムのそれぞれの動作は後述される。

【0025】

実施形態の動作を容易にするために、コンピュータ16は、カメラ等の画像キャプチャ装置12から画像を受信するように構成されている。画像キャプチャ装置12はコンピュータ16に直接的に接続されてよい、あるいは代わりにインターネット等のネットワークを介してコンピュータ16に論理的に接続されてよい。画像キャプチャ装置12は、オブジェクトが検出され、追跡されなければならない場面の連続ビデオ画像を提供するように構成され、前記ビデオ画像は、特定の輝度特性とクロミナンス特性を有するために特定の値を取るピクチャエレメント(ピクセル)から構成されている。画像キャプチャ装置12から出力されるピクセルのために使用されるカラーモデルは、RGB、YUV等当技術分野において公知のものであってよい。

【0026】

動作中、汎用コンピュータ16はネットワークを介して、または直接的に画像キャプチャ装置12から画像を受信し、受信された画像の中のオブジェクトを追跡するために受信された入力画像を処理するように制御プログラム31の総合的な制御下でデータ記憶媒体22に記憶されている多様なプログラムを実行する。本実施形態の動作のさらに詳細な説明は図2と図3に関してここで行われる。

【0027】

図2に関して、ステップ2.2で新しいビデオ画像が画像キャプチャ装置12から受信され、該装置から受信されるビデオシーケンスの一部を形成する。この説明のために、過去の画像が受信された、及びオブジェクトがその中で過去に検出され、追跡されたと仮定する。シーケンスの第1の画像が受信されるときの起動動作の簡単な説明が以下に示される。

【0028】

ステップ2.2に続いて、実行される第1の処理は、関心のあるオブジェクト(おもに移動するオブジェクト)が入力画像内で検出される必要がある、「セグメンテーション」として一般的に知られているプロセスである。「人の集団を追跡すること(Tracking Groups of People)」、コンピュータビジョンと画像の理解、80、42−56、2000、McKennaらによって、あるいは「リアルタイムのロバストなバックグランド除去技法及び陰影検出のための統計的な手法(A Statistical Approach for Real−time Robust Background Subtraction and Shadow Detection)」、IEEE ICCV’99 FRAME_RATEワークショップでHorprasetらによって説明されているもの等のすでに公知のセグメンテーション手順が使用されてよい。しかしながら、代わりに、及び好ましくはこれとともに同時に出願され、英国出願第0326374.4号からの優先権を主張する本出願人の同時係属国際特許出願に説明されるようなオブジェクト検出技法も使用されてよい。どちらの技法が利用されようとも、ステップ2.4ではオブジェクト検出は、推定上個々のオブジェクトに属しているすべてのピクセルをそれぞれのブロブにリンクするためにオブジェクト検出プログラム26によって実行される。

【0029】

次に以下のステップの目的は、オブジェクトを表現するそれぞれのブロブを、検出されたオブジェクトの特徴ベクトルを時間的なテンプレート(オブジェクトモデル)と比較することにより場面内でのそれらの動きを通して時間的に追跡することである。オブジェクトテンプレートの内容は後述される。

【0030】

本実施形態では、各検出されたオブジェクト(候補ブロブ)の速度、形状、及び色を説明する5つの重要な特徴の集合が使用されている。つまり、

速度v=その中心軌跡(px、py)での(vx、vy)

含まれているサイズ、またはピクセル数(s)

ブロブに最も適合する楕円(r)の長軸対短軸の比率−楕円のこの比率はその境界ボックスの縦横比よりオブジェクトをよく記述する。

楕円の主軸の向き(θ)及び

ブロブの凝集ピクセルの色共分散行列の主要な固有ベクトルを使用する有力な色の表現(cp)

ステップ2.6では、特徴抽出プログラム32が、前記に概略されたように、オブジェクトマッチング特性を検出するために動作する。つまり(p’kx、p’ky)を中心とするフレームt+1の中の候補ブロブkについて、特徴ベクトルBk(t+1)=(v’k、s’k、r’k、θ’k、c’p)が検出される。それぞれの特徴ベクトルが本入力フレームt+1の中の検出されたオブジェクトごとに求められることに留意せよ。候補ブロブkの速度は、以下のように計算される。

【0031】

v’k=(p’kx、p’ky)T−(p’lx、p’ly)T

rとθを求めるための楕円の適合は、Fitzgibbon,A.W及びFisher,R.B.、「円錐フィッティングのバイヤーガイド(A buyer’s guide to conic fitting)」、会議録、第5回英国マシンビジョン会議、バーミンガム、513−522ページ(1995年)に説明されるように実行されてよい。cを求める方法の説明については、Zhou Q.及びAggarwal,J.K.、「ビデオから移動するオブジェクトを追跡し、分類すること(Tracking and classifying moving objects from video)」、会議録、追跡と監視の性能評価に関する第2回IEEE国際ワークショップ(PETS2001年)、米国、ハワイ、カウアイ(2001年12月)を参照されたい。

【0032】

検出されたオブジェクトの特徴ベクトルを計算すると、記憶されているオブジェクトテンプレートにより表現される追跡されているオブジェクトに検出されたオブジェクトをマッチングすることを開始できる。さらに詳細には、及び図3に図示されているように、入力画像により表現されている場面の中で過去に追跡されたことのある関心のある各オブジェクトは、永続的な特性の時間テンプレートによってモデリングされる。任意の時間tで、追跡されたオブジェクト/(plx、ply)を中心とするそれぞれに特徴のテンプレートを有する。

【0033】

Ml(t)=(vl、sl、vl、θl、cp)

それらのオブジェクトモデル(またはテンプレート)は、オブジェクトモデル領域24の中のデータ記憶媒体22に記憶されている。

【0034】

特徴ベクトルBk(t+1)=(v’k、s’k、r’k、θ’k、c’p)と、(p’kx、p’ky)を中心とするフレームt+1の中の候補ブロブkを有するテンプレートMlをマッチングする前に、カルマンフィルタが、それぞれ

【数5】

【0035】

のその新しい速度、サイズ、縦横比、向きを予測することによりテンプレートを更新するために使用される。ここでは、

【数6】

【0036】

がすでに予測され、記憶されていると仮定される。さらに、記憶されているオブジェクトモデルも平均

【数7】

【0037】

と分散vl(t)ベクトルを含む。つまりこれらの値は、フレームt+1の中の候補ブロブkがテンプレートと一致することが判明すると必ず更新される。したがって、ステップ2.8で、入力画像内のあらゆる検出されたオブジェクトに関して記憶されているオブジェクトテンプレートごとにマッチング距離の順序付きリストを生成するFOR処理ループを開始するマッチング距離計算プログラム36が起動される。さらに詳細には、ステップ2.8の第1の反復時に、最初に記憶されているオブジェクトテンプレートが選択され、その特徴ベクトルが取り出される。次に、ステップ2.10では、あらゆる検出されたオブジェクトの特徴ベクトルを通るために動作する第2のネスト化されたFOR処理ループが開始され、ステップ2.12に従って各集合を処理する。ステップ2.12では、それぞれのマッチング特徴を比較することによって本オブジェクトテンプレートと処理されている本検出されたオブジェクトの間でマッチング距離値が計算されてその間のマッチング距離を求める。ステップ2.12で適用されるマッチング関数の追加の詳細は次に示される。

【0038】

明らかに、他が雑音の影響をより受けやすい一方、あるオブジェクトについていくつかの特徴はより永続的である。また、異なる特徴は通常異なる分散を有する異なる範囲内で値を取る。ユークリッド距離は、距離測度を支配するためにより大きなスケールと分散を有する次元を可能にするであろうため、これらの要因を考慮しない。

【0039】

この問題に立ち向かう1つの方法は、特徴のスケーリングと分散だけではなく、共分散行列に基づく他の特徴の変分も考慮に入れるマハラノビスの距離メトリックを使用することである。したがって、相関する特徴がある場合、それらの貢献は適切に加重される。代替実施形態では、このような距離メトリックが利用されてよい。

【0040】

しかしながら、高次元データでは、共分散行列は不可逆となる場合がある。さらに行列反転はコンピュータ的に高価なプロセスであり、リアルタイム演算に適していない。したがって本実施形態では、テンプレート

【数8】

【0041】

と候補ブロブkの間の、方程式(2)に示されているスケーリングされたユークリッド距離が採用される。異種データセットの場合、これが妥当な距離定義であり、

【数9】

【0042】

ここでは、xliとykiは、それぞれテンプレート

【数10】

【0043】

と特徴ベクトルBkのスカラー要素であり、

【数11】

【0044】

は分散ベクトルvl(t)の対応する成分であり、指数iはテンプレートのすべての特徴を通る。方程式(2)が特徴の間に相関がないケースでマハラノビスの距離によって出されるのと同じ結果であり、そのために共分散行列が対角行列になることに留意せよ。したがって、方程式(2)は、特徴が無相関であると仮定することによって簡略化を表現する。この公式化の1つの例外が色である。これは色距離

【数12】

【0045】

を計算し、(xli−yki)の代わりにこれを使用することにより処理される。対応する分散σliは

【数13】

【0046】

の分散である。

【0047】

ステップ2.12に続いて、ステップ2.14では、検出されたオブジェクトのすべてが処理されている本オブジェクトテンプレートと対照してマッチングされたかどうか、つまり内側FORループが完了したかどうかの判断が実行される。マッチングされていない場合には、次に検出されたオブジェクトが選択され、内側FORループが繰り返される。マッチングされた場合には、処理はS2.16に進む。

【0048】

ステップ2.16ではこの処理の状態は、あらゆる検出されたオブジェクトを、現在処理中の記憶されているオブジェクトテンプレートにマッチングするマッチング距離のリストが得られたが、このリストが順序付けられておらず、距離測度値が妥当であるかどうかを判断するためにチェックもされていないということである。これに鑑みて、ステップ2.16では、リスト中の距離値に閾値が適用され、閾値を上回るそれらの値はリストから取り除かれる。10というTHR値が実際に機能することが判明したが、他の値も有効でなければならない。閾値化演算に続き、ステップ2.18では、結果として生じる閾値化されたリストが、標準ソートルーチンを使用して距離値をマッチングすることにより順序付けられる。

【0049】

次に、ステップ2.20は記憶されているオブジェクトテンプレートのすべてが処理されたかどうか、つまり外側FORループが終了したかどうかをチェックする。処理されていない場合、次のオブジェクトテンプレートが選択され、外側FORループと内側FORループが繰り返される。処理されている場合、処理はS.2.22に進む。

【0050】

処理のこの段階で、作業データ領域30の中に、記憶されているオブジェクトモデルごとに1つマッチング距離のそれぞれの順序付きリストを記憶した。これらの順序付きリストを使用すると、記憶されているオブジェクトモデルに検出されたモデルをマッチングすることは可能であり、これは次に実行される。

【0051】

さらに詳細には、ステップ2.22では、順に、それぞれの記憶されているオブジェクトテンプレートに対して処理ステップを実行するために再び動作する第2のFOR処理ループが開始される。特に、ステップ2.24で第1に、処理されているオブジェクトモデルが使用可能な一致を有するかどうかを判断するための評価が実行される。一致は、本オブジェクトモデルの順序付きリストの中の最低のマッチング距離値を与えた検出されたオブジェクトとなされる。過去に実行された閾値化ステップのために、本オブジェクトモデルの順序付きリストの中にマッチング距離値がない場合には一致は利用できない。

【0052】

ステップ2.24の評価が真で戻ると、つまりテンプレート予測

【数14】

【0053】

分散ベクトルvl(t)及びBk(t+1)を手段として本オブジェクトlがフレームt+1の中の候補ブロブkによってマッチングされると、処理はステップ2.26に進み、本オブジェクトモデルIのための更新が実行される。特に、本オブジェクトのためのオブジェクトテンプレートは、平均と分散

【数15】

【0054】

だけではなくM1(t+1)=Bk(t+1)も得るためにオブジェクトモデル更新プログラム34によって更新される。これらのベクトルは、オブジェクトがマッチングした最新の対応するL個のブロブ、またはL個のフレーム(例えばL=50)の時間ウィンドウを使用して計算される。追跡されているオブジェクトごとのテンプレートはそれぞれ次のフレームの中に(主要な色を除く)各特徴の予想値を予測する関連カルマンフィルタの集合を有する。ステップ2.28では、オブジェクトモデルのためのカルマンフィルタKFl(t)も、予測フィルタプログラム38を使用してマッチングされた検出されたオブジェクトの値を入れることによって更新され、次の入力フレームと使用するためのオブジェクトモデルの特徴の予測値

【数16】

【0055】

が求められ、記憶される。さらに、ステップ2.30では、オブジェクトが追跡されたフレーム数を表す「TK_counts」カウンタ値が1で増分され、オブジェクトのトラックが前の数個のフレームで一時的に失われた場合に設定された可能性がある「MS_counts」がステップ2.32でゼロに設定される。次にFORループは、記憶されたオブジェクトテンプレートのすべてが処理されたかどうかに関する評価で終了し、処理されていた場合には、処理は(後述される)ステップ2.56に進む。記憶されたオブジェクトテンプレートのすべてが処理されていなかった場合には、s.2.22のFORループが処理される次の記憶されたオブジェクトテンプレートで再開される。

【0056】

ステップ2.24に戻り、ここで、利用可能な一致があるかどうかの評価がマイナスを返すケースを考える。この場合、前述されたように、オブジェクトテンプレートの距離測度のリストに適用された閾値化のために、リスト内にはマッチング距離はない。つまり検出されたオブジェクトは閾値距離の中でオブジェクトテンプレートに一致しない。この場合、最初に処理はステップ2.36の評価に進み、本オブジェクトテンプレートのためのTK_countsが、それが、20等の値を取ることがある所定の値MIN_SEEN未満であるかどうかを判断するために評価される。TK_countsがMIN_SEEN未満である場合には、処理はステップ2.54に進み、本オブジェクトテンプレートはオブジェクトモデル記憶装置24から削除される。次に処理は、図上別のステップとして示されているが、現実には前述されたものと同一であるステップ2.34に進む。MIN_SEEN閾値のこの使用は、瞬間的なオブジェクトの移動と、一時的にセグメント化されてよいが、事実上追跡される適切なオブジェクトに対応していないアーチファクトブロブを無視するためである。

【0057】

ステップ2.36の評価が、TK_countsがMIN_SEEN閾値を超えることを示すと、ステップ2.38で閉塞があるかどうかの試験が次に実行される。本実施形態では、オブジェクトが場面に入る/場面からである領域に関する特別な経験則は使用されない。オブジェクトは画像の真中でただ出現する、あるいは消えるだけであるため、位置の規則は必要ない。したがって閉塞を取り扱うためには、経験則の使用は必須である。結果として、実施形態の中で、オブジェクトが検出されたオブジェクトとの一致を見つけることができないたびに、ステップ2.38で閉塞に関する試験が実行される。本オブジェクトの境界ボックスが何らかの他のオブジェクトの境界ボックスと重複する場合、ステップ2.40で評価によって決定されるように、ステップ2.42で両方のオブジェクトも「閉塞済み」と記される。次に処理は後述されるステップ2.48に進む。

【0058】

ステップ2.40に戻ると、閉塞試験が重複する他のテンプレートがない、つまり本オブジェクトが閉塞していないことを示すと、オブジェクトのトラッキングが失われたという結果が出される。したがって、処理は、ある特定のオブジェクトモデルのトラッキングが成功しなかった入力フレームの数のカウントを保つためにMS_countsカウンタが増分されるs.2.48に進む。ステップ2.50では、このカウントは、5等の値を取ってよい閾値MAX_LOSTに比較される。この評価が、カウンタが閾値以上であると示すと、オブジェクトのトラッキングが回復できないほど失われたという結論が出されるため、処理は、前記に説明されたように本オブジェクトモデルが削除されるステップ2.54に進む。

【0059】

しかしながら、ステップ2.50の評価が、カウンタがMAX_LOST未満であることを示すと、処理はステップ2.52に進み、オブジェクトモデルの分散値が、方程式(3)に従って調整される。

【数17】

【0060】

ここではδ=0.05が優れた選択である。分散のこの増加は、追跡者が予想外または突然の動きを経験した失われたオブジェクトを回復するのを支援する。

【0061】

ステップ2.52に続き、処理はステップ2.44に進む。このステップ2.44に、本オブジェクトモデルが閉塞されていると記されるステップ2.42から到達できることにも留意せよ。マッチングの誤差(error)は単に予測誤差(error)のために発生する可能性があるため、ステップ2.44では予測モデルは失われた追跡の考えられる回復を容易にするために変更される。したがって、MAX_LOST期間内では、特徴のテンプレートを更新するためにカルマンフィルタは使用されず、代わりにステップ2.44で、

【数18】

【0062】

のように記載する、特徴ごとに最後の50の正しい予測の平均が使用される。さらに、オブジェクトが閉塞されていると記されると、同じ更新が実行される。これは、最後の数個のフレーム内の小さな異常な動きが除去されるため、閉塞されたオブジェクトが平均化されたテンプレート予測を使用してさらによく追跡されるためである。位置の予測も閉塞ブロブ内で制約される。

【0063】

ステップ2.44に続き、処理はすでに説明されたステップ2.34の評価に進む。

【0064】

いったんステップ2.34の評価が、s.2.22で開始された処理ループに従ってあらゆるオブジェクトテンプレートが処理されたことを示すと、処理の現在の状態は、あらゆる記憶されてたオブジェクトモデルが、MAX_LOST期間内以外にマッチングされていない、閉塞済みと記されている検出されたオブジェクトとマッチングされたか、あるいは(MIN_SEEN期間内で検出された一致なしのために、あるいはオブジェクトが再取得されることなく超えられたMAX_LOST期間のためのどちらかで)オブジェクトモデル記憶装置24から削除されている。しかしながら、通常は現在のフレームの中で始めて画像場面内に表示されたばかりの新しいオブジェクトであるために、記憶されているオブジェクトモデルにマッチングされたことがない検出されたオブジェクトがまだ画像内にある可能性がある(例えば、側部から画像視界に歩いて入ってくる人物)。これらの不一致検出済みオブジェクトを考慮に入れるために、新しいオブジェクトモデルがインスタンス化され、オブジェクトモデル記憶装置に記憶されなければならない。

【0065】

これを達成するために、(いったんそれが、あらゆるオブジェクトテンプレートがs.2.22で開始した処理ループに従って処理されたことを示すと)ステップ2.34に続いて、処理はステップ2.56に進み、追加のFOR処理ループが開始され、今回は検出されたオブジェクトを処理する。処理ループ内では、実行される第1のステップは、処理中の本検出済みオブジェクトがオブジェクトモデルにマッチングされたかどうかをチェックする評価であるステップ2.58のものである。これが当てはまると、つまり本オブジェクトがマッチングされた場合には、検出されたオブジェクトに新しいオブジェクトモデルを作成する必要はないため、処理はステップ2.62に進む。ステップ2.62はステップ2.56で開始したFORループによってすべての検出されたオブジェクトが処理されたかどうかを判断し、処理されなかった場合には次に検出されたオブジェクトを処理するために処理をステップ2.56に戻す、あるいはすべての検出されたオブジェクトが処理されている場合はFORを終了する。

【0066】

しかしながら、本検出されたオブジェクトが記憶されているオブジェクトモデルとマッチングされなかった場合、新しいオブジェクトモデルがステップ2.60でインスタンス化され、記憶されなければならず、検出されたオブジェクトの特徴値をその初期値として取る。つまり、フレームt+1内の本検出されたオブジェクトkの場合、新しいオブジェクトテンプレートMk(t+1)がBk(t+1)から作成される。新しいオブジェクトのための初期の分散ベクトルvk(t+1)の選択はある程度の検討を必要とするが、適切な値はすでに場面内にある非常に類似したオブジェクトからコピーできる、あるいは設計のオプションとして正しく追跡されるオブジェクトの従来の統計的な分析によって得られる典型的な値から取ることができるかのどちらかである。新しいオブジェクトモデルはオブジェクトモデル記憶装置24に記憶されるため、次の入力画像が受信されると、突き合わせるために使用できる。

【0067】

ステップ2.60に続き、ステップ2.62のループ評価が前述されたように実行され、いったん検出されたオブジェクトのすべてがループによって処理されると、処理はステップ2.64に進むことができる。処理のこの段階で、記憶されているオブジェクトモデルのすべてが、MAX_LOST期間内に閉塞または失われた、あるいは削除されたと記された検出されたオブジェクトにマッチングされ、検出されたオブジェクトのすべては記憶されているオブジェクトモデルにマッチングされたか、あるいはその点で作成された新しいオブジェクトモデルを有していた。したがって、この時点で、検出されたオブジェクトと記憶されているオブジェクトモデルの間で検出された一致を示す、及び画像内で追跡されたオブジェクトの位置を示すトラッキングデータを出力することが可能である。したがって、ステップ2.64では、TK_countsカウンタがMIN_SEEN閾値を上回る記憶されているオブジェクトテンプレートごとに検出された一致を示すトラッキング出力が提供される。前述されたように、MIN_SEEN閾値を使用すると、あらゆる短い瞬間的なオブジェクト移動を無視できるようになり、実際のオブジェクトに対応しないアーチファクトの一時的にセグメント化されたブロブも補償される。さらに、確かめたように、MIN_SEEN期間内にそれらが関係するオブジェクトのトラッキングが失われる(つまり、オブジェクトモデルがマッチングされない)と、オブジェクトモデルは削除される。もちろん、起動時には、記憶されているテンプレートはない。したがって、当初、検出されるすべてのオブジェクトは新しいオブジェクトであり、新しいテンプレートを作成するために図2(b)に従って処理される。

【0068】

実施形態の中では、図4と図5に示されているように、出力トラッキング情報が、画像の中のそれぞれの追跡されるオブジェクトの回りに目に見える境界ボックスを置くために画像を操作するために使用される。図4と図5は、時間的に分離されている約40フレームであるビデオシーケンスからの2つのフレームである(図5が後のフレームである)。これらの画像内では、オブジェクト参照番号を備えた境界ボックスが追跡されたオブジェクトの回りに置かれたことがわかり、図4を図5に比較することにより、場面の中のオブジェクトが、それらが(各画像内で同じ参照番号を有する各オブジェクトの回りの境界ボックスによってここで示されている)場面全体で移動するにつれて追跡されることが分かる。さらに、図5は、オブジェクト956として追跡される人の集団がオブジェクト787として追跡されるトラックによって閉塞されるが、各オブジェクトが依然として無事に追跡されているときに閉塞を処理する本発明の実施形態の能力を描いている。

【0069】

画像上に可視出力を提供することにより、オブジェクトが追跡されていることを単に示すだけではなく、本実施形態によって提供されるトラッキング情報も、オブジェクト分類アプリケーション等の追加のアプリケーションで利用されてよい。さらに、トラッキング情報は、それを利用してよい他のシステムにコンピュータ16(図1を参照されたい)のトラッキング出力40で出力されてよい。例えば、トラッキング情報は、オブジェクトが移動するときに装置が画像の中のある特定のオブジェクトに向けられたままであることを確実にするために、カメラや武器等の装置を制御するための装置ポインティングシステムに対する入力として使用されてよい。トラッキング情報の他の使用は当業者に明らかになるであろう。

【0070】

文脈上明らかに他の意味に解すべきではない場合、説明全体及び請求項では、ワード「備える」「備えている」等は排他的または包括的な意味とは対照的に含めた意味で解釈されなければならない。つまり、「含むが、限定されない」の意味である。

【図面の簡単な説明】

【0071】

【図1】本発明によるコンピュータシステムを描くシステムブロック図である。

【図2(a)】本発明の実施形態のトラッキング方法及びシステムの動作を描く流れ図である。

【図2(b)】本発明の実施形態のトラッキング方法及びシステムの動作を描く流れ図である。

【図3】本発明の実施形態で使用される検出されたオブジェクトブロブにマッチングされているオブジェクトテンプレートの概念を描く図である。

【図4】本発明の実施形態により実行されるトラッキングを示すビデオシーケンスのフレームである。

【図5】本発明により実行されるオブジェクトのトラッキングを再び描く、図4のフレームを含むビデオシーケンスの後のフレームである。

【特許請求の範囲】

【請求項1】

ビデオ画像のシーケンスの中でオブジェクトを追跡する方法であって、

前記シーケンスの過去のビデオ画像の中で検出されたオブジェクトに関係するオブジェクトモデルを記憶する段階であって、前記オブジェクトモデルが前記検出されたオブジェクトの特性の値とそれらの値の分散とを備える段階と、

処理される前記シーケンスの追加のビデオ画像を受信する段階と、

前記受信されたビデオ画像の中のオブジェクトを検出する段階と、

前記検出されたオブジェクトの特性を決定する段階と、

前記特性の少なくとも前記分散を考慮に入れる距離関数を使用して前記それぞれの特性に基づいて各検出されたオブジェクトと各オブジェクトモデルの間の距離測度を計算する段階と、

前記計算された距離測度に基づいて前記オブジェクトモデルに前記検出されたオブジェクトをマッチングする段階と、

前記オブジェクトモデルを、それにマッチングされた前記それぞれの検出されたオブジェクトの特性を使用して更新する段階と、

を備える、方法。

【請求項2】

前記距離測度はスケーリングされたユークリッド距離である、請求項1に記載の方法。

【請求項3】

前記距離関数はオブジェクトモデルlと検出されたオブジェクトkについて

【数1】

の形を取り、ここではxliとykiがそれぞれ記憶されているオブジェクトモデルと検出されたオブジェクトの特性の値であり、σ2liが各特徴の前記分散の対応する成分であり、前記指数iがオブジェクトモデルのN個の特徴を通る、請求項2に記載の方法。

【請求項4】

前記距離測度はマハラノビスの距離である、請求項1に記載の方法。

【請求項5】

前記受信されたフレームのための記憶されているオブジェクトモデルの前記特性の値を予測する段階とをさらに備え、前記計算する段階は前記オブジェクトモジュールからの前記特徴値として前記特性の前記予測値を使用する、請求項1乃至請求項4のいずれか1項に記載の方法。

【請求項6】

オブジェクトモデルが検出されたオブジェクトにマッチングされない場合に、そのオブジェクトの特性値の分散が増加する、請求項1乃至請求項5のいずれか1項に記載の方法。

【請求項7】

オブジェクトモデルが前記受信された画像の中の検出されたオブジェクトにマッチングされない場合、前記更新段階が所定数の過去の画像で同じオブジェクトについて検出されたそれぞれの個別の値の平均で前記特性値を更新することを備える、請求項1乃至請求項6のいずれか1項に記載の方法。

【請求項8】

オブジェクトモデルが前記受信された画像の中の検出されたオブジェクトにマッチングされない場合、前記オブジェクトが別のオブジェクトと重複するかどうかを判断するために試験が実行され、重複が検出されるとオブジェクトが閉塞していると見なされる、請求項1乃至請求項7のいずれか1項に記載の方法。

【請求項9】

各オブジェクトが追跡される連続ビデオ画像の数をカウントする段階と、オブジェクトが所定数の連続フレームの間追跡されると、トラッキングが発生したことを示す追跡信号を出力する段階とをさらに備える、請求項1乃至請求項8のいずれか1項に記載の方法。

【請求項10】

オブジェクトモデルが前記受信された画像内の検出されたオブジェクトにマッチングされない場合、オブジェクトモデルがマッチングされていない連続フレーム数のカウントが増分され、前記カウントが所定数を上回ると前記オブジェクトモデルを削除する段階をさらに備える、請求項の1乃至請求項9のいずれか1項に記載の方法。

【請求項11】

検出されたオブジェクトがオブジェクトモデルにマッチングされない場合に、新しいオブジェクトモデルが前記検出されたオブジェクトに対応して記憶される、請求項1乃至請求項10のいずれか1項に記載の方法。

【請求項12】

コンピュータで実行時に、それ/それらによって前記コンピュータが請求項1乃至請求項11のいずれか1項に従って動作するように構成される、コンピュータプログラムまたはコンピュータプログラムのセット。

【請求項13】

請求項12に記載のコンピュータプログラムまたはコンピュータプログラムのセットの少なくとも1つを記憶する、コンピュータ読み取り可能記憶媒体。

【請求項14】

ビデオ画像のシーケンスの中でオブジェクトを追跡するためのシステムであって、

前記シーケンスの過去のビデオ画像で検出されるオブジェクトに関係するオブジェクトモデルを記憶するための記憶手段であって、前記オブジェクトモデルが前記検出されたオブジェクトの特性の値とそれらの値の分散を備える記憶手段と、

処理される前記シーケンスの追加のビデオ画像を受信するための手段と、

使用時に、

前記受信されたビデオ画像の中で1つまたは複数のオブジェクトを検出し、

前記検出されたオブジェクトの特性を決定し、

前記特性の少なくとも前記分散を考慮する距離関数を使用して前記それぞれの特性に基づいて各検出されたオブジェクトと各オブジェクトモデルの間の距離測度を計算し、

前記計算された距離測度に基づいて前記オブジェクトモデルに前記検出されたオブジェクトをマッチングし、

前記記憶されているオブジェクトモデルを、それにマッチングされた前記それぞれの検出されたオブジェクトの特性を使用して更新するように、

構成された処理手段と、

を備える、システム。

【請求項15】

前記距離測度はスケーリングされたユークリッド距離である、請求項14に記載のシステム。

【請求項16】

前記距離関数は、オブジェクトモデルl及び検出されたオブジェクトkについて

【数2】

の形を取り、ここではxliとykiがそれぞれ記憶されているオブジェクトモデルと検出されたオブジェクトの前記特性の値であり、σ2liが各特徴の前記分散の対応する成分であり、前記指数iがオブジェクトモデルのN個の特徴を通る、請求項15に記載のシステム。

【請求項17】

前記距離測度はマハラノビスの距離である、請求項14に記載のシステム。

【請求項18】

前記受信されたフレームのための前記記憶されているオブジェクトモデルの前記特性の値を予測するための手段をさらに備え、前記処理手段は前記距離測度計算の中で前記オブジェクトモデルからの前記特徴値として前記特性の予測値を使用する、請求項14乃至請求項17のいずれか1項に記載のシステム。

【請求項19】

オブジェクトモデルが検出されたオブジェクトにマッチングされない場合に、そのオブジェクトの前記特性値の前記分散が増加する、請求項14乃至請求項18のいずれか1項に記載のシステム。

【請求項20】

オブジェクトモデルが前記受信された画像の中の検出されたオブジェクトにマッチングされない場合に、前記更新ステップが所定数の過去の画像の間前記同じオブジェクトについて検出されたそれぞれの個別の値の平均で前記特性値を更新することを備える、請求項14乃至請求項19のいずれか1項に記載のシステム。

【請求項21】

オブジェクトモデルが前記受信された画像の中の検出されたオブジェクトにマッチングされない場合に、前記オブジェクトが別のオブジェクトと重複するかどうかを判断するために試験が実行され、重複が検出されると前記オブジェクトが閉塞されていると見なされる、請求項14乃至請求項20のいずれか1項に記載のシステム。

【請求項22】

各オブジェクトが追跡される連続ビデオ画像の数をカウントするための手段と、オブジェクトが所定数の連続フレームの間追跡される場合にトラッキングが発生したことを示す追跡信号を出力するための手段とをさらに備える、請求項14乃至請求項21のいずれか1項に記載のシステム。

【請求項23】

オブジェクトモデルが前記受信された画像の中の検出されたオブジェクトにマッチングされない場合に、前記オブジェクトモデルがマッチングされない連続フレーム数のカウントが増分され、前記システムは、前記カウントが所定数を超える場合に前記オブジェクトモデルを削除するための手段をさらに備える、請求項14乃至請求項22のいずれか1項に記載のシステム。

【請求項24】

検出されたオブジェクトがオブジェクトモデルにマッチングされない場合に、新しいオブジェクトモデルが前記検出されたオブジェクトに対応して記憶される、請求項14乃至請求項23のいずれか1項に記載のシステム。

【請求項1】

ビデオ画像のシーケンスの中でオブジェクトを追跡する方法であって、

前記シーケンスの過去のビデオ画像の中で検出されたオブジェクトに関係するオブジェクトモデルを記憶する段階であって、前記オブジェクトモデルが前記検出されたオブジェクトの特性の値とそれらの値の分散とを備える段階と、

処理される前記シーケンスの追加のビデオ画像を受信する段階と、

前記受信されたビデオ画像の中のオブジェクトを検出する段階と、

前記検出されたオブジェクトの特性を決定する段階と、

前記特性の少なくとも前記分散を考慮に入れる距離関数を使用して前記それぞれの特性に基づいて各検出されたオブジェクトと各オブジェクトモデルの間の距離測度を計算する段階と、

前記計算された距離測度に基づいて前記オブジェクトモデルに前記検出されたオブジェクトをマッチングする段階と、

前記オブジェクトモデルを、それにマッチングされた前記それぞれの検出されたオブジェクトの特性を使用して更新する段階と、

を備える、方法。

【請求項2】

前記距離測度はスケーリングされたユークリッド距離である、請求項1に記載の方法。

【請求項3】

前記距離関数はオブジェクトモデルlと検出されたオブジェクトkについて

【数1】

の形を取り、ここではxliとykiがそれぞれ記憶されているオブジェクトモデルと検出されたオブジェクトの特性の値であり、σ2liが各特徴の前記分散の対応する成分であり、前記指数iがオブジェクトモデルのN個の特徴を通る、請求項2に記載の方法。

【請求項4】

前記距離測度はマハラノビスの距離である、請求項1に記載の方法。

【請求項5】

前記受信されたフレームのための記憶されているオブジェクトモデルの前記特性の値を予測する段階とをさらに備え、前記計算する段階は前記オブジェクトモジュールからの前記特徴値として前記特性の前記予測値を使用する、請求項1乃至請求項4のいずれか1項に記載の方法。

【請求項6】

オブジェクトモデルが検出されたオブジェクトにマッチングされない場合に、そのオブジェクトの特性値の分散が増加する、請求項1乃至請求項5のいずれか1項に記載の方法。

【請求項7】

オブジェクトモデルが前記受信された画像の中の検出されたオブジェクトにマッチングされない場合、前記更新段階が所定数の過去の画像で同じオブジェクトについて検出されたそれぞれの個別の値の平均で前記特性値を更新することを備える、請求項1乃至請求項6のいずれか1項に記載の方法。

【請求項8】

オブジェクトモデルが前記受信された画像の中の検出されたオブジェクトにマッチングされない場合、前記オブジェクトが別のオブジェクトと重複するかどうかを判断するために試験が実行され、重複が検出されるとオブジェクトが閉塞していると見なされる、請求項1乃至請求項7のいずれか1項に記載の方法。

【請求項9】

各オブジェクトが追跡される連続ビデオ画像の数をカウントする段階と、オブジェクトが所定数の連続フレームの間追跡されると、トラッキングが発生したことを示す追跡信号を出力する段階とをさらに備える、請求項1乃至請求項8のいずれか1項に記載の方法。

【請求項10】

オブジェクトモデルが前記受信された画像内の検出されたオブジェクトにマッチングされない場合、オブジェクトモデルがマッチングされていない連続フレーム数のカウントが増分され、前記カウントが所定数を上回ると前記オブジェクトモデルを削除する段階をさらに備える、請求項の1乃至請求項9のいずれか1項に記載の方法。

【請求項11】

検出されたオブジェクトがオブジェクトモデルにマッチングされない場合に、新しいオブジェクトモデルが前記検出されたオブジェクトに対応して記憶される、請求項1乃至請求項10のいずれか1項に記載の方法。

【請求項12】

コンピュータで実行時に、それ/それらによって前記コンピュータが請求項1乃至請求項11のいずれか1項に従って動作するように構成される、コンピュータプログラムまたはコンピュータプログラムのセット。

【請求項13】

請求項12に記載のコンピュータプログラムまたはコンピュータプログラムのセットの少なくとも1つを記憶する、コンピュータ読み取り可能記憶媒体。

【請求項14】

ビデオ画像のシーケンスの中でオブジェクトを追跡するためのシステムであって、

前記シーケンスの過去のビデオ画像で検出されるオブジェクトに関係するオブジェクトモデルを記憶するための記憶手段であって、前記オブジェクトモデルが前記検出されたオブジェクトの特性の値とそれらの値の分散を備える記憶手段と、

処理される前記シーケンスの追加のビデオ画像を受信するための手段と、

使用時に、

前記受信されたビデオ画像の中で1つまたは複数のオブジェクトを検出し、

前記検出されたオブジェクトの特性を決定し、

前記特性の少なくとも前記分散を考慮する距離関数を使用して前記それぞれの特性に基づいて各検出されたオブジェクトと各オブジェクトモデルの間の距離測度を計算し、

前記計算された距離測度に基づいて前記オブジェクトモデルに前記検出されたオブジェクトをマッチングし、

前記記憶されているオブジェクトモデルを、それにマッチングされた前記それぞれの検出されたオブジェクトの特性を使用して更新するように、

構成された処理手段と、

を備える、システム。

【請求項15】

前記距離測度はスケーリングされたユークリッド距離である、請求項14に記載のシステム。

【請求項16】

前記距離関数は、オブジェクトモデルl及び検出されたオブジェクトkについて

【数2】

の形を取り、ここではxliとykiがそれぞれ記憶されているオブジェクトモデルと検出されたオブジェクトの前記特性の値であり、σ2liが各特徴の前記分散の対応する成分であり、前記指数iがオブジェクトモデルのN個の特徴を通る、請求項15に記載のシステム。

【請求項17】

前記距離測度はマハラノビスの距離である、請求項14に記載のシステム。

【請求項18】

前記受信されたフレームのための前記記憶されているオブジェクトモデルの前記特性の値を予測するための手段をさらに備え、前記処理手段は前記距離測度計算の中で前記オブジェクトモデルからの前記特徴値として前記特性の予測値を使用する、請求項14乃至請求項17のいずれか1項に記載のシステム。

【請求項19】

オブジェクトモデルが検出されたオブジェクトにマッチングされない場合に、そのオブジェクトの前記特性値の前記分散が増加する、請求項14乃至請求項18のいずれか1項に記載のシステム。

【請求項20】

オブジェクトモデルが前記受信された画像の中の検出されたオブジェクトにマッチングされない場合に、前記更新ステップが所定数の過去の画像の間前記同じオブジェクトについて検出されたそれぞれの個別の値の平均で前記特性値を更新することを備える、請求項14乃至請求項19のいずれか1項に記載のシステム。

【請求項21】

オブジェクトモデルが前記受信された画像の中の検出されたオブジェクトにマッチングされない場合に、前記オブジェクトが別のオブジェクトと重複するかどうかを判断するために試験が実行され、重複が検出されると前記オブジェクトが閉塞されていると見なされる、請求項14乃至請求項20のいずれか1項に記載のシステム。

【請求項22】

各オブジェクトが追跡される連続ビデオ画像の数をカウントするための手段と、オブジェクトが所定数の連続フレームの間追跡される場合にトラッキングが発生したことを示す追跡信号を出力するための手段とをさらに備える、請求項14乃至請求項21のいずれか1項に記載のシステム。

【請求項23】

オブジェクトモデルが前記受信された画像の中の検出されたオブジェクトにマッチングされない場合に、前記オブジェクトモデルがマッチングされない連続フレーム数のカウントが増分され、前記システムは、前記カウントが所定数を超える場合に前記オブジェクトモデルを削除するための手段をさらに備える、請求項14乃至請求項22のいずれか1項に記載のシステム。

【請求項24】

検出されたオブジェクトがオブジェクトモデルにマッチングされない場合に、新しいオブジェクトモデルが前記検出されたオブジェクトに対応して記憶される、請求項14乃至請求項23のいずれか1項に記載のシステム。

【図1】

【図2(a)】

【図2(b)】

【図3】

【図4】

【図5】

【図2(a)】

【図2(b)】

【図3】

【図4】

【図5】

【公表番号】特表2007−510994(P2007−510994A)

【公表日】平成19年4月26日(2007.4.26)

【国際特許分類】

【出願番号】特願2006−538931(P2006−538931)

【出願日】平成16年11月8日(2004.11.8)

【国際出願番号】PCT/GB2004/004687

【国際公開番号】WO2005/048196

【国際公開日】平成17年5月26日(2005.5.26)

【出願人】(390028587)ブリティッシュ・テレコミュニケーションズ・パブリック・リミテッド・カンパニー (104)

【氏名又は名称原語表記】BRITISH TELECOMMUNICATIONS PUBLIC LIMITED COMPANY

【Fターム(参考)】

【公表日】平成19年4月26日(2007.4.26)

【国際特許分類】

【出願日】平成16年11月8日(2004.11.8)

【国際出願番号】PCT/GB2004/004687

【国際公開番号】WO2005/048196

【国際公開日】平成17年5月26日(2005.5.26)

【出願人】(390028587)ブリティッシュ・テレコミュニケーションズ・パブリック・リミテッド・カンパニー (104)

【氏名又は名称原語表記】BRITISH TELECOMMUNICATIONS PUBLIC LIMITED COMPANY

【Fターム(参考)】

[ Back to top ]