ユーザ指示取得装置、ユーザ指示取得プログラムおよびテレビ受像機

【課題】ユーザの自然な発話、動作によって機器を的確に指示制御することができ、ユーザが実際に指示を行っている場合のみ指示を取得するユーザ指示取得装置、ユーザ指示取得プログラムおよびテレビ受像機を提供する。

【解決手段】カメラCrによって撮影された映像から予め登録された複数のユーザのそれぞれを認識するとともにその顔の変化を検出し、当該顔の変化から複数のユーザのそれぞれの発話期間を生成する顔分析手段20と、映像から複数のユーザの手の動作を認識する手動作分析手段30と、発話期間に基づいて機器の周囲の音声を検出し、音響特徴量を用いて音声の内容および話者を認識する音声分析手段10と、顔分析手段20によって認識された複数のユーザに話者が含まれている場合、ユーザの顔の変化、手の動作、音声の内容に対して予め定められたコマンドを生成するコマンド生成手段40と、を備える。

【解決手段】カメラCrによって撮影された映像から予め登録された複数のユーザのそれぞれを認識するとともにその顔の変化を検出し、当該顔の変化から複数のユーザのそれぞれの発話期間を生成する顔分析手段20と、映像から複数のユーザの手の動作を認識する手動作分析手段30と、発話期間に基づいて機器の周囲の音声を検出し、音響特徴量を用いて音声の内容および話者を認識する音声分析手段10と、顔分析手段20によって認識された複数のユーザに話者が含まれている場合、ユーザの顔の変化、手の動作、音声の内容に対して予め定められたコマンドを生成するコマンド生成手段40と、を備える。

【発明の詳細な説明】

【技術分野】

【0001】

本発明は、テレビ、オーディオ機器、パソコンおよび各種家電等の機器を利用するユーザから、当該機器を制御するための指示を取得するユーザ指示取得装置、ユーザ指示取得プログラムおよびテレビ受像機に関する。

【背景技術】

【0002】

テレビ等の機器がユーザからの指示を受け取る方法としては、例えば最も基本的なものとして、リモコンによって指示を受け取る方法が挙げられる。また、特許文献1,2では、前記したようなリモコン操作の煩わしさを回避するために、リモコンの代わりに音声認識やジェスチャ(動作認識)を利用してユーザから指示を受け取る装置が提案されている。

【先行技術文献】

【特許文献】

【0003】

【特許文献1】特開2004−192653号公報

【特許文献2】特許第3886074号公報

【発明の概要】

【発明が解決しようとする課題】

【0004】

しかしながら、前記したようなリモコンを用いた方法では、テレビ等の機器に指示する内容が固定であるため柔軟性に欠けており、また、リモコンの操作が複雑で扱いにくいという問題があった。そして、特許文献1,2で提案された音声認識やジェスチャを利用する装置では、常に音声認識を行っているため、ユーザが実際に指示をいったタイミングや複数のユーザのうちの誰が指示を行っているのかが分からず、さらに雑音にも反応してしまうという問題があった。また、特許文献1,2で提案された装置では、ユーザがディスプレイ画面に表示された擬人化されたエージェント画像を見ながら指示を行う等、日常的ではない不自然な状況下で指示を行う必要があり煩雑であるという問題があった。

【0005】

本発明はかかる点に鑑みてなされたものであって、ユーザの自然な発話あるいは動作によって機器を的確に指示制御することができ、かつ、ユーザが実際に指示を行っている場合のみ指示を取得するユーザ指示取得装置、ユーザ指示取得プログラムおよびテレビ受像機を提供することを課題とする。

【課題を解決するための手段】

【0006】

前記課題を解決するために請求項1に係るユーザ指示取得装置は、機器を利用する複数のユーザの中から当該機器を制御するための指示を行っているユーザを特定し、当該ユーザからの指示を取得するユーザ指示取得装置であって、カメラによって撮影された映像から、予め登録された前記複数のユーザのぞれぞれを認識するとともに前記複数のユーザのぞれぞれの顔の変化を検出し、当該顔の変化から前記複数のユーザのそれぞれが発話している期間を示す発話期間を生成する顔分析手段と、前記複数のユーザの映像から、前記複数のユーザの手の動作を認識する手動作分析手段と、前記顔分析手段によって生成された前記発話期間に基づいて、前記機器の周囲の音から音声を検出し、予め前記ユーザごとに登録された音響特徴量を用いて前記音声の内容および話者を認識する音声分析手段と、前記顔分析手段によって認識された前記複数のユーザの中に前記音声分析手段によって認識された前記話者が含まれている場合、当該話者を前記指示を行っているユーザとして特定し、前記顔分析手段によって検出された前記ユーザの顔の変化と、前記手動作分析手段によって認識された前記ユーザの手の動作と、前記音声分析手段によって認識された前記ユーザの音声の内容と、に対して予め定められたコマンドを生成するコマンド生成手段と、を備える構成とした。

【0007】

このような構成によれば、ユーザ指示取得装置は、顔分析手段によってユーザの顔の変化から当該ユーザが発話している期間を生成し、ユーザが発話している場合のみ音声認識を行うため、音声認識の精度を高めることができる。また、顔認識で認識したユーザと音声認識で認識した話者とを比較することで、機器に対して音声指示を行ったユーザを特定できるため、複数のユーザが機器を利用する場合であっても、コマンドを的確に生成することができる。

【0008】

また、請求項2に係るユーザ指示取得装置は、前記顔分析手段が、前記映像から前記複数のユーザの顔の領域を検出する顔領域検出手段と、予め前記ユーザごとに登録された顔特徴量を用いて、前記顔の領域に対応するユーザを認識する顔認識手段と、前記複数のユーザの顔の領域から、当該複数のユーザの顔の変化を検出する顔変化検出手段と、前記複数のユーザの顔の変化から、当該複数のユーザが発話しているか否かを判定し、発話していると判定した場合に前記発話期間を生成する発話状態推定手段と、を備える構成とした。

【0009】

このような構成によれば、ユーザ指示取得装置は、発話状態推定手段によって当該ユーザが発話しているのか否かを判定し、ユーザが発話していると判定した場合のみ発話期間を生成して音声分析手段に出力するため、音声認識の精度をより高めることができる。

【0010】

また、請求項3に係るユーザ指示取得プログラムは、機器を利用する複数のユーザの中から当該機器を制御するための指示を行っているユーザを特定し、当該ユーザからの指示を取得するために、コンピュータを、カメラによって撮影された映像から、予め登録された前記複数のユーザのぞれぞれを認識するとともに前記複数のユーザのぞれぞれの顔の変化を検出し、当該顔の変化から前記複数のユーザのそれぞれが発話している期間を示す発話期間を生成する顔分析手段、前記複数のユーザの映像から、前記複数のユーザの手の動作を認識する手動作分析手段、前記顔分析手段によって生成された前記発話期間に基づいて、前記機器の周囲の音から音声を検出し、予め前記ユーザごとに登録された音響特徴量を用いて前記音声の内容および話者を認識する音声分析手段、前記顔分析手段によって認識された前記複数のユーザの中に前記音声分析手段によって認識された前記話者が含まれている場合、当該話者を前記指示を行っているユーザとして特定し、前記顔分析手段によって検出された前記ユーザの顔の変化と、前記手動作分析手段によって認識された前記ユーザの手の動作と、前記音声分析手段によって認識された前記ユーザの音声の内容と、に対して予め定められたコマンドを生成するコマンド生成手段、として機能させる構成とした。

【0011】

このような構成によれば、ユーザ指示取得プログラムは、顔分析手段によってユーザの顔の変化から当該ユーザが発話している期間を生成し、ユーザが発話している場合のみ音声認識を行うため、音声認識の精度を高めることができる。また、顔認識で認識したユーザと音声認識で認識した話者とを比較することで、機器に対して音声指示を行ったユーザを特定できるため、複数のユーザが機器を利用する場合であっても、コマンドを的確に生成することができる。

【0012】

また、請求項4に係るテレビ受像機は、ユーザに放送番組を提供するテレビ受像機であって、当該テレビ受像機に設置されたカメラの映像およびマイクの音を分析することで、前記ユーザの音声および動作による前記ユーザからの指示を取得する請求項1または請求項2に記載のユーザ指示取得装置を備える構成とした。

【0013】

このような構成によれば、テレビ受像機は、顔分析手段によってユーザの顔の変化から当該ユーザが発話しているのか否かを判定し、ユーザが発話している場合のみ音声認識を行うため、音声認識の精度を高めることができる。また、顔認識で認識したユーザと音声認識で認識した話者とを比較することで、機器に対して音声指示を行ったユーザを特定できるため、複数のユーザが機器を利用する場合であっても、コマンドを的確に生成することができる。

【発明の効果】

【0014】

請求項1、請求項2、請求項3および請求項4に係る発明によれば、ユーザの顔の変化から当該ユーザの発話状態を自動的に判定するとともに、ユーザが機器に対して音声および動作による指示を行うだけでコマンドを生成することができる。従って、複雑な操作を行うことなく、ユーザの自然な行動の延長上でその指示内容を機器に伝え、当該機器を制御することができる。

【図面の簡単な説明】

【0015】

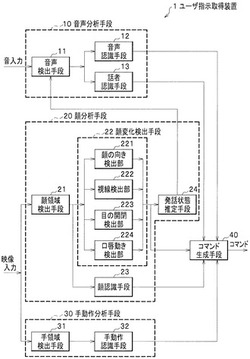

【図1】本発明に係るユーザ指示取得装置の全体構成を示すブロック図である。

【図2】(a)は、本発明に係るユーザ指示取得装置における発話状態推定手段の具体的構成を示すブロック図であり、(b)は、本発明に係るユーザ指示取得装置における発話条件記憶部が予め保持する発話条件の一例を示す図である。

【図3】(a)は、本発明に係るユーザ指示取得装置におけるコマンド生成手段の具体的構成を示すブロック図であり、(b)は、本発明に係るユーザ指示取得装置におけるコマンド条件記憶部が予め保持するコマンド条件の一例を示す図である。

【図4】本発明に係るユーザ指示取得装置におけるユーザの指示の一例を示す図である。

【図5】本発明に係るユーザ指示取得装置の動作を示すフローチャートである。

【図6】本発明に係るユーザ指示装置を備えるテレビ受像機の一例を示す概略図である。

【発明を実施するための形態】

【0016】

本発明の実施形態に係るユーザ指示取得装置、ユーザ指示取得プログラムおよびテレビ受像機について、図面を参照しながら説明する。なお、以下の説明において、同一の構成については同一の名称及び符号を付し、詳細説明を省略する。

【0017】

[ユーザ指示取得装置]

ユーザ指示取得装置1は、テレビ等の機器を利用する複数のユーザの中から当該機器を制御するための指示を行っているユーザを特定し、当該ユーザからの指示を取得するためのものである。

【0018】

ユーザ指示取得装置1は、例えば図6に示すように、ユーザに放送番組を提供するテレビ受像機(以下、テレビという)Tと接続され、テレビT上部に設置されたカメラCrおよびマイクMから入力されたユーザの映像および音声を分析することでユーザの指示を取得する。そして、ユーザ指示取得装置1は、図1に示すように、これに対応するコマンドを生成し、当該コマンドを機器の制御部等に出力する。なお、ユーザ指示取得装置1は、図6に示すようにテレビTの外部に備えられるのではなく、当該テレビTの内部に内蔵されてもよい。

【0019】

ユーザ指示取得装置1は、ここでは図1に示すように、音声分析手段10と、顔分析手段20と、手動作分析手段30と、を備えている。また、ユーザ指示取得装置1は、前記したように、機器を利用するユーザの映像を撮影するためのカメラCrと、機器の周囲の音を集音するためのマイクMと、を備えている。なお、ユーザ指示取得装置1が備えるカメラCrとマイクMは、例えば前記した図6に示すように、機器の上部に設置され、機器を利用するユーザの映像と、機器の周囲の音と、を取得できるように構成されている。以下、ユーザ指示取得装置1が備える各構成について、詳細に説明する。

【0020】

音声分析手段10は、マイクMによって集音した機器の周囲の音から音声を検出し、予めユーザごとに登録された音響特徴量を用いて音声の内容および話者を認識するものである。音声分析手段10は、ここでは図1に示すように、音声検出手段11と、音声認識手段12と、話者認識手段13と、を備えている。

【0021】

音声検出手段11は、機器の周囲の音から音声を検出するためのものである。音声検出手段11は、図1に示すように、マイクMから機器の周囲の音が入力されると、予め登録された音声の周波数特性等を用いて、機器の周囲の音から音声を抽出する。また、音声検出手段11は、後記する発話状態推定手段24から、ユーザが発話している期間を示す発話期間が入力されると、当該発話期間に検出した音声を音声認識手段12および話者認識手段13に出力する。すなわち、音声検出手段11は、ユーザが発話している間のみ、検出した音声を音声認識手段12および話者認識手段13に対して出力するように構成されている。なお、音声検出手段11は、前記した音声の周波数特性のデータを予め保持する図示しない記憶部を備えている。

【0022】

音声認識手段12は、音声からその音声の内容を認識するためのものである。音声認識手段12は、具体的には、音声の時間波形から音響分析によって、例えば、スペクトルの低次DCT成分等の周波数特性を音響特徴量として抽出し、予め登録されている全ての単語の発音に応じた音響モデルと照合し、さらに言語モデル(単語の連続出現頻度分布)も用いることで、音響的および言語的に最も可能性の高い単語列を認識結果として得る。なお、音声認識手段12は、前記した音響モデルおよび言語モデルを予め保持する図示しない記憶部を備えている。

【0023】

音声認識手段12には、図1に示すように、音声検出手段11から音声が入力される。そして、音声認識手段12は、前記した手法によって音声から単語列を抽出し、これを音声情報としてコマンド生成手段40の情報取得部41に出力する(図3(a)参照)。

【0024】

話者認識手段13は、音声からその音声の話者、すなわちどのユーザがその音声を発しているのかを認識するためのものである。話者認識手段13は、具体的には、音声から前記した音声認識手段12と同様の音響特徴量を抽出し、当該音響特徴量と特定の話者について予め登録されている話者モデルとを比較して、話者が誰であるかを判定する。

【0025】

話者認識手段13における話者の判定には、ベイズ情報量基準を用いることもできる。また、音響特徴量を音素のクラスに分類し、音素クラスの混合モデルを使って照合することもできる。なお、話者認識手段13は、前記した話者モデルを予め保持する図示しない記憶部を備えている。また、この話者モデルは、例えばユーザが予め特定の単語を発話し、このユーザの音声を氏名あるいはニックネーム等の登録名とともに前記した記憶部に登録することで作成することができる。

【0026】

話者認識手段13には、図1に示すように、音声検出手段11から音声が入力される。そして、話者認識手段13は、前記した手法によって音声から話者を判定し、これを話者 情報としてコマンド生成手段40の情報取得部41に出力する(図3(a)参照)。

【0027】

顔分析手段20は、カメラCrによって撮影された映像から、顔画像認識処理によって予め登録された複数のユーザのそれぞれを認識するとともに、複数のユーザのそれぞれの顔の変化を検出するものである。また、顔分析手段20は、複数のユーザの顔の変化から当該複数のユーザが発話しているか否かを判定するとともに、複数のユーザのそれぞれが発話している期間を示す発話期間を生成するものである。顔分析手段20は、ここでは図1に示すように、顔領域検出手段21と、顔変化検出手段22と、顔認識手段23と、発話状態推定手段24と、を備えている。

【0028】

顔領域検出手段21は、複数のユーザの映像から人物の顔の領域を検出するものである。顔領域検出手段21は、具体的には、複数のユーザの映像を構成する画像から、ユーザの普遍的な特徴を抽出し、それらの特徴を検出することで人物の顔の領域を検出する。なお、顔領域検出手段21は、画像からの前記普遍的特徴の抽出にハール関数を用いることで、高速処理が可能となる。

【0029】

顔領域検出手段21には、図1に示すように、カメラCrから機器を利用する複数のユーザの映像が入力される。そして、顔領域検出手段21は、前記した手法によって映像からユーザの顔の領域を検出し、これを顔領域情報として顔変化検出手段22の各検出部および顔認識手段23に出力する。

【0030】

顔変化検出手段22は、複数のユーザの映像から検出されたユーザの顔の領域から、それぞれのユーザの顔の変化を検出するものである。顔変化検出手段22は、例えば、顔領域検出手段21で3人分の顔の領域が検出された場合、当該3人分の顔の領域のそれぞれの顔の変化を検出する。顔変化検出手段22は、ここでは図1に示すように、顔の向き検出部221と、視線検出部222と、目の開閉検出部223と、口唇動き検出部224と、を備えている。

【0031】

顔の向き検出部221は、機器を基準とした複数のユーザの顔の向きを検出するものである。顔の向き検出部221は、例えば機器がテレビTである場合(図6参照)、前記した顔領域情報から、ユーザの顔の向きがテレビ画面の中央に対して水平方向および垂直方向にそれぞれどのくらいの角度回っているかを検出する。顔の向き検出部221は、具体的には、前記したハール関数や、後記するガボールウェーブレットによる特徴抽出により、例えばユーザの目と鼻と口の周りの特徴の配置情報をもとに、様々な顔の向きのテンプレートを記録しておき、それらテンプレートとのマッチングによってユーザの顔の向きを推定する。

【0032】

視線検出部222は、機器を基準とした複数のユーザの視線の向きを検出するものである。視線検出部222は、前記した顔領域情報から、ユーザの目の視線の向きが頭部に対して水平方向および垂直方向にそれぞれどのくらいの角度回っているかを検出する。視線検出部222は、顔領域検出手段21が検出したユーザの顔の領域をもとに、ユーザの顔内のパーツの配置情報に基づいてユーザの目の位置を推定し、事前に登録しておいた各視線の方向の画像パターンとのマッチングによりユーザの視線方向を推定する。なお、視線検出部222は、例えば機器がテレビTである場合(図6参照)、前記した顔の向き検出部221による検出結果と組み合わせることで、ユーザがテレビ画面のどのあたりを見ているかも推定することができる。

【0033】

目の開閉検出部223は、ユーザが目を開けているか、あるいは閉じているかを検出するものである。目の開閉検出部223は、視線検出部222と同様に、顔領域検出手段21が検出したユーザの顔の領域をもとに、ユーザの顔内のパーツの配置情報に基づいてユーザの目の位置を推定し、その位置に黒い部分がある場合に目を開けていると判定し、その位置に黒い部分がなくなった場合に目を閉じていると判定する。

【0034】

口唇動き検出部224は、ユーザの口唇の動きを検出するものである。口唇動き検出部224は、顔領域検出手段21が検出したユーザの顔の領域をもとに、ユーザの顔内のパーツの配置情報に基づいてユーザの口の位置を推定し、ブロックマッチングやLucas−Kanadeの手法等の動き検出アルゴリズムによって口唇の動きベクトルを抽出し、動きベクトルのパワーがある閾値を越え、かつそのパワー変動に周期性が見られる場合に、ユーザの口唇が動いて発話していると判定する。

【0035】

そして、顔変化検出手段22は、前記した顔の向き検出部221、視線検出部222、目の開閉検出部223および口唇動き検出部224が顔の領域ごとに検出した顔の変化を、顔変化情報として発話状態推定手段24の発話状態判定部241に出力するとともに(図2(a)参照)、コマンド生成手段40の情報取得部41に出力する(図3(a)参照)。

【0036】

顔認識手段23は、複数のユーザの映像から検出されたユーザの顔の領域から、当該領域に含まれるユーザを認識するものである。顔認識手段23は、前記した顔領域検出手段21で検出された顔の領域に対して顔画像認識技術を適用し、誰が機器を利用しているのかを判定する。顔認識手段23は、例えば機器がテレビTである場合(図6参照)であって3人のユーザがテレビを視聴している場合、顔画像認識技術を用いて、3つの顔の領域からそれぞれの領域の顔に対応するユーザの氏名、あるいはニックネーム等の登録名を割り出す。

【0037】

顔認識手段23は、具体的には、ガボールウェーブレットによる局所的な輝度成分の周波数分析結果を特徴とするテンプレートマッチング手法によって前記した顔の領域に含まれる顔からユーザを特定する。顔認識手段23は、具体的には、顔領域検出手段21が検出したユーザの顔の領域における目と鼻と口の周りで決めた位置の特徴量とその配置情報を顔特徴量として抽出し、予め登録されているユーザの画像特徴量と照合することでユーザを特定する。

【0038】

また、顔認識手段23は、表情変化などに対しても認識性能を落とさないために、特徴の配置の位置関係の変形も許す手法を用いることもできる。なお、顔認識手段23は、前記した顔特徴量を予め保持する図示しない記憶部を備えている。また、この顔特徴量は、例えばユーザが予め特定の角度から顔を撮影し、その顔画像を氏名あるいはニックネーム等の登録名とともにユーザ指示取得装置1に登録することで、作成することができる。

【0039】

顔認識手段23には、図1に示すように、顔領域検出手段21から顔領域情報が入力される。そして、顔認識手段23は、前記した手法によって顔領域情報からユーザを認識し、これを人物情報としてその検出時間とともにコマンド生成手段40の情報取得部41に出力する(図3(a)参照)。

【0040】

発話状態推定手段24は、複数のユーザの顔の変化から、当該複数のユーザが発話しているか否かを判定するとともに、複数のユーザが発話している期間を示す発話期間を生成するものである。発話状態推定手段24は、ここでは図2(a)に示すように、発話状態判定部241と、発話条件記憶部242と、を備えている。

【0041】

発話状態判定部241は、ユーザが発話しているか否かを判定するためのものである。発話状態判定部241には、図2(a)に示すように、顔変化検出手段22から、ユーザの顔の向き、ユーザの視線、ユーザの目の開閉、ユーザの口唇動き等の情報からなる顔変化情報と、これらのユーザの顔の変化を検出した検出時間(図示省略)と、が入力される。また、発話状態判定部241には、図2(a)に示すように、発話条件を予め保持する発話条件記憶部242から発話条件が入力される。

【0042】

ここで、発話条件とは、ユーザが発話していると判定するために予め定められた条件であり、図2(b)に示すように、ユーザの顔の向き、視線、目の開閉、口唇動き等の顔の変化の検出結果によって決定される条件のことを示している。すなわち、発話状態判定部241は、顔変化検出手段22によって検出されたユーザの顔の変化がこの発話条件を満たしている場合に限り、機器を利用するユーザが発話状態にあると判定する。

【0043】

発話条件は、ここでは図2(b)に示すように、ユーザの顔が時間率80%以上で正面を向いていること、ユーザの視線が時間率80%以上でテレビ画面方向を向いていること、ユーザの目が時間率80%以上で開いていること、ユーザの口唇が時間率50%以上で動いていること、の全ての条件を満たしているときに、ユーザが発話状態にあると規定している。なお、前記した時間率とは、ユーザの顔の変化の検出時間に対する顔の変化の持続時間の割合を示している。例えば、顔変化検出手段22においてユーザの顔の変化を2秒間検出した場合、顔の変化が1秒持続していれば時間率は50%となり、1.6秒間持続していれば時間率は80%となる。

【0044】

なお、図2(b)に示した発話条件はあくまでも例示であり、発話条件および時間率は、機器の種類あるいはユーザの種別によって適宜変更することができる。例えば、図2(b)における発話条件の検出対象から顔の向き、視線、目の開閉を除外し、ユーザの口唇のみが所定の時間率以上で動いていれば、ユーザが発話状態にあると判定することもできる。

【0045】

発話状態判定部241は、顔変化検出手段22から入力される顔変化情報と、発話条件記憶部242から入力される発話条件とを照合し、当該発話条件を満たしている場合は、前記した顔変化情報の検出時間から、ユーザが発話している期間を示す発話期間を生成する。そして、発話状態判定部241は、図1および図2(a)に示すように、当該発話期間を音声検出手段11に出力する。

【0046】

なお、発話状態判定部241は、発話状態か否かの判定結果を機器に表示することが出好ましい。例えば機器がテレビTである場合(図6参照)、発話状態判定部241は、ユーザが発話状態にあると判定すると、テレビ画面にユーザが発話状態にあることを表示する。このように、発話状態か否かの判定結果をテレビ画面に表示することで、ユーザがテレビTを見続けることが期待できるため、判定精度を高めることができる。以下、図1に戻ってユーザ指示取得装置1の残りの構成について、説明する。

【0047】

手動作分析手段30は、カメラCrによって撮影した複数のユーザの映像から人物の手の領域を検出し、複数のユーザの手の動作を認識するものである。手動作分析手段30は、ここでは図1に示すように、手領域検出手段31と、手動作認識手段32と、を備えている。

【0048】

手領域検出手段31は、複数のユーザの映像から人物の手の領域を検出するものである。手領域検出手段31は、具体的には、複数のユーザの映像を構成する画像から、肌色と大まかな形状情報を用いて人物の手の領域を検出する。また、手領域検出手段31は、例えば、ユーザが指さしまたは手を差し伸べながら指示するという前提がある場合は、距離画像を用い、最も手前に出ている部分を切り出すことで、手の領域を特定することもできる。

【0049】

手領域検出手段31には、図1に示すように、カメラCrから機器を利用する複数のユーザの映像が入力される。そして、手領域検出手段31は、前記した手法によって映像からユーザの手の領域を検出し、これを手領域情報として手動作認識手段32に出力する。

【0050】

手動作認識手段32は、複数のユーザの映像から検出されたユーザの手の領域から、ユーザの手の動作を認識するものである。手動作認識手段32は、手領域検出手段31で検出された領域に対して動作認識手法を適用し、予め定められたコマンドに対応するユーザの手の動作を認識する。手動作認識手段32は、具体的には、ユーザの手の領域から、事前に作成した、例えばSIFTやSURFと呼ばれる普遍的な特徴の時系列データ、すなわち各特徴をフレームごとに追跡していくことにより得られるデータからなる各動作認識のテンプレートと、ユーザの手の領域から抽出したこれらの特徴量の時系列データとのマッチングを取ることで、動作認識を行うことができる。なお、手動作認識手段32は、ユーザの手動作の有無のみならず、その手動作の種類(指さし、指ふり等)も認識する。

【0051】

手動作認識手段32には、図1に示すように、手領域検出手段31から手領域情報が入力される。そして、手動作認識手段32は、前記した手法によってユーザの手の動作を認識し、これを手動作情報としてその検出時間とともにコマンド生成手段40の情報取得部41に出力する(図3(a)参照)。

【0052】

コマンド生成手段40は、顔分析手段20によって認識された複数のユーザの中に、音声分析手段10によって認識された話者が含まれている場合、顔分析手段20によって検出されたユーザの顔の変化と、手動作分析手段30によって認識されたユーザの手の動作と、音声分析手段10によって認識されたユーザの音声の内容と、に対して予め定められたコマンドを生成するものである。コマンド生成手段40は、ここでは図3(a)に示すように、情報取得部41と、コマンド生成部42と、コマンド条件記憶部43と、を備えている。

【0053】

情報取得部41は、機器を制御するためのコマンドの生成に必要な情報を取得するものである。情報取得部41には、図3(a)に示すように、顔変化検出手段22から顔変化情報が、顔認識手段23から人物情報が、手動作認識手段32から手動作情報が、音声認識手段12から音声情報が、話者認識手段13から話者情報が入力される。

【0054】

そして、情報取得部41は、顔認識手段23によって認識された人物の中に、話者認識手段13によって認識された話者が含まれている場合、すなわち、機器を利用する複数のユーザの中に、機器に対して音声指示を行ったユーザが含まれる場合、図3(a)に示すように、当該音声指示を行ったユーザの顔変化情報と、手動作情報と、音声情報と、をコマンド生成部42に出力する。このように、情報取得部41は、複数のユーザが機器を利用する場合において、顔認識手段23によって認識された複数のユーザの中から機器に指示を行っているユーザを特定することができる。なお、情報取得部41は、前記した顔変化情報、人物情報、手動作情報、音声情報および話者情報を一時的に保持するための図示しない記憶部を備えている。

【0055】

なお、顔変化検出手段22から情報取得部41に入力される顔変化情報は、顔領域検出手段21によって検出された顔の領域ごとの顔変化の情報である。また、顔認識手段23から情報取得部41に入力される人物情報も、同じく顔領域検出手段21によって検出された顔の領域ごとの氏名等の登録名の情報である。従って、情報取得部41は、顔の領域を基準とすることで、顔変化検出手段22から入力された顔変化情報がどのユーザの顔変化に関する情報であるかを判別することができる。

【0056】

また、情報取得部41には、前記したように、顔認識手段23から人物情報とともにその検出時間が入力され、手動作認識手段32から手動作情報とともにその検出時間が入力される。従って、情報取得部41は、検出時間を基準とすることで、手動作認識手段32から入力された手動作情報がどのユーザの手動作に関する情報であるかを判別することができる。

【0057】

コマンド生成部42は、機器を制御するための指示に対応するコマンドを生成するものである。コマンド生成部42には、図3(a)に示すように、情報取得部41から、機器に対して音声指示を行ったユーザの顔変化情報と、手動作情報と、音声情報と、が入力される。また、コマンド生成部42には、図3(a)に示すように、コマンド条件を予め保持するコマンド条件記憶部43からコマンド条件が入力される。

【0058】

ここで、コマンド条件とは、予め定められたコマンド生成のための条件であり、図3(b)に示すように、ユーザの顔の向き、視線、目の開閉、口唇動き、手動作、音声等の検出結果によって決定される条件のことを示している。すなわち、コマンド生成部42は、顔変化検出手段22によって検出されたユーザの顔の変化と、手動作認識手段32によって認識されたユーザの手の動作と、音声認識手段12によって認識されたユーザの音声と、がこのコマンド条件を満たしている場合に限り、コマンドを生成する。

【0059】

コマンド条件は、ここでは図3(b)に示すように、4つのパターンが規定されている。第1パターンは、図3(b)の検出結果の欄の第1列目であり、ユーザの顔が正面を向いており、ユーザの視線がテレビ画面方向を向いており、ユーザの目が開いており、ユーザの口唇が動いており、ユーザが手動作を行っており、ユーザが発話している場合に、音声指示内容および手動作指示内容を解析してコマンドを生成する旨が規定されている。これは、例えば図4(a)に示すユーザAのような状況の場合にコマンドを生成することを意味している。

【0060】

第2パターンは、図3(b)の検出結果の欄の第2列目であり、ユーザの顔が正面を向いており、ユーザの視線がテレビ画面方向を向いており、ユーザの目が開いており、ユーザの口唇が動いており、ユーザが手動作を行っておらず、ユーザが発話している場合に、音声指示内容を解析してコマンドを生成する旨が規定されている。これは、例えば図4(b)に示すユーザBのような状況の場合にコマンドを生成することを意味している。

【0061】

第3パターンは、図3(b)の検出結果の欄の第3列目であり、ユーザの顔が横を向いており、ユーザの視線が横方向を向いており、ユーザの目が開いており、ユーザの口唇が動いており、ユーザが手動作を行っており、ユーザが発話している場合に、音声指示内容および手動作指示内容を解析してコマンドを生成する旨が規定されている。これは、例えば図4(c)に示すユーザCのような状況の場合にコマンドを生成することを意味している。

【0062】

第4パターンは、図3(b)の検出結果の欄の第4列目であり、ユーザの顔が横を向いており、ユーザの視線が横方向を向いており、ユーザの目が閉じており、ユーザの口唇が動いており、ユーザが手動作を行っておらず、ユーザが発話している場合に、音声指示内容を解析してコマンドを生成する旨が規定されている。これは、例えば図4(d)に示すユーザDのような状況の場合にコマンドを生成することを意味している。

【0063】

なお、図3(b)に示したコマンド条件はあくまでも例示であり、機器の種類あるいはユーザの種別によって適宜変更することができる。例えば、図3(b)におけるコマンド条件の検出対象から顔の向き、視線、目の開閉を除外し、ユーザの口唇動きと音声のみをコマンド生成のための条件とすることもできる。

【0064】

ここで、コマンド生成部42は、機器を制御するためのコマンドリストを予め保持する図示しないデータベースを備えている。そして、コマンド生成部42は、音声認識手段12が認識したユーザの音声の内容および、手動作認識手段32が認識したユーザの手の動作に相当するコマンドを、前記したデータベースで検索することで、ユーザの音声指示内容および手動作指示内容を解析する。

【0065】

なお、前記したデータベースには、ユーザが日常的に発する自然な言葉や動作と、コマンドが関連付けられている。例えば、機器がテレビTである場合(図6参照)、ユーザがテレビTの音量が不足していることに関して発する「音ちっちゃいよね」、「声小さいな」、「よく聞こえないな」というような言葉は、前記したデータベースにおいて、「テレビの音量を上げる」というコマンドと関連付けられている。また、同様に、ユーザがテレビの音量が大きすぎることに関して行う「耳を塞ぐ」という動作は、前記したデータベースにおいて、「テレビの音量を下げる」というコマンドと関連付けられている。

【0066】

このように、コマンド生成部42のデータベースがユーザの自然な発話や動作に対応するコマンドリストを保持することで、ユーザが機器に対してより自然な状況下で指示を行うことができる。

【0067】

以上説明したような構成を備えるユーザ指示取得装置1は、顔分析手段20によってユーザの顔の変化から当該ユーザが発話しているのか否かを判定し、ユーザが発話している場合のみ音声認識を行うため、音声認識の精度を高めることができる。また、顔認識で認識したユーザと音声認識で認識した話者とを比較することで、機器に対して音声指示を行ったユーザを特定できるため、複数のユーザが機器を利用する場合であっても、コマンドを的確に生成することができる。

【0068】

また、ユーザ指示取得装置1によれば、ユーザの顔の変化から当該ユーザの発話状態を自動的に判定するとともに、ユーザが機器に対して音声および動作による指示を行うだけでコマンドを生成することができる。従って、複雑な操作を行うことなく、ユーザの自然な行動の延長上でその指示内容を機器に伝え、当該機器を制御することができる。

【0069】

ここで、ユーザ指示取得装置1は、一般的なコンピュータを、前記した各手段として機能させるプログラムにより動作させることで実現することができる。このプログラム(コンテンツ暗号化プログラム)は、通信回線を介して配布することも可能であるし、CD−ROM等の記録媒体に書き込んで配布することも可能である。

【0070】

[ユーザ指示取得装置の動作]

ユーザ指示取得装置1の動作について、図5を参照しながら簡単に説明する。

まず、ユーザ指示取得装置1が動作を開始すると、カメラCrが機器を利用する複数のユーザの映像を取得し、これを顔領域検出手段21および手領域検出手段31に出力する。また、マイクMが機器の周囲の音を取得し、これを音声検出手段11に出力する。そして、音声検出手段11が、機器の周囲の音から音声を検出する(ステップS1)。次に、顔領域検出手段21が、複数のユーザの映像から人物の顔の領域を検出し、これを顔領域情報として顔変化検出手段22の各検出部および顔認識手段23に出力する(ステップS2)。

【0071】

次に、顔変化検出手段22の各検出部が、複数のユーザの顔領域情報からユーザの顔の向き、視線、目の開閉、口唇動き等の顔の変化を検出し、これを顔変化情報として発話状態判定部241および情報取得部41に出力する(ステップS3)。次に、顔認識手段23が、複数のユーザの顔領域情報から当該領域に含まれる顔に対応する人物、すなわちユーザを認識し、これを人物情報として情報取得部41に出力する(ステップS4)。

【0072】

また、手領域検出手段31が、複数のユーザの映像から人物の手の領域を検出し、これを手領域情報として手動作認識手段32に出力する(ステップS5)。次に、手動作認識手段32が、複数のユーザの手領域情報からユーザの手の動作を認識し、これを手動作情報として情報取得部41に出力する(ステップS6)。

【0073】

次に、発話状態判定部241が、複数のユーザの顔変化情報が発話条件記憶部242から入力される発話条件を満たしているかどうかを判断し、複数のユーザが発話しているか否かを判定する(ステップS7)。そして、発話状態判定部241は、複数のユーザが発話していると判定した場合、ユーザが発話している期間を示す発話期間を生成し、これを音声検出手段11に出力する。これにより、音声検出手段11が、機器の周囲の音声を音声認識手段12および話者認識手段13に出力する(ステップS7でYes)。一方、発話状態判定部241は、複数のユーザが発話していると判定しなかった場合、新たな入力があるまで待機する(ステップS7でNo)。

【0074】

次に、音声認識手段12が、機器の周囲の音声からその音声の内容を認識し、これを音声情報として情報取得部41に出力する(ステップS8)。また、話者認識手段13が、機器の周囲の音声からその音声の話者を認識し、これを話者情報として情報取得部41に出力する(ステップS9)。

【0075】

次に、人物情報の人物の中に話者情報の話者が含まれる場合、情報取得部41が音声指示を行ったユーザの顔変化情報と、手動作情報と、音声情報と、をコマンド生成部42に出力する。そして、ユーザの顔変化情報と、手動作情報と、音声情報と、がコマンド条件を満たしている場合、コマンド生成部42がコマンドを生成する(ステップS10)。

【符号の説明】

【0076】

1 ユーザ指示取得装置

10 音声分析手段

11 音声検出手段

12 音声認識手段

13 話者認識手段

20 顔分析手段

21 顔領域検出手段

22 顔変化検出手段

23 顔認識手段

24 発話状態推定手段

30 手動作分析手段

31 手領域検出手段

32 手動作認識手段

40 コマンド生成手段

41 情報取得部

42 コマンド生成部

43 コマンド条件記憶部

221 顔の向き検出部

222 視線検出部

223 目の開閉検出部

224 口唇動き検出部

241 発話状態判定部

242 発話条件記憶部

Cr カメラ

M マイク

T テレビ受像機(テレビ)

【技術分野】

【0001】

本発明は、テレビ、オーディオ機器、パソコンおよび各種家電等の機器を利用するユーザから、当該機器を制御するための指示を取得するユーザ指示取得装置、ユーザ指示取得プログラムおよびテレビ受像機に関する。

【背景技術】

【0002】

テレビ等の機器がユーザからの指示を受け取る方法としては、例えば最も基本的なものとして、リモコンによって指示を受け取る方法が挙げられる。また、特許文献1,2では、前記したようなリモコン操作の煩わしさを回避するために、リモコンの代わりに音声認識やジェスチャ(動作認識)を利用してユーザから指示を受け取る装置が提案されている。

【先行技術文献】

【特許文献】

【0003】

【特許文献1】特開2004−192653号公報

【特許文献2】特許第3886074号公報

【発明の概要】

【発明が解決しようとする課題】

【0004】

しかしながら、前記したようなリモコンを用いた方法では、テレビ等の機器に指示する内容が固定であるため柔軟性に欠けており、また、リモコンの操作が複雑で扱いにくいという問題があった。そして、特許文献1,2で提案された音声認識やジェスチャを利用する装置では、常に音声認識を行っているため、ユーザが実際に指示をいったタイミングや複数のユーザのうちの誰が指示を行っているのかが分からず、さらに雑音にも反応してしまうという問題があった。また、特許文献1,2で提案された装置では、ユーザがディスプレイ画面に表示された擬人化されたエージェント画像を見ながら指示を行う等、日常的ではない不自然な状況下で指示を行う必要があり煩雑であるという問題があった。

【0005】

本発明はかかる点に鑑みてなされたものであって、ユーザの自然な発話あるいは動作によって機器を的確に指示制御することができ、かつ、ユーザが実際に指示を行っている場合のみ指示を取得するユーザ指示取得装置、ユーザ指示取得プログラムおよびテレビ受像機を提供することを課題とする。

【課題を解決するための手段】

【0006】

前記課題を解決するために請求項1に係るユーザ指示取得装置は、機器を利用する複数のユーザの中から当該機器を制御するための指示を行っているユーザを特定し、当該ユーザからの指示を取得するユーザ指示取得装置であって、カメラによって撮影された映像から、予め登録された前記複数のユーザのぞれぞれを認識するとともに前記複数のユーザのぞれぞれの顔の変化を検出し、当該顔の変化から前記複数のユーザのそれぞれが発話している期間を示す発話期間を生成する顔分析手段と、前記複数のユーザの映像から、前記複数のユーザの手の動作を認識する手動作分析手段と、前記顔分析手段によって生成された前記発話期間に基づいて、前記機器の周囲の音から音声を検出し、予め前記ユーザごとに登録された音響特徴量を用いて前記音声の内容および話者を認識する音声分析手段と、前記顔分析手段によって認識された前記複数のユーザの中に前記音声分析手段によって認識された前記話者が含まれている場合、当該話者を前記指示を行っているユーザとして特定し、前記顔分析手段によって検出された前記ユーザの顔の変化と、前記手動作分析手段によって認識された前記ユーザの手の動作と、前記音声分析手段によって認識された前記ユーザの音声の内容と、に対して予め定められたコマンドを生成するコマンド生成手段と、を備える構成とした。

【0007】

このような構成によれば、ユーザ指示取得装置は、顔分析手段によってユーザの顔の変化から当該ユーザが発話している期間を生成し、ユーザが発話している場合のみ音声認識を行うため、音声認識の精度を高めることができる。また、顔認識で認識したユーザと音声認識で認識した話者とを比較することで、機器に対して音声指示を行ったユーザを特定できるため、複数のユーザが機器を利用する場合であっても、コマンドを的確に生成することができる。

【0008】

また、請求項2に係るユーザ指示取得装置は、前記顔分析手段が、前記映像から前記複数のユーザの顔の領域を検出する顔領域検出手段と、予め前記ユーザごとに登録された顔特徴量を用いて、前記顔の領域に対応するユーザを認識する顔認識手段と、前記複数のユーザの顔の領域から、当該複数のユーザの顔の変化を検出する顔変化検出手段と、前記複数のユーザの顔の変化から、当該複数のユーザが発話しているか否かを判定し、発話していると判定した場合に前記発話期間を生成する発話状態推定手段と、を備える構成とした。

【0009】

このような構成によれば、ユーザ指示取得装置は、発話状態推定手段によって当該ユーザが発話しているのか否かを判定し、ユーザが発話していると判定した場合のみ発話期間を生成して音声分析手段に出力するため、音声認識の精度をより高めることができる。

【0010】

また、請求項3に係るユーザ指示取得プログラムは、機器を利用する複数のユーザの中から当該機器を制御するための指示を行っているユーザを特定し、当該ユーザからの指示を取得するために、コンピュータを、カメラによって撮影された映像から、予め登録された前記複数のユーザのぞれぞれを認識するとともに前記複数のユーザのぞれぞれの顔の変化を検出し、当該顔の変化から前記複数のユーザのそれぞれが発話している期間を示す発話期間を生成する顔分析手段、前記複数のユーザの映像から、前記複数のユーザの手の動作を認識する手動作分析手段、前記顔分析手段によって生成された前記発話期間に基づいて、前記機器の周囲の音から音声を検出し、予め前記ユーザごとに登録された音響特徴量を用いて前記音声の内容および話者を認識する音声分析手段、前記顔分析手段によって認識された前記複数のユーザの中に前記音声分析手段によって認識された前記話者が含まれている場合、当該話者を前記指示を行っているユーザとして特定し、前記顔分析手段によって検出された前記ユーザの顔の変化と、前記手動作分析手段によって認識された前記ユーザの手の動作と、前記音声分析手段によって認識された前記ユーザの音声の内容と、に対して予め定められたコマンドを生成するコマンド生成手段、として機能させる構成とした。

【0011】

このような構成によれば、ユーザ指示取得プログラムは、顔分析手段によってユーザの顔の変化から当該ユーザが発話している期間を生成し、ユーザが発話している場合のみ音声認識を行うため、音声認識の精度を高めることができる。また、顔認識で認識したユーザと音声認識で認識した話者とを比較することで、機器に対して音声指示を行ったユーザを特定できるため、複数のユーザが機器を利用する場合であっても、コマンドを的確に生成することができる。

【0012】

また、請求項4に係るテレビ受像機は、ユーザに放送番組を提供するテレビ受像機であって、当該テレビ受像機に設置されたカメラの映像およびマイクの音を分析することで、前記ユーザの音声および動作による前記ユーザからの指示を取得する請求項1または請求項2に記載のユーザ指示取得装置を備える構成とした。

【0013】

このような構成によれば、テレビ受像機は、顔分析手段によってユーザの顔の変化から当該ユーザが発話しているのか否かを判定し、ユーザが発話している場合のみ音声認識を行うため、音声認識の精度を高めることができる。また、顔認識で認識したユーザと音声認識で認識した話者とを比較することで、機器に対して音声指示を行ったユーザを特定できるため、複数のユーザが機器を利用する場合であっても、コマンドを的確に生成することができる。

【発明の効果】

【0014】

請求項1、請求項2、請求項3および請求項4に係る発明によれば、ユーザの顔の変化から当該ユーザの発話状態を自動的に判定するとともに、ユーザが機器に対して音声および動作による指示を行うだけでコマンドを生成することができる。従って、複雑な操作を行うことなく、ユーザの自然な行動の延長上でその指示内容を機器に伝え、当該機器を制御することができる。

【図面の簡単な説明】

【0015】

【図1】本発明に係るユーザ指示取得装置の全体構成を示すブロック図である。

【図2】(a)は、本発明に係るユーザ指示取得装置における発話状態推定手段の具体的構成を示すブロック図であり、(b)は、本発明に係るユーザ指示取得装置における発話条件記憶部が予め保持する発話条件の一例を示す図である。

【図3】(a)は、本発明に係るユーザ指示取得装置におけるコマンド生成手段の具体的構成を示すブロック図であり、(b)は、本発明に係るユーザ指示取得装置におけるコマンド条件記憶部が予め保持するコマンド条件の一例を示す図である。

【図4】本発明に係るユーザ指示取得装置におけるユーザの指示の一例を示す図である。

【図5】本発明に係るユーザ指示取得装置の動作を示すフローチャートである。

【図6】本発明に係るユーザ指示装置を備えるテレビ受像機の一例を示す概略図である。

【発明を実施するための形態】

【0016】

本発明の実施形態に係るユーザ指示取得装置、ユーザ指示取得プログラムおよびテレビ受像機について、図面を参照しながら説明する。なお、以下の説明において、同一の構成については同一の名称及び符号を付し、詳細説明を省略する。

【0017】

[ユーザ指示取得装置]

ユーザ指示取得装置1は、テレビ等の機器を利用する複数のユーザの中から当該機器を制御するための指示を行っているユーザを特定し、当該ユーザからの指示を取得するためのものである。

【0018】

ユーザ指示取得装置1は、例えば図6に示すように、ユーザに放送番組を提供するテレビ受像機(以下、テレビという)Tと接続され、テレビT上部に設置されたカメラCrおよびマイクMから入力されたユーザの映像および音声を分析することでユーザの指示を取得する。そして、ユーザ指示取得装置1は、図1に示すように、これに対応するコマンドを生成し、当該コマンドを機器の制御部等に出力する。なお、ユーザ指示取得装置1は、図6に示すようにテレビTの外部に備えられるのではなく、当該テレビTの内部に内蔵されてもよい。

【0019】

ユーザ指示取得装置1は、ここでは図1に示すように、音声分析手段10と、顔分析手段20と、手動作分析手段30と、を備えている。また、ユーザ指示取得装置1は、前記したように、機器を利用するユーザの映像を撮影するためのカメラCrと、機器の周囲の音を集音するためのマイクMと、を備えている。なお、ユーザ指示取得装置1が備えるカメラCrとマイクMは、例えば前記した図6に示すように、機器の上部に設置され、機器を利用するユーザの映像と、機器の周囲の音と、を取得できるように構成されている。以下、ユーザ指示取得装置1が備える各構成について、詳細に説明する。

【0020】

音声分析手段10は、マイクMによって集音した機器の周囲の音から音声を検出し、予めユーザごとに登録された音響特徴量を用いて音声の内容および話者を認識するものである。音声分析手段10は、ここでは図1に示すように、音声検出手段11と、音声認識手段12と、話者認識手段13と、を備えている。

【0021】

音声検出手段11は、機器の周囲の音から音声を検出するためのものである。音声検出手段11は、図1に示すように、マイクMから機器の周囲の音が入力されると、予め登録された音声の周波数特性等を用いて、機器の周囲の音から音声を抽出する。また、音声検出手段11は、後記する発話状態推定手段24から、ユーザが発話している期間を示す発話期間が入力されると、当該発話期間に検出した音声を音声認識手段12および話者認識手段13に出力する。すなわち、音声検出手段11は、ユーザが発話している間のみ、検出した音声を音声認識手段12および話者認識手段13に対して出力するように構成されている。なお、音声検出手段11は、前記した音声の周波数特性のデータを予め保持する図示しない記憶部を備えている。

【0022】

音声認識手段12は、音声からその音声の内容を認識するためのものである。音声認識手段12は、具体的には、音声の時間波形から音響分析によって、例えば、スペクトルの低次DCT成分等の周波数特性を音響特徴量として抽出し、予め登録されている全ての単語の発音に応じた音響モデルと照合し、さらに言語モデル(単語の連続出現頻度分布)も用いることで、音響的および言語的に最も可能性の高い単語列を認識結果として得る。なお、音声認識手段12は、前記した音響モデルおよび言語モデルを予め保持する図示しない記憶部を備えている。

【0023】

音声認識手段12には、図1に示すように、音声検出手段11から音声が入力される。そして、音声認識手段12は、前記した手法によって音声から単語列を抽出し、これを音声情報としてコマンド生成手段40の情報取得部41に出力する(図3(a)参照)。

【0024】

話者認識手段13は、音声からその音声の話者、すなわちどのユーザがその音声を発しているのかを認識するためのものである。話者認識手段13は、具体的には、音声から前記した音声認識手段12と同様の音響特徴量を抽出し、当該音響特徴量と特定の話者について予め登録されている話者モデルとを比較して、話者が誰であるかを判定する。

【0025】

話者認識手段13における話者の判定には、ベイズ情報量基準を用いることもできる。また、音響特徴量を音素のクラスに分類し、音素クラスの混合モデルを使って照合することもできる。なお、話者認識手段13は、前記した話者モデルを予め保持する図示しない記憶部を備えている。また、この話者モデルは、例えばユーザが予め特定の単語を発話し、このユーザの音声を氏名あるいはニックネーム等の登録名とともに前記した記憶部に登録することで作成することができる。

【0026】

話者認識手段13には、図1に示すように、音声検出手段11から音声が入力される。そして、話者認識手段13は、前記した手法によって音声から話者を判定し、これを話者 情報としてコマンド生成手段40の情報取得部41に出力する(図3(a)参照)。

【0027】

顔分析手段20は、カメラCrによって撮影された映像から、顔画像認識処理によって予め登録された複数のユーザのそれぞれを認識するとともに、複数のユーザのそれぞれの顔の変化を検出するものである。また、顔分析手段20は、複数のユーザの顔の変化から当該複数のユーザが発話しているか否かを判定するとともに、複数のユーザのそれぞれが発話している期間を示す発話期間を生成するものである。顔分析手段20は、ここでは図1に示すように、顔領域検出手段21と、顔変化検出手段22と、顔認識手段23と、発話状態推定手段24と、を備えている。

【0028】

顔領域検出手段21は、複数のユーザの映像から人物の顔の領域を検出するものである。顔領域検出手段21は、具体的には、複数のユーザの映像を構成する画像から、ユーザの普遍的な特徴を抽出し、それらの特徴を検出することで人物の顔の領域を検出する。なお、顔領域検出手段21は、画像からの前記普遍的特徴の抽出にハール関数を用いることで、高速処理が可能となる。

【0029】

顔領域検出手段21には、図1に示すように、カメラCrから機器を利用する複数のユーザの映像が入力される。そして、顔領域検出手段21は、前記した手法によって映像からユーザの顔の領域を検出し、これを顔領域情報として顔変化検出手段22の各検出部および顔認識手段23に出力する。

【0030】

顔変化検出手段22は、複数のユーザの映像から検出されたユーザの顔の領域から、それぞれのユーザの顔の変化を検出するものである。顔変化検出手段22は、例えば、顔領域検出手段21で3人分の顔の領域が検出された場合、当該3人分の顔の領域のそれぞれの顔の変化を検出する。顔変化検出手段22は、ここでは図1に示すように、顔の向き検出部221と、視線検出部222と、目の開閉検出部223と、口唇動き検出部224と、を備えている。

【0031】

顔の向き検出部221は、機器を基準とした複数のユーザの顔の向きを検出するものである。顔の向き検出部221は、例えば機器がテレビTである場合(図6参照)、前記した顔領域情報から、ユーザの顔の向きがテレビ画面の中央に対して水平方向および垂直方向にそれぞれどのくらいの角度回っているかを検出する。顔の向き検出部221は、具体的には、前記したハール関数や、後記するガボールウェーブレットによる特徴抽出により、例えばユーザの目と鼻と口の周りの特徴の配置情報をもとに、様々な顔の向きのテンプレートを記録しておき、それらテンプレートとのマッチングによってユーザの顔の向きを推定する。

【0032】

視線検出部222は、機器を基準とした複数のユーザの視線の向きを検出するものである。視線検出部222は、前記した顔領域情報から、ユーザの目の視線の向きが頭部に対して水平方向および垂直方向にそれぞれどのくらいの角度回っているかを検出する。視線検出部222は、顔領域検出手段21が検出したユーザの顔の領域をもとに、ユーザの顔内のパーツの配置情報に基づいてユーザの目の位置を推定し、事前に登録しておいた各視線の方向の画像パターンとのマッチングによりユーザの視線方向を推定する。なお、視線検出部222は、例えば機器がテレビTである場合(図6参照)、前記した顔の向き検出部221による検出結果と組み合わせることで、ユーザがテレビ画面のどのあたりを見ているかも推定することができる。

【0033】

目の開閉検出部223は、ユーザが目を開けているか、あるいは閉じているかを検出するものである。目の開閉検出部223は、視線検出部222と同様に、顔領域検出手段21が検出したユーザの顔の領域をもとに、ユーザの顔内のパーツの配置情報に基づいてユーザの目の位置を推定し、その位置に黒い部分がある場合に目を開けていると判定し、その位置に黒い部分がなくなった場合に目を閉じていると判定する。

【0034】

口唇動き検出部224は、ユーザの口唇の動きを検出するものである。口唇動き検出部224は、顔領域検出手段21が検出したユーザの顔の領域をもとに、ユーザの顔内のパーツの配置情報に基づいてユーザの口の位置を推定し、ブロックマッチングやLucas−Kanadeの手法等の動き検出アルゴリズムによって口唇の動きベクトルを抽出し、動きベクトルのパワーがある閾値を越え、かつそのパワー変動に周期性が見られる場合に、ユーザの口唇が動いて発話していると判定する。

【0035】

そして、顔変化検出手段22は、前記した顔の向き検出部221、視線検出部222、目の開閉検出部223および口唇動き検出部224が顔の領域ごとに検出した顔の変化を、顔変化情報として発話状態推定手段24の発話状態判定部241に出力するとともに(図2(a)参照)、コマンド生成手段40の情報取得部41に出力する(図3(a)参照)。

【0036】

顔認識手段23は、複数のユーザの映像から検出されたユーザの顔の領域から、当該領域に含まれるユーザを認識するものである。顔認識手段23は、前記した顔領域検出手段21で検出された顔の領域に対して顔画像認識技術を適用し、誰が機器を利用しているのかを判定する。顔認識手段23は、例えば機器がテレビTである場合(図6参照)であって3人のユーザがテレビを視聴している場合、顔画像認識技術を用いて、3つの顔の領域からそれぞれの領域の顔に対応するユーザの氏名、あるいはニックネーム等の登録名を割り出す。

【0037】

顔認識手段23は、具体的には、ガボールウェーブレットによる局所的な輝度成分の周波数分析結果を特徴とするテンプレートマッチング手法によって前記した顔の領域に含まれる顔からユーザを特定する。顔認識手段23は、具体的には、顔領域検出手段21が検出したユーザの顔の領域における目と鼻と口の周りで決めた位置の特徴量とその配置情報を顔特徴量として抽出し、予め登録されているユーザの画像特徴量と照合することでユーザを特定する。

【0038】

また、顔認識手段23は、表情変化などに対しても認識性能を落とさないために、特徴の配置の位置関係の変形も許す手法を用いることもできる。なお、顔認識手段23は、前記した顔特徴量を予め保持する図示しない記憶部を備えている。また、この顔特徴量は、例えばユーザが予め特定の角度から顔を撮影し、その顔画像を氏名あるいはニックネーム等の登録名とともにユーザ指示取得装置1に登録することで、作成することができる。

【0039】

顔認識手段23には、図1に示すように、顔領域検出手段21から顔領域情報が入力される。そして、顔認識手段23は、前記した手法によって顔領域情報からユーザを認識し、これを人物情報としてその検出時間とともにコマンド生成手段40の情報取得部41に出力する(図3(a)参照)。

【0040】

発話状態推定手段24は、複数のユーザの顔の変化から、当該複数のユーザが発話しているか否かを判定するとともに、複数のユーザが発話している期間を示す発話期間を生成するものである。発話状態推定手段24は、ここでは図2(a)に示すように、発話状態判定部241と、発話条件記憶部242と、を備えている。

【0041】

発話状態判定部241は、ユーザが発話しているか否かを判定するためのものである。発話状態判定部241には、図2(a)に示すように、顔変化検出手段22から、ユーザの顔の向き、ユーザの視線、ユーザの目の開閉、ユーザの口唇動き等の情報からなる顔変化情報と、これらのユーザの顔の変化を検出した検出時間(図示省略)と、が入力される。また、発話状態判定部241には、図2(a)に示すように、発話条件を予め保持する発話条件記憶部242から発話条件が入力される。

【0042】

ここで、発話条件とは、ユーザが発話していると判定するために予め定められた条件であり、図2(b)に示すように、ユーザの顔の向き、視線、目の開閉、口唇動き等の顔の変化の検出結果によって決定される条件のことを示している。すなわち、発話状態判定部241は、顔変化検出手段22によって検出されたユーザの顔の変化がこの発話条件を満たしている場合に限り、機器を利用するユーザが発話状態にあると判定する。

【0043】

発話条件は、ここでは図2(b)に示すように、ユーザの顔が時間率80%以上で正面を向いていること、ユーザの視線が時間率80%以上でテレビ画面方向を向いていること、ユーザの目が時間率80%以上で開いていること、ユーザの口唇が時間率50%以上で動いていること、の全ての条件を満たしているときに、ユーザが発話状態にあると規定している。なお、前記した時間率とは、ユーザの顔の変化の検出時間に対する顔の変化の持続時間の割合を示している。例えば、顔変化検出手段22においてユーザの顔の変化を2秒間検出した場合、顔の変化が1秒持続していれば時間率は50%となり、1.6秒間持続していれば時間率は80%となる。

【0044】

なお、図2(b)に示した発話条件はあくまでも例示であり、発話条件および時間率は、機器の種類あるいはユーザの種別によって適宜変更することができる。例えば、図2(b)における発話条件の検出対象から顔の向き、視線、目の開閉を除外し、ユーザの口唇のみが所定の時間率以上で動いていれば、ユーザが発話状態にあると判定することもできる。

【0045】

発話状態判定部241は、顔変化検出手段22から入力される顔変化情報と、発話条件記憶部242から入力される発話条件とを照合し、当該発話条件を満たしている場合は、前記した顔変化情報の検出時間から、ユーザが発話している期間を示す発話期間を生成する。そして、発話状態判定部241は、図1および図2(a)に示すように、当該発話期間を音声検出手段11に出力する。

【0046】

なお、発話状態判定部241は、発話状態か否かの判定結果を機器に表示することが出好ましい。例えば機器がテレビTである場合(図6参照)、発話状態判定部241は、ユーザが発話状態にあると判定すると、テレビ画面にユーザが発話状態にあることを表示する。このように、発話状態か否かの判定結果をテレビ画面に表示することで、ユーザがテレビTを見続けることが期待できるため、判定精度を高めることができる。以下、図1に戻ってユーザ指示取得装置1の残りの構成について、説明する。

【0047】

手動作分析手段30は、カメラCrによって撮影した複数のユーザの映像から人物の手の領域を検出し、複数のユーザの手の動作を認識するものである。手動作分析手段30は、ここでは図1に示すように、手領域検出手段31と、手動作認識手段32と、を備えている。

【0048】

手領域検出手段31は、複数のユーザの映像から人物の手の領域を検出するものである。手領域検出手段31は、具体的には、複数のユーザの映像を構成する画像から、肌色と大まかな形状情報を用いて人物の手の領域を検出する。また、手領域検出手段31は、例えば、ユーザが指さしまたは手を差し伸べながら指示するという前提がある場合は、距離画像を用い、最も手前に出ている部分を切り出すことで、手の領域を特定することもできる。

【0049】

手領域検出手段31には、図1に示すように、カメラCrから機器を利用する複数のユーザの映像が入力される。そして、手領域検出手段31は、前記した手法によって映像からユーザの手の領域を検出し、これを手領域情報として手動作認識手段32に出力する。

【0050】

手動作認識手段32は、複数のユーザの映像から検出されたユーザの手の領域から、ユーザの手の動作を認識するものである。手動作認識手段32は、手領域検出手段31で検出された領域に対して動作認識手法を適用し、予め定められたコマンドに対応するユーザの手の動作を認識する。手動作認識手段32は、具体的には、ユーザの手の領域から、事前に作成した、例えばSIFTやSURFと呼ばれる普遍的な特徴の時系列データ、すなわち各特徴をフレームごとに追跡していくことにより得られるデータからなる各動作認識のテンプレートと、ユーザの手の領域から抽出したこれらの特徴量の時系列データとのマッチングを取ることで、動作認識を行うことができる。なお、手動作認識手段32は、ユーザの手動作の有無のみならず、その手動作の種類(指さし、指ふり等)も認識する。

【0051】

手動作認識手段32には、図1に示すように、手領域検出手段31から手領域情報が入力される。そして、手動作認識手段32は、前記した手法によってユーザの手の動作を認識し、これを手動作情報としてその検出時間とともにコマンド生成手段40の情報取得部41に出力する(図3(a)参照)。

【0052】

コマンド生成手段40は、顔分析手段20によって認識された複数のユーザの中に、音声分析手段10によって認識された話者が含まれている場合、顔分析手段20によって検出されたユーザの顔の変化と、手動作分析手段30によって認識されたユーザの手の動作と、音声分析手段10によって認識されたユーザの音声の内容と、に対して予め定められたコマンドを生成するものである。コマンド生成手段40は、ここでは図3(a)に示すように、情報取得部41と、コマンド生成部42と、コマンド条件記憶部43と、を備えている。

【0053】

情報取得部41は、機器を制御するためのコマンドの生成に必要な情報を取得するものである。情報取得部41には、図3(a)に示すように、顔変化検出手段22から顔変化情報が、顔認識手段23から人物情報が、手動作認識手段32から手動作情報が、音声認識手段12から音声情報が、話者認識手段13から話者情報が入力される。

【0054】

そして、情報取得部41は、顔認識手段23によって認識された人物の中に、話者認識手段13によって認識された話者が含まれている場合、すなわち、機器を利用する複数のユーザの中に、機器に対して音声指示を行ったユーザが含まれる場合、図3(a)に示すように、当該音声指示を行ったユーザの顔変化情報と、手動作情報と、音声情報と、をコマンド生成部42に出力する。このように、情報取得部41は、複数のユーザが機器を利用する場合において、顔認識手段23によって認識された複数のユーザの中から機器に指示を行っているユーザを特定することができる。なお、情報取得部41は、前記した顔変化情報、人物情報、手動作情報、音声情報および話者情報を一時的に保持するための図示しない記憶部を備えている。

【0055】

なお、顔変化検出手段22から情報取得部41に入力される顔変化情報は、顔領域検出手段21によって検出された顔の領域ごとの顔変化の情報である。また、顔認識手段23から情報取得部41に入力される人物情報も、同じく顔領域検出手段21によって検出された顔の領域ごとの氏名等の登録名の情報である。従って、情報取得部41は、顔の領域を基準とすることで、顔変化検出手段22から入力された顔変化情報がどのユーザの顔変化に関する情報であるかを判別することができる。

【0056】

また、情報取得部41には、前記したように、顔認識手段23から人物情報とともにその検出時間が入力され、手動作認識手段32から手動作情報とともにその検出時間が入力される。従って、情報取得部41は、検出時間を基準とすることで、手動作認識手段32から入力された手動作情報がどのユーザの手動作に関する情報であるかを判別することができる。

【0057】

コマンド生成部42は、機器を制御するための指示に対応するコマンドを生成するものである。コマンド生成部42には、図3(a)に示すように、情報取得部41から、機器に対して音声指示を行ったユーザの顔変化情報と、手動作情報と、音声情報と、が入力される。また、コマンド生成部42には、図3(a)に示すように、コマンド条件を予め保持するコマンド条件記憶部43からコマンド条件が入力される。

【0058】

ここで、コマンド条件とは、予め定められたコマンド生成のための条件であり、図3(b)に示すように、ユーザの顔の向き、視線、目の開閉、口唇動き、手動作、音声等の検出結果によって決定される条件のことを示している。すなわち、コマンド生成部42は、顔変化検出手段22によって検出されたユーザの顔の変化と、手動作認識手段32によって認識されたユーザの手の動作と、音声認識手段12によって認識されたユーザの音声と、がこのコマンド条件を満たしている場合に限り、コマンドを生成する。

【0059】

コマンド条件は、ここでは図3(b)に示すように、4つのパターンが規定されている。第1パターンは、図3(b)の検出結果の欄の第1列目であり、ユーザの顔が正面を向いており、ユーザの視線がテレビ画面方向を向いており、ユーザの目が開いており、ユーザの口唇が動いており、ユーザが手動作を行っており、ユーザが発話している場合に、音声指示内容および手動作指示内容を解析してコマンドを生成する旨が規定されている。これは、例えば図4(a)に示すユーザAのような状況の場合にコマンドを生成することを意味している。

【0060】

第2パターンは、図3(b)の検出結果の欄の第2列目であり、ユーザの顔が正面を向いており、ユーザの視線がテレビ画面方向を向いており、ユーザの目が開いており、ユーザの口唇が動いており、ユーザが手動作を行っておらず、ユーザが発話している場合に、音声指示内容を解析してコマンドを生成する旨が規定されている。これは、例えば図4(b)に示すユーザBのような状況の場合にコマンドを生成することを意味している。

【0061】

第3パターンは、図3(b)の検出結果の欄の第3列目であり、ユーザの顔が横を向いており、ユーザの視線が横方向を向いており、ユーザの目が開いており、ユーザの口唇が動いており、ユーザが手動作を行っており、ユーザが発話している場合に、音声指示内容および手動作指示内容を解析してコマンドを生成する旨が規定されている。これは、例えば図4(c)に示すユーザCのような状況の場合にコマンドを生成することを意味している。

【0062】

第4パターンは、図3(b)の検出結果の欄の第4列目であり、ユーザの顔が横を向いており、ユーザの視線が横方向を向いており、ユーザの目が閉じており、ユーザの口唇が動いており、ユーザが手動作を行っておらず、ユーザが発話している場合に、音声指示内容を解析してコマンドを生成する旨が規定されている。これは、例えば図4(d)に示すユーザDのような状況の場合にコマンドを生成することを意味している。

【0063】

なお、図3(b)に示したコマンド条件はあくまでも例示であり、機器の種類あるいはユーザの種別によって適宜変更することができる。例えば、図3(b)におけるコマンド条件の検出対象から顔の向き、視線、目の開閉を除外し、ユーザの口唇動きと音声のみをコマンド生成のための条件とすることもできる。

【0064】

ここで、コマンド生成部42は、機器を制御するためのコマンドリストを予め保持する図示しないデータベースを備えている。そして、コマンド生成部42は、音声認識手段12が認識したユーザの音声の内容および、手動作認識手段32が認識したユーザの手の動作に相当するコマンドを、前記したデータベースで検索することで、ユーザの音声指示内容および手動作指示内容を解析する。

【0065】

なお、前記したデータベースには、ユーザが日常的に発する自然な言葉や動作と、コマンドが関連付けられている。例えば、機器がテレビTである場合(図6参照)、ユーザがテレビTの音量が不足していることに関して発する「音ちっちゃいよね」、「声小さいな」、「よく聞こえないな」というような言葉は、前記したデータベースにおいて、「テレビの音量を上げる」というコマンドと関連付けられている。また、同様に、ユーザがテレビの音量が大きすぎることに関して行う「耳を塞ぐ」という動作は、前記したデータベースにおいて、「テレビの音量を下げる」というコマンドと関連付けられている。

【0066】

このように、コマンド生成部42のデータベースがユーザの自然な発話や動作に対応するコマンドリストを保持することで、ユーザが機器に対してより自然な状況下で指示を行うことができる。

【0067】

以上説明したような構成を備えるユーザ指示取得装置1は、顔分析手段20によってユーザの顔の変化から当該ユーザが発話しているのか否かを判定し、ユーザが発話している場合のみ音声認識を行うため、音声認識の精度を高めることができる。また、顔認識で認識したユーザと音声認識で認識した話者とを比較することで、機器に対して音声指示を行ったユーザを特定できるため、複数のユーザが機器を利用する場合であっても、コマンドを的確に生成することができる。

【0068】

また、ユーザ指示取得装置1によれば、ユーザの顔の変化から当該ユーザの発話状態を自動的に判定するとともに、ユーザが機器に対して音声および動作による指示を行うだけでコマンドを生成することができる。従って、複雑な操作を行うことなく、ユーザの自然な行動の延長上でその指示内容を機器に伝え、当該機器を制御することができる。

【0069】

ここで、ユーザ指示取得装置1は、一般的なコンピュータを、前記した各手段として機能させるプログラムにより動作させることで実現することができる。このプログラム(コンテンツ暗号化プログラム)は、通信回線を介して配布することも可能であるし、CD−ROM等の記録媒体に書き込んで配布することも可能である。

【0070】

[ユーザ指示取得装置の動作]

ユーザ指示取得装置1の動作について、図5を参照しながら簡単に説明する。

まず、ユーザ指示取得装置1が動作を開始すると、カメラCrが機器を利用する複数のユーザの映像を取得し、これを顔領域検出手段21および手領域検出手段31に出力する。また、マイクMが機器の周囲の音を取得し、これを音声検出手段11に出力する。そして、音声検出手段11が、機器の周囲の音から音声を検出する(ステップS1)。次に、顔領域検出手段21が、複数のユーザの映像から人物の顔の領域を検出し、これを顔領域情報として顔変化検出手段22の各検出部および顔認識手段23に出力する(ステップS2)。

【0071】

次に、顔変化検出手段22の各検出部が、複数のユーザの顔領域情報からユーザの顔の向き、視線、目の開閉、口唇動き等の顔の変化を検出し、これを顔変化情報として発話状態判定部241および情報取得部41に出力する(ステップS3)。次に、顔認識手段23が、複数のユーザの顔領域情報から当該領域に含まれる顔に対応する人物、すなわちユーザを認識し、これを人物情報として情報取得部41に出力する(ステップS4)。

【0072】

また、手領域検出手段31が、複数のユーザの映像から人物の手の領域を検出し、これを手領域情報として手動作認識手段32に出力する(ステップS5)。次に、手動作認識手段32が、複数のユーザの手領域情報からユーザの手の動作を認識し、これを手動作情報として情報取得部41に出力する(ステップS6)。

【0073】

次に、発話状態判定部241が、複数のユーザの顔変化情報が発話条件記憶部242から入力される発話条件を満たしているかどうかを判断し、複数のユーザが発話しているか否かを判定する(ステップS7)。そして、発話状態判定部241は、複数のユーザが発話していると判定した場合、ユーザが発話している期間を示す発話期間を生成し、これを音声検出手段11に出力する。これにより、音声検出手段11が、機器の周囲の音声を音声認識手段12および話者認識手段13に出力する(ステップS7でYes)。一方、発話状態判定部241は、複数のユーザが発話していると判定しなかった場合、新たな入力があるまで待機する(ステップS7でNo)。

【0074】

次に、音声認識手段12が、機器の周囲の音声からその音声の内容を認識し、これを音声情報として情報取得部41に出力する(ステップS8)。また、話者認識手段13が、機器の周囲の音声からその音声の話者を認識し、これを話者情報として情報取得部41に出力する(ステップS9)。

【0075】

次に、人物情報の人物の中に話者情報の話者が含まれる場合、情報取得部41が音声指示を行ったユーザの顔変化情報と、手動作情報と、音声情報と、をコマンド生成部42に出力する。そして、ユーザの顔変化情報と、手動作情報と、音声情報と、がコマンド条件を満たしている場合、コマンド生成部42がコマンドを生成する(ステップS10)。

【符号の説明】

【0076】

1 ユーザ指示取得装置

10 音声分析手段

11 音声検出手段

12 音声認識手段

13 話者認識手段

20 顔分析手段

21 顔領域検出手段

22 顔変化検出手段

23 顔認識手段

24 発話状態推定手段

30 手動作分析手段

31 手領域検出手段

32 手動作認識手段

40 コマンド生成手段

41 情報取得部

42 コマンド生成部

43 コマンド条件記憶部

221 顔の向き検出部

222 視線検出部

223 目の開閉検出部

224 口唇動き検出部

241 発話状態判定部

242 発話条件記憶部

Cr カメラ

M マイク

T テレビ受像機(テレビ)

【特許請求の範囲】

【請求項1】

機器を利用する複数のユーザの中から当該機器を制御するための指示を行っているユーザを特定し、当該ユーザからの指示を取得するユーザ指示取得装置であって、

カメラによって撮影された映像から、予め登録された前記複数のユーザのぞれぞれを認識するとともに前記複数のユーザのぞれぞれの顔の変化を検出し、当該顔の変化から前記複数のユーザのそれぞれが発話している期間を示す発話期間を生成する顔分析手段と、

前記複数のユーザの映像から、前記複数のユーザの手の動作を認識する手動作分析手段と、

前記顔分析手段によって生成された前記発話期間に基づいて、前記機器の周囲の音から音声を検出し、予め前記ユーザごとに登録された音響特徴量を用いて前記音声の内容および話者を認識する音声分析手段と、

前記顔分析手段によって認識された前記複数のユーザの中に前記音声分析手段によって認識された前記話者が含まれている場合、当該話者を前記指示を行っているユーザとして特定し、前記顔分析手段によって検出された前記ユーザの顔の変化と、前記手動作分析手段によって認識された前記ユーザの手の動作と、前記音声分析手段によって認識された前記ユーザの音声の内容と、に対して予め定められたコマンドを生成するコマンド生成手段と、

を備えることを特徴とするユーザ指示取得装置。

【請求項2】

前記顔分析手段は、

前記映像から前記複数のユーザの顔の領域を検出する顔領域検出手段と、

予め前記ユーザごとに登録された顔特徴量を用いて、前記顔の領域に対応するユーザを認識する顔認識手段と、

前記複数のユーザの顔の領域から、当該複数のユーザの顔の変化を検出する顔変化検出手段と、

前記複数のユーザの顔の変化から、当該複数のユーザが発話しているか否かを判定し、発話していると判定した場合に前記発話期間を生成する発話状態推定手段と、

を備えることを特徴とする請求項1に記載のユーザ指示取得装置。

【請求項3】

機器を利用する複数のユーザの中から当該機器を制御するための指示を行っているユーザを特定し、当該ユーザからの指示を取得するために、コンピュータを、

カメラによって撮影された映像から、予め登録された前記複数のユーザのぞれぞれを認識するとともに前記複数のユーザのぞれぞれの顔の変化を検出し、当該顔の変化から前記複数のユーザのそれぞれが発話している期間を示す発話期間を生成する顔分析手段、

前記複数のユーザの映像から、前記複数のユーザの手の動作を認識する手動作分析手段、

前記顔分析手段によって生成された前記発話期間に基づいて、前記機器の周囲の音から音声を検出し、予め前記ユーザごとに登録された音響特徴量を用いて前記音声の内容および話者を認識する音声分析手段、

前記顔分析手段によって認識された前記複数のユーザの中に前記音声分析手段によって認識された前記話者が含まれている場合、当該話者を前記指示を行っているユーザとして特定し、前記顔分析手段によって検出された前記ユーザの顔の変化と、前記手動作分析手段によって認識された前記ユーザの手の動作と、前記音声分析手段によって認識された前記ユーザの音声の内容と、に対して予め定められたコマンドを生成するコマンド生成手段、

として機能させることを特徴とするユーザ指示取得プログラム。

【請求項4】

ユーザに放送番組を提供するテレビ受像機であって、

当該テレビ受像機に設置されたカメラの映像およびマイクの音を分析することで、前記ユーザの音声および動作による前記ユーザからの指示を取得する請求項1または請求項2に記載のユーザ指示取得装置を備えることを特徴とするテレビ受像機。

【請求項1】

機器を利用する複数のユーザの中から当該機器を制御するための指示を行っているユーザを特定し、当該ユーザからの指示を取得するユーザ指示取得装置であって、

カメラによって撮影された映像から、予め登録された前記複数のユーザのぞれぞれを認識するとともに前記複数のユーザのぞれぞれの顔の変化を検出し、当該顔の変化から前記複数のユーザのそれぞれが発話している期間を示す発話期間を生成する顔分析手段と、

前記複数のユーザの映像から、前記複数のユーザの手の動作を認識する手動作分析手段と、

前記顔分析手段によって生成された前記発話期間に基づいて、前記機器の周囲の音から音声を検出し、予め前記ユーザごとに登録された音響特徴量を用いて前記音声の内容および話者を認識する音声分析手段と、

前記顔分析手段によって認識された前記複数のユーザの中に前記音声分析手段によって認識された前記話者が含まれている場合、当該話者を前記指示を行っているユーザとして特定し、前記顔分析手段によって検出された前記ユーザの顔の変化と、前記手動作分析手段によって認識された前記ユーザの手の動作と、前記音声分析手段によって認識された前記ユーザの音声の内容と、に対して予め定められたコマンドを生成するコマンド生成手段と、

を備えることを特徴とするユーザ指示取得装置。

【請求項2】

前記顔分析手段は、

前記映像から前記複数のユーザの顔の領域を検出する顔領域検出手段と、

予め前記ユーザごとに登録された顔特徴量を用いて、前記顔の領域に対応するユーザを認識する顔認識手段と、

前記複数のユーザの顔の領域から、当該複数のユーザの顔の変化を検出する顔変化検出手段と、

前記複数のユーザの顔の変化から、当該複数のユーザが発話しているか否かを判定し、発話していると判定した場合に前記発話期間を生成する発話状態推定手段と、

を備えることを特徴とする請求項1に記載のユーザ指示取得装置。

【請求項3】

機器を利用する複数のユーザの中から当該機器を制御するための指示を行っているユーザを特定し、当該ユーザからの指示を取得するために、コンピュータを、

カメラによって撮影された映像から、予め登録された前記複数のユーザのぞれぞれを認識するとともに前記複数のユーザのぞれぞれの顔の変化を検出し、当該顔の変化から前記複数のユーザのそれぞれが発話している期間を示す発話期間を生成する顔分析手段、

前記複数のユーザの映像から、前記複数のユーザの手の動作を認識する手動作分析手段、

前記顔分析手段によって生成された前記発話期間に基づいて、前記機器の周囲の音から音声を検出し、予め前記ユーザごとに登録された音響特徴量を用いて前記音声の内容および話者を認識する音声分析手段、

前記顔分析手段によって認識された前記複数のユーザの中に前記音声分析手段によって認識された前記話者が含まれている場合、当該話者を前記指示を行っているユーザとして特定し、前記顔分析手段によって検出された前記ユーザの顔の変化と、前記手動作分析手段によって認識された前記ユーザの手の動作と、前記音声分析手段によって認識された前記ユーザの音声の内容と、に対して予め定められたコマンドを生成するコマンド生成手段、

として機能させることを特徴とするユーザ指示取得プログラム。

【請求項4】

ユーザに放送番組を提供するテレビ受像機であって、

当該テレビ受像機に設置されたカメラの映像およびマイクの音を分析することで、前記ユーザの音声および動作による前記ユーザからの指示を取得する請求項1または請求項2に記載のユーザ指示取得装置を備えることを特徴とするテレビ受像機。

【図1】

【図2】

【図3】

【図4】

【図5】

【図6】

【図2】

【図3】

【図4】

【図5】

【図6】

【公開番号】特開2012−14394(P2012−14394A)

【公開日】平成24年1月19日(2012.1.19)

【国際特許分類】

【出願番号】特願2010−149860(P2010−149860)

【出願日】平成22年6月30日(2010.6.30)

【出願人】(000004352)日本放送協会 (2,206)

【Fターム(参考)】

【公開日】平成24年1月19日(2012.1.19)

【国際特許分類】

【出願日】平成22年6月30日(2010.6.30)

【出願人】(000004352)日本放送協会 (2,206)

【Fターム(参考)】

[ Back to top ]