ロボットシステムおよびそれに用いる空間陣形認識装置

【構成】 ロボットシステム100は、ロボット10およびモーションキャプチャシステム12を含む。ロボットシステム100では、ロボット10および人の位置、体の向きおよび視線方向を用いてロボット10と人との空間陣形を分析し、ロボット10および人の対話参加状態を認識する。そして、認識した対話参加状態に応じて、ロボット10が適宜の行動を取ることによって、ロボット10および人の双方が対話参加状態になるようにした後、ロボット10が人に対して挨拶発話を行う。

【効果】 双方が対話参加状態となる空間陣形を生成した後に挨拶発話を実行するので、ロボットは人との対話を自然に開始でき、円滑にコミュニケーションを図ることができる。

【効果】 双方が対話参加状態となる空間陣形を生成した後に挨拶発話を実行するので、ロボットは人との対話を自然に開始でき、円滑にコミュニケーションを図ることができる。

【発明の詳細な説明】

【技術分野】

【0001】

この発明はロボットシステムおよびそれに用いる空間陣形認識装置に関し、特にたとえば、少なくとも発話を用いて人との間でコミュニケーションを実行するロボットを含む、ロボットシステムおよびそれに用いる空間陣形認識装置に関する。

【背景技術】

【0002】

近年、発話や身体動作などを用いて、展示案内や客引きなどの多様なサービスを提供するロボット(コミュニケーションロボット)が開発されている。ここで、ロボットが展示案内や客引きなどのサービスを提供する場合には、人とのインタラクション(コミュニケーション)をどのように引き起こすかが重要となる。ロボットが目新しい存在である場合には、人の方からインタラクションを開始してくれるかもしれないが、近い将来、ロボットの目新しさが薄れるであろうことを考慮すると、ロボット側から働きかけてインタラクションを開始する必要があると考えられるからである。

【0003】

すなわち、人とのコミュニケーションをより円滑に遂行し、サービスをより効率良く提供するためには、ロボットが、適切なタイミングおよび位置で人に話しかける機能、つまり人と対話(会話)を自然に始める機能を身に付けることが重要であると考えられる。

【0004】

たとえば、特許文献1には、従来の会話ロボットの一例が開示されている。特許文献1の会話ロボットは、人の顔または体の正面方向を検出し、検出した人の顔または体の正面方向に移動した後、人の目を見て人に話しかけるようにしている。

【0005】

一方、非特許文献1には、人同士がインタラクションを行う際に、F陣形と呼ばれる特定の空間陣形を維持することが開示されている。また、非特許文献2には、非特許文献1の空間陣形に関する考えを、人とロボットとのインタラクションに利用することが開示されている。

【特許文献1】特開2004−34274号公報 [G05D 1/02]

【非特許文献1】Kendon,A., 1990, Spatial Organization in Social Encounters: the F-formation System, in Conducting Interaction: Patterns of Behavior in Focused Encounters, A. Kendon ed., Cambridge University Press, pp. 209-238.

【非特許文献2】Kuzuoka, H., Suzuki, Y., Yamashita, J. and Yamazaki, K., 2010, Reconfiguring Spatial Formation Arrangement by Robot Body Orientation, ACM/IEEE Int. Conf. on Human-Robot Interaction (HRI2010), pp. 285-292.

【発明の概要】

【発明が解決しようとする課題】

【0006】

特許文献1の技術では、人の真正面に移動してから対話を開始している。人の真正面で人の目を見ながら話すことによって親近感は増すかもしれないが、人に声をかけるタイミングおよび位置としては、人の真正面に移動したときが常に適切であるとは限らない。たとえば、人間同士が対話をするときにいつでも、わざわざ相手の真正面に移動してから対話を始めるかというと、そうではないので、特許文献1の技術のようなロボットの行動は、不自然なものとなってしまう。すなわち、ロボットが人に話しかける状況というのは、様々であり、たとえば、人の正面方向から近づいて話しかける状況があれば、横方向や背後方向から近づいて話しかける状況もある。また、単に人との対話を目的とするだけの状況があれば、人に商品の説明をしたり、人を商品の近くまで誘導したりしなければならない状況もある。特許文献1の技術では、このような様々な状況に対して適切に対応することができない。

【0007】

また、非特許文献1および2の技術では、人同士、或いは人とロボットとが、既にインタラクションを開始していることを前提としている。つまり、様々な状況が起こり得る中で、ロボットが、人に対してどのようなタイミングおよび位置で話しかけて対話を開始すればよいかについては、明らかにされていない。

【0008】

それゆえに、この発明の主たる目的は、新規な、ロボットシステムおよびそれに用いる空間陣形認識装置を提供することである。

【0009】

この発明の他の目的は、人との対話を自然に開始できる、ロボットシステムおよびそれに用いる空間陣形認識装置を提供することである。

【課題を解決するための手段】

【0010】

この発明は、上記の課題を解決するために、以下の構成を採用した。なお、括弧内の参照符号および補足説明などは、本発明の理解を助けるために後述する実施の形態との対応関係を示したものであって、この発明を何ら限定するものではない。

【0011】

第1の発明は、少なくとも発話を用いて人との間でコミュニケーションを実行するロボットを含むロボットシステムであって、位置、体の向きおよび視線方向を含む人およびロボットの配置情報を検出する検出手段、検出手段によって検出された配置情報に基づいて人とロボットとの空間陣形を分析し、人およびロボットの対話参加状態を判定する判定手段、判定手段によって人およびロボットの少なくとも一方が対話参加状態でないと判断されたとき、人およびロボットの双方が対話参加状態となるようにロボットの動作を制御する空間陣形調整手段、および判定手段によって人およびロボットの双方が対話参加状態であると判断されたとき、人に対する挨拶発話をロボットに実行させる挨拶実行手段を備える、ロボットシステムである。

【0012】

第1の発明では、ロボットシステム(100)は、少なくとも発話を用いて人との間でコミュニケーションを実行するロボット(10)を含む。このロボットは、配置された環境内において、人に対して自ら話しかけて人とのインタラクションを引き起こす。検出手段(12,62,66,84,86,S1)は、人およびロボットの配置情報、たとえば位置、体の向きおよび視線方向を検出する。判定手段(62,66,S3)は、人およびロボットの配置情報に基づいて空間陣形(空間的な配置関係)を分析することによって、人およびロボットの対話参加状態を判定する。ここで、対話参加状態とは、対話への参加に対して暗黙的に同意した状態(心的同意状態)をいい、たとえば、人および自身に対して予め定義される視線領域(gz)、正面領域(bz)、視野領域(sz)および視野(fv)を用いて表される空間陣形に基づいて推定(認識)される。空間陣形調整手段(26,54,62,66,82,S5−17)は、人およびロボットの対話参加状態に応じてロボットの動作を制御し、人およびロボットの双方が対話参加状態となる空間陣形を形成する。挨拶実行手段(54,62,66,S19)は、人およびロボットの双方が対話参加状態(双方参加状態)になったとき、「こんにちは」や「いらっしゃいませ」等の挨拶発話をロボットに実行させる。

【0013】

第1の発明によれば、双方が対話参加状態となる空間陣形を生成した後に挨拶発話を実行するので、人との対話を自然に開始でき、円滑にコミュニケーションを図ることができる。

【0014】

第2の発明は、第1の発明に従属し、判定手段は、人の頭部およびロボットの頭部が共に相手の視線領域に入る状態の空間陣形になったとき、人およびロボットの双方が対話参加状態であると判断する。

【0015】

第2の発明では、判定手段(62,66,S3)は、人の頭部がロボット(10)の視線領域(gz)に入り、かつロボットの頭部(52)が人の視線領域に入る状態の空間陣形になったとき、つまり所定距離内で人およびロボットの視線が合ったとき、双方参加状態であると判断する。これによって、双方参加状態を適切に認識できる。

【0016】

第3の発明は、第1または第2の発明に従属し、判定手段は、人およびロボットが共に相手の正面領域に入る状態の空間陣形になったとき、人およびロボットの双方が対話参加状態であると判断する。

【0017】

第3の発明では、判定手段(62,66,S3)は、ロボット(10)の正面領域(bz)に人が入り、かつ人の正面領域にロボットが入る状態の空間陣形になったとき、双方参加状態であると判断する。これによって、双方参加状態を適切に認識できる。

【0018】

第4の発明は、第1ないし第3のいずれかの発明に従属し、判定手段は、人の頭部およびロボットの頭部が共に相手の視線領域に入る状態ではなく、人の正面領域にロボットが入り、ロボットの正面領域に人が入らず、かつロボットの視野に人が入る状態の空間陣形になったとき、人のみが対話参加状態であると判断する。

【0019】

第4の発明では、判定手段(62,66,S3)は、所定距離内で人およびロボット(10)の視線が合う状態ではなく、人の正面領域(bz)にロボットが入り、ロボットの正面領域に人が入らず、かつロボットの視野(fv)に人が入る状態の空間陣形になったとき、人のみが対話参加状態であると判断する。これによって、人のみが対話参加状態であることを適切に認識できる。

【0020】

第5の発明は、第1ないし第4のいずれかの発明に従属し、判定手段は、人の頭部およびロボットの頭部が共に相手の視線領域に入る状態ではなく、ロボットの正面領域に人が入り、人の正面領域にロボットが入らず、かつ人の視野領域にロボットが入る状態の空間陣形になったとき、ロボットのみが対話参加状態であると判断する。

【0021】

第5の発明では、判定手段(62,66,S3)は、所定距離内で人およびロボット(10)の視線が合う状態ではなく、ロボットの正面領域(bz)に人が入り、人の正面領域にロボットが入らず、かつ人の視野領域(sz)にロボットが入る状態の空間陣形になったとき、ロボットのみが対話参加状態であると判断する。これによって、ロボットのみが対話参加状態であることを適切に認識できる。

【0022】

第6の発明は、第1ないし第5のいずれかの発明に従属し、空間陣形調整手段は、判定手段によって人およびロボットの双方が対話参加状態でないと判断されたとき、空間陣形の主動調整移動をロボットに実行させる主動調整手段を含む。

【0023】

第6の発明では、空間陣形調整手段(26,54,62,66,82,S5−17)は、主動調整手段(26,62,66,82,S5,S7)を含む。主動調整手段は、判定手段(62,66,S3)によって、人およびロボット(10)の双方が対話参加状態でない、すなわち双方非参加状態である判断されたとき、ロボットに空間陣形の主動調整移動を実行させる。たとえば、空間陣形の主動調整移動では、ロボットの正面領域(fz)に人が入り、かつ人の視野領域(fv)にロボットが入るような地点(或いは配置状態)を移動目標位置として設定してロボットを移動させる。

【0024】

第6の発明によれば、少なくともロボットが対話参加状態になる空間陣形が確保される。

【0025】

第7の発明は、第6の発明に従属し、主動調整手段は、説明すべき対象物があるとき、対象物の説明を行い易い地点をロボットの移動目標位置として選択する。

【0026】

第7の発明では、主動調整手段(26,62,66,82,S5,S7)は、説明すべき対象物があるとき、対象物の説明を行い易い地点をロボット(10)の移動目標位置として設定する。たとえば、ロボットの正面領域(fz)に人が入り、かつ人の視野領域(fv)にロボットが入るような地点を移動目標位置として設定するという条件を満たす上で、さらに、対象物がロボットおよび人の双方の視野(fv)に入る空間陣形となるように、移動目標位置が設定される。

【0027】

第7の発明によれば、対象物の説明を行い易い地点をロボットの移動目標位置として選択するので、ロボットは、対話を始めた後の位置や体の向き等の調整を極力避けることができ、より自然で円滑なインタラクションを人との間で実行できる。

【0028】

第8の発明は、第1ないし第7のいずれかの発明に従属し、空間陣形調整手段は、判定手段によって人のみが対話参加状態であると判断されたとき、空間陣形の受動調整移動をロボットに実行させる受動調整手段を含む。

【0029】

第8の発明では、空間陣形調整手段(26,54,62,66,82,S5−17)は、受動調整手段(26,62,66,82,S9,S11)を含む。受動調整手段は、判定手段(62,66,S3)によって、人のみが対話参加状態であると判断されたとき、ロボット(10)に空間陣形の受動調整移動を実行させる。たとえば、空間陣形の受動調整移動では、ロボットの正面領域(fz)に人が入るように体の向きを調整することによって、ロボットも対話参加状態になるようにされる。

【0030】

第8の発明によれば、人の方からロボットに働きかけようとした場合に、ロボットが人に興味を持っていることを人に示すことができるので、人が途中で諦めてロボットから離れてしまうことを防止できる。

【0031】

第9の発明は、第1ないし第8のいずれかの発明に従属し、空間陣形調整手段は、判定手段によってロボットのみが対話参加状態であると判断されたとき、注意喚起発話をロボットに実行させる注意喚起実行手段を含む。

【0032】

第9の発明では、空間陣形調整手段(26,54,62,66,82,S5−17)は、注意喚起実行手段(54,62,66,S13,S15)を含む。注意喚起実行手段は、判定手段(62,66,S3)によって、ロボット(10)のみが対話参加状態であると判断されたとき、ロボットに「すみません」等の注意喚起発話を実行させる。この注意喚起発話によって、人に位置や体の向き等を調整してもらうことができるので、双方参加状態を実現できる。

【0033】

第9の発明によれば、人の前方の空間が狭い等して、ロボットが人の正面領域に回り込めない状況にも柔軟に対応でき、より自然で円滑なインタラクションを人との間で実行できる。

【0034】

第10の発明は、第1ないし第9のいずれかの発明に従属し、判定手段によって人およびロボットの双方が対話参加状態であると判断されたとき、対話に適した空間陣形となるようにロボットの動作を制御する対話陣形調整手段をさらに備える。

【0035】

第10の発明では、対話陣形調整手段(26,62,66,82,S21)をさらに備える。対話陣形調整手段は、対話のためにより適切な場所への調整移動をロボット(10)に実行させる。たとえば、双方参加状態となる空間陣形を維持しながら、人との距離が1.1−1.5mとなる領域にロボットを移動させる。

【0036】

第10の発明によれば、その後の人との対話をより快適に実行することができ、より自然で円滑なインタラクションを人との間で実行できる。

【0037】

第11の発明は、少なくとも発話を用いて人との間でコミュニケーションを実行するロボットの動作制御に用いられる空間陣形認識装置であって、位置、体の向きおよび視線方向を含む人およびロボットの配置情報を検出する検出手段、および検出手段によって検出された配置情報に基づいて人とロボットとの空間陣形を分析し、人およびロボットの対話参加状態を判定する判定手段を備える、空間陣形認識装置である。

【0038】

第11の発明では、空間陣形認識装置(10,62,66)は、少なくとも発話を用いて人との間でコミュニケーションを実行するロボット(10)の動作制御に用いられ、検出手段(12,62,66,84,86,S1)および判定手段(62,66,S3)を含む。検出手段(12,62,66,84,86,S1)は、人およびロボットの配置情報、たとえば位置、体の向きおよび視線方向を検出する。判定手段(62,66,S3)は、人およびロボットの配置情報に基づいて空間陣形(空間的な配置関係)を分析することによって、人およびロボットの対話参加状態を判定する。ここで、対話参加状態とは、対話への参加に対して暗黙的に同意した状態(心的同意状態)をいい、たとえば、人および自身に対して予め定義される視線領域(gz)、正面領域(bz)、視野領域(sz)および視野(fv)を用いて表される空間陣形に基づいて推定(認識)される。

【0039】

第11の発明によれば、人およびロボットの対話参加状態を判定できるので、この判定結果に合わせてロボットの動作を制御することによって、人との対話を自然に開始できるロボットを実現できる。

【発明の効果】

【0040】

この発明によれば、双方が対話参加状態となる空間陣形を生成した後に挨拶発話を実行するので、人との対話を自然に開始でき、円滑にコミュニケーションを図ることができる。

【0041】

この発明の上述の目的、その他の目的、特徴および利点は、図面を参照して行う後述の実施例の詳細な説明から一層明らかとなろう。

【図面の簡単な説明】

【0042】

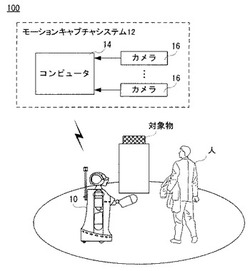

【図1】この発明の一実施例のロボットシステムの構成を示す図解図である。

【図2】図1のロボットの外観を正面から見た様子を示す図解図である。

【図3】図1のロボットの電気的構成を示すブロック図である。

【図4】視線領域の定義の一例を示す図解図である。

【図5】正面領域の定義の一例を示す図解図である。

【図6】視線領域および視線の定義の一例を示す図解図である。

【図7】双方参加状態となる空間陣形の一例を示す図解図である。

【図8】双方参加状態となる空間陣形の他の一例を示す図解図である。

【図9】人のみ参加状態となる空間陣形の一例を示す図解図である。

【図10】ロボットのみ参加状態となる空間陣形の一例を示す図解図である。

【図11】対象物が無い場合の主動調整移動の目標位置の一例を示す図解図である。

【図12】対象物がある場合の主動調整移動の目標位置の一例を示す図解図である。

【図13】受動調整移動の目標位置の一例を示す図解図である。

【図14】対話陣形の調整移動の目標位置の一例を示す図解図である。

【図15】図3のCPUが実行する全体処理の一例を示すフロー図である。

【発明を実施するための形態】

【0043】

図1を参照して、この発明の一実施例であるロボットシステム100は、通信可能に接続されるロボット10とモーションキャプチャシステム12とを含む。ロボット10は、発話やジェスチャ等を用いて人との間でコミュニケーション行動を実行する相互作用指向のロボット(コミュニケーションロボット)であり、店舗やイベント会場などの様々な環境に配置される。そして、配置された環境内において、人に対して自ら話しかけて人とのインタラクションを引き起こし、展示案内、客引きおよびエンタテインメントなどの様々なサービスを提供する。ロボットシステム100では、詳細は後述するように、ロボット10と人との空間陣形を適切に調整することによって、ロボット10が人(対話者)との対話を自然に開始できるようにしている。

【0044】

図2は、ロボット10の外観を示す正面図である。この図2を参照して、ロボット10のハードウェアの構成について説明する。

【0045】

ロボット10は、台車20を含み、この台車20の下面には、ロボット10を自律移動させる2つの車輪22および1つの従輪24が設けられる。2つの車輪22は車輪モータ26(図3参照)によってそれぞれ独立に駆動され、ロボット10を前後左右任意の方向に動かすことができる。また、従輪24は車輪22を補助する補助輪である。このように、ロボット10は、配置された環境内を自由に移動可能なものである。ただし、ロボット10の移動機構は、車輪タイプに限定されず、公知の移動機構を適宜採用でき、たとえば2足歩行タイプの移動機構を採用することもできる。

【0046】

なお、ロボット10は、このロボットシステム100が適用される環境の地図データを内部メモリ(メモリ66:図3参照)に記憶している。そして、ロボット10は、任意に設定された原点位置を基準として、地図データを参照して環境内を移動する。この際、ロボット10が参照する地図データの座標系と、モーションキャプチャシステム12のコンピュータ14で算出される座標の座標系とは同じに設定される。

【0047】

台車20の上には、円柱形のセンサ取付パネル28が設けられ、このセンサ取付パネル28には、赤外線距離センサ30が取り付けられる。この赤外線距離センサ30は、ロボット10と周囲の物体(人や障害物など)との距離を計測するものである。

【0048】

また、センサ取付パネル28の上には、胴体32が直立するように設けられる。胴体32の前方中央上部(胸に相当する位置)には、上述した赤外線距離センサ30がさらに設けられる。これは、ロボット10の前方の主として人との距離を計測する。また、胴体32には、1つの全方位カメラ34が設けられる。全方位カメラ34は、たとえば背面側上端部のほぼ中央から延びる支柱36上に設けられる。全方位カメラ34は、ロボット10の周囲を撮影するものであり、後述する眼カメラ60とは区別される。この全方位カメラ34としては、たとえばCCDやCMOSのような固体撮像素子を用いるカメラを採用することができる。なお、これら赤外線距離センサ30および全方位カメラ34の設置位置は当該部位に限られず適宜変更され得る。

【0049】

胴体32の両側面上端部(肩に相当する位置)のそれぞれには、肩関節38Rおよび38Lによって、上腕40Rおよび40Lが設けられる。図示は省略するが、肩関節38Rおよび38Lのそれぞれは、直交する3軸の自由度を有する。すなわち、肩関節38Rは、直交する3軸のそれぞれの軸廻りにおいて上腕40Rの角度を制御できる。肩関節38Rの或る軸(ヨー軸)は、上腕40Rの長手方向に平行な軸であり、他の2軸(ピッチ軸、ロール軸)は、それにそれぞれ異なる方向から直交する軸である。同様に、肩関節38Lは、直交する3軸のそれぞれの軸廻りにおいて上腕40Lの角度を制御できる。肩関節38Lの或る軸(ヨー軸)は、上腕40Lの長手方向に平行な軸であり、他の2軸(ピッチ軸、ロール軸)は、それにそれぞれ異なる方向から直交する軸である。

【0050】

また、上腕40Rおよび40Lのそれぞれの先端には、肘関節42Rおよび42Lを介して、前腕44Rおよび44Lが設けられる。図示は省略するが、肘関節42Rおよび42Lは、それぞれ1軸の自由度を有し、この軸(ピッチ軸)の軸廻りにおいて前腕44Rおよび44Lの角度を制御できる。

【0051】

前腕44Rおよび44Lのそれぞれの先端には、手に相当する球体46Rおよび46Lがそれぞれ固定的に設けられる。ただし、指や掌の機能が必要な場合には、人の手の形をした「手」を用いることも可能である。

【0052】

また、図示は省略するが、台車20の前面、肩関節38R,38Lを含む肩に相当する部位、上腕40R,40L、前腕44R,44Lおよび球体46R,46Lには、それぞれ、接触センサ(図3で接触センサ48として包括的に示す。)が設けられている。台車20の前面の接触センサ48は、台車20への人や他の障害物の接触を検知する。したがって、ロボット10の移動中に障害物との接触があると、それを検知し、直ちに車輪22の駆動を停止してロボット10の移動を急停止させることができる。また、その他の接触センサ48は、主に、人がロボット10の当該各部位に触れたかどうかを検知する。なお、接触センサ48の設置位置はこれらに限定されず、適宜な位置(胸、腹、脇、背中、腰など)に設けられてよい。

【0053】

胴体32の中央上部(首に相当する位置)には首関節50が設けられ、さらにその上には頭部52が設けられる。図示は省略するが、首関節50は、3軸の自由度を有し、3軸の各軸廻りに角度制御可能である。或る軸(ヨー軸)はロボット10の真上(鉛直上向き)に向かう軸であり、他の2軸(ピッチ軸、ロール軸)は、それぞれ、それと異なる方向で直交する軸である。

【0054】

頭部52には、口に相当する位置に、スピーカ54が設けられる。スピーカ54は、ロボット10が、それの周辺の人に対して音声ないし音によってコミュニケーションを取るために用いられる。また、耳に相当する位置には、マイク56Rおよび56Lが設けられる。以下、右耳に相当するマイク56Rと左耳に相当するマイク56Lとをまとめて「マイク56」ということがある。マイク56は、周囲の音、とりわけコミュニケーションを実行する対象である人の声を取り込む。さらに、目に相当する位置には、眼球部58Rおよび58Lが設けられる。眼球部58Rおよび58Lは、それぞれ眼カメラ60Rおよび60Lを含む。以下、右の眼球部58Rと左の眼球部58Lとをまとめて「眼球部58」ということがあり、また、右の眼カメラ60Rと左の眼カメラ60Lとをまとめて「眼カメラ60」ということがある。

【0055】

眼カメラ60は、ロボット10に接近した人の顔や他の部分ないし物体などを撮影して、それに対応する映像信号を取り込む。眼カメラ60としては、上述した全方位カメラ34と同様のカメラを用いることができる。たとえば、眼カメラ60は眼球部58内に固定され、眼球部58は眼球支持部(図示せず)を介して頭部52内の所定位置に取り付けられる。図示は省略するが、眼球支持部は、2軸の自由度を有し、それらの各軸廻りに角度制御可能である。たとえば、この2軸の一方は、頭部52の上へ向かう方向の軸(ヨー軸)であり、他方は、一方の軸に直交しかつ頭部52の正面側(顔)が向く方向に直交する方向の軸(ピッチ軸)である。眼球支持部がこの2軸の各軸廻りに回転されることによって、眼球部58ないし眼カメラ60の先端(正面)側が変位され、カメラ軸すなわち視線方向が移動される。なお、上述のスピーカ54、マイク56および眼カメラ60の設置位置は、これらに限定されず、適宜な位置に設けてられてよい。

【0056】

なお、ロボット10は、人(特に子供)に威圧感を与えることのないように、大人よりも一回り小さい大きさになるように設計されており、その身長は120cmであり、半径は50cmである。

【0057】

図3は、ロボット10の電気的な構成を示すブロック図である。図3に示すように、ロボット10は、全体を制御するCPU62を含む。CPU62は、マイクロコンピュータ或いはプロセサとも呼ばれ、バス64を介して、メモリ66、モータ制御ボード68、センサ入力/出力ボード70および音声入力/出力ボード72等に接続される。

【0058】

メモリ66は、図示は省略するが、ROMやHDDおよびRAMを含む。ROMやHDDには、ロボット10の制御プログラムが予め記憶される。たとえば、人との間でコミュニケーション行動を実行するための行動制御プログラム、外部コンピュータ(モーションキャプチャシステム12)との間で必要な情報を送受信するための通信プログラム、モーションキャプチャシステム12等からのデータに基づいて人と自身との空間陣形を分析して人および自身の対話参加状態を判定する判定プログラム、および所定の空間陣形を形成するための空間陣形調整プログラム等である。また、ROMやHDDには、各行動を実行する際に発生すべき音声または声の音声データ(音声合成データ)、所定の身振りを提示するための角度データ、環境の地図データ、および説明すべき商品(対象物)に関するデータなどのデータも適宜記憶される。また、RAMは、ワークメモリやバッファメモリとして用いられる。

【0059】

モータ制御ボード68は、たとえばDSPで構成され、各腕や首関節50および眼球部58などの各軸モータの駆動を制御する。すなわち、モータ制御ボード68は、CPU62からの制御データを受け、右眼球部58Rの2軸のそれぞれの角度を制御する2つのモータ(図3では、まとめて「右眼球モータ」と示す。)74の回転角度を制御する。同様に、モータ制御ボード68は、CPU62からの制御データを受け、左眼球部58Lの2軸のそれぞれの角度を制御する2つのモータ(図3では、まとめて「左眼球モータ」と示す。)76の回転角度を制御する。

【0060】

また、モータ制御ボード68は、CPU62からの制御データを受け、右肩関節38Rの直交する3軸のそれぞれの角度を制御する3つのモータと右肘関節42Rの角度を制御する1つのモータとの計4つのモータ(図3では、まとめて「右腕モータ」と示す。)78の回転角度を調節する。同様に、モータ制御ボード68は、CPU62からの制御データを受け、左肩関節38Lの直交する3軸のそれぞれの角度を制御する3つのモータと左肘関節42Lの角度を制御する1つのモータとの計4つのモータ(図3では、まとめて「左腕モータ」と示す。)80の回転角度を調節する。

【0061】

さらに、モータ制御ボード68は、CPU62からの制御データを受け、首関節50の直交する3軸のそれぞれの角度を制御する3つのモータ(図3では、まとめて「頭部モータ」と示す。)82の回転角度を制御する。さらにまた、モータ制御ボード68は、CPU62からの制御データを受け、車輪22を駆動する2つのモータ(図3では、まとめて「車輪モータ」と示す。)26の回転角度を制御する。

【0062】

なお、この実施例では、車輪モータ26を除くモータは、制御を簡素化するために、ステッピングモータ或いはパルスモータを用いるようにしてある。ただし、車輪モータ26と同様に、直流モータを用いるようにしてもよい。

【0063】

センサ入力/出力ボード70もまた、同様に、DSPで構成され、各センサからの信号を取り込んでCPU62に与える。すなわち、赤外線距離センサ30のそれぞれからの反射時間に関するデータが、センサ入力/出力ボード70を通してCPU62に入力される。また、全方位カメラ34からの映像信号が、必要に応じてセンサ入力/出力ボード70で所定の処理を施された後、CPU62に入力される。眼カメラ60からの映像信号も、同様にして、CPU62に入力される。また、上述した複数の接触センサ48からの信号がセンサ入力/出力ボード70を介してCPU62に与えられる。

【0064】

音声入力/出力ボード72もまた、同様に、DSPで構成され、CPU62から与えられる音声合成データに従った音声または声がスピーカ54から出力される。また、マイク56からの音声入力が、音声入力/出力ボード56を介してCPU62に取り込まれる。

【0065】

また、CPU62は、バス64を介して通信LANボード84に接続される。通信LANボード84は、DSPで構成され、CPU62から送られる送信データを無線通信装置86に与え、無線通信装置86から送信データを、たとえば、無線LANのようなネットワークを介して外部コンピュータに送信する。また、通信LANボード84は、無線通信装置86を介してデータを受信し、受信したデータをCPU62に与える。つまり、この通信LANボード84および無線通信装置86によって、ロボット10は外部コンピュータなどと無線通信を行うことができる。

【0066】

図1に戻って、モーションキャプチャシステム12は、ロボット10および人の位置、体の方向および視線方向などを検出するために用いられ、PC等の汎用のコンピュータ14と環境に設置される複数のカメラ(赤外線カメラ)16とを備える。また、図示は省略するが、ロボット10および人には、複数の赤外線反射マーカが装着される。この実施例では、ロボット10および人のそれぞれ対して、頭部、胴体部および腕部などの適宜な位置に、合計23個の赤外線反射マーカが取り付けられる。また、ロボット10が人に対して説明(紹介)すべき対象物(商品など)にも、赤外線反射マーカが装着される。モーションキャプチャシステム12としては、公知のモーションキャプチャシステムが適用でき、たとえば、VICON社の光学式のモーションキャプチャシステムを用いることができる。

【0067】

モーションキャプチャシステム12のコンピュータ14は、カメラ16から画像データをたとえば60Hz(1秒間に60フレーム)で取得し、画像データを画像処理することによって、その計測時の全ての画像データにおける各赤外線反射マーカの2次元位置を抽出する。そして、コンピュータ14は、画像データにおける各赤外線反射マーカの2次元位置に基づいて、実空間における各赤外線反射マーカの3次元位置を算出することによって、ロボット10および人の位置(座標)、体の方向、および顔(視線)の方向を算出する。そして、コンピュータ14は、算出したロボット10および人の位置データ(座標データ)、体方向データおよび視線方向データ等の配置情報を、ロボット10(CPU62)からの要求に応じてロボット10に送信する。

【0068】

なお、ロボット10の位置、体の向きおよび視線方向は、必ずしもモーションキャプチャシステム12を用いなくても把握できる。たとえば、上述の車輪モータ26および頭部モータ66の回転角度などから、ロボット10の位置、体の向きおよび視線方向を計算によって求めることもできる。しかしながら、実施例では、CPU62のリアルタイムの計算量を軽減するために、モーションキャプチャ12を用いるようにした。

【0069】

このようなロボットシステム100では、ロボット10は、配置された環境内において、人に対して自ら働きかけて人とのインタラクションを引き起こし、展示案内、客引きおよびエンタテインメントなどの様々なサービスを提供する。ここで、ロボット10がサービスをより効率良く提供するためには、ロボット10が、適切なタイミングおよび位置で人に話しかける機能、つまり人と対話を自然に始める機能を身に付けることが重要である。

【0070】

本発明者らは、人同士が対話を始めるときの様子を注意深く観察したところ、人同士は、特定の空間陣形(つまり空間的な配置関係)を形成してから対話を始めることを見出した。そこで、この実施例では、それをモデル化してロボット10に実行させることによって、人と対話を自然に始めることができるロボットシステム100(ロボット10)を実現した。

【0071】

具体的には、本発明者らが、ロボット10がサービスを提供する際に幅広く利用できると考えられる、店員が客に対して話しかける状況を観察したところ、以下の4つの点が確認された。(1)客が店員の存在に気付いたとき(2人の視線が合ったとき)は、店員は、客との距離が所定距離(たとえば2.5m)に近づいたときに挨拶をし、その後対話をするときにはもう少し近づく(たとえば1.5m以内まで)。ただし、この際の所定距離は状況や環境などに依存する。(2)客の前方(正面方向を中心とする120°の範囲)から近づいてくる店員は、約2mの距離まで近づいたときに挨拶をし、その後対話をするときには1.5m以内まで近づく。(3)客の前方以外から近づいてくる店員は、客の視野(正面方向を中心とする270°の範囲)内に入るように移動し、約1.5mの距離まで近づく。そして、客が店員の接近に気付かない場合には、「すいません」等の注意喚起の言葉を発し、客に自身の存在を気付かせてから挨拶をする。(4)店員に次の計画、たとえば商品の説明をしたり、商品の場所まで客を誘導したりする必要があるときであって、客が店員の存在に気づいていないときには、店員は、商品の説明などの次の行動を起こし易い場所で挨拶を行う。

【0072】

以上の観察結果から、人同士が挨拶をして対話を始めるときには必ず、特定の空間陣形を形成することによって、双方が相手の存在を認識している状態、すなわち対話への参加に対して暗黙的に同意した状態(心的同意状態)が双方に対して形成されていることが分かる。この実施例では、この心的同意状態を「対話参加状態」と名付ける。また、観察結果からは、対話を始めるための空間陣形と対話をするための空間陣形とは、必ずしも同じではないことも分かる。つまり、ロボット10が人との対話を自然に開始するためには、先ず、ロボット10および人の双方を対話参加状態にする、つまり双方が対話参加状態となる空間陣形を形成することが重要であり、状況に応じて、対話をするのに適した空間陣形に調整することが必要であると言える。

【0073】

そこで、この実施例では、ロボット10が自ら働きかけて人との対話(インタラクション)を開始する際には、先ず、ロボット10と人との空間陣形を分析して、ロボット10および人の対話参加状態を認識(推定)する。そして、認識した対話参加状態に応じて、ロボット10が適宜の行動を取ることによって、ロボット10および人の双方が対話参加状態になるようにした後、ロボット10が人に対して挨拶発話を行うようにしている。以下、具体的に説明する。

【0074】

空間陣形に基づいて対話参加状態を認識するために、視線領域gz、正面領域fz、視野領域szおよび視野fvを次のように定義する。

【0075】

図4に示すように、視線領域gzは、視線方向gdを中心軸として、頭部(顔)の中心から顔正面方向に向かって延びる円錐形の領域であって、その頂角θが30°であり、頂点から底面までの距離が2.5mである領域とする。また、図5に示すように、正面領域fzは、体の正面方向bdを中心とする120°の範囲であって、体の中心からの距離が2m以内である扇形の領域とする。さらに、図6に示すように、視野領域szは、体の正面方向bdを中心とする270°の範囲であって、体の中心からの距離が1.5m以内である領域とする。また、視野fvは、体の正面方向bdを中心とする270°の範囲であって、体の中心からの距離制限がない領域とする。

【0076】

そして、次の所定の空間条件を満たすと、対話参加状態にあると判断する。

【0077】

(1)図7に示すように、ロボット10の視線領域gzに人の頭部(顔)が入り、かつ人の視線領域gzにロボット10の頭部52が入る状態の空間陣形になったとき、すなわち、ロボット10と人とが所定距離内で視線を合わせた状態になったときには、ロボット10および人の双方が対話参加状態である(双方参加状態)と判断する。(2)図8に示すように、ロボット10と人との視線が合わない状態で、ロボット10の正面領域fzに人が入り、かつ人の正面領域fzにロボット10が入る状態の空間陣形になったときには、ロボット10および人の双方が対話参加状態であると判断する。(3)図9に示すように、ロボット10と人との視線が合わない状態で、人の正面領域fzにロボット10が入り、ロボット10の正面領域fzに人が入らず、かつロボット10の視野fvに人が入る状態の空間陣形になったときには、人のみが対話参加状態(人のみ参加状態)であると判断する。(4)図10に示すように、ロボット10と人との視線が合わない状態で、ロボット10の正面領域fzに人が入り、人の正面領域fzにロボット10が入らず、かつ人の視野領域szにロボット10が入る状態の空間陣形になったときには、ロボット10のみが対話参加状態(ロボットのみ参加状態)であると判断する。(5)以上の空間条件1−4を満たさない空間陣形のときには、ロボット10および人の双方が対話参加状態でない(双方非参加状態)と判断する。

【0078】

なお、各領域を定義する具体的数値(閾値)は、人同士のコミュニケーションを観察した結果に基づいて決定した数値ではあるが、これらの最適値はロボット10を配置する環境や対話相手などによって変動する数値でもあるので、必要に応じて適宜変更するようにしてもよい。たとえば、見晴らしのよい広い場所では、視線領域gzを定義する距離の大きさは、2.5mよりも大きく設定してもよいし、ロボット10や対話相手の人の身長が高い場合には、各領域の距離設定を大きくとるようにしてもよい。また、或る領域内に入ったか否かの判断は、体(または頭部)の中心がその領域内に入ったか否かで判断してもよいし、体(または頭部)の全体がその領域内に入ったか否かで判断してもよい。

【0079】

ロボット10および人の対話参加状態を認識すると、その認識結果に応じてロボット10の行動(動作)が決定される。すなわち、ロボット10は、双方参加状態となる所定の空間陣形(つまり対話を始めるための空間陣形)を形成するための行動を行う。

【0080】

具体的には、双方非参加状態であると判断されたときには、ロボット10は、空間陣形の主動調整移動(Proactive adjustment of spatial formation)を行う。空間陣形の主動調整移動では、ロボット10は、ロボット10の正面領域fzに人が入り、かつ人の視野領域fvにロボット10が入るような地点(或いは配置状態)を移動目標位置として設定して移動する。

【0081】

この際、ロボット10に次の計画が無い場合、つまり単に人と対話をすることだけが目的の場合には、図11に示すように、自身の位置から最短距離となる地点が移動目標位置として選択される。ただし、図11から分かるように、ロボット10が人の正面領域fzの方向から近づく場合には、人の正面領域fzに入った時点で双方参加状態となるので、ロボット10は人の正面領域fzに入るだけでよい。また、人の視線領域gzの方向から近づく場合には、人の視線領域gzに入った時点で双方参加状態となるので、ロボット10は人の視線領域gzに入るだけでよい。

【0082】

一方、ロボット10に次の計画がある場合、たとえば商品の説明をしたり、商品の場所まで人を誘導したりする必要があるときには、空間陣形の主動調整移動は、次の行動を考慮した態様とされる。たとえば、説明すべき対象物がある場合には、ロボット10の正面領域fzに人が入り、かつ人の視野領域fvにロボット10が入るような地点を移動目標位置として設定するという条件を満たす上で、さらに、対象物の説明を行い易い地点が移動目標位置として選択される。具体的には、図12に示すように、対象物がロボット10および人の双方の視野fvに入る空間陣形となるように、移動目標位置が設定される。

【0083】

ただし、空間陣形の主動調整移動の実行途中に、人が移動したり、体の向きや視線方向を変えたりすることによって、双方参加状態になったり、人のみ参加状態になったりすると、ロボット10は、空間陣形の主動調整移動をそこで終了し、ロボット10および人の対話参加状態に応じた次の行動に移る。上述のような空間陣形の主動調整移動によって、少なくともロボット10が対話参加状態になる空間陣形が確保される。

【0084】

人のみ参加状態であると判断されたときには、ロボット10は、空間陣形の受動調整移動(Reactive adjustment of spatial formation)を行う。空間陣形の受動調整移動では、図13に示すように、ロボット10の正面領域fzに人が入るように体の向きを調整することによって、ロボット10も対話参加状態になるようにする。この際には、ロボット10の視線領域gzに人の頭部(顔)が入るように視線方向も調整するとよい。なお、人のみが対話参加状態になる空間陣形は、空間陣形の主動調整移動の途中に、人が移動したり、体の向きや視線方向を変えたりしたときに生じる状況、つまり人の方からロボット10に働きかけようとしている状況が想定されるので、対話のためにより適切な場所への調整移動(詳細は後述)も、空間陣形の受動調整移動において同時に行うようにしてもよい。この空間陣形の受動調整移動によって、ロボット10が人に興味を持っていることを人に示すことができるので、人の方からロボット10に働きかけようとした場合に、人が途中で諦めてロボット10から離れてしまうことを防止できる。

【0085】

ロボットのみ参加状態であると判断されたときには、ロボット10は、注意喚起発話を行う。ロボット10のみが対話参加状態になる空間陣形は、ロボット10が近づいたことを人が気づいていない状況が想定される。そこで、ロボット10は、「すみません」等の注意喚起発話を行うことによって、人に体の向きや視線方向を調整してもらい、双方参加状態の空間陣形を形成する。ここで重要なことは、ロボット10がすでに人の視野領域szに入っていることであり、これによって、人にとって不意打ちとなる話しかけが極力防止される。この注意喚起発話によって、人に体の向きや視線方向を調整してもらうことができるので、人の正面側の空間が狭い等して、ロボット10が人の正面領域fzに回り込めないような状況にも柔軟に対応できる。

【0086】

そして、双方参加状態であると判断されたときには、ロボット10は、人に対して「こんにちは」や「いらっしゃいませ」等の挨拶発話を実行する。双方参加状態は、ロボット10および人の双方が対話への参加に対して暗黙的に同意した状態である。すなわち、人側からすると、自身と対話したい(或いは自身との対話を受け入れる)という意思をロボット10から示された状態であり、かつロボット10との対話を受け入れる(或いはロボット10と対話したい)という意思をロボット10に示した状態となる。したがって、双方参加状態となったときのロボット10の挨拶発話は、極めて自然に人に受け入れられ、ロボット10は人との対話を自然に始めることができる。

【0087】

また、上述の人同士の対話の観察結果から、対話をするのに適した空間陣形(対話陣形)があることも分かったので、この実施例ではさらに、ロボット10が人と対話をする際には、対話のためにより適切な場所への調整移動(対話陣形の調整移動)も実行する。具体的には、図14に示すように、双方参加状態となる空間陣形を維持しながら、人との距離が、1.1−1.5mとなる領域に移動する。この対話陣形の調整移動によって、その後の人との対話をより快適に実行することができる。なお、対話陣形の調整移動は、ロボット10の挨拶発話が終わった後の次の発話を行う前に実行してもよいし、人との対話を行いながら実行してもよい。

【0088】

続いて、フロー図を用いて、人とのインタラクション(対話)を開始する際のロボット10(ロボットシステム100)の動作を説明する。具体的には、図3に示したロボット10のCPU62が、図15に示すフロー図に従って全体処理を実行する。図15を参照して、CPU62は、ステップS1において、ロボット10および人の位置、体の向きおよび視線方向を検出する。すなわち、ロボット10および人の位置データ、体方向データおよび視線方向データ等の配置情報を、無線通信装置86および通信LANボード84を介してモーションキャプチャシステム12から取得する。

【0089】

次のステップS3では、空間陣形からロボット10および人の対話参加状態を認識する。すなわち、ステップS1で取得した配置情報に基づいて、ロボット10と人との空間陣形を分析することによって、ロボット10および人の対話参加状態が、双方非参加状態、人のみ参加状態、ロボットのみ参加状態、および双方参加状態のいずれであるかを認識(判断)する。たとえば、双方の頭部が互いに相手の視線領域gzに入る状態の空間陣形になったとき(互いの視線が合ったとき)や、双方が互いの正面領域fzに入る状態の空間陣形になったときには、双方参加状態であると認識する。また、たとえば、互いの視線が合わない状態で、人の正面領域fzにロボット10が入り、ロボット10の正面領域fzに人が入らず、かつロボット10の視野fvに人が入る状態の空間陣形になったときには、人のみ参加状態であると判断する。さらに、たとえば、互いの視線が合わない状態で、ロボット10の正面領域fzに人が入り、人の正面領域fzにロボット10が入らず、かつ人の視野領域szにロボット10が入る状態の空間陣形になったときには、ロボットのみ参加状態であると判断する。また、人のみ参加状態、ロボットのみ参加状態、および双方参加状態となるいずれの空間条件(空間陣形)にも当てはまらない場合には、双方非参加状態であると判断する。なお、ステップS1およびS3の処理は、所定時間毎に繰り返し実行される。

【0090】

次のステップS5では、ステップS3で認識されたロボット10および人の対話参加状態が、双方共に非参加状態であるか否かを判定する。ステップS5で“YES”の場合、すなわち双方共に非参加状態である場合には、ステップS7に進み、ステップS5で“NO”の場合、すなわち双方共に非参加状態でない場合には、ステップS9に進む。

【0091】

ステップS7では、空間陣形の主動調整移動を実行する。すなわち、ロボット10の正面領域fzに人が入り、かつ人の視野領域fvにロボット10が入るような地点(或いは配置状態)を移動目標位置として設定し、その移動目標位置までロボット10が移動するように、車輪モータ26の回転角度を制御する制御データをモータ制御ボード68に対して送信する。この際、ロボット10に次の計画が無い場合、つまり単に人と対話をすることだけが目的の場合には、自身の位置から最短距離となる地点(或いは配置状態)が移動目標位置として選択される。一方、ロボット10に次の計画がある場合、たとえば商品の説明をしたり、商品の場所まで人を誘導したりする必要があるときには、その商品(対象物)がロボット10および人の双方の視野fvに入る空間陣形となるような地点が移動目標位置として設定される。ステップS7が終了すると、処理はステップS1に戻る。

【0092】

ステップS9では、ステップS3で認識されたロボット10および人の対話参加状態が、人のみ参加状態であるか否かを判定する。ステップS9で“YES”の場合、すなわち人のみ参加状態である場合には、ステップS11に進み、ステップS9で“NO”の場合、すなわち人のみ参加状態でない場合には、ステップS13に進む。

【0093】

ステップS11では、空間陣形の受動調整移動を実行する。すなわち、ロボット10の正面領域fzに人が入るように、車輪モータ26の回転角度を制御する制御データをモータ制御ボード68に対して送信して、ロボット10の体の向きを調整したり、ロボット10の視線領域gzに人の頭部が入るように、頭部モータ82の回転角度を制御する制御データをモータ制御ボード68に対して送信して、ロボット10の視線方向を調整したりして、ロボット10も対話参加状態になるようにする。この際には、対話のためにより適切な場所への調整移動も同時に行うようにしてもよい。ステップS11が終了すると、処理はステップS1に戻る。

【0094】

ステップS13では、ステップS3で認識されたロボット10および人の対話参加状態が、ロボットのみ参加状態であるか否かを判定する。ステップS13で“YES”の場合、すなわちロボットのみ参加状態である場合には、ステップS15に進み、ステップS13で“NO”の場合、すなわちロボットのみ参加状態でない場合には、ステップS17に進む。

【0095】

ステップS15では、注意喚起発話を実行する。すなわち、「すみません」等の注意喚起発話を行うための音声データを音声入力/出力ボード72に送信して、スピーカ54から注意喚起発話を出力する。ステップS15が終了すると、処理はステップS1に戻る。

【0096】

ステップS17では、ステップS3で認識されたロボット10および人の対話参加状態が、双方参加状態であるか否かを判定する。ステップS17で“YES”の場合、すなわち双方参加状態である場合には、ステップS19に進み、ステップS17で“NO”の場合、すなわち双方参加状態でない場合には、ステップS1に戻る。

【0097】

ステップS19では、挨拶発話を実行する。すなわち、「こんにちは」や「いらっしゃいませ」等のその状況に応じた挨拶発話を実行するための音声データを音声入力/出力ボード72に送信して、スピーカ54から注意喚起発話を出力する。この際には、挨拶発話と連動させて、お辞儀などの身体動作を実行するための制御データをモータ制御ボード68に対して送信するようにしてもよい。

【0098】

続くステップS21では、対話陣形の調整移動を実行する。すなわち、双方参加状態となる空間陣形を維持しながら、人との距離が1.1−1.5mとなる領域に移動するように、車輪モータ26の回転角度を制御する制御データをモータ制御ボード68に対して送信する。そして、ステップS21の処理によって、対話をするための空間陣形が確立されると、この全体処理を終了する。

【0099】

この実施例によれば、ロボット10および人の双方が対話参加状態となる空間陣形を生成した後に、ロボット10が挨拶発話を実行する。つまり、人間同士の対話により近い挨拶発話を実行するので、ロボット10の挨拶発話は、極めて自然に人に受け入れられる。したがって、ロボット10は、人との対話を自然に始めることができ、円滑に人とのコミュニケーションを図ることができる。

【0100】

また、この実施例によれば、ロボット10に次の計画がある場合には、ロボット10の空間陣形の主動調整移動は、次の行動を考慮した態様とされる。すなわち、説明すべき対象物がある場合には、対象物の説明を行い易い地点がロボット10の移動目標位置として選択される。これによって、ロボット10は、対話を始めた後の位置や体の向き等の調整を極力避けることができるので、より自然で円滑なインタラクションを人との間で実行できる。特に、ロボット10、人および対象物の空間関係が直線状に並んでしまうと、ロボット10が指差しジェスチャを用いて対象物を指し示すことが困難になってしまうが、この問題を回避できる。

【0101】

さらに、この実施例では、人のみが対話参加状態である判断されたときには、ロボット10は空間陣形の受動調整移動を行う。これによって、人の方からロボット10に働きかけようとした場合に、ロボット10が人に興味を持っていることを人に示すことができるので、人が途中で諦めてロボット10から離れてしまうことを防止できる。

【0102】

また、この実施例では、ロボット10のみが対話参加状態であると判断されたときには、ロボット10は注意喚起発話を行い、人に体の向きや視線方向を調整してもらう。これによって、人の前方の空間が狭い等して、ロボット10が人の正面領域fzに回り込めない状況にも柔軟に対応でき、より自然で円滑なインタラクションを人との間で実行できる。

【0103】

さらに、この実施例では、対話のためにより適切な場所への調整移動(対話陣形の調整移動)も実行する。これは、対話を始めるための空間陣形と対話をするための空間陣形とは、必ずしも同じになるとは限らないからであり、対話陣形の調整移動を行うことによって、より自然で円滑なインタラクションを人との間で実行できる。

【0104】

なお、上述の実施例では、モーションキャプチャシステム12を利用して、ロボット10および人の配置情報、つまり位置、体の向きおよび視線方向を検出するようにしたが、これに限定されず、公知の方法を適宜利用することができる。たとえば、人およびロボット10の位置検出および体の向きの検出については、この発明者らが先に出願した特開2009−168578号公報に開示したLRFを用いる方法を利用することができる。また、視線方向を計測する装置の一例として、株式会社ナックイメージテクノロジーの視線計測システム「アイマークレコーダ」の技術を利用することができる。

【0105】

また、上述の実施例では、ロボット10のCPU62が、ロボット10と人との空間陣形を分析して対話参加状態を認識する処理(ステップS3に相当)、および対話参加状態に応じて次の動作を制御する処理(ステップS5−S17に相当)を行うようにしたが、これに限定されない。たとえば、ロボット制御装置(或いは空間陣形認識装置)としての外部コンピュータを別に設け、空間陣形を分析してロボット10の動作を決定するこれらの処理の一部または全部を外部コンピュータに実行させて、外部コンピュータからロボット10に対して動作制御データを送信するようにしてもよい。

【0106】

なお、上で挙げた所定距離などの具体的数値は、いずれも単なる一例であり、必要に応じて適宜変更可能である。

【符号の説明】

【0107】

10 …コミュニケーションロボット

12 …モーションキャプチャシステム

22 …車輪

26 …車輪モータ

54 …スピーカ

62 …CPU

66 …メモリ

100 …ロボットシステム

【技術分野】

【0001】

この発明はロボットシステムおよびそれに用いる空間陣形認識装置に関し、特にたとえば、少なくとも発話を用いて人との間でコミュニケーションを実行するロボットを含む、ロボットシステムおよびそれに用いる空間陣形認識装置に関する。

【背景技術】

【0002】

近年、発話や身体動作などを用いて、展示案内や客引きなどの多様なサービスを提供するロボット(コミュニケーションロボット)が開発されている。ここで、ロボットが展示案内や客引きなどのサービスを提供する場合には、人とのインタラクション(コミュニケーション)をどのように引き起こすかが重要となる。ロボットが目新しい存在である場合には、人の方からインタラクションを開始してくれるかもしれないが、近い将来、ロボットの目新しさが薄れるであろうことを考慮すると、ロボット側から働きかけてインタラクションを開始する必要があると考えられるからである。

【0003】

すなわち、人とのコミュニケーションをより円滑に遂行し、サービスをより効率良く提供するためには、ロボットが、適切なタイミングおよび位置で人に話しかける機能、つまり人と対話(会話)を自然に始める機能を身に付けることが重要であると考えられる。

【0004】

たとえば、特許文献1には、従来の会話ロボットの一例が開示されている。特許文献1の会話ロボットは、人の顔または体の正面方向を検出し、検出した人の顔または体の正面方向に移動した後、人の目を見て人に話しかけるようにしている。

【0005】

一方、非特許文献1には、人同士がインタラクションを行う際に、F陣形と呼ばれる特定の空間陣形を維持することが開示されている。また、非特許文献2には、非特許文献1の空間陣形に関する考えを、人とロボットとのインタラクションに利用することが開示されている。

【特許文献1】特開2004−34274号公報 [G05D 1/02]

【非特許文献1】Kendon,A., 1990, Spatial Organization in Social Encounters: the F-formation System, in Conducting Interaction: Patterns of Behavior in Focused Encounters, A. Kendon ed., Cambridge University Press, pp. 209-238.

【非特許文献2】Kuzuoka, H., Suzuki, Y., Yamashita, J. and Yamazaki, K., 2010, Reconfiguring Spatial Formation Arrangement by Robot Body Orientation, ACM/IEEE Int. Conf. on Human-Robot Interaction (HRI2010), pp. 285-292.

【発明の概要】

【発明が解決しようとする課題】

【0006】

特許文献1の技術では、人の真正面に移動してから対話を開始している。人の真正面で人の目を見ながら話すことによって親近感は増すかもしれないが、人に声をかけるタイミングおよび位置としては、人の真正面に移動したときが常に適切であるとは限らない。たとえば、人間同士が対話をするときにいつでも、わざわざ相手の真正面に移動してから対話を始めるかというと、そうではないので、特許文献1の技術のようなロボットの行動は、不自然なものとなってしまう。すなわち、ロボットが人に話しかける状況というのは、様々であり、たとえば、人の正面方向から近づいて話しかける状況があれば、横方向や背後方向から近づいて話しかける状況もある。また、単に人との対話を目的とするだけの状況があれば、人に商品の説明をしたり、人を商品の近くまで誘導したりしなければならない状況もある。特許文献1の技術では、このような様々な状況に対して適切に対応することができない。

【0007】

また、非特許文献1および2の技術では、人同士、或いは人とロボットとが、既にインタラクションを開始していることを前提としている。つまり、様々な状況が起こり得る中で、ロボットが、人に対してどのようなタイミングおよび位置で話しかけて対話を開始すればよいかについては、明らかにされていない。

【0008】

それゆえに、この発明の主たる目的は、新規な、ロボットシステムおよびそれに用いる空間陣形認識装置を提供することである。

【0009】

この発明の他の目的は、人との対話を自然に開始できる、ロボットシステムおよびそれに用いる空間陣形認識装置を提供することである。

【課題を解決するための手段】

【0010】

この発明は、上記の課題を解決するために、以下の構成を採用した。なお、括弧内の参照符号および補足説明などは、本発明の理解を助けるために後述する実施の形態との対応関係を示したものであって、この発明を何ら限定するものではない。

【0011】

第1の発明は、少なくとも発話を用いて人との間でコミュニケーションを実行するロボットを含むロボットシステムであって、位置、体の向きおよび視線方向を含む人およびロボットの配置情報を検出する検出手段、検出手段によって検出された配置情報に基づいて人とロボットとの空間陣形を分析し、人およびロボットの対話参加状態を判定する判定手段、判定手段によって人およびロボットの少なくとも一方が対話参加状態でないと判断されたとき、人およびロボットの双方が対話参加状態となるようにロボットの動作を制御する空間陣形調整手段、および判定手段によって人およびロボットの双方が対話参加状態であると判断されたとき、人に対する挨拶発話をロボットに実行させる挨拶実行手段を備える、ロボットシステムである。

【0012】

第1の発明では、ロボットシステム(100)は、少なくとも発話を用いて人との間でコミュニケーションを実行するロボット(10)を含む。このロボットは、配置された環境内において、人に対して自ら話しかけて人とのインタラクションを引き起こす。検出手段(12,62,66,84,86,S1)は、人およびロボットの配置情報、たとえば位置、体の向きおよび視線方向を検出する。判定手段(62,66,S3)は、人およびロボットの配置情報に基づいて空間陣形(空間的な配置関係)を分析することによって、人およびロボットの対話参加状態を判定する。ここで、対話参加状態とは、対話への参加に対して暗黙的に同意した状態(心的同意状態)をいい、たとえば、人および自身に対して予め定義される視線領域(gz)、正面領域(bz)、視野領域(sz)および視野(fv)を用いて表される空間陣形に基づいて推定(認識)される。空間陣形調整手段(26,54,62,66,82,S5−17)は、人およびロボットの対話参加状態に応じてロボットの動作を制御し、人およびロボットの双方が対話参加状態となる空間陣形を形成する。挨拶実行手段(54,62,66,S19)は、人およびロボットの双方が対話参加状態(双方参加状態)になったとき、「こんにちは」や「いらっしゃいませ」等の挨拶発話をロボットに実行させる。

【0013】

第1の発明によれば、双方が対話参加状態となる空間陣形を生成した後に挨拶発話を実行するので、人との対話を自然に開始でき、円滑にコミュニケーションを図ることができる。

【0014】

第2の発明は、第1の発明に従属し、判定手段は、人の頭部およびロボットの頭部が共に相手の視線領域に入る状態の空間陣形になったとき、人およびロボットの双方が対話参加状態であると判断する。

【0015】

第2の発明では、判定手段(62,66,S3)は、人の頭部がロボット(10)の視線領域(gz)に入り、かつロボットの頭部(52)が人の視線領域に入る状態の空間陣形になったとき、つまり所定距離内で人およびロボットの視線が合ったとき、双方参加状態であると判断する。これによって、双方参加状態を適切に認識できる。

【0016】

第3の発明は、第1または第2の発明に従属し、判定手段は、人およびロボットが共に相手の正面領域に入る状態の空間陣形になったとき、人およびロボットの双方が対話参加状態であると判断する。

【0017】

第3の発明では、判定手段(62,66,S3)は、ロボット(10)の正面領域(bz)に人が入り、かつ人の正面領域にロボットが入る状態の空間陣形になったとき、双方参加状態であると判断する。これによって、双方参加状態を適切に認識できる。

【0018】

第4の発明は、第1ないし第3のいずれかの発明に従属し、判定手段は、人の頭部およびロボットの頭部が共に相手の視線領域に入る状態ではなく、人の正面領域にロボットが入り、ロボットの正面領域に人が入らず、かつロボットの視野に人が入る状態の空間陣形になったとき、人のみが対話参加状態であると判断する。

【0019】

第4の発明では、判定手段(62,66,S3)は、所定距離内で人およびロボット(10)の視線が合う状態ではなく、人の正面領域(bz)にロボットが入り、ロボットの正面領域に人が入らず、かつロボットの視野(fv)に人が入る状態の空間陣形になったとき、人のみが対話参加状態であると判断する。これによって、人のみが対話参加状態であることを適切に認識できる。

【0020】

第5の発明は、第1ないし第4のいずれかの発明に従属し、判定手段は、人の頭部およびロボットの頭部が共に相手の視線領域に入る状態ではなく、ロボットの正面領域に人が入り、人の正面領域にロボットが入らず、かつ人の視野領域にロボットが入る状態の空間陣形になったとき、ロボットのみが対話参加状態であると判断する。

【0021】

第5の発明では、判定手段(62,66,S3)は、所定距離内で人およびロボット(10)の視線が合う状態ではなく、ロボットの正面領域(bz)に人が入り、人の正面領域にロボットが入らず、かつ人の視野領域(sz)にロボットが入る状態の空間陣形になったとき、ロボットのみが対話参加状態であると判断する。これによって、ロボットのみが対話参加状態であることを適切に認識できる。

【0022】

第6の発明は、第1ないし第5のいずれかの発明に従属し、空間陣形調整手段は、判定手段によって人およびロボットの双方が対話参加状態でないと判断されたとき、空間陣形の主動調整移動をロボットに実行させる主動調整手段を含む。

【0023】

第6の発明では、空間陣形調整手段(26,54,62,66,82,S5−17)は、主動調整手段(26,62,66,82,S5,S7)を含む。主動調整手段は、判定手段(62,66,S3)によって、人およびロボット(10)の双方が対話参加状態でない、すなわち双方非参加状態である判断されたとき、ロボットに空間陣形の主動調整移動を実行させる。たとえば、空間陣形の主動調整移動では、ロボットの正面領域(fz)に人が入り、かつ人の視野領域(fv)にロボットが入るような地点(或いは配置状態)を移動目標位置として設定してロボットを移動させる。

【0024】

第6の発明によれば、少なくともロボットが対話参加状態になる空間陣形が確保される。

【0025】

第7の発明は、第6の発明に従属し、主動調整手段は、説明すべき対象物があるとき、対象物の説明を行い易い地点をロボットの移動目標位置として選択する。

【0026】

第7の発明では、主動調整手段(26,62,66,82,S5,S7)は、説明すべき対象物があるとき、対象物の説明を行い易い地点をロボット(10)の移動目標位置として設定する。たとえば、ロボットの正面領域(fz)に人が入り、かつ人の視野領域(fv)にロボットが入るような地点を移動目標位置として設定するという条件を満たす上で、さらに、対象物がロボットおよび人の双方の視野(fv)に入る空間陣形となるように、移動目標位置が設定される。

【0027】

第7の発明によれば、対象物の説明を行い易い地点をロボットの移動目標位置として選択するので、ロボットは、対話を始めた後の位置や体の向き等の調整を極力避けることができ、より自然で円滑なインタラクションを人との間で実行できる。

【0028】

第8の発明は、第1ないし第7のいずれかの発明に従属し、空間陣形調整手段は、判定手段によって人のみが対話参加状態であると判断されたとき、空間陣形の受動調整移動をロボットに実行させる受動調整手段を含む。

【0029】

第8の発明では、空間陣形調整手段(26,54,62,66,82,S5−17)は、受動調整手段(26,62,66,82,S9,S11)を含む。受動調整手段は、判定手段(62,66,S3)によって、人のみが対話参加状態であると判断されたとき、ロボット(10)に空間陣形の受動調整移動を実行させる。たとえば、空間陣形の受動調整移動では、ロボットの正面領域(fz)に人が入るように体の向きを調整することによって、ロボットも対話参加状態になるようにされる。

【0030】

第8の発明によれば、人の方からロボットに働きかけようとした場合に、ロボットが人に興味を持っていることを人に示すことができるので、人が途中で諦めてロボットから離れてしまうことを防止できる。

【0031】

第9の発明は、第1ないし第8のいずれかの発明に従属し、空間陣形調整手段は、判定手段によってロボットのみが対話参加状態であると判断されたとき、注意喚起発話をロボットに実行させる注意喚起実行手段を含む。

【0032】

第9の発明では、空間陣形調整手段(26,54,62,66,82,S5−17)は、注意喚起実行手段(54,62,66,S13,S15)を含む。注意喚起実行手段は、判定手段(62,66,S3)によって、ロボット(10)のみが対話参加状態であると判断されたとき、ロボットに「すみません」等の注意喚起発話を実行させる。この注意喚起発話によって、人に位置や体の向き等を調整してもらうことができるので、双方参加状態を実現できる。

【0033】

第9の発明によれば、人の前方の空間が狭い等して、ロボットが人の正面領域に回り込めない状況にも柔軟に対応でき、より自然で円滑なインタラクションを人との間で実行できる。

【0034】

第10の発明は、第1ないし第9のいずれかの発明に従属し、判定手段によって人およびロボットの双方が対話参加状態であると判断されたとき、対話に適した空間陣形となるようにロボットの動作を制御する対話陣形調整手段をさらに備える。

【0035】

第10の発明では、対話陣形調整手段(26,62,66,82,S21)をさらに備える。対話陣形調整手段は、対話のためにより適切な場所への調整移動をロボット(10)に実行させる。たとえば、双方参加状態となる空間陣形を維持しながら、人との距離が1.1−1.5mとなる領域にロボットを移動させる。

【0036】

第10の発明によれば、その後の人との対話をより快適に実行することができ、より自然で円滑なインタラクションを人との間で実行できる。

【0037】

第11の発明は、少なくとも発話を用いて人との間でコミュニケーションを実行するロボットの動作制御に用いられる空間陣形認識装置であって、位置、体の向きおよび視線方向を含む人およびロボットの配置情報を検出する検出手段、および検出手段によって検出された配置情報に基づいて人とロボットとの空間陣形を分析し、人およびロボットの対話参加状態を判定する判定手段を備える、空間陣形認識装置である。

【0038】

第11の発明では、空間陣形認識装置(10,62,66)は、少なくとも発話を用いて人との間でコミュニケーションを実行するロボット(10)の動作制御に用いられ、検出手段(12,62,66,84,86,S1)および判定手段(62,66,S3)を含む。検出手段(12,62,66,84,86,S1)は、人およびロボットの配置情報、たとえば位置、体の向きおよび視線方向を検出する。判定手段(62,66,S3)は、人およびロボットの配置情報に基づいて空間陣形(空間的な配置関係)を分析することによって、人およびロボットの対話参加状態を判定する。ここで、対話参加状態とは、対話への参加に対して暗黙的に同意した状態(心的同意状態)をいい、たとえば、人および自身に対して予め定義される視線領域(gz)、正面領域(bz)、視野領域(sz)および視野(fv)を用いて表される空間陣形に基づいて推定(認識)される。

【0039】

第11の発明によれば、人およびロボットの対話参加状態を判定できるので、この判定結果に合わせてロボットの動作を制御することによって、人との対話を自然に開始できるロボットを実現できる。

【発明の効果】

【0040】

この発明によれば、双方が対話参加状態となる空間陣形を生成した後に挨拶発話を実行するので、人との対話を自然に開始でき、円滑にコミュニケーションを図ることができる。

【0041】

この発明の上述の目的、その他の目的、特徴および利点は、図面を参照して行う後述の実施例の詳細な説明から一層明らかとなろう。

【図面の簡単な説明】

【0042】

【図1】この発明の一実施例のロボットシステムの構成を示す図解図である。

【図2】図1のロボットの外観を正面から見た様子を示す図解図である。

【図3】図1のロボットの電気的構成を示すブロック図である。

【図4】視線領域の定義の一例を示す図解図である。

【図5】正面領域の定義の一例を示す図解図である。

【図6】視線領域および視線の定義の一例を示す図解図である。

【図7】双方参加状態となる空間陣形の一例を示す図解図である。

【図8】双方参加状態となる空間陣形の他の一例を示す図解図である。

【図9】人のみ参加状態となる空間陣形の一例を示す図解図である。

【図10】ロボットのみ参加状態となる空間陣形の一例を示す図解図である。

【図11】対象物が無い場合の主動調整移動の目標位置の一例を示す図解図である。

【図12】対象物がある場合の主動調整移動の目標位置の一例を示す図解図である。

【図13】受動調整移動の目標位置の一例を示す図解図である。

【図14】対話陣形の調整移動の目標位置の一例を示す図解図である。

【図15】図3のCPUが実行する全体処理の一例を示すフロー図である。

【発明を実施するための形態】

【0043】

図1を参照して、この発明の一実施例であるロボットシステム100は、通信可能に接続されるロボット10とモーションキャプチャシステム12とを含む。ロボット10は、発話やジェスチャ等を用いて人との間でコミュニケーション行動を実行する相互作用指向のロボット(コミュニケーションロボット)であり、店舗やイベント会場などの様々な環境に配置される。そして、配置された環境内において、人に対して自ら話しかけて人とのインタラクションを引き起こし、展示案内、客引きおよびエンタテインメントなどの様々なサービスを提供する。ロボットシステム100では、詳細は後述するように、ロボット10と人との空間陣形を適切に調整することによって、ロボット10が人(対話者)との対話を自然に開始できるようにしている。

【0044】

図2は、ロボット10の外観を示す正面図である。この図2を参照して、ロボット10のハードウェアの構成について説明する。

【0045】

ロボット10は、台車20を含み、この台車20の下面には、ロボット10を自律移動させる2つの車輪22および1つの従輪24が設けられる。2つの車輪22は車輪モータ26(図3参照)によってそれぞれ独立に駆動され、ロボット10を前後左右任意の方向に動かすことができる。また、従輪24は車輪22を補助する補助輪である。このように、ロボット10は、配置された環境内を自由に移動可能なものである。ただし、ロボット10の移動機構は、車輪タイプに限定されず、公知の移動機構を適宜採用でき、たとえば2足歩行タイプの移動機構を採用することもできる。

【0046】

なお、ロボット10は、このロボットシステム100が適用される環境の地図データを内部メモリ(メモリ66:図3参照)に記憶している。そして、ロボット10は、任意に設定された原点位置を基準として、地図データを参照して環境内を移動する。この際、ロボット10が参照する地図データの座標系と、モーションキャプチャシステム12のコンピュータ14で算出される座標の座標系とは同じに設定される。

【0047】

台車20の上には、円柱形のセンサ取付パネル28が設けられ、このセンサ取付パネル28には、赤外線距離センサ30が取り付けられる。この赤外線距離センサ30は、ロボット10と周囲の物体(人や障害物など)との距離を計測するものである。

【0048】

また、センサ取付パネル28の上には、胴体32が直立するように設けられる。胴体32の前方中央上部(胸に相当する位置)には、上述した赤外線距離センサ30がさらに設けられる。これは、ロボット10の前方の主として人との距離を計測する。また、胴体32には、1つの全方位カメラ34が設けられる。全方位カメラ34は、たとえば背面側上端部のほぼ中央から延びる支柱36上に設けられる。全方位カメラ34は、ロボット10の周囲を撮影するものであり、後述する眼カメラ60とは区別される。この全方位カメラ34としては、たとえばCCDやCMOSのような固体撮像素子を用いるカメラを採用することができる。なお、これら赤外線距離センサ30および全方位カメラ34の設置位置は当該部位に限られず適宜変更され得る。

【0049】

胴体32の両側面上端部(肩に相当する位置)のそれぞれには、肩関節38Rおよび38Lによって、上腕40Rおよび40Lが設けられる。図示は省略するが、肩関節38Rおよび38Lのそれぞれは、直交する3軸の自由度を有する。すなわち、肩関節38Rは、直交する3軸のそれぞれの軸廻りにおいて上腕40Rの角度を制御できる。肩関節38Rの或る軸(ヨー軸)は、上腕40Rの長手方向に平行な軸であり、他の2軸(ピッチ軸、ロール軸)は、それにそれぞれ異なる方向から直交する軸である。同様に、肩関節38Lは、直交する3軸のそれぞれの軸廻りにおいて上腕40Lの角度を制御できる。肩関節38Lの或る軸(ヨー軸)は、上腕40Lの長手方向に平行な軸であり、他の2軸(ピッチ軸、ロール軸)は、それにそれぞれ異なる方向から直交する軸である。

【0050】

また、上腕40Rおよび40Lのそれぞれの先端には、肘関節42Rおよび42Lを介して、前腕44Rおよび44Lが設けられる。図示は省略するが、肘関節42Rおよび42Lは、それぞれ1軸の自由度を有し、この軸(ピッチ軸)の軸廻りにおいて前腕44Rおよび44Lの角度を制御できる。

【0051】

前腕44Rおよび44Lのそれぞれの先端には、手に相当する球体46Rおよび46Lがそれぞれ固定的に設けられる。ただし、指や掌の機能が必要な場合には、人の手の形をした「手」を用いることも可能である。

【0052】

また、図示は省略するが、台車20の前面、肩関節38R,38Lを含む肩に相当する部位、上腕40R,40L、前腕44R,44Lおよび球体46R,46Lには、それぞれ、接触センサ(図3で接触センサ48として包括的に示す。)が設けられている。台車20の前面の接触センサ48は、台車20への人や他の障害物の接触を検知する。したがって、ロボット10の移動中に障害物との接触があると、それを検知し、直ちに車輪22の駆動を停止してロボット10の移動を急停止させることができる。また、その他の接触センサ48は、主に、人がロボット10の当該各部位に触れたかどうかを検知する。なお、接触センサ48の設置位置はこれらに限定されず、適宜な位置(胸、腹、脇、背中、腰など)に設けられてよい。

【0053】

胴体32の中央上部(首に相当する位置)には首関節50が設けられ、さらにその上には頭部52が設けられる。図示は省略するが、首関節50は、3軸の自由度を有し、3軸の各軸廻りに角度制御可能である。或る軸(ヨー軸)はロボット10の真上(鉛直上向き)に向かう軸であり、他の2軸(ピッチ軸、ロール軸)は、それぞれ、それと異なる方向で直交する軸である。

【0054】

頭部52には、口に相当する位置に、スピーカ54が設けられる。スピーカ54は、ロボット10が、それの周辺の人に対して音声ないし音によってコミュニケーションを取るために用いられる。また、耳に相当する位置には、マイク56Rおよび56Lが設けられる。以下、右耳に相当するマイク56Rと左耳に相当するマイク56Lとをまとめて「マイク56」ということがある。マイク56は、周囲の音、とりわけコミュニケーションを実行する対象である人の声を取り込む。さらに、目に相当する位置には、眼球部58Rおよび58Lが設けられる。眼球部58Rおよび58Lは、それぞれ眼カメラ60Rおよび60Lを含む。以下、右の眼球部58Rと左の眼球部58Lとをまとめて「眼球部58」ということがあり、また、右の眼カメラ60Rと左の眼カメラ60Lとをまとめて「眼カメラ60」ということがある。

【0055】

眼カメラ60は、ロボット10に接近した人の顔や他の部分ないし物体などを撮影して、それに対応する映像信号を取り込む。眼カメラ60としては、上述した全方位カメラ34と同様のカメラを用いることができる。たとえば、眼カメラ60は眼球部58内に固定され、眼球部58は眼球支持部(図示せず)を介して頭部52内の所定位置に取り付けられる。図示は省略するが、眼球支持部は、2軸の自由度を有し、それらの各軸廻りに角度制御可能である。たとえば、この2軸の一方は、頭部52の上へ向かう方向の軸(ヨー軸)であり、他方は、一方の軸に直交しかつ頭部52の正面側(顔)が向く方向に直交する方向の軸(ピッチ軸)である。眼球支持部がこの2軸の各軸廻りに回転されることによって、眼球部58ないし眼カメラ60の先端(正面)側が変位され、カメラ軸すなわち視線方向が移動される。なお、上述のスピーカ54、マイク56および眼カメラ60の設置位置は、これらに限定されず、適宜な位置に設けてられてよい。

【0056】

なお、ロボット10は、人(特に子供)に威圧感を与えることのないように、大人よりも一回り小さい大きさになるように設計されており、その身長は120cmであり、半径は50cmである。

【0057】

図3は、ロボット10の電気的な構成を示すブロック図である。図3に示すように、ロボット10は、全体を制御するCPU62を含む。CPU62は、マイクロコンピュータ或いはプロセサとも呼ばれ、バス64を介して、メモリ66、モータ制御ボード68、センサ入力/出力ボード70および音声入力/出力ボード72等に接続される。

【0058】

メモリ66は、図示は省略するが、ROMやHDDおよびRAMを含む。ROMやHDDには、ロボット10の制御プログラムが予め記憶される。たとえば、人との間でコミュニケーション行動を実行するための行動制御プログラム、外部コンピュータ(モーションキャプチャシステム12)との間で必要な情報を送受信するための通信プログラム、モーションキャプチャシステム12等からのデータに基づいて人と自身との空間陣形を分析して人および自身の対話参加状態を判定する判定プログラム、および所定の空間陣形を形成するための空間陣形調整プログラム等である。また、ROMやHDDには、各行動を実行する際に発生すべき音声または声の音声データ(音声合成データ)、所定の身振りを提示するための角度データ、環境の地図データ、および説明すべき商品(対象物)に関するデータなどのデータも適宜記憶される。また、RAMは、ワークメモリやバッファメモリとして用いられる。

【0059】

モータ制御ボード68は、たとえばDSPで構成され、各腕や首関節50および眼球部58などの各軸モータの駆動を制御する。すなわち、モータ制御ボード68は、CPU62からの制御データを受け、右眼球部58Rの2軸のそれぞれの角度を制御する2つのモータ(図3では、まとめて「右眼球モータ」と示す。)74の回転角度を制御する。同様に、モータ制御ボード68は、CPU62からの制御データを受け、左眼球部58Lの2軸のそれぞれの角度を制御する2つのモータ(図3では、まとめて「左眼球モータ」と示す。)76の回転角度を制御する。

【0060】

また、モータ制御ボード68は、CPU62からの制御データを受け、右肩関節38Rの直交する3軸のそれぞれの角度を制御する3つのモータと右肘関節42Rの角度を制御する1つのモータとの計4つのモータ(図3では、まとめて「右腕モータ」と示す。)78の回転角度を調節する。同様に、モータ制御ボード68は、CPU62からの制御データを受け、左肩関節38Lの直交する3軸のそれぞれの角度を制御する3つのモータと左肘関節42Lの角度を制御する1つのモータとの計4つのモータ(図3では、まとめて「左腕モータ」と示す。)80の回転角度を調節する。

【0061】

さらに、モータ制御ボード68は、CPU62からの制御データを受け、首関節50の直交する3軸のそれぞれの角度を制御する3つのモータ(図3では、まとめて「頭部モータ」と示す。)82の回転角度を制御する。さらにまた、モータ制御ボード68は、CPU62からの制御データを受け、車輪22を駆動する2つのモータ(図3では、まとめて「車輪モータ」と示す。)26の回転角度を制御する。

【0062】

なお、この実施例では、車輪モータ26を除くモータは、制御を簡素化するために、ステッピングモータ或いはパルスモータを用いるようにしてある。ただし、車輪モータ26と同様に、直流モータを用いるようにしてもよい。

【0063】

センサ入力/出力ボード70もまた、同様に、DSPで構成され、各センサからの信号を取り込んでCPU62に与える。すなわち、赤外線距離センサ30のそれぞれからの反射時間に関するデータが、センサ入力/出力ボード70を通してCPU62に入力される。また、全方位カメラ34からの映像信号が、必要に応じてセンサ入力/出力ボード70で所定の処理を施された後、CPU62に入力される。眼カメラ60からの映像信号も、同様にして、CPU62に入力される。また、上述した複数の接触センサ48からの信号がセンサ入力/出力ボード70を介してCPU62に与えられる。

【0064】

音声入力/出力ボード72もまた、同様に、DSPで構成され、CPU62から与えられる音声合成データに従った音声または声がスピーカ54から出力される。また、マイク56からの音声入力が、音声入力/出力ボード56を介してCPU62に取り込まれる。

【0065】

また、CPU62は、バス64を介して通信LANボード84に接続される。通信LANボード84は、DSPで構成され、CPU62から送られる送信データを無線通信装置86に与え、無線通信装置86から送信データを、たとえば、無線LANのようなネットワークを介して外部コンピュータに送信する。また、通信LANボード84は、無線通信装置86を介してデータを受信し、受信したデータをCPU62に与える。つまり、この通信LANボード84および無線通信装置86によって、ロボット10は外部コンピュータなどと無線通信を行うことができる。

【0066】

図1に戻って、モーションキャプチャシステム12は、ロボット10および人の位置、体の方向および視線方向などを検出するために用いられ、PC等の汎用のコンピュータ14と環境に設置される複数のカメラ(赤外線カメラ)16とを備える。また、図示は省略するが、ロボット10および人には、複数の赤外線反射マーカが装着される。この実施例では、ロボット10および人のそれぞれ対して、頭部、胴体部および腕部などの適宜な位置に、合計23個の赤外線反射マーカが取り付けられる。また、ロボット10が人に対して説明(紹介)すべき対象物(商品など)にも、赤外線反射マーカが装着される。モーションキャプチャシステム12としては、公知のモーションキャプチャシステムが適用でき、たとえば、VICON社の光学式のモーションキャプチャシステムを用いることができる。

【0067】

モーションキャプチャシステム12のコンピュータ14は、カメラ16から画像データをたとえば60Hz(1秒間に60フレーム)で取得し、画像データを画像処理することによって、その計測時の全ての画像データにおける各赤外線反射マーカの2次元位置を抽出する。そして、コンピュータ14は、画像データにおける各赤外線反射マーカの2次元位置に基づいて、実空間における各赤外線反射マーカの3次元位置を算出することによって、ロボット10および人の位置(座標)、体の方向、および顔(視線)の方向を算出する。そして、コンピュータ14は、算出したロボット10および人の位置データ(座標データ)、体方向データおよび視線方向データ等の配置情報を、ロボット10(CPU62)からの要求に応じてロボット10に送信する。

【0068】

なお、ロボット10の位置、体の向きおよび視線方向は、必ずしもモーションキャプチャシステム12を用いなくても把握できる。たとえば、上述の車輪モータ26および頭部モータ66の回転角度などから、ロボット10の位置、体の向きおよび視線方向を計算によって求めることもできる。しかしながら、実施例では、CPU62のリアルタイムの計算量を軽減するために、モーションキャプチャ12を用いるようにした。

【0069】

このようなロボットシステム100では、ロボット10は、配置された環境内において、人に対して自ら働きかけて人とのインタラクションを引き起こし、展示案内、客引きおよびエンタテインメントなどの様々なサービスを提供する。ここで、ロボット10がサービスをより効率良く提供するためには、ロボット10が、適切なタイミングおよび位置で人に話しかける機能、つまり人と対話を自然に始める機能を身に付けることが重要である。

【0070】

本発明者らは、人同士が対話を始めるときの様子を注意深く観察したところ、人同士は、特定の空間陣形(つまり空間的な配置関係)を形成してから対話を始めることを見出した。そこで、この実施例では、それをモデル化してロボット10に実行させることによって、人と対話を自然に始めることができるロボットシステム100(ロボット10)を実現した。

【0071】

具体的には、本発明者らが、ロボット10がサービスを提供する際に幅広く利用できると考えられる、店員が客に対して話しかける状況を観察したところ、以下の4つの点が確認された。(1)客が店員の存在に気付いたとき(2人の視線が合ったとき)は、店員は、客との距離が所定距離(たとえば2.5m)に近づいたときに挨拶をし、その後対話をするときにはもう少し近づく(たとえば1.5m以内まで)。ただし、この際の所定距離は状況や環境などに依存する。(2)客の前方(正面方向を中心とする120°の範囲)から近づいてくる店員は、約2mの距離まで近づいたときに挨拶をし、その後対話をするときには1.5m以内まで近づく。(3)客の前方以外から近づいてくる店員は、客の視野(正面方向を中心とする270°の範囲)内に入るように移動し、約1.5mの距離まで近づく。そして、客が店員の接近に気付かない場合には、「すいません」等の注意喚起の言葉を発し、客に自身の存在を気付かせてから挨拶をする。(4)店員に次の計画、たとえば商品の説明をしたり、商品の場所まで客を誘導したりする必要があるときであって、客が店員の存在に気づいていないときには、店員は、商品の説明などの次の行動を起こし易い場所で挨拶を行う。

【0072】

以上の観察結果から、人同士が挨拶をして対話を始めるときには必ず、特定の空間陣形を形成することによって、双方が相手の存在を認識している状態、すなわち対話への参加に対して暗黙的に同意した状態(心的同意状態)が双方に対して形成されていることが分かる。この実施例では、この心的同意状態を「対話参加状態」と名付ける。また、観察結果からは、対話を始めるための空間陣形と対話をするための空間陣形とは、必ずしも同じではないことも分かる。つまり、ロボット10が人との対話を自然に開始するためには、先ず、ロボット10および人の双方を対話参加状態にする、つまり双方が対話参加状態となる空間陣形を形成することが重要であり、状況に応じて、対話をするのに適した空間陣形に調整することが必要であると言える。

【0073】

そこで、この実施例では、ロボット10が自ら働きかけて人との対話(インタラクション)を開始する際には、先ず、ロボット10と人との空間陣形を分析して、ロボット10および人の対話参加状態を認識(推定)する。そして、認識した対話参加状態に応じて、ロボット10が適宜の行動を取ることによって、ロボット10および人の双方が対話参加状態になるようにした後、ロボット10が人に対して挨拶発話を行うようにしている。以下、具体的に説明する。

【0074】

空間陣形に基づいて対話参加状態を認識するために、視線領域gz、正面領域fz、視野領域szおよび視野fvを次のように定義する。

【0075】

図4に示すように、視線領域gzは、視線方向gdを中心軸として、頭部(顔)の中心から顔正面方向に向かって延びる円錐形の領域であって、その頂角θが30°であり、頂点から底面までの距離が2.5mである領域とする。また、図5に示すように、正面領域fzは、体の正面方向bdを中心とする120°の範囲であって、体の中心からの距離が2m以内である扇形の領域とする。さらに、図6に示すように、視野領域szは、体の正面方向bdを中心とする270°の範囲であって、体の中心からの距離が1.5m以内である領域とする。また、視野fvは、体の正面方向bdを中心とする270°の範囲であって、体の中心からの距離制限がない領域とする。

【0076】

そして、次の所定の空間条件を満たすと、対話参加状態にあると判断する。

【0077】

(1)図7に示すように、ロボット10の視線領域gzに人の頭部(顔)が入り、かつ人の視線領域gzにロボット10の頭部52が入る状態の空間陣形になったとき、すなわち、ロボット10と人とが所定距離内で視線を合わせた状態になったときには、ロボット10および人の双方が対話参加状態である(双方参加状態)と判断する。(2)図8に示すように、ロボット10と人との視線が合わない状態で、ロボット10の正面領域fzに人が入り、かつ人の正面領域fzにロボット10が入る状態の空間陣形になったときには、ロボット10および人の双方が対話参加状態であると判断する。(3)図9に示すように、ロボット10と人との視線が合わない状態で、人の正面領域fzにロボット10が入り、ロボット10の正面領域fzに人が入らず、かつロボット10の視野fvに人が入る状態の空間陣形になったときには、人のみが対話参加状態(人のみ参加状態)であると判断する。(4)図10に示すように、ロボット10と人との視線が合わない状態で、ロボット10の正面領域fzに人が入り、人の正面領域fzにロボット10が入らず、かつ人の視野領域szにロボット10が入る状態の空間陣形になったときには、ロボット10のみが対話参加状態(ロボットのみ参加状態)であると判断する。(5)以上の空間条件1−4を満たさない空間陣形のときには、ロボット10および人の双方が対話参加状態でない(双方非参加状態)と判断する。

【0078】

なお、各領域を定義する具体的数値(閾値)は、人同士のコミュニケーションを観察した結果に基づいて決定した数値ではあるが、これらの最適値はロボット10を配置する環境や対話相手などによって変動する数値でもあるので、必要に応じて適宜変更するようにしてもよい。たとえば、見晴らしのよい広い場所では、視線領域gzを定義する距離の大きさは、2.5mよりも大きく設定してもよいし、ロボット10や対話相手の人の身長が高い場合には、各領域の距離設定を大きくとるようにしてもよい。また、或る領域内に入ったか否かの判断は、体(または頭部)の中心がその領域内に入ったか否かで判断してもよいし、体(または頭部)の全体がその領域内に入ったか否かで判断してもよい。

【0079】

ロボット10および人の対話参加状態を認識すると、その認識結果に応じてロボット10の行動(動作)が決定される。すなわち、ロボット10は、双方参加状態となる所定の空間陣形(つまり対話を始めるための空間陣形)を形成するための行動を行う。

【0080】

具体的には、双方非参加状態であると判断されたときには、ロボット10は、空間陣形の主動調整移動(Proactive adjustment of spatial formation)を行う。空間陣形の主動調整移動では、ロボット10は、ロボット10の正面領域fzに人が入り、かつ人の視野領域fvにロボット10が入るような地点(或いは配置状態)を移動目標位置として設定して移動する。

【0081】

この際、ロボット10に次の計画が無い場合、つまり単に人と対話をすることだけが目的の場合には、図11に示すように、自身の位置から最短距離となる地点が移動目標位置として選択される。ただし、図11から分かるように、ロボット10が人の正面領域fzの方向から近づく場合には、人の正面領域fzに入った時点で双方参加状態となるので、ロボット10は人の正面領域fzに入るだけでよい。また、人の視線領域gzの方向から近づく場合には、人の視線領域gzに入った時点で双方参加状態となるので、ロボット10は人の視線領域gzに入るだけでよい。

【0082】

一方、ロボット10に次の計画がある場合、たとえば商品の説明をしたり、商品の場所まで人を誘導したりする必要があるときには、空間陣形の主動調整移動は、次の行動を考慮した態様とされる。たとえば、説明すべき対象物がある場合には、ロボット10の正面領域fzに人が入り、かつ人の視野領域fvにロボット10が入るような地点を移動目標位置として設定するという条件を満たす上で、さらに、対象物の説明を行い易い地点が移動目標位置として選択される。具体的には、図12に示すように、対象物がロボット10および人の双方の視野fvに入る空間陣形となるように、移動目標位置が設定される。

【0083】

ただし、空間陣形の主動調整移動の実行途中に、人が移動したり、体の向きや視線方向を変えたりすることによって、双方参加状態になったり、人のみ参加状態になったりすると、ロボット10は、空間陣形の主動調整移動をそこで終了し、ロボット10および人の対話参加状態に応じた次の行動に移る。上述のような空間陣形の主動調整移動によって、少なくともロボット10が対話参加状態になる空間陣形が確保される。

【0084】

人のみ参加状態であると判断されたときには、ロボット10は、空間陣形の受動調整移動(Reactive adjustment of spatial formation)を行う。空間陣形の受動調整移動では、図13に示すように、ロボット10の正面領域fzに人が入るように体の向きを調整することによって、ロボット10も対話参加状態になるようにする。この際には、ロボット10の視線領域gzに人の頭部(顔)が入るように視線方向も調整するとよい。なお、人のみが対話参加状態になる空間陣形は、空間陣形の主動調整移動の途中に、人が移動したり、体の向きや視線方向を変えたりしたときに生じる状況、つまり人の方からロボット10に働きかけようとしている状況が想定されるので、対話のためにより適切な場所への調整移動(詳細は後述)も、空間陣形の受動調整移動において同時に行うようにしてもよい。この空間陣形の受動調整移動によって、ロボット10が人に興味を持っていることを人に示すことができるので、人の方からロボット10に働きかけようとした場合に、人が途中で諦めてロボット10から離れてしまうことを防止できる。

【0085】

ロボットのみ参加状態であると判断されたときには、ロボット10は、注意喚起発話を行う。ロボット10のみが対話参加状態になる空間陣形は、ロボット10が近づいたことを人が気づいていない状況が想定される。そこで、ロボット10は、「すみません」等の注意喚起発話を行うことによって、人に体の向きや視線方向を調整してもらい、双方参加状態の空間陣形を形成する。ここで重要なことは、ロボット10がすでに人の視野領域szに入っていることであり、これによって、人にとって不意打ちとなる話しかけが極力防止される。この注意喚起発話によって、人に体の向きや視線方向を調整してもらうことができるので、人の正面側の空間が狭い等して、ロボット10が人の正面領域fzに回り込めないような状況にも柔軟に対応できる。

【0086】

そして、双方参加状態であると判断されたときには、ロボット10は、人に対して「こんにちは」や「いらっしゃいませ」等の挨拶発話を実行する。双方参加状態は、ロボット10および人の双方が対話への参加に対して暗黙的に同意した状態である。すなわち、人側からすると、自身と対話したい(或いは自身との対話を受け入れる)という意思をロボット10から示された状態であり、かつロボット10との対話を受け入れる(或いはロボット10と対話したい)という意思をロボット10に示した状態となる。したがって、双方参加状態となったときのロボット10の挨拶発話は、極めて自然に人に受け入れられ、ロボット10は人との対話を自然に始めることができる。

【0087】

また、上述の人同士の対話の観察結果から、対話をするのに適した空間陣形(対話陣形)があることも分かったので、この実施例ではさらに、ロボット10が人と対話をする際には、対話のためにより適切な場所への調整移動(対話陣形の調整移動)も実行する。具体的には、図14に示すように、双方参加状態となる空間陣形を維持しながら、人との距離が、1.1−1.5mとなる領域に移動する。この対話陣形の調整移動によって、その後の人との対話をより快適に実行することができる。なお、対話陣形の調整移動は、ロボット10の挨拶発話が終わった後の次の発話を行う前に実行してもよいし、人との対話を行いながら実行してもよい。

【0088】

続いて、フロー図を用いて、人とのインタラクション(対話)を開始する際のロボット10(ロボットシステム100)の動作を説明する。具体的には、図3に示したロボット10のCPU62が、図15に示すフロー図に従って全体処理を実行する。図15を参照して、CPU62は、ステップS1において、ロボット10および人の位置、体の向きおよび視線方向を検出する。すなわち、ロボット10および人の位置データ、体方向データおよび視線方向データ等の配置情報を、無線通信装置86および通信LANボード84を介してモーションキャプチャシステム12から取得する。

【0089】

次のステップS3では、空間陣形からロボット10および人の対話参加状態を認識する。すなわち、ステップS1で取得した配置情報に基づいて、ロボット10と人との空間陣形を分析することによって、ロボット10および人の対話参加状態が、双方非参加状態、人のみ参加状態、ロボットのみ参加状態、および双方参加状態のいずれであるかを認識(判断)する。たとえば、双方の頭部が互いに相手の視線領域gzに入る状態の空間陣形になったとき(互いの視線が合ったとき)や、双方が互いの正面領域fzに入る状態の空間陣形になったときには、双方参加状態であると認識する。また、たとえば、互いの視線が合わない状態で、人の正面領域fzにロボット10が入り、ロボット10の正面領域fzに人が入らず、かつロボット10の視野fvに人が入る状態の空間陣形になったときには、人のみ参加状態であると判断する。さらに、たとえば、互いの視線が合わない状態で、ロボット10の正面領域fzに人が入り、人の正面領域fzにロボット10が入らず、かつ人の視野領域szにロボット10が入る状態の空間陣形になったときには、ロボットのみ参加状態であると判断する。また、人のみ参加状態、ロボットのみ参加状態、および双方参加状態となるいずれの空間条件(空間陣形)にも当てはまらない場合には、双方非参加状態であると判断する。なお、ステップS1およびS3の処理は、所定時間毎に繰り返し実行される。

【0090】

次のステップS5では、ステップS3で認識されたロボット10および人の対話参加状態が、双方共に非参加状態であるか否かを判定する。ステップS5で“YES”の場合、すなわち双方共に非参加状態である場合には、ステップS7に進み、ステップS5で“NO”の場合、すなわち双方共に非参加状態でない場合には、ステップS9に進む。

【0091】

ステップS7では、空間陣形の主動調整移動を実行する。すなわち、ロボット10の正面領域fzに人が入り、かつ人の視野領域fvにロボット10が入るような地点(或いは配置状態)を移動目標位置として設定し、その移動目標位置までロボット10が移動するように、車輪モータ26の回転角度を制御する制御データをモータ制御ボード68に対して送信する。この際、ロボット10に次の計画が無い場合、つまり単に人と対話をすることだけが目的の場合には、自身の位置から最短距離となる地点(或いは配置状態)が移動目標位置として選択される。一方、ロボット10に次の計画がある場合、たとえば商品の説明をしたり、商品の場所まで人を誘導したりする必要があるときには、その商品(対象物)がロボット10および人の双方の視野fvに入る空間陣形となるような地点が移動目標位置として設定される。ステップS7が終了すると、処理はステップS1に戻る。

【0092】

ステップS9では、ステップS3で認識されたロボット10および人の対話参加状態が、人のみ参加状態であるか否かを判定する。ステップS9で“YES”の場合、すなわち人のみ参加状態である場合には、ステップS11に進み、ステップS9で“NO”の場合、すなわち人のみ参加状態でない場合には、ステップS13に進む。

【0093】

ステップS11では、空間陣形の受動調整移動を実行する。すなわち、ロボット10の正面領域fzに人が入るように、車輪モータ26の回転角度を制御する制御データをモータ制御ボード68に対して送信して、ロボット10の体の向きを調整したり、ロボット10の視線領域gzに人の頭部が入るように、頭部モータ82の回転角度を制御する制御データをモータ制御ボード68に対して送信して、ロボット10の視線方向を調整したりして、ロボット10も対話参加状態になるようにする。この際には、対話のためにより適切な場所への調整移動も同時に行うようにしてもよい。ステップS11が終了すると、処理はステップS1に戻る。

【0094】

ステップS13では、ステップS3で認識されたロボット10および人の対話参加状態が、ロボットのみ参加状態であるか否かを判定する。ステップS13で“YES”の場合、すなわちロボットのみ参加状態である場合には、ステップS15に進み、ステップS13で“NO”の場合、すなわちロボットのみ参加状態でない場合には、ステップS17に進む。

【0095】

ステップS15では、注意喚起発話を実行する。すなわち、「すみません」等の注意喚起発話を行うための音声データを音声入力/出力ボード72に送信して、スピーカ54から注意喚起発話を出力する。ステップS15が終了すると、処理はステップS1に戻る。

【0096】

ステップS17では、ステップS3で認識されたロボット10および人の対話参加状態が、双方参加状態であるか否かを判定する。ステップS17で“YES”の場合、すなわち双方参加状態である場合には、ステップS19に進み、ステップS17で“NO”の場合、すなわち双方参加状態でない場合には、ステップS1に戻る。

【0097】

ステップS19では、挨拶発話を実行する。すなわち、「こんにちは」や「いらっしゃいませ」等のその状況に応じた挨拶発話を実行するための音声データを音声入力/出力ボード72に送信して、スピーカ54から注意喚起発話を出力する。この際には、挨拶発話と連動させて、お辞儀などの身体動作を実行するための制御データをモータ制御ボード68に対して送信するようにしてもよい。

【0098】

続くステップS21では、対話陣形の調整移動を実行する。すなわち、双方参加状態となる空間陣形を維持しながら、人との距離が1.1−1.5mとなる領域に移動するように、車輪モータ26の回転角度を制御する制御データをモータ制御ボード68に対して送信する。そして、ステップS21の処理によって、対話をするための空間陣形が確立されると、この全体処理を終了する。

【0099】

この実施例によれば、ロボット10および人の双方が対話参加状態となる空間陣形を生成した後に、ロボット10が挨拶発話を実行する。つまり、人間同士の対話により近い挨拶発話を実行するので、ロボット10の挨拶発話は、極めて自然に人に受け入れられる。したがって、ロボット10は、人との対話を自然に始めることができ、円滑に人とのコミュニケーションを図ることができる。

【0100】

また、この実施例によれば、ロボット10に次の計画がある場合には、ロボット10の空間陣形の主動調整移動は、次の行動を考慮した態様とされる。すなわち、説明すべき対象物がある場合には、対象物の説明を行い易い地点がロボット10の移動目標位置として選択される。これによって、ロボット10は、対話を始めた後の位置や体の向き等の調整を極力避けることができるので、より自然で円滑なインタラクションを人との間で実行できる。特に、ロボット10、人および対象物の空間関係が直線状に並んでしまうと、ロボット10が指差しジェスチャを用いて対象物を指し示すことが困難になってしまうが、この問題を回避できる。

【0101】

さらに、この実施例では、人のみが対話参加状態である判断されたときには、ロボット10は空間陣形の受動調整移動を行う。これによって、人の方からロボット10に働きかけようとした場合に、ロボット10が人に興味を持っていることを人に示すことができるので、人が途中で諦めてロボット10から離れてしまうことを防止できる。

【0102】

また、この実施例では、ロボット10のみが対話参加状態であると判断されたときには、ロボット10は注意喚起発話を行い、人に体の向きや視線方向を調整してもらう。これによって、人の前方の空間が狭い等して、ロボット10が人の正面領域fzに回り込めない状況にも柔軟に対応でき、より自然で円滑なインタラクションを人との間で実行できる。

【0103】

さらに、この実施例では、対話のためにより適切な場所への調整移動(対話陣形の調整移動)も実行する。これは、対話を始めるための空間陣形と対話をするための空間陣形とは、必ずしも同じになるとは限らないからであり、対話陣形の調整移動を行うことによって、より自然で円滑なインタラクションを人との間で実行できる。

【0104】

なお、上述の実施例では、モーションキャプチャシステム12を利用して、ロボット10および人の配置情報、つまり位置、体の向きおよび視線方向を検出するようにしたが、これに限定されず、公知の方法を適宜利用することができる。たとえば、人およびロボット10の位置検出および体の向きの検出については、この発明者らが先に出願した特開2009−168578号公報に開示したLRFを用いる方法を利用することができる。また、視線方向を計測する装置の一例として、株式会社ナックイメージテクノロジーの視線計測システム「アイマークレコーダ」の技術を利用することができる。

【0105】

また、上述の実施例では、ロボット10のCPU62が、ロボット10と人との空間陣形を分析して対話参加状態を認識する処理(ステップS3に相当)、および対話参加状態に応じて次の動作を制御する処理(ステップS5−S17に相当)を行うようにしたが、これに限定されない。たとえば、ロボット制御装置(或いは空間陣形認識装置)としての外部コンピュータを別に設け、空間陣形を分析してロボット10の動作を決定するこれらの処理の一部または全部を外部コンピュータに実行させて、外部コンピュータからロボット10に対して動作制御データを送信するようにしてもよい。

【0106】

なお、上で挙げた所定距離などの具体的数値は、いずれも単なる一例であり、必要に応じて適宜変更可能である。

【符号の説明】

【0107】

10 …コミュニケーションロボット

12 …モーションキャプチャシステム

22 …車輪

26 …車輪モータ

54 …スピーカ

62 …CPU

66 …メモリ

100 …ロボットシステム

【特許請求の範囲】

【請求項1】

少なくとも発話を用いて人との間でコミュニケーションを実行するロボットを含むロボットシステムであって、

位置、体の向きおよび視線方向を含む前記人および前記ロボットの配置情報を検出する検出手段、

前記検出手段によって検出された前記配置情報に基づいて前記人と前記ロボットとの空間陣形を分析し、前記人および前記ロボットの対話参加状態を判定する判定手段、

前記判定手段によって前記人および前記ロボットの少なくとも一方が対話参加状態でないと判断されたとき、前記人および前記ロボットの双方が対話参加状態となるように前記ロボットの動作を制御する空間陣形調整手段、および

前記判定手段によって前記人および前記ロボットの双方が対話参加状態であると判断されたとき、前記人に対する挨拶発話を前記ロボットに実行させる挨拶実行手段を備える、ロボットシステム。

【請求項2】

前記判定手段は、前記人の頭部および前記ロボットの頭部が共に相手の視線領域に入る状態の空間陣形になったとき、前記人および前記ロボットの双方が対話参加状態であると判断する、請求項1記載のロボットシステム。

【請求項3】

前記判定手段は、前記人および前記ロボットが共に相手の正面領域に入る状態の空間陣形になったとき、前記人および前記ロボットの双方が対話参加状態であると判断する、請求項1または2記載のロボットシステム。

【請求項4】

前記判定手段は、前記人の頭部および前記ロボットの頭部が共に相手の視線領域に入る状態ではなく、前記人の正面領域に前記ロボットが入り、前記ロボットの正面領域に前記人が入らず、かつ前記ロボットの視野に前記人が入る状態の空間陣形になったとき、前記人のみが対話参加状態であると判断する、請求項1ないし3のいずれかに記載のロボットシステム。

【請求項5】

前記判定手段は、前記人の頭部および前記ロボットの頭部が共に相手の視線領域に入る状態ではなく、前記ロボットの正面領域に前記人が入り、前記人の正面領域に前記ロボットが入らず、かつ前記人の視野領域に前記ロボットが入る状態の空間陣形になったとき、前記ロボットのみが対話参加状態であると判断する、請求項1ないし4のいずれかに記載のロボットシステム。

【請求項6】

前記空間陣形調整手段は、前記判定手段によって前記人および前記ロボットの双方が対話参加状態でないと判断されたとき、空間陣形の主動調整移動を前記ロボットに実行させる主動調整手段を含む、請求項1ないし5のいずれかに記載のロボットシステム。

【請求項7】

前記主動調整手段は、説明すべき対象物があるとき、前記対象物の説明を行い易い地点を前記ロボットの移動目標位置として選択する、請求項6記載のロボットシステム。

【請求項8】

前記空間陣形調整手段は、前記判定手段によって前記人のみが対話参加状態であると判断されたとき、空間陣形の受動調整移動を前記ロボットに実行させる受動調整手段を含む、請求項1ないし7のいずれかに記載のロボットシステム。

【請求項9】

前記空間陣形調整手段は、前記判定手段によって前記ロボットのみが対話参加状態であると判断されたとき、注意喚起発話を前記ロボットに実行させる注意喚起実行手段を含む、請求項1ないし8のいずれかに記載のロボットシステム。

【請求項10】

前記判定手段によって前記人および前記ロボットの双方が対話参加状態であると判断されたとき、対話に適した空間陣形となるように前記ロボットの動作を制御する対話陣形調整手段をさらに備える、請求項1ないし9のいずれかに記載のロボットシステム。

【請求項11】

少なくとも発話を用いて人との間でコミュニケーションを実行するロボットの動作制御に用いられる空間陣形認識装置であって、

位置、体の向きおよび視線方向を含む前記人および前記ロボットの配置情報を検出する検出手段、および

前記検出手段によって検出された前記配置情報に基づいて前記人と前記ロボットとの空間陣形を分析し、前記人および前記ロボットの対話参加状態を判定する判定手段を備える、空間陣形認識装置。

【請求項1】

少なくとも発話を用いて人との間でコミュニケーションを実行するロボットを含むロボットシステムであって、

位置、体の向きおよび視線方向を含む前記人および前記ロボットの配置情報を検出する検出手段、

前記検出手段によって検出された前記配置情報に基づいて前記人と前記ロボットとの空間陣形を分析し、前記人および前記ロボットの対話参加状態を判定する判定手段、

前記判定手段によって前記人および前記ロボットの少なくとも一方が対話参加状態でないと判断されたとき、前記人および前記ロボットの双方が対話参加状態となるように前記ロボットの動作を制御する空間陣形調整手段、および

前記判定手段によって前記人および前記ロボットの双方が対話参加状態であると判断されたとき、前記人に対する挨拶発話を前記ロボットに実行させる挨拶実行手段を備える、ロボットシステム。

【請求項2】

前記判定手段は、前記人の頭部および前記ロボットの頭部が共に相手の視線領域に入る状態の空間陣形になったとき、前記人および前記ロボットの双方が対話参加状態であると判断する、請求項1記載のロボットシステム。

【請求項3】

前記判定手段は、前記人および前記ロボットが共に相手の正面領域に入る状態の空間陣形になったとき、前記人および前記ロボットの双方が対話参加状態であると判断する、請求項1または2記載のロボットシステム。

【請求項4】

前記判定手段は、前記人の頭部および前記ロボットの頭部が共に相手の視線領域に入る状態ではなく、前記人の正面領域に前記ロボットが入り、前記ロボットの正面領域に前記人が入らず、かつ前記ロボットの視野に前記人が入る状態の空間陣形になったとき、前記人のみが対話参加状態であると判断する、請求項1ないし3のいずれかに記載のロボットシステム。

【請求項5】

前記判定手段は、前記人の頭部および前記ロボットの頭部が共に相手の視線領域に入る状態ではなく、前記ロボットの正面領域に前記人が入り、前記人の正面領域に前記ロボットが入らず、かつ前記人の視野領域に前記ロボットが入る状態の空間陣形になったとき、前記ロボットのみが対話参加状態であると判断する、請求項1ないし4のいずれかに記載のロボットシステム。

【請求項6】

前記空間陣形調整手段は、前記判定手段によって前記人および前記ロボットの双方が対話参加状態でないと判断されたとき、空間陣形の主動調整移動を前記ロボットに実行させる主動調整手段を含む、請求項1ないし5のいずれかに記載のロボットシステム。

【請求項7】

前記主動調整手段は、説明すべき対象物があるとき、前記対象物の説明を行い易い地点を前記ロボットの移動目標位置として選択する、請求項6記載のロボットシステム。

【請求項8】

前記空間陣形調整手段は、前記判定手段によって前記人のみが対話参加状態であると判断されたとき、空間陣形の受動調整移動を前記ロボットに実行させる受動調整手段を含む、請求項1ないし7のいずれかに記載のロボットシステム。

【請求項9】

前記空間陣形調整手段は、前記判定手段によって前記ロボットのみが対話参加状態であると判断されたとき、注意喚起発話を前記ロボットに実行させる注意喚起実行手段を含む、請求項1ないし8のいずれかに記載のロボットシステム。

【請求項10】

前記判定手段によって前記人および前記ロボットの双方が対話参加状態であると判断されたとき、対話に適した空間陣形となるように前記ロボットの動作を制御する対話陣形調整手段をさらに備える、請求項1ないし9のいずれかに記載のロボットシステム。

【請求項11】

少なくとも発話を用いて人との間でコミュニケーションを実行するロボットの動作制御に用いられる空間陣形認識装置であって、

位置、体の向きおよび視線方向を含む前記人および前記ロボットの配置情報を検出する検出手段、および

前記検出手段によって検出された前記配置情報に基づいて前記人と前記ロボットとの空間陣形を分析し、前記人および前記ロボットの対話参加状態を判定する判定手段を備える、空間陣形認識装置。

【図1】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図13】

【図14】

【図15】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図13】

【図14】

【図15】

【公開番号】特開2012−161851(P2012−161851A)

【公開日】平成24年8月30日(2012.8.30)

【国際特許分類】

【出願番号】特願2011−21940(P2011−21940)

【出願日】平成23年2月3日(2011.2.3)

【国等の委託研究の成果に係る記載事項】(出願人による申告)平成21年6月19日付け、支出負担行為担当官 総務省大臣官房会計課企画官、研究テーマ「高齢者・障がい者(チャレンジド)のためのユビキタスネットワークロボット技術の研究開発」に関する委託研究、産業技術力強化法第19条の適用を受ける特許出願

【出願人】(393031586)株式会社国際電気通信基礎技術研究所 (905)

【Fターム(参考)】

【公開日】平成24年8月30日(2012.8.30)

【国際特許分類】

【出願日】平成23年2月3日(2011.2.3)

【国等の委託研究の成果に係る記載事項】(出願人による申告)平成21年6月19日付け、支出負担行為担当官 総務省大臣官房会計課企画官、研究テーマ「高齢者・障がい者(チャレンジド)のためのユビキタスネットワークロボット技術の研究開発」に関する委託研究、産業技術力強化法第19条の適用を受ける特許出願

【出願人】(393031586)株式会社国際電気通信基礎技術研究所 (905)

【Fターム(参考)】

[ Back to top ]