ロボットシステム

【課題】少ない時間で操作を習得することができる、直感的なロボットの遠隔操作インタフェースを提供する。

【解決手段】ロボットの操作装置が、カメラから取り込まれたカメラ映像が表示されるタッチスクリーンと、カメラ映像からロボットの3次元的な位置及び姿勢を認識するロボット認識部と、ロボット認識部で認識した位置及び姿勢とからロボットのCG映像を生成し、CG映像をタッチスクリーン上のロボットのカメラ映像に重畳表示するCG合成部と、ユーザのタッチ操作に応じて、タッチスクリーン上でCG映像のロボットを仮想的に動作させる操作入力部と、CG映像のロボットの仮想的な動作に追従してロボットが動作するように、ロボットに対して制御命令を送出するロボット制御部と、を有している。

【解決手段】ロボットの操作装置が、カメラから取り込まれたカメラ映像が表示されるタッチスクリーンと、カメラ映像からロボットの3次元的な位置及び姿勢を認識するロボット認識部と、ロボット認識部で認識した位置及び姿勢とからロボットのCG映像を生成し、CG映像をタッチスクリーン上のロボットのカメラ映像に重畳表示するCG合成部と、ユーザのタッチ操作に応じて、タッチスクリーン上でCG映像のロボットを仮想的に動作させる操作入力部と、CG映像のロボットの仮想的な動作に追従してロボットが動作するように、ロボットに対して制御命令を送出するロボット制御部と、を有している。

【発明の詳細な説明】

【技術分野】

【0001】

本発明は、タッチスクリーンを利用したロボットの遠隔操作技術に関する。

【背景技術】

【0002】

人間が作業を行うのが困難な環境として、水中、高所、高温または低温の環境、毒物や放射性物質が充満した環境などが上げられる。このような危険環境において、人間に代わって作業を行うさまざまなロボットが提案されている。そのようなロボットは、理想的には完全自律型で運用されることが望まれるが、一般物体認識や状況認識の点で課題が残っており、実現はまだ遠い。この問題を軽減する方法として、物体認識用のタグや、事前に作成した対象空間のモデルを利用する方法が提案されているが、これらの方法は未知環境では使用できない。以上の理由から、人間によるロボットの遠隔操作は依然として行われている。

【0003】

人間に代わって物体を把持したり運んだりするロボットは一般的に多自由度の構造を持っているが、そのようなロボットの遠隔操作は初心者にとって簡単なものではない。例えば、ロボットアームは一般的に4から6の自由度を持つ。また、そのようなロボットアームが移動台車の上に固定されていると、自由度はさらに増加する。ロボットの遠隔操作には、一般的にジョイスティックやゲームパッドが広く利用されている。しかし、これらの入力デバイスでは、操作可能な自由度の数はボタンや軸の数に制限される。複数のボタンを同時押しすることによって操作可能な自由度の数を増やす工夫もたびたび行われるが、それは操作をより複雑にし、習得により多くの時間を要する。

【0004】

多関節のロボットの操作を簡単にする方法として、IK(Inverse Kinematics:逆運動学)が広く用いられている。IKを用いた一般的なロボットアームの操作では、手先の位置の操作がジョイスティックにマッピングされ、手先の動きに応じて腕や肘の関節の角度は自動的に計算されるようになっている。しかし、一般的なジョイスティックベースのコントローラでは、スティックを傾けた量に比例した運動速度およびスティックを傾けている時間に比例した移動量が与えられる仕組みになっているため、ユーザが思い通りの位置に手先を移動させられるようになるためにはある程度の訓練を要する。

【0005】

なお、関連する先行技術として、例えば特許文献1には、テレビカメラと消火装置を具備するロボットをジョイスティックにより遠隔操作することで、危険な場所での消火活動や確認作業を行うシステムが開示されている。また特許文献2には、多自由度のロボットをジョイスティックとフットペダルにより操作するシステムが開示されている。

【先行技術文献】

【特許文献】

【0006】

【特許文献1】特開平6−150181号公報

【特許文献2】特開2005−66752号公報

【発明の概要】

【発明が解決しようとする課題】

【0007】

本発明は上記実情に鑑みたものであり、その目的とするところは、少ない時間で操作を習得することができる、直感的なロボットの遠隔操作インタフェースを提供することにある。

【課題を解決するための手段】

【0008】

上記目的を達成するために、本発明では、タッチスクリーン上でロボットのCG(Computer Graphics)をタッチ操作するという直感的なインタフェースを採用する。

【0009】

具体的には、本発明に係るロボットシステムは、目標物体に対して処理を行うロボットと、前記目標物体及び前記ロボットを含む作業空間を撮影する三人称視点のカメラと、前記ロボットを遠隔操作するための操作装置と、を備えるロボットシステムにおいて、前記操作装置は、前記カメラから取り込まれたカメラ映像が表示されるタッチスクリーンと、前記カメラ映像から前記ロボットの3次元的な位置及び姿勢を認識するロボット認識部と、前記ロボットの3次元モデルを記憶する記憶部と、前記3次元モデルと前記ロボット認識部で認識した位置及び姿勢とから前記ロボットのCG映像を生成し、前記CG映像を前記タッチスクリーン上の前記ロボットのカメラ映像に重畳表示するCG合成部と、ユーザのタッチ操作に応じて、前記タッチスクリーン上で前記CG映像のロボットを仮想的に動作させる操作入力部と、前記CG映像のロボットの仮想的な動作に追従して前記ロボットが動作するように、前記ロボットに対して制御命令を送出するロボット制御部と、を有していることを特徴とするロボットシステムである。

【0010】

この構成によれば、まず、タッチスクリーン上に表示されたカメラ映像を見ることで、ユーザは実際のロボットの状態(位置、姿勢など)、目標物体の状態、作業空間内に存在する障害物、ロボットの動線などを容易に把握することができる。そして、タッチ(タップ)やドラッグなどのタッチ操作によりCG映像のロボットを所望の位置・姿勢まで動かすだけで、実際のロボットの位置・姿勢を指示することができる。したがって、このようなインタフェースを用いることにより、誰でも簡単かつ直感的にロボットの遠隔操作を行うことが可能となる。

【0011】

また、CG映像のロボットは、動作入力のためのインタフェースとしての役割だけでなく、ロボットがどのように動くかの予測をユーザに提示するシミュレータとしての役割も発揮する。したがって、ロボットの作業手順の組み立てやトライ&エラーが容易になるという利点もある。さらに、作業空間が暗かったり、ロボットの一部が死角に入りこんだりして、カメラ映像ではロボットの状態を視認するのが困難な場合であっても、CG映像によりロボットの位置、姿勢、挙動などを確認できるという利点もある。

【0012】

ところで、実際のロボットの動作速度には物理的な限界があるため、CG映像のロボットの仮想的な動作に対して遅れ無くロボットを動作させることは難しい。そこで、本発明では、ロボットの動作に遅れがあることを前提としたタッチインタラクションを3種類提案する。

【0013】

第1の方法は、前記ロボット制御部が、タッチ操作が続いている間は前記ロボットに対する制御命令の送出を行わず、タッチ操作が終了すると前記ロボットに対する制御命令の送出を開始し、タッチ操作が終了した時点の前記CG映像と同じ位置及び姿勢になるように前記ロボットを動作させる、というものである。第2の方法は、前記ロボット制御部が、タッチ操作の開始とともに前記ロボットに対する制御命令の送出を開始し、タッチ操作が続いている間は前記ロボットを動作させ、タッチ操作が終了した時点で前記ロボットの動作を停止させる、というものである。第3の方法は、前記ロボット制御部が、タッチ操作の開始とともに前記ロボットに対する制御命令の送出を開始し、タッチ操作が続いている間に前記ロボットを動作させるとともに、タッチ操作の終了後も、タッチ操作が終了した時点の前記CG映像と同じ位置及び姿勢になるまで前記ロボットを動作させる、というものである。

【0014】

三人称視点のカメラとしては、例えば、監視カメラのように作業空間内に設置されている固定カメラや、UAV(無人航空機)などの飛行体に搭載された空撮カメラを用いるこ

とができる。また、各々がカメラを具備する2つ以上のロボットを用い、前記操作装置が、一方のロボットのカメラから取り込まれるカメラ映像を他方のロボットの操作用のカメラ映像として用いる構成も好ましく採用できる。このように他のロボットのカメラを利用する構成であれば、固定カメラが設置されていない環境や飛行体の進入が困難な環境などでの作業も可能となり、本発明のロボットシステムの適用範囲が広がる。

【0015】

また、本発明のロボットが、エンドエフェクタを有するアームと、前記エンドエフェクタが向いている方向に光を照射するライトとを備えていることも好ましい。この構成によれば、エンドエフェクタの向いている所に光が当たるため、タッチスクリーンに表示されているカメラ映像(2次元映像)だけで、エンドエフェクタの3次元的な位置及び向き(特に画面奥行き方向に関する位置及び向き)が正しいかどうかを容易に判別することができるようになる。

【0016】

また、前記ロボットが、関節で接続された複数のリンクからなるアームを有している場合に、前記操作入力部におけるタッチ操作として、前記アーム上の1点をタッチしドラッグすることにより前記アームの各リンクを移動させるシングルタッチ操作と、移動させないリンクにタッチした状態を維持したまま他のリンクをタッチしドラッグすることにより一部のリンクのみを移動させるマルチタッチ操作とを含むことが好ましい。これにより、多自由度のロボットアームを直感的かつ簡単に操作することが可能となる。

【0017】

なお、本発明は、上記の構成や機能を有するロボットシステムとして捉えることもできるし、上記の処理や制御を行うロボットの操作方法又はロボットの制御方法として捉えることもできるし、そのような操作方法又は制御方法の各ステップをタッチスクリーンを具備するコンピュータに実行させるためのプログラムとして捉えることもできる。また、上記の構成、機能、処理などは、特段の技術的制約がない限り、任意に組み合わせることが可能である。

【発明の効果】

【0018】

本発明によれば、少ない時間で操作を習得することができる、直感的なロボットの遠隔操作インタフェースを実現することが可能である。

【図面の簡単な説明】

【0019】

【図1】ロボットシステムの概要を模式的に示す図。

【図2】ロボットシステムの機能構成を示すブロック図。

【図3】操作インタフェースの概要を示す図。

【図4】バーチャルハンドルの例を示す図。

【図5】シングルタッチ操作とマルチタッチ操作の例を示す図。

【図6】3種類のタッチインタラクションを説明する図。

【発明を実施するための形態】

【0020】

本発明は、タッチスクリーンを利用したAR(Augmented Reality:拡張現実)インタ

フェースによりロボットの直感的操作を可能とするものである。本発明は、例えば、危険環境の中で作業を行うロボット、製造ラインで利用される産業用ロボット、家庭内で家事を支援するホームロボットのように、目標物体に対して何らかの処理を行うさまざまなロボットの操作に広く適用可能である。以下に述べる実施形態では、物体を把持するためのハンドが取り付けられたロボットアームと移動機構を具備するロボットを例にとり、本発明の説明を行う。

【0021】

<システム構成>

図1は、本発明の実施形態に係るロボットシステムの概要を模式的に示す図であり、図

2は、同ロボットシステムの機能構成を示すブロック図である。

【0022】

このロボットシステムは、ロボット1と、目標物体O及びロボット1を含む作業空間を撮影するカメラ2と、ロボット1を遠隔操作するための操作装置3と、を備えて構成される。ロボット1及びカメラ2は、それぞれ、有線又は無線により操作装置3に接続されている。

【0023】

(ロボット)

ロボット1は、ロボット台車10とロボットアーム11を備えている。ロボット台車10は移動機構として四輪のホイールを持ち、前後方向の移動と定置旋回が可能である。ロボットアーム11は、4本のリンク12a〜12dを関節13a〜13cで接続した多関節アームであり、その先端にはハンド(エンドエフェクタ)14が取り付けられている。このロボット1は全体として、(1)前後方向の移動、(2)定置旋回、(3)関節13aの回転、(4)関節13bの回転、(5)関節13cの回転、(6)ハンド14の開閉の6自由度を有している。

【0024】

ロボット台車10とロボットアーム11は、操作装置3から送出される制御命令によって制御される。操作装置3は、ロボットアーム11の各関節13a〜13cの角度値を指定することができ、また、各関節13a〜13cの角度値を取得することができる。

【0025】

ロボットアーム11の手首部分にはライト15が装着されている。このライト15は、ハンド14が向いている方向に光Lを照射するためのものであり、本実施形態では、緑色の光Lを発するLED(発光ダイオード)が用いられる。また、ロボット台車10には、ロボット1の3次元的な位置及び姿勢を認識するために用いるビジュアルマーカ16が付されている。

【0026】

(カメラ)

ロボットの遠隔操作では、ロボットに搭載されたカメラから得られる主観視点の映像が用いられることが多いが、その方法では、ロボットが回転又は後進する際に、ロボットの側方や後方にある障害物の回避を行うのが難しい。また主観視点の映像では、ロボットの周囲の状況を把握しづらいため、ロボットの動線や作業手順をどのようにすべきかの判断が難しいこともある。そこで本実施形態では、目標物体O及びロボット1を含む作業空間を画角におさめるように設置されている三人称視点のカメラ2を用いる。カメラ2で取り込まれた映像(動画)は、操作装置3に送られる。

【0027】

なお図1では、作業空間内に設置された固定カメラを例示しているが、空撮カメラや他のロボットのカメラを利用することもできる。その点については後述する。

【0028】

(操作装置)

操作装置3は、ロボット1の遠隔操作に用いられる機器であり、タッチスクリーン、CPU、メモリ、補助記憶装置、通信IFなどのハードウェア資源を備えるコンピュータにより構成されるものである。例えば、汎用のパーソナル・コンピュータ、タブレット端末、スマートフォンなどにプログラムをインストールすることにより実現することもできるし、専用の装置として構成することも可能である。また、タッチスクリーンの部分と演算や制御を行う部分とを別々の筐体で構成することもできる。

【0029】

図2に操作装置3の機能構成を示す。操作装置3は、タッチスクリーン30、カメラ映像取込部31、ロボット認識部32、記憶部33、CG合成部34、操作入力部35、ロボット制御部36を備えている。カメラ映像取込部31は、カメラ2から取り込まれたカメラ映像(動画)をタッチスクリーン30にリアルタイム表示する機能であり、ロボット

認識部32は、カメラ映像からロボット1の3次元的な位置及び姿勢を認識する機能である。CG合成部34は、ロボットのCG映像を生成しカメラ映像に重畳表示する機能である。操作入力部35は、ユーザのタッチ操作に応じてCG映像のロボットを仮想的に動作せる機能であり、ロボット制御部36は、CG映像のロボットの仮想的な動作に追従して実際のロボット1が動作するように、ロボット1に対して制御命令を送出する機能である。

【0030】

<操作装置の動作>

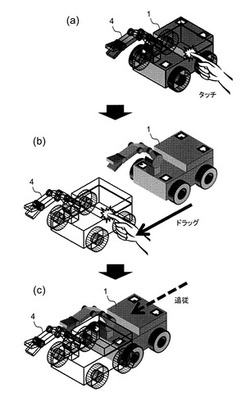

図3は、操作装置を用いた操作インタフェースの概要を示している。

操作装置3は、カメラ2から作業空間内の映像をリアルタイムで取得し、そのカメラ映像にロボットのCG4を重畳表示したものをタッチスクリーン30上に表示する。図3(a)に示すように、CG4は実物のロボット1の画像の上に半透明又はワイヤーフレームで合成される。図3(b)に示すように、ユーザがCG4に触れてドラッグ操作を行うと、CG4の位置・姿勢が変化する。CG4は実物のロボット1に対する目標値として機能するものであり、図3(c)に示すように、ロボット1はCG4と同じ位置及び姿勢になるよう追従動作を行う。

【0031】

ユーザは、動かしたい部位に触れ、それをドラッグすることにより、ロボット1に位置と姿勢を指示することができる。例えば、ロボット1を特定の場所に移動させたいときは、ロボットの本体部分に触れ、目的の場所までドラッグする。また、目標物体Oを把持するべくアーム11を伸ばしたいときは、アームの先端部分に触れてドラッグを行えばよい。このとき、ハンド14の向いている所にライト15の光が当たるため、タッチスクリーンに表示されているカメラ映像だけで、ハンド14の3次元的な位置及び向き(特に画面奥行き方向に関する位置及び向き)が正しいかどうかを容易に判別することができる。

【0032】

(ロボットの位置・姿勢の認識)

ロボット認識部32は、カメラ映像からビジュアルマーカ16を認識することにより、ロボット1の3次元的な位置及び姿勢を認識する。ビジュアルマーカに関しては、ARToolKitの技術を利用することができるため、ここでは詳しい説明を省略する。なお、ロボット台車10に複数のマーカ16を付しているが、これはマーカがカメラの死角に入ることによる認識エラーを可及的に少なくするためである。カメラ映像から複数のマーカが検出できた場合には、最も大きく写っているマーカのみを姿勢認識に用いてもよいし、複数のマーカを姿勢認識に利用することも好ましい。

【0033】

本実施形態では、ロボットアーム11の状態については、ロボット1から取得した各関節13a〜13cの角度値から判断することとする。しかし、ロボットアーム11にもビジュアルマーカを付すことにより、カメラ映像からロボットアーム11の状態を認識することも可能である。

【0034】

(CGの表示)

CG合成部34は、記憶部33からロボット1の3次元モデルを読み込むとともに、ロボット認識部32からロボット1の位置及び姿勢とアーム11の状態を取得し、ロボットのCG4を生成する。この3次元モデルは、実物のロボット1と同一のサイズ及び自由度を有するものであり、例えばロボット1を設計した時のCADデータなどを利用して作成することができる。

【0035】

CG4は、実物のロボット1とまったく同じ形状にする必要はない。むしろ、操作画面を見やすくするため、ロボット1を簡略化(模式化)したような形状のCGを用いるとよい。また、CG4には、操作を支援するためのGUIであるバーチャルハンドルを付すことが好ましい。バーチャルハンドルは、小さな可動部位の操作を容易にしたり、パーツの

可動方向や可動範囲を可視化するために用いられるものである。図4(a)は、リングタイプのバーチャルハンドル40の例を示している。これは、回転部位(ロボット台車10の定置旋回、ロボットアーム11の関節など)の操作に用いられる。また図4(b)は、レバータイプのバーチャルハンドル41の例を示している。これは、ハンド14などの小さな部位の操作に用いられる。

【0036】

(タッチ操作)

ロボット台車10の前後移動と定置旋回の操作は、シングルタッチ操作により行う。すなわち、ユーザが指などでロボット台車部分(又はロボット台車に付されたバーチャルハンドル)をタッチしドラッグすることで、CG4を前後に移動させたり、回転させたりすることができる。ユーザがタッチスクリーンから指を離すと、タッチ操作の完了となる。

【0037】

ロボットアーム11の操作には、シングルタッチ操作とマルチタッチ操作の2種類がある。図5を参照してそれぞれの操作の違いを説明する。シングルタッチ操作では、図5(a)に示すように、ユーザはロボットアーム上の任意の1点をタッチしドラッグする。この場合、操作入力部35は、ロボットアーム11の基端にあるリンク12aの位置のみを拘束条件として、各関節13a〜13cの角度を計算する。一方、マルチタッチ操作では、移動させないリンク(図5(b)では12b)にタッチした状態を維持したたま、別の指で他のリンク(図5(b)では12d)をタッチしドラッグする。この場合、操作入力部35は、固定部位となるリンク12bの位置を拘束条件とし、可動部位となる関節13b、13cの角度を計算する。もちろん、マルチタッチ操作においては、2点以上の部位を固定したり、逆に2点以上の部位を動かしたりすることもできる。なお、シングルタッチ操作、マルチタッチ操作のいずれの場合でも、複数の関節が連動する場合には、IK(Inverse Kinematics)のアルゴリズムを利用すればよい。

【0038】

ハンド14の開閉操作は、バーチャルハンドルのドラッグにより行うことができる。ただし、マルチタッチ操作のピンチアウト/ピンチインによりハンド14の開閉を行うことができるようにしてもよい。

【0039】

なお、ロボットのCG4に対する操作ではないが、ピンチアウト/ピンチインにより表示映像の拡大/縮小を行えるようにしたり、ロボット以外の部分をドラッグすることでカメラの視点を変更できるようにすることも好ましい。

【0040】

(ロボット制御)

ロボット1の動作速度には物理的な限界があるため、ユーザによって操作されるCGの動作に対して遅れ無くロボット1を動作させることは難しい。そこで、本システムでは、ロボット1の動作に遅れがあることを前提としたタッチインタラクションを3種類提案する。以下に述べる3つの方法の全て若しくは2つをシステムに実装し切り替え可能としてもよいし、いずれか1つのみを実装することもできる。

【0041】

(1)Move−after−touch

ユーザが画面に触れてCGを操作している間はロボット1は動かない。ユーザが画面から指を離すと、ロボット制御部36は、タッチ操作が終了した時点のCGの状態をロボット1の目標位置・姿勢とし、ロボット1への制御命令の送出を開始する。ロボット1の位置・姿勢がCGの位置・姿勢に一致すると、ロボット1は停止する。この方法によるCGとロボットの動きを図6(a)に示す。図中、横軸は時間の経過を示しており、ワイヤーフレームのものがCGのロボットアーム、グレーのものが実物のロボットアームを示している。

【0042】

(2)Move−during−touch

ユーザが画面に指を触れてCGを操作し始めると同時に、ロボット制御部36がロボット1への制御命令の送出を開始し、ロボット1はCGへの追従動作を開始する。ユーザがCGを操作している間は、ロボット1の目標位置・姿勢はCGの現在の状態によって更新され、ロボット1はそれに追従するように動く。ユーザが画面から指を離すと、ロボット制御部36は、ロボット1がCGに一致しているかどうかに拘らず、ロボット1の動作をすぐに停止する。CGはその時点のロボット1の状態と一致するように更新される。この方法によるCGとロボットの動きを図6(b)に示す。

【0043】

(3)Move−during−and−after−touch

この方法は前述の2つの方法を組み合わせたものである。ユーザが画面に触れてCGを操作し始めると同時に、ロボット制御部36がロボット1への制御命令の送出を開始し、ロボット1はCGへの追従動作を開始する。ユーザがCGを操作している間は、(2)の方法と同様、ロボット1の目標位置・姿勢はCGの現在の状態によって更新され、ロボット1はそれに追従するように動く。ユーザが画面から指を離すと、ロボット制御部36は、タッチ操作が終了した時点のCGの状態をロボット1の目標位置・姿勢とし、ロボット1がCGに一致するまでロボット1を動作させる。この手法によるCGとロボットの動きを図6(c)に示す。

【0044】

上述した(1)の方法は、ユーザがタッチ操作を終えるまでロボット1が動かないので、あせらず落ち着いて操作ができるという利点がある。また、目標値となるロボット1の位置・姿勢が確定した後にロボット1の動作を開始するため、操作ミスを未然に防ぐことができるという利点もある。これに対し、(2)と(3)の方法は、ユーザの操作に反応してロボット1がすぐに動き始めるために、同じ内容の処理を行う場合であれば(1)の方法よりも短時間で処理を遂行できるという利点がある。また(2)の方法の場合は、ユーザがタッチスクリーンから指を離すなどしてタッチ操作を中断すればロボット1の動作が止まるように構成されているため、例えばロボット1が障害物に衝突しそうになったときに瞬時に停止させることが可能になるという利点がある。

【0045】

<三人称視点カメラ>

前述したように、本システムでは、目標物体O、ロボット1、障害物などを含む作業空間全体の状況把握を容易にするために、三人称視点のカメラを利用する。三人称視点のカメラとして、固定カメラ、空撮カメラ、他のロボットのカメラなどが利用可能である。以下、それぞれのカメラの長所と短所をまとめる。

【0046】

(固定カメラ)

一般的に運用されている固定カメラとして監視カメラがある。監視カメラは、道路、公園、駅、博物館、工場、学校、商店、住宅などさまざまな場所にセキュリティや記録の目的で設置されている。監視カメラは高い場所に設置され、俯瞰視点を提供する。固定された監視カメラの利点は、作業空間の状況把握をするために安定した視界が得られることだが、カメラの動きはパン、チルト、ズームに限られ、対象空間に遮蔽が生じた場合はそれを解消するのが難しい。

【0047】

(空撮カメラ)

無線制御の小型のヘリコプターや飛行船など、さまざまなUAV(Unmanned Aerial Vehicle)が開発されている。UAVに搭載されたカメラ(空撮カメラ)も俯瞰視点を提供

するが、固定監視カメラと違い、空間内を自由に移動することができる。空撮カメラは3Dモデリングツールで行われるような視点操作を実世界において行うことができる。さらに、操作対象のロボットを常に視界内におさめるように自動追従させることも可能である。空撮カメラは、3Dアクションゲームで使われているような、プレイヤの背後から追従するような三人称視点を提供することができる。しかし、そのような視点を提供するため

には、UAVの制御を非常に安定かつ正確に行う必要がある。

【0048】

(他のロボットのカメラ)

作業空間内に2台以上のロボットが存在し、かつ一方のロボットがカメラを持つとき、そのロボットのカメラを借りて、三人称視点でもう1台のロボットを操作することができる。すべてのロボットがカメラを持っていれば、ユーザは主観視点と三人称視点を自由に切り替えて作業を行うことができる。例えば、ロボットのハンドを使った作業を行うときは、そのロボットの主観視点を利用して手元の視界を得ながら作業を行い、そのロボットを別な場所に移動させるときは、他のロボットの視点を用いて障害物を回避しながら移動を行う。また、2台以上のカメラ映像を用いれば、空間認識により障害物の3次元形状を把握することも可能となる。作業空間内の障害物の3次元形状が分かれば、ロボットと障害物のコリジョン判定によりロボットの可動範囲を求め、それをCGの可動範囲にフィードバックすることもできる。

【0049】

視点の操作は、画面内のロボット以外の領域(背景)をタッチするか、視点操作用のアイコンをタッチすることによって行う。また、作業を行うのに良好な視界を得るためにカメラが自動的に移動する方法も考えられる。

【0050】

なお、上記実施形態は本発明の一具体例を示したものにすぎず、種々の変形が可能である。本発明はアーム付きの台車ロボットに限定するものではなく、さまざまな機構を持つロボットや、さまざまな大きさのロボットに対して適用可能である。例えば、ヒューマノイドロボット、ブルドーザ、パワーショベル、フォークリフト、クレーン、巨大ロボット、卓上ロボット、顕微鏡映像に映る極小ロボットなどが想定される。

また、1台のタッチスクリーンで、2台以上のロボット(画面に映っているすべてのロボット)を操作することもできる。特にマルチタッチであれば、両手で2台のロボットを操ったり、1つの画面で2人以上のユーザが同時に複数のロボットを操ることもできる。

【0051】

<本システムの利点>

以上述べたロボットシステムによれば、まず、タッチスクリーン上に表示されたカメラ映像を見ることで、ユーザは実際のロボットの状態(位置、姿勢など)、目標物体の状態、作業空間内に存在する障害物、ロボットの動線などを容易に把握することができる。そして、タッチ(タップ)やドラッグなどのタッチ操作によりCG映像のロボットを所望の位置・姿勢まで動かすだけで、実際のロボットの位置・姿勢を指示することができる。したがって、このようなインタフェースを用いることにより、誰でも簡単かつ直感的にロボットの遠隔操作を行うことが可能となる。

【0052】

また、CG映像のロボットは、動作入力のためのインタフェースとしての役割だけでなく、ロボットがどのように動くかの予測をユーザに提示するシミュレータとしての役割も発揮する。したがって、ロボットの作業手順の組み立てやトライ&エラーが容易になるという利点もある。さらに、作業空間が暗かったり、ロボットの一部が死角に入りこんだりして、カメラ映像ではロボットの状態を視認するのが困難な場合であっても、CG映像によりロボットの位置、姿勢、挙動などを確認できるという利点もある。

【符号の説明】

【0053】

1:ロボット

10:ロボット台車

11:ロボットアーム

12a〜12d:リンク

13a〜13c:関節

14:ハンド

15:ライト

16:ビジュアルマーカ

2:カメラ

3:操作装置

4:CG

【技術分野】

【0001】

本発明は、タッチスクリーンを利用したロボットの遠隔操作技術に関する。

【背景技術】

【0002】

人間が作業を行うのが困難な環境として、水中、高所、高温または低温の環境、毒物や放射性物質が充満した環境などが上げられる。このような危険環境において、人間に代わって作業を行うさまざまなロボットが提案されている。そのようなロボットは、理想的には完全自律型で運用されることが望まれるが、一般物体認識や状況認識の点で課題が残っており、実現はまだ遠い。この問題を軽減する方法として、物体認識用のタグや、事前に作成した対象空間のモデルを利用する方法が提案されているが、これらの方法は未知環境では使用できない。以上の理由から、人間によるロボットの遠隔操作は依然として行われている。

【0003】

人間に代わって物体を把持したり運んだりするロボットは一般的に多自由度の構造を持っているが、そのようなロボットの遠隔操作は初心者にとって簡単なものではない。例えば、ロボットアームは一般的に4から6の自由度を持つ。また、そのようなロボットアームが移動台車の上に固定されていると、自由度はさらに増加する。ロボットの遠隔操作には、一般的にジョイスティックやゲームパッドが広く利用されている。しかし、これらの入力デバイスでは、操作可能な自由度の数はボタンや軸の数に制限される。複数のボタンを同時押しすることによって操作可能な自由度の数を増やす工夫もたびたび行われるが、それは操作をより複雑にし、習得により多くの時間を要する。

【0004】

多関節のロボットの操作を簡単にする方法として、IK(Inverse Kinematics:逆運動学)が広く用いられている。IKを用いた一般的なロボットアームの操作では、手先の位置の操作がジョイスティックにマッピングされ、手先の動きに応じて腕や肘の関節の角度は自動的に計算されるようになっている。しかし、一般的なジョイスティックベースのコントローラでは、スティックを傾けた量に比例した運動速度およびスティックを傾けている時間に比例した移動量が与えられる仕組みになっているため、ユーザが思い通りの位置に手先を移動させられるようになるためにはある程度の訓練を要する。

【0005】

なお、関連する先行技術として、例えば特許文献1には、テレビカメラと消火装置を具備するロボットをジョイスティックにより遠隔操作することで、危険な場所での消火活動や確認作業を行うシステムが開示されている。また特許文献2には、多自由度のロボットをジョイスティックとフットペダルにより操作するシステムが開示されている。

【先行技術文献】

【特許文献】

【0006】

【特許文献1】特開平6−150181号公報

【特許文献2】特開2005−66752号公報

【発明の概要】

【発明が解決しようとする課題】

【0007】

本発明は上記実情に鑑みたものであり、その目的とするところは、少ない時間で操作を習得することができる、直感的なロボットの遠隔操作インタフェースを提供することにある。

【課題を解決するための手段】

【0008】

上記目的を達成するために、本発明では、タッチスクリーン上でロボットのCG(Computer Graphics)をタッチ操作するという直感的なインタフェースを採用する。

【0009】

具体的には、本発明に係るロボットシステムは、目標物体に対して処理を行うロボットと、前記目標物体及び前記ロボットを含む作業空間を撮影する三人称視点のカメラと、前記ロボットを遠隔操作するための操作装置と、を備えるロボットシステムにおいて、前記操作装置は、前記カメラから取り込まれたカメラ映像が表示されるタッチスクリーンと、前記カメラ映像から前記ロボットの3次元的な位置及び姿勢を認識するロボット認識部と、前記ロボットの3次元モデルを記憶する記憶部と、前記3次元モデルと前記ロボット認識部で認識した位置及び姿勢とから前記ロボットのCG映像を生成し、前記CG映像を前記タッチスクリーン上の前記ロボットのカメラ映像に重畳表示するCG合成部と、ユーザのタッチ操作に応じて、前記タッチスクリーン上で前記CG映像のロボットを仮想的に動作させる操作入力部と、前記CG映像のロボットの仮想的な動作に追従して前記ロボットが動作するように、前記ロボットに対して制御命令を送出するロボット制御部と、を有していることを特徴とするロボットシステムである。

【0010】

この構成によれば、まず、タッチスクリーン上に表示されたカメラ映像を見ることで、ユーザは実際のロボットの状態(位置、姿勢など)、目標物体の状態、作業空間内に存在する障害物、ロボットの動線などを容易に把握することができる。そして、タッチ(タップ)やドラッグなどのタッチ操作によりCG映像のロボットを所望の位置・姿勢まで動かすだけで、実際のロボットの位置・姿勢を指示することができる。したがって、このようなインタフェースを用いることにより、誰でも簡単かつ直感的にロボットの遠隔操作を行うことが可能となる。

【0011】

また、CG映像のロボットは、動作入力のためのインタフェースとしての役割だけでなく、ロボットがどのように動くかの予測をユーザに提示するシミュレータとしての役割も発揮する。したがって、ロボットの作業手順の組み立てやトライ&エラーが容易になるという利点もある。さらに、作業空間が暗かったり、ロボットの一部が死角に入りこんだりして、カメラ映像ではロボットの状態を視認するのが困難な場合であっても、CG映像によりロボットの位置、姿勢、挙動などを確認できるという利点もある。

【0012】

ところで、実際のロボットの動作速度には物理的な限界があるため、CG映像のロボットの仮想的な動作に対して遅れ無くロボットを動作させることは難しい。そこで、本発明では、ロボットの動作に遅れがあることを前提としたタッチインタラクションを3種類提案する。

【0013】

第1の方法は、前記ロボット制御部が、タッチ操作が続いている間は前記ロボットに対する制御命令の送出を行わず、タッチ操作が終了すると前記ロボットに対する制御命令の送出を開始し、タッチ操作が終了した時点の前記CG映像と同じ位置及び姿勢になるように前記ロボットを動作させる、というものである。第2の方法は、前記ロボット制御部が、タッチ操作の開始とともに前記ロボットに対する制御命令の送出を開始し、タッチ操作が続いている間は前記ロボットを動作させ、タッチ操作が終了した時点で前記ロボットの動作を停止させる、というものである。第3の方法は、前記ロボット制御部が、タッチ操作の開始とともに前記ロボットに対する制御命令の送出を開始し、タッチ操作が続いている間に前記ロボットを動作させるとともに、タッチ操作の終了後も、タッチ操作が終了した時点の前記CG映像と同じ位置及び姿勢になるまで前記ロボットを動作させる、というものである。

【0014】

三人称視点のカメラとしては、例えば、監視カメラのように作業空間内に設置されている固定カメラや、UAV(無人航空機)などの飛行体に搭載された空撮カメラを用いるこ

とができる。また、各々がカメラを具備する2つ以上のロボットを用い、前記操作装置が、一方のロボットのカメラから取り込まれるカメラ映像を他方のロボットの操作用のカメラ映像として用いる構成も好ましく採用できる。このように他のロボットのカメラを利用する構成であれば、固定カメラが設置されていない環境や飛行体の進入が困難な環境などでの作業も可能となり、本発明のロボットシステムの適用範囲が広がる。

【0015】

また、本発明のロボットが、エンドエフェクタを有するアームと、前記エンドエフェクタが向いている方向に光を照射するライトとを備えていることも好ましい。この構成によれば、エンドエフェクタの向いている所に光が当たるため、タッチスクリーンに表示されているカメラ映像(2次元映像)だけで、エンドエフェクタの3次元的な位置及び向き(特に画面奥行き方向に関する位置及び向き)が正しいかどうかを容易に判別することができるようになる。

【0016】

また、前記ロボットが、関節で接続された複数のリンクからなるアームを有している場合に、前記操作入力部におけるタッチ操作として、前記アーム上の1点をタッチしドラッグすることにより前記アームの各リンクを移動させるシングルタッチ操作と、移動させないリンクにタッチした状態を維持したまま他のリンクをタッチしドラッグすることにより一部のリンクのみを移動させるマルチタッチ操作とを含むことが好ましい。これにより、多自由度のロボットアームを直感的かつ簡単に操作することが可能となる。

【0017】

なお、本発明は、上記の構成や機能を有するロボットシステムとして捉えることもできるし、上記の処理や制御を行うロボットの操作方法又はロボットの制御方法として捉えることもできるし、そのような操作方法又は制御方法の各ステップをタッチスクリーンを具備するコンピュータに実行させるためのプログラムとして捉えることもできる。また、上記の構成、機能、処理などは、特段の技術的制約がない限り、任意に組み合わせることが可能である。

【発明の効果】

【0018】

本発明によれば、少ない時間で操作を習得することができる、直感的なロボットの遠隔操作インタフェースを実現することが可能である。

【図面の簡単な説明】

【0019】

【図1】ロボットシステムの概要を模式的に示す図。

【図2】ロボットシステムの機能構成を示すブロック図。

【図3】操作インタフェースの概要を示す図。

【図4】バーチャルハンドルの例を示す図。

【図5】シングルタッチ操作とマルチタッチ操作の例を示す図。

【図6】3種類のタッチインタラクションを説明する図。

【発明を実施するための形態】

【0020】

本発明は、タッチスクリーンを利用したAR(Augmented Reality:拡張現実)インタ

フェースによりロボットの直感的操作を可能とするものである。本発明は、例えば、危険環境の中で作業を行うロボット、製造ラインで利用される産業用ロボット、家庭内で家事を支援するホームロボットのように、目標物体に対して何らかの処理を行うさまざまなロボットの操作に広く適用可能である。以下に述べる実施形態では、物体を把持するためのハンドが取り付けられたロボットアームと移動機構を具備するロボットを例にとり、本発明の説明を行う。

【0021】

<システム構成>

図1は、本発明の実施形態に係るロボットシステムの概要を模式的に示す図であり、図

2は、同ロボットシステムの機能構成を示すブロック図である。

【0022】

このロボットシステムは、ロボット1と、目標物体O及びロボット1を含む作業空間を撮影するカメラ2と、ロボット1を遠隔操作するための操作装置3と、を備えて構成される。ロボット1及びカメラ2は、それぞれ、有線又は無線により操作装置3に接続されている。

【0023】

(ロボット)

ロボット1は、ロボット台車10とロボットアーム11を備えている。ロボット台車10は移動機構として四輪のホイールを持ち、前後方向の移動と定置旋回が可能である。ロボットアーム11は、4本のリンク12a〜12dを関節13a〜13cで接続した多関節アームであり、その先端にはハンド(エンドエフェクタ)14が取り付けられている。このロボット1は全体として、(1)前後方向の移動、(2)定置旋回、(3)関節13aの回転、(4)関節13bの回転、(5)関節13cの回転、(6)ハンド14の開閉の6自由度を有している。

【0024】

ロボット台車10とロボットアーム11は、操作装置3から送出される制御命令によって制御される。操作装置3は、ロボットアーム11の各関節13a〜13cの角度値を指定することができ、また、各関節13a〜13cの角度値を取得することができる。

【0025】

ロボットアーム11の手首部分にはライト15が装着されている。このライト15は、ハンド14が向いている方向に光Lを照射するためのものであり、本実施形態では、緑色の光Lを発するLED(発光ダイオード)が用いられる。また、ロボット台車10には、ロボット1の3次元的な位置及び姿勢を認識するために用いるビジュアルマーカ16が付されている。

【0026】

(カメラ)

ロボットの遠隔操作では、ロボットに搭載されたカメラから得られる主観視点の映像が用いられることが多いが、その方法では、ロボットが回転又は後進する際に、ロボットの側方や後方にある障害物の回避を行うのが難しい。また主観視点の映像では、ロボットの周囲の状況を把握しづらいため、ロボットの動線や作業手順をどのようにすべきかの判断が難しいこともある。そこで本実施形態では、目標物体O及びロボット1を含む作業空間を画角におさめるように設置されている三人称視点のカメラ2を用いる。カメラ2で取り込まれた映像(動画)は、操作装置3に送られる。

【0027】

なお図1では、作業空間内に設置された固定カメラを例示しているが、空撮カメラや他のロボットのカメラを利用することもできる。その点については後述する。

【0028】

(操作装置)

操作装置3は、ロボット1の遠隔操作に用いられる機器であり、タッチスクリーン、CPU、メモリ、補助記憶装置、通信IFなどのハードウェア資源を備えるコンピュータにより構成されるものである。例えば、汎用のパーソナル・コンピュータ、タブレット端末、スマートフォンなどにプログラムをインストールすることにより実現することもできるし、専用の装置として構成することも可能である。また、タッチスクリーンの部分と演算や制御を行う部分とを別々の筐体で構成することもできる。

【0029】

図2に操作装置3の機能構成を示す。操作装置3は、タッチスクリーン30、カメラ映像取込部31、ロボット認識部32、記憶部33、CG合成部34、操作入力部35、ロボット制御部36を備えている。カメラ映像取込部31は、カメラ2から取り込まれたカメラ映像(動画)をタッチスクリーン30にリアルタイム表示する機能であり、ロボット

認識部32は、カメラ映像からロボット1の3次元的な位置及び姿勢を認識する機能である。CG合成部34は、ロボットのCG映像を生成しカメラ映像に重畳表示する機能である。操作入力部35は、ユーザのタッチ操作に応じてCG映像のロボットを仮想的に動作せる機能であり、ロボット制御部36は、CG映像のロボットの仮想的な動作に追従して実際のロボット1が動作するように、ロボット1に対して制御命令を送出する機能である。

【0030】

<操作装置の動作>

図3は、操作装置を用いた操作インタフェースの概要を示している。

操作装置3は、カメラ2から作業空間内の映像をリアルタイムで取得し、そのカメラ映像にロボットのCG4を重畳表示したものをタッチスクリーン30上に表示する。図3(a)に示すように、CG4は実物のロボット1の画像の上に半透明又はワイヤーフレームで合成される。図3(b)に示すように、ユーザがCG4に触れてドラッグ操作を行うと、CG4の位置・姿勢が変化する。CG4は実物のロボット1に対する目標値として機能するものであり、図3(c)に示すように、ロボット1はCG4と同じ位置及び姿勢になるよう追従動作を行う。

【0031】

ユーザは、動かしたい部位に触れ、それをドラッグすることにより、ロボット1に位置と姿勢を指示することができる。例えば、ロボット1を特定の場所に移動させたいときは、ロボットの本体部分に触れ、目的の場所までドラッグする。また、目標物体Oを把持するべくアーム11を伸ばしたいときは、アームの先端部分に触れてドラッグを行えばよい。このとき、ハンド14の向いている所にライト15の光が当たるため、タッチスクリーンに表示されているカメラ映像だけで、ハンド14の3次元的な位置及び向き(特に画面奥行き方向に関する位置及び向き)が正しいかどうかを容易に判別することができる。

【0032】

(ロボットの位置・姿勢の認識)

ロボット認識部32は、カメラ映像からビジュアルマーカ16を認識することにより、ロボット1の3次元的な位置及び姿勢を認識する。ビジュアルマーカに関しては、ARToolKitの技術を利用することができるため、ここでは詳しい説明を省略する。なお、ロボット台車10に複数のマーカ16を付しているが、これはマーカがカメラの死角に入ることによる認識エラーを可及的に少なくするためである。カメラ映像から複数のマーカが検出できた場合には、最も大きく写っているマーカのみを姿勢認識に用いてもよいし、複数のマーカを姿勢認識に利用することも好ましい。

【0033】

本実施形態では、ロボットアーム11の状態については、ロボット1から取得した各関節13a〜13cの角度値から判断することとする。しかし、ロボットアーム11にもビジュアルマーカを付すことにより、カメラ映像からロボットアーム11の状態を認識することも可能である。

【0034】

(CGの表示)

CG合成部34は、記憶部33からロボット1の3次元モデルを読み込むとともに、ロボット認識部32からロボット1の位置及び姿勢とアーム11の状態を取得し、ロボットのCG4を生成する。この3次元モデルは、実物のロボット1と同一のサイズ及び自由度を有するものであり、例えばロボット1を設計した時のCADデータなどを利用して作成することができる。

【0035】

CG4は、実物のロボット1とまったく同じ形状にする必要はない。むしろ、操作画面を見やすくするため、ロボット1を簡略化(模式化)したような形状のCGを用いるとよい。また、CG4には、操作を支援するためのGUIであるバーチャルハンドルを付すことが好ましい。バーチャルハンドルは、小さな可動部位の操作を容易にしたり、パーツの

可動方向や可動範囲を可視化するために用いられるものである。図4(a)は、リングタイプのバーチャルハンドル40の例を示している。これは、回転部位(ロボット台車10の定置旋回、ロボットアーム11の関節など)の操作に用いられる。また図4(b)は、レバータイプのバーチャルハンドル41の例を示している。これは、ハンド14などの小さな部位の操作に用いられる。

【0036】

(タッチ操作)

ロボット台車10の前後移動と定置旋回の操作は、シングルタッチ操作により行う。すなわち、ユーザが指などでロボット台車部分(又はロボット台車に付されたバーチャルハンドル)をタッチしドラッグすることで、CG4を前後に移動させたり、回転させたりすることができる。ユーザがタッチスクリーンから指を離すと、タッチ操作の完了となる。

【0037】

ロボットアーム11の操作には、シングルタッチ操作とマルチタッチ操作の2種類がある。図5を参照してそれぞれの操作の違いを説明する。シングルタッチ操作では、図5(a)に示すように、ユーザはロボットアーム上の任意の1点をタッチしドラッグする。この場合、操作入力部35は、ロボットアーム11の基端にあるリンク12aの位置のみを拘束条件として、各関節13a〜13cの角度を計算する。一方、マルチタッチ操作では、移動させないリンク(図5(b)では12b)にタッチした状態を維持したたま、別の指で他のリンク(図5(b)では12d)をタッチしドラッグする。この場合、操作入力部35は、固定部位となるリンク12bの位置を拘束条件とし、可動部位となる関節13b、13cの角度を計算する。もちろん、マルチタッチ操作においては、2点以上の部位を固定したり、逆に2点以上の部位を動かしたりすることもできる。なお、シングルタッチ操作、マルチタッチ操作のいずれの場合でも、複数の関節が連動する場合には、IK(Inverse Kinematics)のアルゴリズムを利用すればよい。

【0038】

ハンド14の開閉操作は、バーチャルハンドルのドラッグにより行うことができる。ただし、マルチタッチ操作のピンチアウト/ピンチインによりハンド14の開閉を行うことができるようにしてもよい。

【0039】

なお、ロボットのCG4に対する操作ではないが、ピンチアウト/ピンチインにより表示映像の拡大/縮小を行えるようにしたり、ロボット以外の部分をドラッグすることでカメラの視点を変更できるようにすることも好ましい。

【0040】

(ロボット制御)

ロボット1の動作速度には物理的な限界があるため、ユーザによって操作されるCGの動作に対して遅れ無くロボット1を動作させることは難しい。そこで、本システムでは、ロボット1の動作に遅れがあることを前提としたタッチインタラクションを3種類提案する。以下に述べる3つの方法の全て若しくは2つをシステムに実装し切り替え可能としてもよいし、いずれか1つのみを実装することもできる。

【0041】

(1)Move−after−touch

ユーザが画面に触れてCGを操作している間はロボット1は動かない。ユーザが画面から指を離すと、ロボット制御部36は、タッチ操作が終了した時点のCGの状態をロボット1の目標位置・姿勢とし、ロボット1への制御命令の送出を開始する。ロボット1の位置・姿勢がCGの位置・姿勢に一致すると、ロボット1は停止する。この方法によるCGとロボットの動きを図6(a)に示す。図中、横軸は時間の経過を示しており、ワイヤーフレームのものがCGのロボットアーム、グレーのものが実物のロボットアームを示している。

【0042】

(2)Move−during−touch

ユーザが画面に指を触れてCGを操作し始めると同時に、ロボット制御部36がロボット1への制御命令の送出を開始し、ロボット1はCGへの追従動作を開始する。ユーザがCGを操作している間は、ロボット1の目標位置・姿勢はCGの現在の状態によって更新され、ロボット1はそれに追従するように動く。ユーザが画面から指を離すと、ロボット制御部36は、ロボット1がCGに一致しているかどうかに拘らず、ロボット1の動作をすぐに停止する。CGはその時点のロボット1の状態と一致するように更新される。この方法によるCGとロボットの動きを図6(b)に示す。

【0043】

(3)Move−during−and−after−touch

この方法は前述の2つの方法を組み合わせたものである。ユーザが画面に触れてCGを操作し始めると同時に、ロボット制御部36がロボット1への制御命令の送出を開始し、ロボット1はCGへの追従動作を開始する。ユーザがCGを操作している間は、(2)の方法と同様、ロボット1の目標位置・姿勢はCGの現在の状態によって更新され、ロボット1はそれに追従するように動く。ユーザが画面から指を離すと、ロボット制御部36は、タッチ操作が終了した時点のCGの状態をロボット1の目標位置・姿勢とし、ロボット1がCGに一致するまでロボット1を動作させる。この手法によるCGとロボットの動きを図6(c)に示す。

【0044】

上述した(1)の方法は、ユーザがタッチ操作を終えるまでロボット1が動かないので、あせらず落ち着いて操作ができるという利点がある。また、目標値となるロボット1の位置・姿勢が確定した後にロボット1の動作を開始するため、操作ミスを未然に防ぐことができるという利点もある。これに対し、(2)と(3)の方法は、ユーザの操作に反応してロボット1がすぐに動き始めるために、同じ内容の処理を行う場合であれば(1)の方法よりも短時間で処理を遂行できるという利点がある。また(2)の方法の場合は、ユーザがタッチスクリーンから指を離すなどしてタッチ操作を中断すればロボット1の動作が止まるように構成されているため、例えばロボット1が障害物に衝突しそうになったときに瞬時に停止させることが可能になるという利点がある。

【0045】

<三人称視点カメラ>

前述したように、本システムでは、目標物体O、ロボット1、障害物などを含む作業空間全体の状況把握を容易にするために、三人称視点のカメラを利用する。三人称視点のカメラとして、固定カメラ、空撮カメラ、他のロボットのカメラなどが利用可能である。以下、それぞれのカメラの長所と短所をまとめる。

【0046】

(固定カメラ)

一般的に運用されている固定カメラとして監視カメラがある。監視カメラは、道路、公園、駅、博物館、工場、学校、商店、住宅などさまざまな場所にセキュリティや記録の目的で設置されている。監視カメラは高い場所に設置され、俯瞰視点を提供する。固定された監視カメラの利点は、作業空間の状況把握をするために安定した視界が得られることだが、カメラの動きはパン、チルト、ズームに限られ、対象空間に遮蔽が生じた場合はそれを解消するのが難しい。

【0047】

(空撮カメラ)

無線制御の小型のヘリコプターや飛行船など、さまざまなUAV(Unmanned Aerial Vehicle)が開発されている。UAVに搭載されたカメラ(空撮カメラ)も俯瞰視点を提供

するが、固定監視カメラと違い、空間内を自由に移動することができる。空撮カメラは3Dモデリングツールで行われるような視点操作を実世界において行うことができる。さらに、操作対象のロボットを常に視界内におさめるように自動追従させることも可能である。空撮カメラは、3Dアクションゲームで使われているような、プレイヤの背後から追従するような三人称視点を提供することができる。しかし、そのような視点を提供するため

には、UAVの制御を非常に安定かつ正確に行う必要がある。

【0048】

(他のロボットのカメラ)

作業空間内に2台以上のロボットが存在し、かつ一方のロボットがカメラを持つとき、そのロボットのカメラを借りて、三人称視点でもう1台のロボットを操作することができる。すべてのロボットがカメラを持っていれば、ユーザは主観視点と三人称視点を自由に切り替えて作業を行うことができる。例えば、ロボットのハンドを使った作業を行うときは、そのロボットの主観視点を利用して手元の視界を得ながら作業を行い、そのロボットを別な場所に移動させるときは、他のロボットの視点を用いて障害物を回避しながら移動を行う。また、2台以上のカメラ映像を用いれば、空間認識により障害物の3次元形状を把握することも可能となる。作業空間内の障害物の3次元形状が分かれば、ロボットと障害物のコリジョン判定によりロボットの可動範囲を求め、それをCGの可動範囲にフィードバックすることもできる。

【0049】

視点の操作は、画面内のロボット以外の領域(背景)をタッチするか、視点操作用のアイコンをタッチすることによって行う。また、作業を行うのに良好な視界を得るためにカメラが自動的に移動する方法も考えられる。

【0050】

なお、上記実施形態は本発明の一具体例を示したものにすぎず、種々の変形が可能である。本発明はアーム付きの台車ロボットに限定するものではなく、さまざまな機構を持つロボットや、さまざまな大きさのロボットに対して適用可能である。例えば、ヒューマノイドロボット、ブルドーザ、パワーショベル、フォークリフト、クレーン、巨大ロボット、卓上ロボット、顕微鏡映像に映る極小ロボットなどが想定される。

また、1台のタッチスクリーンで、2台以上のロボット(画面に映っているすべてのロボット)を操作することもできる。特にマルチタッチであれば、両手で2台のロボットを操ったり、1つの画面で2人以上のユーザが同時に複数のロボットを操ることもできる。

【0051】

<本システムの利点>

以上述べたロボットシステムによれば、まず、タッチスクリーン上に表示されたカメラ映像を見ることで、ユーザは実際のロボットの状態(位置、姿勢など)、目標物体の状態、作業空間内に存在する障害物、ロボットの動線などを容易に把握することができる。そして、タッチ(タップ)やドラッグなどのタッチ操作によりCG映像のロボットを所望の位置・姿勢まで動かすだけで、実際のロボットの位置・姿勢を指示することができる。したがって、このようなインタフェースを用いることにより、誰でも簡単かつ直感的にロボットの遠隔操作を行うことが可能となる。

【0052】

また、CG映像のロボットは、動作入力のためのインタフェースとしての役割だけでなく、ロボットがどのように動くかの予測をユーザに提示するシミュレータとしての役割も発揮する。したがって、ロボットの作業手順の組み立てやトライ&エラーが容易になるという利点もある。さらに、作業空間が暗かったり、ロボットの一部が死角に入りこんだりして、カメラ映像ではロボットの状態を視認するのが困難な場合であっても、CG映像によりロボットの位置、姿勢、挙動などを確認できるという利点もある。

【符号の説明】

【0053】

1:ロボット

10:ロボット台車

11:ロボットアーム

12a〜12d:リンク

13a〜13c:関節

14:ハンド

15:ライト

16:ビジュアルマーカ

2:カメラ

3:操作装置

4:CG

【特許請求の範囲】

【請求項1】

目標物体に対して処理を行うロボットと、

前記目標物体及び前記ロボットを含む作業空間を撮影する三人称視点のカメラと、

前記ロボットを遠隔操作するための操作装置と、

を備えるロボットシステムにおいて、

前記操作装置は、

前記カメラから取り込まれたカメラ映像が表示されるタッチスクリーンと、

前記カメラ映像から前記ロボットの3次元的な位置及び姿勢を認識するロボット認識部と、

前記ロボットの3次元モデルを記憶する記憶部と、

前記3次元モデルと前記ロボット認識部で認識した位置及び姿勢とから前記ロボットのCG映像を生成し、前記CG映像を前記タッチスクリーン上の前記ロボットのカメラ映像に重畳表示するCG合成部と、

ユーザのタッチ操作に応じて、前記タッチスクリーン上で前記CG映像のロボットを仮想的に動作させる操作入力部と、

前記CG映像のロボットの仮想的な動作に追従して前記ロボットが動作するように、前記ロボットに対して制御命令を送出するロボット制御部と、

を有していることを特徴とするロボットシステム。

【請求項2】

前記ロボット制御部は、

タッチ操作が続いている間は前記ロボットに対する制御命令の送出を行わず、

タッチ操作が終了すると前記ロボットに対する制御命令の送出を開始し、タッチ操作が終了した時点の前記CG映像と同じ位置及び姿勢になるように前記ロボットを動作させることを特徴とする請求項1に記載のロボットシステム。

【請求項3】

前記ロボット制御部は、

タッチ操作の開始とともに前記ロボットに対する制御命令の送出を開始し、タッチ操作が続いている間は前記ロボットを動作させ、

タッチ操作が終了した時点で前記ロボットの動作を停止させることを特徴とする請求項1に記載のロボットシステム。

【請求項4】

前記ロボット制御部は、

タッチ操作の開始とともに前記ロボットに対する制御命令の送出を開始し、タッチ操作が続いている間に前記ロボットを動作させるとともに、

タッチ操作の終了後も、タッチ操作が終了した時点の前記CG映像と同じ位置及び姿勢になるまで前記ロボットを動作させることを特徴とする請求項1に記載のロボットシステム。

【請求項5】

前記ロボットとして、各々がカメラを具備する2つのロボットを有しており、

前記操作装置は、一方のロボットのカメラから取り込まれるカメラ映像を他方のロボットの操作用のカメラ映像として用いることを特徴とする請求項1〜4のうちいずれか1項に記載にロボットシステム。

【請求項6】

前記ロボットは、エンドエフェクタを有するアームと、前記エンドエフェクタが向いている方向に光を照射するライトとを備えていることを特徴とする請求項1〜5のうちいずれか1項に記載のロボットシステム。

【請求項7】

前記ロボットは、関節で接続された複数のリンクからなるアームを有しており、

前記操作入力部におけるタッチ操作は、

前記アーム上の1点をタッチしドラッグすることにより前記アームの各リンクを移動させるシングルタッチ操作と、

移動させないリンクにタッチした状態を維持したまま他のリンクをタッチしドラッグすることにより一部のリンクのみを移動させるマルチタッチ操作と、を含むことを特徴とする請求項1〜6のうちいずれか1項に記載のロボットシステム。

【請求項1】

目標物体に対して処理を行うロボットと、

前記目標物体及び前記ロボットを含む作業空間を撮影する三人称視点のカメラと、

前記ロボットを遠隔操作するための操作装置と、

を備えるロボットシステムにおいて、

前記操作装置は、

前記カメラから取り込まれたカメラ映像が表示されるタッチスクリーンと、

前記カメラ映像から前記ロボットの3次元的な位置及び姿勢を認識するロボット認識部と、

前記ロボットの3次元モデルを記憶する記憶部と、

前記3次元モデルと前記ロボット認識部で認識した位置及び姿勢とから前記ロボットのCG映像を生成し、前記CG映像を前記タッチスクリーン上の前記ロボットのカメラ映像に重畳表示するCG合成部と、

ユーザのタッチ操作に応じて、前記タッチスクリーン上で前記CG映像のロボットを仮想的に動作させる操作入力部と、

前記CG映像のロボットの仮想的な動作に追従して前記ロボットが動作するように、前記ロボットに対して制御命令を送出するロボット制御部と、

を有していることを特徴とするロボットシステム。

【請求項2】

前記ロボット制御部は、

タッチ操作が続いている間は前記ロボットに対する制御命令の送出を行わず、

タッチ操作が終了すると前記ロボットに対する制御命令の送出を開始し、タッチ操作が終了した時点の前記CG映像と同じ位置及び姿勢になるように前記ロボットを動作させることを特徴とする請求項1に記載のロボットシステム。

【請求項3】

前記ロボット制御部は、

タッチ操作の開始とともに前記ロボットに対する制御命令の送出を開始し、タッチ操作が続いている間は前記ロボットを動作させ、

タッチ操作が終了した時点で前記ロボットの動作を停止させることを特徴とする請求項1に記載のロボットシステム。

【請求項4】

前記ロボット制御部は、

タッチ操作の開始とともに前記ロボットに対する制御命令の送出を開始し、タッチ操作が続いている間に前記ロボットを動作させるとともに、

タッチ操作の終了後も、タッチ操作が終了した時点の前記CG映像と同じ位置及び姿勢になるまで前記ロボットを動作させることを特徴とする請求項1に記載のロボットシステム。

【請求項5】

前記ロボットとして、各々がカメラを具備する2つのロボットを有しており、

前記操作装置は、一方のロボットのカメラから取り込まれるカメラ映像を他方のロボットの操作用のカメラ映像として用いることを特徴とする請求項1〜4のうちいずれか1項に記載にロボットシステム。

【請求項6】

前記ロボットは、エンドエフェクタを有するアームと、前記エンドエフェクタが向いている方向に光を照射するライトとを備えていることを特徴とする請求項1〜5のうちいずれか1項に記載のロボットシステム。

【請求項7】

前記ロボットは、関節で接続された複数のリンクからなるアームを有しており、

前記操作入力部におけるタッチ操作は、

前記アーム上の1点をタッチしドラッグすることにより前記アームの各リンクを移動させるシングルタッチ操作と、

移動させないリンクにタッチした状態を維持したまま他のリンクをタッチしドラッグすることにより一部のリンクのみを移動させるマルチタッチ操作と、を含むことを特徴とする請求項1〜6のうちいずれか1項に記載のロボットシステム。

【図1】

【図2】

【図3】

【図4】

【図5】

【図6】

【図2】

【図3】

【図4】

【図5】

【図6】

【公開番号】特開2012−171024(P2012−171024A)

【公開日】平成24年9月10日(2012.9.10)

【国際特許分類】

【出願番号】特願2011−32547(P2011−32547)

【出願日】平成23年2月17日(2011.2.17)

【出願人】(503360115)独立行政法人科学技術振興機構 (1,734)

【Fターム(参考)】

【公開日】平成24年9月10日(2012.9.10)

【国際特許分類】

【出願日】平成23年2月17日(2011.2.17)

【出願人】(503360115)独立行政法人科学技術振興機構 (1,734)

【Fターム(参考)】

[ Back to top ]