人型ロボット

【課題】特定個人に似顔、似声により情報を伝達する人型ロボットにおいて、音声を発する際の動きのなかに、特定の話者の個性を表現することにより、話者が伝達しようとする愛情などを演出できる人型ロボットを提供する。

【解決手段】特定個人に似顔のロボット本体(1)の内部に搭載したストレージ(3)にあらかじめ特定個人の声を収録し発話するために必要となる五十音等の音素データや特定個人の癖となる動作データ等を登録し、発話時にその音声を制御部(2)内のメインCPUユニット(211)により合成して、スピーカ(26)より出力し、同時にアクチュエータ(9)〜(25)を四肢動作させる。

【解決手段】特定個人に似顔のロボット本体(1)の内部に搭載したストレージ(3)にあらかじめ特定個人の声を収録し発話するために必要となる五十音等の音素データや特定個人の癖となる動作データ等を登録し、発話時にその音声を制御部(2)内のメインCPUユニット(211)により合成して、スピーカ(26)より出力し、同時にアクチュエータ(9)〜(25)を四肢動作させる。

【発明の詳細な説明】

【技術分野】

【0001】

本発明は、画像、音声や複数のセンサからの入力情報を基に身振り手振り、表情などを用いてコミュニケーションを行う人型ロボットに関する。

【背景技術】

【0002】

玩具やゲーム等の民生用分野、あるいは製造業や流通業等の産業用分野において各種のロボットが広く用いられており、これらのロボットの中には、姿形が人間に酷似し、ユーザとコミュニケーションを行ういわゆる人型のロボットも開発されている。

従来の人型ロボットは、顔面部、発声機構、四肢動作のいずれかに対して特定個人を対象にしたものはあるが、一般に、顔面部、発声機構、四肢動作は画一的に特定されている。

【0003】

例えば、特許文献1に開示される発明においては、文章の内容を解析して感情に関わる情報を抽出し、抽出された感情情報に対応した発声やジェスチャ(身振り・手振り)を行なう電子メールを読み上げるロボットが示されている。

【0004】

【特許文献1】特開2006−142407号公報

【発明の開示】

【発明が解決しようとする課題】

【0005】

上述した従来例のように、ロボットが伝達しようとする文章の内容を解析して文章中から感情に関わる情報を抽出し、抽出された感情情報に対応したジェスチャを音声とともに発現することで音声と動作とにより、すなわち言語と非言語とにより、感情表現をすることができる。

しかしながら、ここでなされているロボットのジェスチャは、特定の感情表現に対応するジェスチャのみであり、しかもその動作は、ロボットに固定的に記憶されている喜怒哀楽に対する動作をジェスチャで表現するものである。

【0006】

一般に、人が会話等で音声を発するときに生じるジェスチャは、千差万別であり、それぞれ癖がある。特定個人が音声を発する際のジェスチャは、その特定個人の癖を含むジェスチャで行われるのが好ましく、また、特定個人に似顔、似声でそのようなジェスチャがなされると、情報を伝達のみでなく、愛情などの感情を表現することができる。

【0007】

本発明は、特定個人に似顔、似声により情報を伝達する人型ロボットにおいて、音声を発する際の動きのなかに、特定の話者の個性を表現することにより、話者が伝達しようとする愛情などを演出できる人型ロボットを提供することを目的とする。

【0008】

また、本発明は、特定個人の声や癖を簡単に変更することができ、特定個人の癖を実現することができる人型ロボットを提供することを目的とする。

【課題を解決するための手段】

【0009】

上記課題を解決するためになされた本発明の人型ロボットは、特定個人の似顔である人体型の外形を有する人型ロボットの外形を構成する部分にそれぞれの部分に対応する人体各部分の動きと同様の動きを起こさせるアクチュエータ群と、音声を発するスピーカとを備えた人型ロボットであって、ロボットのモデルとなる特定個人の情報を蓄積するモデル情報データベースと、特定個人の音声の音素を蓄積する音声合成音素データベースと、特定個人の癖などの動作を時系列データとして蓄積する癖モーションデータベースと、対話相手の顔画像データや特徴情報を蓄積する相手情報データベースと、ロボットの行動履歴を蓄積する行動履歴データベースと、対話から得た情報やインターネット上の情報を蓄積する知識情報データベースを備え、前記音声合成音素データベースの蓄積データに基づいて特定個人の音素を合成して発話する音声合成手段と、前記癖モーションデータベースの蓄積データに基づいて特定個人の癖を演出する動作手段と、前記相手情報データベース、前記モデル情報データベース、及び前記行動履歴データベースの蓄積データに基づいて対話相手に対する感情を認識する感情認識手段と、対話相手の音声データの内容を認識する音声認識手段と、前記音声認識手段の認識結果に応じて対話相手との対話やインターネット上の情報を知識として前記知識情報データベースに蓄積する学習手段と、前記感情認識手段における認識結果、前記学習手段における蓄積知識に応じて対話相手に対する感情を演出し、該演出結果に応じて前記音声合成手段及び動作手段を制御する感情演出制御手段とを備えたことを特徴とする。

【0010】

また、人型ロボットは、特定個人のシナリオが記述されているモデル情報データベースから対話相手と対話を行い、その対話から対話相手に対するロボットの感情を認識する。その感情に対する感情を持った演出をするため、音声合成で合成された音声をスピーカから発生させる制御を行うとともに、その音声に対応する癖データに記憶された人体各部の動きを、形体癖模写部が模写するように制御し、音声と動きとが同期するようにして、人型ロボットを動作させる。

【発明の効果】

【0011】

本発明によれば、特定個人に似顔のロボットが似声でしかも音声を発するときに特定個人の癖を動作で演出するので、感情や愛情を演出することができる。

【発明を実施するため最良の形態】

【0012】

図1〜図9を用いて本発明の実施形態を説明する。

本発明は、特定個人の音声や癖を特定個人の似顔のロボットで制御することで、従来に無い特定個人に似た人型ロボットを実現する。その概略を図1、2に基づいて説明すれば、特定個人に似顔のロボット本体(1)の内部に含まれる制御部(2)に搭載されたストレージ(220)にあらかじめ特定個人の声を収録し発話するために必要となる五十音等の音素データや特定個人の癖となる動作データ等を登録し、発話時にその音声を制御部(2)内のメインCPUユニット(211)により合成して、スピーカ(26)より出力し、同時にアクチュエータ(9)〜(25)を四肢動作させるものである。

【0013】

図1は本発明の概要を示すロボット本体(1)の構成図である。

写真等を基にした特定個人の似顔であるロボット本体(1)は、主に録音音源等を基にした発声機構であるスピーカ(26)、聴音機構であるマイク(27,28)、カメラ(11),(12)、四肢動作をするアクチュエータ(9)〜(25)、ネットワーク接続機構(6)、センサのタッチセンサ(29),(30)、温度センサ(31)及びこれらの各部を統括する制御部(2)から構成される。

【0014】

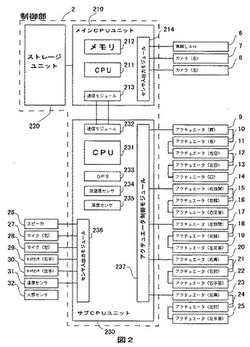

図2はロボット本体(1)に含まれる制御部(2)の構成図である。

制御部(2)は、人型ロボットの人工知能を持つメインCPUユニット(210)とアクチュエータやセンサを制御するサブCPUユニット(230)とデータベース等のデータファイルを保存するストレージユニット(220)から構成され、メインCPUユニット(210)とサブCPUユニット(230)は、メインCPUユニット(210)内の通信モジュール(213)とサブCPU(230)内の通信モジュール(232)とで常に互いの情報を伝達している。

メインCPUユニット(210)は、人工知能であるアプリケーションソフトを実行するCPU(211)とメモリ(212)とカメラ(7)(8)や無線LAN(6)を制御するセンサ入出力モジュール(214)とサブCPUからの情報を得るための通信モジュール(213)から構成されている。

サブCPUユニット(230)は、各アクチュエータの制御や各センサの管理をするCPU(231)とアクチュエータ(9)〜(25)を制御するアクチュエータ制御モジュール(237)と握手などを検出するためのタッチセンサ(29)(30)や周囲の温度を測定する温度センサ(31)や人を検出するための人感センサ(32)等を制御するセンサ入出力モジュール(236)と位置情報を得るためのGPS(233)と人型ロボットが揺すられたりなどの振動を検出するための加速度センサ(234)と人型ロボット内の温度を測定するための温度センサ(235)から構成される。

【0015】

図3は、ソフトウェアの概要を示す構成図である。

本ソフトウェアは、制御部(2)上のCPUのオペレーションシステム(S101)上で動作する。

オペレーションシステム(S101)上には、人工知能の役割をするアプリケーションプログラム(S102)、カメラを制御するカメラデバイスプログラム(S117)、マイクを制御するマイクデバイスプログラム(S118)、スピーカを制御するスピーカデバイスプログラム(S119)、特定個人のデータや行動履歴等を蓄積している行動履歴データベース(S103)から構成される。

アプリケーションプログラム(S102)は、話者の顔や物体を認識するための画像認識プログラム(S111)、音声や対話相手を特定するための音声認識プログラム(S112)、対話相手の感情を認識するための感情認識プログラム(S113)、対話相手との対話やインターネット上の情報を知識としてデータベースに蓄積する学習制御プログラム(S114)、音声を合成するための音声合成プログラム(S115)、感情を演出するための感情演出プログラムから構成される。

データベース(S103)は、対話から得た情報やインターネット上情報を蓄積する知識情報データベース(S121)、特定個人の似声を音声合成するための音声合成音素データベース(S122)、特定個人の癖の動作データを蓄積するための癖モーションデータベース(S123)、特定個人を演出するためのシナリオを記述するモデル情報データベース(S124)、ロボットと対話する相手の顔情報や特徴を蓄積するための相手情報データベース(S125)、時間に対する本システムの各センサの取得データを蓄積するための行動履歴データベース(S126)から構成される。

【0016】

本発明は、特定個人を演出するため複数のセンサからの入力に基づいてロボットが対話する相手話者への感情に対して対応動作をする。

その制御方法は、相手情報データベースに登録されている話者に対する感情レベルに対して、対応動作のパターンを変化させる。

相手情報データベースには、相手話者に対して「好き」「普通」「嫌い」の感情レベルを持っている。対応動作は、例えば、好きな話者には、優しい言葉使いで話しをしたり、愛嬌を振舞ったりする。嫌いな人には無視をするような動作をさせる。

また、感情レベルは、更新される。例えば、大好きな話者であっても、話しかけられる回数が減ったりすると、「大好き」から「好き」に変化する。

対応動作における言葉使いについては、イントネーションを変化させ対応する。また、対応する動きについては、予め登録した癖モーションデータベースから選択し、実行する。

【0017】

特定個人を演出するフローを図4フローチャートにより説明すると、相手話者がロボットと会話を始めるとロボットは日常会話で会話をする。(S401)そのときにロボットは、画像による顔認識処理を行い話者を特定する。(S402)並行して、音声による話者特定を行い(S403)、(S402)と(S403)が一定の確度で一致した場合、話者の名前を呼び、確認を行い特定する(S404)。特定された相手話者の相手情報データベースと照らし合わせて、話者が好きな場合(S405)、好きな人モード(S407)の処理を行い、話者が嫌いな場合(S406)、嫌いな人モード(S408)の処理を行い、いずれでもない場合、普通の人モード(S409)の処理を行う。(S407)又は(S408)又は(S409)の処理が終わると、日常会話(S401)に戻る。

【0018】

例えば、好きな人モード(S407)の処理を図5フローチャートにより説明すると、好きな人モードに遷移するとロボットは、愛嬌のある音素による音声合成を行いながら好きな人用日常会話を行う。(S501)そのときにロボットは、音声による話者の感情を測定し(S502)、感情を特定するための話題を投げかけて、話者の感情を特定する。(S503)話者が元気の場合(S504)、元気モード(S506)の処理を行い、話者が落ち込んでいる場合(S505)、慰めモード(S507)の処理を行う。いずれでもない場合、平常モード(S508)での処理を行う。

【0019】

好きな人モード、嫌いな人モード及び普通の人モードに対する音声合成は音声合成音素データベースより、異なるイントネーション選択することで対応する。

【0020】

元気モード、慰めモード及び平常モードにおける会話内容は、予めモデルとなる特定個人のモデル情報をモデル情報データベース(S124)に会話の流れに沿ったシナリオとして予め記述し登録しておく。

【0021】

モデル情報データベース(S124)に登録されるシナリオの一例を図6に示す。図において、ロボットのモデルとなるモデル情報データベース(S124)は、名前(S601)、生年月日(S602)、趣味(S603)、特技(S604)、演出を表現するためのシナリオ(S605)、シナリオのトリガーとなる音声認識語句(S606)、演出するための声(S608)、演出するための動き(S609)をXML形式で記述する。

特定個人を対象としているため、特定個人の癖などを演出する際に柔軟性の高いXML形式としている。

【0022】

音声認識語句(S606)は、音声認識の辞書の役割をしている。

このモデル情報データベース(S124)に記述されている音声認識語句数がロボットの認識できる語句数となる。

【0023】

一方、音声合成音素データベース(S122)には、予め用意した基本文を読み上げて、あらかじめ登録しておく。

【0024】

また、癖モーションデータベース(S123)には、本人の癖となる各関節の時系列データをあらかじめ登録する。

【0025】

相手情報データベース(S125)は、図7に示すようにID(S701)、対話相手の名前(S702)、生年月日(S703)、趣味(S704)、特技(S705)、音声認識用音素(S706)、顔認識用固有値(S707)、対話相手に対する感情レベル(S708)等のフィールドから構成される。感情レベル(S708)は、行動履歴データベース(S126)から、ロボットとの会話頻度や会話シーケンスによる会話をしたときのロボットが話者に対して判定した感情値や制御部(2)内のサブCPUユニット(230)内の加速度センサ(234)から取得したデータから優しく抱いてもらっているかあるいは頭を叩かれていないか等を判定し感情値を決定して、更新される。

【0026】

行動履歴データベース(S126)は、図に示すようにID(S801)、履歴登録時の年月日(S802)、時間(S803)、場所(S804)、対話相手(S805)、そのときの遷移したシナリオであるシナリオ(S806)、対話相手が未知のときに新規に登録される対話相手の顔認識用固有値(S807)、未知の人の名前や新しい単語を覚えたときの新単語(S808)等のフィールドから構成される。新単語(S808)は、対話相手との対話やインターネット上のデータを取得した際に学習制御プログラム(S114)により、登録される。場所(S804)は、制御部(2)内のサブCPUユニット(230)内のGPS(233)から取得した位置情報と会話シーケンスにより、場所を特定し、登録される。

【0027】

知識情報データベース(S121)は、ID(S901)、情報取得日(S902)、時間(S903)、場所(S904)、対話相手(S905)、そのときの遷移したシナリオのカテゴリ(S906)、新規に覚えた人の名前や単語である新単語(S907)等のフィールドから構成される。知識情報データベースは、行動履歴データベース(S126)やインターネット上のデータを取得した際に学習制御プログラム(S114)により、登録される。

【図面の簡単な説明】

【0028】

【図1】本発明のシステムの一例を示す説明図である。

【図2】図1に示す制御部、アクチュエータ及びセンサの電気的な構成を示すブロック図である。

【図3】制御部のソフトウェアの構成を示すブロック図である。

【図4】感情表現をするソフトウェアのフローチャートである。

【図5】好きな人モードにおけるソフトウェアのフローチャートである。

【図6】モデル情報データベースである。

【図7】相手情報データベースである。

【図8】行動履歴データベースである。

【図9】知識情報データベースである。

【符号の説明】

【0029】

1 ロボット

2 制御部

210 メインCPUユニット

220 ストレージ

230 サブCPUユニット

6 無線LAN

7、8 カメラ

9〜25 アクチュエータ

26 スピーカ

27、28 マイク

29、30 タッチセンサ

31 温度センサ

32 人感センサ

【技術分野】

【0001】

本発明は、画像、音声や複数のセンサからの入力情報を基に身振り手振り、表情などを用いてコミュニケーションを行う人型ロボットに関する。

【背景技術】

【0002】

玩具やゲーム等の民生用分野、あるいは製造業や流通業等の産業用分野において各種のロボットが広く用いられており、これらのロボットの中には、姿形が人間に酷似し、ユーザとコミュニケーションを行ういわゆる人型のロボットも開発されている。

従来の人型ロボットは、顔面部、発声機構、四肢動作のいずれかに対して特定個人を対象にしたものはあるが、一般に、顔面部、発声機構、四肢動作は画一的に特定されている。

【0003】

例えば、特許文献1に開示される発明においては、文章の内容を解析して感情に関わる情報を抽出し、抽出された感情情報に対応した発声やジェスチャ(身振り・手振り)を行なう電子メールを読み上げるロボットが示されている。

【0004】

【特許文献1】特開2006−142407号公報

【発明の開示】

【発明が解決しようとする課題】

【0005】

上述した従来例のように、ロボットが伝達しようとする文章の内容を解析して文章中から感情に関わる情報を抽出し、抽出された感情情報に対応したジェスチャを音声とともに発現することで音声と動作とにより、すなわち言語と非言語とにより、感情表現をすることができる。

しかしながら、ここでなされているロボットのジェスチャは、特定の感情表現に対応するジェスチャのみであり、しかもその動作は、ロボットに固定的に記憶されている喜怒哀楽に対する動作をジェスチャで表現するものである。

【0006】

一般に、人が会話等で音声を発するときに生じるジェスチャは、千差万別であり、それぞれ癖がある。特定個人が音声を発する際のジェスチャは、その特定個人の癖を含むジェスチャで行われるのが好ましく、また、特定個人に似顔、似声でそのようなジェスチャがなされると、情報を伝達のみでなく、愛情などの感情を表現することができる。

【0007】

本発明は、特定個人に似顔、似声により情報を伝達する人型ロボットにおいて、音声を発する際の動きのなかに、特定の話者の個性を表現することにより、話者が伝達しようとする愛情などを演出できる人型ロボットを提供することを目的とする。

【0008】

また、本発明は、特定個人の声や癖を簡単に変更することができ、特定個人の癖を実現することができる人型ロボットを提供することを目的とする。

【課題を解決するための手段】

【0009】

上記課題を解決するためになされた本発明の人型ロボットは、特定個人の似顔である人体型の外形を有する人型ロボットの外形を構成する部分にそれぞれの部分に対応する人体各部分の動きと同様の動きを起こさせるアクチュエータ群と、音声を発するスピーカとを備えた人型ロボットであって、ロボットのモデルとなる特定個人の情報を蓄積するモデル情報データベースと、特定個人の音声の音素を蓄積する音声合成音素データベースと、特定個人の癖などの動作を時系列データとして蓄積する癖モーションデータベースと、対話相手の顔画像データや特徴情報を蓄積する相手情報データベースと、ロボットの行動履歴を蓄積する行動履歴データベースと、対話から得た情報やインターネット上の情報を蓄積する知識情報データベースを備え、前記音声合成音素データベースの蓄積データに基づいて特定個人の音素を合成して発話する音声合成手段と、前記癖モーションデータベースの蓄積データに基づいて特定個人の癖を演出する動作手段と、前記相手情報データベース、前記モデル情報データベース、及び前記行動履歴データベースの蓄積データに基づいて対話相手に対する感情を認識する感情認識手段と、対話相手の音声データの内容を認識する音声認識手段と、前記音声認識手段の認識結果に応じて対話相手との対話やインターネット上の情報を知識として前記知識情報データベースに蓄積する学習手段と、前記感情認識手段における認識結果、前記学習手段における蓄積知識に応じて対話相手に対する感情を演出し、該演出結果に応じて前記音声合成手段及び動作手段を制御する感情演出制御手段とを備えたことを特徴とする。

【0010】

また、人型ロボットは、特定個人のシナリオが記述されているモデル情報データベースから対話相手と対話を行い、その対話から対話相手に対するロボットの感情を認識する。その感情に対する感情を持った演出をするため、音声合成で合成された音声をスピーカから発生させる制御を行うとともに、その音声に対応する癖データに記憶された人体各部の動きを、形体癖模写部が模写するように制御し、音声と動きとが同期するようにして、人型ロボットを動作させる。

【発明の効果】

【0011】

本発明によれば、特定個人に似顔のロボットが似声でしかも音声を発するときに特定個人の癖を動作で演出するので、感情や愛情を演出することができる。

【発明を実施するため最良の形態】

【0012】

図1〜図9を用いて本発明の実施形態を説明する。

本発明は、特定個人の音声や癖を特定個人の似顔のロボットで制御することで、従来に無い特定個人に似た人型ロボットを実現する。その概略を図1、2に基づいて説明すれば、特定個人に似顔のロボット本体(1)の内部に含まれる制御部(2)に搭載されたストレージ(220)にあらかじめ特定個人の声を収録し発話するために必要となる五十音等の音素データや特定個人の癖となる動作データ等を登録し、発話時にその音声を制御部(2)内のメインCPUユニット(211)により合成して、スピーカ(26)より出力し、同時にアクチュエータ(9)〜(25)を四肢動作させるものである。

【0013】

図1は本発明の概要を示すロボット本体(1)の構成図である。

写真等を基にした特定個人の似顔であるロボット本体(1)は、主に録音音源等を基にした発声機構であるスピーカ(26)、聴音機構であるマイク(27,28)、カメラ(11),(12)、四肢動作をするアクチュエータ(9)〜(25)、ネットワーク接続機構(6)、センサのタッチセンサ(29),(30)、温度センサ(31)及びこれらの各部を統括する制御部(2)から構成される。

【0014】

図2はロボット本体(1)に含まれる制御部(2)の構成図である。

制御部(2)は、人型ロボットの人工知能を持つメインCPUユニット(210)とアクチュエータやセンサを制御するサブCPUユニット(230)とデータベース等のデータファイルを保存するストレージユニット(220)から構成され、メインCPUユニット(210)とサブCPUユニット(230)は、メインCPUユニット(210)内の通信モジュール(213)とサブCPU(230)内の通信モジュール(232)とで常に互いの情報を伝達している。

メインCPUユニット(210)は、人工知能であるアプリケーションソフトを実行するCPU(211)とメモリ(212)とカメラ(7)(8)や無線LAN(6)を制御するセンサ入出力モジュール(214)とサブCPUからの情報を得るための通信モジュール(213)から構成されている。

サブCPUユニット(230)は、各アクチュエータの制御や各センサの管理をするCPU(231)とアクチュエータ(9)〜(25)を制御するアクチュエータ制御モジュール(237)と握手などを検出するためのタッチセンサ(29)(30)や周囲の温度を測定する温度センサ(31)や人を検出するための人感センサ(32)等を制御するセンサ入出力モジュール(236)と位置情報を得るためのGPS(233)と人型ロボットが揺すられたりなどの振動を検出するための加速度センサ(234)と人型ロボット内の温度を測定するための温度センサ(235)から構成される。

【0015】

図3は、ソフトウェアの概要を示す構成図である。

本ソフトウェアは、制御部(2)上のCPUのオペレーションシステム(S101)上で動作する。

オペレーションシステム(S101)上には、人工知能の役割をするアプリケーションプログラム(S102)、カメラを制御するカメラデバイスプログラム(S117)、マイクを制御するマイクデバイスプログラム(S118)、スピーカを制御するスピーカデバイスプログラム(S119)、特定個人のデータや行動履歴等を蓄積している行動履歴データベース(S103)から構成される。

アプリケーションプログラム(S102)は、話者の顔や物体を認識するための画像認識プログラム(S111)、音声や対話相手を特定するための音声認識プログラム(S112)、対話相手の感情を認識するための感情認識プログラム(S113)、対話相手との対話やインターネット上の情報を知識としてデータベースに蓄積する学習制御プログラム(S114)、音声を合成するための音声合成プログラム(S115)、感情を演出するための感情演出プログラムから構成される。

データベース(S103)は、対話から得た情報やインターネット上情報を蓄積する知識情報データベース(S121)、特定個人の似声を音声合成するための音声合成音素データベース(S122)、特定個人の癖の動作データを蓄積するための癖モーションデータベース(S123)、特定個人を演出するためのシナリオを記述するモデル情報データベース(S124)、ロボットと対話する相手の顔情報や特徴を蓄積するための相手情報データベース(S125)、時間に対する本システムの各センサの取得データを蓄積するための行動履歴データベース(S126)から構成される。

【0016】

本発明は、特定個人を演出するため複数のセンサからの入力に基づいてロボットが対話する相手話者への感情に対して対応動作をする。

その制御方法は、相手情報データベースに登録されている話者に対する感情レベルに対して、対応動作のパターンを変化させる。

相手情報データベースには、相手話者に対して「好き」「普通」「嫌い」の感情レベルを持っている。対応動作は、例えば、好きな話者には、優しい言葉使いで話しをしたり、愛嬌を振舞ったりする。嫌いな人には無視をするような動作をさせる。

また、感情レベルは、更新される。例えば、大好きな話者であっても、話しかけられる回数が減ったりすると、「大好き」から「好き」に変化する。

対応動作における言葉使いについては、イントネーションを変化させ対応する。また、対応する動きについては、予め登録した癖モーションデータベースから選択し、実行する。

【0017】

特定個人を演出するフローを図4フローチャートにより説明すると、相手話者がロボットと会話を始めるとロボットは日常会話で会話をする。(S401)そのときにロボットは、画像による顔認識処理を行い話者を特定する。(S402)並行して、音声による話者特定を行い(S403)、(S402)と(S403)が一定の確度で一致した場合、話者の名前を呼び、確認を行い特定する(S404)。特定された相手話者の相手情報データベースと照らし合わせて、話者が好きな場合(S405)、好きな人モード(S407)の処理を行い、話者が嫌いな場合(S406)、嫌いな人モード(S408)の処理を行い、いずれでもない場合、普通の人モード(S409)の処理を行う。(S407)又は(S408)又は(S409)の処理が終わると、日常会話(S401)に戻る。

【0018】

例えば、好きな人モード(S407)の処理を図5フローチャートにより説明すると、好きな人モードに遷移するとロボットは、愛嬌のある音素による音声合成を行いながら好きな人用日常会話を行う。(S501)そのときにロボットは、音声による話者の感情を測定し(S502)、感情を特定するための話題を投げかけて、話者の感情を特定する。(S503)話者が元気の場合(S504)、元気モード(S506)の処理を行い、話者が落ち込んでいる場合(S505)、慰めモード(S507)の処理を行う。いずれでもない場合、平常モード(S508)での処理を行う。

【0019】

好きな人モード、嫌いな人モード及び普通の人モードに対する音声合成は音声合成音素データベースより、異なるイントネーション選択することで対応する。

【0020】

元気モード、慰めモード及び平常モードにおける会話内容は、予めモデルとなる特定個人のモデル情報をモデル情報データベース(S124)に会話の流れに沿ったシナリオとして予め記述し登録しておく。

【0021】

モデル情報データベース(S124)に登録されるシナリオの一例を図6に示す。図において、ロボットのモデルとなるモデル情報データベース(S124)は、名前(S601)、生年月日(S602)、趣味(S603)、特技(S604)、演出を表現するためのシナリオ(S605)、シナリオのトリガーとなる音声認識語句(S606)、演出するための声(S608)、演出するための動き(S609)をXML形式で記述する。

特定個人を対象としているため、特定個人の癖などを演出する際に柔軟性の高いXML形式としている。

【0022】

音声認識語句(S606)は、音声認識の辞書の役割をしている。

このモデル情報データベース(S124)に記述されている音声認識語句数がロボットの認識できる語句数となる。

【0023】

一方、音声合成音素データベース(S122)には、予め用意した基本文を読み上げて、あらかじめ登録しておく。

【0024】

また、癖モーションデータベース(S123)には、本人の癖となる各関節の時系列データをあらかじめ登録する。

【0025】

相手情報データベース(S125)は、図7に示すようにID(S701)、対話相手の名前(S702)、生年月日(S703)、趣味(S704)、特技(S705)、音声認識用音素(S706)、顔認識用固有値(S707)、対話相手に対する感情レベル(S708)等のフィールドから構成される。感情レベル(S708)は、行動履歴データベース(S126)から、ロボットとの会話頻度や会話シーケンスによる会話をしたときのロボットが話者に対して判定した感情値や制御部(2)内のサブCPUユニット(230)内の加速度センサ(234)から取得したデータから優しく抱いてもらっているかあるいは頭を叩かれていないか等を判定し感情値を決定して、更新される。

【0026】

行動履歴データベース(S126)は、図に示すようにID(S801)、履歴登録時の年月日(S802)、時間(S803)、場所(S804)、対話相手(S805)、そのときの遷移したシナリオであるシナリオ(S806)、対話相手が未知のときに新規に登録される対話相手の顔認識用固有値(S807)、未知の人の名前や新しい単語を覚えたときの新単語(S808)等のフィールドから構成される。新単語(S808)は、対話相手との対話やインターネット上のデータを取得した際に学習制御プログラム(S114)により、登録される。場所(S804)は、制御部(2)内のサブCPUユニット(230)内のGPS(233)から取得した位置情報と会話シーケンスにより、場所を特定し、登録される。

【0027】

知識情報データベース(S121)は、ID(S901)、情報取得日(S902)、時間(S903)、場所(S904)、対話相手(S905)、そのときの遷移したシナリオのカテゴリ(S906)、新規に覚えた人の名前や単語である新単語(S907)等のフィールドから構成される。知識情報データベースは、行動履歴データベース(S126)やインターネット上のデータを取得した際に学習制御プログラム(S114)により、登録される。

【図面の簡単な説明】

【0028】

【図1】本発明のシステムの一例を示す説明図である。

【図2】図1に示す制御部、アクチュエータ及びセンサの電気的な構成を示すブロック図である。

【図3】制御部のソフトウェアの構成を示すブロック図である。

【図4】感情表現をするソフトウェアのフローチャートである。

【図5】好きな人モードにおけるソフトウェアのフローチャートである。

【図6】モデル情報データベースである。

【図7】相手情報データベースである。

【図8】行動履歴データベースである。

【図9】知識情報データベースである。

【符号の説明】

【0029】

1 ロボット

2 制御部

210 メインCPUユニット

220 ストレージ

230 サブCPUユニット

6 無線LAN

7、8 カメラ

9〜25 アクチュエータ

26 スピーカ

27、28 マイク

29、30 タッチセンサ

31 温度センサ

32 人感センサ

【特許請求の範囲】

【請求項1】

顔面部、発声機構、聴音機構、カメラ機構、四肢動作機構、ネットワーク接続機構、情報記憶機構、及びこれらの各部を統括する制御機構を有する姿形が特定個人に似せたロボットであって、

該ロボットの肢体の各部に設けられた複数のセンサからの入力に基づいて認識された該ロボットへの刺激に応じた対応動作を、該ロボットに実行させる対応動作実行手段を備える人型ロボット。

【請求項2】

前記顔面部は、特定個人の似顔であり、また、前記発声機構は、特定個人の音声に近似させた音源を用い、前記対応動作は、特定個人の癖に近似させた動作であることを特徴とする請求項1に記載の人型ロボット。

【請求項3】

特定個人の情報を蓄積するモデル情報データベースと、

特定個人の音声の音素を蓄積する音声合成音素データベースと、

特定個人の癖などの動作を時系列データとして蓄積する癖モーションデータベースと、

対話相手の顔画像データや特徴情報を蓄積する相手情報データベースと、

ロボットの行動履歴を蓄積する行動履歴データベースと、

対話から得た情報やインターネット上の情報を蓄積する知識情報データベースを備え、

前記音声合成音素データベースの蓄積データに基づいて特定個人の音素を合成して発話する音声合成手段と、

前記癖モーションデータベースの蓄積データに基づいて特定個人の癖を演出する動作手段と、

前記相手情報データベース、前記モデル情報データベース、及び前記行動履歴データベースの蓄積データに基づいて対話相手に対する感情を認識する感情認識手段と、

対話相手の音声データの内容を認識する音声認識手段と、

前記音声認識手段の認識結果に応じて対話相手との対話やインターネット上の情報を知識として前記知識情報データベースに蓄積する学習手段と、

前記感情認識手段における認識結果、前記学習手段における蓄積知識に応じて対話相手に対する感情を演出し、該演出結果に応じて前記音声合成手段及び動作手段を制御する感情演出制御手段と、

を備えることを特徴とする請求項1又は2に記載の人型ロボット。

【請求項1】

顔面部、発声機構、聴音機構、カメラ機構、四肢動作機構、ネットワーク接続機構、情報記憶機構、及びこれらの各部を統括する制御機構を有する姿形が特定個人に似せたロボットであって、

該ロボットの肢体の各部に設けられた複数のセンサからの入力に基づいて認識された該ロボットへの刺激に応じた対応動作を、該ロボットに実行させる対応動作実行手段を備える人型ロボット。

【請求項2】

前記顔面部は、特定個人の似顔であり、また、前記発声機構は、特定個人の音声に近似させた音源を用い、前記対応動作は、特定個人の癖に近似させた動作であることを特徴とする請求項1に記載の人型ロボット。

【請求項3】

特定個人の情報を蓄積するモデル情報データベースと、

特定個人の音声の音素を蓄積する音声合成音素データベースと、

特定個人の癖などの動作を時系列データとして蓄積する癖モーションデータベースと、

対話相手の顔画像データや特徴情報を蓄積する相手情報データベースと、

ロボットの行動履歴を蓄積する行動履歴データベースと、

対話から得た情報やインターネット上の情報を蓄積する知識情報データベースを備え、

前記音声合成音素データベースの蓄積データに基づいて特定個人の音素を合成して発話する音声合成手段と、

前記癖モーションデータベースの蓄積データに基づいて特定個人の癖を演出する動作手段と、

前記相手情報データベース、前記モデル情報データベース、及び前記行動履歴データベースの蓄積データに基づいて対話相手に対する感情を認識する感情認識手段と、

対話相手の音声データの内容を認識する音声認識手段と、

前記音声認識手段の認識結果に応じて対話相手との対話やインターネット上の情報を知識として前記知識情報データベースに蓄積する学習手段と、

前記感情認識手段における認識結果、前記学習手段における蓄積知識に応じて対話相手に対する感情を演出し、該演出結果に応じて前記音声合成手段及び動作手段を制御する感情演出制御手段と、

を備えることを特徴とする請求項1又は2に記載の人型ロボット。

【図1】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【公開番号】特開2010−94799(P2010−94799A)

【公開日】平成22年4月30日(2010.4.30)

【国際特許分類】

【出願番号】特願2008−290366(P2008−290366)

【出願日】平成20年10月17日(2008.10.17)

【出願人】(508336702)株式会社リトルアイランド (1)

【Fターム(参考)】

【公開日】平成22年4月30日(2010.4.30)

【国際特許分類】

【出願日】平成20年10月17日(2008.10.17)

【出願人】(508336702)株式会社リトルアイランド (1)

【Fターム(参考)】

[ Back to top ]