入力装置

【課題】非接触で入力操作を実行する入力装置において、ユーザが意図する操作を円滑に入力できる入力装置を提供する。

【解決手段】入力装置を操作するユーザの手などの操作物体の位置を検出する位置検出部と、前記位置検出部の検出結果に基づき、位置検出部から操作物体における最も近いポイントの位置の変化を検出する位置変化検出部と、映像表示部とを備え、前記位置変化検出部は、所定の範囲における位置検出部から最も近いポイントの位置の変化を検出し、前記映像表示部は、前記位置変化検出部の検出結果に応じて表示の変更を行う。

【解決手段】入力装置を操作するユーザの手などの操作物体の位置を検出する位置検出部と、前記位置検出部の検出結果に基づき、位置検出部から操作物体における最も近いポイントの位置の変化を検出する位置変化検出部と、映像表示部とを備え、前記位置変化検出部は、所定の範囲における位置検出部から最も近いポイントの位置の変化を検出し、前記映像表示部は、前記位置変化検出部の検出結果に応じて表示の変更を行う。

【発明の詳細な説明】

【技術分野】

【0001】

本発明は入力装置に係り、特に電子機器に指示を与えるユーザインタフェースの使い勝手を向上させた入力装置に関する。

【背景技術】

【0002】

従来、TVやレコーダといった映像装置、あるいは、PCなどの情報処理機器に対して、ユーザは、リモコンによりチャンネル操作・表示操作をし、キーボードやマウス、あるいはタッチパネルなどの入力デバイスによりコマンド入力やデータ入力をすることが一般的であった。また近年では、センサ技術の向上により、特にゲーム機やポータブル機器の分野において、ユーザの動作をセンサで認識し、その結果によりユーザの意思を判断して、機器を動作させる手法が用いられている。

【0003】

特許文献1には、手指の形状、動作を認識して、操作を判定する画像認識装置が開示されている。

特許文献2では、ユーザの操作となるジェスチャの認識対象を視覚的に表すためのジェスチャ画像表示を行うインタフェース装置が開示される。ユーザは、ジェスチャ画像を確認しながら、装置の操作を行うことができる。

【0004】

特許文献3では、ユーザの操作となるジェスチャを表示したアイコンと行える操作を表示する車載機器が開示される。ユーザは、行うべきジェスチャを容易に知ることができる。

特許文献4では、ステアリング上の手の状態と操作対象機器を示す選択ガイド情報を表示する車両用操作入力装置が開示される。ユーザは、当該ガイドを参照して、手を動かして、目的の操作機器を選択することができる。

【先行技術文献】

【特許文献】

【0005】

【特許文献1】特許第4318056号公報

【特許文献2】特開2008−52590号公報

【特許文献3】特開2001−216069号公報

【特許文献4】特開2005−250785号公報

【発明の概要】

【発明が解決しようとする課題】

【0006】

特許文献1の画像認識装置では、ユーザの体の位置に応じて操作面を作成し、ユーザはその操作面に対する手あるいは指の位置、あるいは動きにより、装置に対する指示を行う。前記操作面は、仮想的な操作面であり、「操作者102は、マーカ101から仮想的な操作面701を想定して手601を突き出したり、モニタ111と連動させて画面上の一部と操作面701とをタッチパネルに見立ててタッチするように手601を動かしたりすることにより、入力操作を容易に行うことができる。(段落番号0033)」ものとしている。

【0007】

この特許文献1では、体の位置に応じて操作面を定めているため、以下のような問題点がある。

(1)仮想的な操作面に対して操作を行うため、ユーザが、操作面の大きさや、操作面と操作の対応関係、あるいは操作面と画面上の表示の対応関係を把握することが難しい。

(2)手を出す前に操作面位置を決めるため、キャリブレーションのタイミングが難しい。特に複数人いる場合に、画面の前にいる誰に対して操作領域を設けるかが決まらない。

また、特許文献2ないし特許文献4では、いずれの特許文献も、操作のための動きやポーズが表示され、ユーザはこれらに従って、所定の装置に関する動作を実行することが開示されている。

【0008】

しかしながら、ユーザが、操作のために、所定の動きをしたり、所定のポーズをとろうとする際、所定の動き、所定のポーズに至るまでに、無意識に行う別の動きや、別のポーズが、操作のための動きと認識されてしまい、ユーザが意図しない装置の動作が実行されてしまう恐れがある。

つまり、いずれの特許文献も、ユーザが操作のためのジェスチャを行う際に、ユーザの動きが、物理的な物や画面表示とどのように対応し、操作としてどのように認識されるかをユーザに直感的に理解させることは考慮されていない。

【0009】

また、いずれの特許文献の入力装置も、入力を検出するために手などの所定の形状を認識することが開示されている。しかし、手などの形状を認識する際に、参照する所定の形状のモデルとの比較や、所定の形状の学習などの処理が必要であり、入力装置が行う処理の負荷が高くかつ認識処理の時間がかかる恐れがある。

そこで本発明は、かかる事情を考慮した上で、上記課題を解決するためになされたもので、その目的は、非接触で入力操作を行う入力装置において、操作を行う物体のセンサに最も位置が近い点(以下、物体検出点と記す)を検出して、該物体検出点の位置の変化に応じて、入力操作の操作状態をリアルタイムに画面上に表示することにより、ユーザが意図する操作を円滑に入力できる入力装置を提供することにある。

【課題を解決するための手段】

【0010】

上記目的を達成するために、本発明の入力装置において、入力装置を操作するユーザの手などの操作を行う物体における各点の位置を検出する位置検出手段と、前記位置検出手段の検出結果に基づき、前記位置検出手段から物体検出点の位置の変化を検出する位置変化検出手段と、映像表示手段とを備え、前記位置変化検出手段は、所定の範囲における位置検出手段から最も近いポイントの位置の変化を検出し、前記映像表示手段は、前記位置変化検出手段の検出結果に応じて表示の変更を行う。

ここで、前記映像表示手段は、前記位置変化検出手段の検出結果に応じて、表示内で示す物体の大きさ、長さ、深さ、縮尺等の量に関する表示や形、表示する物体の位置を変化させる。

【発明の効果】

【0011】

本発明によれば、非接触で入力操作を行う入力装置において、ユーザは操作を直感的に把握して意図する操作を円滑に入力することができ、入力装置の使い勝手を向上できるという効果がある。

【図面の簡単な説明】

【0012】

【図1】実施例1の入力装置を示す概観図である。

【図2】実施例1の入力装置の構成を示すブロック図である。

【図3】実施例1の入力装置の操作領域とユーザの操作方法を示す概観図である。

【図4】実施例1の入力装置の操作状態に応じた表示を説明する概観図である。

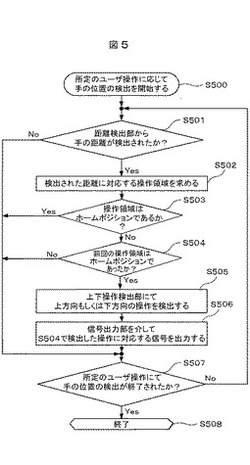

【図5】実施例1の入力装置の動作を説明するフローチャートである。

【図6】実施例2の入力装置の操作領域とユーザの操作方法を示す概観図である。

【図7】実施例2の入力装置の操作状態に応じた表示を説明する概観図である。

【図8】実施例2の入力装置の動作を説明するフローチャートである。

【図9】実施例2の入力装置の操作状態に応じた表示を説明する概観図である。

【図10】実施例3の入力装置を示す概観図である。

【図11】実施例3の入力装置の構成を示すブロック図である。

【図12】実施例3の入力装置の操作領域とユーザの操作方法を示す概観図である。

【図13】実施例3の入力装置の動作を説明するフローチャートである。

【図14】実施例4の入力装置の操作領域とユーザの操作方法を示す概観図である。

【図15】実施例4の入力装置の動作を説明するフローチャートである。

【図16】実施例5の入力装置を示す概観図である。

【図17】実施例5の入力装置の構成を示すブロック図である。

【図18】実施例5の入力装置の動作を説明するフローチャートである。

【図19】実施例5の入力装置の入力操作空間を示す概観図である。

【図20】実施例5の入力装置の距離テーブルである。

【図21A】実施例6の入力装置の操作ポインタを検出する方法を説明する第1の概観図である。

【図21B】実施例6の入力装置の操作ポインタを検出する方法を説明する第2の概観図である。

【図22A】実施例7の入力装置の操作ポインタを検出する方法を説明する第1の概観図である。

【図22B】実施例7の入力装置の操作ポインタを検出する方法を説明する第2の概観図である。

【図22C】実施例7の入力装置の操作ポインタを検出する方法を説明する第3の概観図である。

【発明を実施するための形態】

【0013】

以下、本発明に係る各実施例について説明する。

【実施例1】

【0014】

以下、本発明に係る第一の実施例を、図1ないし図5を用いて説明する。本実施例の入力装置100は、ユーザの手と入力装置100の間の距離をセンサにより検出し、該距離に応じて映像表示装置101に対する操作の指示を与える装置である。

先ず、図1および図2を用いて第一の実施例における入力装置の構成を説明する。

【0015】

図1は、実施例1の入力装置100を示す概観図であり、映像表示装置101、センシング部102、ユーザ103により、入力装置100をユーザ103が使用する際の動作環境の概観を示す。

映像表示装置101は、映像表示装置101の外部から与えられる操作入力信号に基づき、ユーザに映像情報を提示する装置であり、例えば、LCD(Liquid Crystal Display)、PDP(Plasma Display Panel)、液晶プロジェクタ、レーザープロジェクタ、リアプロジェクタなどのディスプレイ装置と、映像コンテンツやGUI(Graphical User Interface)などの表示処理に必要な演算処理装置やメモリを有する装置である。

【0016】

センシング部102は、ユーザ103の手とセンサの間の距離を検出する構成要素であり、例えば、赤外線距離センサ、レーザ距離センサ、超音波距離センサ、距離画像センサ、電界センサをはじめとするセンサと、データ処理を行うマイクロコンピュータ(以下、マイコンと略記する)、及びマイコン上で動作するソフトウェアから構成される。センシング部102に用いるセンサは、特に限定されず、ユーザの手までの距離を検出するために得られる信号を、距離データに変換する機能を有すればよい。

ユーザ103は、入力装置100に対して操作を行うユーザである。

図2は、実施例1の入力装置100の構成を示すブロック図である。

入力装置100は、図2に示すように、センシング部102、システム制御部200、信号出力部201、を備える。

システム制御部200は、距離検出部202、上下操作検出部203、を有する。

【0017】

距離検出部202は、センシング部102から得られる距離データから、検出される距離を抽出あるいは分類する操作を行う構成要素である。上下操作検出部203は、距離検出部202が操作して検出した距離から、ユーザ103が手を上下に動かす操作を検出する構成要素である。

システム制御部200は、ユーザ103の手のセンシング部102からの距離を検出し、手を上下に動かす操作を検出するためのデータ処理をおこなう構成要素である。システム制御部200は、CPU(Central Processing Unit)が、メモリ上に記憶されているソフトウェアモジュールを実行することにより実現してもよいし、専用のハードウェア回路により実現してもよい。

【0018】

信号出力部201は、システム制御部200から指示とデータを受け取り、映像表示装置101で表示を行う映像信号を出力する構成要素である。

次に、図3および図4を用いて第一の実施例に係る入力装置100による操作方法について説明する。

【0019】

図3は、実施例1の入力装置100の操作領域とユーザの操作方法を示す概観図である。図3に示されるように、入力装置100は、センシング部102から得られるユーザの手のセンシング部102からの距離に基づき、上方向操作領域、ホームポジション、下方向操作領域、の3つの操作領域のどこに手が位置しているかを検出する。前記操作領域は、ユーザ103の操作の検出方法を説明するための概念的な領域であり、ユーザ103が手をかざした位置に応じて、手の付近の空間に存在するものとする。

図4は、実施例1の入力装置の操作状態に応じた表示を説明する概観図である。図4では、映像表示装置101に画像を一覧するための表示がされており、ユーザ103の操作に応じて、一覧する画像のサイズや表示数が変更される様子を示している。

【0020】

第一の実施例に係る入力装置100の操作イメージは、図4に示されるように、ユーザ103が映像表示装置101を見ながら手を使って操作し、該手までのセンシング部102からの距離を入力装置100が検出し、その検出結果に基づいて映像表示装置101の表示が変更されるものである。例えば、図4の“開始状態”に示されるように、ユーザ103の手が図3の“ホームポジション”の位置にあるとする。次に、図4の“操作状態A”に示されるように、ユーザ103が手を図3の“ホームポジション”の位置から、図3の“上方向操作領域”に移動させると、映像表示装置101に表示される画像の一覧は、個々の画像のサイズが小さくなり、同時に表示される画像の数が多くなる。

一方、図4の“操作状態B”に示されるように、ユーザ103の手を図3の“ホームポジション”の位置から、図3の“下方向操作領域”に移動させると、映像表示装置101に表示される画像の一覧は、個々の画像のサイズが大きくなり、同時に表示される画像の数が少なくなる。すなわち、ユーザ103の手が検出される位置が、図3の“ホームポジション”から、図3の“上方向操作領域”や図3の“下方向操作領域”に移動すると、入力装置100は映像出力装置101に対して、ユーザ103の手の移動方向に応じた指示を与え、映像出力装置101の表示が変更される。

【0021】

図5は、実施例1の入力装置100の動作を説明するフローチャートである。図5に基づき入力装置100による入力操作の検出処理の手順について説明する。

入力操作の検出処理は、図2に示したシステム制御部200が行う処理である。

先ず、システム制御部200は、所定のユーザ操作に応じて、手の位置の検出を開始し(ステップS500)、距離検出部202にてセンシング部102から得られる距離データから、検出される距離を抽出あるいは分類する処理を行い、手のセンシング部102からの距離を検出する。手の距離が検出された際には(ステップS501:Yes)、検出された距離に対応する操作領域を求める(ステップS502)。

【0022】

手が位置する操作領域がホームポジションである場合は(ステップS503:Yes)、後記するステップS507に到る。一方、手が位置する操作領域がホームポジションではない場合は(ステップS503:No)、まず前回の検出で手が位置した操作領域がホームポジションであったことを確認し(ステップS504:Yes)、上下操作検出部203にて、上方向、もしくは下方向の操作を検出する(ステップS505)。このとき、ステップS504において、前回検出した操作領域がホームポジションではなかった場合は(ステップS504:No)、後記するステップS507に到る。すなわち、手が位置する操作領域がホームポジションから、他の操作領域に移動した場合にのみ、ステップS505で操作が検出され、上方向もしくは下方向の操作を検出した際には、信号出力部201を介して、検出した操作に対応する、映像表示装置101に操作を指示するため操作入力信号が出力される(ステップS506)。

【0023】

ユーザ103が所定の操作にて、操作終了の意思表示をしたときには(ステップS507:Yes)、処理を終了し(ステップS508)、そうでないときには(ステップS507:No)、ステップS501に戻り、前記した手の距離の検出を継続する。

このように、入力装置100は、ユーザ103が入力装置100に対して手をかざしている距離の変化に応じて操作を検出し、映像表示装置101に操作の指示を与える。これにより、ユーザ103は、物理的な装置と手の距離の関係から、手の距離と操作の対応を直感的に把握でき、ユーザ103が意図する操作を円滑に入力できる。

【実施例2】

【0024】

以下、本発明に係る第二の実施例を、図6ないし図9を用いて説明する。

第一の実施形態の入力装置100の表示制御方法は、手が位置する操作領域の変化に応じて操作を実行するインタフェースを提供するものであった。本実施例では、第一の実施例の操作方法に加えて、さらに、手と入力装置100の相対的な距離の変化応じて操作を実行するインタフェースを提供するものである。

本実施形態の入力装置100でも、図2に示したように、センシング部102、システム制御部200、信号出力部201からなることは、第一の実施例と同様であるが、システム制御部200が上下操作検出部で検出する操作のみが異なる。

【0025】

先ず、図6及び図7を用いて第二の実施例の入力装置100の操作方法について説明する。

図6は、実施例2の入力装置100の操作領域とユーザの操作方法を示す概観図である。

【0026】

図6に示されるように、入力装置100は、センシング部102から得られるユーザの手の距離に基づき、操作に反映される大きさや量、長さ等を図るための操作基準600に対して、どこに手が位置しているかを検出する。前記操作基準600は、ユーザ103の操作の検出方法を説明するための概念的な基準であり、ユーザ103が手をかざした位置に応じて、手の付近の空間に存在するものとする。

図7は、実施例2の入力装置100の操作状態に応じた表示を説明する概観図であり、ユーザ操作と操作結果の対応を示す。図7では、映像表示装置101に地図が表示されており、ユーザ103の操作に応じて、地図の縮尺が変更される様子を示している。

【0027】

第二の実施例に係る入力装置100の操作イメージは、図7に示されるように、ユーザ103が映像表示装置101を見ながら手を使って操作し、該手までのセンシング部102からの距離を入力装置100が検出し、その検出結果に基づいて映像表示装置101の表示が変更されるものである。例えば、図7の“操作状態1”に示されるように、ユーザ103の手が操作基準600の上位付近の位置にあるとする。次に、図7の“操作状態2”に示されるように、ユーザ103が手を操作基準600の中位付近に移動させると、映像表示装置101に表示される地図の縮尺は拡大される。さらに、図7の“操作状態3”に示されるように、ユーザ103が手を操作基準600の下位付近に移動させると、映像表示装置101に表示される地図の縮尺はより拡大される。

【0028】

次に、図8を用いて第二の実施例に係る入力装置100による入力操作の検出処理の手順について説明する。

図8は、実施例2の入力装置100の動作を説明するフローチャートである。

入力操作の検出処理は、図2に示したシステム制御部200が行う処理である。

【0029】

先ず、システム制御部200は、所定のユーザ操作に応じて、手の位置の検出を開始し(ステップS800)、距離検出部202にてセンシング部102から得られる距離データから、検出される距離を抽出あるいは分類する処理を行い、手のセンシング部102からの距離を検出する。手の距離が検出された際には(ステップS801:Yes)、操作基準600に対する手の位置を求める(ステップS802)。

次に、信号出力部201において、操作基準600に対する、検出した手の相対的な位置より、地図の縮尺率を算出し、映像表示装置101に地図の縮尺率を変更する操作を指示するため操作入力信号が出力される(ステップS803)。

ユーザ103が所定の操作にて、操作終了の意思表示をしたときには(ステップS804:Yes)、処理を終了し(ステップS805)、そうでないときには(ステップS804:No)、ステップS801に戻り、前記した手の距離の検出を継続する。

【0030】

このように、第二の実施例に係る入力装置100は、ユーザ103が入力装置100に対して手をかざしている距離の変化に応じて、操作基準600に対する手の位置を検出し、操作基準600に対する手の位置で示される大きさや量、長さ等を、映像表示装置101に対する操作として指示する。これにより、ユーザ103は、物理的な装置と手の距離の関係から、手の距離と、大きさ、長さ、深さ、縮尺等の量の対応を直感的に把握でき、ユーザ103が意図する操作を円滑に入力できる。

【0031】

また、上記入力操作は、複数の階層からなるメニューを操作させるのに有効である。

図9は、実施例2の入力装置の操作状態に応じた表示を説明する概観図である。図9に示すように、映像表示装置101に複数の階層からなるメニューが表示される場合、操作基準600に対し、階層を割り当てることにより、図中の斜め線で示すように、操作対象となる階層を手の位置により変更することができる。これにより、ユーザ103は、物理的な装置と手の距離の関係から、手の距離と、操作対象となる階層の対応を直感的に把握でき、ユーザ103が意図する操作を円滑に入力できる。

【実施例3】

【0032】

以下、本発明に係る第三の実施例を、図10ないし図13を用いて説明する。

第一の実施例の入力装置100の表示制御方法は、手と入力装置100の距離に応じて操作を実行するインタフェースを提供するものであった。本実施例では、第一の実施例の操作方法に加えて、さらに、手と入力装置100の距離を検出する際に、手の形状に応じて検出距離の検出基準を決定するものである。

【0033】

図10は、実施例3の入力装置100を示す概観図である。

図11は、実施例3の入力装置100の構成を示すブロック図である。

本実施形態の入力装置100でも、図10および図11に示すように、システム制御部200、信号出力部201を有することは、第一の実施例と同様であるが、センシング部102が撮像部1000に置き換わることと、システム制御部200が形状検出部1100を有することが異なる。このため図10で示すように、撮像部1000が指の形状を明確に捕らえられるよう、図1のセンシング部102とは異なる位置に設けられても良い。また、図1のセンシング部102と図10の撮像部1000の双方を備えるようにしても良い。

【0034】

撮像部1000は、ユーザの手を撮像するための装置であり、例えば、TOF(Time of flight)センサ機能を有する赤外線カメラ、ステレオカメラ、或いはRGBカメラを用いると良い。撮像部1000に用いるカメラは、特に、限定されず、ユーザに対して画像認識をするために、得た画像をデジタルデータに変換するための撮像画像を得る機能を有すればよい。

形状検出部1100は、撮像部1000から得られる撮像画像から、所定の手の形を検出する部分であり、例えば、パターンマッチング等の画像解析手法が用いられる。形状検出部1100に用いられる画像解析手法は、特に限定されず、得た撮像画像の中に所定の手の形が存在するか否かと、手の距離および位置を検出する機能を有すればよい。

【0035】

先ず、図12を用いて第三の実施例の入力装置100の操作の検出方法について説明する。

図12は、実施例3の入力装置100の操作領域とユーザの操作方法を示す概観図である。

図12に示されるように、入力装置100は、撮像部1000から得られる撮像画像の中から、手の形1200を検出し、手の形1200を検出した際の入力装置100とユーザ103の手の距離を、検出基準1201とする。さらに、入力装置100は、前記検出基準1201に応じて、第一の実施例で示した操作領域の位置を変更する。操作領域が変更された後の操作については、第一の実施例と同様となる。

【0036】

次に、図13を用いて第三の実施例に係る入力装置100による入力操作の検出処理の手順について説明する。

図13は、実施例3の入力装置100の動作を説明するフローチャートであり、第一の実施例で説明した図5のフローチャートに対して、ステップS501で手の位置を検出した後、ステップS502で操作領域を求めるまでの間に、ステップS1300及びステップS1301を加えている。

【0037】

入力操作の検出処理は、図11に示したシステム制御部200が行う処理である。

先ず、システム制御部200は、所定のユーザ操作に応じて、手の位置の検出を開始し(ステップS500)、距離検出部202にて撮像部1000から得られる撮像画像から手を検出し、操作として検出される距離を抽出あるいは分類する処理を経て、手の距離を検出する。手の距離が検出された際には(ステップS501:Yes)、形状検出部1100にて、所定の手の形状1200を検出する処理を行う(ステップS1300)。所定の手の形状は、例えば図12の“ホームポジション”で示すように、親指と人差し指を接触させた時の形状などと予め定めておけば良い。所定の手の形状1200が検出された際には(ステップ1300:Yes)、手の距離を検出する際の検出基準1201を設定し(ステップS1301)、ステップS502以降の処理を行う。

【0038】

一方、所定の手の形状1200が検出されない場合は(ステップS1300:No)、検出基準1201は設定されず、ステップS502以降の処理が行われる。ステップS502以降の処理については、第一の実施例で説明した図5のフローチャートと同様となる。即ち、図13では図6と異なり、ユーザ103の手の形状を検出してホームポジションを設定できることに特徴がある。

このように、第三の実施例に係る入力装置100は、ユーザ103が入力装置100に対してかざしている手の形状に応じて、検出基準1201を設定する。これにより、ユーザ103は、手と操作領域の相対的な位置を、意図したタイミングで変更することができ、ユーザ103が任意の位置でより確実に操作を入力できる。

【実施例4】

【0039】

以下、本発明に係る第四の実施例を、図14ないし図15を用いて説明する。

第三の実施例の入力装置100の表示制御方法は、手の形状に応じて検出基準1201を設定することにより、第一の実施例で説明した操作における、手と操作領域の相対的な位置を、意図したタイミングで変更することができるものであった。本実施例では、第三の実施例の操作方法に加えて、さらに、第二の実施例で説明した操作における、手と操作基準600の相対的な位置を、意図したタイミングで変更できるものである。

【0040】

本実施形態の入力装置100でも、図10および図11に示すように、撮像部1000、システム制御部200、信号出力部201を有することは、第三の実施例と同様であるが、システム制御部200で行われる検出処理の手順が異なる。

先ず、図14を用いて第四の実施例の入力装置100の操作の検出方法について説明する。

図14は、実施例4の入力装置100の操作領域とユーザの操作方法を示す概観図である。

【0041】

図14に示されるように、入力装置100は、撮像部1000から得られる撮像画像の中から、手の形1200を検出し、手の形1200を検出した際の入力装置100とユーザ103の手の距離を、検出基準1201とする。さらに、入力装置100は、前記検出基準1201に応じて、第二の実施例で示した操作基準600の位置を変更する。また、操作基準600が変更された後の操作は、手の形1200が検出され続けている場合にのみ有効となり、操作が有効な場合の操作方法については第二の実施例と同様となる。

【0042】

次に、図15を用いて第四の実施例に係る入力装置100による入力操作の検出処理の手順について説明する。

図15は、実施例4の入力装置100の動作を説明するフローチャートであり、第二の実施例で説明した図8のフローチャートに、ステップS1500ないしステップS1502を加えたフローチャートである。

入力操作の検出処理は、図11に示したシステム制御部200が行う。

【0043】

先ず、システム制御部200は、所定のユーザ操作に応じて、手の位置の検出を開始し(ステップS800)、距離検出部202にて撮像部1000から得られる撮像画像から手を検出し、操作として検出される距離を抽出あるいは分類する処理を経て、手の距離を検出する。手の距離が検出された際には(ステップS801)、形状検出部1100にて、所定の手の形状1200を検出する処理を行う(ステップ1500)。この際に、所定の手の形状が検出されない場合は(ステップ1500:No)、以降の処理には進まず、ステップS804に到る。すなわち、所定の手の形状1200が検出されている場合にのみ、操作が有効になる。

一方、所定の手の形状1200が検出された際には(ステップ1500:Yes)、前回の手の検出時に所定の手の形状であったかを確認し(ステップS1501)、前回の手の検出時に所定の手の形状ではなかった場合は(ステップS1501:No)、手の距離を検出する際の検出基準1201を設定し(ステップS1502)、ステップS802以降の処理を行う。また、前回の手の検出時に所定の手の形状であった場合は(ステップ1501:Yes)、検出基準1201は新たには設定されず、ステップS802以降の処理が行われる。ステップ802以降の処理については、第二の実施例で説明した図8のフローチャートと同様となる。

【0044】

このように、第四の実施例に係る入力装置100は、ユーザ103が入力装置100に対してかざしている手の形状に応じて、検出基準1201を設定する。また、ユーザ103が所定の手の形状で手をかざしている場合にのみ、操作が有効になる。これより、ユーザ103は、手と操作基準の相対的な位置を、意図したタイミングで変更することができ、尚且つ、手の形により意図したタイミングでのみ操作を行うことができるため、ユーザ103が任意の位置でより確実に操作を入力できる。

以上、第一の実施例ないし第四の実施例で説明してきたように、本発明の入力装置の入力方法によれば、特許文献1ないし特許文献4の従来技術とは異なり、ユーザが手を出したときに表示され、さらに手と入力装置の間の距離に応じて変化する、画面上の表示を介して、入力装置に対して可能な入力操作と、操作状態を直感的に把握でき、操作性を向上させることができる。

【実施例5】

【0045】

以下、本発明に係る第五の実施例を、図16ないし図20を用いて説明する。

第一ないし第四の実施例の入力装置100は、ユーザの手を認識して、手と入力装置100の間の距離をセンサにより検出し、該距離に応じて映像表示装置101の表示を変更する装置であった。本実施例の入力装置1600は、センシング部1602の距離検出結果を用いて物体検出点を検出し、該物体検出点の位置の変化(以下、動きと記す)に応じて映像表示装置1601の表示を変更する装置である。

【0046】

まず、図16および図17を用いて第五実施例の入力装置1600の構成を説明する。

図16は、実施例5の入力装置1600を示す概観図であり、映像表示装置1601、センシング部1602、ユーザ1603により、入力装置1600をユーザ1603が使用する際の動作環境の概観を示す。

映像表示装置1601は、上記第一の実施例の映像表示装置101と同様な構成要素である。

【0047】

センシング部1602は、センシング部1602の前方の空間に存在する物体の距離を測定する部分であり、例えば、赤外線距離センサ、レーザ距離センサ、超音波距離センサ、距離画像センサ、電界センサをはじめとするセンサと、データ処理を行うマイコン、及びマイコン上で動作するソフトウェアから構成される。センシング部1602に用いるセンサは、特に限定されず、物体の距離を検出するために得られる信号を、距離データに変換する機能を有すればよい。

ユーザ1603は、入力装置1600に対して操作を行うユーザである。

【0048】

方向軸1604は、センシング部1602の前方の空間に対応して互いに直交するX軸、Y軸、およびZ軸からなる方向を示す軸である。ここでX軸はセンシング部1602の横方向の軸を表し、X軸位置の値は、センシング部1602のX軸を0(零)とし、左右方向の距離を示す。Y軸はセンシング部1602の縦方向の軸を表し、Y軸位置の値は、センシング部1602の位置を0(零)とし、上下方向の距離を示す。Z軸はセンシング部1602の奥行方向の軸を表し、Z軸位置の値は、センシング部1602の位置を0(零)とし、センシング部1602の前方方向の距離を示す。

センシング部1602が距離測定した結果を、例えば以下に説明するX軸およびY軸の各位置の組合せ(以下、XY座標値と記す)に対してZ軸の位置の値を示すテーブル2000で表す。これによって、センシング部1602に対して、前方する空間にある物体の各点の位置はX軸、Y軸およびZ軸位置の値の組合せ(XYZ座標値)で表すことができる。

【0049】

図17は、実施例5の入力装置1600の構成を示すブロック図である。

入力装置1600は、図17に示すように、センシング部1602、システム制御部1700、信号出力部1701、を備える。

システム制御部1700は、操作ポインタ抽出部1702および入力操作検出部1703の機能を実現する部分を有する。システム制御部1700は、物体検出点を検出して、該物体検出点を操作ポインタとして扱い、入力装置1600に対する操作を検出するためのデータ処理をおこなう部分である。システム制御部1701は、上記第一の実施例のシステム制御部200と同様、CPUが、メモリ上に記憶されているソフトウェアモジュールを実行することにより実現してもよいし、専用のハードウェア回路により実現してもよい。

【0050】

信号出力部1701は、上記第一の実施例の信号出力部201と同様、システム制御部1700から指示とデータを受け取り、映像表示装置1601で表示を行う映像信号を出力する部分である。

操作ポインタ抽出部1702は、上記センシング部1602の出力結果により、物体検出点を操作ポインタとしてみなす部分である。

入力操作部検出部1703は、上記操作ポインタの動きから、入力装置1600に対する入力操作の検出を行う部分である。ここで、入力操作とは、第一の実施例ないし第四の実施例に記載した、入力装置1600に対する手の動きと相当し、例えば手が入力装置1600に近づける、あるいは遠ざかるという動きのことを指す。

【0051】

図18は、実施例5の入力装置1600の動作を説明するフローチャートであり、ユーザ入力操作の検出処理の手順を説明するものである。

図19は、実施例5の入力装置1600の入力操作空間を示す概観図であり、入力操作空間1900とユーザ1603が操作する際の様子を説明するものである。

【0052】

入力操作空間1900は、センシング部1602の前方にあるユーザから入力操作の動作を検出する3次元空間である。入力操作空間1900の大きさは、例えばX軸に関してはX1からX2、Y軸に関してはY1からY2、Z軸に関してはZ1からZ2の各方向においた所定の区間で定義される。ユーザの手の先にある物体検出点1901は、ユーザの手のセンシング部1602に最も位置が近い点である。

図20は、実施例5の入力装置1600の距離テーブルであり、入力操作空間におけるセンシング部1602の出力結果を表わす。テーブル2000は、XY座標値に対する各点のZ軸の位置を表す。

【0053】

次に、図18ないし図20を用いて第五の実施例に係る入力装置1600による操作方法について説明する。

例えば、入力装置1600の電源がオンとなったときに、入力装置1600は入力操作の検出を開始する(ステップS1800)。

入力操作の検出が開始されると、入力装置1600は図19に示す入力操作空間1900を生成する(ステップS1801)。

以下に説明するステップS1802ないしステップS1806で行われる一連の処理は、終了命令がなされていない限り、繰り返しされるループである。

【0054】

まず、ユーザが行う入力操作の検出の終了命令があるか否かをチェックする(ステップS1802)。終了命令がなければ、次のステップに進む(ステップS1802:No)。終了命令があれば、入力操作の検出処理を終了する(ステップS1802:Yes)。検出終了の命令を与える方法として、例えばユーザが所定のスイッチなどで電源をオフにすることや、タイムアウト処理などで行ってもよい(ステップS1807)。

次に、センシング部1602を用いて、上記入力操作空間1900内の物体の距離測定を行う(ステップS1803)。センシング部1602が距離測定した結果を図20に示す距離テーブル2000として出力する。

【0055】

次に、上記テーブル2000を参照して、入力操作空間1900内に物体が存在するか否かをチェックする(ステップS1804)。具体的には、テーブル2000を参照して、Z軸の位置がZ1以上かつZ2以下の点が存在するか否かをチェックする。該当する点が存在しなければ、処理ステップをステップS1802に戻す(ステップS1804:No)。該当する点が存在すれば、次のステップに進む(ステップ1804:Yes)。

次に、入力装置1600の操作ポインタ抽出部1702は、上記物体検出点を操作ポインタとして設定する(ステップS1805)。

【0056】

次に、ステップS1805で設定操作ポインタの位置の変化を用いて、入力装置1600に対する入力操作を検出する(ステップS1806)。ここで、図19においてユーザが手を動かすと操作ポインタとして扱う物体検出点1901の位置が手の動きに応じて変化するため、入力操作検出部1703は該物体検出点の動きをみて、入力操作を検出する。

ここで、上記ステップS1806で検出したユーザの操作に応じて、上記第一の実施例ないし第四の実施例と同様に、映像表示装置1601への表示を変化させる。

このように、本実施例の入力装置1600は、物体検出点の位置の変化に応じて、操作の入力を行う。これにより、高い処理負荷かつ処理時間がかかる手の形状を認識する処理等を行わなくても、低処理負荷の非接触の入力装置を実現することができる。

【実施例6】

【0057】

以下、本発明に係る第六の実施例を、図21Aと図21Bを用いて説明する。

上記第五の実施例の入力装置1600は、物体検出点を操作ポインタの位置として扱い、該操作ポインタの動きに応じて映像表示装置1601の表示を変更する入力装置であった。本実施例の入力装置1600は、第五の実施例の入力装置1600と同様な構成を持つが、操作ポインタの抽出する方法が異なる入力装置1600に関するものである。

【0058】

図21Aと図21Bは、実施例6の入力装置の操作ポインタを検出する方法を説明する概観図であり、本実施例に係る操作ポインタを抽出するために、物体検出点のY軸の位置における、X軸の位置に対するZ軸の位置を示す。

【0059】

図21Aの線2100は、図18のフローチャートに示すステップS1802で生成したテーブル2000を参照し、物体検出点1901のY軸の位置における、X軸の各位置に対して、Z軸の距離を表す線である。

図21Bの線2103は、物体検出点2104が例えばユーザ1603の頭や胴体など大きいな物体のセンシング部1602に最も位置が近い点として検出した場合の、該物体検出点2104のY軸の位置における、X軸の位置に対するZ軸の位置を表す線である。

【0060】

次に、本実施例における操作ポインタの抽出方法(図18のステップS1805)について説明する。

まず、操作ポインタ抽出部1702は、図21Aにおける物体検出点1901を操作ポインタの候補とする。次に、線2100上に存在する、物体検出点1901の周辺点が輪郭となる2次元の形状2101を生成する。ここで、本実施例の入力装置1600は上記形状2101のX軸の幅2102がある所定の条件幅A以内であり、かつZ軸の幅2012がある所定の条件幅B以上であるという条件を満たしていれば、物体検出点1901を入力装置1600の操作ポインタとしてみなし、該条件を満たさなければ物体検出点1901を操作ポインタとしてみなさない。

【0061】

条件幅Aおよび条件幅Bの大きさの決め方によって、操作ポインタとみなす物体の形や大きさが異なる。例えば図21Aと図21Bに示すように、ユーザの手を、操作を行う物体としたい場合に、条件幅Aおよび条件幅Bの大きさを人間の手の大きさに合わせる。

これにより、図21Aに関しては、形状2101が上記の条件を満たすものであるとして、点1901は操作ポインタとしてみなす。また、図21Bに関しては、点2104の周辺で生成された形状2105のX軸幅2106が、条件幅Aよりも長く、上記の条件を満たさないため、点2104を操作ポインタとしてみなさない。

なお、X軸の条件幅およびZ軸の条件幅で操作ポインタの判定を行うが、Y軸の条件幅を用いてもよい。

【0062】

このように、本実施例の入力装置1600は、入力操作空間1900において、センシング部1602から最も近い点を操作ポインタの候補とし、該操作ポインタの周辺の点で生成する形状の大きさ、形に応じて、実際に操作ポインタとみなすか否かを判定する。これにより、センシング部1602から最も近い点が例えばユーザの頭、胴体など、手の大きさより大きな物体の存在する点にあると検出されれば、該点を操作ポインタとしてみなさない。つまり第五の入力装置1600と比較して、本実施例の入力装置1600は、ユーザが意図しない物体を誤って操作ポインタと扱わず、より正確に入力の検出を行うことができる。

【実施例7】

【0063】

以下、本発明に係る第七の実施例を、図22Aないし図22Cをを用いて説明する。

第五の実施例および第六の実施例の入力装置1600は、一つの入力操作空間における物体検出点を操作ポインタとして扱い、該操作ポインタの動きに応じて映像表示装置1601の表示を変更する入力装置であった。本実施例の入力装置1600は、複数の入力操作空間を生成し、各該入力操作空間に応じて操作ポインタの決め方を変えて、ユーザの入力操作を検出する入力装置1600に関するものである。

【0064】

図22Aないし図22Cをは、本実施例に係る複数の入力操作空間におけるユーザの入力操作を検出する際の入力装置1600とユーザの様子と、それぞれの様子において、操作ポインタを抽出するために、Y軸の位置がセンシング部1602から最も距離が近い点のY軸の位置における、X軸の各位置に対するZ軸の距離を説明する概観図である。

上記ステップS1801で、本実施例の入力装置1600は、3つの入力操作空間を作成する。第一の入力操作空間2210は、X1からX2のX軸区間、Y1からY2のY軸区間、Z1からZ2のZ軸区間で設定されるセンシング部1602から最も近い入力操作空間である。第二の入力操作空間2211は、X1からX2のX軸区間、Y1からY2のY軸区間、Z2からZ3のZ軸区間で設定される入力操作空間である。第三の入力操作空間2212は、X1からX2のX軸区間、Y1からY2のY軸区間、Z3からZ4のZ軸区間で設定される入力操作空間である。つまり、Z軸方向において、センシング部1602から最も近い順から、第一の入力操作空間2210、第二の入力操作空間2011と最後に第三の入力操作空間2012が作成される。

【0065】

本実施例の入力装置1600は、第五の実施例と同様に、操作ポインタを抽出する際にまず物体検出点の周辺の点で生成する形状の大きさおよび形をみて、操作ポインタとみなすか否かを判定するが、物体検出点がどの入力操作空間に存在するかに応じて、上記条件幅Aおよび条件幅Bを異なる値にする。

例えば、第一の操作空間2010において、操作ポインタとみなすための条件幅は、条件幅A1および条件幅B1とする。これによって、図22Aに示すように、ユーザの手が第一の入力操作空間2110に出した際に、手の先の点に生成される形状2201のX軸幅2202が条件幅A1の長さ以内、かつ形状2201のZ軸幅2203が条件幅B1の長さ以上であるため、ユーザの手の先は操作ポインタとしてみなす。このとき、入力装置1600は、手の動きを操作として検出する。

【0066】

第二の操作空間2011において、操作ポインタとみなすための条件幅は、条件幅A2および条件幅B2とする。これによって、図22Bに示すように、ユーザが第二の入力操作空間2111立っている場合に、物体検出点の周辺から生成される形状2204のX軸幅2205が条件幅A2の長さ以内、かつ形状2204のZ軸幅2206が条件幅B2の長さ以上であるため、該物体検出点を操作ポインタとしてみなす。この場合、入力装置1600は、ユーザがZ2およびZ3の間にことを認識することができる。

第三の操作空間2012において、操作ポインタとみなすための条件幅は、条件幅A3および条件幅B3とする。これによって、図22Cに示すように、例えば複数のユーザ集まって第三の入力操作空間2111にいる場合に、物体検出点の周辺から生成される形状2207のX軸幅2208が条件幅A3の長さ以内、かつ形状2207のZ軸幅2209が条件幅B3の長さ以上であるため、該物体検出点を操作ポインタとしてみなす。この場合、入力装置1600は、一人以上のユーザがZ3およびZ4の間にいることを認識することができる。

【0067】

本実施例の入力装置1600は、操作ポインタが第一の入力操作空間2010、第二の入力操作空間2011、または第三の入力操作空間2012のどちらかに検出されるかに応じて、異なった入力操作を検出する。例えば、操作ポインタが第三の入力操作空間2012に検出された場合、映像表示装置1601に広告を表示する。操作ポインタが第二の入力操作空間2011に検出された場合、映像表示装置1601に、ユーザをさらに近づけるようにガイドの画像を表示する。操作ポインタが第一の入力操作空間2010に検出された場合、上記第一の実施例ないし第四の実施例と同様に、手の動きを検出して表示する画面を変化する。

【0068】

このように、本実施例の入力装置1600は複数の入力操作空間を生成し、各該入力操作空間において、異なる方法でユーザの入力操作を検出する。これにより、操作ポインタがどの入力操作空間に検出されたかに応じて、入力装置1600に対して異なった操作に割り当てることができる。

以上、第五の実施例ないし第七の実施例で説明してきたように、本発明の入力方法によれば、ユーザが手などの操作物体を出したときに、該物体のもっとも先端の点を操作ポインタとしてみなす。ユーザが該操作物体を動かすと、センサからみた手の先端の点の位置の変化に応じて、入力装置に対する操作を検出することができる。これにより、手の形状や人体モデルを使わなくても、低処理負荷の入力検出方法が実現できる。

【符号の説明】

【0069】

100…入力装置、101…表示画面、102…センシング部、103…ユーザ、

200…システム制御部、201…信号出力部、202…距離検出部、203…上下操作

検出部、600…操作基準、1000…撮像部、1100…形状検出部、1200…手の

形状、1201…検出基準、1600…入力操作、1601…表示画面、1602…センシング部、1603…ユーザ、1700…システム制御部、1701…信号出力部、1702…操作ポインタ抽出部、1703…入力操作検出部、1900…入力操作空間。

【技術分野】

【0001】

本発明は入力装置に係り、特に電子機器に指示を与えるユーザインタフェースの使い勝手を向上させた入力装置に関する。

【背景技術】

【0002】

従来、TVやレコーダといった映像装置、あるいは、PCなどの情報処理機器に対して、ユーザは、リモコンによりチャンネル操作・表示操作をし、キーボードやマウス、あるいはタッチパネルなどの入力デバイスによりコマンド入力やデータ入力をすることが一般的であった。また近年では、センサ技術の向上により、特にゲーム機やポータブル機器の分野において、ユーザの動作をセンサで認識し、その結果によりユーザの意思を判断して、機器を動作させる手法が用いられている。

【0003】

特許文献1には、手指の形状、動作を認識して、操作を判定する画像認識装置が開示されている。

特許文献2では、ユーザの操作となるジェスチャの認識対象を視覚的に表すためのジェスチャ画像表示を行うインタフェース装置が開示される。ユーザは、ジェスチャ画像を確認しながら、装置の操作を行うことができる。

【0004】

特許文献3では、ユーザの操作となるジェスチャを表示したアイコンと行える操作を表示する車載機器が開示される。ユーザは、行うべきジェスチャを容易に知ることができる。

特許文献4では、ステアリング上の手の状態と操作対象機器を示す選択ガイド情報を表示する車両用操作入力装置が開示される。ユーザは、当該ガイドを参照して、手を動かして、目的の操作機器を選択することができる。

【先行技術文献】

【特許文献】

【0005】

【特許文献1】特許第4318056号公報

【特許文献2】特開2008−52590号公報

【特許文献3】特開2001−216069号公報

【特許文献4】特開2005−250785号公報

【発明の概要】

【発明が解決しようとする課題】

【0006】

特許文献1の画像認識装置では、ユーザの体の位置に応じて操作面を作成し、ユーザはその操作面に対する手あるいは指の位置、あるいは動きにより、装置に対する指示を行う。前記操作面は、仮想的な操作面であり、「操作者102は、マーカ101から仮想的な操作面701を想定して手601を突き出したり、モニタ111と連動させて画面上の一部と操作面701とをタッチパネルに見立ててタッチするように手601を動かしたりすることにより、入力操作を容易に行うことができる。(段落番号0033)」ものとしている。

【0007】

この特許文献1では、体の位置に応じて操作面を定めているため、以下のような問題点がある。

(1)仮想的な操作面に対して操作を行うため、ユーザが、操作面の大きさや、操作面と操作の対応関係、あるいは操作面と画面上の表示の対応関係を把握することが難しい。

(2)手を出す前に操作面位置を決めるため、キャリブレーションのタイミングが難しい。特に複数人いる場合に、画面の前にいる誰に対して操作領域を設けるかが決まらない。

また、特許文献2ないし特許文献4では、いずれの特許文献も、操作のための動きやポーズが表示され、ユーザはこれらに従って、所定の装置に関する動作を実行することが開示されている。

【0008】

しかしながら、ユーザが、操作のために、所定の動きをしたり、所定のポーズをとろうとする際、所定の動き、所定のポーズに至るまでに、無意識に行う別の動きや、別のポーズが、操作のための動きと認識されてしまい、ユーザが意図しない装置の動作が実行されてしまう恐れがある。

つまり、いずれの特許文献も、ユーザが操作のためのジェスチャを行う際に、ユーザの動きが、物理的な物や画面表示とどのように対応し、操作としてどのように認識されるかをユーザに直感的に理解させることは考慮されていない。

【0009】

また、いずれの特許文献の入力装置も、入力を検出するために手などの所定の形状を認識することが開示されている。しかし、手などの形状を認識する際に、参照する所定の形状のモデルとの比較や、所定の形状の学習などの処理が必要であり、入力装置が行う処理の負荷が高くかつ認識処理の時間がかかる恐れがある。

そこで本発明は、かかる事情を考慮した上で、上記課題を解決するためになされたもので、その目的は、非接触で入力操作を行う入力装置において、操作を行う物体のセンサに最も位置が近い点(以下、物体検出点と記す)を検出して、該物体検出点の位置の変化に応じて、入力操作の操作状態をリアルタイムに画面上に表示することにより、ユーザが意図する操作を円滑に入力できる入力装置を提供することにある。

【課題を解決するための手段】

【0010】

上記目的を達成するために、本発明の入力装置において、入力装置を操作するユーザの手などの操作を行う物体における各点の位置を検出する位置検出手段と、前記位置検出手段の検出結果に基づき、前記位置検出手段から物体検出点の位置の変化を検出する位置変化検出手段と、映像表示手段とを備え、前記位置変化検出手段は、所定の範囲における位置検出手段から最も近いポイントの位置の変化を検出し、前記映像表示手段は、前記位置変化検出手段の検出結果に応じて表示の変更を行う。

ここで、前記映像表示手段は、前記位置変化検出手段の検出結果に応じて、表示内で示す物体の大きさ、長さ、深さ、縮尺等の量に関する表示や形、表示する物体の位置を変化させる。

【発明の効果】

【0011】

本発明によれば、非接触で入力操作を行う入力装置において、ユーザは操作を直感的に把握して意図する操作を円滑に入力することができ、入力装置の使い勝手を向上できるという効果がある。

【図面の簡単な説明】

【0012】

【図1】実施例1の入力装置を示す概観図である。

【図2】実施例1の入力装置の構成を示すブロック図である。

【図3】実施例1の入力装置の操作領域とユーザの操作方法を示す概観図である。

【図4】実施例1の入力装置の操作状態に応じた表示を説明する概観図である。

【図5】実施例1の入力装置の動作を説明するフローチャートである。

【図6】実施例2の入力装置の操作領域とユーザの操作方法を示す概観図である。

【図7】実施例2の入力装置の操作状態に応じた表示を説明する概観図である。

【図8】実施例2の入力装置の動作を説明するフローチャートである。

【図9】実施例2の入力装置の操作状態に応じた表示を説明する概観図である。

【図10】実施例3の入力装置を示す概観図である。

【図11】実施例3の入力装置の構成を示すブロック図である。

【図12】実施例3の入力装置の操作領域とユーザの操作方法を示す概観図である。

【図13】実施例3の入力装置の動作を説明するフローチャートである。

【図14】実施例4の入力装置の操作領域とユーザの操作方法を示す概観図である。

【図15】実施例4の入力装置の動作を説明するフローチャートである。

【図16】実施例5の入力装置を示す概観図である。

【図17】実施例5の入力装置の構成を示すブロック図である。

【図18】実施例5の入力装置の動作を説明するフローチャートである。

【図19】実施例5の入力装置の入力操作空間を示す概観図である。

【図20】実施例5の入力装置の距離テーブルである。

【図21A】実施例6の入力装置の操作ポインタを検出する方法を説明する第1の概観図である。

【図21B】実施例6の入力装置の操作ポインタを検出する方法を説明する第2の概観図である。

【図22A】実施例7の入力装置の操作ポインタを検出する方法を説明する第1の概観図である。

【図22B】実施例7の入力装置の操作ポインタを検出する方法を説明する第2の概観図である。

【図22C】実施例7の入力装置の操作ポインタを検出する方法を説明する第3の概観図である。

【発明を実施するための形態】

【0013】

以下、本発明に係る各実施例について説明する。

【実施例1】

【0014】

以下、本発明に係る第一の実施例を、図1ないし図5を用いて説明する。本実施例の入力装置100は、ユーザの手と入力装置100の間の距離をセンサにより検出し、該距離に応じて映像表示装置101に対する操作の指示を与える装置である。

先ず、図1および図2を用いて第一の実施例における入力装置の構成を説明する。

【0015】

図1は、実施例1の入力装置100を示す概観図であり、映像表示装置101、センシング部102、ユーザ103により、入力装置100をユーザ103が使用する際の動作環境の概観を示す。

映像表示装置101は、映像表示装置101の外部から与えられる操作入力信号に基づき、ユーザに映像情報を提示する装置であり、例えば、LCD(Liquid Crystal Display)、PDP(Plasma Display Panel)、液晶プロジェクタ、レーザープロジェクタ、リアプロジェクタなどのディスプレイ装置と、映像コンテンツやGUI(Graphical User Interface)などの表示処理に必要な演算処理装置やメモリを有する装置である。

【0016】

センシング部102は、ユーザ103の手とセンサの間の距離を検出する構成要素であり、例えば、赤外線距離センサ、レーザ距離センサ、超音波距離センサ、距離画像センサ、電界センサをはじめとするセンサと、データ処理を行うマイクロコンピュータ(以下、マイコンと略記する)、及びマイコン上で動作するソフトウェアから構成される。センシング部102に用いるセンサは、特に限定されず、ユーザの手までの距離を検出するために得られる信号を、距離データに変換する機能を有すればよい。

ユーザ103は、入力装置100に対して操作を行うユーザである。

図2は、実施例1の入力装置100の構成を示すブロック図である。

入力装置100は、図2に示すように、センシング部102、システム制御部200、信号出力部201、を備える。

システム制御部200は、距離検出部202、上下操作検出部203、を有する。

【0017】

距離検出部202は、センシング部102から得られる距離データから、検出される距離を抽出あるいは分類する操作を行う構成要素である。上下操作検出部203は、距離検出部202が操作して検出した距離から、ユーザ103が手を上下に動かす操作を検出する構成要素である。

システム制御部200は、ユーザ103の手のセンシング部102からの距離を検出し、手を上下に動かす操作を検出するためのデータ処理をおこなう構成要素である。システム制御部200は、CPU(Central Processing Unit)が、メモリ上に記憶されているソフトウェアモジュールを実行することにより実現してもよいし、専用のハードウェア回路により実現してもよい。

【0018】

信号出力部201は、システム制御部200から指示とデータを受け取り、映像表示装置101で表示を行う映像信号を出力する構成要素である。

次に、図3および図4を用いて第一の実施例に係る入力装置100による操作方法について説明する。

【0019】

図3は、実施例1の入力装置100の操作領域とユーザの操作方法を示す概観図である。図3に示されるように、入力装置100は、センシング部102から得られるユーザの手のセンシング部102からの距離に基づき、上方向操作領域、ホームポジション、下方向操作領域、の3つの操作領域のどこに手が位置しているかを検出する。前記操作領域は、ユーザ103の操作の検出方法を説明するための概念的な領域であり、ユーザ103が手をかざした位置に応じて、手の付近の空間に存在するものとする。

図4は、実施例1の入力装置の操作状態に応じた表示を説明する概観図である。図4では、映像表示装置101に画像を一覧するための表示がされており、ユーザ103の操作に応じて、一覧する画像のサイズや表示数が変更される様子を示している。

【0020】

第一の実施例に係る入力装置100の操作イメージは、図4に示されるように、ユーザ103が映像表示装置101を見ながら手を使って操作し、該手までのセンシング部102からの距離を入力装置100が検出し、その検出結果に基づいて映像表示装置101の表示が変更されるものである。例えば、図4の“開始状態”に示されるように、ユーザ103の手が図3の“ホームポジション”の位置にあるとする。次に、図4の“操作状態A”に示されるように、ユーザ103が手を図3の“ホームポジション”の位置から、図3の“上方向操作領域”に移動させると、映像表示装置101に表示される画像の一覧は、個々の画像のサイズが小さくなり、同時に表示される画像の数が多くなる。

一方、図4の“操作状態B”に示されるように、ユーザ103の手を図3の“ホームポジション”の位置から、図3の“下方向操作領域”に移動させると、映像表示装置101に表示される画像の一覧は、個々の画像のサイズが大きくなり、同時に表示される画像の数が少なくなる。すなわち、ユーザ103の手が検出される位置が、図3の“ホームポジション”から、図3の“上方向操作領域”や図3の“下方向操作領域”に移動すると、入力装置100は映像出力装置101に対して、ユーザ103の手の移動方向に応じた指示を与え、映像出力装置101の表示が変更される。

【0021】

図5は、実施例1の入力装置100の動作を説明するフローチャートである。図5に基づき入力装置100による入力操作の検出処理の手順について説明する。

入力操作の検出処理は、図2に示したシステム制御部200が行う処理である。

先ず、システム制御部200は、所定のユーザ操作に応じて、手の位置の検出を開始し(ステップS500)、距離検出部202にてセンシング部102から得られる距離データから、検出される距離を抽出あるいは分類する処理を行い、手のセンシング部102からの距離を検出する。手の距離が検出された際には(ステップS501:Yes)、検出された距離に対応する操作領域を求める(ステップS502)。

【0022】

手が位置する操作領域がホームポジションである場合は(ステップS503:Yes)、後記するステップS507に到る。一方、手が位置する操作領域がホームポジションではない場合は(ステップS503:No)、まず前回の検出で手が位置した操作領域がホームポジションであったことを確認し(ステップS504:Yes)、上下操作検出部203にて、上方向、もしくは下方向の操作を検出する(ステップS505)。このとき、ステップS504において、前回検出した操作領域がホームポジションではなかった場合は(ステップS504:No)、後記するステップS507に到る。すなわち、手が位置する操作領域がホームポジションから、他の操作領域に移動した場合にのみ、ステップS505で操作が検出され、上方向もしくは下方向の操作を検出した際には、信号出力部201を介して、検出した操作に対応する、映像表示装置101に操作を指示するため操作入力信号が出力される(ステップS506)。

【0023】

ユーザ103が所定の操作にて、操作終了の意思表示をしたときには(ステップS507:Yes)、処理を終了し(ステップS508)、そうでないときには(ステップS507:No)、ステップS501に戻り、前記した手の距離の検出を継続する。

このように、入力装置100は、ユーザ103が入力装置100に対して手をかざしている距離の変化に応じて操作を検出し、映像表示装置101に操作の指示を与える。これにより、ユーザ103は、物理的な装置と手の距離の関係から、手の距離と操作の対応を直感的に把握でき、ユーザ103が意図する操作を円滑に入力できる。

【実施例2】

【0024】

以下、本発明に係る第二の実施例を、図6ないし図9を用いて説明する。

第一の実施形態の入力装置100の表示制御方法は、手が位置する操作領域の変化に応じて操作を実行するインタフェースを提供するものであった。本実施例では、第一の実施例の操作方法に加えて、さらに、手と入力装置100の相対的な距離の変化応じて操作を実行するインタフェースを提供するものである。

本実施形態の入力装置100でも、図2に示したように、センシング部102、システム制御部200、信号出力部201からなることは、第一の実施例と同様であるが、システム制御部200が上下操作検出部で検出する操作のみが異なる。

【0025】

先ず、図6及び図7を用いて第二の実施例の入力装置100の操作方法について説明する。

図6は、実施例2の入力装置100の操作領域とユーザの操作方法を示す概観図である。

【0026】

図6に示されるように、入力装置100は、センシング部102から得られるユーザの手の距離に基づき、操作に反映される大きさや量、長さ等を図るための操作基準600に対して、どこに手が位置しているかを検出する。前記操作基準600は、ユーザ103の操作の検出方法を説明するための概念的な基準であり、ユーザ103が手をかざした位置に応じて、手の付近の空間に存在するものとする。

図7は、実施例2の入力装置100の操作状態に応じた表示を説明する概観図であり、ユーザ操作と操作結果の対応を示す。図7では、映像表示装置101に地図が表示されており、ユーザ103の操作に応じて、地図の縮尺が変更される様子を示している。

【0027】

第二の実施例に係る入力装置100の操作イメージは、図7に示されるように、ユーザ103が映像表示装置101を見ながら手を使って操作し、該手までのセンシング部102からの距離を入力装置100が検出し、その検出結果に基づいて映像表示装置101の表示が変更されるものである。例えば、図7の“操作状態1”に示されるように、ユーザ103の手が操作基準600の上位付近の位置にあるとする。次に、図7の“操作状態2”に示されるように、ユーザ103が手を操作基準600の中位付近に移動させると、映像表示装置101に表示される地図の縮尺は拡大される。さらに、図7の“操作状態3”に示されるように、ユーザ103が手を操作基準600の下位付近に移動させると、映像表示装置101に表示される地図の縮尺はより拡大される。

【0028】

次に、図8を用いて第二の実施例に係る入力装置100による入力操作の検出処理の手順について説明する。

図8は、実施例2の入力装置100の動作を説明するフローチャートである。

入力操作の検出処理は、図2に示したシステム制御部200が行う処理である。

【0029】

先ず、システム制御部200は、所定のユーザ操作に応じて、手の位置の検出を開始し(ステップS800)、距離検出部202にてセンシング部102から得られる距離データから、検出される距離を抽出あるいは分類する処理を行い、手のセンシング部102からの距離を検出する。手の距離が検出された際には(ステップS801:Yes)、操作基準600に対する手の位置を求める(ステップS802)。

次に、信号出力部201において、操作基準600に対する、検出した手の相対的な位置より、地図の縮尺率を算出し、映像表示装置101に地図の縮尺率を変更する操作を指示するため操作入力信号が出力される(ステップS803)。

ユーザ103が所定の操作にて、操作終了の意思表示をしたときには(ステップS804:Yes)、処理を終了し(ステップS805)、そうでないときには(ステップS804:No)、ステップS801に戻り、前記した手の距離の検出を継続する。

【0030】

このように、第二の実施例に係る入力装置100は、ユーザ103が入力装置100に対して手をかざしている距離の変化に応じて、操作基準600に対する手の位置を検出し、操作基準600に対する手の位置で示される大きさや量、長さ等を、映像表示装置101に対する操作として指示する。これにより、ユーザ103は、物理的な装置と手の距離の関係から、手の距離と、大きさ、長さ、深さ、縮尺等の量の対応を直感的に把握でき、ユーザ103が意図する操作を円滑に入力できる。

【0031】

また、上記入力操作は、複数の階層からなるメニューを操作させるのに有効である。

図9は、実施例2の入力装置の操作状態に応じた表示を説明する概観図である。図9に示すように、映像表示装置101に複数の階層からなるメニューが表示される場合、操作基準600に対し、階層を割り当てることにより、図中の斜め線で示すように、操作対象となる階層を手の位置により変更することができる。これにより、ユーザ103は、物理的な装置と手の距離の関係から、手の距離と、操作対象となる階層の対応を直感的に把握でき、ユーザ103が意図する操作を円滑に入力できる。

【実施例3】

【0032】

以下、本発明に係る第三の実施例を、図10ないし図13を用いて説明する。

第一の実施例の入力装置100の表示制御方法は、手と入力装置100の距離に応じて操作を実行するインタフェースを提供するものであった。本実施例では、第一の実施例の操作方法に加えて、さらに、手と入力装置100の距離を検出する際に、手の形状に応じて検出距離の検出基準を決定するものである。

【0033】

図10は、実施例3の入力装置100を示す概観図である。

図11は、実施例3の入力装置100の構成を示すブロック図である。

本実施形態の入力装置100でも、図10および図11に示すように、システム制御部200、信号出力部201を有することは、第一の実施例と同様であるが、センシング部102が撮像部1000に置き換わることと、システム制御部200が形状検出部1100を有することが異なる。このため図10で示すように、撮像部1000が指の形状を明確に捕らえられるよう、図1のセンシング部102とは異なる位置に設けられても良い。また、図1のセンシング部102と図10の撮像部1000の双方を備えるようにしても良い。

【0034】

撮像部1000は、ユーザの手を撮像するための装置であり、例えば、TOF(Time of flight)センサ機能を有する赤外線カメラ、ステレオカメラ、或いはRGBカメラを用いると良い。撮像部1000に用いるカメラは、特に、限定されず、ユーザに対して画像認識をするために、得た画像をデジタルデータに変換するための撮像画像を得る機能を有すればよい。

形状検出部1100は、撮像部1000から得られる撮像画像から、所定の手の形を検出する部分であり、例えば、パターンマッチング等の画像解析手法が用いられる。形状検出部1100に用いられる画像解析手法は、特に限定されず、得た撮像画像の中に所定の手の形が存在するか否かと、手の距離および位置を検出する機能を有すればよい。

【0035】

先ず、図12を用いて第三の実施例の入力装置100の操作の検出方法について説明する。

図12は、実施例3の入力装置100の操作領域とユーザの操作方法を示す概観図である。

図12に示されるように、入力装置100は、撮像部1000から得られる撮像画像の中から、手の形1200を検出し、手の形1200を検出した際の入力装置100とユーザ103の手の距離を、検出基準1201とする。さらに、入力装置100は、前記検出基準1201に応じて、第一の実施例で示した操作領域の位置を変更する。操作領域が変更された後の操作については、第一の実施例と同様となる。

【0036】

次に、図13を用いて第三の実施例に係る入力装置100による入力操作の検出処理の手順について説明する。

図13は、実施例3の入力装置100の動作を説明するフローチャートであり、第一の実施例で説明した図5のフローチャートに対して、ステップS501で手の位置を検出した後、ステップS502で操作領域を求めるまでの間に、ステップS1300及びステップS1301を加えている。

【0037】

入力操作の検出処理は、図11に示したシステム制御部200が行う処理である。

先ず、システム制御部200は、所定のユーザ操作に応じて、手の位置の検出を開始し(ステップS500)、距離検出部202にて撮像部1000から得られる撮像画像から手を検出し、操作として検出される距離を抽出あるいは分類する処理を経て、手の距離を検出する。手の距離が検出された際には(ステップS501:Yes)、形状検出部1100にて、所定の手の形状1200を検出する処理を行う(ステップS1300)。所定の手の形状は、例えば図12の“ホームポジション”で示すように、親指と人差し指を接触させた時の形状などと予め定めておけば良い。所定の手の形状1200が検出された際には(ステップ1300:Yes)、手の距離を検出する際の検出基準1201を設定し(ステップS1301)、ステップS502以降の処理を行う。

【0038】

一方、所定の手の形状1200が検出されない場合は(ステップS1300:No)、検出基準1201は設定されず、ステップS502以降の処理が行われる。ステップS502以降の処理については、第一の実施例で説明した図5のフローチャートと同様となる。即ち、図13では図6と異なり、ユーザ103の手の形状を検出してホームポジションを設定できることに特徴がある。

このように、第三の実施例に係る入力装置100は、ユーザ103が入力装置100に対してかざしている手の形状に応じて、検出基準1201を設定する。これにより、ユーザ103は、手と操作領域の相対的な位置を、意図したタイミングで変更することができ、ユーザ103が任意の位置でより確実に操作を入力できる。

【実施例4】

【0039】

以下、本発明に係る第四の実施例を、図14ないし図15を用いて説明する。

第三の実施例の入力装置100の表示制御方法は、手の形状に応じて検出基準1201を設定することにより、第一の実施例で説明した操作における、手と操作領域の相対的な位置を、意図したタイミングで変更することができるものであった。本実施例では、第三の実施例の操作方法に加えて、さらに、第二の実施例で説明した操作における、手と操作基準600の相対的な位置を、意図したタイミングで変更できるものである。

【0040】

本実施形態の入力装置100でも、図10および図11に示すように、撮像部1000、システム制御部200、信号出力部201を有することは、第三の実施例と同様であるが、システム制御部200で行われる検出処理の手順が異なる。

先ず、図14を用いて第四の実施例の入力装置100の操作の検出方法について説明する。

図14は、実施例4の入力装置100の操作領域とユーザの操作方法を示す概観図である。

【0041】

図14に示されるように、入力装置100は、撮像部1000から得られる撮像画像の中から、手の形1200を検出し、手の形1200を検出した際の入力装置100とユーザ103の手の距離を、検出基準1201とする。さらに、入力装置100は、前記検出基準1201に応じて、第二の実施例で示した操作基準600の位置を変更する。また、操作基準600が変更された後の操作は、手の形1200が検出され続けている場合にのみ有効となり、操作が有効な場合の操作方法については第二の実施例と同様となる。

【0042】

次に、図15を用いて第四の実施例に係る入力装置100による入力操作の検出処理の手順について説明する。

図15は、実施例4の入力装置100の動作を説明するフローチャートであり、第二の実施例で説明した図8のフローチャートに、ステップS1500ないしステップS1502を加えたフローチャートである。

入力操作の検出処理は、図11に示したシステム制御部200が行う。

【0043】

先ず、システム制御部200は、所定のユーザ操作に応じて、手の位置の検出を開始し(ステップS800)、距離検出部202にて撮像部1000から得られる撮像画像から手を検出し、操作として検出される距離を抽出あるいは分類する処理を経て、手の距離を検出する。手の距離が検出された際には(ステップS801)、形状検出部1100にて、所定の手の形状1200を検出する処理を行う(ステップ1500)。この際に、所定の手の形状が検出されない場合は(ステップ1500:No)、以降の処理には進まず、ステップS804に到る。すなわち、所定の手の形状1200が検出されている場合にのみ、操作が有効になる。

一方、所定の手の形状1200が検出された際には(ステップ1500:Yes)、前回の手の検出時に所定の手の形状であったかを確認し(ステップS1501)、前回の手の検出時に所定の手の形状ではなかった場合は(ステップS1501:No)、手の距離を検出する際の検出基準1201を設定し(ステップS1502)、ステップS802以降の処理を行う。また、前回の手の検出時に所定の手の形状であった場合は(ステップ1501:Yes)、検出基準1201は新たには設定されず、ステップS802以降の処理が行われる。ステップ802以降の処理については、第二の実施例で説明した図8のフローチャートと同様となる。

【0044】

このように、第四の実施例に係る入力装置100は、ユーザ103が入力装置100に対してかざしている手の形状に応じて、検出基準1201を設定する。また、ユーザ103が所定の手の形状で手をかざしている場合にのみ、操作が有効になる。これより、ユーザ103は、手と操作基準の相対的な位置を、意図したタイミングで変更することができ、尚且つ、手の形により意図したタイミングでのみ操作を行うことができるため、ユーザ103が任意の位置でより確実に操作を入力できる。

以上、第一の実施例ないし第四の実施例で説明してきたように、本発明の入力装置の入力方法によれば、特許文献1ないし特許文献4の従来技術とは異なり、ユーザが手を出したときに表示され、さらに手と入力装置の間の距離に応じて変化する、画面上の表示を介して、入力装置に対して可能な入力操作と、操作状態を直感的に把握でき、操作性を向上させることができる。

【実施例5】

【0045】

以下、本発明に係る第五の実施例を、図16ないし図20を用いて説明する。

第一ないし第四の実施例の入力装置100は、ユーザの手を認識して、手と入力装置100の間の距離をセンサにより検出し、該距離に応じて映像表示装置101の表示を変更する装置であった。本実施例の入力装置1600は、センシング部1602の距離検出結果を用いて物体検出点を検出し、該物体検出点の位置の変化(以下、動きと記す)に応じて映像表示装置1601の表示を変更する装置である。

【0046】

まず、図16および図17を用いて第五実施例の入力装置1600の構成を説明する。

図16は、実施例5の入力装置1600を示す概観図であり、映像表示装置1601、センシング部1602、ユーザ1603により、入力装置1600をユーザ1603が使用する際の動作環境の概観を示す。

映像表示装置1601は、上記第一の実施例の映像表示装置101と同様な構成要素である。

【0047】

センシング部1602は、センシング部1602の前方の空間に存在する物体の距離を測定する部分であり、例えば、赤外線距離センサ、レーザ距離センサ、超音波距離センサ、距離画像センサ、電界センサをはじめとするセンサと、データ処理を行うマイコン、及びマイコン上で動作するソフトウェアから構成される。センシング部1602に用いるセンサは、特に限定されず、物体の距離を検出するために得られる信号を、距離データに変換する機能を有すればよい。

ユーザ1603は、入力装置1600に対して操作を行うユーザである。

【0048】

方向軸1604は、センシング部1602の前方の空間に対応して互いに直交するX軸、Y軸、およびZ軸からなる方向を示す軸である。ここでX軸はセンシング部1602の横方向の軸を表し、X軸位置の値は、センシング部1602のX軸を0(零)とし、左右方向の距離を示す。Y軸はセンシング部1602の縦方向の軸を表し、Y軸位置の値は、センシング部1602の位置を0(零)とし、上下方向の距離を示す。Z軸はセンシング部1602の奥行方向の軸を表し、Z軸位置の値は、センシング部1602の位置を0(零)とし、センシング部1602の前方方向の距離を示す。

センシング部1602が距離測定した結果を、例えば以下に説明するX軸およびY軸の各位置の組合せ(以下、XY座標値と記す)に対してZ軸の位置の値を示すテーブル2000で表す。これによって、センシング部1602に対して、前方する空間にある物体の各点の位置はX軸、Y軸およびZ軸位置の値の組合せ(XYZ座標値)で表すことができる。

【0049】

図17は、実施例5の入力装置1600の構成を示すブロック図である。

入力装置1600は、図17に示すように、センシング部1602、システム制御部1700、信号出力部1701、を備える。

システム制御部1700は、操作ポインタ抽出部1702および入力操作検出部1703の機能を実現する部分を有する。システム制御部1700は、物体検出点を検出して、該物体検出点を操作ポインタとして扱い、入力装置1600に対する操作を検出するためのデータ処理をおこなう部分である。システム制御部1701は、上記第一の実施例のシステム制御部200と同様、CPUが、メモリ上に記憶されているソフトウェアモジュールを実行することにより実現してもよいし、専用のハードウェア回路により実現してもよい。

【0050】

信号出力部1701は、上記第一の実施例の信号出力部201と同様、システム制御部1700から指示とデータを受け取り、映像表示装置1601で表示を行う映像信号を出力する部分である。

操作ポインタ抽出部1702は、上記センシング部1602の出力結果により、物体検出点を操作ポインタとしてみなす部分である。

入力操作部検出部1703は、上記操作ポインタの動きから、入力装置1600に対する入力操作の検出を行う部分である。ここで、入力操作とは、第一の実施例ないし第四の実施例に記載した、入力装置1600に対する手の動きと相当し、例えば手が入力装置1600に近づける、あるいは遠ざかるという動きのことを指す。

【0051】

図18は、実施例5の入力装置1600の動作を説明するフローチャートであり、ユーザ入力操作の検出処理の手順を説明するものである。

図19は、実施例5の入力装置1600の入力操作空間を示す概観図であり、入力操作空間1900とユーザ1603が操作する際の様子を説明するものである。

【0052】

入力操作空間1900は、センシング部1602の前方にあるユーザから入力操作の動作を検出する3次元空間である。入力操作空間1900の大きさは、例えばX軸に関してはX1からX2、Y軸に関してはY1からY2、Z軸に関してはZ1からZ2の各方向においた所定の区間で定義される。ユーザの手の先にある物体検出点1901は、ユーザの手のセンシング部1602に最も位置が近い点である。

図20は、実施例5の入力装置1600の距離テーブルであり、入力操作空間におけるセンシング部1602の出力結果を表わす。テーブル2000は、XY座標値に対する各点のZ軸の位置を表す。

【0053】

次に、図18ないし図20を用いて第五の実施例に係る入力装置1600による操作方法について説明する。

例えば、入力装置1600の電源がオンとなったときに、入力装置1600は入力操作の検出を開始する(ステップS1800)。

入力操作の検出が開始されると、入力装置1600は図19に示す入力操作空間1900を生成する(ステップS1801)。

以下に説明するステップS1802ないしステップS1806で行われる一連の処理は、終了命令がなされていない限り、繰り返しされるループである。

【0054】

まず、ユーザが行う入力操作の検出の終了命令があるか否かをチェックする(ステップS1802)。終了命令がなければ、次のステップに進む(ステップS1802:No)。終了命令があれば、入力操作の検出処理を終了する(ステップS1802:Yes)。検出終了の命令を与える方法として、例えばユーザが所定のスイッチなどで電源をオフにすることや、タイムアウト処理などで行ってもよい(ステップS1807)。

次に、センシング部1602を用いて、上記入力操作空間1900内の物体の距離測定を行う(ステップS1803)。センシング部1602が距離測定した結果を図20に示す距離テーブル2000として出力する。

【0055】

次に、上記テーブル2000を参照して、入力操作空間1900内に物体が存在するか否かをチェックする(ステップS1804)。具体的には、テーブル2000を参照して、Z軸の位置がZ1以上かつZ2以下の点が存在するか否かをチェックする。該当する点が存在しなければ、処理ステップをステップS1802に戻す(ステップS1804:No)。該当する点が存在すれば、次のステップに進む(ステップ1804:Yes)。

次に、入力装置1600の操作ポインタ抽出部1702は、上記物体検出点を操作ポインタとして設定する(ステップS1805)。

【0056】

次に、ステップS1805で設定操作ポインタの位置の変化を用いて、入力装置1600に対する入力操作を検出する(ステップS1806)。ここで、図19においてユーザが手を動かすと操作ポインタとして扱う物体検出点1901の位置が手の動きに応じて変化するため、入力操作検出部1703は該物体検出点の動きをみて、入力操作を検出する。

ここで、上記ステップS1806で検出したユーザの操作に応じて、上記第一の実施例ないし第四の実施例と同様に、映像表示装置1601への表示を変化させる。

このように、本実施例の入力装置1600は、物体検出点の位置の変化に応じて、操作の入力を行う。これにより、高い処理負荷かつ処理時間がかかる手の形状を認識する処理等を行わなくても、低処理負荷の非接触の入力装置を実現することができる。

【実施例6】

【0057】

以下、本発明に係る第六の実施例を、図21Aと図21Bを用いて説明する。

上記第五の実施例の入力装置1600は、物体検出点を操作ポインタの位置として扱い、該操作ポインタの動きに応じて映像表示装置1601の表示を変更する入力装置であった。本実施例の入力装置1600は、第五の実施例の入力装置1600と同様な構成を持つが、操作ポインタの抽出する方法が異なる入力装置1600に関するものである。

【0058】

図21Aと図21Bは、実施例6の入力装置の操作ポインタを検出する方法を説明する概観図であり、本実施例に係る操作ポインタを抽出するために、物体検出点のY軸の位置における、X軸の位置に対するZ軸の位置を示す。

【0059】

図21Aの線2100は、図18のフローチャートに示すステップS1802で生成したテーブル2000を参照し、物体検出点1901のY軸の位置における、X軸の各位置に対して、Z軸の距離を表す線である。

図21Bの線2103は、物体検出点2104が例えばユーザ1603の頭や胴体など大きいな物体のセンシング部1602に最も位置が近い点として検出した場合の、該物体検出点2104のY軸の位置における、X軸の位置に対するZ軸の位置を表す線である。

【0060】

次に、本実施例における操作ポインタの抽出方法(図18のステップS1805)について説明する。

まず、操作ポインタ抽出部1702は、図21Aにおける物体検出点1901を操作ポインタの候補とする。次に、線2100上に存在する、物体検出点1901の周辺点が輪郭となる2次元の形状2101を生成する。ここで、本実施例の入力装置1600は上記形状2101のX軸の幅2102がある所定の条件幅A以内であり、かつZ軸の幅2012がある所定の条件幅B以上であるという条件を満たしていれば、物体検出点1901を入力装置1600の操作ポインタとしてみなし、該条件を満たさなければ物体検出点1901を操作ポインタとしてみなさない。

【0061】

条件幅Aおよび条件幅Bの大きさの決め方によって、操作ポインタとみなす物体の形や大きさが異なる。例えば図21Aと図21Bに示すように、ユーザの手を、操作を行う物体としたい場合に、条件幅Aおよび条件幅Bの大きさを人間の手の大きさに合わせる。

これにより、図21Aに関しては、形状2101が上記の条件を満たすものであるとして、点1901は操作ポインタとしてみなす。また、図21Bに関しては、点2104の周辺で生成された形状2105のX軸幅2106が、条件幅Aよりも長く、上記の条件を満たさないため、点2104を操作ポインタとしてみなさない。

なお、X軸の条件幅およびZ軸の条件幅で操作ポインタの判定を行うが、Y軸の条件幅を用いてもよい。

【0062】

このように、本実施例の入力装置1600は、入力操作空間1900において、センシング部1602から最も近い点を操作ポインタの候補とし、該操作ポインタの周辺の点で生成する形状の大きさ、形に応じて、実際に操作ポインタとみなすか否かを判定する。これにより、センシング部1602から最も近い点が例えばユーザの頭、胴体など、手の大きさより大きな物体の存在する点にあると検出されれば、該点を操作ポインタとしてみなさない。つまり第五の入力装置1600と比較して、本実施例の入力装置1600は、ユーザが意図しない物体を誤って操作ポインタと扱わず、より正確に入力の検出を行うことができる。

【実施例7】

【0063】

以下、本発明に係る第七の実施例を、図22Aないし図22Cをを用いて説明する。

第五の実施例および第六の実施例の入力装置1600は、一つの入力操作空間における物体検出点を操作ポインタとして扱い、該操作ポインタの動きに応じて映像表示装置1601の表示を変更する入力装置であった。本実施例の入力装置1600は、複数の入力操作空間を生成し、各該入力操作空間に応じて操作ポインタの決め方を変えて、ユーザの入力操作を検出する入力装置1600に関するものである。

【0064】

図22Aないし図22Cをは、本実施例に係る複数の入力操作空間におけるユーザの入力操作を検出する際の入力装置1600とユーザの様子と、それぞれの様子において、操作ポインタを抽出するために、Y軸の位置がセンシング部1602から最も距離が近い点のY軸の位置における、X軸の各位置に対するZ軸の距離を説明する概観図である。

上記ステップS1801で、本実施例の入力装置1600は、3つの入力操作空間を作成する。第一の入力操作空間2210は、X1からX2のX軸区間、Y1からY2のY軸区間、Z1からZ2のZ軸区間で設定されるセンシング部1602から最も近い入力操作空間である。第二の入力操作空間2211は、X1からX2のX軸区間、Y1からY2のY軸区間、Z2からZ3のZ軸区間で設定される入力操作空間である。第三の入力操作空間2212は、X1からX2のX軸区間、Y1からY2のY軸区間、Z3からZ4のZ軸区間で設定される入力操作空間である。つまり、Z軸方向において、センシング部1602から最も近い順から、第一の入力操作空間2210、第二の入力操作空間2011と最後に第三の入力操作空間2012が作成される。

【0065】

本実施例の入力装置1600は、第五の実施例と同様に、操作ポインタを抽出する際にまず物体検出点の周辺の点で生成する形状の大きさおよび形をみて、操作ポインタとみなすか否かを判定するが、物体検出点がどの入力操作空間に存在するかに応じて、上記条件幅Aおよび条件幅Bを異なる値にする。

例えば、第一の操作空間2010において、操作ポインタとみなすための条件幅は、条件幅A1および条件幅B1とする。これによって、図22Aに示すように、ユーザの手が第一の入力操作空間2110に出した際に、手の先の点に生成される形状2201のX軸幅2202が条件幅A1の長さ以内、かつ形状2201のZ軸幅2203が条件幅B1の長さ以上であるため、ユーザの手の先は操作ポインタとしてみなす。このとき、入力装置1600は、手の動きを操作として検出する。

【0066】

第二の操作空間2011において、操作ポインタとみなすための条件幅は、条件幅A2および条件幅B2とする。これによって、図22Bに示すように、ユーザが第二の入力操作空間2111立っている場合に、物体検出点の周辺から生成される形状2204のX軸幅2205が条件幅A2の長さ以内、かつ形状2204のZ軸幅2206が条件幅B2の長さ以上であるため、該物体検出点を操作ポインタとしてみなす。この場合、入力装置1600は、ユーザがZ2およびZ3の間にことを認識することができる。

第三の操作空間2012において、操作ポインタとみなすための条件幅は、条件幅A3および条件幅B3とする。これによって、図22Cに示すように、例えば複数のユーザ集まって第三の入力操作空間2111にいる場合に、物体検出点の周辺から生成される形状2207のX軸幅2208が条件幅A3の長さ以内、かつ形状2207のZ軸幅2209が条件幅B3の長さ以上であるため、該物体検出点を操作ポインタとしてみなす。この場合、入力装置1600は、一人以上のユーザがZ3およびZ4の間にいることを認識することができる。

【0067】

本実施例の入力装置1600は、操作ポインタが第一の入力操作空間2010、第二の入力操作空間2011、または第三の入力操作空間2012のどちらかに検出されるかに応じて、異なった入力操作を検出する。例えば、操作ポインタが第三の入力操作空間2012に検出された場合、映像表示装置1601に広告を表示する。操作ポインタが第二の入力操作空間2011に検出された場合、映像表示装置1601に、ユーザをさらに近づけるようにガイドの画像を表示する。操作ポインタが第一の入力操作空間2010に検出された場合、上記第一の実施例ないし第四の実施例と同様に、手の動きを検出して表示する画面を変化する。

【0068】

このように、本実施例の入力装置1600は複数の入力操作空間を生成し、各該入力操作空間において、異なる方法でユーザの入力操作を検出する。これにより、操作ポインタがどの入力操作空間に検出されたかに応じて、入力装置1600に対して異なった操作に割り当てることができる。

以上、第五の実施例ないし第七の実施例で説明してきたように、本発明の入力方法によれば、ユーザが手などの操作物体を出したときに、該物体のもっとも先端の点を操作ポインタとしてみなす。ユーザが該操作物体を動かすと、センサからみた手の先端の点の位置の変化に応じて、入力装置に対する操作を検出することができる。これにより、手の形状や人体モデルを使わなくても、低処理負荷の入力検出方法が実現できる。

【符号の説明】

【0069】

100…入力装置、101…表示画面、102…センシング部、103…ユーザ、

200…システム制御部、201…信号出力部、202…距離検出部、203…上下操作

検出部、600…操作基準、1000…撮像部、1100…形状検出部、1200…手の

形状、1201…検出基準、1600…入力操作、1601…表示画面、1602…センシング部、1603…ユーザ、1700…システム制御部、1701…信号出力部、1702…操作ポインタ抽出部、1703…入力操作検出部、1900…入力操作空間。

【特許請求の範囲】

【請求項1】

電子機器をはじめとする装置に該装置のユーザが指示を与えるためのユーザインタフェースを有する入力装置であって、

所定の検出空間にあるユーザの体における所定部の位置を検出する位置検出部と、

前記入力装置の動作を制御し、前記所定部の位置を操作の基準点と見做すか否かを決定するシステム制御部と、

該システム制御部が前記所定部の位置を操作の基準点と見做すと決定した場合に前記所定部の位置の変化を検出する位置変化検出部と、

前記システム制御部からの指示に応じて所定の画像を表示する表示部と、を備え、

前記システム制御部は、

前記位置変化検出部における前記位置の変化の検出結果に基づき、前記表示部に表示する画像を変更する

ことを特徴とする入力装置。

【請求項2】

請求項1に記載の入力装置において、前記システム制御部は、前記位置検出部が検出した前記ユーザの体における所定部の前記入力装置からの距離に応じて、前記表示部に表示する画像を拡大または縮小することを特徴とする入力装置。

【請求項3】

請求項1に記載の入力装置において、前記システム制御部は、前記所定部の位置を操作の基準点と見做すか否かを決定する際には、前記ユーザの体における所定部の形状に応じて決定することを特徴とする入力装置。

【請求項4】

電子機器をはじめとする装置に該装置のユーザが該装置周辺の所定の検出空間から指示を与えるためのユーザインタフェースを有する入力装置であって、

物体の大きさを検出する物体大きさ検出部と、

前記入力装置の動作を制御し、前記ユーザの操作の基準点を決定するシステム制御部と、

該システム制御部が決定した前記基準点に対する前記ユーザの位置の変化を検出する位置変化検出部と、

前記システム制御部からの指示に応じて所定の画像を表示する表示部と、を備え、

前記物体の大きさ検出部は、前記検出空間に定めた所定の位置のうち最も前記入力装置に近い所定位置における周辺の物体の大きさを検出し、該物体の大きさが所定値よりも大きい場合には、

前記システム制御部は、前記最も近い所定位置を操作の基準点と決定し、前記位置変化検出部における前記位置の変化の検出結果に基づき、前記表示部に表示する画像を変更することを特徴とする入力装置。

【請求項5】

請求項4に記載の入力装置において、前記システム制御部は、前記検出空間を複数の空間に分割し、分割された検出空間毎に前記物体大きさ検出部が検出した物体の大きさに対して異なる値の前記所定値を設定すること、を特徴とする入力装置。

【請求項1】

電子機器をはじめとする装置に該装置のユーザが指示を与えるためのユーザインタフェースを有する入力装置であって、

所定の検出空間にあるユーザの体における所定部の位置を検出する位置検出部と、

前記入力装置の動作を制御し、前記所定部の位置を操作の基準点と見做すか否かを決定するシステム制御部と、

該システム制御部が前記所定部の位置を操作の基準点と見做すと決定した場合に前記所定部の位置の変化を検出する位置変化検出部と、

前記システム制御部からの指示に応じて所定の画像を表示する表示部と、を備え、

前記システム制御部は、

前記位置変化検出部における前記位置の変化の検出結果に基づき、前記表示部に表示する画像を変更する

ことを特徴とする入力装置。

【請求項2】

請求項1に記載の入力装置において、前記システム制御部は、前記位置検出部が検出した前記ユーザの体における所定部の前記入力装置からの距離に応じて、前記表示部に表示する画像を拡大または縮小することを特徴とする入力装置。

【請求項3】

請求項1に記載の入力装置において、前記システム制御部は、前記所定部の位置を操作の基準点と見做すか否かを決定する際には、前記ユーザの体における所定部の形状に応じて決定することを特徴とする入力装置。

【請求項4】

電子機器をはじめとする装置に該装置のユーザが該装置周辺の所定の検出空間から指示を与えるためのユーザインタフェースを有する入力装置であって、

物体の大きさを検出する物体大きさ検出部と、

前記入力装置の動作を制御し、前記ユーザの操作の基準点を決定するシステム制御部と、

該システム制御部が決定した前記基準点に対する前記ユーザの位置の変化を検出する位置変化検出部と、

前記システム制御部からの指示に応じて所定の画像を表示する表示部と、を備え、

前記物体の大きさ検出部は、前記検出空間に定めた所定の位置のうち最も前記入力装置に近い所定位置における周辺の物体の大きさを検出し、該物体の大きさが所定値よりも大きい場合には、

前記システム制御部は、前記最も近い所定位置を操作の基準点と決定し、前記位置変化検出部における前記位置の変化の検出結果に基づき、前記表示部に表示する画像を変更することを特徴とする入力装置。

【請求項5】

請求項4に記載の入力装置において、前記システム制御部は、前記検出空間を複数の空間に分割し、分割された検出空間毎に前記物体大きさ検出部が検出した物体の大きさに対して異なる値の前記所定値を設定すること、を特徴とする入力装置。

【図1】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図13】

【図14】

【図15】

【図16】

【図17】

【図18】

【図19】

【図20】

【図21A】

【図21B】

【図22A】

【図22B】

【図22C】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図13】

【図14】

【図15】

【図16】

【図17】

【図18】

【図19】

【図20】

【図21A】

【図21B】

【図22A】

【図22B】

【図22C】

【公開番号】特開2013−45217(P2013−45217A)

【公開日】平成25年3月4日(2013.3.4)

【国際特許分類】

【出願番号】特願2011−181387(P2011−181387)

【出願日】平成23年8月23日(2011.8.23)

【出願人】(509189444)日立コンシューマエレクトロニクス株式会社 (998)

【Fターム(参考)】

【公開日】平成25年3月4日(2013.3.4)

【国際特許分類】

【出願日】平成23年8月23日(2011.8.23)

【出願人】(509189444)日立コンシューマエレクトロニクス株式会社 (998)

【Fターム(参考)】

[ Back to top ]