情報処理装置、および情報処理方法、並びにプログラム

【課題】ユーザ発話やジェスチャーにより、情報処理装置に様々な処理を実行させることを可能とした装置および方法を提供する。

【解決手段】ユーザ発話の音声解析処理や、ユーザ動作(ジェスチャー)を解析する画像解析を実行し、これらの解析結果に基づいて情報処理装置の実行する処理を決定する。さらに、ユーザ発話やユーザ動作に対する情報処理装置の認識結果を含む情報をフィードバック情報として表示または音声出力する。さらにユーザからの要求に対する情報処理装置の応答や、情報処理装置の処理状況等を、情報処理装置の代理であるアバターを介して表示、出力する。ユーザはこれらのフィードバック情報を取得することで、誤りの少ない確実な処理を実行できる。

【解決手段】ユーザ発話の音声解析処理や、ユーザ動作(ジェスチャー)を解析する画像解析を実行し、これらの解析結果に基づいて情報処理装置の実行する処理を決定する。さらに、ユーザ発話やユーザ動作に対する情報処理装置の認識結果を含む情報をフィードバック情報として表示または音声出力する。さらにユーザからの要求に対する情報処理装置の応答や、情報処理装置の処理状況等を、情報処理装置の代理であるアバターを介して表示、出力する。ユーザはこれらのフィードバック情報を取得することで、誤りの少ない確実な処理を実行できる。

【発明の詳細な説明】

【技術分野】

【0001】

本発明は、情報処理装置、および情報処理方法、並びにプログラムに関する。特に、ユーザの発話や動作に基づいて様々な処理を実行する情報処理装置、および情報処理方法、並びにプログラムに関する。

【背景技術】

【0002】

PCや、テレビ、録画再生機、その他、様々な家電製品を操作する場合、ユーザは、各装置に備えられた入力部やあるいはリモコンなどを操作して、所望の処理を装置に実行させる。例えばPCを利用する場合にはキーボードやマウスを入力デバイスとして用いることが多い。また、テレビや録画再生機などに対してはリモコンを用いて、様々な処理、例えばチャンネルの切り替えや再生コンテンツの選択などを行うことが多い。

【0003】

このような様々な装置に対する指示を、ユーザの発話や動作(ジェスチャー)によって実行するシステムについて、様々な研究がなされている。具体的には音声認識処理を用いてユーザの発話を認識するシステムや、画像処理を用いてユーザの行動やジェスチャーを認識するシステムなどである。

【0004】

リモコン、キーボート、マウス等の一般的な入力デバイスに加えて、音声認識や画像認識など、様々な複数のコミュニケーションモードを利用して、ユーザとのコミュニケーションを実行するインタフェースは、マルチモーダル・インタフェースと呼ばれる。マルチモーダル・インタフェースについて開示した従来技術として、例えば、特許文献1(US特許6988072号公報)がある。

【0005】

しかしながら、このようなマルチモーダル・インタフェース等において利用される音声認識装置や画像認識装置は処理能力に限界があり、理解できるユーザの発話や動作が限られてしまう。従って、ユーザの意思がシステム側に伝わらない場合が多いというのが現状である。

【先行技術文献】

【特許文献】

【0006】

【特許文献1】US特許第6,988,072号公報

【発明の概要】

【発明が解決しようとする課題】

【0007】

本発明は、例えば上記問題点に鑑みてなされたものであり、ユーザの発話や動作(ジェスチャー)などの音声情報や画像情報を情報処理装置が入力して処理を実行する構成において、ユーザと装置とのコミュニケーションの実行中にユーザに様々なフィードバック情報を提供することでシステムとユーザ間の相互理解度を高め、ユーザ要求の正確な理解に基づく正確な処理の実行を可能とした情報処理装置、および情報処理方法、並びにプログラムを提供することを目的とする。

【課題を解決するための手段】

【0008】

本発明の第1の側面は、

ユーザ発話の解析処理を実行する音声解析部と、

前記音声解析部の解析結果を入力し、情報処理装置の実行する処理を決定するデータ処理部を有し、

前記データ処理部は、

ユーザ発話に関する情報処理装置の認識結果を示すフィードバック情報を生成して出力する処理を行う情報処理装置にある。

【0009】

さらに、本発明の情報処理装置の一実施態様において、前記情報処理装置は、ユーザ動作を解析する画像解析部を有し、前記データ処理部は、前記画像解析部の解析結果を入力し、情報処理装置の実行する処理を決定し、ユーザ動作に関する情報処理装置の認識結果を示すフィードバック情報を生成して出力する処理を行う。

【0010】

さらに、本発明の情報処理装置の一実施態様において、前記データ処理部は、前記データ処理部は、前記フィードバック情報として、ユーザ発話の音声認識結果を示すユーザ発話内容、または、ユーザ動作に基づいて情報処理装置が認識した要求内容を出力する。

【0011】

さらに、本発明の情報処理装置の一実施態様において、前記データ処理部は、前記フィードバック情報として、ユーザ発話またはユーザ動作に対する情報処理装置の応答または情報処理装置の装置状態を示す情報を出力する。

【0012】

さらに、本発明の情報処理装置の一実施態様において、前記データ処理部は、前記フィードバック情報として、ユーザ発話またはユーザ動作に対する情報処理装置の応答または情報処理装置の装置状態を示す情報を、情報処理装置の代理としてのアバターを介して出力する。

【0013】

さらに、本発明の情報処理装置の一実施態様において、前記データ処理部は、前記フィードバック情報として、ユーザ発話またはユーザ動作に対する情報処理装置の状況を示すため、情報処理装置の代理としてのアバターの表示態様を変更する処理を行う。

【0014】

さらに、本発明の情報処理装置の一実施態様において、前記データ処理部は、ユーザによるデータ入力が可能な情報入力領域を表示部に出力し、かつ、該情報入力領域に入力可能なデータについてのガイド情報を表示する処理を行う。

【0015】

さらに、本発明の情報処理装置の一実施態様において、前記データ処理部は、前記画像解析部における画像解析結果に基づいてユーザ識別処理を実行し、識別ユーザのユーザ画像と、情報処理装置の代理としてのアバターを表示部に表示して、双方の対話内容を表示する。

【0016】

さらに、本発明の第2の側面は、

情報処理装置において、情報処理を実行する情報処理方法であり、

音声解析部が、ユーザ発話の解析処理を実行する音声解析ステップと、

データ処理部が、前記音声解析ステップにおける解析結果を入力し、情報処理装置の実行する処理を決定するデータ処理ステップを有し、

前記データ処理ステップは、

ユーザ発話に関する情報処理装置の認識結果を示すフィードバック情報を生成して出力する処理を行うステップを含む情報処理方法にある。

【0017】

さらに、本発明の第3の側面は、

情報処理装置において、情報処理を実行させるプログラムであり、

音声解析部に、ユーザ発話の解析処理を実行させる音声解析ステップと、

データ処理部に、前記音声解析ステップにおける解析結果を入力させ、情報処理装置の実行する処理を決定させるデータ処理ステップを有し、

前記データ処理ステップは、

ユーザ発話に関する情報処理装置の認識結果を示すフィードバック情報を生成して出力する処理を行わせるステップを含むプログラムにある。

【0018】

なお、本発明のプログラムは、例えば、様々なプログラム・コードを実行可能な情報処理装置やコンピュータ・システムに対して、コンピュータ可読な形式で提供する記憶媒体、通信媒体によって提供可能なプログラムである。このようなプログラムをコンピュータ可読な形式で提供することにより、情報処理装置やコンピュータ・システム上でプログラムに応じた処理が実現される。

【0019】

本発明のさらに他の目的、特徴や利点は、後述する本発明の実施例や添付する図面に基づくより詳細な説明によって明らかになるであろう。なお、本明細書においてシステムとは、複数の装置の論理的集合構成であり、各構成の装置が同一筐体内にあるものには限らない。

【発明の効果】

【0020】

本発明の一実施例の構成によれば、ユーザ発話やジェスチャーにより、情報処理装置に様々な処理を実行させることを可能とした装置および方法が提供される。ユーザ発話の音声解析処理や、ユーザ動作(ジェスチャー)を解析する画像解析を実行し、これらの解析結果に基づいて情報処理装置の実行する処理を決定する。さらに、ユーザ発話やユーザ動作に対する情報処理装置の認識結果を含む情報をフィードバック情報として表示または音声出力する。さらにユーザからの要求に対する情報処理装置の応答や、情報処理装置の処理状況等を、情報処理装置の代理であるアバターを介して表示、出力する。ユーザはこれらのフィードバック情報を取得することで、誤りの少ない確実な処理を実行できる。

【図面の簡単な説明】

【0021】

【図1】本発明の情報処理装置の利用例について説明する図である。

【図2】本発明の情報処理装置の構成例を示すブロック図である。

【図3】本発明の情報処理装置の実行する処理例について説明する図である。

【図4】本発明の情報処理装置の実行する処理例について説明する図である。

【図5】本発明の情報処理装置の実行する処理例について説明する図である。

【図6】本発明の情報処理装置の実行する処理であるアバターの表示例について説明する図である。

【図7】本発明の情報処理装置の実行する処理例について説明する図である。

【図8】本発明の情報処理装置の実行する処理例について説明する図である。

【図9】本発明の情報処理装置の実行する処理例について説明する図である。

【図10】本発明の情報処理装置の実行する処理例について説明する図である。

【図11】本発明の情報処理装置の実行する処理例について説明する図である。

【図12】本発明の情報処理装置の実行する処理例について説明する図である。

【図13】本発明の情報処理装置の実行する処理例について説明する図である。

【図14】本発明の情報処理装置がユーザ発話に対応して実行する処理例について説明する図である。

【図15】本発明の情報処理装置がユーザ発話に対応する処理の実行中に行うアバター表示の変更例について説明する図である。

【図16】本発明の情報処理装置がユーザ動作(ジェスチャー)に対応して実行する処理例について説明する図である。

【図17】本発明の情報処理装置がユーザ動作(ジェスチャー)に対応する処理の実行中に行うアバター表示の変更例について説明する図である。

【図18】本発明の情報処理装置のハードウェア構成例について説明する図である。

【発明を実施するための形態】

【0022】

以下、図面を参照しながら本発明の情報処理装置、および情報処理方法、並びにプログラムの詳細について説明する。なお、説明は以下の項目に従って行う。

1.本発明の情報処理装置の実行する処理の概要について

2.本発明の情報処理装置の構成例について

3.ユーザに対するフィードバックおよび誘導(ガイド)による相互理解の向上を行う処理例について

(3−1)アバターを利用したフィードバック処理例

(3−2)ユーザの入力可能な情報についての誘導(ガイド)を行う処理例

(3−3)ユーザに対するフィードバック情報と誘導(ガイド)情報を併せて利用する処理例

(3−4)ユーザ同定処理について

4.ユーザに対するフィードバックにより、ユーザ入力の必要性や入力タイミングを理解させる処理例について

(4−1)ユーザの発話に対するフィードバック処理例について

(4−2)ユーザの動作(ジェスチャー)に対するフィードバック処理例について

5.情報処理装置のハードウェア構成例について

【0023】

[1.本発明の情報処理装置の実行する処理の概要について]

まず、図1を参照して本発明の情報処理装置の実行する処理の概要について説明する。図1には、本発明に係る情報処理装置の例としてテレビを示している。情報処理装置100は、例えば、放送コンテンツの表示処理の他、内蔵する録画再生機器、例えばハードディスク、DVDやBlu−rayディスク等に記録されたコンテンツの再生処理や、録画再生機器に対する番組の録画処理などを実行する。

【0024】

情報処理装置100の前には、複数のユーザがいる。図に示す例では、ユーザa,11、ユーザb,12、ユーザc,13がいる。これらのユーザは、情報処理装置100に対して、様々な要求を行う。例えばチャンネルの切り替え、ボリュームの調整、録画処理の開始、あるいは記録コンテンツの一覧リストの表示、リストからのコンテンツの選択再生要求などである。再生の停止、早送りなどの要求である。

【0025】

ユーザは、これらの要求を音声、すなわち発話によって行う。情報処理装置100は、カメラ101、マイクとスピーカを備えた音声入出力部102を有する。ユーザa〜c,11〜13の発する言葉は、マイクとスピーカを備えた音声入出力部102を介して情報処理装置100内に入力される。また、ユーザa〜c,11〜13の画像は、カメラ101を介して情報処理装置100内に入力される。

【0026】

情報処理装置101は、これらの入力情報を解析して、装置が実行すべきアクションを決定し、実行する。ユーザの要求が理解できた場合は、その要求に応じた処理を実行する。例えばチャンネルの切り替えやコンテンツの選択再生処理などである。

【0027】

さらに、情報処理装置101は、ユーザとのコミュニケーションの実行中、逐次、ユーザに対するフィードバック処理を実行する。例えばユーザの発話の内容の確認表示や、情報処理装置の応答などをユーザに提供する。具体的には、例えばユーザの要求が理解できない場合、あるいは実行できない場合などにおいて、ユーザに対して、その状況を説明するためのフィードバック処理を行う。これらの具体的な処理については後段で説明する。

【0028】

[2.本発明の情報処理装置の構成例について]

次に、図2を参照して本発明の情報処理装置の構成例について説明する。図2に示す情報処理装置100は、例えば図1に示す情報処理装置100に対応する。なお、本発明の情報処理装置はテレビに限らず、PCや、録画再生機、その他、様々な家電製品として実現可能である。すなわち、ユーザ要求に応じて様々な処理を行う情報処理装置である。

【0029】

図2に示すように情報処理装置100は、音声入力部(マイク)201、音声解析部202、画像入力部(カメラ)203、画像解析部204、データ処理部205、音声出力部(スピーカ)206、画像出力部(表示部)207を有する。

【0030】

音声入力部(マイク)201は、情報処理装置200の周囲の音声情報、例えばユーザの発話を入力する。音声入力部(マイク)201の入力した音声情報は音声解析部202に入力される。音声解析部202は、音声解析用の辞書を記憶部内に有しており、ユーザの発話した単語を、辞書を用いて解析し、解析情報をデータ処理部205に入力する。

【0031】

画像入力部(カメラ)203は、情報処理装置200の周囲の画像、例えばユーザの画像を入力する。画像入力部(カメラ)203の撮影した画像は画像解析部204に入力される。画像解析部204は、例えば、予め記憶部に格納済みのユーザの顔情報などの登録情報を用いて、撮影画像に含まれるユーザの識別処理を実行する。具体的には、ユーザの位置、ユーザが誰であるかなどの情報を解析する。この解析情報がデータ処理部205に入力される。

【0032】

データ処理部205では、音声解析部202から音声解析情報を入力し、画像解析部204から画像解析情報を入力し、入力情報に従って、情報処理装置が実行する処理(アクション)を決定する。すなわち、前述したように、ユーザの要求が理解できた場合は、その要求に応じた処理を実行する。例えばチャンネルの切り替えやコンテンツの選択再生処理などである。

【0033】

さらに、データ処理部205は、ユーザ発話やユーザ動作(ジェスチャー)に関する情報処理装置の認識結果等を示すフィードバック情報を生成して出力する処理を行う。例えばユーザの要求が理解できない場合、あるいは実行できない場合などに、状況を説明するためのフィードバック情報を生成し、生成したフィードバック情報を表示し、音声出力する。

【0034】

フィードバック処理は、音声出力部(スピーカ)206を介した音声出力、あるいは画像出力部(表示部)207を介した画像出力のいずれか、あるいはその組み合わせによって行われる。この具体的な内容については、以下において詳細に説明する。

【0035】

[3.ユーザに対するフィードバックおよび誘導(ガイド)による相互理解の向上を行う処理例について]

次に、本発明の情報処理装置の実行する処理例として、ユーザに対するフィードバックおよび誘導(ガイド)による相互理解の向上を行う処理例について説明する。

【0036】

先に説明したように、音声認識や画像認識を適用したマルチモーダル・インタフェースでは、利用される音声認識装置や画像認識装置の処理能力に限界があり、理解できるユーザの発話や動作(ジェスチャー)が限られてしまう。この結果、ユーザの意思がシステム側に伝わらず、ユーザの意思に応じた処理が実行されない場合が発生するという問題がある。以下に説明する処理例は、このような問題を解決する処理例であり、具体的には、ユーザに対するフィードバックおよび誘導(ガイド)による相互理解の向上を行う処理例である。

【0037】

以下では、ユーザに対するフィードバックおよび誘導(ガイド)による相互理解の向上を行う処理例として、以下の3つの具体的処理例について順次説明する。

(3−1)アバターを利用したフィードバック処理例

(3−2)ユーザの入力可能な情報についての誘導(ガイド)を行う処理例

(3−3)ユーザに対するフィードバック情報と誘導(ガイド)情報を併せて利用する処理例

(3−4)ユーザ同定処理について

【0038】

(3−1)アバターを利用したフィードバック処理例

まず、情報処理装置の代理としてのアバターを利用したフィードバック処理例について説明する。

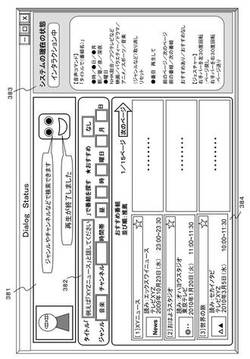

図3を参照して、情報処理装置の実行する具体的な処理例について説明する。

図3は、例えば図1に示すテレビ等の情報処理装置100の表示部の表示例を示している。情報処理装置100は、ユーザの発話やジェスチャーを解析して、解析結果に応じた処理を実行する。例えばチャンネルの変更や、コンテンツの選択再生処理、録画処理などである。

【0039】

図3は、ユーザが発話または動作(ジェスチャー)に基づいて処理要求を実行し、情報処理装置100がこれらの発話や動作(ジェスチャー)を入力して解析を行い、ユーザに対するフィードバック処理として実行した表示部に対するデータ表示例を示している。

【0040】

表示部には、フィードバック情報表示領域300が設定される。フィードバック情報表示領域300には、情報処理装置100とのコミュニケーションを実行するユーザのユーザ画像301がユーザ識別情報として提示される。

【0041】

このユーザ画像301は、図2に示す画像解析部204が、画像入力部203を介して入力した画像から識別した人の顔に基づいて、予め登録した顔画像データとのマッチング処理を実行して特定した画像である。なお、フィードバック情報表示領域300に提示するユーザ画像301は、画像入力部203が撮影している生の画像であってもよいし、情報処理装置100の記憶部に格納された登録済みの画像でもよい。

ユーザは、このユーザ画像301を見て、情報処理装置100が認識したユーザが自分であることを確認できる。

例えば、自分でないユーザの顔がユーザ画像301として表示された場合は、ユーザは「ユーザが違います」といった発話等による入力を行って、情報処理装置100に対して、ユーザの誤認を通知することができる。

【0042】

フィードバック情報表示領域300には、さらに、ユーザとの対話の相手として認識可能なアバター(仮想キャラクタ)303が提示される。このアバター(仮想キャラクタ)303は情報処理装置100の代理としてユーザとの会話を行う仮想キャラクタである。

【0043】

このアバター303の提示により、ユーザは、対話の相手を装置ではなく、アバターであると想定することができ、より親しみやすい対話が実現される。

なお、アバター303は、ユーザの入力(発話や動作)の理解レベルや情報処理装置100の実行する処理などに応じて、その表情を変化させる。ユーザは、アバターの表情の変化に基づいて、情報処理装置の状況等を知ることができる。この具体例については後述する。

【0044】

フィードバック情報表示領域300には、さらに、ユーザからの発話等によるユーザ入力情報302の表示がなされる。このユーザ入力情報は、ユーザの発話やジェスチャーを情報処理装置100が解釈した結果としてのデータである。例えば、ユーザ発話の音声認識結果に基づくユーザ発話の内容、あるいは画像解析によって得られたユーザの動作(ジェスチャー)に基づいて情報処理装置が認識した要求内容である。

【0045】

情報処理装置100の解釈が誤っていれば、その誤った情報が表示される。

ユーザは、このユーザ入力情報302の表示に基づいて、情報処理装置100が正しく要求を理解したか否かを判断することができる。

例えば、ユーザの実際の要求と異なるユーザ入力情報302の表示がなされた場合は、ユーザは「要求が違います」といった発話等による入力を行って、情報処理装置100に対して、ユーザ入力の誤認を通知することができる。

【0046】

さらに、フィードバック情報表示領域300には、アバター303の発話として、情報処理装置の応答や装置状態を示す装置処理情報304の表示がなされる。この装置処理情報304は、図に示す例では、「再生します」となっている。

これは、ユーザ入力「移動コマンド:6番目再生」に対応した情報処理装置100側の処理である。

情報処理装置100の解釈が誤っていれば、その誤った処理情報が表示される。

ユーザは、この装置処理情報304の表示に基づいて、情報処理装置100が正しく要求を理解し、ユーザ要求に応じた正しい処理を行おうとしているか否かを判断することができる。

例えば、ユーザの実際の要求と異なる処理に対応する装置処理情報304の表示がなされた場合は、ユーザは「処理が違います」といった発話等による入力を行って、情報処理装置100に対して、実行する処理が誤っていることを通知することができる。

【0047】

このように、本発明の情報処理装置では、

ユーザ画像301の提示によるユーザ同定処理の正否の確認、

ユーザ入力情報302の表示によるユーザ入力の解釈の正否の確認、

アバター303と、装置処理情報304の表示による情報処理装置の状態の確認、

これらの情報をユーザに対するフィードバック情報として提示する。

ユーザはこれらのフィードバック情報に基づいて、情報処理装置100がユーザおよびユーザ要求を正しく理解しているか否かを容易に把握することができ、誤りがある場合は誤りを具体的に情報処理装置に対して通知することが可能となる。

【0048】

現状の音声認識や画像認識を適用したマルチモーダル・インタフェースにおける問題点と、本発明の情報処理装置の実行する処理との対応関係について、図4に示す表を参照して説明する。

現状の問題点として、例えば、図4に示す(1)〜(4)がある。

【0049】

例えば、(1)インタラクション開始・終了変遷が分かりにくいという問題点である。

本発明の情報処理装置は、この問題点を解決するため、インタラクション状態を表示して、現在の状態を確認可能とする。具体的には、図3に示すような、ユーザ画像301、ユーザ入力情報302、アバター303、装置処理情報304の表示である。

【0050】

また、現状の問題点として、(2)困った時にどうすれば分からないという問題がある。この問題点を解決するため、本発明の情報処理装置は、装置(システム)側の代理としてのアバター(仮想キャラクタ)を表示して、アバターに対して質問できる環境を設定している。

【0051】

さらに、現状の問題点として、(3)装置(TVなど)に対して話す違和感があるという問題点がある。この問題点を解決するため、本発明の情報処理装置は、装置(システム)側の代理としてのアバター(仮想キャラクタ)を設定している。

【0052】

さらに、現状の問題点として、(4)ユーザへのフィードバックが不足しているという問題点がある。この問題点を解決するため、本発明の情報処理装置は、アバター経由で逐次、フィードバック情報を提供するという構成としている。

【0053】

図4に示す(4)ユーザへのフィードバックが不足しているという問題点に対しては、本発明の情報処理装置では、図3に示すアバター303を用いて逐次、フィードバック情報を提供する。なお、アバター303の発話は、表示部に表示するのみではなく、音声情報として音声出力部(スピーカ)206からも出力される。

【0054】

アバター303を適用したフィードバック処理の具体例について図5を参照して説明する。

図5には、

(X)ユーザに対するフィードバック不足の態様

(Y)アバター経由のフィードバック情報の内容

(Z)アバターの表情と装置処理情報の出力例

これらの対応データを示している。

【0055】

(X)ユーザに対するフィードバック不足の態様としては、例えば図5に示す(a)〜(d)がある。

(a)いつ話せばいいかが分からない?

(b)発話が装置(システム)に入力されたか否かが分からない?

(c)発話が装置(システム)に理解されたか否かが分からない?

(d)発話に基づく処理を装置(システム)が実行しているか否かが分からない?

例えば、これら(a)〜(d)のようなフィードバック情報不足に基づくユーザが困る状況が発生する。

【0056】

本発明の情報処理装置100のデータ処理部205は、これらのフィードバック情報不足を解消するフィードバック情報を生成して出力する。

具体的には、

(a)いつ話せばいいかが分からない?

この問題に対して、

図5(Z)に示すように、アバターの発話として「指示お願いします」といった発話の出力(表示と音声出力)を実行する。

このような処理によって(Y)に示すように、装置(システム)がユーザ発話の待機状態であることを示すような構成としている。

【0057】

(b)発話が装置(システム)に入力されたか否かが分からない?

この問題に対して、

図5(Z)に示すように、アバターの発話として「話を聴いています」といった発話の出力(表示と音声出力)を実行する。さらに、アバターの耳を大きくするなど、強調表示しての聞いている状態にあることを視覚的に理解可能としたアバター表示を行う。

このような処理によって(Y)に示すように、装置(システム)がユーザ発話を聴いていることを示す構成としている。

【0058】

(c)発話が装置(システム)に理解されたか否かが分からない?

この問題に対して、

図5(Z)に示すように、アバターの発話として「分かりました」といった発話の出力(表示と音声出力)を実行する。さらに、アバターの表情を笑顔にするなど、理解したことを視覚的に示したアバター表示を行う。

このような処理によって(Y)に示すように、装置(システム)がユーザ発話を理解したことを示す構成としている。

【0059】

(d)発話に基づく処理を装置(システム)が実行しているか否かが分からない?

この問題に対して、

図5(Z)に示すように、アバターの発話として「処理中です」といった発話の出力(表示と音声出力)を実行する。この処理によって(Y)に示すように、装置(システム)がユーザ発話に基づく処理を実行中であることを示す構成としている。

【0060】

なお、アバターの表情は、情報処理装置100の処理状態に応じた様々な設定とする。図6にその一部の例を示す。図6のアバター例は上から以下の設定としたアバター表示例である。

(a)ユーザの話を聞いている状態であることを示すアバターの表示例であり、耳を強調表示したアバターの表示例である。

(b)ユーザの話を理解して、行動する状態であることを示すアバターの表示例であり、笑顔を示すアバターの表示例である。

(c)ユーザの話がよく聞こえなかった状態であることを示すアバターの表示例であり、聞こえてない困った表情を設定したアバターの表示例である。

(d)ユーザの話が理解できなかった状態であることを示すアバターの表示例であり、理解できずに困った状態である表情を示したアバターの表示例である。

【0061】

(3−2)ユーザの入力可能な情報についての誘導(ガイド)を行う処理例

次に、ユーザの入力可能な情報についての誘導(ガイド)を行う処理例について説明する。

【0062】

ユーザが、例えば図1に示す情報処理装置100に対して、何らかの録画済みコンテンツを再生する場合、コンテンツを検索する処理が必要となる。この検索の際には、様々な検索条件を設定することで、効率的な検索が実現される。

本発明の情報処理装置は、例えばこのようなコンテンツ検索の際の指定条件をカテゴリ単位で、どのような選択条件の指定ができるか等の情報をユーザに提供する。

【0063】

具体的な処理例について、図7以下を参照して説明する。

図7は、再生コンテンツの選択処理に際して情報処理装置100の表示部に表示されるガイド付き情報入力領域350の表示例である。

【0064】

コンテンツ検索を実行する場合の指定可能な情報は、図に示すように、タイトル、おすすめの有無、ジャンル、チャンネル、時間帯、例えば、これらの情報がある。

しかし、これらの情報入力欄に、実際どのような情報が入力む可能であるかについては、初心者は分かりづらい。

【0065】

本発明の情報処理装置では、このような状況に鑑み、各情報入力欄にどのような情報が入力できるかを示す誘導情報(ガイド情報)を表示する。なお、この表示に併せて音声出力も実行する。

【0066】

例えば、最初のタイトル情報の入力欄に対する入力時に、「例えばXYZニュースと入力してください」と表示する。ユーザは、この表示を見て、番組名を入力すればよいことが理解でき、即座に正しい入力を行うことができる。なお、入力は例えばユーザの発話によって行われる。

【0067】

その他の情報入力欄に対する誘導情報(ガイド情報)の表示例を図8に示す。

図8に示すように、タイトル情報の入力欄には、「例えばXYZニュースと入力してください」と表示する。これは、図7を参照して説明したと同様である。

おすすめ情報入力欄には、「あり」「なし」のいずれかを提示する。あるいは、「あり」「なし」の切り替え表示を行う。ユーザ入力によって確定した場合は、切り替え表示から確定データの常時表示に切り換える。

ジャンル欄には、アニメ。スポーツ、・・・音楽、これらの登録されたジャンル情報のいずれか、あるいは、切り換えて繰り返し表示する。ユーザ入力によって確定した場合は、確定情報を常時表示する。

【0068】

チャンネル欄には、NHK総合、・・・、複数の登録されたチャンネル情報のいずれか、あるいは、繰り返し切り換えて表示する。ユーザ入力によって確定した場合は、確定情報を常時表示する。

時間帯、時間、曜日情報についても、それぞれ入力可能な情報のいずれか、あるいは、切り換えて順次表示する。ユーザ入力によって確定した場合は、確定情報を常時表示する。

【0069】

このように、各入力欄に対して、入力可能な情報をユーザに示すことで、ユーザは具体的に入力可能な情報を知ることが可能となり、迷うことなく正しい情報を入力することができる。

【0070】

図7、図8を参照して説明した誘導情報(ガイド情報)の表示例は、ガイド付き情報入力領域350であり、実際の情報入力欄に誘導情報(ガイド情報)を埋め込んで表示する例であるが、このような処理例の他、情報入力欄と異なる独立したガイド情報表示領域を設定して誘導情報(ガイド情報)を表示する構成としてもよい。

【0071】

具体的には、例えば、図9に示すガイド情報表示領域370のような表示例である。ガイド情報表示領域370には、装置の処理状況を示す装置状態表示欄371と、ガイド情報表示欄372が設定される。

【0072】

装置状態表示欄371には、例えば、図に示すように、装置の実行している処理についての説明を表示する。この例では、ユーザとの「インタラクション中」であることを示した例を示している。

ガイド情報表示欄372には、先に、図7、図8を参照して説明したユーザ入力の態様等についての説明を表示する。

図に示す例では、ユーザの発話に基づく入力の仕方についての説明をガイド情報表示欄372の上部の「音声コマンド」の欄に表示し、ユーザの動作(ジェスチャー)に基づく入力の仕方についての説明をガイド情報表示欄372の下部の「ジェスチャー」の欄に表示している。

ユーザは、これらの説明を見て、各データ入力欄に対して容易に正しい入力を行うことが可能となる。

【0073】

(3−3)ユーザに対するフィードバック情報と誘導(ガイド)情報を併せて利用する処理例

次に、上述したユーザに対するフィードバック情報と誘導(ガイド)情報を併せて利用する処理例について図10を参照して説明する。

図10は、例えば図1のテレビなどの情報処理装置100の表示部の表示データの例を示す図である。

【0074】

図10に示す表示データは、

アバターとの対話設定を可能としたフィードバック情報表示領域381、

各データ入力欄単位で誘導(ガイド)情報を表示したガイド付き情報入力領域382、

独立した誘導(ガイド)情報を表示したガイド情報表示領域383、

コンテンツリスト表示領域384、

これらの各領域によって構成されている。

【0075】

この表示例は、コンテンツリスト表示領域384に表示されたコンテンツから再生コンテンツを選択するための処理を行う場合に表示部に表示するデータの例である。

【0076】

アバターとの対話設定を可能としたフィードバック情報表示領域381は、先に、図3〜図6を参照して説明した[(3−1)アバターを利用したフィードバック処理例]に対応するフィードバック情報の表示領域である。

各データ入力欄単位で誘導(ガイド)情報を表示したガイド付き情報入力領域382は、先に、図7〜図8を参照して説明した[(3−2)ユーザの入力可能な情報についての誘導(ガイド)を行う処理例]に対応する誘導(ガイド)情報の表示領域である。

独立した誘導(ガイド)情報を表示したガイド情報表示領域383は、先に、図9を参照して説明した[(3−2)ユーザの入力可能な情報についての誘導(ガイド)を行う処理例]に対応する誘導(ガイド)情報の表示領域である。

【0077】

これらの各情報を併せて表示することで、ユーザは迷うことなく情報処理装置に対する指示を発話またはジェスチャーによって行うことができる。

【0078】

(3−4)ユーザ同定処理について

次に、ユーザ同定処理について説明する。例えば、図1のような環境では、情報処理装置100の前に複数のユーザが存在する。ユーザa11〜ユーザc13である。情報処理装置100は、カメラ101(=図2の画像入力部(カメラ)203)を介して、情報処理装置100の前の画像を取得し、図2に示す画像解析部204において、あらかじめ記憶部に格納されたユーザの顔画像との比較を実行して、ユーザの識別処理を実行する。図2に示すデータ処理部205は、この識別結果のフィードバック情報を生成する。

【0079】

具体的には、例えば図11に示すような識別ユーザの表示を実行する。図11は、情報処理装置100の表示部の表示データ例である。図11に示す例では、情報処理装置100が認識したユーザの画像として2つのユーザ画像391,392が表示されている。

【0080】

ユーザ画像391,392は、ユーザ識別処理によって識別されたユーザの登録画像、すなわち情報処理装置の記憶部に格納済みの登録画像データを表示してもよいし、カメラによって撮影中のユーザ画像を表示してもよい。

【0081】

この図11に示す識別ユーザの表示画面に、さらに、各ユーザからの発話の認識結果を表示する。この表示処理は、先に、図3〜図6を参照して説明した[(3−1)アバターを利用したフィードバック処理例]におけるユーザ入力情報302(図3参照)と同様の表示処理として行われる。

なお、どのユーザが話したかについては、音声解析部202における音声解析処理、すなわち予め情報処理装置100に格納されているユーザ単位の音声特徴情報との呼格処理によって実行される。また画像解析部204において画像から口の動きを解析してその解析結果を利用してもよい。

【0082】

図11に示す例では、ユーザ画像391に示される「まことくん」が発話を行っている。「まことくん」は情報処理装置100に対応するアバターに対してよびかけを実行している。アバターに対してはニックネームが設定可能であり、設定されたニックネームは情報処理装置に登録される。図11に示す例は情報処理装置100に対応するアバターのニックネームとして「テレビくん」が設定されている場合の例である。

このニックネームの呼びかけを情報処理装置100の音声解析部202が検出するとデータ処理部205は、例えば図12に示す表示データを表示する。

【0083】

図12にはアバター395がユーザー(まことくん)からの呼びかけに答える設定であり、アバター(テレビくん)がユーザー(まことくん)にあいさつ「こんにちは まことくん」という発話を行った例である。なお、この発話は、情報処理装置100の音声出力部(スピーカ)206を介しても出力される。

【0084】

ユーザは、図11、図12に示す画面を見ることで、情報処理装置100が自分を正しく認識し、自分の発話が正しく理解されているか否かを把握することができる。

この図11、図12に示す画面は、例えば初期画面であり、情報処理装置の起動時などに表示される。

この図11、図12に示す初期画面の出力後、ユーザは情報処理装置に対して、様々な要求を発話またはジェスチャーによって入力する。

【0085】

(3−5)ユーザ同定処理について

図13を参照して、本発明の情報処理装置100の表示部に表示される画面遷移の具体的な例について説明する。

図13には、

(A)初期画面

(B)入力画面

(C)再生画面

これらの3つの画面表示例を示している。

【0086】

(A)初期画面は、図11、図12を参照して説明した処理[(3−4)ユーザ同定処理]によって表示される画面である。

情報処理装置100の画像解析部204におけるユーザ画像の解析と、音声解析部202におけるユーザ発話の解析情報を用いて、データ処理部205が生成する初期画面である。

ユーザは、この画面を見ることで、自分が装置に正しく認識され、自分の要求が装置に正しく伝わっていることを確認することができる。

【0087】

(B)入力画面は、先に図10を参照して説明した画面に対応する。

アバターとの対話設定を可能としたフィードバック情報表示領域、

各データ入力欄単位で誘導(ガイド)情報を表示したガイド付き情報入力領域、

独立した誘導(ガイド)情報を表示したガイド情報表示領域、

コンテンツリスト表示領域、

これらの各領域によって構成されている。

この表示例は、コンテンツリスト表示領域に表示されたコンテンツから再生コンテンツを選択するための処理を行う場合に表示部に表示するデータの例である。

【0088】

アバターとの対話設定を可能としたフィードバック情報表示領域は、先に、図3〜図6を参照して説明した[(3−1)アバターを利用したフィードバック処理例]に対応するフィードバック情報の表示領域である。

各データ入力欄単位で誘導(ガイド)情報を表示したガイド付き情報入力領域は、先に、図7〜図8を参照して説明した[(3−2)ユーザの入力可能な情報についての誘導(ガイド)を行う処理例]に対応する誘導(ガイド)情報の表示領域である。

独立した誘導(ガイド)情報を表示したガイド情報表示領域は、先に、図9を参照して説明した[(3−2)ユーザの入力可能な情報についての誘導(ガイド)を行う処理例]に対応する誘導(ガイド)情報の表示領域である。

これらの各情報を併せて表示することで、ユーザは迷うことなく情報処理装置に対する指示を発話またはジェスチャーによって行うことができる。

【0089】

(C)再生画面は、(B)入力画面を利用してユーザが選択した番組(コンテンツ)を再生している画面の例である。このコンテンツ再生表示の場合は、再生コンテンツを全画面表示する表示パターンと、図に示すように再生コンテンツに併せて、アバターとの対話設定を可能としたフィードバック情報表示領域と、独立した誘導(ガイド)情報を表示したガイド情報表示領域を表示するパターンとを切り換えることができる。

この状態においてもユーザは、アバターとの会話が可能であり、例えば再生コンテンツの切り替え要求などを随時実行することができる。

【0090】

[4.ユーザに対するフィードバックにより、ユーザ入力の必要性や入力タイミングを理解させる処理例について]

次に、ユーザに対するフィードバック処理を実行して、ユーザ入力の必要性や入力タイミングをユーザに理解させる処理例について説明する。

【0091】

上述の実施例において、アバターを利用したユーザと装置との対話や、様々なデータ入力領域に対するガイド表示によって、ユーザの入力を正確に行わせる処理例を説明した。

しかし、このような構成を提供しても、100%誤りのないユーザ入力が行われる保証はない。必ず、何らかの入力ミスが発生し、また、ユーザの意図とは異なる情報処理装置の処理が開始される場合もある。

具体的には音声解析のエラーが発生した場合には、ユーザの発話に対して情報処理装置が全く処理を開始できない場合が発生する。

また、情報処理装置の前に複数のユーザがいる場合、情報処理装置に対して話かけたユーザと異なる無関係のユーザの発話に対して処理を開始してしまうといった場合も発生する可能性がある。

また、ユーザの要求が情報処理装置の実行可能な処理でない場合もある。

【0092】

このようにユーザと情報処理装置とのコミュニケーションには、エラー発生要因が多々、存在する。以下において説明する処理は、このようなトラブル発生時に、最適な対応としてのユーザに対するフィードバックを行う処理例である。

具体的には、図2に示す情報処理装置のデータ処理部205は、ユーザ発話やユーザ動作(ジェスチャー)に基づく処理において処理継続の阻害要因が発生した場合、阻害要因が発生した処理ステージに対応したフィードバック情報を生成して出力する処理を行う。

【0093】

(4−1)ユーザの発話に対するフィードバック処理例について

例えば本発明のシステムは、ユーザ発話を音声認識によって解析し、解析結果に基づいて情報処理装置の処理を決定する。

この音声認識による処理決定までのプロセスにおいては、複数の異なる処理を連続的に実行することが必要となる。すなわち複数の処理ステージをパイプライン処理としてシーケンシャルに実行することが必要である。

複数の処理ステージが順調に進めば、最終的な処理、例えばユーザに対する応答が出力される。具体的にはアバターの出力が画像として表示、あるいは音声出力される。

【0094】

しかし、パイプライン処理のいずれかの処理ステージにおいて、処理エラーが発生すると、最終的な処理であるアバターの応答はいつまでたっても実行されないことになってしまう。

このような場合、ユーザは、ただ待機するしかなく、情報処理装置の状態について知ることができない。

【0095】

以下において説明する処理例は、情報処理装置の実行する複数の処理ステージの各々において発生するエラーの状況等をユーザに逐次、フィードバックすることで、ユーザが装置(システム)状態を常に把握することを可能としたものである。

【0096】

図14を参照してユーザ発話に対する情報処理装置の処理例について説明する。

図14は、ユーザ501が何らかの発話を実行した場合に情報処理装置が実行する処理に含まれる処理ステージを実行順に従って示した図である。

すべての処理が進めば、最終的な処理として、アバター502がユーザに対して何らかの発話を行う場合の処理例である。

【0097】

図14に示すように、ユーザ発話を入力した情報処理装置は、ステップS101において音響分析を実行する。この処理は、図2に示す音声解析部202の処理である。音響分析処理に際しては、音声以外の音を棄却し、人の声のみを取得する処理が行われる。音声ではないと判断され棄却された音データについては、後段の処理は行われない。しかし、このような棄却データが実際はユーザの発話データである場合がある。このような場合は、ユーザの意図に従った処理が実行されない事態が発生してしまう。

【0098】

ステップS102において、取得した音声情報に基づく意味抽出処理が実行される。この処理も図2に示す音声解析部202の処理である。この処理は、例えば音声解析部202の保持する辞書データとのマッチング処理をベースとして行われる。この処理において、マッチする登録単語がない場合などには、無意味な発話としてデータが棄却される。棄却された音データについては、後段の処理は行われない。しかし、このような棄却データが実際はユーザの発話データである場合がある。このような場合は、ユーザの意図に従った処理が実行されない事態が発生してしまう。

【0099】

次に、ステップS103において、音声認識の信頼度が算出される。この処理も音声解析部202の処理である。信頼度は、例えば音声解析部202の保持する辞書データとのマッチング率等に基づいて行われ、予め設定した閾値等との比較により信頼度が測位と判断された発話は棄却されることになる。棄却された音データについては、後段の処理は行われない。しかし、このような棄却データが実際はユーザの発話データである場合がある。このような場合は、ユーザの意図に従った処理が実行されない事態が発生してしまう。

【0100】

ステップS104において環境理解処理が実行される。この処理は、音声解析部202とデータ処理部205の処理として実行される。情報処理装置の前に複数のユーザが存在する場合には、情報処理装置に対して要求を行っているターゲットとしているユーザ以外のユーザも、装置と無関係の発話を行う場合がある。このような発話については棄却することが必要となる。ただし、このような棄却された発話が情報処理装置を対象とした発話である場合がある。このような場合には処理エラー、すなわちユーザの意図に従った処理が実行されない事態が発生してしまう。

【0101】

ステップS105では、ユーザ管理処理が実行される。この処理はデータ処理部205の処理として実行される。情報処理装置に対して要求を行っているターゲットユーザであっても、情報処理装置に対する発話のみを行うとは限らない。例えば、他のユーザに対する発話を行う場合がある。このような発話を識別し棄却する処理が行われる。しかし、この棄却された発話が情報処理装置を対象とした発話である場合がある。このような場合には処理エラー、すなわちユーザの意図に従った処理が実行されない事態が発生してしまう。

【0102】

ステップS106では、対話管理処理を行う。この処理はデータ処理部205の処理として実行される。情報処理装置に対して要求を行っているユーザの発話に含まれるあいまいな発話については、処理対象とせず棄却する。しかし、この棄却された発話がユーザにとっては情報処理装置を対象とした要求を含む発話である場合がある。このような場合には処理エラー、すなわちユーザの意図に従った処理が実行されない事態が発生してしまう。

【0103】

ステップS107では、タスク管理処理を行う。この処理はデータ処理部205の処理として実行される。ユーザの発話に基づく処理を実行するアプリケーションがユーザ発話に基づく処理を開始する処理である。しかしアプリケーションがユーザ要求を実行できない場合がある。例えば、実行中の他の処理がある場合や、アプリケーションの能力を超える要求である場合などである。このような場合にはユーザの意図に従った処理が実行されない事態が発生してしまう。

【0104】

ステップS101〜S107の処理が実行されると、最終的にステップS108の行動表出処理が行われる。この処理はデータ処理部205の処理として実行される。例えばアバターがユーザに対する応答を出力する処理である。

【0105】

図14を参照して説明したように、ユーザ発話に基づいて情報処理装置が実行する処理は、複数の異なる処理をパイプライン化した処理として実行され、各処理ステージでエラーを発生する可能性がある。このようなエラーが発生すると、アバターによるユーザ応答はなされないことになってしまう。結果として、情報処理装置に対する何らかの要求や問いかけを行ったユーザは、アバターが何の応答もしてくれないので、情報処理装置が全くユーザの要求を聞いていないのか、あるいは処理を実行中で待機すればよいのか、全く理解できなくなってしまう。

【0106】

このような事態を防止するため、本発明の情報処理装置は、各処理ステージにおける情報処理装置の処理状況に応じてアバターの表示変更を行う。あるいはアバターの応答を行う。

この例について、図15を参照して説明する。

【0107】

図15に示す処理内容(1)〜(7)は、図14に示す処理ステップS101〜S107の各処理に対応する。

(1)音響分析(S101)

(2)意味抽出(S102)

(3)信頼度算出(S103)

(4)環境理解(S104)

(5)ユーザ管理(S105)

(6)対話管理(S106)

(7)タスク管理(S107)

【0108】

先に図14を参照して説明したように、ステップS101〜S107の処理の各々においてデータ棄却が発生する場合がある。このデータ棄却が実行された場合、後段の処理ステージの処理が実行されないことになる。

【0109】

このような場合、本発明の情報処理装置では、アバターの表示を変更する。なお、説明のため、アバターの表示態様については、図15の右端欄に示すように、異なるアバター表示の各々について、アバター表示(a),(b),(c),・・・として記号で区別して説明する。

【0110】

例えば、図15(1)音響分析(S101)の処理において、処理実行中は、図15のアバター表示例の最上段に示すように、耳を強調表示して頭を揺り動かした状態のアバター(アバター表示(a))を表示する。この表示により、ユーザは情報処理装置がユーザの発話を確かに聞いていることを確認することができる。

【0111】

一方、例えば情報処理装置がユーザ発話ではないと判断した場合には、処理結果は、非音声の棄却処理(Failure)となる。この場合、アバターの表示は、図に示すように、耳を強調表示して頭を揺り動かした状態(a)から、ポカンとしたアバター表示(b)に変更され、聞いていないことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの発話を聞きとっていないことを確認することができる。

【0112】

図15(2)意味抽出(S102)の処理において、例えば、音声解析部202の保持する辞書データとのマッチング処理に失敗し、意味抽出ができなかった場合、耳を強調表示して頭を揺り動かした状態(a)から、ポカンとしたアバター表示(b)に変更され、処理エラー(意味抽出ができなかった)が発生したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの発話を聞きとっていないことを確認することができる。

【0113】

図15(3)信頼度算出(S103)の処理において、例えば、音声解析部202の保持する辞書データとのマッチング処理において所定のマッチング率が得られなかった場合も、耳を強調表示して頭を揺り動かした状態(a)から、ポカンとしたアバター表示(b)に変更され、処理エラー(信頼度の高い意味抽出ができなかった)が発生したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの発話を聞きとっていないことを確認することができる。

【0114】

図15(4)環境理解(S104)の処理において、例えば、音声解析部202やデータ処理部205が本来処理対象とすべきユーザの発話を棄却してしまった場合には、図に示すように、耳を強調表示して頭を揺り動かした状態(a)から、困ったアバター表示(c)に変更され、処理エラー(ユーザ発話に対する処理が実行できなかった)が発生したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの発話に基づく処理を実行できない状態であることを確認することができる。

【0115】

図15(5)ユーザ管理(S105)の処理において、例えば、データ処理部205が、本来処理対象とすべきユーザの発話を棄却してしまった場合には、図に示すように、耳を強調表示して頭を揺り動かした状態(a)から、困ったアバター表示(c)に変更され、処理エラー(ユーザ発話に対する処理が実行できなかった)が発生したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの発話に基づく処理を実行できない状態であることを確認することができる。

【0116】

図15(6)対話管理(S106)の処理において、例えば、データ処理部205が、ユーザの発話をあいまいであると棄却してしまった場合には、図に示すように、耳を強調表示して頭を揺り動かした状態(a)から、困ったアバター表示(c)に変更され、処理エラー(ユーザ発話に対する処理が実行できなかった)が発生したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの発話に基づく処理を実行できない状態であることを確認することができる。

【0117】

一方、図15(6)対話管理(S106)の処理において、例えば、データ処理部205が、ユーザの発話を理解できた場合は、(6)下段のアバター表示例に示すように、耳を強調表示して頭を揺り動かした状態(a)から、口を大きく開け、笑ったアバター表示(d)に変更され、処理に成功(ユーザ発話を理解できた)したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの発話を理解したことを確認することができる。

【0118】

図15(7)タスク管理(S107)の処理において、例えば、データ処理部205が、ユーザの発話を理解でき、アプリケーションにおいて実行可能と判定された場合は、口を大きく開け、笑ったアバター表示(d)から、口を開け、笑ったアバター表示(e)に変更され、処理に成功(ユーザ発話による処理が開始)したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置において、ユーザの発話に基づく処理が開始されることを確認することができる。

【0119】

このように、本発明の情報処理装置では、情報処理装置の実行する様々な処理ステージにおける処理の状況(成功/失敗等)に応じて、アバターの表示を変更し、装置の状態をユーザに提示して知らせる構成としている。この処理によってユーザは装置の状態をある程度把握でき、例えば、アバターが困った表情である場合は、再度、要求を発話するといった処理を行うことが可能となり、ただ待機するといった無駄な処理を省くことが可能となる。

【0120】

なお、図15を参照して説明した処理ではアバターの表情のみを変更する例として説明したが、アバターの発話として具体的な処理情報についての文書表示処理や、音声出力処理を行う構成としてもよい。すなわち、情報処理装置の代理としてのアバターを表示部に表示し、表示したアバターを介して情報処理装置の状況の説明情報を出力する処理を行う構成としてもよい。例えば失敗した処理の説明や成功した処理の内容などを出力する処理を行う。

【0121】

(4−2)ユーザの動作(ジェスチャー)に対するフィードバック処理例について

図14、図15を参照して説明した処理は、ユーザの発話に対する音声解析における処理ステージと各処理ステージにおけるとフィードバック処理例である。次に、ユーザの動作(ジェスチャー)の画像解析における処理ステージと各処理ステージにおけるフィードバック処理形について図16、図17を参照して説明する。

【0122】

図16を参照してユーザの動作(ジェスチャー)に対する情報処理装置の処理例について説明する。

図16は、ユーザが手の指を使って何らかの動作(ジェスチャー)を実行した場合に情報処理装置が実行する処理に含まれる処理ステージを実行順(ステップS210→S220→S230→S240)に従って示した図である。

すべての処理が進めば、最終的な処理として、例えばアバターがユーザに対して何らかの発話を行う。あるいは指示された処理(例えばコンテンツ再生など)を実行する。

【0123】

図16に示すように、ユーザの動作(ジェスチャー)を入力した情報処理装置は、ステップS210において手検出処理を実行する。この処理は、図2に示す画像解析部204が画像入力部(カメラ)203から入力する画像に基づいて実行する処理である。この手検出処理は失敗する場合と、成功する場合の2つのケースが存在する。失敗した場合はステップS211に進み、データ処理部205においてアバターの表示切り替え等の処理が実行される。この処理については後述する。成功した場合は、例えばステップS212に示すような手検出情報を取得し、次のステップS220の指検出処理に移行する。

【0124】

ステップS220では、指検出処理を実行する。この処理は、図2に示す画像解析部204が画像入力部(カメラ)203から入力する画像に基づいて実行する処理である。この指検出処理も失敗する場合と、成功する場合の2つのケースが存在する。失敗した場合はステップS221に進み、データ処理部205においてアバターの表示切り替え等の処理が実行される。この処理については後述する。成功した場合は、例えばステップS222に示すような指検出情報を取得し、次のステップS230の手のパターン認識処理に移行する。

【0125】

ステップS230では、手のパターン認識処理を実行する。この処理は、図2に示す画像解析部204、あるいはデータ処理部205において実行する処理である。この手のパターン検出処理も失敗する場合と、成功する場合の2つのケースが存在する。失敗した場合はステップS231に進み、データ処理部205においてアバターの表示切り替え等の処理が実行される。この処理については後述する。成功した場合は、例えばステップS232に示すような例えば[ピースサイン]であるとの検出情報を取得し、次のステップS240のジェスチャー識別処理に移行する。

【0126】

ステップS240では、ジェスチャー識別処理を実行する。この処理は、図2に示す画像解析部204、あるいはデータ処理部205において実行する処理である。このジェスチャー識別処理も失敗する場合と、成功する場合の2つのケースが存在する。失敗した場合はステップS241に進み、データ処理部205においてアバターの表示切り替え等の処理が実行される。この処理については後述する。成功した場合は、例えばステップS242に示すような例えば[ピースサインのウェーブ]であるとの検出情報を取得し、次のステップに移行する。

【0127】

図16を参照して説明したように、ユーザの動作(ジェスチャー)に基づいて情報処理装置が実行する処理も、複数の異なる処理をパイプライン化した処理として実行され、各処理ステージでエラーを発生する可能性がある。このようなエラーが発生すると、ユーザ要求に対する情報処理装置の応答や処理が実行されなくなる。結果として、情報処理装置に対する何らかの要求や問いかけを行ったユーザは、アバターが何の応答もしてくれず、情報処理装置も新たな処理を開始しないので、情報処理装置が全くユーザの要求を聞いていないのか、あるいは処理を実行中で待機すればよいのか、全く理解できなくなってしまう。

【0128】

このような事態を防止するため、本発明の情報処理装置は、各処理ステージにおける情報処理装置の処理状況に応じてアバターの表示変更を行う。あるいはアバターの応答を行う。

この例について、図17を参照して説明する。

【0129】

図17に示す処理内容(1)〜(4)は、図16に示す処理ステップS210〜S240の各処理に対応する。(5)は最終処理としてのタスク管理処理を示している。図17に示す処理は、以下の(1)〜(5)の処理である。

(1)手検出処理(S210)

(2)指検出処理(S220)

(3)手のパターン認識処理(S230)

(4)動作(ジェスチャー)識別処理(S240)

(5)タスク管理

【0130】

先に図16を参照して説明したように、ステップS210〜S240の処理においては、エラーが発生する可能性がある。エラーが発生した場合は後段の処理ステージの処理が実行されないことになる。このような場合、本発明の情報処理装置では、アバターの表示を変更する。なお、説明のため、アバターの表示態様については、図17の右端欄に示すように、異なるアバター表示の各々について、アバター表示(a),(b),(c),・・・として記号で区別して説明する。

【0131】

例えば、図17(1)画像からの手検出処理(S210)において、処理実行中は、アバター表示例の図17(1)の上段に示すように、見ていることを示すように頭を揺り動かした状態のアバター(アバター表示(a))を表示する。この表示により、ユーザは情報処理装置がユーザの動作(ジェスチャー)を確かに見ていることを確認することができる。

【0132】

一方、例えば情報処理装置が手検出処理(S210)に失敗した場合は、アバターの表示は、図17(1)の下段に示すように、頭を揺り動かした状態(a)から、ポカンとしたアバター表示(b)に変更され、処理エラー(手検出失敗)が発生したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの動作(ジェスチャー)を確認できていないことを知ることができる。

【0133】

図17(2)指検出処理(S220)において、指検出に失敗した場合は、アバターの表示は、図17(2)の右端欄に示すように、頭を揺り動かした状態(a)から、ポカンとしたアバター表示(b)に変更され、処理エラー(手検出失敗)が発生したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの動作(ジェスチャー)を確認できていないことを知ることができる。

【0134】

図17(3)手の形状パターン認識処理(S230)において、手の形状パターン認識に失敗した場合は、アバターの表示は、図17(3)の右端欄に示すように、頭を揺り動かした状態(a)から、困った表情のアバター表示(c)に変更され、処理エラー(手の形状パターン認識に失敗)が発生したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの動作(ジェスチャー)を確認できていないことを知ることができる。

【0135】

図17(4)動作(ジェスチャー)識別処理(S240)において、動作(ジェスチャー)識別に失敗した場合は、アバターの表示は、図17(4)の右端欄に示すように、頭を揺り動かした状態(a)から、困った表情のアバター表示(c)に変更され、処理エラー(手の形状パターン認識に失敗)が発生したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの動作(ジェスチャー)を確認できていないことを知ることができる。

【0136】

一方、図17(4)動作(ジェスチャー)識別処理(S240)において、動作(ジェスチャー)識別に成功した場合は、(4)下段のアバター表示例に示すように、頭を揺り動かした状態(a)から、口を大きく開け、笑ったアバター表示(d)に変更され、処理に成功(ユーザ発話を理解できた)したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの動作(ジェスチャー)を理解したことを確認することができる。

【0137】

図17(7)タスク管理の処理において、例えば、データ処理部205が、ユーザの動作(ジェスチャー)を理解でき、アプリケーションにおいて実行可能と判定された場合は、口を大きく開け、笑ったアバター表示(d)から、口を開け、笑ったアバター表示(e)に変更され、処理に成功(ユーザ動作(ジェスチャー)による処理が開始)したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置において、ユーザの動作(ジェスチャー)に基づく処理が開始されることを確認することができる。

【0138】

このように、本発明の情報処理装置では、情報処理装置の実行する様々な処理ステージにおける処理の状況(成功/失敗等)に応じて、アバターの表示を変更し、装置の状態をユーザに提示して知らせる構成としている。この処理によってユーザは装置の状態をある程度把握でき、例えば、アバターが困った表情である場合は、再度、要求を発話するといった処理を行うことが可能となり、ただ待機するといった無駄な処理を省くことが可能となる。

【0139】

なお、図17を参照して説明した処理ではアバターの表情のみを変更する例として説明したが、アバターの発話として具体的な処理情報についての文書表示処理や、音声出力処理を行う構成としてもよい。すなわち、情報処理装置の代理としてのアバターを表示部に表示し、表示したアバターを介して情報処理装置の状況の説明情報を出力する処理を行う構成としてもよい。例えば失敗した処理の説明や成功した処理の内容などを出力する処理を行う。

【0140】

[5.情報処理装置のハードウェア構成例について]

最後に、図18を参照して、上述した処理を実行する情報処理装置のハードウェア構成例について説明する。CPU(Central Processing Unit)701は、ROM(Read Only Memory)702、または記憶部708に記憶されているプログラムに従って各種の処理を実行する。

例えば、図2の情報処理装置の構成における音声解析部202、画像解析部204、データ処理部205の処理を実行する。RAM(Random Access Memory)703には、CPU701が実行するプログラムやデータなどが適宜記憶される。これらのCPU701、ROM702、およびRAM703は、バス704により相互に接続されている。

【0141】

CPU701はバス704を介して入出力インタフェース705に接続され、入出力インタフェース705には、カメラ、マイク、リモコン、キーボード、マウスなどの入力部706、ディスプレイ、スピーカなどよりなる出力部707が接続されている。CPU701は、入力部706から入力される情報に対応して各種の処理を実行し、処理結果を例えば出力部707に出力する。

【0142】

入出力インタフェース705に接続されている記憶部708は、例えばハードディスクからなり、CPU701が実行するプログラムや各種のデータを記憶する。

さらに、音声認識処理に必用となる各種の音声情報や辞書データ、さらには、ユーザ認識処理に必用となるユーザ画像データ等が記録されている。通信部709は、インターネットやローカルエリアネットワークなどのネットワークを介して外部の装置と通信する。

【0143】

入出力インタフェース705に接続されているドライブ710は、磁気ディスク、光ディスク、光磁気ディスク、或いは半導体メモリなどのリムーバブルメディア711を駆動し、記録されているプログラムやデータなどを取得する。取得されたプログラムやデータは、必要に応じて記憶部708に転送され記憶される。

【0144】

以上、特定の実施例を参照しながら、本発明について詳解してきた。しかしながら、本発明の要旨を逸脱しない範囲で当業者が実施例の修正や代用を成し得ることは自明である。すなわち、例示という形態で本発明を開示してきたのであり、限定的に解釈されるべきではない。本発明の要旨を判断するためには、特許請求の範囲の欄を参酌すべきである。

【0145】

また、明細書中において説明した一連の処理はハードウェア、またはソフトウェア、あるいは両者の複合構成によって実行することが可能である。ソフトウェアによる処理を実行する場合は、処理シーケンスを記録したプログラムを、専用のハードウェアに組み込まれたコンピュータ内のメモリにインストールして実行させるか、あるいは、各種処理が実行可能な汎用コンピュータにプログラムをインストールして実行させることが可能である。例えば、プログラムは記録媒体に予め記録しておくことができる。記録媒体からコンピュータにインストールする他、LAN(Local Area Network)、インターネットといったネットワークを介してプログラムを受信し、内蔵するハードディスク等の記録媒体にインストールすることができる。

【0146】

なお、明細書に記載された各種の処理は、記載に従って時系列に実行されるのみならず、処理を実行する装置の処理能力あるいは必要に応じて並列的にあるいは個別に実行されてもよい。また、本明細書においてシステムとは、複数の装置の論理的集合構成であり、各構成の装置が同一筐体内にあるものには限らない。

【産業上の利用可能性】

【0147】

以上、説明したように、本発明の一実施例の構成によれば、ユーザ発話やジェスチャーにより、情報処理装置に様々な処理を実行させることを可能とした装置および方法が提供される。ユーザ発話の音声解析処理や、ユーザ動作(ジェスチャー)を解析する画像解析を実行し、これらの解析結果に基づいて情報処理装置の実行する処理を決定する。さらに、ユーザ発話やユーザ動作に対する情報処理装置の認識結果を含む情報をフィードバック情報として表示または音声出力する。さらにユーザからの要求に対する情報処理装置の応答や、情報処理装置の処理状況等を、情報処理装置の代理であるアバターを介して表示、出力する。ユーザはこれらのフィードバック情報を取得することで、誤りの少ない確実な処理を実行できる。

【符号の説明】

【0148】

11〜13 ユーザ

100 情報処理装置

101 カメラ

102 音声入出力部

201 音声入力部

202 音声解析部

203 画像入力部

204 画像解析部

205 データ処理部

206 音声出力部

207 画像出力部

300 フィードバック情報表示領域

301 ユーザ画像

302 ユーザ入力情報

303 アバター

304 装置処理情報

350 ガイド付き情報入力領域

370 ガイド情報表示領域

371 装置状態表示欄

372 ガイド情報表示欄

381 フィードバック情報表示領域

382 ガイド付き情報入力領域

383 ガイド情報表示領域

384 コンテンツリスト表示領域

391,392 ユーザ画像

395 アバター

501 ユーザ

502 アバター

701 CPU

702 ROM

703 RAM

704 バス

705 入出力インタフェース

706 入力部

707 出力部

708 記憶部

709 通信部

710 ドライブ

711 リムーバブルメディア

【技術分野】

【0001】

本発明は、情報処理装置、および情報処理方法、並びにプログラムに関する。特に、ユーザの発話や動作に基づいて様々な処理を実行する情報処理装置、および情報処理方法、並びにプログラムに関する。

【背景技術】

【0002】

PCや、テレビ、録画再生機、その他、様々な家電製品を操作する場合、ユーザは、各装置に備えられた入力部やあるいはリモコンなどを操作して、所望の処理を装置に実行させる。例えばPCを利用する場合にはキーボードやマウスを入力デバイスとして用いることが多い。また、テレビや録画再生機などに対してはリモコンを用いて、様々な処理、例えばチャンネルの切り替えや再生コンテンツの選択などを行うことが多い。

【0003】

このような様々な装置に対する指示を、ユーザの発話や動作(ジェスチャー)によって実行するシステムについて、様々な研究がなされている。具体的には音声認識処理を用いてユーザの発話を認識するシステムや、画像処理を用いてユーザの行動やジェスチャーを認識するシステムなどである。

【0004】

リモコン、キーボート、マウス等の一般的な入力デバイスに加えて、音声認識や画像認識など、様々な複数のコミュニケーションモードを利用して、ユーザとのコミュニケーションを実行するインタフェースは、マルチモーダル・インタフェースと呼ばれる。マルチモーダル・インタフェースについて開示した従来技術として、例えば、特許文献1(US特許6988072号公報)がある。

【0005】

しかしながら、このようなマルチモーダル・インタフェース等において利用される音声認識装置や画像認識装置は処理能力に限界があり、理解できるユーザの発話や動作が限られてしまう。従って、ユーザの意思がシステム側に伝わらない場合が多いというのが現状である。

【先行技術文献】

【特許文献】

【0006】

【特許文献1】US特許第6,988,072号公報

【発明の概要】

【発明が解決しようとする課題】

【0007】

本発明は、例えば上記問題点に鑑みてなされたものであり、ユーザの発話や動作(ジェスチャー)などの音声情報や画像情報を情報処理装置が入力して処理を実行する構成において、ユーザと装置とのコミュニケーションの実行中にユーザに様々なフィードバック情報を提供することでシステムとユーザ間の相互理解度を高め、ユーザ要求の正確な理解に基づく正確な処理の実行を可能とした情報処理装置、および情報処理方法、並びにプログラムを提供することを目的とする。

【課題を解決するための手段】

【0008】

本発明の第1の側面は、

ユーザ発話の解析処理を実行する音声解析部と、

前記音声解析部の解析結果を入力し、情報処理装置の実行する処理を決定するデータ処理部を有し、

前記データ処理部は、

ユーザ発話に関する情報処理装置の認識結果を示すフィードバック情報を生成して出力する処理を行う情報処理装置にある。

【0009】

さらに、本発明の情報処理装置の一実施態様において、前記情報処理装置は、ユーザ動作を解析する画像解析部を有し、前記データ処理部は、前記画像解析部の解析結果を入力し、情報処理装置の実行する処理を決定し、ユーザ動作に関する情報処理装置の認識結果を示すフィードバック情報を生成して出力する処理を行う。

【0010】

さらに、本発明の情報処理装置の一実施態様において、前記データ処理部は、前記データ処理部は、前記フィードバック情報として、ユーザ発話の音声認識結果を示すユーザ発話内容、または、ユーザ動作に基づいて情報処理装置が認識した要求内容を出力する。

【0011】

さらに、本発明の情報処理装置の一実施態様において、前記データ処理部は、前記フィードバック情報として、ユーザ発話またはユーザ動作に対する情報処理装置の応答または情報処理装置の装置状態を示す情報を出力する。

【0012】

さらに、本発明の情報処理装置の一実施態様において、前記データ処理部は、前記フィードバック情報として、ユーザ発話またはユーザ動作に対する情報処理装置の応答または情報処理装置の装置状態を示す情報を、情報処理装置の代理としてのアバターを介して出力する。

【0013】

さらに、本発明の情報処理装置の一実施態様において、前記データ処理部は、前記フィードバック情報として、ユーザ発話またはユーザ動作に対する情報処理装置の状況を示すため、情報処理装置の代理としてのアバターの表示態様を変更する処理を行う。

【0014】

さらに、本発明の情報処理装置の一実施態様において、前記データ処理部は、ユーザによるデータ入力が可能な情報入力領域を表示部に出力し、かつ、該情報入力領域に入力可能なデータについてのガイド情報を表示する処理を行う。

【0015】

さらに、本発明の情報処理装置の一実施態様において、前記データ処理部は、前記画像解析部における画像解析結果に基づいてユーザ識別処理を実行し、識別ユーザのユーザ画像と、情報処理装置の代理としてのアバターを表示部に表示して、双方の対話内容を表示する。

【0016】

さらに、本発明の第2の側面は、

情報処理装置において、情報処理を実行する情報処理方法であり、

音声解析部が、ユーザ発話の解析処理を実行する音声解析ステップと、

データ処理部が、前記音声解析ステップにおける解析結果を入力し、情報処理装置の実行する処理を決定するデータ処理ステップを有し、

前記データ処理ステップは、

ユーザ発話に関する情報処理装置の認識結果を示すフィードバック情報を生成して出力する処理を行うステップを含む情報処理方法にある。

【0017】

さらに、本発明の第3の側面は、

情報処理装置において、情報処理を実行させるプログラムであり、

音声解析部に、ユーザ発話の解析処理を実行させる音声解析ステップと、

データ処理部に、前記音声解析ステップにおける解析結果を入力させ、情報処理装置の実行する処理を決定させるデータ処理ステップを有し、

前記データ処理ステップは、

ユーザ発話に関する情報処理装置の認識結果を示すフィードバック情報を生成して出力する処理を行わせるステップを含むプログラムにある。

【0018】

なお、本発明のプログラムは、例えば、様々なプログラム・コードを実行可能な情報処理装置やコンピュータ・システムに対して、コンピュータ可読な形式で提供する記憶媒体、通信媒体によって提供可能なプログラムである。このようなプログラムをコンピュータ可読な形式で提供することにより、情報処理装置やコンピュータ・システム上でプログラムに応じた処理が実現される。

【0019】

本発明のさらに他の目的、特徴や利点は、後述する本発明の実施例や添付する図面に基づくより詳細な説明によって明らかになるであろう。なお、本明細書においてシステムとは、複数の装置の論理的集合構成であり、各構成の装置が同一筐体内にあるものには限らない。

【発明の効果】

【0020】

本発明の一実施例の構成によれば、ユーザ発話やジェスチャーにより、情報処理装置に様々な処理を実行させることを可能とした装置および方法が提供される。ユーザ発話の音声解析処理や、ユーザ動作(ジェスチャー)を解析する画像解析を実行し、これらの解析結果に基づいて情報処理装置の実行する処理を決定する。さらに、ユーザ発話やユーザ動作に対する情報処理装置の認識結果を含む情報をフィードバック情報として表示または音声出力する。さらにユーザからの要求に対する情報処理装置の応答や、情報処理装置の処理状況等を、情報処理装置の代理であるアバターを介して表示、出力する。ユーザはこれらのフィードバック情報を取得することで、誤りの少ない確実な処理を実行できる。

【図面の簡単な説明】

【0021】

【図1】本発明の情報処理装置の利用例について説明する図である。

【図2】本発明の情報処理装置の構成例を示すブロック図である。

【図3】本発明の情報処理装置の実行する処理例について説明する図である。

【図4】本発明の情報処理装置の実行する処理例について説明する図である。

【図5】本発明の情報処理装置の実行する処理例について説明する図である。

【図6】本発明の情報処理装置の実行する処理であるアバターの表示例について説明する図である。

【図7】本発明の情報処理装置の実行する処理例について説明する図である。

【図8】本発明の情報処理装置の実行する処理例について説明する図である。

【図9】本発明の情報処理装置の実行する処理例について説明する図である。

【図10】本発明の情報処理装置の実行する処理例について説明する図である。

【図11】本発明の情報処理装置の実行する処理例について説明する図である。

【図12】本発明の情報処理装置の実行する処理例について説明する図である。

【図13】本発明の情報処理装置の実行する処理例について説明する図である。

【図14】本発明の情報処理装置がユーザ発話に対応して実行する処理例について説明する図である。

【図15】本発明の情報処理装置がユーザ発話に対応する処理の実行中に行うアバター表示の変更例について説明する図である。

【図16】本発明の情報処理装置がユーザ動作(ジェスチャー)に対応して実行する処理例について説明する図である。

【図17】本発明の情報処理装置がユーザ動作(ジェスチャー)に対応する処理の実行中に行うアバター表示の変更例について説明する図である。

【図18】本発明の情報処理装置のハードウェア構成例について説明する図である。

【発明を実施するための形態】

【0022】

以下、図面を参照しながら本発明の情報処理装置、および情報処理方法、並びにプログラムの詳細について説明する。なお、説明は以下の項目に従って行う。

1.本発明の情報処理装置の実行する処理の概要について

2.本発明の情報処理装置の構成例について

3.ユーザに対するフィードバックおよび誘導(ガイド)による相互理解の向上を行う処理例について

(3−1)アバターを利用したフィードバック処理例

(3−2)ユーザの入力可能な情報についての誘導(ガイド)を行う処理例

(3−3)ユーザに対するフィードバック情報と誘導(ガイド)情報を併せて利用する処理例

(3−4)ユーザ同定処理について

4.ユーザに対するフィードバックにより、ユーザ入力の必要性や入力タイミングを理解させる処理例について

(4−1)ユーザの発話に対するフィードバック処理例について

(4−2)ユーザの動作(ジェスチャー)に対するフィードバック処理例について

5.情報処理装置のハードウェア構成例について

【0023】

[1.本発明の情報処理装置の実行する処理の概要について]

まず、図1を参照して本発明の情報処理装置の実行する処理の概要について説明する。図1には、本発明に係る情報処理装置の例としてテレビを示している。情報処理装置100は、例えば、放送コンテンツの表示処理の他、内蔵する録画再生機器、例えばハードディスク、DVDやBlu−rayディスク等に記録されたコンテンツの再生処理や、録画再生機器に対する番組の録画処理などを実行する。

【0024】

情報処理装置100の前には、複数のユーザがいる。図に示す例では、ユーザa,11、ユーザb,12、ユーザc,13がいる。これらのユーザは、情報処理装置100に対して、様々な要求を行う。例えばチャンネルの切り替え、ボリュームの調整、録画処理の開始、あるいは記録コンテンツの一覧リストの表示、リストからのコンテンツの選択再生要求などである。再生の停止、早送りなどの要求である。

【0025】

ユーザは、これらの要求を音声、すなわち発話によって行う。情報処理装置100は、カメラ101、マイクとスピーカを備えた音声入出力部102を有する。ユーザa〜c,11〜13の発する言葉は、マイクとスピーカを備えた音声入出力部102を介して情報処理装置100内に入力される。また、ユーザa〜c,11〜13の画像は、カメラ101を介して情報処理装置100内に入力される。

【0026】

情報処理装置101は、これらの入力情報を解析して、装置が実行すべきアクションを決定し、実行する。ユーザの要求が理解できた場合は、その要求に応じた処理を実行する。例えばチャンネルの切り替えやコンテンツの選択再生処理などである。

【0027】

さらに、情報処理装置101は、ユーザとのコミュニケーションの実行中、逐次、ユーザに対するフィードバック処理を実行する。例えばユーザの発話の内容の確認表示や、情報処理装置の応答などをユーザに提供する。具体的には、例えばユーザの要求が理解できない場合、あるいは実行できない場合などにおいて、ユーザに対して、その状況を説明するためのフィードバック処理を行う。これらの具体的な処理については後段で説明する。

【0028】

[2.本発明の情報処理装置の構成例について]

次に、図2を参照して本発明の情報処理装置の構成例について説明する。図2に示す情報処理装置100は、例えば図1に示す情報処理装置100に対応する。なお、本発明の情報処理装置はテレビに限らず、PCや、録画再生機、その他、様々な家電製品として実現可能である。すなわち、ユーザ要求に応じて様々な処理を行う情報処理装置である。

【0029】

図2に示すように情報処理装置100は、音声入力部(マイク)201、音声解析部202、画像入力部(カメラ)203、画像解析部204、データ処理部205、音声出力部(スピーカ)206、画像出力部(表示部)207を有する。

【0030】

音声入力部(マイク)201は、情報処理装置200の周囲の音声情報、例えばユーザの発話を入力する。音声入力部(マイク)201の入力した音声情報は音声解析部202に入力される。音声解析部202は、音声解析用の辞書を記憶部内に有しており、ユーザの発話した単語を、辞書を用いて解析し、解析情報をデータ処理部205に入力する。

【0031】

画像入力部(カメラ)203は、情報処理装置200の周囲の画像、例えばユーザの画像を入力する。画像入力部(カメラ)203の撮影した画像は画像解析部204に入力される。画像解析部204は、例えば、予め記憶部に格納済みのユーザの顔情報などの登録情報を用いて、撮影画像に含まれるユーザの識別処理を実行する。具体的には、ユーザの位置、ユーザが誰であるかなどの情報を解析する。この解析情報がデータ処理部205に入力される。

【0032】

データ処理部205では、音声解析部202から音声解析情報を入力し、画像解析部204から画像解析情報を入力し、入力情報に従って、情報処理装置が実行する処理(アクション)を決定する。すなわち、前述したように、ユーザの要求が理解できた場合は、その要求に応じた処理を実行する。例えばチャンネルの切り替えやコンテンツの選択再生処理などである。

【0033】

さらに、データ処理部205は、ユーザ発話やユーザ動作(ジェスチャー)に関する情報処理装置の認識結果等を示すフィードバック情報を生成して出力する処理を行う。例えばユーザの要求が理解できない場合、あるいは実行できない場合などに、状況を説明するためのフィードバック情報を生成し、生成したフィードバック情報を表示し、音声出力する。

【0034】

フィードバック処理は、音声出力部(スピーカ)206を介した音声出力、あるいは画像出力部(表示部)207を介した画像出力のいずれか、あるいはその組み合わせによって行われる。この具体的な内容については、以下において詳細に説明する。

【0035】

[3.ユーザに対するフィードバックおよび誘導(ガイド)による相互理解の向上を行う処理例について]

次に、本発明の情報処理装置の実行する処理例として、ユーザに対するフィードバックおよび誘導(ガイド)による相互理解の向上を行う処理例について説明する。

【0036】

先に説明したように、音声認識や画像認識を適用したマルチモーダル・インタフェースでは、利用される音声認識装置や画像認識装置の処理能力に限界があり、理解できるユーザの発話や動作(ジェスチャー)が限られてしまう。この結果、ユーザの意思がシステム側に伝わらず、ユーザの意思に応じた処理が実行されない場合が発生するという問題がある。以下に説明する処理例は、このような問題を解決する処理例であり、具体的には、ユーザに対するフィードバックおよび誘導(ガイド)による相互理解の向上を行う処理例である。

【0037】

以下では、ユーザに対するフィードバックおよび誘導(ガイド)による相互理解の向上を行う処理例として、以下の3つの具体的処理例について順次説明する。

(3−1)アバターを利用したフィードバック処理例

(3−2)ユーザの入力可能な情報についての誘導(ガイド)を行う処理例

(3−3)ユーザに対するフィードバック情報と誘導(ガイド)情報を併せて利用する処理例

(3−4)ユーザ同定処理について

【0038】

(3−1)アバターを利用したフィードバック処理例

まず、情報処理装置の代理としてのアバターを利用したフィードバック処理例について説明する。

図3を参照して、情報処理装置の実行する具体的な処理例について説明する。

図3は、例えば図1に示すテレビ等の情報処理装置100の表示部の表示例を示している。情報処理装置100は、ユーザの発話やジェスチャーを解析して、解析結果に応じた処理を実行する。例えばチャンネルの変更や、コンテンツの選択再生処理、録画処理などである。

【0039】

図3は、ユーザが発話または動作(ジェスチャー)に基づいて処理要求を実行し、情報処理装置100がこれらの発話や動作(ジェスチャー)を入力して解析を行い、ユーザに対するフィードバック処理として実行した表示部に対するデータ表示例を示している。

【0040】

表示部には、フィードバック情報表示領域300が設定される。フィードバック情報表示領域300には、情報処理装置100とのコミュニケーションを実行するユーザのユーザ画像301がユーザ識別情報として提示される。

【0041】

このユーザ画像301は、図2に示す画像解析部204が、画像入力部203を介して入力した画像から識別した人の顔に基づいて、予め登録した顔画像データとのマッチング処理を実行して特定した画像である。なお、フィードバック情報表示領域300に提示するユーザ画像301は、画像入力部203が撮影している生の画像であってもよいし、情報処理装置100の記憶部に格納された登録済みの画像でもよい。

ユーザは、このユーザ画像301を見て、情報処理装置100が認識したユーザが自分であることを確認できる。

例えば、自分でないユーザの顔がユーザ画像301として表示された場合は、ユーザは「ユーザが違います」といった発話等による入力を行って、情報処理装置100に対して、ユーザの誤認を通知することができる。

【0042】

フィードバック情報表示領域300には、さらに、ユーザとの対話の相手として認識可能なアバター(仮想キャラクタ)303が提示される。このアバター(仮想キャラクタ)303は情報処理装置100の代理としてユーザとの会話を行う仮想キャラクタである。

【0043】

このアバター303の提示により、ユーザは、対話の相手を装置ではなく、アバターであると想定することができ、より親しみやすい対話が実現される。

なお、アバター303は、ユーザの入力(発話や動作)の理解レベルや情報処理装置100の実行する処理などに応じて、その表情を変化させる。ユーザは、アバターの表情の変化に基づいて、情報処理装置の状況等を知ることができる。この具体例については後述する。

【0044】

フィードバック情報表示領域300には、さらに、ユーザからの発話等によるユーザ入力情報302の表示がなされる。このユーザ入力情報は、ユーザの発話やジェスチャーを情報処理装置100が解釈した結果としてのデータである。例えば、ユーザ発話の音声認識結果に基づくユーザ発話の内容、あるいは画像解析によって得られたユーザの動作(ジェスチャー)に基づいて情報処理装置が認識した要求内容である。

【0045】

情報処理装置100の解釈が誤っていれば、その誤った情報が表示される。

ユーザは、このユーザ入力情報302の表示に基づいて、情報処理装置100が正しく要求を理解したか否かを判断することができる。

例えば、ユーザの実際の要求と異なるユーザ入力情報302の表示がなされた場合は、ユーザは「要求が違います」といった発話等による入力を行って、情報処理装置100に対して、ユーザ入力の誤認を通知することができる。

【0046】

さらに、フィードバック情報表示領域300には、アバター303の発話として、情報処理装置の応答や装置状態を示す装置処理情報304の表示がなされる。この装置処理情報304は、図に示す例では、「再生します」となっている。

これは、ユーザ入力「移動コマンド:6番目再生」に対応した情報処理装置100側の処理である。

情報処理装置100の解釈が誤っていれば、その誤った処理情報が表示される。

ユーザは、この装置処理情報304の表示に基づいて、情報処理装置100が正しく要求を理解し、ユーザ要求に応じた正しい処理を行おうとしているか否かを判断することができる。

例えば、ユーザの実際の要求と異なる処理に対応する装置処理情報304の表示がなされた場合は、ユーザは「処理が違います」といった発話等による入力を行って、情報処理装置100に対して、実行する処理が誤っていることを通知することができる。

【0047】

このように、本発明の情報処理装置では、

ユーザ画像301の提示によるユーザ同定処理の正否の確認、

ユーザ入力情報302の表示によるユーザ入力の解釈の正否の確認、

アバター303と、装置処理情報304の表示による情報処理装置の状態の確認、

これらの情報をユーザに対するフィードバック情報として提示する。

ユーザはこれらのフィードバック情報に基づいて、情報処理装置100がユーザおよびユーザ要求を正しく理解しているか否かを容易に把握することができ、誤りがある場合は誤りを具体的に情報処理装置に対して通知することが可能となる。

【0048】

現状の音声認識や画像認識を適用したマルチモーダル・インタフェースにおける問題点と、本発明の情報処理装置の実行する処理との対応関係について、図4に示す表を参照して説明する。

現状の問題点として、例えば、図4に示す(1)〜(4)がある。

【0049】

例えば、(1)インタラクション開始・終了変遷が分かりにくいという問題点である。

本発明の情報処理装置は、この問題点を解決するため、インタラクション状態を表示して、現在の状態を確認可能とする。具体的には、図3に示すような、ユーザ画像301、ユーザ入力情報302、アバター303、装置処理情報304の表示である。

【0050】

また、現状の問題点として、(2)困った時にどうすれば分からないという問題がある。この問題点を解決するため、本発明の情報処理装置は、装置(システム)側の代理としてのアバター(仮想キャラクタ)を表示して、アバターに対して質問できる環境を設定している。

【0051】

さらに、現状の問題点として、(3)装置(TVなど)に対して話す違和感があるという問題点がある。この問題点を解決するため、本発明の情報処理装置は、装置(システム)側の代理としてのアバター(仮想キャラクタ)を設定している。

【0052】

さらに、現状の問題点として、(4)ユーザへのフィードバックが不足しているという問題点がある。この問題点を解決するため、本発明の情報処理装置は、アバター経由で逐次、フィードバック情報を提供するという構成としている。

【0053】

図4に示す(4)ユーザへのフィードバックが不足しているという問題点に対しては、本発明の情報処理装置では、図3に示すアバター303を用いて逐次、フィードバック情報を提供する。なお、アバター303の発話は、表示部に表示するのみではなく、音声情報として音声出力部(スピーカ)206からも出力される。

【0054】

アバター303を適用したフィードバック処理の具体例について図5を参照して説明する。

図5には、

(X)ユーザに対するフィードバック不足の態様

(Y)アバター経由のフィードバック情報の内容

(Z)アバターの表情と装置処理情報の出力例

これらの対応データを示している。

【0055】

(X)ユーザに対するフィードバック不足の態様としては、例えば図5に示す(a)〜(d)がある。

(a)いつ話せばいいかが分からない?

(b)発話が装置(システム)に入力されたか否かが分からない?

(c)発話が装置(システム)に理解されたか否かが分からない?

(d)発話に基づく処理を装置(システム)が実行しているか否かが分からない?

例えば、これら(a)〜(d)のようなフィードバック情報不足に基づくユーザが困る状況が発生する。

【0056】

本発明の情報処理装置100のデータ処理部205は、これらのフィードバック情報不足を解消するフィードバック情報を生成して出力する。

具体的には、

(a)いつ話せばいいかが分からない?

この問題に対して、

図5(Z)に示すように、アバターの発話として「指示お願いします」といった発話の出力(表示と音声出力)を実行する。

このような処理によって(Y)に示すように、装置(システム)がユーザ発話の待機状態であることを示すような構成としている。

【0057】

(b)発話が装置(システム)に入力されたか否かが分からない?

この問題に対して、

図5(Z)に示すように、アバターの発話として「話を聴いています」といった発話の出力(表示と音声出力)を実行する。さらに、アバターの耳を大きくするなど、強調表示しての聞いている状態にあることを視覚的に理解可能としたアバター表示を行う。

このような処理によって(Y)に示すように、装置(システム)がユーザ発話を聴いていることを示す構成としている。

【0058】

(c)発話が装置(システム)に理解されたか否かが分からない?

この問題に対して、

図5(Z)に示すように、アバターの発話として「分かりました」といった発話の出力(表示と音声出力)を実行する。さらに、アバターの表情を笑顔にするなど、理解したことを視覚的に示したアバター表示を行う。

このような処理によって(Y)に示すように、装置(システム)がユーザ発話を理解したことを示す構成としている。

【0059】

(d)発話に基づく処理を装置(システム)が実行しているか否かが分からない?

この問題に対して、

図5(Z)に示すように、アバターの発話として「処理中です」といった発話の出力(表示と音声出力)を実行する。この処理によって(Y)に示すように、装置(システム)がユーザ発話に基づく処理を実行中であることを示す構成としている。

【0060】

なお、アバターの表情は、情報処理装置100の処理状態に応じた様々な設定とする。図6にその一部の例を示す。図6のアバター例は上から以下の設定としたアバター表示例である。

(a)ユーザの話を聞いている状態であることを示すアバターの表示例であり、耳を強調表示したアバターの表示例である。

(b)ユーザの話を理解して、行動する状態であることを示すアバターの表示例であり、笑顔を示すアバターの表示例である。

(c)ユーザの話がよく聞こえなかった状態であることを示すアバターの表示例であり、聞こえてない困った表情を設定したアバターの表示例である。

(d)ユーザの話が理解できなかった状態であることを示すアバターの表示例であり、理解できずに困った状態である表情を示したアバターの表示例である。

【0061】

(3−2)ユーザの入力可能な情報についての誘導(ガイド)を行う処理例

次に、ユーザの入力可能な情報についての誘導(ガイド)を行う処理例について説明する。

【0062】

ユーザが、例えば図1に示す情報処理装置100に対して、何らかの録画済みコンテンツを再生する場合、コンテンツを検索する処理が必要となる。この検索の際には、様々な検索条件を設定することで、効率的な検索が実現される。

本発明の情報処理装置は、例えばこのようなコンテンツ検索の際の指定条件をカテゴリ単位で、どのような選択条件の指定ができるか等の情報をユーザに提供する。

【0063】

具体的な処理例について、図7以下を参照して説明する。

図7は、再生コンテンツの選択処理に際して情報処理装置100の表示部に表示されるガイド付き情報入力領域350の表示例である。

【0064】

コンテンツ検索を実行する場合の指定可能な情報は、図に示すように、タイトル、おすすめの有無、ジャンル、チャンネル、時間帯、例えば、これらの情報がある。

しかし、これらの情報入力欄に、実際どのような情報が入力む可能であるかについては、初心者は分かりづらい。

【0065】

本発明の情報処理装置では、このような状況に鑑み、各情報入力欄にどのような情報が入力できるかを示す誘導情報(ガイド情報)を表示する。なお、この表示に併せて音声出力も実行する。

【0066】

例えば、最初のタイトル情報の入力欄に対する入力時に、「例えばXYZニュースと入力してください」と表示する。ユーザは、この表示を見て、番組名を入力すればよいことが理解でき、即座に正しい入力を行うことができる。なお、入力は例えばユーザの発話によって行われる。

【0067】

その他の情報入力欄に対する誘導情報(ガイド情報)の表示例を図8に示す。

図8に示すように、タイトル情報の入力欄には、「例えばXYZニュースと入力してください」と表示する。これは、図7を参照して説明したと同様である。

おすすめ情報入力欄には、「あり」「なし」のいずれかを提示する。あるいは、「あり」「なし」の切り替え表示を行う。ユーザ入力によって確定した場合は、切り替え表示から確定データの常時表示に切り換える。

ジャンル欄には、アニメ。スポーツ、・・・音楽、これらの登録されたジャンル情報のいずれか、あるいは、切り換えて繰り返し表示する。ユーザ入力によって確定した場合は、確定情報を常時表示する。

【0068】

チャンネル欄には、NHK総合、・・・、複数の登録されたチャンネル情報のいずれか、あるいは、繰り返し切り換えて表示する。ユーザ入力によって確定した場合は、確定情報を常時表示する。

時間帯、時間、曜日情報についても、それぞれ入力可能な情報のいずれか、あるいは、切り換えて順次表示する。ユーザ入力によって確定した場合は、確定情報を常時表示する。

【0069】

このように、各入力欄に対して、入力可能な情報をユーザに示すことで、ユーザは具体的に入力可能な情報を知ることが可能となり、迷うことなく正しい情報を入力することができる。

【0070】

図7、図8を参照して説明した誘導情報(ガイド情報)の表示例は、ガイド付き情報入力領域350であり、実際の情報入力欄に誘導情報(ガイド情報)を埋め込んで表示する例であるが、このような処理例の他、情報入力欄と異なる独立したガイド情報表示領域を設定して誘導情報(ガイド情報)を表示する構成としてもよい。

【0071】

具体的には、例えば、図9に示すガイド情報表示領域370のような表示例である。ガイド情報表示領域370には、装置の処理状況を示す装置状態表示欄371と、ガイド情報表示欄372が設定される。

【0072】

装置状態表示欄371には、例えば、図に示すように、装置の実行している処理についての説明を表示する。この例では、ユーザとの「インタラクション中」であることを示した例を示している。

ガイド情報表示欄372には、先に、図7、図8を参照して説明したユーザ入力の態様等についての説明を表示する。

図に示す例では、ユーザの発話に基づく入力の仕方についての説明をガイド情報表示欄372の上部の「音声コマンド」の欄に表示し、ユーザの動作(ジェスチャー)に基づく入力の仕方についての説明をガイド情報表示欄372の下部の「ジェスチャー」の欄に表示している。

ユーザは、これらの説明を見て、各データ入力欄に対して容易に正しい入力を行うことが可能となる。

【0073】

(3−3)ユーザに対するフィードバック情報と誘導(ガイド)情報を併せて利用する処理例

次に、上述したユーザに対するフィードバック情報と誘導(ガイド)情報を併せて利用する処理例について図10を参照して説明する。

図10は、例えば図1のテレビなどの情報処理装置100の表示部の表示データの例を示す図である。

【0074】

図10に示す表示データは、

アバターとの対話設定を可能としたフィードバック情報表示領域381、

各データ入力欄単位で誘導(ガイド)情報を表示したガイド付き情報入力領域382、

独立した誘導(ガイド)情報を表示したガイド情報表示領域383、

コンテンツリスト表示領域384、

これらの各領域によって構成されている。

【0075】

この表示例は、コンテンツリスト表示領域384に表示されたコンテンツから再生コンテンツを選択するための処理を行う場合に表示部に表示するデータの例である。

【0076】

アバターとの対話設定を可能としたフィードバック情報表示領域381は、先に、図3〜図6を参照して説明した[(3−1)アバターを利用したフィードバック処理例]に対応するフィードバック情報の表示領域である。

各データ入力欄単位で誘導(ガイド)情報を表示したガイド付き情報入力領域382は、先に、図7〜図8を参照して説明した[(3−2)ユーザの入力可能な情報についての誘導(ガイド)を行う処理例]に対応する誘導(ガイド)情報の表示領域である。

独立した誘導(ガイド)情報を表示したガイド情報表示領域383は、先に、図9を参照して説明した[(3−2)ユーザの入力可能な情報についての誘導(ガイド)を行う処理例]に対応する誘導(ガイド)情報の表示領域である。

【0077】

これらの各情報を併せて表示することで、ユーザは迷うことなく情報処理装置に対する指示を発話またはジェスチャーによって行うことができる。

【0078】

(3−4)ユーザ同定処理について

次に、ユーザ同定処理について説明する。例えば、図1のような環境では、情報処理装置100の前に複数のユーザが存在する。ユーザa11〜ユーザc13である。情報処理装置100は、カメラ101(=図2の画像入力部(カメラ)203)を介して、情報処理装置100の前の画像を取得し、図2に示す画像解析部204において、あらかじめ記憶部に格納されたユーザの顔画像との比較を実行して、ユーザの識別処理を実行する。図2に示すデータ処理部205は、この識別結果のフィードバック情報を生成する。

【0079】

具体的には、例えば図11に示すような識別ユーザの表示を実行する。図11は、情報処理装置100の表示部の表示データ例である。図11に示す例では、情報処理装置100が認識したユーザの画像として2つのユーザ画像391,392が表示されている。

【0080】

ユーザ画像391,392は、ユーザ識別処理によって識別されたユーザの登録画像、すなわち情報処理装置の記憶部に格納済みの登録画像データを表示してもよいし、カメラによって撮影中のユーザ画像を表示してもよい。

【0081】

この図11に示す識別ユーザの表示画面に、さらに、各ユーザからの発話の認識結果を表示する。この表示処理は、先に、図3〜図6を参照して説明した[(3−1)アバターを利用したフィードバック処理例]におけるユーザ入力情報302(図3参照)と同様の表示処理として行われる。

なお、どのユーザが話したかについては、音声解析部202における音声解析処理、すなわち予め情報処理装置100に格納されているユーザ単位の音声特徴情報との呼格処理によって実行される。また画像解析部204において画像から口の動きを解析してその解析結果を利用してもよい。

【0082】

図11に示す例では、ユーザ画像391に示される「まことくん」が発話を行っている。「まことくん」は情報処理装置100に対応するアバターに対してよびかけを実行している。アバターに対してはニックネームが設定可能であり、設定されたニックネームは情報処理装置に登録される。図11に示す例は情報処理装置100に対応するアバターのニックネームとして「テレビくん」が設定されている場合の例である。

このニックネームの呼びかけを情報処理装置100の音声解析部202が検出するとデータ処理部205は、例えば図12に示す表示データを表示する。

【0083】

図12にはアバター395がユーザー(まことくん)からの呼びかけに答える設定であり、アバター(テレビくん)がユーザー(まことくん)にあいさつ「こんにちは まことくん」という発話を行った例である。なお、この発話は、情報処理装置100の音声出力部(スピーカ)206を介しても出力される。

【0084】

ユーザは、図11、図12に示す画面を見ることで、情報処理装置100が自分を正しく認識し、自分の発話が正しく理解されているか否かを把握することができる。

この図11、図12に示す画面は、例えば初期画面であり、情報処理装置の起動時などに表示される。

この図11、図12に示す初期画面の出力後、ユーザは情報処理装置に対して、様々な要求を発話またはジェスチャーによって入力する。

【0085】

(3−5)ユーザ同定処理について

図13を参照して、本発明の情報処理装置100の表示部に表示される画面遷移の具体的な例について説明する。

図13には、

(A)初期画面

(B)入力画面

(C)再生画面

これらの3つの画面表示例を示している。

【0086】

(A)初期画面は、図11、図12を参照して説明した処理[(3−4)ユーザ同定処理]によって表示される画面である。

情報処理装置100の画像解析部204におけるユーザ画像の解析と、音声解析部202におけるユーザ発話の解析情報を用いて、データ処理部205が生成する初期画面である。

ユーザは、この画面を見ることで、自分が装置に正しく認識され、自分の要求が装置に正しく伝わっていることを確認することができる。

【0087】

(B)入力画面は、先に図10を参照して説明した画面に対応する。

アバターとの対話設定を可能としたフィードバック情報表示領域、

各データ入力欄単位で誘導(ガイド)情報を表示したガイド付き情報入力領域、

独立した誘導(ガイド)情報を表示したガイド情報表示領域、

コンテンツリスト表示領域、

これらの各領域によって構成されている。

この表示例は、コンテンツリスト表示領域に表示されたコンテンツから再生コンテンツを選択するための処理を行う場合に表示部に表示するデータの例である。

【0088】

アバターとの対話設定を可能としたフィードバック情報表示領域は、先に、図3〜図6を参照して説明した[(3−1)アバターを利用したフィードバック処理例]に対応するフィードバック情報の表示領域である。

各データ入力欄単位で誘導(ガイド)情報を表示したガイド付き情報入力領域は、先に、図7〜図8を参照して説明した[(3−2)ユーザの入力可能な情報についての誘導(ガイド)を行う処理例]に対応する誘導(ガイド)情報の表示領域である。

独立した誘導(ガイド)情報を表示したガイド情報表示領域は、先に、図9を参照して説明した[(3−2)ユーザの入力可能な情報についての誘導(ガイド)を行う処理例]に対応する誘導(ガイド)情報の表示領域である。

これらの各情報を併せて表示することで、ユーザは迷うことなく情報処理装置に対する指示を発話またはジェスチャーによって行うことができる。

【0089】

(C)再生画面は、(B)入力画面を利用してユーザが選択した番組(コンテンツ)を再生している画面の例である。このコンテンツ再生表示の場合は、再生コンテンツを全画面表示する表示パターンと、図に示すように再生コンテンツに併せて、アバターとの対話設定を可能としたフィードバック情報表示領域と、独立した誘導(ガイド)情報を表示したガイド情報表示領域を表示するパターンとを切り換えることができる。

この状態においてもユーザは、アバターとの会話が可能であり、例えば再生コンテンツの切り替え要求などを随時実行することができる。

【0090】

[4.ユーザに対するフィードバックにより、ユーザ入力の必要性や入力タイミングを理解させる処理例について]

次に、ユーザに対するフィードバック処理を実行して、ユーザ入力の必要性や入力タイミングをユーザに理解させる処理例について説明する。

【0091】

上述の実施例において、アバターを利用したユーザと装置との対話や、様々なデータ入力領域に対するガイド表示によって、ユーザの入力を正確に行わせる処理例を説明した。

しかし、このような構成を提供しても、100%誤りのないユーザ入力が行われる保証はない。必ず、何らかの入力ミスが発生し、また、ユーザの意図とは異なる情報処理装置の処理が開始される場合もある。

具体的には音声解析のエラーが発生した場合には、ユーザの発話に対して情報処理装置が全く処理を開始できない場合が発生する。

また、情報処理装置の前に複数のユーザがいる場合、情報処理装置に対して話かけたユーザと異なる無関係のユーザの発話に対して処理を開始してしまうといった場合も発生する可能性がある。

また、ユーザの要求が情報処理装置の実行可能な処理でない場合もある。

【0092】

このようにユーザと情報処理装置とのコミュニケーションには、エラー発生要因が多々、存在する。以下において説明する処理は、このようなトラブル発生時に、最適な対応としてのユーザに対するフィードバックを行う処理例である。

具体的には、図2に示す情報処理装置のデータ処理部205は、ユーザ発話やユーザ動作(ジェスチャー)に基づく処理において処理継続の阻害要因が発生した場合、阻害要因が発生した処理ステージに対応したフィードバック情報を生成して出力する処理を行う。

【0093】

(4−1)ユーザの発話に対するフィードバック処理例について

例えば本発明のシステムは、ユーザ発話を音声認識によって解析し、解析結果に基づいて情報処理装置の処理を決定する。

この音声認識による処理決定までのプロセスにおいては、複数の異なる処理を連続的に実行することが必要となる。すなわち複数の処理ステージをパイプライン処理としてシーケンシャルに実行することが必要である。

複数の処理ステージが順調に進めば、最終的な処理、例えばユーザに対する応答が出力される。具体的にはアバターの出力が画像として表示、あるいは音声出力される。

【0094】

しかし、パイプライン処理のいずれかの処理ステージにおいて、処理エラーが発生すると、最終的な処理であるアバターの応答はいつまでたっても実行されないことになってしまう。

このような場合、ユーザは、ただ待機するしかなく、情報処理装置の状態について知ることができない。

【0095】

以下において説明する処理例は、情報処理装置の実行する複数の処理ステージの各々において発生するエラーの状況等をユーザに逐次、フィードバックすることで、ユーザが装置(システム)状態を常に把握することを可能としたものである。

【0096】

図14を参照してユーザ発話に対する情報処理装置の処理例について説明する。

図14は、ユーザ501が何らかの発話を実行した場合に情報処理装置が実行する処理に含まれる処理ステージを実行順に従って示した図である。

すべての処理が進めば、最終的な処理として、アバター502がユーザに対して何らかの発話を行う場合の処理例である。

【0097】

図14に示すように、ユーザ発話を入力した情報処理装置は、ステップS101において音響分析を実行する。この処理は、図2に示す音声解析部202の処理である。音響分析処理に際しては、音声以外の音を棄却し、人の声のみを取得する処理が行われる。音声ではないと判断され棄却された音データについては、後段の処理は行われない。しかし、このような棄却データが実際はユーザの発話データである場合がある。このような場合は、ユーザの意図に従った処理が実行されない事態が発生してしまう。

【0098】

ステップS102において、取得した音声情報に基づく意味抽出処理が実行される。この処理も図2に示す音声解析部202の処理である。この処理は、例えば音声解析部202の保持する辞書データとのマッチング処理をベースとして行われる。この処理において、マッチする登録単語がない場合などには、無意味な発話としてデータが棄却される。棄却された音データについては、後段の処理は行われない。しかし、このような棄却データが実際はユーザの発話データである場合がある。このような場合は、ユーザの意図に従った処理が実行されない事態が発生してしまう。

【0099】

次に、ステップS103において、音声認識の信頼度が算出される。この処理も音声解析部202の処理である。信頼度は、例えば音声解析部202の保持する辞書データとのマッチング率等に基づいて行われ、予め設定した閾値等との比較により信頼度が測位と判断された発話は棄却されることになる。棄却された音データについては、後段の処理は行われない。しかし、このような棄却データが実際はユーザの発話データである場合がある。このような場合は、ユーザの意図に従った処理が実行されない事態が発生してしまう。

【0100】

ステップS104において環境理解処理が実行される。この処理は、音声解析部202とデータ処理部205の処理として実行される。情報処理装置の前に複数のユーザが存在する場合には、情報処理装置に対して要求を行っているターゲットとしているユーザ以外のユーザも、装置と無関係の発話を行う場合がある。このような発話については棄却することが必要となる。ただし、このような棄却された発話が情報処理装置を対象とした発話である場合がある。このような場合には処理エラー、すなわちユーザの意図に従った処理が実行されない事態が発生してしまう。

【0101】

ステップS105では、ユーザ管理処理が実行される。この処理はデータ処理部205の処理として実行される。情報処理装置に対して要求を行っているターゲットユーザであっても、情報処理装置に対する発話のみを行うとは限らない。例えば、他のユーザに対する発話を行う場合がある。このような発話を識別し棄却する処理が行われる。しかし、この棄却された発話が情報処理装置を対象とした発話である場合がある。このような場合には処理エラー、すなわちユーザの意図に従った処理が実行されない事態が発生してしまう。

【0102】

ステップS106では、対話管理処理を行う。この処理はデータ処理部205の処理として実行される。情報処理装置に対して要求を行っているユーザの発話に含まれるあいまいな発話については、処理対象とせず棄却する。しかし、この棄却された発話がユーザにとっては情報処理装置を対象とした要求を含む発話である場合がある。このような場合には処理エラー、すなわちユーザの意図に従った処理が実行されない事態が発生してしまう。

【0103】

ステップS107では、タスク管理処理を行う。この処理はデータ処理部205の処理として実行される。ユーザの発話に基づく処理を実行するアプリケーションがユーザ発話に基づく処理を開始する処理である。しかしアプリケーションがユーザ要求を実行できない場合がある。例えば、実行中の他の処理がある場合や、アプリケーションの能力を超える要求である場合などである。このような場合にはユーザの意図に従った処理が実行されない事態が発生してしまう。

【0104】

ステップS101〜S107の処理が実行されると、最終的にステップS108の行動表出処理が行われる。この処理はデータ処理部205の処理として実行される。例えばアバターがユーザに対する応答を出力する処理である。

【0105】

図14を参照して説明したように、ユーザ発話に基づいて情報処理装置が実行する処理は、複数の異なる処理をパイプライン化した処理として実行され、各処理ステージでエラーを発生する可能性がある。このようなエラーが発生すると、アバターによるユーザ応答はなされないことになってしまう。結果として、情報処理装置に対する何らかの要求や問いかけを行ったユーザは、アバターが何の応答もしてくれないので、情報処理装置が全くユーザの要求を聞いていないのか、あるいは処理を実行中で待機すればよいのか、全く理解できなくなってしまう。

【0106】

このような事態を防止するため、本発明の情報処理装置は、各処理ステージにおける情報処理装置の処理状況に応じてアバターの表示変更を行う。あるいはアバターの応答を行う。

この例について、図15を参照して説明する。

【0107】

図15に示す処理内容(1)〜(7)は、図14に示す処理ステップS101〜S107の各処理に対応する。

(1)音響分析(S101)

(2)意味抽出(S102)

(3)信頼度算出(S103)

(4)環境理解(S104)

(5)ユーザ管理(S105)

(6)対話管理(S106)

(7)タスク管理(S107)

【0108】

先に図14を参照して説明したように、ステップS101〜S107の処理の各々においてデータ棄却が発生する場合がある。このデータ棄却が実行された場合、後段の処理ステージの処理が実行されないことになる。

【0109】

このような場合、本発明の情報処理装置では、アバターの表示を変更する。なお、説明のため、アバターの表示態様については、図15の右端欄に示すように、異なるアバター表示の各々について、アバター表示(a),(b),(c),・・・として記号で区別して説明する。

【0110】

例えば、図15(1)音響分析(S101)の処理において、処理実行中は、図15のアバター表示例の最上段に示すように、耳を強調表示して頭を揺り動かした状態のアバター(アバター表示(a))を表示する。この表示により、ユーザは情報処理装置がユーザの発話を確かに聞いていることを確認することができる。

【0111】

一方、例えば情報処理装置がユーザ発話ではないと判断した場合には、処理結果は、非音声の棄却処理(Failure)となる。この場合、アバターの表示は、図に示すように、耳を強調表示して頭を揺り動かした状態(a)から、ポカンとしたアバター表示(b)に変更され、聞いていないことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの発話を聞きとっていないことを確認することができる。

【0112】

図15(2)意味抽出(S102)の処理において、例えば、音声解析部202の保持する辞書データとのマッチング処理に失敗し、意味抽出ができなかった場合、耳を強調表示して頭を揺り動かした状態(a)から、ポカンとしたアバター表示(b)に変更され、処理エラー(意味抽出ができなかった)が発生したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの発話を聞きとっていないことを確認することができる。

【0113】

図15(3)信頼度算出(S103)の処理において、例えば、音声解析部202の保持する辞書データとのマッチング処理において所定のマッチング率が得られなかった場合も、耳を強調表示して頭を揺り動かした状態(a)から、ポカンとしたアバター表示(b)に変更され、処理エラー(信頼度の高い意味抽出ができなかった)が発生したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの発話を聞きとっていないことを確認することができる。

【0114】

図15(4)環境理解(S104)の処理において、例えば、音声解析部202やデータ処理部205が本来処理対象とすべきユーザの発話を棄却してしまった場合には、図に示すように、耳を強調表示して頭を揺り動かした状態(a)から、困ったアバター表示(c)に変更され、処理エラー(ユーザ発話に対する処理が実行できなかった)が発生したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの発話に基づく処理を実行できない状態であることを確認することができる。

【0115】

図15(5)ユーザ管理(S105)の処理において、例えば、データ処理部205が、本来処理対象とすべきユーザの発話を棄却してしまった場合には、図に示すように、耳を強調表示して頭を揺り動かした状態(a)から、困ったアバター表示(c)に変更され、処理エラー(ユーザ発話に対する処理が実行できなかった)が発生したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの発話に基づく処理を実行できない状態であることを確認することができる。

【0116】

図15(6)対話管理(S106)の処理において、例えば、データ処理部205が、ユーザの発話をあいまいであると棄却してしまった場合には、図に示すように、耳を強調表示して頭を揺り動かした状態(a)から、困ったアバター表示(c)に変更され、処理エラー(ユーザ発話に対する処理が実行できなかった)が発生したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの発話に基づく処理を実行できない状態であることを確認することができる。

【0117】

一方、図15(6)対話管理(S106)の処理において、例えば、データ処理部205が、ユーザの発話を理解できた場合は、(6)下段のアバター表示例に示すように、耳を強調表示して頭を揺り動かした状態(a)から、口を大きく開け、笑ったアバター表示(d)に変更され、処理に成功(ユーザ発話を理解できた)したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの発話を理解したことを確認することができる。

【0118】

図15(7)タスク管理(S107)の処理において、例えば、データ処理部205が、ユーザの発話を理解でき、アプリケーションにおいて実行可能と判定された場合は、口を大きく開け、笑ったアバター表示(d)から、口を開け、笑ったアバター表示(e)に変更され、処理に成功(ユーザ発話による処理が開始)したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置において、ユーザの発話に基づく処理が開始されることを確認することができる。

【0119】

このように、本発明の情報処理装置では、情報処理装置の実行する様々な処理ステージにおける処理の状況(成功/失敗等)に応じて、アバターの表示を変更し、装置の状態をユーザに提示して知らせる構成としている。この処理によってユーザは装置の状態をある程度把握でき、例えば、アバターが困った表情である場合は、再度、要求を発話するといった処理を行うことが可能となり、ただ待機するといった無駄な処理を省くことが可能となる。

【0120】

なお、図15を参照して説明した処理ではアバターの表情のみを変更する例として説明したが、アバターの発話として具体的な処理情報についての文書表示処理や、音声出力処理を行う構成としてもよい。すなわち、情報処理装置の代理としてのアバターを表示部に表示し、表示したアバターを介して情報処理装置の状況の説明情報を出力する処理を行う構成としてもよい。例えば失敗した処理の説明や成功した処理の内容などを出力する処理を行う。

【0121】

(4−2)ユーザの動作(ジェスチャー)に対するフィードバック処理例について

図14、図15を参照して説明した処理は、ユーザの発話に対する音声解析における処理ステージと各処理ステージにおけるとフィードバック処理例である。次に、ユーザの動作(ジェスチャー)の画像解析における処理ステージと各処理ステージにおけるフィードバック処理形について図16、図17を参照して説明する。

【0122】

図16を参照してユーザの動作(ジェスチャー)に対する情報処理装置の処理例について説明する。

図16は、ユーザが手の指を使って何らかの動作(ジェスチャー)を実行した場合に情報処理装置が実行する処理に含まれる処理ステージを実行順(ステップS210→S220→S230→S240)に従って示した図である。

すべての処理が進めば、最終的な処理として、例えばアバターがユーザに対して何らかの発話を行う。あるいは指示された処理(例えばコンテンツ再生など)を実行する。

【0123】

図16に示すように、ユーザの動作(ジェスチャー)を入力した情報処理装置は、ステップS210において手検出処理を実行する。この処理は、図2に示す画像解析部204が画像入力部(カメラ)203から入力する画像に基づいて実行する処理である。この手検出処理は失敗する場合と、成功する場合の2つのケースが存在する。失敗した場合はステップS211に進み、データ処理部205においてアバターの表示切り替え等の処理が実行される。この処理については後述する。成功した場合は、例えばステップS212に示すような手検出情報を取得し、次のステップS220の指検出処理に移行する。

【0124】

ステップS220では、指検出処理を実行する。この処理は、図2に示す画像解析部204が画像入力部(カメラ)203から入力する画像に基づいて実行する処理である。この指検出処理も失敗する場合と、成功する場合の2つのケースが存在する。失敗した場合はステップS221に進み、データ処理部205においてアバターの表示切り替え等の処理が実行される。この処理については後述する。成功した場合は、例えばステップS222に示すような指検出情報を取得し、次のステップS230の手のパターン認識処理に移行する。

【0125】

ステップS230では、手のパターン認識処理を実行する。この処理は、図2に示す画像解析部204、あるいはデータ処理部205において実行する処理である。この手のパターン検出処理も失敗する場合と、成功する場合の2つのケースが存在する。失敗した場合はステップS231に進み、データ処理部205においてアバターの表示切り替え等の処理が実行される。この処理については後述する。成功した場合は、例えばステップS232に示すような例えば[ピースサイン]であるとの検出情報を取得し、次のステップS240のジェスチャー識別処理に移行する。

【0126】

ステップS240では、ジェスチャー識別処理を実行する。この処理は、図2に示す画像解析部204、あるいはデータ処理部205において実行する処理である。このジェスチャー識別処理も失敗する場合と、成功する場合の2つのケースが存在する。失敗した場合はステップS241に進み、データ処理部205においてアバターの表示切り替え等の処理が実行される。この処理については後述する。成功した場合は、例えばステップS242に示すような例えば[ピースサインのウェーブ]であるとの検出情報を取得し、次のステップに移行する。

【0127】

図16を参照して説明したように、ユーザの動作(ジェスチャー)に基づいて情報処理装置が実行する処理も、複数の異なる処理をパイプライン化した処理として実行され、各処理ステージでエラーを発生する可能性がある。このようなエラーが発生すると、ユーザ要求に対する情報処理装置の応答や処理が実行されなくなる。結果として、情報処理装置に対する何らかの要求や問いかけを行ったユーザは、アバターが何の応答もしてくれず、情報処理装置も新たな処理を開始しないので、情報処理装置が全くユーザの要求を聞いていないのか、あるいは処理を実行中で待機すればよいのか、全く理解できなくなってしまう。

【0128】

このような事態を防止するため、本発明の情報処理装置は、各処理ステージにおける情報処理装置の処理状況に応じてアバターの表示変更を行う。あるいはアバターの応答を行う。

この例について、図17を参照して説明する。

【0129】

図17に示す処理内容(1)〜(4)は、図16に示す処理ステップS210〜S240の各処理に対応する。(5)は最終処理としてのタスク管理処理を示している。図17に示す処理は、以下の(1)〜(5)の処理である。

(1)手検出処理(S210)

(2)指検出処理(S220)

(3)手のパターン認識処理(S230)

(4)動作(ジェスチャー)識別処理(S240)

(5)タスク管理

【0130】

先に図16を参照して説明したように、ステップS210〜S240の処理においては、エラーが発生する可能性がある。エラーが発生した場合は後段の処理ステージの処理が実行されないことになる。このような場合、本発明の情報処理装置では、アバターの表示を変更する。なお、説明のため、アバターの表示態様については、図17の右端欄に示すように、異なるアバター表示の各々について、アバター表示(a),(b),(c),・・・として記号で区別して説明する。

【0131】

例えば、図17(1)画像からの手検出処理(S210)において、処理実行中は、アバター表示例の図17(1)の上段に示すように、見ていることを示すように頭を揺り動かした状態のアバター(アバター表示(a))を表示する。この表示により、ユーザは情報処理装置がユーザの動作(ジェスチャー)を確かに見ていることを確認することができる。

【0132】

一方、例えば情報処理装置が手検出処理(S210)に失敗した場合は、アバターの表示は、図17(1)の下段に示すように、頭を揺り動かした状態(a)から、ポカンとしたアバター表示(b)に変更され、処理エラー(手検出失敗)が発生したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの動作(ジェスチャー)を確認できていないことを知ることができる。

【0133】

図17(2)指検出処理(S220)において、指検出に失敗した場合は、アバターの表示は、図17(2)の右端欄に示すように、頭を揺り動かした状態(a)から、ポカンとしたアバター表示(b)に変更され、処理エラー(手検出失敗)が発生したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの動作(ジェスチャー)を確認できていないことを知ることができる。

【0134】

図17(3)手の形状パターン認識処理(S230)において、手の形状パターン認識に失敗した場合は、アバターの表示は、図17(3)の右端欄に示すように、頭を揺り動かした状態(a)から、困った表情のアバター表示(c)に変更され、処理エラー(手の形状パターン認識に失敗)が発生したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの動作(ジェスチャー)を確認できていないことを知ることができる。

【0135】

図17(4)動作(ジェスチャー)識別処理(S240)において、動作(ジェスチャー)識別に失敗した場合は、アバターの表示は、図17(4)の右端欄に示すように、頭を揺り動かした状態(a)から、困った表情のアバター表示(c)に変更され、処理エラー(手の形状パターン認識に失敗)が発生したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの動作(ジェスチャー)を確認できていないことを知ることができる。

【0136】

一方、図17(4)動作(ジェスチャー)識別処理(S240)において、動作(ジェスチャー)識別に成功した場合は、(4)下段のアバター表示例に示すように、頭を揺り動かした状態(a)から、口を大きく開け、笑ったアバター表示(d)に変更され、処理に成功(ユーザ発話を理解できた)したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置がユーザの動作(ジェスチャー)を理解したことを確認することができる。

【0137】

図17(7)タスク管理の処理において、例えば、データ処理部205が、ユーザの動作(ジェスチャー)を理解でき、アプリケーションにおいて実行可能と判定された場合は、口を大きく開け、笑ったアバター表示(d)から、口を開け、笑ったアバター表示(e)に変更され、処理に成功(ユーザ動作(ジェスチャー)による処理が開始)したことを示す表示に切り替わる。その後、また元のアバター表示(a)状態に変更される。この表示により、ユーザは情報処理装置において、ユーザの動作(ジェスチャー)に基づく処理が開始されることを確認することができる。

【0138】

このように、本発明の情報処理装置では、情報処理装置の実行する様々な処理ステージにおける処理の状況(成功/失敗等)に応じて、アバターの表示を変更し、装置の状態をユーザに提示して知らせる構成としている。この処理によってユーザは装置の状態をある程度把握でき、例えば、アバターが困った表情である場合は、再度、要求を発話するといった処理を行うことが可能となり、ただ待機するといった無駄な処理を省くことが可能となる。

【0139】

なお、図17を参照して説明した処理ではアバターの表情のみを変更する例として説明したが、アバターの発話として具体的な処理情報についての文書表示処理や、音声出力処理を行う構成としてもよい。すなわち、情報処理装置の代理としてのアバターを表示部に表示し、表示したアバターを介して情報処理装置の状況の説明情報を出力する処理を行う構成としてもよい。例えば失敗した処理の説明や成功した処理の内容などを出力する処理を行う。

【0140】

[5.情報処理装置のハードウェア構成例について]

最後に、図18を参照して、上述した処理を実行する情報処理装置のハードウェア構成例について説明する。CPU(Central Processing Unit)701は、ROM(Read Only Memory)702、または記憶部708に記憶されているプログラムに従って各種の処理を実行する。

例えば、図2の情報処理装置の構成における音声解析部202、画像解析部204、データ処理部205の処理を実行する。RAM(Random Access Memory)703には、CPU701が実行するプログラムやデータなどが適宜記憶される。これらのCPU701、ROM702、およびRAM703は、バス704により相互に接続されている。

【0141】

CPU701はバス704を介して入出力インタフェース705に接続され、入出力インタフェース705には、カメラ、マイク、リモコン、キーボード、マウスなどの入力部706、ディスプレイ、スピーカなどよりなる出力部707が接続されている。CPU701は、入力部706から入力される情報に対応して各種の処理を実行し、処理結果を例えば出力部707に出力する。

【0142】

入出力インタフェース705に接続されている記憶部708は、例えばハードディスクからなり、CPU701が実行するプログラムや各種のデータを記憶する。

さらに、音声認識処理に必用となる各種の音声情報や辞書データ、さらには、ユーザ認識処理に必用となるユーザ画像データ等が記録されている。通信部709は、インターネットやローカルエリアネットワークなどのネットワークを介して外部の装置と通信する。

【0143】

入出力インタフェース705に接続されているドライブ710は、磁気ディスク、光ディスク、光磁気ディスク、或いは半導体メモリなどのリムーバブルメディア711を駆動し、記録されているプログラムやデータなどを取得する。取得されたプログラムやデータは、必要に応じて記憶部708に転送され記憶される。

【0144】

以上、特定の実施例を参照しながら、本発明について詳解してきた。しかしながら、本発明の要旨を逸脱しない範囲で当業者が実施例の修正や代用を成し得ることは自明である。すなわち、例示という形態で本発明を開示してきたのであり、限定的に解釈されるべきではない。本発明の要旨を判断するためには、特許請求の範囲の欄を参酌すべきである。

【0145】

また、明細書中において説明した一連の処理はハードウェア、またはソフトウェア、あるいは両者の複合構成によって実行することが可能である。ソフトウェアによる処理を実行する場合は、処理シーケンスを記録したプログラムを、専用のハードウェアに組み込まれたコンピュータ内のメモリにインストールして実行させるか、あるいは、各種処理が実行可能な汎用コンピュータにプログラムをインストールして実行させることが可能である。例えば、プログラムは記録媒体に予め記録しておくことができる。記録媒体からコンピュータにインストールする他、LAN(Local Area Network)、インターネットといったネットワークを介してプログラムを受信し、内蔵するハードディスク等の記録媒体にインストールすることができる。

【0146】

なお、明細書に記載された各種の処理は、記載に従って時系列に実行されるのみならず、処理を実行する装置の処理能力あるいは必要に応じて並列的にあるいは個別に実行されてもよい。また、本明細書においてシステムとは、複数の装置の論理的集合構成であり、各構成の装置が同一筐体内にあるものには限らない。

【産業上の利用可能性】

【0147】

以上、説明したように、本発明の一実施例の構成によれば、ユーザ発話やジェスチャーにより、情報処理装置に様々な処理を実行させることを可能とした装置および方法が提供される。ユーザ発話の音声解析処理や、ユーザ動作(ジェスチャー)を解析する画像解析を実行し、これらの解析結果に基づいて情報処理装置の実行する処理を決定する。さらに、ユーザ発話やユーザ動作に対する情報処理装置の認識結果を含む情報をフィードバック情報として表示または音声出力する。さらにユーザからの要求に対する情報処理装置の応答や、情報処理装置の処理状況等を、情報処理装置の代理であるアバターを介して表示、出力する。ユーザはこれらのフィードバック情報を取得することで、誤りの少ない確実な処理を実行できる。

【符号の説明】

【0148】

11〜13 ユーザ

100 情報処理装置

101 カメラ

102 音声入出力部

201 音声入力部

202 音声解析部

203 画像入力部

204 画像解析部

205 データ処理部

206 音声出力部

207 画像出力部

300 フィードバック情報表示領域

301 ユーザ画像

302 ユーザ入力情報

303 アバター

304 装置処理情報

350 ガイド付き情報入力領域

370 ガイド情報表示領域

371 装置状態表示欄

372 ガイド情報表示欄

381 フィードバック情報表示領域

382 ガイド付き情報入力領域

383 ガイド情報表示領域

384 コンテンツリスト表示領域

391,392 ユーザ画像

395 アバター

501 ユーザ

502 アバター

701 CPU

702 ROM

703 RAM

704 バス

705 入出力インタフェース

706 入力部

707 出力部

708 記憶部

709 通信部

710 ドライブ

711 リムーバブルメディア

【特許請求の範囲】

【請求項1】

ユーザ発話の解析処理を実行する音声解析部と、

前記音声解析部の解析結果を入力し、情報処理装置の実行する処理を決定するデータ処理部を有し、

前記データ処理部は、

ユーザ発話に関する情報処理装置の認識結果を示すフィードバック情報を生成して出力する処理を行う情報処理装置。

【請求項2】

前記情報処理装置は、

ユーザ動作を解析する画像解析部を有し、

前記データ処理部は、前記画像解析部の解析結果を入力し、情報処理装置の実行する処理を決定し、ユーザ動作に関する情報処理装置の認識結果を示すフィードバック情報を生成して出力する処理を行う請求項1に記載の情報処理装置。

【請求項3】

前記データ処理部は、

前記フィードバック情報として、ユーザ発話の音声認識結果を示すユーザ発話内容、または、ユーザ動作に基づいて情報処理装置が認識した要求内容を出力する請求項1または2に記載の情報処理装置。

【請求項4】

前記データ処理部は、

前記フィードバック情報として、ユーザ発話またはユーザ動作に対する情報処理装置の応答または情報処理装置の装置状態を示す情報を出力する請求項1または2に記載の情報処理装置。

【請求項5】

前記データ処理部は、

前記フィードバック情報として、ユーザ発話またはユーザ動作に対する情報処理装置の応答または情報処理装置の装置状態を示す情報を、情報処理装置の代理としてのアバターを介して出力する請求項4に記載の情報処理装置。

【請求項6】

前記データ処理部は、

前記フィードバック情報として、ユーザ発話またはユーザ動作に対する情報処理装置の状況を示すため、情報処理装置の代理としてのアバターの表示態様を変更する処理を行う請求項1または2に記載の情報処理装置。

【請求項7】

前記データ処理部は、

ユーザによるデータ入力が可能な情報入力領域を表示部に出力し、かつ、該情報入力領域に入力可能なデータについてのガイド情報を表示する処理を行う請求項1または2に記載の情報処理装置。

【請求項8】

前記データ処理部は、

前記画像解析部における画像解析結果に基づいてユーザ識別処理を実行し、識別ユーザのユーザ画像と、情報処理装置の代理としてのアバターを表示部に表示して、双方の対話内容を表示する請求項2に記載の情報処理装置。

【請求項9】

情報処理装置において、情報処理を実行する情報処理方法であり、

音声解析部が、ユーザ発話の解析処理を実行する音声解析ステップと、

データ処理部が、前記音声解析ステップにおける解析結果を入力し、情報処理装置の実行する処理を決定するデータ処理ステップを有し、

前記データ処理ステップは、

ユーザ発話に関する情報処理装置の認識結果を示すフィードバック情報を生成して出力する処理を行うステップを含む情報処理方法。

【請求項10】

情報処理装置において、情報処理を実行させるプログラムであり、

音声解析部に、ユーザ発話の解析処理を実行させる音声解析ステップと、

データ処理部に、前記音声解析ステップにおける解析結果を入力させ、情報処理装置の実行する処理を決定させるデータ処理ステップを有し、

前記データ処理ステップは、

ユーザ発話に関する情報処理装置の認識結果を示すフィードバック情報を生成して出力する処理を行わせるステップを含むプログラム。

【請求項1】

ユーザ発話の解析処理を実行する音声解析部と、

前記音声解析部の解析結果を入力し、情報処理装置の実行する処理を決定するデータ処理部を有し、

前記データ処理部は、

ユーザ発話に関する情報処理装置の認識結果を示すフィードバック情報を生成して出力する処理を行う情報処理装置。

【請求項2】

前記情報処理装置は、

ユーザ動作を解析する画像解析部を有し、

前記データ処理部は、前記画像解析部の解析結果を入力し、情報処理装置の実行する処理を決定し、ユーザ動作に関する情報処理装置の認識結果を示すフィードバック情報を生成して出力する処理を行う請求項1に記載の情報処理装置。

【請求項3】

前記データ処理部は、

前記フィードバック情報として、ユーザ発話の音声認識結果を示すユーザ発話内容、または、ユーザ動作に基づいて情報処理装置が認識した要求内容を出力する請求項1または2に記載の情報処理装置。

【請求項4】

前記データ処理部は、

前記フィードバック情報として、ユーザ発話またはユーザ動作に対する情報処理装置の応答または情報処理装置の装置状態を示す情報を出力する請求項1または2に記載の情報処理装置。

【請求項5】

前記データ処理部は、

前記フィードバック情報として、ユーザ発話またはユーザ動作に対する情報処理装置の応答または情報処理装置の装置状態を示す情報を、情報処理装置の代理としてのアバターを介して出力する請求項4に記載の情報処理装置。

【請求項6】

前記データ処理部は、

前記フィードバック情報として、ユーザ発話またはユーザ動作に対する情報処理装置の状況を示すため、情報処理装置の代理としてのアバターの表示態様を変更する処理を行う請求項1または2に記載の情報処理装置。

【請求項7】

前記データ処理部は、

ユーザによるデータ入力が可能な情報入力領域を表示部に出力し、かつ、該情報入力領域に入力可能なデータについてのガイド情報を表示する処理を行う請求項1または2に記載の情報処理装置。

【請求項8】

前記データ処理部は、

前記画像解析部における画像解析結果に基づいてユーザ識別処理を実行し、識別ユーザのユーザ画像と、情報処理装置の代理としてのアバターを表示部に表示して、双方の対話内容を表示する請求項2に記載の情報処理装置。

【請求項9】

情報処理装置において、情報処理を実行する情報処理方法であり、

音声解析部が、ユーザ発話の解析処理を実行する音声解析ステップと、

データ処理部が、前記音声解析ステップにおける解析結果を入力し、情報処理装置の実行する処理を決定するデータ処理ステップを有し、

前記データ処理ステップは、

ユーザ発話に関する情報処理装置の認識結果を示すフィードバック情報を生成して出力する処理を行うステップを含む情報処理方法。

【請求項10】

情報処理装置において、情報処理を実行させるプログラムであり、

音声解析部に、ユーザ発話の解析処理を実行させる音声解析ステップと、

データ処理部に、前記音声解析ステップにおける解析結果を入力させ、情報処理装置の実行する処理を決定させるデータ処理ステップを有し、

前記データ処理ステップは、

ユーザ発話に関する情報処理装置の認識結果を示すフィードバック情報を生成して出力する処理を行わせるステップを含むプログラム。

【図2】

【図4】

【図8】

【図11】

【図12】

【図13】

【図14】

【図18】

【図1】

【図3】

【図5】

【図6】

【図7】

【図9】

【図10】

【図15】

【図16】

【図17】

【図4】

【図8】

【図11】

【図12】

【図13】

【図14】

【図18】

【図1】

【図3】

【図5】

【図6】

【図7】

【図9】

【図10】

【図15】

【図16】

【図17】

【公開番号】特開2011−209786(P2011−209786A)

【公開日】平成23年10月20日(2011.10.20)

【国際特許分類】

【出願番号】特願2010−74157(P2010−74157)

【出願日】平成22年3月29日(2010.3.29)

【出願人】(000002185)ソニー株式会社 (34,172)

【Fターム(参考)】

【公開日】平成23年10月20日(2011.10.20)

【国際特許分類】

【出願日】平成22年3月29日(2010.3.29)

【出願人】(000002185)ソニー株式会社 (34,172)

【Fターム(参考)】

[ Back to top ]