情報処理装置、ダイジェスト生成方法、及びダイジェスト生成プログラム

【課題】より適切なダイジェストを生成する。

【解決手段】情報処理装置において、所定時間撮影された1又は複数の被写体を含む映像情報及び音声情報を蓄積する蓄積部と、前記蓄積部に蓄積された映像情報及び音声情報を用いて、予め設定された1又は複数の要素に基づき、前記所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出するダイジェスト生成部と、を有し、前記ダイジェスト生成部は、前記ダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体の状況又は特徴をパターン認識し、認識された結果に基づいて前記ダイジェスト候補からダイジェストを生成するパターン認識部を有する。

【解決手段】情報処理装置において、所定時間撮影された1又は複数の被写体を含む映像情報及び音声情報を蓄積する蓄積部と、前記蓄積部に蓄積された映像情報及び音声情報を用いて、予め設定された1又は複数の要素に基づき、前記所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出するダイジェスト生成部と、を有し、前記ダイジェスト生成部は、前記ダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体の状況又は特徴をパターン認識し、認識された結果に基づいて前記ダイジェスト候補からダイジェストを生成するパターン認識部を有する。

【発明の詳細な説明】

【技術分野】

【0001】

本発明は、より適切なダイジェストを生成するための情報処理装置、ダイジェスト生成方法、及びダイジェスト生成プログラムに関する。

【背景技術】

【0002】

従来では、例えば会議の議事録等のように、ある事象に対する情報の全体からダイジェスト(概要情報)を生成する場合がある。例えば、会議の議事録のような場合には、結論や確認事項、次回までの宿題等のアクションアイテム(以下、「A.I.」と略称する)だけでなく、そこに至るまでの会議参加者の発言や会議の雰囲気等を含めた議事録を生成することが好ましいことが知られている。しかしながら、上述した議事録を生成するためには、音声や画像等のデータの収集が膨大になると共に、後から必要な部分を参照して会議概要を把握する場合には、所望の情報の検索に時間がかかってしまう。

【0003】

そこで、従来では、発言者の音声から自動的にその文章化と要約文章を作成して議事録を作成する技術が存在する。また、従来では、会議中に発生する各参加者の発話データや映像データ等を時系列形式で蓄積し、会議の開始時刻から現時点までの発話の話速、音程又は音量等により算出される盛上り度により会議概要情報を作成する技術が存在する(例えば、特許文献1,2参照)。

【先行技術文献】

【特許文献】

【0004】

【特許文献1】特開平2−206825号公報

【特許文献2】特開2004−350134号公報

【発明の概要】

【発明が解決しようとする課題】

【0005】

しかしながら、上述した特許文献1に示されている技術では、議事発言者の音声から自動的にその文章化と要約文章を作成して可視化しているが、文章ベースの議事録では会議の雰囲気、発言のニュアンス等の要素を十分に捉えたり、伝えることができなかった。

【0006】

また、特許文献2に示されている技術では、音声データにより算出される盛上りを、閾値を用いて抽出するという方法を取っているため、議事内容に関わらず盛上りの高い部分が抽出されることになる。また、この閾値は、会議の内容や参加者によって変動すると考えられ、一意に決めることはできない。したがって、このような音としての特徴にのみ注目した閾値による抽出方法では、より適切な会議概要(ダイジェスト)を正確に捉えることができなかった。

【0007】

開示の技術は、かかる問題を鑑み、より適切なダイジェストを生成することを目的とする。

【課題を解決するための手段】

【0008】

開示の一態様における情報処理装置は、所定時間撮影された1又は複数の被写体を含む映像情報及び音声情報を蓄積する蓄積部と、前記蓄積部に蓄積された映像情報及び音声情報を用いて、予め設定された1又は複数の要素に基づき、前記所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出するダイジェスト生成部と、を有し、前記ダイジェスト生成部は、前記ダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体の状況又は特徴をパターン認識し、認識された結果に基づいて前記ダイジェスト候補からダイジェストを生成するパターン認識部を有する。

【発明の効果】

【0009】

開示の技術によれば、より適切なダイジェストを生成することができる。

【図面の簡単な説明】

【0010】

【図1】実施例1における会議システムの概要構成例を示す図である。

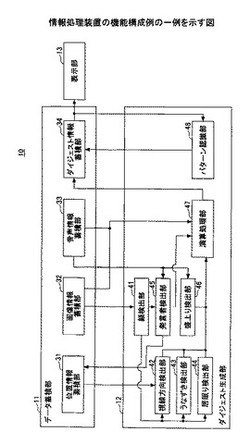

【図2】情報処理装置の機能構成例の一例を示す図である。

【図3】実施例1における各検出部の具体例を示す図である。

【図4】うなずき検出の具体例を示す図である。

【図5】居眠り判定の具体例を説明するための図である。

【図6】実施例1における画像入力部の位置、向き、画角と、視線との関係の具体例について説明するための図である。

【図7】実施例1における加算要素と減算要素の組み合わせ例を示す図である。

【図8】実施例1における点数結果とダイジェストの抽出例を示す図である。

【図9】実施例2における点数結果とダイジェストの抽出例を示す図である。

【図10】実施例3における会議システムの概要構成例を示す図である。

【図11】実施例3における複数の映像情報と被写体との位置関係の取得例について説明するための図である。

【図12】ダイジェスト生成機能を搭載したPCの概観図である。

【図13】ダイジェスト生成機能を搭載したPCのハードウェア構成例を示す図である。

【図14】ダイジェスト生成処理の一例を示すフローチャートである。

【発明を実施するための形態】

【0011】

以下、添付図面を参照しながら実施例について詳細に説明する。なお、以下の説明では、ある事象に対する情報の全体からダイジェスト(概要情報)を生成する例として、会議全体から議事録を生成する例について説明するが、これに限定されるものではない。

【0012】

<実施例1>

図1は、実施例1における会議システムの概要構成例を示す図である。図1に示す会議システム1は、情報処理装置10と、画像・音声取得装置20とを有する。情報処理装置10は、データ蓄積部11と、ダイジェスト生成部12と、表示部13とを有する。また、画像・音声取得装置20は、画像入力部21と、音声入力部22とを有する。

【0013】

データ蓄積部11は、例えばダイジェスト生成部12におけるダイジェスト生成、及び表示部13による表示等に必要な各種情報を蓄積する蓄積部である。また、データ蓄積部11は、画像・音声取得装置20の位置情報や、画像入力部21により得られる映像情報、音声入力部22により得られる音声情報等の各種データを蓄積する。なお、上述の映像情報は、例えば映像中に含まれる複数の画像情報(例えば、画像フレーム)を含むものとする。また、データ蓄積部11は、ダイジェスト生成部12において生成されたダイジェスト情報を蓄積する。

【0014】

ダイジェスト生成部12は、データ蓄積部11に蓄積されている映像情報や音声情報を用いて、例えば予め設定された1又は複数の要素等に基づき、所定の単位時間毎の状況を評価する。また、ダイジェスト生成部12は、評価結果に基づいて1又は複数のダイジェスト候補を抽出し、抽出された候補の前後の時間を含む映像情報及び音声情報を用いてダイジェストを生成する。

【0015】

なお、ダイジェスト生成部12は、上述した映像情報及び音声情報を用いて、予め設定された複数の要素に基づき、所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出する。そのとき、ダイジェスト生成部12は、上述したダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体をパターン認識により特定し、特定された被写体情報に基づいてダイジェスト候補からダイジェストを生成する。

【0016】

表示部13は、ダイジェスト生成部12により生成されたダイジェスト情報に基づいて対応するダイジェスト映像や音声を表示する。また、表示部13は、ダイジェスト生成処理を実行するための設定情報の入力画面や実行経過、実行結果、エラー情報等、多種の情報を表示することができる。表示部13は、例えばディスプレイやモニタ等である。

【0017】

画像入力部21は、所定の画角に基づく周囲の画像(映像も含む)を取得する。なお、映像とは、時系列に配列された複数の画像を含むものである。また、画像入力部21は、例えばCCD(Charge Coupled Device)等の撮像素子を有する撮像手段である。音声入力部22は、周囲の音声を取得する。なお、音声入力部22は、例えばマイク等である。

【0018】

ここで、画像入力部21及び音声入力部22は、情報処理装置10内に含まれていてもよく、またそれぞれが別体に設けられていてもよい。また、画像入力部21及び音声入力部22は、例えばデジタルカメラやビデオカメラ等の撮像手段を用いることもできる。更に、図1に示すデータ蓄積部11には、複数の画像・音声取得装置20を接続し、接続した各装置からの映像情報及び音声情報を取得するようにしてもよい。このとき、複数の画像・音声取得装置20は、例えば各装置の識別情報を含む映像情報及び音声情報を情報処理装置10に出力する。これにより、情報処理装置10は、映像情報や音声情報等を各装置の識別情報に基づいて管理することができる。

【0019】

<情報処理装置10:機能構成例>

次に、情報処理装置の機能構成例について図を用いて説明する。図2は、情報処理装置の機能構成例の一例を示す図である。図2に示す情報処理装置10は、図1と同様にデータ蓄積部11と、ダイジェスト生成部12と、表示部13とを有する。データ蓄積部11は、位置情報蓄積部31と、画像情報蓄積部32と、音声情報蓄積部33と、ダイジェスト情報蓄積部34とを有する。また、ダイジェスト生成部12は、顔検出部41と、視線方向検出部42と、うなずき検出部43と、居眠り検出部44と、発言者検出部45と、盛上り検出部46と、演算処理部47と、パターン認識部48とを有する。

【0020】

データ蓄積部11における位置情報蓄積部31は、例えば会議室内に設置された画像・音声取得装置20等の位置情報(例えば、撮影される画角に対応する参加者の位置等)を蓄積する。また、位置情報蓄積部31は、発言者検出部45により得られる発言者の位置情報を蓄積する。

【0021】

画像情報蓄積部32は、例えば上述した画像入力部21等から得られる会議中に撮影された映像情報(例えば、複数の画像情報)等を蓄積する。

【0022】

音声情報蓄積部33は、例えば上述した音声入力部22等から得られる会議中に集音された所定方向又は全周囲の音声情報等を蓄積する。なお、画像情報蓄積部32に蓄積される映像情報と、音声情報蓄積部33に蓄積される音声情報とは、例えば時間情報等が付加され、お互いが対応付けられているものとする。

【0023】

また、上述した映像情報や音声情報は、画像入力部21や音声入力部22以外の手段から取得してもよい。具体的には、上述した映像情報や音声情報は、例えばUSB(Universal Serial Bus)メモリやCD(Compact Disc)、DVD(Digital Versatile Disc)等の記録媒体から取得してもよい。また、上述した映像情報や音声情報は、例えばインターネット等の通信ネットワークを介して接続される外部装置からのダウンロード等により取得してもよい。

【0024】

ダイジェスト情報蓄積部34は、ダイジェスト生成部12の演算処理部47により演算された点数や経過時間等から得られるダイジェスト情報、又はパターン認識部48により特定されたダイジェスト情報等を蓄積する。

【0025】

また、ダイジェスト生成部12における顔検出部41は、画像情報蓄積部32に蓄積されている映像に含まれる画像情報に基づいて、画像中に含まれる少なくとも1人の会議参加者(被写体)の顔の位置情報(例えば、画面中の位置座標)等を検出する。なお、顔検出部41は、入力画像から顔が検出された場合には、その顔の位置情報のみを出力したり、入力画像に顔の位置情報を付加して出力することができる。

【0026】

視線方向検出部42は、例えば顔検出部41により入力される顔の位置情報が付加された画像情報に基づいて、会議参加者毎の視線方向を検出する。また、視線方向検出部42は、位置情報蓄積部31から発言者の位置情報を取得し、その位置情報から各参加者の視線が発言者に向いているか否かを判断する。

【0027】

うなずき検出部43は、例えば顔検出部41により入力される画像情報に基づいて、会議参加者のうなずきを検出する。居眠り検出部44は、例えば顔検出部41により入力される画像情報に基づいて、会議参加者の居眠りを検出する。発言者検出部45は、例えば顔検出部41により入力される画像情報と、音声情報蓄積部33に蓄積されている音声情報とに基づいて発言者を検出する。盛上り検出部46は、例えば音声情報蓄積部33に蓄積されている音声情報等に基づいて、会議が盛り上がっていると判断される位置(時間)を検出する。

【0028】

演算処理部47は、例えばダイジェスト生成部12に含まれる上述した各検出部(顔検出部41、視線方向検出部42、うなずき検出部43、居眠り検出部44、発言者検出部45、盛上り検出部46)から、会議参加者人数、時間、音量等の情報等を取得する。また、演算処理部47は、取得した各種情報(要素)等に基づいて、所定の単位時間毎の状況を評価するため、所定の単位時間毎の点数等を算出する。また、演算処理部47は、算出された点数等に基づいて、画像情報蓄積部32及び音声情報蓄積部33から所定部分(所定場面)の映像情報(1又は複数の画像情報も含む)及び音声情報をダイジェスト候補として抽出する。

【0029】

また、演算処理部47は、抽出した候補の前後の時間を含む映像情報及び音声情報と、予め設定されるダイジェストの合計時間等に応じて、最終的に使用されるダイジェストを生成し、ダイジェスト情報蓄積部34に出力する。なお、演算処理部47は、算出された点数等もダイジェスト情報蓄積部34に出力することができる。

【0030】

また、演算処理部47は、上述した映像情報及び音声情報を用いて、予め設定された複数の要素に基づき、所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出する。

【0031】

パターン認識部48は、予め設定されたパターンに基づいて、ダイジェスト情報蓄積部34に蓄積された内容から抽出すべきダイジェストを認識する。具体的には、パターン認識部48は、例えば上述したダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体をパターン認識により特定し、特定された被写体情報に基づいて、ダイジェスト候補から所定のダイジェストを生成する。また、パターン認識部48は、パターン認識結果をダイジェスト情報蓄積部34に出力する。

【0032】

また、表示部13は、上述した処理によりダイジェスト情報蓄積部34から得られるダイジェストを表示する。

【0033】

次に、上述した各検出部の具体的な処理内容について説明する。図3は、実施例1における各検出部の具体例を示す図である。なお、図3(A)は視線方向検出部42の具体例を示し、図3(B)はうなずき検出部43の具体例を示し、図3(C)は居眠り検出部44の具体例を示し、図3(D)は発言者検出部45の具体例を示し、図3(E)は盛上り検出部46の具体例を示している。

【0034】

<顔検出部41の具体的な処理内容>

実施例1における顔検出部41は、画像情報蓄積部33に蓄積された映像に含まれる各画像情報から、各画像フレーム内における1又は複数の顔の位置を検出し、後段の検出部に対して顔の位置情報や画像情報を出力する。なお、顔検出部41における顔検出手法としては、例えば画像中から顔の特徴情報(例えば、顔の輪郭、目、鼻、口等の特徴点)に基づいて顔を検出することができる。また、他の顔検出手法としては、例えば予め設定された特徴パラメータ(例えば、顔の特徴点のそれぞれの位置やバランス、色情報等)とのパターンマッチングを行うことで、顔検出を行うことができるが、これに限定されるものではない。

【0035】

また、顔検出部41は、例えば入力画像から顔が検出された場合に、その入力画像に顔の位置情報を付加し、視線方向検出部42、うなずき検出部43、居眠り検出部44、発言者検出部45等に出力する。

【0036】

更に、顔検出部41は、予め複数の人物(被写体)の顔の特徴情報を蓄積しておき、その特徴情報に基づいて、入力画像中に含まれる人物を特定することもできる。

【0037】

<視線方向検出部42の具体的な処理内容>

図3(A)に示す視線方向検出部42は、目検出部51と、方向判定部52とを有する。目検出部51は、入力した顔の位置情報が付加された各画像から目の位置を検出する。また、方向判定部52は、目検出部51により検出された上述した位置情報蓄積部31から入力された位置情報に基づいての視線方向を判定する。また、方向判定部52は、判定された視線の方向が、発言者に対して向けられているかどうかを判定する。なお、発言者の位置は、発言者検出部45により検出された発言者の位置情報等を位置情報蓄積部31から取得して用いることができる。

【0038】

ここで、方向判定部52は、例えば予め設定された単位時間(例えば、60秒)のうち、新たに発言者に対して視線を向けていると判定された人物を検出する。そして、方向判定部52は、上述した人物を検出した場合に、演算処理部47において注目度合いを算出するために、発言者に視線を向けている人物の画像を抽出し、その人物の画像を出力データとして演算処理部47に出力する。なお、方向判定部52は、発言者に視線を向けている人物が、すでに演算処理部47に出力されている人物と同一である場合には、演算処理部47への出力は行わない。

【0039】

ここで、上述した内容について具体的に説明する。なお、実施例1では、例えば発言者検出部45により単位時間60秒中のある時点YAにおける発言者位置を特定できているものとする。このとき、方向判定部52は、単位時間60秒中のある時点YAの画像Aに映っている参加者(被写体)から見た発言者位置の方向(角度)αと、参加者の視線方向(角度)θ1とが等しい場合、その参加者は単位時間60秒中に発言者に視線を向けていると判定する。

【0040】

これにより、演算処理部47は、方向判定部52から判定結果として得られる出力データから単位時間60秒あたりの発言者に視線を向けている人数として加算する。

【0041】

<うなずき検出部43の具体的な処理内容>

図3(B)に示すうなずき検出部43は、顔傾斜検出部61と、うなずき判定部62とを有する。顔傾斜検出部61は、入力画像に対して顔の傾斜を検出する。また、うなずき判定部62は、入力した顔の位置情報が付加された各画像を前後の時間の同画像と比較し、顔傾斜検出部61により検出された顔傾斜情報を用いて、顔の傾斜が閾値以上であればうなずきと判定する。

【0042】

ここで、うなずき判定部62は、例えば予め設定された単位時間(例えば、60秒)のうち、新たにうなずいていると判定された1又は複数の人物を検出する。そして、うなずき判定部62は、上述した人物を検出した場合に、演算処理部47においてうなずき度合いを算出するため、うなずいている人物の画像を演算処理部47に出力する。なお、うなずき判定部62は、うなずいている人物が、すでに演算処理部47に出力されている人物と同一である場合には、演算処理部47への出力は行わない。

【0043】

ここで、上述したうなずき検出の具体例について説明する。図4は、うなずき検出の具体例を示す図である。うなずき検出部43は、例えば予め設定された単位時間60秒(例えば、1800フレーム)中のある時点YAにおいて、ある人物の顔の位置情報を有する画像Aを検出した場合、時間YAの前後15フレーム中(計30フレーム=1秒間)に同一人物の顔が映っている画像A1〜ANを抽出する。次に、うなずき検出部43は、図4(A)に示すように、画像A1〜ANのうち、両目と口を含む矩形領域の高さが最も高い画像AH(矩形領域の高さah)と、画像AH以外の画像A1〜ANに映っている顔について、両目と口を含む矩形領域の高さ(an)、及び矩形領域の中心点位置の比較を行う。

【0044】

ここで、人物の顔の高さについての近似計算は、図4(B)に示すように求めることができる。つまり、実施例1では、画像A1〜ANのうち画像AHに比べ矩形領域の高さが√3/2以下(例えば、顔の傾斜角θが30°以上)であり、かつ矩形領域中心点が画像AHの矩形領域中心点CHより低い位置にある画像AU1〜AUNを2フレーム以上検出する。また、画像を2フレーム以上検出した場合には、更に図4(C)に示すようにAU1〜AUN間の画像について、矩形領域中心点CH以上である画像AUが1フレーム以上あれば、その人物(参加者)は、単位時間中にうなずいていると判定する。

【0045】

これにより、演算処理部47は、うなずき判定部62から判定結果として得られる出力データから単位時間60秒あたりのうなずいている人数として加算する。

【0046】

<居眠り検出部44の具体的な処理内容>

図3(C)に示す居眠り検出部44は、目検出部71と、顔傾斜検出部72と、居眠り判定部73とを有する。なお、目検出部71及び顔傾斜検出部72は、上述した目検出部51及び顔傾斜検出部61と同様の処理を行うため、ここでの具体的な説明は、省略する。つまり、目検出部71は、入力した顔の位置情報が付加された各画像から目を検出する。また、顔傾斜検出部72は、上述したように入力画像に含まれる顔画像の位置を時系列に計測して顔の傾斜を検出する。居眠り検出部73は、前後の時間の同画像のうち、目を開いているときの画像と比較し、顔の傾斜が下向きであり、かつ目をつぶっていると判断した場合には、居眠りと判定する。

【0047】

ここで、居眠り判定部73は、例えば予め設定された単位時間(例えば、60秒)のうち、新たに居眠りと判定された1又は複数の人物を検出する。そして、居眠り判定部73は、上述した人物を検出した場合に、演算処理部47において居眠り人数を算出するため、居眠りと判定された人物の画像を演算処理部47に出力する。なお、居眠り判定部73は、居眠りしている人物が、すでに演算処理部47に出力されている人物と同一である場合には、演算処理部47への出力は行わない。

【0048】

ここで、上述した居眠り判定について更に具体的に説明する。図5は、居眠り判定の具体例を説明するための図である。居眠り判定部73は、例えば、単位時間60秒(1800フレーム)中のある時点YAにおいて、ある人物の顔の位置情報を持つ画像Aを検出した場合、単位時間60秒中に同一人物の顔が映っている画像A1〜ANを抽出する。また、居眠り判定部73は、図5(A)に示すように、会議中の同一人物の顔が映っている画像のうち、両目と口を含む矩形領域の高さが最も高い画像AH(矩形領域の高さah)と、画像AH以外の画像A1〜ANについて、両目と口を含む矩形領域の高さ(an)、及び矩形領域の中心点位置の比較を行う。なお、図5(A)の例は、上述した図4(A)と同様である。

【0049】

また、居眠り判定部73は、上述したように、画像A1〜ANのうち画像AHに比べ矩形領域の高さが√3/2以下(顔の傾斜角θが30°以上)であり、かつ矩形領域中心点が画像AHの矩形領域中心点CHより低い位置にある画像を取得する。更に居眠り判定部73は、取得した画像から、図5(B)に示すように目をつぶっていると判断される画像AI1〜AINが連続して所定数(例えば、1620フレーム(単位時間の9割))以上あれば、その人物は単位時間のうちに居眠りしていると判定する。

【0050】

これにより、演算処理部47は、居眠り判定部73から判定結果として得られる出力データから単位時間60秒あたりの居眠り人数として加算する。

【0051】

<発言者検出部45の具体的な処理内容>

図3(D)に示す発言者検出部45は、口検出部81と、発言判定部82とを有する。口検出部81は、入力した顔の位置情報が付加された各画像から口の位置を検出する。また、発言判定部82は、口検出部81により得られる口検出結果と、音声情報蓄積部33から入力された音声情報とに基づいて発言者を判定する。

【0052】

ここで、発言判定部82は、例えば予め設定された単位時間(例えば、60秒)のうち、新たに発言者と判定された1又は複数の人物を検出する。そして、発言判定部82は、上述した人物を検出した場合に、演算処理部47において発言者数、沈黙度合いを算出するため、発言者画像を演算処理部47に出力する。なお、発言判定部82は、発言者がすでに演算処理部47に出力されている人物と同一である場合には、演算処理部47への出力は行わない。

【0053】

<盛上り検出部46の具体的な処理内容>

図3(E)に示す盛上り検出部46は、音量判定部91を有する。音量判定部91は、音声情報蓄積部33から入力された音声情報から音量値を測定する。また、音量判定部91は、測定した音量値が、予め設定した標準値(例えば、60dB)以上であれば、演算処理部47において盛上りを算出するため、音量値を演算処理部47に出力する。

【0054】

<実施例1における画像入力部21の位置、向き、画角と、視線との関係>

ここで、実施例1におけるカメラ等の画像入力部21の位置、向き、画角と、視線との関係の具体例について、図を用いて説明する。図6は、実施例1における画像入力部の位置、向き、画角と、視線との関係の具体例について説明するための図である。

【0055】

なお、図6の例では、一例として会議参加者である被写体A〜Cは、図6(A)に示すように、画像入力部21であるカメラD1の撮影範囲(例えば、画角θc)内に収まるように着席しているものとする。

【0056】

ここで、図6の例では、予め設定された単位時間(例えば、60秒(1800フレーム))中のある時点YBにおいて、ある人物の顔の位置情報を有する画像Bを検出した場合を示している。このような場合には、図6(B)に示すように、会議中の同一人物の顔が映っている画像のうち両目と口を含む矩形領域面積が最も広い画像BHと画像Bの矩形領域の上辺の長さ及び中心点位置より、時間YBにおける水平角θ1を求める。なお、矩形領域面積が最も広い画像BHは、例えば画角内の顔位置に関わらず、まっすぐに画像入力部を見ている人物の画像となる。

【0057】

つまり、図6(B)の例では、BHの矩形領域の上辺の長さbh、Bの矩形領域の上辺の長さb、顔の水平角をθ1とし、cosθ1=bh/bより水平角θ1を求める。また、実施例1では、図6(C)に示すように、例えばLED(Light Emitting Diode)等の発光部と受光部により、三角測量の原理を利用し、反射光の入射角により、対象物である被写体までの距離I1を取得する。また、実施例1では、例えば写真測量法により、画像入力部21により撮影された画像中心からの実際の距離dを取得する。更に、実施例1では、上述した距離I1と距離dとにより、真正面からの被写体位置の角度θ1’(例えば、図6(C)に示すsinθ1’=d/I1)を求めることができる。

【0058】

<実施例1における演算処理部47の演算手法>

次に、実施例1における演算処理部47の演算手法について説明する。演算処理部47では、上述した各検出部から得られるデータを用いて、各々の算出手法に基づき点数を算出する。

【0059】

具体的には、演算処理部47は、データ蓄積部11に蓄積された映像情報と音声情報とから予め設定された短い単位時間毎の会議の状況を、複数の観点で数値評価し、その合計点数を算出する。更に、演算処理部47は、算出された点数の高い場面を上位から複数抽出する。また、演算処理部47は、抽出した場面の前後に時間を広げた映像と音声とをダイジェスト場面とし、そのダイジェスト場面を複数連結して会議のダイジェストを生成する。

【0060】

なお、演算処理部47は、上述した短い単位時間毎の場面の数値評価の例として、例えば注目度合い、うなずき度合い、発言者数、盛上り等を加算要素として用いる。また、演算処理部47は、居眠り人数、沈黙度合い等を減算要素として用いる。演算処理部47は、これらの加算要素及び減算要素を用いて評価を行う。

【0061】

ここで、上述した加算要素及び減算要素のそれぞれの具体例について説明する。

【0062】

<加算要素>

加算要素について、例えば、注目度合いについては、予め設定された単位時間(例えば、60秒)あたりの発言者に対して視線を向けている人数n(人)及び時間m(秒)を用いて、点数xを、例えば以下の式(1)により算出する。

x=(n×m)/(参加人数×60) ・・・(1)

なお、発言者に対して視線を向けている人数は、例えば上述した視線方向検出部42から得られる出力データにより取得することができる。

【0063】

また、うなずき度合いについては、例えば会議参加者のうち、予め設定された単位時間(例えば、60秒)あたりのうなずいている人数n(人)を用いて、会議参加者に占める割合を点数xとして、例えば以下の式(2)により算出する。

x=n/参加人数 ・・・(2)

なお、うなずいている人数は、例えば上述したうなずき検出部43から得られる出力データにより取得することができる。

【0064】

また、発言者数については、例えば予め設定される単位時間(例えば、60秒)あたりの発言者数n(人)を用い、会議参加者数に占める割合を点数xとして、例えば以下の式(3)により算出する。

x=n/参加人数 ・・・(3)

なお、発言者数は、例えば上述した発言者検出部45から得られる出力データにより取得することができる。

【0065】

更に、盛上りについては、例えば予め設定された単位時間(例えば、60秒)あたりの平均ボリューム(音量)n(dB)を用いて、予め設定されるボリュームの標準値(例えば、60dB)からの倍率を点数xとして、例えば以下の式(3)により算出する。

x=10^((n−60)/20) ・・・(4)

(例えば、n(dB)=20log10(x))

なお、ボリュームについては、例えば上述した盛上り検出部46から得られる出力データにより取得することができる。

【0066】

<減算要素>

減算要素について、例えば、居眠り人数については、例えば、予め設定された単位時間(例えば、60秒)のうちに居眠りと判定された人数n(人)を用いて、会議参加者数に占める割合を点数xとして、例えば以下の式(5)により算出する。

x=n/参加人数 ・・・(5)

なお、居眠り人数については、例えば上述した居眠り検出部44から得られる出力データにより取得することができる。

【0067】

更に、沈黙度合いについては、例えば予め設定された単位時間(例えば、60秒)あたりの発言者数が0人である時間n(秒)を用いて、点数xを、例えば以下の式(6)により算出する。

x=n/60 ・・・(6)

なお、発言者数が0人である時間は、例えば上述した発言者検出部45から得られる出力データにより取得することができる。

【0068】

上述したようにして得られた加算要素又は減算要素については、それぞれ加算要素については加算、減算要素については減算し、各要素について算出された点数を合計し、その値を経過時間Y(分)の点数X(点)とする。

【0069】

更に、実施例1では、上述した各加算要素及び減算要素は、少なくとも1つを用いて点数を算出することができるが、これに限定されるものではなく、例えばダイジェストを生成する目的や入力される映像や音声の内容等に応じて任意に選択することができる。ここで、図7は、実施例1における加算要素と減算要素の組み合わせ例を示す図である。

【0070】

図7に示す例では、例えば、複数の会議実施形態(映像情報の撮影内容)に応じて、予め設定される加算要素と減算装置との組み合わせ例を示しており、一例として会議実施形態が「ブレーンストーミング」、「説明会」、「講演会」の場合が示されている。

【0071】

ここで、例えば、会議実施形態が「ブレーンストーミング」の場合には、活発なブレスト(ブレーンストーミング)がされていれば、加算要素が大きく増加することが想定される。また、会議実施形態が「説明会」の場合には、資料閲覧が多く、質疑応答が発生することが想定される。また、会議実施形態が「講演会」の場合には、発言者は固定され、終了前に質疑応答、拍手等の時間があることが想定される。

【0072】

つまり、実施例1では、それぞれの会議実施形態に応じたダイジェストを抽出する上で、それぞれの会議の特性(例えば、図7に示す「備考」等)に対応させて、信頼性が高く最低限必要な必須要素(例えば、図7における「○」)が選択される。また、実施例1では、信頼性が低い要素(例えば、図7における「△」)については、ユーザ等の選択等により要素に含めるか否かを設定することができる。

【0073】

また、実施例1では、例えば、加算要素と減算要素の個数が同一になるように調整したり、合計要素数が所定数以下、又は所定数以上となるように設定することもできる。なお、合計要素数を所定数以下とする場合には、その分ダイジェストの生成処理の時間を短縮することができ、所定数以上とする場合には、ダイジェスト候補の抽出精度を向上させることができる。

【0074】

更に、実施例1において、上述した加算要素と減算要素は、各要素毎にそれぞれ重み付けをつけて調整することができる。例えば上述したうなずき度合いでは、同意のうなずきである場合や単なる相槌の場合が考えられる。そのため、例えば図7に示す会議実施形態のうち「ブレーンストーミング」におけるうなずきの場合には、同意によるうなずきであり、合意事項の可能性が高いとして、重みを大きく設定する。一方、会議実施形態のうち「講演会」におけるうなずきの場合には、単なる相槌によるうなずきであるため、重みを小さく設定する。

【0075】

また、上述した注目度合いでは、例えば注目されている人数や時間が長いと、重要人物、発言である可能性が高いと想定されるため、重みが大きくなるよう調整する。また、上述した盛上りでは、標準値より静かである場合に、普通の会話以下と判断し、更に議論があまりなされていないことが想定されるため、沈黙度合いをマイナスとして調整する。一方、標準値より騒がしい場合(例えば、最大でも怒鳴っている人ぐらい)には、いろいろな人が発言していると想定されるため、内容に関わらず重要度は比較的高く設定する。

【0076】

このように、実施例1では、各要素の内容や予め設定される優先度、要素の取得回数等に応じて重み付けを行うことにより、最適なダイジェスト候補を抽出することができる。また、実施例1では、上述したように、予め設定された複数の要素に基づき、所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出することができる。

【0077】

なお、上述した加算要素と減算要素の数や種類については、上述した内容に限定されるものではなく、例えば各要素について任意に追加や変更、削除等を行うことができる。

【0078】

<ダイジェストの抽出例>

次に、上述した演算処理部47により得られる点数結果からダイジェストを抽出する例について、図を用いて説明する。図8は、実施例1における点数結果とダイジェストの抽出例を示す図である。なお、図8(A),(B)において、横軸は会議時間(分)を示し、縦軸は点数(点)を示している。また、図8(A),(B)の時間軸に対する枠線(実線)で囲まれた部分が、ダイジェスト候補又はダイジェストとして抽出された部分である。

【0079】

演算処理部47は、取得した各単位時間における点数から、予め設定された閾値よりも評価値の高い部分をダイジェスト候補として抽出する。また、演算処理部47は、そのダイジェスト候補の中から、生成するダイジェストの合計時間等に応じて、最終的に使用されるダイジェストを選択することができる。

【0080】

具体的に説明すると、図8(A)の例では、会議の長さを1時間(60分)、会議参加者を10人と仮定し、ダイジェストの長さは全体の15%(9分)と設定する。したがって、演算処理部47は、例えば約1分のダイジェスト場面を9箇所抽出する。そこで、演算処理部47は、例えば会議経緯説明、結論やA.I.等のまとめに関する発言を逃さないために、会議全体の開始5%及び終了前5%、すなわち会議開始から3分間及び会議終了3分間で、必ず1箇所以上はダイジェスト場面として抽出するよう設定する。また、演算処理部47は、残り7箇所について、点数Xの上位の場面を順に抽出する。

【0081】

なお、演算処理部47は、上位から数箇所を抽出する場合に、例えば会議の総合計時間の半分の時間を中心として前後に分け、それぞれからほぼ等しい数が抽出されるように調整してもよい。これにより、会議全体からダイジェストを生成することができる。また、演算処理部47は、上位の点数を算出した地点の時間の前後において、特に後方に重点を置く場合には、例えばその地点を中心として抽出される前後の時間をそれぞれ異なる時間(区間)で取得してもよい。その場合には、例えば、上位の点数を算出した地点を中心とし、その前15秒間と、後45秒間の範囲をダイジェスト候補として取得するようにしてもよい。

【0082】

また、図8(B)の例では、抽出地点の前後の時間を拡大する具体例を示している。つまり、実施例1において、演算処理部47は、各ダイジェスト場面は、点数の高い場面として抽出された時点を基準とし、その点数の高さ等に応じて、その前後の時間を拡大し、各ダイジェスト画面の開始時点と終了時点とを決定してダイジェスト候補として取得してもよい。なお、上述した拡大される時間は、例えば上述した基準時点の前及び後の両方から、それぞれ所定時間拡大させてもよく、前又は後の何れかのみを所定時間拡大させてもよい。

【0083】

また、実施例1において、演算処理部47は、抽出された複数のダイジェスト候補を時間情報に基づいて時系列に連結して最終的なダイジェストを生成する。なお、ダイジェストの合計時間は、予め設定された時間であってもよく、また会議実時間に比例した一定の割合の時間として算出された時間であってもよい。

【0084】

なお、実施例1では、ユーザからダイジェスト時間の拡大を要求される可能性がある。これは、例えば、あるダイジェスト場面の前後の単位時間の点数が、全時間の点数の平均点と比較して高い場合やダイジェスト提供を望むユーザが、図8(A)の例で抽出したダイジェストを閲覧し、不足を感じた場合等である。

【0085】

そこで、実施例1では、上記の際の拡大方法として、抽出された各ダイジェスト場面の点数と、前後のダイジェスト場面でない単位時間60秒の点数について比較を行い、所定のダイジェスト候補の時間の拡大を行う。

【0086】

図8(B)には、図8(A)の内容に基づいて、20%(12分)まで設定時間を拡大してよいとユーザの意思決定があった場合の例を示している。つまり、実施例1では、例えば、図8(B)の点線で囲まれた部分が、新たに追加抽出されたダイジェスト候補となる。

【0087】

実施例1では、例えば、あるダイジェスト候補の前の単位時間の点数が、あるダイジェスト候補の点数と比較して8割を超え、かつ未だダイジェスト候補に含まれていない場合、あるダイジェスト候補の前の単位時間(例えば、60秒)をダイジェスト候補として追加抽出する。

【0088】

また、実施例1では、図8(B)の場合に示すように、あるダイジェスト候補の後の単位時間(例えば、60秒)においても上記と同様の比較により判定する。また、追加抽出されたダイジェスト場面を含めたダイジェスト合計時間が、設定の20%を越える場合には、追加抽出されたダイジェスト場面の中で、点数が上位の方から追加していき、設定の20%に到達した時点で追加処理を終了する。

【0089】

なお、上述した予め設定された単位時間の一例として60秒としているが、これに限定されるものではなく、30秒や90秒、120秒、300秒等でもよい。上述した実施例1によれば、より適切なダイジェストを生成することができる。

【0090】

<実施例2>

次に、実施例2について説明する。実施例2では、上述した実施例1に示すように、単に所定の数値を用いた区間抽出だけではなく、それに関連する特定の出席者の発言も組み合わせることにより、より適切なダイジェストを生成する。

【0091】

なお、実施例2の情報処理装置における映像情報及び音声情報の収集にあたっては、図1に示す画像入力部21及び音声入力部22から取得するものとする。例えば、収集された2時間分の映像情報、音声情報の解析にあたり、以下の要素について、上述した図2,3等の各検出部にて検出を行う。これらの詳細な動作は、上述した実施例1と同じであるため、ここでの具体的な説明は省略する。

【0092】

実施例2では、例えば会議中の映像情報や音声情報を収集、解析し、会議の状態を示す要素毎に点数を算出する。また、実施例2では、算出結果から、その要素の所定の閾値以上の時系列変化の増減パターン部分と、その前後のキーマン(有力者)の発言、又は司会者の発言とを組み合わせて、ダイジェスト候補から最終的なダイジェストとして抽出する。

【0093】

なお、キーマンの発言や司会者の発言といった特定の人物の発言を検出する方法としては、従来の顔認識処理や声紋認識といった手法を用いることができる。この場合には、例えば事前にキーマンや司会者の顔認識又は声紋認識データを登録しておき、上述したパターン認識部48を用いたパターンマッチング処理により判定することができる。つまり、実施例2では、パターン認識処理を行うことで、ダイジェストの精度を上げることができる。

【0094】

<パターン認識部48について>

ここで、情報処理装置10におけるパターン認識部48について具体的に説明する。パターン認識部48では、ダイジェスト情報蓄積部34から得られる映像情報等を解析し、例えば以下に示すようなパターンを認識した場合には、その部分から得られる映像区間や音声区間をダイジェストとして抽出する。

【0095】

例えば、パターン認識部48は、単位時間あたりの発言者数が多い部分だけでなく、発言者数の増え始めも重要なダイジェストのポイントとして認識する。また、パターン認識部48は、キーマンの提案の後に参加者のうなずき度合いの増加が起こり、司会者のまとめの発言の後にも参加者のうなずき度合いの増加が起こるため、これらの部分をダイジェストのポイントとして認識する。また、パターン認識部48は、例えば「まとめ」、「A.I.」、「アクションアイテム」等といったキーワードの前後が議論のまとめやアクションアイテムの確認を行っている部分をダイジェストのポイントとして認識する。

【0096】

つまり、実施例2では、パターン認識部48により認識される状況パターンや被写体(人物)の特徴パターン等に基づいて、より的確なダイジェストの生成を実現することができる。ここで、一例として、実施例2のパターン認識部48により被写体(人物)を特定(判別)する手法について具体的に説明する。

【0097】

<特徴を用いて判別する場合>

パターン認識部48は、所定の被写体に対する特徴を予め設定しておき、会議参加者を条件に当てはめて司会者や有力者として判別する。ここで、司会者の特徴としては、例えば「会議の冒頭に会話を切り出し、会議の最後に締めくくる傾向にある」、「議題の切り換わりにその議題のまとめを行い、次の議題の提起を行う傾向にある」等である。また、有力者の特徴としては、例えば「発言時の注目度合いが高い傾向にある」、「服装がスーツである可能性が高い」等である。

【0098】

また、パターン認識部48は、例えば予め蓄積された社員データベース等との照合により被写体を特定することもできる。例えば、有力者は役職がある管理職であるとした場合には、例えば会議室の扉を開けるときに使用する従業員カードのRFID(Radio Frequency IDentification)タグ等から得られる情報を利用することができる。例えば、RFIDタグから社員番号が取得できる場合には、取得した社員番号を用いて予め蓄積されている社員データベース等を参照し、照合することで被写体を特定することができる。

【0099】

また、パターン認識部48は、被写体の座る位置、又は、所定のカメラ(画像入力部21)の位置とそのカメラからの映像に映る被写体の位置とにより、その被写体が司会者であるか有力者であるかを認識することができる。例えば、ホワイトボードの近くに位置をとるような被写体は、司会者であると判定することができる。また、会議室の上座に座る被写体は、有力者であると判定したりすることができる。

【0100】

ここで、パターン認識部48における認識のタイミングについて、例えば上述したように被写体の特徴を用いる場合には、会議終了時に、それぞれの特徴について分析、最も当てはまる人物をそれぞれ司会者、有力者として判別する。

また、例えば社員データベースと照合する場合には、会議室入室時にIC(Integrated Circuit)チップ付IDカードをスキャナ等で読み取ったり、カメラ等で顔画像を取得したり、着席時の顔画像と照合したときに、司会者、有力者を判別する。なお、IDカードがRFIDタグの場合には、非接触認証が可能である。

また、パターン認識部48は、例えば予め会議場所を指定する場合に、会議開始時における各被写体の位置を予め指定して、司会者、有力者を認識することもできる。例えば、司会者を認識する場合には、ホワイトボードの横に司会者を位置付けさせる等である。なお、上述したパターン認識手法は、複数を組み合わせてもよい。

【0101】

ここで、図9は、実施例2における点数結果とダイジェストの抽出例を示す図である。なお、図9(A),(B)において、横軸は会議時間(分)を示し、縦軸は点数(点)を示している。また、図9(A),(B)の時間軸に対する枠線(実線)で囲まれた部分が、ダイジェスト候補又はダイジェストとして抽出された部分である。会議の長さを1時間(60分)、会議参加者を10人と仮定し、ダイジェストの長さは全体の15%(9分)と設定する。

【0102】

演算処理部47は、取得した各単位時間における点数から、予め設定された閾値よりも評価値の高い部分をダイジェスト候補として抽出する。また、演算処理部47は、そのダイジェスト候補の中から、生成するダイジェストの合計時間等に応じて、最終的に使用されるダイジェストを選択することができる。

【0103】

また、パターン認識部48では、上述した状況パターンや特徴パターン等に基づいて例えば算出された点数結果の時系列から予め設定された条件に対応する点数の時系列的な変化を示す部分を抽出する。

【0104】

具体的に説明すると、図9(A)の例では、ある時間方向の閾値以内である一定のうなずき度合いの点数の変化量を示している。なお、図9(A)におけるパターン認識部48におけるダイジェスト部分の抽出条件としては、例えば「連続する3分間に0.40以上の増加を示し、かつ、その増加開始時点にてキーマンの発言或いは司会者によるまとめの発言がある場合に、増加開始時点から減少する前の時点を抽出する」という条件が設定されているものとする。

【0105】

この条件により、図9(A)では、経過時間3分にてキーマンの発言があり、経過時間3〜5分にうなずき度合いが0.15→0.6まで上昇し、経過時間5〜6分で減少しているため、経過時間3〜5分をダイジェスト場面として抽出される。また同様に、例えば経過時間11〜13分及び53〜55分といった時間についても抽出条件を満たしているため、ダイジェスト抽出対象となる。

【0106】

また、図9(B)の例では、ある時間方向の閾値以内である一定の発言者数の点数の変化量を示している。なお、図9(B)におけるパターン認識部48におけるダイジェスト部分の抽出条件としては、予め設定された所定の単位時間毎の点数の算出結果の変化量が予め設定された閾値等よりも大きい区間を基準としてダイジェストの開始時点と終了時点を決定する。

【0107】

実施例2では、例えば「3分間で0.40以上の増加を示し、かつその増加開始時点及び増加開始時点の点数以下に到達する議論の収束時点に、キーマンの発言或いは司会者のまとめの発言がある場合、増加開始時点から収束時点までを抽出する」という条件が設定されているものとする。

【0108】

この条件により、図9(B)の例では、経過時間41分にてキーマンの発言があり、経過時間41〜43分に発言者数が0.21→0.63まで上昇し、経過時間45分においてもキーマンの発言がある。そのため、図9(B)の例では、経過時間41〜45分までをダイジェスト場面として抽出される。

【0109】

<パターン認識部48における文字認識>

ここで、上述したパターン認識部48は、例えば上述した位置情報蓄積部31において、会議室内にあるホワイトボードや黒板、プロジェクターから光を投射するスクリーンや壁等の文字や図面等を提示する提示領域の位置情報を取得する。そして、パターン認識部48は、その提示領域が撮影されている映像から得られる提示領域中に記載された文字等を認識する。なお、文字認識手法としては、例えば既存のOCR(Optical Character Recognition)等を用いることができるが、これに限定されるものではない。

【0110】

これにより、実施例2では、例えばホワイトボード上に対応する画像認識から、例えば「A.I.」、「アクションアイテム」、「まとめ」、「次回予定」等の所定のキーワードの記載を文字認識することで、認識された文字を用いて会議の状況等を高精度に取得する。したがって、実施例2では、上述したような状況パターンからより適切なダイジェストを生成することができる。

【0111】

例えば、実施例2における「まとめの時間」と「文字認識のタイミング」については、「結論」、「A.I.」等の文字認識の精度を向上させるために、常時、所定の対象キーワードについてホワイトボード上の文字認識を行う。キーワードを検出した場合には、そのキーワードの書き始めからまとめが開始されている可能性が高い。そのため、パターン認識部48は、その時点からの発言に対してキーワードの音声認識による検出を行うことで、議論の「結論」や「A.I.」等をより高精度に抽出することができる。

【0112】

実施例2によれば、会議開始からの所定の時間で単位時間あたりのうなずき度合いが増加していること、またその直前でのキーマンの発言があること、所定の時間でうなずき度合いが低下したこと、その直前での司会者の発言があること等が検出できる。これにより、所定時間における時間帯の映像をダイジェストとして抽出することができる。また、上述の内容を他の要素と組み合わせて、その増加と減少の過度においてキーマンの発言や司会者の発言を組み合わせて適切なダイジェストの抽出が可能となる。

【0113】

また、実施例2では、例えば、議論のきっかけとなる増加開始前後のキーマンの発言、又は司会者の発言も抽出対象としたり、その議論の収束となる減少過程での司会者の発言をも抽出対象とすることで、議論の経過を適切に抽出することができる。

【0114】

更に、実施例2では、議論の収束となる減少過程での司会者の発言を検出する場合、「まとめ」、「AI(エーアイ)」、「アクションアイテム」といったキーワードを音声認識により検出することにより、その議論で確認した議論の結論をダイジェストとして確実に抽出することができる。また、上述した実施例では、うなずき度合いや発言者数等の単独の要素での例を示したが、これに限定されるものではなく、複数の要素を結合した点数で実施することも可能である。

【0115】

<実施例3>

次に、実施例3について説明する。上述した実施例1及び2では、画像・音声取得装置20が1つの場合について説明したが、実施例3では、画像・音声取得装置20が複数設けられている例を示す。つまり、実施例3では、複数の画像・音声取得装置20のそれぞれが、所定の画角で異なる方向を撮影し、異なる人物(被写体)の画像及び音声を取得している。なお、以下の説明では、上述した構成とほぼ同様の処理を行う構成については、同一の符号を付するものとし、ここでの具体的な説明は省略する。

【0116】

図10は、実施例3における会議システムの概要構成例を示す図である。図10に示す会議システム2は、情報処理装置10と、複数の画像・音声取得装置20−1〜20−3とを有する。なお、図10の例では、画像・音声取得装置20を3台設けているが、少なくとも1台を有していれば、台数や設置位置等についてはこれに限定されるものではない。

【0117】

画像・音声取得装置20−1〜20−3は、予め設定された位置(例えば、図10に示す会議卓上の所定の位置等)に配置されている。位置的な対応関係は、情報処理装置10の位置情報蓄積部31に予め蓄積されている。なお、複数の画像・音声装置20−1〜20−3は、会議卓上に設置してもよく、天井や壁に設置してもよい。

【0118】

また、画像・音声装置20−1〜20−3は、ハブ(HUB)100等により接続され、例えば離れた位置にある情報処理装置10とのデータの送受信が可能な状態となっている。

【0119】

図10に示す画像・音声装置20−1は、所定の画角(例えば、θ1)により参加者A及びその周囲の画像及び音声を取得する。画像・音声装置20−2は、所定の画角(例えば、θ2)により参加者B、C、D及びその周囲の画像及び音声を取得する。画像・音声装置20−3は、所定の画角(例えば、θ3)により参加者E,F及びその周囲の画像及び音声を取得する。

【0120】

情報処理装置10は、図10に示す画像・音声取得装置20−1〜20−3から得られるそれぞれの映像情報(例えば、複数の画像情報)を位置情報及び画像に付加されている時間情報に基づいて、時間に同期させて結合し、1つの映像を生成する。情報処理装置10は、上述した画像情報蓄積部32に蓄積される。また、画像・音声取得装置20−1〜20−3から得られるそれぞれの音声情報については、時間情報に基づいて、映像情報に対応させて音声情報蓄積部33に蓄積される。なお、画像・音声取得装置20−1〜20−3から得られる各映像情報と各音声情報との対応は、例えば予め設定される識別情報等を付加しておくことにより容易に対応させることができる。

【0121】

実施例2では、上述のように取得した映像情報及び音声情報に基づいて、上述した実施例1に示すダイジェスト生成と同様な手法でダイジェストを生成することができる。これにより、実施例2では、例えば広い会議室等の広範囲においても複数の画像・音声取得装置から得られる映像及び音声を用いて、より適切なダイジェストを生成することができる。

【0122】

<複数の映像情報と参加者(被写体)との位置関係>

ここで、実施例3における複数の画像・音声装置から得られた映像情報(複数の画像情報を含む)と、参加者(被写体)との位置関係の取得例について、図を用いて具体的に説明する。図11は、実施例3における複数の映像情報と被写体との位置関係の取得例について説明するための図である。

【0123】

なお、図11の例では、上述した図10と同様に3つの画像・音声取得装置20−1〜20−3を用いるものとし、各画像・音声取得装置20−1〜20−3の映像情報と、その被写体との関係が画像・音声取得装置毎に把握できているものとする。また、複数の画像・音声取得装置20−1〜20−3は、固定位置に設置され、予め位置関係が把握できているものとする。

【0124】

図11(A)の例では、説明を容易にするため、各辺の長さがLの正三角形の各頂点に各画像・音声取得装置20−1〜20−3を位置させ、正三角形の中線の延長戦上に画像・音声取得装置20の画角の中心がくるように設置する。

【0125】

ここで、例えば図11(A)に示すように、画像・音声取得装置20−1が発言者(被写体)Aを撮影している場合には、画像・音声取得装置20−1と発言者の位置関係及び画像・音声取得装置20−2と被写体Bとの位置関係により、画像・音声取得装置20−2の被写体Bから見た発言者の位置関係を算出することができる。

【0126】

つまり、図11(B)に示すように、γ=π−(θ1’+π/6)=5π/6−θ1’、β=π−(θ2’+π/6)=5π/6−θ2’と、余弦定理を用いてcosαを算出し、αを求めることができる。

【0127】

<変形例>

ここで、上述した情報処理装置10は、例えばCPU(Central Processing Unit)、RAM(Random Access Memory)等の揮発性の記憶媒体、ROM(Read Only Memory)等の不揮発性の記憶媒体、マウスやキーボード、ポインティングデバイス等の入力装置、画像やデータを表示する表示装置、並びに外部と通信するためのインタフェース装置を備えたコンピュータによって構成することができる。

【0128】

したがって、情報処理装置10が有する上述した各機能は、これらの機能を記述したプログラムをCPUに実行させることによりそれぞれ実現可能となる。また、これらのプログラムは、磁気ディスク(フロッピィーディスク、ハードディスク等)、光ディスク(CD−ROM、DVD等)、半導体メモリ等の記録媒体に格納して頒布することもできる。

【0129】

つまり、上述した各構成における処理をコンピュータに実行させるための実行プログラム(ダイジェスト生成プログラム)を生成し、例えば汎用のパーソナルコンピュータやサーバ等にそのプログラムをインストールすることにより、ダイジェスト生成処理等を実現することができる。

【0130】

ここで、図12は、ダイジェスト生成機能を搭載したPC(Personal Computer)の概観図である。また、図13は、ダイジェスト生成機能を搭載したPCのハードウェア構成例を示す図である。なお、PC110は、ノート型PCの例を示しているが、これに限定されるものではなく、例えば、デスクトップ型PCやサーバ、携帯電話、Personal Digital Assistant(PDA、携帯情報端末)、ゲーム機器等を用いてもよい。また、図12に示すPC110の例では、画像入力部21及び音声入力部22がPC本体111内に有しているが、別体に設けられてもよい。また、図12及び図13において、同一の構成部分については、同一の符号を付するものとする。

【0131】

図12に示すPC110は、PC本体111と、表示部112と、キーボード113と、タッチパッド114と、電源ボタン115と、USBコネクタ116と、CD/DVD装填口117と、マイク118と、スピーカー119と、カメラ120とを有する。

【0132】

また、図13に示すハードウェア構成例では、PC110は、システムコントローラ121と、CPU122と、主記憶装置123と、HDD(Hard Disk Drive)124と、キーボードコントローラ125と、表示部112と、EEPROM(Electrically Erasable Programmable Read Only Memory)126と、CMOS(Complementary Metal Oxide Semiconductor)127と、電源監視部128とを有する。なお、図13に示す各構成は、バス129によりデータの送受信が可能な状態で接続されている。

【0133】

PC本体111は、上述したダイジェスト生成機能を搭載したPCである。また、PC本体111は、外部機器(ネットワークドライブ等)と接続することができる。表示部112は、PC本体111が有する各構成からの命令により画像等を表示する。また、表示部112は、例えば液晶ディスプレイ等である。

【0134】

キーボード113は、ユーザ等による操作によりPC本体111に命令を与える。タッチパッド114は、表示画面112上にカーソルを移動させ、ユーザ等によるボタン操作等により、そのカーソルが重ねられたアイコンに応じた命令を与える。

【0135】

電源ボタン115は、PC110への電源投入を行うボタンである。USBコネクタ116は、USB規格に準拠しており、例えばUSBメモリ等を装着してメモリ内の情報を読み出したり、USBメモリに情報を書き込むことができる。また、CD/DVD装填口117は、CDやDVDが装填し、CDやDVDに記録された情報を読み出したり、CDやDVD内に情報を書き込むことができる。

【0136】

マイク118は、音声入力を可能とする。なお、マイク118は、例えば上述した音声入力部22である。また、スピーカー119は、音声出力を可能とする。また、カメラ120は、画像入力を可能とする。なお、カメラ120は、例えば上述した画像入力部21である。

【0137】

また、図13に示すシステムコントローラ121は、データの入出力管理やダイジェスト生成等、システム全体の制御を行う。CPU122は、主記憶装置123に展開されるOS(Operating System)、BIOS(Basic Input/Output System)等の各種プログラムや上述したダイジェスト生成プログラム等を実行する。

【0138】

主記憶装置123は、HDD124から読み出されたプログラムの実行のための作業エリアとして使用される。また、主記憶装置123は、バックアップを行う保存先(外部メディア又は外部機器)の設定等も格納される。つまり、本実施例においては、主記憶装置123にOS、BIOS、アプリケーション等が展開される。HDD124は、OSやアプリケーションプログラムを格納している。なお、HDD124は、例えば上述したデータ蓄積部11である。キーボードコントローラ125は、キーボード113及びタッチパッド114等からの入力を検出する。

【0139】

表示部112は、CPU122がシステムコントローラ121を介して出す命令に基づいた各種データや処理経過、処理結果等を画面に表示する。なお、表示部112は、例えば上述した表示部13である。EEPROM126は、PCに電源が投入された後、最初に実行されるBIOSを格納している。

【0140】

CMOS127は、BIOSメニューの設定を記憶している。電源監視部128は、電源ボタン115が操作されたか否かを監視している。なお、上述したシステムコントローラ121、CPU122、及び主記憶装置123は、例えば上述したダイジェスト生成部12である。

【0141】

本実施例では、上述したハードウェア構成等に、上述した情報処理装置における各処理を実行するための実行プログラム(ダイジェスト生成プログラム)をインストールすることにより、図12,図13に示す構成において容易にダイジェスト生成処理を実行させることができる。

【0142】

<ダイジェスト生成処理>

ここで、上述した実行プログラム(ダイジェスト生成プログラム)にて実行されるダイジェスト生成処理の一例について、フローチャートを用いて説明する。図14は、ダイジェスト生成処理の一例を示すフローチャートである。

【0143】

図14に示す例では、まず、CPU122は、所定時間撮影された1又は複数の人物(被写体)の映像情報及び音声情報を、例えばHDD124等のデータ蓄積部等に蓄積する(S01)。

【0144】

次に、CPU122は、蓄積された映像情報に含まれる画像情報及び音声情報に対し、予め設定された1又は複数の要素に基づいて、所定の単位時間毎の状況を評価する(S02)。なお、予め設定された1又は複数の要素とは、例えば上述した加算要素及び減算要素等を含む。また、評価とは、例えば上述したように各要素に基づく単位時間毎の点数を算出し、算出された結果からダイジェスト必要な部分を抽出する処理等を含む。

【0145】

次に、CPU122は、S02の処理により取得した評価結果に基づいて、1又は複数のダイジェスト候補を抽出する(S03)。また、CPU122は、S03の処理で得られたダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体の状況又は特徴をパターン認識する(S04)。また、CPU122は、パターン認識結果により得られるダイジェスト候補の前後の時間を含む映像情報及び音声情報を用いてダイジェストを生成する(S05)。

【0146】

なお、上述したダイジェスト生成処理は、ユーザからの実行指示により実行されてもよく、S01の処理により各種情報が蓄積された直後又は蓄積されてから所定のタイミングで実行してもよい。

【0147】

また、他の実施例としては、例えばS04の処理における映像情報及び音声情報に含まれる被写体の状況又は特徴のパターン認識を、S01の処理で蓄積された全ての映像情報及び音声情報を対象として行ってもよい。その場合には、全ての映像情報及び音声情報から得られたパターン認識結果と、S02の処理で得られた評価結果とを組み合わせてダイジェスト候補の前後の時間を含むダイジェストを生成する。

【0148】

上述した各実施例によれば、より適切なダイジェストを生成することができる。また、各実施例によれば、例えば映像や音声から会議議事内容のより効率的な閲覧が可能となるダイジェストを生成することができる。これにより、例えば会議後に議事録を生成する場合には、膨大なデータの全てを参照する必要がなくなり、議論の流れ、結論、A.I.等の会議の概要を捉えられることのできるダイジェストを短時間に提供することができる。

【0149】

また、上述した実施例では、会議中の音声や画像等から得られる複数要素について、時系列変化を検知し、特定のパターン等を認識し、その認識結果を利用して、より適切なダイジェストを生成することができる。また、上述した実施例では、会議の概要を短時間で捉えることのできるダイジェストを提供でき、またパターン認識によりダイジェストの精度を上げることができる。

【0150】

なお、上述した手法は、例えばテレビ会議システムや参加型の議論番組、講義中継、セミナーの評価等、映像(画像を含む)及び音声を有する入力情報であれば、広く適用することができ、それぞれに対応したダイジェストを生成することができる。

【0151】

また、上述した手法は、例えばコンバージェンスサービス等にも適用することができる。コンバージェンスサービスとは、例えば様々な業務等で使用されるセンサや端末によって収集されたデータを、その分野専用に活用したり、蓄積したりするサービスをいう。また、コンバージェンスサービスは、上述した内容だけでなく、他の異種分野や業務に対して、その専門家の知識や判断基準等を付加して再利用することで、新たな価値を創造してサービスを提供することができる。したがって、上述した各実施例で得られる予め設定された要素の基づく評価結果やパターン認識結果等をコンバージェンスサービスに適用することで、各分野で個別に新たなシステム構築やデータ収集等をすることなく、既存データの有効利用を行うことができる。

【0152】

コンバージェンスサービスに各実施例を適用した例としては、各実施例で得られたダイジェストデータを用いて、まず人事部門、経理部門、出席者の上司等の知識の付加等により出席者の会議やプロジェクトに対する重要度、貢献度、居眠り度合い等を取得する。次に、上記の例では、取得した情報を用いて各個人の業務査定や評価、或いは会議時間や出席者情報による各出席者の仕事や工数管理、又はそれらの積算によるプロジェクトの原価算出の参考情報等として活用することができる。また、本実施例により評価の精度を向上させることで、業務評価や勤怠、業務工数、原価管理機能として商品化又はクラウド化してビジネスに結び付けることができる。

【0153】

更に、上述した各実施例を適用して得られたダイジェストを用いて、知財担当者や担当部門或いは当該業務の専門家の知識の付加により、特許候補を短時間で効率よく検索し抽出するツールとして活用することができる。

【0154】

以上、各実施例について詳述したが、特定の実施例に限定されるものではなく、特許請求の範囲に記載された範囲内において、上記変形例以外にも種々の変形及び変更が可能である。

【0155】

なお、以上の実施例に関し、更に以下の付記を開示する。

(付記1)

所定時間撮影された1又は複数の被写体を含む映像情報及び音声情報を蓄積する蓄積部と、

前記蓄積部に蓄積された映像情報及び音声情報を用いて、予め設定された1又は複数の要素に基づき、前記所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出するダイジェスト生成部と、を有し、

前記ダイジェスト生成部は、前記ダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体の状況又は特徴をパターン認識し、認識された結果に基づいて前記ダイジェスト候補からダイジェストを生成するパターン認識部を有することを特徴とする情報処理装置。

(付記2)

前記ダイジェスト生成部は、

前記1又は複数の要素として、加算要素と減算要素とを有し、

前記加算要素は、前記映像情報に含まれる前記被写体の注目度合い、うなずき度合い、発言者数、及び盛上りのうち少なくとも1つを有し、前記減算要素は、前記映像情報に含まれる居眠り人数、及び沈黙度合いのうち少なくとも1つを有することを特徴とする付記1に記載の情報処理装置。

(付記3)

前記ダイジェスト生成部は、

前記加算要素と前記減算要素との組み合わせを、前記映像情報の撮影内容に応じて設定することを特徴とする付記2に記載の情報処理装置。

(付記4)

前記ダイジェスト生成部は、

前記評価結果として得られる前記1又は複数の要素による所定の単位時間毎の点数の算出結果の変化量が予め設定された閾値より大きい区間を基準として前記ダイジェストの開始時点と終了時点を決定することを特徴とする付記1乃至3の何れか1項に記載の情報処理装置。

(付記5)

前記ダイジェスト生成部は、

前記ダイジェストの合計時間を、予め設定された時間又は前記映像情報の合計時間に比例させた一定の割合の時間とすることを特徴とする付記1乃至4の何れか1項に記載の情報処理装置。

(付記6)

前記ダイジェスト生成部は、

前記1又は複数の被写体を異なる位置から撮影した映像情報が複数ある場合には、複数の映像情報に含まれる位置情報に基づいて前記複数の映像情報を連結することを特徴とする付記1乃至5の何れか1項に記載の情報処理装置。

(付記7)

所定時間撮影された1又は複数の被写体を含む映像情報及び音声情報を蓄積し、蓄積された映像情報及び音声情報を用いて、予め設定された1又は複数の要素に基づき、前記所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出し、ダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体の状況又は特徴をパターン認識し、認識された結果に基づいて前記ダイジェスト候補からダイジェストを生成する、処理を有することを特徴とするダイジェスト生成方法。

(付記8)

所定時間撮影された1又は複数の被写体を含む映像情報及び音声情報を蓄積し、蓄積された映像情報及び音声情報を用いて、予め設定された1又は複数の要素に基づき、前記所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出し、ダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体の状況又は特徴をパターン認識し、認識された結果に基づいて前記ダイジェスト候補からダイジェストを生成する、処理をコンピュータに実行させるためのダイジェスト生成プログラム。

【符号の説明】

【0156】

1,2 会議システム

10 情報処理装置

11 データ蓄積部

12 ダイジェスト生成部

13 表示部

20 画像・音声取得装置

21 画像入力部

22 音声入力部

31 位置情報蓄積部

32 画像情報蓄積部

33 音声情報蓄積部

34 ダイジェスト情報蓄積部

41 顔検出部

42 視線方向検出部

43 うなずき検出部

44 居眠り検出部

45 発言者検出部

46 盛上り検出部

47 演算処理部

51,71 目検出部

52 方向判定部

61,72 顔傾斜検出部

62 うなずき判定部

73 居眠り判定部

81 口検出部

82 発言判定部

91 音量判定部

100 ハブ

110 PC

111 PC本体

112 表示部

113 キーボード

114 タッチパッド

115 電源ボタン

116 USBコネクタ

117 CD/DVD装填口

118 マイク

119 スピーカー

120 カメラ

121 システムコントローラ

122 CPU

123 主記憶装置

124 HDD

125 キーボードコントローラ

126 EEPROM

127 CMOS

128 電源監視部

129 バス

【技術分野】

【0001】

本発明は、より適切なダイジェストを生成するための情報処理装置、ダイジェスト生成方法、及びダイジェスト生成プログラムに関する。

【背景技術】

【0002】

従来では、例えば会議の議事録等のように、ある事象に対する情報の全体からダイジェスト(概要情報)を生成する場合がある。例えば、会議の議事録のような場合には、結論や確認事項、次回までの宿題等のアクションアイテム(以下、「A.I.」と略称する)だけでなく、そこに至るまでの会議参加者の発言や会議の雰囲気等を含めた議事録を生成することが好ましいことが知られている。しかしながら、上述した議事録を生成するためには、音声や画像等のデータの収集が膨大になると共に、後から必要な部分を参照して会議概要を把握する場合には、所望の情報の検索に時間がかかってしまう。

【0003】

そこで、従来では、発言者の音声から自動的にその文章化と要約文章を作成して議事録を作成する技術が存在する。また、従来では、会議中に発生する各参加者の発話データや映像データ等を時系列形式で蓄積し、会議の開始時刻から現時点までの発話の話速、音程又は音量等により算出される盛上り度により会議概要情報を作成する技術が存在する(例えば、特許文献1,2参照)。

【先行技術文献】

【特許文献】

【0004】

【特許文献1】特開平2−206825号公報

【特許文献2】特開2004−350134号公報

【発明の概要】

【発明が解決しようとする課題】

【0005】

しかしながら、上述した特許文献1に示されている技術では、議事発言者の音声から自動的にその文章化と要約文章を作成して可視化しているが、文章ベースの議事録では会議の雰囲気、発言のニュアンス等の要素を十分に捉えたり、伝えることができなかった。

【0006】

また、特許文献2に示されている技術では、音声データにより算出される盛上りを、閾値を用いて抽出するという方法を取っているため、議事内容に関わらず盛上りの高い部分が抽出されることになる。また、この閾値は、会議の内容や参加者によって変動すると考えられ、一意に決めることはできない。したがって、このような音としての特徴にのみ注目した閾値による抽出方法では、より適切な会議概要(ダイジェスト)を正確に捉えることができなかった。

【0007】

開示の技術は、かかる問題を鑑み、より適切なダイジェストを生成することを目的とする。

【課題を解決するための手段】

【0008】

開示の一態様における情報処理装置は、所定時間撮影された1又は複数の被写体を含む映像情報及び音声情報を蓄積する蓄積部と、前記蓄積部に蓄積された映像情報及び音声情報を用いて、予め設定された1又は複数の要素に基づき、前記所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出するダイジェスト生成部と、を有し、前記ダイジェスト生成部は、前記ダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体の状況又は特徴をパターン認識し、認識された結果に基づいて前記ダイジェスト候補からダイジェストを生成するパターン認識部を有する。

【発明の効果】

【0009】

開示の技術によれば、より適切なダイジェストを生成することができる。

【図面の簡単な説明】

【0010】

【図1】実施例1における会議システムの概要構成例を示す図である。

【図2】情報処理装置の機能構成例の一例を示す図である。

【図3】実施例1における各検出部の具体例を示す図である。

【図4】うなずき検出の具体例を示す図である。

【図5】居眠り判定の具体例を説明するための図である。

【図6】実施例1における画像入力部の位置、向き、画角と、視線との関係の具体例について説明するための図である。

【図7】実施例1における加算要素と減算要素の組み合わせ例を示す図である。

【図8】実施例1における点数結果とダイジェストの抽出例を示す図である。

【図9】実施例2における点数結果とダイジェストの抽出例を示す図である。

【図10】実施例3における会議システムの概要構成例を示す図である。

【図11】実施例3における複数の映像情報と被写体との位置関係の取得例について説明するための図である。

【図12】ダイジェスト生成機能を搭載したPCの概観図である。

【図13】ダイジェスト生成機能を搭載したPCのハードウェア構成例を示す図である。

【図14】ダイジェスト生成処理の一例を示すフローチャートである。

【発明を実施するための形態】

【0011】

以下、添付図面を参照しながら実施例について詳細に説明する。なお、以下の説明では、ある事象に対する情報の全体からダイジェスト(概要情報)を生成する例として、会議全体から議事録を生成する例について説明するが、これに限定されるものではない。

【0012】

<実施例1>

図1は、実施例1における会議システムの概要構成例を示す図である。図1に示す会議システム1は、情報処理装置10と、画像・音声取得装置20とを有する。情報処理装置10は、データ蓄積部11と、ダイジェスト生成部12と、表示部13とを有する。また、画像・音声取得装置20は、画像入力部21と、音声入力部22とを有する。

【0013】

データ蓄積部11は、例えばダイジェスト生成部12におけるダイジェスト生成、及び表示部13による表示等に必要な各種情報を蓄積する蓄積部である。また、データ蓄積部11は、画像・音声取得装置20の位置情報や、画像入力部21により得られる映像情報、音声入力部22により得られる音声情報等の各種データを蓄積する。なお、上述の映像情報は、例えば映像中に含まれる複数の画像情報(例えば、画像フレーム)を含むものとする。また、データ蓄積部11は、ダイジェスト生成部12において生成されたダイジェスト情報を蓄積する。

【0014】

ダイジェスト生成部12は、データ蓄積部11に蓄積されている映像情報や音声情報を用いて、例えば予め設定された1又は複数の要素等に基づき、所定の単位時間毎の状況を評価する。また、ダイジェスト生成部12は、評価結果に基づいて1又は複数のダイジェスト候補を抽出し、抽出された候補の前後の時間を含む映像情報及び音声情報を用いてダイジェストを生成する。

【0015】

なお、ダイジェスト生成部12は、上述した映像情報及び音声情報を用いて、予め設定された複数の要素に基づき、所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出する。そのとき、ダイジェスト生成部12は、上述したダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体をパターン認識により特定し、特定された被写体情報に基づいてダイジェスト候補からダイジェストを生成する。

【0016】

表示部13は、ダイジェスト生成部12により生成されたダイジェスト情報に基づいて対応するダイジェスト映像や音声を表示する。また、表示部13は、ダイジェスト生成処理を実行するための設定情報の入力画面や実行経過、実行結果、エラー情報等、多種の情報を表示することができる。表示部13は、例えばディスプレイやモニタ等である。

【0017】

画像入力部21は、所定の画角に基づく周囲の画像(映像も含む)を取得する。なお、映像とは、時系列に配列された複数の画像を含むものである。また、画像入力部21は、例えばCCD(Charge Coupled Device)等の撮像素子を有する撮像手段である。音声入力部22は、周囲の音声を取得する。なお、音声入力部22は、例えばマイク等である。

【0018】

ここで、画像入力部21及び音声入力部22は、情報処理装置10内に含まれていてもよく、またそれぞれが別体に設けられていてもよい。また、画像入力部21及び音声入力部22は、例えばデジタルカメラやビデオカメラ等の撮像手段を用いることもできる。更に、図1に示すデータ蓄積部11には、複数の画像・音声取得装置20を接続し、接続した各装置からの映像情報及び音声情報を取得するようにしてもよい。このとき、複数の画像・音声取得装置20は、例えば各装置の識別情報を含む映像情報及び音声情報を情報処理装置10に出力する。これにより、情報処理装置10は、映像情報や音声情報等を各装置の識別情報に基づいて管理することができる。

【0019】

<情報処理装置10:機能構成例>

次に、情報処理装置の機能構成例について図を用いて説明する。図2は、情報処理装置の機能構成例の一例を示す図である。図2に示す情報処理装置10は、図1と同様にデータ蓄積部11と、ダイジェスト生成部12と、表示部13とを有する。データ蓄積部11は、位置情報蓄積部31と、画像情報蓄積部32と、音声情報蓄積部33と、ダイジェスト情報蓄積部34とを有する。また、ダイジェスト生成部12は、顔検出部41と、視線方向検出部42と、うなずき検出部43と、居眠り検出部44と、発言者検出部45と、盛上り検出部46と、演算処理部47と、パターン認識部48とを有する。

【0020】

データ蓄積部11における位置情報蓄積部31は、例えば会議室内に設置された画像・音声取得装置20等の位置情報(例えば、撮影される画角に対応する参加者の位置等)を蓄積する。また、位置情報蓄積部31は、発言者検出部45により得られる発言者の位置情報を蓄積する。

【0021】

画像情報蓄積部32は、例えば上述した画像入力部21等から得られる会議中に撮影された映像情報(例えば、複数の画像情報)等を蓄積する。

【0022】

音声情報蓄積部33は、例えば上述した音声入力部22等から得られる会議中に集音された所定方向又は全周囲の音声情報等を蓄積する。なお、画像情報蓄積部32に蓄積される映像情報と、音声情報蓄積部33に蓄積される音声情報とは、例えば時間情報等が付加され、お互いが対応付けられているものとする。

【0023】

また、上述した映像情報や音声情報は、画像入力部21や音声入力部22以外の手段から取得してもよい。具体的には、上述した映像情報や音声情報は、例えばUSB(Universal Serial Bus)メモリやCD(Compact Disc)、DVD(Digital Versatile Disc)等の記録媒体から取得してもよい。また、上述した映像情報や音声情報は、例えばインターネット等の通信ネットワークを介して接続される外部装置からのダウンロード等により取得してもよい。

【0024】

ダイジェスト情報蓄積部34は、ダイジェスト生成部12の演算処理部47により演算された点数や経過時間等から得られるダイジェスト情報、又はパターン認識部48により特定されたダイジェスト情報等を蓄積する。

【0025】

また、ダイジェスト生成部12における顔検出部41は、画像情報蓄積部32に蓄積されている映像に含まれる画像情報に基づいて、画像中に含まれる少なくとも1人の会議参加者(被写体)の顔の位置情報(例えば、画面中の位置座標)等を検出する。なお、顔検出部41は、入力画像から顔が検出された場合には、その顔の位置情報のみを出力したり、入力画像に顔の位置情報を付加して出力することができる。

【0026】

視線方向検出部42は、例えば顔検出部41により入力される顔の位置情報が付加された画像情報に基づいて、会議参加者毎の視線方向を検出する。また、視線方向検出部42は、位置情報蓄積部31から発言者の位置情報を取得し、その位置情報から各参加者の視線が発言者に向いているか否かを判断する。

【0027】

うなずき検出部43は、例えば顔検出部41により入力される画像情報に基づいて、会議参加者のうなずきを検出する。居眠り検出部44は、例えば顔検出部41により入力される画像情報に基づいて、会議参加者の居眠りを検出する。発言者検出部45は、例えば顔検出部41により入力される画像情報と、音声情報蓄積部33に蓄積されている音声情報とに基づいて発言者を検出する。盛上り検出部46は、例えば音声情報蓄積部33に蓄積されている音声情報等に基づいて、会議が盛り上がっていると判断される位置(時間)を検出する。

【0028】

演算処理部47は、例えばダイジェスト生成部12に含まれる上述した各検出部(顔検出部41、視線方向検出部42、うなずき検出部43、居眠り検出部44、発言者検出部45、盛上り検出部46)から、会議参加者人数、時間、音量等の情報等を取得する。また、演算処理部47は、取得した各種情報(要素)等に基づいて、所定の単位時間毎の状況を評価するため、所定の単位時間毎の点数等を算出する。また、演算処理部47は、算出された点数等に基づいて、画像情報蓄積部32及び音声情報蓄積部33から所定部分(所定場面)の映像情報(1又は複数の画像情報も含む)及び音声情報をダイジェスト候補として抽出する。

【0029】

また、演算処理部47は、抽出した候補の前後の時間を含む映像情報及び音声情報と、予め設定されるダイジェストの合計時間等に応じて、最終的に使用されるダイジェストを生成し、ダイジェスト情報蓄積部34に出力する。なお、演算処理部47は、算出された点数等もダイジェスト情報蓄積部34に出力することができる。

【0030】

また、演算処理部47は、上述した映像情報及び音声情報を用いて、予め設定された複数の要素に基づき、所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出する。

【0031】

パターン認識部48は、予め設定されたパターンに基づいて、ダイジェスト情報蓄積部34に蓄積された内容から抽出すべきダイジェストを認識する。具体的には、パターン認識部48は、例えば上述したダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体をパターン認識により特定し、特定された被写体情報に基づいて、ダイジェスト候補から所定のダイジェストを生成する。また、パターン認識部48は、パターン認識結果をダイジェスト情報蓄積部34に出力する。

【0032】

また、表示部13は、上述した処理によりダイジェスト情報蓄積部34から得られるダイジェストを表示する。

【0033】

次に、上述した各検出部の具体的な処理内容について説明する。図3は、実施例1における各検出部の具体例を示す図である。なお、図3(A)は視線方向検出部42の具体例を示し、図3(B)はうなずき検出部43の具体例を示し、図3(C)は居眠り検出部44の具体例を示し、図3(D)は発言者検出部45の具体例を示し、図3(E)は盛上り検出部46の具体例を示している。

【0034】

<顔検出部41の具体的な処理内容>

実施例1における顔検出部41は、画像情報蓄積部33に蓄積された映像に含まれる各画像情報から、各画像フレーム内における1又は複数の顔の位置を検出し、後段の検出部に対して顔の位置情報や画像情報を出力する。なお、顔検出部41における顔検出手法としては、例えば画像中から顔の特徴情報(例えば、顔の輪郭、目、鼻、口等の特徴点)に基づいて顔を検出することができる。また、他の顔検出手法としては、例えば予め設定された特徴パラメータ(例えば、顔の特徴点のそれぞれの位置やバランス、色情報等)とのパターンマッチングを行うことで、顔検出を行うことができるが、これに限定されるものではない。

【0035】

また、顔検出部41は、例えば入力画像から顔が検出された場合に、その入力画像に顔の位置情報を付加し、視線方向検出部42、うなずき検出部43、居眠り検出部44、発言者検出部45等に出力する。

【0036】

更に、顔検出部41は、予め複数の人物(被写体)の顔の特徴情報を蓄積しておき、その特徴情報に基づいて、入力画像中に含まれる人物を特定することもできる。

【0037】

<視線方向検出部42の具体的な処理内容>

図3(A)に示す視線方向検出部42は、目検出部51と、方向判定部52とを有する。目検出部51は、入力した顔の位置情報が付加された各画像から目の位置を検出する。また、方向判定部52は、目検出部51により検出された上述した位置情報蓄積部31から入力された位置情報に基づいての視線方向を判定する。また、方向判定部52は、判定された視線の方向が、発言者に対して向けられているかどうかを判定する。なお、発言者の位置は、発言者検出部45により検出された発言者の位置情報等を位置情報蓄積部31から取得して用いることができる。

【0038】

ここで、方向判定部52は、例えば予め設定された単位時間(例えば、60秒)のうち、新たに発言者に対して視線を向けていると判定された人物を検出する。そして、方向判定部52は、上述した人物を検出した場合に、演算処理部47において注目度合いを算出するために、発言者に視線を向けている人物の画像を抽出し、その人物の画像を出力データとして演算処理部47に出力する。なお、方向判定部52は、発言者に視線を向けている人物が、すでに演算処理部47に出力されている人物と同一である場合には、演算処理部47への出力は行わない。

【0039】

ここで、上述した内容について具体的に説明する。なお、実施例1では、例えば発言者検出部45により単位時間60秒中のある時点YAにおける発言者位置を特定できているものとする。このとき、方向判定部52は、単位時間60秒中のある時点YAの画像Aに映っている参加者(被写体)から見た発言者位置の方向(角度)αと、参加者の視線方向(角度)θ1とが等しい場合、その参加者は単位時間60秒中に発言者に視線を向けていると判定する。

【0040】

これにより、演算処理部47は、方向判定部52から判定結果として得られる出力データから単位時間60秒あたりの発言者に視線を向けている人数として加算する。

【0041】

<うなずき検出部43の具体的な処理内容>

図3(B)に示すうなずき検出部43は、顔傾斜検出部61と、うなずき判定部62とを有する。顔傾斜検出部61は、入力画像に対して顔の傾斜を検出する。また、うなずき判定部62は、入力した顔の位置情報が付加された各画像を前後の時間の同画像と比較し、顔傾斜検出部61により検出された顔傾斜情報を用いて、顔の傾斜が閾値以上であればうなずきと判定する。

【0042】

ここで、うなずき判定部62は、例えば予め設定された単位時間(例えば、60秒)のうち、新たにうなずいていると判定された1又は複数の人物を検出する。そして、うなずき判定部62は、上述した人物を検出した場合に、演算処理部47においてうなずき度合いを算出するため、うなずいている人物の画像を演算処理部47に出力する。なお、うなずき判定部62は、うなずいている人物が、すでに演算処理部47に出力されている人物と同一である場合には、演算処理部47への出力は行わない。

【0043】

ここで、上述したうなずき検出の具体例について説明する。図4は、うなずき検出の具体例を示す図である。うなずき検出部43は、例えば予め設定された単位時間60秒(例えば、1800フレーム)中のある時点YAにおいて、ある人物の顔の位置情報を有する画像Aを検出した場合、時間YAの前後15フレーム中(計30フレーム=1秒間)に同一人物の顔が映っている画像A1〜ANを抽出する。次に、うなずき検出部43は、図4(A)に示すように、画像A1〜ANのうち、両目と口を含む矩形領域の高さが最も高い画像AH(矩形領域の高さah)と、画像AH以外の画像A1〜ANに映っている顔について、両目と口を含む矩形領域の高さ(an)、及び矩形領域の中心点位置の比較を行う。

【0044】

ここで、人物の顔の高さについての近似計算は、図4(B)に示すように求めることができる。つまり、実施例1では、画像A1〜ANのうち画像AHに比べ矩形領域の高さが√3/2以下(例えば、顔の傾斜角θが30°以上)であり、かつ矩形領域中心点が画像AHの矩形領域中心点CHより低い位置にある画像AU1〜AUNを2フレーム以上検出する。また、画像を2フレーム以上検出した場合には、更に図4(C)に示すようにAU1〜AUN間の画像について、矩形領域中心点CH以上である画像AUが1フレーム以上あれば、その人物(参加者)は、単位時間中にうなずいていると判定する。

【0045】

これにより、演算処理部47は、うなずき判定部62から判定結果として得られる出力データから単位時間60秒あたりのうなずいている人数として加算する。

【0046】

<居眠り検出部44の具体的な処理内容>

図3(C)に示す居眠り検出部44は、目検出部71と、顔傾斜検出部72と、居眠り判定部73とを有する。なお、目検出部71及び顔傾斜検出部72は、上述した目検出部51及び顔傾斜検出部61と同様の処理を行うため、ここでの具体的な説明は、省略する。つまり、目検出部71は、入力した顔の位置情報が付加された各画像から目を検出する。また、顔傾斜検出部72は、上述したように入力画像に含まれる顔画像の位置を時系列に計測して顔の傾斜を検出する。居眠り検出部73は、前後の時間の同画像のうち、目を開いているときの画像と比較し、顔の傾斜が下向きであり、かつ目をつぶっていると判断した場合には、居眠りと判定する。

【0047】

ここで、居眠り判定部73は、例えば予め設定された単位時間(例えば、60秒)のうち、新たに居眠りと判定された1又は複数の人物を検出する。そして、居眠り判定部73は、上述した人物を検出した場合に、演算処理部47において居眠り人数を算出するため、居眠りと判定された人物の画像を演算処理部47に出力する。なお、居眠り判定部73は、居眠りしている人物が、すでに演算処理部47に出力されている人物と同一である場合には、演算処理部47への出力は行わない。

【0048】

ここで、上述した居眠り判定について更に具体的に説明する。図5は、居眠り判定の具体例を説明するための図である。居眠り判定部73は、例えば、単位時間60秒(1800フレーム)中のある時点YAにおいて、ある人物の顔の位置情報を持つ画像Aを検出した場合、単位時間60秒中に同一人物の顔が映っている画像A1〜ANを抽出する。また、居眠り判定部73は、図5(A)に示すように、会議中の同一人物の顔が映っている画像のうち、両目と口を含む矩形領域の高さが最も高い画像AH(矩形領域の高さah)と、画像AH以外の画像A1〜ANについて、両目と口を含む矩形領域の高さ(an)、及び矩形領域の中心点位置の比較を行う。なお、図5(A)の例は、上述した図4(A)と同様である。

【0049】

また、居眠り判定部73は、上述したように、画像A1〜ANのうち画像AHに比べ矩形領域の高さが√3/2以下(顔の傾斜角θが30°以上)であり、かつ矩形領域中心点が画像AHの矩形領域中心点CHより低い位置にある画像を取得する。更に居眠り判定部73は、取得した画像から、図5(B)に示すように目をつぶっていると判断される画像AI1〜AINが連続して所定数(例えば、1620フレーム(単位時間の9割))以上あれば、その人物は単位時間のうちに居眠りしていると判定する。

【0050】

これにより、演算処理部47は、居眠り判定部73から判定結果として得られる出力データから単位時間60秒あたりの居眠り人数として加算する。

【0051】

<発言者検出部45の具体的な処理内容>

図3(D)に示す発言者検出部45は、口検出部81と、発言判定部82とを有する。口検出部81は、入力した顔の位置情報が付加された各画像から口の位置を検出する。また、発言判定部82は、口検出部81により得られる口検出結果と、音声情報蓄積部33から入力された音声情報とに基づいて発言者を判定する。

【0052】

ここで、発言判定部82は、例えば予め設定された単位時間(例えば、60秒)のうち、新たに発言者と判定された1又は複数の人物を検出する。そして、発言判定部82は、上述した人物を検出した場合に、演算処理部47において発言者数、沈黙度合いを算出するため、発言者画像を演算処理部47に出力する。なお、発言判定部82は、発言者がすでに演算処理部47に出力されている人物と同一である場合には、演算処理部47への出力は行わない。

【0053】

<盛上り検出部46の具体的な処理内容>

図3(E)に示す盛上り検出部46は、音量判定部91を有する。音量判定部91は、音声情報蓄積部33から入力された音声情報から音量値を測定する。また、音量判定部91は、測定した音量値が、予め設定した標準値(例えば、60dB)以上であれば、演算処理部47において盛上りを算出するため、音量値を演算処理部47に出力する。

【0054】

<実施例1における画像入力部21の位置、向き、画角と、視線との関係>

ここで、実施例1におけるカメラ等の画像入力部21の位置、向き、画角と、視線との関係の具体例について、図を用いて説明する。図6は、実施例1における画像入力部の位置、向き、画角と、視線との関係の具体例について説明するための図である。

【0055】

なお、図6の例では、一例として会議参加者である被写体A〜Cは、図6(A)に示すように、画像入力部21であるカメラD1の撮影範囲(例えば、画角θc)内に収まるように着席しているものとする。

【0056】

ここで、図6の例では、予め設定された単位時間(例えば、60秒(1800フレーム))中のある時点YBにおいて、ある人物の顔の位置情報を有する画像Bを検出した場合を示している。このような場合には、図6(B)に示すように、会議中の同一人物の顔が映っている画像のうち両目と口を含む矩形領域面積が最も広い画像BHと画像Bの矩形領域の上辺の長さ及び中心点位置より、時間YBにおける水平角θ1を求める。なお、矩形領域面積が最も広い画像BHは、例えば画角内の顔位置に関わらず、まっすぐに画像入力部を見ている人物の画像となる。

【0057】

つまり、図6(B)の例では、BHの矩形領域の上辺の長さbh、Bの矩形領域の上辺の長さb、顔の水平角をθ1とし、cosθ1=bh/bより水平角θ1を求める。また、実施例1では、図6(C)に示すように、例えばLED(Light Emitting Diode)等の発光部と受光部により、三角測量の原理を利用し、反射光の入射角により、対象物である被写体までの距離I1を取得する。また、実施例1では、例えば写真測量法により、画像入力部21により撮影された画像中心からの実際の距離dを取得する。更に、実施例1では、上述した距離I1と距離dとにより、真正面からの被写体位置の角度θ1’(例えば、図6(C)に示すsinθ1’=d/I1)を求めることができる。

【0058】

<実施例1における演算処理部47の演算手法>

次に、実施例1における演算処理部47の演算手法について説明する。演算処理部47では、上述した各検出部から得られるデータを用いて、各々の算出手法に基づき点数を算出する。

【0059】

具体的には、演算処理部47は、データ蓄積部11に蓄積された映像情報と音声情報とから予め設定された短い単位時間毎の会議の状況を、複数の観点で数値評価し、その合計点数を算出する。更に、演算処理部47は、算出された点数の高い場面を上位から複数抽出する。また、演算処理部47は、抽出した場面の前後に時間を広げた映像と音声とをダイジェスト場面とし、そのダイジェスト場面を複数連結して会議のダイジェストを生成する。

【0060】

なお、演算処理部47は、上述した短い単位時間毎の場面の数値評価の例として、例えば注目度合い、うなずき度合い、発言者数、盛上り等を加算要素として用いる。また、演算処理部47は、居眠り人数、沈黙度合い等を減算要素として用いる。演算処理部47は、これらの加算要素及び減算要素を用いて評価を行う。

【0061】

ここで、上述した加算要素及び減算要素のそれぞれの具体例について説明する。

【0062】

<加算要素>

加算要素について、例えば、注目度合いについては、予め設定された単位時間(例えば、60秒)あたりの発言者に対して視線を向けている人数n(人)及び時間m(秒)を用いて、点数xを、例えば以下の式(1)により算出する。

x=(n×m)/(参加人数×60) ・・・(1)

なお、発言者に対して視線を向けている人数は、例えば上述した視線方向検出部42から得られる出力データにより取得することができる。

【0063】

また、うなずき度合いについては、例えば会議参加者のうち、予め設定された単位時間(例えば、60秒)あたりのうなずいている人数n(人)を用いて、会議参加者に占める割合を点数xとして、例えば以下の式(2)により算出する。

x=n/参加人数 ・・・(2)

なお、うなずいている人数は、例えば上述したうなずき検出部43から得られる出力データにより取得することができる。

【0064】

また、発言者数については、例えば予め設定される単位時間(例えば、60秒)あたりの発言者数n(人)を用い、会議参加者数に占める割合を点数xとして、例えば以下の式(3)により算出する。

x=n/参加人数 ・・・(3)

なお、発言者数は、例えば上述した発言者検出部45から得られる出力データにより取得することができる。

【0065】

更に、盛上りについては、例えば予め設定された単位時間(例えば、60秒)あたりの平均ボリューム(音量)n(dB)を用いて、予め設定されるボリュームの標準値(例えば、60dB)からの倍率を点数xとして、例えば以下の式(3)により算出する。

x=10^((n−60)/20) ・・・(4)

(例えば、n(dB)=20log10(x))

なお、ボリュームについては、例えば上述した盛上り検出部46から得られる出力データにより取得することができる。

【0066】

<減算要素>

減算要素について、例えば、居眠り人数については、例えば、予め設定された単位時間(例えば、60秒)のうちに居眠りと判定された人数n(人)を用いて、会議参加者数に占める割合を点数xとして、例えば以下の式(5)により算出する。

x=n/参加人数 ・・・(5)

なお、居眠り人数については、例えば上述した居眠り検出部44から得られる出力データにより取得することができる。

【0067】

更に、沈黙度合いについては、例えば予め設定された単位時間(例えば、60秒)あたりの発言者数が0人である時間n(秒)を用いて、点数xを、例えば以下の式(6)により算出する。

x=n/60 ・・・(6)

なお、発言者数が0人である時間は、例えば上述した発言者検出部45から得られる出力データにより取得することができる。

【0068】

上述したようにして得られた加算要素又は減算要素については、それぞれ加算要素については加算、減算要素については減算し、各要素について算出された点数を合計し、その値を経過時間Y(分)の点数X(点)とする。

【0069】

更に、実施例1では、上述した各加算要素及び減算要素は、少なくとも1つを用いて点数を算出することができるが、これに限定されるものではなく、例えばダイジェストを生成する目的や入力される映像や音声の内容等に応じて任意に選択することができる。ここで、図7は、実施例1における加算要素と減算要素の組み合わせ例を示す図である。

【0070】

図7に示す例では、例えば、複数の会議実施形態(映像情報の撮影内容)に応じて、予め設定される加算要素と減算装置との組み合わせ例を示しており、一例として会議実施形態が「ブレーンストーミング」、「説明会」、「講演会」の場合が示されている。

【0071】

ここで、例えば、会議実施形態が「ブレーンストーミング」の場合には、活発なブレスト(ブレーンストーミング)がされていれば、加算要素が大きく増加することが想定される。また、会議実施形態が「説明会」の場合には、資料閲覧が多く、質疑応答が発生することが想定される。また、会議実施形態が「講演会」の場合には、発言者は固定され、終了前に質疑応答、拍手等の時間があることが想定される。

【0072】

つまり、実施例1では、それぞれの会議実施形態に応じたダイジェストを抽出する上で、それぞれの会議の特性(例えば、図7に示す「備考」等)に対応させて、信頼性が高く最低限必要な必須要素(例えば、図7における「○」)が選択される。また、実施例1では、信頼性が低い要素(例えば、図7における「△」)については、ユーザ等の選択等により要素に含めるか否かを設定することができる。

【0073】

また、実施例1では、例えば、加算要素と減算要素の個数が同一になるように調整したり、合計要素数が所定数以下、又は所定数以上となるように設定することもできる。なお、合計要素数を所定数以下とする場合には、その分ダイジェストの生成処理の時間を短縮することができ、所定数以上とする場合には、ダイジェスト候補の抽出精度を向上させることができる。

【0074】

更に、実施例1において、上述した加算要素と減算要素は、各要素毎にそれぞれ重み付けをつけて調整することができる。例えば上述したうなずき度合いでは、同意のうなずきである場合や単なる相槌の場合が考えられる。そのため、例えば図7に示す会議実施形態のうち「ブレーンストーミング」におけるうなずきの場合には、同意によるうなずきであり、合意事項の可能性が高いとして、重みを大きく設定する。一方、会議実施形態のうち「講演会」におけるうなずきの場合には、単なる相槌によるうなずきであるため、重みを小さく設定する。

【0075】

また、上述した注目度合いでは、例えば注目されている人数や時間が長いと、重要人物、発言である可能性が高いと想定されるため、重みが大きくなるよう調整する。また、上述した盛上りでは、標準値より静かである場合に、普通の会話以下と判断し、更に議論があまりなされていないことが想定されるため、沈黙度合いをマイナスとして調整する。一方、標準値より騒がしい場合(例えば、最大でも怒鳴っている人ぐらい)には、いろいろな人が発言していると想定されるため、内容に関わらず重要度は比較的高く設定する。

【0076】

このように、実施例1では、各要素の内容や予め設定される優先度、要素の取得回数等に応じて重み付けを行うことにより、最適なダイジェスト候補を抽出することができる。また、実施例1では、上述したように、予め設定された複数の要素に基づき、所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出することができる。

【0077】

なお、上述した加算要素と減算要素の数や種類については、上述した内容に限定されるものではなく、例えば各要素について任意に追加や変更、削除等を行うことができる。

【0078】

<ダイジェストの抽出例>

次に、上述した演算処理部47により得られる点数結果からダイジェストを抽出する例について、図を用いて説明する。図8は、実施例1における点数結果とダイジェストの抽出例を示す図である。なお、図8(A),(B)において、横軸は会議時間(分)を示し、縦軸は点数(点)を示している。また、図8(A),(B)の時間軸に対する枠線(実線)で囲まれた部分が、ダイジェスト候補又はダイジェストとして抽出された部分である。

【0079】

演算処理部47は、取得した各単位時間における点数から、予め設定された閾値よりも評価値の高い部分をダイジェスト候補として抽出する。また、演算処理部47は、そのダイジェスト候補の中から、生成するダイジェストの合計時間等に応じて、最終的に使用されるダイジェストを選択することができる。

【0080】

具体的に説明すると、図8(A)の例では、会議の長さを1時間(60分)、会議参加者を10人と仮定し、ダイジェストの長さは全体の15%(9分)と設定する。したがって、演算処理部47は、例えば約1分のダイジェスト場面を9箇所抽出する。そこで、演算処理部47は、例えば会議経緯説明、結論やA.I.等のまとめに関する発言を逃さないために、会議全体の開始5%及び終了前5%、すなわち会議開始から3分間及び会議終了3分間で、必ず1箇所以上はダイジェスト場面として抽出するよう設定する。また、演算処理部47は、残り7箇所について、点数Xの上位の場面を順に抽出する。

【0081】

なお、演算処理部47は、上位から数箇所を抽出する場合に、例えば会議の総合計時間の半分の時間を中心として前後に分け、それぞれからほぼ等しい数が抽出されるように調整してもよい。これにより、会議全体からダイジェストを生成することができる。また、演算処理部47は、上位の点数を算出した地点の時間の前後において、特に後方に重点を置く場合には、例えばその地点を中心として抽出される前後の時間をそれぞれ異なる時間(区間)で取得してもよい。その場合には、例えば、上位の点数を算出した地点を中心とし、その前15秒間と、後45秒間の範囲をダイジェスト候補として取得するようにしてもよい。

【0082】

また、図8(B)の例では、抽出地点の前後の時間を拡大する具体例を示している。つまり、実施例1において、演算処理部47は、各ダイジェスト場面は、点数の高い場面として抽出された時点を基準とし、その点数の高さ等に応じて、その前後の時間を拡大し、各ダイジェスト画面の開始時点と終了時点とを決定してダイジェスト候補として取得してもよい。なお、上述した拡大される時間は、例えば上述した基準時点の前及び後の両方から、それぞれ所定時間拡大させてもよく、前又は後の何れかのみを所定時間拡大させてもよい。

【0083】

また、実施例1において、演算処理部47は、抽出された複数のダイジェスト候補を時間情報に基づいて時系列に連結して最終的なダイジェストを生成する。なお、ダイジェストの合計時間は、予め設定された時間であってもよく、また会議実時間に比例した一定の割合の時間として算出された時間であってもよい。

【0084】

なお、実施例1では、ユーザからダイジェスト時間の拡大を要求される可能性がある。これは、例えば、あるダイジェスト場面の前後の単位時間の点数が、全時間の点数の平均点と比較して高い場合やダイジェスト提供を望むユーザが、図8(A)の例で抽出したダイジェストを閲覧し、不足を感じた場合等である。

【0085】

そこで、実施例1では、上記の際の拡大方法として、抽出された各ダイジェスト場面の点数と、前後のダイジェスト場面でない単位時間60秒の点数について比較を行い、所定のダイジェスト候補の時間の拡大を行う。

【0086】

図8(B)には、図8(A)の内容に基づいて、20%(12分)まで設定時間を拡大してよいとユーザの意思決定があった場合の例を示している。つまり、実施例1では、例えば、図8(B)の点線で囲まれた部分が、新たに追加抽出されたダイジェスト候補となる。

【0087】

実施例1では、例えば、あるダイジェスト候補の前の単位時間の点数が、あるダイジェスト候補の点数と比較して8割を超え、かつ未だダイジェスト候補に含まれていない場合、あるダイジェスト候補の前の単位時間(例えば、60秒)をダイジェスト候補として追加抽出する。

【0088】

また、実施例1では、図8(B)の場合に示すように、あるダイジェスト候補の後の単位時間(例えば、60秒)においても上記と同様の比較により判定する。また、追加抽出されたダイジェスト場面を含めたダイジェスト合計時間が、設定の20%を越える場合には、追加抽出されたダイジェスト場面の中で、点数が上位の方から追加していき、設定の20%に到達した時点で追加処理を終了する。

【0089】

なお、上述した予め設定された単位時間の一例として60秒としているが、これに限定されるものではなく、30秒や90秒、120秒、300秒等でもよい。上述した実施例1によれば、より適切なダイジェストを生成することができる。

【0090】

<実施例2>

次に、実施例2について説明する。実施例2では、上述した実施例1に示すように、単に所定の数値を用いた区間抽出だけではなく、それに関連する特定の出席者の発言も組み合わせることにより、より適切なダイジェストを生成する。

【0091】

なお、実施例2の情報処理装置における映像情報及び音声情報の収集にあたっては、図1に示す画像入力部21及び音声入力部22から取得するものとする。例えば、収集された2時間分の映像情報、音声情報の解析にあたり、以下の要素について、上述した図2,3等の各検出部にて検出を行う。これらの詳細な動作は、上述した実施例1と同じであるため、ここでの具体的な説明は省略する。

【0092】

実施例2では、例えば会議中の映像情報や音声情報を収集、解析し、会議の状態を示す要素毎に点数を算出する。また、実施例2では、算出結果から、その要素の所定の閾値以上の時系列変化の増減パターン部分と、その前後のキーマン(有力者)の発言、又は司会者の発言とを組み合わせて、ダイジェスト候補から最終的なダイジェストとして抽出する。

【0093】

なお、キーマンの発言や司会者の発言といった特定の人物の発言を検出する方法としては、従来の顔認識処理や声紋認識といった手法を用いることができる。この場合には、例えば事前にキーマンや司会者の顔認識又は声紋認識データを登録しておき、上述したパターン認識部48を用いたパターンマッチング処理により判定することができる。つまり、実施例2では、パターン認識処理を行うことで、ダイジェストの精度を上げることができる。

【0094】

<パターン認識部48について>

ここで、情報処理装置10におけるパターン認識部48について具体的に説明する。パターン認識部48では、ダイジェスト情報蓄積部34から得られる映像情報等を解析し、例えば以下に示すようなパターンを認識した場合には、その部分から得られる映像区間や音声区間をダイジェストとして抽出する。

【0095】

例えば、パターン認識部48は、単位時間あたりの発言者数が多い部分だけでなく、発言者数の増え始めも重要なダイジェストのポイントとして認識する。また、パターン認識部48は、キーマンの提案の後に参加者のうなずき度合いの増加が起こり、司会者のまとめの発言の後にも参加者のうなずき度合いの増加が起こるため、これらの部分をダイジェストのポイントとして認識する。また、パターン認識部48は、例えば「まとめ」、「A.I.」、「アクションアイテム」等といったキーワードの前後が議論のまとめやアクションアイテムの確認を行っている部分をダイジェストのポイントとして認識する。

【0096】

つまり、実施例2では、パターン認識部48により認識される状況パターンや被写体(人物)の特徴パターン等に基づいて、より的確なダイジェストの生成を実現することができる。ここで、一例として、実施例2のパターン認識部48により被写体(人物)を特定(判別)する手法について具体的に説明する。

【0097】

<特徴を用いて判別する場合>

パターン認識部48は、所定の被写体に対する特徴を予め設定しておき、会議参加者を条件に当てはめて司会者や有力者として判別する。ここで、司会者の特徴としては、例えば「会議の冒頭に会話を切り出し、会議の最後に締めくくる傾向にある」、「議題の切り換わりにその議題のまとめを行い、次の議題の提起を行う傾向にある」等である。また、有力者の特徴としては、例えば「発言時の注目度合いが高い傾向にある」、「服装がスーツである可能性が高い」等である。

【0098】

また、パターン認識部48は、例えば予め蓄積された社員データベース等との照合により被写体を特定することもできる。例えば、有力者は役職がある管理職であるとした場合には、例えば会議室の扉を開けるときに使用する従業員カードのRFID(Radio Frequency IDentification)タグ等から得られる情報を利用することができる。例えば、RFIDタグから社員番号が取得できる場合には、取得した社員番号を用いて予め蓄積されている社員データベース等を参照し、照合することで被写体を特定することができる。

【0099】

また、パターン認識部48は、被写体の座る位置、又は、所定のカメラ(画像入力部21)の位置とそのカメラからの映像に映る被写体の位置とにより、その被写体が司会者であるか有力者であるかを認識することができる。例えば、ホワイトボードの近くに位置をとるような被写体は、司会者であると判定することができる。また、会議室の上座に座る被写体は、有力者であると判定したりすることができる。

【0100】

ここで、パターン認識部48における認識のタイミングについて、例えば上述したように被写体の特徴を用いる場合には、会議終了時に、それぞれの特徴について分析、最も当てはまる人物をそれぞれ司会者、有力者として判別する。

また、例えば社員データベースと照合する場合には、会議室入室時にIC(Integrated Circuit)チップ付IDカードをスキャナ等で読み取ったり、カメラ等で顔画像を取得したり、着席時の顔画像と照合したときに、司会者、有力者を判別する。なお、IDカードがRFIDタグの場合には、非接触認証が可能である。

また、パターン認識部48は、例えば予め会議場所を指定する場合に、会議開始時における各被写体の位置を予め指定して、司会者、有力者を認識することもできる。例えば、司会者を認識する場合には、ホワイトボードの横に司会者を位置付けさせる等である。なお、上述したパターン認識手法は、複数を組み合わせてもよい。

【0101】

ここで、図9は、実施例2における点数結果とダイジェストの抽出例を示す図である。なお、図9(A),(B)において、横軸は会議時間(分)を示し、縦軸は点数(点)を示している。また、図9(A),(B)の時間軸に対する枠線(実線)で囲まれた部分が、ダイジェスト候補又はダイジェストとして抽出された部分である。会議の長さを1時間(60分)、会議参加者を10人と仮定し、ダイジェストの長さは全体の15%(9分)と設定する。

【0102】

演算処理部47は、取得した各単位時間における点数から、予め設定された閾値よりも評価値の高い部分をダイジェスト候補として抽出する。また、演算処理部47は、そのダイジェスト候補の中から、生成するダイジェストの合計時間等に応じて、最終的に使用されるダイジェストを選択することができる。

【0103】

また、パターン認識部48では、上述した状況パターンや特徴パターン等に基づいて例えば算出された点数結果の時系列から予め設定された条件に対応する点数の時系列的な変化を示す部分を抽出する。

【0104】

具体的に説明すると、図9(A)の例では、ある時間方向の閾値以内である一定のうなずき度合いの点数の変化量を示している。なお、図9(A)におけるパターン認識部48におけるダイジェスト部分の抽出条件としては、例えば「連続する3分間に0.40以上の増加を示し、かつ、その増加開始時点にてキーマンの発言或いは司会者によるまとめの発言がある場合に、増加開始時点から減少する前の時点を抽出する」という条件が設定されているものとする。

【0105】

この条件により、図9(A)では、経過時間3分にてキーマンの発言があり、経過時間3〜5分にうなずき度合いが0.15→0.6まで上昇し、経過時間5〜6分で減少しているため、経過時間3〜5分をダイジェスト場面として抽出される。また同様に、例えば経過時間11〜13分及び53〜55分といった時間についても抽出条件を満たしているため、ダイジェスト抽出対象となる。

【0106】

また、図9(B)の例では、ある時間方向の閾値以内である一定の発言者数の点数の変化量を示している。なお、図9(B)におけるパターン認識部48におけるダイジェスト部分の抽出条件としては、予め設定された所定の単位時間毎の点数の算出結果の変化量が予め設定された閾値等よりも大きい区間を基準としてダイジェストの開始時点と終了時点を決定する。

【0107】

実施例2では、例えば「3分間で0.40以上の増加を示し、かつその増加開始時点及び増加開始時点の点数以下に到達する議論の収束時点に、キーマンの発言或いは司会者のまとめの発言がある場合、増加開始時点から収束時点までを抽出する」という条件が設定されているものとする。

【0108】

この条件により、図9(B)の例では、経過時間41分にてキーマンの発言があり、経過時間41〜43分に発言者数が0.21→0.63まで上昇し、経過時間45分においてもキーマンの発言がある。そのため、図9(B)の例では、経過時間41〜45分までをダイジェスト場面として抽出される。

【0109】

<パターン認識部48における文字認識>

ここで、上述したパターン認識部48は、例えば上述した位置情報蓄積部31において、会議室内にあるホワイトボードや黒板、プロジェクターから光を投射するスクリーンや壁等の文字や図面等を提示する提示領域の位置情報を取得する。そして、パターン認識部48は、その提示領域が撮影されている映像から得られる提示領域中に記載された文字等を認識する。なお、文字認識手法としては、例えば既存のOCR(Optical Character Recognition)等を用いることができるが、これに限定されるものではない。

【0110】

これにより、実施例2では、例えばホワイトボード上に対応する画像認識から、例えば「A.I.」、「アクションアイテム」、「まとめ」、「次回予定」等の所定のキーワードの記載を文字認識することで、認識された文字を用いて会議の状況等を高精度に取得する。したがって、実施例2では、上述したような状況パターンからより適切なダイジェストを生成することができる。

【0111】

例えば、実施例2における「まとめの時間」と「文字認識のタイミング」については、「結論」、「A.I.」等の文字認識の精度を向上させるために、常時、所定の対象キーワードについてホワイトボード上の文字認識を行う。キーワードを検出した場合には、そのキーワードの書き始めからまとめが開始されている可能性が高い。そのため、パターン認識部48は、その時点からの発言に対してキーワードの音声認識による検出を行うことで、議論の「結論」や「A.I.」等をより高精度に抽出することができる。

【0112】

実施例2によれば、会議開始からの所定の時間で単位時間あたりのうなずき度合いが増加していること、またその直前でのキーマンの発言があること、所定の時間でうなずき度合いが低下したこと、その直前での司会者の発言があること等が検出できる。これにより、所定時間における時間帯の映像をダイジェストとして抽出することができる。また、上述の内容を他の要素と組み合わせて、その増加と減少の過度においてキーマンの発言や司会者の発言を組み合わせて適切なダイジェストの抽出が可能となる。

【0113】

また、実施例2では、例えば、議論のきっかけとなる増加開始前後のキーマンの発言、又は司会者の発言も抽出対象としたり、その議論の収束となる減少過程での司会者の発言をも抽出対象とすることで、議論の経過を適切に抽出することができる。

【0114】

更に、実施例2では、議論の収束となる減少過程での司会者の発言を検出する場合、「まとめ」、「AI(エーアイ)」、「アクションアイテム」といったキーワードを音声認識により検出することにより、その議論で確認した議論の結論をダイジェストとして確実に抽出することができる。また、上述した実施例では、うなずき度合いや発言者数等の単独の要素での例を示したが、これに限定されるものではなく、複数の要素を結合した点数で実施することも可能である。

【0115】

<実施例3>

次に、実施例3について説明する。上述した実施例1及び2では、画像・音声取得装置20が1つの場合について説明したが、実施例3では、画像・音声取得装置20が複数設けられている例を示す。つまり、実施例3では、複数の画像・音声取得装置20のそれぞれが、所定の画角で異なる方向を撮影し、異なる人物(被写体)の画像及び音声を取得している。なお、以下の説明では、上述した構成とほぼ同様の処理を行う構成については、同一の符号を付するものとし、ここでの具体的な説明は省略する。

【0116】

図10は、実施例3における会議システムの概要構成例を示す図である。図10に示す会議システム2は、情報処理装置10と、複数の画像・音声取得装置20−1〜20−3とを有する。なお、図10の例では、画像・音声取得装置20を3台設けているが、少なくとも1台を有していれば、台数や設置位置等についてはこれに限定されるものではない。

【0117】

画像・音声取得装置20−1〜20−3は、予め設定された位置(例えば、図10に示す会議卓上の所定の位置等)に配置されている。位置的な対応関係は、情報処理装置10の位置情報蓄積部31に予め蓄積されている。なお、複数の画像・音声装置20−1〜20−3は、会議卓上に設置してもよく、天井や壁に設置してもよい。

【0118】

また、画像・音声装置20−1〜20−3は、ハブ(HUB)100等により接続され、例えば離れた位置にある情報処理装置10とのデータの送受信が可能な状態となっている。

【0119】

図10に示す画像・音声装置20−1は、所定の画角(例えば、θ1)により参加者A及びその周囲の画像及び音声を取得する。画像・音声装置20−2は、所定の画角(例えば、θ2)により参加者B、C、D及びその周囲の画像及び音声を取得する。画像・音声装置20−3は、所定の画角(例えば、θ3)により参加者E,F及びその周囲の画像及び音声を取得する。

【0120】

情報処理装置10は、図10に示す画像・音声取得装置20−1〜20−3から得られるそれぞれの映像情報(例えば、複数の画像情報)を位置情報及び画像に付加されている時間情報に基づいて、時間に同期させて結合し、1つの映像を生成する。情報処理装置10は、上述した画像情報蓄積部32に蓄積される。また、画像・音声取得装置20−1〜20−3から得られるそれぞれの音声情報については、時間情報に基づいて、映像情報に対応させて音声情報蓄積部33に蓄積される。なお、画像・音声取得装置20−1〜20−3から得られる各映像情報と各音声情報との対応は、例えば予め設定される識別情報等を付加しておくことにより容易に対応させることができる。

【0121】

実施例2では、上述のように取得した映像情報及び音声情報に基づいて、上述した実施例1に示すダイジェスト生成と同様な手法でダイジェストを生成することができる。これにより、実施例2では、例えば広い会議室等の広範囲においても複数の画像・音声取得装置から得られる映像及び音声を用いて、より適切なダイジェストを生成することができる。

【0122】

<複数の映像情報と参加者(被写体)との位置関係>

ここで、実施例3における複数の画像・音声装置から得られた映像情報(複数の画像情報を含む)と、参加者(被写体)との位置関係の取得例について、図を用いて具体的に説明する。図11は、実施例3における複数の映像情報と被写体との位置関係の取得例について説明するための図である。

【0123】

なお、図11の例では、上述した図10と同様に3つの画像・音声取得装置20−1〜20−3を用いるものとし、各画像・音声取得装置20−1〜20−3の映像情報と、その被写体との関係が画像・音声取得装置毎に把握できているものとする。また、複数の画像・音声取得装置20−1〜20−3は、固定位置に設置され、予め位置関係が把握できているものとする。

【0124】

図11(A)の例では、説明を容易にするため、各辺の長さがLの正三角形の各頂点に各画像・音声取得装置20−1〜20−3を位置させ、正三角形の中線の延長戦上に画像・音声取得装置20の画角の中心がくるように設置する。

【0125】

ここで、例えば図11(A)に示すように、画像・音声取得装置20−1が発言者(被写体)Aを撮影している場合には、画像・音声取得装置20−1と発言者の位置関係及び画像・音声取得装置20−2と被写体Bとの位置関係により、画像・音声取得装置20−2の被写体Bから見た発言者の位置関係を算出することができる。

【0126】

つまり、図11(B)に示すように、γ=π−(θ1’+π/6)=5π/6−θ1’、β=π−(θ2’+π/6)=5π/6−θ2’と、余弦定理を用いてcosαを算出し、αを求めることができる。

【0127】

<変形例>

ここで、上述した情報処理装置10は、例えばCPU(Central Processing Unit)、RAM(Random Access Memory)等の揮発性の記憶媒体、ROM(Read Only Memory)等の不揮発性の記憶媒体、マウスやキーボード、ポインティングデバイス等の入力装置、画像やデータを表示する表示装置、並びに外部と通信するためのインタフェース装置を備えたコンピュータによって構成することができる。

【0128】

したがって、情報処理装置10が有する上述した各機能は、これらの機能を記述したプログラムをCPUに実行させることによりそれぞれ実現可能となる。また、これらのプログラムは、磁気ディスク(フロッピィーディスク、ハードディスク等)、光ディスク(CD−ROM、DVD等)、半導体メモリ等の記録媒体に格納して頒布することもできる。

【0129】

つまり、上述した各構成における処理をコンピュータに実行させるための実行プログラム(ダイジェスト生成プログラム)を生成し、例えば汎用のパーソナルコンピュータやサーバ等にそのプログラムをインストールすることにより、ダイジェスト生成処理等を実現することができる。

【0130】

ここで、図12は、ダイジェスト生成機能を搭載したPC(Personal Computer)の概観図である。また、図13は、ダイジェスト生成機能を搭載したPCのハードウェア構成例を示す図である。なお、PC110は、ノート型PCの例を示しているが、これに限定されるものではなく、例えば、デスクトップ型PCやサーバ、携帯電話、Personal Digital Assistant(PDA、携帯情報端末)、ゲーム機器等を用いてもよい。また、図12に示すPC110の例では、画像入力部21及び音声入力部22がPC本体111内に有しているが、別体に設けられてもよい。また、図12及び図13において、同一の構成部分については、同一の符号を付するものとする。

【0131】

図12に示すPC110は、PC本体111と、表示部112と、キーボード113と、タッチパッド114と、電源ボタン115と、USBコネクタ116と、CD/DVD装填口117と、マイク118と、スピーカー119と、カメラ120とを有する。

【0132】

また、図13に示すハードウェア構成例では、PC110は、システムコントローラ121と、CPU122と、主記憶装置123と、HDD(Hard Disk Drive)124と、キーボードコントローラ125と、表示部112と、EEPROM(Electrically Erasable Programmable Read Only Memory)126と、CMOS(Complementary Metal Oxide Semiconductor)127と、電源監視部128とを有する。なお、図13に示す各構成は、バス129によりデータの送受信が可能な状態で接続されている。

【0133】

PC本体111は、上述したダイジェスト生成機能を搭載したPCである。また、PC本体111は、外部機器(ネットワークドライブ等)と接続することができる。表示部112は、PC本体111が有する各構成からの命令により画像等を表示する。また、表示部112は、例えば液晶ディスプレイ等である。

【0134】

キーボード113は、ユーザ等による操作によりPC本体111に命令を与える。タッチパッド114は、表示画面112上にカーソルを移動させ、ユーザ等によるボタン操作等により、そのカーソルが重ねられたアイコンに応じた命令を与える。

【0135】

電源ボタン115は、PC110への電源投入を行うボタンである。USBコネクタ116は、USB規格に準拠しており、例えばUSBメモリ等を装着してメモリ内の情報を読み出したり、USBメモリに情報を書き込むことができる。また、CD/DVD装填口117は、CDやDVDが装填し、CDやDVDに記録された情報を読み出したり、CDやDVD内に情報を書き込むことができる。

【0136】

マイク118は、音声入力を可能とする。なお、マイク118は、例えば上述した音声入力部22である。また、スピーカー119は、音声出力を可能とする。また、カメラ120は、画像入力を可能とする。なお、カメラ120は、例えば上述した画像入力部21である。

【0137】

また、図13に示すシステムコントローラ121は、データの入出力管理やダイジェスト生成等、システム全体の制御を行う。CPU122は、主記憶装置123に展開されるOS(Operating System)、BIOS(Basic Input/Output System)等の各種プログラムや上述したダイジェスト生成プログラム等を実行する。

【0138】

主記憶装置123は、HDD124から読み出されたプログラムの実行のための作業エリアとして使用される。また、主記憶装置123は、バックアップを行う保存先(外部メディア又は外部機器)の設定等も格納される。つまり、本実施例においては、主記憶装置123にOS、BIOS、アプリケーション等が展開される。HDD124は、OSやアプリケーションプログラムを格納している。なお、HDD124は、例えば上述したデータ蓄積部11である。キーボードコントローラ125は、キーボード113及びタッチパッド114等からの入力を検出する。

【0139】

表示部112は、CPU122がシステムコントローラ121を介して出す命令に基づいた各種データや処理経過、処理結果等を画面に表示する。なお、表示部112は、例えば上述した表示部13である。EEPROM126は、PCに電源が投入された後、最初に実行されるBIOSを格納している。

【0140】

CMOS127は、BIOSメニューの設定を記憶している。電源監視部128は、電源ボタン115が操作されたか否かを監視している。なお、上述したシステムコントローラ121、CPU122、及び主記憶装置123は、例えば上述したダイジェスト生成部12である。

【0141】

本実施例では、上述したハードウェア構成等に、上述した情報処理装置における各処理を実行するための実行プログラム(ダイジェスト生成プログラム)をインストールすることにより、図12,図13に示す構成において容易にダイジェスト生成処理を実行させることができる。

【0142】

<ダイジェスト生成処理>

ここで、上述した実行プログラム(ダイジェスト生成プログラム)にて実行されるダイジェスト生成処理の一例について、フローチャートを用いて説明する。図14は、ダイジェスト生成処理の一例を示すフローチャートである。

【0143】

図14に示す例では、まず、CPU122は、所定時間撮影された1又は複数の人物(被写体)の映像情報及び音声情報を、例えばHDD124等のデータ蓄積部等に蓄積する(S01)。

【0144】

次に、CPU122は、蓄積された映像情報に含まれる画像情報及び音声情報に対し、予め設定された1又は複数の要素に基づいて、所定の単位時間毎の状況を評価する(S02)。なお、予め設定された1又は複数の要素とは、例えば上述した加算要素及び減算要素等を含む。また、評価とは、例えば上述したように各要素に基づく単位時間毎の点数を算出し、算出された結果からダイジェスト必要な部分を抽出する処理等を含む。

【0145】

次に、CPU122は、S02の処理により取得した評価結果に基づいて、1又は複数のダイジェスト候補を抽出する(S03)。また、CPU122は、S03の処理で得られたダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体の状況又は特徴をパターン認識する(S04)。また、CPU122は、パターン認識結果により得られるダイジェスト候補の前後の時間を含む映像情報及び音声情報を用いてダイジェストを生成する(S05)。

【0146】

なお、上述したダイジェスト生成処理は、ユーザからの実行指示により実行されてもよく、S01の処理により各種情報が蓄積された直後又は蓄積されてから所定のタイミングで実行してもよい。

【0147】

また、他の実施例としては、例えばS04の処理における映像情報及び音声情報に含まれる被写体の状況又は特徴のパターン認識を、S01の処理で蓄積された全ての映像情報及び音声情報を対象として行ってもよい。その場合には、全ての映像情報及び音声情報から得られたパターン認識結果と、S02の処理で得られた評価結果とを組み合わせてダイジェスト候補の前後の時間を含むダイジェストを生成する。

【0148】

上述した各実施例によれば、より適切なダイジェストを生成することができる。また、各実施例によれば、例えば映像や音声から会議議事内容のより効率的な閲覧が可能となるダイジェストを生成することができる。これにより、例えば会議後に議事録を生成する場合には、膨大なデータの全てを参照する必要がなくなり、議論の流れ、結論、A.I.等の会議の概要を捉えられることのできるダイジェストを短時間に提供することができる。

【0149】

また、上述した実施例では、会議中の音声や画像等から得られる複数要素について、時系列変化を検知し、特定のパターン等を認識し、その認識結果を利用して、より適切なダイジェストを生成することができる。また、上述した実施例では、会議の概要を短時間で捉えることのできるダイジェストを提供でき、またパターン認識によりダイジェストの精度を上げることができる。

【0150】

なお、上述した手法は、例えばテレビ会議システムや参加型の議論番組、講義中継、セミナーの評価等、映像(画像を含む)及び音声を有する入力情報であれば、広く適用することができ、それぞれに対応したダイジェストを生成することができる。

【0151】

また、上述した手法は、例えばコンバージェンスサービス等にも適用することができる。コンバージェンスサービスとは、例えば様々な業務等で使用されるセンサや端末によって収集されたデータを、その分野専用に活用したり、蓄積したりするサービスをいう。また、コンバージェンスサービスは、上述した内容だけでなく、他の異種分野や業務に対して、その専門家の知識や判断基準等を付加して再利用することで、新たな価値を創造してサービスを提供することができる。したがって、上述した各実施例で得られる予め設定された要素の基づく評価結果やパターン認識結果等をコンバージェンスサービスに適用することで、各分野で個別に新たなシステム構築やデータ収集等をすることなく、既存データの有効利用を行うことができる。

【0152】

コンバージェンスサービスに各実施例を適用した例としては、各実施例で得られたダイジェストデータを用いて、まず人事部門、経理部門、出席者の上司等の知識の付加等により出席者の会議やプロジェクトに対する重要度、貢献度、居眠り度合い等を取得する。次に、上記の例では、取得した情報を用いて各個人の業務査定や評価、或いは会議時間や出席者情報による各出席者の仕事や工数管理、又はそれらの積算によるプロジェクトの原価算出の参考情報等として活用することができる。また、本実施例により評価の精度を向上させることで、業務評価や勤怠、業務工数、原価管理機能として商品化又はクラウド化してビジネスに結び付けることができる。

【0153】

更に、上述した各実施例を適用して得られたダイジェストを用いて、知財担当者や担当部門或いは当該業務の専門家の知識の付加により、特許候補を短時間で効率よく検索し抽出するツールとして活用することができる。

【0154】

以上、各実施例について詳述したが、特定の実施例に限定されるものではなく、特許請求の範囲に記載された範囲内において、上記変形例以外にも種々の変形及び変更が可能である。

【0155】

なお、以上の実施例に関し、更に以下の付記を開示する。

(付記1)

所定時間撮影された1又は複数の被写体を含む映像情報及び音声情報を蓄積する蓄積部と、

前記蓄積部に蓄積された映像情報及び音声情報を用いて、予め設定された1又は複数の要素に基づき、前記所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出するダイジェスト生成部と、を有し、

前記ダイジェスト生成部は、前記ダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体の状況又は特徴をパターン認識し、認識された結果に基づいて前記ダイジェスト候補からダイジェストを生成するパターン認識部を有することを特徴とする情報処理装置。

(付記2)

前記ダイジェスト生成部は、

前記1又は複数の要素として、加算要素と減算要素とを有し、

前記加算要素は、前記映像情報に含まれる前記被写体の注目度合い、うなずき度合い、発言者数、及び盛上りのうち少なくとも1つを有し、前記減算要素は、前記映像情報に含まれる居眠り人数、及び沈黙度合いのうち少なくとも1つを有することを特徴とする付記1に記載の情報処理装置。

(付記3)

前記ダイジェスト生成部は、

前記加算要素と前記減算要素との組み合わせを、前記映像情報の撮影内容に応じて設定することを特徴とする付記2に記載の情報処理装置。

(付記4)

前記ダイジェスト生成部は、

前記評価結果として得られる前記1又は複数の要素による所定の単位時間毎の点数の算出結果の変化量が予め設定された閾値より大きい区間を基準として前記ダイジェストの開始時点と終了時点を決定することを特徴とする付記1乃至3の何れか1項に記載の情報処理装置。

(付記5)

前記ダイジェスト生成部は、

前記ダイジェストの合計時間を、予め設定された時間又は前記映像情報の合計時間に比例させた一定の割合の時間とすることを特徴とする付記1乃至4の何れか1項に記載の情報処理装置。

(付記6)

前記ダイジェスト生成部は、

前記1又は複数の被写体を異なる位置から撮影した映像情報が複数ある場合には、複数の映像情報に含まれる位置情報に基づいて前記複数の映像情報を連結することを特徴とする付記1乃至5の何れか1項に記載の情報処理装置。

(付記7)

所定時間撮影された1又は複数の被写体を含む映像情報及び音声情報を蓄積し、蓄積された映像情報及び音声情報を用いて、予め設定された1又は複数の要素に基づき、前記所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出し、ダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体の状況又は特徴をパターン認識し、認識された結果に基づいて前記ダイジェスト候補からダイジェストを生成する、処理を有することを特徴とするダイジェスト生成方法。

(付記8)

所定時間撮影された1又は複数の被写体を含む映像情報及び音声情報を蓄積し、蓄積された映像情報及び音声情報を用いて、予め設定された1又は複数の要素に基づき、前記所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出し、ダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体の状況又は特徴をパターン認識し、認識された結果に基づいて前記ダイジェスト候補からダイジェストを生成する、処理をコンピュータに実行させるためのダイジェスト生成プログラム。

【符号の説明】

【0156】

1,2 会議システム

10 情報処理装置

11 データ蓄積部

12 ダイジェスト生成部

13 表示部

20 画像・音声取得装置

21 画像入力部

22 音声入力部

31 位置情報蓄積部

32 画像情報蓄積部

33 音声情報蓄積部

34 ダイジェスト情報蓄積部

41 顔検出部

42 視線方向検出部

43 うなずき検出部

44 居眠り検出部

45 発言者検出部

46 盛上り検出部

47 演算処理部

51,71 目検出部

52 方向判定部

61,72 顔傾斜検出部

62 うなずき判定部

73 居眠り判定部

81 口検出部

82 発言判定部

91 音量判定部

100 ハブ

110 PC

111 PC本体

112 表示部

113 キーボード

114 タッチパッド

115 電源ボタン

116 USBコネクタ

117 CD/DVD装填口

118 マイク

119 スピーカー

120 カメラ

121 システムコントローラ

122 CPU

123 主記憶装置

124 HDD

125 キーボードコントローラ

126 EEPROM

127 CMOS

128 電源監視部

129 バス

【特許請求の範囲】

【請求項1】

所定時間撮影された1又は複数の被写体を含む映像情報及び音声情報を蓄積する蓄積部と、

前記蓄積部に蓄積された映像情報及び音声情報を用いて、予め設定された1又は複数の要素に基づき、前記所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出するダイジェスト生成部と、を有し、

前記ダイジェスト生成部は、前記ダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体の状況又は特徴をパターン認識し、認識された結果に基づいて前記ダイジェスト候補からダイジェストを生成するパターン認識部を有することを特徴とする情報処理装置。

【請求項2】

前記ダイジェスト生成部は、

前記1又は複数の要素として、加算要素と減算要素とを有し、

前記加算要素は、前記映像情報に含まれる前記被写体の注目度合い、うなずき度合い、発言者数、及び盛上りのうち少なくとも1つを有し、前記減算要素は、前記映像情報に含まれる居眠り人数、及び沈黙度合いのうち少なくとも1つを有することを特徴とする請求項1に記載の情報処理装置。

【請求項3】

前記ダイジェスト生成部は、

前記評価結果として得られる前記1又は複数の要素による所定の単位時間毎の点数の算出結果の変化量が予め設定された閾値より大きい区間を基準として前記ダイジェストの開始時点と終了時点を決定することを特徴とする請求項1又は2に記載の情報処理装置。

【請求項4】

前記ダイジェスト生成部は、

前記ダイジェストの合計時間を、予め設定された時間又は前記映像情報の合計時間に比例させた一定の割合の時間とすることを特徴とする請求項1乃至3の何れか1項に記載の情報処理装置。

【請求項5】

前記ダイジェスト生成部は、

前記1又は複数の被写体を異なる位置から撮影した映像情報が複数ある場合には、複数の映像情報に含まれる位置情報に基づいて前記複数の映像情報を連結することを特徴とする請求項1乃至4の何れか1項に記載の情報処理装置。

【請求項6】

所定時間撮影された1又は複数の被写体を含む映像情報及び音声情報を蓄積し、蓄積された映像情報及び音声情報を用いて、予め設定された1又は複数の要素に基づき、前記所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出し、ダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体の状況又は特徴をパターン認識し、認識された結果に基づいて前記ダイジェスト候補からダイジェストを生成する、処理を有することを特徴とするダイジェスト生成方法。

【請求項7】

所定時間撮影された1又は複数の被写体を含む映像情報及び音声情報を蓄積し、蓄積された映像情報及び音声情報を用いて、予め設定された1又は複数の要素に基づき、前記所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出し、ダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体の状況又は特徴をパターン認識し、認識された結果に基づいて前記ダイジェスト候補からダイジェストを生成する、処理をコンピュータに実行させるためのダイジェスト生成プログラム。

【請求項1】

所定時間撮影された1又は複数の被写体を含む映像情報及び音声情報を蓄積する蓄積部と、

前記蓄積部に蓄積された映像情報及び音声情報を用いて、予め設定された1又は複数の要素に基づき、前記所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出するダイジェスト生成部と、を有し、

前記ダイジェスト生成部は、前記ダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体の状況又は特徴をパターン認識し、認識された結果に基づいて前記ダイジェスト候補からダイジェストを生成するパターン認識部を有することを特徴とする情報処理装置。

【請求項2】

前記ダイジェスト生成部は、

前記1又は複数の要素として、加算要素と減算要素とを有し、

前記加算要素は、前記映像情報に含まれる前記被写体の注目度合い、うなずき度合い、発言者数、及び盛上りのうち少なくとも1つを有し、前記減算要素は、前記映像情報に含まれる居眠り人数、及び沈黙度合いのうち少なくとも1つを有することを特徴とする請求項1に記載の情報処理装置。

【請求項3】

前記ダイジェスト生成部は、

前記評価結果として得られる前記1又は複数の要素による所定の単位時間毎の点数の算出結果の変化量が予め設定された閾値より大きい区間を基準として前記ダイジェストの開始時点と終了時点を決定することを特徴とする請求項1又は2に記載の情報処理装置。

【請求項4】

前記ダイジェスト生成部は、

前記ダイジェストの合計時間を、予め設定された時間又は前記映像情報の合計時間に比例させた一定の割合の時間とすることを特徴とする請求項1乃至3の何れか1項に記載の情報処理装置。

【請求項5】

前記ダイジェスト生成部は、

前記1又は複数の被写体を異なる位置から撮影した映像情報が複数ある場合には、複数の映像情報に含まれる位置情報に基づいて前記複数の映像情報を連結することを特徴とする請求項1乃至4の何れか1項に記載の情報処理装置。

【請求項6】

所定時間撮影された1又は複数の被写体を含む映像情報及び音声情報を蓄積し、蓄積された映像情報及び音声情報を用いて、予め設定された1又は複数の要素に基づき、前記所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出し、ダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体の状況又は特徴をパターン認識し、認識された結果に基づいて前記ダイジェスト候補からダイジェストを生成する、処理を有することを特徴とするダイジェスト生成方法。

【請求項7】

所定時間撮影された1又は複数の被写体を含む映像情報及び音声情報を蓄積し、蓄積された映像情報及び音声情報を用いて、予め設定された1又は複数の要素に基づき、前記所定時間の時系列における所定の単位時間毎の変化量を評価し、評価された結果に基づいて1又は複数のダイジェスト候補を抽出し、ダイジェスト候補に対応する映像情報及び音声情報に含まれる被写体の状況又は特徴をパターン認識し、認識された結果に基づいて前記ダイジェスト候補からダイジェストを生成する、処理をコンピュータに実行させるためのダイジェスト生成プログラム。

【図1】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図13】

【図14】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図13】

【図14】

【公開番号】特開2013−31009(P2013−31009A)

【公開日】平成25年2月7日(2013.2.7)

【国際特許分類】

【出願番号】特願2011−165949(P2011−165949)

【出願日】平成23年7月28日(2011.7.28)

【出願人】(000005223)富士通株式会社 (25,993)

【Fターム(参考)】

【公開日】平成25年2月7日(2013.2.7)

【国際特許分類】

【出願日】平成23年7月28日(2011.7.28)

【出願人】(000005223)富士通株式会社 (25,993)

【Fターム(参考)】

[ Back to top ]