感情生成装置およびその方法

【課題】 ニューラルネットを用いて、自然かつ生物的な変化をする感情の生成を可能にする感情生成装置およびその方法を実現する。

【解決手段】 人間と電気機器との間の情報仲介のためのインタフェース装置において、ニューラルネット8はユーザ情報I0 〜I5 ,機器情報I6 ,I7 および現在の感情状態O0 〜O3 を入力して次の感情状態O0 〜O3 を出力し、行動決定エンジン10はニューラルネット8の感情状態O0 〜O3 およびユーザ情報I0 〜I5 を入力してインタフェースの行動を決定し、様相決定エンジン11はニューラルネット8の感情状態O0 〜O3 を入力してインタフェースの様相を決定する。

【解決手段】 人間と電気機器との間の情報仲介のためのインタフェース装置において、ニューラルネット8はユーザ情報I0 〜I5 ,機器情報I6 ,I7 および現在の感情状態O0 〜O3 を入力して次の感情状態O0 〜O3 を出力し、行動決定エンジン10はニューラルネット8の感情状態O0 〜O3 およびユーザ情報I0 〜I5 を入力してインタフェースの行動を決定し、様相決定エンジン11はニューラルネット8の感情状態O0 〜O3 を入力してインタフェースの様相を決定する。

【発明の詳細な説明】

【0001】

【発明の属する技術分野】本発明は感情生成装置およびその方法に関し、特に人工生命,人工エージェント等(以下、インタフェースと総称する)を含む電気機器における感情生成装置およびその方法に関する。

【0002】

【従来の技術】近年、家庭用電化製品,オフィスオートメーション機器などの電気機器(以下、単に機器という)の多機能化および複雑化が進んでいる。また、多機能になるにつれて使い易さを強調したインタフェースが実現されている。バーコード入力,音声入出力などが、その例である。従来、複雑なマニュアル操作で行っていた機器への命令操作が簡単なボタン操作になり、簡単なボタン操作の組合せがバーコード入力による一括入力になり、そしてなじみの深い自然言語での音声命令が可能になってきた。また、機器からの反応も進化を遂げており、以前は命令された結果を実行するのみであったものが、命令を受理したことを示すために反応をするようになった。たとえば、ビデオの録画予約を例に考えると、録画予約が済むとビデオ前面の時計表示部分に録画予約マークがつくようになり、予約終了時に予約をした旨をつげる記号列や自然言語がテレビ画面に表示されるようになり、自然言語が音声化され「予約しました」と告げるようになった。

【0003】現在、前記のような簡単化されたインタフェースが徐々に実用化され、その動作を擬人化したエージェントが行っているように見せる方法が注目されはじめている。しかし、擬人化することにより、ユーザのインタフェースに対する期待は増し、結果としてインタフェースに不満を感じる可能性がある。これを解消するため、特開平6−12401号公報では、擬人化エージェントに感情を持たせる試みが行われている。

【0004】

【発明が解決しようとする課題】上述した従来の擬人化エジェーントでは、感情の実現方法が、ある単一の状況に対して1つもしくは複数のパラメータを個別に変更することにより実現されているため、外部からの影響が同じであれば、現在の感情状態にかかわらず、感情の変化量も一意に決定するので、実際の生物的な感情の変化と比較すると不自然な点がみられるという問題点があった。

【0005】また、外部から受け入れるあらかじめ定義したものに限定しているため、定義されていない状況に対しては感情が変化せず、多様性がないという問題点があった。

【0006】さらに、感情の変化量に乱数を使用する方法もあるが、不自然さが生じる可能性があるという問題点があった。

【0007】本発明の目的は、ニューラルネットワーク(以下、ニューラルネットと略記する),行動決定エンジンおよび様相決定エンジンを備えることにより、自然かつ生物的な変化をする感情の生成を可能にする感情生成装置を提供することにある。

【0008】また、本発明の他の目的は、ニューラルネットを用いて、自然かつ生物的な変化をする感情の生成を可能にした感情生成方法を提供することにある。

【0009】

【課題を解決するための手段】本発明の感情生成装置は、人間と電気機器との間の情報仲介のためのインタフェース装置において、ユーザ情報,機器情報および現在の感情状態を入力して次の感情状態を出力するニューラルネットと、このニューラルネットの感情状態およびユーザ情報を入力してインタフェースの行動を決定する行動決定エンジンと、前記ニューラルネットの感情状態を入力してインタフェースの様相を決定する様相決定エンジンとを備えることを特徴とする。

【0010】また、本発明の感情生成方法は、人間と電気機器との間の情報仲介のための感情生成方法において、ニューラルネットを用いることにより、前記電気機器のインタフェースが生物的要素としての感情を備えていることを特徴とする。

【0011】

【発明の実施の形態】次に、本発明の実施の形態について図面を参照して説明する。

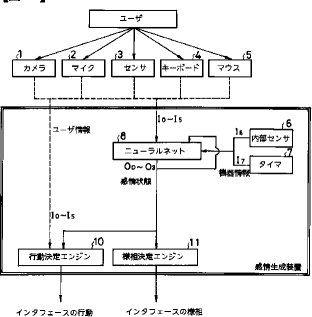

【0012】図1は、本発明の第1の実施の形態に係る感情生成装置の構成を示すブロック図である。本実施の形態に係る感情生成装置は、ニューラルネット8と、行動決定エンジン10と、様相決定エンジン11とから、その主要部が構成されている。

【0013】第1の実施の形態に係る感情生成装置では、パーソナルコンピュータへの実装を想定している。ユーザから感情生成装置へのデータの入力手段としては、カメラ1,マイク2,センサ3,キーボード4,マウス5などがある。ここで、ユーザのアナログ変動する情報(以下、アナログ変動情報という)を獲得する手段としては、カメラ1,マイク2,センサ3があり、カメラ1による視線,顔つきなど、センサ3による皮膚温度,脈拍数など、またマイク2からの音声入力で得られた声質,その他の音などがアナログ変動情報となる。プログラム中で定義された流れをもって変動する情報(以下、流れを持つ情報という)として考えられるものには、インタフェースのミスに対するユーザの怒鳴り声や舌打ちなど、機器の出力に対する反応、およびその履歴があげられる。これらの情報は、カメラ1,マイク2,キーボード4,マウス5のいずれかを用いて伝達される。以下、アナログ変動情報および流れを持つ情報を総称して、ユーザ情報という。機器内で変動する時系列的な情報(以下、機器情報という)には、内部センサ6により得られる機器の温度I6 ,タイマ7により測定されたパーソナルコンピュータの使用時間I7 などが対応する。

【0014】図2を参照すると、ニューラルネット8は、入力層,中間層,出力層の3層からなる。ニューラルネット8に入力として与えられるユーザ情報としては、カメラ1から得られる「瞬きの回数」I0 ,マイク2から得られる「声の大きさ」I1 および「発声間隔」I2 ,センサ3から得られる「脈拍数」I3 ,キーボード4から得られる「打鍵の強さ」I4 ,およびマウス5から得られる1回当たりの「使用時間」I5 がある。また、機器情報としては、内部センサ6から得られる「内部温度」I6 ,およびタイマ7から得られる「使用時間」I7 がある。また、ニューラルネット8の出力層に得られる出力O0 〜O3 は、感情状態を表すデータであり、「喜」,「怒」,「悲」,および「驚」に対応した4出力である。以下、出力O0 〜O3 を感情状態という。さらに、ニューラルネット8には、前回出力された感情状態O0 〜O3 が、現在の感情状態S0 〜S3 として入力されている。

【0015】図3は、ニューラルネット8の学習に必要な学習データ(ユーザ情報I0 〜I5 ,機器情報I6 ,I7 および教師信号T0 〜T3 )を例示する図である。ニューラルネット8は、例えば、バックプロパゲーション法等を用いて学習させて使用する。バックプロパゲーション法は、教師付き学習の一種であり、入力とそれに対する適切な解答(教師)のデータとのセットを用意し、その対になったデータを用いて学習を行う方法である。例えば、機器を長時間使用し、ユーザおよび機器ともに疲労が感じられる場合を例示すると、そのような状況を表す入力が入ったときに、最初のうちはニューラルネット8は不適切である可能性が高い感情状態O0 〜O3 を出力する。このとき、理想の感情状態O0 〜O3 、つまり機器の感情は「激怒」であることを学習させるために、教師信号として「激怒」を表す信号T0 〜T3 を与える。このようにして、いくつかの入力に対して、信号T0 〜T3 を与える処理を繰り返して学習を行う。学習が済むと、入力セットとして直接与えていない情報に関しても、与えられた入力セットを補完する形で感情状態O0 〜O3 が得られるようになる。ここで、もし「怒る」ことを教えなければ、決して怒らない感情を作り上げることも可能である。一方、実際の感情は、連続性および方向性があり、強く反応する部分とそうでない部分とがある(怒りやすく、喜びにくいなど)。つまり、ニューラルネット8の特性を使うことにより、生物らしい感情を表現できる。なお、ニューラルネット8の学習についてのより詳しい解説については、「ニューロコンピュータ」(技術評論社)などに記載されている。

【0016】ニューラルネット8の感情状態O0 〜O3 は、行動決定エンジン10および様相決定エンジン11に渡され、ユーザからの問い合わせに対する機器からの返答等の行動を決定する際の1つの決定要素として用いられたり、擬人化インタフェースの表情や色といった様相の生成に使用されたりする。

【0017】図4は、感情状態O0 〜O3 によって形成される仮想的な4次元空間(以下、感情マップという)を例示する図である。感情マップは、(喜,怒,悲,驚)の4次元の感情状態O0 〜O3 からなるマップであり、各感情状態O0 〜O3 は(0,0,0,0)から(1,1,1,1)の範囲で変動する。それぞれの感情状態O0 〜O3 の特性は値が大きくなる程強くなり、(0,0,0,0)から(1,1,1,1)を結ぶ線上、すなわちすべての感情状態O0 〜O3 の値が等しい時には感情は中立安定な状態である。

【0018】図5は、行動決定エンジン10の内部構造の一例を示すブロック図である。行動決定エンジン10は、入力検出・情報加工部51と、行動決定データベース52と、行動決定部53とから、その主要部が構成されている。

【0019】入力検出・情報加工部51は、外部から得られたユーザ情報I0 〜I5 がどのような情報であるかを検出し、画像は画像認識手段を用いて、音声は音声認識手段を用いてというように、ユーザ情報に応じた手段を用いてその加工を行う(以下、加工された結果の情報を加工情報という)。

【0020】図6を参照すると、入力検出・情報加工部51の処理は、入力タイプ判別ステップS101と、入力文字列判断ステップS102と、入力ボタン判断・入力位置判断ステップS103と、入力文字列判断・音質判断ステップS104と、画像特徴判断ステップS105と、脈拍数判断ステップS106とからなる。

【0021】図7は、行動決定データベース52の内容の一部を例示する図である。この行動決定データベース52では、入力される加工情報およびニューラルネット8の感情状態O0 〜O3 に対応して、インタフェースの行動が記述されている。

【0022】行動決定部53は、入力検出・情報加工部51からの加工情報とニューラルネット8の感情状態O0 〜O3 とを用いて、行動決定データベース52を検索することにより、インタフェースの行動を決定する。

【0023】図8を参照すると、行動決定部53の処理は、加工情報入力ステップS201と、ニューラルネット感情状態入力ステップS202と、行動決定データベース検索ステップS203と、行動出力ステップS204とからなる。

【0024】図9は、様相決定エンジン11の概要を示すブロック図である。様相決定エンジン11は、目データ導出部91と、目データデータベース92と、鼻データ導出部93と、鼻データデータベース94と、口データ導出部95と、口データデータベース96と、色データ導出部97と、色データデータベース98と、様相データ導出部99とから構成されている。

【0025】様相は、目,鼻,口,色などの部品に分けてデータの作成を行う。各部品は、部品ごとのデータベースを持ち、ニューラルネット8の感情状態O0 〜O3 と目データデータベース92,鼻データデータベース94,口データデータベース96,および色データデータベース98とから、ニューラルネット8の感情状態O0 〜O3 に合った目データ,鼻データ,口データおよび色データを導出し、これら導出データを基に画像データなどの様相を形成するデータを導出する。

【0026】図10は、目データデータベース92,鼻データデータベース94,口データデータベース96および色データデータベース98におけるデータ格納形式を例示する図である。感情値Di (i=0〜3)は、ニューラルネット8の感情状態O0 〜O3 と同様に、「喜」,「怒」,「悲」,および「驚」に対応するが、感情値Di の取り得る値は、[0,0.5,1]の3値のいずれかである。感情値Di が決定すると、それぞれの部品を形成するデータが決定する。この形成データは、ビットマップデータやポリゴンデータなどの画像データである。すべての部品のデータが得られたならば、様相データ導出部99は、それらを統合した画像データを様相として作成する。

【0027】図11は、目データ導出部91,鼻データ導出部93,口データ導出部95,および色データ導出部97によるニューラルネット8の感情状態Oi (i=0〜3)から感情値Di (i=0〜3)を求める方法を示すフローチャートである。ニューラルネット8の感情状態Oi (i=0〜3)から感情値Di (i=0〜3)を求める方法は、ニューラルネット8の出力Oi (i=0〜3)と目データデータベース92,鼻データデータベース94,口データデータベース96および色データデータベース98に記録されている感情Di (i=0〜3)を比較して一番近いものを選択するという方法である。

【0028】図11を参照すると、感情値Di (i=0〜3)を求める方法は、カウンタi=4判定ステップS301と、感情状態Oi 0.25未満判定ステップS302と、感情状態Oi 0.25以上0.75未満判定ステップS303と、感情値Di =0設定ステップS304と、感情値Di =0.5設定ステップS305と、と、感情値Di =1設定ステップS306と、カウンタi増加ステップS307とからなる。

【0029】次に、このように構成された第1の実施の形態に係る感情生成装置の動作について、その感情生成方法とともに説明する。

【0030】カメラ1,マイク2およびセンサ3からアナログ変動情報が、キーボード4およびマウス5から流れを持った情報がユーザ情報I0 〜I5 として入力されるとともに、機器の内部センサ6およびタイマ7から機器情報I6 およびI7 が入力されると、ニューラルネット8は、前回の感情状態S0 〜S3 も一緒に入力して、今回の感情状態O0 〜O3 を出力する。

【0031】次に、行動決定エンジン10は、ユーザ情報I0 〜I5 およびニューラルネット8の感情状態O0 〜O3 を入力してインタフェースの行動を決定する。

【0032】詳しくは、行動決定エンジン10では、入力検出・情報加工部51が、ユーザ情報I0 〜I5 を入力して入力タイプを判別し(ステップS101)、キー入力であれば入力文字列を判断し(ステップS102)、マウス入力であれば入力ボタンおよび入力位置を判断し(ステップS103)、音声入力であれば入力文字列および音質を判断し(ステップS104)、画像入力であれば画像特徴を判断し(ステップS105)、センサ入力であれば脈拍数を判断して(ステップS106)、加工情報として出力する。

【0033】次に、行動決定部52は、入力検出・情報加工部51からの加工情報と、ニューラルネット8の感情状態O0 〜O3 とを入力して行動決定データベース53を検索することにより、インタフェースの行動を決定する。

【0034】例えば、図7の行動決定データベース52を参照すると、マウス5のクリックを示すユーザ情報I4 が入力されたとすると、行動決定部53は、ニューラルネット8の感情状態O1 が0.5以上の場合には何もせず、その他の場合には(x,y)の位置のイベントを判定し、イベントを処理する。また、マイク2からの音声入力を示すユーザ情報I1 が入力されたとすると、行動決定部53は、ニューラルネット8の感情状態O2 が0.5以上の場合にはトーンを下げて音声「お・は・よ・う」を出力し、感情状態O1 が0.8より大きいか、または感情状態O3 が0.5より大きい場合には何もせず、その他の場合には音声「う・る・さ・い」を出力する。

【0035】一方、様相決定エンジン11は、ニューラルネット8の感情状態O0 〜O3 を入力してインタフェースの様相を決定する。

【0036】詳しくは、様相決定エンジン11では、目データ導出部91が目データデータベース92を検索して目データを決定し、鼻データ導出部93が鼻データデータベース94を検索して鼻データを決定し、口データ導出部95が口データデータベース96を検索して口データを決定し、色データ導出部97が色データデータベース98を検索して色データを決定して、これらデータを様相データ導出部99が、重畳してインタフェースの様相として出力する。

【0037】このとき、目データ導出部91,鼻データ導出部93,口データ導出部95,および色データ導出部97では、ニューラルネット8の感情状態Oi (i=0〜3)から感情値Di (i=0〜3)を求める。すなわち、感情状態Oi (i=0〜3)が0.25より小さければ(ステップS302)、感情値Di (i=0〜3)を0とし、感情状態Oi (i=0〜3)が0.25から0.75の間であれば(ステップS303)、感情値Di (i=0〜3)を0.5とし、感情状態Oi (i=0〜3)が0.75より大きければ、感情値Di (i=0〜3)を1として正規化する。つまり、ニューラルネット8の感情状態Oi (i=0〜3)と目データデータベース92,鼻データデータベース94,口データデータベース96および色データデータベース98に記録されている感情値Di (i=0〜3)とを比較して一番近いものを選択する。

【0038】図12は、様相決定の方法として、顔の表情の決定方法の一例を示す図である。感情値Di (i=0〜3)は感情マップ上のいずれかの点であるので、あらかじめ感情マップ上の主要な点、ユーザから見て常識的な感情の変化を学習させる。その主要な点に関して、あらかじめ顔の様相データを用意して、主要な点以外の点の様相に対しては、その主要な点を補完するような中間的な様相を出力するようにする。目の例を挙げれば、主要な点として、「普通」(0,0,0,0),「怒」(0,0.5,0,0),「激怒」(0,1,0,0)を用意しておき、その中間の点があったときに、「ちょっと怒」(0,0.3,0,0)に適するようなデータを合成して作り出す。

【0039】図13は、本発明の第2の実施の形態に係る感情生成装置を示すブロック図である。本実施の形態に係る感情生成装置は、図1に示した第1の実施の形態に係る感情生成装置に対して、感情生成方法を実現する感情生成プログラム(データを含む)を記録した記録媒体20を備えるようにしたものである。この記録媒体20は、磁気ディスク,半導体メモリその他の記録媒体であってよい。感情生成プログラムは、記録媒体20からコンピュータ(図示せず)に読み込まれ、コンピュータの動作を感情生成装置として制御する。感情生成装置の動作は、第1の実施の形態に係る感情生成装置の場合と全く同様なので、その詳しい説明は割愛する。

【0040】上記実施の形態に係る感情生成装置およびその方法は、ニューラルネット8にユーザ情報ユーザ情報I0 〜I5 および機器情報I6 ,I7 の組合せとそれに対する理想的な感情状態O0 〜O3 を有限パタン学習させることにより、あらゆる状況に対して感情状態O0 〜O3 を出力することを可能とし、インタフェースの行動および様相をより擬人化することが可能となる。

【0041】

【発明の効果】以上説明したように、本発明の感情生成装置およびその方法によれば、ニューラルネットを用いて常にユーザの動作をとらえているので、それによって変動するインタフェースの行動およびインタフェースの様相も常に変化するという効果がある。

【0042】また、同じ入力をした場合でも、感情状態の変動に応じてインタフェースの行動および様相に違いが生じ、より自然で生物的な対応を可能にして擬人化を高めることができるという効果がある。

【図面の簡単な説明】

【図1】本発明の第1の実施の形態に係る感情生成装置の構成を示すブロック図である。

【図2】図1中のニューラルネットの入力層,中間層および出力層を示す図である。

【図3】図1中のニューラルネットの学習に必要な学習データを例示する図である。

【図4】図1中のニューラルネットの感情状態によって形成される感情マップの一例を説明する図である。

【図5】図1中の行動決定エンジンの内部構造を示すブロック図である。

【図6】図5中の入力検出・情報加工部の処理を示すフローチャートである。

【図7】図5中の行動決定データベースの内容の一部を例示する図である。

【図8】図5中の行動決定部の処理を示すフローチャートである。

【図9】図1中の様相決定エンジンの概略を示すブロック図である。

【図10】図9中の目データデータベース,鼻データデータベース,口データデータベースおよび色データデータベースのデータ格納形式を例示する図である。

【図11】図9中の目データ導出部,鼻データ導出部,口データ導出部および色データ導出部によるニューラルネットの感情状態から感情値を求める方法を示すフローチャートである。

【図12】図1中の様相決定エンジンにおける様相決定の方法として顔の表情の決定方法の一例を示す図である。

【図13】本発明の第2の実施の形態に係る感情生成装置の構成を示すブロック図である。

【符号の説明】

1 カメラ

2 マイク

3 センサ

4 キーボード

5 マウス

6 内部センサ

7 タイマ

8 ニューラルネット

10 行動決定エンジン

11 様相決定エンジン

51 入力検出・情報加工部

52 行動決定データベース

53 行動決定部

91 目データ導出部

92 目データデータベース

93 鼻データ導出部

94 鼻データデータベース

95 口データ導出部

96 口データデータベース

97 色データ導出部

98 色データデータベース

99 様相データ導出部

O0 〜O3 感情状態

S101 入力タイプ判別ステップ

S102 入力文字列判断ステップ

S103 入力ボタン判断・入力位置判断ステップ

S104 入力文字列判断・音質判断ステップ

S105 画像特徴判断ステップ

S106 脈拍数判断ステップ

S201 加工情報入力ステップ

S202 ニューラルネット感情状態入力ステップ

S203 行動決定データベース検索ステップ

S204 行動出力ステップ

S301 カウンタi=4判定ステップ

S302 感情状態Oi 0.25未満判定ステップ

S303 感情状態Oi 0.25以上0.75未満判定ステップ

S304 感情値Di =0設定ステップ

S305 感情値Di =0.5設定ステップ

S306 感情値Di =1設定ステップ

S307 カウンタi増加ステップ

S0 〜S3 前回の感情状態

T0 〜T3 教師信号

【0001】

【発明の属する技術分野】本発明は感情生成装置およびその方法に関し、特に人工生命,人工エージェント等(以下、インタフェースと総称する)を含む電気機器における感情生成装置およびその方法に関する。

【0002】

【従来の技術】近年、家庭用電化製品,オフィスオートメーション機器などの電気機器(以下、単に機器という)の多機能化および複雑化が進んでいる。また、多機能になるにつれて使い易さを強調したインタフェースが実現されている。バーコード入力,音声入出力などが、その例である。従来、複雑なマニュアル操作で行っていた機器への命令操作が簡単なボタン操作になり、簡単なボタン操作の組合せがバーコード入力による一括入力になり、そしてなじみの深い自然言語での音声命令が可能になってきた。また、機器からの反応も進化を遂げており、以前は命令された結果を実行するのみであったものが、命令を受理したことを示すために反応をするようになった。たとえば、ビデオの録画予約を例に考えると、録画予約が済むとビデオ前面の時計表示部分に録画予約マークがつくようになり、予約終了時に予約をした旨をつげる記号列や自然言語がテレビ画面に表示されるようになり、自然言語が音声化され「予約しました」と告げるようになった。

【0003】現在、前記のような簡単化されたインタフェースが徐々に実用化され、その動作を擬人化したエージェントが行っているように見せる方法が注目されはじめている。しかし、擬人化することにより、ユーザのインタフェースに対する期待は増し、結果としてインタフェースに不満を感じる可能性がある。これを解消するため、特開平6−12401号公報では、擬人化エージェントに感情を持たせる試みが行われている。

【0004】

【発明が解決しようとする課題】上述した従来の擬人化エジェーントでは、感情の実現方法が、ある単一の状況に対して1つもしくは複数のパラメータを個別に変更することにより実現されているため、外部からの影響が同じであれば、現在の感情状態にかかわらず、感情の変化量も一意に決定するので、実際の生物的な感情の変化と比較すると不自然な点がみられるという問題点があった。

【0005】また、外部から受け入れるあらかじめ定義したものに限定しているため、定義されていない状況に対しては感情が変化せず、多様性がないという問題点があった。

【0006】さらに、感情の変化量に乱数を使用する方法もあるが、不自然さが生じる可能性があるという問題点があった。

【0007】本発明の目的は、ニューラルネットワーク(以下、ニューラルネットと略記する),行動決定エンジンおよび様相決定エンジンを備えることにより、自然かつ生物的な変化をする感情の生成を可能にする感情生成装置を提供することにある。

【0008】また、本発明の他の目的は、ニューラルネットを用いて、自然かつ生物的な変化をする感情の生成を可能にした感情生成方法を提供することにある。

【0009】

【課題を解決するための手段】本発明の感情生成装置は、人間と電気機器との間の情報仲介のためのインタフェース装置において、ユーザ情報,機器情報および現在の感情状態を入力して次の感情状態を出力するニューラルネットと、このニューラルネットの感情状態およびユーザ情報を入力してインタフェースの行動を決定する行動決定エンジンと、前記ニューラルネットの感情状態を入力してインタフェースの様相を決定する様相決定エンジンとを備えることを特徴とする。

【0010】また、本発明の感情生成方法は、人間と電気機器との間の情報仲介のための感情生成方法において、ニューラルネットを用いることにより、前記電気機器のインタフェースが生物的要素としての感情を備えていることを特徴とする。

【0011】

【発明の実施の形態】次に、本発明の実施の形態について図面を参照して説明する。

【0012】図1は、本発明の第1の実施の形態に係る感情生成装置の構成を示すブロック図である。本実施の形態に係る感情生成装置は、ニューラルネット8と、行動決定エンジン10と、様相決定エンジン11とから、その主要部が構成されている。

【0013】第1の実施の形態に係る感情生成装置では、パーソナルコンピュータへの実装を想定している。ユーザから感情生成装置へのデータの入力手段としては、カメラ1,マイク2,センサ3,キーボード4,マウス5などがある。ここで、ユーザのアナログ変動する情報(以下、アナログ変動情報という)を獲得する手段としては、カメラ1,マイク2,センサ3があり、カメラ1による視線,顔つきなど、センサ3による皮膚温度,脈拍数など、またマイク2からの音声入力で得られた声質,その他の音などがアナログ変動情報となる。プログラム中で定義された流れをもって変動する情報(以下、流れを持つ情報という)として考えられるものには、インタフェースのミスに対するユーザの怒鳴り声や舌打ちなど、機器の出力に対する反応、およびその履歴があげられる。これらの情報は、カメラ1,マイク2,キーボード4,マウス5のいずれかを用いて伝達される。以下、アナログ変動情報および流れを持つ情報を総称して、ユーザ情報という。機器内で変動する時系列的な情報(以下、機器情報という)には、内部センサ6により得られる機器の温度I6 ,タイマ7により測定されたパーソナルコンピュータの使用時間I7 などが対応する。

【0014】図2を参照すると、ニューラルネット8は、入力層,中間層,出力層の3層からなる。ニューラルネット8に入力として与えられるユーザ情報としては、カメラ1から得られる「瞬きの回数」I0 ,マイク2から得られる「声の大きさ」I1 および「発声間隔」I2 ,センサ3から得られる「脈拍数」I3 ,キーボード4から得られる「打鍵の強さ」I4 ,およびマウス5から得られる1回当たりの「使用時間」I5 がある。また、機器情報としては、内部センサ6から得られる「内部温度」I6 ,およびタイマ7から得られる「使用時間」I7 がある。また、ニューラルネット8の出力層に得られる出力O0 〜O3 は、感情状態を表すデータであり、「喜」,「怒」,「悲」,および「驚」に対応した4出力である。以下、出力O0 〜O3 を感情状態という。さらに、ニューラルネット8には、前回出力された感情状態O0 〜O3 が、現在の感情状態S0 〜S3 として入力されている。

【0015】図3は、ニューラルネット8の学習に必要な学習データ(ユーザ情報I0 〜I5 ,機器情報I6 ,I7 および教師信号T0 〜T3 )を例示する図である。ニューラルネット8は、例えば、バックプロパゲーション法等を用いて学習させて使用する。バックプロパゲーション法は、教師付き学習の一種であり、入力とそれに対する適切な解答(教師)のデータとのセットを用意し、その対になったデータを用いて学習を行う方法である。例えば、機器を長時間使用し、ユーザおよび機器ともに疲労が感じられる場合を例示すると、そのような状況を表す入力が入ったときに、最初のうちはニューラルネット8は不適切である可能性が高い感情状態O0 〜O3 を出力する。このとき、理想の感情状態O0 〜O3 、つまり機器の感情は「激怒」であることを学習させるために、教師信号として「激怒」を表す信号T0 〜T3 を与える。このようにして、いくつかの入力に対して、信号T0 〜T3 を与える処理を繰り返して学習を行う。学習が済むと、入力セットとして直接与えていない情報に関しても、与えられた入力セットを補完する形で感情状態O0 〜O3 が得られるようになる。ここで、もし「怒る」ことを教えなければ、決して怒らない感情を作り上げることも可能である。一方、実際の感情は、連続性および方向性があり、強く反応する部分とそうでない部分とがある(怒りやすく、喜びにくいなど)。つまり、ニューラルネット8の特性を使うことにより、生物らしい感情を表現できる。なお、ニューラルネット8の学習についてのより詳しい解説については、「ニューロコンピュータ」(技術評論社)などに記載されている。

【0016】ニューラルネット8の感情状態O0 〜O3 は、行動決定エンジン10および様相決定エンジン11に渡され、ユーザからの問い合わせに対する機器からの返答等の行動を決定する際の1つの決定要素として用いられたり、擬人化インタフェースの表情や色といった様相の生成に使用されたりする。

【0017】図4は、感情状態O0 〜O3 によって形成される仮想的な4次元空間(以下、感情マップという)を例示する図である。感情マップは、(喜,怒,悲,驚)の4次元の感情状態O0 〜O3 からなるマップであり、各感情状態O0 〜O3 は(0,0,0,0)から(1,1,1,1)の範囲で変動する。それぞれの感情状態O0 〜O3 の特性は値が大きくなる程強くなり、(0,0,0,0)から(1,1,1,1)を結ぶ線上、すなわちすべての感情状態O0 〜O3 の値が等しい時には感情は中立安定な状態である。

【0018】図5は、行動決定エンジン10の内部構造の一例を示すブロック図である。行動決定エンジン10は、入力検出・情報加工部51と、行動決定データベース52と、行動決定部53とから、その主要部が構成されている。

【0019】入力検出・情報加工部51は、外部から得られたユーザ情報I0 〜I5 がどのような情報であるかを検出し、画像は画像認識手段を用いて、音声は音声認識手段を用いてというように、ユーザ情報に応じた手段を用いてその加工を行う(以下、加工された結果の情報を加工情報という)。

【0020】図6を参照すると、入力検出・情報加工部51の処理は、入力タイプ判別ステップS101と、入力文字列判断ステップS102と、入力ボタン判断・入力位置判断ステップS103と、入力文字列判断・音質判断ステップS104と、画像特徴判断ステップS105と、脈拍数判断ステップS106とからなる。

【0021】図7は、行動決定データベース52の内容の一部を例示する図である。この行動決定データベース52では、入力される加工情報およびニューラルネット8の感情状態O0 〜O3 に対応して、インタフェースの行動が記述されている。

【0022】行動決定部53は、入力検出・情報加工部51からの加工情報とニューラルネット8の感情状態O0 〜O3 とを用いて、行動決定データベース52を検索することにより、インタフェースの行動を決定する。

【0023】図8を参照すると、行動決定部53の処理は、加工情報入力ステップS201と、ニューラルネット感情状態入力ステップS202と、行動決定データベース検索ステップS203と、行動出力ステップS204とからなる。

【0024】図9は、様相決定エンジン11の概要を示すブロック図である。様相決定エンジン11は、目データ導出部91と、目データデータベース92と、鼻データ導出部93と、鼻データデータベース94と、口データ導出部95と、口データデータベース96と、色データ導出部97と、色データデータベース98と、様相データ導出部99とから構成されている。

【0025】様相は、目,鼻,口,色などの部品に分けてデータの作成を行う。各部品は、部品ごとのデータベースを持ち、ニューラルネット8の感情状態O0 〜O3 と目データデータベース92,鼻データデータベース94,口データデータベース96,および色データデータベース98とから、ニューラルネット8の感情状態O0 〜O3 に合った目データ,鼻データ,口データおよび色データを導出し、これら導出データを基に画像データなどの様相を形成するデータを導出する。

【0026】図10は、目データデータベース92,鼻データデータベース94,口データデータベース96および色データデータベース98におけるデータ格納形式を例示する図である。感情値Di (i=0〜3)は、ニューラルネット8の感情状態O0 〜O3 と同様に、「喜」,「怒」,「悲」,および「驚」に対応するが、感情値Di の取り得る値は、[0,0.5,1]の3値のいずれかである。感情値Di が決定すると、それぞれの部品を形成するデータが決定する。この形成データは、ビットマップデータやポリゴンデータなどの画像データである。すべての部品のデータが得られたならば、様相データ導出部99は、それらを統合した画像データを様相として作成する。

【0027】図11は、目データ導出部91,鼻データ導出部93,口データ導出部95,および色データ導出部97によるニューラルネット8の感情状態Oi (i=0〜3)から感情値Di (i=0〜3)を求める方法を示すフローチャートである。ニューラルネット8の感情状態Oi (i=0〜3)から感情値Di (i=0〜3)を求める方法は、ニューラルネット8の出力Oi (i=0〜3)と目データデータベース92,鼻データデータベース94,口データデータベース96および色データデータベース98に記録されている感情Di (i=0〜3)を比較して一番近いものを選択するという方法である。

【0028】図11を参照すると、感情値Di (i=0〜3)を求める方法は、カウンタi=4判定ステップS301と、感情状態Oi 0.25未満判定ステップS302と、感情状態Oi 0.25以上0.75未満判定ステップS303と、感情値Di =0設定ステップS304と、感情値Di =0.5設定ステップS305と、と、感情値Di =1設定ステップS306と、カウンタi増加ステップS307とからなる。

【0029】次に、このように構成された第1の実施の形態に係る感情生成装置の動作について、その感情生成方法とともに説明する。

【0030】カメラ1,マイク2およびセンサ3からアナログ変動情報が、キーボード4およびマウス5から流れを持った情報がユーザ情報I0 〜I5 として入力されるとともに、機器の内部センサ6およびタイマ7から機器情報I6 およびI7 が入力されると、ニューラルネット8は、前回の感情状態S0 〜S3 も一緒に入力して、今回の感情状態O0 〜O3 を出力する。

【0031】次に、行動決定エンジン10は、ユーザ情報I0 〜I5 およびニューラルネット8の感情状態O0 〜O3 を入力してインタフェースの行動を決定する。

【0032】詳しくは、行動決定エンジン10では、入力検出・情報加工部51が、ユーザ情報I0 〜I5 を入力して入力タイプを判別し(ステップS101)、キー入力であれば入力文字列を判断し(ステップS102)、マウス入力であれば入力ボタンおよび入力位置を判断し(ステップS103)、音声入力であれば入力文字列および音質を判断し(ステップS104)、画像入力であれば画像特徴を判断し(ステップS105)、センサ入力であれば脈拍数を判断して(ステップS106)、加工情報として出力する。

【0033】次に、行動決定部52は、入力検出・情報加工部51からの加工情報と、ニューラルネット8の感情状態O0 〜O3 とを入力して行動決定データベース53を検索することにより、インタフェースの行動を決定する。

【0034】例えば、図7の行動決定データベース52を参照すると、マウス5のクリックを示すユーザ情報I4 が入力されたとすると、行動決定部53は、ニューラルネット8の感情状態O1 が0.5以上の場合には何もせず、その他の場合には(x,y)の位置のイベントを判定し、イベントを処理する。また、マイク2からの音声入力を示すユーザ情報I1 が入力されたとすると、行動決定部53は、ニューラルネット8の感情状態O2 が0.5以上の場合にはトーンを下げて音声「お・は・よ・う」を出力し、感情状態O1 が0.8より大きいか、または感情状態O3 が0.5より大きい場合には何もせず、その他の場合には音声「う・る・さ・い」を出力する。

【0035】一方、様相決定エンジン11は、ニューラルネット8の感情状態O0 〜O3 を入力してインタフェースの様相を決定する。

【0036】詳しくは、様相決定エンジン11では、目データ導出部91が目データデータベース92を検索して目データを決定し、鼻データ導出部93が鼻データデータベース94を検索して鼻データを決定し、口データ導出部95が口データデータベース96を検索して口データを決定し、色データ導出部97が色データデータベース98を検索して色データを決定して、これらデータを様相データ導出部99が、重畳してインタフェースの様相として出力する。

【0037】このとき、目データ導出部91,鼻データ導出部93,口データ導出部95,および色データ導出部97では、ニューラルネット8の感情状態Oi (i=0〜3)から感情値Di (i=0〜3)を求める。すなわち、感情状態Oi (i=0〜3)が0.25より小さければ(ステップS302)、感情値Di (i=0〜3)を0とし、感情状態Oi (i=0〜3)が0.25から0.75の間であれば(ステップS303)、感情値Di (i=0〜3)を0.5とし、感情状態Oi (i=0〜3)が0.75より大きければ、感情値Di (i=0〜3)を1として正規化する。つまり、ニューラルネット8の感情状態Oi (i=0〜3)と目データデータベース92,鼻データデータベース94,口データデータベース96および色データデータベース98に記録されている感情値Di (i=0〜3)とを比較して一番近いものを選択する。

【0038】図12は、様相決定の方法として、顔の表情の決定方法の一例を示す図である。感情値Di (i=0〜3)は感情マップ上のいずれかの点であるので、あらかじめ感情マップ上の主要な点、ユーザから見て常識的な感情の変化を学習させる。その主要な点に関して、あらかじめ顔の様相データを用意して、主要な点以外の点の様相に対しては、その主要な点を補完するような中間的な様相を出力するようにする。目の例を挙げれば、主要な点として、「普通」(0,0,0,0),「怒」(0,0.5,0,0),「激怒」(0,1,0,0)を用意しておき、その中間の点があったときに、「ちょっと怒」(0,0.3,0,0)に適するようなデータを合成して作り出す。

【0039】図13は、本発明の第2の実施の形態に係る感情生成装置を示すブロック図である。本実施の形態に係る感情生成装置は、図1に示した第1の実施の形態に係る感情生成装置に対して、感情生成方法を実現する感情生成プログラム(データを含む)を記録した記録媒体20を備えるようにしたものである。この記録媒体20は、磁気ディスク,半導体メモリその他の記録媒体であってよい。感情生成プログラムは、記録媒体20からコンピュータ(図示せず)に読み込まれ、コンピュータの動作を感情生成装置として制御する。感情生成装置の動作は、第1の実施の形態に係る感情生成装置の場合と全く同様なので、その詳しい説明は割愛する。

【0040】上記実施の形態に係る感情生成装置およびその方法は、ニューラルネット8にユーザ情報ユーザ情報I0 〜I5 および機器情報I6 ,I7 の組合せとそれに対する理想的な感情状態O0 〜O3 を有限パタン学習させることにより、あらゆる状況に対して感情状態O0 〜O3 を出力することを可能とし、インタフェースの行動および様相をより擬人化することが可能となる。

【0041】

【発明の効果】以上説明したように、本発明の感情生成装置およびその方法によれば、ニューラルネットを用いて常にユーザの動作をとらえているので、それによって変動するインタフェースの行動およびインタフェースの様相も常に変化するという効果がある。

【0042】また、同じ入力をした場合でも、感情状態の変動に応じてインタフェースの行動および様相に違いが生じ、より自然で生物的な対応を可能にして擬人化を高めることができるという効果がある。

【図面の簡単な説明】

【図1】本発明の第1の実施の形態に係る感情生成装置の構成を示すブロック図である。

【図2】図1中のニューラルネットの入力層,中間層および出力層を示す図である。

【図3】図1中のニューラルネットの学習に必要な学習データを例示する図である。

【図4】図1中のニューラルネットの感情状態によって形成される感情マップの一例を説明する図である。

【図5】図1中の行動決定エンジンの内部構造を示すブロック図である。

【図6】図5中の入力検出・情報加工部の処理を示すフローチャートである。

【図7】図5中の行動決定データベースの内容の一部を例示する図である。

【図8】図5中の行動決定部の処理を示すフローチャートである。

【図9】図1中の様相決定エンジンの概略を示すブロック図である。

【図10】図9中の目データデータベース,鼻データデータベース,口データデータベースおよび色データデータベースのデータ格納形式を例示する図である。

【図11】図9中の目データ導出部,鼻データ導出部,口データ導出部および色データ導出部によるニューラルネットの感情状態から感情値を求める方法を示すフローチャートである。

【図12】図1中の様相決定エンジンにおける様相決定の方法として顔の表情の決定方法の一例を示す図である。

【図13】本発明の第2の実施の形態に係る感情生成装置の構成を示すブロック図である。

【符号の説明】

1 カメラ

2 マイク

3 センサ

4 キーボード

5 マウス

6 内部センサ

7 タイマ

8 ニューラルネット

10 行動決定エンジン

11 様相決定エンジン

51 入力検出・情報加工部

52 行動決定データベース

53 行動決定部

91 目データ導出部

92 目データデータベース

93 鼻データ導出部

94 鼻データデータベース

95 口データ導出部

96 口データデータベース

97 色データ導出部

98 色データデータベース

99 様相データ導出部

O0 〜O3 感情状態

S101 入力タイプ判別ステップ

S102 入力文字列判断ステップ

S103 入力ボタン判断・入力位置判断ステップ

S104 入力文字列判断・音質判断ステップ

S105 画像特徴判断ステップ

S106 脈拍数判断ステップ

S201 加工情報入力ステップ

S202 ニューラルネット感情状態入力ステップ

S203 行動決定データベース検索ステップ

S204 行動出力ステップ

S301 カウンタi=4判定ステップ

S302 感情状態Oi 0.25未満判定ステップ

S303 感情状態Oi 0.25以上0.75未満判定ステップ

S304 感情値Di =0設定ステップ

S305 感情値Di =0.5設定ステップ

S306 感情値Di =1設定ステップ

S307 カウンタi増加ステップ

S0 〜S3 前回の感情状態

T0 〜T3 教師信号

【特許請求の範囲】

【請求項1】 人間と電気機器との間の情報仲介のためのインタフェース装置において、ユーザ情報,機器情報および自身の現在の感情状態を入力して次回の感情状態を出力するニューラルネットと、このニューラルネットの感情状態およびユーザ情報を入力してインタフェースの行動を決定する行動決定エンジンと、前記ニューラルネットの感情状態を入力してインタフェースの様相を決定する様相決定エンジンとを備えることを特徴とする感情生成装置。

【請求項2】 前記ニューラルネットが、カメラから瞬きの回数、マイクから声の大きさおよび発声間隔、センサから脈拍数、キーボードから打鍵の強さ、マウスから使用時間をユーザ情報として入力し、センサから内部温度、タイマから使用時間を機器情報として入力し、感情状態として喜,怒,悲および驚を出力する請求項1記載の感情生成装置。

【請求項3】 前記行動決定エンジンが、加工情報,感情状態および行動の対応テーブルを有する行動決定データベースと、カメラから瞬きの回数、マイクから声の大きさおよび発声間隔、センサから脈拍数、キーボードから打鍵の強さ、マウスから使用時間をユーザ情報として検出して加工情報を出力する入力検出・情報加工部と、この入力検出・情報加工部からの加工情報および前記ニューラルネットからの喜,怒,悲および驚の感情状態を入力して前記行動決定データベースを検索することによりインタフェースの行動を決定する行動決定部とを含む請求項1記載の感情生成装置。

【請求項4】 前記様相決定エンジンが、目データを格納する目データデータベースと、この目データデータベースから前記ニューラルネットの感情状態に対応する目データを導出する目データ導出部と、鼻データを格納する鼻データデータベースと、この鼻データデータベースから前記ニューラルネットの感情状態に対応する鼻データを導出する鼻データ導出部と、口データを格納する口データデータベースと、この口データベースから前記ニューラルネットの感情状態に対応する口データを導出する口データ導出部と、色データを格納する色データデータベースと、この色データデータベースから前記ニューラルネットの感情状態に対応する色データを導出する色データ導出部と、前記目データ導出部,前記鼻データ導出部,前記口データ導出部および前記色データ導出部により導出された目データ,鼻データ,口データおよび色データに基づいてインタフェースの様相を導出する様相データ導出部とからなる請求項1記載の感情生成装置。

【請求項5】 コンピュータを、ユーザ情報,機器情報および自身の現在の感情状態を入力して次回の感情状態を出力するニューラルネット,このニューラルネットの感情状態およびユーザ情報を入力してインタフェースの行動を決定する行動決定エンジン,および前記ニューラルネットの感情状態を入力してインタフェースの様相を決定する様相決定エンジンとして機能させるためのプログラムを記録した機械読み取り可能な記録媒体。

【請求項6】 人間と電気機器との間の情報仲介のための感情生成方法において、ニューラルネットを用いることにより、前記電気機器のインタフェースが生物的要素としての感情を備えていることを特徴とする感情生成方法。

【請求項1】 人間と電気機器との間の情報仲介のためのインタフェース装置において、ユーザ情報,機器情報および自身の現在の感情状態を入力して次回の感情状態を出力するニューラルネットと、このニューラルネットの感情状態およびユーザ情報を入力してインタフェースの行動を決定する行動決定エンジンと、前記ニューラルネットの感情状態を入力してインタフェースの様相を決定する様相決定エンジンとを備えることを特徴とする感情生成装置。

【請求項2】 前記ニューラルネットが、カメラから瞬きの回数、マイクから声の大きさおよび発声間隔、センサから脈拍数、キーボードから打鍵の強さ、マウスから使用時間をユーザ情報として入力し、センサから内部温度、タイマから使用時間を機器情報として入力し、感情状態として喜,怒,悲および驚を出力する請求項1記載の感情生成装置。

【請求項3】 前記行動決定エンジンが、加工情報,感情状態および行動の対応テーブルを有する行動決定データベースと、カメラから瞬きの回数、マイクから声の大きさおよび発声間隔、センサから脈拍数、キーボードから打鍵の強さ、マウスから使用時間をユーザ情報として検出して加工情報を出力する入力検出・情報加工部と、この入力検出・情報加工部からの加工情報および前記ニューラルネットからの喜,怒,悲および驚の感情状態を入力して前記行動決定データベースを検索することによりインタフェースの行動を決定する行動決定部とを含む請求項1記載の感情生成装置。

【請求項4】 前記様相決定エンジンが、目データを格納する目データデータベースと、この目データデータベースから前記ニューラルネットの感情状態に対応する目データを導出する目データ導出部と、鼻データを格納する鼻データデータベースと、この鼻データデータベースから前記ニューラルネットの感情状態に対応する鼻データを導出する鼻データ導出部と、口データを格納する口データデータベースと、この口データベースから前記ニューラルネットの感情状態に対応する口データを導出する口データ導出部と、色データを格納する色データデータベースと、この色データデータベースから前記ニューラルネットの感情状態に対応する色データを導出する色データ導出部と、前記目データ導出部,前記鼻データ導出部,前記口データ導出部および前記色データ導出部により導出された目データ,鼻データ,口データおよび色データに基づいてインタフェースの様相を導出する様相データ導出部とからなる請求項1記載の感情生成装置。

【請求項5】 コンピュータを、ユーザ情報,機器情報および自身の現在の感情状態を入力して次回の感情状態を出力するニューラルネット,このニューラルネットの感情状態およびユーザ情報を入力してインタフェースの行動を決定する行動決定エンジン,および前記ニューラルネットの感情状態を入力してインタフェースの様相を決定する様相決定エンジンとして機能させるためのプログラムを記録した機械読み取り可能な記録媒体。

【請求項6】 人間と電気機器との間の情報仲介のための感情生成方法において、ニューラルネットを用いることにより、前記電気機器のインタフェースが生物的要素としての感情を備えていることを特徴とする感情生成方法。

【図1】

【図2】

【図3】

【図4】

【図10】

【図5】

【図6】

【図7】

【図9】

【図12】

【図8】

【図11】

【図13】

【図2】

【図3】

【図4】

【図10】

【図5】

【図6】

【図7】

【図9】

【図12】

【図8】

【図11】

【図13】

【公開番号】特開平10−254592

【公開日】平成10年(1998)9月25日

【国際特許分類】

【出願番号】特願平9−78918

【出願日】平成9年(1997)3月13日

【出願人】(000004237)日本電気株式会社 (19,353)

【公開日】平成10年(1998)9月25日

【国際特許分類】

【出願日】平成9年(1997)3月13日

【出願人】(000004237)日本電気株式会社 (19,353)

[ Back to top ]