拡張現実感提供装置及び仮想物体の重畳方法

【課題】マーカーを用いることなく、違和感のない拡張現実感を提供することが可能な拡張現実感提供装置を提供する。

【解決手段】地面推定部5は、撮像部1,2で撮像して得られる2つの撮像画像データの各々から顔を検出し、検出した顔の目と口を結ぶ三角形の三次元座標を算出する。地面推定部5は、2つの撮像画像データの一方から前記検出した顔を含む被写体の輪郭を抽出し、この輪郭を前記三角形の三次元座標を用いて三次元空間に逆投影する。地面推定部5は、三次元空間における前記輪郭のデジタルカメラ100の鉛直線の伸びる方向の端部を含みかつ当該方向に垂直な面を地面と推定する。地面推定部5は、表示部11に表示される立体映像において、前記推定した地面上に仮想物体を重畳表示させる。

【解決手段】地面推定部5は、撮像部1,2で撮像して得られる2つの撮像画像データの各々から顔を検出し、検出した顔の目と口を結ぶ三角形の三次元座標を算出する。地面推定部5は、2つの撮像画像データの一方から前記検出した顔を含む被写体の輪郭を抽出し、この輪郭を前記三角形の三次元座標を用いて三次元空間に逆投影する。地面推定部5は、三次元空間における前記輪郭のデジタルカメラ100の鉛直線の伸びる方向の端部を含みかつ当該方向に垂直な面を地面と推定する。地面推定部5は、表示部11に表示される立体映像において、前記推定した地面上に仮想物体を重畳表示させる。

【発明の詳細な説明】

【技術分野】

【0001】

本発明は、拡張現実感を提供する拡張現実感提供装置及び仮想物体の重畳方法に関する。

【背景技術】

【0002】

カメラで撮影した被写界の画像に、仮想物体を重畳表示させる拡張現実技術が普及してきており、この技術を採用した携帯電話機やヘッドマウントディスプレイ(HMD)が登場してきている。

【0003】

例えば、特許文献1には、デジタルカメラで撮像して得られたマーカーを含む画像をモニタ上に表示すると共に、モニタに表示されているカードのマーカー上に、当該マーカーに対応したオブジェクトの三次元画像(仮想物体)を重畳して表示する拡張現実感提供装置が記載されている。

【0004】

特許文献1に記載の装置では、仮想物体を重畳させるべき位置を、マーカーを検出することによって決めている。このため、マーカーを含む画像にしか仮想物体を重畳させることができず、汎用性が低い。

【0005】

特許文献2には、撮影者の視点位置や視線方向等によって被写体の位置関係を特定し、撮像画像上に仮想物体を重畳する技術が記載されている。この技術によれば、マーカーを用いなくとも、撮像画像に仮想物体を重畳させることができる。

【先行技術文献】

【特許文献】

【0006】

【特許文献1】特開2000−322602号公報

【特許文献2】特開2008−78908号公報

【発明の概要】

【発明が解決しようとする課題】

【0007】

しかしながら、特許文献2に記載の技術では、撮影画像における地面の位置までは把握することができないため、仮想物体を地面に対して適当な角度でしか重畳させることができず、ユーザに違和感を与えてしまうことがある。

【0008】

本発明は、上記事情に鑑みてなされたものであり、マーカーを用いることなく、違和感のない拡張現実感を提供することが可能な拡張現実感提供装置及び仮想物体の重畳方法を提供することを目的とする。

【課題を解決するための手段】

【0009】

本発明の拡張現実感提供装置は、使用者に対して拡張現実感を提供する拡張現実感提供装置であって、視差のある2つの撮像画像信号から生成される2つの撮像画像データの一方である第一の撮像画像データに基づく第一の画像、及び、前記2つの撮像画像データの他方である第二の撮像画像データに基づく第二の画像を立体視可能に合成表示する表示部と、前記第一の撮像画像データ及び前記第二の撮像画像データから顔を検出する顔検出処理、前記第一の撮像画像データ及び前記第二の撮像画像データから共通に検出された顔のデータを用いて前記拡張現実感提供装置を原点とする三次元空間における当該顔の座標を算出する顔座標算出処理、前記第一の撮像画像データ又は前記第二の撮像画像データから前記顔を含む被写体の輪郭を抽出する輪郭抽出処理、前記輪郭抽出処理により抽出した輪郭の二次元座標を、前記顔座標算出処理により算出した前記顔の座標に基づいて前記三次元空間における座標に変換する座標変換処理、及び前記三次元空間における前記輪郭の前記拡張現実感提供装置の鉛直線の伸びる方向の端部を含みかつ前記鉛直線に垂直な面を地面と推定する地面推定処理、を行う地面推定部と、前記表示部に表示される立体映像における前記地面推定部によって推定された地面上に、仮想物体を重畳表示させる制御を行う表示制御部とを備えるものである。

【0010】

本発明の仮想物体の重畳方法は、視差のある2つの撮像画像信号から生成される2つの撮像画像データの一方である第一の撮像画像データに基づく第一の画像、及び、前記2つの撮像画像データの他方である第二の撮像画像データに基づく第二の画像を立体視可能に合成表示し、当該立体視可能に表示される立体映像に仮想物体を重畳表示させて拡張現実感を提供する拡張現実感提供装置における仮想物体の重畳方法であって、前記第一の撮像画像データ及び前記第二の撮像画像データから顔を検出する顔検出ステップと、前記第一の撮像画像データ及び前記第二の撮像画像データから共通に検出された顔のデータを用いて前記拡張現実感提供装置を原点とする三次元空間における当該顔の座標を算出する顔座標算出ステップと、前記第一の撮像画像データ及び前記第二の撮像画像データから前記顔を含む被写体の輪郭を抽出する輪郭抽出ステップと、前記輪郭抽出ステップにより抽出した輪郭の二次元座標を、前記顔座標算出ステップにより算出した前記顔の座標に基づいて前記三次元空間における座標に変換する座標変換ステップと、前記三次元空間における前記輪郭の前記拡張現実感提供装置の鉛直線の伸びる方向の端部を含みかつ前記鉛直線に垂直な面を地面と推定する地面推定ステップと、前記立体映像における前記地面推定ステップによって推定された地面上に、仮想物体を重畳表示させる制御を行う表示制御ステップとを備えるものである。

【発明の効果】

【0011】

本発明によれば、マーカーを用いることなく、違和感のない拡張現実感を提供することが可能な拡張現実感提供装置及び仮想物体の重畳方法を提供することができる。

【図面の簡単な説明】

【0012】

【図1】本発明の一実施形態を説明するための拡張現実感提供装置の一例としてのデジタルカメラの外観図

【図2】図1に示されるデジタルカメラ100の内部構成を示すブロック図

【図3】図1に示されるデジタルカメラ100の拡張現実モード時の動作を説明するためのフローチャート

【図4】図1に示されるデジタルカメラ100の拡張現実モード時の動作を説明するための図

【図5】図1に示されるデジタルカメラ100の拡張現実モード時の動作を説明するための図

【図6】図1に示されるデジタルカメラ100の拡張現実モード時の動作を説明するための図

【図7】図1に示されるデジタルカメラ100の拡張現実モード時の動作を説明するための図

【図8】図1に示されるデジタルカメラ100の拡張現実モード時の動作を説明するための図

【図9】図1に示されるデジタルカメラ100の拡張現実モード時の動作を説明するための図

【図10】図1に示されるデジタルカメラ100の拡張現実モード時の撮影状態の例を示す図

【図11】図1に示されるデジタルカメラ100の拡張現実モード時の撮影状態の例を示す図

【図12】図1に示されるデジタルカメラ100の変形例であるデジタルカメラ200の内部構成を示すブロック図

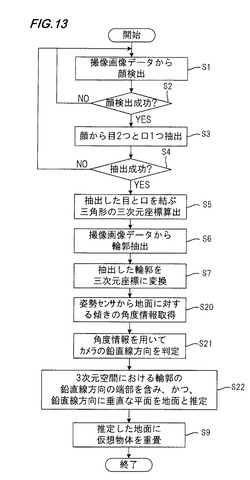

【図13】図12に示されるデジタルカメラ200の拡張現実モード時の動作を説明するためのフローチャート

【発明を実施するための形態】

【0013】

以下、本発明の一実施形態を説明するための拡張現実感提供装置について図面を参照して説明する。この拡張現実感提供装置は、距離をあけて配置された左右2つの撮像部を有し、各撮像部で撮像して得られた右撮像画像データ及び左撮像画像データを表示部において立体視可能に合成表示するものとなっている。また、この拡張現実感提供装置は、表示部に表示される立体映像に、コンピュータグラフィックにより形成された仮想物体を重畳表示させるものである。この拡張現実感提供装置によれば、表示部には、撮影中の被写界像に仮想物体が重畳された映像が表示されるため、この表示部を観察する人に対して拡張現実感を与えることができる。

【0014】

図1は、本発明の一実施形態を説明するための拡張現実感提供装置の一例としてのデジタルカメラの外観図である。図1に示されるデジタルカメラ100は、箱状のハウジングKと、ハウジングKの前面に水平方向(ハウジングKの長手方向)に距離を空けて設けられた右眼用の撮像部1及び左眼用の撮像部2と、ハウジングKの上面に設けられたレリーズボタン16aとを備える。撮像部1は撮影レンズ1Rを備え、撮像部2は撮影レンズ1Lを備える。撮影レンズ1Rの光軸Rと、撮影レンズ1Lの光軸Lとが交差する角度を輻輳角といい、輻輳角が所定値となるように、撮影レンズ1Rと撮影レンズ1Lの位置が設定されている。

【0015】

図2は、図1に示されるデジタルカメラ100の内部構成を示すブロック図である。

【0016】

図2に示されるように、デジタルカメラ100は、撮像部1,2と、画像入力コントローラ3と、画像処理部4と、地面推定部5と、仮想物体データベース(DB)6と、デジタルカメラ100全体を統括制御するCPU(中央演算処理装置)8と、ワークメモリとして使用されるRAM(ランダムアクセスメモリ)9と、表示部11が接続された表示制御部10と、着脱可能な記録媒体13が接続された記録制御部12と、マイク及びスピーカ15が接続された音声制御部14と、CPU8に接続された操作部16(図1のレリーズボタン16aを含む)とを備え、撮像部1,2以外の各部はバス17で相互に接続されている。

【0017】

撮像部1,2は、それぞれ、撮影レンズ及び絞り等の光学系、CCDイメージセンサやCMOSイメージセンサ等の撮像素子、この撮像素子から出力された撮像画像信号にアナログ信号処理を施すアナログ信号処理部、アナログ信号処理部で処理後の信号をデジタル変換するAD変換部、及び撮像素子を駆動する駆動部等を含む。撮像部1と撮像部2は、視差のある2つの撮像画像信号を得るために、水平方向に距離を空けて配置されており、この水平方向が、デジタルカメラ100において視差の得られる方向となる。

【0018】

画像入力コントローラ3は、撮像部1,2の各々から出力された撮像画像信号を取り込み、この撮像画像信号をRAM9に記憶する。

【0019】

画像処理部4は、RAM9に記憶された撮像画像信号に、同時化処理(1画素に3つの色データを持たせる処理)、ホワイトバランス処理、RGB−YC変換処理等の周知のデジタル信号処理を施して、撮像画像データを生成する。ここで生成される撮像画像データのうち、撮像部1から出力された撮像画像信号から生成されたものを右撮像画像データといい、撮像部2から出力された撮像画像信号から生成されたものを左撮像画像データという。右撮像画像データ及び左撮像画像データはRAM9に記憶される。

【0020】

表示制御部10は、画像処理部4にて生成された右撮像画像データに基づく右画像と、画像処理部4にて生成された左撮像画像データに基く左画像とを、表示部11にて立体視可能に合成表示させる。

【0021】

表示部11は、時分割視差画像方式、レンチキュラ方式、及びパララックスバリア方式等に対応した液晶表示装置等で構成され、表示制御部10の制御により、右画像と左画像とを例えば交互に表示させることで立体視可能な映像(立体映像)を表示する。

【0022】

仮想物体DB6は、表示部11に表示される立体映像に重畳すべき仮想物体のデータが予め登録されているものである。仮想物体のデータは、右画像に重畳するべき右画像用仮想データと、左画像に重畳するべき左画像用仮想データとが登録されている。

【0023】

地面推定部5は、デジタルカメラ100の置かれている三次元空間における地面の位置を推定するものである。この三次元空間は、デジタルカメラ100の重心位置を原点とし、この原点を通りかつ筐体Kの長手方向(視差の得られる方向)に伸びる直線をY軸とし、この原点を通りかつ撮像部1,2が設けられる筐体K前面に垂直な方向(撮影方向)に伸びる直線をX軸とし、この原点を通りかつXY平面に垂直な直線(筐体Kの短手方向に伸びる直線)をZ軸とした座標によって定義される空間である。なお、撮像部1,2によって撮像して得られる各撮像画像データは、被写体を上記三次元空間のYZ平面に投影したものに相当し、各撮像画像データの各画素は、各撮像画像データの中心にある画素を原点とする座標(y,z)によってその位置が特定される。

【0024】

表示制御部10は、表示部11に表示中の立体映像における、地面推定部5によって推定された地面に対応する位置に、仮想物体DB6から取得した仮想物体のデータに基づく仮想物体画像を重畳表示させる制御も行う。表示制御部10は、右画像用仮想データに基づく仮想物体画像を右画像に重畳表示させ、左画像用仮想データに基づく仮想物体画像を左画像に重畳表示させることで、立体映像の所定位置に、仮想物体画像を重畳表示させる。

【0025】

デジタルカメラ100は、撮像部1と撮像部2によって撮像を行い、当該撮像によって生成された右撮像画像データと左撮像画像データを立体視可能な形式で対応付けて記録媒体13に記録する3D撮影モードの他に、撮像部1と撮像部2によって人物を含む被写体の撮像を行い、当該撮像によって生成された右撮像画像データに基づく右画像と左撮像画像データに基づく左画像とを立体映像として表示すると共に、当該立体映像に仮想物体画像を重畳させて、ユーザに拡張現実感を提供する拡張現実モードを設定可能であり、以下では、拡張現実モード時のデジタルカメラ100の動作を説明する。

【0026】

図3は、図1に示されるデジタルカメラ100の拡張現実モード時の動作を説明するためのフローチャートである。図4〜図9は、図1に示されるデジタルカメラ100の拡張現実モード時の動作を説明するための図である。以下では、デジタルカメラ100のZ軸方向が地面に対して垂直の状態で撮影がなされることを前提として説明する。

【0027】

デジタルカメラ100が拡張現実モードに設定されると、撮像部1及び撮像部2により動画撮影が開始され、表示部11には、撮影中の被写界像が立体映像として表示される。

【0028】

動画撮影が開始されると、画像処理部4では、右撮像画像データ及び左撮像画像データがフレーム毎に生成され、RAM9に記憶される。RAM9に記憶された右撮像画像データ及び左撮像画像データは、表示制御部10によって表示部11に立体視可能に表示される。地面推定部5は、右撮像画像データ及び左撮像画像データが生成されるたびに、RAM9に記憶された右撮像画像データ及び左撮像画像データの各々に対して顔検出処理を行う(ステップS1)。

【0029】

地面推定部5は、顔検出処理の結果、顔が検出されない場合(ステップS2:NO)は、次フレームの右撮像画像データ及び左撮像画像データに対してステップS1の処理を再び行い、顔が検出された場合(ステップS2:YES)はステップS3の処理を行う。

【0030】

例えば、デジタルカメラ100のユーザが、図4に示されるように、表示部11に表示される撮影中の立体映像に人物が含まれるように画角を決めると、当該人物を含む右撮像画像データ及び左撮像画像データから顔が検出されて、ステップS3の処理が行われる。

【0031】

ステップS3では、地面推定部5が、右撮像画像データ及び左撮像画像データの各々から検出した顔から、目と口を抽出する処理を行う。

【0032】

ステップS3において2つの目と1つの口が抽出されると(ステップS4:YES)、地面推定部5はステップS5の処理を行う。ステップS3において2つの目と1つの口が抽出されない場合(ステップS4:NO)、地面推定部5は次フレームの右撮像画像データ及び左撮像画像データに対してステップS1の処理を行う。

【0033】

ステップS5では、地面推定部5が、図5に示されるように、右撮像画像データ及び左撮像画像データの各々から抽出した2つの目及び1つの口のそれぞれの中心を結ぶ三角形50を求め、右撮像画像データに対して求めた三角形50と、左撮像画像データに対して求めた三角形50との視差、双方の三角形50の撮像画像データ上における位置、デジタルカメラ100の撮像部1,2の設計値(輻輳角、基線長等)等を用いて、三角形50の三次元空間における座標を算出する。

【0034】

地面推定部5は、ステップS5において、図6に示されるように、三次元空間における三角形50の3つの頂点の各々の座標(a1,b1,c1),(a2,b2,c2),(a3,b3,c3)を算出する。

【0035】

次に、地面推定部5は、右撮像画像データ又は左撮像画像データから検出した顔を含む被写体の輪郭を、右撮像画像データ又は左撮像画像データから周知の技術により抽出する(ステップS6)。

【0036】

例えば、地面推定部5は、図7に示されるように、右撮像画像データ70に含まれる人物の輪郭71(矩形領域)を抽出し、輪郭71の4つの頂点の座標データ((y1,z1),(y2,z2),(y3,z3),(y4,z4))を取得する。また、地面推定部5は、ステップS3にて抽出した右撮像画像データ70に含まれる人物の顔に含まれる目と口を結ぶ三角形50の3つの頂点の座標データ((y5,z5),(y6,z6),(y7,z7))を取得する。

【0037】

座標データ((y5,z5),(y6,z6),(y7,z7))を三次元空間の座標に変換したものが、図6に示される三角形50の頂点の座標データ((a1,b1,c1),(a2,b2,c2),(a3,b3,c3))である。地面推定部5は、座標データ((y5,z5),(y6,z6),(y7,z7))から座標データ((a1,b1,c1),(a2,b2,c2),(a3,b3,c3))への座標変換式を求め、座標データ((y1,z1),(y2,z2),(y3,z3),(y4,z4))を、この座標変換式にしたがって三次元空間の座標に変換する(ステップS7)。

【0038】

ステップS7の処理により、図8に示されるように、三次元空間における輪郭71の座標が求まる。

【0039】

次に、地面推定部5は、図8に示される三次元空間上の輪郭71における、Z軸方向下側の端部(図8における輪郭71の下辺)を含み、かつ、Z軸方向に垂直な平面Gを、三次元空間における地面として推定する(ステップS8)。

【0040】

ステップS8において地面が推定されると、表示制御部10は、仮想物体DB6から仮想物体のデータを読み込み、ステップS8にて推定された地面上に仮想物体を配置した立体映像を表示部11にて表示させる(ステップS9)。表示部11に表示される立体映像は、三次元空間を映像として再現したものであるため、三次元空間における地面が推定できれば、立体映像における地面の位置も推定することができる。ステップS9の処理により、表示部11を見ているユーザは、左画像と右画像による立体映像における推定地面上に仮想物体が重畳された立体映像を見ることができる。

【0041】

図9は、表示部11に表示される画面例を示す図であり、撮影中の立体映像に対し、その立体映像中の推定された地面90上に仮想物体画像91が重畳されている画面例を示している。ユーザは、このような画面を見ることで、違和感なく、拡張現実感を味わうことができる。なお、図9では地面90を図示しているが、これは説明のためであり、実際には、表示部11に地面90は表示されない。

【0042】

なお、以上の説明では、図10(a)や図11(a)に示されるように、デジタルカメラ100のZ軸が地面に垂直になるようにして撮影を行うことを前提にしているが、実際には、図10(b)や図11(b)に示されるように、デジタルカメラ100のZ軸が地面と垂直にならない状態で撮影が行われることも有りえる。

【0043】

図10(b)や図11(b)に示される状態で撮影が行われた場合に、地面推定部5が、図3のステップS8において、デジタルカメラ100のZ軸に垂直な平面を地面として推定してしまうと、推定される地面が、実際の地面に対して傾いたものとなってしまい、仮想物体画像を重畳したときにユーザに違和感を生じさせてしまう。このような違和感を生じさせないためのデジタルカメラの構成を以下に説明する。

【0044】

図12は、図1に示されるデジタルカメラ100の変形例であるデジタルカメラ200の内部構成を示すブロック図である。図12に示されるデジタルカメラ200は、姿勢センサ20が追加された点を除いては、図2に示されるブロック図と同じである。

【0045】

姿勢センサ20は、デジタルカメラ200の姿勢を検出するものであり、例えばジャイロセンサによって構成される。姿勢センサ20は、デジタルカメラ200の重心を通るZ軸の地面に対する傾き(図10(b)、図11(b)における角度θ)を検出し、検出した角度の情報を地面推定部5に通知する。以下、デジタルカメラ200の拡張現実モード時の動作について説明する。

【0046】

図13は、図12に示されるデジタルカメラ200の拡張現実モード時の動作を説明するためのフローチャートである。図13において図3に示される処理と同じ処理には同一符号を付して説明を省略する。

【0047】

地面推定部5は、ステップS7までの処理を行った後、姿勢センサ20から、デジタルカメラ200の地面に対する傾きを示す角度情報を取得する(ステップS20)。

【0048】

次に、地面推定部5は、ステップS20において取得した角度情報を用いて、三次元空間におけるデジタルカメラ200の鉛直線の伸びる方向(デジタルカメラ200の重心に錘をつけたときにその錘が垂れる方向)を判定する(ステップS21)。

【0049】

姿勢センサ20から取得した角度情報は、三次元空間におけるZ軸に対する角度の情報であるため、この角度情報を用いることで、三次元空間におけるデジタルカメラ200の鉛直線方向を判定することができる。

【0050】

次に、地面推定部5は、ステップS21にて判定した鉛直線方向に垂直な平面であって、ステップS7にて変換した三次元空間の輪郭のうちの当該鉛直線方向の端部を含む平面を、三次元空間における地面として推定する(ステップS22)。

【0051】

例えば、図10(b),図11(b)に示されるように、三次元空間における輪郭が符号110のように存在していた場合、この輪郭110のデジタルカメラ200の鉛直線方向の端部110Tを含み、かつ、鉛直線方向に垂直な平面Gが地面として推定される。

【0052】

なお、ユーザが、図10(a)及び図11(a)に示されるような状態で撮影を行っていた場合には、デジタルカメラ200の傾きθ=0度となるため、三次元空間におけるZ軸方向下側と、デジタルカメラ200の鉛直線方向とが一致する。このため、この場合には、地面推定部5は、ステップS22において図3のステップS8の処理と同じ処理によって地面を推定することになる。

【0053】

ステップS22の後はステップS9において、表示部11に表示中の立体映像における推定した地面上に仮想物体が重畳表示される。

【0054】

以上のように、デジタルカメラ200によれば、デジタルカメラ200を地面に対して傾けて撮影を行った場合でも、地面を精度良く推定することができるため、違和感のない拡張現実感を提供することが可能になる。

【0055】

なお、ここまでは、撮像画像データから検出される顔の数が1つであることを前提にしてきたが、撮像画像データから顔が複数種類検出された場合(図13のステップS4において、2組以上の顔の目及び口の抽出が成功した場合)には、地面推定部5が、その複数種類の顔の中から1つを選択した後、選択した顔に対し、図13のステップS5〜S9の処理を行えばよい。複数種類の顔の中からどれを選択するかは、ユーザによって指定可能にしておいてもよいし、個人認識を行って予め登録されている顔との一致度が高いものを選択するようにしてもよい。

【0056】

また、撮像画像データから顔が複数種類検出された場合(図13のステップS4において2組以上の顔の目及び口の抽出が成功した場合)には、地面推定部5が、その複数種類の顔の中から2つを選択した後、選択した2つの顔の各々に対し、図13のステップS5〜S22の処理を行い、選択した2つの顔の各々に対して求められた2つの地面の座標を用いて、この2つの地面と最も相関性の高い地面を最終的な地面(表示制御部10が仮想物体を重畳させる地面)として推定することで、地面の推定精度を上げることができる。

【0057】

なお、デジタルカメラ100,200は、撮像部1,2の2つの撮像部により視差のある2つの撮像画像信号を得ているが、視差のある2つの撮像画像信号を得ることができれば、撮像部は2つなくてもよい。

【0058】

例えば、単一の光学系と2つの撮像素子によって視差のある2つの撮像画像信号を出力する撮像部を用いてもよい。または、単一の光学系と単一の撮像素子によって視差のある2つの撮像画像信号を出力可能な撮像部を用いてもよい。単一の光学系と単一の撮像素子によって視差のある2つの撮像画像信号を出力可能な撮像部では、撮像素子として、位相差を検出可能な画素ペア(例えば、遮光膜開口が互いに逆方向に偏心された2つの画素)を二次元状に配置したものを用いることで、視差のある2つの撮像画像信号を出力可能である。また、撮影範囲を連続的に変えながら複数回の撮像を行って視差のある2つの撮像画像信号を取得するような方式の撮像部を用いてもよい。

【0059】

また、以上の説明では、拡張現実感提供装置が、視差のある2つの撮像画像信号を出力可能な撮像部を有するものとしたが、拡張現実感提供装置に撮像部は搭載されていなくてもよい。例えば、拡張現実感提供装置内の記憶部(記録媒体13)に、別の撮像部によって撮像して得られた視差のある2つの撮像画像信号(静止画、動画)や、インターネット等からダウンロードした視差のある2つの撮像画像信号(静止画、動画)を予め記憶しておき、拡張現実感提供装置の地面推定部が、記録媒体13から上記2つの撮像画像信号を取得し、取得した2つの撮像画像信号に対し、図3や図13に示される処理を行うようにしてもよい。

【0060】

以上のように、本明細書には以下の事項が開示されている。

【0061】

開示された拡張現実感提供装置は、使用者に対して拡張現実感を提供する拡張現実感提供装置であって、視差のある2つの撮像画像信号から生成される2つの撮像画像データの一方である第一の撮像画像データに基づく第一の画像、及び、前記2つの撮像画像データの他方である第二の撮像画像データに基づく第二の画像を立体視可能に合成表示する表示部と、前記第一の撮像画像データ及び前記第二の撮像画像データから顔を検出する顔検出処理、前記第一の撮像画像データ及び前記第二の撮像画像データから共通に検出された顔のデータを用いて前記拡張現実感提供装置を原点とする三次元空間における当該顔の座標を算出する顔座標算出処理、前記第一の撮像画像データ又は前記第二の撮像画像データから前記顔を含む被写体の輪郭を抽出する輪郭抽出処理、前記輪郭抽出処理により抽出した輪郭の二次元座標を、前記顔座標算出処理により算出した前記顔の座標に基づいて前記三次元空間における座標に変換する座標変換処理、及び前記三次元空間における前記輪郭の前記拡張現実感提供装置の鉛直線の伸びる方向の端部を含みかつ前記鉛直線に垂直な面を地面と推定する地面推定処理、を行う地面推定部と、前記表示部に表示される立体映像における前記地面推定部によって推定された地面上に、仮想物体を重畳表示させる制御を行う表示制御部とを備えるものである。

【0062】

開示された拡張現実感提供装置は、前記拡張現実感提供装置の姿勢を検出する姿勢検出部を備え、前記地面推定部は、前記姿勢検出部によって検出された前記拡張現実感提供装置の傾きの情報により、前記鉛直線の伸びる方向を判定するものである。

【0063】

開示された拡張現実感提供装置は、前記顔検出処理によって検出された顔が複数種類ある場合、前記地面推定部は、当該複数種類の顔の中から1つを選択し、選択した顔を含む被写体に対して、前記顔座標算出処理、前記輪郭抽出処理、前記座標変換処理、及び前記地面推定処理を行って前記地面を推定するものである。

【0064】

開示された拡張現実感提供装置は、前記顔検出処理によって検出された顔が複数種類ある場合、前記地面推定部は、当該複数種類の顔の中から2つを選択し、選択した2つの顔の各々を含む異なる種類の被写体に対して、前記顔座標算出処理、前記輪郭抽出処理、前記座標変換処理、及び前記地面推定処理を行って2種類の被写体毎に前記地面を推定し、前記2種類の被写体毎に求めた2つの地面と最も相関性の高い平面を、前記仮想物体を重畳させる最終的な地面として推定し、前記表示制御部は、前記地面推定部によって推定された前記最終的な地面上に前記仮想物体を重畳させるものである。

【0065】

開示された拡張現実感提供装置は、前記視差のある2つの撮像画像信号を出力可能な撮像部を備えるものである。

【0066】

開示された仮想物体の重畳方法は、視差のある2つの撮像画像信号から生成される2つの撮像画像データの一方である第一の撮像画像データに基づく第一の画像、及び、前記2つの撮像画像データの他方である第二の撮像画像データに基づく第二の画像を立体視可能に合成表示し、当該立体視可能に表示される立体映像に仮想物体を重畳表示させて拡張現実感を提供する拡張現実感提供装置における仮想物体の重畳方法であって、前記第一の撮像画像データ及び前記第二の撮像画像データから顔を検出する顔検出ステップと、前記第一の撮像画像データ及び前記第二の撮像画像データから共通に検出された顔のデータを用いて前記拡張現実感提供装置を原点とする三次元空間における当該顔の座標を算出する顔座標算出ステップと、前記第一の撮像画像データ及び前記第二の撮像画像データから前記顔を含む被写体の輪郭を抽出する輪郭抽出ステップと、前記輪郭抽出ステップにより抽出した輪郭の二次元座標を、前記顔座標算出ステップにより算出した前記顔の座標に基づいて前記三次元空間における座標に変換する座標変換ステップと、前記三次元空間における前記輪郭の前記拡張現実感提供装置の鉛直線の伸びる方向の端部を含みかつ前記鉛直線に垂直な面を地面と推定する地面推定ステップと、前記立体映像における前記地面推定ステップによって推定された地面上に、仮想物体を重畳表示させる制御を行う表示制御ステップとを備えるものである。

【0067】

開示された仮想物体の重畳方法は、前記拡張現実感提供装置の姿勢を検出する姿勢検出ステップを備え、前記地面推定ステップでは、前記姿勢検出ステップによって検出された前記拡張現実感提供装置の傾きの情報により、前記鉛直線の伸びる方向を判定するものである。

【0068】

開示された仮想物体の重畳方法は、前記顔検出ステップによって検出された顔が複数種類ある場合、当該複数種類の顔の中から1つを選択し、選択した顔を含む被写体に対して、前記顔座標算出ステップ、前記輪郭抽出ステップ、前記座標変換ステップ、及び前記地面推定ステップを行って前記地面を推定するものである。

【0069】

開示された仮想物体の重畳方法は、前記顔検出ステップによって検出された顔が複数種類ある場合、当該複数種類の顔の中から2つを選択し、選択した2つの顔の各々を含む異なる種類の被写体に対して、前記顔座標算出ステップ、前記輪郭抽出ステップ、前記座標変換ステップ、及び前記地面推定ステップを行って2種類の被写体毎に前記地面を推定し、前記2種類の被写体毎に求めた2つの地面と最も相関性の高い平面を、前記仮想物体を重畳させる最終的な地面として推定し、当該最終的な地面上に前記仮想物体を重畳させるものである。

【符号の説明】

【0070】

1,2 撮像部

5 地面推定部

200 デジタルカメラ

【技術分野】

【0001】

本発明は、拡張現実感を提供する拡張現実感提供装置及び仮想物体の重畳方法に関する。

【背景技術】

【0002】

カメラで撮影した被写界の画像に、仮想物体を重畳表示させる拡張現実技術が普及してきており、この技術を採用した携帯電話機やヘッドマウントディスプレイ(HMD)が登場してきている。

【0003】

例えば、特許文献1には、デジタルカメラで撮像して得られたマーカーを含む画像をモニタ上に表示すると共に、モニタに表示されているカードのマーカー上に、当該マーカーに対応したオブジェクトの三次元画像(仮想物体)を重畳して表示する拡張現実感提供装置が記載されている。

【0004】

特許文献1に記載の装置では、仮想物体を重畳させるべき位置を、マーカーを検出することによって決めている。このため、マーカーを含む画像にしか仮想物体を重畳させることができず、汎用性が低い。

【0005】

特許文献2には、撮影者の視点位置や視線方向等によって被写体の位置関係を特定し、撮像画像上に仮想物体を重畳する技術が記載されている。この技術によれば、マーカーを用いなくとも、撮像画像に仮想物体を重畳させることができる。

【先行技術文献】

【特許文献】

【0006】

【特許文献1】特開2000−322602号公報

【特許文献2】特開2008−78908号公報

【発明の概要】

【発明が解決しようとする課題】

【0007】

しかしながら、特許文献2に記載の技術では、撮影画像における地面の位置までは把握することができないため、仮想物体を地面に対して適当な角度でしか重畳させることができず、ユーザに違和感を与えてしまうことがある。

【0008】

本発明は、上記事情に鑑みてなされたものであり、マーカーを用いることなく、違和感のない拡張現実感を提供することが可能な拡張現実感提供装置及び仮想物体の重畳方法を提供することを目的とする。

【課題を解決するための手段】

【0009】

本発明の拡張現実感提供装置は、使用者に対して拡張現実感を提供する拡張現実感提供装置であって、視差のある2つの撮像画像信号から生成される2つの撮像画像データの一方である第一の撮像画像データに基づく第一の画像、及び、前記2つの撮像画像データの他方である第二の撮像画像データに基づく第二の画像を立体視可能に合成表示する表示部と、前記第一の撮像画像データ及び前記第二の撮像画像データから顔を検出する顔検出処理、前記第一の撮像画像データ及び前記第二の撮像画像データから共通に検出された顔のデータを用いて前記拡張現実感提供装置を原点とする三次元空間における当該顔の座標を算出する顔座標算出処理、前記第一の撮像画像データ又は前記第二の撮像画像データから前記顔を含む被写体の輪郭を抽出する輪郭抽出処理、前記輪郭抽出処理により抽出した輪郭の二次元座標を、前記顔座標算出処理により算出した前記顔の座標に基づいて前記三次元空間における座標に変換する座標変換処理、及び前記三次元空間における前記輪郭の前記拡張現実感提供装置の鉛直線の伸びる方向の端部を含みかつ前記鉛直線に垂直な面を地面と推定する地面推定処理、を行う地面推定部と、前記表示部に表示される立体映像における前記地面推定部によって推定された地面上に、仮想物体を重畳表示させる制御を行う表示制御部とを備えるものである。

【0010】

本発明の仮想物体の重畳方法は、視差のある2つの撮像画像信号から生成される2つの撮像画像データの一方である第一の撮像画像データに基づく第一の画像、及び、前記2つの撮像画像データの他方である第二の撮像画像データに基づく第二の画像を立体視可能に合成表示し、当該立体視可能に表示される立体映像に仮想物体を重畳表示させて拡張現実感を提供する拡張現実感提供装置における仮想物体の重畳方法であって、前記第一の撮像画像データ及び前記第二の撮像画像データから顔を検出する顔検出ステップと、前記第一の撮像画像データ及び前記第二の撮像画像データから共通に検出された顔のデータを用いて前記拡張現実感提供装置を原点とする三次元空間における当該顔の座標を算出する顔座標算出ステップと、前記第一の撮像画像データ及び前記第二の撮像画像データから前記顔を含む被写体の輪郭を抽出する輪郭抽出ステップと、前記輪郭抽出ステップにより抽出した輪郭の二次元座標を、前記顔座標算出ステップにより算出した前記顔の座標に基づいて前記三次元空間における座標に変換する座標変換ステップと、前記三次元空間における前記輪郭の前記拡張現実感提供装置の鉛直線の伸びる方向の端部を含みかつ前記鉛直線に垂直な面を地面と推定する地面推定ステップと、前記立体映像における前記地面推定ステップによって推定された地面上に、仮想物体を重畳表示させる制御を行う表示制御ステップとを備えるものである。

【発明の効果】

【0011】

本発明によれば、マーカーを用いることなく、違和感のない拡張現実感を提供することが可能な拡張現実感提供装置及び仮想物体の重畳方法を提供することができる。

【図面の簡単な説明】

【0012】

【図1】本発明の一実施形態を説明するための拡張現実感提供装置の一例としてのデジタルカメラの外観図

【図2】図1に示されるデジタルカメラ100の内部構成を示すブロック図

【図3】図1に示されるデジタルカメラ100の拡張現実モード時の動作を説明するためのフローチャート

【図4】図1に示されるデジタルカメラ100の拡張現実モード時の動作を説明するための図

【図5】図1に示されるデジタルカメラ100の拡張現実モード時の動作を説明するための図

【図6】図1に示されるデジタルカメラ100の拡張現実モード時の動作を説明するための図

【図7】図1に示されるデジタルカメラ100の拡張現実モード時の動作を説明するための図

【図8】図1に示されるデジタルカメラ100の拡張現実モード時の動作を説明するための図

【図9】図1に示されるデジタルカメラ100の拡張現実モード時の動作を説明するための図

【図10】図1に示されるデジタルカメラ100の拡張現実モード時の撮影状態の例を示す図

【図11】図1に示されるデジタルカメラ100の拡張現実モード時の撮影状態の例を示す図

【図12】図1に示されるデジタルカメラ100の変形例であるデジタルカメラ200の内部構成を示すブロック図

【図13】図12に示されるデジタルカメラ200の拡張現実モード時の動作を説明するためのフローチャート

【発明を実施するための形態】

【0013】

以下、本発明の一実施形態を説明するための拡張現実感提供装置について図面を参照して説明する。この拡張現実感提供装置は、距離をあけて配置された左右2つの撮像部を有し、各撮像部で撮像して得られた右撮像画像データ及び左撮像画像データを表示部において立体視可能に合成表示するものとなっている。また、この拡張現実感提供装置は、表示部に表示される立体映像に、コンピュータグラフィックにより形成された仮想物体を重畳表示させるものである。この拡張現実感提供装置によれば、表示部には、撮影中の被写界像に仮想物体が重畳された映像が表示されるため、この表示部を観察する人に対して拡張現実感を与えることができる。

【0014】

図1は、本発明の一実施形態を説明するための拡張現実感提供装置の一例としてのデジタルカメラの外観図である。図1に示されるデジタルカメラ100は、箱状のハウジングKと、ハウジングKの前面に水平方向(ハウジングKの長手方向)に距離を空けて設けられた右眼用の撮像部1及び左眼用の撮像部2と、ハウジングKの上面に設けられたレリーズボタン16aとを備える。撮像部1は撮影レンズ1Rを備え、撮像部2は撮影レンズ1Lを備える。撮影レンズ1Rの光軸Rと、撮影レンズ1Lの光軸Lとが交差する角度を輻輳角といい、輻輳角が所定値となるように、撮影レンズ1Rと撮影レンズ1Lの位置が設定されている。

【0015】

図2は、図1に示されるデジタルカメラ100の内部構成を示すブロック図である。

【0016】

図2に示されるように、デジタルカメラ100は、撮像部1,2と、画像入力コントローラ3と、画像処理部4と、地面推定部5と、仮想物体データベース(DB)6と、デジタルカメラ100全体を統括制御するCPU(中央演算処理装置)8と、ワークメモリとして使用されるRAM(ランダムアクセスメモリ)9と、表示部11が接続された表示制御部10と、着脱可能な記録媒体13が接続された記録制御部12と、マイク及びスピーカ15が接続された音声制御部14と、CPU8に接続された操作部16(図1のレリーズボタン16aを含む)とを備え、撮像部1,2以外の各部はバス17で相互に接続されている。

【0017】

撮像部1,2は、それぞれ、撮影レンズ及び絞り等の光学系、CCDイメージセンサやCMOSイメージセンサ等の撮像素子、この撮像素子から出力された撮像画像信号にアナログ信号処理を施すアナログ信号処理部、アナログ信号処理部で処理後の信号をデジタル変換するAD変換部、及び撮像素子を駆動する駆動部等を含む。撮像部1と撮像部2は、視差のある2つの撮像画像信号を得るために、水平方向に距離を空けて配置されており、この水平方向が、デジタルカメラ100において視差の得られる方向となる。

【0018】

画像入力コントローラ3は、撮像部1,2の各々から出力された撮像画像信号を取り込み、この撮像画像信号をRAM9に記憶する。

【0019】

画像処理部4は、RAM9に記憶された撮像画像信号に、同時化処理(1画素に3つの色データを持たせる処理)、ホワイトバランス処理、RGB−YC変換処理等の周知のデジタル信号処理を施して、撮像画像データを生成する。ここで生成される撮像画像データのうち、撮像部1から出力された撮像画像信号から生成されたものを右撮像画像データといい、撮像部2から出力された撮像画像信号から生成されたものを左撮像画像データという。右撮像画像データ及び左撮像画像データはRAM9に記憶される。

【0020】

表示制御部10は、画像処理部4にて生成された右撮像画像データに基づく右画像と、画像処理部4にて生成された左撮像画像データに基く左画像とを、表示部11にて立体視可能に合成表示させる。

【0021】

表示部11は、時分割視差画像方式、レンチキュラ方式、及びパララックスバリア方式等に対応した液晶表示装置等で構成され、表示制御部10の制御により、右画像と左画像とを例えば交互に表示させることで立体視可能な映像(立体映像)を表示する。

【0022】

仮想物体DB6は、表示部11に表示される立体映像に重畳すべき仮想物体のデータが予め登録されているものである。仮想物体のデータは、右画像に重畳するべき右画像用仮想データと、左画像に重畳するべき左画像用仮想データとが登録されている。

【0023】

地面推定部5は、デジタルカメラ100の置かれている三次元空間における地面の位置を推定するものである。この三次元空間は、デジタルカメラ100の重心位置を原点とし、この原点を通りかつ筐体Kの長手方向(視差の得られる方向)に伸びる直線をY軸とし、この原点を通りかつ撮像部1,2が設けられる筐体K前面に垂直な方向(撮影方向)に伸びる直線をX軸とし、この原点を通りかつXY平面に垂直な直線(筐体Kの短手方向に伸びる直線)をZ軸とした座標によって定義される空間である。なお、撮像部1,2によって撮像して得られる各撮像画像データは、被写体を上記三次元空間のYZ平面に投影したものに相当し、各撮像画像データの各画素は、各撮像画像データの中心にある画素を原点とする座標(y,z)によってその位置が特定される。

【0024】

表示制御部10は、表示部11に表示中の立体映像における、地面推定部5によって推定された地面に対応する位置に、仮想物体DB6から取得した仮想物体のデータに基づく仮想物体画像を重畳表示させる制御も行う。表示制御部10は、右画像用仮想データに基づく仮想物体画像を右画像に重畳表示させ、左画像用仮想データに基づく仮想物体画像を左画像に重畳表示させることで、立体映像の所定位置に、仮想物体画像を重畳表示させる。

【0025】

デジタルカメラ100は、撮像部1と撮像部2によって撮像を行い、当該撮像によって生成された右撮像画像データと左撮像画像データを立体視可能な形式で対応付けて記録媒体13に記録する3D撮影モードの他に、撮像部1と撮像部2によって人物を含む被写体の撮像を行い、当該撮像によって生成された右撮像画像データに基づく右画像と左撮像画像データに基づく左画像とを立体映像として表示すると共に、当該立体映像に仮想物体画像を重畳させて、ユーザに拡張現実感を提供する拡張現実モードを設定可能であり、以下では、拡張現実モード時のデジタルカメラ100の動作を説明する。

【0026】

図3は、図1に示されるデジタルカメラ100の拡張現実モード時の動作を説明するためのフローチャートである。図4〜図9は、図1に示されるデジタルカメラ100の拡張現実モード時の動作を説明するための図である。以下では、デジタルカメラ100のZ軸方向が地面に対して垂直の状態で撮影がなされることを前提として説明する。

【0027】

デジタルカメラ100が拡張現実モードに設定されると、撮像部1及び撮像部2により動画撮影が開始され、表示部11には、撮影中の被写界像が立体映像として表示される。

【0028】

動画撮影が開始されると、画像処理部4では、右撮像画像データ及び左撮像画像データがフレーム毎に生成され、RAM9に記憶される。RAM9に記憶された右撮像画像データ及び左撮像画像データは、表示制御部10によって表示部11に立体視可能に表示される。地面推定部5は、右撮像画像データ及び左撮像画像データが生成されるたびに、RAM9に記憶された右撮像画像データ及び左撮像画像データの各々に対して顔検出処理を行う(ステップS1)。

【0029】

地面推定部5は、顔検出処理の結果、顔が検出されない場合(ステップS2:NO)は、次フレームの右撮像画像データ及び左撮像画像データに対してステップS1の処理を再び行い、顔が検出された場合(ステップS2:YES)はステップS3の処理を行う。

【0030】

例えば、デジタルカメラ100のユーザが、図4に示されるように、表示部11に表示される撮影中の立体映像に人物が含まれるように画角を決めると、当該人物を含む右撮像画像データ及び左撮像画像データから顔が検出されて、ステップS3の処理が行われる。

【0031】

ステップS3では、地面推定部5が、右撮像画像データ及び左撮像画像データの各々から検出した顔から、目と口を抽出する処理を行う。

【0032】

ステップS3において2つの目と1つの口が抽出されると(ステップS4:YES)、地面推定部5はステップS5の処理を行う。ステップS3において2つの目と1つの口が抽出されない場合(ステップS4:NO)、地面推定部5は次フレームの右撮像画像データ及び左撮像画像データに対してステップS1の処理を行う。

【0033】

ステップS5では、地面推定部5が、図5に示されるように、右撮像画像データ及び左撮像画像データの各々から抽出した2つの目及び1つの口のそれぞれの中心を結ぶ三角形50を求め、右撮像画像データに対して求めた三角形50と、左撮像画像データに対して求めた三角形50との視差、双方の三角形50の撮像画像データ上における位置、デジタルカメラ100の撮像部1,2の設計値(輻輳角、基線長等)等を用いて、三角形50の三次元空間における座標を算出する。

【0034】

地面推定部5は、ステップS5において、図6に示されるように、三次元空間における三角形50の3つの頂点の各々の座標(a1,b1,c1),(a2,b2,c2),(a3,b3,c3)を算出する。

【0035】

次に、地面推定部5は、右撮像画像データ又は左撮像画像データから検出した顔を含む被写体の輪郭を、右撮像画像データ又は左撮像画像データから周知の技術により抽出する(ステップS6)。

【0036】

例えば、地面推定部5は、図7に示されるように、右撮像画像データ70に含まれる人物の輪郭71(矩形領域)を抽出し、輪郭71の4つの頂点の座標データ((y1,z1),(y2,z2),(y3,z3),(y4,z4))を取得する。また、地面推定部5は、ステップS3にて抽出した右撮像画像データ70に含まれる人物の顔に含まれる目と口を結ぶ三角形50の3つの頂点の座標データ((y5,z5),(y6,z6),(y7,z7))を取得する。

【0037】

座標データ((y5,z5),(y6,z6),(y7,z7))を三次元空間の座標に変換したものが、図6に示される三角形50の頂点の座標データ((a1,b1,c1),(a2,b2,c2),(a3,b3,c3))である。地面推定部5は、座標データ((y5,z5),(y6,z6),(y7,z7))から座標データ((a1,b1,c1),(a2,b2,c2),(a3,b3,c3))への座標変換式を求め、座標データ((y1,z1),(y2,z2),(y3,z3),(y4,z4))を、この座標変換式にしたがって三次元空間の座標に変換する(ステップS7)。

【0038】

ステップS7の処理により、図8に示されるように、三次元空間における輪郭71の座標が求まる。

【0039】

次に、地面推定部5は、図8に示される三次元空間上の輪郭71における、Z軸方向下側の端部(図8における輪郭71の下辺)を含み、かつ、Z軸方向に垂直な平面Gを、三次元空間における地面として推定する(ステップS8)。

【0040】

ステップS8において地面が推定されると、表示制御部10は、仮想物体DB6から仮想物体のデータを読み込み、ステップS8にて推定された地面上に仮想物体を配置した立体映像を表示部11にて表示させる(ステップS9)。表示部11に表示される立体映像は、三次元空間を映像として再現したものであるため、三次元空間における地面が推定できれば、立体映像における地面の位置も推定することができる。ステップS9の処理により、表示部11を見ているユーザは、左画像と右画像による立体映像における推定地面上に仮想物体が重畳された立体映像を見ることができる。

【0041】

図9は、表示部11に表示される画面例を示す図であり、撮影中の立体映像に対し、その立体映像中の推定された地面90上に仮想物体画像91が重畳されている画面例を示している。ユーザは、このような画面を見ることで、違和感なく、拡張現実感を味わうことができる。なお、図9では地面90を図示しているが、これは説明のためであり、実際には、表示部11に地面90は表示されない。

【0042】

なお、以上の説明では、図10(a)や図11(a)に示されるように、デジタルカメラ100のZ軸が地面に垂直になるようにして撮影を行うことを前提にしているが、実際には、図10(b)や図11(b)に示されるように、デジタルカメラ100のZ軸が地面と垂直にならない状態で撮影が行われることも有りえる。

【0043】

図10(b)や図11(b)に示される状態で撮影が行われた場合に、地面推定部5が、図3のステップS8において、デジタルカメラ100のZ軸に垂直な平面を地面として推定してしまうと、推定される地面が、実際の地面に対して傾いたものとなってしまい、仮想物体画像を重畳したときにユーザに違和感を生じさせてしまう。このような違和感を生じさせないためのデジタルカメラの構成を以下に説明する。

【0044】

図12は、図1に示されるデジタルカメラ100の変形例であるデジタルカメラ200の内部構成を示すブロック図である。図12に示されるデジタルカメラ200は、姿勢センサ20が追加された点を除いては、図2に示されるブロック図と同じである。

【0045】

姿勢センサ20は、デジタルカメラ200の姿勢を検出するものであり、例えばジャイロセンサによって構成される。姿勢センサ20は、デジタルカメラ200の重心を通るZ軸の地面に対する傾き(図10(b)、図11(b)における角度θ)を検出し、検出した角度の情報を地面推定部5に通知する。以下、デジタルカメラ200の拡張現実モード時の動作について説明する。

【0046】

図13は、図12に示されるデジタルカメラ200の拡張現実モード時の動作を説明するためのフローチャートである。図13において図3に示される処理と同じ処理には同一符号を付して説明を省略する。

【0047】

地面推定部5は、ステップS7までの処理を行った後、姿勢センサ20から、デジタルカメラ200の地面に対する傾きを示す角度情報を取得する(ステップS20)。

【0048】

次に、地面推定部5は、ステップS20において取得した角度情報を用いて、三次元空間におけるデジタルカメラ200の鉛直線の伸びる方向(デジタルカメラ200の重心に錘をつけたときにその錘が垂れる方向)を判定する(ステップS21)。

【0049】

姿勢センサ20から取得した角度情報は、三次元空間におけるZ軸に対する角度の情報であるため、この角度情報を用いることで、三次元空間におけるデジタルカメラ200の鉛直線方向を判定することができる。

【0050】

次に、地面推定部5は、ステップS21にて判定した鉛直線方向に垂直な平面であって、ステップS7にて変換した三次元空間の輪郭のうちの当該鉛直線方向の端部を含む平面を、三次元空間における地面として推定する(ステップS22)。

【0051】

例えば、図10(b),図11(b)に示されるように、三次元空間における輪郭が符号110のように存在していた場合、この輪郭110のデジタルカメラ200の鉛直線方向の端部110Tを含み、かつ、鉛直線方向に垂直な平面Gが地面として推定される。

【0052】

なお、ユーザが、図10(a)及び図11(a)に示されるような状態で撮影を行っていた場合には、デジタルカメラ200の傾きθ=0度となるため、三次元空間におけるZ軸方向下側と、デジタルカメラ200の鉛直線方向とが一致する。このため、この場合には、地面推定部5は、ステップS22において図3のステップS8の処理と同じ処理によって地面を推定することになる。

【0053】

ステップS22の後はステップS9において、表示部11に表示中の立体映像における推定した地面上に仮想物体が重畳表示される。

【0054】

以上のように、デジタルカメラ200によれば、デジタルカメラ200を地面に対して傾けて撮影を行った場合でも、地面を精度良く推定することができるため、違和感のない拡張現実感を提供することが可能になる。

【0055】

なお、ここまでは、撮像画像データから検出される顔の数が1つであることを前提にしてきたが、撮像画像データから顔が複数種類検出された場合(図13のステップS4において、2組以上の顔の目及び口の抽出が成功した場合)には、地面推定部5が、その複数種類の顔の中から1つを選択した後、選択した顔に対し、図13のステップS5〜S9の処理を行えばよい。複数種類の顔の中からどれを選択するかは、ユーザによって指定可能にしておいてもよいし、個人認識を行って予め登録されている顔との一致度が高いものを選択するようにしてもよい。

【0056】

また、撮像画像データから顔が複数種類検出された場合(図13のステップS4において2組以上の顔の目及び口の抽出が成功した場合)には、地面推定部5が、その複数種類の顔の中から2つを選択した後、選択した2つの顔の各々に対し、図13のステップS5〜S22の処理を行い、選択した2つの顔の各々に対して求められた2つの地面の座標を用いて、この2つの地面と最も相関性の高い地面を最終的な地面(表示制御部10が仮想物体を重畳させる地面)として推定することで、地面の推定精度を上げることができる。

【0057】

なお、デジタルカメラ100,200は、撮像部1,2の2つの撮像部により視差のある2つの撮像画像信号を得ているが、視差のある2つの撮像画像信号を得ることができれば、撮像部は2つなくてもよい。

【0058】

例えば、単一の光学系と2つの撮像素子によって視差のある2つの撮像画像信号を出力する撮像部を用いてもよい。または、単一の光学系と単一の撮像素子によって視差のある2つの撮像画像信号を出力可能な撮像部を用いてもよい。単一の光学系と単一の撮像素子によって視差のある2つの撮像画像信号を出力可能な撮像部では、撮像素子として、位相差を検出可能な画素ペア(例えば、遮光膜開口が互いに逆方向に偏心された2つの画素)を二次元状に配置したものを用いることで、視差のある2つの撮像画像信号を出力可能である。また、撮影範囲を連続的に変えながら複数回の撮像を行って視差のある2つの撮像画像信号を取得するような方式の撮像部を用いてもよい。

【0059】

また、以上の説明では、拡張現実感提供装置が、視差のある2つの撮像画像信号を出力可能な撮像部を有するものとしたが、拡張現実感提供装置に撮像部は搭載されていなくてもよい。例えば、拡張現実感提供装置内の記憶部(記録媒体13)に、別の撮像部によって撮像して得られた視差のある2つの撮像画像信号(静止画、動画)や、インターネット等からダウンロードした視差のある2つの撮像画像信号(静止画、動画)を予め記憶しておき、拡張現実感提供装置の地面推定部が、記録媒体13から上記2つの撮像画像信号を取得し、取得した2つの撮像画像信号に対し、図3や図13に示される処理を行うようにしてもよい。

【0060】

以上のように、本明細書には以下の事項が開示されている。

【0061】

開示された拡張現実感提供装置は、使用者に対して拡張現実感を提供する拡張現実感提供装置であって、視差のある2つの撮像画像信号から生成される2つの撮像画像データの一方である第一の撮像画像データに基づく第一の画像、及び、前記2つの撮像画像データの他方である第二の撮像画像データに基づく第二の画像を立体視可能に合成表示する表示部と、前記第一の撮像画像データ及び前記第二の撮像画像データから顔を検出する顔検出処理、前記第一の撮像画像データ及び前記第二の撮像画像データから共通に検出された顔のデータを用いて前記拡張現実感提供装置を原点とする三次元空間における当該顔の座標を算出する顔座標算出処理、前記第一の撮像画像データ又は前記第二の撮像画像データから前記顔を含む被写体の輪郭を抽出する輪郭抽出処理、前記輪郭抽出処理により抽出した輪郭の二次元座標を、前記顔座標算出処理により算出した前記顔の座標に基づいて前記三次元空間における座標に変換する座標変換処理、及び前記三次元空間における前記輪郭の前記拡張現実感提供装置の鉛直線の伸びる方向の端部を含みかつ前記鉛直線に垂直な面を地面と推定する地面推定処理、を行う地面推定部と、前記表示部に表示される立体映像における前記地面推定部によって推定された地面上に、仮想物体を重畳表示させる制御を行う表示制御部とを備えるものである。

【0062】

開示された拡張現実感提供装置は、前記拡張現実感提供装置の姿勢を検出する姿勢検出部を備え、前記地面推定部は、前記姿勢検出部によって検出された前記拡張現実感提供装置の傾きの情報により、前記鉛直線の伸びる方向を判定するものである。

【0063】

開示された拡張現実感提供装置は、前記顔検出処理によって検出された顔が複数種類ある場合、前記地面推定部は、当該複数種類の顔の中から1つを選択し、選択した顔を含む被写体に対して、前記顔座標算出処理、前記輪郭抽出処理、前記座標変換処理、及び前記地面推定処理を行って前記地面を推定するものである。

【0064】

開示された拡張現実感提供装置は、前記顔検出処理によって検出された顔が複数種類ある場合、前記地面推定部は、当該複数種類の顔の中から2つを選択し、選択した2つの顔の各々を含む異なる種類の被写体に対して、前記顔座標算出処理、前記輪郭抽出処理、前記座標変換処理、及び前記地面推定処理を行って2種類の被写体毎に前記地面を推定し、前記2種類の被写体毎に求めた2つの地面と最も相関性の高い平面を、前記仮想物体を重畳させる最終的な地面として推定し、前記表示制御部は、前記地面推定部によって推定された前記最終的な地面上に前記仮想物体を重畳させるものである。

【0065】

開示された拡張現実感提供装置は、前記視差のある2つの撮像画像信号を出力可能な撮像部を備えるものである。

【0066】

開示された仮想物体の重畳方法は、視差のある2つの撮像画像信号から生成される2つの撮像画像データの一方である第一の撮像画像データに基づく第一の画像、及び、前記2つの撮像画像データの他方である第二の撮像画像データに基づく第二の画像を立体視可能に合成表示し、当該立体視可能に表示される立体映像に仮想物体を重畳表示させて拡張現実感を提供する拡張現実感提供装置における仮想物体の重畳方法であって、前記第一の撮像画像データ及び前記第二の撮像画像データから顔を検出する顔検出ステップと、前記第一の撮像画像データ及び前記第二の撮像画像データから共通に検出された顔のデータを用いて前記拡張現実感提供装置を原点とする三次元空間における当該顔の座標を算出する顔座標算出ステップと、前記第一の撮像画像データ及び前記第二の撮像画像データから前記顔を含む被写体の輪郭を抽出する輪郭抽出ステップと、前記輪郭抽出ステップにより抽出した輪郭の二次元座標を、前記顔座標算出ステップにより算出した前記顔の座標に基づいて前記三次元空間における座標に変換する座標変換ステップと、前記三次元空間における前記輪郭の前記拡張現実感提供装置の鉛直線の伸びる方向の端部を含みかつ前記鉛直線に垂直な面を地面と推定する地面推定ステップと、前記立体映像における前記地面推定ステップによって推定された地面上に、仮想物体を重畳表示させる制御を行う表示制御ステップとを備えるものである。

【0067】

開示された仮想物体の重畳方法は、前記拡張現実感提供装置の姿勢を検出する姿勢検出ステップを備え、前記地面推定ステップでは、前記姿勢検出ステップによって検出された前記拡張現実感提供装置の傾きの情報により、前記鉛直線の伸びる方向を判定するものである。

【0068】

開示された仮想物体の重畳方法は、前記顔検出ステップによって検出された顔が複数種類ある場合、当該複数種類の顔の中から1つを選択し、選択した顔を含む被写体に対して、前記顔座標算出ステップ、前記輪郭抽出ステップ、前記座標変換ステップ、及び前記地面推定ステップを行って前記地面を推定するものである。

【0069】

開示された仮想物体の重畳方法は、前記顔検出ステップによって検出された顔が複数種類ある場合、当該複数種類の顔の中から2つを選択し、選択した2つの顔の各々を含む異なる種類の被写体に対して、前記顔座標算出ステップ、前記輪郭抽出ステップ、前記座標変換ステップ、及び前記地面推定ステップを行って2種類の被写体毎に前記地面を推定し、前記2種類の被写体毎に求めた2つの地面と最も相関性の高い平面を、前記仮想物体を重畳させる最終的な地面として推定し、当該最終的な地面上に前記仮想物体を重畳させるものである。

【符号の説明】

【0070】

1,2 撮像部

5 地面推定部

200 デジタルカメラ

【特許請求の範囲】

【請求項1】

使用者に対して拡張現実感を提供する拡張現実感提供装置であって、

視差のある2つの撮像画像信号から生成される2つの撮像画像データの一方である第一の撮像画像データに基づく第一の画像、及び、前記2つの撮像画像データの他方である第二の撮像画像データに基づく第二の画像を立体視可能に合成表示する表示部と、

前記第一の撮像画像データ及び前記第二の撮像画像データから顔を検出する顔検出処理、前記第一の撮像画像データ及び前記第二の撮像画像データから共通に検出された顔のデータを用いて前記拡張現実感提供装置を原点とする三次元空間における当該顔の座標を算出する顔座標算出処理、前記第一の撮像画像データ又は前記第二の撮像画像データから前記顔を含む被写体の輪郭を抽出する輪郭抽出処理、前記輪郭抽出処理により抽出した輪郭の二次元座標を、前記顔座標算出処理により算出した前記顔の座標に基づいて前記三次元空間における座標に変換する座標変換処理、及び前記三次元空間における前記輪郭の前記拡張現実感提供装置の鉛直線の伸びる方向の端部を含みかつ前記鉛直線に垂直な面を地面と推定する地面推定処理、を行う地面推定部と、

前記表示部に表示される立体映像における前記地面推定部によって推定された地面上に、仮想物体を重畳表示させる制御を行う表示制御部とを備える拡張現実感提供装置。

【請求項2】

請求項1記載の拡張現実感提供装置であって、

前記拡張現実感提供装置の姿勢を検出する姿勢検出部を備え、

前記地面推定部は、前記姿勢検出部によって検出された前記拡張現実感提供装置の傾きの情報により、前記鉛直線の伸びる方向を判定する拡張現実感提供装置。

【請求項3】

請求項1又は2記載の拡張現実感提供装置であって、

前記顔検出処理によって検出された顔が複数種類ある場合、前記地面推定部は、当該複数種類の顔の中から1つを選択し、選択した顔を含む被写体に対して、前記顔座標算出処理、前記輪郭抽出処理、前記座標変換処理、及び前記地面推定処理を行って前記地面を推定する拡張現実感提供装置。

【請求項4】

請求項1又は2記載の拡張現実感提供装置であって、

前記顔検出処理によって検出された顔が複数種類ある場合、前記地面推定部は、当該複数種類の顔の中から2つを選択し、選択した2つの顔の各々を含む異なる種類の被写体に対して、前記顔座標算出処理、前記輪郭抽出処理、前記座標変換処理、及び前記地面推定処理を行って2種類の被写体毎に前記地面を推定し、前記2種類の被写体毎に求めた2つの地面と最も相関性の高い平面を、前記仮想物体を重畳させる最終的な地面として推定し、

前記表示制御部は、前記地面推定部によって推定された前記最終的な地面上に前記仮想物体を重畳させる拡張現実感提供装置。

【請求項5】

請求項1〜4のいずれか1項記載の拡張現実感提供装置であって、

前記視差のある2つの撮像画像信号を出力可能な撮像部を備える拡張現実感提供装置。

【請求項6】

視差のある2つの撮像画像信号から生成される2つの撮像画像データの一方である第一の撮像画像データに基づく第一の画像、及び、前記2つの撮像画像データの他方である第二の撮像画像データに基づく第二の画像を立体視可能に合成表示し、当該立体視可能に表示される立体映像に仮想物体を重畳表示させて拡張現実感を提供する拡張現実感提供装置における仮想物体の重畳方法であって、

前記第一の撮像画像データ及び前記第二の撮像画像データから顔を検出する顔検出ステップと、

前記第一の撮像画像データ及び前記第二の撮像画像データから共通に検出された顔のデータを用いて前記拡張現実感提供装置を原点とする三次元空間における当該顔の座標を算出する顔座標算出ステップと、

前記第一の撮像画像データ及び前記第二の撮像画像データから前記顔を含む被写体の輪郭を抽出する輪郭抽出ステップと、

前記輪郭抽出ステップにより抽出した輪郭の二次元座標を、前記顔座標算出ステップにより算出した前記顔の座標に基づいて前記三次元空間における座標に変換する座標変換ステップと、

前記三次元空間における前記輪郭の前記拡張現実感提供装置の鉛直線の伸びる方向の端部を含みかつ前記鉛直線に垂直な面を地面と推定する地面推定ステップと、

前記立体映像における前記地面推定ステップによって推定された地面上に、仮想物体を重畳表示させる制御を行う表示制御ステップとを備える仮想物体の重畳方法。

【請求項7】

請求項6記載の仮想物体の重畳方法であって、

前記拡張現実感提供装置の姿勢を検出する姿勢検出ステップを備え、

前記地面推定ステップでは、前記姿勢検出ステップによって検出された前記拡張現実感提供装置の傾きの情報により、前記鉛直線の伸びる方向を判定する仮想物体の重畳方法。

【請求項8】

請求項6又は7記載の仮想物体の重畳方法であって、

前記顔検出ステップによって検出された顔が複数種類ある場合、当該複数種類の顔の中から1つを選択し、選択した顔を含む被写体に対して、前記顔座標算出ステップ、前記輪郭抽出ステップ、前記座標変換ステップ、及び前記地面推定ステップを行って前記地面を推定する仮想物体の重畳方法。

【請求項9】

請求項6又は7記載の仮想物体の重畳方法であって、

前記顔検出ステップによって検出された顔が複数種類ある場合、当該複数種類の顔の中から2つを選択し、選択した2つの顔の各々を含む異なる種類の被写体に対して、前記顔座標算出ステップ、前記輪郭抽出ステップ、前記座標変換ステップ、及び前記地面推定ステップを行って2種類の被写体毎に前記地面を推定し、前記2種類の被写体毎に求めた2つの地面と最も相関性の高い平面を、前記仮想物体を重畳させる最終的な地面として推定し、当該最終的な地面上に前記仮想物体を重畳させる仮想物体の重畳方法。

【請求項1】

使用者に対して拡張現実感を提供する拡張現実感提供装置であって、

視差のある2つの撮像画像信号から生成される2つの撮像画像データの一方である第一の撮像画像データに基づく第一の画像、及び、前記2つの撮像画像データの他方である第二の撮像画像データに基づく第二の画像を立体視可能に合成表示する表示部と、

前記第一の撮像画像データ及び前記第二の撮像画像データから顔を検出する顔検出処理、前記第一の撮像画像データ及び前記第二の撮像画像データから共通に検出された顔のデータを用いて前記拡張現実感提供装置を原点とする三次元空間における当該顔の座標を算出する顔座標算出処理、前記第一の撮像画像データ又は前記第二の撮像画像データから前記顔を含む被写体の輪郭を抽出する輪郭抽出処理、前記輪郭抽出処理により抽出した輪郭の二次元座標を、前記顔座標算出処理により算出した前記顔の座標に基づいて前記三次元空間における座標に変換する座標変換処理、及び前記三次元空間における前記輪郭の前記拡張現実感提供装置の鉛直線の伸びる方向の端部を含みかつ前記鉛直線に垂直な面を地面と推定する地面推定処理、を行う地面推定部と、

前記表示部に表示される立体映像における前記地面推定部によって推定された地面上に、仮想物体を重畳表示させる制御を行う表示制御部とを備える拡張現実感提供装置。

【請求項2】

請求項1記載の拡張現実感提供装置であって、

前記拡張現実感提供装置の姿勢を検出する姿勢検出部を備え、

前記地面推定部は、前記姿勢検出部によって検出された前記拡張現実感提供装置の傾きの情報により、前記鉛直線の伸びる方向を判定する拡張現実感提供装置。

【請求項3】

請求項1又は2記載の拡張現実感提供装置であって、

前記顔検出処理によって検出された顔が複数種類ある場合、前記地面推定部は、当該複数種類の顔の中から1つを選択し、選択した顔を含む被写体に対して、前記顔座標算出処理、前記輪郭抽出処理、前記座標変換処理、及び前記地面推定処理を行って前記地面を推定する拡張現実感提供装置。

【請求項4】

請求項1又は2記載の拡張現実感提供装置であって、

前記顔検出処理によって検出された顔が複数種類ある場合、前記地面推定部は、当該複数種類の顔の中から2つを選択し、選択した2つの顔の各々を含む異なる種類の被写体に対して、前記顔座標算出処理、前記輪郭抽出処理、前記座標変換処理、及び前記地面推定処理を行って2種類の被写体毎に前記地面を推定し、前記2種類の被写体毎に求めた2つの地面と最も相関性の高い平面を、前記仮想物体を重畳させる最終的な地面として推定し、

前記表示制御部は、前記地面推定部によって推定された前記最終的な地面上に前記仮想物体を重畳させる拡張現実感提供装置。

【請求項5】

請求項1〜4のいずれか1項記載の拡張現実感提供装置であって、

前記視差のある2つの撮像画像信号を出力可能な撮像部を備える拡張現実感提供装置。

【請求項6】

視差のある2つの撮像画像信号から生成される2つの撮像画像データの一方である第一の撮像画像データに基づく第一の画像、及び、前記2つの撮像画像データの他方である第二の撮像画像データに基づく第二の画像を立体視可能に合成表示し、当該立体視可能に表示される立体映像に仮想物体を重畳表示させて拡張現実感を提供する拡張現実感提供装置における仮想物体の重畳方法であって、

前記第一の撮像画像データ及び前記第二の撮像画像データから顔を検出する顔検出ステップと、

前記第一の撮像画像データ及び前記第二の撮像画像データから共通に検出された顔のデータを用いて前記拡張現実感提供装置を原点とする三次元空間における当該顔の座標を算出する顔座標算出ステップと、

前記第一の撮像画像データ及び前記第二の撮像画像データから前記顔を含む被写体の輪郭を抽出する輪郭抽出ステップと、

前記輪郭抽出ステップにより抽出した輪郭の二次元座標を、前記顔座標算出ステップにより算出した前記顔の座標に基づいて前記三次元空間における座標に変換する座標変換ステップと、

前記三次元空間における前記輪郭の前記拡張現実感提供装置の鉛直線の伸びる方向の端部を含みかつ前記鉛直線に垂直な面を地面と推定する地面推定ステップと、

前記立体映像における前記地面推定ステップによって推定された地面上に、仮想物体を重畳表示させる制御を行う表示制御ステップとを備える仮想物体の重畳方法。

【請求項7】

請求項6記載の仮想物体の重畳方法であって、

前記拡張現実感提供装置の姿勢を検出する姿勢検出ステップを備え、

前記地面推定ステップでは、前記姿勢検出ステップによって検出された前記拡張現実感提供装置の傾きの情報により、前記鉛直線の伸びる方向を判定する仮想物体の重畳方法。

【請求項8】

請求項6又は7記載の仮想物体の重畳方法であって、

前記顔検出ステップによって検出された顔が複数種類ある場合、当該複数種類の顔の中から1つを選択し、選択した顔を含む被写体に対して、前記顔座標算出ステップ、前記輪郭抽出ステップ、前記座標変換ステップ、及び前記地面推定ステップを行って前記地面を推定する仮想物体の重畳方法。

【請求項9】

請求項6又は7記載の仮想物体の重畳方法であって、

前記顔検出ステップによって検出された顔が複数種類ある場合、当該複数種類の顔の中から2つを選択し、選択した2つの顔の各々を含む異なる種類の被写体に対して、前記顔座標算出ステップ、前記輪郭抽出ステップ、前記座標変換ステップ、及び前記地面推定ステップを行って2種類の被写体毎に前記地面を推定し、前記2種類の被写体毎に求めた2つの地面と最も相関性の高い平面を、前記仮想物体を重畳させる最終的な地面として推定し、当該最終的な地面上に前記仮想物体を重畳させる仮想物体の重畳方法。

【図1】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図13】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図13】

【公開番号】特開2012−216077(P2012−216077A)

【公開日】平成24年11月8日(2012.11.8)

【国際特許分類】

【出願番号】特願2011−80897(P2011−80897)

【出願日】平成23年3月31日(2011.3.31)

【出願人】(306037311)富士フイルム株式会社 (25,513)

【Fターム(参考)】

【公開日】平成24年11月8日(2012.11.8)

【国際特許分類】

【出願日】平成23年3月31日(2011.3.31)

【出願人】(306037311)富士フイルム株式会社 (25,513)

【Fターム(参考)】

[ Back to top ]