画像処理方法、画像処理装置及びコンピュータプログラム

【課題】画像間の対応付けが困難な場合であっても、奥行き推定誤差を抑制し、高品質な仮想視点画像を合成すること。

【解決手段】複数の異なる視点から被写体を撮影した多視点画像に基づいて、任意の仮想視点位置から見た被写体の画像を合成する画像処理方法である。多視点画像に対して各画素の奥行きに対する尤度を算出し、尤度に基づいて個々の画素の奥行きを推定し、高精度推定画素の奥行き推定結果を用いて、画像特徴から奥行きに対する尤度を推定するための推定関数を算出し、補正対象画素に対して推定関数を用いて尤度の補正を行い、補正後の尤度を用いて画像全体の奥行きを再推定し、再推定した奥行きと、多視点画像とに基づいて、仮想視点位置に応じた被写体の画像を合成する。

【解決手段】複数の異なる視点から被写体を撮影した多視点画像に基づいて、任意の仮想視点位置から見た被写体の画像を合成する画像処理方法である。多視点画像に対して各画素の奥行きに対する尤度を算出し、尤度に基づいて個々の画素の奥行きを推定し、高精度推定画素の奥行き推定結果を用いて、画像特徴から奥行きに対する尤度を推定するための推定関数を算出し、補正対象画素に対して推定関数を用いて尤度の補正を行い、補正後の尤度を用いて画像全体の奥行きを再推定し、再推定した奥行きと、多視点画像とに基づいて、仮想視点位置に応じた被写体の画像を合成する。

【発明の詳細な説明】

【技術分野】

【0001】

本発明は、被写体にテクスチャが少ない領域やオクルージョンがあり、ステレオマッチング法で対応付けが難しい場合に有効な技術に関する。

【背景技術】

【0002】

複数のカメラから撮影された多視点画像を用いて、仮想の視点位置から見た画像を合成することを仮想視点画像合成という。図10は、多視点画像を用いて任意の視点位置の画像を合成する従来技術の処理の流れを示す図である。以下、多視点画像を用いて任意の視点位置の画像を合成するため従来技術の処理の流れについて説明する。まず、多視点画像及びカメラパラメータが入力される(ステップSa1)。次に、二次元の画像群から三次元情報(奥行き)を推定する(ステップSa2)。そして、多視点画像と、カメラパラメータと、奥行きとに基づいて、仮想視点画像を合成する(ステップSa3)。このとき、奥行きの推定精度が低いと、仮想視点の合成画像の品質が劣化してしまう。

【0003】

奥行きを推定する手法にステレオマッチング法がある。ステレオマッチング法では、多視点画像間の画素の対応づけとカメラの内部パラメータと外部パラメータとが用いられる。そして、三角測量の原理により、注目画素の実空間での位置が計算により求められる。図11は、ステレオマッチング法による処理の概略を示す図である。例えば、図11に示すように、地点P1及び地点P2から注目地点Aを見ると仮定する。この場合、地点P1及びP2を結んだ直線の距離と、注目地点Aと地点P1と地点P2とを頂点とした三角形の各頂点の角度とが得られれば、地点P1(もしくは地点P2)から注目地点Aへの距離を求めることができる。

【0004】

しかしながら、模様(テクスチャ)が少ない領域や、周期的なテクスチャが存在する領域や、オクルージョンの影響を受けた領域がある場合には、その領域内の画素の対応付けは困難である。図12は、従来技術における問題点を示す図である。例えば、図12に示すように、鳥のような被写体Cが横切るなど、オクルージョンが生じた場合を考えると、地点P1からは注目地点Aが見えないので対応付けができない。

【0005】

このとき、ステレオマッチング法では、地点P2から見える注目地点Aについて、地点P1から似たような形状として見える地点Bと誤って対応付けされやすい。そのため、奥行き推定が間違った地点Aのような画素の影響により、合成された画像に不自然な像(アーティファクト)が生じる。これが仮想視点画像合成の品質に繋がる重要な課題である。

【0006】

従来の仮想視点画像合成手法では、このような対応付けが困難な画素について、画像をセグメンテーションすることにより対応するアプローチがあった。

【0007】

例えば、画素の色(R、G、B)情報を基にして画像を細かくセグメンテーションし、同じセグメント内の画素は、同一の被写体、つまり同一平面(曲面)上に存在すると仮定していた。この仮定により、注目画素の奥行きが所属するセグメントの平面の奥行きとなるように、奥行きを補正する手法(例えば非特許文献1参照)がある。

【0008】

他にも奥行きを補正する手法として、画像の色情報から前景と背景を分離する手法がある。これは、被写体が前景と背景との2種類という前提のもと、ステレオマッチング法により対応付けが困難な画素について、その画素と類似した色を持つ被写体(前景か背景)を検出し、その被写体の奥行き情報を用いて、その画素の奥行きの尤度を補正する手法(例えば非特許文献2、3参照)がある。

【先行技術文献】

【非特許文献】

【0009】

【非特許文献1】A. Klaus, M. Sormann, K. Karner: Segment-Based Stereo Matching Using Belief Propagation and a Self-Adapting Dissimilarity Measure, in Proc. of ICPR, pp. 15-18 (2006)

【非特許文献2】V. Kolmogorov, A. Criminisi, A. Blake, G. Cross, C. Rother : Bi-layer segmentation of binocular stereo video, In Proc. of CVPR, vol. 2, pp. 407-414 (2005)

【非特許文献3】石井,高橋,苗村:自由視点画像のための合成とセグメンテーションの連結手法,3次元画像コンファレンス,5-1, pp.49-52 (2009)

【発明の概要】

【発明が解決しようとする課題】

【0010】

上述の仮想視点画像合成の研究では、ある画素の奥行き情報を補正するときに、その画素と同一のセグメント内の画素の奥行き情報を用いて補正を行っていた。この手法では、カメラを密に置ける環境で、対応付けの誤りが狭い領域で起こるような場合には有効である。しかしながら、注目画素周辺の広範囲において対応付けが誤っている場合、つまり同一セグメント内の大部分の画素の対応付けが誤っている場合には、セグメント内の大部分の画素の奥行き推定精度が低くなってしまう。そのため、そのセグメントの奥行き推定結果を用いても、注目画素の奥行きを正しく補正することは難しいという問題があった。

【0011】

また、前景の被写体と背景の被写体とを分離する手法では、各被写体の色特徴を利用することは有効ではある。しかし、仮想視点画像合成の場合には、奥行きは多値であり、前景の奥行きと背景の奥行きとの2値で近似することが難しいという問題がある。

【0012】

本発明は、このような事情を考慮してなされたものであり、テクスチャが少ない領域や、オクルージョンの影響により画像間の対応付けが困難な場合であっても、奥行き推定誤差を抑制し、高品質な仮想視点画像を合成することができる技術を提供することにある。

【課題を解決するための手段】

【0013】

本発明の一態様は、複数の異なる視点から被写体を撮影した多視点画像に基づいて、任意の仮想視点位置から見た前記被写体の画像を合成する画像処理方法であって、ステレオマッチング法により、前記多視点画像に対して、各画素の奥行きに対する尤度を算出する第1のステップと、前記第1のステップで求めた尤度に基づいて、個々の画素の奥行きを推定する第2のステップと、奥行きの推定精度が高いと推定されるための条件を満たす高精度推定画素の奥行き推定結果を用いて、画像特徴から奥行きに対する尤度を推定するための推定関数を算出する第3のステップと、奥行きの推定精度が低いと推定されるための条件を満たす補正対象画素に対して、前記第3のステップで算出された推定関数を用いて、尤度の補正を行う第4のステップと、前記第4のステップで行われた補正後の尤度を用いて、画像全体の奥行きを再推定する第5のステップと、前記第5のステップで再推定した奥行きと、前記多視点画像とに基づいて、前記仮想視点位置に応じた前記被写体の画像を合成する第6のステップとを有する。

【0014】

本発明の一態様は、複数の異なる視点から被写体を撮影した多視点画像に基づいて、任意の仮想視点位置から見た前記被写体の画像を合成する画像処理装置であって、ステレオマッチング法により、前記多視点画像に対して、各画素の奥行きに対する尤度を算出する尤度算出部と、前記尤度算出部で求めた尤度に基づいて、個々の画素の奥行きを推定する奥行き推定部と、奥行きの推定精度が高いと推定されるための条件を満たす高精度推定画素の奥行き推定結果を用いて、画像特徴から奥行きに対する尤度を推定するための推定関数を算出する尤度推定関数算出部と、奥行きの推定精度が低いと推定されるための条件を満たす補正対象画素に対して、前記尤度推定関数算出部で算出された推定関数を用いて、尤度の補正を行う尤度補正部と、前記尤度補正部で行われた補正後の尤度を用いて、画像全体の奥行きを再推定する奥行き再推定部と、前記奥行き再推定部により再推定された奥行きと、前記多視点画像とに基づいて、前記仮想視点位置に応じた前記被写体の画像を合成する画像合成部とを備える。

【0015】

本発明の一態様は、複数の異なる視点から被写体を撮影した多視点画像に基づいて、任意の仮想視点位置から見た前記被写体の画像を合成する画像処理装置のコンピュータに、ステレオマッチング法により、前記多視点画像に対して、各画素の奥行きに対する尤度を算出する尤度算出ステップと、前記尤度算出ステップで求めた尤度に基づいて、個々の画素の奥行きを推定する奥行き推定ステップと、奥行きの推定精度が高いと推定されるための条件を満たす高精度推定画素の奥行き推定結果を用いて、画像特徴から奥行きに対する尤度を推定するための推定関数を算出する尤度推定関数算出ステップと、奥行きの推定精度が低いと推定されるための条件を満たす補正対象画素に対して、前記尤度推定関数算出ステップで算出された推定関数を用いて、尤度の補正を行う尤度補正ステップと、前記尤度補正ステップで行われた補正後の尤度を用いて、画像全体の奥行きを再推定する奥行き再推定ステップと、前記奥行き再推定ステップで再推定された奥行きと、多視点画像とに基づいて、前記仮想視点位置に応じた前記被写体の画像を合成する画像合成ステップと、を実行させるためのコンピュータプログラムである。

【発明の効果】

【0016】

本発明により、テクスチャが少ない領域や、オクルージョンの影響により画像間の対応付けが困難な場合であっても、奥行き推定誤差を抑制し、高品質な仮想視点画像を合成することが可能となる。

【図面の簡単な説明】

【0017】

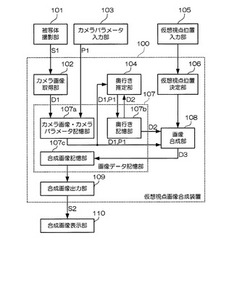

【図1】仮想視点画像合成システムの構成を示すブロック図である。

【図2】本実施形態による仮想視点画像合成方法を説明するためのフローチャートである。

【図3】本実施形態による仮想視点画像合成方法で用いるカメラの配置例を示す概念図である。

【図4】本実施形態による奥行きに対する尤度の計算方法を説明するための概念図である。

【図5】複数の画像間のエピポーラ線(EL1、EL2)を説明するための概念図である。

【図6】画像特徴から奥行きに対する尤度推定関数Fの算出方法を説明するための概念図である。

【図7】画像特徴から奥行きに対する尤度推定関数Fの算出方法を説明するための概念図である。

【図8】仮想視点位置の画像合成を説明するための概念図である。

【図9】3Dワーピング法について説明するための概念図である。

【図10】多視点画像を用いて任意の視点位置の画像を合成する従来技術の処理の流れを示す図である。

【図11】ステレオマッチング法による処理の概略を示す図である。

【図12】従来技術における問題点を示す図である。

【発明を実施するための形態】

【0018】

<概略>

まず、本発明の実施形態である仮想視点画像合成システム(以下、単に「仮想視点画像合成システム」という。)の概略について説明する。

仮想視点画像合成システムは、卓球や、テニスなどのスポーツの鑑賞や、大学等の授業を撮影した遠隔教育の教材向けに、視聴者があたかも撮影した環境にいると思えるような臨場感のある画像を高品質に合成する。そのため、本仮想視点画像合成システムによれば、光線空間法や、視体積交差法のようにカメラを密に配置する撮影環境や、被写体を全方位から撮影できるような撮影環境ではなくても、高品質な仮想視点画像の合成を実現する。すなわち、仮想視点画像合成システムは、実際の競技場や、イベント会場などにおける撮影を対象として、卓球やテニス等のスポーツシーン、またライブコンサートのようなイベントシーンにおいても、高品質な仮想視点画像の合成を実現する。

【0019】

上述したような合成を実現するため、仮想視点画像合成システムは、対応付けが困難な領域の画素、もしくはセグメントされた領域について、その画素や、セグメントされた領域の奥行きの尤度を画像の特徴から補正する関数を算出する。そして、その関数の結果により補正を行う。画像特徴とは、色情報、テクスチャ情報、又は動き情報を意味する。

【0020】

具体的には以下の通りである。まず、仮想視点画像合成システムは、事前に検出した対応付け精度が高い画素(以下では高精度推定画素と呼ぶ)を用いて、奥行き値毎に画像特徴を抽出する。次に、仮想視点画像合成システムは、奥行き値毎に求めた画像特徴と、対応付けが困難な領域の画素(以下、補正対象画素と呼ぶ)との特徴とを比較する。そして、仮想視点画像合成システムは、最も類似した画像特徴を持つ奥行き値を用いて、対応付けが困難な画素の奥行きを補正する。対応付けが困難な画素と対応付けが困難な小領域(セグメントされた小領域)とは、スケール(空間的な大きさ)が違うだけで本質的な違いはない。以下の説明では、対応付けが困難な画素の補正方法についてのみ説明をする。

【0021】

<詳細>

次に、仮想視点画像合成システムの詳細について説明する。

図1は、仮想視点画像合成システムの構成を示すブロック図である。被写体撮影部101は、複数台のカメラで構成される多視点画像取得システムである。被写体撮影部101は、撮影した映像信号S1をカメラ画像取得部102に供給する。カメラパラメータ入力部103は、キャリブレーションしたカメラパラメータP1を入力する装置である。仮想視点位置入力部105は、ユーザーが希望する視点位置を入力する装置である。カメラパラメータ入力部103と仮想視点位置入力部105は、例えば、キーボードや、マウス、タッチ入力装置などのユーザーインタフェースや、DVD(Digital Versatile Disc)や、USB(Universal Serial Bus)メモリ等の外部記憶装置である。

【0022】

仮想視点画像合成装置100は、カメラ画像取得部102、奥行き推定部104、仮想視点位置決定部106、画像データ記憶部107、画像合成部108、及び合成画像出力部109を備える。カメラ画像取得部102は、被写体撮影部101からの映像信号S1を取得し、画像データD1として画像データ記憶部107に供給する。仮想視点位置決定部106は、仮想視点位置入力部105により与えられた、仮想視点位置のカメラパラメータを決定し、画像合成部108に供給する。

【0023】

画像データ記憶部107は、磁気ハードディスク装置や半導体記憶装置などの記憶装置を用いて構成される。画像データ記憶部107は、カメラ画像・カメラパラメータ記憶部107a、奥行き記憶部107b、及び合成画像記憶部107cを備える。各記憶部は、同一の記憶装置上に構成されても良いし、それぞれ異なる記憶装置上に構成されても良い。カメラ画像・カメラパラメータ記憶部107aは、カメラ画像取得部102からの画像データD1を記憶する。奥行き記憶部107bは、後述する奥行き推定部104から出力される推定された奥行きデータD2を記憶する。合成画像記憶部107cは、後述する画像合成部108から出力される画像データD3を記憶する。被写体撮影部101のカメラによる被写体撮影で予め撮影したシーンの画像とキャリブレーションで求めたカメラパラメータP1と奥行き推定部104の出力結果D2とを、それぞれカメラ画像・カメラパラメータ記憶部107aと奥行き記憶部107bとに記憶しておき、ユーザーが希望する仮想視点位置の入力に応じて画像合成を独立して実行することが可能となる。

【0024】

奥行き推定部104は、カメラ画像・カメラパラメータ記憶部107aからカメラパラメータP1と画像データD1とを取り出し、奥行き推定結果D2を出力して奥行き記憶部107bに供給する。

画像合成部108は、カメラ画像・カメラパラメータ記憶部107aからカメラパラメータP1と画像データD1を取り出し、奥行き記憶部107bから奥行き推定結果D2を取り出して、合成画像(仮想視点から見た画像)データD3を出力する。

【0025】

合成画像出力部109は、合成画像記憶部107cに記憶された合成画像データD3を、出力用画像データとして読み出し、ディスプレイ表示用の映像信号S2として合成画像表示部110に出力する。合成画像表示部110は、例えば、ディスプレイ端子等の合成画像出力部109に接続されたCRT(Cathode Ray Tube)、LCD(Liquid Crystal Display)、PDP(Plasma Display Panel)等の表示装置である。合成画像表示部110は、合成画像出力部109からの映像信号S2に従って合成画像を表示する。なお、合成画像表示部110は、例えば、二次元平面状の装置でもよいし、装置利用者を取り囲むような曲面状の表示装置であってもよい。

【0026】

(画像合成方法の説明)

次に、本実施形態の仮想視点画像合成装置100による仮想視点画像合成方法について説明する。図2は、本実施形態による仮想視点画像合成方法を説明するためのフローチャートである。仮想視点画像合成において、カメラの配置は、本来自由でよい。しかし、本実施形態では、複数台のカメラで共通視野を確保しやすくするために、格子状、もしくは一直線上にカメラを配置する。図3は、本実施形態による仮想視点画像合成方法で用いるカメラの配置例を示す概念図である。図3に示すように、カメラCn−2、Cn−1、Cn、Cn+1、…の向きは、並行、もしくは特定の被写体を注視点Mとするように放射線状に配置されており、全てのカメラCn−2、Cn−1、Cn、Cn+1、…は同期している。

【0027】

[多視点画像とカメラパラメータの入力]

まず、カメラパラメータ入力部103で、前処理として各カメラのカメラパラメータをキャリブレーションにより求める(ステップS1)。カメラ番号をn(=1,2,3,…,N)、カメラの内部パラメータをAn、外部パラメータをRn、Tn、カメラCnの画像の画素の位置をmnとすると、カメラCnの画像上の位置mn=[xn,yn]とカメラCnの座標系の位置Mc=[Xc,Yc,Zc]、世界座標系の位置M=[X,Y,Z]の関係は次式(1)、(2)で求まる。

【0028】

【数1】

【0029】

【数2】

【0030】

数式(1)と数式(2)より、

【0031】

【数3】

【0032】

となる。但し、snは奥行き方向のスケールを決める正の定数、右上添え字のTは転置行列を意味し、チルダ(〜)mnとチルダ(〜)Mとは拡張ベクトルであり、チルダ(〜)mn=[xn,yn,1]T,チルダ(〜)M=[X,Y,Z,1]Tである。

画像の奥行きが分かれば、数式(1)により定数snが決定されカメラCnの座標系での位置Mcが分かる。そして、数式(2)により世界座標系での位置Mを求めることができる。

また、カメラCnの画素mnの奥行きがZ=dのとき、カメラCn−1の画像上の画素mn−1は、ホモグラフィ行列Hn,n−1により求めることができる。

【0033】

【数4】

【0034】

【数5】

【0035】

[奥行きに対する尤度の計算]

次に、奥行き推定部104が、カメラCnの画像Inについて、奥行きに対する尤度をステレオマッチング法により求める(ステップS2)。カメラCn以外の全てのカメラの画像についても、同様にして奥行きを推定することが可能である。多視点画像を前提としているので、2眼ステレオで利用されるSSD(Sum of Squared Difference)を拡張した複数基線長を利用したステレオマッチング法(参考文献1:奥富,金出:複数の基線長を利用したステレオマッチング法, 信学論, vol. J75-D-II, no. 8, pp. 1317-1327 (1992))のSSSD(Sum of SSDs)を尤度の計算に用いる。

【0036】

以下では、NCC(Normalized Cross Correlation)を用いた場合の尤度の計算を示す。カメラCnの画像Inの注目画素pについて、奥行きdに対する尤度Lp(d)は、次式(6)で表現される。

【0037】

【数6】

【0038】

但し、OはカメラCnの周辺カメラの集合とし、rは数式(4)のホモグラフィ行列により求まるカメラCoの画像Ioの画素の位置、νγは画像Ioにおいて画素r周辺の局所領域の画像のR,G,Bの輝度値を並べたベクトルである。νp・νγは、ベクトルの内積を表し、normは、ベクトルの大きさを表し、1−ノルム、2−ノルム等を意味する。Γpは、奥行きdを変化させたとき、尤度Lp(d)の総和が1になるようにする正規化係数である。

【0039】

図4は、本実施形態による奥行きに対する尤度の計算方法を説明するための概念図である。また、図5は、複数の画像間のエピポーラ線(EL1、EL2)を説明するための概念図である。周辺領域とは、図4に示すように、注目画素pの周辺の3×3や、5×5、7×7画素等の領域である。νpや、νγは、R,G,B成分の値をラスタースキャンしたベクトルで表すことができる。例えば、局所領域の大きさが3×3の場合には、それぞれの成分が9次元なので、νpは27(=9次元×3成分)次元のベクトルとなる。

【0040】

数式(6)により、カメラCnの画素pについて複数の画像間のエピポーラ線(図5を参照)上の局所領域の相関情報を計算することにより尤度を求めている。また、カメラCnに対して、周辺カメラCoの選び方は撮影環境に依存する。共通視野がなるべく多いカメラを選ぶことで対応付けが行いやすくなる。そのため、カメラCnから近い2台以上のカメラを選んだ方が好ましい。

【0041】

[奥行き推定]

次に、奥行き推定部104が、個々の画素の尤度に基づいて奥行きを推定する(ステップS3)。本実施形態では、個々の画素の尤度と平滑化項で定義されるエネルギー関数の最小化問題を解くことで、多視点画像の奥行きを推定する手法を用いる。この手法は、個々の画素の奥行きに対する尤度と近傍画素の奥行きの推定結果とが近い値になるような平滑化項により、エネルギー関数が定義される。ステレオマッチング法の尤度の結果だけでは、被写体表面が凸凹な奥行きに推定されがちである。しかし、平滑化項を設定することで推定結果が滑らかになる効果があり、その有効性が報告されている(参考文献2:Li Hong, George Chen : Segment-based Stereo matching Using Graph Cuts, in Proc. of CVPR, vol.1, pp. 74-81 (2004))。

カメラCnの画像Inについて、注目画素をp、近傍画素をqで表わすと、エネルギー関数は、以下の数式(7)、(8)、(9)ように定義される。

【0042】

【数7】

【0043】

【数8】

【0044】

【数9】

【0045】

但し、大文字のD(p)は、画素pの推定された奥行きであり、ELikelihoodは、画素pの奥行きがD(p)と推定されたときのコストを出力する関数であり、Esmoothは、平滑化項であり、λは、2つの関数を重視する比率である。尤度が大きい程、コストは小さくなる。Esmoothは、画素pと近傍画素の奥行きの推定結果D(p)とD(q)の差が小さいほど、小さいコストを出力する関数である。

【0046】

また、平滑化項については、数式(9)以外にも、近傍画素qとの色の違いによりコストの大きさを変化させるような次式(10)の形や、pとqの画素の奥行きが違うときには、一定のコストを算出する次式(11)にしてもよい。

【0047】

【数10】

【0048】

【数11】

【0049】

ここで、I(p)とI(q)は、カメラCnの画素pと画素qの色情報であり、画素pとqの位置の[R,G,B]成分を並べたベクトルであり、||I(p)−I(q)||は、2−ノルムを表す。数式(10)の平滑化項は、色が切り替わるところでは、近傍画素の奥行きも変化しやすい効果が得られる。

【0050】

最後に、数式(7)のエネルギー関数Etotalが最小にするような奥行きを求める。この最小化問題は、Simulated Annealing法や、Graph Cuts法、Belief Propagation法などのアルゴリズムにより近似解を得ることができる。

【0051】

[奥行き推定結果の評価]

次に、奥行き推定部104が、奥行きを補正する対象の画素(補正対象画素)の検出と、奥行き推定精度が高い画素(高精度推定画素)の検出とを行う(ステップS4)。奥行き推定部104は、補正対象画素として、ステレオマッチング法での対応付けが困難な画素を選択する。以下で、2通りの評価方法について述べる。

(1)ステレオマッチング法の尤度を用いた評価

テクスチャが少ない領域の画素やオクルージョンの領域では、数式(6)において画素pの奥行きに対する尤度関数の値の最大値が小さくなる傾向がある。また、奥行き推定を誤った場合には、その奥行きを用いて仮想視点画像を合成したときにアーティファクトが生じる。

【0052】

そこで奥行き推定部104は、補正対象画素として、尤度の最大値が閾値Th_likeよりも小さい画素で、かつ、推定した奥行きの値で合成した画像と実カメラの映像との差分が閾値Th_diffよりも大きい画素を選択しても良い。逆に、奥行き推定部104は、尤度の最大値が閾値Th_likeよりも大きい画素で、かつ、推定した奥行きの値で合成した画像と実カメラの映像との差分が閾値Th_diffよりも小さい画素を、高精度推定画素として選択しても良い。

【0053】

これらの閾値は、例えば事前に実験を行う事によって決められるパラメータである。本実施形態では、画像全体の尤度の平均値と差分の平均を、それぞれ閾値Th_likeとTh_diffとした。以下では、高精度推定画素をuで表わし、高精度推定画素の集合をUと表現する。

(2) 近傍カメラ画像との比較による評価

カメラCnの画像Iiの画素pについて推定精度の評価を述べる.

画素pの推定された奥行きをDi(p)、その奥行きをもとに式(4)のホモグラフィ行列により近傍カメラCoへ射影した画素の位置をq、またカメラCoの画素qの推定された奥行きをDo(q)と表現すると、以下の式で評価をする。

【0054】

【数12】

【数13】

【0055】

画素pについて、近傍カメラCoの画素qの奥行きと色を比較したSDとSIについて、閾値Th_SD; Th_SIを設定し、その閾値以下の画素について推定精度が高い画素と判定した。これらの閾値は実験的に決めるパラメータである。

【0056】

[画像特徴から奥行き推定関数fの算出]

次に、カメラCnの補正をする画素pについて、奥行き推定関数を算出する(ステップS5)。以下、奥行き推定関数の算出について、図6及び図7を用いて説明する。図6及び図7は、画像特徴から奥行き推定関数fの算出方法を説明するための概念図である。奥行き推定関数の算出には、補正対象画素pから半径R以内の高精度推定画素u(∈U)を用いる(図6、図7を参照)。ここで、画素集合UはカメラCnの近傍のカメラCo(o=…n−2,n−1,n,n+1,…)をカメラCnに射影した画素も含める。カメラCoの高精度推定画素をuo、画素uoをカメラCnに射影した座標の画素をuonで表わすと、尤度推定関数の算出の際に用いる高精度推定画素uの集合Uは、次式(12)、(13)のように求まる。

【0057】

【数14】

【0058】

【数15】

【0059】

次に、カメラCnの奥行き方向に多層平面をD枚設定し、各層(d(=1,2,…,D))に所属する高精度推定画素u(∈U)から画像特徴を抽出する。画像特徴は、奥行きがdの高精度推定画素uを含むN×Nの局所領域から抽出される。例えば、N=1として高精度推定画素uの色(R,G,B)成分を並べた三次元のベクトルや、図4で示したように、5×5の領域のR,G,Bをラスタースキャンして並べたテクスチャ情報を含むベクトルや、HOG(Histograms of Oriented Gradients)特徴や、SURF(Speeded-Up Robust Features)特徴を用いる。

【0060】

高精度推定画素uの奥行きがdに推定された画素の集合をUd、その画素uの特徴ベクトルをvdで表わす。奥行き推定関数は、この辞書ベクトルと補正画素の画像特徴ベクトルとの類似度や距離から奥行きを推定する。類似度の算出方法は、例えば、辞書ベクトルと補正画素の画像特徴ベクトルとのマハラノビス距離や、最近傍探索した結果得られた最近傍ベクトルと補正画素の画像特徴ベクトルとの距離や、辞書ベクトルから生成される部分空間と補正画素との特徴ベクトルの内積角度などによって計算される。

以下では、マハラノビス距離を用いたときの奥行き推定関数fが、補正画素について奥行きdに所属される尤度F(d)の算出方法を示す。補正画素の特徴ベクトルをxpで表すと、次式(14)、(15)、(16)、(17)で表される。

【0061】

【数16】

【数17】

【数18】

【数19】

但し、ΓFは、奥行きd(=1,2,…,D)の尤度の総和が1になるための正規化係数、num(vd)は辞書ベクトルvdの数、dist(xp,μd)はマハラノビス距離、μdは奥行きdの辞書ベクトルvdの平均ベクトル、Sdは共分散行列であり、εは0割りを避けるための微小値である。半径Rは、実験的に決めるパラメータで、本実施形態では、R=10〜40、εは0.1とした。

【0062】

[尤度の補正]

次に、補正対象画素について、その画素が属する被写体の奥行き情報により尤度を補正する(ステップS6)。補正対象画素pのステレオマッチング法で求めた尤度Lp(d)について、補正後の尤度L’p(d)は次式(18)で表される。

【0063】

【数20】

【0064】

ここで、w(0<w<1)は、ステレオマッチング法で計算した尤度と奥行き推定関数の出力のいずれを重視するかを表す割合いとを調整するパラメータである。wが大きいとステレオマッチング法の尤度を重視することとなり、実験的に決定する。

【0065】

[画像の奥行きの再推定]

次に、個々の画素の尤度と平滑化項で定義されるエネルギー関数の最小化問題を解くことで、奥行きを再推定する(ステップS7)。すなわち、数式(7)に補正後の尤度を代入することで、奥行きを再推定する。

【0066】

[仮想視点位置の画像合成]

次に、画像合成部108が、仮想視点位置に近いカメラを選択し、選択されたN個のカメラ画像と推定された奥行き情報とから3Dワーピング法により画像を合成する(ステップS8)。色をブレンドする際には、各カメラと仮想視点との位置の近さや、推定された奥行きの尤度の強さに応じた加重平均を行う。

【0067】

ここで、図8は、仮想視点位置の画像合成を説明するための概念図である。3Dワーピング法は、多視点画像と画像の奥行き(デプスマップ)を基にして、仮想視点位置のカメラCvの画像の画素mvの色Iv(mv)を決める方法である。図8に2台のカメラの例を示す。カメラの選択は、仮想視点から適当な距離の範囲にあるカメラを用いればよいので、2台以上でも可能である。

【0068】

カメラC1とカメラC2の内部パラメータと外部パラメータをそれぞれA1、A2、R1、T1、R2、T2とし、カメラC1とカメラC2の画像の奥行きをD1,D2とする。このとき、点Mの色はカメラC1、カメラC2それぞれから式(3)により仮想視点カメラCvへ射影される。仮想視点カメラの内部パラメータをAv、外部パラメータをRv、Tvとすると、

【0069】

【数21】

【0070】

【数22】

【0071】

となる。ここで、チルダ(〜)mv1とチルダ(〜)mv2は、カメラC1とカメラC2の画素m1、m2を数式(3)で射影したときの、位置の拡張ベクトルである。

【0072】

仮想視点とカメラC1、カメラC2との距離の比と画素m1と画素m2の奥行きの尤度により、仮想視点の画像の画素mvの色I(mv)を加重平均により求める。仮想視点とカメラC1とカメラC2の距離の比率をα:(1−α)(0<α<1)とし、尤度をL(Dm1):L(Dm2)とすると、

【0073】

【数23】

【0074】

【数24】

【0075】

【数25】

【0076】

但し、L(Dm1)、L(Dm2)は、カメラC1、カメラC2の画像の画素m1、m2について、奥行き推定時に計算した尤度である。また、距離の比率と尤度の比率を加算によりw1とw2を求めたが、どちらか一方のみを利用することや、比率を掛け算することで求めてもよい。

【0077】

ここで、図9A及び図9Bは、本実施形態による、3Dワーピング法について説明するための概念図である。式(4)により画素を奥行きに応じて射影した際に、図9に示すように異なる点Pと点Qが仮想視点カメラCvから見ると、一直線上に存在する場合がある。このときは、点Pと点QについてカメラCvの座標系における奥行きが小さい方の点Pが仮想カメラCvから見える。例えば、カメラC1から見える点PとカメラC2から見える点Qについて、カメラCvの座標系での奥行きがそれぞれDv(P)、Dv(Q)としたときに、(Dv(Q)−Dv(P))>δとすると、

【0078】

【数26】

【0079】

となる。但し、δは閾値のパラメータであり、事前に予備実験により決める。閾値δ以下の場合には、数式(21)により色を混合する。

【0080】

次に、本発明の実施形態である仮想視点画像合成装置100の効果について説明する。

【0081】

従来手法では、対応付けが困難な領域(画素)について、同一セグメント内の画素の奥行き情報を用いて補正を行っていた。従来手法では、他にも、前景や、背景というように被写体の奥行きが2値であることを前提に、対応付けが困難な画素と類似した色の被写体(前景もしくは背景)の奥行き情報を用いた補正も行っていた。

【0082】

しかし、前者の手法では、同一セグメント内の大部分の画素の奥行き推定精度が高くないと、正しく補正が行えない。つまり、テクスチャが少ない領域やオクルージョンの影響を受ける領域が広範囲な場合には、奥行き推定誤差が大きくなる可能性がある。また、同一の被写体が同一のセグメントになることが前提となるが、高精度に画像をセグメンテーションすることが難しい。

【0083】

後者の手法では、被写体が前景又は背景に存在している、つまり、奥行きは、2段階で近似することを前提としている。しかし、仮想視点画像合成では、奥行きの値は、多値であるため適用が難しい。また、後者の手法は、色情報を基にして背景と前景とを分離するものである。しかし、前景と背景に類似した色がある場合には、分離が困難となる。

【0084】

一方、上述した仮想視点画像合成装置100によれば、画像間の対応付けが困難な場合であっても奥行き推定誤差を抑制することが可能である。そのため、このような場合であっても高品質な仮想視点画像を合成できる。これにより、被写体のパーツ(顔、足、手など)にアーティファクトが生じることを防止し、合成画像の品質を向上させることが可能となる。

【0085】

なお、画像間の対応付けが困難な場合とは、例えば、テクスチャが少ない領域が広範囲である場合や、オクルージョンの影響を受ける領域が広範囲な場合である。また、被写体の境界付近に、被写体と類似した色を持つ別の被写体が存在する場合も、画像間の対応付けが困難であった。また、被写体のパーツに生じるアーティファクトとは、例えばパーツの一部が欠損してしまった画像や、パーツの一部が拡大又は縮小されてしまった画像のことである。

【0086】

<変形例>

補正対象画素を選択する処理は、上述したものに限定される必要は無い。例えば、注目画素周辺にテクスチャが少ない場合に、その注目画素を補正対象画素として選択しても良い。例えば、注目画素周辺に繰り返しテクスチャがある場合に、その注目画素を補正対象画素として選択しても良い。例えば、注目画素周辺がオクルージョンの影響を受けている場合に、その注目画素を補正対象画素として選択しても良い。例えば、テクスチャが少ないか否かについては、以下のような手法によって判定することができる。まず、注目画像に対してソーベルフィルタ(Sobel Filter:水平、垂直方向の輝度値の微分フィルタ)を適用する。そして、画素毎にフィルタ後の値をエッジ強度として使用し、エッジ強度に基づいてテクスチャが多いか少ないかの判定が可能である。

【0087】

以上、この発明の実施形態について図面を参照して詳述してきたが、具体的な構成はこの実施形態に限られるものではなく、この発明の要旨を逸脱しない範囲の設計等も含まれる。

【符号の説明】

【0088】

100…仮想視点画像合成装置, 101…被写体撮影部, 102…カメラ画像取得部, 103…カメラパラメータ入力部, 104…奥行き推定部, 105…仮想視点位置入力部, 106…仮想視点位置決定部, 107…画像データ記憶部, 107a…カメラ画像・カメラパラメータ記憶部, 107b…奥行き記憶部, 107c…合成画像記憶部, 108…画像合成部, 109…合成画像出力部, 110…合成画像表示部

【技術分野】

【0001】

本発明は、被写体にテクスチャが少ない領域やオクルージョンがあり、ステレオマッチング法で対応付けが難しい場合に有効な技術に関する。

【背景技術】

【0002】

複数のカメラから撮影された多視点画像を用いて、仮想の視点位置から見た画像を合成することを仮想視点画像合成という。図10は、多視点画像を用いて任意の視点位置の画像を合成する従来技術の処理の流れを示す図である。以下、多視点画像を用いて任意の視点位置の画像を合成するため従来技術の処理の流れについて説明する。まず、多視点画像及びカメラパラメータが入力される(ステップSa1)。次に、二次元の画像群から三次元情報(奥行き)を推定する(ステップSa2)。そして、多視点画像と、カメラパラメータと、奥行きとに基づいて、仮想視点画像を合成する(ステップSa3)。このとき、奥行きの推定精度が低いと、仮想視点の合成画像の品質が劣化してしまう。

【0003】

奥行きを推定する手法にステレオマッチング法がある。ステレオマッチング法では、多視点画像間の画素の対応づけとカメラの内部パラメータと外部パラメータとが用いられる。そして、三角測量の原理により、注目画素の実空間での位置が計算により求められる。図11は、ステレオマッチング法による処理の概略を示す図である。例えば、図11に示すように、地点P1及び地点P2から注目地点Aを見ると仮定する。この場合、地点P1及びP2を結んだ直線の距離と、注目地点Aと地点P1と地点P2とを頂点とした三角形の各頂点の角度とが得られれば、地点P1(もしくは地点P2)から注目地点Aへの距離を求めることができる。

【0004】

しかしながら、模様(テクスチャ)が少ない領域や、周期的なテクスチャが存在する領域や、オクルージョンの影響を受けた領域がある場合には、その領域内の画素の対応付けは困難である。図12は、従来技術における問題点を示す図である。例えば、図12に示すように、鳥のような被写体Cが横切るなど、オクルージョンが生じた場合を考えると、地点P1からは注目地点Aが見えないので対応付けができない。

【0005】

このとき、ステレオマッチング法では、地点P2から見える注目地点Aについて、地点P1から似たような形状として見える地点Bと誤って対応付けされやすい。そのため、奥行き推定が間違った地点Aのような画素の影響により、合成された画像に不自然な像(アーティファクト)が生じる。これが仮想視点画像合成の品質に繋がる重要な課題である。

【0006】

従来の仮想視点画像合成手法では、このような対応付けが困難な画素について、画像をセグメンテーションすることにより対応するアプローチがあった。

【0007】

例えば、画素の色(R、G、B)情報を基にして画像を細かくセグメンテーションし、同じセグメント内の画素は、同一の被写体、つまり同一平面(曲面)上に存在すると仮定していた。この仮定により、注目画素の奥行きが所属するセグメントの平面の奥行きとなるように、奥行きを補正する手法(例えば非特許文献1参照)がある。

【0008】

他にも奥行きを補正する手法として、画像の色情報から前景と背景を分離する手法がある。これは、被写体が前景と背景との2種類という前提のもと、ステレオマッチング法により対応付けが困難な画素について、その画素と類似した色を持つ被写体(前景か背景)を検出し、その被写体の奥行き情報を用いて、その画素の奥行きの尤度を補正する手法(例えば非特許文献2、3参照)がある。

【先行技術文献】

【非特許文献】

【0009】

【非特許文献1】A. Klaus, M. Sormann, K. Karner: Segment-Based Stereo Matching Using Belief Propagation and a Self-Adapting Dissimilarity Measure, in Proc. of ICPR, pp. 15-18 (2006)

【非特許文献2】V. Kolmogorov, A. Criminisi, A. Blake, G. Cross, C. Rother : Bi-layer segmentation of binocular stereo video, In Proc. of CVPR, vol. 2, pp. 407-414 (2005)

【非特許文献3】石井,高橋,苗村:自由視点画像のための合成とセグメンテーションの連結手法,3次元画像コンファレンス,5-1, pp.49-52 (2009)

【発明の概要】

【発明が解決しようとする課題】

【0010】

上述の仮想視点画像合成の研究では、ある画素の奥行き情報を補正するときに、その画素と同一のセグメント内の画素の奥行き情報を用いて補正を行っていた。この手法では、カメラを密に置ける環境で、対応付けの誤りが狭い領域で起こるような場合には有効である。しかしながら、注目画素周辺の広範囲において対応付けが誤っている場合、つまり同一セグメント内の大部分の画素の対応付けが誤っている場合には、セグメント内の大部分の画素の奥行き推定精度が低くなってしまう。そのため、そのセグメントの奥行き推定結果を用いても、注目画素の奥行きを正しく補正することは難しいという問題があった。

【0011】

また、前景の被写体と背景の被写体とを分離する手法では、各被写体の色特徴を利用することは有効ではある。しかし、仮想視点画像合成の場合には、奥行きは多値であり、前景の奥行きと背景の奥行きとの2値で近似することが難しいという問題がある。

【0012】

本発明は、このような事情を考慮してなされたものであり、テクスチャが少ない領域や、オクルージョンの影響により画像間の対応付けが困難な場合であっても、奥行き推定誤差を抑制し、高品質な仮想視点画像を合成することができる技術を提供することにある。

【課題を解決するための手段】

【0013】

本発明の一態様は、複数の異なる視点から被写体を撮影した多視点画像に基づいて、任意の仮想視点位置から見た前記被写体の画像を合成する画像処理方法であって、ステレオマッチング法により、前記多視点画像に対して、各画素の奥行きに対する尤度を算出する第1のステップと、前記第1のステップで求めた尤度に基づいて、個々の画素の奥行きを推定する第2のステップと、奥行きの推定精度が高いと推定されるための条件を満たす高精度推定画素の奥行き推定結果を用いて、画像特徴から奥行きに対する尤度を推定するための推定関数を算出する第3のステップと、奥行きの推定精度が低いと推定されるための条件を満たす補正対象画素に対して、前記第3のステップで算出された推定関数を用いて、尤度の補正を行う第4のステップと、前記第4のステップで行われた補正後の尤度を用いて、画像全体の奥行きを再推定する第5のステップと、前記第5のステップで再推定した奥行きと、前記多視点画像とに基づいて、前記仮想視点位置に応じた前記被写体の画像を合成する第6のステップとを有する。

【0014】

本発明の一態様は、複数の異なる視点から被写体を撮影した多視点画像に基づいて、任意の仮想視点位置から見た前記被写体の画像を合成する画像処理装置であって、ステレオマッチング法により、前記多視点画像に対して、各画素の奥行きに対する尤度を算出する尤度算出部と、前記尤度算出部で求めた尤度に基づいて、個々の画素の奥行きを推定する奥行き推定部と、奥行きの推定精度が高いと推定されるための条件を満たす高精度推定画素の奥行き推定結果を用いて、画像特徴から奥行きに対する尤度を推定するための推定関数を算出する尤度推定関数算出部と、奥行きの推定精度が低いと推定されるための条件を満たす補正対象画素に対して、前記尤度推定関数算出部で算出された推定関数を用いて、尤度の補正を行う尤度補正部と、前記尤度補正部で行われた補正後の尤度を用いて、画像全体の奥行きを再推定する奥行き再推定部と、前記奥行き再推定部により再推定された奥行きと、前記多視点画像とに基づいて、前記仮想視点位置に応じた前記被写体の画像を合成する画像合成部とを備える。

【0015】

本発明の一態様は、複数の異なる視点から被写体を撮影した多視点画像に基づいて、任意の仮想視点位置から見た前記被写体の画像を合成する画像処理装置のコンピュータに、ステレオマッチング法により、前記多視点画像に対して、各画素の奥行きに対する尤度を算出する尤度算出ステップと、前記尤度算出ステップで求めた尤度に基づいて、個々の画素の奥行きを推定する奥行き推定ステップと、奥行きの推定精度が高いと推定されるための条件を満たす高精度推定画素の奥行き推定結果を用いて、画像特徴から奥行きに対する尤度を推定するための推定関数を算出する尤度推定関数算出ステップと、奥行きの推定精度が低いと推定されるための条件を満たす補正対象画素に対して、前記尤度推定関数算出ステップで算出された推定関数を用いて、尤度の補正を行う尤度補正ステップと、前記尤度補正ステップで行われた補正後の尤度を用いて、画像全体の奥行きを再推定する奥行き再推定ステップと、前記奥行き再推定ステップで再推定された奥行きと、多視点画像とに基づいて、前記仮想視点位置に応じた前記被写体の画像を合成する画像合成ステップと、を実行させるためのコンピュータプログラムである。

【発明の効果】

【0016】

本発明により、テクスチャが少ない領域や、オクルージョンの影響により画像間の対応付けが困難な場合であっても、奥行き推定誤差を抑制し、高品質な仮想視点画像を合成することが可能となる。

【図面の簡単な説明】

【0017】

【図1】仮想視点画像合成システムの構成を示すブロック図である。

【図2】本実施形態による仮想視点画像合成方法を説明するためのフローチャートである。

【図3】本実施形態による仮想視点画像合成方法で用いるカメラの配置例を示す概念図である。

【図4】本実施形態による奥行きに対する尤度の計算方法を説明するための概念図である。

【図5】複数の画像間のエピポーラ線(EL1、EL2)を説明するための概念図である。

【図6】画像特徴から奥行きに対する尤度推定関数Fの算出方法を説明するための概念図である。

【図7】画像特徴から奥行きに対する尤度推定関数Fの算出方法を説明するための概念図である。

【図8】仮想視点位置の画像合成を説明するための概念図である。

【図9】3Dワーピング法について説明するための概念図である。

【図10】多視点画像を用いて任意の視点位置の画像を合成する従来技術の処理の流れを示す図である。

【図11】ステレオマッチング法による処理の概略を示す図である。

【図12】従来技術における問題点を示す図である。

【発明を実施するための形態】

【0018】

<概略>

まず、本発明の実施形態である仮想視点画像合成システム(以下、単に「仮想視点画像合成システム」という。)の概略について説明する。

仮想視点画像合成システムは、卓球や、テニスなどのスポーツの鑑賞や、大学等の授業を撮影した遠隔教育の教材向けに、視聴者があたかも撮影した環境にいると思えるような臨場感のある画像を高品質に合成する。そのため、本仮想視点画像合成システムによれば、光線空間法や、視体積交差法のようにカメラを密に配置する撮影環境や、被写体を全方位から撮影できるような撮影環境ではなくても、高品質な仮想視点画像の合成を実現する。すなわち、仮想視点画像合成システムは、実際の競技場や、イベント会場などにおける撮影を対象として、卓球やテニス等のスポーツシーン、またライブコンサートのようなイベントシーンにおいても、高品質な仮想視点画像の合成を実現する。

【0019】

上述したような合成を実現するため、仮想視点画像合成システムは、対応付けが困難な領域の画素、もしくはセグメントされた領域について、その画素や、セグメントされた領域の奥行きの尤度を画像の特徴から補正する関数を算出する。そして、その関数の結果により補正を行う。画像特徴とは、色情報、テクスチャ情報、又は動き情報を意味する。

【0020】

具体的には以下の通りである。まず、仮想視点画像合成システムは、事前に検出した対応付け精度が高い画素(以下では高精度推定画素と呼ぶ)を用いて、奥行き値毎に画像特徴を抽出する。次に、仮想視点画像合成システムは、奥行き値毎に求めた画像特徴と、対応付けが困難な領域の画素(以下、補正対象画素と呼ぶ)との特徴とを比較する。そして、仮想視点画像合成システムは、最も類似した画像特徴を持つ奥行き値を用いて、対応付けが困難な画素の奥行きを補正する。対応付けが困難な画素と対応付けが困難な小領域(セグメントされた小領域)とは、スケール(空間的な大きさ)が違うだけで本質的な違いはない。以下の説明では、対応付けが困難な画素の補正方法についてのみ説明をする。

【0021】

<詳細>

次に、仮想視点画像合成システムの詳細について説明する。

図1は、仮想視点画像合成システムの構成を示すブロック図である。被写体撮影部101は、複数台のカメラで構成される多視点画像取得システムである。被写体撮影部101は、撮影した映像信号S1をカメラ画像取得部102に供給する。カメラパラメータ入力部103は、キャリブレーションしたカメラパラメータP1を入力する装置である。仮想視点位置入力部105は、ユーザーが希望する視点位置を入力する装置である。カメラパラメータ入力部103と仮想視点位置入力部105は、例えば、キーボードや、マウス、タッチ入力装置などのユーザーインタフェースや、DVD(Digital Versatile Disc)や、USB(Universal Serial Bus)メモリ等の外部記憶装置である。

【0022】

仮想視点画像合成装置100は、カメラ画像取得部102、奥行き推定部104、仮想視点位置決定部106、画像データ記憶部107、画像合成部108、及び合成画像出力部109を備える。カメラ画像取得部102は、被写体撮影部101からの映像信号S1を取得し、画像データD1として画像データ記憶部107に供給する。仮想視点位置決定部106は、仮想視点位置入力部105により与えられた、仮想視点位置のカメラパラメータを決定し、画像合成部108に供給する。

【0023】

画像データ記憶部107は、磁気ハードディスク装置や半導体記憶装置などの記憶装置を用いて構成される。画像データ記憶部107は、カメラ画像・カメラパラメータ記憶部107a、奥行き記憶部107b、及び合成画像記憶部107cを備える。各記憶部は、同一の記憶装置上に構成されても良いし、それぞれ異なる記憶装置上に構成されても良い。カメラ画像・カメラパラメータ記憶部107aは、カメラ画像取得部102からの画像データD1を記憶する。奥行き記憶部107bは、後述する奥行き推定部104から出力される推定された奥行きデータD2を記憶する。合成画像記憶部107cは、後述する画像合成部108から出力される画像データD3を記憶する。被写体撮影部101のカメラによる被写体撮影で予め撮影したシーンの画像とキャリブレーションで求めたカメラパラメータP1と奥行き推定部104の出力結果D2とを、それぞれカメラ画像・カメラパラメータ記憶部107aと奥行き記憶部107bとに記憶しておき、ユーザーが希望する仮想視点位置の入力に応じて画像合成を独立して実行することが可能となる。

【0024】

奥行き推定部104は、カメラ画像・カメラパラメータ記憶部107aからカメラパラメータP1と画像データD1とを取り出し、奥行き推定結果D2を出力して奥行き記憶部107bに供給する。

画像合成部108は、カメラ画像・カメラパラメータ記憶部107aからカメラパラメータP1と画像データD1を取り出し、奥行き記憶部107bから奥行き推定結果D2を取り出して、合成画像(仮想視点から見た画像)データD3を出力する。

【0025】

合成画像出力部109は、合成画像記憶部107cに記憶された合成画像データD3を、出力用画像データとして読み出し、ディスプレイ表示用の映像信号S2として合成画像表示部110に出力する。合成画像表示部110は、例えば、ディスプレイ端子等の合成画像出力部109に接続されたCRT(Cathode Ray Tube)、LCD(Liquid Crystal Display)、PDP(Plasma Display Panel)等の表示装置である。合成画像表示部110は、合成画像出力部109からの映像信号S2に従って合成画像を表示する。なお、合成画像表示部110は、例えば、二次元平面状の装置でもよいし、装置利用者を取り囲むような曲面状の表示装置であってもよい。

【0026】

(画像合成方法の説明)

次に、本実施形態の仮想視点画像合成装置100による仮想視点画像合成方法について説明する。図2は、本実施形態による仮想視点画像合成方法を説明するためのフローチャートである。仮想視点画像合成において、カメラの配置は、本来自由でよい。しかし、本実施形態では、複数台のカメラで共通視野を確保しやすくするために、格子状、もしくは一直線上にカメラを配置する。図3は、本実施形態による仮想視点画像合成方法で用いるカメラの配置例を示す概念図である。図3に示すように、カメラCn−2、Cn−1、Cn、Cn+1、…の向きは、並行、もしくは特定の被写体を注視点Mとするように放射線状に配置されており、全てのカメラCn−2、Cn−1、Cn、Cn+1、…は同期している。

【0027】

[多視点画像とカメラパラメータの入力]

まず、カメラパラメータ入力部103で、前処理として各カメラのカメラパラメータをキャリブレーションにより求める(ステップS1)。カメラ番号をn(=1,2,3,…,N)、カメラの内部パラメータをAn、外部パラメータをRn、Tn、カメラCnの画像の画素の位置をmnとすると、カメラCnの画像上の位置mn=[xn,yn]とカメラCnの座標系の位置Mc=[Xc,Yc,Zc]、世界座標系の位置M=[X,Y,Z]の関係は次式(1)、(2)で求まる。

【0028】

【数1】

【0029】

【数2】

【0030】

数式(1)と数式(2)より、

【0031】

【数3】

【0032】

となる。但し、snは奥行き方向のスケールを決める正の定数、右上添え字のTは転置行列を意味し、チルダ(〜)mnとチルダ(〜)Mとは拡張ベクトルであり、チルダ(〜)mn=[xn,yn,1]T,チルダ(〜)M=[X,Y,Z,1]Tである。

画像の奥行きが分かれば、数式(1)により定数snが決定されカメラCnの座標系での位置Mcが分かる。そして、数式(2)により世界座標系での位置Mを求めることができる。

また、カメラCnの画素mnの奥行きがZ=dのとき、カメラCn−1の画像上の画素mn−1は、ホモグラフィ行列Hn,n−1により求めることができる。

【0033】

【数4】

【0034】

【数5】

【0035】

[奥行きに対する尤度の計算]

次に、奥行き推定部104が、カメラCnの画像Inについて、奥行きに対する尤度をステレオマッチング法により求める(ステップS2)。カメラCn以外の全てのカメラの画像についても、同様にして奥行きを推定することが可能である。多視点画像を前提としているので、2眼ステレオで利用されるSSD(Sum of Squared Difference)を拡張した複数基線長を利用したステレオマッチング法(参考文献1:奥富,金出:複数の基線長を利用したステレオマッチング法, 信学論, vol. J75-D-II, no. 8, pp. 1317-1327 (1992))のSSSD(Sum of SSDs)を尤度の計算に用いる。

【0036】

以下では、NCC(Normalized Cross Correlation)を用いた場合の尤度の計算を示す。カメラCnの画像Inの注目画素pについて、奥行きdに対する尤度Lp(d)は、次式(6)で表現される。

【0037】

【数6】

【0038】

但し、OはカメラCnの周辺カメラの集合とし、rは数式(4)のホモグラフィ行列により求まるカメラCoの画像Ioの画素の位置、νγは画像Ioにおいて画素r周辺の局所領域の画像のR,G,Bの輝度値を並べたベクトルである。νp・νγは、ベクトルの内積を表し、normは、ベクトルの大きさを表し、1−ノルム、2−ノルム等を意味する。Γpは、奥行きdを変化させたとき、尤度Lp(d)の総和が1になるようにする正規化係数である。

【0039】

図4は、本実施形態による奥行きに対する尤度の計算方法を説明するための概念図である。また、図5は、複数の画像間のエピポーラ線(EL1、EL2)を説明するための概念図である。周辺領域とは、図4に示すように、注目画素pの周辺の3×3や、5×5、7×7画素等の領域である。νpや、νγは、R,G,B成分の値をラスタースキャンしたベクトルで表すことができる。例えば、局所領域の大きさが3×3の場合には、それぞれの成分が9次元なので、νpは27(=9次元×3成分)次元のベクトルとなる。

【0040】

数式(6)により、カメラCnの画素pについて複数の画像間のエピポーラ線(図5を参照)上の局所領域の相関情報を計算することにより尤度を求めている。また、カメラCnに対して、周辺カメラCoの選び方は撮影環境に依存する。共通視野がなるべく多いカメラを選ぶことで対応付けが行いやすくなる。そのため、カメラCnから近い2台以上のカメラを選んだ方が好ましい。

【0041】

[奥行き推定]

次に、奥行き推定部104が、個々の画素の尤度に基づいて奥行きを推定する(ステップS3)。本実施形態では、個々の画素の尤度と平滑化項で定義されるエネルギー関数の最小化問題を解くことで、多視点画像の奥行きを推定する手法を用いる。この手法は、個々の画素の奥行きに対する尤度と近傍画素の奥行きの推定結果とが近い値になるような平滑化項により、エネルギー関数が定義される。ステレオマッチング法の尤度の結果だけでは、被写体表面が凸凹な奥行きに推定されがちである。しかし、平滑化項を設定することで推定結果が滑らかになる効果があり、その有効性が報告されている(参考文献2:Li Hong, George Chen : Segment-based Stereo matching Using Graph Cuts, in Proc. of CVPR, vol.1, pp. 74-81 (2004))。

カメラCnの画像Inについて、注目画素をp、近傍画素をqで表わすと、エネルギー関数は、以下の数式(7)、(8)、(9)ように定義される。

【0042】

【数7】

【0043】

【数8】

【0044】

【数9】

【0045】

但し、大文字のD(p)は、画素pの推定された奥行きであり、ELikelihoodは、画素pの奥行きがD(p)と推定されたときのコストを出力する関数であり、Esmoothは、平滑化項であり、λは、2つの関数を重視する比率である。尤度が大きい程、コストは小さくなる。Esmoothは、画素pと近傍画素の奥行きの推定結果D(p)とD(q)の差が小さいほど、小さいコストを出力する関数である。

【0046】

また、平滑化項については、数式(9)以外にも、近傍画素qとの色の違いによりコストの大きさを変化させるような次式(10)の形や、pとqの画素の奥行きが違うときには、一定のコストを算出する次式(11)にしてもよい。

【0047】

【数10】

【0048】

【数11】

【0049】

ここで、I(p)とI(q)は、カメラCnの画素pと画素qの色情報であり、画素pとqの位置の[R,G,B]成分を並べたベクトルであり、||I(p)−I(q)||は、2−ノルムを表す。数式(10)の平滑化項は、色が切り替わるところでは、近傍画素の奥行きも変化しやすい効果が得られる。

【0050】

最後に、数式(7)のエネルギー関数Etotalが最小にするような奥行きを求める。この最小化問題は、Simulated Annealing法や、Graph Cuts法、Belief Propagation法などのアルゴリズムにより近似解を得ることができる。

【0051】

[奥行き推定結果の評価]

次に、奥行き推定部104が、奥行きを補正する対象の画素(補正対象画素)の検出と、奥行き推定精度が高い画素(高精度推定画素)の検出とを行う(ステップS4)。奥行き推定部104は、補正対象画素として、ステレオマッチング法での対応付けが困難な画素を選択する。以下で、2通りの評価方法について述べる。

(1)ステレオマッチング法の尤度を用いた評価

テクスチャが少ない領域の画素やオクルージョンの領域では、数式(6)において画素pの奥行きに対する尤度関数の値の最大値が小さくなる傾向がある。また、奥行き推定を誤った場合には、その奥行きを用いて仮想視点画像を合成したときにアーティファクトが生じる。

【0052】

そこで奥行き推定部104は、補正対象画素として、尤度の最大値が閾値Th_likeよりも小さい画素で、かつ、推定した奥行きの値で合成した画像と実カメラの映像との差分が閾値Th_diffよりも大きい画素を選択しても良い。逆に、奥行き推定部104は、尤度の最大値が閾値Th_likeよりも大きい画素で、かつ、推定した奥行きの値で合成した画像と実カメラの映像との差分が閾値Th_diffよりも小さい画素を、高精度推定画素として選択しても良い。

【0053】

これらの閾値は、例えば事前に実験を行う事によって決められるパラメータである。本実施形態では、画像全体の尤度の平均値と差分の平均を、それぞれ閾値Th_likeとTh_diffとした。以下では、高精度推定画素をuで表わし、高精度推定画素の集合をUと表現する。

(2) 近傍カメラ画像との比較による評価

カメラCnの画像Iiの画素pについて推定精度の評価を述べる.

画素pの推定された奥行きをDi(p)、その奥行きをもとに式(4)のホモグラフィ行列により近傍カメラCoへ射影した画素の位置をq、またカメラCoの画素qの推定された奥行きをDo(q)と表現すると、以下の式で評価をする。

【0054】

【数12】

【数13】

【0055】

画素pについて、近傍カメラCoの画素qの奥行きと色を比較したSDとSIについて、閾値Th_SD; Th_SIを設定し、その閾値以下の画素について推定精度が高い画素と判定した。これらの閾値は実験的に決めるパラメータである。

【0056】

[画像特徴から奥行き推定関数fの算出]

次に、カメラCnの補正をする画素pについて、奥行き推定関数を算出する(ステップS5)。以下、奥行き推定関数の算出について、図6及び図7を用いて説明する。図6及び図7は、画像特徴から奥行き推定関数fの算出方法を説明するための概念図である。奥行き推定関数の算出には、補正対象画素pから半径R以内の高精度推定画素u(∈U)を用いる(図6、図7を参照)。ここで、画素集合UはカメラCnの近傍のカメラCo(o=…n−2,n−1,n,n+1,…)をカメラCnに射影した画素も含める。カメラCoの高精度推定画素をuo、画素uoをカメラCnに射影した座標の画素をuonで表わすと、尤度推定関数の算出の際に用いる高精度推定画素uの集合Uは、次式(12)、(13)のように求まる。

【0057】

【数14】

【0058】

【数15】

【0059】

次に、カメラCnの奥行き方向に多層平面をD枚設定し、各層(d(=1,2,…,D))に所属する高精度推定画素u(∈U)から画像特徴を抽出する。画像特徴は、奥行きがdの高精度推定画素uを含むN×Nの局所領域から抽出される。例えば、N=1として高精度推定画素uの色(R,G,B)成分を並べた三次元のベクトルや、図4で示したように、5×5の領域のR,G,Bをラスタースキャンして並べたテクスチャ情報を含むベクトルや、HOG(Histograms of Oriented Gradients)特徴や、SURF(Speeded-Up Robust Features)特徴を用いる。

【0060】

高精度推定画素uの奥行きがdに推定された画素の集合をUd、その画素uの特徴ベクトルをvdで表わす。奥行き推定関数は、この辞書ベクトルと補正画素の画像特徴ベクトルとの類似度や距離から奥行きを推定する。類似度の算出方法は、例えば、辞書ベクトルと補正画素の画像特徴ベクトルとのマハラノビス距離や、最近傍探索した結果得られた最近傍ベクトルと補正画素の画像特徴ベクトルとの距離や、辞書ベクトルから生成される部分空間と補正画素との特徴ベクトルの内積角度などによって計算される。

以下では、マハラノビス距離を用いたときの奥行き推定関数fが、補正画素について奥行きdに所属される尤度F(d)の算出方法を示す。補正画素の特徴ベクトルをxpで表すと、次式(14)、(15)、(16)、(17)で表される。

【0061】

【数16】

【数17】

【数18】

【数19】

但し、ΓFは、奥行きd(=1,2,…,D)の尤度の総和が1になるための正規化係数、num(vd)は辞書ベクトルvdの数、dist(xp,μd)はマハラノビス距離、μdは奥行きdの辞書ベクトルvdの平均ベクトル、Sdは共分散行列であり、εは0割りを避けるための微小値である。半径Rは、実験的に決めるパラメータで、本実施形態では、R=10〜40、εは0.1とした。

【0062】

[尤度の補正]

次に、補正対象画素について、その画素が属する被写体の奥行き情報により尤度を補正する(ステップS6)。補正対象画素pのステレオマッチング法で求めた尤度Lp(d)について、補正後の尤度L’p(d)は次式(18)で表される。

【0063】

【数20】

【0064】

ここで、w(0<w<1)は、ステレオマッチング法で計算した尤度と奥行き推定関数の出力のいずれを重視するかを表す割合いとを調整するパラメータである。wが大きいとステレオマッチング法の尤度を重視することとなり、実験的に決定する。

【0065】

[画像の奥行きの再推定]

次に、個々の画素の尤度と平滑化項で定義されるエネルギー関数の最小化問題を解くことで、奥行きを再推定する(ステップS7)。すなわち、数式(7)に補正後の尤度を代入することで、奥行きを再推定する。

【0066】

[仮想視点位置の画像合成]

次に、画像合成部108が、仮想視点位置に近いカメラを選択し、選択されたN個のカメラ画像と推定された奥行き情報とから3Dワーピング法により画像を合成する(ステップS8)。色をブレンドする際には、各カメラと仮想視点との位置の近さや、推定された奥行きの尤度の強さに応じた加重平均を行う。

【0067】

ここで、図8は、仮想視点位置の画像合成を説明するための概念図である。3Dワーピング法は、多視点画像と画像の奥行き(デプスマップ)を基にして、仮想視点位置のカメラCvの画像の画素mvの色Iv(mv)を決める方法である。図8に2台のカメラの例を示す。カメラの選択は、仮想視点から適当な距離の範囲にあるカメラを用いればよいので、2台以上でも可能である。

【0068】

カメラC1とカメラC2の内部パラメータと外部パラメータをそれぞれA1、A2、R1、T1、R2、T2とし、カメラC1とカメラC2の画像の奥行きをD1,D2とする。このとき、点Mの色はカメラC1、カメラC2それぞれから式(3)により仮想視点カメラCvへ射影される。仮想視点カメラの内部パラメータをAv、外部パラメータをRv、Tvとすると、

【0069】

【数21】

【0070】

【数22】

【0071】

となる。ここで、チルダ(〜)mv1とチルダ(〜)mv2は、カメラC1とカメラC2の画素m1、m2を数式(3)で射影したときの、位置の拡張ベクトルである。

【0072】

仮想視点とカメラC1、カメラC2との距離の比と画素m1と画素m2の奥行きの尤度により、仮想視点の画像の画素mvの色I(mv)を加重平均により求める。仮想視点とカメラC1とカメラC2の距離の比率をα:(1−α)(0<α<1)とし、尤度をL(Dm1):L(Dm2)とすると、

【0073】

【数23】

【0074】

【数24】

【0075】

【数25】

【0076】

但し、L(Dm1)、L(Dm2)は、カメラC1、カメラC2の画像の画素m1、m2について、奥行き推定時に計算した尤度である。また、距離の比率と尤度の比率を加算によりw1とw2を求めたが、どちらか一方のみを利用することや、比率を掛け算することで求めてもよい。

【0077】

ここで、図9A及び図9Bは、本実施形態による、3Dワーピング法について説明するための概念図である。式(4)により画素を奥行きに応じて射影した際に、図9に示すように異なる点Pと点Qが仮想視点カメラCvから見ると、一直線上に存在する場合がある。このときは、点Pと点QについてカメラCvの座標系における奥行きが小さい方の点Pが仮想カメラCvから見える。例えば、カメラC1から見える点PとカメラC2から見える点Qについて、カメラCvの座標系での奥行きがそれぞれDv(P)、Dv(Q)としたときに、(Dv(Q)−Dv(P))>δとすると、

【0078】

【数26】

【0079】

となる。但し、δは閾値のパラメータであり、事前に予備実験により決める。閾値δ以下の場合には、数式(21)により色を混合する。

【0080】

次に、本発明の実施形態である仮想視点画像合成装置100の効果について説明する。

【0081】

従来手法では、対応付けが困難な領域(画素)について、同一セグメント内の画素の奥行き情報を用いて補正を行っていた。従来手法では、他にも、前景や、背景というように被写体の奥行きが2値であることを前提に、対応付けが困難な画素と類似した色の被写体(前景もしくは背景)の奥行き情報を用いた補正も行っていた。

【0082】

しかし、前者の手法では、同一セグメント内の大部分の画素の奥行き推定精度が高くないと、正しく補正が行えない。つまり、テクスチャが少ない領域やオクルージョンの影響を受ける領域が広範囲な場合には、奥行き推定誤差が大きくなる可能性がある。また、同一の被写体が同一のセグメントになることが前提となるが、高精度に画像をセグメンテーションすることが難しい。

【0083】

後者の手法では、被写体が前景又は背景に存在している、つまり、奥行きは、2段階で近似することを前提としている。しかし、仮想視点画像合成では、奥行きの値は、多値であるため適用が難しい。また、後者の手法は、色情報を基にして背景と前景とを分離するものである。しかし、前景と背景に類似した色がある場合には、分離が困難となる。

【0084】

一方、上述した仮想視点画像合成装置100によれば、画像間の対応付けが困難な場合であっても奥行き推定誤差を抑制することが可能である。そのため、このような場合であっても高品質な仮想視点画像を合成できる。これにより、被写体のパーツ(顔、足、手など)にアーティファクトが生じることを防止し、合成画像の品質を向上させることが可能となる。

【0085】

なお、画像間の対応付けが困難な場合とは、例えば、テクスチャが少ない領域が広範囲である場合や、オクルージョンの影響を受ける領域が広範囲な場合である。また、被写体の境界付近に、被写体と類似した色を持つ別の被写体が存在する場合も、画像間の対応付けが困難であった。また、被写体のパーツに生じるアーティファクトとは、例えばパーツの一部が欠損してしまった画像や、パーツの一部が拡大又は縮小されてしまった画像のことである。

【0086】

<変形例>

補正対象画素を選択する処理は、上述したものに限定される必要は無い。例えば、注目画素周辺にテクスチャが少ない場合に、その注目画素を補正対象画素として選択しても良い。例えば、注目画素周辺に繰り返しテクスチャがある場合に、その注目画素を補正対象画素として選択しても良い。例えば、注目画素周辺がオクルージョンの影響を受けている場合に、その注目画素を補正対象画素として選択しても良い。例えば、テクスチャが少ないか否かについては、以下のような手法によって判定することができる。まず、注目画像に対してソーベルフィルタ(Sobel Filter:水平、垂直方向の輝度値の微分フィルタ)を適用する。そして、画素毎にフィルタ後の値をエッジ強度として使用し、エッジ強度に基づいてテクスチャが多いか少ないかの判定が可能である。

【0087】

以上、この発明の実施形態について図面を参照して詳述してきたが、具体的な構成はこの実施形態に限られるものではなく、この発明の要旨を逸脱しない範囲の設計等も含まれる。

【符号の説明】

【0088】

100…仮想視点画像合成装置, 101…被写体撮影部, 102…カメラ画像取得部, 103…カメラパラメータ入力部, 104…奥行き推定部, 105…仮想視点位置入力部, 106…仮想視点位置決定部, 107…画像データ記憶部, 107a…カメラ画像・カメラパラメータ記憶部, 107b…奥行き記憶部, 107c…合成画像記憶部, 108…画像合成部, 109…合成画像出力部, 110…合成画像表示部

【特許請求の範囲】

【請求項1】

複数の異なる視点から被写体を撮影した多視点画像に基づいて、任意の仮想視点位置から見た前記被写体の画像を合成する画像処理方法であって、

ステレオマッチング法により、前記多視点画像に対して、各画素の奥行きに対する尤度を算出する第1のステップと、

前記第1のステップで求めた尤度に基づいて、個々の画素の奥行きを推定する第2のステップと、

奥行きの推定精度が高いと推定されるための条件を満たす高精度推定画素の奥行き推定結果を用いて、画像特徴から奥行きに対する尤度を推定するための推定関数を算出する第3のステップと、

奥行きの推定精度が低いと推定されるための条件を満たす補正対象画素に対して、前記第3のステップで算出された推定関数を用いて、尤度の補正を行う第4のステップと、

前記第4のステップで行われた補正後の尤度を用いて、画像全体の奥行きを再推定する第5のステップと、

前記第5のステップで再推定した奥行きと、前記多視点画像とに基づいて、前記仮想視点位置に応じた前記被写体の画像を合成する第6のステップと

を有する画像処理方法。

【請求項2】

複数の異なる視点から被写体を撮影した多視点画像に基づいて、任意の仮想視点位置から見た前記被写体の画像を合成する画像処理装置であって、

ステレオマッチング法により、前記多視点画像に対して、各画素の奥行きに対する尤度を算出する尤度算出部と、

前記尤度算出部で求めた尤度に基づいて、個々の画素の奥行きを推定する奥行き推定部と、

奥行きの推定精度が高いと推定されるための条件を満たす高精度推定画素の奥行き推定結果を用いて、画像特徴から奥行きに対する尤度を推定するための推定関数を算出する尤度推定関数算出部と、

奥行きの推定精度が低いと推定されるための条件を満たす補正対象画素に対して、前記尤度推定関数算出部で算出された推定関数を用いて、尤度の補正を行う尤度補正部と、

前記尤度補正部で行われた補正後の尤度を用いて、画像全体の奥行きを再推定する奥行き再推定部と、

前記奥行き再推定部により再推定された奥行きと、前記多視点画像とに基づいて、前記仮想視点位置に応じた前記被写体の画像を合成する画像合成部と

を備えることを特徴とする画像処理装置。

【請求項3】

複数の異なる視点から被写体を撮影した多視点画像に基づいて、任意の仮想視点位置から見た前記被写体の画像を合成する画像処理装置のコンピュータに、

ステレオマッチング法により、前記多視点画像に対して、各画素の奥行きに対する尤度を算出する尤度算出ステップと、

前記尤度算出ステップで求めた尤度に基づいて、個々の画素の奥行きを推定する奥行き推定ステップと、

奥行きの推定精度が高いと推定されるための条件を満たす高精度推定画素の奥行き推定結果を用いて、画像特徴から奥行きに対する尤度を推定するための推定関数を算出する尤度推定関数算出ステップと、

奥行きの推定精度が低いと推定されるための条件を満たす補正対象画素に対して、前記尤度推定関数算出ステップで算出された推定関数を用いて、尤度の補正を行う尤度補正ステップと、

前記尤度補正ステップで行われた補正後の尤度を用いて、画像全体の奥行きを再推定する奥行き再推定ステップと、

前記奥行き再推定ステップで再推定された奥行きと、多視点画像とに基づいて、前記仮想視点位置に応じた前記被写体の画像を合成する画像合成ステップと

を実行させるためのコンピュータプログラム。

【請求項1】

複数の異なる視点から被写体を撮影した多視点画像に基づいて、任意の仮想視点位置から見た前記被写体の画像を合成する画像処理方法であって、

ステレオマッチング法により、前記多視点画像に対して、各画素の奥行きに対する尤度を算出する第1のステップと、

前記第1のステップで求めた尤度に基づいて、個々の画素の奥行きを推定する第2のステップと、

奥行きの推定精度が高いと推定されるための条件を満たす高精度推定画素の奥行き推定結果を用いて、画像特徴から奥行きに対する尤度を推定するための推定関数を算出する第3のステップと、

奥行きの推定精度が低いと推定されるための条件を満たす補正対象画素に対して、前記第3のステップで算出された推定関数を用いて、尤度の補正を行う第4のステップと、

前記第4のステップで行われた補正後の尤度を用いて、画像全体の奥行きを再推定する第5のステップと、

前記第5のステップで再推定した奥行きと、前記多視点画像とに基づいて、前記仮想視点位置に応じた前記被写体の画像を合成する第6のステップと

を有する画像処理方法。

【請求項2】

複数の異なる視点から被写体を撮影した多視点画像に基づいて、任意の仮想視点位置から見た前記被写体の画像を合成する画像処理装置であって、

ステレオマッチング法により、前記多視点画像に対して、各画素の奥行きに対する尤度を算出する尤度算出部と、

前記尤度算出部で求めた尤度に基づいて、個々の画素の奥行きを推定する奥行き推定部と、

奥行きの推定精度が高いと推定されるための条件を満たす高精度推定画素の奥行き推定結果を用いて、画像特徴から奥行きに対する尤度を推定するための推定関数を算出する尤度推定関数算出部と、

奥行きの推定精度が低いと推定されるための条件を満たす補正対象画素に対して、前記尤度推定関数算出部で算出された推定関数を用いて、尤度の補正を行う尤度補正部と、

前記尤度補正部で行われた補正後の尤度を用いて、画像全体の奥行きを再推定する奥行き再推定部と、

前記奥行き再推定部により再推定された奥行きと、前記多視点画像とに基づいて、前記仮想視点位置に応じた前記被写体の画像を合成する画像合成部と

を備えることを特徴とする画像処理装置。

【請求項3】

複数の異なる視点から被写体を撮影した多視点画像に基づいて、任意の仮想視点位置から見た前記被写体の画像を合成する画像処理装置のコンピュータに、

ステレオマッチング法により、前記多視点画像に対して、各画素の奥行きに対する尤度を算出する尤度算出ステップと、

前記尤度算出ステップで求めた尤度に基づいて、個々の画素の奥行きを推定する奥行き推定ステップと、

奥行きの推定精度が高いと推定されるための条件を満たす高精度推定画素の奥行き推定結果を用いて、画像特徴から奥行きに対する尤度を推定するための推定関数を算出する尤度推定関数算出ステップと、

奥行きの推定精度が低いと推定されるための条件を満たす補正対象画素に対して、前記尤度推定関数算出ステップで算出された推定関数を用いて、尤度の補正を行う尤度補正ステップと、

前記尤度補正ステップで行われた補正後の尤度を用いて、画像全体の奥行きを再推定する奥行き再推定ステップと、

前記奥行き再推定ステップで再推定された奥行きと、多視点画像とに基づいて、前記仮想視点位置に応じた前記被写体の画像を合成する画像合成ステップと

を実行させるためのコンピュータプログラム。

【図1】

【図2】

【図3】

【図5】

【図6】

【図8】

【図9】

【図10】

【図11】

【図12】

【図4】

【図7】

【図2】

【図3】

【図5】

【図6】

【図8】

【図9】

【図10】

【図11】

【図12】

【図4】

【図7】

【公開番号】特開2013−12045(P2013−12045A)

【公開日】平成25年1月17日(2013.1.17)

【国際特許分類】

【出願番号】特願2011−144417(P2011−144417)

【出願日】平成23年6月29日(2011.6.29)

【出願人】(000004226)日本電信電話株式会社 (13,992)

【Fターム(参考)】

【公開日】平成25年1月17日(2013.1.17)

【国際特許分類】

【出願日】平成23年6月29日(2011.6.29)

【出願人】(000004226)日本電信電話株式会社 (13,992)

【Fターム(参考)】

[ Back to top ]