画像処理装置および方法、並びにプログラム

【課題】より高速かつ高精度にハンドジェスチャを認識できるようにする。

【解決手段】手形状認識部は、入力画像に対する手形状認識を行なって、入力画像から特定形状の手を検出する。手検出情報保持部は、手の検出結果により得られる手の形状、大きさ、および位置と、手の色情報とからなる手検出情報を保持する。判定領域設定部は、手検出情報に基づいて、検出された手近傍の領域に判定領域を設定する。ジェスチャ認識部は、入力画像上の設定された判定領域を監視して、ユーザの手が判定領域内に移動した場合に、ジェスチャが行なわれたと判定する。本発明は、画像処理装置に適用することができる。

【解決手段】手形状認識部は、入力画像に対する手形状認識を行なって、入力画像から特定形状の手を検出する。手検出情報保持部は、手の検出結果により得られる手の形状、大きさ、および位置と、手の色情報とからなる手検出情報を保持する。判定領域設定部は、手検出情報に基づいて、検出された手近傍の領域に判定領域を設定する。ジェスチャ認識部は、入力画像上の設定された判定領域を監視して、ユーザの手が判定領域内に移動した場合に、ジェスチャが行なわれたと判定する。本発明は、画像処理装置に適用することができる。

【発明の詳細な説明】

【技術分野】

【0001】

本技術は画像処理装置および方法、並びにプログラムに関し、特に、より高速かつ高精度にハンドジェスチャを認識することができるようにした画像処理装置および方法、並びにプログラムに関する。

【背景技術】

【0002】

従来、ユーザが手で予め定められたジェスチャを行なうと、そのジェスチャ(手の動き)に応じた処理を行なう技術が知られている。

【0003】

このような技術では、ユーザのジェスチャの認識が必要となるが、ジェスチャの認識方法として、画像上の特定の色の領域や動被写体の領域を利用する方法が提案されている(例えば、特許文献1および特許文献2参照)。例えば、特定色の領域を利用する方法では、画像から手の色が抽出され、その色の領域の動きに基づいてジェスチャが認識される。また、動被写体の領域を利用する方法では、画像のフレーム間の差分から動きのある領域が特定され、その領域の動きに基づいてジェスチャが認識される。

【先行技術文献】

【特許文献】

【0004】

【特許文献1】特開平08−315154号公報

【特許文献2】特開2008−52590号公報

【発明の概要】

【発明が解決しようとする課題】

【0005】

しかしながら、上述した技術では、高速かつ高精度にユーザのジェスチャを認識することができなかった。

【0006】

例えば、特定色の領域や動被写体の領域を利用する方法では、画像全体を監視対象とし、ユーザの手のジェスチャを認識する必要があるため、処理量が多くなりジェスチャ認識に時間がかかるだけでなく、ジェスチャの認識精度も低下してしまう。また、ジェスチャの認識精度を少しでも高くするためには、ユーザが大きく手を動かさなければならなかった。

【0007】

さらに、動被写体の領域を利用したジェスチャ認識では、ユーザの手以外に動きのある被写体がある場合など、ユーザの周囲の環境によっては誤認識が生じる恐れがあった。

【0008】

本技術は、このような状況に鑑みてなされたものであり、より高速かつ高精度にジェスチャを認識することができるようにするものである。

【課題を解決するための手段】

【0009】

本技術の一側面の画像処理装置は、入力画像に対する手形状認識を行って、前記入力画像における特定形状の手の位置と大きさを検出する手形状認識部と、前記手の位置および大きさに基づいて、前記入力画像上の前記手近傍の領域を、前記手を用いたジェスチャの認識の判定領域として設定する判定領域設定部と、前記手の前記判定領域への移動を監視することで、前記ジェスチャを認識するジェスチャ認識部とを備える。

【0010】

前記判定領域設定部には、前記入力画像上の前記手近傍に複数の前記判定領域を設定させることができる。

【0011】

複数の前記判定領域のそれぞれを、互いに異なる前記ジェスチャを認識するための領域とすることができる。

【0012】

画像処理装置には、前記ジェスチャの認識結果に応じた処理を行う処理部をさらに設けることができる。

【0013】

前記ジェスチャ認識部には、検出された前記手の領域から抽出された色と、前記入力画像上の前記判定領域の色とを比較させることで、前記ジェスチャを認識させることができる。

【0014】

前記ジェスチャ認識部には、前記入力画像のフレーム間の差分に基づいて前記手の前記判定領域への移動を監視させ、前記ジェスチャを認識させることができる。

【0015】

前記手形状認識部には、予め定められた複数の形状の手の位置と大きさの検出を行なわせることができる。

【0016】

前記判定領域設定部には、新たに特定形状の前記手の位置と大きさが検出された場合、新たに検出された前記手の形状、位置、および大きさに基づいて前記判定領域を設定させることができる。

【0017】

本技術の一側面の画像処理方法またはプログラムは、入力画像に対する手形状認識を行って、前記入力画像における特定形状の手の位置と大きさを検出し、前記手の位置および大きさに基づいて、前記入力画像上の前記手近傍の領域を、前記手を用いたジェスチャの認識の判定領域として設定し、前記手の前記判定領域への移動を監視することで、前記ジェスチャを認識するステップを含む。

【0018】

本技術の一側面においては、入力画像に対する手形状認識が行われて、前記入力画像における特定形状の手の位置と大きさが検出され、前記手の位置および大きさに基づいて、前記入力画像上の前記手近傍の領域が、前記手を用いたジェスチャの認識の判定領域として設定され、前記手の前記判定領域への移動を監視することで、前記ジェスチャが認識される。

【発明の効果】

【0019】

本技術の一側面によれば、より高速かつ高精度にジェスチャを認識することができる。

【図面の簡単な説明】

【0020】

【図1】本技術の概要を説明する図である。

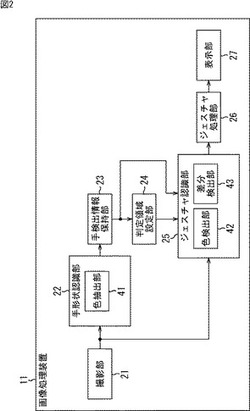

【図2】画像処理装置の構成例を示す図である。

【図3】ジェスチャ認識処理を説明するフローチャートである。

【図4】判定領域監視処理を説明するフローチャートである。

【図5】ジェスチャ認識処理を説明するフローチャートである。

【図6】画像処理装置の他の構成例を示す図である。

【図7】判定領域監視処理を説明するフローチャートである。

【図8】画像処理装置の他の構成例を示す図である。

【図9】判定領域監視処理を説明するフローチャートである。

【図10】手形状とジェスチャについて説明する図である。

【図11】画像処理装置の他の構成例を示す図である。

【図12】ジェスチャ認識処理を説明するフローチャートである。

【図13】ジェスチャ認識処理を説明するフローチャートである。

【図14】画像処理装置の他の構成例を示す図である。

【図15】画像処理装置の他の構成例を示す図である。

【図16】画像処理装置の他の構成例を示す図である。

【図17】ジェスチャ認識処理を説明するフローチャートである。

【図18】コンピュータの構成例を示す図である。

【発明を実施するための形態】

【0021】

以下、図面を参照して、本技術を適用した実施の形態について説明する。

【0022】

〈第1の実施の形態〉

[本技術の概要]

まず、図1を参照して本技術の概要について説明する。本技術は、ユーザによるハンドジェスチャ(以下、単にジェスチャと称する)を認識し、認識されたジェスチャに応じた処理を行うためのものである。

【0023】

以下では、いわゆるパー形状の手、つまり全ての指が開かれた状態の手が認識された状態から、ユーザが手を左右のどちらかの方向に動かす動作を認識対象のジェスチャとする場合を例として、説明を続ける。

【0024】

ジェスチャ認識では、ユーザの手を含む入力画像が撮影され、得られた入力画像から手形状認識により、予め定められた形状の手が検出される。ここでは、例えば図1の左側に示すように、パー形状の手H11が検出される。

【0025】

パー形状のユーザの手H11が検出されると、次に検出されたユーザの手H11の位置と大きさに基づいて、ユーザにより行なわれるジェスチャを認識するために監視される判定領域DR11−1と判定領域DR11−2が定められる。

【0026】

例えば、ユーザの手H11が検出されると、その手H11の中心位置C11が求まるので、中心位置C11から図中、左方向に手H11の幅の半分の距離だけ離れた位置を中心とする、所定の大きさの矩形領域が判定領域DR11−1とされる。同様に、中心位置C11から図中、右方向に手H11の幅の半分の距離だけ離れた位置を中心とする、所定の大きさの矩形領域が判定領域DR11−2とされる。なお、以下、判定領域DR11−1と判定領域DR11−2を特に区別する必要のない場合、単に判定領域DR11とも称する。

【0027】

このようにしてユーザがパー形状の手H11を認識させると、ユーザは、その状態から手を右または左に動かす。例えば、図中、右側に示すようにユーザが手H11を右方向に動かして、その手H11が判定領域DR11−2に到達(移動)すると、ユーザによりジェスチャが行なわれたと認識される。

【0028】

このように、本技術では、特定形状のユーザの手が検出され、その検出結果により定まる、ユーザの手近傍の位置が判定領域として設定される。そして、ユーザの手が設定した判定領域に到達すると、ジェスチャが行なわれたと認識される。

【0029】

本技術では手形状認識により特定形状のユーザの手を検出するので、その手の形状や大きさと認識対象のジェスチャに応じて、適切な位置に適切な大きさの判定領域を設定することができる。したがって、判定領域だけを監視対象とすればよいので、少ない処理で高速かつ高精度にジェスチャ認識を行なうことができる。

【0030】

[画像処理装置の構成例]

図2は、本技術を適用した画像処理装置の一実施の形態の構成例を示す図である。

【0031】

画像処理装置11は、撮影部21、手形状認識部22、手検出情報保持部23、判定領域設定部24、ジェスチャ認識部25、ジェスチャ処理部26、および表示部27から構成される。

【0032】

撮影部21は、画像処理装置11の周囲、例えば表示部27を正面から観察するユーザの画像を入力画像として撮影し、手形状認識部22およびジェスチャ認識部25に供給する。手形状認識部22は、撮影部21から供給された入力画像に基づいて手形状認識を行い、入力画像から特定形状の手の領域を検出する。

【0033】

また、手形状認識部22は色抽出部41を備えており、色抽出部41は、入力画像からの手の検出結果に基づいて、入力画像の手の領域の色情報を抽出する。手形状認識部22は、手形状認識の結果と色情報とを手検出情報保持部23に供給する。

【0034】

手検出情報保持部23は、手形状認識部22から供給された手形状認識の結果と色情報を手検出情報として保持し、必要に応じて判定領域設定部24およびジェスチャ認識部25に供給する。判定領域設定部24は、手検出情報保持部23に保持されている手検出情報に基づいて判定領域を設定し、ジェスチャ認識部25に供給する。

【0035】

ジェスチャ認識部25は、撮影部21からの入力画像、手検出情報保持部23からの手検出情報、および判定領域設定部24からの判定領域に基づいてユーザのジェスチャを認識し、その認識結果をジェスチャ処理部26に供給する。

【0036】

ジェスチャ認識部25は、色検出部42および差分検出部43を備えている。色検出部42は、入力画像上の色情報により示される色の領域の判定領域内への移動を監視することで、ユーザのジェスチャを検出する。また、差分検出部43は、入力画像のフレーム間の差分を求めることで、入力画像上の動被写体の判定領域への移動を監視することで、ユーザのジェスチャを検出する。

【0037】

ジェスチャ処理部26は、ジェスチャ認識部25から供給されたジェスチャの認識結果に応じた処理を行い、必要に応じて表示部27に画像を表示させる。表示部27は、ジェスチャ処理部26の制御にしたがって画像を表示する。

【0038】

例えば、表示部27には、ジェスチャの認識結果そのものが表示されてもよいし、表示部27に表示される番組のチャンネルがジェスチャの認識結果に応じて変更され、変更後のチャンネルの番組が表示部27に表示されるようにしてもよい。

【0039】

[手形状認識について]

ところで、手形状認識部22による手形状認識は、入力画像から特定形状の手を認識することができれば、どのような手形状認識方法であってもよい。手形状認識の処理として、様々な方法が知られているが、以下では手形状認識の処理として、統計学習により得られた、特定形状の手を認識するための辞書が用いられることとして説明を続ける。

【0040】

手形状認識用の辞書には、特定形状の手を認識するために用いられるフィルタの種類と、フィルタを用いて特徴量を抽出する特徴点とを示す情報などが含まれている。例えば、特定形状の手の認識用のフィルタとして、異なる角度や微分値のレクタングルフィルタを示す情報が辞書に含まれている。

【0041】

このような辞書に基づいて入力画像の各領域に対してフィルタ処理を行なって特徴量を抽出すると、領域ごとに特定形状の手らしさを示すスコアが得られるので、所定の閾値以上となる最も高いスコアの領域が特定形状の手が含まれている領域として検出される。このような手形状認識では、特定形状の手の認識結果として、入力画像上で認識された手の形状、手の大きさ、および手の位置(手の領域)を示す情報が得られる。

【0042】

なお、より詳細には、入力画像の各位置の輝度を示す輝度画像が生成され、輝度画像に対してフィルタ処理が行なわれることで、入力画像から特徴量が抽出される。

【0043】

また、物体認識については例えば以下の文献に詳細に記載されている。

文献1「“Vector Boosting for Rotation Invariant Multi-View Face Detection”C. Huang, H.Z. Ai, Y. Li, and S.H. Lao,Proc. 10th IEEE Int’l Conf. Computer Vision, 2005.」

文献2「“A detector tree of boosted classifiers for real-time object detection andtracking”R.Lienhart, L.Liang, A.Kuranov,Proceedings of the 2003 International Conference on Multimedia and Expo -Volume 1」

文献3「“Multi-view face pose classification by tree-structured classifier”Zhiguang Yang; Haizhou Ai; Okamoto, T.; Shihong Lao;Image Processing, 2005. ICIP 2005. IEEE International Conference on Volume 2, 11-14 Sept. 2005 Page(s):II - 358-61」,

文献4「“A boosted classifier tree for hand shape detection”EJ Ong, R Bowden,Face and Gesture Recognition, 2004」

文献5「“Cluster Boosted Tree Classifier for Multi-View, Multi-Pose Object Detection”Bo Wu; Nevatia, R. ICCV 2007. IEEE 11th International Conference on Computer Vision, 14-21 Oct.2007 Page(s):1 8」

文献6「“Sharing visual features for multiclass and multiview object detection”A. Torralba, K. P. Murphy and W. T. Freeman,IEEE Transactions on Pattern Analysis and Machine Intelligence , vol. 29,no. 5, pp. 854-869, May, 2007」

文献7「“Fast Multi-View Face Detection”M. Jones and P. Viola,MERLTR2003-96, July 2003.」

【0044】

[ジェスチャ認識処理の説明]

また、画像処理装置11は、ユーザによりジェスチャに応じた処理の実行を指示されると、ジェスチャ認識処理を開始して、ジェスチャ認識を行なうとともに、認識されたジェスチャに応じた処理を行なう。以下、図3のフローチャートを参照して、画像処理装置11によるジェスチャ認識処理について説明する。

【0045】

ステップS11において、撮影部21は、ユーザを被写体とする入力画像の撮影を開始し、撮影により得られた各フレームの入力画像を順次手形状認識部22およびジェスチャ認識部25に供給する。

【0046】

ステップS12において、手形状認識部22は、撮影部21から供給された入力画像に基づいて、手形状認識を行なう。例えば、手形状認識部22は、予め記録している、パー形状の手を認識するための辞書を用いて入力画像から特徴量を抽出し、入力画像からパー形状の手の領域を検出する。

【0047】

ステップS13において、手形状認識部22は、処理対象のフレームの入力画像から特定形状の手が検出されたか否かを判定する。ステップS13において、特定形状の手が検出されなかったと判定された場合、ステップS14において、手形状認識部22は、既に手が検出されているか否かを判定する。

【0048】

例えば、処理対象のフレームよりも過去のフレームの入力画像から、特定形状の手が検出されたことがあり、既に手検出情報保持部23に手検出情報が保持されている場合、既に特定形状の手が検出されていると判定される。

【0049】

ステップS14において、まだ特定形状の手が検出されていない、つまり入力画像から一度も特定形状の手が検出されていないと判定された場合、処理はステップS12に戻り、上述した処理が繰り返される。

【0050】

これに対して、ステップS14において、既に特定形状の手が検出されていると判定された場合、既に手検出情報保持部23に手検出情報が保持されており、ジェスチャ認識が可能であるので、処理はステップS17に進む。

【0051】

また、ステップS13において、特定形状の手が検出されたと判定された場合、ステップS15において、手検出情報保持部23は、手検出情報を保持する。

【0052】

すなわち、手形状認識により特定形状の手が検出されると、手形状認識の結果として、認識された手の形状、手の大きさ、および手の位置を示す情報が得られる。すると、これらの情報から入力画像上のおおよその手の領域が分かるので、色抽出部41は、例えば入力画像上の手の領域のうち、手のほぼ中央の領域の色を検出されたユーザの手の色とし、その色を示す色情報を生成する。

【0053】

手形状認識部22は、このようにして得られた手の形状、手の大きさ、および手の位置を示す情報と、色情報とを手検出情報として手検出情報保持部23に供給する。そして、手検出情報保持部23は、手形状認識部22から供給された手検出情報を保持する。

【0054】

なお、入力画像上の肌色の領域が検出されたり、ユーザによる指定操作が行なわれたりして、予めユーザの手形状とその手の領域が分かっている場合には、入力画像の撮影開始後、ステップS12およびステップS13の処理が行なわれずに、ステップS15の処理が行なわれ、手検出情報が保持されるようにしてもよい。

【0055】

ステップS16において、判定領域設定部24は、手検出情報保持部23に保持されている手検出情報に基づいて、判定領域を定める。

【0056】

例えば、手形状認識でパー形状の手が認識され、図1を参照して説明したジェスチャが認識対象のジェスチャとされているとする。また、図1中、右方向を+x方向とし、上方向を+y方向であるとして、xy座標系における手H11の中心位置C11と、手H11の幅および高さが手検出情報として保持されているとする。

【0057】

ここで、例えば中心位置C11が座標(Cx,Cy)であるとする。また、手H11の幅、つまり手H11のx方向の長さがHwであり、手H11の高さ、つまり手H11のy方向の長さがHhであるとする。この例では、中心位置C11の座標(Cx,Cy)が手検出情報に含まれる手の位置を示す情報であり、手H11の幅Hwと高さHhが手検出情報に含まれる手の大きさを示す情報である。

【0058】

このような場合、判定領域設定部24は、手検出情報に基づいて、判定領域DR11−1となる矩形領域の左下の頂点SLのxy座標系における座標(SLx,SLy)を求める。例えば、(SLx,SLy)=(Cx−Hw/α,Cy−Hh/β)とされる。ここで、αとβは任意の定数である。

【0059】

また、判定領域設定部24は、判定領域DR11−1となる矩形領域の右上の頂点ELのxy座標系における座標(ELx,ELy)を求める。例えば、任意の定数をγとして(ELx,ELy)=(SLx+γ,SLy+γ)とされる。このようにして定められた頂点SLと頂点ELにより、判定領域DR11−1が特定されることになる。

【0060】

同様にして、判定領域設定部24は、手検出情報に基づいて、判定領域DR11−2となる矩形領域の左下の頂点SRの座標(SRx,SRy)と右上の頂点ERの座標(ERx,ERy)を求める。例えば、(SRx,SRy)=(Cx+Hw/α,Cy−Hh/β)とされ、(ERx,ERy)=(SRx+γ,SRy+γ)とされる。

【0061】

このように、判定領域DR11の位置を決定付ける定数α,βや、判定領域DR11の大きさを決定付ける定数γは、認識対象のジェスチャに応じて任意に設定される。一般的には、ハンドジェスチャの認識を簡単かつ確実に行なうことができるように、認識された手近傍の領域が判定領域とされる。

【0062】

例えば、図1の例では、認識対象のジェスチャは、パー形状の手を認識させた状態から、ユーザが手H11を図中、右または左の何れかの方向に移動させるジェスチャである。そのため、この例では、判定領域DR11は、手H11の左右の方向に対して、手H11の大きさ(幅)により定められる距離だけ離れた位置に設定される。

【0063】

判定領域DR11−1は、ユーザが図1中、手H11を左方向に移動させるジェスチャを認識するための監視対象の領域であり、判定領域DR11−2は、ユーザが図1中、手H11を右方向に移動させるジェスチャを認識するための監視対象の領域である。これらの2つのジェスチャの何れかが認識された場合、ジェスチャに応じて同じ処理が行なわれるようにしてもよいし、ジェスチャの方向によって異なる処理が行なわれるようにしてもよい。

【0064】

手形状認識により手の形状や位置、大きさなどが特定されれば、認識対象となるジェスチャに対して、適切に判定領域DR11を定めることができる。これにより、ジェスチャ認識時における入力画像の監視対象とする領域をより小さくすることができ、より簡単な処理で高速かつ高精度にジェスチャを認識することができるようになる。

【0065】

なお、判定領域DR11を定めるときに用いられる定数α,β,γは、ジェスチャの使用用途等によって、適切な手の検索範囲が異なることもあるため、ユーザにより設定されるようにしてもよい。また、判定領域が手の領域近傍となるように手の位置や大きさに基づいて、判定領域が定められているが、ジェスチャを使用する状況が明確な場合には、判定領域が任意の位置に指定されるようにしてもよい。

【0066】

図3のフローチャートの説明に戻り、判定領域が定められると、判定領域設定部24は判定領域をジェスチャ認識部25に供給し、処理はステップS16からステップS17に進む。

【0067】

ステップS17において、ジェスチャ認識部25は、手検出情報保持部23に保持されている手検出情報を必要に応じて参照しながら、判定領域設定部24からの判定領域と、撮影部21からの入力画像とに基づいて、判定領域監視処理を行なう。

【0068】

ここで、図4のフローチャートを参照して、ジェスチャ認識部25による判定領域監視処理を説明する。

【0069】

ステップS51において、色検出部42は、撮影部21から供給された処理対象の入力画像における判定領域内の各位置の色を特定する。そして、ステップS52において、色検出部42は、判定領域の色と、手検出情報に含まれる色情報により示されるユーザの手の色とを比較する。すなわち、判定領域の色がユーザの手の色と同じであれば、ユーザの手が判定領域内に移動してきたことになり、ジェスチャが行なわれたことが分かる。

【0070】

ステップS53において、差分検出部43は、撮影部21から供給された処理対象のフレームの入力画像と、処理対象のフレームよりも前、例えば直前のフレームの入力画像とのフレーム間の差分を求める。具体的には、それらのフレームの入力画像の同じ位置にある画素の画素値の差分絶対値が算出される。

【0071】

ステップS54において、差分検出部43は、入力画像のフレーム間の差分に基づいて、入力画像上の差分領域を特定する。ここで差分領域とは、ステップS53の処理で求められたフレーム間の差分絶対値が所定の閾値以上となる、互いに隣接する画素からなる領域である。フレーム間の差分絶対値が大きい領域は、動きのある被写体(動被写体)の領域であるので、このような動被写体はユーザの手である可能性が高い。

【0072】

そこで、差分検出部43は、入力画像上の動被写体の領域を差分領域として検出し、判定領域が差分領域内に含まれるかを監視することで、ユーザのジェスチャを認識する。すなわち、ユーザの手が移動されると、手の領域は差分領域となるので、この差分領域が判定領域に到達した場合、ユーザの手が判定領域内に移動してきたことになり、ジェスチャが行なわれたことが分かる。

【0073】

このようにして、ユーザの手の色と、入力画像の差分情報とにより判定領域へのユーザの手の移動の有無の検出が行なわれると、判定領域監視処理は終了し、その後、処理は図3のステップS18に進む。

【0074】

ステップS18において、ジェスチャ認識部25は、色情報により示される色と判定領域の色の比較結果と、差分領域の特定結果とに基づいて、ユーザによりジェスチャが行なわれたか否かを判定する。

【0075】

例えば、判定領域の色が色情報により示されるユーザの手の色であり、かつ判定領域の一部または全部が差分領域内に含まれる場合、ユーザによりジェスチャが行なわれたと判定される。

【0076】

なお、判定領域の色が色情報により示されるユーザの手の色であるか、または判定領域の一部若しくは全部が差分領域内に含まれているかの少なくとも何れかの状態となった場合に、ユーザによりジェスチャが行なわれたと判定されるようにしてもよい。

【0077】

ステップS18において、ジェスチャが行なわれていないと判定された場合、処理はステップS12に戻り、上述した処理が繰り返される。すなわち、次のフレームが処理対象のフレームとされて、新たな処理対象のフレームの入力画像に対して、手形状認識とジェスチャ認識が行なわれる。

【0078】

なお、ユーザの手が移動している状態では、ユーザの手形状が変化するため、入力画像から特定形状(例えば、パー形状)の手が検出されることはなく、手検出情報の更新も行なわれない。これに対して、ユーザが再度、手形状を認識させようとして、撮影部21に対して特定形状の手をかざすと、手形状認識で手が検出されて手検出情報が更新され、これにより新たな判定領域が設定される。

【0079】

また、ステップS18において、ジェスチャが行なわれた判定された場合、ジェスチャ認識部25は、ジェスチャの認識結果をジェスチャ処理部26に供給し、処理はステップS19に進む。例えば、ジェスチャ認識部25は、ユーザの手をパー形状の状態から図1の判定領域DR11−1まで移動させるジェスチャが行なわれた旨のジェスチャ認識結果をジェスチャ処理部26に供給する。

【0080】

ステップS19において、ジェスチャ処理部26は、ジェスチャ認識部25からのジェスチャ認識結果に応じた処理を行なう。例えば、ジェスチャ処理部26は、ジェスチャの認識結果を示す画像を表示部27に供給して表示させたり、ジェスチャに応じて表示部27に表示する番組のチャンネルを変更したりする。

【0081】

ステップS20において、画像処理装置11は、処理を終了するか否かを判定する。例えば、ユーザによりジェスチャ認識に応じた処理の実行の終了が指示された場合、処理を終了すると判定される。

【0082】

ステップS20において、処理を終了しないと判定された場合、処理はステップS12に戻り、上述した処理が繰り返される。すなわち、新たなジェスチャの認識が行なわれる。

【0083】

これに対してステップS20において、処理を終了すると判定された場合、画像処理装置11は各部の処理を停止させ、ジェスチャ認識処理は終了する。

【0084】

以上のようにして、画像処理装置11は、入力画像から特定形状の手を検出し、その検出結果に基づいて判定領域を設定して、判定領域への手の移動を監視することで、ユーザのジェスチャを認識する。

【0085】

このように、手形状の検出結果に基づいて判定領域を設定することで、ジェスチャごとに適切な判定領域を定めることができ、より高速かつ高精度にジェスチャを認識することができる。また、入力画像の解像度によらず、安定した速度でジェスチャ認識可能である。

【0086】

しかも、手が認識されるごとにユーザの手の色が抽出されて、その色情報が手検出情報として保持されるとともに、ジェスチャ認識時には、手の領域近傍のみが監視対象とされる。したがって、照明条件が変化して入力画像上のユーザの手の色が変化したり、入力画像の背景に手の色と類似する色の被写体がある場合でも、高精度に手の領域を特定することができ、ジェスチャの認識精度をさらに向上させることができる。

【0087】

また、特定形状の手が検出された後は、その検出結果に基づいて設定された判定領域の監視によりジェスチャ認識が行なわれるため、ユーザの手形状によらずジェスチャを認識することができる。つまり、ユーザは、同じ手形状のままジェスチャを行なう必要がなくなり、簡単なジェスチャで操作入力を行なうことができる。

【0088】

〈変形例1〉

[ジェスチャ認識処理の説明]

なお、以上においては、ジェスチャ認識処理において、入力画像の撮影開始後、手形状認識とジェスチャ認識とが常に継続して行なわれる場合について説明したが、手形状認識により手が検出された後、一定期間はジェスチャ認識のみが行なわれるようにしてもよい。すなわち、手形状認識により手が検出されると、その後、ジェスチャが認識されるまでジェスチャ認識のみが継続して行なわれ、一定期間が経過してもジェスチャが認識されなかった場合に、再び手形状認識が行なわれる。

【0089】

そのような場合、画像処理装置11は、図5に示すジェスチャ認識処理を行なう。以下、図5のフローチャートを参照して、画像処理装置11によるジェスチャ認識処理について説明する。

【0090】

なお、ステップS81およびステップS82の処理は図3のステップS11およびステップS12の処理と同様であるため、その説明は省略する。

【0091】

ステップS83において、手形状認識部22は、処理対象のフレームの入力画像から特定形状の手が検出されたか否かを判定する。ステップS83において、特定形状の手が検出されなかったと判定された場合、処理はステップS82に戻り、上述した処理が繰り返される。すなわち、特定形状の手が検出されるまで、手形状認識が繰り返し行なわれる。

【0092】

これに対して、ステップS83において、特定形状の手が検出されたと判定された場合、その後、ステップS84乃至ステップS87の処理が行なわれる。なお、これらの処理は図3のステップS15乃至ステップS18の処理と同様であるので、その説明は省略する。

【0093】

また、ステップS87において、ジェスチャが行なわれなかったと判定された場合、ステップS90において、ジェスチャ認識部25は、手形状認識により特定形状の手が認識されてから一定期間、ジェスチャが認識されなかったか否かを判定する。

【0094】

ステップS90において、一定期間、ジェスチャが認識されなかったと判定された場合、処理はステップS82に戻り、上述した処理が繰り返される。つまり、新たに手形状認識が行なわれて、その結果得られた情報に基づいてジェスチャ認識が行なわれる。

【0095】

一方、ステップS90において、一定期間、ジェスチャが認識されなかったと判定されなかった場合、つまりジェスチャ認識が開始されてからまだ一定期間経過していない場合、処理はステップS86に戻り、上述した処理が繰り返される。すなわち、継続してジェスチャ認識が行なわれる。

【0096】

また、ステップS87においてジェスチャが行なわれたと判定された場合、その後ステップS88およびステップS89の処理が行なわれてジェスチャ認識処理は終了するが、これらの処理は図3のステップS19およびステップS20と同様であるので、その説明は省略する。

【0097】

以上のようにして画像処理装置11は、入力画像から特定形状の手を検出し、その検出結果に基づいてユーザのジェスチャを認識する。

【0098】

〈第2の実施の形態〉

[画像処理装置の構成例]

なお、以上においては、ユーザの手の色と入力画像の差分情報を用いてジェスチャ認識を行なうと説明したが、ユーザの手の色のみを用いてジェスチャ認識を行なうようにしてもよい。そのような場合、画像処理装置は、図6に示すように構成される。なお、図6において、図2における場合と対応する部分には同一の符号を付してあり、その説明は適宜省略する。

【0099】

図6の画像処理装置71は、撮影部21乃至表示部27から構成される。この画像処理装置71の構成は、ジェスチャ認識部25に差分検出部43が設けられていない点で画像処理装置11と異なり、その他の点では画像処理装置11と同じとなっている。

【0100】

[判定領域監視処理の説明]

また、画像処理装置71も図3を参照して説明したジェスチャ認識処理と同様の処理を行なう、但し、ステップS17の判定領域監視処理では、ユーザの手の色の領域が判定領域に移動したかが監視される。

【0101】

以下、図7のフローチャートを参照して、画像処理装置71により行なわれる図3のジェスチャ認識処理のステップS17の処理に対応する判定領域監視処理について説明する。

【0102】

ステップS121において、色検出部42は、撮影部21から供給された処理対象の入力画像における判定領域内の各位置の色を特定する。そして、ステップS122において、色検出部42は、判定領域の色と、手検出情報に含まれる色情報により示されるユーザの手の色とを比較する。すなわち、判定領域の色がユーザの手の色と同じであれば、ユーザの手が判定領域内に移動してきたことになり、ジェスチャが行なわれたことが分かる。これらのステップS121およびステップS122の処理は図4のステップS51およびステップS52の処理と同様の処理である。

【0103】

ステップS122の処理が行なわれて、判定領域の色とユーザの手の色とが比較されると、判定領域監視処理は終了し、その後、処理は図3のステップS18に進む。そして、ステップS18乃至ステップS20の処理が行なわれてジェスチャ認識処理は終了する。但し、ステップS18では、判定領域の色が色情報により示されるユーザの手の色である場合、ユーザによりジェスチャが行なわれたと判定される。

【0104】

なお、画像処理装置71により図5を参照して説明したジェスチャ認識処理が行なわれるようにしてもよい。そのような場合、ステップS81乃至ステップS90では、基本的には画像処理装置11における場合と同様の処理が行なわれるが、ステップS86では、図7を参照して説明した判定領域監視処理が行なわれる。また、ステップS87では、判定領域の色が色情報により示されるユーザの手の色である場合、ユーザによりジェスチャが行なわれたと判定される。

【0105】

〈第3の実施の形態〉

[画像処理装置の構成例]

また、ジェスチャ認識時に、入力画像の差分情報のみが用いられるようにしてもよい。そのような場合、画像処理装置は、図8に示すように構成される。なお、図8において、図2における場合と対応する部分には同一の符号を付してあり、その説明は適宜省略する。

【0106】

図8の画像処理装置101は、撮影部21乃至表示部27から構成される。この画像処理装置101の構成は、手形状認識部22に色抽出部41が設けられておらず、またジェスチャ認識部25に色検出部42が設けられていない点で画像処理装置11と異なり、その他の点では画像処理装置11と同じとなっている。

【0107】

なお、画像処理装置101では、手検出情報保持部23に保持される手検出情報には、色情報は含まれず、この手検出情報はジェスチャ認識部25には供給されない。

【0108】

[判定領域監視処理の説明]

また、画像処理装置101は、図3を参照して説明したジェスチャ認識処理と同様の処理を行なう。但し、ステップS15では、手形状認識の結果として得られた手の形状、手の大きさ、および手の位置を示す情報が手検出情報として手検出情報保持部23に保持される。

【0109】

また、ステップS17の判定領域監視処理では、入力画像の差分情報に基づいて、ユーザの手の領域が判定領域に移動したかが監視される。

【0110】

以下、図9のフローチャートを参照して、画像処理装置101により行なわれる図3のジェスチャ認識処理のステップS17の処理に対応する判定領域監視処理について説明する。

【0111】

ステップS151において、差分検出部43は、撮影部21から供給された処理対象のフレームの入力画像と、処理対象のフレームよりも前のフレームの入力画像とのフレーム間の差分を求める。そして、ステップS152において、差分検出部43は、入力画像のフレーム間の差分に基づいて、入力画像上の差分領域を特定する。これらのステップS151およびステップS152の処理は図4のステップS53およびステップS54の処理と同様の処理である。

【0112】

ステップS152の処理が行なわれて、入力画像上の差分領域が特定されると、判定領域監視処理は終了し、その後、処理は図3のステップS18に進む。そして、ステップS18乃至ステップS20の処理が行なわれてジェスチャ認識処理は終了する。但し、ステップS18では、判定領域の一部または全部が差分領域内に含まれる場合、ユーザによりジェスチャが行なわれたと判定される。

【0113】

なお、画像処理装置101により図5を参照して説明したジェスチャ認識処理が行なわれるようにしてもよい。そのような場合においても、ステップS81乃至ステップS90では、基本的には画像処理装置11における場合と同様の処理が行なわれる。

【0114】

但し、ステップS84では、手形状の認識結果のみから手検出情報が生成され、ステップS86では、図9を参照して説明した判定領域監視処理が行なわれる。また、ステップS87では、判定領域の一部または全部が差分領域内に含まれる場合、ユーザによりジェスチャが行なわれたと判定される。

【0115】

〈第4の実施の形態〉

[認識対象のジェスチャについて]

なお、以上においては、1つの特定形状の手を認識させた後、ジェスチャが行なわれる場合について説明したが、ジェスチャによって、ジェスチャの開始時に画像処理装置に認識させる手の形状が異なるようにしてもよい。これにより、より多くのジェスチャを認識対象とすることができ、多様なジェスチャ操作を実現することができる。

【0116】

そのような場合、例えば図10の上側に示す手形状を検出させ、図中、下側に示すジェスチャを認識対象のジェスチャとすることが考えられる。なお、図10では、矢印A11乃至矢印A18により検出させる手形状が示されており、矢印B11乃至矢印B18に、矢印A11乃至矢印A18に示した手形状ごとのジェスチャが示されている。

【0117】

例えば、矢印A11に示す手形状は、手をカメラ等の撮影部に対して横に向け、親指とその他の指とで何かをつまんでいる状態(以下、つまみ形状とも称する)の手形状となっている。この場合、ユーザは、手を矢印A11に示すつまみ形状とした後、矢印B11に示すように、親指と、その他の指とを図中、上下方向に何度か移動させ、何かをつまんだり、離したりするようなジェスチャを行なう。

【0118】

このようなジェスチャでは、つまみ形状の手の親指と人差し指の指先から上下方向に所定の距離だけ離れた位置に判定領域DR21−1と判定領域DR21−2が設けられる。ここで、つまみ形状の手における親指や人差し指のおおよその位置は、手形状認識の結果から特定することが可能である。また、例えば指先から判定領域DR21−1と判定領域DR21−2までの距離は、例えば手の上下方向の長さ(高さ)により定められる。

【0119】

矢印A12に示す手形状は、図1の例と同様にパー形状となっている。この場合、ユーザは、手をパー形状とした後、矢印B12に示すように、左右のどちらかの方向に手を移動させるジェスチャを行なう。このようなジェスチャでは、手のひらの中心から左右方向に所定の距離だけ離れた位置に判定領域DR22−1と判定領域DR22−2が設けられる。

【0120】

なお、以下では、手形状認識の結果により、認識された特定形状の手の各部位のおおよその位置が特定できるものとして説明を続ける。

【0121】

例えば、手形状認識でパー形状の手が認識された場合、手の領域の輪郭から手のひらの中心位置と、手の各指先の候補となる位置(以下、指先候補位置と称する)とが定められ、中心位置と各指先候位置とを結ぶ線分の傾きから各指先のおおよその位置が特定される。つまり、中心位置と指先候補位置とから定まる指の輪郭の角度から、指先候補位置の確からしさを求めることができる。このように、手形状認識の結果に基づいて、各形状の手の所望の部位のおおよその位置を特定することができる。

【0122】

矢印A13に示す手形状は、グーの状態から親指と小指を立てた手形状となっている。この場合、ユーザは、手を矢印A13に示す形状とした後、矢印B13に示すように、図中、縦方向の線を回転軸として手首を回転させるジェスチャを行なう。

【0123】

このようなジェスチャでは、小指と親指のそれぞれの図中、下方向に所定の距離だけ離れた位置に判定領域DR23−1と判定領域DR23−2が設けられる。例えば、判定領域DR23−1と判定領域DR23−2の位置は、手の中心位置と、親指および小指の指先の位置から定められる。この例では、例えば小指と親指の一方または両方が、判定領域DR23−1や判定領域DR23−2に移動された場合、ジェスチャが行なわれたとされる。

【0124】

矢印A14に示す手形状はグーの手形状となっている。この場合、ユーザは手をグー形状とした後、矢印B14に示すように、左右のどちらかの方向に手を移動させるジェスチャを行なう。このようなジェスチャでは、手の中心から左右方向に所定の距離だけ離れた位置に判定領域DR24−1と判定領域DR24−2が設けられる。手の中心から判定領域DR24−1や判定領域DR24−2までの距離は、例えば手の横方向の長さ(幅)により定められる。

【0125】

矢印A15に示す手形状は、チョキの手形状、すなわち人差し指と中指を開き、他の指を閉じた状態の手形状となっている。この場合、ユーザは、手をチョキ形状とした後、矢印B15に示すように、図中、奥行き方向の線を回転軸として手首を左右に回転させるジェスチャを行なう。

【0126】

このようなジェスチャでは、中指と人差し指のそれぞれの図中、斜め下方向に、各指から所定の距離だけ離れた位置に判定領域DR25−1と判定領域DR25−2が設けられる。例えば、判定領域DR25−1と判定領域DR25−2の位置は、手の中心位置と、人差し指および中指の指先の位置から定められる。この例では、中指と人差し指の一方または両方が、判定領域DR25−1や判定領域DR25−2に移動された場合、ジェスチャが行なわれたとされる。

【0127】

また、矢印A16に示す手形状は、グー形状の手を縦向きにして親指を立てた、いわゆるサムアップの手形状となっている。この場合、ユーザは、矢印A16に示す手形状とした後、矢印B16に示すように、図中、奥行き方向の線を回転軸として手首を左右に回転させるジェスチャを行なう。

【0128】

このようなジェスチャでは、親指の指先の図中、左右の斜め下方向のそれぞれに、親指から所定の距離だけ離れた位置に判定領域DR26−1と判定領域DR26−2が設けられる。例えば、判定領域DR26−1と判定領域DR26−2の位置は、手の中心位置と、親指の指先の位置から定められる。この例では、親指が、判定領域DR26−1と判定領域DR26−2の一方または両方に移動された場合、ジェスチャが行なわれたとされる。

【0129】

矢印A17に示す手形状は、グー形状の状態から人差し指を開いた、いわゆる指差しの手形状となっている。この場合、ユーザは、矢印A17に示す手形状とした後、矢印B17に示すように、図中、奥行き方向の線を回転軸として手首を左右に回転させるジェスチャを行なう。

【0130】

このようなジェスチャでは人指し指の指先の図中、左右方向のそれぞれに、人指し指から所定の距離だけ離れた位置に判定領域DR27−1と判定領域DR27−2が設けられる。例えば、判定領域DR27−1と判定領域DR27−2の位置は、人差し指の指先の位置と、手の高さまたは幅とから定められる。この例では、例えば人差し指が、判定領域DR27−1と判定領域DR27−2の一方または両方に移動された場合、ジェスチャが行なわれたとされる。

【0131】

さらに、矢印A18に示す手形状は、グー形状の状態から人差し指を開き、人差し指を図中、手前方向に向けた指差しの手形状となっている。この場合、ユーザは手を矢印A18に示す手形状とした後、矢印B18に示すように、左右のどちらかの方向に手を移動させるジェスチャを行なう。このようなジェスチャでは、手の中心から左右方向に所定の距離だけ離れた位置に判定領域DR28−1と判定領域DR28−2が設けられる。手の中心から判定領域DR28−1や判定領域DR28−2までの距離は、例えば手の横方向の長さ(幅)により定められる。

【0132】

なお、ユーザにより行なわれるジェスチャは、図10に示した例に限らず、その他、どのようなものであってもよい。

【0133】

[画像処理装置の構成例]

図10に示したようにユーザにより複数のジェスチャが行なわれ、それらのジェスチャの認識結果に応じた処理が行なわれる場合、画像処理装置は例えば図11に示すように構成される。なお、図11において、図2における場合と対応する部分には同一の符号を付してあり、その説明は適宜省略する。

【0134】

図11の画像処理装置131は、撮影部21乃至表示部27から構成される。この画像処理装置131の構成は、手形状認識部22に新たに手形状特定部141が設けられている点で画像処理装置11と異なり、その他の点では画像処理装置11と同じとなっている。

【0135】

手形状認識部22は、例えば図10で示した複数の手形状ごとに、それらの手形状を認識するための辞書を記録しており、撮影部21から供給された入力画像に対して各辞書を用いた手形状認識を行なう。

【0136】

また、手形状認識部22は、手形状特定部141を備えており、手形状特定部141は、各手形状の辞書を用いた手形状認識により得られたスコアに基づいて、入力画像に含まれる手の形状を特定する。

【0137】

[ジェスチャ認識処理の説明]

次に、図12のフローチャートを参照して、画像処理装置131によるジェスチャ認識処理について説明する。なお、ステップS181乃至ステップS184の処理は図3のステップS11乃至ステップS14の処理と同様であるので、その説明は省略する。

【0138】

但し、ステップS182では、手形状認識部22は、手形状ごとの辞書について、入力画像に対するフィルタ処理を行なって特定形状の手らしさのスコアを求める。すなわち、入力画像の領域ごとのスコアのうち、最も高いスコアがその辞書を用いた手形状認識のスコアとされる。

【0139】

そして、手形状ごとのスコアのうち、1つでも所定の閾値以上のスコアがある場合、ステップS183で特定形状の手が検出されたと判定される。

【0140】

ステップS183で特定形状の手が検出されたと判定された場合、処理はステップS185に進む。そしてステップS185において、手形状特定部141は、手形状認識を行なった各手形状のうち、最もスコアの高い手形状が、手形状認識により検出された手の形状であるとして、入力画像上の手の形状を特定する。

【0141】

入力画像に含まれる手の形状が特定されると、その後、ステップS186乃至ステップS191の処理が行なわれてジェスチャ認識処理は終了するが、これらの処理は図3のステップS15乃至ステップS20の処理と同様であるので、その説明は省略する。

【0142】

但し、ステップS186では、ステップS185により特定された手形状についての手形状認識の結果と、その手形状認識の結果に基づいて色抽出部41により生成された色情報とが手検出情報として手検出情報保持部23に保持される。

【0143】

したがって、図12のジェスチャ認識処理では、異なる形状の手が検出されるごとに、手検出情報保持部23に保持される手検出情報が、異なる手形状の手検出情報に更新されることになる。

【0144】

そして、ステップS187では、特定された手形状ごとに、すなわち認識対象となるジェスチャごとに適切な判定領域が設定される。例えば、図10の矢印A11に示したつまみ形状の手が検出されると、矢印B11に示したように判定領域DR21−1と判定領域DR21−2が設定され、それらの両方の判定領域に親指や人差し指が移動されたと特定された場合に、ジェスチャが行なわれたとされる。

【0145】

また、ステップS188では、図4を参照して説明した判定領域監視処理と同様の処理が行なわれることになる。

【0146】

以上のようにして、画像処理装置131は、入力画像から複数の形状のうちの何れかの形状の手を検出し、その検出結果に基づいて判定領域を設定し、判定領域への手の移動を監視することで、ユーザのジェスチャを認識する。このように、手形状の検出結果に基づいて、検出された手形状ごとに判定領域を設定することで、各ジェスチャに対して適切な判定領域を定めることができ、より高速かつ高精度にジェスチャを認識することができる。

【0147】

〈変形例2〉

[ジェスチャ認識処理の説明]

また、画像処理装置131によるジェスチャ認識処理においても、手形状認識により手が検出された後、一定期間はジェスチャ認識のみが行なわれるようにしてもよい。

【0148】

そのような場合、画像処理装置131は、図13に示すジェスチャ認識処理を行なう。以下、図13のフローチャートを参照して、画像処理装置131によるジェスチャ認識処理について説明する。

【0149】

なお、ステップS221乃至ステップS223では、図5のステップS81乃至ステップS83の処理と同様の処理が行なわれるので、その説明は省略する。

【0150】

但し、ステップS222では、手形状認識部22は、図12のステップS182の処理と同様に、手形状ごとに辞書を用いた手形状認識を行い、ステップS223では、手形状ごとのスコアのうち、1つでも所定の閾値以上のスコアがある場合、特定形状の手が検出されたと判定される。

【0151】

ステップS223において、特定形状の手が検出されたと判定された場合、ステップS224において、手形状特定部141は、各手形状の手形状認識の結果に基づいて、入力画像上の手の形状を特定する。すなわち、ステップS224では、図12のステップS185と同様の処理が行なわれる。

【0152】

そして、手形状が特定されると、その後、ステップS225乃至ステップS231の処理が行なわれてジェスチャ認識処理は終了するが、これらの処理は図5のステップS84乃至ステップS90の処理と同様であるので、その説明は省略する。但し、ステップS225では、図12のステップS186と同様に、特定された手形状についての手形状認識の結果と、その手形状認識の結果に基づいて生成された色情報とが手検出情報として手検出情報保持部23に保持される。また、ステップS227では、図4を参照して説明した判定領域監視処理と同様の処理が行なわれる。

【0153】

以上のようにして画像処理装置131は、入力画像から複数の形状のうちの何れかの形状の手を検出し、その検出結果に基づいてユーザのジェスチャを認識する。

【0154】

〈第5の実施の形態〉

[画像処理装置の構成例]

なお、複数の手形状を認識対象の手形状とする場合においても、ユーザの手の色のみを用いてジェスチャ認識を行なうようにしてもよい。そのような場合、画像処理装置は、図14に示すように構成される。なお、図14において、図11における場合と対応する部分には同一の符号を付してあり、その説明は適宜省略する。

【0155】

図14の画像処理装置171は、撮影部21乃至表示部27から構成される。この画像処理装置171の構成は、ジェスチャ認識部25に差分検出部43が設けられていない点で画像処理装置131と異なり、その他の点では画像処理装置131と同じとなっている。

【0156】

[ジェスチャ認識処理の説明]

また、画像処理装置171も図12を参照して説明したジェスチャ認識処理と同様の処理を行なう、但し、ステップS188の判定領域監視処理では、ユーザの手の色の領域が判定領域に移動したかが監視される。すなわち、図7を参照して説明した判定領域監視処理が行なわれる。

【0157】

したがって、例えばステップS189では、判定領域の色が色情報により示されるユーザの手の色である場合、ユーザによりジェスチャが行なわれたと判定される。

【0158】

なお、画像処理装置171により図13を参照して説明したジェスチャ認識処理が行なわれるようにしてもよい。そのような場合、ステップS221乃至ステップS231では、基本的に画像処理装置131における場合と同様の処理が行なわれるが、ステップS227では、図7を参照して説明した判定領域監視処理が行なわれる。また、ステップS228では、判定領域の色が色情報により示されるユーザの手の色である場合、ユーザによりジェスチャが行なわれたと判定される。

【0159】

〈第6の実施の形態〉

[画像処理装置の構成例]

また、複数の手形状を認識対象の手形状とする場合において、ジェスチャ認識時に、入力画像の差分情報のみが用いられるようにしてもよい。そのような場合、画像処理装置は、図15に示すように構成される。なお、図15において、図11における場合と対応する部分には同一の符号を付してあり、その説明は適宜省略する。

【0160】

図15の画像処理装置201は、撮影部21乃至表示部27から構成される。この画像処理装置201の構成は、手形状認識部22に色抽出部41が設けられておらず、またジェスチャ認識部25に色検出部42が設けられていない点で画像処理装置131と異なり、その他の点では画像処理装置131と同じとなっている。

【0161】

なお、画像処理装置201では、手検出情報保持部23に保持される手検出情報には、色情報は含まれず、この手検出情報はジェスチャ認識部25には供給されない。

【0162】

[ジェスチャ認識処理の説明]

また、画像処理装置201は、図12を参照して説明したジェスチャ認識処理と同様の処理を行なう。但し、ステップS186では、手形状認識の結果として得られた手の形状、手の大きさ、および手の位置を示す情報が手検出情報として手検出情報保持部23に保持される。

【0163】

また、ステップS188の判定領域監視処理では、入力画像の差分情報に基づいて、ユーザの手の領域が判定領域に移動したかが監視される。すなわち、図9を参照して説明した判定領域監視処理が行なわれる。したがって、ステップS189では、判定領域の一部または全部が差分領域内に含まれる場合、ユーザによりジェスチャが行なわれたと判定される。

【0164】

なお、画像処理装置201により図13を参照して説明したジェスチャ認識処理が行なわれるようにしてもよい。そのような場合においても、ステップS221乃至ステップS231では、基本的には画像処理装置131における場合と同様の処理が行なわれる。

【0165】

但し、ステップS225では、手形状の認識結果のみから手検出情報が生成され、ステップS227では、図9を参照して説明した判定領域監視処理が行なわれる。また、ステップS228では、判定領域の一部または全部が差分領域内に含まれる場合、ユーザによりジェスチャが行なわれたと判定される。

【0166】

〈第7の実施の形態〉

[画像処理装置の構成例]

さらに、以上においては、手形状認識により手を検出する例について説明したが、ユーザの手の色がある程度推定可能である場合には、手の色情報のみを用いてジェスチャ認識を行なうようにしてもよい。

【0167】

そのような場合、画像処理装置は、例えば図16に示すように構成される。なお、図16において、図2における場合と対応する部分には同一の符号を付してあり、その説明は適宜省略する。

【0168】

図16の画像処理装置231は、撮影部21、色抽出部241、領域抽出部242、判定領域設定部243、ジェスチャ認識部244、ジェスチャ処理部26、および表示部27から構成される。

【0169】

色抽出部241は、撮影部21から供給された入力画像から、予めユーザの手の色として登録された色の画素を抽出し、その抽出結果を領域抽出部242に供給する。領域抽出部242は、色抽出部241からの手の色の抽出結果に基づいて、入力画像からユーザの手の領域を抽出し、ユーザの手の領域を判定領域設定部243に供給する。

【0170】

判定領域設定部243は、領域抽出部242から供給されたユーザの手の領域に基づいて判定領域を設定し、ジェスチャ認識部244に供給する。ジェスチャ認識部244は、撮影部21からの入力画像と、判定領域設定部243からの判定領域とに基づいて、ユーザによるジェスチャの認識を行い、その認識結果をジェスチャ処理部26に供給する。

【0171】

[ジェスチャ認識処理の説明]

次に、図17のフローチャートを参照して、画像処理装置231によるジェスチャ認識処理について説明する。

【0172】

ステップS261において、撮影部21は、入力画像の撮影を開始する。撮影部21は、撮影により得られた入力画像を順次、色抽出部241およびジェスチャ認識部244に供給する。

【0173】

ステップS262において、色抽出部241は、撮影部21から供給された入力画像から、予めユーザの手の色として登録された色の領域(画素)を抽出する。

【0174】

ステップS263において、色抽出部241は、入力画像からのユーザの手の色の抽出結果に基づいて、入力画像からユーザの手が検出されたか否かを判定する。例えば、入力画像上にユーザの手の色からなる、所定の大きさ以上の領域がある場合、ユーザの手が検出されたと判定される。

【0175】

ステップS263において、ユーザの手が検出されなかったと判定された場合、処理はステップS262に戻り、上述した処理が繰り返される。

【0176】

これに対して、ステップS263において、ユーザの手が検出されたと判定された場合、色抽出部241は、入力画像からのユーザの手の色の画素の抽出結果を領域抽出部242に供給し、処理はステップS264に進む。

【0177】

ステップS264において、領域抽出部242は、色抽出部241からの手の色の抽出結果に基づいて、入力画像からユーザの手の領域を抽出し、ユーザの手の領域を判定領域設定部243に供給する。例えば、領域抽出部242は、入力画像上のユーザの手の色の画素からなる領域のうち、最も大きい領域など、最もユーザの手らしい領域を、ユーザの手の領域として抽出する。

【0178】

ステップS265において、判定領域設定部243は、領域抽出部242から供給されたユーザの手の領域に基づいて判定領域を定め、ジェスチャ認識部244に供給する。具体的には、入力画像上のユーザの手の領域から、その領域の中心位置、ユーザの手のおおよその高さや幅などが求まる。そこで、例えばユーザの手の領域の中心位置から、左右方向にユーザの手の幅により定まる距離だけ離れた位置など、認識対象のジェスチャに応じた位置および大きさの判定領域が設定される。

【0179】

ステップS266において、ジェスチャ認識部244は、撮影部21からの入力画像と、判定領域設定部243からの判定領域とに基づいて、ユーザによるジェスチャが行なわれたか否かを判定する。

【0180】

例えば、ジェスチャ認識部244は、ユーザの手の領域と、入力画像の差分領域とのうちの少なくとも一方に基づいて、ユーザのジェスチャ認識を行なう。

【0181】

例えば、ジェスチャ認識部244は、入力画像上のユーザの手の領域が、設定した判定領域に移動し、かつ入力画像の連続するフレーム間の差分により求まる動被写体の領域が判定領域に移動した場合、ユーザによるジェスチャが行なわれたと判定される。

【0182】

ステップS266において、ジェスチャが行われなかったと判定された場合、処理はステップS262に戻り、上述した処理が繰り返される。

【0183】

これに対して、ステップS266において、ジェスチャが行なわれたと判定された場合、ジェスチャ認識部244は、ユーザによるジェスチャの認識結果をジェスチャ処理部26に供給し、処理はステップS267に進む。

【0184】

ステップS267において、ジェスチャ処理部26は、ジェスチャ認識部244からのジェスチャ認識結果に応じた処理を行ない、ジェスチャ認識処理は終了する。例えば、ジェスチャ処理部26は、ジェスチャの認識結果を示す画像を表示部27に供給して表示させたり、ジェスチャに応じて表示部27に表示する番組のチャンネルを変更したりする。

【0185】

以上のようにして画像処理装置231は、入力画像から特定の色の領域を抽出することでユーザの手の領域を検出し、その検出結果に基づいて判定領域を設定してユーザのジェスチャ認識を行なう。このように、ユーザの手の領域の検出結果に基づいて判定領域を設定することで、より高速かつ高精度にジェスチャ認識を行なうことができる。

【0186】

上述した一連の処理は、ハードウェアにより実行することもできるし、ソフトウェアにより実行することもできる。一連の処理をソフトウェアにより実行する場合には、そのソフトウェアを構成するプログラムが、専用のハードウェアに組み込まれているコンピュータ、または、各種のプログラムをインストールすることで、各種の機能を実行することが可能な、例えば汎用のパーソナルコンピュータなどに、プログラム記録媒体からインストールされる。

【0187】

図18は、上述した一連の処理をプログラムにより実行するコンピュータのハードウェアの構成例を示すブロック図である。

【0188】

コンピュータにおいて、CPU(Central Processing Unit)301,ROM(Read Only Memory)302,RAM(Random Access Memory)303は、バス304により相互に接続されている。

【0189】

バス304には、さらに、入出力インターフェース305が接続されている。入出力インターフェース305には、キーボード、マウス、マイクロホンなどよりなる入力部306、ディスプレイ、スピーカなどよりなる出力部307、ハードディスクや不揮発性のメモリなどよりなる記録部308、ネットワークインターフェースなどよりなる通信部309、磁気ディスク、光ディスク、光磁気ディスク、或いは半導体メモリなどのリムーバブルメディア311を駆動するドライブ310が接続されている。

【0190】

以上のように構成されるコンピュータでは、CPU301が、例えば、記録部308に記録されているプログラムを、入出力インターフェース305及びバス304を介して、RAM303にロードして実行することにより、上述した一連の処理が行われる。

【0191】

コンピュータ(CPU301)が実行するプログラムは、例えば、磁気ディスク(フレキシブルディスクを含む)、光ディスク(CD-ROM(Compact Disc-Read Only Memory),DVD(Digital Versatile Disc)等)、光磁気ディスク、もしくは半導体メモリなどよりなるパッケージメディアであるリムーバブルメディア311に記録して、あるいは、ローカルエリアネットワーク、インターネット、デジタル衛星放送といった、有線または無線の伝送媒体を介して提供される。

【0192】

そして、プログラムは、リムーバブルメディア311をドライブ310に装着することにより、入出力インターフェース305を介して、記録部308にインストールすることができる。また、プログラムは、有線または無線の伝送媒体を介して、通信部309で受信し、記録部308にインストールすることができる。その他、プログラムは、ROM302や記録部308に、あらかじめインストールしておくことができる。

【0193】

なお、コンピュータが実行するプログラムは、本明細書で説明する順序に沿って時系列に処理が行われるプログラムであっても良いし、並列に、あるいは呼び出しが行われたとき等の必要なタイミングで処理が行われるプログラムであっても良い。

【0194】

また、本技術の実施の形態は、上述した実施の形態に限定されるものではなく、本技術の要旨を逸脱しない範囲において種々の変更が可能である。

【0195】

さらに、本技術は、以下の構成とすることも可能である。

【0196】

[1]

入力画像に対する手形状認識を行って、前記入力画像における特定形状の手の位置と大きさを検出する手形状認識部と、

前記手の位置および大きさに基づいて、前記入力画像上の前記手近傍の領域を、前記手を用いたジェスチャの認識の判定領域として設定する判定領域設定部と、

前記手の前記判定領域への移動を監視することで、前記ジェスチャを認識するジェスチャ認識部と

を備える画像処理装置。

[2]

前記判定領域設定部は、前記入力画像上の前記手近傍に複数の前記判定領域を設定する

[1]に記載の画像処理装置。

[3]

複数の前記判定領域のそれぞれは、互いに異なる前記ジェスチャを認識するための領域である

[2]に記載の画像処理装置。

[4]

前記ジェスチャの認識結果に応じた処理を行う処理部をさらに備える

[1]乃至[3]の何れかに記載の画像処理装置。

[5]

前記ジェスチャ認識部は、検出された前記手の領域から抽出された色と、前記入力画像上の前記判定領域の色とを比較することで、前記ジェスチャを認識する

[1]乃至[4]の何れかに記載の画像処理装置。

[6]

前記ジェスチャ認識部は、前記入力画像のフレーム間の差分に基づいて前記手の前記判定領域への移動を監視し、前記ジェスチャを認識する

[1]乃至[4]の何れかに記載の画像処理装置。

[7]

前記手形状認識部は、予め定められた複数の形状の手の位置と大きさの検出を行なう

[1]乃至[6]の何れかに記載の画像処理装置。

[8]

前記判定領域設定部は、新たに特定形状の前記手の位置と大きさが検出された場合、新たに検出された前記手の形状、位置、および大きさに基づいて前記判定領域を設定する

[7]に記載の画像処理装置。

【符号の説明】

【0197】

11 画像処理装置, 22 手形状認識部, 23 手検出情報保持部, 24 判定領域設定部, 25 ジェスチャ認識部, 41 色抽出部, 42 色検出部, 43 差分検出部, 141 手形状特定部

【技術分野】

【0001】

本技術は画像処理装置および方法、並びにプログラムに関し、特に、より高速かつ高精度にハンドジェスチャを認識することができるようにした画像処理装置および方法、並びにプログラムに関する。

【背景技術】

【0002】

従来、ユーザが手で予め定められたジェスチャを行なうと、そのジェスチャ(手の動き)に応じた処理を行なう技術が知られている。

【0003】

このような技術では、ユーザのジェスチャの認識が必要となるが、ジェスチャの認識方法として、画像上の特定の色の領域や動被写体の領域を利用する方法が提案されている(例えば、特許文献1および特許文献2参照)。例えば、特定色の領域を利用する方法では、画像から手の色が抽出され、その色の領域の動きに基づいてジェスチャが認識される。また、動被写体の領域を利用する方法では、画像のフレーム間の差分から動きのある領域が特定され、その領域の動きに基づいてジェスチャが認識される。

【先行技術文献】

【特許文献】

【0004】

【特許文献1】特開平08−315154号公報

【特許文献2】特開2008−52590号公報

【発明の概要】

【発明が解決しようとする課題】

【0005】

しかしながら、上述した技術では、高速かつ高精度にユーザのジェスチャを認識することができなかった。

【0006】

例えば、特定色の領域や動被写体の領域を利用する方法では、画像全体を監視対象とし、ユーザの手のジェスチャを認識する必要があるため、処理量が多くなりジェスチャ認識に時間がかかるだけでなく、ジェスチャの認識精度も低下してしまう。また、ジェスチャの認識精度を少しでも高くするためには、ユーザが大きく手を動かさなければならなかった。

【0007】

さらに、動被写体の領域を利用したジェスチャ認識では、ユーザの手以外に動きのある被写体がある場合など、ユーザの周囲の環境によっては誤認識が生じる恐れがあった。

【0008】

本技術は、このような状況に鑑みてなされたものであり、より高速かつ高精度にジェスチャを認識することができるようにするものである。

【課題を解決するための手段】

【0009】

本技術の一側面の画像処理装置は、入力画像に対する手形状認識を行って、前記入力画像における特定形状の手の位置と大きさを検出する手形状認識部と、前記手の位置および大きさに基づいて、前記入力画像上の前記手近傍の領域を、前記手を用いたジェスチャの認識の判定領域として設定する判定領域設定部と、前記手の前記判定領域への移動を監視することで、前記ジェスチャを認識するジェスチャ認識部とを備える。

【0010】

前記判定領域設定部には、前記入力画像上の前記手近傍に複数の前記判定領域を設定させることができる。

【0011】

複数の前記判定領域のそれぞれを、互いに異なる前記ジェスチャを認識するための領域とすることができる。

【0012】

画像処理装置には、前記ジェスチャの認識結果に応じた処理を行う処理部をさらに設けることができる。

【0013】

前記ジェスチャ認識部には、検出された前記手の領域から抽出された色と、前記入力画像上の前記判定領域の色とを比較させることで、前記ジェスチャを認識させることができる。

【0014】

前記ジェスチャ認識部には、前記入力画像のフレーム間の差分に基づいて前記手の前記判定領域への移動を監視させ、前記ジェスチャを認識させることができる。

【0015】

前記手形状認識部には、予め定められた複数の形状の手の位置と大きさの検出を行なわせることができる。

【0016】

前記判定領域設定部には、新たに特定形状の前記手の位置と大きさが検出された場合、新たに検出された前記手の形状、位置、および大きさに基づいて前記判定領域を設定させることができる。

【0017】

本技術の一側面の画像処理方法またはプログラムは、入力画像に対する手形状認識を行って、前記入力画像における特定形状の手の位置と大きさを検出し、前記手の位置および大きさに基づいて、前記入力画像上の前記手近傍の領域を、前記手を用いたジェスチャの認識の判定領域として設定し、前記手の前記判定領域への移動を監視することで、前記ジェスチャを認識するステップを含む。

【0018】

本技術の一側面においては、入力画像に対する手形状認識が行われて、前記入力画像における特定形状の手の位置と大きさが検出され、前記手の位置および大きさに基づいて、前記入力画像上の前記手近傍の領域が、前記手を用いたジェスチャの認識の判定領域として設定され、前記手の前記判定領域への移動を監視することで、前記ジェスチャが認識される。

【発明の効果】

【0019】

本技術の一側面によれば、より高速かつ高精度にジェスチャを認識することができる。

【図面の簡単な説明】

【0020】

【図1】本技術の概要を説明する図である。

【図2】画像処理装置の構成例を示す図である。

【図3】ジェスチャ認識処理を説明するフローチャートである。

【図4】判定領域監視処理を説明するフローチャートである。

【図5】ジェスチャ認識処理を説明するフローチャートである。

【図6】画像処理装置の他の構成例を示す図である。

【図7】判定領域監視処理を説明するフローチャートである。

【図8】画像処理装置の他の構成例を示す図である。

【図9】判定領域監視処理を説明するフローチャートである。

【図10】手形状とジェスチャについて説明する図である。

【図11】画像処理装置の他の構成例を示す図である。

【図12】ジェスチャ認識処理を説明するフローチャートである。

【図13】ジェスチャ認識処理を説明するフローチャートである。

【図14】画像処理装置の他の構成例を示す図である。

【図15】画像処理装置の他の構成例を示す図である。

【図16】画像処理装置の他の構成例を示す図である。

【図17】ジェスチャ認識処理を説明するフローチャートである。

【図18】コンピュータの構成例を示す図である。

【発明を実施するための形態】

【0021】

以下、図面を参照して、本技術を適用した実施の形態について説明する。

【0022】

〈第1の実施の形態〉

[本技術の概要]

まず、図1を参照して本技術の概要について説明する。本技術は、ユーザによるハンドジェスチャ(以下、単にジェスチャと称する)を認識し、認識されたジェスチャに応じた処理を行うためのものである。

【0023】

以下では、いわゆるパー形状の手、つまり全ての指が開かれた状態の手が認識された状態から、ユーザが手を左右のどちらかの方向に動かす動作を認識対象のジェスチャとする場合を例として、説明を続ける。

【0024】

ジェスチャ認識では、ユーザの手を含む入力画像が撮影され、得られた入力画像から手形状認識により、予め定められた形状の手が検出される。ここでは、例えば図1の左側に示すように、パー形状の手H11が検出される。

【0025】

パー形状のユーザの手H11が検出されると、次に検出されたユーザの手H11の位置と大きさに基づいて、ユーザにより行なわれるジェスチャを認識するために監視される判定領域DR11−1と判定領域DR11−2が定められる。

【0026】

例えば、ユーザの手H11が検出されると、その手H11の中心位置C11が求まるので、中心位置C11から図中、左方向に手H11の幅の半分の距離だけ離れた位置を中心とする、所定の大きさの矩形領域が判定領域DR11−1とされる。同様に、中心位置C11から図中、右方向に手H11の幅の半分の距離だけ離れた位置を中心とする、所定の大きさの矩形領域が判定領域DR11−2とされる。なお、以下、判定領域DR11−1と判定領域DR11−2を特に区別する必要のない場合、単に判定領域DR11とも称する。

【0027】

このようにしてユーザがパー形状の手H11を認識させると、ユーザは、その状態から手を右または左に動かす。例えば、図中、右側に示すようにユーザが手H11を右方向に動かして、その手H11が判定領域DR11−2に到達(移動)すると、ユーザによりジェスチャが行なわれたと認識される。

【0028】

このように、本技術では、特定形状のユーザの手が検出され、その検出結果により定まる、ユーザの手近傍の位置が判定領域として設定される。そして、ユーザの手が設定した判定領域に到達すると、ジェスチャが行なわれたと認識される。

【0029】

本技術では手形状認識により特定形状のユーザの手を検出するので、その手の形状や大きさと認識対象のジェスチャに応じて、適切な位置に適切な大きさの判定領域を設定することができる。したがって、判定領域だけを監視対象とすればよいので、少ない処理で高速かつ高精度にジェスチャ認識を行なうことができる。

【0030】

[画像処理装置の構成例]

図2は、本技術を適用した画像処理装置の一実施の形態の構成例を示す図である。

【0031】

画像処理装置11は、撮影部21、手形状認識部22、手検出情報保持部23、判定領域設定部24、ジェスチャ認識部25、ジェスチャ処理部26、および表示部27から構成される。

【0032】

撮影部21は、画像処理装置11の周囲、例えば表示部27を正面から観察するユーザの画像を入力画像として撮影し、手形状認識部22およびジェスチャ認識部25に供給する。手形状認識部22は、撮影部21から供給された入力画像に基づいて手形状認識を行い、入力画像から特定形状の手の領域を検出する。

【0033】

また、手形状認識部22は色抽出部41を備えており、色抽出部41は、入力画像からの手の検出結果に基づいて、入力画像の手の領域の色情報を抽出する。手形状認識部22は、手形状認識の結果と色情報とを手検出情報保持部23に供給する。

【0034】

手検出情報保持部23は、手形状認識部22から供給された手形状認識の結果と色情報を手検出情報として保持し、必要に応じて判定領域設定部24およびジェスチャ認識部25に供給する。判定領域設定部24は、手検出情報保持部23に保持されている手検出情報に基づいて判定領域を設定し、ジェスチャ認識部25に供給する。

【0035】

ジェスチャ認識部25は、撮影部21からの入力画像、手検出情報保持部23からの手検出情報、および判定領域設定部24からの判定領域に基づいてユーザのジェスチャを認識し、その認識結果をジェスチャ処理部26に供給する。

【0036】

ジェスチャ認識部25は、色検出部42および差分検出部43を備えている。色検出部42は、入力画像上の色情報により示される色の領域の判定領域内への移動を監視することで、ユーザのジェスチャを検出する。また、差分検出部43は、入力画像のフレーム間の差分を求めることで、入力画像上の動被写体の判定領域への移動を監視することで、ユーザのジェスチャを検出する。

【0037】

ジェスチャ処理部26は、ジェスチャ認識部25から供給されたジェスチャの認識結果に応じた処理を行い、必要に応じて表示部27に画像を表示させる。表示部27は、ジェスチャ処理部26の制御にしたがって画像を表示する。

【0038】

例えば、表示部27には、ジェスチャの認識結果そのものが表示されてもよいし、表示部27に表示される番組のチャンネルがジェスチャの認識結果に応じて変更され、変更後のチャンネルの番組が表示部27に表示されるようにしてもよい。

【0039】

[手形状認識について]

ところで、手形状認識部22による手形状認識は、入力画像から特定形状の手を認識することができれば、どのような手形状認識方法であってもよい。手形状認識の処理として、様々な方法が知られているが、以下では手形状認識の処理として、統計学習により得られた、特定形状の手を認識するための辞書が用いられることとして説明を続ける。

【0040】

手形状認識用の辞書には、特定形状の手を認識するために用いられるフィルタの種類と、フィルタを用いて特徴量を抽出する特徴点とを示す情報などが含まれている。例えば、特定形状の手の認識用のフィルタとして、異なる角度や微分値のレクタングルフィルタを示す情報が辞書に含まれている。

【0041】

このような辞書に基づいて入力画像の各領域に対してフィルタ処理を行なって特徴量を抽出すると、領域ごとに特定形状の手らしさを示すスコアが得られるので、所定の閾値以上となる最も高いスコアの領域が特定形状の手が含まれている領域として検出される。このような手形状認識では、特定形状の手の認識結果として、入力画像上で認識された手の形状、手の大きさ、および手の位置(手の領域)を示す情報が得られる。

【0042】

なお、より詳細には、入力画像の各位置の輝度を示す輝度画像が生成され、輝度画像に対してフィルタ処理が行なわれることで、入力画像から特徴量が抽出される。

【0043】

また、物体認識については例えば以下の文献に詳細に記載されている。

文献1「“Vector Boosting for Rotation Invariant Multi-View Face Detection”C. Huang, H.Z. Ai, Y. Li, and S.H. Lao,Proc. 10th IEEE Int’l Conf. Computer Vision, 2005.」

文献2「“A detector tree of boosted classifiers for real-time object detection andtracking”R.Lienhart, L.Liang, A.Kuranov,Proceedings of the 2003 International Conference on Multimedia and Expo -Volume 1」

文献3「“Multi-view face pose classification by tree-structured classifier”Zhiguang Yang; Haizhou Ai; Okamoto, T.; Shihong Lao;Image Processing, 2005. ICIP 2005. IEEE International Conference on Volume 2, 11-14 Sept. 2005 Page(s):II - 358-61」,

文献4「“A boosted classifier tree for hand shape detection”EJ Ong, R Bowden,Face and Gesture Recognition, 2004」

文献5「“Cluster Boosted Tree Classifier for Multi-View, Multi-Pose Object Detection”Bo Wu; Nevatia, R. ICCV 2007. IEEE 11th International Conference on Computer Vision, 14-21 Oct.2007 Page(s):1 8」

文献6「“Sharing visual features for multiclass and multiview object detection”A. Torralba, K. P. Murphy and W. T. Freeman,IEEE Transactions on Pattern Analysis and Machine Intelligence , vol. 29,no. 5, pp. 854-869, May, 2007」

文献7「“Fast Multi-View Face Detection”M. Jones and P. Viola,MERLTR2003-96, July 2003.」

【0044】

[ジェスチャ認識処理の説明]

また、画像処理装置11は、ユーザによりジェスチャに応じた処理の実行を指示されると、ジェスチャ認識処理を開始して、ジェスチャ認識を行なうとともに、認識されたジェスチャに応じた処理を行なう。以下、図3のフローチャートを参照して、画像処理装置11によるジェスチャ認識処理について説明する。

【0045】

ステップS11において、撮影部21は、ユーザを被写体とする入力画像の撮影を開始し、撮影により得られた各フレームの入力画像を順次手形状認識部22およびジェスチャ認識部25に供給する。

【0046】

ステップS12において、手形状認識部22は、撮影部21から供給された入力画像に基づいて、手形状認識を行なう。例えば、手形状認識部22は、予め記録している、パー形状の手を認識するための辞書を用いて入力画像から特徴量を抽出し、入力画像からパー形状の手の領域を検出する。

【0047】

ステップS13において、手形状認識部22は、処理対象のフレームの入力画像から特定形状の手が検出されたか否かを判定する。ステップS13において、特定形状の手が検出されなかったと判定された場合、ステップS14において、手形状認識部22は、既に手が検出されているか否かを判定する。

【0048】

例えば、処理対象のフレームよりも過去のフレームの入力画像から、特定形状の手が検出されたことがあり、既に手検出情報保持部23に手検出情報が保持されている場合、既に特定形状の手が検出されていると判定される。

【0049】

ステップS14において、まだ特定形状の手が検出されていない、つまり入力画像から一度も特定形状の手が検出されていないと判定された場合、処理はステップS12に戻り、上述した処理が繰り返される。

【0050】

これに対して、ステップS14において、既に特定形状の手が検出されていると判定された場合、既に手検出情報保持部23に手検出情報が保持されており、ジェスチャ認識が可能であるので、処理はステップS17に進む。

【0051】

また、ステップS13において、特定形状の手が検出されたと判定された場合、ステップS15において、手検出情報保持部23は、手検出情報を保持する。

【0052】

すなわち、手形状認識により特定形状の手が検出されると、手形状認識の結果として、認識された手の形状、手の大きさ、および手の位置を示す情報が得られる。すると、これらの情報から入力画像上のおおよその手の領域が分かるので、色抽出部41は、例えば入力画像上の手の領域のうち、手のほぼ中央の領域の色を検出されたユーザの手の色とし、その色を示す色情報を生成する。

【0053】

手形状認識部22は、このようにして得られた手の形状、手の大きさ、および手の位置を示す情報と、色情報とを手検出情報として手検出情報保持部23に供給する。そして、手検出情報保持部23は、手形状認識部22から供給された手検出情報を保持する。

【0054】

なお、入力画像上の肌色の領域が検出されたり、ユーザによる指定操作が行なわれたりして、予めユーザの手形状とその手の領域が分かっている場合には、入力画像の撮影開始後、ステップS12およびステップS13の処理が行なわれずに、ステップS15の処理が行なわれ、手検出情報が保持されるようにしてもよい。

【0055】

ステップS16において、判定領域設定部24は、手検出情報保持部23に保持されている手検出情報に基づいて、判定領域を定める。

【0056】

例えば、手形状認識でパー形状の手が認識され、図1を参照して説明したジェスチャが認識対象のジェスチャとされているとする。また、図1中、右方向を+x方向とし、上方向を+y方向であるとして、xy座標系における手H11の中心位置C11と、手H11の幅および高さが手検出情報として保持されているとする。

【0057】

ここで、例えば中心位置C11が座標(Cx,Cy)であるとする。また、手H11の幅、つまり手H11のx方向の長さがHwであり、手H11の高さ、つまり手H11のy方向の長さがHhであるとする。この例では、中心位置C11の座標(Cx,Cy)が手検出情報に含まれる手の位置を示す情報であり、手H11の幅Hwと高さHhが手検出情報に含まれる手の大きさを示す情報である。

【0058】

このような場合、判定領域設定部24は、手検出情報に基づいて、判定領域DR11−1となる矩形領域の左下の頂点SLのxy座標系における座標(SLx,SLy)を求める。例えば、(SLx,SLy)=(Cx−Hw/α,Cy−Hh/β)とされる。ここで、αとβは任意の定数である。

【0059】

また、判定領域設定部24は、判定領域DR11−1となる矩形領域の右上の頂点ELのxy座標系における座標(ELx,ELy)を求める。例えば、任意の定数をγとして(ELx,ELy)=(SLx+γ,SLy+γ)とされる。このようにして定められた頂点SLと頂点ELにより、判定領域DR11−1が特定されることになる。

【0060】

同様にして、判定領域設定部24は、手検出情報に基づいて、判定領域DR11−2となる矩形領域の左下の頂点SRの座標(SRx,SRy)と右上の頂点ERの座標(ERx,ERy)を求める。例えば、(SRx,SRy)=(Cx+Hw/α,Cy−Hh/β)とされ、(ERx,ERy)=(SRx+γ,SRy+γ)とされる。

【0061】

このように、判定領域DR11の位置を決定付ける定数α,βや、判定領域DR11の大きさを決定付ける定数γは、認識対象のジェスチャに応じて任意に設定される。一般的には、ハンドジェスチャの認識を簡単かつ確実に行なうことができるように、認識された手近傍の領域が判定領域とされる。

【0062】

例えば、図1の例では、認識対象のジェスチャは、パー形状の手を認識させた状態から、ユーザが手H11を図中、右または左の何れかの方向に移動させるジェスチャである。そのため、この例では、判定領域DR11は、手H11の左右の方向に対して、手H11の大きさ(幅)により定められる距離だけ離れた位置に設定される。

【0063】

判定領域DR11−1は、ユーザが図1中、手H11を左方向に移動させるジェスチャを認識するための監視対象の領域であり、判定領域DR11−2は、ユーザが図1中、手H11を右方向に移動させるジェスチャを認識するための監視対象の領域である。これらの2つのジェスチャの何れかが認識された場合、ジェスチャに応じて同じ処理が行なわれるようにしてもよいし、ジェスチャの方向によって異なる処理が行なわれるようにしてもよい。

【0064】

手形状認識により手の形状や位置、大きさなどが特定されれば、認識対象となるジェスチャに対して、適切に判定領域DR11を定めることができる。これにより、ジェスチャ認識時における入力画像の監視対象とする領域をより小さくすることができ、より簡単な処理で高速かつ高精度にジェスチャを認識することができるようになる。

【0065】

なお、判定領域DR11を定めるときに用いられる定数α,β,γは、ジェスチャの使用用途等によって、適切な手の検索範囲が異なることもあるため、ユーザにより設定されるようにしてもよい。また、判定領域が手の領域近傍となるように手の位置や大きさに基づいて、判定領域が定められているが、ジェスチャを使用する状況が明確な場合には、判定領域が任意の位置に指定されるようにしてもよい。

【0066】

図3のフローチャートの説明に戻り、判定領域が定められると、判定領域設定部24は判定領域をジェスチャ認識部25に供給し、処理はステップS16からステップS17に進む。

【0067】

ステップS17において、ジェスチャ認識部25は、手検出情報保持部23に保持されている手検出情報を必要に応じて参照しながら、判定領域設定部24からの判定領域と、撮影部21からの入力画像とに基づいて、判定領域監視処理を行なう。

【0068】

ここで、図4のフローチャートを参照して、ジェスチャ認識部25による判定領域監視処理を説明する。

【0069】

ステップS51において、色検出部42は、撮影部21から供給された処理対象の入力画像における判定領域内の各位置の色を特定する。そして、ステップS52において、色検出部42は、判定領域の色と、手検出情報に含まれる色情報により示されるユーザの手の色とを比較する。すなわち、判定領域の色がユーザの手の色と同じであれば、ユーザの手が判定領域内に移動してきたことになり、ジェスチャが行なわれたことが分かる。

【0070】

ステップS53において、差分検出部43は、撮影部21から供給された処理対象のフレームの入力画像と、処理対象のフレームよりも前、例えば直前のフレームの入力画像とのフレーム間の差分を求める。具体的には、それらのフレームの入力画像の同じ位置にある画素の画素値の差分絶対値が算出される。

【0071】

ステップS54において、差分検出部43は、入力画像のフレーム間の差分に基づいて、入力画像上の差分領域を特定する。ここで差分領域とは、ステップS53の処理で求められたフレーム間の差分絶対値が所定の閾値以上となる、互いに隣接する画素からなる領域である。フレーム間の差分絶対値が大きい領域は、動きのある被写体(動被写体)の領域であるので、このような動被写体はユーザの手である可能性が高い。

【0072】

そこで、差分検出部43は、入力画像上の動被写体の領域を差分領域として検出し、判定領域が差分領域内に含まれるかを監視することで、ユーザのジェスチャを認識する。すなわち、ユーザの手が移動されると、手の領域は差分領域となるので、この差分領域が判定領域に到達した場合、ユーザの手が判定領域内に移動してきたことになり、ジェスチャが行なわれたことが分かる。

【0073】

このようにして、ユーザの手の色と、入力画像の差分情報とにより判定領域へのユーザの手の移動の有無の検出が行なわれると、判定領域監視処理は終了し、その後、処理は図3のステップS18に進む。

【0074】

ステップS18において、ジェスチャ認識部25は、色情報により示される色と判定領域の色の比較結果と、差分領域の特定結果とに基づいて、ユーザによりジェスチャが行なわれたか否かを判定する。

【0075】

例えば、判定領域の色が色情報により示されるユーザの手の色であり、かつ判定領域の一部または全部が差分領域内に含まれる場合、ユーザによりジェスチャが行なわれたと判定される。

【0076】

なお、判定領域の色が色情報により示されるユーザの手の色であるか、または判定領域の一部若しくは全部が差分領域内に含まれているかの少なくとも何れかの状態となった場合に、ユーザによりジェスチャが行なわれたと判定されるようにしてもよい。

【0077】

ステップS18において、ジェスチャが行なわれていないと判定された場合、処理はステップS12に戻り、上述した処理が繰り返される。すなわち、次のフレームが処理対象のフレームとされて、新たな処理対象のフレームの入力画像に対して、手形状認識とジェスチャ認識が行なわれる。

【0078】

なお、ユーザの手が移動している状態では、ユーザの手形状が変化するため、入力画像から特定形状(例えば、パー形状)の手が検出されることはなく、手検出情報の更新も行なわれない。これに対して、ユーザが再度、手形状を認識させようとして、撮影部21に対して特定形状の手をかざすと、手形状認識で手が検出されて手検出情報が更新され、これにより新たな判定領域が設定される。

【0079】

また、ステップS18において、ジェスチャが行なわれた判定された場合、ジェスチャ認識部25は、ジェスチャの認識結果をジェスチャ処理部26に供給し、処理はステップS19に進む。例えば、ジェスチャ認識部25は、ユーザの手をパー形状の状態から図1の判定領域DR11−1まで移動させるジェスチャが行なわれた旨のジェスチャ認識結果をジェスチャ処理部26に供給する。

【0080】

ステップS19において、ジェスチャ処理部26は、ジェスチャ認識部25からのジェスチャ認識結果に応じた処理を行なう。例えば、ジェスチャ処理部26は、ジェスチャの認識結果を示す画像を表示部27に供給して表示させたり、ジェスチャに応じて表示部27に表示する番組のチャンネルを変更したりする。

【0081】

ステップS20において、画像処理装置11は、処理を終了するか否かを判定する。例えば、ユーザによりジェスチャ認識に応じた処理の実行の終了が指示された場合、処理を終了すると判定される。

【0082】

ステップS20において、処理を終了しないと判定された場合、処理はステップS12に戻り、上述した処理が繰り返される。すなわち、新たなジェスチャの認識が行なわれる。

【0083】

これに対してステップS20において、処理を終了すると判定された場合、画像処理装置11は各部の処理を停止させ、ジェスチャ認識処理は終了する。

【0084】

以上のようにして、画像処理装置11は、入力画像から特定形状の手を検出し、その検出結果に基づいて判定領域を設定して、判定領域への手の移動を監視することで、ユーザのジェスチャを認識する。

【0085】

このように、手形状の検出結果に基づいて判定領域を設定することで、ジェスチャごとに適切な判定領域を定めることができ、より高速かつ高精度にジェスチャを認識することができる。また、入力画像の解像度によらず、安定した速度でジェスチャ認識可能である。

【0086】

しかも、手が認識されるごとにユーザの手の色が抽出されて、その色情報が手検出情報として保持されるとともに、ジェスチャ認識時には、手の領域近傍のみが監視対象とされる。したがって、照明条件が変化して入力画像上のユーザの手の色が変化したり、入力画像の背景に手の色と類似する色の被写体がある場合でも、高精度に手の領域を特定することができ、ジェスチャの認識精度をさらに向上させることができる。

【0087】

また、特定形状の手が検出された後は、その検出結果に基づいて設定された判定領域の監視によりジェスチャ認識が行なわれるため、ユーザの手形状によらずジェスチャを認識することができる。つまり、ユーザは、同じ手形状のままジェスチャを行なう必要がなくなり、簡単なジェスチャで操作入力を行なうことができる。

【0088】

〈変形例1〉

[ジェスチャ認識処理の説明]

なお、以上においては、ジェスチャ認識処理において、入力画像の撮影開始後、手形状認識とジェスチャ認識とが常に継続して行なわれる場合について説明したが、手形状認識により手が検出された後、一定期間はジェスチャ認識のみが行なわれるようにしてもよい。すなわち、手形状認識により手が検出されると、その後、ジェスチャが認識されるまでジェスチャ認識のみが継続して行なわれ、一定期間が経過してもジェスチャが認識されなかった場合に、再び手形状認識が行なわれる。

【0089】

そのような場合、画像処理装置11は、図5に示すジェスチャ認識処理を行なう。以下、図5のフローチャートを参照して、画像処理装置11によるジェスチャ認識処理について説明する。

【0090】

なお、ステップS81およびステップS82の処理は図3のステップS11およびステップS12の処理と同様であるため、その説明は省略する。

【0091】

ステップS83において、手形状認識部22は、処理対象のフレームの入力画像から特定形状の手が検出されたか否かを判定する。ステップS83において、特定形状の手が検出されなかったと判定された場合、処理はステップS82に戻り、上述した処理が繰り返される。すなわち、特定形状の手が検出されるまで、手形状認識が繰り返し行なわれる。

【0092】

これに対して、ステップS83において、特定形状の手が検出されたと判定された場合、その後、ステップS84乃至ステップS87の処理が行なわれる。なお、これらの処理は図3のステップS15乃至ステップS18の処理と同様であるので、その説明は省略する。

【0093】

また、ステップS87において、ジェスチャが行なわれなかったと判定された場合、ステップS90において、ジェスチャ認識部25は、手形状認識により特定形状の手が認識されてから一定期間、ジェスチャが認識されなかったか否かを判定する。

【0094】

ステップS90において、一定期間、ジェスチャが認識されなかったと判定された場合、処理はステップS82に戻り、上述した処理が繰り返される。つまり、新たに手形状認識が行なわれて、その結果得られた情報に基づいてジェスチャ認識が行なわれる。

【0095】

一方、ステップS90において、一定期間、ジェスチャが認識されなかったと判定されなかった場合、つまりジェスチャ認識が開始されてからまだ一定期間経過していない場合、処理はステップS86に戻り、上述した処理が繰り返される。すなわち、継続してジェスチャ認識が行なわれる。

【0096】

また、ステップS87においてジェスチャが行なわれたと判定された場合、その後ステップS88およびステップS89の処理が行なわれてジェスチャ認識処理は終了するが、これらの処理は図3のステップS19およびステップS20と同様であるので、その説明は省略する。

【0097】

以上のようにして画像処理装置11は、入力画像から特定形状の手を検出し、その検出結果に基づいてユーザのジェスチャを認識する。

【0098】

〈第2の実施の形態〉

[画像処理装置の構成例]

なお、以上においては、ユーザの手の色と入力画像の差分情報を用いてジェスチャ認識を行なうと説明したが、ユーザの手の色のみを用いてジェスチャ認識を行なうようにしてもよい。そのような場合、画像処理装置は、図6に示すように構成される。なお、図6において、図2における場合と対応する部分には同一の符号を付してあり、その説明は適宜省略する。

【0099】

図6の画像処理装置71は、撮影部21乃至表示部27から構成される。この画像処理装置71の構成は、ジェスチャ認識部25に差分検出部43が設けられていない点で画像処理装置11と異なり、その他の点では画像処理装置11と同じとなっている。

【0100】

[判定領域監視処理の説明]

また、画像処理装置71も図3を参照して説明したジェスチャ認識処理と同様の処理を行なう、但し、ステップS17の判定領域監視処理では、ユーザの手の色の領域が判定領域に移動したかが監視される。

【0101】

以下、図7のフローチャートを参照して、画像処理装置71により行なわれる図3のジェスチャ認識処理のステップS17の処理に対応する判定領域監視処理について説明する。

【0102】

ステップS121において、色検出部42は、撮影部21から供給された処理対象の入力画像における判定領域内の各位置の色を特定する。そして、ステップS122において、色検出部42は、判定領域の色と、手検出情報に含まれる色情報により示されるユーザの手の色とを比較する。すなわち、判定領域の色がユーザの手の色と同じであれば、ユーザの手が判定領域内に移動してきたことになり、ジェスチャが行なわれたことが分かる。これらのステップS121およびステップS122の処理は図4のステップS51およびステップS52の処理と同様の処理である。

【0103】

ステップS122の処理が行なわれて、判定領域の色とユーザの手の色とが比較されると、判定領域監視処理は終了し、その後、処理は図3のステップS18に進む。そして、ステップS18乃至ステップS20の処理が行なわれてジェスチャ認識処理は終了する。但し、ステップS18では、判定領域の色が色情報により示されるユーザの手の色である場合、ユーザによりジェスチャが行なわれたと判定される。

【0104】

なお、画像処理装置71により図5を参照して説明したジェスチャ認識処理が行なわれるようにしてもよい。そのような場合、ステップS81乃至ステップS90では、基本的には画像処理装置11における場合と同様の処理が行なわれるが、ステップS86では、図7を参照して説明した判定領域監視処理が行なわれる。また、ステップS87では、判定領域の色が色情報により示されるユーザの手の色である場合、ユーザによりジェスチャが行なわれたと判定される。

【0105】

〈第3の実施の形態〉

[画像処理装置の構成例]

また、ジェスチャ認識時に、入力画像の差分情報のみが用いられるようにしてもよい。そのような場合、画像処理装置は、図8に示すように構成される。なお、図8において、図2における場合と対応する部分には同一の符号を付してあり、その説明は適宜省略する。

【0106】

図8の画像処理装置101は、撮影部21乃至表示部27から構成される。この画像処理装置101の構成は、手形状認識部22に色抽出部41が設けられておらず、またジェスチャ認識部25に色検出部42が設けられていない点で画像処理装置11と異なり、その他の点では画像処理装置11と同じとなっている。

【0107】

なお、画像処理装置101では、手検出情報保持部23に保持される手検出情報には、色情報は含まれず、この手検出情報はジェスチャ認識部25には供給されない。

【0108】

[判定領域監視処理の説明]

また、画像処理装置101は、図3を参照して説明したジェスチャ認識処理と同様の処理を行なう。但し、ステップS15では、手形状認識の結果として得られた手の形状、手の大きさ、および手の位置を示す情報が手検出情報として手検出情報保持部23に保持される。

【0109】

また、ステップS17の判定領域監視処理では、入力画像の差分情報に基づいて、ユーザの手の領域が判定領域に移動したかが監視される。

【0110】

以下、図9のフローチャートを参照して、画像処理装置101により行なわれる図3のジェスチャ認識処理のステップS17の処理に対応する判定領域監視処理について説明する。

【0111】

ステップS151において、差分検出部43は、撮影部21から供給された処理対象のフレームの入力画像と、処理対象のフレームよりも前のフレームの入力画像とのフレーム間の差分を求める。そして、ステップS152において、差分検出部43は、入力画像のフレーム間の差分に基づいて、入力画像上の差分領域を特定する。これらのステップS151およびステップS152の処理は図4のステップS53およびステップS54の処理と同様の処理である。

【0112】

ステップS152の処理が行なわれて、入力画像上の差分領域が特定されると、判定領域監視処理は終了し、その後、処理は図3のステップS18に進む。そして、ステップS18乃至ステップS20の処理が行なわれてジェスチャ認識処理は終了する。但し、ステップS18では、判定領域の一部または全部が差分領域内に含まれる場合、ユーザによりジェスチャが行なわれたと判定される。

【0113】

なお、画像処理装置101により図5を参照して説明したジェスチャ認識処理が行なわれるようにしてもよい。そのような場合においても、ステップS81乃至ステップS90では、基本的には画像処理装置11における場合と同様の処理が行なわれる。

【0114】

但し、ステップS84では、手形状の認識結果のみから手検出情報が生成され、ステップS86では、図9を参照して説明した判定領域監視処理が行なわれる。また、ステップS87では、判定領域の一部または全部が差分領域内に含まれる場合、ユーザによりジェスチャが行なわれたと判定される。

【0115】

〈第4の実施の形態〉

[認識対象のジェスチャについて]

なお、以上においては、1つの特定形状の手を認識させた後、ジェスチャが行なわれる場合について説明したが、ジェスチャによって、ジェスチャの開始時に画像処理装置に認識させる手の形状が異なるようにしてもよい。これにより、より多くのジェスチャを認識対象とすることができ、多様なジェスチャ操作を実現することができる。

【0116】

そのような場合、例えば図10の上側に示す手形状を検出させ、図中、下側に示すジェスチャを認識対象のジェスチャとすることが考えられる。なお、図10では、矢印A11乃至矢印A18により検出させる手形状が示されており、矢印B11乃至矢印B18に、矢印A11乃至矢印A18に示した手形状ごとのジェスチャが示されている。

【0117】

例えば、矢印A11に示す手形状は、手をカメラ等の撮影部に対して横に向け、親指とその他の指とで何かをつまんでいる状態(以下、つまみ形状とも称する)の手形状となっている。この場合、ユーザは、手を矢印A11に示すつまみ形状とした後、矢印B11に示すように、親指と、その他の指とを図中、上下方向に何度か移動させ、何かをつまんだり、離したりするようなジェスチャを行なう。

【0118】

このようなジェスチャでは、つまみ形状の手の親指と人差し指の指先から上下方向に所定の距離だけ離れた位置に判定領域DR21−1と判定領域DR21−2が設けられる。ここで、つまみ形状の手における親指や人差し指のおおよその位置は、手形状認識の結果から特定することが可能である。また、例えば指先から判定領域DR21−1と判定領域DR21−2までの距離は、例えば手の上下方向の長さ(高さ)により定められる。

【0119】

矢印A12に示す手形状は、図1の例と同様にパー形状となっている。この場合、ユーザは、手をパー形状とした後、矢印B12に示すように、左右のどちらかの方向に手を移動させるジェスチャを行なう。このようなジェスチャでは、手のひらの中心から左右方向に所定の距離だけ離れた位置に判定領域DR22−1と判定領域DR22−2が設けられる。

【0120】

なお、以下では、手形状認識の結果により、認識された特定形状の手の各部位のおおよその位置が特定できるものとして説明を続ける。

【0121】

例えば、手形状認識でパー形状の手が認識された場合、手の領域の輪郭から手のひらの中心位置と、手の各指先の候補となる位置(以下、指先候補位置と称する)とが定められ、中心位置と各指先候位置とを結ぶ線分の傾きから各指先のおおよその位置が特定される。つまり、中心位置と指先候補位置とから定まる指の輪郭の角度から、指先候補位置の確からしさを求めることができる。このように、手形状認識の結果に基づいて、各形状の手の所望の部位のおおよその位置を特定することができる。

【0122】

矢印A13に示す手形状は、グーの状態から親指と小指を立てた手形状となっている。この場合、ユーザは、手を矢印A13に示す形状とした後、矢印B13に示すように、図中、縦方向の線を回転軸として手首を回転させるジェスチャを行なう。

【0123】

このようなジェスチャでは、小指と親指のそれぞれの図中、下方向に所定の距離だけ離れた位置に判定領域DR23−1と判定領域DR23−2が設けられる。例えば、判定領域DR23−1と判定領域DR23−2の位置は、手の中心位置と、親指および小指の指先の位置から定められる。この例では、例えば小指と親指の一方または両方が、判定領域DR23−1や判定領域DR23−2に移動された場合、ジェスチャが行なわれたとされる。

【0124】

矢印A14に示す手形状はグーの手形状となっている。この場合、ユーザは手をグー形状とした後、矢印B14に示すように、左右のどちらかの方向に手を移動させるジェスチャを行なう。このようなジェスチャでは、手の中心から左右方向に所定の距離だけ離れた位置に判定領域DR24−1と判定領域DR24−2が設けられる。手の中心から判定領域DR24−1や判定領域DR24−2までの距離は、例えば手の横方向の長さ(幅)により定められる。

【0125】

矢印A15に示す手形状は、チョキの手形状、すなわち人差し指と中指を開き、他の指を閉じた状態の手形状となっている。この場合、ユーザは、手をチョキ形状とした後、矢印B15に示すように、図中、奥行き方向の線を回転軸として手首を左右に回転させるジェスチャを行なう。

【0126】

このようなジェスチャでは、中指と人差し指のそれぞれの図中、斜め下方向に、各指から所定の距離だけ離れた位置に判定領域DR25−1と判定領域DR25−2が設けられる。例えば、判定領域DR25−1と判定領域DR25−2の位置は、手の中心位置と、人差し指および中指の指先の位置から定められる。この例では、中指と人差し指の一方または両方が、判定領域DR25−1や判定領域DR25−2に移動された場合、ジェスチャが行なわれたとされる。

【0127】

また、矢印A16に示す手形状は、グー形状の手を縦向きにして親指を立てた、いわゆるサムアップの手形状となっている。この場合、ユーザは、矢印A16に示す手形状とした後、矢印B16に示すように、図中、奥行き方向の線を回転軸として手首を左右に回転させるジェスチャを行なう。

【0128】

このようなジェスチャでは、親指の指先の図中、左右の斜め下方向のそれぞれに、親指から所定の距離だけ離れた位置に判定領域DR26−1と判定領域DR26−2が設けられる。例えば、判定領域DR26−1と判定領域DR26−2の位置は、手の中心位置と、親指の指先の位置から定められる。この例では、親指が、判定領域DR26−1と判定領域DR26−2の一方または両方に移動された場合、ジェスチャが行なわれたとされる。

【0129】

矢印A17に示す手形状は、グー形状の状態から人差し指を開いた、いわゆる指差しの手形状となっている。この場合、ユーザは、矢印A17に示す手形状とした後、矢印B17に示すように、図中、奥行き方向の線を回転軸として手首を左右に回転させるジェスチャを行なう。

【0130】

このようなジェスチャでは人指し指の指先の図中、左右方向のそれぞれに、人指し指から所定の距離だけ離れた位置に判定領域DR27−1と判定領域DR27−2が設けられる。例えば、判定領域DR27−1と判定領域DR27−2の位置は、人差し指の指先の位置と、手の高さまたは幅とから定められる。この例では、例えば人差し指が、判定領域DR27−1と判定領域DR27−2の一方または両方に移動された場合、ジェスチャが行なわれたとされる。

【0131】

さらに、矢印A18に示す手形状は、グー形状の状態から人差し指を開き、人差し指を図中、手前方向に向けた指差しの手形状となっている。この場合、ユーザは手を矢印A18に示す手形状とした後、矢印B18に示すように、左右のどちらかの方向に手を移動させるジェスチャを行なう。このようなジェスチャでは、手の中心から左右方向に所定の距離だけ離れた位置に判定領域DR28−1と判定領域DR28−2が設けられる。手の中心から判定領域DR28−1や判定領域DR28−2までの距離は、例えば手の横方向の長さ(幅)により定められる。

【0132】

なお、ユーザにより行なわれるジェスチャは、図10に示した例に限らず、その他、どのようなものであってもよい。

【0133】

[画像処理装置の構成例]

図10に示したようにユーザにより複数のジェスチャが行なわれ、それらのジェスチャの認識結果に応じた処理が行なわれる場合、画像処理装置は例えば図11に示すように構成される。なお、図11において、図2における場合と対応する部分には同一の符号を付してあり、その説明は適宜省略する。

【0134】

図11の画像処理装置131は、撮影部21乃至表示部27から構成される。この画像処理装置131の構成は、手形状認識部22に新たに手形状特定部141が設けられている点で画像処理装置11と異なり、その他の点では画像処理装置11と同じとなっている。

【0135】

手形状認識部22は、例えば図10で示した複数の手形状ごとに、それらの手形状を認識するための辞書を記録しており、撮影部21から供給された入力画像に対して各辞書を用いた手形状認識を行なう。

【0136】

また、手形状認識部22は、手形状特定部141を備えており、手形状特定部141は、各手形状の辞書を用いた手形状認識により得られたスコアに基づいて、入力画像に含まれる手の形状を特定する。

【0137】

[ジェスチャ認識処理の説明]

次に、図12のフローチャートを参照して、画像処理装置131によるジェスチャ認識処理について説明する。なお、ステップS181乃至ステップS184の処理は図3のステップS11乃至ステップS14の処理と同様であるので、その説明は省略する。

【0138】

但し、ステップS182では、手形状認識部22は、手形状ごとの辞書について、入力画像に対するフィルタ処理を行なって特定形状の手らしさのスコアを求める。すなわち、入力画像の領域ごとのスコアのうち、最も高いスコアがその辞書を用いた手形状認識のスコアとされる。

【0139】

そして、手形状ごとのスコアのうち、1つでも所定の閾値以上のスコアがある場合、ステップS183で特定形状の手が検出されたと判定される。

【0140】

ステップS183で特定形状の手が検出されたと判定された場合、処理はステップS185に進む。そしてステップS185において、手形状特定部141は、手形状認識を行なった各手形状のうち、最もスコアの高い手形状が、手形状認識により検出された手の形状であるとして、入力画像上の手の形状を特定する。

【0141】

入力画像に含まれる手の形状が特定されると、その後、ステップS186乃至ステップS191の処理が行なわれてジェスチャ認識処理は終了するが、これらの処理は図3のステップS15乃至ステップS20の処理と同様であるので、その説明は省略する。

【0142】

但し、ステップS186では、ステップS185により特定された手形状についての手形状認識の結果と、その手形状認識の結果に基づいて色抽出部41により生成された色情報とが手検出情報として手検出情報保持部23に保持される。

【0143】

したがって、図12のジェスチャ認識処理では、異なる形状の手が検出されるごとに、手検出情報保持部23に保持される手検出情報が、異なる手形状の手検出情報に更新されることになる。

【0144】

そして、ステップS187では、特定された手形状ごとに、すなわち認識対象となるジェスチャごとに適切な判定領域が設定される。例えば、図10の矢印A11に示したつまみ形状の手が検出されると、矢印B11に示したように判定領域DR21−1と判定領域DR21−2が設定され、それらの両方の判定領域に親指や人差し指が移動されたと特定された場合に、ジェスチャが行なわれたとされる。

【0145】

また、ステップS188では、図4を参照して説明した判定領域監視処理と同様の処理が行なわれることになる。

【0146】

以上のようにして、画像処理装置131は、入力画像から複数の形状のうちの何れかの形状の手を検出し、その検出結果に基づいて判定領域を設定し、判定領域への手の移動を監視することで、ユーザのジェスチャを認識する。このように、手形状の検出結果に基づいて、検出された手形状ごとに判定領域を設定することで、各ジェスチャに対して適切な判定領域を定めることができ、より高速かつ高精度にジェスチャを認識することができる。

【0147】

〈変形例2〉

[ジェスチャ認識処理の説明]

また、画像処理装置131によるジェスチャ認識処理においても、手形状認識により手が検出された後、一定期間はジェスチャ認識のみが行なわれるようにしてもよい。

【0148】

そのような場合、画像処理装置131は、図13に示すジェスチャ認識処理を行なう。以下、図13のフローチャートを参照して、画像処理装置131によるジェスチャ認識処理について説明する。

【0149】

なお、ステップS221乃至ステップS223では、図5のステップS81乃至ステップS83の処理と同様の処理が行なわれるので、その説明は省略する。

【0150】

但し、ステップS222では、手形状認識部22は、図12のステップS182の処理と同様に、手形状ごとに辞書を用いた手形状認識を行い、ステップS223では、手形状ごとのスコアのうち、1つでも所定の閾値以上のスコアがある場合、特定形状の手が検出されたと判定される。

【0151】

ステップS223において、特定形状の手が検出されたと判定された場合、ステップS224において、手形状特定部141は、各手形状の手形状認識の結果に基づいて、入力画像上の手の形状を特定する。すなわち、ステップS224では、図12のステップS185と同様の処理が行なわれる。

【0152】

そして、手形状が特定されると、その後、ステップS225乃至ステップS231の処理が行なわれてジェスチャ認識処理は終了するが、これらの処理は図5のステップS84乃至ステップS90の処理と同様であるので、その説明は省略する。但し、ステップS225では、図12のステップS186と同様に、特定された手形状についての手形状認識の結果と、その手形状認識の結果に基づいて生成された色情報とが手検出情報として手検出情報保持部23に保持される。また、ステップS227では、図4を参照して説明した判定領域監視処理と同様の処理が行なわれる。

【0153】

以上のようにして画像処理装置131は、入力画像から複数の形状のうちの何れかの形状の手を検出し、その検出結果に基づいてユーザのジェスチャを認識する。

【0154】

〈第5の実施の形態〉

[画像処理装置の構成例]

なお、複数の手形状を認識対象の手形状とする場合においても、ユーザの手の色のみを用いてジェスチャ認識を行なうようにしてもよい。そのような場合、画像処理装置は、図14に示すように構成される。なお、図14において、図11における場合と対応する部分には同一の符号を付してあり、その説明は適宜省略する。

【0155】

図14の画像処理装置171は、撮影部21乃至表示部27から構成される。この画像処理装置171の構成は、ジェスチャ認識部25に差分検出部43が設けられていない点で画像処理装置131と異なり、その他の点では画像処理装置131と同じとなっている。

【0156】

[ジェスチャ認識処理の説明]

また、画像処理装置171も図12を参照して説明したジェスチャ認識処理と同様の処理を行なう、但し、ステップS188の判定領域監視処理では、ユーザの手の色の領域が判定領域に移動したかが監視される。すなわち、図7を参照して説明した判定領域監視処理が行なわれる。

【0157】

したがって、例えばステップS189では、判定領域の色が色情報により示されるユーザの手の色である場合、ユーザによりジェスチャが行なわれたと判定される。

【0158】

なお、画像処理装置171により図13を参照して説明したジェスチャ認識処理が行なわれるようにしてもよい。そのような場合、ステップS221乃至ステップS231では、基本的に画像処理装置131における場合と同様の処理が行なわれるが、ステップS227では、図7を参照して説明した判定領域監視処理が行なわれる。また、ステップS228では、判定領域の色が色情報により示されるユーザの手の色である場合、ユーザによりジェスチャが行なわれたと判定される。

【0159】

〈第6の実施の形態〉

[画像処理装置の構成例]

また、複数の手形状を認識対象の手形状とする場合において、ジェスチャ認識時に、入力画像の差分情報のみが用いられるようにしてもよい。そのような場合、画像処理装置は、図15に示すように構成される。なお、図15において、図11における場合と対応する部分には同一の符号を付してあり、その説明は適宜省略する。

【0160】

図15の画像処理装置201は、撮影部21乃至表示部27から構成される。この画像処理装置201の構成は、手形状認識部22に色抽出部41が設けられておらず、またジェスチャ認識部25に色検出部42が設けられていない点で画像処理装置131と異なり、その他の点では画像処理装置131と同じとなっている。

【0161】

なお、画像処理装置201では、手検出情報保持部23に保持される手検出情報には、色情報は含まれず、この手検出情報はジェスチャ認識部25には供給されない。

【0162】

[ジェスチャ認識処理の説明]

また、画像処理装置201は、図12を参照して説明したジェスチャ認識処理と同様の処理を行なう。但し、ステップS186では、手形状認識の結果として得られた手の形状、手の大きさ、および手の位置を示す情報が手検出情報として手検出情報保持部23に保持される。

【0163】

また、ステップS188の判定領域監視処理では、入力画像の差分情報に基づいて、ユーザの手の領域が判定領域に移動したかが監視される。すなわち、図9を参照して説明した判定領域監視処理が行なわれる。したがって、ステップS189では、判定領域の一部または全部が差分領域内に含まれる場合、ユーザによりジェスチャが行なわれたと判定される。

【0164】

なお、画像処理装置201により図13を参照して説明したジェスチャ認識処理が行なわれるようにしてもよい。そのような場合においても、ステップS221乃至ステップS231では、基本的には画像処理装置131における場合と同様の処理が行なわれる。

【0165】

但し、ステップS225では、手形状の認識結果のみから手検出情報が生成され、ステップS227では、図9を参照して説明した判定領域監視処理が行なわれる。また、ステップS228では、判定領域の一部または全部が差分領域内に含まれる場合、ユーザによりジェスチャが行なわれたと判定される。

【0166】

〈第7の実施の形態〉

[画像処理装置の構成例]

さらに、以上においては、手形状認識により手を検出する例について説明したが、ユーザの手の色がある程度推定可能である場合には、手の色情報のみを用いてジェスチャ認識を行なうようにしてもよい。

【0167】

そのような場合、画像処理装置は、例えば図16に示すように構成される。なお、図16において、図2における場合と対応する部分には同一の符号を付してあり、その説明は適宜省略する。

【0168】

図16の画像処理装置231は、撮影部21、色抽出部241、領域抽出部242、判定領域設定部243、ジェスチャ認識部244、ジェスチャ処理部26、および表示部27から構成される。

【0169】

色抽出部241は、撮影部21から供給された入力画像から、予めユーザの手の色として登録された色の画素を抽出し、その抽出結果を領域抽出部242に供給する。領域抽出部242は、色抽出部241からの手の色の抽出結果に基づいて、入力画像からユーザの手の領域を抽出し、ユーザの手の領域を判定領域設定部243に供給する。

【0170】

判定領域設定部243は、領域抽出部242から供給されたユーザの手の領域に基づいて判定領域を設定し、ジェスチャ認識部244に供給する。ジェスチャ認識部244は、撮影部21からの入力画像と、判定領域設定部243からの判定領域とに基づいて、ユーザによるジェスチャの認識を行い、その認識結果をジェスチャ処理部26に供給する。

【0171】

[ジェスチャ認識処理の説明]

次に、図17のフローチャートを参照して、画像処理装置231によるジェスチャ認識処理について説明する。

【0172】

ステップS261において、撮影部21は、入力画像の撮影を開始する。撮影部21は、撮影により得られた入力画像を順次、色抽出部241およびジェスチャ認識部244に供給する。

【0173】

ステップS262において、色抽出部241は、撮影部21から供給された入力画像から、予めユーザの手の色として登録された色の領域(画素)を抽出する。

【0174】

ステップS263において、色抽出部241は、入力画像からのユーザの手の色の抽出結果に基づいて、入力画像からユーザの手が検出されたか否かを判定する。例えば、入力画像上にユーザの手の色からなる、所定の大きさ以上の領域がある場合、ユーザの手が検出されたと判定される。

【0175】

ステップS263において、ユーザの手が検出されなかったと判定された場合、処理はステップS262に戻り、上述した処理が繰り返される。

【0176】

これに対して、ステップS263において、ユーザの手が検出されたと判定された場合、色抽出部241は、入力画像からのユーザの手の色の画素の抽出結果を領域抽出部242に供給し、処理はステップS264に進む。

【0177】

ステップS264において、領域抽出部242は、色抽出部241からの手の色の抽出結果に基づいて、入力画像からユーザの手の領域を抽出し、ユーザの手の領域を判定領域設定部243に供給する。例えば、領域抽出部242は、入力画像上のユーザの手の色の画素からなる領域のうち、最も大きい領域など、最もユーザの手らしい領域を、ユーザの手の領域として抽出する。

【0178】

ステップS265において、判定領域設定部243は、領域抽出部242から供給されたユーザの手の領域に基づいて判定領域を定め、ジェスチャ認識部244に供給する。具体的には、入力画像上のユーザの手の領域から、その領域の中心位置、ユーザの手のおおよその高さや幅などが求まる。そこで、例えばユーザの手の領域の中心位置から、左右方向にユーザの手の幅により定まる距離だけ離れた位置など、認識対象のジェスチャに応じた位置および大きさの判定領域が設定される。

【0179】

ステップS266において、ジェスチャ認識部244は、撮影部21からの入力画像と、判定領域設定部243からの判定領域とに基づいて、ユーザによるジェスチャが行なわれたか否かを判定する。

【0180】

例えば、ジェスチャ認識部244は、ユーザの手の領域と、入力画像の差分領域とのうちの少なくとも一方に基づいて、ユーザのジェスチャ認識を行なう。

【0181】

例えば、ジェスチャ認識部244は、入力画像上のユーザの手の領域が、設定した判定領域に移動し、かつ入力画像の連続するフレーム間の差分により求まる動被写体の領域が判定領域に移動した場合、ユーザによるジェスチャが行なわれたと判定される。

【0182】

ステップS266において、ジェスチャが行われなかったと判定された場合、処理はステップS262に戻り、上述した処理が繰り返される。

【0183】

これに対して、ステップS266において、ジェスチャが行なわれたと判定された場合、ジェスチャ認識部244は、ユーザによるジェスチャの認識結果をジェスチャ処理部26に供給し、処理はステップS267に進む。

【0184】

ステップS267において、ジェスチャ処理部26は、ジェスチャ認識部244からのジェスチャ認識結果に応じた処理を行ない、ジェスチャ認識処理は終了する。例えば、ジェスチャ処理部26は、ジェスチャの認識結果を示す画像を表示部27に供給して表示させたり、ジェスチャに応じて表示部27に表示する番組のチャンネルを変更したりする。

【0185】

以上のようにして画像処理装置231は、入力画像から特定の色の領域を抽出することでユーザの手の領域を検出し、その検出結果に基づいて判定領域を設定してユーザのジェスチャ認識を行なう。このように、ユーザの手の領域の検出結果に基づいて判定領域を設定することで、より高速かつ高精度にジェスチャ認識を行なうことができる。

【0186】

上述した一連の処理は、ハードウェアにより実行することもできるし、ソフトウェアにより実行することもできる。一連の処理をソフトウェアにより実行する場合には、そのソフトウェアを構成するプログラムが、専用のハードウェアに組み込まれているコンピュータ、または、各種のプログラムをインストールすることで、各種の機能を実行することが可能な、例えば汎用のパーソナルコンピュータなどに、プログラム記録媒体からインストールされる。

【0187】

図18は、上述した一連の処理をプログラムにより実行するコンピュータのハードウェアの構成例を示すブロック図である。

【0188】

コンピュータにおいて、CPU(Central Processing Unit)301,ROM(Read Only Memory)302,RAM(Random Access Memory)303は、バス304により相互に接続されている。

【0189】

バス304には、さらに、入出力インターフェース305が接続されている。入出力インターフェース305には、キーボード、マウス、マイクロホンなどよりなる入力部306、ディスプレイ、スピーカなどよりなる出力部307、ハードディスクや不揮発性のメモリなどよりなる記録部308、ネットワークインターフェースなどよりなる通信部309、磁気ディスク、光ディスク、光磁気ディスク、或いは半導体メモリなどのリムーバブルメディア311を駆動するドライブ310が接続されている。

【0190】

以上のように構成されるコンピュータでは、CPU301が、例えば、記録部308に記録されているプログラムを、入出力インターフェース305及びバス304を介して、RAM303にロードして実行することにより、上述した一連の処理が行われる。

【0191】

コンピュータ(CPU301)が実行するプログラムは、例えば、磁気ディスク(フレキシブルディスクを含む)、光ディスク(CD-ROM(Compact Disc-Read Only Memory),DVD(Digital Versatile Disc)等)、光磁気ディスク、もしくは半導体メモリなどよりなるパッケージメディアであるリムーバブルメディア311に記録して、あるいは、ローカルエリアネットワーク、インターネット、デジタル衛星放送といった、有線または無線の伝送媒体を介して提供される。

【0192】

そして、プログラムは、リムーバブルメディア311をドライブ310に装着することにより、入出力インターフェース305を介して、記録部308にインストールすることができる。また、プログラムは、有線または無線の伝送媒体を介して、通信部309で受信し、記録部308にインストールすることができる。その他、プログラムは、ROM302や記録部308に、あらかじめインストールしておくことができる。

【0193】

なお、コンピュータが実行するプログラムは、本明細書で説明する順序に沿って時系列に処理が行われるプログラムであっても良いし、並列に、あるいは呼び出しが行われたとき等の必要なタイミングで処理が行われるプログラムであっても良い。

【0194】

また、本技術の実施の形態は、上述した実施の形態に限定されるものではなく、本技術の要旨を逸脱しない範囲において種々の変更が可能である。

【0195】

さらに、本技術は、以下の構成とすることも可能である。

【0196】

[1]

入力画像に対する手形状認識を行って、前記入力画像における特定形状の手の位置と大きさを検出する手形状認識部と、

前記手の位置および大きさに基づいて、前記入力画像上の前記手近傍の領域を、前記手を用いたジェスチャの認識の判定領域として設定する判定領域設定部と、

前記手の前記判定領域への移動を監視することで、前記ジェスチャを認識するジェスチャ認識部と

を備える画像処理装置。

[2]

前記判定領域設定部は、前記入力画像上の前記手近傍に複数の前記判定領域を設定する

[1]に記載の画像処理装置。

[3]

複数の前記判定領域のそれぞれは、互いに異なる前記ジェスチャを認識するための領域である

[2]に記載の画像処理装置。

[4]

前記ジェスチャの認識結果に応じた処理を行う処理部をさらに備える

[1]乃至[3]の何れかに記載の画像処理装置。

[5]

前記ジェスチャ認識部は、検出された前記手の領域から抽出された色と、前記入力画像上の前記判定領域の色とを比較することで、前記ジェスチャを認識する

[1]乃至[4]の何れかに記載の画像処理装置。

[6]

前記ジェスチャ認識部は、前記入力画像のフレーム間の差分に基づいて前記手の前記判定領域への移動を監視し、前記ジェスチャを認識する

[1]乃至[4]の何れかに記載の画像処理装置。

[7]

前記手形状認識部は、予め定められた複数の形状の手の位置と大きさの検出を行なう

[1]乃至[6]の何れかに記載の画像処理装置。

[8]

前記判定領域設定部は、新たに特定形状の前記手の位置と大きさが検出された場合、新たに検出された前記手の形状、位置、および大きさに基づいて前記判定領域を設定する

[7]に記載の画像処理装置。

【符号の説明】

【0197】

11 画像処理装置, 22 手形状認識部, 23 手検出情報保持部, 24 判定領域設定部, 25 ジェスチャ認識部, 41 色抽出部, 42 色検出部, 43 差分検出部, 141 手形状特定部

【特許請求の範囲】

【請求項1】

入力画像に対する手形状認識を行って、前記入力画像における特定形状の手の位置と大きさを検出する手形状認識部と、

前記手の位置および大きさに基づいて、前記入力画像上の前記手近傍の領域を、前記手を用いたジェスチャの認識の判定領域として設定する判定領域設定部と、

前記手の前記判定領域への移動を監視することで、前記ジェスチャを認識するジェスチャ認識部と

を備える画像処理装置。

【請求項2】

前記判定領域設定部は、前記入力画像上の前記手近傍に複数の前記判定領域を設定する

請求項1に記載の画像処理装置。

【請求項3】

複数の前記判定領域のそれぞれは、互いに異なる前記ジェスチャを認識するための領域である

請求項2に記載の画像処理装置。

【請求項4】

前記ジェスチャの認識結果に応じた処理を行う処理部をさらに備える

請求項3に記載の画像処理装置。

【請求項5】

前記ジェスチャ認識部は、検出された前記手の領域から抽出された色と、前記入力画像上の前記判定領域の色とを比較することで、前記ジェスチャを認識する

請求項4に記載の画像処理装置。

【請求項6】

前記ジェスチャ認識部は、前記入力画像のフレーム間の差分に基づいて前記手の前記判定領域への移動を監視し、前記ジェスチャを認識する

請求項4に記載の画像処理装置。

【請求項7】

前記手形状認識部は、予め定められた複数の形状の手の位置と大きさの検出を行なう

請求項6に記載の画像処理装置。

【請求項8】

前記判定領域設定部は、新たに特定形状の前記手の位置と大きさが検出された場合、新たに検出された前記手の形状、位置、および大きさに基づいて前記判定領域を設定する

請求項7に記載の画像処理装置。

【請求項9】

入力画像に対する手形状認識を行って、前記入力画像における特定形状の手の位置と大きさを検出する手形状認識部と、

前記手の位置および大きさに基づいて、前記入力画像上の前記手近傍の領域を、前記手を用いたジェスチャの認識の判定領域として設定する判定領域設定部と、

前記手の前記判定領域への移動を監視することで、前記ジェスチャを認識するジェスチャ認識部と

を備える画像処理装置の画像処理方法であって、

前記手形状認識部が特定形状の前記手の位置と大きさを検出し、

前記判定領域設定部が前記判定領域を設定し、

前記ジェスチャ認識部が前記ジェスチャを認識する

ステップを含む画像処理方法。

【請求項10】

入力画像に対する手形状認識を行って、前記入力画像における特定形状の手の位置と大きさを検出し、

前記手の位置および大きさに基づいて、前記入力画像上の前記手近傍の領域を、前記手を用いたジェスチャの認識の判定領域として設定し、

前記手の前記判定領域への移動を監視することで、前記ジェスチャを認識する

ステップを含む処理をコンピュータに実行させるプログラム。

【請求項1】

入力画像に対する手形状認識を行って、前記入力画像における特定形状の手の位置と大きさを検出する手形状認識部と、

前記手の位置および大きさに基づいて、前記入力画像上の前記手近傍の領域を、前記手を用いたジェスチャの認識の判定領域として設定する判定領域設定部と、

前記手の前記判定領域への移動を監視することで、前記ジェスチャを認識するジェスチャ認識部と

を備える画像処理装置。

【請求項2】

前記判定領域設定部は、前記入力画像上の前記手近傍に複数の前記判定領域を設定する

請求項1に記載の画像処理装置。

【請求項3】

複数の前記判定領域のそれぞれは、互いに異なる前記ジェスチャを認識するための領域である

請求項2に記載の画像処理装置。

【請求項4】

前記ジェスチャの認識結果に応じた処理を行う処理部をさらに備える

請求項3に記載の画像処理装置。

【請求項5】

前記ジェスチャ認識部は、検出された前記手の領域から抽出された色と、前記入力画像上の前記判定領域の色とを比較することで、前記ジェスチャを認識する

請求項4に記載の画像処理装置。

【請求項6】

前記ジェスチャ認識部は、前記入力画像のフレーム間の差分に基づいて前記手の前記判定領域への移動を監視し、前記ジェスチャを認識する

請求項4に記載の画像処理装置。

【請求項7】

前記手形状認識部は、予め定められた複数の形状の手の位置と大きさの検出を行なう

請求項6に記載の画像処理装置。

【請求項8】

前記判定領域設定部は、新たに特定形状の前記手の位置と大きさが検出された場合、新たに検出された前記手の形状、位置、および大きさに基づいて前記判定領域を設定する

請求項7に記載の画像処理装置。

【請求項9】

入力画像に対する手形状認識を行って、前記入力画像における特定形状の手の位置と大きさを検出する手形状認識部と、

前記手の位置および大きさに基づいて、前記入力画像上の前記手近傍の領域を、前記手を用いたジェスチャの認識の判定領域として設定する判定領域設定部と、

前記手の前記判定領域への移動を監視することで、前記ジェスチャを認識するジェスチャ認識部と

を備える画像処理装置の画像処理方法であって、

前記手形状認識部が特定形状の前記手の位置と大きさを検出し、

前記判定領域設定部が前記判定領域を設定し、

前記ジェスチャ認識部が前記ジェスチャを認識する

ステップを含む画像処理方法。

【請求項10】

入力画像に対する手形状認識を行って、前記入力画像における特定形状の手の位置と大きさを検出し、

前記手の位置および大きさに基づいて、前記入力画像上の前記手近傍の領域を、前記手を用いたジェスチャの認識の判定領域として設定し、

前記手の前記判定領域への移動を監視することで、前記ジェスチャを認識する

ステップを含む処理をコンピュータに実行させるプログラム。

【図1】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図13】

【図14】

【図15】

【図16】

【図17】

【図18】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図13】

【図14】

【図15】

【図16】

【図17】

【図18】

【公開番号】特開2012−256098(P2012−256098A)

【公開日】平成24年12月27日(2012.12.27)

【国際特許分類】

【出願番号】特願2011−127331(P2011−127331)

【出願日】平成23年6月7日(2011.6.7)

【出願人】(000002185)ソニー株式会社 (34,172)

【出願人】(310021766)株式会社ソニー・コンピュータエンタテインメント (417)

【Fターム(参考)】

【公開日】平成24年12月27日(2012.12.27)

【国際特許分類】

【出願日】平成23年6月7日(2011.6.7)

【出願人】(000002185)ソニー株式会社 (34,172)

【出願人】(310021766)株式会社ソニー・コンピュータエンタテインメント (417)

【Fターム(参考)】

[ Back to top ]