画像認識装置、画像認識方法および画像認識プログラム

【課題】物体の認識を精度良く行うことができる画像認識装置を提供する。

【解決手段】画像認識装置1は、画像に対して3D解析手法による物体認識を行う3D解析手法による物体認識部13と、前記画像に対してパターン認識による物体認識を行うパターン認識による物体認識部14と、を備え、前記3D解析手法による物体認識部13により得られる3D解析手法による物体認識の結果と前記パターン認識による物体認識部14により得られるパターン認識による物体認識の結果に基づいて最終ターゲットの認識結果を得る、ことを特徴とする。

【解決手段】画像認識装置1は、画像に対して3D解析手法による物体認識を行う3D解析手法による物体認識部13と、前記画像に対してパターン認識による物体認識を行うパターン認識による物体認識部14と、を備え、前記3D解析手法による物体認識部13により得られる3D解析手法による物体認識の結果と前記パターン認識による物体認識部14により得られるパターン認識による物体認識の結果に基づいて最終ターゲットの認識結果を得る、ことを特徴とする。

【発明の詳細な説明】

【技術分野】

【0001】

本発明は、画像認識装置、画像認識方法および画像認識プログラムに関する。

【背景技術】

【0002】

近年、車両の運転支援装置や予防安全装置として、車間距離制御装置(ACC:Adaptive Cruise Control)や前方衝突警報装置(FCW:Forward Collision Warning)や歩行者衝突警報装置などが開発されている。このような装置では、レーダ等を用いずに、車載カメラのみによる簡易な装置の実現が期待されている。また、車載用の装置は、コストが重視されるため、ステレオカメラではなく、単眼カメラによる装置が求められている。

【0003】

単眼カメラでは、ステレオカメラによる方式に比べて物体の距離や相対速度を容易に推定することができず、TTC(Time To Collision)の算出も困難であるため、例えば、車載の単眼カメラから得られる時系列画像を用いて走行環境の3次元構造を推定し、物体の検知を行う方式が考えられている。これは、3D(3次元)の解析手法である(例えば、非特許文献1参照。)。

【0004】

非特許文献1で開示された技術の方式では、今回画像サイクル(t)と前回画像サイクル(t−1)の画像から特徴点を抽出し、オプティカルフロー等の手法により、自車両の運動を推定し、特徴点の三次元位置計算、路面領域の検出を行った後、移動物体の領域の検出を行う。

【0005】

3D解析手法に対する他の手法として、物体の形状をあらかじめ学習しておき、検出したい物体のパターンを識別する手法(パターン認識の手法)がある。このような手法では、近年、HOG(Histgrams of Oriented Gradients)特徴量やHaar−like特徴量等の特徴量と、AdaBoost(Adaptive Boosting)やSVM(Support Vector Machine)等の認識アルゴリズムを組み合わせた方式が主流となっている。

【先行技術文献】

【非特許文献】

【0006】

【非特許文献1】山口、加藤、二宮、「車載単眼カメラによる車両前方の障害物検出」、社団法人 情報処理学会 研究報告、2005年11月18日、2005−CVIM−151(10)、p.69−76

【発明の概要】

【発明が解決しようとする課題】

【0007】

しかしながら、前記した3D解析手法による認識では、中・近距離での性能は良いが、画像の消失点付近を含む比較的遠距離の物体については、特徴点は抽出できるものの、物体の形状を認識する精度が大幅に劣化してしまう。従って、前記した3D解析手法による認識では、ACCやFCWへの適用は困難であった。

【0008】

一方、前記したパターン認識では、時系列画像処理を織り込むことによって距離と相対速度を算出することも可能ではあるが、その精度と信頼度が前記した3D解析手法に対して大幅に劣るため、車載用の装置に適応するには困難であり、工夫が求められていた。

【0009】

本発明は、このような事情を考慮して為されたものであり、物体の認識を精度良く行うことができる画像認識装置、画像認識方法および画像認識プログラムを提供することを目的としている。

【課題を解決するための手段】

【0010】

(1)上述した課題を解決するために、本発明に係る画像認識装置は、画像に対して3D解析手法による物体認識を行う3D解析手法による物体認識部と、前記画像に対してパターン認識による物体認識を行うパターン認識による物体認識部と、を備え、前記3D解析手法による物体認識部により得られる3D解析手法による物体認識の結果と前記パターン認識による物体認識部により得られるパターン認識による物体認識の結果に基づいて最終ターゲットの認識結果を得る、ことを特徴とする。

【0011】

(2)本発明は、(1)に記載の画像認識装置において、前記3D解析手法による物体認識部により得られた3D解析手法による物体認識の結果と前記パターン認識による物体認識部により得られたパターン認識による物体認識の結果に基づいて、AND論理により、最終ターゲットの認識結果を得る最終ターゲット認識部を備える、ことを特徴とする。

【0012】

(3)本発明は、(1)に記載の画像認識装置において、前記3D解析手法による物体認識部により得られた3D解析手法による物体認識の結果と前記パターン認識による物体認識部により得られたパターン認識による物体認識の結果に基づいて、OR論理により、最終ターゲットの認識結果を得る最終ターゲット認識部を備える、ことを特徴とする。

【0013】

(4)本発明は、(1)から(3)のいずれか1つに記載の画像認識装置において、前記パターン認識による物体認識部は、前記3D解析手法による物体認識部により検出した特徴点とオプティカルフローのうちの一方または両方に基づいて、座標のスキャン領域を決定する、ことを特徴とする。

【0014】

(5)本発明は、(1)から(3)のいずれか1つに記載の画像認識装置において、前記パターン認識による物体認識部は、前記3D解析手法による物体認識部により得られた3D解析手法による物体認識の結果に基づいて、座標のスキャン領域を決定する、ことを特徴とする。

【0015】

(6)本発明は、(1)から(3)のいずれか1つに記載の画像認識装置において、前記パターン認識による物体認識部は、前記3D解析手法による物体認識部により検出した特徴点とオプティカルフローのうちの一方または両方に基づいて、認識対象の物体の識別を行う、ことを特徴とする。

【0016】

(7)本発明は、(6)に記載の画像認識装置において、前記パターン認識による物体認識部は、前記3D解析手法による物体認識部により検出した特徴点とオプティカルフローのうちの一方または両方に基づいて、認識対象の物体が映っている可能性が高いと推定される領域について、物体を認識し易くするように、パターン認識による物体認識において用いられる閾値を変更して、認識対象の物体の識別を行う、ことを特徴とする。

【0017】

(8)本発明は、(1)から(3)のいずれか1つに記載の画像認識装置において、前記パターン認識による物体認識部は、前記3D解析手法による物体認識部により得られた3D解析手法による物体認識の結果に基づいて、認識対象の物体の識別を行う、ことを特徴とする。

【0018】

(9)本発明は、(8)に記載の画像認識装置において、前記パターン認識による物体認識部は、前記3D解析手法による物体認識部により得られた3D解析手法による物体認識の結果に基づいて、認識対象の物体が映っている可能性が高いと推定される領域について、物体を認識し易くするように、パターン認識による物体認識において用いられる閾値を変更して、認識対象の物体の識別を行う、ことを特徴とする。

【0019】

(10)本発明は、(1)に記載の画像認識装置において、前記3D解析手法による物体認識部は、前記パターン認識による物体認識部により得られたパターン認識による物体認識の結果に基づいて、特徴点またはオプティカルフローのうちの一方または両方を検出する、ことを特徴とする。

【0020】

(11)本発明は、(10)に記載の画像認識装置において、前記3D解析手法による物体認識部により得られた3D解析手法による物体認識の結果に基づいて最終ターゲットの認識結果を得る最終ターゲット認識部を備える、ことを特徴とする。

【0021】

(12)本発明は、(1)に記載の画像認識装置において、前記3D解析手法による物体認識部は、前記パターン認識による物体認識部により得られたパターン認識による物体認識の結果に基づいて、認識対象の物体の識別を行う、ことを特徴とする。

【0022】

(13)本発明は、(1)から(12)のいずれか1つに記載の画像認識装置において、車載用の画像認識装置であり、画像を撮像するカメラを備え、前記3D解析手法による物体認識部および前記パターン認識による物体認識部は、前記カメラにより撮像される画像に対して物体認識を行う、ことを特徴とする。

【0023】

(14)上述した課題を解決するために、本発明に係る画像認識方法は、3D解析手法による物体認識部が、画像に対して3D解析手法による物体認識を行い、パターン認識による物体認識部が、前記画像に対してパターン認識による物体認識を行い、前記3D解析手法による物体認識部により得られる3D解析手法による物体認識の結果と前記パターン認識による物体認識部により得られるパターン認識による物体認識の結果に基づいて最終ターゲットの認識結果を得る、ことを特徴とする。

【0024】

(15)上述した課題を解決するために、本発明に係る画像認識プログラムは、3D解析手法による物体認識部により得られる3D解析手法による物体認識の結果とパターン認識による物体認識部により得られるパターン認識による物体認識の結果に基づいて最終ターゲットの認識結果を得るために、3D解析手法による物体認識部が、画像に対して3D解析手法による物体認識を行う手順と、パターン認識による物体認識部が、前記画像に対してパターン認識による物体認識を行う手順と、をコンピュータに実行させるためのものである。

【発明の効果】

【0025】

以上説明したように、本発明によれば、物体の認識を精度良く行うことができる画像認識装置、画像認識方法および画像認識プログラムを提供することが可能になる。

【図面の簡単な説明】

【0026】

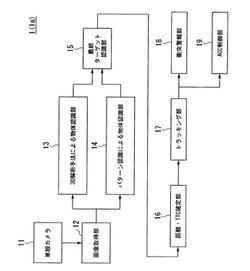

【図1】本発明の第1実施形態および第2実施形態に係る画像認識装置の構成を示すブロック図である。

【図2】パターン認識による物体認識部の構成を示すブロック図である。

【図3】3D解析手法による物体認識とパターン認識による物体認識との組み合わせにより物体認識の性能を向上させることが望まれる領域の例を示す図である。

【図4】本発明の第3実施形態に係る画像認識装置の構成を示すブロック図である。

【図5】本発明の第4実施形態に係る画像認識装置の構成を示すブロック図である。

【図6】本発明の第5実施形態に係る画像認識装置の構成を示すブロック図である。

【図7】本発明の第6実施形態に係る画像認識装置の構成を示すブロック図である。

【図8】本発明の第7実施形態に係る画像認識装置の構成を示すブロック図である。

【図9】3D解析手法の処理の手順の一例を示す図である。

【図10】パターン認識による物体認識部のより詳細な構成を示すブロック図である。

【図11】積分画像を説明するための図である。

【発明を実施するための形態】

【0027】

以下の実施形態では、車両(自己の車両)に搭載される車載用の画像認識装置を例として示す。そして、以下の実施形態に係る画像認識装置は、車両の前方の画像を撮像する単眼カメラを備え、当該単眼カメラにより撮像した画像における物体を認識する装置として動作する。

【0028】

[第1実施形態]

図1は、本発明の第1実施形態に係る画像認識装置1の構成を示すブロック図である。

本実施形態に係る画像認識装置1は、単眼カメラ11と、画像取得部12と、3D解析手法による物体認識部13と、パターン認識による物体認識部14と、最終ターゲット認識部15と、距離・TTC確定部16と、トラッキング部17と、衝突警報部18と、ACC制御部19と、を備える。

【0029】

本実施形態では、単眼カメラ11は、画像認識装置1が搭載される車両の前方の画像を撮像する位置に設けられる。

【0030】

本実施形態に係る画像認識装置1において行われる動作の例を示す。

単眼カメラ11は、画像を撮像し、撮像した画像を画像取得部12に出力する。

画像取得部12は、単眼カメラ11から入力された画像を取得し、取得した画像のデータを3D解析手法による物体認識部13とパターン認識による物体認識部14のそれぞれに出力する。

ここで、画像取得部12は、例えば、取得した画像のデータを一時的に記憶する記憶部を有する。

【0031】

3D解析手法による物体認識部13は、画像取得部12から入力された画像のデータについて、3D解析手法による物体認識の処理を行い、この物体認識の処理の結果を最終ターゲット認識部15に出力する。

本実施形態では、3D解析手法による物体認識部13は、画像取得部12から入力された画像のデータについて、その画像の中で、車両が映っていると推定される画像領域を認識し、その画像領域を特定する情報を物体認識の処理の結果として最終ターゲット認識部15に出力する。全体の画像中の画像領域は、例えば、水平(横)方向の座標値と垂直(縦)方向の座標値からなる座標の情報を用いて表現することができる。

ここで、3D解析手法による物体認識部13では、処理の誤差によって、車両以外のものが映っている画像領域を、車両が映っている画像領域として誤認識することが生じ得る。

【0032】

なお、本実施形態では、3D解析手法による物体認識部13において、画像中に映っている移動物体(時間の流れとともに移動する物体であり、静止物体ではないもの)を検出し、検出した移動物体が映っている画像領域を、車両が映っていると推定される画像領域として認識する構成を示す。他の例として、3D解析手法による物体認識部13において、車両が映っていると推定される画像領域を特定するための特徴となる情報を設定しておき、その特徴となる情報に一致または類似する物体が映っている画像領域を、車両が映っていると推定される画像領域(静止車両も含む)として認識する構成を用いることも可能である。

【0033】

パターン認識による物体認識部14は、画像取得部12から入力された画像のデータについて、パターン認識による物体認識の処理を行い、この物体認識の処理の結果を最終ターゲット認識部15に出力する。

本実施形態では、パターン認識による物体認識部14は、車両の画像のパターン(学習結果による、弱識別器のパラメータ等)をメモリに記憶しており、画像取得部12から入力された画像のデータについて、その画像の中で、メモリに記憶された車両の画像のパターンと同一または類似するものが映っていると推定される画像領域を認識し、その画像領域を特定する情報を物体認識の処理の結果として最終ターゲット認識部15に出力する。全体の画像中の画像領域は、例えば、水平(横)方向の座標値と垂直(縦)方向の座標値からなる座標の情報を用いて表現することができる。

ここで、パターン認識による物体認識部14では、処理の誤差によって、車両以外のものが映っている画像領域を、車両が映っている画像領域として誤認識することが生じ得る。

【0034】

最終ターゲット認識部15は、3D解析手法による物体認識部13から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)と、パターン認識による物体認識部14から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)について、これら2つの物体認識の処理の結果において、認識対象の物体(本実施形態では、車両)であると特定した画像領域(座標の領域)が一致する(重なる)部分を、最終的なターゲットの領域であると認識し、認識した最終的なターゲットの領域を特定する情報を距離・TTC確定部16に出力する。

【0035】

具体例として、最終ターゲット認識部15は、3D解析手法による物体認識部13から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)と、パターン認識による物体認識部14から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)について、AND論理の処理を行うことによって、これら2つの一致部分(重複部分)を検出し、その一致部分を、最終的なターゲットの領域であると認識する。

【0036】

ここで、本実施形態では、全体の画像に認識対象の物体(本実施形態では、車両)が複数映っている場合には、3D解析手法による物体認識部13やパターン認識による物体認識部14はそれぞれの物体について物体認識の処理を行い、最終ターゲット認識部15はそれぞれの物体について最終ターゲットの認識の処理を行う。

【0037】

距離・TTC確定部16は、最終ターゲット認識部15から入力された最終的なターゲットの領域を特定する情報に基づいて、それぞれの最終的なターゲット(本実施形態では、車両)ごとに、距離とTTCを算出して確定し、確定した距離とTTCの情報をトラッキング部17に出力する。なお、本実施形態では、距離・TTC確定部16は、それぞれの最終的なターゲットの領域を特定する情報と、確定した距離とTTCの情報との組をトラッキング部17に出力する。

【0038】

ここで、最終的なターゲットごとの距離とTTCは、例えば、距離・TTC確定部16により算出する構成が用いられてもよく、あるいは、他の例として、3D解析手法による物体認識部13またはパターン認識による物体認識部14により算出して、算出した最終的なターゲットごとの距離とTTCの情報を最終ターゲット認識部15を介して距離・TTC確定部16に出力し、距離・TTC確定部16が入力された最終的なターゲットごとの距離とTTCの情報により最終的なターゲットごとの距離とTTCを確定する構成が用いられてもよい。

なお、最終的なターゲットごとの距離とTTCは、例えば、3D解析手法による物体認識部13により得られた物体認識の処理の結果を用いて算出することができ、他の例として、パターン認識による物体認識部14により得られた物体認識の処理の結果を用いて算出されてもよく、さらに他の例として、これら両方の物体認識の処理の結果を用いて算出されてもよい。

【0039】

トラッキング部17は、距離・TTC確定部16から入力された情報に基づいて、トラッキングの処理を行い、衝突警報部18とACC制御部19のそれぞれに各制御に必要な情報を出力する。本実施形態では、トラッキング部17は、例えば、最終的なターゲットごとのTTCの情報を衝突警報部18に出力し、また、トラッキングの処理の結果の情報や、最終的なターゲットごとの距離や相対速度(自己の車両と最終的なターゲットとの距離や相対速度)の情報をACC制御部19に出力する。

【0040】

ここで、最終的なターゲットごとの相対速度は、例えば、トラッキング部17により算出され、他の例として、ACC制御部19などで算出されてもよい。

なお、トラッキング部17は、時系列画像のトラッキングの処理を行う場合に、例えば、制御サイクルの時系列フィルタ処理で、過去制御サイクルとの結果で最終的な判定を行う。

【0041】

衝突警報部18は、トラッキング部17から入力された情報に基づいて、TTCの計算結果により、最終的なターゲット(本実施形態では、他の車両)との衝突の可能性があると判断した場合には、その旨を自己の車両の乗員に警報する(FCWアプリケーション)。

【0042】

ACC制御部19は、トラッキング部17から入力された情報に基づいて、最終的なターゲット(本実施形態では、他の車両)との距離と相対速度の情報を用いて、前走車との車間距離の制御を行う。

【0043】

ここで、本実施形態では、3D解析手法による物体認識部13およびパターン認識による物体認識部14が車両が映っていると推定される画像領域を認識し、最終ターゲット認識部15が車両が映っていると推定される画像領域について最終的なターゲットの領域を認識する構成を示したが、他の例として、車両以外の種々なものが物体認識の対象(ターゲット)とされてもよく、例えば、二輪車や歩行者などが物体認識の対象(ターゲット)とされてもよく、また、車両と二輪車といったように2つ以上のものが物体認識の対象(ターゲット)とされてもよい。3D解析手法による物体認識部13およびパターン認識による物体認識部14には、例えば、あらかじめ、物体認識の対象(ターゲット)とするものを特定するための条件が設定され、その条件に基づいて物体認識の対象(ターゲット)が特定される。

【0044】

次に、3D解析手法による物体認識部13により行われる処理の例を示す。

図9は、3D解析手法の処理の手順の一例を示す図である。ここでは、各処理の概略を説明する。

なお、この処理の手順は、非特許文献1に記載されたものを引用しており、詳細については非特許文献1に記載されている。

【0045】

3D解析手法による物体認識部13は、画像取得部12から入力される画像について、時間的に連続する2枚の画像を取得する(ステップS1)。時間的に連続する2枚の画像は、例えば、時刻tの画像と、時刻t+1の画像となる。

次に、3D解析手法による物体認識部13は、特徴点を検出し、オプティカルフローを計算する(ステップS2)。

【0046】

次に、3D解析手法による物体認識部13は、自車両(自己の車両)の運動を推定する(ステップS3)。この処理では、一時刻前に検出された路面領域の情報と移動物体領域の情報が用いられる(ステップS8)。

次に、3D解析手法による物体認識部13は、特徴点の三次元位置を計算する(ステップS4)。

【0047】

次に、3D解析手法による物体認識部13は、路面領域を検出する(ステップS5)。この処理では、一時刻前に検出された路面領域の情報と移動物体領域の情報が用いられる(ステップS8)。

次に、3D解析手法による物体認識部13は、移動物体領域を検出する(ステップS6)。

そして、3D解析手法による物体認識部13は、検出した移動物体(本実施形態では、車両であると推定される移動物体)をターゲットとして認識する(ステップS7)。

【0048】

なお、3D解析手法による物体認識部13により行われる処理としては、他の種々な3D解析手法による物体認識の処理が用いられてもよい。

また、本実施形態では、動きベクトルとして、オプティカルフローを用いる場合を示すが、他の種々なものが用いられてもよい。

【0049】

次に、パターン認識による物体認識部14の構成例を示す。

図2は、パターン認識による物体認識部14の構成例を示すブロック図である。

本実施形態に係るパターン認識による物体認識部14は、勾配積分画像算出部101と、座標スキャン部102と、特徴量ベクトル算出部103と、識別部104と、を備える。

【0050】

ここで、本実施形態に係るパターン認識による物体認識部14では、特徴量として、HOG特徴量を用いている。他の例として、特徴量として、Haar−like特徴量やEdgelet特徴量等の他の種々な特徴量が用いられてもよい。

また、本実施形態に係るパターン認識による物体認識部14では、識別部104において、AdaBoostの認識アルゴリズムを用いている。他の例として、認識アルゴリズムとして、Real AdaBoostやSVM等の他の種々な認識アルゴリズムやその改良アルゴリズムが用いられてもよい。

【0051】

パターン認識による物体認識部14において行われる動作の例を示す。

なお、HOG特徴量やAdaBoostの認識アルゴリズムとしては、それぞれ、公知の技術を利用することができ、本実施形態では、詳しい説明は省略する。

【0052】

パターン認識による物体認識部14に入力された画像は、勾配積分画像算出部101に入力される。

勾配積分画像算出部101は、入力された画像について、全画像に対して勾配強度と勾配方向を算出し、それぞれの勾配方向の勾配強度に対して積分画像を算出し、ヒストグラムを計算する。勾配積分画像算出部101は、この計算結果の情報を座標スキャン部102に出力する。

なお、本実施形態では、元の全画像に対して勾配強度と勾配方向を算出するが、他の例として、ピラミッド画像により解像度を下げた画像にも適用可能である。

【0053】

座標スキャン部102は、勾配積分画像算出部101から入力された情報に基づいて、全画像の中であらかじめ設定した任意の座標領域に対して、前記した勾配方向の勾配強度を算出する。座標スキャン部102は、この算出結果の情報を特徴量ベクトル算出部103に出力する。

【0054】

ここで、本実施形態では、勾配積分画像算出部101によりあらかじめ算出しておいた積分画像があるため、座標スキャン部102により任意のウインドウ(枠)の積分値を容易に算出することができる。

なお、他の例として、このような積分画像を使用しない構成が用いられてもよい。

【0055】

特徴量ベクトル算出部103は、座標スキャン部102から入力された情報に基づいて、HOG特徴量としての特徴ベクトル化を行う。特徴量ベクトル算出部103は、この結果の情報(特徴量ベクトルの情報)を識別部104に出力する。

識別部104は、特徴量ベクトル算出部103から入力された情報に基づいて、AdaBoostによる識別の処理を行い、あらかじめターゲットとしている物体(本実施形態では、あらかじめ用意された車両の画像のパターンに合致する物体)を認識する。識別部104は、この物体認識の処理の結果を出力する。

識別部104から出力された物体認識の処理の結果は、パターン認識による物体認識部14から出力されて、最終ターゲット認識部15に入力される。

なお、識別部104と最終ターゲット認識部15との間にクラスタリング部を設けてミーンシフト等のクラスタリングを行ってもよい。

【0056】

図10は、パターン認識による物体認識部14のより詳細な構成を示すブロック図である。

図10は、勾配積分画像算出部101と、特徴量ベクトル算出部103について、詳しい構成例を示してある。

勾配積分画像算出部101は、勾配強度検出部301と、勾配方向検出部302と、勾配方向ごとの勾配強度の積分部303と、を備える。

特徴量ベクトル算出部103は、セル単位の積分値算出部311と、ブロック正規化部312と、特徴量ベクトル算出処理部313と、を備える。

【0057】

勾配積分画像算出部101において行われる動作の例を示す。

勾配積分画像算出部101に入力された画像は、勾配強度検出部301に入力される。

勾配強度検出部301は、入力された画像に基づいて、各ピクセル(u,v)における画素値(例えば、輝度値)の勾配強度m(u,v)を検出する。勾配強度検出部301は、入力された画像および検出した勾配強度m(u,v)を勾配方向検出部302に出力する。

ここで、uとvは、直交座標平面上における画素(ピクセル)の位置を表すための座標の縦軸方向の値と横軸方向の値である。

【0058】

勾配方向検出部302は、勾配強度検出部301から画像および勾配強度m(u,v)を入力し、入力した画像に基づいて各ピクセル(u,v)における勾配方向q(u,v)を検出する。勾配方向検出部302は、入力した勾配強度m(u,v)および検出した勾配方向q(u,v)を勾配方向ごとの勾配強度の積分部303に出力する。

【0059】

勾配方向ごとの勾配強度の積分部303は、勾配方向検出部302から入力された勾配強度m(u,v)および勾配方向q(u,v)に基づいて、勾配方向ごとに勾配強度の積分を行う。勾配方向ごとの勾配強度の積分部303は、この積分の結果により得られる情報を出力する。

勾配方向ごとの勾配強度の積分部303から出力された情報は、勾配積分画像算出部101による計算結果の情報として当該勾配積分画像算出部101から出力されて、座標スキャン部102に入力される。

【0060】

座標スキャン部102は、全画像領域またはその中の所望の比較的大きい領域内を、特定の座標領域(ウインドウ)をスライド(ウインドウサイズのスケールも可変して、順次スライドする)しながら、次の特徴量ベクトル算出部103で算出するウインドウを選択する。

【0061】

特徴量ベクトル算出部103において行われる動作の例を示す。

座標スキャン部102から特徴量ベクトル算出部103に入力された情報は、セル単位の積分値算出部311に入力される。

セル単位の積分値算出部311は、入力された情報に基づいて、勾配方向ごとの勾配強度について、セル単位の積分値を算出する。セル単位の積分値算出部311は、算出したセル単位の積分値をブロック正規化部312に出力する。

【0062】

ブロック正規化部312は、セル単位の積分値算出部311から入力されたセル単位の積分値について、ブロック単位で、正規化を行う。ブロック正規化部312は、この正規化の結果の情報を特徴量ベクトル算出処理部313に出力する。

特徴量ベクトル算出処理部313は、ブロック正規化部312から入力された情報に基づいて、特徴量ベクトル(本実施形態では、HOG特徴量のベクトル)を算出する。特徴量ベクトル算出処理部313は、算出した特徴量ベクトルの情報を出力する。

特徴量ベクトル算出処理部313から出力された情報は、特徴量ベクトル算出部103から出力されて、識別部104に入力される。

【0063】

ここで、本実施形態では、1つのセルは座標スキャンするウインドウの1/16のサイズから構成されており、1つのブロックは3セル(縦)×3セル(横)の領域から構成されている。

なお、セルの大きさや、ブロックの大きさとしては、それぞれ、他の種々な構成が用いられてもよい。

【0064】

ここで、積分画像について説明しておく。積分画像は、一般に知られた技術であり、ここでは、その概略を説明する。

図11は、積分画像を説明するための図である。

図11において、画像の左上を画素の座標の基準位置(0,0)として、座標(u、v)を考える。また、座標(u,v)における画像の画素値をi(u,v)とする。

s(u,v)を行の画素の総和(縦方向の総和)とし、ii(u,v)を列のs(u,v)の総和(横方向の総和)とする。このii(u,v)が積分画像となる。

このとき、次の式(1)、式(2)が表される。ここで、s(−1,v)=0とし、ii(u,−1)=0とする。

【0065】

s(u,v)=s(u−1,v)+i(u,v) ・・・(1)

【0066】

ii(u,v)=ii(u,v−1)+s(u、v) ・・・(2)

【0067】

このとき、一例として、図11に示される第4領域における画素値の和S(4)を求める場合には、式(3)により算出することができる。

【0068】

S(4)=ii(u,v)−ii(u,v−Q1)−ii(u−P1,v)+ii(u−P1,v−Q1) ・・・(3)

【0069】

本実施形態では、このような積分画像ii(u,v)を使用することで、演算を容易化することが可能である。

【0070】

次に、3D解析手法による物体認識部13により行われる3D解析手法による物体認識とパターン認識による物体認識部14により行われるパターン認識による物体認識との組み合わせについて説明する。

図3は、3D解析手法による物体認識とパターン認識による物体認識との組み合わせにより物体認識の性能を向上させることが望まれる領域の例を示す図である。

図3に示される画像1001では、道路上に車両が走行している。そして、3D解析手法による物体認識とパターン認識による物体認識との組み合わせにより物体認識の性能を向上させることが望まれる領域として、縦方向の辺よりも横方向の辺の方が長い矩形の枠1002の領域が示されている。

【0071】

この枠1002の領域は、3D解析手法による物体認識の単体ではターゲット(本実施形態では、車両)以外の物体を誤認識する可能性がある領域であり、且つ、パターン認識による物体認識の単体でもターゲット(本実施形態では、車両)以外の物体を誤認識する可能性がある領域である。

従って、このような互いの認識性能がある場合には、本実施形態のように、最終的なターゲットと認識するために、最終ターゲット認識部15によりAND論理での認識を行うことが効果的である。このように最終的なターゲットと認識する論理(本実施形態では、AND論理)は、3D解析手法による物体認識とパターン認識による物体認識との互いの判定性能に依存して定めたものである。

【0072】

なお、このような、3D解析手法による物体認識とパターン認識による物体認識との組み合わせにより物体認識の性能を向上させることが望まれる領域は、例えば、道路の状況などによって、変動する。

図3に示される例では、道路がほぼ直進方向にあるが、大きいカーブでの前走車を認識することが必要であることから、横長の枠1002の領域を設定している。

ここで、枠1002の領域は、例えば、画像1001における座標の値を用いて表すことができる。

【0073】

以上のように、本実施形態に係る画像認識装置1は、3D解析手法による物体認識の結果と、パターン認識による物体認識の結果とで、画像中においてAND論理が成立した座標領域の物体を最終的にターゲット(目標と定めた物体)であると判断する。

従って、本実施形態に係る画像認識装置1によれば、物体の認識を精度良く行うことができ、ターゲットとする物体の検出に好適な装置を提供することができる。例えば、本実施形態に係る画像認識装置1によれば、画像の消失点付近を含む比較的遠距離にある物体の形状を認識する精度が大幅に向上するため、前方衝突警報装置(FCW)に適用することができ、さらに、特に遠距離での認識が必要な車間距離制御装置(ACC)への適用が可能となる効果を有する。

【0074】

なお、一般的に、3D解析手法による物体認識では、遠距離にある物体の認識は不得手であると考えられるが、本実施形態では、パターン認識による物体認識を併用することで、遠距離にある物体の認識についても、精度を向上させている。

【0075】

[第2実施形態]

本実施形態に係る画像認識装置1aの概略的な構成は、図1に示される第1実施形態に係る画像認識装置1の構成と同様であるため、以下では、図1に示される構成および各構成部の符号を利用して説明する。

なお、以下では、第1実施形態に係る画像認識装置1とは異なる点について詳しく説明する。

【0076】

本実施形態に係る画像認識装置1aでは、主に、最終ターゲット認識部15の構成および動作が、第1実施形態の場合とは異なっている。

本実施形態では、最終ターゲット認識部15は、OR論理を用いて認識を行う。

具体的には、最終ターゲット認識部15は、3D解析手法による物体認識部13から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)と、パターン認識による物体認識部14から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)について、これら2つの物体認識の処理の結果において、認識対象の物体(本実施形態では、車両)であると特定した何れかまたは一致する画像領域(座標の領域)の部分を、最終的なターゲットの領域であると認識し、認識した最終的なターゲットの領域を特定する情報を距離・TTC確定部16に出力する。

【0077】

具体例として、最終ターゲット認識部15は、3D解析手法による物体認識部13から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)と、パターン認識による物体認識部14から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)について、OR論理の処理を行うことによって、最終的なターゲットの領域であると認識する。

【0078】

ここで、本実施形態では、全体の画像に認識対象の物体(本実施形態では、車両)が複数映っている場合には、3D解析手法による物体認識部13やパターン認識による物体認識部14はそれぞれの物体について物体認識の処理を行い、最終ターゲット認識部15はそれぞれの物体について最終ターゲットの認識の処理を行う。

【0079】

次に、3D解析手法による物体認識部13により行われる3D解析手法による物体認識とパターン認識による物体認識部14により行われるパターン認識による物体認識との組み合わせについて説明する。

第1実施形態において参照した図3には、3D解析手法による物体認識とパターン認識による物体認識との組み合わせにより物体認識の性能を向上させることが望まれる領域として、矩形の枠1002の領域が示されている。

【0080】

この枠1002の領域は、3D解析手法による物体認識の単体ではターゲット(本実施形態では、車両)を認識することができない可能性がある領域であり、且つ、パターン認識による物体認識でもターゲット(本実施形態では、車両)を認識することができない可能性がある領域である。

従って、このような互いの認識性能がある場合には、本実施形態のように、最終的なターゲットと認識するために、最終ターゲット認識部15によりOR論理での認識を行うことが効果的である。このように最終的なターゲットと認識する論理(本実施形態では、OR論理)は、3D解析手法による物体認識とパターン認識による物体認識との互いの判定性能に依存して定めたものである。

【0081】

以上のように、本実施形態に係る画像認識装置1aは、3D解析手法による物体認識の結果と、パターン認識による物体認識の結果とで、画像中においてOR論理が成立した座標領域の物体を最終的にターゲット(目標と定めた物体)であると判断する。

従って、本実施形態に係る画像認識装置1aによれば、物体の認識を精度良く行うことができ、ターゲットとする物体の検出に好適な装置を提供することができる。例えば、本実施形態に係る画像認識装置1aによれば、画像の消失点付近を含む比較的遠距離にある物体の形状を認識する精度が大幅に向上するため、前方衝突警報装置(FCW)に適用することができ、さらに、特に遠距離での認識が必要な車間距離制御装置(ACC)への適用が可能となる効果を有する。

【0082】

ここで、最終ターゲット認識部15により行われる動作として、第1実施形態ではAND論理の動作を示し、第2実施形態ではOR論理の動作を示したが、他の動作が用いられてもよい。

AND論理の一例として、最終ターゲット認識部15は、3D解析手法による物体認識部13から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)と、パターン認識による物体認識部14から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)について、これら2つの物体認識の処理の結果において、認識対象の物体(本実施形態では、車両)であると特定した画像領域(座標の領域)の重複部分(オーバーラップする部分)が所定の割合(例えば、50%など)以上である場合に、あらかじめ定められたいずれか一方の物体認識の処理の結果を最終的なターゲットの領域であると認識し、認識した最終的なターゲットの領域を特定する情報を距離・TTC確定部16に出力する、といった構成を用いることができる。

【0083】

[第3実施形態]

図4は、本発明の第3実施形態に係る画像認識装置2の構成を示すブロック図である。

本実施形態に係る画像認識装置2は、単眼カメラ11と、画像取得部12と、3D解析手法による物体認識部21と、パターン認識による物体認識部22と、最終ターゲット認識部15と、距離・TTC確定部16と、トラッキング部17と、衝突警報部18と、ACC制御部19と、を備える。

【0084】

ここで、本実施形態に係る画像認識装置2の構成や動作は、3D解析手法による物体認識部21とパターン認識による物体認識部22に関する構成や動作を除いて、図1に示される第1実施形態に係る画像認識装置1の構成(AND論理を用いる構成)、または、第2実施形態に係る画像認識装置1aの構成(OR論理を用いる構成)と同様である。

このため、図4では、第1実施形態または第2実施形態と同様な構成部については、同一の符号を付してある。以下では、第1実施形態に係る画像認識装置1または第2実施形態に係る画像認識装置1aとは異なる点について詳しく説明する。

【0085】

3D解析手法による物体認識部21は、特徴点・オプティカルフロー検出部111と、自車に対する相対距離検出部112と、クラスタリング部113と、を備える。

パターン認識による物体認識部22は、勾配積分画像算出部121と、座標スキャン部122と、特徴量ベクトル算出部123と、識別部124と、を備える。座標スキャン部122は、座標のスキャン領域決定部126を備える。

【0086】

3D解析手法による物体認識部21において行われる動作の例を示す。

画像取得部12から3D解析手法による物体認識部21に入力された画像は、特徴点・オプティカルフロー検出部111に入力される。

この入力画像は、特徴点・オプティカルフロー検出部111、自車に対する相対距離検出部112、クラスタリング部113により、順に処理されて、その処理の結果がクラスタリング部113から出力される。

クラスタリング部113から出力された処理の結果は、3D解析手法による物体認識の処理の結果として、3D解析手法による物体認識部21から出力されて、最終ターゲット認識部15に入力される。

【0087】

ここで、本実施形態では、3D解析手法による物体認識部21において、図9に示されるのと同様な3D解析手法の処理の手順による処理を行う。

本実施形態では、一例として、特徴点・オプティカルフロー検出部111がステップS1〜ステップS2の処理を実行し、自車に対する相対距離検出部112がステップS3〜ステップS6の処理を実行し、クラスタリング部113がステップS7の処理を実行する。

【0088】

さらに、本実施形態では、特徴点・オプティカルフロー検出部111は、検出した特徴点の情報と、検出(本実施形態では、計算)したオプティカルフローの情報を座標スキャン部122に出力する。

【0089】

パターン認識による物体認識部22において行われる動作の例を示す。

画像取得部12からパターン認識による物体認識部22に入力された画像は、勾配積分画像算出部121に入力される。

この入力画像は、勾配積分画像算出部121、座標スキャン部122、特徴量ベクトル算出部123、識別部124により、順に処理されて、その処理の結果が識別部124から出力される。

識別部124から出力された処理の結果は、パターン認識による物体認識の処理の結果として、パターン認識による物体認識部22から出力されて、最終ターゲット認識部15に入力される。

【0090】

ここで、本実施形態では、パターン認識による物体認識部22に備えられた勾配積分画像算出部121と、座標スキャン部122と、特徴量ベクトル算出部123と、識別部124によって、概略的には、それぞれ、図2に示される勾配積分画像算出部101と、座標スキャン部102と、特徴量ベクトル算出部103と、識別部104と同様な動作を行う。

【0091】

さらに、本実施形態では、特徴点・オプティカルフロー検出部111から出力された特徴点の情報と、オプティカルフローの情報が、座標スキャン部122に入力される。座標スキャン部122に入力された特徴点の情報とオプティカルフローの情報は、座標のスキャン領域決定部126に入力される。

【0092】

座標のスキャン領域決定部126は、入力された特徴点の情報とオプティカルフローの情報のうちの一方または両方に基づいて、座標スキャン部122において座標スキャンする領域を決定する。本実施形態では、このようにして決定される座標スキャン部122において座標スキャンする領域は、パターン認識を行う領域となる。

【0093】

本実施形態では、座標スキャン部122は、勾配積分画像算出部121から入力された情報に基づいて、全画像の中で、座標のスキャン領域決定部126により決定された座標スキャンする領域(座標領域)に対して、勾配方向の勾配強度を算出する。座標スキャン部122は、この算出結果の情報を特徴量ベクトル算出部123に出力する。

【0094】

ここで、座標のスキャン領域決定部126は、例えば、入力された特徴点の情報とオプティカルフローの情報のうちの一方または両方に基づいて、座標スキャン部122において座標スキャンする領域として、全画像中において、認識対象の物体(本実施形態では、車両)が映っている可能性が高いと推定される領域を決定する。

【0095】

特徴点の情報を優先してパターン認識の座標スキャンの領域を決定する手法の一例として、特徴点が密集する領域を検出し、その密集する領域のサイズを包含する広めの領域を、座標スキャン部122において座標スキャンする領域として決定することができる。

【0096】

特徴点の情報を優先してパターン認識の座標スキャンの領域を決定する手法の他の一例として、座標のスキャン領域決定部126は、特徴点が多い方が認識対象の物体が映っている可能性が高いという推定に基づいて、全画像をあらかじめ設定された複数に分割した領域(分割領域)を想定し、各分割領域内に存在する特徴点の数を算出し、算出した特徴点の数があらかじめ設定された値(閾値)より多い分割領域のみを、座標スキャン部122において座標スキャンする領域として決定することができる。

【0097】

なお、この閾値としては、一例として、2以上の値を設定する。

他の一例として、この閾値として、1を設定することもできる。この場合、座標のスキャン領域決定部126は、全画像をあらかじめ設定された複数に分割した領域(分割領域)を想定し、1つでも特徴点が抽出された分割領域のみを、座標スキャン部122において座標スキャンする領域として決定することができる。

【0098】

オプティカルフローの情報を優先してパターン認識の座標スキャンの領域を決定する手法の一例として、座標のスキャン領域決定部126は、オプティカルフローにより定められる変化量(例えば、勾配の強度)の平均値が大きい方が認識対象の物体が映っている可能性が高いという推定に基づいて、全画像をあらかじめ設定された複数に分割した領域(分割領域)を想定し、各分割領域内に存在する1つ以上のオプティカルフローにより定められる変化量の平均値を算出し、算出した平均値があらかじめ設定された値(閾値)より大きい分割領域のみを、座標スキャン部122において座標スキャンする領域として決定することができる。

【0099】

また、オプティカルフローの情報を優先してパターン認識の座標スキャンの領域を決定する手法の他の一例として、座標のスキャン領域決定部126は、全画像をあらかじめ設定された複数に分割した領域(分割領域)を想定し、あらかじめ設定された値(閾値)より大きいオプティカルフローが1つでも抽出された分割領域のみを、座標スキャン部122において座標スキャンする領域として決定することができる。

【0100】

また、特徴点の情報やオプティカルフローの情報を優先してパターン認識の座標スキャンの領域を決定する手法の一例として、座標のスキャン領域決定部126は、特徴点に関する条件(例えば、上記したもの等、1つ以上の条件)を満たし、且つ、オプティカルフローに関する条件(例えば、上記したもの等、1つ以上の条件)を満たす分割領域のみを、座標スキャン部122において座標スキャンする領域として決定することができる。

【0101】

また、特徴点の情報やオプティカルフローの情報を優先してパターン認識の座標スキャンの領域を決定する手法の他の一例として、座標のスキャン領域決定部126は、特徴点に関する条件(例えば、上記したもの等、1つ以上の条件)またはオプティカルフローに関する条件(例えば、上記したもの等、1つ以上の条件)のうちの少なくとも1つの条件を満たす分割領域(これらの全ての条件を満たす分割領域も含む)のみを、座標スキャン部122において座標スキャンする領域として決定することができる。

【0102】

また、以上のようにして特徴点の情報とオプティカルフローの情報のうちの一方または両方を優先してパターン認識の座標スキャンの領域を決定する手法では、例えば、座標のスキャン領域決定部126は、以上のようにして特徴点の情報とオプティカルフローの情報のうちの一方または両方に基づいて決定した領域のみを座標スキャン部122において座標スキャンする領域とする構成以外に、以上のようにして特徴点の情報とオプティカルフローの情報のうちの一方または両方に基づいて決定した領域とともに、他の任意の手法により決定した領域についても、座標スキャン部122において座標スキャンする領域とする、こともできる。

【0103】

次に、座標のスキャン領域決定部126について、他の例を示す。

他の例に係る座標のスキャン領域決定部126は、入力された特徴点の情報とオプティカルフローの情報のうちの一方または両方に基づいて、座標スキャン部122において座標スキャンする領域の重要度を決定する。本実施形態では、このようにして決定される座標スキャン部122において座標スキャンする領域の重要度は、パターン認識を行う領域の重要度として使用される。

【0104】

本実施形態では、座標スキャン部122は、勾配積分画像算出部121から入力された情報に基づいて、例えば全画像の中であらかじめ設定した任意の座標領域に対して、他の例に係る座標のスキャン領域決定部126により決定された座標スキャンする領域(座標領域)の重要度を考慮して、勾配方向の勾配強度を算出する。座標スキャン部122は、この算出結果の情報を特徴量ベクトル算出部123に出力する。

【0105】

ここで、他の例に係る座標のスキャン領域決定部126は、例えば、入力された特徴点の情報とオプティカルフローの情報のうちの一方または両方に基づいて、座標スキャン部122において座標スキャンする領域の重要度として、全画像中において認識対象の物体が映っている可能性が高いと推定される領域の重要度を高い重要度とするように決定する。

【0106】

特徴点の情報とオプティカルフローの情報のうちの一方または両方を重要視してパターン認識の座標スキャンの領域の重要度を決定する手法の一例として、他の例に係る座標のスキャン領域決定部126は、上記のように特徴点の情報とオプティカルフローの情報のうちの一方または両方を優先してパターン認識の座標スキャンの領域を決定する手法により決定された分割領域については、特徴量に関する情報(例えば、勾配強度など)を算出するときの重み付け(重要度)を大きくすることができる。具体例として、他の例に係る座標のスキャン領域決定部126は、上記のように特徴点の情報とオプティカルフローの情報のうちの一方または両方を優先してパターン認識の座標スキャンの領域を決定する手法により決定された分割領域については、他の分割領域と比べて、得られた特徴量に関する値(例えば、勾配強度など)にあらかじめ設定された値(例えば、1より大きい値)を乗算することができ、つまり、このような分割領域においては、他の分割領域と比べて、小さい特徴量に関する値であっても、より特徴量が大きいとみなす。

【0107】

特徴点の情報とオプティカルフローの情報のうちの一方または両方を重要視してパターン認識の座標スキャンの領域の重要度を決定する手法の他の一例として、他の例に係る座標のスキャン領域決定部126は、上記のように特徴点の情報とオプティカルフローの情報のうちの一方または両方を優先してパターン認識の座標スキャンの領域を決定する手法により決定された分割領域については、他の分割領域と比べて、特徴量に関する情報(例えば、勾配強度など)を算出するときの分解能を細かくすることができる。具体例として、他の例に係る座標のスキャン領域決定部126は、上記のように特徴点の情報とオプティカルフローの情報のうちの一方または両方を優先してパターン認識の座標スキャンの領域を決定する手法により決定された分割領域については、あらかじめ設定された比較的細かい分解能でスライド(移動)させてスキャンし、他の分割領域については、あらかじめ設定された比較的粗い分解能でスライド(移動)させてスキャンすることができる。

【0108】

以上のように、本実施形態に係る画像認識装置2では、3D解析手法による物体認識部21の特徴点・オプティカルフロー検出部111により得られた情報が、パターン認識による物体認識部22の座標のスキャン領域決定部126(上記した他の例に係る座標のスキャン領域決定部126でもよい)に伝えられて利用される構成となっている。

従って、本実施形態に係る画像認識装置2によれば、物体の認識を精度良く行うことができ、ターゲットとする物体の検出に好適な装置を提供することができる。例えば、本実施形態に係る画像認識装置2によれば、3D解析手法による物体認識において得られた特徴点の情報または動きベクトル(本実施形態では、オプティカルフロー)の情報に基づく座標領域を優先してまたは重要視して、パターン認識を行う画像において座標をスキャンする領域に関する設定を行うことができる。これにより、例えば、パターン認識の座標スキャン時の処理負荷を軽減することが可能である。

【0109】

[第4実施形態]

図5は、本発明の第4実施形態に係る画像認識装置3の構成を示すブロック図である。

本実施形態に係る画像認識装置3は、単眼カメラ11と、画像取得部12と、3D解析手法による物体認識部31と、パターン認識による物体認識部32と、最終ターゲット認識部15と、距離・TTC確定部16と、トラッキング部17と、衝突警報部18と、ACC制御部19と、を備える。

【0110】

ここで、本実施形態に係る画像認識装置3の構成や動作は、3D解析手法による物体認識部31とパターン認識による物体認識部32に関する構成や動作を除いて、図1に示される第1実施形態に係る画像認識装置1の構成(AND論理を用いる構成)、または、第2実施形態に係る画像認識装置1aの構成(OR論理を用いる構成)と同様である。

このため、図5では、第1実施形態または第2実施形態と同様な構成部については、同一の符号を付してある。以下では、第1実施形態に係る画像認識装置1または第2実施形態に係る画像認識装置1aとは異なる点について詳しく説明する。

【0111】

3D解析手法による物体認識部31は、特徴点・オプティカルフロー検出部131と、自車に対する相対距離検出部132と、クラスタリング部133と、を備える。

パターン認識による物体認識部32は、座標のスキャン領域決定部141と、勾配積分画像算出部142と、特徴量ベクトル算出部143と、識別部144と、を備える。

【0112】

3D解析手法による物体認識部31において行われる動作の例を示す。

画像取得部12から3D解析手法による物体認識部31に入力された画像は、特徴点・オプティカルフロー検出部131に入力される。

この入力画像は、特徴点・オプティカルフロー検出部131、自車に対する相対距離検出部132、クラスタリング部133により、順に処理されて、その処理の結果がクラスタリング部133から出力される。

クラスタリング部133から出力された処理の結果は、3D解析手法による物体認識の処理の結果として、3D解析手法による物体認識部31から出力されて、最終ターゲット認識部15に入力される。

【0113】

ここで、本実施形態では、3D解析手法による物体認識部31において、図9に示されるのと同様な3D解析手法の処理の手順による処理を行う。

本実施形態では、一例として、特徴点・オプティカルフロー検出部131がステップS1〜ステップS2の処理を実行し、自車に対する相対距離検出部132がステップS3〜ステップS6の処理を実行し、クラスタリング部133がステップS7の処理を実行する。

【0114】

さらに、本実施形態では、クラスタリング部133は、検出された移動物体(本実施形態では、車両であると推定される移動物体)をターゲットとして認識した結果に基づいて、物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)を座標のスキャン領域決定部141に出力する。

【0115】

パターン認識による物体認識部32において行われる動作の例を示す。

画像取得部12からパターン認識による物体認識部32に入力された画像は、座標のスキャン領域決定部141に入力される。

この入力画像は、座標のスキャン領域決定部141、勾配積分画像算出部142、特徴量ベクトル算出部143、識別部144により、順に処理されて、その処理の結果が識別部144から出力される。

識別部144から出力された処理の結果は、パターン認識による物体認識の処理の結果として、パターン認識による物体認識部32から出力されて、最終ターゲット認識部15に入力される。

【0116】

ここで、本実施形態では、クラスタリング部133から出力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)が、座標のスキャン領域決定部141に入力される。

【0117】

座標のスキャン領域決定部141は、入力された画像について、クラスタリング部133から入力された物体認識の処理の結果に基づいて、座標スキャンする領域を決定する。一例として、座標スキャンする領域は、クラスタリング部133から入力された物体の領域よりも広めの領域とする。座標のスキャン領域決定部141は、決定した座標スキャンする領域を特定する情報および入力された画像を勾配積分画像算出部142に出力する。本実施形態では、このようにして決定される座標スキャンする領域は、パターン認識を行う領域となる。

【0118】

勾配積分画像算出部142は、座標のスキャン領域決定部141から入力された画像について、座標のスキャン領域決定部141から入力された情報により特定される座標スキャンする領域(座標領域)の画像に対して、勾配強度と勾配方向を算出し、それぞれの勾配方向の勾配強度に対して積分画像を算出し、ヒストグラムを計算する。勾配積分画像算出部142は、この計算結果の情報を特徴量ベクトル算出部143に出力する。

【0119】

特徴量ベクトル算出部143は、勾配積分画像算出部142から入力された情報に基づいて、HOG特徴量としての特徴ベクトル化を行う。特徴量ベクトル算出部143は、この結果の情報を識別部144に出力する。

識別部144は、特徴量ベクトル算出部143から入力された情報に基づいて、AdaBoostによる識別の処理を行い、あらかじめターゲットとしている物体(本実施形態では、あらかじめ用意された車両の画像のパターンに合致する物体)を認識する。識別部144は、この物体認識の処理の結果を出力する。

【0120】

なお、本実施形態では、パターン認識による物体認識部32において、座標のスキャン領域決定部141により座標のスキャン領域を決定した後に、勾配積分画像算出部142により勾配積分画像を算出する構成としてあり、この構成によって、例えば、第3実施形態に係る図4に示されるように、パターン認識による物体認識部22において、勾配積分画像算出部121による処理を行った後に、座標のスキャン領域決定部126による処理を行う構成と、全体としては同様な処理を実現している。

【0121】

ここで、座標のスキャン領域決定部141は、例えば、クラスタリング部133から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)に基づいて、座標スキャンする領域として、全画像中において、認識対象の物体(本実施形態では、車両)が映っていると推定される領域を決定する。

【0122】

3D解析手法による物体認識の処理の結果を優先してパターン認識の座標スキャンの領域を決定する手法の一例として、座標のスキャン領域決定部141は、3D解析手法による物体認識の処理の結果に基づいて、3D解析手法による物体認識によって認識対象の物体が映っていると判定された領域(判定領域)のみを、座標スキャンする領域として決定することができる。

【0123】

また、3D解析手法による物体認識の処理の結果を優先してパターン認識の座標スキャンの領域を決定する手法の他の一例として、座標のスキャン領域決定部141は、全画像をあらかじめ設定された複数に分割した領域(分割領域)を想定し、3D解析手法による物体認識の処理の結果に基づいて、3D解析手法による物体認識によって認識対象の物体が映っていると判定された領域を含む分割領域のみを、座標スキャンする領域として決定することができる。

【0124】

また、以上のようにして3D解析手法による物体認識の処理の結果を優先してパターン認識の座標スキャンの領域を決定する手法では、例えば、座標のスキャン領域決定部141は、以上のようにして3D解析手法による物体認識の処理の結果に基づいて決定した領域のみを座標スキャンする領域とする構成以外に、以上のようにして3D解析手法による物体認識の処理の結果に基づいて決定した領域とともに、他の任意の手法により決定した領域についても、座標スキャンする領域とする、こともできる。

【0125】

次に、座標のスキャン領域決定部141について、他の例を示す。

他の例に係る座標のスキャン領域決定部141は、クラスタリング部133から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)に基づいて、座標スキャンする領域の重要度を決定する。そして、他の例に係る座標のスキャン領域決定部141は、決定した座標スキャンする領域の重要度の情報を勾配積分画像算出部142に出力する。本実施形態では、このようにして決定される座標スキャンする領域の重要度は、パターン認識を行う領域の重要度として使用される。

【0126】

本実施形態では、勾配積分画像算出部142は、他の例に係る座標のスキャン領域決定部141から入力された情報に基づいて、例えば全画像の中であらかじめ設定した任意の座標領域に対して、他の例に係る座標のスキャン領域決定部141により決定された座標スキャンする領域(座標領域)の重要度を考慮して、勾配方向の勾配強度を算出する。勾配積分画像算出部142は、この算出結果の情報を特徴量ベクトル算出部143に出力する。

【0127】

ここで、他の例に係る座標のスキャン領域決定部141は、例えば、クラスタリング部133から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)に基づいて、座標スキャンする領域の重要度として、全画像中において、認識対象の物体(本実施形態では、車両)が映っていると推定される領域の重要度を高い重要度とするように決定する。

【0128】

3D解析手法による物体認識の処理の結果を重要視してパターン認識の座標スキャンの領域の重要度を決定する手法の一例として、他の例に係る座標のスキャン領域決定部141は、上記のように3D解析手法による物体認識の処理の結果を優先してパターン認識の座標スキャンの領域を決定する手法により決定された領域(判定領域または分割領域)については、特徴量に関する情報(例えば、勾配強度など)を算出するときの重み付け(重要度)を大きくすることができる。この場合、具体例として、勾配積分画像算出部142は、上記のように3D解析手法による物体認識の処理の結果を優先してパターン認識の座標スキャンの領域を決定する手法により決定された領域(判定領域または分割領域)については、他の領域と比べて、得られた特徴量に関する値(例えば、勾配強度など)にあらかじめ設定された値(例えば、1より大きい値)を乗算することができ、つまり、このような領域(判定領域または分割領域)においては、他の領域と比べて、小さい特徴量に関する値であっても、より特徴量が大きいとみなす。

【0129】

3D解析手法による物体認識の処理の結果を重要視してパターン認識の座標スキャンの領域の重要度を決定する手法の他の一例として、他の例に係る座標のスキャン領域決定部141は、上記のように3D解析手法による物体認識の処理の結果を優先してパターン認識の座標スキャンの領域を決定する手法により決定された領域(判定領域または分割領域)については、他の領域と比べて、特徴量に関する情報(例えば、勾配強度など)を算出するときの分解能を細かくすることができる。この場合、具体例として、勾配積分画像算出部142は、上記のように3D解析手法による物体認識の処理の結果を優先してパターン認識の座標スキャンの領域を決定する手法により決定された領域(判定領域または分割領域)については、あらかじめ設定された比較的細かい分解能でスライド(移動)させてスキャンし、他の領域については、あらかじめ設定された比較的粗い分解能でスライド(移動)させてスキャンすることができる。

【0130】

以上のように、本実施形態に係る画像認識装置3では、3D解析手法による物体認識部31のクラスタリング部133により得られた情報が、パターン認識による物体認識部32の座標のスキャン領域決定部141(上記した他の例に係る座標のスキャン領域決定部141でもよい)に伝えられて利用される構成となっている。

従って、本実施形態に係る画像認識装置3によれば、物体の認識を精度良く行うことができ、ターゲットとする物体の検出に好適な装置を提供することができる。例えば、本実施形態に係る画像認識装置3によれば、3D解析手法による物体認識において確定した座標領域を優先してまたは重要視して、パターン認識を行う画像において座標をスキャンする領域に関する設定を行うことができる。これにより、例えば、パターン認識の座標スキャン時の処理負荷を軽減することが可能である。

【0131】

[第5実施形態]

図6は、本発明の第5実施形態に係る画像認識装置4の構成を示すブロック図である。

本実施形態に係る画像認識装置4は、単眼カメラ11と、画像取得部12と、3D解析手法による物体認識部41と、パターン認識による物体認識部42と、最終ターゲット認識部15と、距離・TTC確定部16と、トラッキング部17と、衝突警報部18と、ACC制御部19と、を備える。

【0132】

ここで、本実施形態に係る画像認識装置4の構成や動作は、3D解析手法による物体認識部41とパターン認識による物体認識部42に関する構成や動作を除いて、図1に示される第1実施形態に係る画像認識装置1の構成(AND論理を用いる構成)、または、第2実施形態に係る画像認識装置1aの構成(OR論理を用いる構成)と同様である。

このため、図6では、第1実施形態または第2実施形態と同様な構成部については、同一の符号を付してある。以下では、第1実施形態に係る画像認識装置1または第2実施形態に係る画像認識装置1aとは異なる点について詳しく説明する。

【0133】

3D解析手法による物体認識部41は、特徴点・オプティカルフロー検出部151と、自車に対する相対距離検出部152と、クラスタリング部153と、を備える。

パターン認識による物体認識部42は、勾配積分画像算出部161と、座標スキャン部162と、特徴量ベクトル算出部163と、識別部164と、を備える。

【0134】

3D解析手法による物体認識部41において行われる動作の例を示す。

画像取得部12から3D解析手法による物体認識部41に入力された画像は、特徴点・オプティカルフロー検出部151に入力される。

この入力画像は、特徴点・オプティカルフロー検出部151、自車に対する相対距離検出部152、クラスタリング部153により、順に処理されて、その処理の結果がクラスタリング部153から出力される。

クラスタリング部153から出力された処理の結果は、3D解析手法による物体認識の処理の結果として、3D解析手法による物体認識部41から出力されて、最終ターゲット認識部15に入力される。

【0135】

ここで、本実施形態では、3D解析手法による物体認識部41において、図9に示されるのと同様な3D解析手法の処理の手順による処理を行う。

本実施形態では、一例として、特徴点・オプティカルフロー検出部151がステップS1〜ステップS2の処理を実行し、自車に対する相対距離検出部152がステップS3〜ステップS6の処理を実行し、クラスタリング部153がステップS7の処理を実行する。

【0136】

さらに、本実施形態では、特徴点・オプティカルフロー検出部151は、検出した特徴点の情報と、検出(本実施形態では、計算)したオプティカルフローの情報を識別部164に出力する。

【0137】

パターン認識による物体認識部42において行われる動作の例を示す。

画像取得部12からパターン認識による物体認識部42に入力された画像は、勾配積分画像算出部161に入力される。

この入力画像は、勾配積分画像算出部161、座標スキャン部162、特徴量ベクトル算出部163、識別部164により、順に処理されて、その処理の結果が識別部164から出力される。

識別部164から出力された処理の結果は、パターン認識による物体認識の処理の結果として、パターン認識による物体認識部42から出力されて、最終ターゲット認識部15に入力される。

【0138】

ここで、本実施形態では、パターン認識による物体認識部42に備えられた勾配積分画像算出部161と、座標スキャン部162と、特徴量ベクトル算出部163と、識別部164によって、概略的には、それぞれ、図2に示される勾配積分画像算出部101と、座標スキャン部102と、特徴量ベクトル算出部103と、識別部104と同様な動作を行う。

【0139】

さらに、本実施形態では、特徴点・オプティカルフロー検出部151から出力された特徴点の情報と、オプティカルフローの情報が、識別部164に入力される。

識別部164は、特徴量ベクトル算出部163から入力された情報(特徴量ベクトルの情報)に基づいて、AdaBoostによる識別の処理を行い、あらかじめターゲットとしている物体(本実施形態では、あらかじめ用意された車両の画像のパターンに合致する物体)を認識し、この場合に、特徴点・オプティカルフロー検出部151から入力された特徴点の情報とオプティカルフローの情報のうちの一方または両方に基づいて、識別の処理を行う。識別部164は、この物体認識の処理の結果を出力する。

【0140】

ここで、識別部164は、例えば、入力された特徴点の情報とオプティカルフローの情報のうちの一方または両方に基づいて、全画像中において、認識対象の物体(本実施形態では、車両)が映っている可能性が高いと推定される領域について、パターン認識による物体認識において物体を認識し易くするように変更(設定)する。言い換えれば、このような領域を重要度(優先度)が高い領域であるとみなす。

【0141】

具体例として、本実施形態では、識別部164は、パターン認識により認識対象の物体を識別(認識)するための閾値(識別閾値)を用いて、パターン認識による物体認識を行う。また、識別部164では、この識別閾値を可変に設定することが可能になっている。

そして、識別部164は、車両の画像のパターンをメモリに記憶しており、特徴量ベクトル算出部163から入力された情報(特徴量ベクトルの情報)に基づいて、画像(画像取得部12から出力される画像)の中で、識別閾値を用いて、メモリに記憶された車両の画像のパターンと同一または類似するものが映っていると推定される画像領域を識別(認識)し、その画像領域を特定する情報を物体認識の処理の結果として最終ターゲット認識部15に出力する。この識別の処理では、メモリに記憶された車両の画像のパターンとの一致度が識別閾値(例えば、弱識別器による線形和の値で強識別器の判定をする際の閾値)以上となる画像中の領域を、メモリに記憶された車両の画像のパターンと同一または類似するものが映っていると推定される画像領域として識別する。

【0142】

識別部164は、入力された特徴点の情報とオプティカルフローの情報のうちの一方または両方に基づいて、全画像中において、認識対象の物体(本実施形態では、車両)が映っている可能性が高いと推定される領域について、パターン認識による物体認識において用いられる識別閾値を小さくするように変更(設定)することで、物体を認識し易くするように設定する。

【0143】

特徴点の情報を優先してまたは重要視してパターン認識による物体認識において用いられる識別閾値を変更(設定)する手法の一例として、識別部164は、特徴点が多い方が認識対象の物体が映っている可能性が高いという推定に基づいて、全画像をあらかじめ設定された複数に分割した領域(分割領域)を想定し、各分割領域内に存在する特徴点の数を算出し、算出した特徴点の数があらかじめ設定された値(閾値)より多い分割領域のみについて、あらかじめ定められた基準となる識別閾値よりも小さい値の識別閾値を用いるように変更(設定)することができる。この場合、例えば、特徴点の数があらかじめ設定された値(閾値)より多い分割領域では、他の領域と比べて、より小さい識別閾値が用いられる。

【0144】

なお、前記した特徴点の数に関する閾値としては、一例として、2以上の値を設定する。

他の一例として、前記した特徴点の数に関する閾値として、1を設定することもできる。この場合、識別部164は、全画像をあらかじめ設定された複数に分割した領域(分割領域)を想定し、1つでも特徴点が抽出された分割領域のみについて、あらかじめ定められた基準となる識別閾値よりも小さい値の識別閾値を用いるように変更(設定)することができる。

また、基準となる識別閾値としては、任意の値が用いられてもよく、例えば、本実施形態におけるような識別閾値の変更(設定)が行われない構成において全ての画像領域に対して一定に設定される識別閾値の値を用いることができる。

【0145】

オプティカルフローの情報を優先してまたは重要視してパターン認識による物体認識において用いられる識別閾値を変更(設定)する手法の一例として、識別部164は、オプティカルフローにより定められる変化量(例えば、勾配の強度)の平均値が大きい方が認識対象の物体が映っている可能性が高いという推定に基づいて、全画像をあらかじめ設定された複数に分割した領域(分割領域)を想定し、各分割領域内に存在する1つ以上のオプティカルフローにより定められる変化量の平均値を算出し、算出した平均値があらかじめ設定された値(閾値)より大きい分割領域のみについて、あらかじめ定められた基準となる識別閾値よりも小さい値の識別閾値を用いるように変更(設定)することができる。この場合、例えば、オプティカルフローにより定められる変化量の平均値があらかじめ設定された値(閾値)より多い分割領域では、他の領域と比べて、より小さい識別閾値が用いられる。

【0146】

また、オプティカルフローの情報を優先してまたは重要視してパターン認識による物体認識において用いられる識別閾値を変更(設定)する手法の他の一例として、識別部164は、全画像をあらかじめ設定された複数に分割した領域(分割領域)を想定し、あらかじめ設定された値(閾値)より大きいオプティカルフローが1つでも抽出された分割領域のみについて、あらかじめ定められた基準となる識別閾値よりも小さい値の識別閾値を用いるように変更(設定)することができる。

【0147】

また、特徴点の情報やオプティカルフローの情報を優先してまたは重要視してパターン認識による物体認識において用いられる識別閾値を変更(設定)する手法の一例として、識別部164は、特徴点に関する条件(例えば、上記したもの等、1つ以上の条件)を満たし、且つ、オプティカルフローに関する条件(例えば、上記したもの等、1つ以上の条件)を満たす分割領域のみについて、あらかじめ定められた基準となる識別閾値よりも小さい値の識別閾値を用いるように変更(設定)することができる。

【0148】

また、特徴点の情報やオプティカルフローの情報を優先してまたは重要視してパターン認識による物体認識において用いられる識別閾値を変更(設定)する手法の他の一例として、識別部164は、特徴点に関する条件(例えば、上記したもの等、1つ以上の条件)またはオプティカルフローに関する条件(例えば、上記したもの等、1つ以上の条件)のうちの少なくとも1つの条件を満たす分割領域(これらの全ての条件を満たす分割領域も含む)のみについて、あらかじめ定められた基準となる識別閾値よりも小さい値の識別閾値を用いるように変更(設定)することができる。

【0149】

また、以上のようにして特徴点の情報とオプティカルフローの情報のうちの一方または両方を優先してまたは重要視してパターン認識による物体認識において用いられる識別閾値を変更(設定)する手法では、例えば、識別部164は、以上のようにして特徴点の情報とオプティカルフローの情報のうちの一方または両方に基づいて決定した特定の領域のみについて、あらかじめ定められた基準となる識別閾値よりも小さい値の識別閾値を用いるように変更(設定)する構成以外に、以上のようにして特徴点の情報とオプティカルフローの情報のうちの一方または両方に基づいて決定した特定の領域とともに、他の任意の手法により決定した領域についても、あらかじめ定められた基準となる識別閾値よりも小さい値の識別閾値を用いるように変更(設定)する、こともできる。

【0150】

以上のように、本実施形態に係る画像認識装置4では、3D解析手法による物体認識部41の特徴点・オプティカルフロー検出部151により得られた情報が、パターン認識による物体認識部42の識別部164に伝えられて利用される構成となっている。

従って、本実施形態に係る画像認識装置4によれば、物体の認識を精度良く行うことができ、ターゲットとする物体の検出に好適な装置を提供することができる。例えば、本実施形態に係る画像認識装置4によれば、3D解析手法による物体認識において得られた特徴点の情報または動きベクトル(本実施形態では、オプティカルフロー)の情報に基づく座標領域を優先してまたは重要視して、パターン認識による物体認識を行う際の識別閾値に関する設定を行うことができる。

【0151】

具体例として、本実施形態に係る画像認識装置4によれば、3D解析手法による物体認識において得られた特徴点の情報または動きベクトル(本実施形態では、オプティカルフロー)の情報に基づく座標領域を優先してまたは重要視して、特定の領域について、AdaBoostによる物体の識別(認識)で用いられる識別閾値を、より認識し易い側へ下げることができる。これは、例えば、3D解析手法による物体認識において得られる特徴点または動きベクトルに基づく座標領域では、認識対象の物体である確からしさがより高いという考え方に基づいている。

【0152】

[第6実施形態]

図7は、本発明の第6実施形態に係る画像認識装置5の構成を示すブロック図である。

本実施形態に係る画像認識装置5は、単眼カメラ11と、画像取得部12と、3D解析手法による物体認識部51と、パターン認識による物体認識部52と、最終ターゲット認識部15と、距離・TTC確定部16と、トラッキング部17と、衝突警報部18と、ACC制御部19と、を備える。

【0153】

ここで、本実施形態に係る画像認識装置5の構成や動作は、3D解析手法による物体認識部51とパターン認識による物体認識部52に関する構成や動作を除いて、図1に示される第1実施形態に係る画像認識装置1の構成(AND論理を用いる構成)、または、第2実施形態に係る画像認識装置1aの構成(OR論理を用いる構成)と同様である。

このため、図7では、第1実施形態または第2実施形態と同様な構成部については、同一の符号を付してある。以下では、第1実施形態に係る画像認識装置1または第2実施形態に係る画像認識装置1aとは異なる点について詳しく説明する。

【0154】

3D解析手法による物体認識部51は、特徴点・オプティカルフロー検出部171と、自車に対する相対距離検出部172と、クラスタリング部173と、を備える。

パターン認識による物体認識部52は、勾配積分画像算出部181と、座標スキャン部182と、特徴量ベクトル算出部183と、識別部184と、を備える。

【0155】

3D解析手法による物体認識部51において行われる動作の例を示す。

画像取得部12から3D解析手法による物体認識部51に入力された画像は、特徴点・オプティカルフロー検出部171に入力される。

この入力画像は、特徴点・オプティカルフロー検出部171、自車に対する相対距離検出部172、クラスタリング部173により、順に処理されて、その処理の結果がクラスタリング部173から出力される。

クラスタリング部173から出力された処理の結果は、3D解析手法による物体認識の処理の結果として、3D解析手法による物体認識部51から出力されて、最終ターゲット認識部15に入力される。

【0156】

ここで、本実施形態では、3D解析手法による物体認識部51において、図9に示されるのと同様な3D解析手法の処理の手順による処理を行う。

本実施形態では、一例として、特徴点・オプティカルフロー検出部171がステップS1〜ステップS2の処理を実行し、自車に対する相対距離検出部172がステップS3〜ステップS6の処理を実行し、クラスタリング部173がステップS7の処理を実行する。

【0157】

さらに、本実施形態では、クラスタリング部173は、検出された移動物体(本実施形態では、車両であると推定される移動物体)をターゲットとして認識した結果に基づいて、物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)を識別部184に出力する。

【0158】

パターン認識による物体認識部52において行われる動作の例を示す。

画像取得部12からパターン認識による物体認識部52に入力された画像は、勾配積分画像算出部181に入力される。

この入力画像は、勾配積分画像算出部181、座標スキャン部182、特徴量ベクトル算出部183、識別部184により、順に処理されて、その処理の結果が識別部184から出力される。

識別部184から出力された処理の結果は、パターン認識による物体認識の処理の結果として、パターン認識による物体認識部52から出力されて、最終ターゲット認識部15に入力される。

【0159】

ここで、本実施形態では、パターン認識による物体認識部52に備えられた勾配積分画像算出部181と、座標スキャン部182と、特徴量ベクトル算出部183と、識別部184によって、概略的には、それぞれ、図2に示される勾配積分画像算出部101と、座標スキャン部102と、特徴量ベクトル算出部103と、識別部104と同様な動作を行う。

【0160】

さらに、本実施形態では、クラスタリング部173から出力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)が、識別部184に入力される。

【0161】

識別部184は、特徴量ベクトル算出部183から入力された情報(特徴量ベクトルの情報)に基づいて、AdaBoostによる識別の処理を行い、あらかじめターゲットとしている物体(本実施形態では、あらかじめ用意された車両の画像のパターンに合致する物体)を認識し、この場合に、クラスタリング部173から入力された物体認識の処理の結果に基づいて、識別の処理を行う。識別部184は、この物体認識の処理の結果を出力する。

【0162】

ここで、識別部184は、例えば、クラスタリング部173から入力された物体認識の処理の結果に基づいて、全画像中において、認識対象の物体(本実施形態では、車両)が映っている可能性が高いと推定される領域について、パターン認識による物体認識において物体を認識し易くするように変更(設定)する。言い換えれば、このような領域を重要度(優先度)が高い領域であるとみなす。

【0163】

具体例として、本実施形態では、識別部184は、パターン認識により認識対象の物体を識別(認識)するための閾値(識別閾値)を用いて、パターン認識による物体認識を行う。また、識別部184では、この識別閾値を可変に設定することが可能になっている。

そして、識別部184は、車両の画像のパターンをメモリに記憶しており、特徴量ベクトル算出部183から入力された情報(特徴量ベクトルの情報)に基づいて、画像(画像取得部12から出力される画像)の中で、識別閾値を用いて、メモリに記憶された車両の画像のパターンと同一または類似するものが映っていると推定される画像領域を識別(認識)し、その画像領域を特定する情報を物体認識の処理の結果として最終ターゲット認識部15に出力する。この識別の処理では、メモリに記憶された車両の画像のパターンとの一致度が識別閾値(例えば、弱識別器による線形和の値で強識別器の判定をする際の閾値)以上となる画像中の領域を、メモリに記憶された車両の画像のパターンと同一または類似するものが映っていると推定される画像領域として識別する。

【0164】

識別部184は、クラスタリング部173から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)に基づいて、全画像中において、認識対象の物体(本実施形態では、車両)が映っている可能性が高いと推定される領域について、パターン認識による物体認識において用いられる識別閾値を小さくするように変更(設定)することで、物体を認識し易くするように設定する。

【0165】

3D解析手法による物体認識の処理の結果を優先してまたは重要視してパターン認識による物体認識において用いられる識別閾値を変更(設定)する手法の一例として、識別部184は、3D解析手法による物体認識の処理の結果に基づいて、3D解析手法による物体認識によって認識対象の物体が映っていると判定された領域(判定領域)のみについて、あらかじめ定められた基準となる識別閾値よりも小さい値の識別閾値を用いるように変更(設定)することができる。この場合、例えば、判定領域では、他の領域と比べて、より小さい識別閾値が用いられる。

【0166】

なお、基準となる識別閾値としては、任意の値が用いられてもよく、例えば、本実施形態におけるような識別閾値の変更(設定)が行われない構成において全ての画像領域に対して一定に設定される識別閾値の値を用いることができる。

【0167】

また、3D解析手法による物体認識の処理の結果を優先してまたは重要視してパターン認識による物体認識において用いられる識別閾値を変更(設定)する手法の他の一例として、識別部184は、全画像をあらかじめ設定された複数に分割した領域(分割領域)を想定し、3D解析手法による物体認識の処理の結果に基づいて、3D解析手法による物体認識によって認識対象の物体が映っていると判定された領域を含む分割領域のみについて、あらかじめ定められた基準となる識別閾値よりも小さい値の識別閾値を用いるように変更(設定)することができる。

【0168】

また、以上のようにして3D解析手法による物体認識の処理の結果を優先してまたは重要視してパターン認識による物体認識において用いられる識別閾値を変更(設定)する手法では、例えば、識別部184は、以上のようにして3D解析手法による物体認識の処理の結果に基づいて決定した特定の領域のみについて、あらかじめ定められた基準となる識別閾値よりも小さい値の識別閾値を用いるように変更(設定)する構成以外に、以上のようにして3D解析手法による物体認識の処理の結果に基づいて決定した特定の領域とともに、他の任意の手法により決定した領域についても、あらかじめ定められた基準となる識別閾値よりも小さい値の識別閾値を用いるように変更(設定)する、こともできる。

【0169】

以上のように、本実施形態に係る画像認識装置5では、3D解析手法による物体認識部51のクラスタリング部173により得られた情報が、パターン認識による物体認識部52の識別部184に伝えられて利用される構成となっている。

従って、本実施形態に係る画像認識装置5によれば、物体の認識を精度良く行うことができ、ターゲットとする物体の検出に好適な装置を提供することができる。例えば、本実施形態に係る画像認識装置5によれば、3D解析手法による物体認識において得られた物体認識の処理の結果に基づく座標領域を優先してまたは重要視して、パターン認識による物体認識を行う際の識別閾値に関する設定を行うことができる。

【0170】

具体例として、本実施形態に係る画像認識装置5によれば、3D解析手法による物体認識において得られた物体認識の処理の結果に基づく座標領域を優先してまたは重要視して、特定の領域について、AdaBoostによる物体の識別(認識)で用いられる識別閾値を、より認識し易い側へ下げることができる。これは、例えば、3D解析手法による物体認識において得られる物体認識の処理の結果に基づく座標領域では、認識対象の物体である確からしさがより高いという考え方に基づいている。

【0171】

[第7実施形態]

図8は、本発明の第7実施形態に係る画像認識装置6の構成を示すブロック図である。

本実施形態に係る画像認識装置6は、単眼カメラ11と、画像取得部12と、3D解析手法による物体認識部61と、パターン認識による物体認識部62と、最終ターゲット認識部63と、距離・TTC確定部16と、トラッキング部17と、衝突警報部18と、ACC制御部19と、を備える。

【0172】

ここで、本実施形態に係る画像認識装置6の構成や動作は、3D解析手法による物体認識部61とパターン認識による物体認識部62と最終ターゲット認識部63に関する構成や動作を除いて、図1に示される第1実施形態に係る画像認識装置1の構成(AND論理を用いる構成)、または、第2実施形態に係る画像認識装置1aの構成(OR論理を用いる構成)と同様である。

このため、図8では、第1実施形態または第2実施形態と同様な構成部については、同一の符号を付してある。以下では、第1実施形態に係る画像認識装置1または第2実施形態に係る画像認識装置1aとは異なる点について詳しく説明する。

【0173】

3D解析手法による物体認識部61は、特徴点・オプティカルフロー検出部191と、自車に対する相対距離検出部192と、クラスタリング部193と、を備える。

パターン認識による物体認識部62は、勾配積分画像算出部201と、座標スキャン部202と、特徴量ベクトル算出部203と、識別部204と、を備える。

【0174】

パターン認識による物体認識部62において行われる動作の例を示す。

画像取得部12からパターン認識による物体認識部62に入力された画像は、勾配積分画像算出部201に入力される。

この入力画像は、勾配積分画像算出部201、座標スキャン部202、特徴量ベクトル算出部203、識別部204により、順に処理されて、その処理の結果が識別部204から出力される。

【0175】

ここで、本実施形態では、パターン認識による物体認識部62に備えられた勾配積分画像算出部201と、座標スキャン部202と、特徴量ベクトル算出部203と、識別部204によって、概略的には、それぞれ、図2に示される勾配積分画像算出部101と、座標スキャン部102と、特徴量ベクトル算出部103と、識別部104と同様な動作を行う。

そして、本実施形態では、識別部204から出力された処理の結果は、パターン認識による物体認識の処理の結果として、パターン認識による物体認識部62から出力されて、3D解析手法による物体認識部61の特徴点・オプティカルフロー検出部191に入力される。

【0176】

3D解析手法による物体認識部61において行われる動作の例を示す。

画像取得部12から3D解析手法による物体認識部61に入力された画像は、特徴点・オプティカルフロー検出部191に入力される。

この入力画像は、特徴点・オプティカルフロー検出部191、自車に対する相対距離検出部192、クラスタリング部193により、順に処理されて、その処理の結果がクラスタリング部193から出力される。

クラスタリング部193から出力された処理の結果は、3D解析手法による物体認識の処理の結果として、3D解析手法による物体認識部61から出力されて、最終ターゲット認識部63に入力される。

【0177】

ここで、本実施形態では、3D解析手法による物体認識部61において、概略的には、図9に示されるのと同様な3D解析手法の処理の手順による処理を行う。

本実施形態では、一例として、特徴点・オプティカルフロー検出部191がステップS1〜ステップS2の処理を実行し、自車に対する相対距離検出部192がステップS3〜ステップS6の処理を実行し、クラスタリング部193がステップS7の処理を実行する。

【0178】

さらに、本実施形態では、特徴点・オプティカルフロー検出部191は、画像取得部12から入力された画像に基づいて、特徴点を検出し、オプティカルフローを検出(本実施形態では、計算)する場合に、パターン認識による物体認識部62の識別部204から入力されたパターン認識による物体認識の処理の結果に基づいて、特徴点の検出や、オプティカルフローの検出(本実施形態では、計算)を行う。

【0179】

ここで、特徴点・オプティカルフロー検出部191は、例えば、パターン認識による物体認識部62の識別部204から入力されたパターン認識による物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)に基づいて、特徴点の検出やオプティカルフローの検出を行う領域を決定する。

【0180】

パターン認識による物体認識の処理の結果を優先して3D解析手法による物体認識における特徴点の検出やオプティカルフローの検出を行う領域を決定する手法の一例として、特徴点・オプティカルフロー検出部191は、パターン認識による物体認識の処理の結果に基づいて、パターン認識による物体認識によって認識対象の物体が映っていると判定された領域(判定領域)のみを、特徴点の検出やオプティカルフローの検出を行う領域として決定することができる。

【0181】

パターン認識による物体認識の処理の結果を優先して3D解析手法による物体認識における特徴点の検出やオプティカルフローの検出を行う領域を決定する手法の他の一例として、特徴点・オプティカルフロー検出部191は、全画像をあらかじめ設定された複数に分割した領域(分割領域)を想定し、パターン認識による物体認識の処理の結果に基づいて、パターン認識による物体認識によって認識対象の物体が映っていると判定された領域を含む分割領域のみを、特徴点の検出やオプティカルフローの検出を行う領域として決定することができる。

【0182】

また、以上のようにしてパターン認識による物体認識の処理の結果を優先して3D解析手法による物体認識における特徴点の検出やオプティカルフローの検出を行う領域を決定する手法では、例えば、特徴点・オプティカルフロー検出部191は、以上のようにしてパターン認識による物体認識の処理の結果に基づいて決定した領域のみを特徴点の検出やオプティカルフローの検出を行う領域とする構成以外に、以上のようにしてパターン認識による物体認識の処理の結果に基づいて決定した領域とともに、他の任意の手法により決定した領域についても、特徴点の検出やオプティカルフローの検出を行う領域とする、こともできる。

【0183】

次に、特徴点・オプティカルフロー検出部191について、他の例を示す。

他の例に係る特徴点・オプティカルフロー検出部191は、パターン認識による物体認識部62の識別部204から入力されたパターン認識による物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)に基づいて、特徴点の検出やオプティカルフローの検出を行う領域の重要度を決定する。

【0184】

本実施形態では、他の例に係る特徴点・オプティカルフロー検出部191は、例えば全画像の中であらかじめ設定した任意の座標領域に対して、決定した領域(座標領域)の重要度を考慮して、特徴点の検出やオプティカルフローの検出を行う。

【0185】

ここで、他の例に係る特徴点・オプティカルフロー検出部191は、例えば、パターン認識による物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)に基づいて、特徴点の検出やオプティカルフローの検出を行う領域の重要度として、全画像中において、認識対象の物体(本実施形態では、車両)が映っていると推定される領域の重要度を高い重要度とするように決定する。

【0186】

パターン認識による物体認識の処理の結果を重要視して3D解析手法による物体認識における特徴点の検出を行う領域の重要度を決定する手法の一例として、他の例に係る特徴点・オプティカルフロー検出部191は、上記のようにパターン認識による物体認識の処理の結果を優先して3D解析手法による物体認識における特徴点の検出やオプティカルフローの検出を行う領域を決定する手法により決定された領域(判定領域または分割領域)については、特徴点を検出するときの重み付け(重要度)を大きくすることができる。この場合、具体例として、他の例に係る特徴点・オプティカルフロー検出部191は、例えば、画素値の変化(例えば、輝度値の変化)に関する閾値があらかじめ定められており、時間的な画素値の変化が当該閾値以上となる画像中の点を特徴点として検出する構成において、上記のようにパターン認識による物体認識の処理の結果を優先して3D解析手法による物体認識における特徴点の検出やオプティカルフローの検出を行う領域を決定する手法により決定された領域(判定領域または分割領域)については、他の領域と比べて、その閾値を小さく変更(設定)することができ、つまり、このような領域(判定領域または分割領域)においては、他の領域と比べて、小さい画素変化量であっても、特徴点として検出する。

【0187】

また、パターン認識による物体認識の処理の結果を重要視して3D解析手法による物体認識における特徴点の検出を行う領域の重要度を決定する手法の他の一例として、他の例に係る特徴点・オプティカルフロー検出部191は、上記のようにパターン認識による物体認識の処理の結果を優先して3D解析手法による物体認識における特徴点の検出やオプティカルフローの検出を行う領域を決定する手法により決定された領域(判定領域または分割領域)については、特徴点を検出するときの分解能を細かくすることができる。この場合、具体例として、他の例に係る特徴点・オプティカルフロー検出部191は、上記のようにパターン認識による物体認識の処理の結果を優先して3D解析手法による物体認識における特徴点の検出やオプティカルフローの検出を行う領域を決定する手法により決定された領域(判定領域または分割領域)については、あらかじめ設定された比較的細かい分解能で特徴点を検出し、他の領域については、あらかじめ設定された比較的粗い分解能で特徴点を検出することができる。

【0188】

パターン認識による物体認識の処理の結果を重要視して3D解析手法による物体認識におけるオプティカルフローの検出を行う領域の重要度を決定する手法の一例として、他の例に係る特徴点・オプティカルフロー検出部191は、上記のようにパターン認識による物体認識の処理の結果を優先して3D解析手法による物体認識における特徴点の検出やオプティカルフローの検出を行う領域を決定する手法により決定された領域(判定領域または分割領域)については、オプティカルフローを検出するときの重み付け(重要度)を大きくすることができる。この場合、具体例として、他の例に係る特徴点・オプティカルフロー検出部191は、例えば、オプティカルフローを検出する際に所定の閾値を用いる構成において、上記のようにパターン認識による物体認識の処理の結果を優先して3D解析手法による物体認識における特徴点の検出やオプティカルフローの検出を行う領域を決定する手法により決定された領域(判定領域または分割領域)については、他の領域と比べて、その閾値を、オプティカルフローがより検出され易いように変更(設定)することができる。

【0189】

また、パターン認識による物体認識の処理の結果を重要視して3D解析手法による物体認識におけるオプティカルフローの検出を行う領域の重要度を決定する手法の他の一例として、他の例に係る特徴点・オプティカルフロー検出部191は、上記のようにパターン認識による物体認識の処理の結果を優先して3D解析手法による物体認識における特徴点の検出やオプティカルフローの検出を行う領域を決定する手法により決定された領域(判定領域または分割領域)については、オプティカルフローを検出するときの分解能を細かくすることができる。この場合、具体例として、他の例に係る特徴点・オプティカルフロー検出部191は、上記のようにパターン認識による物体認識の処理の結果を優先して3D解析手法による物体認識における特徴点の検出やオプティカルフローの検出を行う領域を決定する手法により決定された領域(判定領域または分割領域)については、あらかじめ設定された比較的細かい分解能でオプティカルフローを検出し、他の領域については、あらかじめ設定された比較的粗い分解能でオプティカルフローを検出することができる。

【0190】

次に、最終ターゲット認識部63により行われる処理について説明する。

本実施形態では、最終ターゲット認識部63は、3D解析手法による物体認識部61から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)に基づいて、認識対象の物体(本実施形態では、車両)であると特定した画像領域(座標の領域)を、最終的なターゲットの領域であると認識し、認識した最終的なターゲットの領域を特定する情報を距離・TTC確定部16に出力する。

このように、本実施形態では、3D解析手法による物体認識の結果が、最終的なターゲット認識の結果となる。

【0191】

ここで、本実施形態では、全体の画像に認識対象の物体(本実施形態では、車両)が複数映っている場合には、3D解析手法による物体認識部61はそれぞれの物体について物体認識の処理を行い、最終ターゲット認識部63はそれぞれの物体について最終ターゲットの認識の処理を行う。

【0192】

以上のように、本実施形態に係る画像認識装置6では、パターン認識による物体認識部62の識別部204により得られた情報が、3D解析手法による物体認識部61の特徴点・オプティカルフロー検出部191(上記した他の例に係る特徴点・オプティカルフロー検出部191でもよい)に伝えられて利用される構成となっている。

従って、本実施形態に係る画像認識装置6によれば、物体の認識を精度良く行うことができ、ターゲットとする物体の検出に好適な装置を提供することができる。例えば、本実施形態に係る画像認識装置6によれば、パターン認識による物体認識において確定した座標領域を優先してまたは重要視して、3D解析手法による物体認識を行う画像において、特徴点を検出する領域に関する設定やオプティカルフローを検出する領域に関する設定を行うことができる。

【0193】

具体例として、図3に示される画像1001中の枠1002の領域のように、3D解析手法による物体認識では物体の認識ができないまたは物体の認識の能力が低い領域について、本実施形態では、パターン認識による物体認識が可能となる場合には、パターン認識による物体認識によって特定した領域の特徴点・オプティカルフローにおいてターゲットがある可能性が高いことを予測して、後段の3D解析手法による物体認識処理を実行することができる。

【0194】

本実施形態(第7実施形態)と類似の構成として、識別部204の出力を自車に対する相対距離検出部192かクラスタリング部193に入力し、物体を認識するステップ(この例では、図9に示されるステップS7の処理)でパターン認識による物体領域を優先または重要視して判定することもできる。

この構成では、クラスタリング部193は、パターン認識による物体認識部62の識別部204により得られたパターン認識による物体認識の結果に基づいて、認識対象の物体の識別を行う。

3D解析手法による物体認識部61のクラスタリング部193において、パターン認識による物体認識の処理の結果(パターン認識による物体領域)を優先してまたは重要視して判定する(物体を認識する)手法としては、様々な手法が用いられてもよく、例えば、画像中のあらかじめ定めた座標領域(例えば図3の1002)に、パターン認識による物体領域がある場合は、前記あらかじめ定めた座標領域に認識すべき物体が存在することを確定する手法や、パターン認識による物体領域と一致する部分のみを物体認識結果の範囲に含める手法や、パターン認識による物体領域と一致する部分の方が一致しない部分よりも物体認識結果の範囲に含まれ易くするように所定の閾値などを変更する手法などを用いることができる。

【0195】

<以上の実施形態についてのまとめ>

ここで、以上の実施形態では、図1、図4〜図8に示される装置を車載用として車両に設ける構成を示したが、他の例として、他の任意の移動体に設けることも可能である。

また、以上の実施形態では、3D解析手法による物体認識の手法として、非特許文献1に記載された手法を用いる構成を示したが、この手法に限定するものではなく、例えば、特徴点の抽出による3D解析手法の全般に適用することもできる。

また、以上の実施形態では、パターン認識による物体認識で用いるHOG特徴量として、輝度勾配の積分画像によるヒストグラム(インテグラルヒストグラム)での作成を例に述べたが、他の手法が用いられてもよい。

【0196】

なお、図1、図2、図4〜図8、図10における任意の構成部により行われる処理の機能を実現するためのプログラムをコンピュータ読み取り可能な記録媒体に記録して、この記録媒体に記録されたプログラムをコンピュータシステムに読み込ませ、実行することにより、処理を行ってもよい。ここで言う「コンピュータシステム」とは、OS(Operating System)や周辺機器等のハードウェアを含むものとする。また、「コンピュータシステム」は、ホームページ提供環境(あるいは、表示環境)を備えたWWWシステムも含むものとする。また、「コンピュータ読み取り可能な記録媒体」とは、フレキシブルディスク、光磁気ディスク、ROM(Read Only Memory)、CD−ROM等の可搬媒体、コンピュータシステムに内蔵されるハードディスク等の記憶装置のことを言う。さらに、「コンピュータ読み取り可能な記録媒体」とは、インターネット等のネットワークや電話回線等の通信回線を介してプログラムが送信された場合のサーバやクライアントとなるコンピュータシステム内部の揮発性メモリ(RAM(Random Access Memory))のように、一定時間プログラムを保持しているものも含むものとする。

【0197】

また、上記プログラムは、このプログラムを記憶装置等に格納したコンピュータシステムから、伝送媒体を介して、あるいは、伝送媒体中の伝送波により他のコンピュータシステムに伝送されてもよい。ここで、プログラムを伝送する「伝送媒体」は、インターネット等のネットワーク(通信網)や電話回線等の通信回線(通信線)のように情報を伝送する機能を有する媒体のことを言う。また、上記プログラムは、前述した機能の一部を実現するためのものであっても良い。さらに、前述した機能をコンピュータシステムにすでに記録されているプログラムとの組み合わせで実現できるもの、いわゆる差分ファイル(差分プログラム)であっても良い。

【0198】

また、上記に限られず、マイクロコンピュータのほか、例えば、FPGA(Field Programmable Gate Array)、あるいは、DSP(Digital Signal Processor)などのデバイスを用いて、図1、図2、図4〜図8、図10における任意の構成部により行われる処理を実現することも可能である。

【0199】

以上、本発明の各実施形態について図面を参照して詳述したが、具体的な構成はこの実施形態に限られるものではなく、この発明の要旨を逸脱しない範囲の設計等も含まれる。

【符号の説明】

【0200】

1、1a、2〜6…画像認識装置

11…単眼カメラ 12…画像取得部

13、21、31、41、51、61…3D解析手法による物体認識部

14、22、32、42、52、62…パターン認識による物体認識部

15、63…最終ターゲット認識部

16…距離・TTC確定部 17…トラッキング部 18…衝突警報部

19…ACC制御部

101、121、142、161、181、201…勾配積分画像算出部

102、122、162、182、202…座標スキャン部

103、123、143、163、183、203…特徴量ベクトル算出部

104、124、144、164、184、204…識別部

126、141…座標のスキャン領域決定部

111、131、151、171、191…特徴点・オプティカルフロー検出部

112、132、152、172、192…自車に対する相対距離検出部

113、133、153、173、193…クラスタリング部

301…勾配強度検出部 302…勾配方向検出部

303…勾配方向ごとの勾配強度の積分部

311…セル単位の積分値算出部 312…ブロック正規化部

313…特徴量ベクトル算出処理部

【技術分野】

【0001】

本発明は、画像認識装置、画像認識方法および画像認識プログラムに関する。

【背景技術】

【0002】

近年、車両の運転支援装置や予防安全装置として、車間距離制御装置(ACC:Adaptive Cruise Control)や前方衝突警報装置(FCW:Forward Collision Warning)や歩行者衝突警報装置などが開発されている。このような装置では、レーダ等を用いずに、車載カメラのみによる簡易な装置の実現が期待されている。また、車載用の装置は、コストが重視されるため、ステレオカメラではなく、単眼カメラによる装置が求められている。

【0003】

単眼カメラでは、ステレオカメラによる方式に比べて物体の距離や相対速度を容易に推定することができず、TTC(Time To Collision)の算出も困難であるため、例えば、車載の単眼カメラから得られる時系列画像を用いて走行環境の3次元構造を推定し、物体の検知を行う方式が考えられている。これは、3D(3次元)の解析手法である(例えば、非特許文献1参照。)。

【0004】

非特許文献1で開示された技術の方式では、今回画像サイクル(t)と前回画像サイクル(t−1)の画像から特徴点を抽出し、オプティカルフロー等の手法により、自車両の運動を推定し、特徴点の三次元位置計算、路面領域の検出を行った後、移動物体の領域の検出を行う。

【0005】

3D解析手法に対する他の手法として、物体の形状をあらかじめ学習しておき、検出したい物体のパターンを識別する手法(パターン認識の手法)がある。このような手法では、近年、HOG(Histgrams of Oriented Gradients)特徴量やHaar−like特徴量等の特徴量と、AdaBoost(Adaptive Boosting)やSVM(Support Vector Machine)等の認識アルゴリズムを組み合わせた方式が主流となっている。

【先行技術文献】

【非特許文献】

【0006】

【非特許文献1】山口、加藤、二宮、「車載単眼カメラによる車両前方の障害物検出」、社団法人 情報処理学会 研究報告、2005年11月18日、2005−CVIM−151(10)、p.69−76

【発明の概要】

【発明が解決しようとする課題】

【0007】

しかしながら、前記した3D解析手法による認識では、中・近距離での性能は良いが、画像の消失点付近を含む比較的遠距離の物体については、特徴点は抽出できるものの、物体の形状を認識する精度が大幅に劣化してしまう。従って、前記した3D解析手法による認識では、ACCやFCWへの適用は困難であった。

【0008】

一方、前記したパターン認識では、時系列画像処理を織り込むことによって距離と相対速度を算出することも可能ではあるが、その精度と信頼度が前記した3D解析手法に対して大幅に劣るため、車載用の装置に適応するには困難であり、工夫が求められていた。

【0009】

本発明は、このような事情を考慮して為されたものであり、物体の認識を精度良く行うことができる画像認識装置、画像認識方法および画像認識プログラムを提供することを目的としている。

【課題を解決するための手段】

【0010】

(1)上述した課題を解決するために、本発明に係る画像認識装置は、画像に対して3D解析手法による物体認識を行う3D解析手法による物体認識部と、前記画像に対してパターン認識による物体認識を行うパターン認識による物体認識部と、を備え、前記3D解析手法による物体認識部により得られる3D解析手法による物体認識の結果と前記パターン認識による物体認識部により得られるパターン認識による物体認識の結果に基づいて最終ターゲットの認識結果を得る、ことを特徴とする。

【0011】

(2)本発明は、(1)に記載の画像認識装置において、前記3D解析手法による物体認識部により得られた3D解析手法による物体認識の結果と前記パターン認識による物体認識部により得られたパターン認識による物体認識の結果に基づいて、AND論理により、最終ターゲットの認識結果を得る最終ターゲット認識部を備える、ことを特徴とする。

【0012】

(3)本発明は、(1)に記載の画像認識装置において、前記3D解析手法による物体認識部により得られた3D解析手法による物体認識の結果と前記パターン認識による物体認識部により得られたパターン認識による物体認識の結果に基づいて、OR論理により、最終ターゲットの認識結果を得る最終ターゲット認識部を備える、ことを特徴とする。

【0013】

(4)本発明は、(1)から(3)のいずれか1つに記載の画像認識装置において、前記パターン認識による物体認識部は、前記3D解析手法による物体認識部により検出した特徴点とオプティカルフローのうちの一方または両方に基づいて、座標のスキャン領域を決定する、ことを特徴とする。

【0014】

(5)本発明は、(1)から(3)のいずれか1つに記載の画像認識装置において、前記パターン認識による物体認識部は、前記3D解析手法による物体認識部により得られた3D解析手法による物体認識の結果に基づいて、座標のスキャン領域を決定する、ことを特徴とする。

【0015】

(6)本発明は、(1)から(3)のいずれか1つに記載の画像認識装置において、前記パターン認識による物体認識部は、前記3D解析手法による物体認識部により検出した特徴点とオプティカルフローのうちの一方または両方に基づいて、認識対象の物体の識別を行う、ことを特徴とする。

【0016】

(7)本発明は、(6)に記載の画像認識装置において、前記パターン認識による物体認識部は、前記3D解析手法による物体認識部により検出した特徴点とオプティカルフローのうちの一方または両方に基づいて、認識対象の物体が映っている可能性が高いと推定される領域について、物体を認識し易くするように、パターン認識による物体認識において用いられる閾値を変更して、認識対象の物体の識別を行う、ことを特徴とする。

【0017】

(8)本発明は、(1)から(3)のいずれか1つに記載の画像認識装置において、前記パターン認識による物体認識部は、前記3D解析手法による物体認識部により得られた3D解析手法による物体認識の結果に基づいて、認識対象の物体の識別を行う、ことを特徴とする。

【0018】

(9)本発明は、(8)に記載の画像認識装置において、前記パターン認識による物体認識部は、前記3D解析手法による物体認識部により得られた3D解析手法による物体認識の結果に基づいて、認識対象の物体が映っている可能性が高いと推定される領域について、物体を認識し易くするように、パターン認識による物体認識において用いられる閾値を変更して、認識対象の物体の識別を行う、ことを特徴とする。

【0019】

(10)本発明は、(1)に記載の画像認識装置において、前記3D解析手法による物体認識部は、前記パターン認識による物体認識部により得られたパターン認識による物体認識の結果に基づいて、特徴点またはオプティカルフローのうちの一方または両方を検出する、ことを特徴とする。

【0020】

(11)本発明は、(10)に記載の画像認識装置において、前記3D解析手法による物体認識部により得られた3D解析手法による物体認識の結果に基づいて最終ターゲットの認識結果を得る最終ターゲット認識部を備える、ことを特徴とする。

【0021】

(12)本発明は、(1)に記載の画像認識装置において、前記3D解析手法による物体認識部は、前記パターン認識による物体認識部により得られたパターン認識による物体認識の結果に基づいて、認識対象の物体の識別を行う、ことを特徴とする。

【0022】

(13)本発明は、(1)から(12)のいずれか1つに記載の画像認識装置において、車載用の画像認識装置であり、画像を撮像するカメラを備え、前記3D解析手法による物体認識部および前記パターン認識による物体認識部は、前記カメラにより撮像される画像に対して物体認識を行う、ことを特徴とする。

【0023】

(14)上述した課題を解決するために、本発明に係る画像認識方法は、3D解析手法による物体認識部が、画像に対して3D解析手法による物体認識を行い、パターン認識による物体認識部が、前記画像に対してパターン認識による物体認識を行い、前記3D解析手法による物体認識部により得られる3D解析手法による物体認識の結果と前記パターン認識による物体認識部により得られるパターン認識による物体認識の結果に基づいて最終ターゲットの認識結果を得る、ことを特徴とする。

【0024】

(15)上述した課題を解決するために、本発明に係る画像認識プログラムは、3D解析手法による物体認識部により得られる3D解析手法による物体認識の結果とパターン認識による物体認識部により得られるパターン認識による物体認識の結果に基づいて最終ターゲットの認識結果を得るために、3D解析手法による物体認識部が、画像に対して3D解析手法による物体認識を行う手順と、パターン認識による物体認識部が、前記画像に対してパターン認識による物体認識を行う手順と、をコンピュータに実行させるためのものである。

【発明の効果】

【0025】

以上説明したように、本発明によれば、物体の認識を精度良く行うことができる画像認識装置、画像認識方法および画像認識プログラムを提供することが可能になる。

【図面の簡単な説明】

【0026】

【図1】本発明の第1実施形態および第2実施形態に係る画像認識装置の構成を示すブロック図である。

【図2】パターン認識による物体認識部の構成を示すブロック図である。

【図3】3D解析手法による物体認識とパターン認識による物体認識との組み合わせにより物体認識の性能を向上させることが望まれる領域の例を示す図である。

【図4】本発明の第3実施形態に係る画像認識装置の構成を示すブロック図である。

【図5】本発明の第4実施形態に係る画像認識装置の構成を示すブロック図である。

【図6】本発明の第5実施形態に係る画像認識装置の構成を示すブロック図である。

【図7】本発明の第6実施形態に係る画像認識装置の構成を示すブロック図である。

【図8】本発明の第7実施形態に係る画像認識装置の構成を示すブロック図である。

【図9】3D解析手法の処理の手順の一例を示す図である。

【図10】パターン認識による物体認識部のより詳細な構成を示すブロック図である。

【図11】積分画像を説明するための図である。

【発明を実施するための形態】

【0027】

以下の実施形態では、車両(自己の車両)に搭載される車載用の画像認識装置を例として示す。そして、以下の実施形態に係る画像認識装置は、車両の前方の画像を撮像する単眼カメラを備え、当該単眼カメラにより撮像した画像における物体を認識する装置として動作する。

【0028】

[第1実施形態]

図1は、本発明の第1実施形態に係る画像認識装置1の構成を示すブロック図である。

本実施形態に係る画像認識装置1は、単眼カメラ11と、画像取得部12と、3D解析手法による物体認識部13と、パターン認識による物体認識部14と、最終ターゲット認識部15と、距離・TTC確定部16と、トラッキング部17と、衝突警報部18と、ACC制御部19と、を備える。

【0029】

本実施形態では、単眼カメラ11は、画像認識装置1が搭載される車両の前方の画像を撮像する位置に設けられる。

【0030】

本実施形態に係る画像認識装置1において行われる動作の例を示す。

単眼カメラ11は、画像を撮像し、撮像した画像を画像取得部12に出力する。

画像取得部12は、単眼カメラ11から入力された画像を取得し、取得した画像のデータを3D解析手法による物体認識部13とパターン認識による物体認識部14のそれぞれに出力する。

ここで、画像取得部12は、例えば、取得した画像のデータを一時的に記憶する記憶部を有する。

【0031】

3D解析手法による物体認識部13は、画像取得部12から入力された画像のデータについて、3D解析手法による物体認識の処理を行い、この物体認識の処理の結果を最終ターゲット認識部15に出力する。

本実施形態では、3D解析手法による物体認識部13は、画像取得部12から入力された画像のデータについて、その画像の中で、車両が映っていると推定される画像領域を認識し、その画像領域を特定する情報を物体認識の処理の結果として最終ターゲット認識部15に出力する。全体の画像中の画像領域は、例えば、水平(横)方向の座標値と垂直(縦)方向の座標値からなる座標の情報を用いて表現することができる。

ここで、3D解析手法による物体認識部13では、処理の誤差によって、車両以外のものが映っている画像領域を、車両が映っている画像領域として誤認識することが生じ得る。

【0032】

なお、本実施形態では、3D解析手法による物体認識部13において、画像中に映っている移動物体(時間の流れとともに移動する物体であり、静止物体ではないもの)を検出し、検出した移動物体が映っている画像領域を、車両が映っていると推定される画像領域として認識する構成を示す。他の例として、3D解析手法による物体認識部13において、車両が映っていると推定される画像領域を特定するための特徴となる情報を設定しておき、その特徴となる情報に一致または類似する物体が映っている画像領域を、車両が映っていると推定される画像領域(静止車両も含む)として認識する構成を用いることも可能である。

【0033】

パターン認識による物体認識部14は、画像取得部12から入力された画像のデータについて、パターン認識による物体認識の処理を行い、この物体認識の処理の結果を最終ターゲット認識部15に出力する。

本実施形態では、パターン認識による物体認識部14は、車両の画像のパターン(学習結果による、弱識別器のパラメータ等)をメモリに記憶しており、画像取得部12から入力された画像のデータについて、その画像の中で、メモリに記憶された車両の画像のパターンと同一または類似するものが映っていると推定される画像領域を認識し、その画像領域を特定する情報を物体認識の処理の結果として最終ターゲット認識部15に出力する。全体の画像中の画像領域は、例えば、水平(横)方向の座標値と垂直(縦)方向の座標値からなる座標の情報を用いて表現することができる。

ここで、パターン認識による物体認識部14では、処理の誤差によって、車両以外のものが映っている画像領域を、車両が映っている画像領域として誤認識することが生じ得る。

【0034】

最終ターゲット認識部15は、3D解析手法による物体認識部13から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)と、パターン認識による物体認識部14から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)について、これら2つの物体認識の処理の結果において、認識対象の物体(本実施形態では、車両)であると特定した画像領域(座標の領域)が一致する(重なる)部分を、最終的なターゲットの領域であると認識し、認識した最終的なターゲットの領域を特定する情報を距離・TTC確定部16に出力する。

【0035】

具体例として、最終ターゲット認識部15は、3D解析手法による物体認識部13から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)と、パターン認識による物体認識部14から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)について、AND論理の処理を行うことによって、これら2つの一致部分(重複部分)を検出し、その一致部分を、最終的なターゲットの領域であると認識する。

【0036】

ここで、本実施形態では、全体の画像に認識対象の物体(本実施形態では、車両)が複数映っている場合には、3D解析手法による物体認識部13やパターン認識による物体認識部14はそれぞれの物体について物体認識の処理を行い、最終ターゲット認識部15はそれぞれの物体について最終ターゲットの認識の処理を行う。

【0037】

距離・TTC確定部16は、最終ターゲット認識部15から入力された最終的なターゲットの領域を特定する情報に基づいて、それぞれの最終的なターゲット(本実施形態では、車両)ごとに、距離とTTCを算出して確定し、確定した距離とTTCの情報をトラッキング部17に出力する。なお、本実施形態では、距離・TTC確定部16は、それぞれの最終的なターゲットの領域を特定する情報と、確定した距離とTTCの情報との組をトラッキング部17に出力する。

【0038】

ここで、最終的なターゲットごとの距離とTTCは、例えば、距離・TTC確定部16により算出する構成が用いられてもよく、あるいは、他の例として、3D解析手法による物体認識部13またはパターン認識による物体認識部14により算出して、算出した最終的なターゲットごとの距離とTTCの情報を最終ターゲット認識部15を介して距離・TTC確定部16に出力し、距離・TTC確定部16が入力された最終的なターゲットごとの距離とTTCの情報により最終的なターゲットごとの距離とTTCを確定する構成が用いられてもよい。

なお、最終的なターゲットごとの距離とTTCは、例えば、3D解析手法による物体認識部13により得られた物体認識の処理の結果を用いて算出することができ、他の例として、パターン認識による物体認識部14により得られた物体認識の処理の結果を用いて算出されてもよく、さらに他の例として、これら両方の物体認識の処理の結果を用いて算出されてもよい。

【0039】

トラッキング部17は、距離・TTC確定部16から入力された情報に基づいて、トラッキングの処理を行い、衝突警報部18とACC制御部19のそれぞれに各制御に必要な情報を出力する。本実施形態では、トラッキング部17は、例えば、最終的なターゲットごとのTTCの情報を衝突警報部18に出力し、また、トラッキングの処理の結果の情報や、最終的なターゲットごとの距離や相対速度(自己の車両と最終的なターゲットとの距離や相対速度)の情報をACC制御部19に出力する。

【0040】

ここで、最終的なターゲットごとの相対速度は、例えば、トラッキング部17により算出され、他の例として、ACC制御部19などで算出されてもよい。

なお、トラッキング部17は、時系列画像のトラッキングの処理を行う場合に、例えば、制御サイクルの時系列フィルタ処理で、過去制御サイクルとの結果で最終的な判定を行う。

【0041】

衝突警報部18は、トラッキング部17から入力された情報に基づいて、TTCの計算結果により、最終的なターゲット(本実施形態では、他の車両)との衝突の可能性があると判断した場合には、その旨を自己の車両の乗員に警報する(FCWアプリケーション)。

【0042】

ACC制御部19は、トラッキング部17から入力された情報に基づいて、最終的なターゲット(本実施形態では、他の車両)との距離と相対速度の情報を用いて、前走車との車間距離の制御を行う。

【0043】

ここで、本実施形態では、3D解析手法による物体認識部13およびパターン認識による物体認識部14が車両が映っていると推定される画像領域を認識し、最終ターゲット認識部15が車両が映っていると推定される画像領域について最終的なターゲットの領域を認識する構成を示したが、他の例として、車両以外の種々なものが物体認識の対象(ターゲット)とされてもよく、例えば、二輪車や歩行者などが物体認識の対象(ターゲット)とされてもよく、また、車両と二輪車といったように2つ以上のものが物体認識の対象(ターゲット)とされてもよい。3D解析手法による物体認識部13およびパターン認識による物体認識部14には、例えば、あらかじめ、物体認識の対象(ターゲット)とするものを特定するための条件が設定され、その条件に基づいて物体認識の対象(ターゲット)が特定される。

【0044】

次に、3D解析手法による物体認識部13により行われる処理の例を示す。

図9は、3D解析手法の処理の手順の一例を示す図である。ここでは、各処理の概略を説明する。

なお、この処理の手順は、非特許文献1に記載されたものを引用しており、詳細については非特許文献1に記載されている。

【0045】

3D解析手法による物体認識部13は、画像取得部12から入力される画像について、時間的に連続する2枚の画像を取得する(ステップS1)。時間的に連続する2枚の画像は、例えば、時刻tの画像と、時刻t+1の画像となる。

次に、3D解析手法による物体認識部13は、特徴点を検出し、オプティカルフローを計算する(ステップS2)。

【0046】

次に、3D解析手法による物体認識部13は、自車両(自己の車両)の運動を推定する(ステップS3)。この処理では、一時刻前に検出された路面領域の情報と移動物体領域の情報が用いられる(ステップS8)。

次に、3D解析手法による物体認識部13は、特徴点の三次元位置を計算する(ステップS4)。

【0047】

次に、3D解析手法による物体認識部13は、路面領域を検出する(ステップS5)。この処理では、一時刻前に検出された路面領域の情報と移動物体領域の情報が用いられる(ステップS8)。

次に、3D解析手法による物体認識部13は、移動物体領域を検出する(ステップS6)。

そして、3D解析手法による物体認識部13は、検出した移動物体(本実施形態では、車両であると推定される移動物体)をターゲットとして認識する(ステップS7)。

【0048】

なお、3D解析手法による物体認識部13により行われる処理としては、他の種々な3D解析手法による物体認識の処理が用いられてもよい。

また、本実施形態では、動きベクトルとして、オプティカルフローを用いる場合を示すが、他の種々なものが用いられてもよい。

【0049】

次に、パターン認識による物体認識部14の構成例を示す。

図2は、パターン認識による物体認識部14の構成例を示すブロック図である。

本実施形態に係るパターン認識による物体認識部14は、勾配積分画像算出部101と、座標スキャン部102と、特徴量ベクトル算出部103と、識別部104と、を備える。

【0050】

ここで、本実施形態に係るパターン認識による物体認識部14では、特徴量として、HOG特徴量を用いている。他の例として、特徴量として、Haar−like特徴量やEdgelet特徴量等の他の種々な特徴量が用いられてもよい。

また、本実施形態に係るパターン認識による物体認識部14では、識別部104において、AdaBoostの認識アルゴリズムを用いている。他の例として、認識アルゴリズムとして、Real AdaBoostやSVM等の他の種々な認識アルゴリズムやその改良アルゴリズムが用いられてもよい。

【0051】

パターン認識による物体認識部14において行われる動作の例を示す。

なお、HOG特徴量やAdaBoostの認識アルゴリズムとしては、それぞれ、公知の技術を利用することができ、本実施形態では、詳しい説明は省略する。

【0052】

パターン認識による物体認識部14に入力された画像は、勾配積分画像算出部101に入力される。

勾配積分画像算出部101は、入力された画像について、全画像に対して勾配強度と勾配方向を算出し、それぞれの勾配方向の勾配強度に対して積分画像を算出し、ヒストグラムを計算する。勾配積分画像算出部101は、この計算結果の情報を座標スキャン部102に出力する。

なお、本実施形態では、元の全画像に対して勾配強度と勾配方向を算出するが、他の例として、ピラミッド画像により解像度を下げた画像にも適用可能である。

【0053】

座標スキャン部102は、勾配積分画像算出部101から入力された情報に基づいて、全画像の中であらかじめ設定した任意の座標領域に対して、前記した勾配方向の勾配強度を算出する。座標スキャン部102は、この算出結果の情報を特徴量ベクトル算出部103に出力する。

【0054】

ここで、本実施形態では、勾配積分画像算出部101によりあらかじめ算出しておいた積分画像があるため、座標スキャン部102により任意のウインドウ(枠)の積分値を容易に算出することができる。

なお、他の例として、このような積分画像を使用しない構成が用いられてもよい。

【0055】

特徴量ベクトル算出部103は、座標スキャン部102から入力された情報に基づいて、HOG特徴量としての特徴ベクトル化を行う。特徴量ベクトル算出部103は、この結果の情報(特徴量ベクトルの情報)を識別部104に出力する。

識別部104は、特徴量ベクトル算出部103から入力された情報に基づいて、AdaBoostによる識別の処理を行い、あらかじめターゲットとしている物体(本実施形態では、あらかじめ用意された車両の画像のパターンに合致する物体)を認識する。識別部104は、この物体認識の処理の結果を出力する。

識別部104から出力された物体認識の処理の結果は、パターン認識による物体認識部14から出力されて、最終ターゲット認識部15に入力される。

なお、識別部104と最終ターゲット認識部15との間にクラスタリング部を設けてミーンシフト等のクラスタリングを行ってもよい。

【0056】

図10は、パターン認識による物体認識部14のより詳細な構成を示すブロック図である。

図10は、勾配積分画像算出部101と、特徴量ベクトル算出部103について、詳しい構成例を示してある。

勾配積分画像算出部101は、勾配強度検出部301と、勾配方向検出部302と、勾配方向ごとの勾配強度の積分部303と、を備える。

特徴量ベクトル算出部103は、セル単位の積分値算出部311と、ブロック正規化部312と、特徴量ベクトル算出処理部313と、を備える。

【0057】

勾配積分画像算出部101において行われる動作の例を示す。

勾配積分画像算出部101に入力された画像は、勾配強度検出部301に入力される。

勾配強度検出部301は、入力された画像に基づいて、各ピクセル(u,v)における画素値(例えば、輝度値)の勾配強度m(u,v)を検出する。勾配強度検出部301は、入力された画像および検出した勾配強度m(u,v)を勾配方向検出部302に出力する。

ここで、uとvは、直交座標平面上における画素(ピクセル)の位置を表すための座標の縦軸方向の値と横軸方向の値である。

【0058】

勾配方向検出部302は、勾配強度検出部301から画像および勾配強度m(u,v)を入力し、入力した画像に基づいて各ピクセル(u,v)における勾配方向q(u,v)を検出する。勾配方向検出部302は、入力した勾配強度m(u,v)および検出した勾配方向q(u,v)を勾配方向ごとの勾配強度の積分部303に出力する。

【0059】

勾配方向ごとの勾配強度の積分部303は、勾配方向検出部302から入力された勾配強度m(u,v)および勾配方向q(u,v)に基づいて、勾配方向ごとに勾配強度の積分を行う。勾配方向ごとの勾配強度の積分部303は、この積分の結果により得られる情報を出力する。

勾配方向ごとの勾配強度の積分部303から出力された情報は、勾配積分画像算出部101による計算結果の情報として当該勾配積分画像算出部101から出力されて、座標スキャン部102に入力される。

【0060】

座標スキャン部102は、全画像領域またはその中の所望の比較的大きい領域内を、特定の座標領域(ウインドウ)をスライド(ウインドウサイズのスケールも可変して、順次スライドする)しながら、次の特徴量ベクトル算出部103で算出するウインドウを選択する。

【0061】

特徴量ベクトル算出部103において行われる動作の例を示す。

座標スキャン部102から特徴量ベクトル算出部103に入力された情報は、セル単位の積分値算出部311に入力される。

セル単位の積分値算出部311は、入力された情報に基づいて、勾配方向ごとの勾配強度について、セル単位の積分値を算出する。セル単位の積分値算出部311は、算出したセル単位の積分値をブロック正規化部312に出力する。

【0062】

ブロック正規化部312は、セル単位の積分値算出部311から入力されたセル単位の積分値について、ブロック単位で、正規化を行う。ブロック正規化部312は、この正規化の結果の情報を特徴量ベクトル算出処理部313に出力する。

特徴量ベクトル算出処理部313は、ブロック正規化部312から入力された情報に基づいて、特徴量ベクトル(本実施形態では、HOG特徴量のベクトル)を算出する。特徴量ベクトル算出処理部313は、算出した特徴量ベクトルの情報を出力する。

特徴量ベクトル算出処理部313から出力された情報は、特徴量ベクトル算出部103から出力されて、識別部104に入力される。

【0063】

ここで、本実施形態では、1つのセルは座標スキャンするウインドウの1/16のサイズから構成されており、1つのブロックは3セル(縦)×3セル(横)の領域から構成されている。

なお、セルの大きさや、ブロックの大きさとしては、それぞれ、他の種々な構成が用いられてもよい。

【0064】

ここで、積分画像について説明しておく。積分画像は、一般に知られた技術であり、ここでは、その概略を説明する。

図11は、積分画像を説明するための図である。

図11において、画像の左上を画素の座標の基準位置(0,0)として、座標(u、v)を考える。また、座標(u,v)における画像の画素値をi(u,v)とする。

s(u,v)を行の画素の総和(縦方向の総和)とし、ii(u,v)を列のs(u,v)の総和(横方向の総和)とする。このii(u,v)が積分画像となる。

このとき、次の式(1)、式(2)が表される。ここで、s(−1,v)=0とし、ii(u,−1)=0とする。

【0065】

s(u,v)=s(u−1,v)+i(u,v) ・・・(1)

【0066】

ii(u,v)=ii(u,v−1)+s(u、v) ・・・(2)

【0067】

このとき、一例として、図11に示される第4領域における画素値の和S(4)を求める場合には、式(3)により算出することができる。

【0068】

S(4)=ii(u,v)−ii(u,v−Q1)−ii(u−P1,v)+ii(u−P1,v−Q1) ・・・(3)

【0069】

本実施形態では、このような積分画像ii(u,v)を使用することで、演算を容易化することが可能である。

【0070】

次に、3D解析手法による物体認識部13により行われる3D解析手法による物体認識とパターン認識による物体認識部14により行われるパターン認識による物体認識との組み合わせについて説明する。

図3は、3D解析手法による物体認識とパターン認識による物体認識との組み合わせにより物体認識の性能を向上させることが望まれる領域の例を示す図である。

図3に示される画像1001では、道路上に車両が走行している。そして、3D解析手法による物体認識とパターン認識による物体認識との組み合わせにより物体認識の性能を向上させることが望まれる領域として、縦方向の辺よりも横方向の辺の方が長い矩形の枠1002の領域が示されている。

【0071】

この枠1002の領域は、3D解析手法による物体認識の単体ではターゲット(本実施形態では、車両)以外の物体を誤認識する可能性がある領域であり、且つ、パターン認識による物体認識の単体でもターゲット(本実施形態では、車両)以外の物体を誤認識する可能性がある領域である。

従って、このような互いの認識性能がある場合には、本実施形態のように、最終的なターゲットと認識するために、最終ターゲット認識部15によりAND論理での認識を行うことが効果的である。このように最終的なターゲットと認識する論理(本実施形態では、AND論理)は、3D解析手法による物体認識とパターン認識による物体認識との互いの判定性能に依存して定めたものである。

【0072】

なお、このような、3D解析手法による物体認識とパターン認識による物体認識との組み合わせにより物体認識の性能を向上させることが望まれる領域は、例えば、道路の状況などによって、変動する。

図3に示される例では、道路がほぼ直進方向にあるが、大きいカーブでの前走車を認識することが必要であることから、横長の枠1002の領域を設定している。

ここで、枠1002の領域は、例えば、画像1001における座標の値を用いて表すことができる。

【0073】

以上のように、本実施形態に係る画像認識装置1は、3D解析手法による物体認識の結果と、パターン認識による物体認識の結果とで、画像中においてAND論理が成立した座標領域の物体を最終的にターゲット(目標と定めた物体)であると判断する。

従って、本実施形態に係る画像認識装置1によれば、物体の認識を精度良く行うことができ、ターゲットとする物体の検出に好適な装置を提供することができる。例えば、本実施形態に係る画像認識装置1によれば、画像の消失点付近を含む比較的遠距離にある物体の形状を認識する精度が大幅に向上するため、前方衝突警報装置(FCW)に適用することができ、さらに、特に遠距離での認識が必要な車間距離制御装置(ACC)への適用が可能となる効果を有する。

【0074】

なお、一般的に、3D解析手法による物体認識では、遠距離にある物体の認識は不得手であると考えられるが、本実施形態では、パターン認識による物体認識を併用することで、遠距離にある物体の認識についても、精度を向上させている。

【0075】

[第2実施形態]

本実施形態に係る画像認識装置1aの概略的な構成は、図1に示される第1実施形態に係る画像認識装置1の構成と同様であるため、以下では、図1に示される構成および各構成部の符号を利用して説明する。

なお、以下では、第1実施形態に係る画像認識装置1とは異なる点について詳しく説明する。

【0076】

本実施形態に係る画像認識装置1aでは、主に、最終ターゲット認識部15の構成および動作が、第1実施形態の場合とは異なっている。

本実施形態では、最終ターゲット認識部15は、OR論理を用いて認識を行う。

具体的には、最終ターゲット認識部15は、3D解析手法による物体認識部13から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)と、パターン認識による物体認識部14から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)について、これら2つの物体認識の処理の結果において、認識対象の物体(本実施形態では、車両)であると特定した何れかまたは一致する画像領域(座標の領域)の部分を、最終的なターゲットの領域であると認識し、認識した最終的なターゲットの領域を特定する情報を距離・TTC確定部16に出力する。

【0077】

具体例として、最終ターゲット認識部15は、3D解析手法による物体認識部13から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)と、パターン認識による物体認識部14から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)について、OR論理の処理を行うことによって、最終的なターゲットの領域であると認識する。

【0078】

ここで、本実施形態では、全体の画像に認識対象の物体(本実施形態では、車両)が複数映っている場合には、3D解析手法による物体認識部13やパターン認識による物体認識部14はそれぞれの物体について物体認識の処理を行い、最終ターゲット認識部15はそれぞれの物体について最終ターゲットの認識の処理を行う。

【0079】

次に、3D解析手法による物体認識部13により行われる3D解析手法による物体認識とパターン認識による物体認識部14により行われるパターン認識による物体認識との組み合わせについて説明する。

第1実施形態において参照した図3には、3D解析手法による物体認識とパターン認識による物体認識との組み合わせにより物体認識の性能を向上させることが望まれる領域として、矩形の枠1002の領域が示されている。

【0080】

この枠1002の領域は、3D解析手法による物体認識の単体ではターゲット(本実施形態では、車両)を認識することができない可能性がある領域であり、且つ、パターン認識による物体認識でもターゲット(本実施形態では、車両)を認識することができない可能性がある領域である。

従って、このような互いの認識性能がある場合には、本実施形態のように、最終的なターゲットと認識するために、最終ターゲット認識部15によりOR論理での認識を行うことが効果的である。このように最終的なターゲットと認識する論理(本実施形態では、OR論理)は、3D解析手法による物体認識とパターン認識による物体認識との互いの判定性能に依存して定めたものである。

【0081】

以上のように、本実施形態に係る画像認識装置1aは、3D解析手法による物体認識の結果と、パターン認識による物体認識の結果とで、画像中においてOR論理が成立した座標領域の物体を最終的にターゲット(目標と定めた物体)であると判断する。

従って、本実施形態に係る画像認識装置1aによれば、物体の認識を精度良く行うことができ、ターゲットとする物体の検出に好適な装置を提供することができる。例えば、本実施形態に係る画像認識装置1aによれば、画像の消失点付近を含む比較的遠距離にある物体の形状を認識する精度が大幅に向上するため、前方衝突警報装置(FCW)に適用することができ、さらに、特に遠距離での認識が必要な車間距離制御装置(ACC)への適用が可能となる効果を有する。

【0082】

ここで、最終ターゲット認識部15により行われる動作として、第1実施形態ではAND論理の動作を示し、第2実施形態ではOR論理の動作を示したが、他の動作が用いられてもよい。

AND論理の一例として、最終ターゲット認識部15は、3D解析手法による物体認識部13から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)と、パターン認識による物体認識部14から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)について、これら2つの物体認識の処理の結果において、認識対象の物体(本実施形態では、車両)であると特定した画像領域(座標の領域)の重複部分(オーバーラップする部分)が所定の割合(例えば、50%など)以上である場合に、あらかじめ定められたいずれか一方の物体認識の処理の結果を最終的なターゲットの領域であると認識し、認識した最終的なターゲットの領域を特定する情報を距離・TTC確定部16に出力する、といった構成を用いることができる。

【0083】

[第3実施形態]

図4は、本発明の第3実施形態に係る画像認識装置2の構成を示すブロック図である。

本実施形態に係る画像認識装置2は、単眼カメラ11と、画像取得部12と、3D解析手法による物体認識部21と、パターン認識による物体認識部22と、最終ターゲット認識部15と、距離・TTC確定部16と、トラッキング部17と、衝突警報部18と、ACC制御部19と、を備える。

【0084】

ここで、本実施形態に係る画像認識装置2の構成や動作は、3D解析手法による物体認識部21とパターン認識による物体認識部22に関する構成や動作を除いて、図1に示される第1実施形態に係る画像認識装置1の構成(AND論理を用いる構成)、または、第2実施形態に係る画像認識装置1aの構成(OR論理を用いる構成)と同様である。

このため、図4では、第1実施形態または第2実施形態と同様な構成部については、同一の符号を付してある。以下では、第1実施形態に係る画像認識装置1または第2実施形態に係る画像認識装置1aとは異なる点について詳しく説明する。

【0085】

3D解析手法による物体認識部21は、特徴点・オプティカルフロー検出部111と、自車に対する相対距離検出部112と、クラスタリング部113と、を備える。

パターン認識による物体認識部22は、勾配積分画像算出部121と、座標スキャン部122と、特徴量ベクトル算出部123と、識別部124と、を備える。座標スキャン部122は、座標のスキャン領域決定部126を備える。

【0086】

3D解析手法による物体認識部21において行われる動作の例を示す。

画像取得部12から3D解析手法による物体認識部21に入力された画像は、特徴点・オプティカルフロー検出部111に入力される。

この入力画像は、特徴点・オプティカルフロー検出部111、自車に対する相対距離検出部112、クラスタリング部113により、順に処理されて、その処理の結果がクラスタリング部113から出力される。

クラスタリング部113から出力された処理の結果は、3D解析手法による物体認識の処理の結果として、3D解析手法による物体認識部21から出力されて、最終ターゲット認識部15に入力される。

【0087】

ここで、本実施形態では、3D解析手法による物体認識部21において、図9に示されるのと同様な3D解析手法の処理の手順による処理を行う。

本実施形態では、一例として、特徴点・オプティカルフロー検出部111がステップS1〜ステップS2の処理を実行し、自車に対する相対距離検出部112がステップS3〜ステップS6の処理を実行し、クラスタリング部113がステップS7の処理を実行する。

【0088】

さらに、本実施形態では、特徴点・オプティカルフロー検出部111は、検出した特徴点の情報と、検出(本実施形態では、計算)したオプティカルフローの情報を座標スキャン部122に出力する。

【0089】

パターン認識による物体認識部22において行われる動作の例を示す。

画像取得部12からパターン認識による物体認識部22に入力された画像は、勾配積分画像算出部121に入力される。

この入力画像は、勾配積分画像算出部121、座標スキャン部122、特徴量ベクトル算出部123、識別部124により、順に処理されて、その処理の結果が識別部124から出力される。

識別部124から出力された処理の結果は、パターン認識による物体認識の処理の結果として、パターン認識による物体認識部22から出力されて、最終ターゲット認識部15に入力される。

【0090】

ここで、本実施形態では、パターン認識による物体認識部22に備えられた勾配積分画像算出部121と、座標スキャン部122と、特徴量ベクトル算出部123と、識別部124によって、概略的には、それぞれ、図2に示される勾配積分画像算出部101と、座標スキャン部102と、特徴量ベクトル算出部103と、識別部104と同様な動作を行う。

【0091】

さらに、本実施形態では、特徴点・オプティカルフロー検出部111から出力された特徴点の情報と、オプティカルフローの情報が、座標スキャン部122に入力される。座標スキャン部122に入力された特徴点の情報とオプティカルフローの情報は、座標のスキャン領域決定部126に入力される。

【0092】

座標のスキャン領域決定部126は、入力された特徴点の情報とオプティカルフローの情報のうちの一方または両方に基づいて、座標スキャン部122において座標スキャンする領域を決定する。本実施形態では、このようにして決定される座標スキャン部122において座標スキャンする領域は、パターン認識を行う領域となる。

【0093】

本実施形態では、座標スキャン部122は、勾配積分画像算出部121から入力された情報に基づいて、全画像の中で、座標のスキャン領域決定部126により決定された座標スキャンする領域(座標領域)に対して、勾配方向の勾配強度を算出する。座標スキャン部122は、この算出結果の情報を特徴量ベクトル算出部123に出力する。

【0094】

ここで、座標のスキャン領域決定部126は、例えば、入力された特徴点の情報とオプティカルフローの情報のうちの一方または両方に基づいて、座標スキャン部122において座標スキャンする領域として、全画像中において、認識対象の物体(本実施形態では、車両)が映っている可能性が高いと推定される領域を決定する。

【0095】

特徴点の情報を優先してパターン認識の座標スキャンの領域を決定する手法の一例として、特徴点が密集する領域を検出し、その密集する領域のサイズを包含する広めの領域を、座標スキャン部122において座標スキャンする領域として決定することができる。

【0096】

特徴点の情報を優先してパターン認識の座標スキャンの領域を決定する手法の他の一例として、座標のスキャン領域決定部126は、特徴点が多い方が認識対象の物体が映っている可能性が高いという推定に基づいて、全画像をあらかじめ設定された複数に分割した領域(分割領域)を想定し、各分割領域内に存在する特徴点の数を算出し、算出した特徴点の数があらかじめ設定された値(閾値)より多い分割領域のみを、座標スキャン部122において座標スキャンする領域として決定することができる。

【0097】

なお、この閾値としては、一例として、2以上の値を設定する。

他の一例として、この閾値として、1を設定することもできる。この場合、座標のスキャン領域決定部126は、全画像をあらかじめ設定された複数に分割した領域(分割領域)を想定し、1つでも特徴点が抽出された分割領域のみを、座標スキャン部122において座標スキャンする領域として決定することができる。

【0098】

オプティカルフローの情報を優先してパターン認識の座標スキャンの領域を決定する手法の一例として、座標のスキャン領域決定部126は、オプティカルフローにより定められる変化量(例えば、勾配の強度)の平均値が大きい方が認識対象の物体が映っている可能性が高いという推定に基づいて、全画像をあらかじめ設定された複数に分割した領域(分割領域)を想定し、各分割領域内に存在する1つ以上のオプティカルフローにより定められる変化量の平均値を算出し、算出した平均値があらかじめ設定された値(閾値)より大きい分割領域のみを、座標スキャン部122において座標スキャンする領域として決定することができる。

【0099】

また、オプティカルフローの情報を優先してパターン認識の座標スキャンの領域を決定する手法の他の一例として、座標のスキャン領域決定部126は、全画像をあらかじめ設定された複数に分割した領域(分割領域)を想定し、あらかじめ設定された値(閾値)より大きいオプティカルフローが1つでも抽出された分割領域のみを、座標スキャン部122において座標スキャンする領域として決定することができる。

【0100】

また、特徴点の情報やオプティカルフローの情報を優先してパターン認識の座標スキャンの領域を決定する手法の一例として、座標のスキャン領域決定部126は、特徴点に関する条件(例えば、上記したもの等、1つ以上の条件)を満たし、且つ、オプティカルフローに関する条件(例えば、上記したもの等、1つ以上の条件)を満たす分割領域のみを、座標スキャン部122において座標スキャンする領域として決定することができる。

【0101】

また、特徴点の情報やオプティカルフローの情報を優先してパターン認識の座標スキャンの領域を決定する手法の他の一例として、座標のスキャン領域決定部126は、特徴点に関する条件(例えば、上記したもの等、1つ以上の条件)またはオプティカルフローに関する条件(例えば、上記したもの等、1つ以上の条件)のうちの少なくとも1つの条件を満たす分割領域(これらの全ての条件を満たす分割領域も含む)のみを、座標スキャン部122において座標スキャンする領域として決定することができる。

【0102】

また、以上のようにして特徴点の情報とオプティカルフローの情報のうちの一方または両方を優先してパターン認識の座標スキャンの領域を決定する手法では、例えば、座標のスキャン領域決定部126は、以上のようにして特徴点の情報とオプティカルフローの情報のうちの一方または両方に基づいて決定した領域のみを座標スキャン部122において座標スキャンする領域とする構成以外に、以上のようにして特徴点の情報とオプティカルフローの情報のうちの一方または両方に基づいて決定した領域とともに、他の任意の手法により決定した領域についても、座標スキャン部122において座標スキャンする領域とする、こともできる。

【0103】

次に、座標のスキャン領域決定部126について、他の例を示す。

他の例に係る座標のスキャン領域決定部126は、入力された特徴点の情報とオプティカルフローの情報のうちの一方または両方に基づいて、座標スキャン部122において座標スキャンする領域の重要度を決定する。本実施形態では、このようにして決定される座標スキャン部122において座標スキャンする領域の重要度は、パターン認識を行う領域の重要度として使用される。

【0104】

本実施形態では、座標スキャン部122は、勾配積分画像算出部121から入力された情報に基づいて、例えば全画像の中であらかじめ設定した任意の座標領域に対して、他の例に係る座標のスキャン領域決定部126により決定された座標スキャンする領域(座標領域)の重要度を考慮して、勾配方向の勾配強度を算出する。座標スキャン部122は、この算出結果の情報を特徴量ベクトル算出部123に出力する。

【0105】

ここで、他の例に係る座標のスキャン領域決定部126は、例えば、入力された特徴点の情報とオプティカルフローの情報のうちの一方または両方に基づいて、座標スキャン部122において座標スキャンする領域の重要度として、全画像中において認識対象の物体が映っている可能性が高いと推定される領域の重要度を高い重要度とするように決定する。

【0106】

特徴点の情報とオプティカルフローの情報のうちの一方または両方を重要視してパターン認識の座標スキャンの領域の重要度を決定する手法の一例として、他の例に係る座標のスキャン領域決定部126は、上記のように特徴点の情報とオプティカルフローの情報のうちの一方または両方を優先してパターン認識の座標スキャンの領域を決定する手法により決定された分割領域については、特徴量に関する情報(例えば、勾配強度など)を算出するときの重み付け(重要度)を大きくすることができる。具体例として、他の例に係る座標のスキャン領域決定部126は、上記のように特徴点の情報とオプティカルフローの情報のうちの一方または両方を優先してパターン認識の座標スキャンの領域を決定する手法により決定された分割領域については、他の分割領域と比べて、得られた特徴量に関する値(例えば、勾配強度など)にあらかじめ設定された値(例えば、1より大きい値)を乗算することができ、つまり、このような分割領域においては、他の分割領域と比べて、小さい特徴量に関する値であっても、より特徴量が大きいとみなす。

【0107】

特徴点の情報とオプティカルフローの情報のうちの一方または両方を重要視してパターン認識の座標スキャンの領域の重要度を決定する手法の他の一例として、他の例に係る座標のスキャン領域決定部126は、上記のように特徴点の情報とオプティカルフローの情報のうちの一方または両方を優先してパターン認識の座標スキャンの領域を決定する手法により決定された分割領域については、他の分割領域と比べて、特徴量に関する情報(例えば、勾配強度など)を算出するときの分解能を細かくすることができる。具体例として、他の例に係る座標のスキャン領域決定部126は、上記のように特徴点の情報とオプティカルフローの情報のうちの一方または両方を優先してパターン認識の座標スキャンの領域を決定する手法により決定された分割領域については、あらかじめ設定された比較的細かい分解能でスライド(移動)させてスキャンし、他の分割領域については、あらかじめ設定された比較的粗い分解能でスライド(移動)させてスキャンすることができる。

【0108】

以上のように、本実施形態に係る画像認識装置2では、3D解析手法による物体認識部21の特徴点・オプティカルフロー検出部111により得られた情報が、パターン認識による物体認識部22の座標のスキャン領域決定部126(上記した他の例に係る座標のスキャン領域決定部126でもよい)に伝えられて利用される構成となっている。

従って、本実施形態に係る画像認識装置2によれば、物体の認識を精度良く行うことができ、ターゲットとする物体の検出に好適な装置を提供することができる。例えば、本実施形態に係る画像認識装置2によれば、3D解析手法による物体認識において得られた特徴点の情報または動きベクトル(本実施形態では、オプティカルフロー)の情報に基づく座標領域を優先してまたは重要視して、パターン認識を行う画像において座標をスキャンする領域に関する設定を行うことができる。これにより、例えば、パターン認識の座標スキャン時の処理負荷を軽減することが可能である。

【0109】

[第4実施形態]

図5は、本発明の第4実施形態に係る画像認識装置3の構成を示すブロック図である。

本実施形態に係る画像認識装置3は、単眼カメラ11と、画像取得部12と、3D解析手法による物体認識部31と、パターン認識による物体認識部32と、最終ターゲット認識部15と、距離・TTC確定部16と、トラッキング部17と、衝突警報部18と、ACC制御部19と、を備える。

【0110】

ここで、本実施形態に係る画像認識装置3の構成や動作は、3D解析手法による物体認識部31とパターン認識による物体認識部32に関する構成や動作を除いて、図1に示される第1実施形態に係る画像認識装置1の構成(AND論理を用いる構成)、または、第2実施形態に係る画像認識装置1aの構成(OR論理を用いる構成)と同様である。

このため、図5では、第1実施形態または第2実施形態と同様な構成部については、同一の符号を付してある。以下では、第1実施形態に係る画像認識装置1または第2実施形態に係る画像認識装置1aとは異なる点について詳しく説明する。

【0111】

3D解析手法による物体認識部31は、特徴点・オプティカルフロー検出部131と、自車に対する相対距離検出部132と、クラスタリング部133と、を備える。

パターン認識による物体認識部32は、座標のスキャン領域決定部141と、勾配積分画像算出部142と、特徴量ベクトル算出部143と、識別部144と、を備える。

【0112】

3D解析手法による物体認識部31において行われる動作の例を示す。

画像取得部12から3D解析手法による物体認識部31に入力された画像は、特徴点・オプティカルフロー検出部131に入力される。

この入力画像は、特徴点・オプティカルフロー検出部131、自車に対する相対距離検出部132、クラスタリング部133により、順に処理されて、その処理の結果がクラスタリング部133から出力される。

クラスタリング部133から出力された処理の結果は、3D解析手法による物体認識の処理の結果として、3D解析手法による物体認識部31から出力されて、最終ターゲット認識部15に入力される。

【0113】

ここで、本実施形態では、3D解析手法による物体認識部31において、図9に示されるのと同様な3D解析手法の処理の手順による処理を行う。

本実施形態では、一例として、特徴点・オプティカルフロー検出部131がステップS1〜ステップS2の処理を実行し、自車に対する相対距離検出部132がステップS3〜ステップS6の処理を実行し、クラスタリング部133がステップS7の処理を実行する。

【0114】

さらに、本実施形態では、クラスタリング部133は、検出された移動物体(本実施形態では、車両であると推定される移動物体)をターゲットとして認識した結果に基づいて、物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)を座標のスキャン領域決定部141に出力する。

【0115】

パターン認識による物体認識部32において行われる動作の例を示す。

画像取得部12からパターン認識による物体認識部32に入力された画像は、座標のスキャン領域決定部141に入力される。

この入力画像は、座標のスキャン領域決定部141、勾配積分画像算出部142、特徴量ベクトル算出部143、識別部144により、順に処理されて、その処理の結果が識別部144から出力される。

識別部144から出力された処理の結果は、パターン認識による物体認識の処理の結果として、パターン認識による物体認識部32から出力されて、最終ターゲット認識部15に入力される。

【0116】

ここで、本実施形態では、クラスタリング部133から出力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)が、座標のスキャン領域決定部141に入力される。

【0117】

座標のスキャン領域決定部141は、入力された画像について、クラスタリング部133から入力された物体認識の処理の結果に基づいて、座標スキャンする領域を決定する。一例として、座標スキャンする領域は、クラスタリング部133から入力された物体の領域よりも広めの領域とする。座標のスキャン領域決定部141は、決定した座標スキャンする領域を特定する情報および入力された画像を勾配積分画像算出部142に出力する。本実施形態では、このようにして決定される座標スキャンする領域は、パターン認識を行う領域となる。

【0118】

勾配積分画像算出部142は、座標のスキャン領域決定部141から入力された画像について、座標のスキャン領域決定部141から入力された情報により特定される座標スキャンする領域(座標領域)の画像に対して、勾配強度と勾配方向を算出し、それぞれの勾配方向の勾配強度に対して積分画像を算出し、ヒストグラムを計算する。勾配積分画像算出部142は、この計算結果の情報を特徴量ベクトル算出部143に出力する。

【0119】

特徴量ベクトル算出部143は、勾配積分画像算出部142から入力された情報に基づいて、HOG特徴量としての特徴ベクトル化を行う。特徴量ベクトル算出部143は、この結果の情報を識別部144に出力する。

識別部144は、特徴量ベクトル算出部143から入力された情報に基づいて、AdaBoostによる識別の処理を行い、あらかじめターゲットとしている物体(本実施形態では、あらかじめ用意された車両の画像のパターンに合致する物体)を認識する。識別部144は、この物体認識の処理の結果を出力する。

【0120】

なお、本実施形態では、パターン認識による物体認識部32において、座標のスキャン領域決定部141により座標のスキャン領域を決定した後に、勾配積分画像算出部142により勾配積分画像を算出する構成としてあり、この構成によって、例えば、第3実施形態に係る図4に示されるように、パターン認識による物体認識部22において、勾配積分画像算出部121による処理を行った後に、座標のスキャン領域決定部126による処理を行う構成と、全体としては同様な処理を実現している。

【0121】

ここで、座標のスキャン領域決定部141は、例えば、クラスタリング部133から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)に基づいて、座標スキャンする領域として、全画像中において、認識対象の物体(本実施形態では、車両)が映っていると推定される領域を決定する。

【0122】

3D解析手法による物体認識の処理の結果を優先してパターン認識の座標スキャンの領域を決定する手法の一例として、座標のスキャン領域決定部141は、3D解析手法による物体認識の処理の結果に基づいて、3D解析手法による物体認識によって認識対象の物体が映っていると判定された領域(判定領域)のみを、座標スキャンする領域として決定することができる。

【0123】

また、3D解析手法による物体認識の処理の結果を優先してパターン認識の座標スキャンの領域を決定する手法の他の一例として、座標のスキャン領域決定部141は、全画像をあらかじめ設定された複数に分割した領域(分割領域)を想定し、3D解析手法による物体認識の処理の結果に基づいて、3D解析手法による物体認識によって認識対象の物体が映っていると判定された領域を含む分割領域のみを、座標スキャンする領域として決定することができる。

【0124】

また、以上のようにして3D解析手法による物体認識の処理の結果を優先してパターン認識の座標スキャンの領域を決定する手法では、例えば、座標のスキャン領域決定部141は、以上のようにして3D解析手法による物体認識の処理の結果に基づいて決定した領域のみを座標スキャンする領域とする構成以外に、以上のようにして3D解析手法による物体認識の処理の結果に基づいて決定した領域とともに、他の任意の手法により決定した領域についても、座標スキャンする領域とする、こともできる。

【0125】

次に、座標のスキャン領域決定部141について、他の例を示す。

他の例に係る座標のスキャン領域決定部141は、クラスタリング部133から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)に基づいて、座標スキャンする領域の重要度を決定する。そして、他の例に係る座標のスキャン領域決定部141は、決定した座標スキャンする領域の重要度の情報を勾配積分画像算出部142に出力する。本実施形態では、このようにして決定される座標スキャンする領域の重要度は、パターン認識を行う領域の重要度として使用される。

【0126】

本実施形態では、勾配積分画像算出部142は、他の例に係る座標のスキャン領域決定部141から入力された情報に基づいて、例えば全画像の中であらかじめ設定した任意の座標領域に対して、他の例に係る座標のスキャン領域決定部141により決定された座標スキャンする領域(座標領域)の重要度を考慮して、勾配方向の勾配強度を算出する。勾配積分画像算出部142は、この算出結果の情報を特徴量ベクトル算出部143に出力する。

【0127】

ここで、他の例に係る座標のスキャン領域決定部141は、例えば、クラスタリング部133から入力された物体認識の処理の結果(本実施形態では、車両が映っていると推定される画像領域を特定する情報)に基づいて、座標スキャンする領域の重要度として、全画像中において、認識対象の物体(本実施形態では、車両)が映っていると推定される領域の重要度を高い重要度とするように決定する。

【0128】

3D解析手法による物体認識の処理の結果を重要視してパターン認識の座標スキャンの領域の重要度を決定する手法の一例として、他の例に係る座標のスキャン領域決定部141は、上記のように3D解析手法による物体認識の処理の結果を優先してパターン認識の座標スキャンの領域を決定する手法により決定された領域(判定領域または分割領域)については、特徴量に関する情報(例えば、勾配強度など)を算出するときの重み付け(重要度)を大きくすることができる。この場合、具体例として、勾配積分画像算出部142は、上記のように3D解析手法による物体認識の処理の結果を優先してパターン認識の座標スキャンの領域を決定する手法により決定された領域(判定領域または分割領域)については、他の領域と比べて、得られた特徴量に関する値(例えば、勾配強度など)にあらかじめ設定された値(例えば、1より大きい値)を乗算することができ、つまり、このような領域(判定領域または分割領域)においては、他の領域と比べて、小さい特徴量に関する値であっても、より特徴量が大きいとみなす。

【0129】

3D解析手法による物体認識の処理の結果を重要視してパターン認識の座標スキャンの領域の重要度を決定する手法の他の一例として、他の例に係る座標のスキャン領域決定部141は、上記のように3D解析手法による物体認識の処理の結果を優先してパターン認識の座標スキャンの領域を決定する手法により決定された領域(判定領域または分割領域)については、他の領域と比べて、特徴量に関する情報(例えば、勾配強度など)を算出するときの分解能を細かくすることができる。この場合、具体例として、勾配積分画像算出部142は、上記のように3D解析手法による物体認識の処理の結果を優先してパターン認識の座標スキャンの領域を決定する手法により決定された領域(判定領域または分割領域)については、あらかじめ設定された比較的細かい分解能でスライド(移動)させてスキャンし、他の領域については、あらかじめ設定された比較的粗い分解能でスライド(移動)させてスキャンすることができる。

【0130】