監視範囲検知装置

【課題】携帯端末の位置や姿勢などに応じて画定される方向・範囲内に、監視装置の監視範囲が存在するか否かを検知可能とする。

【解決手段】撮像部と、撮像部の位置と光軸を取得する状態取得部と、監視場所を3次元仮想空間として表現した場所モデルと、監視装置の設置位置、監視方向及び監視角情報を場所モデルと対応付けた監視条件情報と、撮像部の位置、光軸及び画角を場所モデルと対応付けた撮像条件情報とを記憶した記憶部と、場所モデルと監視条件情報とから監視装置の監視範囲を表す監視範囲モデルを生成し、場所モデルと撮像条件情報とから撮像部の撮像範囲を表す撮像範囲モデルを生成するモデル生成手段と、監視範囲モデルと撮像範囲モデルとが交わっているときに撮像部の視野内に監視装置の監視範囲が含まれていると判定する判定手段と、判定手段による判定結果を表示する表示部と、を有することを特徴とする監視範囲検知装置。

【解決手段】撮像部と、撮像部の位置と光軸を取得する状態取得部と、監視場所を3次元仮想空間として表現した場所モデルと、監視装置の設置位置、監視方向及び監視角情報を場所モデルと対応付けた監視条件情報と、撮像部の位置、光軸及び画角を場所モデルと対応付けた撮像条件情報とを記憶した記憶部と、場所モデルと監視条件情報とから監視装置の監視範囲を表す監視範囲モデルを生成し、場所モデルと撮像条件情報とから撮像部の撮像範囲を表す撮像範囲モデルを生成するモデル生成手段と、監視範囲モデルと撮像範囲モデルとが交わっているときに撮像部の視野内に監視装置の監視範囲が含まれていると判定する判定手段と、判定手段による判定結果を表示する表示部と、を有することを特徴とする監視範囲検知装置。

【発明の詳細な説明】

【技術分野】

【0001】

本発明は、監視場所に設置された監視カメラや赤外線センサなどの監視装置の監視範囲(すなわち、監視カメラの撮像範囲や赤外線センサ等の検知範囲)を検知して利用者に通知する監視範囲検知装置に関する。

【背景技術】

【0002】

近年、セキュリティを目的として、監視カメラを取り付ける個人、法人、公共機関などが増加しつつある。例えば、住宅街に居住する住民が、自宅の外壁にカメラ用回転台付の監視カメラを設置し、自宅のパソコンを用いてパン、チルト、ズーム等の操作を行いながら屋外を画像監視する事例も出てきている。

【0003】

しかし、このような監視カメラを用いて、利用者が意図的に、隣人の住宅内部を閲覧したり、路上にいる隣人を望遠で閲覧する等のプライバシを侵害するような使用をする可能性は否定できない。そのため、このようなパブリックスペースを監視している監視カメラの監視範囲の適切性を、通行人等の一般人によって確認したいといったニーズが高まりつつある。

【0004】

従来、監視カメラによって撮像された監視画像を人が目視により直接的に確認することによって、当該監視カメラが他人のプライバシを侵害していないことを確認していた。また、監視カメラの監視範囲を確認するために、当該監視カメラの設置位置や姿勢、画角情報等から算出した撮像範囲を表す画像を、地図画像上に重畳表示する技術も提案されている(特許文献1)。

【先行技術文献】

【特許文献】

【0005】

【特許文献1】特開2000−358240

【発明の概要】

【発明が解決しようとする課題】

【0006】

しかしながら、上記の従来技術では、利用者が、例えば自らの前方に監視カメラの監視範囲が存在するか否かを把握するにあたって、常に自らの現在位置と地図上に重畳表示された撮像範囲を表す画像との位置関係を確認しなければならず、実用上の手間を要していた。

【0007】

そこで本発明は、利用者によって所持される端末の位置や姿勢などに応じて画定される方向・範囲内に、監視カメラ等の監視装置の監視範囲が存在するか否かを検知可能とすることを目的とする。これにより、利用者は、従来技術のように地図による位置関係を常に確認することなく、例えば自らの前方の所定範囲内に監視カメラの監視範囲が存在するか否かを容易に把握できることを目的とする。

【課題を解決するための手段】

【0008】

かかる課題を解決するために、監視装置の監視範囲を検知する監視範囲検知装置であって、撮像画像を取得する撮像部と、撮像部の現在の位置及び光軸を取得する状態取得部と、監視装置が監視する場所を3次元の仮想空間として表現した場所モデルと、監視装置の設置位置、監視方向及び監視角情報を場所モデルと対応付けた監視条件情報と、撮像部の画角と状態取得部で取得した該撮像部の現在の位置及び光軸とを場所モデルと対応付けた撮像条件情報とを記憶した記憶部と、場所モデルと監視条件情報とに基づいて監視装置の監視範囲を表す監視範囲モデルを生成し、場所モデルと撮像条件情報とに基づいて撮像部の撮像範囲を表す撮像範囲モデルを生成するモデル生成手段と、監視範囲モデルと撮像範囲モデルとが交わっているときに撮像部の視野内に監視装置の監視範囲が含まれていると判定する判定手段と、判定手段による判定結果を表示する表示部と、を有することを特徴とする監視範囲検知装置を提供する。

【0009】

かかる構成により、本発明のモデル生成手段は、場所モデルと監視条件情報とに基づいて監視装置の監視範囲を表す3次元形状の監視範囲モデルを生成し、場所モデルと撮像条件情報とに基づいて撮像部の撮像範囲を表す3次元形状の撮像範囲モデルを生成する処理を行う。そして、本発明の判定手段は、監視範囲モデルと撮像範囲モデルとが場所モデル上において交わっているか否かを判定する処理を行う。ここで、判定手段は、監視範囲モデルと撮像範囲モデルとが交わっているときに撮像部の視野内に監視装置の監視範囲が含まれていると判定する。そして、本発明の表示部は、判定手段にて撮像部の視野内に監視装置の監視範囲が含まれていると判定したときに、判定結果として、例えばその旨を示すメッセージを表示する。

上記処理により、利用者は、撮像部の視野内に監視装置の監視範囲が含まれていることを検知することができるため、例えば自らの前方に監視装置の監視範囲が存在するか否かについて確認したい場合、撮像部の光軸が自らの前方に向くよう視野方向を制御することによって検知することが可能となる。

【0010】

また、本発明の好ましい態様として、場所モデルは、監視場所に存在する物体を含めて3次元の仮想空間を表現したものとする。

例えば、場所モデルは、監視場所にある建物の壁面や柱等の建築構造物や地面などといった物体の3次元形状情報を含めて3次元の仮想空間を表現したものとして記憶部に記憶されているものとする。かかる構成により、本発明のモデル生成手段は、場所モデルの物体との干渉を考慮して監視条件情報に基づいて監視範囲モデルを生成し、当該監視範囲モデルを場所モデル内に配置する処理を行う。また、本発明のモデル生成手段は、場所モデルの物体との干渉を考慮して撮像条件情報に基づいて撮像範囲モデルを生成し、当該撮像範囲モデルを場所モデル内に配置する処理を行う。そして、本発明の判定手段は、監視範囲モデルと撮像範囲モデルとが場所モデル上において交わっているか否かによって、撮像部の視野内に前記監視装置の監視範囲が含まれているか否かを判定する処理を行う。

上記処理により、例えば、監視装置の監視範囲が壁等の物体によって遮られていたり、監視装置の監視範囲が撮像部から見て壁等の物体の陰となって隠蔽されていたりする場合、当該遮られている(又は隠蔽されている)部分の監視範囲を考慮して、撮像部の視野内に監視範囲が含まれているか否かを判定することができる。したがって、利用者は、より正確に監視装置の監視範囲を検知することができる。

【0011】

また、本発明の好ましい態様として、更に、判定手段にて撮像部の視野内に監視装置の監視範囲が含まれていると判定したとき、監視範囲モデルと撮像条件情報とを用いて撮像部の視野に相当するレンダリング画像を生成するレンダリング手段と、撮像部で取得した撮像画像とレンダリング画像とを合成した合成画像を出力する合成処理手段と、を備え、表示部は、合成画像を表示するものとする。

かかる構成により、本発明の判定手段にて撮像部の視野内に監視装置の監視範囲が含まれていると判定されたとき、本発明のレンダリング手段は、監視範囲モデルが配置された場所モデルと撮像条件情報とを用いて、撮像部からの視野に相当するレンダリング画像を生成する処理を行う。例えば、レンダリング手段は、監視範囲モデルが配置された場所モデル内に、撮像条件情報に基づいて設定された仮想的なカメラ(以下、「仮想カメラ」という)を配置し、当該仮想カメラから、3次元コンピュータグラフィックスのレンダリング処理を行うことにより、撮像部の視野に相当するレンダリング画像を生成する。そして、本発明の合成処理手段は、撮像部からの撮像画像とレンダリング画像とを合成した合成画像を出力する処理を行う。例えば、レンダリング画像から、監視装置の監視範囲を表す画像領域(以下、「監視範囲画像」という)を抽出し、当該監視範囲画像を撮像画像上にオーバーレイすることにより合成画像を出力する。そして、本発明の表示部により、当該合成画像を表示する。

上記処理により、利用者は、合成画像における監視範囲画像を閲覧することによって、撮像部の視野内に監視装置の監視範囲が含まれていることを検知できるだけでなく、当該監視範囲の形状を立体的に捉えることができるため、監視範囲の適切性なども確認することができる。さらに、上記処理により、撮像部の視野内に監視装置の監視範囲が含まれていると判定したときのみ監視範囲画像を再現するレンダリング処理を行うため、不要なレンダリング処理を行う必要がなく、レンダリング処理に要する処理負荷を軽減することができる。

【0012】

また、本発明の好ましい態様として、表示部は、撮像部の光軸に対して垂直となる位置に固定的に配置されるものとする。

これにより、利用者は、撮像部と共に表示部を移動可能であり、更に、表示部を閲覧する利用者の視線と撮像部の光軸とを略一致させることができるため、監視装置の監視範囲を利用者目線により確認することができる。

【発明の効果】

【0013】

上記のように、本発明の監視範囲検知装置は、監視装置の監視範囲と撮像部の撮像範囲とをぞれぞれモデル化して、これらの交わりを判定することによって、利用者が、撮像部の視野内に監視範囲の監視範囲が含まれているか否かを検知することができるため、例えば利用者の前方に監視装置の監視範囲が存在するか否かについて確認することができる。

【図面の簡単な説明】

【0014】

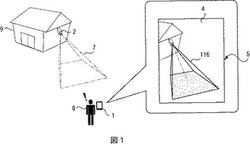

【図1】監視範囲検知装置の利用形態の模式図

【図2】監視範囲検知装置の構成を示すブロック図

【図3】電子コンパス、傾斜センサで得られる角度の説明図

【図4】監視範囲モデルを説明する図

【図5】監視範囲モデルを説明する図

【図6】判定手段の処理を説明する図

【図7】制御部における処理を示すフローチャート

【図8】場所モデルを表す図

【図9】モデリング処理後の場所モデルを表す図

【図10】レンダリング処理後のレンダリング画像を表す図

【図11】撮像画像を表す図

【図12】合成画像を表す図

【発明を実施するための形態】

【0015】

以下、本発明の一実施形態として、ある建物の壁面に設置され屋外の監視場所を監視している監視カメラの監視範囲(撮像範囲)を、利用者が自ら所持している監視範囲検知装置によって確認する場合の実施例について、図面を参照して説明する。すなわち、本実施例は、監視カメラが、本発明における監視装置として機能した場合の実施例である。

【0016】

図1は、本実施の形態の監視範囲検知装置1の利用形態を説明する模式図である。監視カメラ2は、建物9の壁面上部等に監視場所を俯瞰して撮像するよう設置され、監視場所を所定時間おきに撮影し、取得した監視画像を図示しない記録装置に順次記録する。ここで、当該監視カメラ2の監視範囲は、一点鎖線で図示された領域7であるとする。

図1に示すように、本実施例では、監視範囲検知装置1は、利用者8によって所持されるコンピュータ端末である。しかし、これに限らず、監視範囲検知装置1は、コンピュータ機能を有するヘットマウントディスプレイ等から構成されるウェアラブルコンピュータであってもよい。後述するように監視範囲検知装置1は、撮像部と表示部とを備え、撮像部によって取得した撮像画像4を表示部に表示する。また、監視範囲検知装置1は、撮像部の視野内に監視カメラ2の監視範囲7が含まれていると判定した場合、当該監視範囲7を表す監視範囲画像116を撮像画像4上に重畳した合成画像5を表示する。なお、本実施例では、図1に示すように一つの監視カメラ2のみ設置されている例を用いて説明するが、複数の監視カメラ2が設置されていても良い。

【0017】

図2は、監視範囲検知装置1の構成を示している。監視範囲検知装置1は、コンピュータ機能を有しており、記憶部11、制御部12、撮像部13、状態取得部14、表示部15、入力部16を備えている。

【0018】

撮像部13は、CCD素子やC−MOS素子等の撮像素子、光学系部品等を含んで構成される所謂カメラである。本実施例では、撮像部13は、所定時間おきに撮像して撮像画像4を記憶部11に一時的に記憶するものとする。撮像画像4を取得する時間間隔は、例えば1/5秒である。

【0019】

入力部16は、キーボード、タッチパネル、可搬記憶媒体の読み取り装置等の情報入力デバイスである。利用者8は、入力部16を用いて、それぞれの監視カメラ2の設置位置等の様々な撮像条件に関する情報を設定したりすることができる。

【0020】

状態取得部14は、GPS(Global Positioning System)、距離センサ、電子コンパス、傾斜センサなどの各種センサを含んで構成され、撮像部13の現在の位置や光軸(姿勢)に関する情報を所定時間おきに取得して記憶部11に記憶する。

【0021】

本実施例では、撮像部13の現在の位置に係る水平面上における位置情報として、GPSにより自立的に測位した結果(緯度・経度)を取得する。また、撮像部13の現在の位置における高さ情報については、超音波センサや赤外線センサ等を用いた距離センサにより地面からの距離を測定した結果を取得する。なお、高さ情報については、距離センサを用いずに、簡易的に人が所持する高さを考慮して設定された固定値(例えば1.2m〜1.7のいずれかの値)を用いてもよい。この場合、利用者8によって入力部16を用いて設定入力される。

【0022】

また、本実施例では、撮像部13の現在の光軸に係る情報として、電子コンパスにより自立的に測定した結果を、所定方向を基準とする角度として取得し、そして、傾斜センサから撮像部13の水平面に対する傾斜の度合いを示す傾斜情報を角度として検出する。具体的には、状態取得部14の電子コンパスは、図3(a)に示されるように、例えば北方向を基準として右回りに、北方向0°、東方向を90°、南方向を180°、西方向を270°として、撮像部13の光軸の方位角を角度θとして検出する。また、状態取得部14の傾斜センサは、図3(b)に示されるように、水平面に対する撮像部13の光軸の傾斜角を上方向への傾斜を角度θ’として、下方向への傾斜を角度−θ’として検出する。

【0023】

記憶部11は、ROM、RAM、HDD等の情報記憶装置である。記憶部11は、各種プログラムや各種データを記憶し、制御部12との間でこれらの情報を入出力する。各種データには、場所モデル111、監視条件情報112、撮像条件情報113、監視範囲モデル114、撮像範囲モデル115が含まれる。

【0024】

場所モデル111は、監視場所に存在する現実世界の壁・地面・柱等の物体をモデル化することにより作成された3次元形状データを含む3次元の仮想空間を表した座標情報である。場所モデル111における3次元形状データは、監視場所の形状情報に基づいて3次元CADで作成されたものでも良いし、3次元レーザースキャナー等により監視場所の3次元形状を取り込んだデータを利用しても良い。このようにして作成された場所モデル111は、利用者等により入力部16から設定登録されることにより記憶部11に記憶される。

【0025】

監視条件情報112は、現在時刻における監視カメラ2の設置位置や光軸(監視方向)に関する設置条件情報と、焦点距離、画素数、画素サイズ、レンズ歪みに関する画角条件情報(監視角情報)とからなり、設置されている監視カメラ2毎に個別設定される。また、監視条件情報112は、場所モデル111の仮想空間における座標情報に対応付けられた値で設定されている。

ここで、監視カメラ2の設置位置に関する設置条件情報とは、監視場所内(実空間)を3次元直交座標系として表し、実空間の直交座標系で座標が既知である基準点の座標値に基準点からの相対距離、方向を測定して補正する等の公知の技術を使用して算出した座標データとして表した情報である。また、監視カメラ2の光軸に関する設置条件情報とは、上記座標軸に対する監視カメラ2の光軸の回転角度に関する情報であり、監視カメラ2のいわゆるパン角度、チルト角度から求めることができる。監視条件情報112は、初期設定時に利用者8等によって入力部16から設定登録されることにより記憶部11に記憶される。

【0026】

撮像条件情報113は、状態取得部14により取得した現在時刻における撮像部13の位置や光軸に関する端末条件情報と、個別に設定された焦点距離、画素数、画素サイズ、レンズ歪みに関する画角条件情報とからなる。

ここで、撮像部13の位置に関する端末条件情報は、状態取得部14のGPSによって取得した結果を、制御部12によって場所モデル111の仮想空間における座標情報に対応付けて変換された値として設定される。また、撮像部13の光軸に関する端末条件情報は、状態取得部14の電子コンパス及び傾斜センサによって取得した結果を、制御部12によって上記座標軸に対する撮像部13の光軸の回転角度に対応付けて変換した値として設定される。このように、撮像条件情報113の端末条件情報は、各種センサによって現在の位置や光軸に関する情報を取得する度に更新される。なお、撮像条件情報113の画角条件情報は、初期設定時に利用者8等によって入力部16から設定登録されることにより記憶部11に記憶される。

【0027】

監視範囲モデル114は、監視カメラ2の監視範囲7を模してモデル化した3次元形状データである。また、撮像範囲モデル115は、撮像部13の監視範囲を模してモデル化した3次元形状データである。監視範囲モデル114及び撮像範囲モデル115は、後述するように制御部12のモデル生成手段121によって生成され、記憶部11に記憶される。

【0028】

制御部12は、例えばCPUやDSP等の演算装置であって、記憶部11に記憶されるプログラムに従って各種の情報処理を実行する。本実施例では、制御部12は、撮像部13の視野内に監視カメラ2の監視範囲7が含まれているか否かを判定する処理を行う。また、制御部12は、撮像部13の視野内に監視カメラ2の監視範囲7が含まれている場合、監視カメラ2の撮像画像4上に、監視カメラ2の監視範囲7を表す監視範囲画像116を合成した合成画像5を生成し、表示部15に出力する処理を行う。また、制御部12は、入力部16からの設定情報や操作情報等の入力情報を記憶部11に記憶する処理を行う。

制御部12は、機能的に、モデル生成手段121と、判定手段122と、レンダリング手段123と、合成処理手段124とを含んで構成される。

【0029】

モデル生成手段121は、記憶部11の監視条件情報112と場所モデル111とに基づいて監視範囲モデル114を生成し、当該監視範囲モデル114を場所モデル111上における位置情報と対応付けて記憶部11に記憶するモデリング処理を行う。また、モデル生成手段121は、記憶部11の撮像条件情報113と場所モデル111とに基づいて撮像範囲モデル115を生成し、当該撮像範囲モデル115を場所モデル111上における位置情報と対応付けて記憶部11に記憶するモデリング処理を行う。すなわち、モデリング処理によって、理論上、監視範囲モデル114と撮像範囲モデル115とが配置された場所モデル111を得られることになる。

【0030】

図4は、監視場所の上方から地面方向を撮像している監視カメラ2に係る監視範囲モデル114の一例を表したものである。ここで、図4を用いて、モデル生成手段121における監視範囲モデル114の生成の処理を説明する。なお、図4において、符号111a、111bは、場所モデル111の一部を表したものであり、そのうち111aが地面を表し、111bが建物9の壁面を表したものとする。

【0031】

モデル生成手段121は、監視範囲モデル114を生成するにあたり、まず、記憶部11の監視条件情報112から監視カメラ2の設置位置(X,Y,Z)を読み出して、その位置に対応する場所モデル111上における光学中心Oを求める。また、モデル生成手段121は、当該光学中心Oと、記憶部11の監視条件情報112から読み出した光軸(姿勢)に関する設置条件情報とから、監視カメラ2の場所モデル111上における光軸を求める。また、モデル生成手段121は、記憶部11から焦点距離fとCCDの画素の実サイズ、画像の縦横のピクセル数とレンズの歪みに関する諸元等の監視条件情報112を読み出し、監視カメラ2の場所モデル111上における投影面abcdを求める。そして、光学中心Oから投影面abcdの四つの頂点を通る四角錐Oa’b’c’d’を生成する。なお、四角錐の高さは、少なくとも四角錐の底面における四つの頂点(a’,b’,c’,d’)が場所モデル111を貫く程度の任意の高さとする。そして、モデル生成手段121は、この四角錐と場所モデル111との干渉面ABCDを公知の幾何計算により求め、当該干渉面と四角錐の頭頂点を含む四つの側面からなる立体形状OABCDを監視範囲モデル114として求める。

【0032】

このように、監視範囲モデル114の形状は、監視条件情報112の値によって変化する。例えば、監視カメラ2がズーム操作を行った場合、焦点距離fが大きくなることに伴って、四角錐の底面a’b’c’d’の辺の長さが小さくなり、干渉面の大きさも小さくなるように変化する。また、監視カメラ2に対して、パン・チルト操作を行い、図5のように床面111aと壁面111bとが監視範囲に含まれるよう監視カメラ2の光軸を移動させた場合、監視範囲モデル114の形状は、OABECDFを頂点とした3次元形状となる。なお、図4、図5はレンズのゆがみを除去した場合の監視範囲モデル114の概略を表したものである。

【0033】

なお、本実施例では、上記のように監視条件情報112として焦点距離、画素数、画素サイズ、レンズ歪みからなる画角条件情報を用いて投影面を求め、当該投影面から監視範囲モデル114を算出するための処理を行っている。しかし、焦点距離、画素数、画素サイズ、レンズ歪みからなる画角条件情報を用いなくても監視範囲モデル114を算出することができる。例えば、監視カメラ2の種類によっては、監視カメラ2の水平角(又は垂直角)を設定することによって、当該水平角(又は垂直角)と当該監視カメラ2のアスペクト比とから一意に監視範囲を求めることができるものがある。このような監視カメラ2では、画角条件情報として水平角(又は垂直角)とアスペクト比とを設定することによって、四角錐の頭頂点Oにおける対向する2つの側面がなす角度を求めることができるため、これから上記実施例と同様に四角錐Oa’b’c’d’を求めることができ、監視範囲モデル114を生成することができる。

【0034】

なお、モデル生成手段121における撮像範囲モデル115の生成処理は、上記の監視範囲モデル114の生成と同様の処理であり、監視範囲モデル114が監視条件情報112を用いて生成されるのに対して、撮像範囲モデル115が撮像条件情報113を用いて生成される点が異なる。したがって、ここでは撮像範囲モデル115の生成処理の詳細な説明を省略する。

【0035】

判定手段122は、記憶部11の監視範囲モデル114と撮像範囲モデル115とに基づいて撮像部13の視野内に監視カメラ2の監視範囲7が含まれているか否かを判定する処理を行う。本実施例では、判定手段122は、監視範囲モデル114と撮像範囲モデル115とが3次元仮想空間内である場所モデル111上において交わっているか否かを判定し、交わっている場合に、撮像部13の視野内に監視カメラ2の監視範囲7が含まれていると判定する。

【0036】

ここで、図6を用いて判定手段122の処理を補足説明する。図6において、符号111a、111bは、場所モデル111の一部を表したものであり、そのうち111aが地面を表し、111bが建物9の壁面を表したものとする。図6(a)に示すように、モデル生成手段121にて生成された監視範囲モデル114aと撮像範囲モデル115aとが交わっていない場合、判定手段122は撮像部13の視野内に監視カメラ2の監視範囲7が含まれていないと判定する。一方、図6(b)に示すように、モデル生成手段121にて生成された監視範囲モデル114bと撮像範囲モデル115bとが交わっている場合、判定手段122は撮像部13の視野内に監視カメラ2の監視範囲7が含まれていると判定する。

【0037】

レンダリング手段123は、判定手段122にて撮像部13の視野内に監視カメラ2の監視範囲7が含まれていると判定した場合、監視条件情報112と撮像条件情報113とに基づいて監視範囲画像116を生成する処理を行う。

【0038】

レンダリング手段123は、監視範囲画像116を生成するにあたって、まず、撮像条件情報113に基づいて、撮像部13に対応する仮想カメラを場所モデル111上に配置する処理も行う。この際、当該仮想カメラは、撮像部13の視野からの撮像画像に相当するレンダリング画像が得られるよう設定されるものとする。

【0039】

そして、レンダリング手段123は、当該仮想カメラを用いて、監視範囲モデル114が配置された場所モデル111を仮想的に撮像するレンダリング処理を行い、撮像部13の視野からの撮像画像に相当する仮想的な画像であるレンダリング画像を生成する処理を行う。レンダリング処理によって生成されたレンダリング画像は、記憶部11に一時的に記憶される。

【0040】

合成処理手段124は、撮像画像4とレンダリング画像とから合成画像5を生成するオーバーレイ処理を行う。オーバーレイ処理では、合成処理手段124は、まず記憶部11に一時的に記憶されたレンダリング画像から、監視範囲モデル114に該当する部分の画像領域である監視範囲画像116を抽出する処理を行う。具体的には、予めモデリング処理にてモデル生成手段121が、監視範囲モデル114の色情報を、場所モデル111とは異なる色として設定しておく。こうすることで、合成処理手段124は、レンダリング画像から上記色情報を含む画像領域を監視範囲画像116として抽出することができる。

【0041】

続いて、オーバーレイ処理では、撮像部13から取得した撮像画像4上に監視範囲画像116をオーバーレイする(重ね合わせる処理)ことにより合成画像5を生成する。この際、監視範囲画像116に隠れた部分における撮像画像4についても利用者8が見ることができるよう、監視範囲画像116を半透明にして重ね合わせることとする。

【0042】

表示部15は、液晶ディスプレイ等の情報表示デバイスである。表示部15は、合成処理手段124から出力された合成画像5を表示する。このように、利用者8は、表示部15からの表示出力を閲覧することにより、撮像部13の視野内に監視カメラ2の監視範囲7が含まれていることを検知できる。また、利用者8は、表示部15に表示された合成画像5から監視カメラ2の監視範囲7を立体的に捉えることができるため、監視範囲7の適切性などを確認することもできる。

【0043】

なお、表示部15は、好適には撮像部13の光軸に対して垂直となる位置に固定的に配置される。こうすることにより、利用者8は、撮像部13と共に表示部15を移動可能であり、更に、表示部15を閲覧する利用者8の視線と撮像部13の光軸とを略一致させることができるため、監視カメラ2の監視範囲7を利用者8の目線から確認することができる。

【0044】

以下、本実施例の監視範囲検知装置1の制御部12が実行する処理の流れの一例について、図7のフローチャートに基づいて説明する。

【0045】

動作に先立ち、利用者等により入力部16を用いて監視条件情報112、撮像条件情報113の画角条件情報の設定、及び場所モデル111の登録等の各種初期設定が行なわれる(S10)。本実施例では、監視場所内に1台の監視カメラ2が設置されている場合を想定しているため、当該監視カメラ2の監視条件情報112が初期設定にて登録される。なお、複数台の監視カメラ2が設置される場合は、監視カメラ2ごとに監視条件情報112が登録される。また、場所モデル111として図8の3次元形状データが、初期設定にて登録されたとして以下の処理を説明する。

【0046】

初期設定が終わると、モデル生成手段121は、監視カメラ2ごとに監視範囲モデル114を生成して記憶部11に記録するモデリング処理を、全ての監視カメラ2についての処理が終了するまで繰り返し実施する(S12、S14)。

【0047】

そして、モデル生成手段121は、状態取得部14にて取得され記憶部11に記憶された撮像条件情報113を読み出し、撮像範囲モデル115を生成するモデリング処理を実施する(S16、S18)。

【0048】

図9は、モデリング処理後における監視範囲モデル114と撮像範囲モデル115とが設置された場所モデル111の模式図である。なお、図9において、監視範囲検知装置1、監視カメラ2及び利用者8は、本明細書における処理説明のため、便宜的に図9に表したに過ぎず、3次元形状を表す形状モデルとして場所モデル111上に配置されたものではない。

【0049】

次に、判定手段122は、監視範囲モデル114と撮像範囲モデル115とが交わっているか否かを判定する判定処理を行う(S20、S22)。判定手段122が監視範囲モデル114と撮像範囲モデル115とが交わっていないと判定した場合(S22−No)、制御部12は処理をステップS16に戻し、モデル生成手段121により状態取得部14で取得した最新の撮像条件情報113を用いてモデリング処理を実施する。

【0050】

一方、判定手段122が監視範囲モデル114と撮像範囲モデル115とが交わっていると判定した場合(S22−Yes)、制御部12は処理をステップS24に進める。ステップS24では、レンダリング手段123は、撮像部13の視野に相当するレンダリング画像を生成するレンダリング処理を行う(S24)。

図10は、レンダリング処理によって撮像部13に対応する仮想カメラから仮想的に撮像した場合のレンダリング画像3の表した図である。図10において、符号31の画像領域は、図9における監視範囲モデル114に対応する監視範囲画像116である。また、図10において、符号32、33の画像領域は、それぞれ場所モデル111における壁面と床面に対応する画像領域である。

【0051】

このように、レンダリング手段123は、判定手段122により撮像部13の視野内に監視カメラ2の監視範囲7が含まれていると判定したときのみレンダリング処理を行うため、不要なレンダリング処理を行う必要がなく、レンダリング処理に要する処理負荷を軽減することができる。

【0052】

次に、合成処理手段124は、撮像部13により取得した撮像画像4と、ステップS24にて生成したレンダリング画像3から抽出した監視範囲画像116とを重ね合わせて合成画像5を生成するオーバーレイ処理を行う(S26)。そして、合成処理手段124は、オーバーレイ処理によって生成した合成画像5を表示部15に出力する処理を行う。これによって、表示部15は、当該合成画像5を表示する(S28)。

図11は撮像部13から取得した撮像画像4を示す図である。そして、図12はオーバーレイ処理によって図11の撮像画像4上にレンダリング画像3から抽出した監視範囲画像116を重ね合わせた合成画像5を示す図である。図12において、符号51の画像領域は、レンダリング画像3から抽出された監視範囲画像116であり、図10における符号31の画像領域に対応する画像領域である。

【0053】

このように利用者8は、表示部15に表示された合成画像5上の監視範囲画像116を確認することにより、撮像部13の視野内に監視カメラ2の監視範囲7が含まれていることを検知することができる。また、利用者8は、表示部15に表示された合成画像5から監視カメラ2の監視範囲7を立体的に捉えることができるため、監視範囲7の適切性などを確認することもできる。

【0054】

本発明は、上記実施例に限定されるものではなく、特許請求の範囲に記載した技術的思想の範囲内で、更に種々の異なる実施例で実施されてもよいものである。また、上記実施例に記載した効果は、これに限定されるものではない。

【0055】

上記実施例では、場所モデル111として監視場所に存在する現実世界の壁・床・柱等の物体をモデル化した3次元形状データを含む3次元の仮想空間を表した座標情報を用いている。しかし、これに限らず、監視カメラ2の設置高から求まる床面を表す平面形状のみを、場所モデル111における物体の3次元形状データとして用いてもよい。すなわち、モデル生成手段121は、監視場所を平面(地面)のみからなる仮想空間と捉えて、監視条件情報112及び撮像条件情報113に基づいて仮想空間である床面上に監視範囲モデル114及び撮像範囲モデル115を生成する処理を行う。この際、モデル生成手段121は、監視カメラの監視範囲(又は撮像部の撮像範囲)を表す四角錐等の立体形状と床面のみとの干渉を幾何計算することにより干渉面を算出して、監視範囲モデル114(又は撮像範囲モデル115)を生成する。

これにより、壁等の物体との干渉を考慮し監視範囲モデル114(又は撮像範囲モデル115)を生成できず、かつ、物体による隠蔽を考慮することはないため、結果として監視範囲を検知する正確性、及び合成画像上に再現表示される監視範囲の正確性は、低下することになる。しかし、簡易的に監視範囲モデル114(又は撮像範囲モデル115)を生成することができ、また簡易的にレンダリング画像を生成することができるため、結果として監視範囲検知装置1の計算量を減少させることができる。また、予め記憶部11に場所モデル111の3次元形状データを設定するといった手間のかかる初期設定を省略できるため、利用者は監視範囲検知装置1を手軽に利用することができ、利便性が向上することとなる。

【0056】

同様に、物体の3次元形状データを含まない3次元の仮想空間を表した場所モデル111を用いてもよい。この場合、監視範囲モデル114(又は撮像範囲モデル115)は、床面との干渉をも一切考慮しないものとなるため、結果として監視範囲を検知する正確性、及び合成画像上に再現表示される監視範囲の正確性は、さらに低下することになる。しかし、監視範囲検知装置1の計算量を最も抑制できるため、簡易的に監視範囲を検知又は再現したい場合には有用である。

【0057】

上記実施例は、判定手段122にて撮像部13の視野内に監視カメラ2の監視範囲7が含まれているか否かを判定し、当該判定結果に基づいて、レンダリング手段123により撮像部からの視野に相当するレンダリング画像を生成し、合成処理手段124により撮像画像4と当該レンダリング画像とを合成した合成画像を出力する処理を行う構成となっている。しかし、これに限らず、合成画像5を出力せずに、判定手段122による判定結果を表示部15にメッセージ表示する構成でも良い。すなわち、判定手段122は、撮像部13の視野内に監視カメラ2の監視範囲7が含まれていると判定した場合、表示部15に対して例えば「撮像部の撮像範囲内に監視カメラの監視範囲が含まれます」などのメッセージを表示させる処理を行っても良い。

これにより、利用者は、上記実施例のように合成画像5により監視カメラ2の監視範囲7を視覚的に確認することができない一方で、撮像部13の視野内に監視カメラ2の監視範囲が含まれていることを検知することについては可能であるため、例えば自らの前方に監視装置の監視範囲が存在するか否かについてのみ簡易的に検知したい場合には有効である。

【0058】

上記実施例は、監視カメラ2が、本発明における監視装置として機能した場合の実施例である。しかし、これに限らず、人物から放射される赤外線の受光量の変化に基づいて人物の存否を検出する赤外線センサを、本発明における監視装置として機能させてもよい。この場合、記憶部11の監視条件情報112には、当該赤外線センサの設置位置や監視方向に関するセンサ設置条件情報と、センサの監視範囲(検知範囲)を画定する監視角情報とが記憶される。また、記憶部11の監視範囲モデル114には、制御部12のモデル生成手段121によって生成された、赤外線センサの監視範囲を模してモデル化した3次元形状データが記憶される。そして、最終的に出力される合成画像は、撮像部13にて取得した撮像画像4上に赤外線センサの監視範囲を表す画像領域、すなわち監視範囲画像を重ね合わせるよう画像処理した画像として出力される。なお、上記の赤外線センサ以外にも、マイクロ波センサや超音波センサ等の設置条件情報と監視角情報とを設定することにより監視範囲を一意に画定できる空間センサを用いてもよい。

【符号の説明】

【0059】

1・・・監視範囲検知装置

2・・・監視カメラ

3・・・レンダリング画像

4・・・撮像画像

5・・・合成画像

7・・・監視範囲

8・・・利用者

9・・・建物

11・・・記憶部

12・・・制御部

13・・・撮像部

14・・・状態取得部

15・・・表示部

16・・・入力部

111・・・場所モデル

112・・・監視条件情報

113・・・撮像条件情報

114・・・監視範囲モデル

115・・・撮像範囲モデル

116・・・監視範囲画像

121・・・モデル生成手段

122・・・判定手段

123・・・レンダリング手段

124・・・合成処理手段

【技術分野】

【0001】

本発明は、監視場所に設置された監視カメラや赤外線センサなどの監視装置の監視範囲(すなわち、監視カメラの撮像範囲や赤外線センサ等の検知範囲)を検知して利用者に通知する監視範囲検知装置に関する。

【背景技術】

【0002】

近年、セキュリティを目的として、監視カメラを取り付ける個人、法人、公共機関などが増加しつつある。例えば、住宅街に居住する住民が、自宅の外壁にカメラ用回転台付の監視カメラを設置し、自宅のパソコンを用いてパン、チルト、ズーム等の操作を行いながら屋外を画像監視する事例も出てきている。

【0003】

しかし、このような監視カメラを用いて、利用者が意図的に、隣人の住宅内部を閲覧したり、路上にいる隣人を望遠で閲覧する等のプライバシを侵害するような使用をする可能性は否定できない。そのため、このようなパブリックスペースを監視している監視カメラの監視範囲の適切性を、通行人等の一般人によって確認したいといったニーズが高まりつつある。

【0004】

従来、監視カメラによって撮像された監視画像を人が目視により直接的に確認することによって、当該監視カメラが他人のプライバシを侵害していないことを確認していた。また、監視カメラの監視範囲を確認するために、当該監視カメラの設置位置や姿勢、画角情報等から算出した撮像範囲を表す画像を、地図画像上に重畳表示する技術も提案されている(特許文献1)。

【先行技術文献】

【特許文献】

【0005】

【特許文献1】特開2000−358240

【発明の概要】

【発明が解決しようとする課題】

【0006】

しかしながら、上記の従来技術では、利用者が、例えば自らの前方に監視カメラの監視範囲が存在するか否かを把握するにあたって、常に自らの現在位置と地図上に重畳表示された撮像範囲を表す画像との位置関係を確認しなければならず、実用上の手間を要していた。

【0007】

そこで本発明は、利用者によって所持される端末の位置や姿勢などに応じて画定される方向・範囲内に、監視カメラ等の監視装置の監視範囲が存在するか否かを検知可能とすることを目的とする。これにより、利用者は、従来技術のように地図による位置関係を常に確認することなく、例えば自らの前方の所定範囲内に監視カメラの監視範囲が存在するか否かを容易に把握できることを目的とする。

【課題を解決するための手段】

【0008】

かかる課題を解決するために、監視装置の監視範囲を検知する監視範囲検知装置であって、撮像画像を取得する撮像部と、撮像部の現在の位置及び光軸を取得する状態取得部と、監視装置が監視する場所を3次元の仮想空間として表現した場所モデルと、監視装置の設置位置、監視方向及び監視角情報を場所モデルと対応付けた監視条件情報と、撮像部の画角と状態取得部で取得した該撮像部の現在の位置及び光軸とを場所モデルと対応付けた撮像条件情報とを記憶した記憶部と、場所モデルと監視条件情報とに基づいて監視装置の監視範囲を表す監視範囲モデルを生成し、場所モデルと撮像条件情報とに基づいて撮像部の撮像範囲を表す撮像範囲モデルを生成するモデル生成手段と、監視範囲モデルと撮像範囲モデルとが交わっているときに撮像部の視野内に監視装置の監視範囲が含まれていると判定する判定手段と、判定手段による判定結果を表示する表示部と、を有することを特徴とする監視範囲検知装置を提供する。

【0009】

かかる構成により、本発明のモデル生成手段は、場所モデルと監視条件情報とに基づいて監視装置の監視範囲を表す3次元形状の監視範囲モデルを生成し、場所モデルと撮像条件情報とに基づいて撮像部の撮像範囲を表す3次元形状の撮像範囲モデルを生成する処理を行う。そして、本発明の判定手段は、監視範囲モデルと撮像範囲モデルとが場所モデル上において交わっているか否かを判定する処理を行う。ここで、判定手段は、監視範囲モデルと撮像範囲モデルとが交わっているときに撮像部の視野内に監視装置の監視範囲が含まれていると判定する。そして、本発明の表示部は、判定手段にて撮像部の視野内に監視装置の監視範囲が含まれていると判定したときに、判定結果として、例えばその旨を示すメッセージを表示する。

上記処理により、利用者は、撮像部の視野内に監視装置の監視範囲が含まれていることを検知することができるため、例えば自らの前方に監視装置の監視範囲が存在するか否かについて確認したい場合、撮像部の光軸が自らの前方に向くよう視野方向を制御することによって検知することが可能となる。

【0010】

また、本発明の好ましい態様として、場所モデルは、監視場所に存在する物体を含めて3次元の仮想空間を表現したものとする。

例えば、場所モデルは、監視場所にある建物の壁面や柱等の建築構造物や地面などといった物体の3次元形状情報を含めて3次元の仮想空間を表現したものとして記憶部に記憶されているものとする。かかる構成により、本発明のモデル生成手段は、場所モデルの物体との干渉を考慮して監視条件情報に基づいて監視範囲モデルを生成し、当該監視範囲モデルを場所モデル内に配置する処理を行う。また、本発明のモデル生成手段は、場所モデルの物体との干渉を考慮して撮像条件情報に基づいて撮像範囲モデルを生成し、当該撮像範囲モデルを場所モデル内に配置する処理を行う。そして、本発明の判定手段は、監視範囲モデルと撮像範囲モデルとが場所モデル上において交わっているか否かによって、撮像部の視野内に前記監視装置の監視範囲が含まれているか否かを判定する処理を行う。

上記処理により、例えば、監視装置の監視範囲が壁等の物体によって遮られていたり、監視装置の監視範囲が撮像部から見て壁等の物体の陰となって隠蔽されていたりする場合、当該遮られている(又は隠蔽されている)部分の監視範囲を考慮して、撮像部の視野内に監視範囲が含まれているか否かを判定することができる。したがって、利用者は、より正確に監視装置の監視範囲を検知することができる。

【0011】

また、本発明の好ましい態様として、更に、判定手段にて撮像部の視野内に監視装置の監視範囲が含まれていると判定したとき、監視範囲モデルと撮像条件情報とを用いて撮像部の視野に相当するレンダリング画像を生成するレンダリング手段と、撮像部で取得した撮像画像とレンダリング画像とを合成した合成画像を出力する合成処理手段と、を備え、表示部は、合成画像を表示するものとする。

かかる構成により、本発明の判定手段にて撮像部の視野内に監視装置の監視範囲が含まれていると判定されたとき、本発明のレンダリング手段は、監視範囲モデルが配置された場所モデルと撮像条件情報とを用いて、撮像部からの視野に相当するレンダリング画像を生成する処理を行う。例えば、レンダリング手段は、監視範囲モデルが配置された場所モデル内に、撮像条件情報に基づいて設定された仮想的なカメラ(以下、「仮想カメラ」という)を配置し、当該仮想カメラから、3次元コンピュータグラフィックスのレンダリング処理を行うことにより、撮像部の視野に相当するレンダリング画像を生成する。そして、本発明の合成処理手段は、撮像部からの撮像画像とレンダリング画像とを合成した合成画像を出力する処理を行う。例えば、レンダリング画像から、監視装置の監視範囲を表す画像領域(以下、「監視範囲画像」という)を抽出し、当該監視範囲画像を撮像画像上にオーバーレイすることにより合成画像を出力する。そして、本発明の表示部により、当該合成画像を表示する。

上記処理により、利用者は、合成画像における監視範囲画像を閲覧することによって、撮像部の視野内に監視装置の監視範囲が含まれていることを検知できるだけでなく、当該監視範囲の形状を立体的に捉えることができるため、監視範囲の適切性なども確認することができる。さらに、上記処理により、撮像部の視野内に監視装置の監視範囲が含まれていると判定したときのみ監視範囲画像を再現するレンダリング処理を行うため、不要なレンダリング処理を行う必要がなく、レンダリング処理に要する処理負荷を軽減することができる。

【0012】

また、本発明の好ましい態様として、表示部は、撮像部の光軸に対して垂直となる位置に固定的に配置されるものとする。

これにより、利用者は、撮像部と共に表示部を移動可能であり、更に、表示部を閲覧する利用者の視線と撮像部の光軸とを略一致させることができるため、監視装置の監視範囲を利用者目線により確認することができる。

【発明の効果】

【0013】

上記のように、本発明の監視範囲検知装置は、監視装置の監視範囲と撮像部の撮像範囲とをぞれぞれモデル化して、これらの交わりを判定することによって、利用者が、撮像部の視野内に監視範囲の監視範囲が含まれているか否かを検知することができるため、例えば利用者の前方に監視装置の監視範囲が存在するか否かについて確認することができる。

【図面の簡単な説明】

【0014】

【図1】監視範囲検知装置の利用形態の模式図

【図2】監視範囲検知装置の構成を示すブロック図

【図3】電子コンパス、傾斜センサで得られる角度の説明図

【図4】監視範囲モデルを説明する図

【図5】監視範囲モデルを説明する図

【図6】判定手段の処理を説明する図

【図7】制御部における処理を示すフローチャート

【図8】場所モデルを表す図

【図9】モデリング処理後の場所モデルを表す図

【図10】レンダリング処理後のレンダリング画像を表す図

【図11】撮像画像を表す図

【図12】合成画像を表す図

【発明を実施するための形態】

【0015】

以下、本発明の一実施形態として、ある建物の壁面に設置され屋外の監視場所を監視している監視カメラの監視範囲(撮像範囲)を、利用者が自ら所持している監視範囲検知装置によって確認する場合の実施例について、図面を参照して説明する。すなわち、本実施例は、監視カメラが、本発明における監視装置として機能した場合の実施例である。

【0016】

図1は、本実施の形態の監視範囲検知装置1の利用形態を説明する模式図である。監視カメラ2は、建物9の壁面上部等に監視場所を俯瞰して撮像するよう設置され、監視場所を所定時間おきに撮影し、取得した監視画像を図示しない記録装置に順次記録する。ここで、当該監視カメラ2の監視範囲は、一点鎖線で図示された領域7であるとする。

図1に示すように、本実施例では、監視範囲検知装置1は、利用者8によって所持されるコンピュータ端末である。しかし、これに限らず、監視範囲検知装置1は、コンピュータ機能を有するヘットマウントディスプレイ等から構成されるウェアラブルコンピュータであってもよい。後述するように監視範囲検知装置1は、撮像部と表示部とを備え、撮像部によって取得した撮像画像4を表示部に表示する。また、監視範囲検知装置1は、撮像部の視野内に監視カメラ2の監視範囲7が含まれていると判定した場合、当該監視範囲7を表す監視範囲画像116を撮像画像4上に重畳した合成画像5を表示する。なお、本実施例では、図1に示すように一つの監視カメラ2のみ設置されている例を用いて説明するが、複数の監視カメラ2が設置されていても良い。

【0017】

図2は、監視範囲検知装置1の構成を示している。監視範囲検知装置1は、コンピュータ機能を有しており、記憶部11、制御部12、撮像部13、状態取得部14、表示部15、入力部16を備えている。

【0018】

撮像部13は、CCD素子やC−MOS素子等の撮像素子、光学系部品等を含んで構成される所謂カメラである。本実施例では、撮像部13は、所定時間おきに撮像して撮像画像4を記憶部11に一時的に記憶するものとする。撮像画像4を取得する時間間隔は、例えば1/5秒である。

【0019】

入力部16は、キーボード、タッチパネル、可搬記憶媒体の読み取り装置等の情報入力デバイスである。利用者8は、入力部16を用いて、それぞれの監視カメラ2の設置位置等の様々な撮像条件に関する情報を設定したりすることができる。

【0020】

状態取得部14は、GPS(Global Positioning System)、距離センサ、電子コンパス、傾斜センサなどの各種センサを含んで構成され、撮像部13の現在の位置や光軸(姿勢)に関する情報を所定時間おきに取得して記憶部11に記憶する。

【0021】

本実施例では、撮像部13の現在の位置に係る水平面上における位置情報として、GPSにより自立的に測位した結果(緯度・経度)を取得する。また、撮像部13の現在の位置における高さ情報については、超音波センサや赤外線センサ等を用いた距離センサにより地面からの距離を測定した結果を取得する。なお、高さ情報については、距離センサを用いずに、簡易的に人が所持する高さを考慮して設定された固定値(例えば1.2m〜1.7のいずれかの値)を用いてもよい。この場合、利用者8によって入力部16を用いて設定入力される。

【0022】

また、本実施例では、撮像部13の現在の光軸に係る情報として、電子コンパスにより自立的に測定した結果を、所定方向を基準とする角度として取得し、そして、傾斜センサから撮像部13の水平面に対する傾斜の度合いを示す傾斜情報を角度として検出する。具体的には、状態取得部14の電子コンパスは、図3(a)に示されるように、例えば北方向を基準として右回りに、北方向0°、東方向を90°、南方向を180°、西方向を270°として、撮像部13の光軸の方位角を角度θとして検出する。また、状態取得部14の傾斜センサは、図3(b)に示されるように、水平面に対する撮像部13の光軸の傾斜角を上方向への傾斜を角度θ’として、下方向への傾斜を角度−θ’として検出する。

【0023】

記憶部11は、ROM、RAM、HDD等の情報記憶装置である。記憶部11は、各種プログラムや各種データを記憶し、制御部12との間でこれらの情報を入出力する。各種データには、場所モデル111、監視条件情報112、撮像条件情報113、監視範囲モデル114、撮像範囲モデル115が含まれる。

【0024】

場所モデル111は、監視場所に存在する現実世界の壁・地面・柱等の物体をモデル化することにより作成された3次元形状データを含む3次元の仮想空間を表した座標情報である。場所モデル111における3次元形状データは、監視場所の形状情報に基づいて3次元CADで作成されたものでも良いし、3次元レーザースキャナー等により監視場所の3次元形状を取り込んだデータを利用しても良い。このようにして作成された場所モデル111は、利用者等により入力部16から設定登録されることにより記憶部11に記憶される。

【0025】

監視条件情報112は、現在時刻における監視カメラ2の設置位置や光軸(監視方向)に関する設置条件情報と、焦点距離、画素数、画素サイズ、レンズ歪みに関する画角条件情報(監視角情報)とからなり、設置されている監視カメラ2毎に個別設定される。また、監視条件情報112は、場所モデル111の仮想空間における座標情報に対応付けられた値で設定されている。

ここで、監視カメラ2の設置位置に関する設置条件情報とは、監視場所内(実空間)を3次元直交座標系として表し、実空間の直交座標系で座標が既知である基準点の座標値に基準点からの相対距離、方向を測定して補正する等の公知の技術を使用して算出した座標データとして表した情報である。また、監視カメラ2の光軸に関する設置条件情報とは、上記座標軸に対する監視カメラ2の光軸の回転角度に関する情報であり、監視カメラ2のいわゆるパン角度、チルト角度から求めることができる。監視条件情報112は、初期設定時に利用者8等によって入力部16から設定登録されることにより記憶部11に記憶される。

【0026】

撮像条件情報113は、状態取得部14により取得した現在時刻における撮像部13の位置や光軸に関する端末条件情報と、個別に設定された焦点距離、画素数、画素サイズ、レンズ歪みに関する画角条件情報とからなる。

ここで、撮像部13の位置に関する端末条件情報は、状態取得部14のGPSによって取得した結果を、制御部12によって場所モデル111の仮想空間における座標情報に対応付けて変換された値として設定される。また、撮像部13の光軸に関する端末条件情報は、状態取得部14の電子コンパス及び傾斜センサによって取得した結果を、制御部12によって上記座標軸に対する撮像部13の光軸の回転角度に対応付けて変換した値として設定される。このように、撮像条件情報113の端末条件情報は、各種センサによって現在の位置や光軸に関する情報を取得する度に更新される。なお、撮像条件情報113の画角条件情報は、初期設定時に利用者8等によって入力部16から設定登録されることにより記憶部11に記憶される。

【0027】

監視範囲モデル114は、監視カメラ2の監視範囲7を模してモデル化した3次元形状データである。また、撮像範囲モデル115は、撮像部13の監視範囲を模してモデル化した3次元形状データである。監視範囲モデル114及び撮像範囲モデル115は、後述するように制御部12のモデル生成手段121によって生成され、記憶部11に記憶される。

【0028】

制御部12は、例えばCPUやDSP等の演算装置であって、記憶部11に記憶されるプログラムに従って各種の情報処理を実行する。本実施例では、制御部12は、撮像部13の視野内に監視カメラ2の監視範囲7が含まれているか否かを判定する処理を行う。また、制御部12は、撮像部13の視野内に監視カメラ2の監視範囲7が含まれている場合、監視カメラ2の撮像画像4上に、監視カメラ2の監視範囲7を表す監視範囲画像116を合成した合成画像5を生成し、表示部15に出力する処理を行う。また、制御部12は、入力部16からの設定情報や操作情報等の入力情報を記憶部11に記憶する処理を行う。

制御部12は、機能的に、モデル生成手段121と、判定手段122と、レンダリング手段123と、合成処理手段124とを含んで構成される。

【0029】

モデル生成手段121は、記憶部11の監視条件情報112と場所モデル111とに基づいて監視範囲モデル114を生成し、当該監視範囲モデル114を場所モデル111上における位置情報と対応付けて記憶部11に記憶するモデリング処理を行う。また、モデル生成手段121は、記憶部11の撮像条件情報113と場所モデル111とに基づいて撮像範囲モデル115を生成し、当該撮像範囲モデル115を場所モデル111上における位置情報と対応付けて記憶部11に記憶するモデリング処理を行う。すなわち、モデリング処理によって、理論上、監視範囲モデル114と撮像範囲モデル115とが配置された場所モデル111を得られることになる。

【0030】

図4は、監視場所の上方から地面方向を撮像している監視カメラ2に係る監視範囲モデル114の一例を表したものである。ここで、図4を用いて、モデル生成手段121における監視範囲モデル114の生成の処理を説明する。なお、図4において、符号111a、111bは、場所モデル111の一部を表したものであり、そのうち111aが地面を表し、111bが建物9の壁面を表したものとする。

【0031】

モデル生成手段121は、監視範囲モデル114を生成するにあたり、まず、記憶部11の監視条件情報112から監視カメラ2の設置位置(X,Y,Z)を読み出して、その位置に対応する場所モデル111上における光学中心Oを求める。また、モデル生成手段121は、当該光学中心Oと、記憶部11の監視条件情報112から読み出した光軸(姿勢)に関する設置条件情報とから、監視カメラ2の場所モデル111上における光軸を求める。また、モデル生成手段121は、記憶部11から焦点距離fとCCDの画素の実サイズ、画像の縦横のピクセル数とレンズの歪みに関する諸元等の監視条件情報112を読み出し、監視カメラ2の場所モデル111上における投影面abcdを求める。そして、光学中心Oから投影面abcdの四つの頂点を通る四角錐Oa’b’c’d’を生成する。なお、四角錐の高さは、少なくとも四角錐の底面における四つの頂点(a’,b’,c’,d’)が場所モデル111を貫く程度の任意の高さとする。そして、モデル生成手段121は、この四角錐と場所モデル111との干渉面ABCDを公知の幾何計算により求め、当該干渉面と四角錐の頭頂点を含む四つの側面からなる立体形状OABCDを監視範囲モデル114として求める。

【0032】

このように、監視範囲モデル114の形状は、監視条件情報112の値によって変化する。例えば、監視カメラ2がズーム操作を行った場合、焦点距離fが大きくなることに伴って、四角錐の底面a’b’c’d’の辺の長さが小さくなり、干渉面の大きさも小さくなるように変化する。また、監視カメラ2に対して、パン・チルト操作を行い、図5のように床面111aと壁面111bとが監視範囲に含まれるよう監視カメラ2の光軸を移動させた場合、監視範囲モデル114の形状は、OABECDFを頂点とした3次元形状となる。なお、図4、図5はレンズのゆがみを除去した場合の監視範囲モデル114の概略を表したものである。

【0033】

なお、本実施例では、上記のように監視条件情報112として焦点距離、画素数、画素サイズ、レンズ歪みからなる画角条件情報を用いて投影面を求め、当該投影面から監視範囲モデル114を算出するための処理を行っている。しかし、焦点距離、画素数、画素サイズ、レンズ歪みからなる画角条件情報を用いなくても監視範囲モデル114を算出することができる。例えば、監視カメラ2の種類によっては、監視カメラ2の水平角(又は垂直角)を設定することによって、当該水平角(又は垂直角)と当該監視カメラ2のアスペクト比とから一意に監視範囲を求めることができるものがある。このような監視カメラ2では、画角条件情報として水平角(又は垂直角)とアスペクト比とを設定することによって、四角錐の頭頂点Oにおける対向する2つの側面がなす角度を求めることができるため、これから上記実施例と同様に四角錐Oa’b’c’d’を求めることができ、監視範囲モデル114を生成することができる。

【0034】

なお、モデル生成手段121における撮像範囲モデル115の生成処理は、上記の監視範囲モデル114の生成と同様の処理であり、監視範囲モデル114が監視条件情報112を用いて生成されるのに対して、撮像範囲モデル115が撮像条件情報113を用いて生成される点が異なる。したがって、ここでは撮像範囲モデル115の生成処理の詳細な説明を省略する。

【0035】

判定手段122は、記憶部11の監視範囲モデル114と撮像範囲モデル115とに基づいて撮像部13の視野内に監視カメラ2の監視範囲7が含まれているか否かを判定する処理を行う。本実施例では、判定手段122は、監視範囲モデル114と撮像範囲モデル115とが3次元仮想空間内である場所モデル111上において交わっているか否かを判定し、交わっている場合に、撮像部13の視野内に監視カメラ2の監視範囲7が含まれていると判定する。

【0036】

ここで、図6を用いて判定手段122の処理を補足説明する。図6において、符号111a、111bは、場所モデル111の一部を表したものであり、そのうち111aが地面を表し、111bが建物9の壁面を表したものとする。図6(a)に示すように、モデル生成手段121にて生成された監視範囲モデル114aと撮像範囲モデル115aとが交わっていない場合、判定手段122は撮像部13の視野内に監視カメラ2の監視範囲7が含まれていないと判定する。一方、図6(b)に示すように、モデル生成手段121にて生成された監視範囲モデル114bと撮像範囲モデル115bとが交わっている場合、判定手段122は撮像部13の視野内に監視カメラ2の監視範囲7が含まれていると判定する。

【0037】

レンダリング手段123は、判定手段122にて撮像部13の視野内に監視カメラ2の監視範囲7が含まれていると判定した場合、監視条件情報112と撮像条件情報113とに基づいて監視範囲画像116を生成する処理を行う。

【0038】

レンダリング手段123は、監視範囲画像116を生成するにあたって、まず、撮像条件情報113に基づいて、撮像部13に対応する仮想カメラを場所モデル111上に配置する処理も行う。この際、当該仮想カメラは、撮像部13の視野からの撮像画像に相当するレンダリング画像が得られるよう設定されるものとする。

【0039】

そして、レンダリング手段123は、当該仮想カメラを用いて、監視範囲モデル114が配置された場所モデル111を仮想的に撮像するレンダリング処理を行い、撮像部13の視野からの撮像画像に相当する仮想的な画像であるレンダリング画像を生成する処理を行う。レンダリング処理によって生成されたレンダリング画像は、記憶部11に一時的に記憶される。

【0040】

合成処理手段124は、撮像画像4とレンダリング画像とから合成画像5を生成するオーバーレイ処理を行う。オーバーレイ処理では、合成処理手段124は、まず記憶部11に一時的に記憶されたレンダリング画像から、監視範囲モデル114に該当する部分の画像領域である監視範囲画像116を抽出する処理を行う。具体的には、予めモデリング処理にてモデル生成手段121が、監視範囲モデル114の色情報を、場所モデル111とは異なる色として設定しておく。こうすることで、合成処理手段124は、レンダリング画像から上記色情報を含む画像領域を監視範囲画像116として抽出することができる。

【0041】

続いて、オーバーレイ処理では、撮像部13から取得した撮像画像4上に監視範囲画像116をオーバーレイする(重ね合わせる処理)ことにより合成画像5を生成する。この際、監視範囲画像116に隠れた部分における撮像画像4についても利用者8が見ることができるよう、監視範囲画像116を半透明にして重ね合わせることとする。

【0042】

表示部15は、液晶ディスプレイ等の情報表示デバイスである。表示部15は、合成処理手段124から出力された合成画像5を表示する。このように、利用者8は、表示部15からの表示出力を閲覧することにより、撮像部13の視野内に監視カメラ2の監視範囲7が含まれていることを検知できる。また、利用者8は、表示部15に表示された合成画像5から監視カメラ2の監視範囲7を立体的に捉えることができるため、監視範囲7の適切性などを確認することもできる。

【0043】

なお、表示部15は、好適には撮像部13の光軸に対して垂直となる位置に固定的に配置される。こうすることにより、利用者8は、撮像部13と共に表示部15を移動可能であり、更に、表示部15を閲覧する利用者8の視線と撮像部13の光軸とを略一致させることができるため、監視カメラ2の監視範囲7を利用者8の目線から確認することができる。

【0044】

以下、本実施例の監視範囲検知装置1の制御部12が実行する処理の流れの一例について、図7のフローチャートに基づいて説明する。

【0045】

動作に先立ち、利用者等により入力部16を用いて監視条件情報112、撮像条件情報113の画角条件情報の設定、及び場所モデル111の登録等の各種初期設定が行なわれる(S10)。本実施例では、監視場所内に1台の監視カメラ2が設置されている場合を想定しているため、当該監視カメラ2の監視条件情報112が初期設定にて登録される。なお、複数台の監視カメラ2が設置される場合は、監視カメラ2ごとに監視条件情報112が登録される。また、場所モデル111として図8の3次元形状データが、初期設定にて登録されたとして以下の処理を説明する。

【0046】

初期設定が終わると、モデル生成手段121は、監視カメラ2ごとに監視範囲モデル114を生成して記憶部11に記録するモデリング処理を、全ての監視カメラ2についての処理が終了するまで繰り返し実施する(S12、S14)。

【0047】

そして、モデル生成手段121は、状態取得部14にて取得され記憶部11に記憶された撮像条件情報113を読み出し、撮像範囲モデル115を生成するモデリング処理を実施する(S16、S18)。

【0048】

図9は、モデリング処理後における監視範囲モデル114と撮像範囲モデル115とが設置された場所モデル111の模式図である。なお、図9において、監視範囲検知装置1、監視カメラ2及び利用者8は、本明細書における処理説明のため、便宜的に図9に表したに過ぎず、3次元形状を表す形状モデルとして場所モデル111上に配置されたものではない。

【0049】

次に、判定手段122は、監視範囲モデル114と撮像範囲モデル115とが交わっているか否かを判定する判定処理を行う(S20、S22)。判定手段122が監視範囲モデル114と撮像範囲モデル115とが交わっていないと判定した場合(S22−No)、制御部12は処理をステップS16に戻し、モデル生成手段121により状態取得部14で取得した最新の撮像条件情報113を用いてモデリング処理を実施する。

【0050】

一方、判定手段122が監視範囲モデル114と撮像範囲モデル115とが交わっていると判定した場合(S22−Yes)、制御部12は処理をステップS24に進める。ステップS24では、レンダリング手段123は、撮像部13の視野に相当するレンダリング画像を生成するレンダリング処理を行う(S24)。

図10は、レンダリング処理によって撮像部13に対応する仮想カメラから仮想的に撮像した場合のレンダリング画像3の表した図である。図10において、符号31の画像領域は、図9における監視範囲モデル114に対応する監視範囲画像116である。また、図10において、符号32、33の画像領域は、それぞれ場所モデル111における壁面と床面に対応する画像領域である。

【0051】

このように、レンダリング手段123は、判定手段122により撮像部13の視野内に監視カメラ2の監視範囲7が含まれていると判定したときのみレンダリング処理を行うため、不要なレンダリング処理を行う必要がなく、レンダリング処理に要する処理負荷を軽減することができる。

【0052】

次に、合成処理手段124は、撮像部13により取得した撮像画像4と、ステップS24にて生成したレンダリング画像3から抽出した監視範囲画像116とを重ね合わせて合成画像5を生成するオーバーレイ処理を行う(S26)。そして、合成処理手段124は、オーバーレイ処理によって生成した合成画像5を表示部15に出力する処理を行う。これによって、表示部15は、当該合成画像5を表示する(S28)。

図11は撮像部13から取得した撮像画像4を示す図である。そして、図12はオーバーレイ処理によって図11の撮像画像4上にレンダリング画像3から抽出した監視範囲画像116を重ね合わせた合成画像5を示す図である。図12において、符号51の画像領域は、レンダリング画像3から抽出された監視範囲画像116であり、図10における符号31の画像領域に対応する画像領域である。

【0053】

このように利用者8は、表示部15に表示された合成画像5上の監視範囲画像116を確認することにより、撮像部13の視野内に監視カメラ2の監視範囲7が含まれていることを検知することができる。また、利用者8は、表示部15に表示された合成画像5から監視カメラ2の監視範囲7を立体的に捉えることができるため、監視範囲7の適切性などを確認することもできる。

【0054】

本発明は、上記実施例に限定されるものではなく、特許請求の範囲に記載した技術的思想の範囲内で、更に種々の異なる実施例で実施されてもよいものである。また、上記実施例に記載した効果は、これに限定されるものではない。

【0055】

上記実施例では、場所モデル111として監視場所に存在する現実世界の壁・床・柱等の物体をモデル化した3次元形状データを含む3次元の仮想空間を表した座標情報を用いている。しかし、これに限らず、監視カメラ2の設置高から求まる床面を表す平面形状のみを、場所モデル111における物体の3次元形状データとして用いてもよい。すなわち、モデル生成手段121は、監視場所を平面(地面)のみからなる仮想空間と捉えて、監視条件情報112及び撮像条件情報113に基づいて仮想空間である床面上に監視範囲モデル114及び撮像範囲モデル115を生成する処理を行う。この際、モデル生成手段121は、監視カメラの監視範囲(又は撮像部の撮像範囲)を表す四角錐等の立体形状と床面のみとの干渉を幾何計算することにより干渉面を算出して、監視範囲モデル114(又は撮像範囲モデル115)を生成する。

これにより、壁等の物体との干渉を考慮し監視範囲モデル114(又は撮像範囲モデル115)を生成できず、かつ、物体による隠蔽を考慮することはないため、結果として監視範囲を検知する正確性、及び合成画像上に再現表示される監視範囲の正確性は、低下することになる。しかし、簡易的に監視範囲モデル114(又は撮像範囲モデル115)を生成することができ、また簡易的にレンダリング画像を生成することができるため、結果として監視範囲検知装置1の計算量を減少させることができる。また、予め記憶部11に場所モデル111の3次元形状データを設定するといった手間のかかる初期設定を省略できるため、利用者は監視範囲検知装置1を手軽に利用することができ、利便性が向上することとなる。

【0056】

同様に、物体の3次元形状データを含まない3次元の仮想空間を表した場所モデル111を用いてもよい。この場合、監視範囲モデル114(又は撮像範囲モデル115)は、床面との干渉をも一切考慮しないものとなるため、結果として監視範囲を検知する正確性、及び合成画像上に再現表示される監視範囲の正確性は、さらに低下することになる。しかし、監視範囲検知装置1の計算量を最も抑制できるため、簡易的に監視範囲を検知又は再現したい場合には有用である。

【0057】

上記実施例は、判定手段122にて撮像部13の視野内に監視カメラ2の監視範囲7が含まれているか否かを判定し、当該判定結果に基づいて、レンダリング手段123により撮像部からの視野に相当するレンダリング画像を生成し、合成処理手段124により撮像画像4と当該レンダリング画像とを合成した合成画像を出力する処理を行う構成となっている。しかし、これに限らず、合成画像5を出力せずに、判定手段122による判定結果を表示部15にメッセージ表示する構成でも良い。すなわち、判定手段122は、撮像部13の視野内に監視カメラ2の監視範囲7が含まれていると判定した場合、表示部15に対して例えば「撮像部の撮像範囲内に監視カメラの監視範囲が含まれます」などのメッセージを表示させる処理を行っても良い。

これにより、利用者は、上記実施例のように合成画像5により監視カメラ2の監視範囲7を視覚的に確認することができない一方で、撮像部13の視野内に監視カメラ2の監視範囲が含まれていることを検知することについては可能であるため、例えば自らの前方に監視装置の監視範囲が存在するか否かについてのみ簡易的に検知したい場合には有効である。

【0058】

上記実施例は、監視カメラ2が、本発明における監視装置として機能した場合の実施例である。しかし、これに限らず、人物から放射される赤外線の受光量の変化に基づいて人物の存否を検出する赤外線センサを、本発明における監視装置として機能させてもよい。この場合、記憶部11の監視条件情報112には、当該赤外線センサの設置位置や監視方向に関するセンサ設置条件情報と、センサの監視範囲(検知範囲)を画定する監視角情報とが記憶される。また、記憶部11の監視範囲モデル114には、制御部12のモデル生成手段121によって生成された、赤外線センサの監視範囲を模してモデル化した3次元形状データが記憶される。そして、最終的に出力される合成画像は、撮像部13にて取得した撮像画像4上に赤外線センサの監視範囲を表す画像領域、すなわち監視範囲画像を重ね合わせるよう画像処理した画像として出力される。なお、上記の赤外線センサ以外にも、マイクロ波センサや超音波センサ等の設置条件情報と監視角情報とを設定することにより監視範囲を一意に画定できる空間センサを用いてもよい。

【符号の説明】

【0059】

1・・・監視範囲検知装置

2・・・監視カメラ

3・・・レンダリング画像

4・・・撮像画像

5・・・合成画像

7・・・監視範囲

8・・・利用者

9・・・建物

11・・・記憶部

12・・・制御部

13・・・撮像部

14・・・状態取得部

15・・・表示部

16・・・入力部

111・・・場所モデル

112・・・監視条件情報

113・・・撮像条件情報

114・・・監視範囲モデル

115・・・撮像範囲モデル

116・・・監視範囲画像

121・・・モデル生成手段

122・・・判定手段

123・・・レンダリング手段

124・・・合成処理手段

【特許請求の範囲】

【請求項1】

監視装置の監視範囲を検知する監視範囲検知装置であって、

撮像画像を取得する撮像部と、

前記撮像部の現在の位置及び光軸を取得する状態取得部と、

前記監視装置が監視する場所を3次元の仮想空間として表現した場所モデルと、前記監視装置の設置位置、監視方向及び監視角情報を前記場所モデルと対応付けた監視条件情報と、前記撮像部の画角と前記状態取得部で取得した該撮像部の現在の位置及び光軸とを前記場所モデルと対応付けた撮像条件情報とを記憶した記憶部と、

前記場所モデルと前記監視条件情報とに基づいて前記監視装置の監視範囲を表す監視範囲モデルを生成し、前記場所モデルと前記撮像条件情報とに基づいて前記撮像部の撮像範囲を表す撮像範囲モデルを生成するモデル生成手段と、

前記監視範囲モデルと前記撮像範囲モデルとが交わっているときに前記撮像部の視野内に前記監視装置の監視範囲が含まれていると判定する判定手段と、

前記判定手段による判定結果を表示する表示部と、

を有することを特徴とする監視範囲検知装置。

【請求項2】

前記場所モデルは、前記監視場所に存在する物体を含めて3次元の仮想空間を表現した請求項1に記載の監視範囲検知装置。

【請求項3】

更に、前記判定手段にて前記撮像部の視野内に前記監視装置の監視範囲が含まれていると判定したとき、前記監視範囲モデルと前記撮像条件情報とを用いて前記撮像部の視野に相当するレンダリング画像を生成するレンダリング手段と、

前記撮像部で取得した撮像画像と前記レンダリング画像とを合成した合成画像を出力する合成処理手段と、を備え、

前記表示部は、前記合成画像を表示することを特徴とする請求項2に記載の監視範囲検知装置。

【請求項4】

前記表示部は、前記撮像部の光軸に対して垂直となる位置に固定的に配置される請求項1から請求項3に記載の監視範囲検知装置。

【請求項1】

監視装置の監視範囲を検知する監視範囲検知装置であって、

撮像画像を取得する撮像部と、

前記撮像部の現在の位置及び光軸を取得する状態取得部と、

前記監視装置が監視する場所を3次元の仮想空間として表現した場所モデルと、前記監視装置の設置位置、監視方向及び監視角情報を前記場所モデルと対応付けた監視条件情報と、前記撮像部の画角と前記状態取得部で取得した該撮像部の現在の位置及び光軸とを前記場所モデルと対応付けた撮像条件情報とを記憶した記憶部と、

前記場所モデルと前記監視条件情報とに基づいて前記監視装置の監視範囲を表す監視範囲モデルを生成し、前記場所モデルと前記撮像条件情報とに基づいて前記撮像部の撮像範囲を表す撮像範囲モデルを生成するモデル生成手段と、

前記監視範囲モデルと前記撮像範囲モデルとが交わっているときに前記撮像部の視野内に前記監視装置の監視範囲が含まれていると判定する判定手段と、

前記判定手段による判定結果を表示する表示部と、

を有することを特徴とする監視範囲検知装置。

【請求項2】

前記場所モデルは、前記監視場所に存在する物体を含めて3次元の仮想空間を表現した請求項1に記載の監視範囲検知装置。

【請求項3】

更に、前記判定手段にて前記撮像部の視野内に前記監視装置の監視範囲が含まれていると判定したとき、前記監視範囲モデルと前記撮像条件情報とを用いて前記撮像部の視野に相当するレンダリング画像を生成するレンダリング手段と、

前記撮像部で取得した撮像画像と前記レンダリング画像とを合成した合成画像を出力する合成処理手段と、を備え、

前記表示部は、前記合成画像を表示することを特徴とする請求項2に記載の監視範囲検知装置。

【請求項4】

前記表示部は、前記撮像部の光軸に対して垂直となる位置に固定的に配置される請求項1から請求項3に記載の監視範囲検知装置。

【図1】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【公開番号】特開2012−213083(P2012−213083A)

【公開日】平成24年11月1日(2012.11.1)

【国際特許分類】

【出願番号】特願2011−78228(P2011−78228)

【出願日】平成23年3月31日(2011.3.31)

【出願人】(000108085)セコム株式会社 (596)

【Fターム(参考)】

【公開日】平成24年11月1日(2012.11.1)

【国際特許分類】

【出願日】平成23年3月31日(2011.3.31)

【出願人】(000108085)セコム株式会社 (596)

【Fターム(参考)】

[ Back to top ]