表情判定プログラムおよび表情判定装置

【課題】表情判定に用いる特徴点を高速に検出することを課題とする。

【解決手段】表情判定装置200は、顔部位検出部221、設定部222、特徴点検出部223および判定部224を有する。顔部位検出部221は顔画像から複数の顔部位を検出する。設定部222は、複数の顔部位の少なくとも一つを用いて口領域処理範囲を設定する。特徴点検出部223は、口領域処理範囲の画素分布に基づいて右口角および左口角を含む口領域を決定し、口領域から右口角および左口角の位置を検出する。判定部224は、口領域の縦横比率、口領域の面積および口領域における右口角の位置および左口角の位置に応じたポイントを付与することで被験者の表情を判定する。

【解決手段】表情判定装置200は、顔部位検出部221、設定部222、特徴点検出部223および判定部224を有する。顔部位検出部221は顔画像から複数の顔部位を検出する。設定部222は、複数の顔部位の少なくとも一つを用いて口領域処理範囲を設定する。特徴点検出部223は、口領域処理範囲の画素分布に基づいて右口角および左口角を含む口領域を決定し、口領域から右口角および左口角の位置を検出する。判定部224は、口領域の縦横比率、口領域の面積および口領域における右口角の位置および左口角の位置に応じたポイントを付与することで被験者の表情を判定する。

【発明の詳細な説明】

【技術分野】

【0001】

本願の開示する技術は、表情判定プログラムおよび表情判定装置に関連する。

【背景技術】

【0002】

従来、顔を撮影した顔画像から特徴部分を検出し、検出した特徴部分に基づいて顔の表情を判定する技術がある。

【0003】

上述した表情を判定する技術の中には、鼻の先端、左口角および右口角の位置を用いて表情を判定するものがある。例えば、この技術では、入力画像から顔が存在する顔画像領域を抽出し、顔画像領域から鼻の先端、左口角および左口角の位置を特徴点としてそれぞれ抽出する。そして、この技術では、鼻の先端を基準として、鼻の先端と左右の口角位置とのなす角度を計測し、計測した角度の時間変化から表情を判定する。また、上述した表情を判定する技術の中には、真顔の画像、言い換えれば無表情の状態の画像から予め抽出された複数の参照特徴を用いて表情を判定するものもある。ここで、参照特徴とは、入力画像における眼や鼻、口などの顔の特徴部分をパターンマッチングにより認識するためのテンプレートなどに相当する。この技術では、入力画像から抽出した特徴量と照合するための参照特徴を予め用意する。そして、この技術では、入力画像から表情の判定に必要な各特徴量を抽出し、抽出した特徴量と複数の参照特徴の特徴量との差分量を計算することで、顔の各特徴量について参照特徴に対する変化量を算出する。そして、この技術では、算出した変化量から特徴ごとの得点を算出し、算出した得点の総和から表情を判定する。

【0004】

また、上述した表情を判定する技術に関連して、顔画像から目的とする特徴部分を高速に検出するものがある。例えば、この技術では、下瞼および上瞼を含む眼部を検出対象とし、顔画像から鼻孔を検出し、鼻孔の位置に基づいて眼部の探索領域を設定する。そして、この技術では、設定した領域の下半分から下瞼を検出し、下瞼の上の領域から上瞼を検出する。なお、この技術では、上瞼と下瞼に挟まれた画素数に基づいて、例えば、眼が開かれた状態か、あるいは眼が閉ざれた状態かのいずれかを判定する。

【先行技術文献】

【特許文献】

【0005】

【特許文献1】特開2009−98901号公報

【特許文献2】特開2005−56388号公報

【特許文献3】特開2008−146172号公報

【発明の概要】

【発明が解決しようとする課題】

【0006】

ところで、表情判定に必要となる特徴を顔画像から高速に検出しつつ表情判定を行うことも考えられる。例えば、上述したように、鼻孔の位置に基づいて眼部の探索領域を設定する技術では、最終的な検出対象である眼部の探索領域を設定する場合に、眼部とは異なる鼻孔を予め検出する必要がある。しかしながら、カメラなどの撮影装置に対する顔の向きや顔画像の撮影状況によっては、鼻孔を予め検出することができない場合もある。このような場合には、鼻孔の位置に基づいて眼部の探索領域を設定できない。

【0007】

例えば、鼻の先端の位置に基づいて口角の探索領域を設定する場合を考えてみる。この場合、上述した鼻孔の位置に基づいて眼部の探索領域を設定する技術と同様に、顔の向きや顔画像の撮影状況によっては、鼻の先端の位置を予め検出することができない可能性がある。このため、表情判定に必要となる特徴を顔画像から高速に検出しつつ表情判定を行うことは現状困難である。

【0008】

開示の技術は、上記に鑑みてなされたものであって、表情判定に用いる特徴点を高速に検出することが可能な表情判定プログラムおよび表情判定装置を提供することを目的とする。

【課題を解決するための手段】

【0009】

本願の開示する技術は、一つの態様において、コンピュータに、次の各処理を実行させるものである。すなわち、コンピュータに、入力画像を受付け、前記入力画像から顔領域を検出し、前記顔領域から第一の特徴点を抽出し、前記顔領域から第二の特徴点を抽出し、前記第一の特徴点と前記第二の特徴点のうち、少なくとも一つの特徴点を選択する処理を実行させる。また、コンピュータに、選択した前記少なくとも一つの特徴点に基づいて前記顔領域に領域を設定し、設定した前記領域から、前記第一の特徴点および前記第二の特徴点とは異なる第三の特徴点を検出する処理を実行させる。また、コンピュータに、検出した前記第三の特徴点に基づいて前記入力画像における表情を判定する処理を実行させる。

【発明の効果】

【0010】

本願の開示する技術の一つの態様によれば、表情判定に用いる特徴点を高速に検出できる。

【図面の簡単な説明】

【0011】

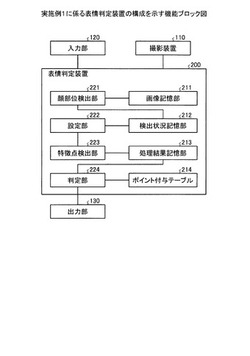

【図1】図1は、実施例1に係る表情判定装置の構成を示す機能ブロック図である。

【図2】図2は、実施例1に係る検出状況記憶部の説明に用いる図である。

【図3】図3は、実施例1に係る処理結果記憶部の説明に用いる図である。

【図4】図4は、実施例1に係るポイント付与テーブルの説明に用いる図である。

【図5】図5は、実施例1に係るポイント付与テーブルの説明に用いる図である。

【図6】図6は、実施例1に係る設定部の説明に用いる図である。

【図7】図7は、実施例1に係る設定部の説明に用いる図である。

【図8】図8は、実施例1に係る設定部の説明に用いる図である。

【図9】図9は、実施例1に係る設定部の説明に用いる図である。

【図10】図10は、実施例1に係る設定部の説明に用いる図である。

【図11】図11は、実施例1に係る設定部の説明に用いる図である。

【図12】図12は、実施例1に係る設定部の説明に用いる図である。

【図13】図13は、実施例1に係る特徴点検出部の説明に用いる図である。

【図14】図14は、実施例1に係る特徴点検出部の説明に用いる図である。

【図15】図15は、実施例1に係る特徴点検出部の説明に用いる図である。

【図16】図16は、実施例1に係る判定部の説明に用いる図である。

【図17】図17は、実施例1に係る表情判定装置による処理の流れを示す図である。

【図18】図18は、実施例1に係る口領域処理範囲の設定処理の流れを示す図である。

【図19】図19は、表情判定プログラムを実行する電子機器の一例を示す図である。

【発明を実施するための形態】

【0012】

以下に、図面を参照しつつ、本願の開示する表情判定プログラムおよび表情判定装置の一実施形態について詳細に説明する。後述する実施例は一実施形態にすぎず、本願の開示する表情判定プログラムおよび表情判定装置を限定するものではない。また、後述する各実施例は処理内容に矛盾を生じさせない範囲で適宜組み合わせることもできる。

【0013】

以下に説明する実施例1では、例えば、被験者に対し所定のアクションを実行し、所定のアクションに対する被験者の反応を撮影した画像を用いて被験者の表情を判定する場合を例に挙げる。ここで、所定のアクションとは、様々な静止画像や動画像の出力に該当し、例えば、一般的に人が悲しいと感じる画像や楽しいと感じる画像の出力に該当する。

【実施例1】

【0014】

[表情判定装置の構成(実施例1)]

図1は、実施例1に係る表情判定装置の構成を示す機能ブロック図である。図1に示すように、実施例1に係る表情判定装置200は、撮影装置110、入力部120および出力部130に接続する。なお、表情判定装置200は、撮影装置110、入力部120および出力部130を内部に有していてもよい。

【0015】

図1に示す撮影装置110は、例えば、表情判定の対象となる被験者の顔を撮影し、撮影した被験者の顔の画像を表情判定装置200に送出する。撮影装置110は、例えば、カメラであり、被験者の顔を撮影可能な位置に設置される。

【0016】

入力部120は、表情判定装置200のユーザから指示を入力する。例えば、入力部120は、所定のアクションとして被験者に閲覧させるための画像等の選択をユーザから受け付けて入力する。なお、入力部120は、キーボードやマウス、タッチパッドなどの入力デバイスを有する。出力部130は、所定のアクションとして実行される画像を出力したり、後述する判定部224による判定結果などを出力したりする。なお、出力部130は、モニタやディスプレイなどの出力デバイスを有し、入力部120が有する入力デバイスと協働して、ポインティングデバイス機能を実現することもできる。

【0017】

図1に示す表情判定装置200は、画像記憶部211、検出状況記憶部212、処理結果記憶部213およびポイント付与テーブル214を有する。なお、画像記憶部211、検出状況記憶部212、処理結果記憶部213およびポイント付与テーブル214は、例えば、RAM(Random Access Memory)やフラッシュメモリ(flash memory)などの半導体メモリ素子である。表情判定装置200は、撮影装置100から被験者の顔の画像(以下、顔画像と表記する)を受け付けると、受け付けた顔の画像を、後述する画像記憶部211に格納する。

【0018】

図1に示す画像記憶部211は、撮影装置100から受け付けた顔画像を記憶する。画像記憶部211は、例えば、撮影装置100から受け付けた画像に対して、撮影装置100から受け付けた順に降順の数字からなる識別情報を付与し、識別情報を付与した画像を被験者の識別情報に対応付けて記憶する。なお、識別情報として付与する数字は一例に過ぎず、英字や、英字と数字との組合せなど、被験者ごとに画像を一意に識別できればよい。

【0019】

図1に示す検出状況記憶部212は、後述する顔部位検出部221による検出状況を記憶する。例えば、検出状況記憶部212は、顔画像における被験者の顔の向きに対応づけて、画像の受付数と、この受付数における顔部位の検出成功数とを記憶する。なお、画像の受付数は、後述する顔部位検出部221により画像記憶部211から読み出され、後述する顔部位検出部221により処理された画像数に該当する。検出状況記憶部212は、情報処理装置100が有するディスプレイやモニタなどに対する被験者の顔の向きとして、例えば、9つの方向に区分けされた顔の向きを記憶する。この9つの方向は、上、正面、下の3つの上下方向と、左、正面、右の3つの左右方向とをそれぞれ1つずつ組合せることで定義され、例えば、上下方向および左右方向がともに「正面」である場合には顔の向きは真正面となる。また、検出状況記憶部212は、画像の受付数内で、言い換えれば後述する制御部220により取り込まれた画像数内で、顔位置、眼、鼻、耳および眼鏡の検出に成功した数を検出成功数として記憶する。なお、顔位置とは、例えば、顔画像における顔の左右の位置に該当し、眼とは顔画像における眼球の中心位置に該当し、鼻とは顔画像における鼻頭の位置に該当し、耳とは顔画像における耳たぶと顔の付け根の位置に該当する。

【0020】

以下、図2を用いて、検出状況記憶部212に記憶される検出状況の一例を説明する。図2は、実施例1に係る検出状況記憶部の説明に用いる図である。例えば、図2に示すように、検出状況記憶部212は、顔の向き「正面+正面」に対応付けて、画像の受付数「125」を記憶する。さらに、検出状況記憶部212は、顔の向き「正面+正面」に対応付けて、画像の受付数「125」における顔位置の検出成功数「125」、眼の検出成功数「100」、鼻の検出成功数「75」、耳の検出成功数「55」、眼鏡の検出成功数「125」を記憶する。

【0021】

なお、上述してきた検出状況記憶部212に記憶されている検出状況のデータは、後述する顔部位検出部221により更新され、後述する設定部222により口領域処理範囲の設定処理に用いられる。また、検出状況のデータは、ユーザが手動で削除しない限り全てのデータを記憶しておいてもよいが、最新のデータから所定の期間まで過去に遡ったデータだけを記憶するようにしてもよい。このようにすれば、検出状況記憶部212に記憶されている検出状況のデータを、後述する設定部222により口領域処理範囲の設定処理に必要な最小限のデータにとどめておくことができ、検出状況記憶部212の記憶領域を圧迫することがない。

【0022】

図1に示す処理結果記憶部213は、後述する特徴点検出部223による処理結果を記憶する。例えば、処理結果記憶部213は、特徴点検出部223による処理結果として、顔画像における口領域の高さ、口領域の幅、右口角位置および左口角位置を対応付けて記憶する。以下、図3を用いて、処理結果記憶部213に記憶される処理結果の一例を説明する。図3は、実施例1に係る処理結果記憶部の説明に用いる図である。例えば、図3に示すように、処理結果記憶部213は、処理結果ごとに一意に付与されるID「1」に対応付けて、口領域の高さ「H1」と、口領域の幅「W1」と、右口角位置「R1」と、左口角位置「L1」とを記憶する。なお、口領域の高さ「H1」および幅「W1」として、対応箇所の画素数や、モニタやディスプレイなどの出力デバイス上に表示される画像上の対応箇所の実距離などを採用することができる。

【0023】

図1に示すポイント付与テーブル214は、被験者の表情がどのような感情に起因するものであるか判定するためのポイント付与方法が定義されたテーブルである。例えば、ポイント付与テーブル214には、口領域の縦横比率、口領域の面積、右口角に上がり具合および左口角の上がり具合の各項目に対して付与されるポイント数が定義される。以下、図4および図5を用いて、ポイント付与テーブル214の一例を説明する。図4および図5は、実施例1に係るポイント付与テーブルの説明に用いる図である。

【0024】

例えば、図4に示すように、ポイント付与テーブル214には、口領域の縦横比率「H:W」、口領域の面積「H×W」、右口角の上がり具合「RH÷H」および左口角の上がり具合「LH÷H」の各項目が定義されている。

【0025】

ここで、図5を用いて、ポイント付与テーブル214に定義されている各項目について説明する。図5に示す「MA」は口領域を表し、図5に示す「L」は左口角位置を表し、図5に示す「R」は右口角位置を表す。また、図5に示す「LH」は左口角位置までの高さを表し、図5に示す「RH」は右口角位置までの高さを表す。また、図5に示す「H」は口領域の高さ、言い換えれば図5における口領域の縦の長さを表し、図5に示す「W」は口領域の幅、言い換えれば図5における口領域の横の長さを表す。また、図5に示すように、ポイント付与テーブル214に定義されている口領域の縦横比率「H:W」は、口領域の高さと幅との比に該当する。また、図5に示すように、ポイント付与テーブル214に定義されている口領域の面積「H×W」は、口領域の高さと幅との積に該当する。また、図5に示すように、右口角の上がり具合「RH÷H」は、口領域の高さと左口角位置までの高さとの比に該当する。また、図5に示すように、左口角の上がり具合「LH÷H」は、口領域の高さと左口角位置までの高さとの比に該当する。なお、図5に示すは左口角位置「L」および右口角位置「RH」は、例えば、後述する特徴点検出部223により口領域として決定された矩形領域の頂点の一つを基準とする画像上の座標値を採用できる。

【0026】

図4に戻り、ポイント付与テーブル214は、顔画像についての上述の各項目の値と、通常時における各項目の値との開き具合に応じて、表情に現れる感情ごとに付与すべきポイント数が定義されている。図4に示す通常度とは、被験者の表情に感情が現れていないではない状態、言い換えれば無表情の状態を示す度合いである。また、図4に示す恐怖度とは、被験者の表情に不安などの感情が表れている状態を示す度合いである。また、図4に示す笑い度とは、被験者の表情に快楽に紐付く感情が表れている状態を示す度合いである。また、図4に示す嫌悪度とは、被験者の表情に嫌悪感などの感情が表れている状態を示す度合いである。また、図4に示す悲しみ度とは、被験者の表情に悲しみの感情が表れている状態を示す度合いである。また、図4に示す冷笑度とは、被験者の表情に軽蔑や愚弄に紐付く感情が表れている状態を示す度合いである。

【0027】

そして、図4に示すように、ポイント付与テーブル214には、口領域の縦横比率「H:W」の値が通常時と同じである場合に、通常度に対し1ポイント付与すべき旨が定義されている。また、図4に示すように、ポイント付与テーブル214には、口領域の縦横比率「H:W」の値が通常時よりも大きい場合に、恐怖度、嫌悪度に対しそれぞれ1ポイント、笑い度に対し2ポイントを付与すべき旨が定義されている。また、図4に示すように、ポイント付与テーブル214には、口領域の縦横比率「H:W」の値が通常時よりも小さい場合に、悲しみ度に対し1ポイントを付与すべき旨が定義されている。

【0028】

ここで、上述した通常時に対応するデータには、以下に説明するいずれかのデータを設定する。例えば、所定のアクションを実行する以前の処理結果記憶部213に記憶されているデータに基づいて算出された口領域の面積、右口角の位置および左口角の位置を通常時のデータとして設定する。あるいは、所定のアクションを実行する以前の処理結果記憶部213に記憶されているデータのうち最も出現頻度の高いデータに基づいて算出された口領域の面積、右口角の位置および左口角の位置を通常時のデータとして設定する。あるいは、被験者が無表情であるときのデータを採取し、このデータに基づいて算出された口領域の面積、右口角の位置および左口角の位置を通常時のデータとして設定する。

【0029】

なお、図4に示すポイント付与テーブル214は、後述する判定部224によるポイントの付与時に参照される。

【0030】

図1に戻り、表情判定装置200は、顔部位検出部221、設定部222、特徴点検出部223および判定部224を有する。なお、顔部位検出部221、設定部222、特徴点検出部223および判定部224は、例えば、電子回路や集積回路に該当する。電子回路としては、例えば、CPU(Central Processing Unit)やMPU(Micro Processing Unit)がある。また、集積回路としては、例えば、ASIC(Application Specific Integrated Circuit)やFPGA(Field Programmable Gate Array)などがある。

【0031】

表情判定装置200は、上述した入力部120を介して、所定のアクションの実行指示をユーザから受け付けると、所定のアクションを実行する。ここで、所定のアクションとは、例えば、被験者の表情の変化を取得する為に静止画像や動画像の出力を実行するアクションに該当する。静止画像としては、例えば、ユニークな動物の写真や凄惨な場面の写真などがあげられる。動画像としては、コメディ映画やお笑い番組のほか、凄惨な現状を報道するドキュメンタリー番組などがあげられる。所定のアクションは、例えば、図1には示していない所定の制御部などが実行してもよい。

【0032】

顔部位検出部221は、画像記憶部211から顔画像を取り込み、取り込んだ顔画像内から、既存技術を用いて顔位置、眼、鼻、耳および眼鏡などの顔部位を検出する。さらに、顔部位検出部221は、顔画像における顔の向きを検出する。

【0033】

例えば、顔部位検出部221は、顔画像において垂直方向に隣り合って配列される各画素値を加算し、加算値の水平方向の分布から顔領域を特定することにより、顔の輪郭、つまり顔位置を検出する。また、顔部位検出部221は、顔画像から鼻の位置を検出し、検出された鼻の位置および顔の位置に基づいて顔の向きを検出する。なお、顔の位置や顔の向きの検出には、例えば、特許第4204336号公報に開示された技術を利用する。

【0034】

また、顔部位検出部221は、顔画像において眼である可能性のある領域について、時系列的に前後の画像データにおける変化に基づき眼の領域を特定する。なお、眼の位置の検出には、例えば、特許第4162503号公報に開示された技術を利用する。また、顔部位検出部221は、顔画像の水平方向の輝度が急激に変化する箇所を強調するフィルタ処理にて、水平方向に並ぶ輝度が低い画素列の両端を検出することで鼻孔を含む領域を検出する。なお、鼻の位置の検出には、例えば、特許第4364275号公報に開示された技術を利用する。また、顔部位検出部221は、顔画像から顔領域を検出し、顔領域を基準として耳を含むと推定される検出処理領域を算出し、検出処理領域において耳の輪郭を抽出する。なお、耳の位置の検出には、特開2007−257574号公報に開示された技術を利用する。また、顔部位検出部221は、顔画像の顔領域にフィルタ処理を行ってエッジの強い箇所を検出することにより眼鏡を検出する。なお、眼鏡の位置の検出には、例えば、特開2008−269182号公報に開示された技術を利用する。

【0035】

また、顔部位検出部221は、顔画像内から眼鏡を検出する場合を説明するが、これに限定されるものではなく、例えば、眼鏡以外のサングラスなどを検出するようにしてもよい。なお、サングラスの検出には、例えば、特開2010−157073号公報に開示された技術を利用する。

【0036】

設定部222は、顔部位検出部221により検出された顔部位に基づいて顔画像に対して口領域処理範囲を設定する。例えば、設定部222は、顔部位検出部221により顔部位の検出が行われると検出状況記憶部212の検出状況を更新する。つまり、設定部222は、顔の向きに対応する画像の受付数および顔部位の検出成功数を更新する。次に、設定部222は、顔の向きに対応する各顔部位の検出率を算出し、算出した検出率の高い順に各顔部位をソートする。続いて、設定部222は、顔部位検出部221により検出された顔部位の中から、検出率の上位2つの顔部位を取得し、取得した2つの顔部位を用いて口領域処理範囲を設定する。以下、図6〜12を用いて、設定部222による口領域処理範囲の設定について説明する。図6〜12は、実施例1に係る設定部の説明に用いる図である。

【0037】

例えば、設定部222は、検出率の上位2つの顔部位として、顔位置と鼻を取得したとする。この場合、設定部222は、図6に示すように、顔位置FPおよび鼻の位置NPを用いて、顔位置FPで得られる顔画像の領域のうち鼻の位置NPから下半分の領域α1を口領域処理範囲に設定する。

【0038】

また、設定部222は、検出率の上位2つの顔部位として、顔位置と眼を取得したとする。この場合、設定部222は、図7に示すように、顔位置FPおよび眼の位置EPを用いて、領域α1を口領域処理範囲に設定する。例えば、設定部222は、顔位置FPにより得られる顔の幅XのN%に相当する値を計算する。続いて、設定部222は、顔の幅XのN%に相当する値だけ眼の位置EPを基点として顔画像の下側に進んだ位置から、顔位置FPで得られる顔画像の領域の下半分の領域α2を口領域処理範囲として設定する。なお、上述したNの値は、例えば、眼と口との平均的な位置関係により予め設定されているものとする。

【0039】

また、設定部222は、検出率の上位2つの顔部位として、顔位置と耳を取得したとする。この場合、設定部222は、図8に示すように、顔位置FPおよび耳の位置ERPを用いて、顔位置FPで得られる顔画像の領域のうち耳の位置ERPから下半分の領域α3を口領域処理範囲に設定する。

【0040】

設定部222は、検出率の上位2つの顔部位として、顔位置と眼鏡を取得したとする。この場合、設定部222は、図9に示すように、顔位置FPおよび眼鏡の部品であるブリッジの位置GPを用いて、領域α4を口領域処理範囲に設定する。例えば、設定部222は、顔位置FPにより得られる顔の幅XのM%に相当する値を計算する。続いて、設定部222は、顔の幅XのM%に相当する値だけ眼鏡のブリッジの位置GPを基点として画像の下側に進んだ位置から、顔位置FPで得られる顔画像の領域の下半分の領域α4を口領域処理範囲として設定する。なお、上述したMの値は、例えば、眼鏡を構成する部品であるブリッジと口との平均的な位置関係により予め設定されているものとする。

【0041】

上述してきた図6〜図9では、設定部222は、検出率の上位2つの顔部位を用いて口領域処理範囲を設定する場合を説明したが、これに限られるものではなく、顔部位検出部221により検出された顔部位の1つを用いて口領域処理範囲を設定してもよい。例えば、設定部222は、図10に示すように、顔部位検出部221により検出された顔位置を用いて顔画像中の顔領域の矩形FAを求める。そして、設定部222は、顔領域の矩形FAの下半分の領域α5を口領域処理範囲に設定する。例えば、顔部位検出部221により検出された顔部位のうち信頼度の高い顔部位が顔位置のみである場合などには、設定部222は、顔位置のみを用いて口領域処理範囲に設定できる。

【0042】

なお、顔位置のみを用いた口領域処理範囲の設定は一例であり、顔部位検出部221により検出された顔部位のうち信頼度の高い顔部位が眼や鼻、耳のみの場合には、設定部222は、眼や鼻、耳のいずれかのみを用いて口領域処理範囲に設定することもできる。例えば、信頼度の高い顔部位が眼のみである場合、設定部222は、顔画像の領域のうち、顔の幅XのN%に相当する値だけ眼の位置EPを基点として顔画像の下側に進んだ位置から下半分の領域を口領域処理範囲に設定する。また、例えば、信頼度の高い顔部位が鼻のみである場合、設定部222は、顔画像の領域のうち鼻の位置NPから下半分の領域を口領域処理範囲に設定する。また、例えば、信頼度の高い顔部位が耳のみである場合、設定部222は、顔画像の領域のうち耳の位置ERPから下半分の領域を口領域処理範囲に設定する。

【0043】

また、上述してきた図6〜図9では、設定部222は、検出率の上位2つの顔部位として、顔位置と他の顔部位のいずれかを用いて口領域処理範囲を設定する場合を説明したが、これに限られるものではない。検出率の上位2つの顔部位が顔位置以外の2つの顔部位である場合、設定部222は、これらの顔部位を用いて口領域処理範囲を設定することもできる。

【0044】

例えば、設定部222は、検出率の上位2つの顔部位として、眼と鼻を取得したとする。この場合、設定部222は、図11に示すように、眼の位置EPおよび鼻の位置NPを用いて、顔画像の領域うち領域α6を口領域処理範囲に設定する。

【0045】

また、設定部222は、例えば、検出率の上位2つの顔部位として、眼と耳を取得したとする。この場合、設定部222は、図12に示すように、眼の位置EPおよび耳の位置ERPを用いて、顔画像の領域うち領域α7を口領域処理範囲に設定する。

【0046】

なお、設定部222は、顔位置、眼、鼻、耳および眼鏡などの顔部位の位置として、画像の左下の画素を基準とする画像上の座標値などを採用することができる。また、設定部222は、顔の幅Xとして、対応箇所の画素数や画像上の実距離などを採用できる。

【0047】

図1に示す特徴点検出部223は、設定部222により設定された口領域処理範囲から右口角および左口角を特徴点として検出する。例えば、特徴点検出部223は、設定部222により設定された口領域処理範囲内の画素分布に基づいて、この領域内において右口角および左口角を含む矩形の口領域を決定する。続いて、特徴点検出部223は、決定した口領域に対して、右口角用のフィルタおよび左口角用のフィルタをそれぞれ用いてフィルタ処理を行う。そして、特徴点検出部223は、右口角用のフィルタを用いたフィルタ処理により得られるフィルタ応答のピークとなる顔画像の位置を右口角として検出する。さらに、特徴点検出部223は、左口角用のフィルタを用いたフィルタ処理により得られるフィルタ応答がピークとなる顔画像の位置を左口角として検出する。以下、図13〜15を用いて特徴点検出部223について説明する。図13〜図15は、実施例1に係る特徴点検出部の説明に用いる図である。

【0048】

まず、図13を用いて特徴点検出部223による口領域の決定について説明する。図13に示すαは、口領域処理範囲を示す。また、図13に示すx軸は顔画像の対応位置を示し、図13に示すy軸は顔画像上の画素値を示す。また、図13に示すP1およびP2はx軸の方向に画素値を投影した結果を示す。特徴点検出部223は、口領域処理範囲の画素値を図13に示すx軸の方向にそれぞれ投影して、各x軸方向での画素値の投影結果を取得する。そして、特徴点検出部223は、口領域処理範囲にて、各x軸方向の画素値の投影結果が交わる矩形領域MAを口領域として決定する。

【0049】

次に、図14を用いて特徴点検出部223による左口角検出処理範囲および右口角検出処理範囲の決定について説明する。図14に示すβ1は、左口角を検出するための左口角検出処理範囲の一例であり、図14に示すβ2は、右口角を検出するための右口角検出処理範囲の一例である。なお、図14に示すMAは口領域であり、図13に示すMAと同一である。

【0050】

図14に示すように、特徴点検出部223は、口領域処理範囲にて決定した口領域MAに対して、左口角検出処理範囲β1および右口角検出処理範囲β2をそれぞれ設定する。例えば、特徴点検出部223は、図14に示すように、口領域MAである矩形領域の左の短辺の中点を中心とする所定サイズの矩形領域を左口角検出処理範囲β1に設定する。同様に、特徴点検出部223は、図14に示すように、口領域MAである矩形領域の右の短辺の中点を中心とする所定サイズの矩形領域を右口角検出処理範囲β2に設定する。

【0051】

続いて、図15を用いて特徴点検出部223による左口角および右口角の検出について説明する。図15に示すF1は左口角を検出する為のフィルタの一例であり、図15に示すF2は左口角を検出する為のフィルタの一例である。図15にて点線で示すように、口形状の類似領域が画像上にある場合に、フィルタF1は、左口角に相当する位置でフィルタの応答がピークとなるようにフィルタの値が設定される。同様に、フィルタF2は、口形状の類似領域が画像上にある場合に、右口角に相当する位置でフィルタの応答がピークとなるようにフィルタの値が設定される。

【0052】

そこで、特徴点検出部223は、まず、図15に示すフィルタF1を用いて、図14に示す左口角検出処理範囲をフィルタ処理する。そして、特徴点検出部223は、フィルタ処理により得られるフィルタ応答がピークとなる左口角検出処理範囲内の左口角の位置を検出する。同様に、特徴点検出部223は、図15に示すフィルタF2を用いて、図14に示す右口角検出処理範囲をフィルタ処理する。そして、特徴点検出部223は、フィルタ処理により得られるフィルタ応答がピークとなる右口角検出処理範囲内の右口角の位置を検出する。そして、特徴点検出部223は、検出した左口角の位置および右口角の位置を、口領域として決定した矩形領域MAの頂点の一つを基準とする画像上の座標を求め、左口角の位置および右口角の位置として決定する。

【0053】

左口角および右口角の検出を完了すると、特徴点検出部223は、口領域の縦および横の長さ、口領域における右口角の位置および左口角の位置を処理結果記憶部213に保存する。なお、口領域の縦および横の長さは、例えば、対応箇所の画素数や画像上の実距離を採用できる。また、右口角および左口角の位置は、上述したように、口領域として決定した矩形領域の頂点の一つを基準とする画像上の座標値を採用できる。

【0054】

図1に示す判定部224は、特徴点検出部223により検出された左口角および右口角の位置に基づいて表情判定処理を実行する。例えば、判定部224は、ポイント付与テーブル214を参照し、特徴点検出部223により検出された口領域の縦横比率、口領域の面積、口領域における左口角および右口角の位置に応じて、被験者の表情を判定するためのポイントを付与する処理を実行する。以下、図16を用いて、判定部224について説明する。図16は、実施例1に係る判定部の説明に用いる図である。図16に示すMAは口領域であり、図16に示すLは左口角の位置であり、図16に示すRは右口角の位置である。

【0055】

また、図16に示す16Aは、口領域の面積、口領域における右口角の位置および左口角の位置の通常時のデータを示す。なお、通常時のデータについては上述したが、判定部224は、以下に説明するいずれかのデータを利用する。例えば、判定部224は、所定のアクションを実行する以前の処理結果記憶部213に記憶されているデータに基づいて算出された口領域の面積、右口角の位置および左口角の位置のデータを採用する。あるいは、判定部224は、所定のアクションを実行する以前の処理結果記憶部213に記憶されているデータのうち最も出現頻度の高いデータに基づいて算出された口領域の面積、右口角の位置および左口角の位置のデータを利用する。あるいは、判定部224は、被験者が無表情であるときのデータを採取し、このデータに基づいて算出された口領域の面積、右口角の位置および左口角の位置のデータを利用する。また、図16に示す16Bおよび16Cは、特徴点検出部223により検出された口領域の面積、口領域における左口角および右口角の位置の一例を示す。

【0056】

判定部224は、特徴点検出部223による検出結果と通常時との比較結果をポイント付与テーブル214に照らし合わせて、口領域の縦横比率、口領域の面積、右口角に上がり具合および左口角の上がり具合の各項目に対してポイントを付与する。

【0057】

例えば、判定部224は、16Aと16Bとを比較すると、口領域の縦横比率が同じであるので、通常度に1ポイント付与する。また、判定部224は、16Aと16Bとを比較すると、口領域の面積が通常時と同じであるので、通常度に1ポイント付与する。また、判定部224は、16Aと16Bとを比較すると、右口角の上がり具合が通常時よりも小さいので、悲しみ度、恐怖度、嫌悪度にそれぞれ1ポイント付与する。また、判定部224は、16Aと16Bとを比較すると、左口角の上がり具合が通常時よりも小さいので、恐怖度に1ポイント付与する。なお、判定部224は、16Aと16Bとを比較した結果、右口角の位置と左口角の位置とに差異はないので、冷笑度に対するポイントは付与しない。口領域の縦横比率が同じであるので、通常度に1ポイント付与する。

【0058】

また、判定部224は、16Aと16Cとを比較すると、口領域の縦横比率が通常時よりも大きいので、恐怖度および嫌悪度にそれぞれ1ポイントを付与し、笑い度に2ポイントを付与する。また、判定部224は、16Aと16Cとを比較すると、口領域の面積が通常時と同じであるので、笑い度に2ポイントを付与し、恐怖度に1ポイントを付与する。また、判定部224は、16Aと16Cとを比較すると、右口角の上がり具合が通常時よりも大きいので、笑い度に3ポイント付与する。また、判定部224は、16Aと16Cとを比較すると、左口角の上がり具合が通常時よりも大きいので、笑い度に3ポイント付与する。なお、判定部224は、16Aと16Cとを比較した結果、右口角の位置と左口角の位置とに差異がないので、冷笑度に対するポイントは付与しない。

【0059】

そして、判定部224は、表情判定の処理を完了すべきかどうかを判定する。そして、判定部224は、判定の結果、処理を完了すべきである場合には、所定のアクションに対応付けて、表情判定の処理結果を出力する。表情判定の処理結果としては、上述したように、例えば、アクションとして出力された静止画像の内容に対応付けて、通常度、恐怖度、嫌悪度、悲しみ度、冷笑度に対して付与されたポイントが出力される。

【0060】

なお、判定部224は、例えば、所定のアクションとして静止画像の出力を実行した場合には、上述したポイントの付与を持って処理を完了すべきものと判定する。また、判定部224は、所定のアクションとして動画像の出力を実行した場合、動画像の再生終了を条件に処理を完了すべきものと判定する。なお、判定部224は、動画像の再生が終了していない場合には、表情判定の処理を継続すべきものと判定し、次に取得した顔画像について顔部位の検出を行うように顔部位検出部221に依頼する。

【0061】

[表情判定装置による処理(実施例1)]

続いて、図17を用いて、表情判定装置による処理の流れを説明する。図17は、実施例1に係る表情判定装置による処理の流れを示す図である。なお、図17に示す処理は、例えば、制御部220によりユーザから所定のアクションの実行指示を受け付けたことが判定されると開始される。

【0062】

図17に示すように、表情判定装置200は所定のアクションを実行する(ステップS101)。次に、顔部位検出部221は、画像記憶部211から顔画像を取り込み(ステップS102)、取り込んだ顔画像内から、既存技術を用いて顔位置、眼、鼻、耳および眼鏡などの顔部位を検出する(ステップS103)。続いて、設定部222は口領域処理範囲の設定処理を実行する(ステップS104)。なお、口領域処理範囲の設定処理については後述する。

【0063】

次に、特徴点検出部223は、設定部222により設定された口領域処理範囲内における口領域を決定する(ステップS105)。続いて、特徴点検出部223は、口領域から、右口角を検出するための右口角検出処理範囲を設定する(ステップS106)。そして、特徴点検出部223は、右口角検出処理範囲から右口角を検出する(ステップS107)。

【0064】

次に、特徴点検出部223は、口領域から、左口角を検出するための左口角検出処理範囲を設定する(ステップS108)。続いて、特徴点検出部223は、左口角検出処理範囲から左口角を検出する(ステップS109)。そして、特徴点検出部223は、口領域の縦および横の長さ、口領域における右口角の位置および左口角の位置を処理結果記憶部213に保存する(ステップS110)。

【0065】

次に、判定部224は特徴点検出部223により検出された口領域の縦横比率、口領域の面積、口領域における左口角および右口角の位置に基づいて表情判定を実行する(ステップS111)。続いて、判定部224は、処理を完了すべきか否かを判定する(ステップS112)。そして、処理を完了すべきものと判定した場合には(ステップS112,Yes)、判定部224は、所定のアクションに対応付けて表情判定結果を出力する(ステップS113)。一方、処理を完了すべきものと判定しなかった場合には(ステップS112,No)、判定部224は、上述したステップS102に処理を移行させる。

【0066】

続いて、図18を用いて、口領域処理範囲の設定処理の流れを説明する。図18は、実施例1に係る口領域処理範囲の設定処理の流れを示す図である。図18に示すように、設定部222は、顔部位検出部221により顔部位の検出が行われると検出状況記憶部212の検出状況を更新する(ステップS201)。

【0067】

次に、設定部222は、顔の向きに対応する各顔部位の検出率を算出し(ステップS202)、算出した検出率の高い順に各顔部位をソートする(ステップS203)。続いて、設定部222は、検出率の上位2つの顔部位を取得し(ステップS204)、取得した2つの顔部位を用いて口領域処理範囲を設定する(ステップS205)。

【0068】

[実施例1による効果]

上述してきたように、実施例1では、顔画像から複数の顔部位を検出し、検出した複数の顔部位の少なくとも1つを用いて口領域処理範囲を設定して、口領域処理範囲から右口角および左口角の位置を検出する。仮に、表情判定に用いる右口角および左口角の位置を検出するための口領域処理範囲を予め設定することができなければ、顔画像全体について右口角および左口角の位置の検出処理を行う必要がある。これに対し、実施例1によれば、特徴点である右口角および左口角の位置を検出するための口領域処理範囲を予め設定するので、顔画像全体について処理する場合に比べて、表情判定に用いる特徴点を高速に検出できる。

【0069】

また、実施例1では、口領域処理範囲の画素分布に基づいて右口角および左口角を含む口領域を決定し、決定した口領域の縦横比率、口領域の面積および口領域における右口角の位置および左口角の位置に応じたポイントを付与することで被験者の表情を判定する。このため、実施例1によれば、口や口角に現れる変化に応じた細かいスコアリンクができ、被験者の表情を簡易かつ詳細に判定できる。

【0070】

また、実施例1では、顔画像における顔の向きを検出し、顔の向きに対応付けて顔画像の受付数、該受付数における顔部位の検出成功数をそれぞれ検出状況記憶部212に保存する。続いて、実施例1では、顔の向きに対応する顔画像の受付数、この受付数における顔部位の検出成功数を取得し、取得した受付数および検出成功数を用いて顔部位ごとの検出率を算出する。そして、実施例1では、検出率に基づいて、検出した顔部位の中から少なくとも1つを取得し、取得した顔部位を用いて口領域処理範囲を設定する。このため、実施例1によれば、顔画像における顔の向きに応じて、より信頼度の高い顔部位を選択でき、選択した顔部位により口領域処理範囲を精度良く設定できる。

【0071】

また、実施例1において、検出した顔部位の中から、検出率の高い顔部位を顔向きに関係なく選択するようにしてもよい。このようにすれば、顔画像の撮影状況に関係なく、現状で最も信頼度の高い顔部位を用いて口領域処理範囲を設定できる。

【0072】

また、実施例1では、表情の判定に用いる特徴点以外、言い換えれば右口角および左口角以外の他の顔部位を用いて、右口角および左口角を探索する口領域処理範囲を設定する場合を説明した。しかしながら、この場合に限定されるものではなく、例えば、眼が探索対象とする場合には、眼以外の他の顔部位を用いて眼を探索する領域を設定するなど、実施例1で説明した方法は、口角以外の他の顔部位を探索する領域の設定にも同様に適用できる。

【0073】

なお、表情判定装置200は、様々な状況が映し出された静止画像や動画像の出力を所定のアクションとして実行する場合を説明したが、これに限定されるものではない。例えば、表情判定装置200のユーザが被験者と楽しい話題や悲しい話題の会話をするというアクションを実行してもよい。この場合、会話中の被験者の顔画像を取得し、被験者の表情を判定する。

【0074】

また、表情判定装置200は、例えば、パーソナルコンピュータやスマートフォンなどの情報処理装置に実装することができる。例えば、医療従事者が使用する情報処理装置に表情判定装置200が実装される場合には、表情判定装置200による表情判定の処理結果がカルテシステムなどに出力される。カルテシステムでは、被験者である患者の情報に関連付けて表情判定の処理結果が保存される。また、例えば、所定のwebサイトにアクセスするユーザのスマートフォンに表情判定装置200が実装される場合には、表情判定装置200による表情判定の処理結果が、例えば、webサイトを運営するサーバなどに出力される。webサイトを運営するサーバでは、webサイトにアクセス中のユーザの情報に関連付けて表情判定の処理結果が保存される。

【0075】

また、表情判定装置200は、例えば、車両に搭載されるマイコンに実装することもできる。この場合、表情判定装置200は、車両の移動中、運転者の顔画像を継続的に取得して運転者の表情を判定し、表情の判定結果を車両制御ユニットに出力する。車両制御ユニットでは、運転者の表情の判定結果に応じて警告の報知や車両制御が実行される。

【実施例2】

【0076】

以下、本願の開示する表情判定プログラムおよび表情判定装置の他の実施形態を説明する。

【0077】

(1)装置構成等

例えば、図1に示した表情判定装置200の機能ブロックの構成は概念的なものであり、必ずしも物理的に図示の如く構成されていることを要しない。例えば、図1に示した顔部位検出部221を、顔位置の検出機能と顔部位の検出機能とに機能的または物理的に分離してもよい。このように、例えば、図1に示した表情判定装置200の機能ブロックの全部または一部を、各種の負荷や使用状況などに応じて、任意の単位で機能的または物理的に分散または統合して構成することができる。

【0078】

(2)表情判定プログラム

また、上述の実施例にて説明した表情判定装置200により実行される各種の処理は、例えば、電子回路や集積回路などの電子機器で所定のプログラムを実行することによって実現できる。

【0079】

そこで、以下では、図19を用いて、上述の実施例にて説明した表情判定装置200により実行される処理と同様の機能を実現する表情判定プログラムを実行するコンピュータの一例を説明する。図19は、表情判定プログラムを実行する電子機器の一例を示す図である。

【0080】

図19に示すように、表情判定装置200により実行される各種処理を実現する電子機器300は、各種演算処理を実行するCPU(Central Processing Unit)310を有する。また、図19に示すように、電子機器300は、外部からのデータ入力を受け付ける入力インターフェース320、カメラ画像を取得するためのカメラインターフェース330、外部へデータを出力する出力インターフェース340を有する。

【0081】

また、図19に示すように、電子機器300は、CPU310により各種処理を実現するためのプログラムやデータ等を記憶するハードディスク装置350と、各種情報を一時記憶するRAM(Random Access Memory)などのメモリ360とを有する。そして、各装置310〜360は、バス370に接続される。

【0082】

なお、CPU310の代わりに、例えば、MPU(Micro Processing Unit)などの電子回路、ASIC(Application Specific Integrated Circuit)やFPGA(Field Programmable Gate Array)などの集積回路を用いることもできる。また、メモリ360の代わりに、フラッシュメモリ(flash memory)などの半導体メモリ素子を用いることもできる。

【0083】

ハードディスク装置350には、表情判定装置200の機能と同様の機能を発揮する表情判定プログラム351および表情判定用データ352が記憶されている。なお、この表情判定プログラム351を適宜分散させて、ネットワークを介して通信可能に接続された他のコンピュータの記憶部に記憶させておくこともできる。

【0084】

そして、CPU310が、表情判定プログラム351をハードディスク装置350から読み出してメモリ360に展開することにより、図19に示すように、表情判定プログラム351は表情判定プロセス361として機能する。表情判定プロセス361は、ハードディスク装置350から読み出した表情判定用データ352等の各種データを適宜メモリ360上の自身に割当てられた領域に展開し、この展開した各種データに基づいて各種処理を実行する。

【0085】

なお、表情判定プロセス361は、例えば、上述した表情判定装置200の制御部220にて実行される処理、例えば、図17、図18を用いて説明した処理を含む。

【0086】

なお、表情判定プログラム351については、必ずしも最初からハードディスク装置350に記憶させておく必要はない。例えば、電子機器300が実装されたECUへ対応ドライブを接続可能なフレキシブルディスク(FD)、CD−ROM、DVDディスク、光磁気ディスク、ICカードなどの「可搬用の物理媒体」に各プログラムを記憶させておく。そして、電子機器300がこれらから各プログラムを読み出して実行するようにしてもよい。

【0087】

さらには、公衆回線、インターネット、LAN、WANなどを介して、電子機器300が実装されたECUに接続される「他のコンピュータ(またはサーバ)」などに各プログラムを記憶させておく。そして、電子機器300がこれらから各プログラムを読み出して実行するようにしてもよい。

【0088】

以上の実施例を含む実施形態に関し、さらに以下の付記を開示する。

【0089】

(付記1)コンピュータに、

入力画像を受付け、

前記入力画像から顔領域を検出し、

前記顔領域から第一の特徴点を検出し、

前記顔領域から第二の特徴点を検出し、

前記第一の特徴点と前記第二の特徴点のうち、少なくとも一つの特徴点を選択し、

選択した前記少なくとも一つの特徴点に基づいて、前記顔領域に領域を設定し、

設定した前記領域から、前記第一の特徴点および前記第二の特徴点とは異なる第三の特徴点を検出し、

検出した前記第三の特徴点に基づいて前記入力画像における表情を判定する

処理を実行させることを特徴とする表情判定プログラム。

【0090】

(付記2)前記第三の特徴点を検出する処理は、前記領域内の画素値の分布に基づいて前記第三の特徴点を含む矩形領域を決定して、該矩形領域から前記第三の特徴点を検出し、

前記表情を判定する処理は、決定した前記矩形領域の縦横比率、該矩形領域の面積および該矩形領域における前記第三の特徴点の位置のいずれか一つ又は複数に基づいて、前記表情を判定することを特徴とする付記1に記載の表情判定プログラム。

【0091】

(付記3)前記コンピュータに、

前記入力画像における顔の向きを検出し、

前記顔の向きに対応付けて、前記入力画像の受付数、該受付数における前記第一の特徴点の検出成功数および前記第二の特徴点の検出成功数をそれぞれ記憶部に保存する

処理をさらに実行させ、

前記少なくとも一つの特徴点を選択する処理は、前記顔の向きに対応する前記受付数、前記第一の特徴点の検出成功数および前記第二の特徴点の検出成功数を前記記憶部からそれぞれ取得し、取得した前記受付数、前記第一の特徴点の検出成功数および前記第二の特徴点の検出成功数に基づいて、前記第一の特徴点および前記第二の特徴点の検出率をそれぞれ算出し、算出した検出率に基づいて、前記第一の特徴点と前記第二の特徴点のうち、少なくとも一つの特徴点を選択することを特徴とする付記1に記載の表情判定プログラム。

【0092】

(付記4)前記コンピュータに、

前記入力画像の受付前に所定のアクションを実行し、

前記表情を判定する処理の処理結果と前記所定のアクションの情報とを対応付けて出力する

処理をさらに実行させることを特徴とする付記1に記載の表情判定プログラム。

【0093】

(付記5)入力画像から顔領域を検出し、該顔領域に含まれる第一の特徴点および第二の特徴点を検出する顔部位検出部と、

前記顔部位検出部により抽出された第一の特徴点と第二の特徴点のうち、少なくとも一つの特徴点を選択し、選択した少なくとも一つの特徴点に基づいて前記顔領域に領域を設定する設定部と、

前記設定部により設定された領域から、前記第一の特徴点および前記第二の特徴点とは異なる第三の特徴点を検出する特徴点検出部と、

前記特徴点検出部により検出された第三の特徴点に基づいて前記入力画像における表情を判定する判定部と

を有することを特徴とする表情判定装置。

【0094】

(付記6)前記特徴点検出部は、前記設定部により設定された前記領域内の画素分布に基づいて前記第三の特徴点を含む矩形領域を決定して、該矩形領域から前記第三の特徴点を検出し、

前記判定部は、前記検出部により決定された前記矩形領域の縦横比率、該矩形領域の面積および該矩形領域における前記第三の特徴点の位置のいずれか一つ又は複数に基づいて、前記表情を判定することを特徴とする付記5に記載の表情判定装置。

【0095】

(付記7)前記顔部位検出部は、前記入力画像における顔の向きを検出して、検出した顔の向きに対応付けて、前記入力画像の処理数、前記第一の特徴点の検出成功数および前記第二の特徴点の検出成功数をそれぞれ記憶部に格納し、

前記特徴点検出部は、前記顔部位検出部により検出された顔の向きに対応する前記受付数、前記第一の特徴点の検出成功数および前記第二の特徴点の検出成功数を前記記憶部からそれぞれ取得し、取得した前記受付数、前記第一の特徴点の検出成功数および前記第二の特徴点の検出成功数に基づいて、前記第一の特徴点および前記第二の特徴点の検出率をそれぞれ算出し、算出した検出率に基づいて、前記第一の特徴点と前記第二の特徴点のうち、少なくとも一つの特徴点を選択することを特徴とする付記5に記載の表情判定装置。

【0096】

(付記8)前記判定部は、前記入力画像の受付前に所定のアクションを実行し、前記表情の判定結果と前記所定のアクションの情報とを対応付けて出力することを特徴とする付記5に記載の表情判定装置。

【符号の説明】

【0097】

100 情報処理装置

110 撮像装置

120 入力部

130 出力部

200 表情判定装置

211 画像記憶部

212 検出状況記憶部

213 処理結果記憶部

214 ポイント付与テーブル

221 顔部位検出部

222 設定部

223 特徴点検出部

224 判定部

300 電子機器

310 CPU

320 入力インターフェース

330 カメラインターフェース

340 出力インターフェース

350 ハードディスク装置

351 表情判定プログラム

352 表情判定用データ

360 メモリ

361 表情判定プロセス

370 バス

【技術分野】

【0001】

本願の開示する技術は、表情判定プログラムおよび表情判定装置に関連する。

【背景技術】

【0002】

従来、顔を撮影した顔画像から特徴部分を検出し、検出した特徴部分に基づいて顔の表情を判定する技術がある。

【0003】

上述した表情を判定する技術の中には、鼻の先端、左口角および右口角の位置を用いて表情を判定するものがある。例えば、この技術では、入力画像から顔が存在する顔画像領域を抽出し、顔画像領域から鼻の先端、左口角および左口角の位置を特徴点としてそれぞれ抽出する。そして、この技術では、鼻の先端を基準として、鼻の先端と左右の口角位置とのなす角度を計測し、計測した角度の時間変化から表情を判定する。また、上述した表情を判定する技術の中には、真顔の画像、言い換えれば無表情の状態の画像から予め抽出された複数の参照特徴を用いて表情を判定するものもある。ここで、参照特徴とは、入力画像における眼や鼻、口などの顔の特徴部分をパターンマッチングにより認識するためのテンプレートなどに相当する。この技術では、入力画像から抽出した特徴量と照合するための参照特徴を予め用意する。そして、この技術では、入力画像から表情の判定に必要な各特徴量を抽出し、抽出した特徴量と複数の参照特徴の特徴量との差分量を計算することで、顔の各特徴量について参照特徴に対する変化量を算出する。そして、この技術では、算出した変化量から特徴ごとの得点を算出し、算出した得点の総和から表情を判定する。

【0004】

また、上述した表情を判定する技術に関連して、顔画像から目的とする特徴部分を高速に検出するものがある。例えば、この技術では、下瞼および上瞼を含む眼部を検出対象とし、顔画像から鼻孔を検出し、鼻孔の位置に基づいて眼部の探索領域を設定する。そして、この技術では、設定した領域の下半分から下瞼を検出し、下瞼の上の領域から上瞼を検出する。なお、この技術では、上瞼と下瞼に挟まれた画素数に基づいて、例えば、眼が開かれた状態か、あるいは眼が閉ざれた状態かのいずれかを判定する。

【先行技術文献】

【特許文献】

【0005】

【特許文献1】特開2009−98901号公報

【特許文献2】特開2005−56388号公報

【特許文献3】特開2008−146172号公報

【発明の概要】

【発明が解決しようとする課題】

【0006】

ところで、表情判定に必要となる特徴を顔画像から高速に検出しつつ表情判定を行うことも考えられる。例えば、上述したように、鼻孔の位置に基づいて眼部の探索領域を設定する技術では、最終的な検出対象である眼部の探索領域を設定する場合に、眼部とは異なる鼻孔を予め検出する必要がある。しかしながら、カメラなどの撮影装置に対する顔の向きや顔画像の撮影状況によっては、鼻孔を予め検出することができない場合もある。このような場合には、鼻孔の位置に基づいて眼部の探索領域を設定できない。

【0007】

例えば、鼻の先端の位置に基づいて口角の探索領域を設定する場合を考えてみる。この場合、上述した鼻孔の位置に基づいて眼部の探索領域を設定する技術と同様に、顔の向きや顔画像の撮影状況によっては、鼻の先端の位置を予め検出することができない可能性がある。このため、表情判定に必要となる特徴を顔画像から高速に検出しつつ表情判定を行うことは現状困難である。

【0008】

開示の技術は、上記に鑑みてなされたものであって、表情判定に用いる特徴点を高速に検出することが可能な表情判定プログラムおよび表情判定装置を提供することを目的とする。

【課題を解決するための手段】

【0009】

本願の開示する技術は、一つの態様において、コンピュータに、次の各処理を実行させるものである。すなわち、コンピュータに、入力画像を受付け、前記入力画像から顔領域を検出し、前記顔領域から第一の特徴点を抽出し、前記顔領域から第二の特徴点を抽出し、前記第一の特徴点と前記第二の特徴点のうち、少なくとも一つの特徴点を選択する処理を実行させる。また、コンピュータに、選択した前記少なくとも一つの特徴点に基づいて前記顔領域に領域を設定し、設定した前記領域から、前記第一の特徴点および前記第二の特徴点とは異なる第三の特徴点を検出する処理を実行させる。また、コンピュータに、検出した前記第三の特徴点に基づいて前記入力画像における表情を判定する処理を実行させる。

【発明の効果】

【0010】

本願の開示する技術の一つの態様によれば、表情判定に用いる特徴点を高速に検出できる。

【図面の簡単な説明】

【0011】

【図1】図1は、実施例1に係る表情判定装置の構成を示す機能ブロック図である。

【図2】図2は、実施例1に係る検出状況記憶部の説明に用いる図である。

【図3】図3は、実施例1に係る処理結果記憶部の説明に用いる図である。

【図4】図4は、実施例1に係るポイント付与テーブルの説明に用いる図である。

【図5】図5は、実施例1に係るポイント付与テーブルの説明に用いる図である。

【図6】図6は、実施例1に係る設定部の説明に用いる図である。

【図7】図7は、実施例1に係る設定部の説明に用いる図である。

【図8】図8は、実施例1に係る設定部の説明に用いる図である。

【図9】図9は、実施例1に係る設定部の説明に用いる図である。

【図10】図10は、実施例1に係る設定部の説明に用いる図である。

【図11】図11は、実施例1に係る設定部の説明に用いる図である。

【図12】図12は、実施例1に係る設定部の説明に用いる図である。

【図13】図13は、実施例1に係る特徴点検出部の説明に用いる図である。

【図14】図14は、実施例1に係る特徴点検出部の説明に用いる図である。

【図15】図15は、実施例1に係る特徴点検出部の説明に用いる図である。

【図16】図16は、実施例1に係る判定部の説明に用いる図である。

【図17】図17は、実施例1に係る表情判定装置による処理の流れを示す図である。

【図18】図18は、実施例1に係る口領域処理範囲の設定処理の流れを示す図である。

【図19】図19は、表情判定プログラムを実行する電子機器の一例を示す図である。

【発明を実施するための形態】

【0012】

以下に、図面を参照しつつ、本願の開示する表情判定プログラムおよび表情判定装置の一実施形態について詳細に説明する。後述する実施例は一実施形態にすぎず、本願の開示する表情判定プログラムおよび表情判定装置を限定するものではない。また、後述する各実施例は処理内容に矛盾を生じさせない範囲で適宜組み合わせることもできる。

【0013】

以下に説明する実施例1では、例えば、被験者に対し所定のアクションを実行し、所定のアクションに対する被験者の反応を撮影した画像を用いて被験者の表情を判定する場合を例に挙げる。ここで、所定のアクションとは、様々な静止画像や動画像の出力に該当し、例えば、一般的に人が悲しいと感じる画像や楽しいと感じる画像の出力に該当する。

【実施例1】

【0014】

[表情判定装置の構成(実施例1)]

図1は、実施例1に係る表情判定装置の構成を示す機能ブロック図である。図1に示すように、実施例1に係る表情判定装置200は、撮影装置110、入力部120および出力部130に接続する。なお、表情判定装置200は、撮影装置110、入力部120および出力部130を内部に有していてもよい。

【0015】

図1に示す撮影装置110は、例えば、表情判定の対象となる被験者の顔を撮影し、撮影した被験者の顔の画像を表情判定装置200に送出する。撮影装置110は、例えば、カメラであり、被験者の顔を撮影可能な位置に設置される。

【0016】

入力部120は、表情判定装置200のユーザから指示を入力する。例えば、入力部120は、所定のアクションとして被験者に閲覧させるための画像等の選択をユーザから受け付けて入力する。なお、入力部120は、キーボードやマウス、タッチパッドなどの入力デバイスを有する。出力部130は、所定のアクションとして実行される画像を出力したり、後述する判定部224による判定結果などを出力したりする。なお、出力部130は、モニタやディスプレイなどの出力デバイスを有し、入力部120が有する入力デバイスと協働して、ポインティングデバイス機能を実現することもできる。

【0017】

図1に示す表情判定装置200は、画像記憶部211、検出状況記憶部212、処理結果記憶部213およびポイント付与テーブル214を有する。なお、画像記憶部211、検出状況記憶部212、処理結果記憶部213およびポイント付与テーブル214は、例えば、RAM(Random Access Memory)やフラッシュメモリ(flash memory)などの半導体メモリ素子である。表情判定装置200は、撮影装置100から被験者の顔の画像(以下、顔画像と表記する)を受け付けると、受け付けた顔の画像を、後述する画像記憶部211に格納する。

【0018】

図1に示す画像記憶部211は、撮影装置100から受け付けた顔画像を記憶する。画像記憶部211は、例えば、撮影装置100から受け付けた画像に対して、撮影装置100から受け付けた順に降順の数字からなる識別情報を付与し、識別情報を付与した画像を被験者の識別情報に対応付けて記憶する。なお、識別情報として付与する数字は一例に過ぎず、英字や、英字と数字との組合せなど、被験者ごとに画像を一意に識別できればよい。

【0019】

図1に示す検出状況記憶部212は、後述する顔部位検出部221による検出状況を記憶する。例えば、検出状況記憶部212は、顔画像における被験者の顔の向きに対応づけて、画像の受付数と、この受付数における顔部位の検出成功数とを記憶する。なお、画像の受付数は、後述する顔部位検出部221により画像記憶部211から読み出され、後述する顔部位検出部221により処理された画像数に該当する。検出状況記憶部212は、情報処理装置100が有するディスプレイやモニタなどに対する被験者の顔の向きとして、例えば、9つの方向に区分けされた顔の向きを記憶する。この9つの方向は、上、正面、下の3つの上下方向と、左、正面、右の3つの左右方向とをそれぞれ1つずつ組合せることで定義され、例えば、上下方向および左右方向がともに「正面」である場合には顔の向きは真正面となる。また、検出状況記憶部212は、画像の受付数内で、言い換えれば後述する制御部220により取り込まれた画像数内で、顔位置、眼、鼻、耳および眼鏡の検出に成功した数を検出成功数として記憶する。なお、顔位置とは、例えば、顔画像における顔の左右の位置に該当し、眼とは顔画像における眼球の中心位置に該当し、鼻とは顔画像における鼻頭の位置に該当し、耳とは顔画像における耳たぶと顔の付け根の位置に該当する。

【0020】

以下、図2を用いて、検出状況記憶部212に記憶される検出状況の一例を説明する。図2は、実施例1に係る検出状況記憶部の説明に用いる図である。例えば、図2に示すように、検出状況記憶部212は、顔の向き「正面+正面」に対応付けて、画像の受付数「125」を記憶する。さらに、検出状況記憶部212は、顔の向き「正面+正面」に対応付けて、画像の受付数「125」における顔位置の検出成功数「125」、眼の検出成功数「100」、鼻の検出成功数「75」、耳の検出成功数「55」、眼鏡の検出成功数「125」を記憶する。

【0021】

なお、上述してきた検出状況記憶部212に記憶されている検出状況のデータは、後述する顔部位検出部221により更新され、後述する設定部222により口領域処理範囲の設定処理に用いられる。また、検出状況のデータは、ユーザが手動で削除しない限り全てのデータを記憶しておいてもよいが、最新のデータから所定の期間まで過去に遡ったデータだけを記憶するようにしてもよい。このようにすれば、検出状況記憶部212に記憶されている検出状況のデータを、後述する設定部222により口領域処理範囲の設定処理に必要な最小限のデータにとどめておくことができ、検出状況記憶部212の記憶領域を圧迫することがない。

【0022】

図1に示す処理結果記憶部213は、後述する特徴点検出部223による処理結果を記憶する。例えば、処理結果記憶部213は、特徴点検出部223による処理結果として、顔画像における口領域の高さ、口領域の幅、右口角位置および左口角位置を対応付けて記憶する。以下、図3を用いて、処理結果記憶部213に記憶される処理結果の一例を説明する。図3は、実施例1に係る処理結果記憶部の説明に用いる図である。例えば、図3に示すように、処理結果記憶部213は、処理結果ごとに一意に付与されるID「1」に対応付けて、口領域の高さ「H1」と、口領域の幅「W1」と、右口角位置「R1」と、左口角位置「L1」とを記憶する。なお、口領域の高さ「H1」および幅「W1」として、対応箇所の画素数や、モニタやディスプレイなどの出力デバイス上に表示される画像上の対応箇所の実距離などを採用することができる。

【0023】

図1に示すポイント付与テーブル214は、被験者の表情がどのような感情に起因するものであるか判定するためのポイント付与方法が定義されたテーブルである。例えば、ポイント付与テーブル214には、口領域の縦横比率、口領域の面積、右口角に上がり具合および左口角の上がり具合の各項目に対して付与されるポイント数が定義される。以下、図4および図5を用いて、ポイント付与テーブル214の一例を説明する。図4および図5は、実施例1に係るポイント付与テーブルの説明に用いる図である。

【0024】

例えば、図4に示すように、ポイント付与テーブル214には、口領域の縦横比率「H:W」、口領域の面積「H×W」、右口角の上がり具合「RH÷H」および左口角の上がり具合「LH÷H」の各項目が定義されている。

【0025】

ここで、図5を用いて、ポイント付与テーブル214に定義されている各項目について説明する。図5に示す「MA」は口領域を表し、図5に示す「L」は左口角位置を表し、図5に示す「R」は右口角位置を表す。また、図5に示す「LH」は左口角位置までの高さを表し、図5に示す「RH」は右口角位置までの高さを表す。また、図5に示す「H」は口領域の高さ、言い換えれば図5における口領域の縦の長さを表し、図5に示す「W」は口領域の幅、言い換えれば図5における口領域の横の長さを表す。また、図5に示すように、ポイント付与テーブル214に定義されている口領域の縦横比率「H:W」は、口領域の高さと幅との比に該当する。また、図5に示すように、ポイント付与テーブル214に定義されている口領域の面積「H×W」は、口領域の高さと幅との積に該当する。また、図5に示すように、右口角の上がり具合「RH÷H」は、口領域の高さと左口角位置までの高さとの比に該当する。また、図5に示すように、左口角の上がり具合「LH÷H」は、口領域の高さと左口角位置までの高さとの比に該当する。なお、図5に示すは左口角位置「L」および右口角位置「RH」は、例えば、後述する特徴点検出部223により口領域として決定された矩形領域の頂点の一つを基準とする画像上の座標値を採用できる。

【0026】

図4に戻り、ポイント付与テーブル214は、顔画像についての上述の各項目の値と、通常時における各項目の値との開き具合に応じて、表情に現れる感情ごとに付与すべきポイント数が定義されている。図4に示す通常度とは、被験者の表情に感情が現れていないではない状態、言い換えれば無表情の状態を示す度合いである。また、図4に示す恐怖度とは、被験者の表情に不安などの感情が表れている状態を示す度合いである。また、図4に示す笑い度とは、被験者の表情に快楽に紐付く感情が表れている状態を示す度合いである。また、図4に示す嫌悪度とは、被験者の表情に嫌悪感などの感情が表れている状態を示す度合いである。また、図4に示す悲しみ度とは、被験者の表情に悲しみの感情が表れている状態を示す度合いである。また、図4に示す冷笑度とは、被験者の表情に軽蔑や愚弄に紐付く感情が表れている状態を示す度合いである。

【0027】

そして、図4に示すように、ポイント付与テーブル214には、口領域の縦横比率「H:W」の値が通常時と同じである場合に、通常度に対し1ポイント付与すべき旨が定義されている。また、図4に示すように、ポイント付与テーブル214には、口領域の縦横比率「H:W」の値が通常時よりも大きい場合に、恐怖度、嫌悪度に対しそれぞれ1ポイント、笑い度に対し2ポイントを付与すべき旨が定義されている。また、図4に示すように、ポイント付与テーブル214には、口領域の縦横比率「H:W」の値が通常時よりも小さい場合に、悲しみ度に対し1ポイントを付与すべき旨が定義されている。

【0028】

ここで、上述した通常時に対応するデータには、以下に説明するいずれかのデータを設定する。例えば、所定のアクションを実行する以前の処理結果記憶部213に記憶されているデータに基づいて算出された口領域の面積、右口角の位置および左口角の位置を通常時のデータとして設定する。あるいは、所定のアクションを実行する以前の処理結果記憶部213に記憶されているデータのうち最も出現頻度の高いデータに基づいて算出された口領域の面積、右口角の位置および左口角の位置を通常時のデータとして設定する。あるいは、被験者が無表情であるときのデータを採取し、このデータに基づいて算出された口領域の面積、右口角の位置および左口角の位置を通常時のデータとして設定する。

【0029】

なお、図4に示すポイント付与テーブル214は、後述する判定部224によるポイントの付与時に参照される。

【0030】

図1に戻り、表情判定装置200は、顔部位検出部221、設定部222、特徴点検出部223および判定部224を有する。なお、顔部位検出部221、設定部222、特徴点検出部223および判定部224は、例えば、電子回路や集積回路に該当する。電子回路としては、例えば、CPU(Central Processing Unit)やMPU(Micro Processing Unit)がある。また、集積回路としては、例えば、ASIC(Application Specific Integrated Circuit)やFPGA(Field Programmable Gate Array)などがある。

【0031】

表情判定装置200は、上述した入力部120を介して、所定のアクションの実行指示をユーザから受け付けると、所定のアクションを実行する。ここで、所定のアクションとは、例えば、被験者の表情の変化を取得する為に静止画像や動画像の出力を実行するアクションに該当する。静止画像としては、例えば、ユニークな動物の写真や凄惨な場面の写真などがあげられる。動画像としては、コメディ映画やお笑い番組のほか、凄惨な現状を報道するドキュメンタリー番組などがあげられる。所定のアクションは、例えば、図1には示していない所定の制御部などが実行してもよい。

【0032】

顔部位検出部221は、画像記憶部211から顔画像を取り込み、取り込んだ顔画像内から、既存技術を用いて顔位置、眼、鼻、耳および眼鏡などの顔部位を検出する。さらに、顔部位検出部221は、顔画像における顔の向きを検出する。

【0033】

例えば、顔部位検出部221は、顔画像において垂直方向に隣り合って配列される各画素値を加算し、加算値の水平方向の分布から顔領域を特定することにより、顔の輪郭、つまり顔位置を検出する。また、顔部位検出部221は、顔画像から鼻の位置を検出し、検出された鼻の位置および顔の位置に基づいて顔の向きを検出する。なお、顔の位置や顔の向きの検出には、例えば、特許第4204336号公報に開示された技術を利用する。

【0034】

また、顔部位検出部221は、顔画像において眼である可能性のある領域について、時系列的に前後の画像データにおける変化に基づき眼の領域を特定する。なお、眼の位置の検出には、例えば、特許第4162503号公報に開示された技術を利用する。また、顔部位検出部221は、顔画像の水平方向の輝度が急激に変化する箇所を強調するフィルタ処理にて、水平方向に並ぶ輝度が低い画素列の両端を検出することで鼻孔を含む領域を検出する。なお、鼻の位置の検出には、例えば、特許第4364275号公報に開示された技術を利用する。また、顔部位検出部221は、顔画像から顔領域を検出し、顔領域を基準として耳を含むと推定される検出処理領域を算出し、検出処理領域において耳の輪郭を抽出する。なお、耳の位置の検出には、特開2007−257574号公報に開示された技術を利用する。また、顔部位検出部221は、顔画像の顔領域にフィルタ処理を行ってエッジの強い箇所を検出することにより眼鏡を検出する。なお、眼鏡の位置の検出には、例えば、特開2008−269182号公報に開示された技術を利用する。

【0035】

また、顔部位検出部221は、顔画像内から眼鏡を検出する場合を説明するが、これに限定されるものではなく、例えば、眼鏡以外のサングラスなどを検出するようにしてもよい。なお、サングラスの検出には、例えば、特開2010−157073号公報に開示された技術を利用する。

【0036】

設定部222は、顔部位検出部221により検出された顔部位に基づいて顔画像に対して口領域処理範囲を設定する。例えば、設定部222は、顔部位検出部221により顔部位の検出が行われると検出状況記憶部212の検出状況を更新する。つまり、設定部222は、顔の向きに対応する画像の受付数および顔部位の検出成功数を更新する。次に、設定部222は、顔の向きに対応する各顔部位の検出率を算出し、算出した検出率の高い順に各顔部位をソートする。続いて、設定部222は、顔部位検出部221により検出された顔部位の中から、検出率の上位2つの顔部位を取得し、取得した2つの顔部位を用いて口領域処理範囲を設定する。以下、図6〜12を用いて、設定部222による口領域処理範囲の設定について説明する。図6〜12は、実施例1に係る設定部の説明に用いる図である。

【0037】

例えば、設定部222は、検出率の上位2つの顔部位として、顔位置と鼻を取得したとする。この場合、設定部222は、図6に示すように、顔位置FPおよび鼻の位置NPを用いて、顔位置FPで得られる顔画像の領域のうち鼻の位置NPから下半分の領域α1を口領域処理範囲に設定する。

【0038】

また、設定部222は、検出率の上位2つの顔部位として、顔位置と眼を取得したとする。この場合、設定部222は、図7に示すように、顔位置FPおよび眼の位置EPを用いて、領域α1を口領域処理範囲に設定する。例えば、設定部222は、顔位置FPにより得られる顔の幅XのN%に相当する値を計算する。続いて、設定部222は、顔の幅XのN%に相当する値だけ眼の位置EPを基点として顔画像の下側に進んだ位置から、顔位置FPで得られる顔画像の領域の下半分の領域α2を口領域処理範囲として設定する。なお、上述したNの値は、例えば、眼と口との平均的な位置関係により予め設定されているものとする。

【0039】

また、設定部222は、検出率の上位2つの顔部位として、顔位置と耳を取得したとする。この場合、設定部222は、図8に示すように、顔位置FPおよび耳の位置ERPを用いて、顔位置FPで得られる顔画像の領域のうち耳の位置ERPから下半分の領域α3を口領域処理範囲に設定する。

【0040】

設定部222は、検出率の上位2つの顔部位として、顔位置と眼鏡を取得したとする。この場合、設定部222は、図9に示すように、顔位置FPおよび眼鏡の部品であるブリッジの位置GPを用いて、領域α4を口領域処理範囲に設定する。例えば、設定部222は、顔位置FPにより得られる顔の幅XのM%に相当する値を計算する。続いて、設定部222は、顔の幅XのM%に相当する値だけ眼鏡のブリッジの位置GPを基点として画像の下側に進んだ位置から、顔位置FPで得られる顔画像の領域の下半分の領域α4を口領域処理範囲として設定する。なお、上述したMの値は、例えば、眼鏡を構成する部品であるブリッジと口との平均的な位置関係により予め設定されているものとする。

【0041】

上述してきた図6〜図9では、設定部222は、検出率の上位2つの顔部位を用いて口領域処理範囲を設定する場合を説明したが、これに限られるものではなく、顔部位検出部221により検出された顔部位の1つを用いて口領域処理範囲を設定してもよい。例えば、設定部222は、図10に示すように、顔部位検出部221により検出された顔位置を用いて顔画像中の顔領域の矩形FAを求める。そして、設定部222は、顔領域の矩形FAの下半分の領域α5を口領域処理範囲に設定する。例えば、顔部位検出部221により検出された顔部位のうち信頼度の高い顔部位が顔位置のみである場合などには、設定部222は、顔位置のみを用いて口領域処理範囲に設定できる。

【0042】

なお、顔位置のみを用いた口領域処理範囲の設定は一例であり、顔部位検出部221により検出された顔部位のうち信頼度の高い顔部位が眼や鼻、耳のみの場合には、設定部222は、眼や鼻、耳のいずれかのみを用いて口領域処理範囲に設定することもできる。例えば、信頼度の高い顔部位が眼のみである場合、設定部222は、顔画像の領域のうち、顔の幅XのN%に相当する値だけ眼の位置EPを基点として顔画像の下側に進んだ位置から下半分の領域を口領域処理範囲に設定する。また、例えば、信頼度の高い顔部位が鼻のみである場合、設定部222は、顔画像の領域のうち鼻の位置NPから下半分の領域を口領域処理範囲に設定する。また、例えば、信頼度の高い顔部位が耳のみである場合、設定部222は、顔画像の領域のうち耳の位置ERPから下半分の領域を口領域処理範囲に設定する。

【0043】

また、上述してきた図6〜図9では、設定部222は、検出率の上位2つの顔部位として、顔位置と他の顔部位のいずれかを用いて口領域処理範囲を設定する場合を説明したが、これに限られるものではない。検出率の上位2つの顔部位が顔位置以外の2つの顔部位である場合、設定部222は、これらの顔部位を用いて口領域処理範囲を設定することもできる。

【0044】

例えば、設定部222は、検出率の上位2つの顔部位として、眼と鼻を取得したとする。この場合、設定部222は、図11に示すように、眼の位置EPおよび鼻の位置NPを用いて、顔画像の領域うち領域α6を口領域処理範囲に設定する。

【0045】

また、設定部222は、例えば、検出率の上位2つの顔部位として、眼と耳を取得したとする。この場合、設定部222は、図12に示すように、眼の位置EPおよび耳の位置ERPを用いて、顔画像の領域うち領域α7を口領域処理範囲に設定する。

【0046】

なお、設定部222は、顔位置、眼、鼻、耳および眼鏡などの顔部位の位置として、画像の左下の画素を基準とする画像上の座標値などを採用することができる。また、設定部222は、顔の幅Xとして、対応箇所の画素数や画像上の実距離などを採用できる。

【0047】

図1に示す特徴点検出部223は、設定部222により設定された口領域処理範囲から右口角および左口角を特徴点として検出する。例えば、特徴点検出部223は、設定部222により設定された口領域処理範囲内の画素分布に基づいて、この領域内において右口角および左口角を含む矩形の口領域を決定する。続いて、特徴点検出部223は、決定した口領域に対して、右口角用のフィルタおよび左口角用のフィルタをそれぞれ用いてフィルタ処理を行う。そして、特徴点検出部223は、右口角用のフィルタを用いたフィルタ処理により得られるフィルタ応答のピークとなる顔画像の位置を右口角として検出する。さらに、特徴点検出部223は、左口角用のフィルタを用いたフィルタ処理により得られるフィルタ応答がピークとなる顔画像の位置を左口角として検出する。以下、図13〜15を用いて特徴点検出部223について説明する。図13〜図15は、実施例1に係る特徴点検出部の説明に用いる図である。

【0048】

まず、図13を用いて特徴点検出部223による口領域の決定について説明する。図13に示すαは、口領域処理範囲を示す。また、図13に示すx軸は顔画像の対応位置を示し、図13に示すy軸は顔画像上の画素値を示す。また、図13に示すP1およびP2はx軸の方向に画素値を投影した結果を示す。特徴点検出部223は、口領域処理範囲の画素値を図13に示すx軸の方向にそれぞれ投影して、各x軸方向での画素値の投影結果を取得する。そして、特徴点検出部223は、口領域処理範囲にて、各x軸方向の画素値の投影結果が交わる矩形領域MAを口領域として決定する。

【0049】

次に、図14を用いて特徴点検出部223による左口角検出処理範囲および右口角検出処理範囲の決定について説明する。図14に示すβ1は、左口角を検出するための左口角検出処理範囲の一例であり、図14に示すβ2は、右口角を検出するための右口角検出処理範囲の一例である。なお、図14に示すMAは口領域であり、図13に示すMAと同一である。

【0050】

図14に示すように、特徴点検出部223は、口領域処理範囲にて決定した口領域MAに対して、左口角検出処理範囲β1および右口角検出処理範囲β2をそれぞれ設定する。例えば、特徴点検出部223は、図14に示すように、口領域MAである矩形領域の左の短辺の中点を中心とする所定サイズの矩形領域を左口角検出処理範囲β1に設定する。同様に、特徴点検出部223は、図14に示すように、口領域MAである矩形領域の右の短辺の中点を中心とする所定サイズの矩形領域を右口角検出処理範囲β2に設定する。

【0051】

続いて、図15を用いて特徴点検出部223による左口角および右口角の検出について説明する。図15に示すF1は左口角を検出する為のフィルタの一例であり、図15に示すF2は左口角を検出する為のフィルタの一例である。図15にて点線で示すように、口形状の類似領域が画像上にある場合に、フィルタF1は、左口角に相当する位置でフィルタの応答がピークとなるようにフィルタの値が設定される。同様に、フィルタF2は、口形状の類似領域が画像上にある場合に、右口角に相当する位置でフィルタの応答がピークとなるようにフィルタの値が設定される。

【0052】

そこで、特徴点検出部223は、まず、図15に示すフィルタF1を用いて、図14に示す左口角検出処理範囲をフィルタ処理する。そして、特徴点検出部223は、フィルタ処理により得られるフィルタ応答がピークとなる左口角検出処理範囲内の左口角の位置を検出する。同様に、特徴点検出部223は、図15に示すフィルタF2を用いて、図14に示す右口角検出処理範囲をフィルタ処理する。そして、特徴点検出部223は、フィルタ処理により得られるフィルタ応答がピークとなる右口角検出処理範囲内の右口角の位置を検出する。そして、特徴点検出部223は、検出した左口角の位置および右口角の位置を、口領域として決定した矩形領域MAの頂点の一つを基準とする画像上の座標を求め、左口角の位置および右口角の位置として決定する。

【0053】

左口角および右口角の検出を完了すると、特徴点検出部223は、口領域の縦および横の長さ、口領域における右口角の位置および左口角の位置を処理結果記憶部213に保存する。なお、口領域の縦および横の長さは、例えば、対応箇所の画素数や画像上の実距離を採用できる。また、右口角および左口角の位置は、上述したように、口領域として決定した矩形領域の頂点の一つを基準とする画像上の座標値を採用できる。

【0054】

図1に示す判定部224は、特徴点検出部223により検出された左口角および右口角の位置に基づいて表情判定処理を実行する。例えば、判定部224は、ポイント付与テーブル214を参照し、特徴点検出部223により検出された口領域の縦横比率、口領域の面積、口領域における左口角および右口角の位置に応じて、被験者の表情を判定するためのポイントを付与する処理を実行する。以下、図16を用いて、判定部224について説明する。図16は、実施例1に係る判定部の説明に用いる図である。図16に示すMAは口領域であり、図16に示すLは左口角の位置であり、図16に示すRは右口角の位置である。

【0055】

また、図16に示す16Aは、口領域の面積、口領域における右口角の位置および左口角の位置の通常時のデータを示す。なお、通常時のデータについては上述したが、判定部224は、以下に説明するいずれかのデータを利用する。例えば、判定部224は、所定のアクションを実行する以前の処理結果記憶部213に記憶されているデータに基づいて算出された口領域の面積、右口角の位置および左口角の位置のデータを採用する。あるいは、判定部224は、所定のアクションを実行する以前の処理結果記憶部213に記憶されているデータのうち最も出現頻度の高いデータに基づいて算出された口領域の面積、右口角の位置および左口角の位置のデータを利用する。あるいは、判定部224は、被験者が無表情であるときのデータを採取し、このデータに基づいて算出された口領域の面積、右口角の位置および左口角の位置のデータを利用する。また、図16に示す16Bおよび16Cは、特徴点検出部223により検出された口領域の面積、口領域における左口角および右口角の位置の一例を示す。

【0056】

判定部224は、特徴点検出部223による検出結果と通常時との比較結果をポイント付与テーブル214に照らし合わせて、口領域の縦横比率、口領域の面積、右口角に上がり具合および左口角の上がり具合の各項目に対してポイントを付与する。

【0057】

例えば、判定部224は、16Aと16Bとを比較すると、口領域の縦横比率が同じであるので、通常度に1ポイント付与する。また、判定部224は、16Aと16Bとを比較すると、口領域の面積が通常時と同じであるので、通常度に1ポイント付与する。また、判定部224は、16Aと16Bとを比較すると、右口角の上がり具合が通常時よりも小さいので、悲しみ度、恐怖度、嫌悪度にそれぞれ1ポイント付与する。また、判定部224は、16Aと16Bとを比較すると、左口角の上がり具合が通常時よりも小さいので、恐怖度に1ポイント付与する。なお、判定部224は、16Aと16Bとを比較した結果、右口角の位置と左口角の位置とに差異はないので、冷笑度に対するポイントは付与しない。口領域の縦横比率が同じであるので、通常度に1ポイント付与する。

【0058】

また、判定部224は、16Aと16Cとを比較すると、口領域の縦横比率が通常時よりも大きいので、恐怖度および嫌悪度にそれぞれ1ポイントを付与し、笑い度に2ポイントを付与する。また、判定部224は、16Aと16Cとを比較すると、口領域の面積が通常時と同じであるので、笑い度に2ポイントを付与し、恐怖度に1ポイントを付与する。また、判定部224は、16Aと16Cとを比較すると、右口角の上がり具合が通常時よりも大きいので、笑い度に3ポイント付与する。また、判定部224は、16Aと16Cとを比較すると、左口角の上がり具合が通常時よりも大きいので、笑い度に3ポイント付与する。なお、判定部224は、16Aと16Cとを比較した結果、右口角の位置と左口角の位置とに差異がないので、冷笑度に対するポイントは付与しない。

【0059】

そして、判定部224は、表情判定の処理を完了すべきかどうかを判定する。そして、判定部224は、判定の結果、処理を完了すべきである場合には、所定のアクションに対応付けて、表情判定の処理結果を出力する。表情判定の処理結果としては、上述したように、例えば、アクションとして出力された静止画像の内容に対応付けて、通常度、恐怖度、嫌悪度、悲しみ度、冷笑度に対して付与されたポイントが出力される。

【0060】

なお、判定部224は、例えば、所定のアクションとして静止画像の出力を実行した場合には、上述したポイントの付与を持って処理を完了すべきものと判定する。また、判定部224は、所定のアクションとして動画像の出力を実行した場合、動画像の再生終了を条件に処理を完了すべきものと判定する。なお、判定部224は、動画像の再生が終了していない場合には、表情判定の処理を継続すべきものと判定し、次に取得した顔画像について顔部位の検出を行うように顔部位検出部221に依頼する。

【0061】

[表情判定装置による処理(実施例1)]

続いて、図17を用いて、表情判定装置による処理の流れを説明する。図17は、実施例1に係る表情判定装置による処理の流れを示す図である。なお、図17に示す処理は、例えば、制御部220によりユーザから所定のアクションの実行指示を受け付けたことが判定されると開始される。

【0062】

図17に示すように、表情判定装置200は所定のアクションを実行する(ステップS101)。次に、顔部位検出部221は、画像記憶部211から顔画像を取り込み(ステップS102)、取り込んだ顔画像内から、既存技術を用いて顔位置、眼、鼻、耳および眼鏡などの顔部位を検出する(ステップS103)。続いて、設定部222は口領域処理範囲の設定処理を実行する(ステップS104)。なお、口領域処理範囲の設定処理については後述する。

【0063】

次に、特徴点検出部223は、設定部222により設定された口領域処理範囲内における口領域を決定する(ステップS105)。続いて、特徴点検出部223は、口領域から、右口角を検出するための右口角検出処理範囲を設定する(ステップS106)。そして、特徴点検出部223は、右口角検出処理範囲から右口角を検出する(ステップS107)。

【0064】

次に、特徴点検出部223は、口領域から、左口角を検出するための左口角検出処理範囲を設定する(ステップS108)。続いて、特徴点検出部223は、左口角検出処理範囲から左口角を検出する(ステップS109)。そして、特徴点検出部223は、口領域の縦および横の長さ、口領域における右口角の位置および左口角の位置を処理結果記憶部213に保存する(ステップS110)。

【0065】

次に、判定部224は特徴点検出部223により検出された口領域の縦横比率、口領域の面積、口領域における左口角および右口角の位置に基づいて表情判定を実行する(ステップS111)。続いて、判定部224は、処理を完了すべきか否かを判定する(ステップS112)。そして、処理を完了すべきものと判定した場合には(ステップS112,Yes)、判定部224は、所定のアクションに対応付けて表情判定結果を出力する(ステップS113)。一方、処理を完了すべきものと判定しなかった場合には(ステップS112,No)、判定部224は、上述したステップS102に処理を移行させる。

【0066】

続いて、図18を用いて、口領域処理範囲の設定処理の流れを説明する。図18は、実施例1に係る口領域処理範囲の設定処理の流れを示す図である。図18に示すように、設定部222は、顔部位検出部221により顔部位の検出が行われると検出状況記憶部212の検出状況を更新する(ステップS201)。

【0067】

次に、設定部222は、顔の向きに対応する各顔部位の検出率を算出し(ステップS202)、算出した検出率の高い順に各顔部位をソートする(ステップS203)。続いて、設定部222は、検出率の上位2つの顔部位を取得し(ステップS204)、取得した2つの顔部位を用いて口領域処理範囲を設定する(ステップS205)。

【0068】

[実施例1による効果]

上述してきたように、実施例1では、顔画像から複数の顔部位を検出し、検出した複数の顔部位の少なくとも1つを用いて口領域処理範囲を設定して、口領域処理範囲から右口角および左口角の位置を検出する。仮に、表情判定に用いる右口角および左口角の位置を検出するための口領域処理範囲を予め設定することができなければ、顔画像全体について右口角および左口角の位置の検出処理を行う必要がある。これに対し、実施例1によれば、特徴点である右口角および左口角の位置を検出するための口領域処理範囲を予め設定するので、顔画像全体について処理する場合に比べて、表情判定に用いる特徴点を高速に検出できる。

【0069】

また、実施例1では、口領域処理範囲の画素分布に基づいて右口角および左口角を含む口領域を決定し、決定した口領域の縦横比率、口領域の面積および口領域における右口角の位置および左口角の位置に応じたポイントを付与することで被験者の表情を判定する。このため、実施例1によれば、口や口角に現れる変化に応じた細かいスコアリンクができ、被験者の表情を簡易かつ詳細に判定できる。

【0070】

また、実施例1では、顔画像における顔の向きを検出し、顔の向きに対応付けて顔画像の受付数、該受付数における顔部位の検出成功数をそれぞれ検出状況記憶部212に保存する。続いて、実施例1では、顔の向きに対応する顔画像の受付数、この受付数における顔部位の検出成功数を取得し、取得した受付数および検出成功数を用いて顔部位ごとの検出率を算出する。そして、実施例1では、検出率に基づいて、検出した顔部位の中から少なくとも1つを取得し、取得した顔部位を用いて口領域処理範囲を設定する。このため、実施例1によれば、顔画像における顔の向きに応じて、より信頼度の高い顔部位を選択でき、選択した顔部位により口領域処理範囲を精度良く設定できる。

【0071】

また、実施例1において、検出した顔部位の中から、検出率の高い顔部位を顔向きに関係なく選択するようにしてもよい。このようにすれば、顔画像の撮影状況に関係なく、現状で最も信頼度の高い顔部位を用いて口領域処理範囲を設定できる。

【0072】

また、実施例1では、表情の判定に用いる特徴点以外、言い換えれば右口角および左口角以外の他の顔部位を用いて、右口角および左口角を探索する口領域処理範囲を設定する場合を説明した。しかしながら、この場合に限定されるものではなく、例えば、眼が探索対象とする場合には、眼以外の他の顔部位を用いて眼を探索する領域を設定するなど、実施例1で説明した方法は、口角以外の他の顔部位を探索する領域の設定にも同様に適用できる。

【0073】

なお、表情判定装置200は、様々な状況が映し出された静止画像や動画像の出力を所定のアクションとして実行する場合を説明したが、これに限定されるものではない。例えば、表情判定装置200のユーザが被験者と楽しい話題や悲しい話題の会話をするというアクションを実行してもよい。この場合、会話中の被験者の顔画像を取得し、被験者の表情を判定する。

【0074】

また、表情判定装置200は、例えば、パーソナルコンピュータやスマートフォンなどの情報処理装置に実装することができる。例えば、医療従事者が使用する情報処理装置に表情判定装置200が実装される場合には、表情判定装置200による表情判定の処理結果がカルテシステムなどに出力される。カルテシステムでは、被験者である患者の情報に関連付けて表情判定の処理結果が保存される。また、例えば、所定のwebサイトにアクセスするユーザのスマートフォンに表情判定装置200が実装される場合には、表情判定装置200による表情判定の処理結果が、例えば、webサイトを運営するサーバなどに出力される。webサイトを運営するサーバでは、webサイトにアクセス中のユーザの情報に関連付けて表情判定の処理結果が保存される。

【0075】

また、表情判定装置200は、例えば、車両に搭載されるマイコンに実装することもできる。この場合、表情判定装置200は、車両の移動中、運転者の顔画像を継続的に取得して運転者の表情を判定し、表情の判定結果を車両制御ユニットに出力する。車両制御ユニットでは、運転者の表情の判定結果に応じて警告の報知や車両制御が実行される。

【実施例2】

【0076】

以下、本願の開示する表情判定プログラムおよび表情判定装置の他の実施形態を説明する。

【0077】

(1)装置構成等

例えば、図1に示した表情判定装置200の機能ブロックの構成は概念的なものであり、必ずしも物理的に図示の如く構成されていることを要しない。例えば、図1に示した顔部位検出部221を、顔位置の検出機能と顔部位の検出機能とに機能的または物理的に分離してもよい。このように、例えば、図1に示した表情判定装置200の機能ブロックの全部または一部を、各種の負荷や使用状況などに応じて、任意の単位で機能的または物理的に分散または統合して構成することができる。

【0078】

(2)表情判定プログラム

また、上述の実施例にて説明した表情判定装置200により実行される各種の処理は、例えば、電子回路や集積回路などの電子機器で所定のプログラムを実行することによって実現できる。

【0079】

そこで、以下では、図19を用いて、上述の実施例にて説明した表情判定装置200により実行される処理と同様の機能を実現する表情判定プログラムを実行するコンピュータの一例を説明する。図19は、表情判定プログラムを実行する電子機器の一例を示す図である。

【0080】

図19に示すように、表情判定装置200により実行される各種処理を実現する電子機器300は、各種演算処理を実行するCPU(Central Processing Unit)310を有する。また、図19に示すように、電子機器300は、外部からのデータ入力を受け付ける入力インターフェース320、カメラ画像を取得するためのカメラインターフェース330、外部へデータを出力する出力インターフェース340を有する。

【0081】

また、図19に示すように、電子機器300は、CPU310により各種処理を実現するためのプログラムやデータ等を記憶するハードディスク装置350と、各種情報を一時記憶するRAM(Random Access Memory)などのメモリ360とを有する。そして、各装置310〜360は、バス370に接続される。

【0082】

なお、CPU310の代わりに、例えば、MPU(Micro Processing Unit)などの電子回路、ASIC(Application Specific Integrated Circuit)やFPGA(Field Programmable Gate Array)などの集積回路を用いることもできる。また、メモリ360の代わりに、フラッシュメモリ(flash memory)などの半導体メモリ素子を用いることもできる。

【0083】

ハードディスク装置350には、表情判定装置200の機能と同様の機能を発揮する表情判定プログラム351および表情判定用データ352が記憶されている。なお、この表情判定プログラム351を適宜分散させて、ネットワークを介して通信可能に接続された他のコンピュータの記憶部に記憶させておくこともできる。

【0084】

そして、CPU310が、表情判定プログラム351をハードディスク装置350から読み出してメモリ360に展開することにより、図19に示すように、表情判定プログラム351は表情判定プロセス361として機能する。表情判定プロセス361は、ハードディスク装置350から読み出した表情判定用データ352等の各種データを適宜メモリ360上の自身に割当てられた領域に展開し、この展開した各種データに基づいて各種処理を実行する。

【0085】

なお、表情判定プロセス361は、例えば、上述した表情判定装置200の制御部220にて実行される処理、例えば、図17、図18を用いて説明した処理を含む。

【0086】

なお、表情判定プログラム351については、必ずしも最初からハードディスク装置350に記憶させておく必要はない。例えば、電子機器300が実装されたECUへ対応ドライブを接続可能なフレキシブルディスク(FD)、CD−ROM、DVDディスク、光磁気ディスク、ICカードなどの「可搬用の物理媒体」に各プログラムを記憶させておく。そして、電子機器300がこれらから各プログラムを読み出して実行するようにしてもよい。

【0087】

さらには、公衆回線、インターネット、LAN、WANなどを介して、電子機器300が実装されたECUに接続される「他のコンピュータ(またはサーバ)」などに各プログラムを記憶させておく。そして、電子機器300がこれらから各プログラムを読み出して実行するようにしてもよい。

【0088】

以上の実施例を含む実施形態に関し、さらに以下の付記を開示する。

【0089】

(付記1)コンピュータに、

入力画像を受付け、

前記入力画像から顔領域を検出し、

前記顔領域から第一の特徴点を検出し、

前記顔領域から第二の特徴点を検出し、

前記第一の特徴点と前記第二の特徴点のうち、少なくとも一つの特徴点を選択し、

選択した前記少なくとも一つの特徴点に基づいて、前記顔領域に領域を設定し、

設定した前記領域から、前記第一の特徴点および前記第二の特徴点とは異なる第三の特徴点を検出し、

検出した前記第三の特徴点に基づいて前記入力画像における表情を判定する

処理を実行させることを特徴とする表情判定プログラム。

【0090】

(付記2)前記第三の特徴点を検出する処理は、前記領域内の画素値の分布に基づいて前記第三の特徴点を含む矩形領域を決定して、該矩形領域から前記第三の特徴点を検出し、

前記表情を判定する処理は、決定した前記矩形領域の縦横比率、該矩形領域の面積および該矩形領域における前記第三の特徴点の位置のいずれか一つ又は複数に基づいて、前記表情を判定することを特徴とする付記1に記載の表情判定プログラム。

【0091】

(付記3)前記コンピュータに、

前記入力画像における顔の向きを検出し、

前記顔の向きに対応付けて、前記入力画像の受付数、該受付数における前記第一の特徴点の検出成功数および前記第二の特徴点の検出成功数をそれぞれ記憶部に保存する

処理をさらに実行させ、

前記少なくとも一つの特徴点を選択する処理は、前記顔の向きに対応する前記受付数、前記第一の特徴点の検出成功数および前記第二の特徴点の検出成功数を前記記憶部からそれぞれ取得し、取得した前記受付数、前記第一の特徴点の検出成功数および前記第二の特徴点の検出成功数に基づいて、前記第一の特徴点および前記第二の特徴点の検出率をそれぞれ算出し、算出した検出率に基づいて、前記第一の特徴点と前記第二の特徴点のうち、少なくとも一つの特徴点を選択することを特徴とする付記1に記載の表情判定プログラム。

【0092】

(付記4)前記コンピュータに、

前記入力画像の受付前に所定のアクションを実行し、

前記表情を判定する処理の処理結果と前記所定のアクションの情報とを対応付けて出力する

処理をさらに実行させることを特徴とする付記1に記載の表情判定プログラム。

【0093】

(付記5)入力画像から顔領域を検出し、該顔領域に含まれる第一の特徴点および第二の特徴点を検出する顔部位検出部と、

前記顔部位検出部により抽出された第一の特徴点と第二の特徴点のうち、少なくとも一つの特徴点を選択し、選択した少なくとも一つの特徴点に基づいて前記顔領域に領域を設定する設定部と、

前記設定部により設定された領域から、前記第一の特徴点および前記第二の特徴点とは異なる第三の特徴点を検出する特徴点検出部と、

前記特徴点検出部により検出された第三の特徴点に基づいて前記入力画像における表情を判定する判定部と

を有することを特徴とする表情判定装置。

【0094】

(付記6)前記特徴点検出部は、前記設定部により設定された前記領域内の画素分布に基づいて前記第三の特徴点を含む矩形領域を決定して、該矩形領域から前記第三の特徴点を検出し、

前記判定部は、前記検出部により決定された前記矩形領域の縦横比率、該矩形領域の面積および該矩形領域における前記第三の特徴点の位置のいずれか一つ又は複数に基づいて、前記表情を判定することを特徴とする付記5に記載の表情判定装置。

【0095】

(付記7)前記顔部位検出部は、前記入力画像における顔の向きを検出して、検出した顔の向きに対応付けて、前記入力画像の処理数、前記第一の特徴点の検出成功数および前記第二の特徴点の検出成功数をそれぞれ記憶部に格納し、

前記特徴点検出部は、前記顔部位検出部により検出された顔の向きに対応する前記受付数、前記第一の特徴点の検出成功数および前記第二の特徴点の検出成功数を前記記憶部からそれぞれ取得し、取得した前記受付数、前記第一の特徴点の検出成功数および前記第二の特徴点の検出成功数に基づいて、前記第一の特徴点および前記第二の特徴点の検出率をそれぞれ算出し、算出した検出率に基づいて、前記第一の特徴点と前記第二の特徴点のうち、少なくとも一つの特徴点を選択することを特徴とする付記5に記載の表情判定装置。

【0096】

(付記8)前記判定部は、前記入力画像の受付前に所定のアクションを実行し、前記表情の判定結果と前記所定のアクションの情報とを対応付けて出力することを特徴とする付記5に記載の表情判定装置。

【符号の説明】

【0097】

100 情報処理装置

110 撮像装置

120 入力部

130 出力部

200 表情判定装置

211 画像記憶部

212 検出状況記憶部

213 処理結果記憶部

214 ポイント付与テーブル

221 顔部位検出部

222 設定部

223 特徴点検出部

224 判定部

300 電子機器

310 CPU

320 入力インターフェース

330 カメラインターフェース

340 出力インターフェース

350 ハードディスク装置

351 表情判定プログラム

352 表情判定用データ

360 メモリ

361 表情判定プロセス

370 バス

【特許請求の範囲】

【請求項1】

コンピュータに、

入力画像を受付け、

前記入力画像から顔領域を検出し、

前記顔領域から第一の特徴点を検出し、

前記顔領域から第二の特徴点を検出し、

前記第一の特徴点と前記第二の特徴点のうち、少なくとも一つの特徴点を選択し、

選択した前記少なくとも一つの特徴点に基づいて、前記顔領域に領域を設定し、

設定した前記領域から、前記第一の特徴点および前記第二の特徴点とは異なる第三の特徴点を検出し、

検出した前記第三の特徴点に基づいて前記入力画像における表情を判定する

処理を実行させることを特徴とする表情判定プログラム。

【請求項2】

前記第三の特徴点を検出する処理は、前記領域内の画素値の分布に基づいて前記第三の特徴点を含む矩形領域を決定して、該矩形領域から前記第三の特徴点を検出し、

前記表情を判定する処理は、決定した前記矩形領域の縦横比率、該矩形領域の面積および該矩形領域における前記第三の特徴点の位置のいずれか一つ又は複数に基づいて、前記表情を判定することを特徴とする請求項1に記載の表情判定プログラム。

【請求項3】

前記コンピュータに、

前記入力画像における顔の向きを検出し、

前記顔の向きに対応付けて、前記入力画像の受付数、該受付数における前記第一の特徴点の検出成功数および前記第二の特徴点の検出成功数をそれぞれ記憶部に保存する

処理をさらに実行させ、

前記少なくとも一つの特徴点を選択する処理は、前記顔の向きに対応付けて前記記憶部に保存された前記受付数、前記第一の特徴点の検出成功数および前記第二の特徴点の検出成功数をそれぞれ取得し、取得した前記受付数、前記第一の特徴点の検出成功数および前記第二の特徴点の検出成功数に基づいて、前記第一の特徴点および前記第二の特徴点の検出率をそれぞれ算出し、算出した検出率に基づいて、前記第一の特徴点と前記第二の特徴点のうち、少なくとも一つの特徴点を選択することを特徴とする請求項1に記載の表情判定プログラム。

【請求項4】

前記コンピュータに、

前記入力画像の受付前に所定のアクションを実行し、

前記表情を判定する処理の処理結果と前記所定のアクションの情報とを対応付けて出力する

処理をさらに実行させることを特徴とする請求項1に記載の表情判定プログラム。

【請求項5】

入力画像から顔領域を検出し、該顔領域に含まれる第一の特徴点および第二の特徴点を検出する顔部位検出部と、

前記顔部位検出部により検出された第一の特徴点と第二の特徴点のうち、少なくとも一つの特徴点を選択し、選択した少なくとも一つの特徴点に基づいて前記顔領域に領域を設定する設定部と、

前記設定部により設定された領域から、前記第一の特徴点および前記第二の特徴点とは異なる第三の特徴点を検出する特徴点検出部と、

前記特徴点検出部により検出された第三の特徴点に基づいて前記入力画像における表情を判定する判定部と

を有することを特徴とする表情判定装置。

【請求項1】

コンピュータに、

入力画像を受付け、

前記入力画像から顔領域を検出し、

前記顔領域から第一の特徴点を検出し、

前記顔領域から第二の特徴点を検出し、

前記第一の特徴点と前記第二の特徴点のうち、少なくとも一つの特徴点を選択し、

選択した前記少なくとも一つの特徴点に基づいて、前記顔領域に領域を設定し、

設定した前記領域から、前記第一の特徴点および前記第二の特徴点とは異なる第三の特徴点を検出し、

検出した前記第三の特徴点に基づいて前記入力画像における表情を判定する

処理を実行させることを特徴とする表情判定プログラム。

【請求項2】

前記第三の特徴点を検出する処理は、前記領域内の画素値の分布に基づいて前記第三の特徴点を含む矩形領域を決定して、該矩形領域から前記第三の特徴点を検出し、

前記表情を判定する処理は、決定した前記矩形領域の縦横比率、該矩形領域の面積および該矩形領域における前記第三の特徴点の位置のいずれか一つ又は複数に基づいて、前記表情を判定することを特徴とする請求項1に記載の表情判定プログラム。

【請求項3】

前記コンピュータに、

前記入力画像における顔の向きを検出し、

前記顔の向きに対応付けて、前記入力画像の受付数、該受付数における前記第一の特徴点の検出成功数および前記第二の特徴点の検出成功数をそれぞれ記憶部に保存する

処理をさらに実行させ、

前記少なくとも一つの特徴点を選択する処理は、前記顔の向きに対応付けて前記記憶部に保存された前記受付数、前記第一の特徴点の検出成功数および前記第二の特徴点の検出成功数をそれぞれ取得し、取得した前記受付数、前記第一の特徴点の検出成功数および前記第二の特徴点の検出成功数に基づいて、前記第一の特徴点および前記第二の特徴点の検出率をそれぞれ算出し、算出した検出率に基づいて、前記第一の特徴点と前記第二の特徴点のうち、少なくとも一つの特徴点を選択することを特徴とする請求項1に記載の表情判定プログラム。

【請求項4】

前記コンピュータに、

前記入力画像の受付前に所定のアクションを実行し、

前記表情を判定する処理の処理結果と前記所定のアクションの情報とを対応付けて出力する

処理をさらに実行させることを特徴とする請求項1に記載の表情判定プログラム。

【請求項5】

入力画像から顔領域を検出し、該顔領域に含まれる第一の特徴点および第二の特徴点を検出する顔部位検出部と、

前記顔部位検出部により検出された第一の特徴点と第二の特徴点のうち、少なくとも一つの特徴点を選択し、選択した少なくとも一つの特徴点に基づいて前記顔領域に領域を設定する設定部と、

前記設定部により設定された領域から、前記第一の特徴点および前記第二の特徴点とは異なる第三の特徴点を検出する特徴点検出部と、

前記特徴点検出部により検出された第三の特徴点に基づいて前記入力画像における表情を判定する判定部と

を有することを特徴とする表情判定装置。

【図1】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図13】

【図14】

【図15】

【図16】

【図17】

【図18】

【図19】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図13】

【図14】

【図15】

【図16】

【図17】

【図18】

【図19】

【公開番号】特開2012−155631(P2012−155631A)

【公開日】平成24年8月16日(2012.8.16)

【国際特許分類】

【出願番号】特願2011−15786(P2011−15786)

【出願日】平成23年1月27日(2011.1.27)

【出願人】(000005223)富士通株式会社 (25,993)

【Fターム(参考)】

【公開日】平成24年8月16日(2012.8.16)

【国際特許分類】

【出願日】平成23年1月27日(2011.1.27)

【出願人】(000005223)富士通株式会社 (25,993)

【Fターム(参考)】

[ Back to top ]