視差映像生成システム、視差映像生成方法、映像配信システムおよび映像配信方法

【課題】視差映像を簡易に生成でき、立体映像を手軽に提供できるようにした視差映像生成システムを提供すること。

【解決手段】実施形態によれば、視差映像生成システムは、モバイル端末によりアクセス可能なネットワークを利用する。視差映像生成システムは、収集部と、視差映像データ生成部とを具備する。収集部は、動画撮影機能を備える撮像機付きモバイル端末により取得された映像データをネットワークを介して収集する。視差映像データ生成部は、異なる撮像機付きモバイル端末で取得された映像データに基づいて、収集部により収集された映像データから視差映像を生成する。

【解決手段】実施形態によれば、視差映像生成システムは、モバイル端末によりアクセス可能なネットワークを利用する。視差映像生成システムは、収集部と、視差映像データ生成部とを具備する。収集部は、動画撮影機能を備える撮像機付きモバイル端末により取得された映像データをネットワークを介して収集する。視差映像データ生成部は、異なる撮像機付きモバイル端末で取得された映像データに基づいて、収集部により収集された映像データから視差映像を生成する。

【発明の詳細な説明】

【技術分野】

【0001】

本発明の実施形態は、例えばIPネットワークを介してライブ映像のストリーム配信あるいは動画像コンテンツのVideo on demand (VOD)配信などを実現する映像配信システムと、この種のシステムに適用可能な視差映像生成システムおよび方法に関する。

【背景技術】

【0002】

近年ではインターネットに繋がれた端末でテレビ放送を視聴することができる。この種の映像配信システムでは、予め用意されたコンテンツの放送だけでなく、スタジアムや競技場などで行われるスポーツや、コンサートのライブ中継なども実施されるようになってきている。

【0003】

Internet Protocol(IP)ネットワークなどの媒体を介して視聴者にビデオストリームを配信する、いわゆるIP Television(IPTV)サービスが知られている。例えばIP-Video on Demand(IP−VOD)、あるいは地上D−IP再送信などの技術が知られている。近年ではIntegrated Services Digital Broadcasting − Terrestrial(ISDB−T)に準拠するワンセグサービスを利用するユーザも多い。

【0004】

さらに、動画共有サイトを介してユーザ間で映像コンテンツを共有するシステムも構築されている。この種のシステムでは、投稿者からサーバにアップロードされた映像コンテンツをインターネット上に公開できるようになっている。

【先行技術文献】

【特許文献】

【0005】

【特許文献1】特表2011−519192号公報

【特許文献2】特開2010−98720号公報

【発明の概要】

【発明が解決しようとする課題】

【0006】

ところで、立体映像の生成に関する技術開発が盛んである。シーンを高精細かつ多角的・多面的に捉えた映像を加工・画像処理することで、視聴者に3次元(3D)の立体的な映像を提供することができる。この技術は映像配信システムでも用いられ、例えばスポーツのダイナミックな動作やゴールシーンといった瞬間的・決定的な映像が3D化され、魅力的な映像コンテンツとして放映・配信されるようになってきている。

【0007】

3次元(3D)映像を視聴者に提供するための方式には、例えば特殊ディスプレイによる方式や、特殊偏光メガネを用いる方式など、いくつかの標準が策定されつつある。しかしながらいずれの方式においても基本となる技術そのものは、複眼視による撮影、または擬似映像の生成により得られる視差映像を利用することである。

【0008】

同じ対象を複数の異なる視点から撮影した画像(フレーム)を視差画像と称する。視差映像は複数の視差画像を時系列で配列して得られる動画像であり、3D映像はその一つの形態である。

映像コンテンツのストリーム配信は、放映権を獲得したテレビ局がその全てを賄ってきた。インターネットの爆発的普及とアクセス端末の高機能化に伴って映像のストリーミング配信は当然のように行われるようになったが、3D映像の生成や配信に関しては、放映権を獲得したテレビ局が独占的に実施している状況にある。

【0009】

一方、近年のわが国ではほぼ全ての人が携帯電話端末を所有しており、その数が飽和状態となるほどに携帯電話端末は普及している。機能の面でも高機能化が著しく、音声通話、メール送受信、インターネットアクセスといった基本的機能に加えて、ディジタルカメラ機能・ディジタルビデオ機能を実装する端末も今や普通である。さらには、GPS(Global Positioning System)により自らの位置情報を取得したり、ジャイロセンサなどを備えるものもある。そこで、このような端末の諸機能を利用すれば、テレビ局に頼らずに視差映像を生成して3D映像を視聴者に配信し得る可能性があるが、そのような技術は未だ知られていない。

目的は、視差映像を簡易に生成でき、これにより立体映像を手軽に提供できるようにした視差映像生成システム、視差映像生成方法、映像配信システムおよび映像配信方法を提供することにある。

【課題を解決するための手段】

【0010】

実施形態によれば、視差映像生成システムは、モバイル端末によりアクセス可能なネットワークを利用する。視差映像生成システムは、収集部と、視差映像データ生成部とを具備する。収集部は、動画撮影機能を備える撮像機付きモバイル端末により取得された映像データをネットワークを介して収集する。視差映像データ生成部は、異なる撮像機付きモバイル端末で取得された映像データに基づいて、収集部により収集された映像データから視差映像を生成する。

【図面の簡単な説明】

【0011】

【図1】第1の実施形態に係わる映像配信システムの一例を示すシステム図。

【図2】視差画像について説明するための図。

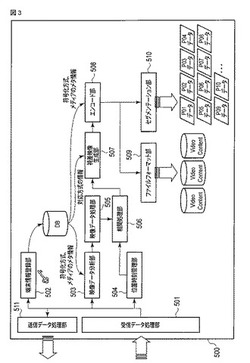

【図3】第1の実施形態に係わる視差映像生成システムの一例を示す機能ブロック図。

【図4】複数のモバイル端末による視点を示す模式図。

【図5】フレームのグループ化に必要な情報を説明するための模式図。

【図6】映像データの収集から配信用コンテンツの生成までの手順を概略的に示す模式図。

【図7】モバイル端末を映像配信システムに登録するための手順を示すシーケンス図。

【図8】第1の実施形態に関わる映像配信システムがモバイル端末からストリームデータを受信する際の手順を示すシーケンス図。

【図9】視差映像の生成に関わる手順を示すシーケンス図。

【図10】それぞれの画像フレーム情報から映像コンテンツを生成するための手順を示すシーケンス図。

【図11】第1の実施形態における映像コンテンツの配信に関わる部分を示すシステム図。

【図12】第1の実施形態に係わる視差映像生成システムの要部を示す機能ブロック図。

【図13】第1の実施形態における映像配信に関わる手順を示すシーケンス図。

【図14】視差映像の生成に係わる第2の実施形態を説明するための図。

【図15】視差映像の生成に係わる第3の実施形態を説明するための図。

【発明を実施するための形態】

【0012】

[第1の実施形態]

図1は、第1の実施形態に係わる映像配信システムの一例を示すシステム図である。図1に示されるシステムは、インターネットに代表されるIPネットワーク(IP Network)1を利用するシステムである。IPネットワーク1としては他にも、Virtual Private Network (VPN)技術を応用した専用ネットワークなどがある。

【0013】

IPネットワーク1はモバイル端末によりアクセス可能なネットワークである。第1の実施形態ではモバイル端末の一例として、インターネットアクセス機能を備えるモバイル端末a,b,c,d,eを想定する。モバイル端末a,b,c,d,eとしてはセルラフォン端末、Personal Handy-phone System(PHS)端末、(Personal Digital Assistants)PDA端末、PDC(Personal Digital Cellular)端末、スマートフォン、モバイルパソコンなどが挙げられる。

【0014】

モバイル端末a,b,c,d,eは動画撮影機能を備え、保持するユーザの操作に応じて、あるいは事前の設定などにより、撮影した映像データをIPネットワーク1に送信する。なお映像データには音声を含んでも良い。

またモバイル端末a,b,c,d,eは、GPSを利用して自らの位置を測位する機能を備える。この種の機能は近年では多くのモバイル端末に搭載されており、例えばこの測位機能と、IPネットワーク1に備わる地図データベースとを連携させることにより、ナビゲーションアプリを利用ことができる。モバイル端末a,b,c,d,eは位置情報に加えて時刻情報も取得する。すなわちモバイル端末a,b,c,d,eは測位衛星としてのGPS衛星から到達する電波を用いて、位置情報および時刻情報を算出する測位処理部を備える。

【0015】

モバイル端末a,b,c,d,eは撮影した映像データと併せて、映像データの撮影時刻と撮影位置とをIPネットワーク1に送信する。撮影時刻、撮影位置ともに、GPSで取得された時刻情報、位置情報を反映するデータである。具体的にはモバイル端末a,b,c,d,eは、映像データに含まれるフレームごとの撮影時刻と撮影位置とをIPネットワーク1に送信する。フレームの撮影時刻と撮影位置とは各フレームごとに対応付けられるデータであり、この種のデータを位置・時刻情報と称することにする。

【0016】

IPネットワーク1には、セッション・チケット管理部100、データストレージ部200、メディア変換部300、およびストリーミング配信部400が接続される。セッション・チケット管理部100、データストレージ部200、メディア変換部300、およびストリーミング配信部400はそれぞれ個別に複数のコンピュータに実装されても良いし、同じコンピュータデバイスに複数の処理機能として実装されても良い。

【0017】

モバイル端末a,b,c,d,eから送信された映像データおよび位置・時刻情報はデータストレージ部200に蓄積される。すなわちデータストレージ部200は、映像情報と位置・時刻情報とを蓄積する。

メディア変換部300は、データストレージ部200に蓄積されたメディアデータ(映像、音声、画像の各データ)を、映像情報/位置・時刻情報に基づいて、IPネットワーク1を介して配信可能なフォーマット、および、受信側で視聴可能なフォーマットに変換する。この変換処理を経て生成された配信用のデータは、ストリーミング配信部400によりIPネットワーク1を介して視聴者に向け配信される。すなわち配信用データは、IPネットワーク1に接続されるパーソナルコンピュータ(PC)4、IPテレビジョン端末(IPTV)5、セットトップボックス(STB)6などに配信される。

【0018】

システム全体に係わる管理、制御はセッション・チケット管理部100により実施される。セッション・チケット管理部100は、システムへの参加を要求するクライアントの認証処理を実施し、要求元のクライアントへのサービスの提供の可否を判定する。またセッション・チケット管理部100は、モバイル端末a,b,c,d,eから送信された映像データをIPネットワーク1経由で収集し、データストレージ部200に蓄積するための制御なども行う。

【0019】

上記構成を基礎としてこの第1の実施形態では、各モバイル端末が備えるインターネットアクセス機能、動画撮影機能、および測位機能と、システム側に設けられるセッション・チケット管理部100、データストレージ部200、およびメディア変換部300とを有機的に機能させ、視差映像を簡易的に生成、配信可能とする手法につき説明する。

【0020】

図2は、視差画像について説明するための図である。立体的な映像のもとになる視差映像を生成するためには、複数の視差画像(フレーム)が必要である。視差画像は図2に示されるように、同じ対象物を複数の異なる視点から見た画像に差分が在ることにより得られる。この第1の実施形態では、この複数の視点をモバイル端末の動画撮影機能で代替することで、いわば観客の参加によるかたちでの視差映像の生成を実現する。

【0021】

図3は、第1の実施形態に係わる視差映像生成システムの一例を示す機能ブロック図である。図3のシステムは図1のセッション・チケット管理部100、データストレージ部200、メディア変換部300の機能を共通のサーバに実装したものとして捉えることが可能であり、このサーバをシステムサーバと称して参照符号500を付して示す。

【0022】

データストレージ部200は、図1に示される動画撮影機能付きのモバイル端末a,b,c,d,eにより取得された映像データをIPネットワーク1を介して収集する収集部としての機能の一部を担う。メディア変換部300は、収集部により収集された映像データから視差映像を生成する視差映像データ生成部としての機能の一部を担う。視差映像は、異なるモバイル端末で既定の時間内に近接する時刻に取得された画像フレームを含む映像データに基づいて生成される。例えば別々のモバイル端末で同時刻に撮影された二つの画像フレームの相関性が高ければ、これらのフレームから立体画像を生成することができる。

【0023】

[同時刻]は本実施形態では[既定の時間内に近接する時刻]を含む。実施形態では物理的に同じ瞬間を意味する同時刻だけでなく、誤差を含めた或る程度の時間的な広がりも、視差映像を生成するうえで支障の無い範囲での同時刻として取り扱う。

例えば一般的なTV放送では1秒間に約30枚の画像フレームが表示される。本技術分野ではこれを30fps(Frame Per Second)と表す。これは映像の時間分解能と捉えられる量である。

例えば30fpsの処理能力を持つモバイル端末では、ある静止画像 Picture(n)と次のPicture(n+1)との間の時間間隔は1/30[秒]すなわち0.033333...秒であり、およそ30msec[ミリ秒]となる。この1/2の15ミリ秒以内の時間差であれば許容範囲内と判断し、視差映像の生成に支障は無いものとして、システムは同時刻として取り扱うようにしても良い。

【0024】

もちろん実施形態における技術思想は上記数値に限定されるものではない。30msecの1/4あるいは1/8であっても精度は向上するので、却って好都合である。モバイル端末のスペックによっては60fpsで処理するもの、あるいは逆に15fpsで処理するものもあり、実施形態ではこのような違いを吸収する手法についても開示する。

【0025】

システムサーバ500は、受信データ処理部501、端末情報登録部502、映像データ分析部503、位置時刻管理部504、映像データ処理部505、相関処理部506、視差映像生成部507、エンコード部508、ファイルフォーマット部509、セグメンテーション部510、および、送信データ処理部511を備える。このうち受信データ処理部501、送信データ処理部511はIPネットワーク1に接続され、データの送受信に関わるインタフェース機能を担う。例えば受信データ処理部501はモバイル端末から送られてくるストリームデータ(映像データを含む)の受信処理に関わる処理を行う。送信データ処理部511はモバイル端末に向けライセンス、チケット情報データなどを送信するための処理を行う。

【0026】

端末情報登録部502は、モバイル端末を含むクライアントから端末情報(例えばユーザID、パスワード、MACアドレス、サポート可能な画像処理方式、画像処理能力、fpsベースでの処理スペックなどの情報)を収集し、これらの情報をシステムに登録するとともにデータベースDBに蓄積する。収集される情報には、画像データのデコードあるいはエンコードの際に必要になるパラメータ情報も含まれる。

【0027】

また端末情報登録部502は、登録された内容に基づいて、各クライアントへのライセンス・チケットなどを発行するための処理も行う。なお登録の際にモバイル端末との間で授受された情報のいくつかは、内部データベース(DB)、またはシステム外部のデータベースに蓄積される。

【0028】

映像データ分析部503は、モバイル端末から受信した映像データをモバイル端末から事前に得られた情報に基づき分析する。モバイル端末から事前に得られた情報をここではモバイル端末情報と称し、上記ユーザID、パスワード、MACアドレス、サポート可能な画像処理方式のほか、ここでは、例えば対応可能な画像エンコード・デコード方式、画面サイズ、単位時間当たりのフレーム数などである。これらの情報は端末情報登録部502により取得されてデータベースDBに蓄積されている。映像データ処理部505は映像データをデコードし、1枚1枚のフレームとして扱えるように処理する。すなわち映像データ処理部505は、モバイル端末の動画撮影機能で録画(取得)される映像の特性を示すパラメータ情報に基づいて映像データをデコードし、映像データから個々の画像フレームを復元する。

【0029】

なお、ここで必要となるパラメータ情報は、モバイル端末のキャリアにより予め公開されているケースがある。このようなケースでは例えば機種名称、電話番号、MACアドレスなどをキーとする問い合わせにより、必要な端末情報を公開されたデータベースから取得することが可能である。

【0030】

位置時刻管理部504は、映像データを撮影した際のモバイル端末の位置情報および絶対時刻情報、すなわち位置・時刻情報を管理する。すなわち位置時刻管理部504は、モバイル端末からIPネットワーク1を介して送信されてくるストリームデータから抽出された位置・時刻情報を、データストレージ部200(図1)に記録するための処理などを行う。

【0031】

位置情報、絶対時刻情報のいずれもGPSを介して取得される位置・時刻情報であり、画像フレームに付随するデータとして位置づけられる。このデータも映像データとともにデータベースDBに蓄積される。つまり各モバイル端末は映像データの撮影時に、その撮影時刻、詳しくは各フレームの撮影時刻と撮影位置とをGPS測位機能を用いて取得し、フレームごとに撮影位置情報、撮影時刻情報を対応付けて記録する。

【0032】

相関処理部506は、画像データ、およびその取得位置情報/絶対時刻情報に基づいて個々のフレーム間の相関性を検出する。この処理によりフレーム間の相関値が算出され、その値と既定の閾値との比較に基づいて、相関処理部506は、閾値以上の相関値を示すフレーム群をグルーピングする。すなわち相関処理部506は、既定の距離内および既定の時間内で撮影されたフレーム、例えば近い位置で同時刻に異なるモバイル端末で撮影されたフレームのうち互いの相関値が既定の閾値以上のフレーム群を一纏まりのグループとし、複数のグループを生成する。

【0033】

視差映像生成部507は視差映像を生成する。すなわち視差映像生成部507は、上記グループにそれぞれ含まれる画像フレームを時刻情報に基づいて時系列で配列して視差映像を生成する。その際、視差映像生成部507は、端末情報に示される対応画像処理方式なども参照し、フレーム群の各フレームを処理、集約する。

【0034】

エンコード部508は、生成された視差映像を、モバイル端末から取得した符号化方式・メディアなどの映像パラメータ情報に基づいて符号化する。ファイルフォーマット部509は、符号化された映像データをファイルとして生成する。生成されたファイルはビデオコンテンツ(Video Content)としてデータストレージ部200などに蓄積される。セグメンテーション部510は、符号化された映像データを、ライブ配信(ストリーム配信)のためのピースブロックとして生成する。ピースブロックP01,P02,…はデータストレージ部200などに蓄積される。

【0035】

ここで、視差映像の生成について説明する。視差映像を生成するための最初の手順として、まず、複数の視点がそれぞれどのような対象物を撮影しているかをマシンにより認知し、判断する必要がある。

図4は、複数のモバイル端末による視点を示す模式図である。図4には、視差映像生成のための選定(グルーピング)スキームが模式的に示される。図4には3台のモバイル端末a,b,cが示され、このうちモバイル端末a,bはシュートするプレーヤを撮影対象としており、モバイル端末cはゴールを守るキーパーを撮影対象としている。このようなケースでは、互いに同じ対象を撮影しているモバイル端末a,bからの映像データには高い相関性のあることが見込まれる。一方、異なる対象を撮影しているモバイル端末a,c、あるいはモバイル端末b,cからの映像データの相関性は低くなる。第1の実施形態ではこの知識を用いて、それぞれ相関が高い映像同士をグループ化して取り扱う。

【0036】

図5は、フレームのグループ化に必要な情報を説明するための模式図である。図5には視差映像生成のための伝送データ例が示される。複数のフレームをグループ化するためには、図5に示される各モバイル端末で取得された映像データ(フレーム)は当然のことながら、それぞれのモバイル端末の絶対位置情報と絶対時刻情報とが必要となる。

絶対時刻情報はフレーム間の同期を取るために必要になる。絶対位置情報と絶対時刻情報とのいずれも各モバイル端末においてGPSにより取得され、位置・時刻情報として映像データとともにシステムに送信される。

【0037】

第1の実施形態では位置情報を(X,Y,Z)の3次元座標で示し、時刻情報をtで示す。位置情報には端末ごとのインデックスを付し、合わせて4次元の情報を取り扱う。例えばモバイル端末で時刻tにおいて撮影された映像データには、(Xa,Ya,Za,t)なる位置・時刻情報が付随することになる。

【0038】

図6は、映像データの収集から配信用コンテンツの生成までの手順を概略的に示す模式図である。例えばそれぞれ位置・時刻情報(Xa,Ya,Za,t)、(Xb,Yb,Zb,t)を持つ複数の映像データ(フレーム)を比較し、互いの相関性が高い場合には概ねXa≒Xb,Ya≒Yb,Za≒Zbが成立する。

【0039】

つまりこれらのフレームは、既定の距離内に存在するモバイル端末で同時刻tに撮影されたものである。そのようなフレームが見つかればシステムはそれらをグループ化し、視差映像として順次蓄積する。そして蓄積されたデータを視聴者が視聴可能なエンコード方式・ファイルフォーマット形式に変換し、コンテンツとしてデータストレージ部200に保存する。または、ライブストリーミング用のデータとしてセグメンテーション化し、同様に保存する。次に、第1の実施形態における作用を説明する。

【0040】

図7は、モバイル端末をシステムに登録するための手順を示すシーケンス図である。ユーザはシステムへの登録により、自らの所有するモバイル端末を用いた映像データの撮影・送信/3D映像の受信に係わる意思表示を行う。

モバイル端末は、まず、システムに向けモバイル端末情報を送信する。送信されたモバイル端末情報は受信データ処理部501により受信される。モバイル端末情報とは、大別して2つの情報を含む。一方は<録画映像>であり、これは、当該モバイル端末に備わる動画撮影機能(ディジタルビデオカメラ)で取得される映像の特性(パラメータ)情報を示す。このパラメータ情報には取得映像の符号化方式、画面サイズ、メディアのビットレートなどがある。

【0041】

他方は<視聴映像>であり、これは、当該モバイル端末(あるいは視聴を要求するクライアント)で視聴可能な(サポートされている)映像の特性(パラメータ)情報を示す。である。このパラメータ情報には対応符号化方式(H.234、MPEG2、MPEG4など)、対応画面サイズ、対応ビットレート、対応3D方式などがある。

【0042】

図7において、モバイル端末から送信された[モバイル端末情報]は図3の受信データ処理部501により受信される。受信データ処理部501は受信した情報を[モバイル端末情報]として認識すると、この[モバイル端末情報]を端末情報登録部502に渡す。端末情報登録部502は[モバイル端末情報]をデータベースDBに登録し、ライセンス、チケットなどの情報を生成する。生成された情報は端末情報登録部502から送信データ処理部511を介して、宛先のモバイル端末に通知される。

ライセンス、チケットとは電子的なデータであり、映像ストリームデータなどの送付先に関する情報、映像を視聴する際の配信要求先、またはその配信要求先を問い合わせるための問い合わせ先に関する情報などを含む。

【0043】

なお、図7に示されるシーケンスは映像データの撮影と視差映像の視聴とを同じモバイル端末で視聴することを前提として記載されているが、視聴可能な端末を、映像を撮影した端末だけに限る必要はない。つまり映像データの提供に関わらない端末において3D映像の配信を受けられるようにすることも可能である。要するにモバイル端末での<映像情報>と、登録に伴い発行されるライセンス・チケットなどの払い出しの関係が成立すれば、視聴そのものはモバイル端末に限らず、撮影機能を持たない一般のクライアント端末で行うことが可能である。

【0044】

図8は、第1の実施形態におけるシステムがモバイル端末からストリームデータを受信する際の手順を示すシーケンス図である。図8には、図7のシーケンスが完了し端末情報の登録を済ませたモバイル端末から送付されるストリームデータを、システムが受信する際の手順が示される。ストリームデータとは個々のモバイル端末で取得された映像データ情報と、その撮影位置情報および撮影時刻情報(位置・時刻情報)を含むデータである。映像データの一例としては例えば図5に示される、視差映像生成のための元になる伝送データである。

【0045】

図8において、モバイル端末から送信されたストリームデータは受信データ処理部501において受信される。受信データ処理部501は受信したデータをストリームデータとして認識すると、ストリームデータから<録画映像データ>を抽出して映像データ分析部503に渡し、<位置・時刻情報>を抽出して位置時刻管理部504に渡す。すなわち受信データ処理部501は、録画データと、各フレームに付随する撮影位置および撮影時刻をストリームデータから抽出する。

【0046】

<録画映像データ>を受信した映像データ分析部503は、当該モバイル端末で撮影された映像のパラメータ情報を用いて<録画映像データ>に対する一時処理を施す。パラメータ情報は符号化方式やメディアのメタ情報などであり、DBに予め登録され管理されている。一時処理には例えば画面サイズの調整などがあり、処理後の一次処理録画映像データは映像データ処理部505に渡される。

【0047】

映像データ処理部505は一次処理録画映像データをデコード処理し、フレームレートの調整およびタイミング調整を施して、1枚の画像フレームを構成するフレームデータを生成する。このフレームデータは相関処理部506に渡される。この相関処理部506には、フレームデータに対応する位置・時刻情報が位置時刻管理部504から与えられる。フレームデータと位置・時刻情報とが与えられることで、相関処理部506は、同時刻において取得された各モバイル端末からの画像データを取得することになる。これらの情報を用いて相関処理部506はフレーム間の相関を取る。

【0048】

図9は視差映像の生成に関わる手順を示すシーケンス図である。図9には、同時刻において撮影された各モバイル端末からの画像データが相関処理部506に入力されたのち、視差映像が生成されるまでのシーケンスが示される。

【0049】

図9において、映像データ処理部505により生成されたフレームデータおよび位置・時刻情報は、相関処理部506に入力される。相関処理部506は相関算出処理を実行し、同時刻のフレームの組み合わせごとに相関値を算出する。相関算出アルゴリズムとしては画素相関アルゴリズム、輝度相関アルゴリズム、あるいは周波数領域に変換してからの相互相関アルゴリズムなどを適用できる。

【0050】

例えば相関処理部506は、複数のフレームのうち画素相関アルゴリズム、輝度相関アルゴリズム、および、輝度値を周波数領域に変換したのちの相互相関アルゴリズム、のいずれかのアルゴリズムに基づき算出された相関値が既定の閾値以上のフレーム群をグループ化する。このほか、およそ符号化方式、画像認識方式、画像処理方式で適用・応用・研究検討されてきたさまざまな手法を用いることが可能である。

【0051】

次に相関処理部506は、算出された相関値を既定の閾値と比較し、閾値以上の相関性を示すフレーム同士をグループ化する。視差映像生成のための選定(グルーピング)スキームは図4において既に示される。すなわち相関処理部506は、位置時刻管理部504やデータベースDBにデータとしての位置・時刻情報をフレームごとに参照し、既定の距離内、および同時刻として許容される時間範囲内で撮影されたフレームのうち、互いの相関値が既定の閾値以上のフレーム群をグループ化する。

【0052】

グループ化処理を経たのち、[グループ化したフレームデータ]と[位置・時刻情報]とが視差映像生成部507に渡される。視差映像生成部507はこの[グループ化したフレームデータ]と[位置・時刻情報]とを用いて視差フレームを生成する。その際、視差映像生成部507は、位置情報データと、DBから取得した<視聴映像>の3D対応方式の情報とを視差フレームの生成基準とする。

【0053】

3D対応方式には、右目用・左目用の2枚の画像フレームを用いる「平行法」や「交差法」を技術ベースとするものや、特殊な偏光グラスを着用することで実現する方式などがある。今後あらたな標準が策定されたとしても、DBに登録された情報を参照して視差映像生成部507の機能を拡張すれば柔軟に対応可能である。視差フレームデータの生成後、この[視差フレームデータ]と[時刻情報データ]とがエンコード部508に渡される。

【0054】

図10は、第1の実施形態において、それぞれの画像フレーム情報から映像コンテンツを生成するための手順を示すシーケンス図である。図9のシーケンスに引き続き、[視差フレームデータ]と[時刻情報データ]とを渡されたエンコード部508は、DBから取得した<視聴映像>の符号化方式やメディアのメタ情報に基づいて符号化した映像を生成する。符号化済みのデータ、すなわち視差映像データはファイルフォーマット部509またはセグメンテーション部510、あるいはその双方に渡される。これは、最終的に符号化済みのデータをコンテンツファイルとするか、Video on Demand(VOD)によるライブ配信用途のピースデータとするか、またはその両方を行うかに応じて制御される。以上の作用により、複数のモバイル端末で撮影された画像データから立体映像コンテンツが生成される。次に、生成された立体映像コンテンツの配信につき説明する。

【0055】

図11は、第1の実施形態における映像コンテンツの配信に関わる部分を示すシステム図である。図1に対応させた場合、図1のストリーミング配信部400は図11に示すように、例えば複数の配信サーバ4a,4b,4cを備える。各配信サーバ4a,4b,4cはそれぞれ異なる画像エンコード方式に対応する(それぞれA方式,B方式,C方式とする)。どのコンテンツ(あるいはストリーム)をどの配信サーバで送出するかは、配信サーバ管理部600により制御される。

【0056】

図12は、第1の実施形態に係わる視差映像生成システムの要部を示す機能ブロック図である。図12のシステムは図1のセッション・チケット管理部100、ストリーミング配信部400の機能を共通のサーバに実装したものとして捉えることが可能である。ここでは図3のシステムサーバ500にその機能を実装するとする。

【0057】

図12においてシステムサーバ500は、受信データ処理部501、ライセンス・チケット情報取得部512、配信サーバ情報取得部513、配信サーバ問い合わせ部514、配信サーバ確定部515、送信データ処理部511、および、ストリーミング配信部400を備える。このうちストリーミング配信部400は配信サーバ4a,4b,4c,4dを備える。配信サーバ4a,4b,4c,4dは予めデータベースDBに、その対応方式の情報とともに登録される。

【0058】

ライセンス・チケット情報取得部512は、アクセス元の端末(モバイル端末、固定端末(PCなど)を含む)に対する認証(Authentication)処理を行う。すなわちライセンス・チケット情報取得部512は、アクセス元の端末から送信されたライセンス、チケットなどの情報をデータベースDBにおける登録内容と照らし合わせ、その正当性を検証する。

【0059】

配信サーバ情報取得部513は、データベースDBを検索して、配信すべきコンテンツ(あるいはストリーム)に対応する方式をサポートする配信サーバを配信サーバ4a,4b,4c,4dのうちから見い出す。配信サーバ問い合わせ部514は、配信サーバ4a,4b,4c,4dに対して現在の状況(standby/busy、Session可能数など)を問い合わせる。この問い合わせに対しては配信サーバ4a,4b,4c,4dに限らず、その代理サーバ(Proxy)が応答するようにしても良い。配信サーバ確定部515は、映像データの要求元クライアント(モバイル端末、他端末など)への映像配信に最適な配信サーバを決定する。

図12、および次の図13においては、ライセンスやチケットなどの情報が、映像を直接視聴する配信要求元ではなく、その配信要求元を問い合わせるための問い合わせ先に関する情報である場合が想定される。これによれば他端末からの配信要求にも応えることが可能になる。

【0060】

図13は、第1の実施形態における映像配信に関わる手順を示すシーケンス図である。図13には、立体映像の配信を要求するクライアントが、適した配信サーバにアクセスするための情報を得るための手順が示される。

図13において、配信要求元のモバイル端末や他端末から送信された[ライセンス、チケットなどの情報]は、受信データ処理部511により受信される。受信データ処理部511は[ライセンス、チケットなどの情報]を認識すると、この[ライセンス、チケットなどの情報]をライセンス・チケット情報取得部512に渡す。

【0061】

ライセンス・チケット情報取得部512は、受信データ処理部511から送付された[ライセンス、チケットなどの情報]が信頼・承認できるものであるか否かを検証する。この処理に際してはデータベースDBにおける登録内容が参照される。[ライセンス、チケットなどの情報]が改竄されたもの、不正入手されたもの、また、ライセンスやチケットそのものは正当なものであるが、例えば視聴有効期限が過ぎていたものなどの理由により信頼・承認できないものであると判断されれば、処理はここで停止される。あるいは、配信要求を拒否する旨、[ライセンス、チケットなどの情報]が信頼・承認できないものである旨を配信要求元に通知したうえで処理を停止するようにしても良い。

【0062】

[ライセンス、チケットなどの情報]が信頼・承認できるものであれば、その旨がライセンス・チケット情報取得部512により認識される。そしてライセンス・チケット情報取得部512は、承認した要求元の端末に適する3D対応方式の情報をデータベースDBから取り出し、配信サーバ情報取得部513に渡す。

【0063】

配信サーバ情報取得部513は、この対応方式の状況をキーインデックスとしてデータベースDBを検索し、登録された配信サーバのうち当該対応方式をサポートする配信サーバを特定する。そうして配信サーバ情報取得部513は、特定した配信サーバを一意に識別できる情報、例えばUniform Resource Locator (URL)やIPアドレスなどの情報を[問い合わせ先の情報]として取得する。

【0064】

配信サーバ情報取得部513は、取得した[問い合わせ先の情報]を配信サーバ問い合わせ部514に渡す。配信サーバ問い合わせ部514はこの[問い合わせ先の情報]を元に[問い合わせ要求]を各配信サーバに送付する。これに対する問い合わせ応答は、各配信サーバから配信サーバ問い合わせ部514に返送される。配信サーバ問い合わせ部514は、各配信サーバからの問い合わせ応答をまとめ、[問い合わせ先の情報]と[問い合わせ応答結果]とを配信サーバ確定部515に渡す。

【0065】

配信サーバ確定部515は各配信サーバの現在の状況情報(standby / busyあるいはセッション可能数など)を参照し、配信要求時点において最適な配信サーバを決定する。配信サーバが確定されると配信サーバ確定部515は、この配信サーバに対応する[配信サーバの宛て先、URI情報]を、配信要求元のモバイル端末・他端末に送信データ処理部501経由で送信する。これを受けたモバイル端末・他端末は[配信サーバの宛て先、URI情報]にアクセスすることで3D映像の配信を受けることができる。

【0066】

以上説明したようにこの第1の実施形態では、インターネットアクセス機能と、GPS機能と、動画撮影機能とを具備するモバイル端末により取得された映像データを、IPネットワーク1を介して収集する。収集された映像データを、モバイル端末の撮影機能に係わるパラメータ情報に基づき複数のフレームにデコードする。複数のフレーム間の相関値を算出し、閾値判定により相関値の高いフレーム群をグループ化する。そうしてグループ化したフレームから、視聴を要求するクライアントでサポートされている映像のパラメータ情報に基づいて視差映像を生成する。処理に必要となる映像データの撮影位置および時刻は、モバイル端末の備えるGPS機能を利用して取得するようにしている。

【0067】

上記構成および作用によれば、モバイル端末で個々に取得された映像データを視差映像生成のための元データとして利用することができるようになり、顧客あるいはユーザの自由な意思のもと、3D映像などの魅力的なコンテンツを生成することが可能になる。このシステムの構築および運用に際しては、テレビ局が主導権を握る必要は必ずしもない。つまり従来では放映権を獲得したテレビ局がその全てをまかなってきた3D映像コンテンツの配信を、テレビ局の介在なしに実現することが可能になり、新たなビジネスモデルを提案することができる。すなわち第1の実施形態において説明した技術を用いれば、立体的な魅力ある映像の放映や配信を、顧客の参加により、インターネットを介在して容易かつ簡易に実現することが可能になる。

これらのことから、視差映像を簡易に生成でき、これにより立体映像を手軽に提供できるようにした視差映像生成システム、視差映像生成方法、映像配信システムおよび映像配信方法を提供することが可能となる。

【0068】

[第2の実施形態]

図14は、視差映像の生成に係わる第2の実施形態を説明するための図である。この実施形態では相関の高いフレームを抽出することが難しいケースへの対応について説明する。このようなケースは例えばスタジアムにおいて観客動員数が少なく、映像を撮影可能なモバイル端末の分布がまばら、つまりモバイル端末間の距離が長いときに生じ得る。

【0069】

相関値の低い画像フレームしか撮影できない上記のようなケースでは、フレーム群を含むグループを少ししか生成できないか、あるいは生成できない。そこで第2の実施形態では、補間用の画像フレームを生成することを考える。

【0070】

図14はそのような状況を想定するものである。例えば視点AおよびBにおいて画像フレームが撮影されたとする。視点A,B間の距離(Distance)が長いと各視点A,Bで得られるフレームの相関性は低くなり、間隔の程度によってはグルーピング可能なフレームが一つも存在しないことが考えられる。つまり位置AにおけるフレームAと位置BにおけるフレームBとの相関値は、視点A,Bの距離によっては閾値を下回ると考えられる。

【0071】

そこで第2の実施形態では、フレームAとフレームBとを用いて補間フレームA′を生成する。補間フレームの生成は主に相関処理部506の演算処理により実現される。補間フレームA′は、視点A′の位置情報(例えば視点Aからの距離Δd)を用いて、例えばフレームAとフレームBのそれぞれの画素値を内挿演算するなどの画像処理により生成することができる。

【0072】

すなわち相関処理部506は、複数のフレームを画像処理し、これらの複数のフレームを補間する新たなフレームを生成する。このようにすればフレームAとA′とのグループ、フレームA′とBとのグループを作成できるようになり、相関処理部506はそのようなグルーピング処理を行う。このようにして生成したグループから視差映像を生成することができる。

従って第2の実施形態によれば、第1の実施形態で得られる効果に加えて、フレームのグルーピングが困難なケースにも対処することが可能になる。

【0073】

なお、実画像フレームA,Bの相関があまりにも低すぎるケースでは、生成された補間画像フレームA′を用いてもグルーピングができないことも考えられ、生成される視差映像の完成度も低くなる。相関値に下限閾値を設けておくことで、このようなケースにも対応することが可能である。

【0074】

例えば図14における左端のフレームの相関値は70であり、これは相関性がないとしてグルーピングの対象から除外される。右に移るほどに相関性は徐々に高まり、値80では十分な相関性はないものの、擬似視差映像としてデータベースに順次蓄積される。値90を超えれば十分な相関性有りとして、生成された補間画像フレームから生成された視差映像は擬似視差映像としてデータベースに蓄積される。

【0075】

[第3の実施形態]

図15は、視差映像の生成に係わる第3の実施形態を説明するための図である。図15においては、視点Aと対象物との距離、および視点Bと対象物の距離の差が大きいケースを想定する。このようなケースでは遠近差が大きく、視点Aでは大きくはっきり見える対象物も、視点Bでは不鮮明になることが考えられる。

【0076】

そこで第3の実施形態では、撮影位置による遠近差を考慮してフレーム間の相関性を判定することを考える。すなわちフレーム間の相関性が高いと判定されたケースでも、撮影位置の状況から遠近差が大きく、視差映像の生成に適さない場合がある。そこで第3の実施形態では、相関値に加えてScalable(倍率値)を加味し、フレーム間の相関性を判定するようにする。

【0077】

この判定は主に相関処理部506の演算処理により実現される。すなわち相関処理部506は、フレーム間の相関値に加えて倍率値を参照して複数のフレームをグループ化する。例えば、倍率は2.0以下というような閾値を設けることにより、相関値は高いがグルーピング対象としては除外すべき対象であると判定することが可能になる。

【0078】

図15において例えばフレーム間の相関性が完全に同一である場合を値100と定義したとすると、値70では、単一的にはフレーム間に十分な相関性はないが、相似性(Scale)で評価すれば十分な相関性があると看做せるフレームについてはグルーピングの対象とし、擬似視差映像の生成に供するようにする。値90以上のフレームについては十分な相関性があるとして、擬似視差映像を生成する。以上のようにすれば、第1の実施形態で得られる効果に加え、鮮明さを保った3D映像を形成することが可能になる。

【0079】

なお本発明は上記実施形態に限定されるものではない。

例えば図12においてはストリーミング配信部400をシステムサーバ500に一体化して示したが、ストリーミング配信部400をシステムサーバ500とは別体で実装しても良い。このようなケースでは、図13の問い合わせ要求/問い合わせ応答は送信データ処理部501/受信データ処理部511を介して、ストリーミング配信部400とシステムサーバ500との間で授受される。

【0080】

また、視差映像、あるいは視差映像から生成された立体映像の供給を受けるクライアントは、映像データを提供したモバイル端末に限られるものではない。映像データをシステムに提供しない端末、あるいは撮影機能を備えていない端末においても立体映像の提供を受けられるようにすることができる。これは、サービスの提供に係わるビジネスモデルに応じて自由に可変できる事柄であり、例えばセッション・チケット管理部100における認証処理、ライセンス提供などの機能をシステム要求に応じて設計すれば良い。あるいは逆に、例えば立体映像の配信に際して、映像データをシステムに提供した端末を優先するなどのビジネスモデルも考え得る。

【0081】

また実施形態では位置情報をGPSにより取得するようにした。これに代えて角速度センサ(ジャイロセンサ)を備えるモバイル端末を用いれば、同様の機能を実現できる。角速度センサを用いれば撮像機の視点が何処を向いているかを検知することができるし、その情報を例えば補助的に用いて画像フレーム間の相関値を算出することも可能である。

【0082】

また第3の実施形態では倍率値を用いて不鮮明なフレームを除外するようにしたが、例えば、対象物に遠いモバイル端末が精細なフォーカスで撮影し、対象物に近いモバイル端末のフォーカスが甘ければ、両者で撮影されたフレームの鮮明さは同程度になると思われる。つまりフレームのグループ化に際してフレームごとのフォーカスを指標として相関値を再評価することも可能である。

【0083】

フレームのフォーカスに係わる情報も、モバイル端末の動画撮影機能で録画(取得)される映像の特性を示すパラメータ情報として取得可能である。このように撮影時のフォーカスも考慮すれば3D映像の形成にさらに寄与できるであろう。

【0084】

本発明のいくつかの実施形態を説明したが、これらの実施形態は例として提示するものであり、発明の範囲を限定することは意図していない。これら新規な実施形態は、その他の様々な形態で実施されることが可能であり、発明の要旨を逸脱しない範囲で、種々の省略、置き換え、変更を行うことができる。これら実施形態やその変形は、発明の範囲や要旨に含まれるとともに、特許請求の範囲に記載された発明とその均等の範囲に含まれる。

【符号の説明】

【0085】

1…IPネットワーク、a,b,c,d,e…モバイル端末、100…セッション・チケット管理部、200…データストレージ部、300…メディア変換部、400…ストリーミング配信部、4…パーソナルコンピュータ(PC)、5…IPTV、6…STB、7…PDC端末、501…受信データ処理部、502…端末情報登録部、503…映像データ分析部、504…位置時刻管理部、505…映像データ処理部、506…相関処理部、507…視差映像生成部、508…エンコード部、509…ファイルフォーマット部、510…セグメンテーション部、511…送信データ処理部、4a,4b,4c…配信サーバ、500…システムサーバ、600…配信サーバ管理部、512…ライセンス・チケット情報取得部、513…配信サーバ情報取得部、514…配信サーバ問い合わせ部、515…配信サーバ確定部、4a,4b,4c,4d…配信サーバ

【技術分野】

【0001】

本発明の実施形態は、例えばIPネットワークを介してライブ映像のストリーム配信あるいは動画像コンテンツのVideo on demand (VOD)配信などを実現する映像配信システムと、この種のシステムに適用可能な視差映像生成システムおよび方法に関する。

【背景技術】

【0002】

近年ではインターネットに繋がれた端末でテレビ放送を視聴することができる。この種の映像配信システムでは、予め用意されたコンテンツの放送だけでなく、スタジアムや競技場などで行われるスポーツや、コンサートのライブ中継なども実施されるようになってきている。

【0003】

Internet Protocol(IP)ネットワークなどの媒体を介して視聴者にビデオストリームを配信する、いわゆるIP Television(IPTV)サービスが知られている。例えばIP-Video on Demand(IP−VOD)、あるいは地上D−IP再送信などの技術が知られている。近年ではIntegrated Services Digital Broadcasting − Terrestrial(ISDB−T)に準拠するワンセグサービスを利用するユーザも多い。

【0004】

さらに、動画共有サイトを介してユーザ間で映像コンテンツを共有するシステムも構築されている。この種のシステムでは、投稿者からサーバにアップロードされた映像コンテンツをインターネット上に公開できるようになっている。

【先行技術文献】

【特許文献】

【0005】

【特許文献1】特表2011−519192号公報

【特許文献2】特開2010−98720号公報

【発明の概要】

【発明が解決しようとする課題】

【0006】

ところで、立体映像の生成に関する技術開発が盛んである。シーンを高精細かつ多角的・多面的に捉えた映像を加工・画像処理することで、視聴者に3次元(3D)の立体的な映像を提供することができる。この技術は映像配信システムでも用いられ、例えばスポーツのダイナミックな動作やゴールシーンといった瞬間的・決定的な映像が3D化され、魅力的な映像コンテンツとして放映・配信されるようになってきている。

【0007】

3次元(3D)映像を視聴者に提供するための方式には、例えば特殊ディスプレイによる方式や、特殊偏光メガネを用いる方式など、いくつかの標準が策定されつつある。しかしながらいずれの方式においても基本となる技術そのものは、複眼視による撮影、または擬似映像の生成により得られる視差映像を利用することである。

【0008】

同じ対象を複数の異なる視点から撮影した画像(フレーム)を視差画像と称する。視差映像は複数の視差画像を時系列で配列して得られる動画像であり、3D映像はその一つの形態である。

映像コンテンツのストリーム配信は、放映権を獲得したテレビ局がその全てを賄ってきた。インターネットの爆発的普及とアクセス端末の高機能化に伴って映像のストリーミング配信は当然のように行われるようになったが、3D映像の生成や配信に関しては、放映権を獲得したテレビ局が独占的に実施している状況にある。

【0009】

一方、近年のわが国ではほぼ全ての人が携帯電話端末を所有しており、その数が飽和状態となるほどに携帯電話端末は普及している。機能の面でも高機能化が著しく、音声通話、メール送受信、インターネットアクセスといった基本的機能に加えて、ディジタルカメラ機能・ディジタルビデオ機能を実装する端末も今や普通である。さらには、GPS(Global Positioning System)により自らの位置情報を取得したり、ジャイロセンサなどを備えるものもある。そこで、このような端末の諸機能を利用すれば、テレビ局に頼らずに視差映像を生成して3D映像を視聴者に配信し得る可能性があるが、そのような技術は未だ知られていない。

目的は、視差映像を簡易に生成でき、これにより立体映像を手軽に提供できるようにした視差映像生成システム、視差映像生成方法、映像配信システムおよび映像配信方法を提供することにある。

【課題を解決するための手段】

【0010】

実施形態によれば、視差映像生成システムは、モバイル端末によりアクセス可能なネットワークを利用する。視差映像生成システムは、収集部と、視差映像データ生成部とを具備する。収集部は、動画撮影機能を備える撮像機付きモバイル端末により取得された映像データをネットワークを介して収集する。視差映像データ生成部は、異なる撮像機付きモバイル端末で取得された映像データに基づいて、収集部により収集された映像データから視差映像を生成する。

【図面の簡単な説明】

【0011】

【図1】第1の実施形態に係わる映像配信システムの一例を示すシステム図。

【図2】視差画像について説明するための図。

【図3】第1の実施形態に係わる視差映像生成システムの一例を示す機能ブロック図。

【図4】複数のモバイル端末による視点を示す模式図。

【図5】フレームのグループ化に必要な情報を説明するための模式図。

【図6】映像データの収集から配信用コンテンツの生成までの手順を概略的に示す模式図。

【図7】モバイル端末を映像配信システムに登録するための手順を示すシーケンス図。

【図8】第1の実施形態に関わる映像配信システムがモバイル端末からストリームデータを受信する際の手順を示すシーケンス図。

【図9】視差映像の生成に関わる手順を示すシーケンス図。

【図10】それぞれの画像フレーム情報から映像コンテンツを生成するための手順を示すシーケンス図。

【図11】第1の実施形態における映像コンテンツの配信に関わる部分を示すシステム図。

【図12】第1の実施形態に係わる視差映像生成システムの要部を示す機能ブロック図。

【図13】第1の実施形態における映像配信に関わる手順を示すシーケンス図。

【図14】視差映像の生成に係わる第2の実施形態を説明するための図。

【図15】視差映像の生成に係わる第3の実施形態を説明するための図。

【発明を実施するための形態】

【0012】

[第1の実施形態]

図1は、第1の実施形態に係わる映像配信システムの一例を示すシステム図である。図1に示されるシステムは、インターネットに代表されるIPネットワーク(IP Network)1を利用するシステムである。IPネットワーク1としては他にも、Virtual Private Network (VPN)技術を応用した専用ネットワークなどがある。

【0013】

IPネットワーク1はモバイル端末によりアクセス可能なネットワークである。第1の実施形態ではモバイル端末の一例として、インターネットアクセス機能を備えるモバイル端末a,b,c,d,eを想定する。モバイル端末a,b,c,d,eとしてはセルラフォン端末、Personal Handy-phone System(PHS)端末、(Personal Digital Assistants)PDA端末、PDC(Personal Digital Cellular)端末、スマートフォン、モバイルパソコンなどが挙げられる。

【0014】

モバイル端末a,b,c,d,eは動画撮影機能を備え、保持するユーザの操作に応じて、あるいは事前の設定などにより、撮影した映像データをIPネットワーク1に送信する。なお映像データには音声を含んでも良い。

またモバイル端末a,b,c,d,eは、GPSを利用して自らの位置を測位する機能を備える。この種の機能は近年では多くのモバイル端末に搭載されており、例えばこの測位機能と、IPネットワーク1に備わる地図データベースとを連携させることにより、ナビゲーションアプリを利用ことができる。モバイル端末a,b,c,d,eは位置情報に加えて時刻情報も取得する。すなわちモバイル端末a,b,c,d,eは測位衛星としてのGPS衛星から到達する電波を用いて、位置情報および時刻情報を算出する測位処理部を備える。

【0015】

モバイル端末a,b,c,d,eは撮影した映像データと併せて、映像データの撮影時刻と撮影位置とをIPネットワーク1に送信する。撮影時刻、撮影位置ともに、GPSで取得された時刻情報、位置情報を反映するデータである。具体的にはモバイル端末a,b,c,d,eは、映像データに含まれるフレームごとの撮影時刻と撮影位置とをIPネットワーク1に送信する。フレームの撮影時刻と撮影位置とは各フレームごとに対応付けられるデータであり、この種のデータを位置・時刻情報と称することにする。

【0016】

IPネットワーク1には、セッション・チケット管理部100、データストレージ部200、メディア変換部300、およびストリーミング配信部400が接続される。セッション・チケット管理部100、データストレージ部200、メディア変換部300、およびストリーミング配信部400はそれぞれ個別に複数のコンピュータに実装されても良いし、同じコンピュータデバイスに複数の処理機能として実装されても良い。

【0017】

モバイル端末a,b,c,d,eから送信された映像データおよび位置・時刻情報はデータストレージ部200に蓄積される。すなわちデータストレージ部200は、映像情報と位置・時刻情報とを蓄積する。

メディア変換部300は、データストレージ部200に蓄積されたメディアデータ(映像、音声、画像の各データ)を、映像情報/位置・時刻情報に基づいて、IPネットワーク1を介して配信可能なフォーマット、および、受信側で視聴可能なフォーマットに変換する。この変換処理を経て生成された配信用のデータは、ストリーミング配信部400によりIPネットワーク1を介して視聴者に向け配信される。すなわち配信用データは、IPネットワーク1に接続されるパーソナルコンピュータ(PC)4、IPテレビジョン端末(IPTV)5、セットトップボックス(STB)6などに配信される。

【0018】

システム全体に係わる管理、制御はセッション・チケット管理部100により実施される。セッション・チケット管理部100は、システムへの参加を要求するクライアントの認証処理を実施し、要求元のクライアントへのサービスの提供の可否を判定する。またセッション・チケット管理部100は、モバイル端末a,b,c,d,eから送信された映像データをIPネットワーク1経由で収集し、データストレージ部200に蓄積するための制御なども行う。

【0019】

上記構成を基礎としてこの第1の実施形態では、各モバイル端末が備えるインターネットアクセス機能、動画撮影機能、および測位機能と、システム側に設けられるセッション・チケット管理部100、データストレージ部200、およびメディア変換部300とを有機的に機能させ、視差映像を簡易的に生成、配信可能とする手法につき説明する。

【0020】

図2は、視差画像について説明するための図である。立体的な映像のもとになる視差映像を生成するためには、複数の視差画像(フレーム)が必要である。視差画像は図2に示されるように、同じ対象物を複数の異なる視点から見た画像に差分が在ることにより得られる。この第1の実施形態では、この複数の視点をモバイル端末の動画撮影機能で代替することで、いわば観客の参加によるかたちでの視差映像の生成を実現する。

【0021】

図3は、第1の実施形態に係わる視差映像生成システムの一例を示す機能ブロック図である。図3のシステムは図1のセッション・チケット管理部100、データストレージ部200、メディア変換部300の機能を共通のサーバに実装したものとして捉えることが可能であり、このサーバをシステムサーバと称して参照符号500を付して示す。

【0022】

データストレージ部200は、図1に示される動画撮影機能付きのモバイル端末a,b,c,d,eにより取得された映像データをIPネットワーク1を介して収集する収集部としての機能の一部を担う。メディア変換部300は、収集部により収集された映像データから視差映像を生成する視差映像データ生成部としての機能の一部を担う。視差映像は、異なるモバイル端末で既定の時間内に近接する時刻に取得された画像フレームを含む映像データに基づいて生成される。例えば別々のモバイル端末で同時刻に撮影された二つの画像フレームの相関性が高ければ、これらのフレームから立体画像を生成することができる。

【0023】

[同時刻]は本実施形態では[既定の時間内に近接する時刻]を含む。実施形態では物理的に同じ瞬間を意味する同時刻だけでなく、誤差を含めた或る程度の時間的な広がりも、視差映像を生成するうえで支障の無い範囲での同時刻として取り扱う。

例えば一般的なTV放送では1秒間に約30枚の画像フレームが表示される。本技術分野ではこれを30fps(Frame Per Second)と表す。これは映像の時間分解能と捉えられる量である。

例えば30fpsの処理能力を持つモバイル端末では、ある静止画像 Picture(n)と次のPicture(n+1)との間の時間間隔は1/30[秒]すなわち0.033333...秒であり、およそ30msec[ミリ秒]となる。この1/2の15ミリ秒以内の時間差であれば許容範囲内と判断し、視差映像の生成に支障は無いものとして、システムは同時刻として取り扱うようにしても良い。

【0024】

もちろん実施形態における技術思想は上記数値に限定されるものではない。30msecの1/4あるいは1/8であっても精度は向上するので、却って好都合である。モバイル端末のスペックによっては60fpsで処理するもの、あるいは逆に15fpsで処理するものもあり、実施形態ではこのような違いを吸収する手法についても開示する。

【0025】

システムサーバ500は、受信データ処理部501、端末情報登録部502、映像データ分析部503、位置時刻管理部504、映像データ処理部505、相関処理部506、視差映像生成部507、エンコード部508、ファイルフォーマット部509、セグメンテーション部510、および、送信データ処理部511を備える。このうち受信データ処理部501、送信データ処理部511はIPネットワーク1に接続され、データの送受信に関わるインタフェース機能を担う。例えば受信データ処理部501はモバイル端末から送られてくるストリームデータ(映像データを含む)の受信処理に関わる処理を行う。送信データ処理部511はモバイル端末に向けライセンス、チケット情報データなどを送信するための処理を行う。

【0026】

端末情報登録部502は、モバイル端末を含むクライアントから端末情報(例えばユーザID、パスワード、MACアドレス、サポート可能な画像処理方式、画像処理能力、fpsベースでの処理スペックなどの情報)を収集し、これらの情報をシステムに登録するとともにデータベースDBに蓄積する。収集される情報には、画像データのデコードあるいはエンコードの際に必要になるパラメータ情報も含まれる。

【0027】

また端末情報登録部502は、登録された内容に基づいて、各クライアントへのライセンス・チケットなどを発行するための処理も行う。なお登録の際にモバイル端末との間で授受された情報のいくつかは、内部データベース(DB)、またはシステム外部のデータベースに蓄積される。

【0028】

映像データ分析部503は、モバイル端末から受信した映像データをモバイル端末から事前に得られた情報に基づき分析する。モバイル端末から事前に得られた情報をここではモバイル端末情報と称し、上記ユーザID、パスワード、MACアドレス、サポート可能な画像処理方式のほか、ここでは、例えば対応可能な画像エンコード・デコード方式、画面サイズ、単位時間当たりのフレーム数などである。これらの情報は端末情報登録部502により取得されてデータベースDBに蓄積されている。映像データ処理部505は映像データをデコードし、1枚1枚のフレームとして扱えるように処理する。すなわち映像データ処理部505は、モバイル端末の動画撮影機能で録画(取得)される映像の特性を示すパラメータ情報に基づいて映像データをデコードし、映像データから個々の画像フレームを復元する。

【0029】

なお、ここで必要となるパラメータ情報は、モバイル端末のキャリアにより予め公開されているケースがある。このようなケースでは例えば機種名称、電話番号、MACアドレスなどをキーとする問い合わせにより、必要な端末情報を公開されたデータベースから取得することが可能である。

【0030】

位置時刻管理部504は、映像データを撮影した際のモバイル端末の位置情報および絶対時刻情報、すなわち位置・時刻情報を管理する。すなわち位置時刻管理部504は、モバイル端末からIPネットワーク1を介して送信されてくるストリームデータから抽出された位置・時刻情報を、データストレージ部200(図1)に記録するための処理などを行う。

【0031】

位置情報、絶対時刻情報のいずれもGPSを介して取得される位置・時刻情報であり、画像フレームに付随するデータとして位置づけられる。このデータも映像データとともにデータベースDBに蓄積される。つまり各モバイル端末は映像データの撮影時に、その撮影時刻、詳しくは各フレームの撮影時刻と撮影位置とをGPS測位機能を用いて取得し、フレームごとに撮影位置情報、撮影時刻情報を対応付けて記録する。

【0032】

相関処理部506は、画像データ、およびその取得位置情報/絶対時刻情報に基づいて個々のフレーム間の相関性を検出する。この処理によりフレーム間の相関値が算出され、その値と既定の閾値との比較に基づいて、相関処理部506は、閾値以上の相関値を示すフレーム群をグルーピングする。すなわち相関処理部506は、既定の距離内および既定の時間内で撮影されたフレーム、例えば近い位置で同時刻に異なるモバイル端末で撮影されたフレームのうち互いの相関値が既定の閾値以上のフレーム群を一纏まりのグループとし、複数のグループを生成する。

【0033】

視差映像生成部507は視差映像を生成する。すなわち視差映像生成部507は、上記グループにそれぞれ含まれる画像フレームを時刻情報に基づいて時系列で配列して視差映像を生成する。その際、視差映像生成部507は、端末情報に示される対応画像処理方式なども参照し、フレーム群の各フレームを処理、集約する。

【0034】

エンコード部508は、生成された視差映像を、モバイル端末から取得した符号化方式・メディアなどの映像パラメータ情報に基づいて符号化する。ファイルフォーマット部509は、符号化された映像データをファイルとして生成する。生成されたファイルはビデオコンテンツ(Video Content)としてデータストレージ部200などに蓄積される。セグメンテーション部510は、符号化された映像データを、ライブ配信(ストリーム配信)のためのピースブロックとして生成する。ピースブロックP01,P02,…はデータストレージ部200などに蓄積される。

【0035】

ここで、視差映像の生成について説明する。視差映像を生成するための最初の手順として、まず、複数の視点がそれぞれどのような対象物を撮影しているかをマシンにより認知し、判断する必要がある。

図4は、複数のモバイル端末による視点を示す模式図である。図4には、視差映像生成のための選定(グルーピング)スキームが模式的に示される。図4には3台のモバイル端末a,b,cが示され、このうちモバイル端末a,bはシュートするプレーヤを撮影対象としており、モバイル端末cはゴールを守るキーパーを撮影対象としている。このようなケースでは、互いに同じ対象を撮影しているモバイル端末a,bからの映像データには高い相関性のあることが見込まれる。一方、異なる対象を撮影しているモバイル端末a,c、あるいはモバイル端末b,cからの映像データの相関性は低くなる。第1の実施形態ではこの知識を用いて、それぞれ相関が高い映像同士をグループ化して取り扱う。

【0036】

図5は、フレームのグループ化に必要な情報を説明するための模式図である。図5には視差映像生成のための伝送データ例が示される。複数のフレームをグループ化するためには、図5に示される各モバイル端末で取得された映像データ(フレーム)は当然のことながら、それぞれのモバイル端末の絶対位置情報と絶対時刻情報とが必要となる。

絶対時刻情報はフレーム間の同期を取るために必要になる。絶対位置情報と絶対時刻情報とのいずれも各モバイル端末においてGPSにより取得され、位置・時刻情報として映像データとともにシステムに送信される。

【0037】

第1の実施形態では位置情報を(X,Y,Z)の3次元座標で示し、時刻情報をtで示す。位置情報には端末ごとのインデックスを付し、合わせて4次元の情報を取り扱う。例えばモバイル端末で時刻tにおいて撮影された映像データには、(Xa,Ya,Za,t)なる位置・時刻情報が付随することになる。

【0038】

図6は、映像データの収集から配信用コンテンツの生成までの手順を概略的に示す模式図である。例えばそれぞれ位置・時刻情報(Xa,Ya,Za,t)、(Xb,Yb,Zb,t)を持つ複数の映像データ(フレーム)を比較し、互いの相関性が高い場合には概ねXa≒Xb,Ya≒Yb,Za≒Zbが成立する。

【0039】

つまりこれらのフレームは、既定の距離内に存在するモバイル端末で同時刻tに撮影されたものである。そのようなフレームが見つかればシステムはそれらをグループ化し、視差映像として順次蓄積する。そして蓄積されたデータを視聴者が視聴可能なエンコード方式・ファイルフォーマット形式に変換し、コンテンツとしてデータストレージ部200に保存する。または、ライブストリーミング用のデータとしてセグメンテーション化し、同様に保存する。次に、第1の実施形態における作用を説明する。

【0040】

図7は、モバイル端末をシステムに登録するための手順を示すシーケンス図である。ユーザはシステムへの登録により、自らの所有するモバイル端末を用いた映像データの撮影・送信/3D映像の受信に係わる意思表示を行う。

モバイル端末は、まず、システムに向けモバイル端末情報を送信する。送信されたモバイル端末情報は受信データ処理部501により受信される。モバイル端末情報とは、大別して2つの情報を含む。一方は<録画映像>であり、これは、当該モバイル端末に備わる動画撮影機能(ディジタルビデオカメラ)で取得される映像の特性(パラメータ)情報を示す。このパラメータ情報には取得映像の符号化方式、画面サイズ、メディアのビットレートなどがある。

【0041】

他方は<視聴映像>であり、これは、当該モバイル端末(あるいは視聴を要求するクライアント)で視聴可能な(サポートされている)映像の特性(パラメータ)情報を示す。である。このパラメータ情報には対応符号化方式(H.234、MPEG2、MPEG4など)、対応画面サイズ、対応ビットレート、対応3D方式などがある。

【0042】

図7において、モバイル端末から送信された[モバイル端末情報]は図3の受信データ処理部501により受信される。受信データ処理部501は受信した情報を[モバイル端末情報]として認識すると、この[モバイル端末情報]を端末情報登録部502に渡す。端末情報登録部502は[モバイル端末情報]をデータベースDBに登録し、ライセンス、チケットなどの情報を生成する。生成された情報は端末情報登録部502から送信データ処理部511を介して、宛先のモバイル端末に通知される。

ライセンス、チケットとは電子的なデータであり、映像ストリームデータなどの送付先に関する情報、映像を視聴する際の配信要求先、またはその配信要求先を問い合わせるための問い合わせ先に関する情報などを含む。

【0043】

なお、図7に示されるシーケンスは映像データの撮影と視差映像の視聴とを同じモバイル端末で視聴することを前提として記載されているが、視聴可能な端末を、映像を撮影した端末だけに限る必要はない。つまり映像データの提供に関わらない端末において3D映像の配信を受けられるようにすることも可能である。要するにモバイル端末での<映像情報>と、登録に伴い発行されるライセンス・チケットなどの払い出しの関係が成立すれば、視聴そのものはモバイル端末に限らず、撮影機能を持たない一般のクライアント端末で行うことが可能である。

【0044】

図8は、第1の実施形態におけるシステムがモバイル端末からストリームデータを受信する際の手順を示すシーケンス図である。図8には、図7のシーケンスが完了し端末情報の登録を済ませたモバイル端末から送付されるストリームデータを、システムが受信する際の手順が示される。ストリームデータとは個々のモバイル端末で取得された映像データ情報と、その撮影位置情報および撮影時刻情報(位置・時刻情報)を含むデータである。映像データの一例としては例えば図5に示される、視差映像生成のための元になる伝送データである。

【0045】

図8において、モバイル端末から送信されたストリームデータは受信データ処理部501において受信される。受信データ処理部501は受信したデータをストリームデータとして認識すると、ストリームデータから<録画映像データ>を抽出して映像データ分析部503に渡し、<位置・時刻情報>を抽出して位置時刻管理部504に渡す。すなわち受信データ処理部501は、録画データと、各フレームに付随する撮影位置および撮影時刻をストリームデータから抽出する。

【0046】

<録画映像データ>を受信した映像データ分析部503は、当該モバイル端末で撮影された映像のパラメータ情報を用いて<録画映像データ>に対する一時処理を施す。パラメータ情報は符号化方式やメディアのメタ情報などであり、DBに予め登録され管理されている。一時処理には例えば画面サイズの調整などがあり、処理後の一次処理録画映像データは映像データ処理部505に渡される。

【0047】

映像データ処理部505は一次処理録画映像データをデコード処理し、フレームレートの調整およびタイミング調整を施して、1枚の画像フレームを構成するフレームデータを生成する。このフレームデータは相関処理部506に渡される。この相関処理部506には、フレームデータに対応する位置・時刻情報が位置時刻管理部504から与えられる。フレームデータと位置・時刻情報とが与えられることで、相関処理部506は、同時刻において取得された各モバイル端末からの画像データを取得することになる。これらの情報を用いて相関処理部506はフレーム間の相関を取る。

【0048】

図9は視差映像の生成に関わる手順を示すシーケンス図である。図9には、同時刻において撮影された各モバイル端末からの画像データが相関処理部506に入力されたのち、視差映像が生成されるまでのシーケンスが示される。

【0049】

図9において、映像データ処理部505により生成されたフレームデータおよび位置・時刻情報は、相関処理部506に入力される。相関処理部506は相関算出処理を実行し、同時刻のフレームの組み合わせごとに相関値を算出する。相関算出アルゴリズムとしては画素相関アルゴリズム、輝度相関アルゴリズム、あるいは周波数領域に変換してからの相互相関アルゴリズムなどを適用できる。

【0050】

例えば相関処理部506は、複数のフレームのうち画素相関アルゴリズム、輝度相関アルゴリズム、および、輝度値を周波数領域に変換したのちの相互相関アルゴリズム、のいずれかのアルゴリズムに基づき算出された相関値が既定の閾値以上のフレーム群をグループ化する。このほか、およそ符号化方式、画像認識方式、画像処理方式で適用・応用・研究検討されてきたさまざまな手法を用いることが可能である。

【0051】

次に相関処理部506は、算出された相関値を既定の閾値と比較し、閾値以上の相関性を示すフレーム同士をグループ化する。視差映像生成のための選定(グルーピング)スキームは図4において既に示される。すなわち相関処理部506は、位置時刻管理部504やデータベースDBにデータとしての位置・時刻情報をフレームごとに参照し、既定の距離内、および同時刻として許容される時間範囲内で撮影されたフレームのうち、互いの相関値が既定の閾値以上のフレーム群をグループ化する。

【0052】

グループ化処理を経たのち、[グループ化したフレームデータ]と[位置・時刻情報]とが視差映像生成部507に渡される。視差映像生成部507はこの[グループ化したフレームデータ]と[位置・時刻情報]とを用いて視差フレームを生成する。その際、視差映像生成部507は、位置情報データと、DBから取得した<視聴映像>の3D対応方式の情報とを視差フレームの生成基準とする。

【0053】

3D対応方式には、右目用・左目用の2枚の画像フレームを用いる「平行法」や「交差法」を技術ベースとするものや、特殊な偏光グラスを着用することで実現する方式などがある。今後あらたな標準が策定されたとしても、DBに登録された情報を参照して視差映像生成部507の機能を拡張すれば柔軟に対応可能である。視差フレームデータの生成後、この[視差フレームデータ]と[時刻情報データ]とがエンコード部508に渡される。

【0054】

図10は、第1の実施形態において、それぞれの画像フレーム情報から映像コンテンツを生成するための手順を示すシーケンス図である。図9のシーケンスに引き続き、[視差フレームデータ]と[時刻情報データ]とを渡されたエンコード部508は、DBから取得した<視聴映像>の符号化方式やメディアのメタ情報に基づいて符号化した映像を生成する。符号化済みのデータ、すなわち視差映像データはファイルフォーマット部509またはセグメンテーション部510、あるいはその双方に渡される。これは、最終的に符号化済みのデータをコンテンツファイルとするか、Video on Demand(VOD)によるライブ配信用途のピースデータとするか、またはその両方を行うかに応じて制御される。以上の作用により、複数のモバイル端末で撮影された画像データから立体映像コンテンツが生成される。次に、生成された立体映像コンテンツの配信につき説明する。

【0055】

図11は、第1の実施形態における映像コンテンツの配信に関わる部分を示すシステム図である。図1に対応させた場合、図1のストリーミング配信部400は図11に示すように、例えば複数の配信サーバ4a,4b,4cを備える。各配信サーバ4a,4b,4cはそれぞれ異なる画像エンコード方式に対応する(それぞれA方式,B方式,C方式とする)。どのコンテンツ(あるいはストリーム)をどの配信サーバで送出するかは、配信サーバ管理部600により制御される。

【0056】

図12は、第1の実施形態に係わる視差映像生成システムの要部を示す機能ブロック図である。図12のシステムは図1のセッション・チケット管理部100、ストリーミング配信部400の機能を共通のサーバに実装したものとして捉えることが可能である。ここでは図3のシステムサーバ500にその機能を実装するとする。

【0057】

図12においてシステムサーバ500は、受信データ処理部501、ライセンス・チケット情報取得部512、配信サーバ情報取得部513、配信サーバ問い合わせ部514、配信サーバ確定部515、送信データ処理部511、および、ストリーミング配信部400を備える。このうちストリーミング配信部400は配信サーバ4a,4b,4c,4dを備える。配信サーバ4a,4b,4c,4dは予めデータベースDBに、その対応方式の情報とともに登録される。

【0058】

ライセンス・チケット情報取得部512は、アクセス元の端末(モバイル端末、固定端末(PCなど)を含む)に対する認証(Authentication)処理を行う。すなわちライセンス・チケット情報取得部512は、アクセス元の端末から送信されたライセンス、チケットなどの情報をデータベースDBにおける登録内容と照らし合わせ、その正当性を検証する。

【0059】

配信サーバ情報取得部513は、データベースDBを検索して、配信すべきコンテンツ(あるいはストリーム)に対応する方式をサポートする配信サーバを配信サーバ4a,4b,4c,4dのうちから見い出す。配信サーバ問い合わせ部514は、配信サーバ4a,4b,4c,4dに対して現在の状況(standby/busy、Session可能数など)を問い合わせる。この問い合わせに対しては配信サーバ4a,4b,4c,4dに限らず、その代理サーバ(Proxy)が応答するようにしても良い。配信サーバ確定部515は、映像データの要求元クライアント(モバイル端末、他端末など)への映像配信に最適な配信サーバを決定する。

図12、および次の図13においては、ライセンスやチケットなどの情報が、映像を直接視聴する配信要求元ではなく、その配信要求元を問い合わせるための問い合わせ先に関する情報である場合が想定される。これによれば他端末からの配信要求にも応えることが可能になる。

【0060】

図13は、第1の実施形態における映像配信に関わる手順を示すシーケンス図である。図13には、立体映像の配信を要求するクライアントが、適した配信サーバにアクセスするための情報を得るための手順が示される。

図13において、配信要求元のモバイル端末や他端末から送信された[ライセンス、チケットなどの情報]は、受信データ処理部511により受信される。受信データ処理部511は[ライセンス、チケットなどの情報]を認識すると、この[ライセンス、チケットなどの情報]をライセンス・チケット情報取得部512に渡す。

【0061】

ライセンス・チケット情報取得部512は、受信データ処理部511から送付された[ライセンス、チケットなどの情報]が信頼・承認できるものであるか否かを検証する。この処理に際してはデータベースDBにおける登録内容が参照される。[ライセンス、チケットなどの情報]が改竄されたもの、不正入手されたもの、また、ライセンスやチケットそのものは正当なものであるが、例えば視聴有効期限が過ぎていたものなどの理由により信頼・承認できないものであると判断されれば、処理はここで停止される。あるいは、配信要求を拒否する旨、[ライセンス、チケットなどの情報]が信頼・承認できないものである旨を配信要求元に通知したうえで処理を停止するようにしても良い。

【0062】

[ライセンス、チケットなどの情報]が信頼・承認できるものであれば、その旨がライセンス・チケット情報取得部512により認識される。そしてライセンス・チケット情報取得部512は、承認した要求元の端末に適する3D対応方式の情報をデータベースDBから取り出し、配信サーバ情報取得部513に渡す。

【0063】

配信サーバ情報取得部513は、この対応方式の状況をキーインデックスとしてデータベースDBを検索し、登録された配信サーバのうち当該対応方式をサポートする配信サーバを特定する。そうして配信サーバ情報取得部513は、特定した配信サーバを一意に識別できる情報、例えばUniform Resource Locator (URL)やIPアドレスなどの情報を[問い合わせ先の情報]として取得する。

【0064】

配信サーバ情報取得部513は、取得した[問い合わせ先の情報]を配信サーバ問い合わせ部514に渡す。配信サーバ問い合わせ部514はこの[問い合わせ先の情報]を元に[問い合わせ要求]を各配信サーバに送付する。これに対する問い合わせ応答は、各配信サーバから配信サーバ問い合わせ部514に返送される。配信サーバ問い合わせ部514は、各配信サーバからの問い合わせ応答をまとめ、[問い合わせ先の情報]と[問い合わせ応答結果]とを配信サーバ確定部515に渡す。

【0065】

配信サーバ確定部515は各配信サーバの現在の状況情報(standby / busyあるいはセッション可能数など)を参照し、配信要求時点において最適な配信サーバを決定する。配信サーバが確定されると配信サーバ確定部515は、この配信サーバに対応する[配信サーバの宛て先、URI情報]を、配信要求元のモバイル端末・他端末に送信データ処理部501経由で送信する。これを受けたモバイル端末・他端末は[配信サーバの宛て先、URI情報]にアクセスすることで3D映像の配信を受けることができる。

【0066】

以上説明したようにこの第1の実施形態では、インターネットアクセス機能と、GPS機能と、動画撮影機能とを具備するモバイル端末により取得された映像データを、IPネットワーク1を介して収集する。収集された映像データを、モバイル端末の撮影機能に係わるパラメータ情報に基づき複数のフレームにデコードする。複数のフレーム間の相関値を算出し、閾値判定により相関値の高いフレーム群をグループ化する。そうしてグループ化したフレームから、視聴を要求するクライアントでサポートされている映像のパラメータ情報に基づいて視差映像を生成する。処理に必要となる映像データの撮影位置および時刻は、モバイル端末の備えるGPS機能を利用して取得するようにしている。

【0067】

上記構成および作用によれば、モバイル端末で個々に取得された映像データを視差映像生成のための元データとして利用することができるようになり、顧客あるいはユーザの自由な意思のもと、3D映像などの魅力的なコンテンツを生成することが可能になる。このシステムの構築および運用に際しては、テレビ局が主導権を握る必要は必ずしもない。つまり従来では放映権を獲得したテレビ局がその全てをまかなってきた3D映像コンテンツの配信を、テレビ局の介在なしに実現することが可能になり、新たなビジネスモデルを提案することができる。すなわち第1の実施形態において説明した技術を用いれば、立体的な魅力ある映像の放映や配信を、顧客の参加により、インターネットを介在して容易かつ簡易に実現することが可能になる。

これらのことから、視差映像を簡易に生成でき、これにより立体映像を手軽に提供できるようにした視差映像生成システム、視差映像生成方法、映像配信システムおよび映像配信方法を提供することが可能となる。

【0068】

[第2の実施形態]

図14は、視差映像の生成に係わる第2の実施形態を説明するための図である。この実施形態では相関の高いフレームを抽出することが難しいケースへの対応について説明する。このようなケースは例えばスタジアムにおいて観客動員数が少なく、映像を撮影可能なモバイル端末の分布がまばら、つまりモバイル端末間の距離が長いときに生じ得る。

【0069】

相関値の低い画像フレームしか撮影できない上記のようなケースでは、フレーム群を含むグループを少ししか生成できないか、あるいは生成できない。そこで第2の実施形態では、補間用の画像フレームを生成することを考える。

【0070】

図14はそのような状況を想定するものである。例えば視点AおよびBにおいて画像フレームが撮影されたとする。視点A,B間の距離(Distance)が長いと各視点A,Bで得られるフレームの相関性は低くなり、間隔の程度によってはグルーピング可能なフレームが一つも存在しないことが考えられる。つまり位置AにおけるフレームAと位置BにおけるフレームBとの相関値は、視点A,Bの距離によっては閾値を下回ると考えられる。

【0071】

そこで第2の実施形態では、フレームAとフレームBとを用いて補間フレームA′を生成する。補間フレームの生成は主に相関処理部506の演算処理により実現される。補間フレームA′は、視点A′の位置情報(例えば視点Aからの距離Δd)を用いて、例えばフレームAとフレームBのそれぞれの画素値を内挿演算するなどの画像処理により生成することができる。

【0072】

すなわち相関処理部506は、複数のフレームを画像処理し、これらの複数のフレームを補間する新たなフレームを生成する。このようにすればフレームAとA′とのグループ、フレームA′とBとのグループを作成できるようになり、相関処理部506はそのようなグルーピング処理を行う。このようにして生成したグループから視差映像を生成することができる。

従って第2の実施形態によれば、第1の実施形態で得られる効果に加えて、フレームのグルーピングが困難なケースにも対処することが可能になる。

【0073】

なお、実画像フレームA,Bの相関があまりにも低すぎるケースでは、生成された補間画像フレームA′を用いてもグルーピングができないことも考えられ、生成される視差映像の完成度も低くなる。相関値に下限閾値を設けておくことで、このようなケースにも対応することが可能である。

【0074】

例えば図14における左端のフレームの相関値は70であり、これは相関性がないとしてグルーピングの対象から除外される。右に移るほどに相関性は徐々に高まり、値80では十分な相関性はないものの、擬似視差映像としてデータベースに順次蓄積される。値90を超えれば十分な相関性有りとして、生成された補間画像フレームから生成された視差映像は擬似視差映像としてデータベースに蓄積される。

【0075】

[第3の実施形態]

図15は、視差映像の生成に係わる第3の実施形態を説明するための図である。図15においては、視点Aと対象物との距離、および視点Bと対象物の距離の差が大きいケースを想定する。このようなケースでは遠近差が大きく、視点Aでは大きくはっきり見える対象物も、視点Bでは不鮮明になることが考えられる。

【0076】

そこで第3の実施形態では、撮影位置による遠近差を考慮してフレーム間の相関性を判定することを考える。すなわちフレーム間の相関性が高いと判定されたケースでも、撮影位置の状況から遠近差が大きく、視差映像の生成に適さない場合がある。そこで第3の実施形態では、相関値に加えてScalable(倍率値)を加味し、フレーム間の相関性を判定するようにする。

【0077】

この判定は主に相関処理部506の演算処理により実現される。すなわち相関処理部506は、フレーム間の相関値に加えて倍率値を参照して複数のフレームをグループ化する。例えば、倍率は2.0以下というような閾値を設けることにより、相関値は高いがグルーピング対象としては除外すべき対象であると判定することが可能になる。

【0078】

図15において例えばフレーム間の相関性が完全に同一である場合を値100と定義したとすると、値70では、単一的にはフレーム間に十分な相関性はないが、相似性(Scale)で評価すれば十分な相関性があると看做せるフレームについてはグルーピングの対象とし、擬似視差映像の生成に供するようにする。値90以上のフレームについては十分な相関性があるとして、擬似視差映像を生成する。以上のようにすれば、第1の実施形態で得られる効果に加え、鮮明さを保った3D映像を形成することが可能になる。

【0079】

なお本発明は上記実施形態に限定されるものではない。

例えば図12においてはストリーミング配信部400をシステムサーバ500に一体化して示したが、ストリーミング配信部400をシステムサーバ500とは別体で実装しても良い。このようなケースでは、図13の問い合わせ要求/問い合わせ応答は送信データ処理部501/受信データ処理部511を介して、ストリーミング配信部400とシステムサーバ500との間で授受される。

【0080】

また、視差映像、あるいは視差映像から生成された立体映像の供給を受けるクライアントは、映像データを提供したモバイル端末に限られるものではない。映像データをシステムに提供しない端末、あるいは撮影機能を備えていない端末においても立体映像の提供を受けられるようにすることができる。これは、サービスの提供に係わるビジネスモデルに応じて自由に可変できる事柄であり、例えばセッション・チケット管理部100における認証処理、ライセンス提供などの機能をシステム要求に応じて設計すれば良い。あるいは逆に、例えば立体映像の配信に際して、映像データをシステムに提供した端末を優先するなどのビジネスモデルも考え得る。

【0081】

また実施形態では位置情報をGPSにより取得するようにした。これに代えて角速度センサ(ジャイロセンサ)を備えるモバイル端末を用いれば、同様の機能を実現できる。角速度センサを用いれば撮像機の視点が何処を向いているかを検知することができるし、その情報を例えば補助的に用いて画像フレーム間の相関値を算出することも可能である。

【0082】

また第3の実施形態では倍率値を用いて不鮮明なフレームを除外するようにしたが、例えば、対象物に遠いモバイル端末が精細なフォーカスで撮影し、対象物に近いモバイル端末のフォーカスが甘ければ、両者で撮影されたフレームの鮮明さは同程度になると思われる。つまりフレームのグループ化に際してフレームごとのフォーカスを指標として相関値を再評価することも可能である。

【0083】

フレームのフォーカスに係わる情報も、モバイル端末の動画撮影機能で録画(取得)される映像の特性を示すパラメータ情報として取得可能である。このように撮影時のフォーカスも考慮すれば3D映像の形成にさらに寄与できるであろう。

【0084】

本発明のいくつかの実施形態を説明したが、これらの実施形態は例として提示するものであり、発明の範囲を限定することは意図していない。これら新規な実施形態は、その他の様々な形態で実施されることが可能であり、発明の要旨を逸脱しない範囲で、種々の省略、置き換え、変更を行うことができる。これら実施形態やその変形は、発明の範囲や要旨に含まれるとともに、特許請求の範囲に記載された発明とその均等の範囲に含まれる。

【符号の説明】

【0085】

1…IPネットワーク、a,b,c,d,e…モバイル端末、100…セッション・チケット管理部、200…データストレージ部、300…メディア変換部、400…ストリーミング配信部、4…パーソナルコンピュータ(PC)、5…IPTV、6…STB、7…PDC端末、501…受信データ処理部、502…端末情報登録部、503…映像データ分析部、504…位置時刻管理部、505…映像データ処理部、506…相関処理部、507…視差映像生成部、508…エンコード部、509…ファイルフォーマット部、510…セグメンテーション部、511…送信データ処理部、4a,4b,4c…配信サーバ、500…システムサーバ、600…配信サーバ管理部、512…ライセンス・チケット情報取得部、513…配信サーバ情報取得部、514…配信サーバ問い合わせ部、515…配信サーバ確定部、4a,4b,4c,4d…配信サーバ

【特許請求の範囲】

【請求項1】

モバイル端末によりアクセス可能なネットワークを利用する視差映像生成システムであって、

動画撮影機能を備える撮像機付きモバイル端末により取得された映像データを含むストリームデータを前記ネットワークを介して収集する収集部と、

異なる撮像機付きモバイル端末で取得された映像データに基づいて、前記収集部により収集されたストリームデータから視差映像を生成する視差映像データ生成部とを具備する視差映像生成システム。

【請求項2】

前記視差映像データ生成部は、

前記モバイル端末に備わる動画撮影機能で取得される取得映像の特性を示すパラメータ情報に基づいて前記映像データをデコードし、当該映像データから複数のフレームを復元するデコード部と、

前記複数のフレームに付随する撮影位置と撮影時刻とを前記ストリームデータから抽出する抽出部と、

前記撮影位置と前記撮影時刻とを前記フレームごとに参照して、既定の距離内および前記時間内で撮影されたフレームのうち互いの相関値が既定の閾値以上のフレーム群をグループ化する相関処理部とを備え、

前記グループのそれぞれに含まれるフレームから前記視差映像を生成する、請求項1に記載の視差映像生成システム。

【請求項3】

前記収集部は、前記取得映像の特性を示すパラメータ情報を前記モバイル端末から取得してデータベースに蓄積し、

前記デコード部は、前記データベースに蓄積された前記パラメータ情報を用いて前記映像データをデコードする、請求項2に記載の視差映像生成システム。

【請求項4】

前記撮像機付きモバイル端末は、測位衛星から到達する電波を用いて位置情報および時刻情報を算出する測位処理部を備え、

前記撮影時刻および前記撮影位置は、前記測位処理部により算出された時刻情報および位置情報を反映する、請求項2に記載の視差映像生成システム。

【請求項5】

前記相関処理部は、前記複数のフレームを画像処理して当該複数のフレームを補間する新たなフレームを生成し、この新たなフレームと当該複数のフレームとをグループ化する、請求項2に記載の視差映像生成システム。

【請求項6】

前記相関処理部は、前記フレーム間の前記相関値と倍率値とに基づいて前記フレーム群をグループ化する、請求項2に記載の視差映像生成システム。

【請求項7】

モバイル端末によりアクセス可能なネットワークを利用する視差映像生成方法であって、

前記ネットワークに接続される収集部が、動画撮影機能を備える撮像機付きモバイル端末により取得された映像データを含むストリームデータを前記ネットワークを介して収集し、

前記収集部に接続される視差映像データ生成部が、異なる撮像機付きモバイル端末で取得された映像データに基づいて、前記収集部により収集されたストリームデータから視差映像を生成する、視差映像生成方法。

【請求項8】

前記生成することは、

前記モバイル端末に備わる動画撮影機能で取得される取得映像の特性を示すパラメータ情報に基づいて前記映像データをデコードし、

前記デコードされた映像データから複数のフレームを復元し、

前記複数のフレームに付随する撮影位置と撮影時刻とを前記ストリームデータから抽出し、

前記撮影位置と前記撮影時刻とを前記フレームごとに参照し、

既定の距離内および前記時間内で撮影されたフレームのうち互いの相関値が既定の閾値以上のフレーム群をグループ化し、

前記グループのそれぞれに含まれるフレームから前記視差映像を生成する、請求項7に記載の視差映像生成方法。

【請求項9】

前記グループ化することは、

前記距離内および前記時間内で撮影されたフレーム同士の互いの相関値を算出することと、

前記算出された相関値と前記既定の閾値とを比較することとを含む、請求項8に記載の視差映像生成方法。

【請求項10】

前記収集することは、前記取得映像の特性を示すパラメータ情報を前記モバイル端末から取得してデータベースに蓄積し、

前記デコードすることは、前記データベースに蓄積された前記パラメータ情報を用いて前記映像データをデコードする、請求項8に記載の視差映像生成方法。

【請求項11】

前記撮像機付きモバイル端末が、測位衛星から到達する電波を用いて位置情報および時刻情報を算出し、

前記撮影時刻および前記撮影位置は、前記測位処理部により算出された時刻情報および位置情報を反映する、請求項8に記載の視差映像生成方法。

【請求項12】

さらに、前記視差映像データ生成部が、前記複数のフレームを画像処理して当該複数のフレームを補間する新たなフレームを生成し、

前記グループ化することは、前記生成された新たなフレームと当該複数のフレームとをグループ化する、請求項8に記載の視差映像生成方法。

【請求項13】

前記グループ化することは、前記フレーム間の前記相関値と倍率値とに基づいて前記フレーム群をグループ化する、請求項8に記載の視差映像生成方法。

【請求項14】

モバイル端末によりアクセス可能なネットワークを利用する映像配信システムであって、

視差映像を生成する視差映像生成部と、

前記生成された視差映像をクライアントに配信する配信部とを具備し、

前記視差映像生成部は、

動画撮影機能を備える撮像機付きモバイル端末により取得された映像データを含むストリームデータを前記ネットワークを介して収集する収集部と、

異なる撮像機付きモバイル端末で取得された映像データに基づいて、前記収集部により収集されたストリームデータから前記視差映像を生成する視差映像データ生成部とを備え、

前記配信部は、

前記生成された視差映像を前記クライアントが視聴可能な形式に変換して視聴用のデータを生成する視聴データ生成部を備える、映像配信システム。

【請求項15】

前記視差映像データ生成部は、

前記モバイル端末に備わる動画撮影機能で取得される取得映像の特性を示すパラメータ情報に基づいて前記映像データをデコードし、当該映像データから複数のフレームを復元するデコード部と、

前記複数のフレームに付随する撮影位置と撮影時刻とを前記ストリームデータから抽出する抽出部と、

前記撮影位置と前記撮影時刻とを前記フレームごとに参照して、既定の距離内および前記時間内で撮影されたフレームのうち互いの相関値が既定の閾値以上のフレーム群をグループ化する相関処理部とを備え、

前記グループのそれぞれに含まれるフレームから前記視差映像を生成する、請求項14に記載の映像配信システム。

【請求項16】

前記収集部は、前記取得映像の特性を示すパラメータ情報を前記モバイル端末から取得してデータベースに蓄積し、

前記デコード部は、前記データベースに蓄積された前記パラメータ情報を用いて前記映像データをデコードする、請求項15に記載の映像配信システム。

【請求項17】

前記相関処理部は、前記複数のフレームを画像処理して当該複数のフレームを補間する新たなフレームを生成し、この新たなフレームと当該複数のフレームとをグループ化する、請求項15に記載の映像配信システム。

【請求項18】

前記相関処理部は、前記フレーム間の前記相関値と倍率値とに基づいて前記フレーム群をグループ化する、請求項15に記載の映像配信システム。

【請求項19】

前記視聴データ生成部は、

前記生成された視差映像を、前記クライアントにおいて視聴可能な視聴映像の特性を示すパラメータ情報に基づいて符号化するエンコード部と、

前記符号化された視差映像をコンテンツファイル化するファイル生成部とを備える、請求項14に記載の映像配信システム。

【請求項20】

前記視聴データ生成部は、

前記生成された視差映像を、前記クライアントにおいて視聴可能な視聴映像の特性を示すパラメータ情報に基づいて符号化するエンコード部と、

前記符号化された視差映像をストリーム配信用のピースブロックデータとするセグメンテーション部とを備える、請求項14に記載の映像配信システム。

【請求項21】

前記収集部は、前記視聴映像の特性を示すパラメータ情報を前記クライアントから取得してデータベースに蓄積し、

前記エンコード部は、前記データベースに蓄積された前記パラメータ情報を用いて前記視差映像を符号化する、請求項19および20のいずれかに記載の映像配信システム。

【請求項22】

前記撮像機付きモバイル端末は、測位衛星から到達する電波を用いて位置情報および時刻情報を算出する測位処理部を備え、

前記撮影時刻および前記撮影位置は、前記測位処理部により算出された時刻情報および位置情報を反映する、請求項15に記載の映像配信システム。

【請求項23】

モバイル端末によりアクセス可能なネットワークを利用する映像配信方法であって、

前記ネットワークに接続される収集部が、動画撮影機能を備える撮像機付きモバイル端末により取得された映像データを含むストリームデータを前記ネットワークを介して収集し、

前記収集部に接続される視差映像データ生成部が、異なる撮像機付きモバイル端末で取得された映像データに基づいて、前記収集部により収集されたストリームデータから視差映像を生成し、

前記視差映像データ生成部に接続される視聴データ生成部が、前記生成された視差映像を前記クライアントが視聴可能な形式に変換して視聴用のデータを生成し、

前記視聴データ生成部により生成された前記視聴用のデータを配信する、映像配信方法。

【請求項1】

モバイル端末によりアクセス可能なネットワークを利用する視差映像生成システムであって、

動画撮影機能を備える撮像機付きモバイル端末により取得された映像データを含むストリームデータを前記ネットワークを介して収集する収集部と、

異なる撮像機付きモバイル端末で取得された映像データに基づいて、前記収集部により収集されたストリームデータから視差映像を生成する視差映像データ生成部とを具備する視差映像生成システム。

【請求項2】

前記視差映像データ生成部は、

前記モバイル端末に備わる動画撮影機能で取得される取得映像の特性を示すパラメータ情報に基づいて前記映像データをデコードし、当該映像データから複数のフレームを復元するデコード部と、

前記複数のフレームに付随する撮影位置と撮影時刻とを前記ストリームデータから抽出する抽出部と、

前記撮影位置と前記撮影時刻とを前記フレームごとに参照して、既定の距離内および前記時間内で撮影されたフレームのうち互いの相関値が既定の閾値以上のフレーム群をグループ化する相関処理部とを備え、

前記グループのそれぞれに含まれるフレームから前記視差映像を生成する、請求項1に記載の視差映像生成システム。

【請求項3】

前記収集部は、前記取得映像の特性を示すパラメータ情報を前記モバイル端末から取得してデータベースに蓄積し、

前記デコード部は、前記データベースに蓄積された前記パラメータ情報を用いて前記映像データをデコードする、請求項2に記載の視差映像生成システム。

【請求項4】

前記撮像機付きモバイル端末は、測位衛星から到達する電波を用いて位置情報および時刻情報を算出する測位処理部を備え、

前記撮影時刻および前記撮影位置は、前記測位処理部により算出された時刻情報および位置情報を反映する、請求項2に記載の視差映像生成システム。

【請求項5】

前記相関処理部は、前記複数のフレームを画像処理して当該複数のフレームを補間する新たなフレームを生成し、この新たなフレームと当該複数のフレームとをグループ化する、請求項2に記載の視差映像生成システム。

【請求項6】

前記相関処理部は、前記フレーム間の前記相関値と倍率値とに基づいて前記フレーム群をグループ化する、請求項2に記載の視差映像生成システム。

【請求項7】

モバイル端末によりアクセス可能なネットワークを利用する視差映像生成方法であって、

前記ネットワークに接続される収集部が、動画撮影機能を備える撮像機付きモバイル端末により取得された映像データを含むストリームデータを前記ネットワークを介して収集し、

前記収集部に接続される視差映像データ生成部が、異なる撮像機付きモバイル端末で取得された映像データに基づいて、前記収集部により収集されたストリームデータから視差映像を生成する、視差映像生成方法。

【請求項8】

前記生成することは、

前記モバイル端末に備わる動画撮影機能で取得される取得映像の特性を示すパラメータ情報に基づいて前記映像データをデコードし、

前記デコードされた映像データから複数のフレームを復元し、

前記複数のフレームに付随する撮影位置と撮影時刻とを前記ストリームデータから抽出し、

前記撮影位置と前記撮影時刻とを前記フレームごとに参照し、

既定の距離内および前記時間内で撮影されたフレームのうち互いの相関値が既定の閾値以上のフレーム群をグループ化し、

前記グループのそれぞれに含まれるフレームから前記視差映像を生成する、請求項7に記載の視差映像生成方法。

【請求項9】

前記グループ化することは、

前記距離内および前記時間内で撮影されたフレーム同士の互いの相関値を算出することと、

前記算出された相関値と前記既定の閾値とを比較することとを含む、請求項8に記載の視差映像生成方法。

【請求項10】

前記収集することは、前記取得映像の特性を示すパラメータ情報を前記モバイル端末から取得してデータベースに蓄積し、

前記デコードすることは、前記データベースに蓄積された前記パラメータ情報を用いて前記映像データをデコードする、請求項8に記載の視差映像生成方法。

【請求項11】

前記撮像機付きモバイル端末が、測位衛星から到達する電波を用いて位置情報および時刻情報を算出し、

前記撮影時刻および前記撮影位置は、前記測位処理部により算出された時刻情報および位置情報を反映する、請求項8に記載の視差映像生成方法。

【請求項12】

さらに、前記視差映像データ生成部が、前記複数のフレームを画像処理して当該複数のフレームを補間する新たなフレームを生成し、

前記グループ化することは、前記生成された新たなフレームと当該複数のフレームとをグループ化する、請求項8に記載の視差映像生成方法。

【請求項13】

前記グループ化することは、前記フレーム間の前記相関値と倍率値とに基づいて前記フレーム群をグループ化する、請求項8に記載の視差映像生成方法。

【請求項14】

モバイル端末によりアクセス可能なネットワークを利用する映像配信システムであって、

視差映像を生成する視差映像生成部と、

前記生成された視差映像をクライアントに配信する配信部とを具備し、

前記視差映像生成部は、

動画撮影機能を備える撮像機付きモバイル端末により取得された映像データを含むストリームデータを前記ネットワークを介して収集する収集部と、

異なる撮像機付きモバイル端末で取得された映像データに基づいて、前記収集部により収集されたストリームデータから前記視差映像を生成する視差映像データ生成部とを備え、

前記配信部は、

前記生成された視差映像を前記クライアントが視聴可能な形式に変換して視聴用のデータを生成する視聴データ生成部を備える、映像配信システム。

【請求項15】

前記視差映像データ生成部は、

前記モバイル端末に備わる動画撮影機能で取得される取得映像の特性を示すパラメータ情報に基づいて前記映像データをデコードし、当該映像データから複数のフレームを復元するデコード部と、

前記複数のフレームに付随する撮影位置と撮影時刻とを前記ストリームデータから抽出する抽出部と、

前記撮影位置と前記撮影時刻とを前記フレームごとに参照して、既定の距離内および前記時間内で撮影されたフレームのうち互いの相関値が既定の閾値以上のフレーム群をグループ化する相関処理部とを備え、

前記グループのそれぞれに含まれるフレームから前記視差映像を生成する、請求項14に記載の映像配信システム。

【請求項16】

前記収集部は、前記取得映像の特性を示すパラメータ情報を前記モバイル端末から取得してデータベースに蓄積し、

前記デコード部は、前記データベースに蓄積された前記パラメータ情報を用いて前記映像データをデコードする、請求項15に記載の映像配信システム。

【請求項17】

前記相関処理部は、前記複数のフレームを画像処理して当該複数のフレームを補間する新たなフレームを生成し、この新たなフレームと当該複数のフレームとをグループ化する、請求項15に記載の映像配信システム。

【請求項18】

前記相関処理部は、前記フレーム間の前記相関値と倍率値とに基づいて前記フレーム群をグループ化する、請求項15に記載の映像配信システム。

【請求項19】

前記視聴データ生成部は、

前記生成された視差映像を、前記クライアントにおいて視聴可能な視聴映像の特性を示すパラメータ情報に基づいて符号化するエンコード部と、

前記符号化された視差映像をコンテンツファイル化するファイル生成部とを備える、請求項14に記載の映像配信システム。

【請求項20】

前記視聴データ生成部は、

前記生成された視差映像を、前記クライアントにおいて視聴可能な視聴映像の特性を示すパラメータ情報に基づいて符号化するエンコード部と、

前記符号化された視差映像をストリーム配信用のピースブロックデータとするセグメンテーション部とを備える、請求項14に記載の映像配信システム。

【請求項21】

前記収集部は、前記視聴映像の特性を示すパラメータ情報を前記クライアントから取得してデータベースに蓄積し、

前記エンコード部は、前記データベースに蓄積された前記パラメータ情報を用いて前記視差映像を符号化する、請求項19および20のいずれかに記載の映像配信システム。

【請求項22】

前記撮像機付きモバイル端末は、測位衛星から到達する電波を用いて位置情報および時刻情報を算出する測位処理部を備え、

前記撮影時刻および前記撮影位置は、前記測位処理部により算出された時刻情報および位置情報を反映する、請求項15に記載の映像配信システム。

【請求項23】

モバイル端末によりアクセス可能なネットワークを利用する映像配信方法であって、

前記ネットワークに接続される収集部が、動画撮影機能を備える撮像機付きモバイル端末により取得された映像データを含むストリームデータを前記ネットワークを介して収集し、

前記収集部に接続される視差映像データ生成部が、異なる撮像機付きモバイル端末で取得された映像データに基づいて、前記収集部により収集されたストリームデータから視差映像を生成し、

前記視差映像データ生成部に接続される視聴データ生成部が、前記生成された視差映像を前記クライアントが視聴可能な形式に変換して視聴用のデータを生成し、

前記視聴データ生成部により生成された前記視聴用のデータを配信する、映像配信方法。

【図1】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図13】

【図14】

【図15】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図13】

【図14】

【図15】

【公開番号】特開2013−65936(P2013−65936A)

【公開日】平成25年4月11日(2013.4.11)

【国際特許分類】

【出願番号】特願2011−201927(P2011−201927)

【出願日】平成23年9月15日(2011.9.15)

【出願人】(000003078)株式会社東芝 (54,554)

【Fターム(参考)】

【公開日】平成25年4月11日(2013.4.11)

【国際特許分類】

【出願日】平成23年9月15日(2011.9.15)

【出願人】(000003078)株式会社東芝 (54,554)

【Fターム(参考)】

[ Back to top ]