観測行動選択機能を有する分類システム及び該システムを使用する分類方法

【課題】対象物を早く、かつ正確に分類するため行動戦略を自動的に作成する観測行動選択機能を有する分類システムを提供する。

【解決手段】本分類システムは、物体の観測行動を繰り返しながら、観測行動によって得られた観測データに基づいて該物体をクラスに分類する分類システムである。本分類システム(100)は、該物体がそれぞれのクラスに分類される確率である分類確率を決定する分類確率決定部(103)と、観測データと該分類確率とから構成される状態空間を使用する強化学習に基づいて次の観測行動を選択する行動選択部(107)とを備えている。

【解決手段】本分類システムは、物体の観測行動を繰り返しながら、観測行動によって得られた観測データに基づいて該物体をクラスに分類する分類システムである。本分類システム(100)は、該物体がそれぞれのクラスに分類される確率である分類確率を決定する分類確率決定部(103)と、観測データと該分類確率とから構成される状態空間を使用する強化学習に基づいて次の観測行動を選択する行動選択部(107)とを備えている。

【発明の詳細な説明】

【技術分野】

【0001】

本発明は、強化学習を使用した観測行動選択機能を有する分類システム及び該システムを使用する分類方法に関する。

【背景技術】

【0002】

ロボットなどの機械が対象物(物体)を操作する際に、対象物をできるだけ早く、かつ正確に分類する必要がある。たとえば、ロボットは対象物を観測し、観測データに基づいて対象物を分類する。ここで、観測データは、ロボットと対象物との位置関係によって変化する。したがって、対象物を早く、かつ正確に分類するためには、対象物を適切な位置から観測した観測データを使用して分類処理を行う必要がある。このように、対象物を早く、かつ正確に分類するためには、ロボットの観測行動の行動戦略が必要である。

【0003】

しかし、対象物を早く、かつ正確に分類するための行動戦略は、従来、ケースごとに設計者によって作成されていた。関連するものとして物体認識のために強化学習を使用する方法が提案されているが(非特許文献1)、対象物を早く、かつ正確に分類するため行動戦略を自動的に作成する観測行動選択機能を有する分類システム及び該システムを使用する分類方法は開発されていなかった。

【先行技術文献】

【特許文献】

【0004】

【非特許文献1】Lucas Paletta,Gerald Fritz,and Christin Seifert,”Rein forcement Learning of Informative Attention Patterns for object Recognition”,Proceedings of 2005 4▲th▼ IEEE International Conference on Development and Learning

【発明の概要】

【発明が解決しようとする課題】

【0005】

したがって、対象物を早く、かつ正確に分類するため行動戦略を自動的に作成する観測行動選択機能を有する分類システム及び該システムを使用する分類方法に対するニーズがある。

【課題を解決するための手段】

【0006】

本発明の第1の態様による観測行動選択機能を有する分類システムは、物体の観測行動を繰り返しながら、観測行動によって得られた観測データに基づいて該物体をクラスに分類する分類システムである。本分類システムは、該物体がそれぞれのクラスに分類される確率である分類確率を決定する分類確率決定部と、観測データと該分類確率とから構成される状態空間を使用する強化学習に基づいて次の観測行動を選択する行動選択部とを備えている。

【0007】

本発明の第1の態様による分類システムによれば、観測データと該分類確率とから構成される状態空間を使用する強化学習に基づいて次の観測行動が選択されるので、観測行動の行動戦略が自動的に作成される。

【0008】

本発明の第1の態様の実施形態において、前記行動選択部は、前記分類確率決定手段によって決定された分類確率から求められたエントロピーの減少分に応じて報酬を決定し、該報酬に基づいて強化学習を行う。

【0009】

本実施形態によれば、分類確率から求められたエントロピーの減少分に応じて報酬が決定されるので、エントロピーを減少させように強化学習を行わせることができる。

【0010】

本発明の第1の態様の実施形態において、前記分類確率決定部は、観測行動ごとに前記物体がそれぞれのクラスに分類される確率を求め、観測行動に関する累積確率を分類確率とする。

【0011】

本実施形態によれば、観測行動に関する累積確率を分類確率とするので、複数の観測行動の結果を適切に集約することができる。

【0012】

本発明の第1の態様の実施形態において、前記分類確率決定手段は、所定の物体の複数の観測データを、EMアルゴリズムで最尤推定することによって求めた、クラスの混合正規分布モデルを使用して分類確率を決定する。

【0013】

本実施形態によれば、所定の物体の複数の観測データを、EMアルゴリズムで最尤推定することによって求めた、クラスの混合正規分布モデルを使用するので、所定の物体の複数の観測データを少ないパラメータによって効率的にモデル化することができる。

【0014】

本発明の第2の態様による、観測行動選択機能を有する分類システムによって物体を分類する分類方法は、該観測行動選択機能を有する分類システムが、物体の観測行動を実施するステップと、該観測行動選択機能を有する分類システムの分類確率決定部が、観測行動によって得られた観測データに基づいて、該物体がそれぞれのクラスに分類される確率である分類確率を決定するステップと、該観測行動選択機能を有する分類システムの行動選択部が、観測データと該分類確率とから構成される状態空間を使用する強化学習に基づいて次の観測行動を選択するステップと、を含む。

【0015】

本発明の第2の態様による分類方法によれば、観測データと該分類確率とから構成される状態空間を使用する強化学習に基づいて次の観測行動が選択されるので、観測行動の行動戦略が自動的に作成される。

【0016】

本発明の第2の態様の実施形態において、前記行動選択部は、前記分類確率決定手段によって決定された分類確率から求められたエントロピーの減少分に応じて報酬を決定し、該報酬に基づいて強化学習を行う。

【0017】

本実施形態によれば、分類確率から求められたエントロピーの減少分に応じて報酬が決定されるので、エントロピーを減少させように強化学習を行わせることができる。

【0018】

本発明の第2の態様の実施形態において、前記分類確率決定部は、観測行動ごとに前記物体がそれぞれのクラスに分類される確率を求め、観測行動に関する累積確率を分類確率とする。

【0019】

本実施形態によれば、観測行動に関する累積確率を分類確率とするので、複数の観測行動の結果を適切に集約することができる。

【0020】

本発明の第2の態様の実施形態による分類方法は、初期化処理として、前記分類確率決定手段が、所定の物体の複数の観測データを、EMアルゴリズムで最尤推定することによって、分類確率を決定するために使用される、クラスの混合正規分布モデルを求めるステップをさらに含み、前記分類確率決定手段は、分類確率を決定するステップにおいて、該混合正規分布モデルを使用して分類確率を決定する。

【0021】

本実施形態によれば、所定の物体の複数の観測データを、EMアルゴリズムで最尤推定することによって求めた、クラスの混合正規分布モデルを使用するので、所定の物体の複数の観測データを少ないパラメータによって効率的にモデル化し、該混合正規分布モデルを使用して効率的に分類確率を決定することができる。

【図面の簡単な説明】

【0022】

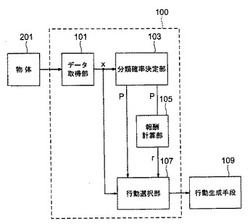

【図1】本発明の一実施形態による観測行動選択機能を有する分類システムの構成を示す図である。

【図2】観測行動選択機能を有する分類システムの分類確率決定部の初期化処理の手順を示す流れ図である。

【図3】観測行動選択機能を有する分類システムによる、観測行動選択及び物体分類処理を示す流れ図である。

【図4】シミュレーション実験の手順を説明するための流れ図である。

【図5】クラス1、クラス1から生成した個体P及びクラス2、クラス2から生成した個体Qを示す概念図である。

【図6】クラス1から生成した個体Pの観測データの採取を説明するための図である。

【図7】分類処理の繰り返し数と分類に必要な行動数との関係を示す図である。

【図8】分類処理の繰り返し数と分類結果の正答率との関係を示す図である。

【発明を実施するための形態】

【0023】

図1は、本発明の一実施形態による観測行動選択機能を有する分類システム100の構成を示す図である。観測行動選択機能を有する分類システム100は、たとえば、自律式ロボットに搭載される。観測行動選択機能を有する分類システム100は、物体201を観測して観測データを取得するデータ取得部101と、データ取得部101が取得した観測データに基づいて、物体がそれぞれのクラスに分類される確率である分類確率を決定する分類確率決定部103と、該分類確率に基づいて強化学習の報酬を計算する報酬計算部105と、該観測データ、該分類確率及び報酬計算部105によって計算された報酬を使用して強化学習を実施し、その結果に基づいて観測行動を選択する行動選択部107と、を含む。図1において報酬計算部105は、行動選択部107とは別のコンポーネントとして構成されているが、報酬計算部105は、行動選択部107の一部として構成してもよい。行動選択部107によって選択された観測行動は、行動生成手段109によって実現され、その結果、データ取得部101が新たな観測データを取得する。分類確率決定部103、報酬計算部105及び行動選択部107の機能の詳細は、後で説明する。

【0024】

図2は、観測行動選択機能を有する分類システム100の分類確率決定部103の初期化処理の手順を示す流れ図である。初期化処理において、観測行動に関する学習が行われる。

【0025】

図2のステップS1010において、外部入力などによって学習対象の1個体が定められる。

【0026】

図2のステップS1020において、観測行動選択機能を有する分類システム100が、観測行動を実行し、1個体から観測データを取得する。

【0027】

図2のステップS1030において、外部入力などによって観測数が十分であるかどうかが判断される。観測数が十分であれば、ステップS1040に進む。観測数が十分でなければステップS1020に戻り、観測行動を繰り返す。

【0028】

図2のステップS1040において、外部入力などによって個体のクラス分類の正解のクラスラベルが教示される。ここで、クラスラベルとは、物体を分類した結果の表示である。たとえば、ロボットが家具の置かれた室内で物体を分類する場合は、椅子やテーブルなどがクラスラベルに相当する。

【0029】

図2のステップS1050において、観測行動選択機能を有する分類システム100の分類確率決定部103は、クラスラベルのデータとして観測データを格納する。より具体的に、分類確率決定部103は、クラス数の混合正規分布モデル(以下において、GMMと呼称する)を予め備えるように構成されており、該クラスラベルのGMMのデータとして観測データを格納する。

【0030】

図2のステップS1060において、観測行動選択機能を有する分類システム100の分類確率決定部103は、該クラスラベルのGMMをEMアルゴリズムで最尤推定する。EMアルゴリズム(Expectation−maximization algorithm)とは、確率モデルのパラメータを最尤法に基づいて推定する手法のひとつであり、観測不可能な隠れ変数に確率モデルが依存する場合に用いられる方法である。具体的には、EMアルゴリズムでGMMの以下のパラメータを定める。

【数1】

ここで、

【数2】

は、各クラスを表し、

【数3】

は、GMMにおける各混合成分を表す。GMMをEMアルゴリズムで最尤推定する方法は広く知られており、たとえば、http://en.wikipedia.org/wiki/Mixture_model#General_mixture_modelなどに記載されている。

【0031】

図2のステップS1070において、外部入力などによって学習対象の個体が他にあるかどうか判断される。学習対象の個体が他にあれば、ステップS1010に進む。学習対象の個体が他になければ、処理を終了する。

【0032】

このようにして、観測行動選択機能を有する分類システム100の分類確率決定部103は、クラスラベルごとに、最尤推定されたGMMを予め準備し保持する。

【0033】

図3は、観測行動選択機能を有する分類システム100による、観測行動選択及び物体分類処理を示す流れ図である。

図3のステップS010において、外部入力などによって観察対象の1個体が定められる。

【0034】

図3のステップS2020において、分類確率決定部103は、観察対象の1個体に対するクラス推定確率を初期化する。また、行動選択部107は、初動観測行動を決定する。具体的に、初動行動は、所定の行動とするかランダムに設定された行動とする。

【0035】

図3のステップS2030において、行動生成手段109は、行動選択部107によって決定された初動行動を実行し、データ取得部101は、観測対象の物体を観測し、観測データを取得する。具体的に、たとえば、ロボットは、観測対象の物体と所定の関係の位置に移動し、その位置から観測対象の物体を観察する。ここで、時刻tにおける観測データを

【数4】

で表し、時刻tまでの時系列観測データを

【数5】

で表す。すなわち、

【数6】

は、時刻t+1までの時系列観測データであり、

【数7】

と表せる。

【0036】

図3のステップS2040において、分類確率決定部103は、クラス推定分布、すなわち、図2の流れ図に示す方法によって求められた、クラスごとのGMMよりクラス累積確率を計算する。この計算方法を以下に説明する。

【0037】

あるクラスのGMMが、観測データ

【数8】

を示す確率は以下の式で表せる。

【数9】

ここで、

【数10】

は、クラスの正規分布を表す。

観測対象があるクラス

【数11】

である場合に、観測データ

【数12】

が得られる確率は以下の式で表せる。

【数13】

ここで、

【数14】

は、クラス数を表す。

さらに、観測対象があるクラス

【数15】

である場合に、時系列観測データ

【数16】

が得られる確率、すなわちクラス累積確率は以下の式で表せる。

【数17】

ここで、nは各時系列データを表し、Nは時系列観測データのデータ数を表す。

【0038】

図3のステップS2050において、行動選択部107は、データ取得部101から受け取った観測データ及び分類確率決定部103から受け取ったクラス累積確率から定めた状態

【数18】

によって状態空間を構成する。ここで、

【数19】

は、各クラスのクラス累積確率の集合を表す。

【0039】

図3のステップS2060において、行動選択部107は、政策関数により次行動を決定する。具体的に政策関数は、ε−Greedy法であってもよい。ε−Greedy法は、εが0以上1以下の定数であるとして、確率1−εで、その状態において、後で説明するQ値が最大となる行動を次行動として選択し、確率εでランダムに次行動を選択する。

【0040】

図3のステップS2070において、報酬計算部105は、分類確率決定部103からクラス累積確率を受け取り、クラス累積確率に基づいて報酬を計算する。具体的に報酬計算部105は、全クラスの累積クラス確率のエントロピーの和の減少分に応じて報酬を決定する。時刻tにおける全クラスの累積クラス確率のエントロピーの和は、以下の式によって表わせる。

【数20】

したがって、時刻t+1における報酬rt+1は、以下の式によって計算される。

【数21】

式(5)においてλは、正の定数を表す。

【0041】

図3のステップS2080において、行動選択部107は、報酬計算部105から報酬の値を受け取り、報酬の値を使用して、その時の状態及び行動に対応するQ値を更新する。ここで、Q値とは、ある状態である行動をとった場合の報酬の期待値である。具体的にQ−Learningによる場合には、以下の式によってQ値を更新する。

【数22】

また、Sarsa(State−Action−Reward−State−Action)による場合には、以下の式によってQ値を更新する。

【数23】

式(6)及び(7)において、sは状態を表し、aは行動を表す。

【0042】

図3のステップS2090において、分類確率決定部103は、クラス累積確率の閾値判定を行う。具体的に、各クラスのクラス累積確率のうち最大のものと閾値とを比較する。すなわち、

【数24】

が満たされれば、ステップS2100に進む。式(8)が満たされなければ、ステップS2030に戻り、観測行動を継続する。ここで、Thは閾値を表す。

【0043】

図3のステップS2100において、分類確率決定部103は、クラス累積確率が閾値を超えたクラスが物体のクラスであると判定する。

【0044】

シミュレーション実験

本発明の効果を確認するためのシミュレーション実験について以下に説明する。複数の分類クラスが存在する。そのうちの一つに属する個体から観測データを取得して、その観測データに基づいて本発明の実施形態による観測行動選択機能を有する分類システム100によって物体のクラスを分類する。

図4は、シミュレーション実験の手順を説明するための流れ図である。

図4のステップS3010において、個体のモデルを作成する。各クラスが正規分布を有するとして、その平均と共分散行列を設定する。

【数25】

個体をどのクラスから発生させるかを決定し、決定したクラスから個体の平均を発生させる。クラス1から個体Pを発生させる場合は、以下のように表現される。

【数26】

予め設定した範囲から共分散行列を乱数にて生成し、個体モデルを生成する。クラス1から生成した個体モデルPは、以下のように表す。

【数27】

【0045】

図5は、クラス1、クラス1から生成した個体P及びクラス2、クラス2から生成した個体Qを示す概念図である。

図4のステップS3020において、図2の流れ図に示した方法によって、観測行動選択機能を有する分類システム100の分類確率決定部103の初期化処理(クラス分類の学習)を行う。観測数は、約300である。

【0046】

図6は、クラス1から生成した個体Pの観測データの採取を説明するための図である。観測行動は、a1及びa2の2種類であるとする。観測行動a1では、平均線より左側のデータが得られ、観測行動a2では、平均線より右側のデータが得られるとする。具体的に、観測行動a1の場合には、以下の手順によって観測データを定める。対象となる個体モデルの分布から分布に従った正規乱数(観測データ)を発生させる。

【数28】

上記の値が平均線より左側であればこの値を観測データとする。そうでなければ、上記の乱数発生を繰り返す。

【0047】

図4のステップS3030において、図3の流れ図に示した、観測行動選択機能を有する分類システム100に観測行動選択及び物体分類処理を実施させる。

【0048】

図4のステップS3040において、分類結果の評価を行う。すなわち、分類されたクラスが、個体の発生したクラスと同じであるかどうか評価する。

【0049】

分類処理は、10000回繰り返す。

【0050】

図7は、分類処理の繰り返し数と分類に必要な行動数との関係を示す図である。図7の横軸は、分類処理の繰り返し数を表す。図7の縦軸は、1回の分類処理に必要な行動数を表す。図7は、100回の実験の平均値を示す。本発明の場合には、ランダムな観測行動を行った場合と比較して、初期の段階から、分類処理に必要な行動数が少ない。さらに、分類処理を繰り返すにしたがって、分類処理に必要な行動数が減少する。

【0051】

図8は、分類処理の繰り返し数と分類結果の正答率との関係を示す図である。図8の横軸は、分類処理の繰り返し数を表す。図8の縦軸は、分類結果の正答率を示す。図8は、100回の実験の平均値を示す。本発明の場合とランダムな観測行動を行った場合と比較して、分類結果の正答率に有意差はない。

【0052】

シミュレーション実験の結果、本発明によれば、観測行動の行動戦略を作成することによって、分類の正確さを維持したまま、より早く分類を実施できることが明らかになった。

【符号の説明】

100…観測行動選択機能を有する分類システム、101…データ取得部、103…分類確率決定部、105…報酬計算部、107…行動選択部

【技術分野】

【0001】

本発明は、強化学習を使用した観測行動選択機能を有する分類システム及び該システムを使用する分類方法に関する。

【背景技術】

【0002】

ロボットなどの機械が対象物(物体)を操作する際に、対象物をできるだけ早く、かつ正確に分類する必要がある。たとえば、ロボットは対象物を観測し、観測データに基づいて対象物を分類する。ここで、観測データは、ロボットと対象物との位置関係によって変化する。したがって、対象物を早く、かつ正確に分類するためには、対象物を適切な位置から観測した観測データを使用して分類処理を行う必要がある。このように、対象物を早く、かつ正確に分類するためには、ロボットの観測行動の行動戦略が必要である。

【0003】

しかし、対象物を早く、かつ正確に分類するための行動戦略は、従来、ケースごとに設計者によって作成されていた。関連するものとして物体認識のために強化学習を使用する方法が提案されているが(非特許文献1)、対象物を早く、かつ正確に分類するため行動戦略を自動的に作成する観測行動選択機能を有する分類システム及び該システムを使用する分類方法は開発されていなかった。

【先行技術文献】

【特許文献】

【0004】

【非特許文献1】Lucas Paletta,Gerald Fritz,and Christin Seifert,”Rein forcement Learning of Informative Attention Patterns for object Recognition”,Proceedings of 2005 4▲th▼ IEEE International Conference on Development and Learning

【発明の概要】

【発明が解決しようとする課題】

【0005】

したがって、対象物を早く、かつ正確に分類するため行動戦略を自動的に作成する観測行動選択機能を有する分類システム及び該システムを使用する分類方法に対するニーズがある。

【課題を解決するための手段】

【0006】

本発明の第1の態様による観測行動選択機能を有する分類システムは、物体の観測行動を繰り返しながら、観測行動によって得られた観測データに基づいて該物体をクラスに分類する分類システムである。本分類システムは、該物体がそれぞれのクラスに分類される確率である分類確率を決定する分類確率決定部と、観測データと該分類確率とから構成される状態空間を使用する強化学習に基づいて次の観測行動を選択する行動選択部とを備えている。

【0007】

本発明の第1の態様による分類システムによれば、観測データと該分類確率とから構成される状態空間を使用する強化学習に基づいて次の観測行動が選択されるので、観測行動の行動戦略が自動的に作成される。

【0008】

本発明の第1の態様の実施形態において、前記行動選択部は、前記分類確率決定手段によって決定された分類確率から求められたエントロピーの減少分に応じて報酬を決定し、該報酬に基づいて強化学習を行う。

【0009】

本実施形態によれば、分類確率から求められたエントロピーの減少分に応じて報酬が決定されるので、エントロピーを減少させように強化学習を行わせることができる。

【0010】

本発明の第1の態様の実施形態において、前記分類確率決定部は、観測行動ごとに前記物体がそれぞれのクラスに分類される確率を求め、観測行動に関する累積確率を分類確率とする。

【0011】

本実施形態によれば、観測行動に関する累積確率を分類確率とするので、複数の観測行動の結果を適切に集約することができる。

【0012】

本発明の第1の態様の実施形態において、前記分類確率決定手段は、所定の物体の複数の観測データを、EMアルゴリズムで最尤推定することによって求めた、クラスの混合正規分布モデルを使用して分類確率を決定する。

【0013】

本実施形態によれば、所定の物体の複数の観測データを、EMアルゴリズムで最尤推定することによって求めた、クラスの混合正規分布モデルを使用するので、所定の物体の複数の観測データを少ないパラメータによって効率的にモデル化することができる。

【0014】

本発明の第2の態様による、観測行動選択機能を有する分類システムによって物体を分類する分類方法は、該観測行動選択機能を有する分類システムが、物体の観測行動を実施するステップと、該観測行動選択機能を有する分類システムの分類確率決定部が、観測行動によって得られた観測データに基づいて、該物体がそれぞれのクラスに分類される確率である分類確率を決定するステップと、該観測行動選択機能を有する分類システムの行動選択部が、観測データと該分類確率とから構成される状態空間を使用する強化学習に基づいて次の観測行動を選択するステップと、を含む。

【0015】

本発明の第2の態様による分類方法によれば、観測データと該分類確率とから構成される状態空間を使用する強化学習に基づいて次の観測行動が選択されるので、観測行動の行動戦略が自動的に作成される。

【0016】

本発明の第2の態様の実施形態において、前記行動選択部は、前記分類確率決定手段によって決定された分類確率から求められたエントロピーの減少分に応じて報酬を決定し、該報酬に基づいて強化学習を行う。

【0017】

本実施形態によれば、分類確率から求められたエントロピーの減少分に応じて報酬が決定されるので、エントロピーを減少させように強化学習を行わせることができる。

【0018】

本発明の第2の態様の実施形態において、前記分類確率決定部は、観測行動ごとに前記物体がそれぞれのクラスに分類される確率を求め、観測行動に関する累積確率を分類確率とする。

【0019】

本実施形態によれば、観測行動に関する累積確率を分類確率とするので、複数の観測行動の結果を適切に集約することができる。

【0020】

本発明の第2の態様の実施形態による分類方法は、初期化処理として、前記分類確率決定手段が、所定の物体の複数の観測データを、EMアルゴリズムで最尤推定することによって、分類確率を決定するために使用される、クラスの混合正規分布モデルを求めるステップをさらに含み、前記分類確率決定手段は、分類確率を決定するステップにおいて、該混合正規分布モデルを使用して分類確率を決定する。

【0021】

本実施形態によれば、所定の物体の複数の観測データを、EMアルゴリズムで最尤推定することによって求めた、クラスの混合正規分布モデルを使用するので、所定の物体の複数の観測データを少ないパラメータによって効率的にモデル化し、該混合正規分布モデルを使用して効率的に分類確率を決定することができる。

【図面の簡単な説明】

【0022】

【図1】本発明の一実施形態による観測行動選択機能を有する分類システムの構成を示す図である。

【図2】観測行動選択機能を有する分類システムの分類確率決定部の初期化処理の手順を示す流れ図である。

【図3】観測行動選択機能を有する分類システムによる、観測行動選択及び物体分類処理を示す流れ図である。

【図4】シミュレーション実験の手順を説明するための流れ図である。

【図5】クラス1、クラス1から生成した個体P及びクラス2、クラス2から生成した個体Qを示す概念図である。

【図6】クラス1から生成した個体Pの観測データの採取を説明するための図である。

【図7】分類処理の繰り返し数と分類に必要な行動数との関係を示す図である。

【図8】分類処理の繰り返し数と分類結果の正答率との関係を示す図である。

【発明を実施するための形態】

【0023】

図1は、本発明の一実施形態による観測行動選択機能を有する分類システム100の構成を示す図である。観測行動選択機能を有する分類システム100は、たとえば、自律式ロボットに搭載される。観測行動選択機能を有する分類システム100は、物体201を観測して観測データを取得するデータ取得部101と、データ取得部101が取得した観測データに基づいて、物体がそれぞれのクラスに分類される確率である分類確率を決定する分類確率決定部103と、該分類確率に基づいて強化学習の報酬を計算する報酬計算部105と、該観測データ、該分類確率及び報酬計算部105によって計算された報酬を使用して強化学習を実施し、その結果に基づいて観測行動を選択する行動選択部107と、を含む。図1において報酬計算部105は、行動選択部107とは別のコンポーネントとして構成されているが、報酬計算部105は、行動選択部107の一部として構成してもよい。行動選択部107によって選択された観測行動は、行動生成手段109によって実現され、その結果、データ取得部101が新たな観測データを取得する。分類確率決定部103、報酬計算部105及び行動選択部107の機能の詳細は、後で説明する。

【0024】

図2は、観測行動選択機能を有する分類システム100の分類確率決定部103の初期化処理の手順を示す流れ図である。初期化処理において、観測行動に関する学習が行われる。

【0025】

図2のステップS1010において、外部入力などによって学習対象の1個体が定められる。

【0026】

図2のステップS1020において、観測行動選択機能を有する分類システム100が、観測行動を実行し、1個体から観測データを取得する。

【0027】

図2のステップS1030において、外部入力などによって観測数が十分であるかどうかが判断される。観測数が十分であれば、ステップS1040に進む。観測数が十分でなければステップS1020に戻り、観測行動を繰り返す。

【0028】

図2のステップS1040において、外部入力などによって個体のクラス分類の正解のクラスラベルが教示される。ここで、クラスラベルとは、物体を分類した結果の表示である。たとえば、ロボットが家具の置かれた室内で物体を分類する場合は、椅子やテーブルなどがクラスラベルに相当する。

【0029】

図2のステップS1050において、観測行動選択機能を有する分類システム100の分類確率決定部103は、クラスラベルのデータとして観測データを格納する。より具体的に、分類確率決定部103は、クラス数の混合正規分布モデル(以下において、GMMと呼称する)を予め備えるように構成されており、該クラスラベルのGMMのデータとして観測データを格納する。

【0030】

図2のステップS1060において、観測行動選択機能を有する分類システム100の分類確率決定部103は、該クラスラベルのGMMをEMアルゴリズムで最尤推定する。EMアルゴリズム(Expectation−maximization algorithm)とは、確率モデルのパラメータを最尤法に基づいて推定する手法のひとつであり、観測不可能な隠れ変数に確率モデルが依存する場合に用いられる方法である。具体的には、EMアルゴリズムでGMMの以下のパラメータを定める。

【数1】

ここで、

【数2】

は、各クラスを表し、

【数3】

は、GMMにおける各混合成分を表す。GMMをEMアルゴリズムで最尤推定する方法は広く知られており、たとえば、http://en.wikipedia.org/wiki/Mixture_model#General_mixture_modelなどに記載されている。

【0031】

図2のステップS1070において、外部入力などによって学習対象の個体が他にあるかどうか判断される。学習対象の個体が他にあれば、ステップS1010に進む。学習対象の個体が他になければ、処理を終了する。

【0032】

このようにして、観測行動選択機能を有する分類システム100の分類確率決定部103は、クラスラベルごとに、最尤推定されたGMMを予め準備し保持する。

【0033】

図3は、観測行動選択機能を有する分類システム100による、観測行動選択及び物体分類処理を示す流れ図である。

図3のステップS010において、外部入力などによって観察対象の1個体が定められる。

【0034】

図3のステップS2020において、分類確率決定部103は、観察対象の1個体に対するクラス推定確率を初期化する。また、行動選択部107は、初動観測行動を決定する。具体的に、初動行動は、所定の行動とするかランダムに設定された行動とする。

【0035】

図3のステップS2030において、行動生成手段109は、行動選択部107によって決定された初動行動を実行し、データ取得部101は、観測対象の物体を観測し、観測データを取得する。具体的に、たとえば、ロボットは、観測対象の物体と所定の関係の位置に移動し、その位置から観測対象の物体を観察する。ここで、時刻tにおける観測データを

【数4】

で表し、時刻tまでの時系列観測データを

【数5】

で表す。すなわち、

【数6】

は、時刻t+1までの時系列観測データであり、

【数7】

と表せる。

【0036】

図3のステップS2040において、分類確率決定部103は、クラス推定分布、すなわち、図2の流れ図に示す方法によって求められた、クラスごとのGMMよりクラス累積確率を計算する。この計算方法を以下に説明する。

【0037】

あるクラスのGMMが、観測データ

【数8】

を示す確率は以下の式で表せる。

【数9】

ここで、

【数10】

は、クラスの正規分布を表す。

観測対象があるクラス

【数11】

である場合に、観測データ

【数12】

が得られる確率は以下の式で表せる。

【数13】

ここで、

【数14】

は、クラス数を表す。

さらに、観測対象があるクラス

【数15】

である場合に、時系列観測データ

【数16】

が得られる確率、すなわちクラス累積確率は以下の式で表せる。

【数17】

ここで、nは各時系列データを表し、Nは時系列観測データのデータ数を表す。

【0038】

図3のステップS2050において、行動選択部107は、データ取得部101から受け取った観測データ及び分類確率決定部103から受け取ったクラス累積確率から定めた状態

【数18】

によって状態空間を構成する。ここで、

【数19】

は、各クラスのクラス累積確率の集合を表す。

【0039】

図3のステップS2060において、行動選択部107は、政策関数により次行動を決定する。具体的に政策関数は、ε−Greedy法であってもよい。ε−Greedy法は、εが0以上1以下の定数であるとして、確率1−εで、その状態において、後で説明するQ値が最大となる行動を次行動として選択し、確率εでランダムに次行動を選択する。

【0040】

図3のステップS2070において、報酬計算部105は、分類確率決定部103からクラス累積確率を受け取り、クラス累積確率に基づいて報酬を計算する。具体的に報酬計算部105は、全クラスの累積クラス確率のエントロピーの和の減少分に応じて報酬を決定する。時刻tにおける全クラスの累積クラス確率のエントロピーの和は、以下の式によって表わせる。

【数20】

したがって、時刻t+1における報酬rt+1は、以下の式によって計算される。

【数21】

式(5)においてλは、正の定数を表す。

【0041】

図3のステップS2080において、行動選択部107は、報酬計算部105から報酬の値を受け取り、報酬の値を使用して、その時の状態及び行動に対応するQ値を更新する。ここで、Q値とは、ある状態である行動をとった場合の報酬の期待値である。具体的にQ−Learningによる場合には、以下の式によってQ値を更新する。

【数22】

また、Sarsa(State−Action−Reward−State−Action)による場合には、以下の式によってQ値を更新する。

【数23】

式(6)及び(7)において、sは状態を表し、aは行動を表す。

【0042】

図3のステップS2090において、分類確率決定部103は、クラス累積確率の閾値判定を行う。具体的に、各クラスのクラス累積確率のうち最大のものと閾値とを比較する。すなわち、

【数24】

が満たされれば、ステップS2100に進む。式(8)が満たされなければ、ステップS2030に戻り、観測行動を継続する。ここで、Thは閾値を表す。

【0043】

図3のステップS2100において、分類確率決定部103は、クラス累積確率が閾値を超えたクラスが物体のクラスであると判定する。

【0044】

シミュレーション実験

本発明の効果を確認するためのシミュレーション実験について以下に説明する。複数の分類クラスが存在する。そのうちの一つに属する個体から観測データを取得して、その観測データに基づいて本発明の実施形態による観測行動選択機能を有する分類システム100によって物体のクラスを分類する。

図4は、シミュレーション実験の手順を説明するための流れ図である。

図4のステップS3010において、個体のモデルを作成する。各クラスが正規分布を有するとして、その平均と共分散行列を設定する。

【数25】

個体をどのクラスから発生させるかを決定し、決定したクラスから個体の平均を発生させる。クラス1から個体Pを発生させる場合は、以下のように表現される。

【数26】

予め設定した範囲から共分散行列を乱数にて生成し、個体モデルを生成する。クラス1から生成した個体モデルPは、以下のように表す。

【数27】

【0045】

図5は、クラス1、クラス1から生成した個体P及びクラス2、クラス2から生成した個体Qを示す概念図である。

図4のステップS3020において、図2の流れ図に示した方法によって、観測行動選択機能を有する分類システム100の分類確率決定部103の初期化処理(クラス分類の学習)を行う。観測数は、約300である。

【0046】

図6は、クラス1から生成した個体Pの観測データの採取を説明するための図である。観測行動は、a1及びa2の2種類であるとする。観測行動a1では、平均線より左側のデータが得られ、観測行動a2では、平均線より右側のデータが得られるとする。具体的に、観測行動a1の場合には、以下の手順によって観測データを定める。対象となる個体モデルの分布から分布に従った正規乱数(観測データ)を発生させる。

【数28】

上記の値が平均線より左側であればこの値を観測データとする。そうでなければ、上記の乱数発生を繰り返す。

【0047】

図4のステップS3030において、図3の流れ図に示した、観測行動選択機能を有する分類システム100に観測行動選択及び物体分類処理を実施させる。

【0048】

図4のステップS3040において、分類結果の評価を行う。すなわち、分類されたクラスが、個体の発生したクラスと同じであるかどうか評価する。

【0049】

分類処理は、10000回繰り返す。

【0050】

図7は、分類処理の繰り返し数と分類に必要な行動数との関係を示す図である。図7の横軸は、分類処理の繰り返し数を表す。図7の縦軸は、1回の分類処理に必要な行動数を表す。図7は、100回の実験の平均値を示す。本発明の場合には、ランダムな観測行動を行った場合と比較して、初期の段階から、分類処理に必要な行動数が少ない。さらに、分類処理を繰り返すにしたがって、分類処理に必要な行動数が減少する。

【0051】

図8は、分類処理の繰り返し数と分類結果の正答率との関係を示す図である。図8の横軸は、分類処理の繰り返し数を表す。図8の縦軸は、分類結果の正答率を示す。図8は、100回の実験の平均値を示す。本発明の場合とランダムな観測行動を行った場合と比較して、分類結果の正答率に有意差はない。

【0052】

シミュレーション実験の結果、本発明によれば、観測行動の行動戦略を作成することによって、分類の正確さを維持したまま、より早く分類を実施できることが明らかになった。

【符号の説明】

100…観測行動選択機能を有する分類システム、101…データ取得部、103…分類確率決定部、105…報酬計算部、107…行動選択部

【特許請求の範囲】

【請求項1】

物体の観測行動を繰り返しながら、観測行動によって得られた観測データに基づいて該物体をクラスに分類する分類システムであって、該物体がそれぞれのクラスに分類される確率である分類確率を決定する分類確率決定部と、観測データと該分類確率とから構成される状態空間を使用する強化学習に基づいて次の観測行動を選択する行動選択部とを備えた、観測行動選択機能を有する分類システム。

【請求項2】

前記行動選択部は、前記分類確率決定手段によって決定された分類確率から求められたエントロピーの減少分に応じて報酬を決定し、該報酬に基づいて強化学習を行う請求項1に記載の観測行動選択機能を有する分類システム。

【請求項3】

前記分類確率決定部は、観測行動ごとに前記物体がそれぞれのクラスに分類される確率を求め、観測行動に関する累積確率を分類確率とする請求項1または2に記載の観測行動選択機能を有する分類システム。

【請求項4】

前記分類確率決定手段は、所定の物体の複数の観測データを、EMアルゴリズムで最尤推定することによって求めた、クラスの混合正規分布モデルを使用して分類確率を決定する請求項1から3のいずれかに記載の観測行動選択機能を有する分類システム。

【請求項5】

観測行動選択機能を有する分類システムによって物体を分類する分類方法であって、

該観測行動選択機能を有する分類システムが、物体の観測行動を実施するステップと、

該観測行動選択機能を有する分類システムの分類確率決定部が、観測行動によって得られた観測データに基づいて、該物体がそれぞれのクラスに分類される確率である分類確率を決定するステップと、

該観測行動選択機能を有する分類システムの行動選択部が、観測データと該分類確率とから構成される状態空間を使用する強化学習に基づいて次の観測行動を選択するステップと、を含む分類方法。

【請求項6】

前記行動選択部は、前記分類確率決定手段によって決定された分類確率から求められたエントロピーの減少分に応じて報酬を決定し、該報酬に基づいて強化学習を行う請求項5に記載の分類方法。

【請求項7】

前記分類確率決定部は、観測行動ごとに前記物体がそれぞれのクラスに分類される確率を求め、観測行動に関する累積確率を分類確率とする請求項5または6に記載の分類方法。

【請求項8】

初期化処理として、前記分類確率決定手段が、所定の物体の複数の観測データを、EMアルゴリズムで最尤推定することによって、分類確率を決定するために使用される、クラスの混合正規分布モデルを求めるステップをさらに含み、前記分類確率決定手段は、分類確率を決定するステップにおいて、該混合正規分布モデルを使用して分類確率を決定する請求項5から7のいずれかに記載の分類方法。

【請求項1】

物体の観測行動を繰り返しながら、観測行動によって得られた観測データに基づいて該物体をクラスに分類する分類システムであって、該物体がそれぞれのクラスに分類される確率である分類確率を決定する分類確率決定部と、観測データと該分類確率とから構成される状態空間を使用する強化学習に基づいて次の観測行動を選択する行動選択部とを備えた、観測行動選択機能を有する分類システム。

【請求項2】

前記行動選択部は、前記分類確率決定手段によって決定された分類確率から求められたエントロピーの減少分に応じて報酬を決定し、該報酬に基づいて強化学習を行う請求項1に記載の観測行動選択機能を有する分類システム。

【請求項3】

前記分類確率決定部は、観測行動ごとに前記物体がそれぞれのクラスに分類される確率を求め、観測行動に関する累積確率を分類確率とする請求項1または2に記載の観測行動選択機能を有する分類システム。

【請求項4】

前記分類確率決定手段は、所定の物体の複数の観測データを、EMアルゴリズムで最尤推定することによって求めた、クラスの混合正規分布モデルを使用して分類確率を決定する請求項1から3のいずれかに記載の観測行動選択機能を有する分類システム。

【請求項5】

観測行動選択機能を有する分類システムによって物体を分類する分類方法であって、

該観測行動選択機能を有する分類システムが、物体の観測行動を実施するステップと、

該観測行動選択機能を有する分類システムの分類確率決定部が、観測行動によって得られた観測データに基づいて、該物体がそれぞれのクラスに分類される確率である分類確率を決定するステップと、

該観測行動選択機能を有する分類システムの行動選択部が、観測データと該分類確率とから構成される状態空間を使用する強化学習に基づいて次の観測行動を選択するステップと、を含む分類方法。

【請求項6】

前記行動選択部は、前記分類確率決定手段によって決定された分類確率から求められたエントロピーの減少分に応じて報酬を決定し、該報酬に基づいて強化学習を行う請求項5に記載の分類方法。

【請求項7】

前記分類確率決定部は、観測行動ごとに前記物体がそれぞれのクラスに分類される確率を求め、観測行動に関する累積確率を分類確率とする請求項5または6に記載の分類方法。

【請求項8】

初期化処理として、前記分類確率決定手段が、所定の物体の複数の観測データを、EMアルゴリズムで最尤推定することによって、分類確率を決定するために使用される、クラスの混合正規分布モデルを求めるステップをさらに含み、前記分類確率決定手段は、分類確率を決定するステップにおいて、該混合正規分布モデルを使用して分類確率を決定する請求項5から7のいずれかに記載の分類方法。

【図1】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【公開番号】特開2012−216158(P2012−216158A)

【公開日】平成24年11月8日(2012.11.8)

【国際特許分類】

【出願番号】特願2011−92450(P2011−92450)

【出願日】平成23年4月1日(2011.4.1)

【出願人】(000005326)本田技研工業株式会社 (23,863)

【出願人】(899000068)学校法人早稲田大学 (602)

【公開日】平成24年11月8日(2012.11.8)

【国際特許分類】

【出願日】平成23年4月1日(2011.4.1)

【出願人】(000005326)本田技研工業株式会社 (23,863)

【出願人】(899000068)学校法人早稲田大学 (602)

[ Back to top ]