車両位置算出方法及び車載装置

【課題】合流前に高精度な自車位置を算出することができる車両位置算出方法及び車載装置を提供する。

【解決手段】運転支援装置1のバックモニタコンピュータ3は、車両に設けられたカメラ20から画像データを取得する。そして、画像データを用いて、合流エリアに路面標示されたゼブラゾーンを検出する。また、検出したゼブラゾーンの幅を算出し、その幅と、ゼブラゾーン終端までの距離を記憶するテーブルに基づいて、加速車線内での車両の位置を算出する。

【解決手段】運転支援装置1のバックモニタコンピュータ3は、車両に設けられたカメラ20から画像データを取得する。そして、画像データを用いて、合流エリアに路面標示されたゼブラゾーンを検出する。また、検出したゼブラゾーンの幅を算出し、その幅と、ゼブラゾーン終端までの距離を記憶するテーブルに基づいて、加速車線内での車両の位置を算出する。

【発明の詳細な説明】

【技術分野】

【0001】

本発明は、車両位置算出方法及び車載装置に関する。

【背景技術】

【0002】

近年、交通事故、渋滞等の問題を解決し、自動車の円滑な走行を図るために、高度道路交通システム(Intelligent Transport Systems)の研究開発が進められている。このシ

ステムでは、例えば、車々間通信や路車間通信、又は自動車が具備する各種装置等により、所定距離内の各自動車の情報を収集し、各自動車に対して周辺道路状況に応じた操作支援を行う。

【0003】

このような操作支援として、例えば、合流エリア、カーブ進入地点、交差点等での支援が提案されている。この操作支援では、各自動車の位置や速度等を用いて各種演算を行うため、路側センサ又は自動車に搭載された各種装置により、車両位置を高精度に検出する必要がある。例えば、特許文献1には、車載カメラが撮像した案内標識を認識する装置が提案されている。この装置では、案内標識や信号を撮像した画像に基づいて、交差点までの距離を算出し、自律航法等によって求めた自車位置を補正する。

【特許文献1】特開2004−45227号公報

【発明の開示】

【発明が解決しようとする課題】

【0004】

ところが、上記した方法では、車両前方を撮像するカメラを車体に取り付ける必要があるため、コストがかかる。また、上記した方法では、交差点付近では自車位置補正を行うことができるが、車両が、交差点以外の操作支援ポイントに到達した際には、自車位置に誤差が生じていることが想定される。例えば、上記した合流エリアの操作支援を行う場合には、合流エリアで算出された自車位置に誤差がある虞がある。この誤差により、操作支援を行うタイミングが遅れたり、案内内容に誤りが生じたりして、合流エリアでの操作支援を的確に行うことができない虞がある。

【0005】

本発明は、上記問題点に鑑みてなされたものであり、その目的は、合流前に高精度な自車位置を算出することができる車両位置算出方法及び車載装置を提供することにある。

【課題を解決するための手段】

【0006】

上記問題点を解決するために、請求項1に記載の発明は、車両の位置を検出する車両位置算出方法において、前記車両に設けられた撮像装置から路面標示を撮像した画像データを取得し、前記画像データを用いてその路面標示を検出し、前記画像データに基づいて、前記路面標示の幅を検出するとともに、検出した前記路面標示の幅と、前記路面標示の幅及び所定地点までの道路進行方向に沿った距離を対応付けた属性情報とを用いて、道路の進行方向に沿った前記車両の位置を算出することを要旨とする。

【0007】

請求項2に記載の発明は、車両の位置を検出する車両位置算出方法において、前記車両に設けられた撮像装置から路面標示を撮像した画像データを取得し、前記画像データを用いてその路面標示を検出し、前記画像データに基づいて、前記路面標示を構成する標示要素の数を検出するとともに、検出した前記標示要素の数と、前記標示要素の数及び所定地点までの道路進行方向に沿った距離を対応付けた属性情報とを用いて、道路の進行方向に沿った前記車両の位置を算出することを要旨とする。

【0008】

請求項3に記載の発明は、車両に設けられた撮像装置から画像データを取得する画像デ

ータ取得手段と、前記画像データを用いて、路面標示を検出する標示検出手段と、前記路面標示の幅と、所定地点までの道路進行方向に沿った距離とを対応付けた属性情報を格納した属性情報記憶手段と、前記路面標示の画像データに基づき、前記路面標示の幅を検出し、検出した幅と前記属性情報とに基づいて、前記所定地点までの距離を演算することにより、前記車両の位置を算出する位置算出手段とを備えたことを要旨とする。

【0009】

請求項4に記載の発明は、車両に設けられた撮像装置から画像データを取得する画像データ取得手段と、前記画像データを用いて、路面標示を検出する標示検出手段と、前記路面標示を構成する標示要素の数と、所定地点までの道路進行方向に沿った距離とを対応付けた属性情報を格納した属性情報記憶手段と、前記路面標示の画像データに基づき、前記路面標示の前記標示要素の数を検出し、検出した前記標示要素の数と前記属性情報とに基づいて、前記所定地点までの距離を演算することにより、前記車両の位置を算出する位置算出手段とを備えたことを要旨とする。

【0010】

請求項5に記載の発明は、請求項3又は4に記載の車載装置において、前記車両の操作支援を行う支援地点に接近したか否かを判断する支援地点判断手段をさらに備え、前記標示検出手段は、前記支援地点に接近した際に、前記支援地点よりも進行方向手前に標示された路面標示を検出することを要旨とする。

【0011】

請求項6に記載の発明は、請求項3〜5のいずれか1項に記載の車載装置において、前記標示検出手段は、各合流エリアの路面標示のパターンを記憶したテンプレートを格納するテンプレート記憶手段と、前記テンプレートと、前記路面標示を撮像した前記画像データとを照合する画像処理手段とを備えたことを要旨とする。

【0012】

請求項7に記載の発明は、請求項6に記載の車載装置において、前記路面標示は、合流エリアに標示され、加速車線及び本線を区画する導流帯であって、前記支援地点判断手段は、前記車両が各合流エリアに接近したか否かを判断し、前記テンプレート記憶手段は、各合流エリアの導流帯のパターンを記憶したテンプレートを格納していることを要旨とする。

【0013】

請求項8に記載の発明は、請求項3〜7のいずれか1項に記載の車載装置において、本線の各車間スペースの位置及び速度を検出するスペース検出手段と、前記位置算出手段が算出した前記車両の位置と、検出した前記車間スペースの位置及び速度とに基づいて、その車間スペースに合流するための案内又は合流待機の案内を行う合流案内手段とをさらに備えたことを要旨とする。

【発明の効果】

【0014】

請求項1に記載の発明によれば、車両位置の検出方法において、画像データに基づき路面標示を検出する。また、その標示の幅と所定地点までの距離とを対応付けた属性情報に基づいて、車両の位置を算出する。このため、路面標示を利用して、高精度な車両位置を算出できる。

【0015】

請求項2に記載の発明によれば、車両位置の検出方法において、画像データに基づき路面標示の標示要素の数を検出する。また、検出した標示要素の数と、その標示要素の数及び所定地点までの距離を対応付けた属性情報とに基づいて、車両の位置を算出する。このため、路面標示を利用して、高精度な車両位置を算出できる。

【0016】

請求項3に記載の発明によれば、車載装置は、画像データに基づき路面標示の幅を検出する。そして、検出した幅と、標示の幅及び所定地点までの距離を対応付けた属性情報とに基づいて、車両の位置を算出する。このため、路面標示を利用して、高精度な車両位置

を算出できる。

【0017】

請求項4に記載の発明によれば、車載装置は、画像データに基づき路面標示の標示要素の数を検出する。そして、検出した標示要素の数と、標示要素の数及び所定地点までの距離を対応付けた属性情報とに基づいて、車両の位置を算出する。このため、路面標示を利用して、高精度な車両位置を算出できる。

【0018】

請求項5に記載の発明によれば、車載装置は、車両の操作支援を行う支援地点に接近した際に、画像データに基づいて、車両の位置を算出する。このため、支援地点直前に、高精度な位置を算出することができるので、その車両位置を用いて操作支援を的確に行うことができる。

【0019】

請求項6に記載の発明によれば、車載装置は、路面標示のパターンを示すテンプレートと、路面標示を撮像した画像データとを照合して、路面標示を検出する。このため、各合流エリアに応じた路面標示を間違うことなく検出できる。

【0020】

請求項7に記載の発明によれば、支援地点判断手段は、合流エリアに接近したか否かを判断する。テンプレート記憶手段は、導流帯のパターンを記憶したテンプレートを格納している。このため、比較的検出しやすく、各合流エリアによって固有のパターンを有する導流帯を利用することができる。

【0021】

請求項8に記載の発明によれば、位置算出手段が算出した車両の現在位置と、本車線の車間スペースに基づいて、その車間スペースに合流するための案内又は合流待機の案内を行う。このため、合流エリアにおいて位置算出手段によって算出された位置を用いることができるので、的確な案内を行うことができる。

【発明を実施するための最良の形態】

【0022】

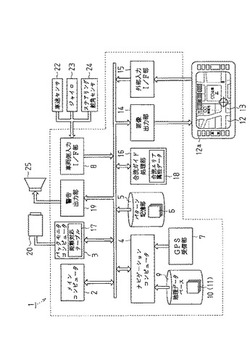

以下、本発明を具体化した一実施形態を図1〜図11に従って説明する。図1は、車載装置としての運転支援装置1の構成を説明するブロック図である。

図1に示すように、運転支援装置1は、メインコンピュータ2、バックモニタコンピュータ3、支援地点判断手段としてのナビゲーションコンピュータ4を備えている。メインコンピュータ2は、各種処理の主制御を行う。

【0023】

バックモニタコンピュータ3は、画像メモリ、画像処理を行う演算部等を有し、所定時間毎に、撮像装置としてのバックモニタカメラ(以下、カメラ20という)から画像データGを入力する。カメラ20は、図2に示すように、車両Cのリヤバンパー21の上方に、光軸を下方に向けて取り付けられている。このカメラ20は、カラー画像を撮像するデジタルカメラであって、広角レンズ、ミラー等から構成される光学機構と、CCD撮像素子(いずれも図示せず)とを備えている。カメラ20は、例えば左右140度の後方視野を有し、車両Cのリヤバンパー21の中央部を含む、車両Cの後側方を撮像する。また、図2に示すように、車両Cから後側方数メートルを、路面標示された白線を認識するための白線認識範囲Zとしている。尚、バックモニタコンピュータ3は、特許請求の範囲の画像データ取得手段、標示検出手段、属性情報記憶手段、位置算出手段、画像処理手段、幅検出手段、距離演算手段及びスペース検出手段を構成する。

【0024】

また、バックモニタコンピュータ3は、カメラ20から入力した画像データGに基づき、パターン認識処理を行う。具体的には、バックモニタコンピュータ3は、車両Cが、図3に示すような高速道路100の加速車線101内に進入したときから、所定のタイミングでカメラ20から画像データGを取得する。例えば、図4の画像30に示すような画像データGを取得する。画像データGに基づく画像30には、車両Cのリヤバンパー21を

撮像したバンパー画像31も含まれている。尚、実際は、カメラ20の広角レンズにより、画像データGの周辺が歪む歪曲収差が生じているが、ここでは便宜上図示省略する。

【0025】

そして、バックモニタコンピュータ3は、画像データGを、カメラ20の撮像範囲を俯瞰する仮想視点に視点変換し、図5(a)の俯瞰画像32に示すような、俯瞰画像データG1を生成する。尚、加速車線101と、加速車線101と並行する本線車道104の一部と、その間の路面標示等を、支援地点としての合流エリアとする。

【0026】

さらに、バックモニタコンピュータ3は、テンプレート記憶手段としてのテンプレート記憶部5に格納された、図5(b)に示すようなテンプレート6を読出す。そして、読出したテンプレート6と俯瞰画像データG1とを用いてテンプレートマッチングを行う。テンプレート記憶部5の各テンプレート6は、各加速車線101の入口付近に標示され、各車両の通行を安全・円滑に誘導するために、車両が通らないようにしている部分である、路面標示としての各導流帯(以下、ゼブラゾーン102という)のパターン(形状)を示すデータである。このテンプレート6は、各加速車線101毎に格納されている。合流エリアに標示されたゼブラゾーン102は、図3に示すように、一般的に、道路の進行方向に向って先細る略三角状の外枠102bと、外枠102b内に標示された複数の白線102cとから構成されているが、その形状や長さ等が各地点によってそれぞれ固有である。従って、各テンプレート6も互いに異なるデータになっている。

【0027】

バックモニタコンピュータ3は、テンプレート6を、俯瞰画像データG1に対して所定の方向に移動させ、各位置でマッチングさせ、ゼブラゾーン102のパターンを認識する。このとき、バックモニタコンピュータ3は、テンプレート6を、俯瞰画像データG1のうち白線認識範囲Zに相当する領域内で移動させる。そして、テンプレート6を移動させたそれぞれの位置で、テンプレート6と俯瞰画像データG1とで対応する各画素値の差分(差の2乗和、又は差の絶対値和等)を演算し、差分が最小となるような位置を求める。さらに、差分が最小となる位置において、テンプレート6と俯瞰画像データG1との類似度を判断する。差分値が充分小さく、類似度が高い場合には、俯瞰画像データG1に撮像されたゼブラゾーン102とテンプレート6とが一致したと判断する。また、このとき、バックモニタコンピュータ3は、俯瞰画像データG1に基づき、ゼブラゾーン102の幅Wを算出可能か否かを判断する。例えば、ゼブラゾーン102の長さ方向(加速車線101の進行方向と略平行な方向)のある位置において、その幅方向が全て撮像されている場合には、幅Wを算出可能であると判断する。

【0028】

ゼブラゾーン102を検出し、その幅Wを演算可能であると判断すると、バックモニタコンピュータ3は、そのゼブラゾーン102の幅Wを、俯瞰画像データG1に基づいて算出する。本実施形態では、バックモニタコンピュータ3は、俯瞰画像データG1を用い、図6に模式的に示すように、ゼブラゾーン102を示す画像36の両側の白線37,38のうち、車両C側の白線37に、他方の白線38から延ばした垂線Z2の長さを算出する。そして、その垂線Z2の長さを、幅測定位置Z3におけるゼブラゾーン102の幅Wとする。尚、幅測定位置Z3とは、垂線Z2を加速車線101側に延ばした位置である。尚、図6中、2点鎖線で示すゼブラゾーン41は、カメラ20により撮像されていない部分であって、説明の便宜上、カメラ20で撮像したゼブラゾーン102に連続して図示する。

【0029】

ゼブラゾーン102の幅Wを算出すると、バックモニタコンピュータ3は、図示しないROMから、図7に模式的に示すような、属性情報としての距離対応テーブル17を読出す。距離対応テーブル17は、各ゼブラゾーン102の幅Wと、幅Wの測定位置(図6中、幅測定位置Z3)からゼブラゾーン終端102a(所定地点)までの距離L1とを紐付けている。そして、バックモニタコンピュータ3は、検出したゼブラゾーン102の幅W

と距離対応テーブル17に基づき、幅測定位置Z3からのゼブラゾーン終端102aまでの、加速車線101の進行方向に沿った距離L1を算出する。尚、本実施形態では、バックモニタコンピュータ3は、距離L1を算出するようにしたが、加速車線101内での幅測定位置Z3の座標(車両位置)を算出するようにしてもよい。

【0030】

距離L1を算出すると、バックモニタコンピュータ3は、距離L1に基づき、画像データGを撮像した車両Cの位置を算出する。即ち、カメラ20は、左右180度の視野を有していないので、図6に模式的に示すように、幅Wを算出した幅測定位置Z3と、実際の車両Cの位置との間には、若干のずれ(距離L2)が生じている。カメラ20の設置位置と、カメラ20の撮像範囲とから、俯瞰画像データG1における各画素の位置から、カメラ20の設置位置までの距離は求めることができるので、バックモニタコンピュータ3は、幅測定位置Z3から車両Cの後端(リヤバンパー21)までの距離L2を算出する。そして、幅測定位置Z3からゼブラゾーン終端102aまでの距離L1から、幅測定位置Z3から車両Cの後端までの距離L2を減算して、加速車線101の進行方向に沿った残距離L3を算出する。残距離L3は、車両Cの後端から、ゼブラゾーン終端102aまでの距離であって、加速車線101内での車両Cの相対位置を示す。尚、ここでは、後の合流支援処理の効率化のために予め残距離L3を算出するようにしたが、加速車線101内での車両Cの座標位置を算出するようにしても勿論よい。残距離L3を算出すると、この残距離L3を、運転支援装置1が備える、合流案内手段としての合流ガイド処理部16に出力する。

【0031】

さらに、バックモニタコンピュータ3は、所定のタイミングで撮像した多数の画像データGに基づき、図3に示す本線車道104内において車両Cの後側方を走行する他車両103を公知の移動体検出処理により検出する。例えば、バックモニタコンピュータ3は、図4に示すように他車両103の画像30を撮像した画像データGを俯瞰画像データG1に変換し、所定時間毎に撮像した多数の画像データGの差分を演算することにより、他車両103(移動体)を認識する。また、検出した他車両103の移動速度を俯瞰画像データG1に基づき演算する。さらに、バックモニタコンピュータ3は、車両Cの後側方の他車両103だけでなく、車両Cを追い抜いた他車両103の速度をメモリに記憶する。そして、車両Cの前方に位置する他車両103の速度に経過時間を乗算して、各時点での車両Cの前方に位置する他車両103の位置を予測する。さらに、バックモニタコンピュータ3は、俯瞰画像データG1及び検出した他車両103の位置に基づき、各他車両103間の車間スペースS及びその距離を検出する。また、他車両103の速度に基づき、車間スペースSの移動速度を演算する。

【0032】

ナビゲーションコンピュータ4は、CPU、RAM、ROM等を備えたコンピュータであって、GPS(Global Positioning System)衛星から電波を受信するGPS受信部7

から、絶対位置検出信号を入力し、車両Cの絶対位置を算出する。また、車両側入力I/F8を介して、車速センサ22、ジャイロ23、ステアリング舵角センサ24から、位置検出信号としての車速パルス、方位検出信号、ステアリングセンサ信号をそれぞれ入力する。そして、各信号に基づき、自律航法により、基準位置からの相対距離及び相対方位を算出し、GPSに基づき算出した絶対位置と組み合わせて車両Cの位置を算出する。

【0033】

また、ナビゲーションコンピュータ4は、地理データベース9から、経路データ10、地図描画データ11を読出す。経路データ10は、道路端、交差点を示すノードデータ、各ノード間を接続するリンクデータ、ノード及びリンクの属性データを有している。属性データは、道路名称、高速道路等の道路種別、交差点、合流地点等を示す属性等を有している。ナビゲーションコンピュータ4は、この経路データ10に基づき、目的地までの推奨経路を探索する。また、自車位置を道路上に位置付けるマップマッチングを行いながら、車両Cが、加速車線101入口に到達したか否か、又は加速車線101に接続する登板

車線106の入口に到達したか否かを判断する。

【0034】

地図描画データ11は、運転支援装置1が備えるディスプレイ12に、地図画面13を表示するためのデータであって、背景データ、道路を描画するための道路データ等を有している。ナビゲーションコンピュータ4は、自車位置周辺の地図描画データ11を画像出力部14に出力し、画像出力部14は、地図描画データ11に基づく映像信号をディスプレイ12に出力する。ディスプレイ12は、タッチパネルであって、ユーザの入力操作に応じた信号を、外部入力I/F15に出力するようになっている。外部入力I/F15は、タッチパネルの操作による入力信号、ディスプレイ12に隣設された操作スイッチ12aの操作による信号を、メインコンピュータ2に出力する。

【0035】

また、合流ガイド処理部16は、CPU、RAM及びROM等を有している。ROMには、属性情報としての合流エリア属性データ18が格納されている。合流エリア属性データ18は、ゼブラゾーン終端102aから、図3に示す加速車線終端105までの合流可能区域107の距離(以下、合流可能距離L4という)を格納している。合流ガイド処理部16は、この合流エリア属性データ18と、バックモニタコンピュータ3が算出した残距離L3、車間スペースSの位置及び移動速度と、車両Cの速度とに基づいて、車両Cが円滑に合流可能な車間スペースSがあるか否かを判断する。

【0036】

合流可能な車間スペースSがあると判断すると、合流ガイド処理部16は、バックモニタコンピュータ3が算出した残距離L3と、合流可能距離L4等を用いて、車両Cが本線車道104に適切に合流するための推奨速度、タイミング等を演算する。合流ガイド処理部16は、推奨速度、タイミング等を演算すると、警告出力部19に出力する。

【0037】

警告出力部19は、各種音声ファイル及びアナログ/デジタル変換器等を有している。そして、合流ガイド処理部16の演算結果に応じて、スピーカ25から、「速度を上げてください」等の音声案内を出力する。

【0038】

次に本実施形態の処理手順について、図8及び図9に従って説明する。図8に示すように、運転支援装置1のナビゲーションコンピュータ4は、経路データ10に基づいて、車両Cが、料金所、又は加速車線101入口、又は登板車線106入口に到達したか否かの判断を繰り返す(ステップS1−1)。それらの地点に到達したと判断すると(ステップS1−1においてYES)、バックモニタコンピュータ3は、自車位置演算処理を行う(ステップS1−2)。

【0039】

図9に示すように、自車位置演算処理では、バックモニタコンピュータ3は、カメラ20から画像データGを入力して(ステップS2−1)、ゼブラゾーン102のパターンを認識するパターン認識を行う(ステップS2−2)。詳述すると、上記したように、バックモニタコンピュータ3は、画像データGを、俯瞰画像データG1に座標変換する。また、テンプレート記憶部5内に格納されたテンプレート6のうち、その加速車線101に関連付けられたテンプレート6を読出す。さらに、読出したテンプレート6を、俯瞰画像データG1に対して移動させ、テンプレートマッチングを行う。そして、それぞれの位置での各画素値の差分を演算し、各位置の類似度を算出する。尚、生成した俯瞰画像データG1は、バックモニタコンピュータ3の画像メモリ(図示略)に蓄積しておく。

【0040】

さらに、バックモニタコンピュータ3は、算出した類似度に基づき、ゼブラゾーン102を検出したか否かを判断する(ステップS2−3)。テンプレート6と俯瞰画像データG1の類似度が小さい場合には、ゼブラゾーン102を検出しないと判断し(ステップS2−3においてNO)、ステップS2−1に戻る。テンプレート6と俯瞰画像データG1との差分が最小となる位置において、その差分値が小さく、類似度が大きいと判断した場

合には、ゼブラゾーン102を検出したと判断して(ステップS2−3においてYES)、ステップS2−4に進む。

【0041】

ステップS2−4では、バックモニタコンピュータ3は、画像データGに基づき、ゼブラゾーン102の幅Wを検出可能であるか否かを判断する。上記したように、バックモニタコンピュータ3は、俯瞰画像データG1に基づき、ゼブラゾーン102の全幅が含まれた部分があるか否かを判断する。図4の画像30に示すように、カメラ20が撮像した画像データGに、ゼブラゾーン102の全幅を撮像した部分がある場合、バックモニタコンピュータ3は、ゼブラゾーン102の幅Wが検出可能であると判断し(ステップS2−4においてYES)、上記のようにゼブラゾーン102の幅Wを算出する(ステップS2−5)。そして、距離対応テーブル17を用いて、幅Wと紐付けられた距離L1を読出す。そして、読出した距離L1から、幅測定位置Z3から車両C後端までの距離L2を減算して、車両C後端からゼブラゾーン終端102aまでの残距離L3を算出する(ステップS2−6)。残距離L3を算出すると、図8に示すステップS1−3に戻る。

【0042】

ステップS1−3では、バックモニタコンピュータ3は、周辺車両情報を取する。具体的には、上記した画像メモリに蓄積された各俯瞰画像データG1と、最新の俯瞰画像データG1とを用いて、移動体である他車両103を検出する移動体検出処理を行う。そして各他車両103の位置に基づき、車間スペースSを検出し、その車間スペースSの距離を算出する。さらに、車両Cと各他車両103との各相対速度Vrをそれぞれ算出し、相対速度Vrに基づいて、車間スペースSの移動速度を算出する。また、過去に検出し、現在において車両Cを通過している他車両103の位置を、過去に算出した相対速度Vrと経過時間とに基づき、予測する。そして、車両Cの前側方、側方、後側方の車間スペースSの位置(座標)、距離(長さ)、移動速度を合流ガイド処理部16に出力する。また、バックモニタコンピュータ3は、算出した残距離L3を、合流ガイド処理部16に出力する。

【0043】

各車間スペースSのデータ、残距離L3を入力した合流ガイド処理部16は、まず、合流エリア属性データ18に基づき、残距離L3と、合流可能距離L4とを加算した値から、車長及び位置算出時点からの車両Cの移動量を減算して、加速可能距離L5(図示略)を算出する(ステップS1−4)。加速可能距離L5は、車両C前端から、加速車線終端105までの距離である。

【0044】

そして、合流ガイド処理部16は、バックモニタコンピュータ3から入力した車間スペースSの位置、距離及び移動速度と、残距離L3及び加速可能距離L5とに基づいて、車両Cが合流可能な車間スペースSがあるか否かを判断する(ステップS1−5)。まず、合流ガイド処理部16は、現在の車速と、残距離とに基づいて、ゼブラゾーン終端102aに到達可能な最小速度、最大速度を求める。そして、最小速度の場合の、ゼブラゾーン終端102aまでの予測到達時間T1、最大速度となった場合のゼブラゾーン終端102aまでの予測到達時間T2とを算出する。そして、各予測到達時間T1,T2を上下限値として、予測到達時間帯ΔTを求める。

【0045】

また、合流ガイド処理部16は、各車間スペースSの中心点が、予測到達時間帯ΔT内に到達する位置を予測し、ゼブラゾーン終端102aから、その中心点までの距離が、予め定めた距離範囲内にあるか否かを判断する。

【0046】

予め定めた距離範囲内に車間スペースSの中心点がある場合には、その車間スペースSの移動速度に応じて、車間スペースSの距離が合流に適しているか否かを判断する。例えば、車間スペースSの移動速度が時速80kmであった場合には、車間スペースSが80m以上の距離であるか否かを判断する。

【0047】

予測到達時間帯ΔTにおいて、ゼブラゾーン102a終端から所定距離範囲内に車間スペースSの中心点が存在し、且つ、その車間スペースSが合流可能な間隔を有している場合には、合流ガイド処理部16は、合流可能であると判断し(ステップS1−5においてYES)、合流案内を行う(ステップS1−6)。まず、合流ガイド処理部16は、その車間スペースSに合流するための推奨速度を求める。このとき、車間スペースSの中心点が、合流可能区域107に隣り合う間に、車両Cがその中心点に到達可能な最大速度及び最小速度を求める。そして、その速度のうち、現在の車速に最も近い速度、法定速度内の速度を推奨速度とする。

【0048】

推奨速度が求まると、まず、合流ガイド処理部16は、推奨速度を示す信号を警告出力部19に出力する。警告出力部19は、この信号を入力すると、図10に示すように、音声ファイルを取得して、「速度を上げてください」、又は「速度を時速80kmまで上げて下さい」等の案内音声をスピーカ25から出力する。このとき、警告出力部19によりディスプレイ12に、加速を促す表示を出力するようにしてもよい。

【0049】

また、合流ガイド処理部16は、車両Cがその推奨速度に到達するまでの予測時間を算出する。そして、その予測時間が経過したときの、車間スペースSの位置を予測する。そして、車間スペースSの予測位置に車両Cが接近した際に、所定の信号を警告出力部19に出力する。警告出力部19は、音声ファイルを読出し、スピーカ25を介して、「合流ポイントに接近しました」、「前後を確認して合流して下さい」等の案内音声、又は案内音を出力する。このように、合流直前において、バックモニタコンピュータ3により算出された高精度な残距離L3を用いることにより、正確な案内ができる。

【0050】

一方、予測到達時間帯ΔTにおいて、ゼブラゾーン終端102aから所定距離範囲内の車間スペースSの中心点が存在しない、又はその車間スペースSが合流可能な距離でない場合、合流ガイド処理部16は、合流可能でないと判断する(ステップS1−5においてNO)。このとき、図11に示すように、合流ガイド処理部16は、警告出力部19を介して、「速度を下げて下さい」等の警告を出力する(ステップS1−7)。

【0051】

合流案内又は警告を行うと、メインコンピュータ2の制御により、バックモニタコンピュータ3は、車両Cが走行している車線を判断する(ステップS1−8)。本実施形態では、バックモニタコンピュータ3が、カメラ20から画像データGを入力し、その画像データGに基づき、ゼブラゾーン102を検出する。そして、加速車線101側で撮像した場合と比較して、ゼブラゾーン102が車両Cの中心に対して反対側にあると判断した場合には、車両Cの走行している車道が、本線車道104であると判断する。また、加速車線101側で撮像した場合と同じ側方にゼブラゾーン102を検出した場合には、車両Cが走行している車道が、加速車線101であると判断する。

【0052】

そして、合流ガイド処理部16は、合流が完了したか否かを判断する(ステップS1−9)。このとき、ステップS1−8で、車両Cが本線車道104を走行していると判断した場合には、合流が完了したと判断する(ステップS1−9においてYES)。そして、ステップS1−1に戻り、再び他の加速車線101入口等に接近するまで待機する。

【0053】

車両Cが加速車線101を走行していると判断した場合には(ステップS1−9においてNO)、ステップS1−3に戻り、上記した処理を繰り返す。

上記実施形態によれば、以下のような効果を得ることができる。

【0054】

(1)上記実施形態では、運転支援装置1は、バックモニタコンピュータ3により、車両Cの後端に設けられたカメラ20から画像データGを入力するようにした。また、バッ

クモニタコンピュータ3は、画像データGを用いて、加速車線101に路面標示されたゼブラゾーン102を検出するようにした。さらに、画像データGに基づき、ゼブラゾーン102の幅Wを算出し、幅Wと距離L1とを紐付けた距離対応テーブル17により、ゼブラゾーン終端102aまでの残距離L3と、加速車線終端105までの加速可能距離L5とを算出するようにした。このため、合流を行う直前に、車両Cの加速車線101内での位置を正確に算出することができる。従って、合流エリアに到達した際に、高精度な車両Cの位置を算出するので、時間経過による誤差が生じる前に、その車両位置を利用して、合流の際の操作支援を行うことができる。従って、的確な操作支援を行うことができる。

【0055】

(2)上記実施形態では、バックモニタコンピュータ3は、テンプレート記憶部5から、テンプレート6を抽出し、テンプレート6と画像データGとを照合して、その地点でのゼブラゾーン102のパターンを検出するようにした。そして、そのゼブラゾーン102の幅Wを算出して、車両Cの加速車線101内での位置を算出するようにした。このため、各合流エリアによって固有のゼブラゾーン102を利用して、車両位置を算出することができる。

【0056】

(3)上記実施形態では、バックモニタコンピュータ3は、ゼブラゾーン102の画像36の幅Wを算出するようにした。そして、幅Wとゼブラゾーン終端102aまでの距離L1を紐付けた距離対応テーブル17を用いて、車両後端からゼブラゾーン終端102aまでの残距離L3を算出するようにした。このため、加速車線101内において、進行方向に沿った車両位置を算出できる。

【0057】

(4)上記実施形態では、バックモニタコンピュータ3により、画像データGを用いて、本線車道104を走行する他車両103を検出するようにした。また、他車両103の位置及び速度に基づき、他車両103の間の車間スペースSの位置、距離、及び速度を算出するようにした。そして、合流ガイド処理部16により、バックモニタコンピュータ3が算出した残距離L3と、検出した車間スペースSとに基づいて、推奨速度、合流タイミングの案内、又は合流待機を案内するようにした。即ち、高精度な車両位置を利用して操作支援を行うので、精度の良い推奨速度、的確な合流タイミングを案内できる。また、車両Cに搭載された運転支援装置1のみを用いて操作支援を行うので、路側に配設された道路状況把握センサの有無、又は車々間通信を行う他車両103の有無等、外部環境条件に関わらず、合流案内を行うことができる。

【0058】

(4)上記実施形態では、GPS受信部7、車速パルス等に基づき、ナビゲーションコンピュータ4により加速車線101への接近を判断するようにした。このため、通常は、外部から入力した各種信号に基づいて位置を算出し、加速車線101入口等に接近した際に、画像データGに基づく位置検出処理に切替えることができる。

【0059】

尚、本実施形態は以下のように変更してもよい。

・上記実施形態では、車両Cの後端に取付けたカメラ20により本線車道104の他車両103を検出するようにしたが、車両Cのサイドミラー周辺に取付けたカメラにより、本線車道104の他車両103を検出するようにしてもよい。

【0060】

・上記した距離対応テーブル17は、ゼブラゾーン102の幅Wと、幅測定位置Z3から加速車線終端105(所定地点)までの距離とを紐付けるようにしてもよい。この場合、バックモニタコンピュータ3は、幅Wに基づき、加速可能距離L5を直接算出することができる。

【0061】

・上記実施形態では、バックモニタコンピュータ3は、俯瞰画像データG1に基づいてゼブラゾーン102の幅Wを算出し、算出した幅Wと距離対応テーブル17とに基づき、

幅測定位置Z3からゼブラゾーン終端102aまでの距離L1を算出するようにした。これ以外に、算出した幅Wとゼブラゾーン102の形状を示す関数とに基づいて、距離L1を算出するようにしてもよい。ゼブラゾーン102の形状を示す関数は、幅Wと距離L1とを変数として有し、ゼブラゾーン102の幅Wに基づき距離L1を算出できる。

【0062】

・上記実施形態では、車両Cがゼブラゾーン終端102aまでに到達する最小速度及び最大速度に基づいて、予測到達時間帯ΔTを算出した。そして、予測到達時間帯ΔT内に、ゼブラゾーン終端102aから所定距離範囲内の車間スペースSの有無を判断して、合流可能な車間スペースがあるか否かを判断したが、これ以外の合流可否の判断方法を用いてもよい。また、推奨速度、タイミングの算出方法も、上記実施形態の方法以外でもよい。また、推奨速度等の案内も、ディスプレイ12に表示したり、インストルメントパネルの表示部に表示するようにしてもよい。

【0063】

・上記実施形態では、バックモニタコンピュータ3は、ゼブラゾーン102の幅Wに基づいて、ゼブラゾーン終端102aまでの距離L1を算出するようにした。これ以外に、ゼブラゾーン102の白線の本数によって、ゼブラゾーン終端102aまでの距離L1を算出するようにしても良い。このとき、本数検出手段を構成するバックモニタコンピュータ3は、俯瞰画像データG1に基づいて、ゼブラゾーン102(画像36)を構成し、車両Cの進行方向と略直交する方向に延びる標示要素としての白線39(図6参照)の本数をカウントする。そして、ゼブラゾーン始端40から、車両Cが通過した白線39の本数を累積する。また、バックモニタコンピュータ3は、ゼブラゾーン始端40からの白線39の累積本数と、ゼブラゾーン終端102aまでの距離とを紐付けたテーブルを有している。そして、カウントした白線39の本数と、テーブルとに基づいて、ゼブラゾーン終端102aまでの距離を求める。このようにしても、加速車線101内での正確な距離を算出できるので、合流案内を的確に行うことができる。

【0064】

・上記実施形態では、カメラ20が撮像した画像データGに基づき、本線車道104の他車両103を検出するようにした。これを、図12に示すように、路側に配置されたセンサ110、又は周辺監視カメラと、発信装置111とにより、他車両103の位置と、その速度、車間スペースSの距離等を検出及び周囲に発信するようにしてもよい。そして、センサ110又は周辺カメラから、発信装置111を介して、運転支援装置1が、他車両103の速度、車間スペースSの距離等を受信するようにしても良い。このようにすると、合流案内の際に、高速道路100の路側にセンサ、周辺監視カメラがあることが必要となるが、加速車線101を走行しているときにカメラ20の死角となる他車両103も検出できる。又は、加速車線101を走行する車両Cと、本線車道104との間で、車々間通信を行って、互いの位置、速度等を送受信するようにしてもよい。そして、他車両103から受信した交通情報に基づき、運転支援装置1が合流案内を行うようにしても良い。

【0065】

・上記実施形態では、バックモニタコンピュータ3は、加速車線101内で撮像した画像データGをエッジ検出してから、テンプレートマッチングするようにしてもよい。

・上記実施形態では、バックモニタコンピュータ3は、ゼブラゾーン102を検出するようにしたが、合流エリアのその他の路面標示を検出するようにしてもよい。ゼブラゾーン終端102a付近から標示され、加速車線101と本線車道104を区画する破線状の白線を検出するようにしても良い。或いは、その加速車線101に路面標示された白線の曲率、形状を検出するようにしてよい。

【0066】

・上記実施形態では、バックモニタコンピュータ3は、ゼブラゾーン102の画像36の幅Wを検出するようにしたが、ゼブラゾーン始端40(図6参照)からの長さを検出してもよい。そして、ゼブラゾーン102のテンプレート6や、ゼブラゾーン102の全長

を示すデータをバックモニタコンピュータ3に格納し、それらのデータと、ゼブラゾーン始端40からの長さとに基づき、残距離L3を算出するようにしてもよい。

【0067】

・上記実施形態では、加速車線101入口等に接近した際に、ゼブラゾーン102を撮像した画像データGを用いて、車両Cの加速車線101内の相対位置を算出するようにしたが、合流エリア以外の地点に接近した際に、自車位置を算出するようにしてもよい。例えば、急カーブ進入地点に接近した際に、路面標示を検出して、車両位置を算出し、急カーブ進入の際の操作支援を行うようにしてもよい。又は、事故が発生しやすい交差点等に接近した際に、交差点手前の路面標示を用いて車両位置を検出してもよい。そして、車々間通信、路車間通信、又は運転支援装置1の画像処理機能を用いて、他車両103に関する情報を取得し、右折衝突防止のための操作支援、出会い頭衝突防止のための操作支援、歩行者回避のための操作支援を行うようにしてもよい。

【0068】

・上記実施形態では、合流エリア等の支援地点に接近した際に、ゼブラゾーン102等の路面標示を検出して車両位置を算出するようにした。これ以外に、ユーザによる操作スイッチ12aの入力操作、マップマッチングが適切に行うことができないとき等に位置を算出し、GPSによる電波航法による車両位置、自律航法による車両位置、又はそれらを組み合わせたハイブリット方式による車両位置を補正してもよい。

【図面の簡単な説明】

【0069】

【図1】本実施形態のナビゲーション装置の構成を説明するブロック図。

【図2】カメラの取付位置、白線認識範囲を説明する説明図。

【図3】合流エリアを説明する説明図。

【図4】ゼブラゾーンを撮像した画像データの説明図。

【図5】(a)は俯瞰画像データ、(b)はテンプレートの説明図。

【図6】ゼブラゾーンの幅を検出する処理の説明図。

【図7】バックモニタコンピュータが有する距離対応テーブルの説明図。

【図8】本実施形態の処理手順の説明図。

【図9】本実施形態の処理手順の説明図。

【図10】合流案内の説明図。

【図11】合流案内の説明図。

【図12】別例の合流案内のためのシステムの説明図。

【符号の説明】

【0070】

1…車載装置としての運転支援装置、3…画像データ取得手段、標示検出手段、属性情報記憶手段、位置算出手段、画像処理手段、幅検出手段、距離演算手段、スペース検出手段、本数検出手段としてのバックモニタコンピュータ、4…位置特定手段、支援地点判断手段としてのナビゲーションコンピュータ、5…テンプレート記憶手段としてのテンプレート記憶部、6…テンプレート、16…合流案内手段としての合流ガイド処理部、17…属性情報としての距離対応テーブル、18…属性情報としての合流エリア属性データ、20…撮像装置としてのカメラ、101…合流エリアを構成する加速車線、102…路面標示、導流帯としてのゼブラゾーン、102a…標示終端としてのゼブラゾーン終端、38…白線、39…標示要素としての白線、104…合流エリアを構成する本線車道、105…加速車線終端、C…車両、G…画像データ、L1,L2…距離、S…車間スペース、W…幅。

【技術分野】

【0001】

本発明は、車両位置算出方法及び車載装置に関する。

【背景技術】

【0002】

近年、交通事故、渋滞等の問題を解決し、自動車の円滑な走行を図るために、高度道路交通システム(Intelligent Transport Systems)の研究開発が進められている。このシ

ステムでは、例えば、車々間通信や路車間通信、又は自動車が具備する各種装置等により、所定距離内の各自動車の情報を収集し、各自動車に対して周辺道路状況に応じた操作支援を行う。

【0003】

このような操作支援として、例えば、合流エリア、カーブ進入地点、交差点等での支援が提案されている。この操作支援では、各自動車の位置や速度等を用いて各種演算を行うため、路側センサ又は自動車に搭載された各種装置により、車両位置を高精度に検出する必要がある。例えば、特許文献1には、車載カメラが撮像した案内標識を認識する装置が提案されている。この装置では、案内標識や信号を撮像した画像に基づいて、交差点までの距離を算出し、自律航法等によって求めた自車位置を補正する。

【特許文献1】特開2004−45227号公報

【発明の開示】

【発明が解決しようとする課題】

【0004】

ところが、上記した方法では、車両前方を撮像するカメラを車体に取り付ける必要があるため、コストがかかる。また、上記した方法では、交差点付近では自車位置補正を行うことができるが、車両が、交差点以外の操作支援ポイントに到達した際には、自車位置に誤差が生じていることが想定される。例えば、上記した合流エリアの操作支援を行う場合には、合流エリアで算出された自車位置に誤差がある虞がある。この誤差により、操作支援を行うタイミングが遅れたり、案内内容に誤りが生じたりして、合流エリアでの操作支援を的確に行うことができない虞がある。

【0005】

本発明は、上記問題点に鑑みてなされたものであり、その目的は、合流前に高精度な自車位置を算出することができる車両位置算出方法及び車載装置を提供することにある。

【課題を解決するための手段】

【0006】

上記問題点を解決するために、請求項1に記載の発明は、車両の位置を検出する車両位置算出方法において、前記車両に設けられた撮像装置から路面標示を撮像した画像データを取得し、前記画像データを用いてその路面標示を検出し、前記画像データに基づいて、前記路面標示の幅を検出するとともに、検出した前記路面標示の幅と、前記路面標示の幅及び所定地点までの道路進行方向に沿った距離を対応付けた属性情報とを用いて、道路の進行方向に沿った前記車両の位置を算出することを要旨とする。

【0007】

請求項2に記載の発明は、車両の位置を検出する車両位置算出方法において、前記車両に設けられた撮像装置から路面標示を撮像した画像データを取得し、前記画像データを用いてその路面標示を検出し、前記画像データに基づいて、前記路面標示を構成する標示要素の数を検出するとともに、検出した前記標示要素の数と、前記標示要素の数及び所定地点までの道路進行方向に沿った距離を対応付けた属性情報とを用いて、道路の進行方向に沿った前記車両の位置を算出することを要旨とする。

【0008】

請求項3に記載の発明は、車両に設けられた撮像装置から画像データを取得する画像デ

ータ取得手段と、前記画像データを用いて、路面標示を検出する標示検出手段と、前記路面標示の幅と、所定地点までの道路進行方向に沿った距離とを対応付けた属性情報を格納した属性情報記憶手段と、前記路面標示の画像データに基づき、前記路面標示の幅を検出し、検出した幅と前記属性情報とに基づいて、前記所定地点までの距離を演算することにより、前記車両の位置を算出する位置算出手段とを備えたことを要旨とする。

【0009】

請求項4に記載の発明は、車両に設けられた撮像装置から画像データを取得する画像データ取得手段と、前記画像データを用いて、路面標示を検出する標示検出手段と、前記路面標示を構成する標示要素の数と、所定地点までの道路進行方向に沿った距離とを対応付けた属性情報を格納した属性情報記憶手段と、前記路面標示の画像データに基づき、前記路面標示の前記標示要素の数を検出し、検出した前記標示要素の数と前記属性情報とに基づいて、前記所定地点までの距離を演算することにより、前記車両の位置を算出する位置算出手段とを備えたことを要旨とする。

【0010】

請求項5に記載の発明は、請求項3又は4に記載の車載装置において、前記車両の操作支援を行う支援地点に接近したか否かを判断する支援地点判断手段をさらに備え、前記標示検出手段は、前記支援地点に接近した際に、前記支援地点よりも進行方向手前に標示された路面標示を検出することを要旨とする。

【0011】

請求項6に記載の発明は、請求項3〜5のいずれか1項に記載の車載装置において、前記標示検出手段は、各合流エリアの路面標示のパターンを記憶したテンプレートを格納するテンプレート記憶手段と、前記テンプレートと、前記路面標示を撮像した前記画像データとを照合する画像処理手段とを備えたことを要旨とする。

【0012】

請求項7に記載の発明は、請求項6に記載の車載装置において、前記路面標示は、合流エリアに標示され、加速車線及び本線を区画する導流帯であって、前記支援地点判断手段は、前記車両が各合流エリアに接近したか否かを判断し、前記テンプレート記憶手段は、各合流エリアの導流帯のパターンを記憶したテンプレートを格納していることを要旨とする。

【0013】

請求項8に記載の発明は、請求項3〜7のいずれか1項に記載の車載装置において、本線の各車間スペースの位置及び速度を検出するスペース検出手段と、前記位置算出手段が算出した前記車両の位置と、検出した前記車間スペースの位置及び速度とに基づいて、その車間スペースに合流するための案内又は合流待機の案内を行う合流案内手段とをさらに備えたことを要旨とする。

【発明の効果】

【0014】

請求項1に記載の発明によれば、車両位置の検出方法において、画像データに基づき路面標示を検出する。また、その標示の幅と所定地点までの距離とを対応付けた属性情報に基づいて、車両の位置を算出する。このため、路面標示を利用して、高精度な車両位置を算出できる。

【0015】

請求項2に記載の発明によれば、車両位置の検出方法において、画像データに基づき路面標示の標示要素の数を検出する。また、検出した標示要素の数と、その標示要素の数及び所定地点までの距離を対応付けた属性情報とに基づいて、車両の位置を算出する。このため、路面標示を利用して、高精度な車両位置を算出できる。

【0016】

請求項3に記載の発明によれば、車載装置は、画像データに基づき路面標示の幅を検出する。そして、検出した幅と、標示の幅及び所定地点までの距離を対応付けた属性情報とに基づいて、車両の位置を算出する。このため、路面標示を利用して、高精度な車両位置

を算出できる。

【0017】

請求項4に記載の発明によれば、車載装置は、画像データに基づき路面標示の標示要素の数を検出する。そして、検出した標示要素の数と、標示要素の数及び所定地点までの距離を対応付けた属性情報とに基づいて、車両の位置を算出する。このため、路面標示を利用して、高精度な車両位置を算出できる。

【0018】

請求項5に記載の発明によれば、車載装置は、車両の操作支援を行う支援地点に接近した際に、画像データに基づいて、車両の位置を算出する。このため、支援地点直前に、高精度な位置を算出することができるので、その車両位置を用いて操作支援を的確に行うことができる。

【0019】

請求項6に記載の発明によれば、車載装置は、路面標示のパターンを示すテンプレートと、路面標示を撮像した画像データとを照合して、路面標示を検出する。このため、各合流エリアに応じた路面標示を間違うことなく検出できる。

【0020】

請求項7に記載の発明によれば、支援地点判断手段は、合流エリアに接近したか否かを判断する。テンプレート記憶手段は、導流帯のパターンを記憶したテンプレートを格納している。このため、比較的検出しやすく、各合流エリアによって固有のパターンを有する導流帯を利用することができる。

【0021】

請求項8に記載の発明によれば、位置算出手段が算出した車両の現在位置と、本車線の車間スペースに基づいて、その車間スペースに合流するための案内又は合流待機の案内を行う。このため、合流エリアにおいて位置算出手段によって算出された位置を用いることができるので、的確な案内を行うことができる。

【発明を実施するための最良の形態】

【0022】

以下、本発明を具体化した一実施形態を図1〜図11に従って説明する。図1は、車載装置としての運転支援装置1の構成を説明するブロック図である。

図1に示すように、運転支援装置1は、メインコンピュータ2、バックモニタコンピュータ3、支援地点判断手段としてのナビゲーションコンピュータ4を備えている。メインコンピュータ2は、各種処理の主制御を行う。

【0023】

バックモニタコンピュータ3は、画像メモリ、画像処理を行う演算部等を有し、所定時間毎に、撮像装置としてのバックモニタカメラ(以下、カメラ20という)から画像データGを入力する。カメラ20は、図2に示すように、車両Cのリヤバンパー21の上方に、光軸を下方に向けて取り付けられている。このカメラ20は、カラー画像を撮像するデジタルカメラであって、広角レンズ、ミラー等から構成される光学機構と、CCD撮像素子(いずれも図示せず)とを備えている。カメラ20は、例えば左右140度の後方視野を有し、車両Cのリヤバンパー21の中央部を含む、車両Cの後側方を撮像する。また、図2に示すように、車両Cから後側方数メートルを、路面標示された白線を認識するための白線認識範囲Zとしている。尚、バックモニタコンピュータ3は、特許請求の範囲の画像データ取得手段、標示検出手段、属性情報記憶手段、位置算出手段、画像処理手段、幅検出手段、距離演算手段及びスペース検出手段を構成する。

【0024】

また、バックモニタコンピュータ3は、カメラ20から入力した画像データGに基づき、パターン認識処理を行う。具体的には、バックモニタコンピュータ3は、車両Cが、図3に示すような高速道路100の加速車線101内に進入したときから、所定のタイミングでカメラ20から画像データGを取得する。例えば、図4の画像30に示すような画像データGを取得する。画像データGに基づく画像30には、車両Cのリヤバンパー21を

撮像したバンパー画像31も含まれている。尚、実際は、カメラ20の広角レンズにより、画像データGの周辺が歪む歪曲収差が生じているが、ここでは便宜上図示省略する。

【0025】

そして、バックモニタコンピュータ3は、画像データGを、カメラ20の撮像範囲を俯瞰する仮想視点に視点変換し、図5(a)の俯瞰画像32に示すような、俯瞰画像データG1を生成する。尚、加速車線101と、加速車線101と並行する本線車道104の一部と、その間の路面標示等を、支援地点としての合流エリアとする。

【0026】

さらに、バックモニタコンピュータ3は、テンプレート記憶手段としてのテンプレート記憶部5に格納された、図5(b)に示すようなテンプレート6を読出す。そして、読出したテンプレート6と俯瞰画像データG1とを用いてテンプレートマッチングを行う。テンプレート記憶部5の各テンプレート6は、各加速車線101の入口付近に標示され、各車両の通行を安全・円滑に誘導するために、車両が通らないようにしている部分である、路面標示としての各導流帯(以下、ゼブラゾーン102という)のパターン(形状)を示すデータである。このテンプレート6は、各加速車線101毎に格納されている。合流エリアに標示されたゼブラゾーン102は、図3に示すように、一般的に、道路の進行方向に向って先細る略三角状の外枠102bと、外枠102b内に標示された複数の白線102cとから構成されているが、その形状や長さ等が各地点によってそれぞれ固有である。従って、各テンプレート6も互いに異なるデータになっている。

【0027】

バックモニタコンピュータ3は、テンプレート6を、俯瞰画像データG1に対して所定の方向に移動させ、各位置でマッチングさせ、ゼブラゾーン102のパターンを認識する。このとき、バックモニタコンピュータ3は、テンプレート6を、俯瞰画像データG1のうち白線認識範囲Zに相当する領域内で移動させる。そして、テンプレート6を移動させたそれぞれの位置で、テンプレート6と俯瞰画像データG1とで対応する各画素値の差分(差の2乗和、又は差の絶対値和等)を演算し、差分が最小となるような位置を求める。さらに、差分が最小となる位置において、テンプレート6と俯瞰画像データG1との類似度を判断する。差分値が充分小さく、類似度が高い場合には、俯瞰画像データG1に撮像されたゼブラゾーン102とテンプレート6とが一致したと判断する。また、このとき、バックモニタコンピュータ3は、俯瞰画像データG1に基づき、ゼブラゾーン102の幅Wを算出可能か否かを判断する。例えば、ゼブラゾーン102の長さ方向(加速車線101の進行方向と略平行な方向)のある位置において、その幅方向が全て撮像されている場合には、幅Wを算出可能であると判断する。

【0028】

ゼブラゾーン102を検出し、その幅Wを演算可能であると判断すると、バックモニタコンピュータ3は、そのゼブラゾーン102の幅Wを、俯瞰画像データG1に基づいて算出する。本実施形態では、バックモニタコンピュータ3は、俯瞰画像データG1を用い、図6に模式的に示すように、ゼブラゾーン102を示す画像36の両側の白線37,38のうち、車両C側の白線37に、他方の白線38から延ばした垂線Z2の長さを算出する。そして、その垂線Z2の長さを、幅測定位置Z3におけるゼブラゾーン102の幅Wとする。尚、幅測定位置Z3とは、垂線Z2を加速車線101側に延ばした位置である。尚、図6中、2点鎖線で示すゼブラゾーン41は、カメラ20により撮像されていない部分であって、説明の便宜上、カメラ20で撮像したゼブラゾーン102に連続して図示する。

【0029】

ゼブラゾーン102の幅Wを算出すると、バックモニタコンピュータ3は、図示しないROMから、図7に模式的に示すような、属性情報としての距離対応テーブル17を読出す。距離対応テーブル17は、各ゼブラゾーン102の幅Wと、幅Wの測定位置(図6中、幅測定位置Z3)からゼブラゾーン終端102a(所定地点)までの距離L1とを紐付けている。そして、バックモニタコンピュータ3は、検出したゼブラゾーン102の幅W

と距離対応テーブル17に基づき、幅測定位置Z3からのゼブラゾーン終端102aまでの、加速車線101の進行方向に沿った距離L1を算出する。尚、本実施形態では、バックモニタコンピュータ3は、距離L1を算出するようにしたが、加速車線101内での幅測定位置Z3の座標(車両位置)を算出するようにしてもよい。

【0030】

距離L1を算出すると、バックモニタコンピュータ3は、距離L1に基づき、画像データGを撮像した車両Cの位置を算出する。即ち、カメラ20は、左右180度の視野を有していないので、図6に模式的に示すように、幅Wを算出した幅測定位置Z3と、実際の車両Cの位置との間には、若干のずれ(距離L2)が生じている。カメラ20の設置位置と、カメラ20の撮像範囲とから、俯瞰画像データG1における各画素の位置から、カメラ20の設置位置までの距離は求めることができるので、バックモニタコンピュータ3は、幅測定位置Z3から車両Cの後端(リヤバンパー21)までの距離L2を算出する。そして、幅測定位置Z3からゼブラゾーン終端102aまでの距離L1から、幅測定位置Z3から車両Cの後端までの距離L2を減算して、加速車線101の進行方向に沿った残距離L3を算出する。残距離L3は、車両Cの後端から、ゼブラゾーン終端102aまでの距離であって、加速車線101内での車両Cの相対位置を示す。尚、ここでは、後の合流支援処理の効率化のために予め残距離L3を算出するようにしたが、加速車線101内での車両Cの座標位置を算出するようにしても勿論よい。残距離L3を算出すると、この残距離L3を、運転支援装置1が備える、合流案内手段としての合流ガイド処理部16に出力する。

【0031】

さらに、バックモニタコンピュータ3は、所定のタイミングで撮像した多数の画像データGに基づき、図3に示す本線車道104内において車両Cの後側方を走行する他車両103を公知の移動体検出処理により検出する。例えば、バックモニタコンピュータ3は、図4に示すように他車両103の画像30を撮像した画像データGを俯瞰画像データG1に変換し、所定時間毎に撮像した多数の画像データGの差分を演算することにより、他車両103(移動体)を認識する。また、検出した他車両103の移動速度を俯瞰画像データG1に基づき演算する。さらに、バックモニタコンピュータ3は、車両Cの後側方の他車両103だけでなく、車両Cを追い抜いた他車両103の速度をメモリに記憶する。そして、車両Cの前方に位置する他車両103の速度に経過時間を乗算して、各時点での車両Cの前方に位置する他車両103の位置を予測する。さらに、バックモニタコンピュータ3は、俯瞰画像データG1及び検出した他車両103の位置に基づき、各他車両103間の車間スペースS及びその距離を検出する。また、他車両103の速度に基づき、車間スペースSの移動速度を演算する。

【0032】

ナビゲーションコンピュータ4は、CPU、RAM、ROM等を備えたコンピュータであって、GPS(Global Positioning System)衛星から電波を受信するGPS受信部7

から、絶対位置検出信号を入力し、車両Cの絶対位置を算出する。また、車両側入力I/F8を介して、車速センサ22、ジャイロ23、ステアリング舵角センサ24から、位置検出信号としての車速パルス、方位検出信号、ステアリングセンサ信号をそれぞれ入力する。そして、各信号に基づき、自律航法により、基準位置からの相対距離及び相対方位を算出し、GPSに基づき算出した絶対位置と組み合わせて車両Cの位置を算出する。

【0033】

また、ナビゲーションコンピュータ4は、地理データベース9から、経路データ10、地図描画データ11を読出す。経路データ10は、道路端、交差点を示すノードデータ、各ノード間を接続するリンクデータ、ノード及びリンクの属性データを有している。属性データは、道路名称、高速道路等の道路種別、交差点、合流地点等を示す属性等を有している。ナビゲーションコンピュータ4は、この経路データ10に基づき、目的地までの推奨経路を探索する。また、自車位置を道路上に位置付けるマップマッチングを行いながら、車両Cが、加速車線101入口に到達したか否か、又は加速車線101に接続する登板

車線106の入口に到達したか否かを判断する。

【0034】

地図描画データ11は、運転支援装置1が備えるディスプレイ12に、地図画面13を表示するためのデータであって、背景データ、道路を描画するための道路データ等を有している。ナビゲーションコンピュータ4は、自車位置周辺の地図描画データ11を画像出力部14に出力し、画像出力部14は、地図描画データ11に基づく映像信号をディスプレイ12に出力する。ディスプレイ12は、タッチパネルであって、ユーザの入力操作に応じた信号を、外部入力I/F15に出力するようになっている。外部入力I/F15は、タッチパネルの操作による入力信号、ディスプレイ12に隣設された操作スイッチ12aの操作による信号を、メインコンピュータ2に出力する。

【0035】

また、合流ガイド処理部16は、CPU、RAM及びROM等を有している。ROMには、属性情報としての合流エリア属性データ18が格納されている。合流エリア属性データ18は、ゼブラゾーン終端102aから、図3に示す加速車線終端105までの合流可能区域107の距離(以下、合流可能距離L4という)を格納している。合流ガイド処理部16は、この合流エリア属性データ18と、バックモニタコンピュータ3が算出した残距離L3、車間スペースSの位置及び移動速度と、車両Cの速度とに基づいて、車両Cが円滑に合流可能な車間スペースSがあるか否かを判断する。

【0036】

合流可能な車間スペースSがあると判断すると、合流ガイド処理部16は、バックモニタコンピュータ3が算出した残距離L3と、合流可能距離L4等を用いて、車両Cが本線車道104に適切に合流するための推奨速度、タイミング等を演算する。合流ガイド処理部16は、推奨速度、タイミング等を演算すると、警告出力部19に出力する。

【0037】

警告出力部19は、各種音声ファイル及びアナログ/デジタル変換器等を有している。そして、合流ガイド処理部16の演算結果に応じて、スピーカ25から、「速度を上げてください」等の音声案内を出力する。

【0038】

次に本実施形態の処理手順について、図8及び図9に従って説明する。図8に示すように、運転支援装置1のナビゲーションコンピュータ4は、経路データ10に基づいて、車両Cが、料金所、又は加速車線101入口、又は登板車線106入口に到達したか否かの判断を繰り返す(ステップS1−1)。それらの地点に到達したと判断すると(ステップS1−1においてYES)、バックモニタコンピュータ3は、自車位置演算処理を行う(ステップS1−2)。

【0039】

図9に示すように、自車位置演算処理では、バックモニタコンピュータ3は、カメラ20から画像データGを入力して(ステップS2−1)、ゼブラゾーン102のパターンを認識するパターン認識を行う(ステップS2−2)。詳述すると、上記したように、バックモニタコンピュータ3は、画像データGを、俯瞰画像データG1に座標変換する。また、テンプレート記憶部5内に格納されたテンプレート6のうち、その加速車線101に関連付けられたテンプレート6を読出す。さらに、読出したテンプレート6を、俯瞰画像データG1に対して移動させ、テンプレートマッチングを行う。そして、それぞれの位置での各画素値の差分を演算し、各位置の類似度を算出する。尚、生成した俯瞰画像データG1は、バックモニタコンピュータ3の画像メモリ(図示略)に蓄積しておく。

【0040】

さらに、バックモニタコンピュータ3は、算出した類似度に基づき、ゼブラゾーン102を検出したか否かを判断する(ステップS2−3)。テンプレート6と俯瞰画像データG1の類似度が小さい場合には、ゼブラゾーン102を検出しないと判断し(ステップS2−3においてNO)、ステップS2−1に戻る。テンプレート6と俯瞰画像データG1との差分が最小となる位置において、その差分値が小さく、類似度が大きいと判断した場

合には、ゼブラゾーン102を検出したと判断して(ステップS2−3においてYES)、ステップS2−4に進む。

【0041】

ステップS2−4では、バックモニタコンピュータ3は、画像データGに基づき、ゼブラゾーン102の幅Wを検出可能であるか否かを判断する。上記したように、バックモニタコンピュータ3は、俯瞰画像データG1に基づき、ゼブラゾーン102の全幅が含まれた部分があるか否かを判断する。図4の画像30に示すように、カメラ20が撮像した画像データGに、ゼブラゾーン102の全幅を撮像した部分がある場合、バックモニタコンピュータ3は、ゼブラゾーン102の幅Wが検出可能であると判断し(ステップS2−4においてYES)、上記のようにゼブラゾーン102の幅Wを算出する(ステップS2−5)。そして、距離対応テーブル17を用いて、幅Wと紐付けられた距離L1を読出す。そして、読出した距離L1から、幅測定位置Z3から車両C後端までの距離L2を減算して、車両C後端からゼブラゾーン終端102aまでの残距離L3を算出する(ステップS2−6)。残距離L3を算出すると、図8に示すステップS1−3に戻る。

【0042】

ステップS1−3では、バックモニタコンピュータ3は、周辺車両情報を取する。具体的には、上記した画像メモリに蓄積された各俯瞰画像データG1と、最新の俯瞰画像データG1とを用いて、移動体である他車両103を検出する移動体検出処理を行う。そして各他車両103の位置に基づき、車間スペースSを検出し、その車間スペースSの距離を算出する。さらに、車両Cと各他車両103との各相対速度Vrをそれぞれ算出し、相対速度Vrに基づいて、車間スペースSの移動速度を算出する。また、過去に検出し、現在において車両Cを通過している他車両103の位置を、過去に算出した相対速度Vrと経過時間とに基づき、予測する。そして、車両Cの前側方、側方、後側方の車間スペースSの位置(座標)、距離(長さ)、移動速度を合流ガイド処理部16に出力する。また、バックモニタコンピュータ3は、算出した残距離L3を、合流ガイド処理部16に出力する。

【0043】

各車間スペースSのデータ、残距離L3を入力した合流ガイド処理部16は、まず、合流エリア属性データ18に基づき、残距離L3と、合流可能距離L4とを加算した値から、車長及び位置算出時点からの車両Cの移動量を減算して、加速可能距離L5(図示略)を算出する(ステップS1−4)。加速可能距離L5は、車両C前端から、加速車線終端105までの距離である。

【0044】

そして、合流ガイド処理部16は、バックモニタコンピュータ3から入力した車間スペースSの位置、距離及び移動速度と、残距離L3及び加速可能距離L5とに基づいて、車両Cが合流可能な車間スペースSがあるか否かを判断する(ステップS1−5)。まず、合流ガイド処理部16は、現在の車速と、残距離とに基づいて、ゼブラゾーン終端102aに到達可能な最小速度、最大速度を求める。そして、最小速度の場合の、ゼブラゾーン終端102aまでの予測到達時間T1、最大速度となった場合のゼブラゾーン終端102aまでの予測到達時間T2とを算出する。そして、各予測到達時間T1,T2を上下限値として、予測到達時間帯ΔTを求める。

【0045】

また、合流ガイド処理部16は、各車間スペースSの中心点が、予測到達時間帯ΔT内に到達する位置を予測し、ゼブラゾーン終端102aから、その中心点までの距離が、予め定めた距離範囲内にあるか否かを判断する。

【0046】

予め定めた距離範囲内に車間スペースSの中心点がある場合には、その車間スペースSの移動速度に応じて、車間スペースSの距離が合流に適しているか否かを判断する。例えば、車間スペースSの移動速度が時速80kmであった場合には、車間スペースSが80m以上の距離であるか否かを判断する。

【0047】

予測到達時間帯ΔTにおいて、ゼブラゾーン102a終端から所定距離範囲内に車間スペースSの中心点が存在し、且つ、その車間スペースSが合流可能な間隔を有している場合には、合流ガイド処理部16は、合流可能であると判断し(ステップS1−5においてYES)、合流案内を行う(ステップS1−6)。まず、合流ガイド処理部16は、その車間スペースSに合流するための推奨速度を求める。このとき、車間スペースSの中心点が、合流可能区域107に隣り合う間に、車両Cがその中心点に到達可能な最大速度及び最小速度を求める。そして、その速度のうち、現在の車速に最も近い速度、法定速度内の速度を推奨速度とする。

【0048】

推奨速度が求まると、まず、合流ガイド処理部16は、推奨速度を示す信号を警告出力部19に出力する。警告出力部19は、この信号を入力すると、図10に示すように、音声ファイルを取得して、「速度を上げてください」、又は「速度を時速80kmまで上げて下さい」等の案内音声をスピーカ25から出力する。このとき、警告出力部19によりディスプレイ12に、加速を促す表示を出力するようにしてもよい。

【0049】

また、合流ガイド処理部16は、車両Cがその推奨速度に到達するまでの予測時間を算出する。そして、その予測時間が経過したときの、車間スペースSの位置を予測する。そして、車間スペースSの予測位置に車両Cが接近した際に、所定の信号を警告出力部19に出力する。警告出力部19は、音声ファイルを読出し、スピーカ25を介して、「合流ポイントに接近しました」、「前後を確認して合流して下さい」等の案内音声、又は案内音を出力する。このように、合流直前において、バックモニタコンピュータ3により算出された高精度な残距離L3を用いることにより、正確な案内ができる。

【0050】

一方、予測到達時間帯ΔTにおいて、ゼブラゾーン終端102aから所定距離範囲内の車間スペースSの中心点が存在しない、又はその車間スペースSが合流可能な距離でない場合、合流ガイド処理部16は、合流可能でないと判断する(ステップS1−5においてNO)。このとき、図11に示すように、合流ガイド処理部16は、警告出力部19を介して、「速度を下げて下さい」等の警告を出力する(ステップS1−7)。

【0051】

合流案内又は警告を行うと、メインコンピュータ2の制御により、バックモニタコンピュータ3は、車両Cが走行している車線を判断する(ステップS1−8)。本実施形態では、バックモニタコンピュータ3が、カメラ20から画像データGを入力し、その画像データGに基づき、ゼブラゾーン102を検出する。そして、加速車線101側で撮像した場合と比較して、ゼブラゾーン102が車両Cの中心に対して反対側にあると判断した場合には、車両Cの走行している車道が、本線車道104であると判断する。また、加速車線101側で撮像した場合と同じ側方にゼブラゾーン102を検出した場合には、車両Cが走行している車道が、加速車線101であると判断する。

【0052】

そして、合流ガイド処理部16は、合流が完了したか否かを判断する(ステップS1−9)。このとき、ステップS1−8で、車両Cが本線車道104を走行していると判断した場合には、合流が完了したと判断する(ステップS1−9においてYES)。そして、ステップS1−1に戻り、再び他の加速車線101入口等に接近するまで待機する。

【0053】

車両Cが加速車線101を走行していると判断した場合には(ステップS1−9においてNO)、ステップS1−3に戻り、上記した処理を繰り返す。

上記実施形態によれば、以下のような効果を得ることができる。

【0054】

(1)上記実施形態では、運転支援装置1は、バックモニタコンピュータ3により、車両Cの後端に設けられたカメラ20から画像データGを入力するようにした。また、バッ

クモニタコンピュータ3は、画像データGを用いて、加速車線101に路面標示されたゼブラゾーン102を検出するようにした。さらに、画像データGに基づき、ゼブラゾーン102の幅Wを算出し、幅Wと距離L1とを紐付けた距離対応テーブル17により、ゼブラゾーン終端102aまでの残距離L3と、加速車線終端105までの加速可能距離L5とを算出するようにした。このため、合流を行う直前に、車両Cの加速車線101内での位置を正確に算出することができる。従って、合流エリアに到達した際に、高精度な車両Cの位置を算出するので、時間経過による誤差が生じる前に、その車両位置を利用して、合流の際の操作支援を行うことができる。従って、的確な操作支援を行うことができる。

【0055】

(2)上記実施形態では、バックモニタコンピュータ3は、テンプレート記憶部5から、テンプレート6を抽出し、テンプレート6と画像データGとを照合して、その地点でのゼブラゾーン102のパターンを検出するようにした。そして、そのゼブラゾーン102の幅Wを算出して、車両Cの加速車線101内での位置を算出するようにした。このため、各合流エリアによって固有のゼブラゾーン102を利用して、車両位置を算出することができる。

【0056】

(3)上記実施形態では、バックモニタコンピュータ3は、ゼブラゾーン102の画像36の幅Wを算出するようにした。そして、幅Wとゼブラゾーン終端102aまでの距離L1を紐付けた距離対応テーブル17を用いて、車両後端からゼブラゾーン終端102aまでの残距離L3を算出するようにした。このため、加速車線101内において、進行方向に沿った車両位置を算出できる。

【0057】

(4)上記実施形態では、バックモニタコンピュータ3により、画像データGを用いて、本線車道104を走行する他車両103を検出するようにした。また、他車両103の位置及び速度に基づき、他車両103の間の車間スペースSの位置、距離、及び速度を算出するようにした。そして、合流ガイド処理部16により、バックモニタコンピュータ3が算出した残距離L3と、検出した車間スペースSとに基づいて、推奨速度、合流タイミングの案内、又は合流待機を案内するようにした。即ち、高精度な車両位置を利用して操作支援を行うので、精度の良い推奨速度、的確な合流タイミングを案内できる。また、車両Cに搭載された運転支援装置1のみを用いて操作支援を行うので、路側に配設された道路状況把握センサの有無、又は車々間通信を行う他車両103の有無等、外部環境条件に関わらず、合流案内を行うことができる。

【0058】

(4)上記実施形態では、GPS受信部7、車速パルス等に基づき、ナビゲーションコンピュータ4により加速車線101への接近を判断するようにした。このため、通常は、外部から入力した各種信号に基づいて位置を算出し、加速車線101入口等に接近した際に、画像データGに基づく位置検出処理に切替えることができる。

【0059】

尚、本実施形態は以下のように変更してもよい。

・上記実施形態では、車両Cの後端に取付けたカメラ20により本線車道104の他車両103を検出するようにしたが、車両Cのサイドミラー周辺に取付けたカメラにより、本線車道104の他車両103を検出するようにしてもよい。

【0060】

・上記した距離対応テーブル17は、ゼブラゾーン102の幅Wと、幅測定位置Z3から加速車線終端105(所定地点)までの距離とを紐付けるようにしてもよい。この場合、バックモニタコンピュータ3は、幅Wに基づき、加速可能距離L5を直接算出することができる。

【0061】

・上記実施形態では、バックモニタコンピュータ3は、俯瞰画像データG1に基づいてゼブラゾーン102の幅Wを算出し、算出した幅Wと距離対応テーブル17とに基づき、

幅測定位置Z3からゼブラゾーン終端102aまでの距離L1を算出するようにした。これ以外に、算出した幅Wとゼブラゾーン102の形状を示す関数とに基づいて、距離L1を算出するようにしてもよい。ゼブラゾーン102の形状を示す関数は、幅Wと距離L1とを変数として有し、ゼブラゾーン102の幅Wに基づき距離L1を算出できる。

【0062】

・上記実施形態では、車両Cがゼブラゾーン終端102aまでに到達する最小速度及び最大速度に基づいて、予測到達時間帯ΔTを算出した。そして、予測到達時間帯ΔT内に、ゼブラゾーン終端102aから所定距離範囲内の車間スペースSの有無を判断して、合流可能な車間スペースがあるか否かを判断したが、これ以外の合流可否の判断方法を用いてもよい。また、推奨速度、タイミングの算出方法も、上記実施形態の方法以外でもよい。また、推奨速度等の案内も、ディスプレイ12に表示したり、インストルメントパネルの表示部に表示するようにしてもよい。

【0063】

・上記実施形態では、バックモニタコンピュータ3は、ゼブラゾーン102の幅Wに基づいて、ゼブラゾーン終端102aまでの距離L1を算出するようにした。これ以外に、ゼブラゾーン102の白線の本数によって、ゼブラゾーン終端102aまでの距離L1を算出するようにしても良い。このとき、本数検出手段を構成するバックモニタコンピュータ3は、俯瞰画像データG1に基づいて、ゼブラゾーン102(画像36)を構成し、車両Cの進行方向と略直交する方向に延びる標示要素としての白線39(図6参照)の本数をカウントする。そして、ゼブラゾーン始端40から、車両Cが通過した白線39の本数を累積する。また、バックモニタコンピュータ3は、ゼブラゾーン始端40からの白線39の累積本数と、ゼブラゾーン終端102aまでの距離とを紐付けたテーブルを有している。そして、カウントした白線39の本数と、テーブルとに基づいて、ゼブラゾーン終端102aまでの距離を求める。このようにしても、加速車線101内での正確な距離を算出できるので、合流案内を的確に行うことができる。

【0064】

・上記実施形態では、カメラ20が撮像した画像データGに基づき、本線車道104の他車両103を検出するようにした。これを、図12に示すように、路側に配置されたセンサ110、又は周辺監視カメラと、発信装置111とにより、他車両103の位置と、その速度、車間スペースSの距離等を検出及び周囲に発信するようにしてもよい。そして、センサ110又は周辺カメラから、発信装置111を介して、運転支援装置1が、他車両103の速度、車間スペースSの距離等を受信するようにしても良い。このようにすると、合流案内の際に、高速道路100の路側にセンサ、周辺監視カメラがあることが必要となるが、加速車線101を走行しているときにカメラ20の死角となる他車両103も検出できる。又は、加速車線101を走行する車両Cと、本線車道104との間で、車々間通信を行って、互いの位置、速度等を送受信するようにしてもよい。そして、他車両103から受信した交通情報に基づき、運転支援装置1が合流案内を行うようにしても良い。

【0065】

・上記実施形態では、バックモニタコンピュータ3は、加速車線101内で撮像した画像データGをエッジ検出してから、テンプレートマッチングするようにしてもよい。

・上記実施形態では、バックモニタコンピュータ3は、ゼブラゾーン102を検出するようにしたが、合流エリアのその他の路面標示を検出するようにしてもよい。ゼブラゾーン終端102a付近から標示され、加速車線101と本線車道104を区画する破線状の白線を検出するようにしても良い。或いは、その加速車線101に路面標示された白線の曲率、形状を検出するようにしてよい。

【0066】

・上記実施形態では、バックモニタコンピュータ3は、ゼブラゾーン102の画像36の幅Wを検出するようにしたが、ゼブラゾーン始端40(図6参照)からの長さを検出してもよい。そして、ゼブラゾーン102のテンプレート6や、ゼブラゾーン102の全長

を示すデータをバックモニタコンピュータ3に格納し、それらのデータと、ゼブラゾーン始端40からの長さとに基づき、残距離L3を算出するようにしてもよい。

【0067】

・上記実施形態では、加速車線101入口等に接近した際に、ゼブラゾーン102を撮像した画像データGを用いて、車両Cの加速車線101内の相対位置を算出するようにしたが、合流エリア以外の地点に接近した際に、自車位置を算出するようにしてもよい。例えば、急カーブ進入地点に接近した際に、路面標示を検出して、車両位置を算出し、急カーブ進入の際の操作支援を行うようにしてもよい。又は、事故が発生しやすい交差点等に接近した際に、交差点手前の路面標示を用いて車両位置を検出してもよい。そして、車々間通信、路車間通信、又は運転支援装置1の画像処理機能を用いて、他車両103に関する情報を取得し、右折衝突防止のための操作支援、出会い頭衝突防止のための操作支援、歩行者回避のための操作支援を行うようにしてもよい。

【0068】

・上記実施形態では、合流エリア等の支援地点に接近した際に、ゼブラゾーン102等の路面標示を検出して車両位置を算出するようにした。これ以外に、ユーザによる操作スイッチ12aの入力操作、マップマッチングが適切に行うことができないとき等に位置を算出し、GPSによる電波航法による車両位置、自律航法による車両位置、又はそれらを組み合わせたハイブリット方式による車両位置を補正してもよい。

【図面の簡単な説明】

【0069】

【図1】本実施形態のナビゲーション装置の構成を説明するブロック図。

【図2】カメラの取付位置、白線認識範囲を説明する説明図。

【図3】合流エリアを説明する説明図。

【図4】ゼブラゾーンを撮像した画像データの説明図。

【図5】(a)は俯瞰画像データ、(b)はテンプレートの説明図。

【図6】ゼブラゾーンの幅を検出する処理の説明図。

【図7】バックモニタコンピュータが有する距離対応テーブルの説明図。

【図8】本実施形態の処理手順の説明図。

【図9】本実施形態の処理手順の説明図。

【図10】合流案内の説明図。

【図11】合流案内の説明図。

【図12】別例の合流案内のためのシステムの説明図。

【符号の説明】

【0070】

1…車載装置としての運転支援装置、3…画像データ取得手段、標示検出手段、属性情報記憶手段、位置算出手段、画像処理手段、幅検出手段、距離演算手段、スペース検出手段、本数検出手段としてのバックモニタコンピュータ、4…位置特定手段、支援地点判断手段としてのナビゲーションコンピュータ、5…テンプレート記憶手段としてのテンプレート記憶部、6…テンプレート、16…合流案内手段としての合流ガイド処理部、17…属性情報としての距離対応テーブル、18…属性情報としての合流エリア属性データ、20…撮像装置としてのカメラ、101…合流エリアを構成する加速車線、102…路面標示、導流帯としてのゼブラゾーン、102a…標示終端としてのゼブラゾーン終端、38…白線、39…標示要素としての白線、104…合流エリアを構成する本線車道、105…加速車線終端、C…車両、G…画像データ、L1,L2…距離、S…車間スペース、W…幅。

【特許請求の範囲】

【請求項1】

車両の位置を検出する車両位置算出方法において、

前記車両に設けられた撮像装置から路面標示を撮像した画像データを取得し、前記画像データを用いてその路面標示を検出し、

前記画像データに基づいて、前記路面標示の幅を検出するとともに、

検出した前記路面標示の幅と、前記路面標示の幅及び所定地点までの道路進行方向に沿った距離を対応付けた属性情報とを用いて、道路の進行方向に沿った前記車両の位置を算出することを特徴とする車両位置算出方法。

【請求項2】

車両の位置を検出する車両位置算出方法において、

前記車両に設けられた撮像装置から路面標示を撮像した画像データを取得し、前記画像データを用いてその路面標示を検出し、

前記画像データに基づいて、前記路面標示を構成する標示要素の数を検出するとともに、

検出した前記標示要素の数と、前記標示要素の数及び所定地点までの道路進行方向に沿った距離を対応付けた属性情報とを用いて、道路の進行方向に沿った前記車両の位置を算出することを特徴とする車両位置算出方法。

【請求項3】

車両に設けられた撮像装置から画像データを取得する画像データ取得手段と、

前記画像データを用いて、路面標示を検出する標示検出手段と、

前記路面標示の幅と、所定地点までの道路進行方向に沿った距離とを対応付けた属性情報を格納した属性情報記憶手段と、

前記路面標示の画像データに基づき、前記路面標示の幅を検出し、検出した幅と前記属性情報とに基づいて、前記所定地点までの距離を演算することにより、前記車両の位置を算出する位置算出手段と

を備えたことを特徴とする車載装置。

【請求項4】

車両に設けられた撮像装置から画像データを取得する画像データ取得手段と、

前記画像データを用いて、路面標示を検出する標示検出手段と、

前記路面標示を構成する標示要素の数と、所定地点までの道路進行方向に沿った距離とを対応付けた属性情報を格納した属性情報記憶手段と、

前記路面標示の画像データに基づき、前記路面標示の前記標示要素の数を検出し、検出した前記標示要素の数と前記属性情報とに基づいて、前記所定地点までの距離を演算することにより、前記車両の位置を算出する位置算出手段と

を備えたことを特徴とする車載装置。

【請求項5】

請求項3又は4に記載の車載装置において、

前記車両の操作支援を行う支援地点に接近したか否かを判断する支援地点判断手段をさらに備え、

前記標示検出手段は、前記支援地点に接近した際に、前記支援地点よりも進行方向手前に標示された路面標示を検出することを特徴とする車載装置。

【請求項6】

請求項3〜5のいずれか1項に記載の車載装置において、

前記標示検出手段は、

各合流エリアの路面標示のパターンを記憶したテンプレートを格納するテンプレート記憶手段と、

前記テンプレートと、前記路面標示を撮像した前記画像データとを照合する画像処理手段と

を備えたことを特徴とする車載装置。

【請求項7】

請求項6に記載の車載装置において、

前記路面標示は、合流エリアに標示され、加速車線及び本線を区画する導流帯であって、

前記支援地点判断手段は、

前記車両が各合流エリアに接近したか否かを判断し、

前記テンプレート記憶手段は、

各合流エリアの導流帯のパターンを記憶したテンプレートを格納していることを特徴とする車載装置。

【請求項8】

請求項3〜7のいずれか1項に記載の車載装置において、

本線の各車間スペースの位置及び速度を検出するスペース検出手段と、

前記位置算出手段が算出した前記車両の位置と、検出した前記車間スペースの位置及び速度とに基づいて、その車間スペースに合流するための案内又は合流待機の案内を行う合流案内手段と

をさらに備えたことを特徴とする車載装置。

【請求項1】

車両の位置を検出する車両位置算出方法において、

前記車両に設けられた撮像装置から路面標示を撮像した画像データを取得し、前記画像データを用いてその路面標示を検出し、

前記画像データに基づいて、前記路面標示の幅を検出するとともに、

検出した前記路面標示の幅と、前記路面標示の幅及び所定地点までの道路進行方向に沿った距離を対応付けた属性情報とを用いて、道路の進行方向に沿った前記車両の位置を算出することを特徴とする車両位置算出方法。

【請求項2】

車両の位置を検出する車両位置算出方法において、

前記車両に設けられた撮像装置から路面標示を撮像した画像データを取得し、前記画像データを用いてその路面標示を検出し、

前記画像データに基づいて、前記路面標示を構成する標示要素の数を検出するとともに、

検出した前記標示要素の数と、前記標示要素の数及び所定地点までの道路進行方向に沿った距離を対応付けた属性情報とを用いて、道路の進行方向に沿った前記車両の位置を算出することを特徴とする車両位置算出方法。

【請求項3】

車両に設けられた撮像装置から画像データを取得する画像データ取得手段と、

前記画像データを用いて、路面標示を検出する標示検出手段と、

前記路面標示の幅と、所定地点までの道路進行方向に沿った距離とを対応付けた属性情報を格納した属性情報記憶手段と、

前記路面標示の画像データに基づき、前記路面標示の幅を検出し、検出した幅と前記属性情報とに基づいて、前記所定地点までの距離を演算することにより、前記車両の位置を算出する位置算出手段と

を備えたことを特徴とする車載装置。

【請求項4】

車両に設けられた撮像装置から画像データを取得する画像データ取得手段と、

前記画像データを用いて、路面標示を検出する標示検出手段と、

前記路面標示を構成する標示要素の数と、所定地点までの道路進行方向に沿った距離とを対応付けた属性情報を格納した属性情報記憶手段と、

前記路面標示の画像データに基づき、前記路面標示の前記標示要素の数を検出し、検出した前記標示要素の数と前記属性情報とに基づいて、前記所定地点までの距離を演算することにより、前記車両の位置を算出する位置算出手段と

を備えたことを特徴とする車載装置。

【請求項5】

請求項3又は4に記載の車載装置において、

前記車両の操作支援を行う支援地点に接近したか否かを判断する支援地点判断手段をさらに備え、

前記標示検出手段は、前記支援地点に接近した際に、前記支援地点よりも進行方向手前に標示された路面標示を検出することを特徴とする車載装置。

【請求項6】

請求項3〜5のいずれか1項に記載の車載装置において、

前記標示検出手段は、

各合流エリアの路面標示のパターンを記憶したテンプレートを格納するテンプレート記憶手段と、

前記テンプレートと、前記路面標示を撮像した前記画像データとを照合する画像処理手段と

を備えたことを特徴とする車載装置。

【請求項7】

請求項6に記載の車載装置において、

前記路面標示は、合流エリアに標示され、加速車線及び本線を区画する導流帯であって、

前記支援地点判断手段は、

前記車両が各合流エリアに接近したか否かを判断し、

前記テンプレート記憶手段は、

各合流エリアの導流帯のパターンを記憶したテンプレートを格納していることを特徴とする車載装置。

【請求項8】

請求項3〜7のいずれか1項に記載の車載装置において、

本線の各車間スペースの位置及び速度を検出するスペース検出手段と、

前記位置算出手段が算出した前記車両の位置と、検出した前記車間スペースの位置及び速度とに基づいて、その車間スペースに合流するための案内又は合流待機の案内を行う合流案内手段と

をさらに備えたことを特徴とする車載装置。

【図1】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【公開番号】特開2007−153031(P2007−153031A)

【公開日】平成19年6月21日(2007.6.21)

【国際特許分類】

【出願番号】特願2005−348331(P2005−348331)

【出願日】平成17年12月1日(2005.12.1)

【出願人】(000100768)アイシン・エィ・ダブリュ株式会社 (3,717)

【Fターム(参考)】

【公開日】平成19年6月21日(2007.6.21)

【国際特許分類】

【出願日】平成17年12月1日(2005.12.1)

【出願人】(000100768)アイシン・エィ・ダブリュ株式会社 (3,717)

【Fターム(参考)】

[ Back to top ]