運転者が注目している外部の物体に関する情報を提供するための車両システムおよび方法

【課題】車両の運転者に情報を提供するためのシステムおよび方法を提供する。

【解決手段】画像取得デバイス、頭部または視線追跡装置、少なくとも1つのプロセッサ、および出力デバイスを有する、車両の運転者に情報を提供するためのシステムおよび方法。画像取得デバイスは、車両の外部の環境の画像を取得する。頭部または視線追跡装置は、車両の運転者が視認している物体を判定する。少なくとも1つのプロセッサは、取得画像を処理する。また、少なくとも1つのプロセッサは、運転者が視認している物体の取得画像に含まれる言語を第2の言語に翻訳するか、または運転者が視認している物体の取得画像に基づいて地点情報を判定する。出力デバイスは、運転者が視認している物体の取得画像の翻訳された第2の言語を含むか、または運転者が視認している物体の取得画像に基づいて判定された地点情報を含む情報を出力する。

【解決手段】画像取得デバイス、頭部または視線追跡装置、少なくとも1つのプロセッサ、および出力デバイスを有する、車両の運転者に情報を提供するためのシステムおよび方法。画像取得デバイスは、車両の外部の環境の画像を取得する。頭部または視線追跡装置は、車両の運転者が視認している物体を判定する。少なくとも1つのプロセッサは、取得画像を処理する。また、少なくとも1つのプロセッサは、運転者が視認している物体の取得画像に含まれる言語を第2の言語に翻訳するか、または運転者が視認している物体の取得画像に基づいて地点情報を判定する。出力デバイスは、運転者が視認している物体の取得画像の翻訳された第2の言語を含むか、または運転者が視認している物体の取得画像に基づいて判定された地点情報を含む情報を出力する。

【発明の詳細な説明】

【技術分野】

【0001】

本開示は、車両の運転者に、運転者が注目している車両の外部の物体に関する言語翻訳情報または地点情報を提供するためのシステムおよび方法に関する。

【背景技術】

【0002】

車両の運転者は、運転者が追加情報を所望する標識、道路標識、または他の種類の物体等の、車両の外部の物体に注目することが多い。多くの車両は、運転者が視認している物体に関する追加情報を得るための、使用が面倒なナビゲーションシステムを収容している。例えば、車両の運転者は、運転者が追加の地点情報を所望する道路標識に注目し、次いで、運転者が所望する地点情報の種類をナビゲーションシステムに入力しなければならないかもしれない。運転者がこの情報をシステムに入力する時までには、運転者は既に出口を逃してしまっているかもしれない。

【0003】

外国を旅行する場合、運転者が注目している道路標識は、運転者が理解することが不可能な外国語である可能性が多い。このことは、外国での運転を危険なものにする場合がある。言語を翻訳するための既存のシステムの多くは、運転者が注目している物体のみに焦点を合わせるようには適合されていない。その結果、運転者は、運転者が何語に翻訳することを所望するかをシステムに伝えなければならない。これは非効率的であり、安全性に対する懸念となる可能性がある。

【発明の概要】

【発明が解決しようとする課題】

【0004】

既存のシステムおよび方法の1つ以上の課題を解決するために、車両の運転者に情報を提供するためのシステムおよび方法が必要である。

【課題を解決するための手段】

【0005】

一実施形態において、車両の運転者に情報を提供するためのシステムが開示される。システムは、画像取得デバイスと、頭部または視線追跡装置と、少なくとも1つのプロセッサと、出力デバイスとを備える。画像取得デバイスは、車両の外部の環境の画像を取得するためのものである。頭部または視線追跡装置は、車両の運転者が視認している物体を判定するためのものである。少なくとも1つのプロセッサは、取得画像を処理し、(1)運転者が視認している物体の取得画像に含まれる言語を第2の言語に翻訳すること、または、(2)運転者が視認している物体の取得画像に基づいて地点情報を判定することのうちの少なくとも1つを行うためのものである。出力デバイスは、(1)運転者が視認している物体の取得画像の翻訳された言語を含む第2の言語、または(2)運転者が視認している物体の取得画像に基づいて判定された地点情報のうちの少なくとも1つを含む情報を出力するためのものである。

【0006】

別の実施形態において、車両の運転者に情報を提供するための方法が開示される。あるステップにおいて、車両の外部の環境の画像は、画像取得デバイスによって取得される。別のステップにおいて、頭部または視線追跡装置は、車両の運転者が視認している物体を判定するために使用される。さらに別のステップにおいて、少なくとも1つのプロセッサは、取得画像を処理し、(1)運転者が視認している物体の取得画像に含まれる言語を第2の言語に翻訳するか、または(2)運転者が視認している物体の取得画像に基づいて地点情報を判定するかのうちの少なくとも1つを行う。さらなるステップにおいて、出力デバイスは、(1)運転者が視認している物体の取得画像の翻訳された言語を含む第2の言語、または(2)運転者が視認している物体の取得画像に基づいて判定された地点情報うちの少なくとも1つを含む情報を出力する。

【0007】

本開示のこれらおよび他の特徴、態様、および利点は、以下の図面、明細書、および特許請求の範囲を参照して、よりよく理解されるであろう。

【図面の簡単な説明】

【0008】

【図1】車両の運転者に情報を提供するためのシステムのブロック図を示す。

【図2】図1のシステムを利用して車両を運転している運転者の一実施形態の側面図を示す。

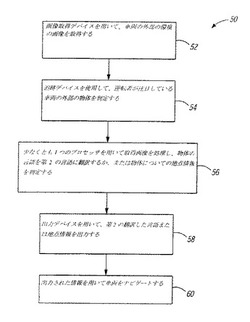

【図3】車両の運転者に情報を提供するための方法の一実施形態のフローチャートを示す。

【発明を実施するための形態】

【0009】

以下の詳細な説明は、現在企図される本開示を実行する最良の様式の説明である。本開示の範囲は、添付の特許請求の範囲によって最良に定義されるため、この説明は、限定的な意味に捉えられるべきではなく、本開示の一般的な原則を例示する目的でなされているに過ぎない。図は、純粋に例示目的のためであって、原寸には比例していないことに留意されたい。

【0010】

図1は、車両14の運転者12に情報を提供するためのシステム10のブロック図を示す。システム10は、入力デバイス16と、画像取得デバイス18と、追跡デバイス20と、プロセッサ22と、通信デバイス24と、出力デバイス26と、ナビゲーションシステム27とを備える。システム10は、車両内に実装される。システム10の上記構成要素の全ては、有線または無線で互いに通信している。

【0011】

入力デバイス16は、運転者がシステム10に情報を入力するか、またはシステム10を制御することを可能にする1つ以上の入力デバイスを備える。例示的な入力デバイス16は、運転者がシステム10に情報を入力することを可能にするマイク、コントロールパネル、または他の種類の入力デバイスを備える。運転者12は、システム10に指示を与えるために、マイクに向かってコマンドを話してもよい。運転者12は、システム10に指示を与えるために、コントロールパネルを使用してコマンドをタイプするか、触れるか、または視覚的に入力してもよい。他の実施形態において、運転者12は、多様な方法および入力デバイス16を使用してコマンドを入力してもよい。

【0012】

画像取得デバイス18は、車両14の外部の環境の画像を取得するための1つ以上の画像取得デバイスを備える。取得画像は、車両14の外部の環境にある標識、道路標識、または別の種類の物体を含んでもよい。一実施形態において、画像取得デバイス18は、車両14の外部の環境のどの部分に運転者12が注目しているのかを判定するための追跡デバイス20からの入力なしに、車両14の外部の環境の画像を無差別に取得する。別の実施形態において、画像取得デバイス18は、運転者12が注目していない車両14の外部の環境の部分の画像を取得することなく、追跡デバイス20からの入力に基づいて、運転者12が注目している車両14の外部の環境の部分の正確な画像のみを取得する。取得画像は、車両14の運転者12が注目している車両の外部の環境にある標識、道路標識、または別の種類の物体を含有してもよい。

【0013】

例示的な画像取得デバイス18は、車両14の外部の環境の画像を取得するためのカメラ、ビデオデバイス、または別の種類の画像取得デバイスを備える。前方画像取得デバイス、側方画像取得デバイス、後方画像取得デバイス、または別の種類の画像取得デバイスなどのような画像取得デバイス18は、車両14の外部の環境の所望の画像を取得するために、車両14周辺のどこに位置してもよい。取得画像は、デジタル形式またはアナログ形式であってもよい。取得画像がアナログである場合、画像取得デバイス18またはプロセッサ22は、画像をデジタル画像に変換するためのアナログデジタル変換機をさらに備えてもよい。一実施形態において、画像取得デバイス18は、車両14の外部の環境の画像を連続的に撮影することができる。別の実施形態において、画像取得デバイス18は、車両14の運転者12が入力デバイス16を使用してシステム10にそうするように指示を与えた場合にのみ、車両14の外部の環境の画像を撮影することができる。これは、システム10の処理およびデータ格納を効率的にする。

【0014】

追跡デバイス20は、車両14の外部の環境のどの部分に運転者12が注目しているのかを判定するための1つ以上の追跡デバイスを備える。これは、運転者12が注目している標識、道路標識、または車両14の外部の別の物体を含んでもよい。例示的な追跡デバイス20は、運転者12の目の動きを追跡するための視線追跡装置、運転者12の頭部の動きを追跡するための頭部追跡装置、または車両14の外部の環境のどの部分に運転者12が注目しているのかを追跡するための別の種類の追跡デバイスを備える。例示的な追跡デバイス20は、運転者の目または頭部の画像を撮影するためのカメラ、運転者の目または頭部を追跡するための発光および光検出システム、ならびに赤外線カメラから受信されたデータに基づいて、カメラによって撮影された画像に基づいて、および運転者の目または頭部の座標を判定する際の補助となる位置座標ユニットに基づいて、運転者の目または頭部の位置を処理、判定、保存、および追跡するための追跡アルゴリズムを実装するためのプロセッサを備えてもよい。例示的な追跡デバイス20には、http://www.smarteyecorporation.com(参照により、本明細書に組み込まれる)において参照される、Smarteye Corporationによって作製される全ての追跡デバイスが含まれる。米国特許第6,578,962号および第6,758,563号(参照により、本明細書に組み込まれる)は、システム10によって使用されてもよいさらなる例示的な追跡デバイス20について記載している。さらに、http://en.wikipedia.org/wiki/Eye_trackingに記載されるような他の追跡デバイスも、本システムによって使用されてもよく、また、参照により本明細書に組み込まれる。他の実施形態において、さまざまな追跡デバイス20が、車両14の外部の環境のどの部分に運転者12が注目しているのかを判定するために利用されてもよい。

【0015】

プロセッサ22は、取得画像を処理するための1つ以上のプロセッサを備える。プロセッサ22は、1つ以上のコンピュータを含んでもよい。一実施形態において、プロセッサ22は、運転者12が注目していなかった画像の部分を排除する一方で、無差別に取得された画像を車両14の運転者12が注目していた画像の部分のみに絞り込むために、追跡デバイス20を使用して、画像取得デバイス18によって取得された車両14の外部の環境の無差別に取得された画像を処理する。別の実施形態において、プロセッサ22は、追跡デバイス20から受信されたデータを使用して、車両14の外部の環境のどの部分に運転者12が注目しているのかを処理し、次いで、画像取得デバイス18に、運転者12が注目していない画像内の物体を取得することなく、運転者12が注目している車両14の外部の環境の部分の画像のみを取得するよう指示を与える。一実施形態において、プロセッサ22は、取得画像に含まれる言語を第2の言語に翻訳するように構成される。例えば、プロセッサ22は、車両14の運転者12が視認していた標識、道路標識、または他の物体の取得画像に含まれる言語を第2の言語に翻訳してもよい。別の実施形態において、プロセッサ22は、取得画像に基づいて地点情報を判定するように構成される。例えば、プロセッサ22は、車両14の運転者12が視認していた標識、道路標識、または他の物体の取得画像に基づいて地点情報を判定してもよい。地点情報は、地点の位置、地点の名称、車両14が地点から離れている距離、地点に位置する場所、製品、もしくはサービスの種類、または他の種類の地点情報を含んでもよい。

【0016】

プロセッサ22は、位置判定ユニット28と、処理ユニット30と、パターン認識ユニット32と、翻訳ユニット34と、データベースユニット36と、音声ユニット38とを備える。他の実施形態において、プロセッサ22は、上記ユニットのうちの1つ以上を含まなくてもよいか、またはプロセッサ22は、さらなる種類のユニットを含んでもよい。言及したプロセッサのユニットは、プロセッサ22内に含まれてもよい。他の実施形態において、言及したプロセッサ22のユニットのうちの1つ以上が、プロセッサ22の外部に含まれてもよいが、プロセッサ22と有線または無線で通信している。

【0017】

位置判定ユニット28は、車両14の位置、方向、もしくは速度を判定するため、および/または車両14の運転者12が注目している標識、道路標識、または他の種類の物体等の、取得画像に含まれる運転者12が注目している車両14の外部の物体の位置を判定するための、1つ以上の位置判定ユニットを備える。位置判定ユニット28は、車両14の運転者12が注目している取得画像に含まれる物体に対する車両14の位置を判定する。例示的な位置判定ユニット28は、グローバルポジショニングシステム、方位磁石、速度計、加速度計、ジャイロメーター、あるいは車両14の位置、方向、もしくは速度を判定するため、および/または車両14の運転者12が注目している取得画像に含まれる物体の位置を判定するための別の種類の位置判定ユニットを備える。

【0018】

処理ユニット30は、取得画像を含むシステム10によって収集された情報を処理するための1つ以上の処理ユニットを備える。処理ユニット30は、システム10の算術演算、論理、または入力/出力動作を行うために、プロセッサ22のメモリ内に保存されたプロセッサプログラムの命令を実行する。

【0019】

パターン認識ユニット32は、パターンを認識および判定するための1つ以上のパターン認識ユニットを備える。パターン認識ユニット32は、取得画像内のパターンを認識してもよい。パターン認識ユニット32は、車両14の運転者12が視認している標識、道路標識、または他の種類の物体等の物体を含むパターンを認識してもよい。また、パターン認識ユニット32は、車両14の運転者12が視認している文字、記号、数字、言語、または別の種類のパターンを含むパターンも認識してもよい。

【0020】

翻訳ユニット34は、車両14の運転者12が視認している物体内のパターンを1つの言語から第2の言語に翻訳するための1つ以上の翻訳ユニットを備える。翻訳ユニット34は、車両14の運転者12が視認している物体の取得画像内のパターンを分析することによってこれを行う。例えば、一実施形態において、翻訳ユニット34は、車両14の運転者12が視認している標識、道路標識、または別の物体の取得画像に含まれる言語を第2の言語に翻訳してもよい。翻訳ユニット34は、車両14の運転者12が視認している物体の判定された位置に基づいて、取得画像に含まれるパターンの言語を自動的に判定するように構成されてもよい。別の実施形態において、翻訳ユニット34は、その中に何の言語があるのかを判定するために、取得画像に含まれるパターンを処理してもよい。翻訳ユニット34は、取得画像に含まれるパターンを車両14の運転者12の第2の言語に自動的に翻訳するように構成されてもよい。他の実施形態において、車両14の運転者12は、入力デバイス16を使用して、画像のパターンが何の言語であるかをシステム10に入力してもよく、かつ/または車両14の運転者12の第2の言語が何であるかをシステム10に入力してもよい。

【0021】

データベースユニット36は、データを受信、格納、またはシステム10に送信するための1つ以上のデータベースユニットを備える。データベースユニット36は、車両14の運転者12が視認している物体の取得画像を格納するためのデータベースを備えてもよい。データベースユニット36は、取得画像のパターンを判定するために、パターン認識ユニット31を支援するようにパターン認識のためのデータベースを備えてもよい。データベースユニット36は、取得画像のための地点を含む地点データベースを備えてもよい。データベースユニット36は、車両14の運転者12の音声を認識するための音声認識データベースを備えてもよい。

【0022】

音声ユニット38は、テキストを音声に変換するため、または音声をテキストに変換するための1つ以上の音声ユニットを備える。音声ユニット38は、翻訳されたまたは翻訳されていない取得画像のパターンを音声に変換してもよい。また、音声ユニット38は、入力デバイス16を通してシステム10に入力された車両14の運転者12の音声をテキストに変換してもよい。

【0023】

通信デバイス24は、システム10またはプロセッサ22が情報を送信または受信するために、車両14の外部のデバイスと通信するための1つ以上の通信デバイスを備える。通信デバイス24は、インターネット、通信衛星、システム10もしくはプロセッサ22にまたはそれらからの情報を通信、提供、または受信するための外部通信または情報システム、システム10またはプロセッサ22がアクセスするかまたはダウンロードする情報を含む外部データベース、あるいは別の種類の外部デバイス等の、車両14の外にある外部デバイスと通信してもよい。通信デバイス24は、通信目的のあらゆる種類の信号を利用してもよい。

【0024】

出力デバイス26は、車両14の運転者12に情報を出力するための1つ以上の出力デバイスを備える。一実施形態において、出力された情報は、取得画像の翻訳された言語を含む。別の実施形態において、出力された情報は、取得画像に基づいて判定された地点情報を含む。出力デバイス26は、車両14の運転者12に出力された情報を視覚的に表示するための画像表示部を備えてもよい。出力デバイス26は、出力された情報を車両14の運転者12に聴覚的に出力するためのスピーカー等の聴覚デバイスをさらに備えてもよい。

【0025】

ナビゲーションシステム27は、運転者12が車両14を操縦する際に補助するためのナビゲーション情報を車両14の運転者12に提供するための1つ以上のナビゲーションシステムを備える。ナビゲーションシステム27は、プロセッサ22の一部を含んでいてもよく、またはプロセッサ22の外部にあって、プロセッサ22と有線または無線で通信していてもよい。ナビゲーションシステム27は、システム10によって出力された翻訳された第2の言語に基づいて、運転者12がある位置まで車両14を操縦する際に補助してもよい。また、ナビゲーションシステム27は、運転者12がシステム10によって識別された地点まで車両14を操縦する際にも補助してもよい。ナビゲーションシステム27は、システム10のあらゆる構成要素を使用して、車両14の運転者12にビデオまたは聴覚による命令を提供することができる。ナビゲーションシステム27は、車両14の運転者12をある位置まで誘導するためのグローバルポジショニングシステムまたは他の種類のナビゲーションシステムを備えてもよい。

【0026】

図2は、図1のシステム10を利用して車両14を運転している運転者12の一実施形態の側面図を示す。追跡デバイス20は、運転者の視線42において、車両14の外部にあるどの物体40に運転者12が注目しているかを判定するために、運転者の焦点を追跡している。画像取得デバイス18は、車両14の外部の環境44の画像を無差別に取得する(運転者12が注目している物体40を取得することを含む)。システム10は、取得画像を処理しており、取得画像を運転者12が注目している物体40のみに削減している。システム10は、車両14に対してどこに物体40が位置しているかを判定している。システム10は、削減された取得画像内のパターンを認識している。システム10は、(1)認識されたパターンに含まれる言語を第2の言語に翻訳しているか、または(2)認識されたパターンに基づいて地点情報を判定しているかのいずれかである。システム10は、(1)認識されたパターンの翻訳された第2の言語、または(2)認識されたパターンに基づいて判定された地点情報のいずれかを、視覚的にまたは聴覚的に運転者12に出力している。

【0027】

図3は、車両の運転者に情報を提供するための方法50の一実施形態のフローチャートを示す。ステップ52において、画像取得デバイスは、車両の外部の環境の画像を取得する。取得画像は、車両の運転者が視認または注目している物体を含む。この物体は、車両の外部の標識、道路標識、または別の種類の物体を含んでもよい。一実施形態において、ステップ52の間に、画像取得デバイスは、車両の外部の環境の画像を無差別に取得する。

【0028】

ステップ54において、追跡デバイスは、運転者が視認または注目している車両の外部の物体を判定する。別の実施形態において、ステップ54は、ステップ52の前に行われ、画像取得デバイスは、運転者が視認していないかまたは注目していない環境の部分を取得することなく、追跡デバイスから受信されたデータを処理することによって、運転者が視認しているかまたは注目している車両の外部の環境の物体のみの画像を取得する。

【0029】

ステップ56において、少なくとも1つのプロセッサは、取得画像を処理し、(1)運転者が視認している物体の取得画像に含まれる言語を第2の言語に翻訳するか、または(2)運転手が視認している物体の取得画像に基づいて地点情報を判定するか、のうちの少なくとも1つを行う。地点情報は、地点の位置、地点の名称、車両が地点から離れている距離、地点に位置する場所、製品、もしくはサービスの種類、または他の種類の地点情報を含んでいてもよい。ステップ56は、パターン認識ユニットを使用して、車両の運転者が視認している取得画像内の物体を認識することを含んでもよい。ステップ56は、グローバルポジショニングシステムまたは他の種類の位置判定ユニット等の位置判定ユニットを使用して、取得画像内の物体の位置または車両の位置のうちの少なくとも1つを判定することをさらに含んでもよい。一実施形態において、ステップ56の間に、少なくとも1つのプロセッサが、取得画像を運転者が視認または注目している物体のみに絞り込み、取得画像の他の部分を排除する。別の実施形態において、方法がステップ56に達する時には、画像取得デバイスが、追跡デバイスから受信したデータを処理することによって、運転者が視認または注目している車両の外部の環境の物体のみの画像を最初に取得することに起因して、取得画像は、既に運転者が視認または注目している物体のみに絞り込まれている。

【0030】

ステップ58において、出力デバイスは、(1)運転者が視認している物体の取得画像の翻訳された言語を含む第2の言語、または、(2)運転者が視認している物体の取得画像に基づいて判定された地点情報のうちの少なくとも1つを出力する。ステップ58は、出力デバイスによって、画像表示部に情報を出力するか、または聴覚デバイスを使用して情報を出力することを含んでもよい。ステップ60において、ナビゲーションシステムが、車両をナビゲートするために使用される。ステップ60は、ナビゲーションシステムによって、出力された情報に基づいて車両をナビゲートすることを含んでもよい。

【0031】

本開示の1つ以上の実施形態は、運転者が注目している車両の外部の物体に自動的に焦点を合わせ、物体の翻訳された言語、または物体に関する地点情報を運転者に自動的に出力することによって、既存の技術の1つ以上の課題を克服する場合がある。これは、時間および安全性における対応する利点により、結果的に車両の運転をより容易にする場合がある。

【0032】

当然のことながら、上記は、本開示の例示的な実施形態に関するものであって、以下の特許請求の範囲に記載される本開示の主旨および範囲から逸脱することなく変更が行われる場合があることを理解されたい。

【技術分野】

【0001】

本開示は、車両の運転者に、運転者が注目している車両の外部の物体に関する言語翻訳情報または地点情報を提供するためのシステムおよび方法に関する。

【背景技術】

【0002】

車両の運転者は、運転者が追加情報を所望する標識、道路標識、または他の種類の物体等の、車両の外部の物体に注目することが多い。多くの車両は、運転者が視認している物体に関する追加情報を得るための、使用が面倒なナビゲーションシステムを収容している。例えば、車両の運転者は、運転者が追加の地点情報を所望する道路標識に注目し、次いで、運転者が所望する地点情報の種類をナビゲーションシステムに入力しなければならないかもしれない。運転者がこの情報をシステムに入力する時までには、運転者は既に出口を逃してしまっているかもしれない。

【0003】

外国を旅行する場合、運転者が注目している道路標識は、運転者が理解することが不可能な外国語である可能性が多い。このことは、外国での運転を危険なものにする場合がある。言語を翻訳するための既存のシステムの多くは、運転者が注目している物体のみに焦点を合わせるようには適合されていない。その結果、運転者は、運転者が何語に翻訳することを所望するかをシステムに伝えなければならない。これは非効率的であり、安全性に対する懸念となる可能性がある。

【発明の概要】

【発明が解決しようとする課題】

【0004】

既存のシステムおよび方法の1つ以上の課題を解決するために、車両の運転者に情報を提供するためのシステムおよび方法が必要である。

【課題を解決するための手段】

【0005】

一実施形態において、車両の運転者に情報を提供するためのシステムが開示される。システムは、画像取得デバイスと、頭部または視線追跡装置と、少なくとも1つのプロセッサと、出力デバイスとを備える。画像取得デバイスは、車両の外部の環境の画像を取得するためのものである。頭部または視線追跡装置は、車両の運転者が視認している物体を判定するためのものである。少なくとも1つのプロセッサは、取得画像を処理し、(1)運転者が視認している物体の取得画像に含まれる言語を第2の言語に翻訳すること、または、(2)運転者が視認している物体の取得画像に基づいて地点情報を判定することのうちの少なくとも1つを行うためのものである。出力デバイスは、(1)運転者が視認している物体の取得画像の翻訳された言語を含む第2の言語、または(2)運転者が視認している物体の取得画像に基づいて判定された地点情報のうちの少なくとも1つを含む情報を出力するためのものである。

【0006】

別の実施形態において、車両の運転者に情報を提供するための方法が開示される。あるステップにおいて、車両の外部の環境の画像は、画像取得デバイスによって取得される。別のステップにおいて、頭部または視線追跡装置は、車両の運転者が視認している物体を判定するために使用される。さらに別のステップにおいて、少なくとも1つのプロセッサは、取得画像を処理し、(1)運転者が視認している物体の取得画像に含まれる言語を第2の言語に翻訳するか、または(2)運転者が視認している物体の取得画像に基づいて地点情報を判定するかのうちの少なくとも1つを行う。さらなるステップにおいて、出力デバイスは、(1)運転者が視認している物体の取得画像の翻訳された言語を含む第2の言語、または(2)運転者が視認している物体の取得画像に基づいて判定された地点情報うちの少なくとも1つを含む情報を出力する。

【0007】

本開示のこれらおよび他の特徴、態様、および利点は、以下の図面、明細書、および特許請求の範囲を参照して、よりよく理解されるであろう。

【図面の簡単な説明】

【0008】

【図1】車両の運転者に情報を提供するためのシステムのブロック図を示す。

【図2】図1のシステムを利用して車両を運転している運転者の一実施形態の側面図を示す。

【図3】車両の運転者に情報を提供するための方法の一実施形態のフローチャートを示す。

【発明を実施するための形態】

【0009】

以下の詳細な説明は、現在企図される本開示を実行する最良の様式の説明である。本開示の範囲は、添付の特許請求の範囲によって最良に定義されるため、この説明は、限定的な意味に捉えられるべきではなく、本開示の一般的な原則を例示する目的でなされているに過ぎない。図は、純粋に例示目的のためであって、原寸には比例していないことに留意されたい。

【0010】

図1は、車両14の運転者12に情報を提供するためのシステム10のブロック図を示す。システム10は、入力デバイス16と、画像取得デバイス18と、追跡デバイス20と、プロセッサ22と、通信デバイス24と、出力デバイス26と、ナビゲーションシステム27とを備える。システム10は、車両内に実装される。システム10の上記構成要素の全ては、有線または無線で互いに通信している。

【0011】

入力デバイス16は、運転者がシステム10に情報を入力するか、またはシステム10を制御することを可能にする1つ以上の入力デバイスを備える。例示的な入力デバイス16は、運転者がシステム10に情報を入力することを可能にするマイク、コントロールパネル、または他の種類の入力デバイスを備える。運転者12は、システム10に指示を与えるために、マイクに向かってコマンドを話してもよい。運転者12は、システム10に指示を与えるために、コントロールパネルを使用してコマンドをタイプするか、触れるか、または視覚的に入力してもよい。他の実施形態において、運転者12は、多様な方法および入力デバイス16を使用してコマンドを入力してもよい。

【0012】

画像取得デバイス18は、車両14の外部の環境の画像を取得するための1つ以上の画像取得デバイスを備える。取得画像は、車両14の外部の環境にある標識、道路標識、または別の種類の物体を含んでもよい。一実施形態において、画像取得デバイス18は、車両14の外部の環境のどの部分に運転者12が注目しているのかを判定するための追跡デバイス20からの入力なしに、車両14の外部の環境の画像を無差別に取得する。別の実施形態において、画像取得デバイス18は、運転者12が注目していない車両14の外部の環境の部分の画像を取得することなく、追跡デバイス20からの入力に基づいて、運転者12が注目している車両14の外部の環境の部分の正確な画像のみを取得する。取得画像は、車両14の運転者12が注目している車両の外部の環境にある標識、道路標識、または別の種類の物体を含有してもよい。

【0013】

例示的な画像取得デバイス18は、車両14の外部の環境の画像を取得するためのカメラ、ビデオデバイス、または別の種類の画像取得デバイスを備える。前方画像取得デバイス、側方画像取得デバイス、後方画像取得デバイス、または別の種類の画像取得デバイスなどのような画像取得デバイス18は、車両14の外部の環境の所望の画像を取得するために、車両14周辺のどこに位置してもよい。取得画像は、デジタル形式またはアナログ形式であってもよい。取得画像がアナログである場合、画像取得デバイス18またはプロセッサ22は、画像をデジタル画像に変換するためのアナログデジタル変換機をさらに備えてもよい。一実施形態において、画像取得デバイス18は、車両14の外部の環境の画像を連続的に撮影することができる。別の実施形態において、画像取得デバイス18は、車両14の運転者12が入力デバイス16を使用してシステム10にそうするように指示を与えた場合にのみ、車両14の外部の環境の画像を撮影することができる。これは、システム10の処理およびデータ格納を効率的にする。

【0014】

追跡デバイス20は、車両14の外部の環境のどの部分に運転者12が注目しているのかを判定するための1つ以上の追跡デバイスを備える。これは、運転者12が注目している標識、道路標識、または車両14の外部の別の物体を含んでもよい。例示的な追跡デバイス20は、運転者12の目の動きを追跡するための視線追跡装置、運転者12の頭部の動きを追跡するための頭部追跡装置、または車両14の外部の環境のどの部分に運転者12が注目しているのかを追跡するための別の種類の追跡デバイスを備える。例示的な追跡デバイス20は、運転者の目または頭部の画像を撮影するためのカメラ、運転者の目または頭部を追跡するための発光および光検出システム、ならびに赤外線カメラから受信されたデータに基づいて、カメラによって撮影された画像に基づいて、および運転者の目または頭部の座標を判定する際の補助となる位置座標ユニットに基づいて、運転者の目または頭部の位置を処理、判定、保存、および追跡するための追跡アルゴリズムを実装するためのプロセッサを備えてもよい。例示的な追跡デバイス20には、http://www.smarteyecorporation.com(参照により、本明細書に組み込まれる)において参照される、Smarteye Corporationによって作製される全ての追跡デバイスが含まれる。米国特許第6,578,962号および第6,758,563号(参照により、本明細書に組み込まれる)は、システム10によって使用されてもよいさらなる例示的な追跡デバイス20について記載している。さらに、http://en.wikipedia.org/wiki/Eye_trackingに記載されるような他の追跡デバイスも、本システムによって使用されてもよく、また、参照により本明細書に組み込まれる。他の実施形態において、さまざまな追跡デバイス20が、車両14の外部の環境のどの部分に運転者12が注目しているのかを判定するために利用されてもよい。

【0015】

プロセッサ22は、取得画像を処理するための1つ以上のプロセッサを備える。プロセッサ22は、1つ以上のコンピュータを含んでもよい。一実施形態において、プロセッサ22は、運転者12が注目していなかった画像の部分を排除する一方で、無差別に取得された画像を車両14の運転者12が注目していた画像の部分のみに絞り込むために、追跡デバイス20を使用して、画像取得デバイス18によって取得された車両14の外部の環境の無差別に取得された画像を処理する。別の実施形態において、プロセッサ22は、追跡デバイス20から受信されたデータを使用して、車両14の外部の環境のどの部分に運転者12が注目しているのかを処理し、次いで、画像取得デバイス18に、運転者12が注目していない画像内の物体を取得することなく、運転者12が注目している車両14の外部の環境の部分の画像のみを取得するよう指示を与える。一実施形態において、プロセッサ22は、取得画像に含まれる言語を第2の言語に翻訳するように構成される。例えば、プロセッサ22は、車両14の運転者12が視認していた標識、道路標識、または他の物体の取得画像に含まれる言語を第2の言語に翻訳してもよい。別の実施形態において、プロセッサ22は、取得画像に基づいて地点情報を判定するように構成される。例えば、プロセッサ22は、車両14の運転者12が視認していた標識、道路標識、または他の物体の取得画像に基づいて地点情報を判定してもよい。地点情報は、地点の位置、地点の名称、車両14が地点から離れている距離、地点に位置する場所、製品、もしくはサービスの種類、または他の種類の地点情報を含んでもよい。

【0016】

プロセッサ22は、位置判定ユニット28と、処理ユニット30と、パターン認識ユニット32と、翻訳ユニット34と、データベースユニット36と、音声ユニット38とを備える。他の実施形態において、プロセッサ22は、上記ユニットのうちの1つ以上を含まなくてもよいか、またはプロセッサ22は、さらなる種類のユニットを含んでもよい。言及したプロセッサのユニットは、プロセッサ22内に含まれてもよい。他の実施形態において、言及したプロセッサ22のユニットのうちの1つ以上が、プロセッサ22の外部に含まれてもよいが、プロセッサ22と有線または無線で通信している。

【0017】

位置判定ユニット28は、車両14の位置、方向、もしくは速度を判定するため、および/または車両14の運転者12が注目している標識、道路標識、または他の種類の物体等の、取得画像に含まれる運転者12が注目している車両14の外部の物体の位置を判定するための、1つ以上の位置判定ユニットを備える。位置判定ユニット28は、車両14の運転者12が注目している取得画像に含まれる物体に対する車両14の位置を判定する。例示的な位置判定ユニット28は、グローバルポジショニングシステム、方位磁石、速度計、加速度計、ジャイロメーター、あるいは車両14の位置、方向、もしくは速度を判定するため、および/または車両14の運転者12が注目している取得画像に含まれる物体の位置を判定するための別の種類の位置判定ユニットを備える。

【0018】

処理ユニット30は、取得画像を含むシステム10によって収集された情報を処理するための1つ以上の処理ユニットを備える。処理ユニット30は、システム10の算術演算、論理、または入力/出力動作を行うために、プロセッサ22のメモリ内に保存されたプロセッサプログラムの命令を実行する。

【0019】

パターン認識ユニット32は、パターンを認識および判定するための1つ以上のパターン認識ユニットを備える。パターン認識ユニット32は、取得画像内のパターンを認識してもよい。パターン認識ユニット32は、車両14の運転者12が視認している標識、道路標識、または他の種類の物体等の物体を含むパターンを認識してもよい。また、パターン認識ユニット32は、車両14の運転者12が視認している文字、記号、数字、言語、または別の種類のパターンを含むパターンも認識してもよい。

【0020】

翻訳ユニット34は、車両14の運転者12が視認している物体内のパターンを1つの言語から第2の言語に翻訳するための1つ以上の翻訳ユニットを備える。翻訳ユニット34は、車両14の運転者12が視認している物体の取得画像内のパターンを分析することによってこれを行う。例えば、一実施形態において、翻訳ユニット34は、車両14の運転者12が視認している標識、道路標識、または別の物体の取得画像に含まれる言語を第2の言語に翻訳してもよい。翻訳ユニット34は、車両14の運転者12が視認している物体の判定された位置に基づいて、取得画像に含まれるパターンの言語を自動的に判定するように構成されてもよい。別の実施形態において、翻訳ユニット34は、その中に何の言語があるのかを判定するために、取得画像に含まれるパターンを処理してもよい。翻訳ユニット34は、取得画像に含まれるパターンを車両14の運転者12の第2の言語に自動的に翻訳するように構成されてもよい。他の実施形態において、車両14の運転者12は、入力デバイス16を使用して、画像のパターンが何の言語であるかをシステム10に入力してもよく、かつ/または車両14の運転者12の第2の言語が何であるかをシステム10に入力してもよい。

【0021】

データベースユニット36は、データを受信、格納、またはシステム10に送信するための1つ以上のデータベースユニットを備える。データベースユニット36は、車両14の運転者12が視認している物体の取得画像を格納するためのデータベースを備えてもよい。データベースユニット36は、取得画像のパターンを判定するために、パターン認識ユニット31を支援するようにパターン認識のためのデータベースを備えてもよい。データベースユニット36は、取得画像のための地点を含む地点データベースを備えてもよい。データベースユニット36は、車両14の運転者12の音声を認識するための音声認識データベースを備えてもよい。

【0022】

音声ユニット38は、テキストを音声に変換するため、または音声をテキストに変換するための1つ以上の音声ユニットを備える。音声ユニット38は、翻訳されたまたは翻訳されていない取得画像のパターンを音声に変換してもよい。また、音声ユニット38は、入力デバイス16を通してシステム10に入力された車両14の運転者12の音声をテキストに変換してもよい。

【0023】

通信デバイス24は、システム10またはプロセッサ22が情報を送信または受信するために、車両14の外部のデバイスと通信するための1つ以上の通信デバイスを備える。通信デバイス24は、インターネット、通信衛星、システム10もしくはプロセッサ22にまたはそれらからの情報を通信、提供、または受信するための外部通信または情報システム、システム10またはプロセッサ22がアクセスするかまたはダウンロードする情報を含む外部データベース、あるいは別の種類の外部デバイス等の、車両14の外にある外部デバイスと通信してもよい。通信デバイス24は、通信目的のあらゆる種類の信号を利用してもよい。

【0024】

出力デバイス26は、車両14の運転者12に情報を出力するための1つ以上の出力デバイスを備える。一実施形態において、出力された情報は、取得画像の翻訳された言語を含む。別の実施形態において、出力された情報は、取得画像に基づいて判定された地点情報を含む。出力デバイス26は、車両14の運転者12に出力された情報を視覚的に表示するための画像表示部を備えてもよい。出力デバイス26は、出力された情報を車両14の運転者12に聴覚的に出力するためのスピーカー等の聴覚デバイスをさらに備えてもよい。

【0025】

ナビゲーションシステム27は、運転者12が車両14を操縦する際に補助するためのナビゲーション情報を車両14の運転者12に提供するための1つ以上のナビゲーションシステムを備える。ナビゲーションシステム27は、プロセッサ22の一部を含んでいてもよく、またはプロセッサ22の外部にあって、プロセッサ22と有線または無線で通信していてもよい。ナビゲーションシステム27は、システム10によって出力された翻訳された第2の言語に基づいて、運転者12がある位置まで車両14を操縦する際に補助してもよい。また、ナビゲーションシステム27は、運転者12がシステム10によって識別された地点まで車両14を操縦する際にも補助してもよい。ナビゲーションシステム27は、システム10のあらゆる構成要素を使用して、車両14の運転者12にビデオまたは聴覚による命令を提供することができる。ナビゲーションシステム27は、車両14の運転者12をある位置まで誘導するためのグローバルポジショニングシステムまたは他の種類のナビゲーションシステムを備えてもよい。

【0026】

図2は、図1のシステム10を利用して車両14を運転している運転者12の一実施形態の側面図を示す。追跡デバイス20は、運転者の視線42において、車両14の外部にあるどの物体40に運転者12が注目しているかを判定するために、運転者の焦点を追跡している。画像取得デバイス18は、車両14の外部の環境44の画像を無差別に取得する(運転者12が注目している物体40を取得することを含む)。システム10は、取得画像を処理しており、取得画像を運転者12が注目している物体40のみに削減している。システム10は、車両14に対してどこに物体40が位置しているかを判定している。システム10は、削減された取得画像内のパターンを認識している。システム10は、(1)認識されたパターンに含まれる言語を第2の言語に翻訳しているか、または(2)認識されたパターンに基づいて地点情報を判定しているかのいずれかである。システム10は、(1)認識されたパターンの翻訳された第2の言語、または(2)認識されたパターンに基づいて判定された地点情報のいずれかを、視覚的にまたは聴覚的に運転者12に出力している。

【0027】

図3は、車両の運転者に情報を提供するための方法50の一実施形態のフローチャートを示す。ステップ52において、画像取得デバイスは、車両の外部の環境の画像を取得する。取得画像は、車両の運転者が視認または注目している物体を含む。この物体は、車両の外部の標識、道路標識、または別の種類の物体を含んでもよい。一実施形態において、ステップ52の間に、画像取得デバイスは、車両の外部の環境の画像を無差別に取得する。

【0028】

ステップ54において、追跡デバイスは、運転者が視認または注目している車両の外部の物体を判定する。別の実施形態において、ステップ54は、ステップ52の前に行われ、画像取得デバイスは、運転者が視認していないかまたは注目していない環境の部分を取得することなく、追跡デバイスから受信されたデータを処理することによって、運転者が視認しているかまたは注目している車両の外部の環境の物体のみの画像を取得する。

【0029】

ステップ56において、少なくとも1つのプロセッサは、取得画像を処理し、(1)運転者が視認している物体の取得画像に含まれる言語を第2の言語に翻訳するか、または(2)運転手が視認している物体の取得画像に基づいて地点情報を判定するか、のうちの少なくとも1つを行う。地点情報は、地点の位置、地点の名称、車両が地点から離れている距離、地点に位置する場所、製品、もしくはサービスの種類、または他の種類の地点情報を含んでいてもよい。ステップ56は、パターン認識ユニットを使用して、車両の運転者が視認している取得画像内の物体を認識することを含んでもよい。ステップ56は、グローバルポジショニングシステムまたは他の種類の位置判定ユニット等の位置判定ユニットを使用して、取得画像内の物体の位置または車両の位置のうちの少なくとも1つを判定することをさらに含んでもよい。一実施形態において、ステップ56の間に、少なくとも1つのプロセッサが、取得画像を運転者が視認または注目している物体のみに絞り込み、取得画像の他の部分を排除する。別の実施形態において、方法がステップ56に達する時には、画像取得デバイスが、追跡デバイスから受信したデータを処理することによって、運転者が視認または注目している車両の外部の環境の物体のみの画像を最初に取得することに起因して、取得画像は、既に運転者が視認または注目している物体のみに絞り込まれている。

【0030】

ステップ58において、出力デバイスは、(1)運転者が視認している物体の取得画像の翻訳された言語を含む第2の言語、または、(2)運転者が視認している物体の取得画像に基づいて判定された地点情報のうちの少なくとも1つを出力する。ステップ58は、出力デバイスによって、画像表示部に情報を出力するか、または聴覚デバイスを使用して情報を出力することを含んでもよい。ステップ60において、ナビゲーションシステムが、車両をナビゲートするために使用される。ステップ60は、ナビゲーションシステムによって、出力された情報に基づいて車両をナビゲートすることを含んでもよい。

【0031】

本開示の1つ以上の実施形態は、運転者が注目している車両の外部の物体に自動的に焦点を合わせ、物体の翻訳された言語、または物体に関する地点情報を運転者に自動的に出力することによって、既存の技術の1つ以上の課題を克服する場合がある。これは、時間および安全性における対応する利点により、結果的に車両の運転をより容易にする場合がある。

【0032】

当然のことながら、上記は、本開示の例示的な実施形態に関するものであって、以下の特許請求の範囲に記載される本開示の主旨および範囲から逸脱することなく変更が行われる場合があることを理解されたい。

【特許請求の範囲】

【請求項1】

車両の運転者に情報を提供するためのシステムであって、

車両の外部の環境の画像を取得するための画像取得デバイスと、

前記車両の運転者が視認している物体を判定するための頭部または視線追跡装置と、

前記取得画像を処理し、(1)前記運転者が視認している前記物体の前記取得画像に含まれる言語を第2の言語に翻訳すること、または(2)前記運転者が視認している前記物体の前記取得画像に基づいて地点情報を判定することのうちの少なくとも1つを行うための、少なくとも1つのプロセッサと、

(1)前記運転者が視認している前記物体の前記取得画像の前記翻訳された言語を含む前記第2の言語、または(2)前記運転者が視認している前記物体の前記取得画像に基づいて判定された前記地点情報のうちの少なくとも1つを含む情報を出力するための、出力デバイスと、を備えるシステム。

【請求項2】

前記少なくとも1つのプロセッサは、前記取得画像を処理し、かつ前記運転者が視認している前記物体の前記取得画像に含まれる前記言語を前記第2の言語に翻訳するためのものであり、前記出力デバイスは、前記運転者が視認している前記物体の前記取得画像の前記翻訳された言語を含む前記第2の言語を出力するためのものである、請求項1に記載のシステム。

【請求項3】

前記少なくとも1つのプロセッサは、前記取得画像を処理し、かつ前記運転者が視認している前記物体の前記取得画像に基づいて前記地点情報を判定するためのものであり、前記出力デバイスは、前記運転者が視認している前記物体の前記取得画像に基づいて前記判定された地点情報を出力するためのものである、請求項1に記載のシステム。

【請求項4】

前記地点情報は、前記地点の位置、前記地点の名称、前記車両が前記地点から離れている距離、または前記地点に位置する場所、製品、もしくはサービスの種類のうちの少なくとも1つを含む、請求項3に記載のシステム。

【請求項5】

前記物体の位置または前記車両の位置のうちの少なくとも1つを判定するための位置判定ユニットをさらに備える、請求項1に記載のシステム。

【請求項6】

前記位置判定ユニットは、グローバルポジショニングシステムを備える、請求項5に記載のシステム。

【請求項7】

前記車両の前記運転者が視認している前記物体を認識するためのパターン認識ユニットをさらに備える、請求項1に記載のシステム。

【請求項8】

前記出力デバイスは、前記出力された情報を視覚的に表示するための表示部を備える、請求項1に記載のシステム。

【請求項9】

前記出力デバイスは、前記出力された情報を聴覚的に出力するための聴覚デバイスを備える、請求項1に記載のシステム。

【請求項10】

前記運転者が前記車両を操縦する際に補助するためのナビゲーションシステムをさらに備える、請求項1に記載のシステム。

【請求項11】

車両の運転者に情報を提供するための方法であって、

画像取得デバイスを用いて車両の外部の環境の画像を取得するステップと、

頭部または視線追跡装置を用いて前記車両の運転者が視認している物体を判定するステップと、

少なくとも1つのプロセッサを用いて前記取得画像を処理し、(1)前記運転者が視認している前記物体の前記取得画像に含まれる言語を第2の言語に翻訳するステップ、または(2)前記運転者が視認している前記物体の前記取得画像に基づいて地点情報を判定することのうちの少なくとも1つを行うステップと、

出力デバイスを用いて、(1)前記運転者が視認している前記物体の前記取得画像の前記翻訳された言語を含む前記第2の言語、または(2)前記運転者が視認している前記物体の前記取得画像に基づいて前記判定された地点情報のうちの少なくとも1つを含む情報を出力するステップと、を含む方法。

【請求項12】

前記処理するステップは、前記少なくとも1つのプロセッサが、前記取得画像を処理し、前記運転者が視認している前記物体の前記取得画像に含まれる前記言語を前記第2の言語に翻訳することを含み、前記出力するステップは、前記出力デバイスが、前記運転者が視認している前記物体の前記取得画像の前記翻訳された言語を含む前記第2の言語を出力することを含む、請求項11に記載の方法。

【請求項13】

前記処理するステップは、前記少なくとも1つのプロセッサが、前記取得画像を処理し、前記運転者が視認している前記物体の前記取得画像に基づいて前記地点情報を判定することを含み、前記出力するステップは、前記出力デバイスが、前記運転者が視認している前記物体の前記取得画像に基づいて前記判定された地点情報を出力することを含む、請求項11に記載の方法。

【請求項14】

前記地点情報は、前記地点の位置、前記地点の名称、前記車両が前記地点から離れている距離、または前記地点に位置する場所、製品、もしくはサービスの種類のうちの少なくとも1つを含む、請求項13に記載の方法。

【請求項15】

位置判定ユニットを使用して、前記物体の位置または前記車両の位置のうちの少なくとも1つを判定するステップをさらに含む、請求項11に記載の方法。

【請求項16】

前記位置判定ユニットは、グローバルポジショニングシステムを備える、請求項15に記載の方法。

【請求項17】

パターン認識ユニットを使用して、前記車両の前記運転者が視認している前記物体を認識するステップをさらに含む、請求項11に記載の方法。

【請求項18】

前記出力デバイスは、表示部を備え、前記出力するステップは、前記出力された情報を前記表示部上に視覚的に表示することを含む、請求項11に記載の方法。

【請求項19】

前記出力デバイスは、聴覚デバイスを備え、前記出力するステップは、前記聴覚デバイスを使用して、前記出力された情報を聴覚的に出力することを含む、請求項11に記載の方法。

【請求項20】

前記車両をナビゲートするためにナビゲーションシステムを使用するステップをさらに含む、請求項11に記載の方法。

【請求項1】

車両の運転者に情報を提供するためのシステムであって、

車両の外部の環境の画像を取得するための画像取得デバイスと、

前記車両の運転者が視認している物体を判定するための頭部または視線追跡装置と、

前記取得画像を処理し、(1)前記運転者が視認している前記物体の前記取得画像に含まれる言語を第2の言語に翻訳すること、または(2)前記運転者が視認している前記物体の前記取得画像に基づいて地点情報を判定することのうちの少なくとも1つを行うための、少なくとも1つのプロセッサと、

(1)前記運転者が視認している前記物体の前記取得画像の前記翻訳された言語を含む前記第2の言語、または(2)前記運転者が視認している前記物体の前記取得画像に基づいて判定された前記地点情報のうちの少なくとも1つを含む情報を出力するための、出力デバイスと、を備えるシステム。

【請求項2】

前記少なくとも1つのプロセッサは、前記取得画像を処理し、かつ前記運転者が視認している前記物体の前記取得画像に含まれる前記言語を前記第2の言語に翻訳するためのものであり、前記出力デバイスは、前記運転者が視認している前記物体の前記取得画像の前記翻訳された言語を含む前記第2の言語を出力するためのものである、請求項1に記載のシステム。

【請求項3】

前記少なくとも1つのプロセッサは、前記取得画像を処理し、かつ前記運転者が視認している前記物体の前記取得画像に基づいて前記地点情報を判定するためのものであり、前記出力デバイスは、前記運転者が視認している前記物体の前記取得画像に基づいて前記判定された地点情報を出力するためのものである、請求項1に記載のシステム。

【請求項4】

前記地点情報は、前記地点の位置、前記地点の名称、前記車両が前記地点から離れている距離、または前記地点に位置する場所、製品、もしくはサービスの種類のうちの少なくとも1つを含む、請求項3に記載のシステム。

【請求項5】

前記物体の位置または前記車両の位置のうちの少なくとも1つを判定するための位置判定ユニットをさらに備える、請求項1に記載のシステム。

【請求項6】

前記位置判定ユニットは、グローバルポジショニングシステムを備える、請求項5に記載のシステム。

【請求項7】

前記車両の前記運転者が視認している前記物体を認識するためのパターン認識ユニットをさらに備える、請求項1に記載のシステム。

【請求項8】

前記出力デバイスは、前記出力された情報を視覚的に表示するための表示部を備える、請求項1に記載のシステム。

【請求項9】

前記出力デバイスは、前記出力された情報を聴覚的に出力するための聴覚デバイスを備える、請求項1に記載のシステム。

【請求項10】

前記運転者が前記車両を操縦する際に補助するためのナビゲーションシステムをさらに備える、請求項1に記載のシステム。

【請求項11】

車両の運転者に情報を提供するための方法であって、

画像取得デバイスを用いて車両の外部の環境の画像を取得するステップと、

頭部または視線追跡装置を用いて前記車両の運転者が視認している物体を判定するステップと、

少なくとも1つのプロセッサを用いて前記取得画像を処理し、(1)前記運転者が視認している前記物体の前記取得画像に含まれる言語を第2の言語に翻訳するステップ、または(2)前記運転者が視認している前記物体の前記取得画像に基づいて地点情報を判定することのうちの少なくとも1つを行うステップと、

出力デバイスを用いて、(1)前記運転者が視認している前記物体の前記取得画像の前記翻訳された言語を含む前記第2の言語、または(2)前記運転者が視認している前記物体の前記取得画像に基づいて前記判定された地点情報のうちの少なくとも1つを含む情報を出力するステップと、を含む方法。

【請求項12】

前記処理するステップは、前記少なくとも1つのプロセッサが、前記取得画像を処理し、前記運転者が視認している前記物体の前記取得画像に含まれる前記言語を前記第2の言語に翻訳することを含み、前記出力するステップは、前記出力デバイスが、前記運転者が視認している前記物体の前記取得画像の前記翻訳された言語を含む前記第2の言語を出力することを含む、請求項11に記載の方法。

【請求項13】

前記処理するステップは、前記少なくとも1つのプロセッサが、前記取得画像を処理し、前記運転者が視認している前記物体の前記取得画像に基づいて前記地点情報を判定することを含み、前記出力するステップは、前記出力デバイスが、前記運転者が視認している前記物体の前記取得画像に基づいて前記判定された地点情報を出力することを含む、請求項11に記載の方法。

【請求項14】

前記地点情報は、前記地点の位置、前記地点の名称、前記車両が前記地点から離れている距離、または前記地点に位置する場所、製品、もしくはサービスの種類のうちの少なくとも1つを含む、請求項13に記載の方法。

【請求項15】

位置判定ユニットを使用して、前記物体の位置または前記車両の位置のうちの少なくとも1つを判定するステップをさらに含む、請求項11に記載の方法。

【請求項16】

前記位置判定ユニットは、グローバルポジショニングシステムを備える、請求項15に記載の方法。

【請求項17】

パターン認識ユニットを使用して、前記車両の前記運転者が視認している前記物体を認識するステップをさらに含む、請求項11に記載の方法。

【請求項18】

前記出力デバイスは、表示部を備え、前記出力するステップは、前記出力された情報を前記表示部上に視覚的に表示することを含む、請求項11に記載の方法。

【請求項19】

前記出力デバイスは、聴覚デバイスを備え、前記出力するステップは、前記聴覚デバイスを使用して、前記出力された情報を聴覚的に出力することを含む、請求項11に記載の方法。

【請求項20】

前記車両をナビゲートするためにナビゲーションシステムを使用するステップをさらに含む、請求項11に記載の方法。

【図1】

【図2】

【図3】

【図2】

【図3】

【公開番号】特開2013−68620(P2013−68620A)

【公開日】平成25年4月18日(2013.4.18)

【国際特許分類】

【出願番号】特願2012−209532(P2012−209532)

【出願日】平成24年9月24日(2012.9.24)

【出願人】(505450755)ビステオン グローバル テクノロジーズ インコーポレイテッド (140)

【Fターム(参考)】

【公開日】平成25年4月18日(2013.4.18)

【国際特許分類】

【出願日】平成24年9月24日(2012.9.24)

【出願人】(505450755)ビステオン グローバル テクノロジーズ インコーポレイテッド (140)

【Fターム(参考)】

[ Back to top ]