遠隔操作ロボット

【構成】 遠隔操作ロボット(10)は、柔軟素材からなり、人間のミニマルデザインに基づいた外観を有する外被(12)を含む。外被は、胴体部分と、頭部分と、腕部分と、脚部分とを含む。外被内にはロボット機構体(14)が収納され、ロボット機構体と外被との間には詰め物(30)が設けられる。ロボット機構体は、胴体部分などに対応する位置に形成される胴体機構(17)などを含む。外被はさらに、頭部分の前面に形成された口部分および目部分を含み、ロボット機構体の口機構(23)が口部分を動かし、目機構(25)は目部分を動かす。スピーカ(32)からは遠隔操作者の音声が出力される。マイク(34)は対話者の音声を取得する。

【効果】ロボットは人間には見えるけれども、性別や年齢は自由に想像できる人間のミニマルデザインに従った外形を有し、しかもロボットから操作者の声がでるので、対話者は、ロボット自体を操作者と強く実感できる。

【効果】ロボットは人間には見えるけれども、性別や年齢は自由に想像できる人間のミニマルデザインに従った外形を有し、しかもロボットから操作者の声がでるので、対話者は、ロボット自体を操作者と強く実感できる。

【発明の詳細な説明】

【技術分野】

【0001】

この発明は、遠隔操作ロボットに関し、特にたとえば、インタネットなどを利用して遠隔場所に存在する人間と音声をやり取りできる、遠隔操作ロボットに関する。

【背景技術】

【0002】

この種の遠隔操作ロボットの一例として、たとえば、非特許文献1において本件発明者が提案した、「アンドロイド」と称する、外観(姿形)が人間に酷似した遠隔操作ロボットがあり、このアンドロイドは、たとえば特許文献1に示すような遠隔操作によって、人間に類似したしぐさ動作を行うことができる。

【0003】

このような遠隔操作ロボットは、その容姿を写した人間(操作者)の代役として適宜場所に置かれる。その状態で、特許文献1のようなシステムを構成し、遠隔場所に存在する操作者の指示に従って、もしくは遠隔操作者の動作を示す動作データに従って、内蔵しているロボット機構が作動して、遠隔操作者の示す動作(振る舞い)を行う。

【0004】

特許文献1の遠隔操作ロボットでは、その場所に存在しない操作者(人間)があたかもその場所に居るかのような実在感を与えることが発明者の実験で確認されている。つまり、遠隔操作ロボットが人間の外観を持っていることは、ロボットとその周囲の人間との融和または調和を図るうえで、重要な意味を持つことが分かった。

【非特許文献1】Ishiguro, H. and Nishio, S. 'Building artificial humans for understanding humans', Journal of Artificial Organs, vol.10, no.3, pp.133-142, 2007

【特許文献1】特開2008-23604号公報[B25J 13/08,A63H 11/00, 3/33, 3/36, 3/40]

【発明の開示】

【発明が解決しようとする課題】

【0005】

しかし、人間に酷似したアンドロイドを製作するためには、その人間の全身を型取りし、その型を用いて、人間の肌に類似した感触を有する材料、たとえばシリコーン樹脂の外被を形成し、その外被内に、多数の自由度(たとえば46自由度)を有するロボット機構をすべて組み込む必要がある。

【0006】

つまり、従来の人間酷似の遠隔操作ロボット、一例としてアンドロイドでは、製作費用が高価になるばかりでなく、多数の自由度の制御のために機構や操作方法が複雑になってしまう。

【0007】

それゆえに、この発明の主たる目的は、新規な、遠隔操作ロボットを提供することである。

【0008】

この発明の他の目的は、製作費用を安価にできる、遠隔操作ロボットを提供することである。

【0009】

この発明のその他の目的は、操作方法を簡単にできる、遠隔操作ロボットを提供することである。

【課題を解決するための手段】

【0010】

本発明は、上記の課題を解決するために、以下の構成を採用した。なお、括弧内の参照 符号および補足説明等は、本発明の把握を助けるために後述する実施の形態との対応関係を示したものであって、本発明を何ら限定するものではない。

【0011】

第1発明は、柔軟素材からなり、人間の胴体に相当しかつ胴体と見える胴体部分と、胴体部分の上にあって人間の頭に相当しかつ頭と見える頭部分と、胴体部分の両側から延びて人間の腕および手に相当しかつ腕および手と見える腕部分と、胴体部分の下端から下方に延びて人間の脚および足に相当しかつ脚および足と見える脚部分とを含む、外被を備え、外被はさらに、頭部分の前面であって、人間の口に相当しかつ口と見える口部分および口部分の上であって、人間の目に相当しかつ目と見える目部分を含み、外被内に収納され、外被の胴体部分、頭部分、腕部分、脚部分、口部分および目部分に対応する位置に形成される、胴体機構、頭機構、腕機構、脚機構、口機構および目機構を含む、ロボット機構体をさらに備え、口機構は口部分を動かすための口駆動手段を含み、目機構は目部分を動かす目駆動手段を含み、さらにロボット機構体と外被との間に設けられる詰め物、音声データに従って音声を出力する第1スピーカ、および周囲の音声を取得する第1マイクを備える、遠隔操作ロボットである。

【0012】

第1発明において、遠隔操作ロボット(10:実施例において相当する部分を例示する参照符号。以下、同様。)は、たとえばシリコーン樹脂などの柔軟素材で作った外被(12)、このような外被(12)内に収納されるロボット機構体(14)、外被(12)とロボット機構体(14)との間に設けられる詰め物(30)、音声データに従って音声を出力する第1スピーカ(32)および周囲の音声を取得する第1マイク(34)を備える。

【0013】

外被(12)は、人間の胴体に相当しかつ胴体と見える胴体部分(16)と、胴体部分(16)の上にあって人間の頭に相当しかつ頭と見える頭部分(18)と、胴体部分(16)の両側から延びて人間の腕および手に相当しかつ腕および手と見える腕部分(26)と、胴体部分(16)の下端から下方に延びて人間の脚および足に相当しかつ脚および足と見える脚部分(28)と、頭部分(18)の前面であって、人間の口に相当しかつ口と見える口部分(22)および口部分(22)の上であって、人間の目に相当しかつ目と見える目部分(24)を含む。

【0014】

ロボット機構体(14)は、外被(12)の胴体部分(16)、頭部分(18)、腕部分(26)、脚部分(28)、口部分(22)および目部分(24)にそれぞれ対応する位置に形成される、胴体機構(17)、頭機構(19)、腕機構(27)、脚機構(29)、口機構(23)および目機構(25)を含む。そのうち、口機構(23)は口部分(22)を動かすための、たとえばモータ(66)を含む口駆動手段を有し、目機構(25)は目部分(24)を動かす、たとえばモータ(76、76、86)を含む目駆動手段を有する。

【0015】

第1発明によれば、遠隔操作ロボットは、人間のミニマルデザインに基づいた外観形状に形成され、口部分や目部分などに最低限の自由度がある。したがって、この発明の遠隔操作ロボットは、一見して人間と分かり、その上で性別や年齢は自由に想像できるので、その遠隔操作ロボットを通じて操作者と対話する対話者は、遠隔操作ロボットを操作者自身と感じることができる。

【0016】

発明者が非特許文献1で提案した「アンドロイド」(人間酷似ロボット)を用い、たとえば特許文献1に記載の遠隔操作システムを利用した実験では、ロボットが酷似させられた被験者(操作者:本人)にロボットと相手(ロボットの近くに存在して被験者とコミュニケーションする人)とを映し出すモニタを見せながら話をしてもらった。そのとき、本人の唇の動きや頭部の動きを画像処理で解析して、インタネットを通じてロボットに伝えて、ロボットの唇や頭部を本人の動きと連動させた。その様子を本人はモニタで確認することによって、ロボットを自分の身体のように感じるようになる。そして、ロボットが誰か(相手)に触られると、被験者(本人)は自らの身体が触られたような感覚を覚える。発明者はこのような現象をこれまでの遠隔操作ロボットの研究によって確認してきた。

【0017】

非特許文献1の「アンドロイド」は発明者自身を酷似させたものであり、このアンドロイドを通じて、発明者自身も上記の現象を実感したところである。

【0018】

これらの実験を通して発明者は、ロボットの容姿が本人に酷似していなくても、対話や動作によって、その人はロボットを自らの身体と感じるようになることが分かった。つまり、本件発明者は、数多くの実験を経験する中で、遠隔操作ロボットは必ずしも本人に酷似した見掛けを持つ必要がない、という確信を得るに至った。

【0019】

そこで、この発明においては、このようにして発明者が得た知見に基づいて、遠隔操作ロボットに、人間のミニマルデザインに基づく外観を持たせることを発想した。「人間のミニマルデザイン」とは、一見して人と分かるが、子供とも年寄りとも、男とも女とも認識できるような、年齢や性別が、見る人によって、どのようにも解釈できる、という人間の形状をいうものとする。

【0020】

この人間のミニマルデザインを体現したのが、上記の外被の形状である。この発明は、このような独特の外観を持ち、かついくつかの自由度を持つので、対話者は遠隔操作ロボット自体の上に対話相手(操作者)を強く実感できるのである。

【0021】

第2の発明は、第1の発明に従属し、腕機構は、腕部分の先端を変位可能にするための変位部材および変位部材を操作データに従って駆動するための駆動手段を含む、遠隔操作ロボットである。

【0022】

第2の発明では、たとえば実施例でいえば先端プレート(100)が変位部材に相当し、モータ(94)を含む駆動手段で変位部材が駆動される。したがって、遠隔操作ロボットを遠隔操作する操作者は、ロボットを通じて対話している対話者に、腕部分の先端の変化によって意思を通じることができる。

【0023】

第3の発明は、第1または第2の発明に従属し、頭機構は、頭部分を少なくとも1つの自由度で変化させるための駆動手段を含む、遠隔操作ロボットである。

【0024】

第3の発明では、頭機構(19)は、たとえばモータ(56,64)を含む駆動手段によって、少なくとも1つの自由度で、実施例では3つの自由度で、頭部分(18)を変化させる。もし、操作者の状態データに従って頭部分(18)が変位するようにすれば、遠隔操作ロボットに操作者の状態が再現されるので、対話者はロボット上に操作者を一層強く実感することができる。

【0025】

第4の発明は、第1ないし第3のいずれかの発明に従った遠隔操作ロボットと、ネットワークを通して遠隔操作ロボットに繋がってそれを遠隔操作するための遠隔制御装置とを含む、遠隔操作システムであって、遠隔操作装置は、操作者の声を取得する第2マイクと、音声を出力する第2スピーカを含み、第2マイクで取得した操作者の声が第1スピーカで出力され、第1マイクで取得した音声が第2スピーカで出力される、遠隔操作システムである。

【0026】

第4の発明では、第1ないし第3のいずれかの発明に従った遠隔操作ロボット(10)と、ネットワーク(14)を通して遠隔操作ロボット(10)に繋がってそれを遠隔操作するための遠隔制御装置(116)とを含む、遠隔操作システム(110)である。遠隔操作装置(116)は、操作者の声を取得する第2マイク(120)と、音声を出力する第2スピーカ(118)を含む。そして、第2マイク(120)で取得した操作者の声が第1スピーカ(32)で出力され、第1マイク(36)で取得した音声が第2スピーカ(118)で出力される。したがって、操作者、対話者ともに強い臨場感のなかで遠隔操作ロボットを通じて対話することができる。

【0027】

第5の発明は、第4の発明に従属し、遠隔制御装置は操作者の状態を検出する状態検出手段、および操作者の状態を表す状態データをネットワークを介して遠隔操作ロボットに送信する状態データ送信手段を備え、口駆動手段および目駆動手段が状態データに従って駆動される、遠隔操作システムである。

【0028】

第5の発明では、状態検出手段としては、実施例の場合、操作者カメラ(166)や、操作者カメラからの映像信号を処理して操作者の状態を検出するCPU(158)で構成される。CPU(158)は操作者の状態を表す状態データをネットワーク(114)を介して制御装置(112)すなわち遠隔操作ロボット(10)に送信する。口駆動手段および目駆動手段が状態データに従って駆動される結果、遠隔操作ロボット(10)において、そのときの操作者の状態が再現される。そのため、遠隔操作ロボットを通して操作者と対話している対話者は、遠隔操作ロボット上に非常に強く操作者を感得できる。

【発明の効果】

【0029】

本件発明者が非特許文献1などで提案した遠隔操作ロボットは、実在人間そっくりの遠隔操作アンドロイドであったが、数々の実験を重ねた本件発明者は、実在人間にそっくりに作らなくとも、遠隔操作ロボットを人間のミニマルデザインに基づいた外観形状にすれば、遠隔操作ロボットを通じて操作者と対話する対話者は、その遠隔操作ロボットを操作者本人と感じることができることを発見した。この発明はこの発見に基づいてなされたものである。

【0030】

この発明によれば、遠隔操作ロボットは、人間のミニマルデザインに基づいた外観形状に形成され、口または目などに最低限の自由度がある。したがって、この発明の遠隔操作ロボットは、一見して人間と分かり、その上で性別や年齢は自由に想像できるので、その遠隔操作ロボットを通じて操作者と対話する対話者は、遠隔操作ロボットを操作者自身と感じることができる。このような人間のミニマルデザインに基づく外観形状はかなり単純化されている。したがって、操作者を対話者に感じさせるために人間に酷似させていた「アンドロイド」と同様に遠隔操作ロボットを操作者と感じさせることができる反面、「アンドロイド」に比べて製作費用を大幅に低減できる。

【0031】

この発明の上述の目的,その他の目的,特徴および利点は、図面を参照して行う以下の実施例の詳細な説明から一層明らかとなろう。

【図面の簡単な説明】

【0032】

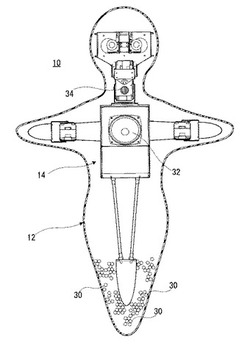

【図1】図1はこの発明の一実施例の遠隔操作ロボットの外観の一例を示す図解図であり、図1(A)は正面図、図1(B)は側面図、図1(C)は平面図である。

【図2】図2は図1実施例の遠隔操作ロボットの体表の凹凸をよく表すコンピュータグラフィックスであり、図2(A)は図1(A)に対応し、図2(B)は図1(B)に対応し、図2(C)は図1(C)に対応している。

【図3】図3は図1実施例の遠隔操作ロボットの構造の一例を示す正面図解図である。

【図4】図4は図1実施例のロボット機構の一例を示す、主として正面側を示す斜視図である。

【図5】図5は図1実施例のロボット機構の一例を示す、主として背面側を示す斜視図である。

【図6】図6は図1実施例のロボット機構の一例を示す平面図解図である。

【図7】図7は図1実施例のロボットを通じて操作者と会話する対話者がロボットを抱き上げている状態の一例を示す図解図である。

【図8】図8は図1実施例のロボットを利用する遠隔操作システムの一例を示す概略ブロック図である。

【図9】図9は図8の制御装置を詳細に示すブロック図である。

【図10】図10は図8の遠隔操作装置を詳細に示すブロック図である。

【図11】図11は図8実施例の遠隔操作システムの動作の一例を示すフロー図である。

【図12】図12はこの発明の他の実施例の遠隔操作ロボットの外観の一例を示す図解図であり、図12(A)は正面図、図12(B)は側面図、図12(C)は平面図である。

【図13】図13は図12実施例の遠隔操作ロボットの構造の一例を示す正面図解図である。

【図14】図14は図12実施例のロボット機構の一例を示す、主として正面側を示す斜視図である。ただし、頭蓋骨相当部分は省略している。

【図15】図15は図12実施例のロボット機構の一例を示す、主として背面側を示す斜視図である。ただし、頭蓋骨相当部分は省略している。

【図16】図16は図12実施例のロボット機構の一例を示す平面図解図である。ただし、頭蓋骨相当部分は省略している。

【図17】図17は図12実施例のロボット機構の一例を示す側面図解図である。ただし、頭蓋骨相当部分は省略している。

【図18】図17は図12実施例のロボット機構の一例を示す側面図解図である。

【図19】図19は図12実施例の制御装置を詳細に示すブロック図である。

【図20】図20は図19の制御装置の動作の一例を示すフロー図である。

【発明を実施するための形態】

【0033】

図1および図2を参照して、この発明の一実施例の遠隔操作ロボット(この明細書では、単に「ロボット」ということがある。)10は、全体としては、人間のミニマルデザイン(minimal design)と呼ぶべき見掛け(外観)を持つ。なお、図1では凹凸が分かりにくく、立体感が十分表現できないので、コンピュータグラフィックス技術で作成した図面を参考的に図2として添付している。図1(A)および図2(A)がともに正面を示し、図1(B)および図2(B)が右側面を示し、図1(C)および図2(C)がともに(C)が平面を示している。

【0034】

発明者が非特許文献1で提案した「アンドロイド」(人間酷似ロボット)を用い、たとえば特許文献1に記載の遠隔操作システムを利用した実験では、ロボットが酷似させられた被験者(操作者:本人)にロボットと相手(ロボットの近くに存在して被験者とコミュニケーションする人)とを映し出すモニタを見せながら話をしてもらった。そのとき、本人の唇の動きや頭部の動きを画像処理で解析して、インタネットを通じてロボットに伝えて、ロボットの唇や頭部を本人の動きと連動させた。その様子を本人はモニタで確認することによって、ロボットを自分の身体のように感じるようになる。そして、ロボットが誰か(相手)に触られると、被験者(本人)は自らの身体が触られたような感覚を覚える。発明者はこのような現象をこれまでの遠隔操作ロボットの研究によって確認してきた。

【0035】

非特許文献1の「アンドロイド」は発明者自身を酷似させたものであり、このアンドロイドを通じて、発明者自身も上記の現象を実感したところである。

【0036】

これらの実験を通して発明者は、ロボットの容姿が本人に酷似していなくても、対話や動作によって、その人はロボットを自らの身体と感じるようになることが分かった。つまり、本件発明者は、数多くの実験を経験する中で、遠隔操作ロボットは必ずしも本人に酷似した見掛けを持つ必要がない、という確信を得るに至った。

【0037】

そこで、この発明においては、このようにして発明者が得た知見に基づいて、遠隔操作ロボット10に上述のように人間のミニマルデザインに基づく外観を持たせることを発想した。「人間のミニマルデザイン」とは、一見して人と分かるが、子供とも年寄りとも、男とも女とも認識できるような、年齢や性別が、見る人によって、どのようにも解釈できる、という人間の形状をいうものとする。

【0038】

このような、人間のミニマルデザインを形作っているロボット10の外観は、人間の皮膚に類似した感触を持つ柔軟体、たとえばシリコーン樹脂、ウレタン(発泡)樹脂などの外被12で形成される。外被12の内部には、図3に示すように、ロボット機構体14が内蔵される。

【0039】

なお、この外被12では、顔を完全に左右対称にすることにより、男性にも女性にも見えるという効果を強く与えることを意図している。また、顔の各パーツの大きさの比率(目、鼻、口の大きさや位置)は、人間の大人と同じ程度の比率にしているが、頭部の大きさに対する身長(等身)は子供のものとすることによって、大人にも子供にも見える効果を強調している。

【0040】

この実施例では、ロボット10の大きさは、対話者(ロボット10を感じさせる操作者と対話する者)がたとえばひざの上に抱き上げることができる程度の大きさにされている。人間の身長に相当する大きさは、一例として80cm程度としている。つまり、少し大きめの人形程度の大きさであるため、対話者が高齢者であっても子供であっても、容易に身近に容易に置きながら、操作者と対話できる。ただし、この数値に限定されるものではなく、抱っこしたり、隣に座らせたりすることよって、ロボット10と対話者とが親密な距離感を持ちながら操作者と対話できるようなサイズであれば或る程度の幅は当然設定できる。

【0041】

外被12は、全体として1枚の外被として形成される。外被12は、人間の胴体に相当して、かつ胴体と見える部分(便宜上、「胴体部分」と呼ぶ。)16と、この胴体部分16の上方に配置され、人間の頭に相当して、かつ頭と見える部分(便宜上、「頭部分」と呼ぶ。)18を含む。頭部分18を形成する外被と胴体部分16を形成する外被とは首部分20の外被によって連続している。

【0042】

頭部分18の前面には、人間の口に相当して、かつ口と見える口部分22が形成される。この口部分22は、外被12に形成した裂け目のようなものであり、後述の口機構によって、開閉され得る。ただし、口部分22において外被12に裂け目を形成する必要は必ずしもない。後述の口機構を内蔵するだけでも、口部分22が動くので、ロボット10を見ている人は、口部分22が動いてロボット10が何かをしゃべっているように見える。

【0043】

さらに、頭部分18の前面であって口部分22の上には、人間の目に相当して、かつ目と見える目部分24が形成される。この目部分24は、外被12に形成した孔から露出するものであり、後述の目機構によって、左右上下に変位される。なお、以下の説明では、目部分24や腕部分26のように左右1対のものは、左右区別なく同じ参照番号を用いて示すが、必要があるときには、区別のための添え字「L」または「R」を用いることがある。

【0044】

胴体部分16の両側には、胴体部分16から連続した外被によって、人間の腕および手に相当して、かつ腕および手と見える部分(便宜上、「腕部分」と呼ぶ。)26が外方に突出するように形成される。この腕部分26は、特に図1(C)からよく分かるように、先端が前方に突出するように全体的に湾曲して形成される。これは、子供が「抱っこ」をせがむときなどの腕の形態を模した形状である。当然ながら、このような湾曲を形成する必要は必ずしもない。

【0045】

胴体部分16の下方には、胴体部分16から連続した外被によって、人間の脚および足に相当して、かつ脚および足と見える部分(便宜上、「脚部分」と呼ぶ。)28が下方に延びて形成される。人間の実際の脚は2本あるのに対して、この脚部分28は、図示からよく分かるように、1つの足部分として形成される。これは、ロボット10を遠隔操作する場面においてはたとえば、ロボット10をあいて対話者(相手)のひざの上に抱いた状態などを想定しているので、足が2本なのか1本しかないのかは機能上重要なことではないとの考えによる。なお、ここで対話者とは、ロボット10が自分の分身であると想定している人(上記の例で言えば、被験者(本人)に相当する。)の遠隔操作を通して、その本人と話をする人のことを指す。たとえば、遠隔地に住む家族の1人が操作者であり、他の1人が対話者の場合などが想定されている。

【0046】

なお、実施例では、腕部分26と脚部分28のそれぞれの先端には手や足に相当する形状(指を含む)のものは設けられておらず、単に先細りの形状にされている。これは、ミニマルデザインの考え方による。つまり、手や足の部分がなくても、少なくとも人間に見えればよく、対話の障害にはならない、と言う考えによる。

【0047】

なお、このような一枚物の外被12を1度の成形工程で作ることはできない。そこで、発明者等は、図1(B)に示すように、前部分12aと後ろ部分12bとを別々の工程で作り、前部分12aの端縁と後ろ部分12bの端縁とをたとえば熱溶着によって接続することを考えた。図1(B)の参照番号「12c」がその継ぎ目を示している。ただし、外被12は、上部分と下部分とを別々に作った後、両者を合体させるようにしてもよい。つまり、外被12の作り方は自由である。

【0048】

このような、人間のミニマルデザインを体現した外形を持つ外被12中に、図2‐図4に示す形状、構造を有するロボット機構体14が収納される。外被12には図示しないが、たとえば胴体部分16の後ろ(背中に相当する)にファスナのような開閉手段を設けておき、ロボット機構体14を収納するときそれを開き、その後閉じるようにすればよい。しかしながら、ファスナのように開閉自在とする必要はなく、工場等での製作過程では外被12の一部を開け、ロボット機構体14を収納後は開けられないように閉じてしまうことも考えられる。使用者が容易に開けられるようになっていると、故障や事故の原因になったりする可能性が考えられるからである。

【0049】

ロボット機構体14の詳細は後述するが、図3に示すように、ロボット機構体14のサイズは外被12のサイズよりかなり小さい。したがって、外被12とロボット機構体14との間には介在する何かが必要である。この実施例では、そのような介在物(詰め物)30として、たとえば発泡スチロールまたは発泡ウレタンのような樹脂から作った小径のビーズを用いる。ただし、樹脂ビーズより大きいサイズのたとえば立方体や球形の柔軟素材、たとえば発泡樹脂(たとえばウレタン)を、詰め物30として外被12とロボット機構体14との間に充填するようにしてもよい。

【0050】

詰め物30を用いる理由は、詰め物30がなければ外被12がたるみ、外被12の独特の形状を保持できないため、詰め物30によって外被12に適度な張りを持たせる必要があるからである。他方、この詰め物30をビーズや柔軟素材のものを用いる理由は、詰め物30によって、ロボット機構体14の可動部、たとえば頭機構、口機構、目機構さらには腕機構などの動き(変位)が阻害されないようにするためである。つまり、詰め物30が軟らかいか、変形容易な集合体(ビーズ)である場合には、可動部が動くときの力によって詰め物30が容易に変形できる。

【0051】

しかしながら、図示しないが、外被12を肉厚に形成してロボット機構体14と間に隙間が出ないようにすることも可能である。この場合には、重くなる可能性があるので、軽量化の工夫が必要であろう。

【0052】

なお、図3に示すように、ロボット機構体14の前面には、このロボット10の発話音声を出力するためのスピーカ32や、このロボット10を通じて操作者と会話する対話者の声を拾うためのマイク34が設けられる。実施例では、スピーカ32は胴体部分16の位置に、マイク34は口部分22の位置にそれぞれ設けられるが、それらの位置はこの位置に限定されるものではない。

【0053】

さらに、ロボット機構体14は、図3に示しかつ後に詳細に説明するすように、外被12の胴体部分16、頭部分18、口部分22、目部分24、腕部分26および脚部分28にそれぞれ位置が対応する、胴体機構17、頭機構19、口機構23、目機構25、腕機構27および脚機構29を含む。

【0054】

図2‐図4を参照して、ロボット機構体14は、外被12の胴体部分16に相当する位置に配置されるべき胴体ボックス36を含む。この胴体ボックス36が胴体機構17を形成する。胴体ボックス36は、実施例ではたとえばアルミニウムの薄板をねじによって組み立てたもので、その中に、ロボット機構体14の一部のモータや制御用の電気回路部品などを収納する。或る程度の強度を持たせるためや、電気回路部品をできるだけ周囲の電気ノイズの影響から保護するためにアルミニウムのような金属で胴体ボックス36を形成したが、材料はこれに限定されるものではない。胴体ボックス36は側面5角形であり、前面は山折れ線を挟んで上下のプレートに分離される。前面の上部プレートには第1スピーカ32(図3)を取り付けるための開口38が形成される。

【0055】

胴体ボックス36の天井プレート40の上には、円形の軸受けプレート42がねじなどによって固着される。個々に言及はしないが、この軸受けプレート42より上の位置に設けられる部品が頭機構19を構成することを予め指摘しておく。

【0056】

軸受けプレート42の上には回転プレート44が積層され、回転プレート44のほぼ中央には、天井プレート40を貫通し、軸受けプレート42に設けた軸受け(図示せず)によって支承されたモータ軸46が固着される。したがって、モータ軸46が天井プレート40の真下に設けられているモータ(図示せず:図4のボックス36の中)によって回転されると、それに固着された回転プレート44が、モータ軸46を中心として水平方向(左右方向)に回転される。

【0057】

回転プレート44のモータ軸46周りの回転によって、ロボット10の頭部分18が図1(C)に示す矢印A方向に回転(または回動)する。頭部分18の矢印A方向での回転によって、ロボット10が頭部分18を横に振る動作を表現でき、たとえば否定(“NO”)や嫌がっていることを対話者に伝えることができる。

【0058】

回転プレート44の上面には正面形状がU字形状でかつ側面形状が3角形のアングル50が回転プレート44と一体的に固定され、アングル50の頂角部分において、回転軸52が左右の立ち上がり板に差し渡されて、それぞれに設けた軸受け(図示せず)によって支承される。アングル50の左右の立ち上がり板に挟まれて、平面矩形でかつ各辺に立上がり板が形成されている支持ボックス54が配置される。支持軸52は、両端部において、支持ボックス54の左右辺の立ち上がり板に固着される。回転軸52は、図示しない連結機構、たとえば歯車を介して、支持ボックス54の中に設置されたモータ56のモータ軸に連結される。したがって、このモータ56が回転されると、モータ軸(図示せず)が回転し、このモータ軸から動力を受ける回転軸52が回転され、回転軸52に一体的に固定されている支持ボックス54が回転軸52周りに回転する。

【0059】

支持ボックス54の回転軸52周りの回転によって、ロボット10の頭部分18が図1(B)に示す矢印B方向(前後)に傾動する。頭部分18の矢印B方向での傾動によって、ロボット10が頭部分18を縦に振る動作を表現でき、たとえば肯定(“YES”)やあいづちなどを対話者に伝えることができる。

【0060】

なお、支持ボックス54の前辺の立ち上がり板に、図3に示す第1マイク34を装着するための開口58が形成される。

【0061】

特に図5からよく分かるように、支持ボックス54の上部において、前後辺の立ち上がり板に軸受け(図示せず)によってモータ軸60が軸支され、モータ軸60には、平面矩形でかつ各辺から垂下する立ち上がり(実際には、立ち下り)板が形成されている支持ボックス62の、前後辺の立ち上がり板の下部が固着される。したがって、モータ64が回転されると、支持ボックス62がモータ軸60と一体的に回転する。

【0062】

支持ボックス62のモータ軸60周りの回転によって、ロボット10の頭部分18が図1(A)に示す矢印C方向(左右)に傾動する。頭部分18の矢印C方向での傾動によって、ロボット10が頭部分18によって「首を傾げる」動作を表現でき、たとえば疑問があることや甘えたい感じなどを対話者に伝えることができる。

【0063】

このようにしてロボット機構体14の頭機構19が形成されるが、頭機構19は上述のように3つの自由度を有し、各自由度における変化量を制御するためのモータ(図示せず:図4のボックス36の中)およびモータ56ならびに64が、頭機構19の駆動手段の一例である。

【0064】

ただし、頭機構19が必ず3つの自由度を持たなくてはならないものではなく、自由度を全てなくして頭機構19すなわち頭部分18が動かないようにしてもよい。あるいは、頭機構19にモータ(図示せず:図4のボックス36の中)とそれによって駆動される機構だけを設けて横首振り(図1の矢印A)だけができるようにしてもよく、頭機構19にモータ58とそれによって駆動される機構だけを設けて縦首振り(図1の矢印B)だけができるようにしてもよく、頭機構19にモータ64とそれによって駆動される機構だけを設けて首傾げ(図1の矢印C)だけができるようにしてもよい。あるいは、これら3つの自由度の任意の2つの組み合わせを設定することもできる。

【0065】

さらに、各自由度(矢印A、BまたはC)においては、基本的には、変化量を連続的に制御できるように設計するが、段階的にしか変化しないような制御を採用することもできる。段階的変化の極端な例が2段階変化であり、たとえば、矢印A方向の横首振りであれば、右‐正面‐左だけの変化が想定でき、矢印B方向の縦首振りであれば、上‐正面‐下だけの変化が想定でき、矢印C方向の首傾げでは、右‐正面‐左だけの変化が想定できる。

【0066】

支持ボックス62の前面の立ち上がり板には図4に示すように、口機構23を作動させるためのモータ66が取り付けられ、それのモータ軸68にU字形状のアングル70の左右片が固着される。したがって、モータ66が回転されると、モータ軸68によって、アングル70がモータ軸68周りに回動する。

【0067】

アングル70のモータ軸68周りの回転によって、ロボット10の口部分22が図1(A)に示す矢印D方向(上下)に開閉される。つまり、アングル70は、口部分22において、下口蓋に相当する動きをするものであり、したがって、アングル70が矢印D方向において下方に動くと、口部分22では下唇が押し下げられて、口部分22が開く。アングル70が矢印D方向において上方に動くと、下唇が元に戻って、口部分22が閉じる。このような口部分22の開閉動作、つまりアングル70の上下動動作をスピーカ32(図3)からの音声と同期させることによって、ロボット10を通じて操作者と会話している対話者は、ごく自然に、操作者の声をロボット10から聴取することができる。したがって、対話者はロボット10に強く操作者を感じることができる。なお、一例として、特開2008‐26485号公報に開示されるように、発話を遅延させる一方で音響特徴に基づいて口形状を推定する(第2コンピュータ126によって)ことで、口部分22の動作と発話とを同期させることができる。

【0068】

また、口機構23では、基本的には、口の開度を連続的に制御できるように設計するが、段階的にしか開度を変えないという制御も考えられる。段階的変化の極端な例が2段階変化であり、口を開けるか閉じるかだけである。

【0069】

このようにモータ66およびアングル70が口機構23の主要構成部品であり、特にモータ66は口機構の動きをするもので、口機構の駆動手段の一例である。

【0070】

口機構23の上方に、図1に示す目部分24を構成する目機構25が設けられる。目部分24と同じように、目機構についても左右区別なく説明する。目部分24の左右の眼球72を支持する支持プレート74が設けられる。眼球72はこの実施例では半球形であり、その前面に図1のような黒目が描かれている。支持プレート74の裏面に、モータ76が、各モータ76のモータ軸78が上に向くように、固着される。モータ軸78の先端にはギア80が固着される。このギア80に噛み合うギア82が、ギア80の前方に設けられる。ギア82は、垂直方向下方に延びる回転軸84(図6)に、回転軸84の後ろ側で固着される。回転軸84の前側は眼球72の中心に固着されている。モータ76が回転されてモータ軸78が回転すると、2つのギア80および82の連係によって、回転軸84が回転し、回転軸84に中心が接続されている眼球72は、ギア82の回転方向とは反対方向に回転する。

【0071】

ギア80のモータ軸78周りの回転に応じて、眼球72が回転すると、ロボット10の目部分24が図1(A)に示す矢印E方向(左右)に変位する。つまり、眼球72の黒目が左右に動く。このような目部分24の動きを対話している操作者の目の動きに連動させれば、対話者は、ごく自然に、操作者の表情をロボット10から聴取することができる。したがって、対話者はロボット10にさらに強く操作者を感じることができる。

【0072】

さらに、図6に示すように、2つのモータ76の間においてモータ86が頭部分を形成する取り付けプレート88に固着され、そのモータ86のモータ軸90は水平方向に延び、上記2つのモータ76の一方(図6では左)のモータハウジングの側面に連結される。したがって、モータ86が回転されて、モータ軸90が回転すると、モータ76がハウジングの側面の1点を中心に回動する。モータ76は上述のように支持プレート74に直接固定されている。そのため、モータ76がそのような態様で回動すると、支持プレート74が上下方向に傾動する。

【0073】

モータ86のモータ軸90周りの支持プレート74の回動に応じて、左右の眼球72が一緒に上下方向に変位する。つまり、眼球72の黒目が上下に動く。このような目部分24の動きを対話している操作者の目の動きと連動させれば、対話者は、ごく自然に、操作者の表情をロボット10から聴取することができる。したがって、対話者はロボット10にさらに一層強く操作者を感じることができる。

【0074】

ここまでで目機構25について説明したが、目機構25は上下左右に変位可能にも受けられた眼球72と、その眼球72を上下左右に動かすモータ76および86が眼球駆動手段の一例である。

【0075】

ただし、目機構25が必ず2つの自由度を持たなくてはならないものではなく、自由度を全てなくして目機構25すなわち目部分24が動かないようにしてもよい。あるいは、目機構25にモータ76とそれによって駆動される機構だけを設けて眼球72を左右方向(図1の矢印E)にだけ動くようにしてもよく、目機構25にモータ86とそれによって駆動される機構だけを設けて眼球72を上下方向(図1の矢印F)にだけ動くようにしてもよい。

【0076】

さらに、目機構25では、自由度(矢印EまたはF)においては、基本的には、変化量を連続的に制御できるように設計するが、段階的にしか変化しないような制御も考えられる。段階的変化の極端な例が2段階変化であり、たとえば、矢印E方向であれば、右‐正面‐左だけの変化が、矢印F方向であれば、上‐正面‐下だけの変化が想定できる。

【0077】

胴体ボックス36の裏面には、たとえばFRP(fiberglass reinforced plastics:ガラス繊維強化プラスチック)の水平プレート92が取り付けられる。この水平プレート92は水平方向に延び、図1のロボット10における腕部分26のための腕機構27(図3)の構成部品である。水平プレート92の先端(両端)前面にはモータ94が、モータ軸96が上に向くように、固着される。モータ軸96の先端は口機構のアングル70と同様の形状のアングル98が固着され、アングル98の垂直面には、たとえば水平プレート92と同じ材料の、先端部材としての先端プレート100が固着される。したがって、モータ94が回転されると、モータ軸96周りにアングル98すなわち先端プレート100が前後方向に回動する。つまり、先端部材としての先端プレート100が水平プレート92の両端に前後に変位可能に設けられ、モータ94がその先端プレート100を前後に動かす駆動手段を構成する。

【0078】

先端プレート100のモータ軸96周りの回転によって、ロボット10の腕部分26が図1(C)に示す矢印G方向(前後)に変位する。腕頭部分26の矢印G方向の動きによって、ロボット10は、たとえば「抱っこ」(ハグ)をして欲しいときに子供が手を前に出すしぐさなどを表現でき、たとえば操作者が甘えたい感情を対話者に伝えることができる。

【0079】

このように、腕機構27は、水平プレート92およびこの水平プレート92の先端に前後に変位可能に設けられる先端プレート100などで構成され、モータ94が先端部材の変位駆動手段の一例となる。

【0080】

なお、腕機構27の先端部材の一例である先端プレート100の平面形状は、ロボット10の腕部分26の先端が先細りに形成されているために、それに合うように、略3角形状にされている。ただし、この先端部材は先端プレート100のような平板形状に限られるものではなく、この先端部材はそれが前後に変位することによって外被12の腕部分26の先端を前後に動かすためのものであるので、その機能がはっきできるのであれば、棒形状などのものであってもよい。

【0081】

また、実施例の腕機構27では、図1(C)に示す腕部分26の湾曲形状を表現するために、先端プレート100の先端が前方に突出するように、先端プレート100を、水平プレート92に対して鈍角に傾斜した位置が初期位置(ホーム位置)となるように、アングル98すなわちモータ軸96に取り付けられる。しかしながら、水平プレート92と整列する(面一になる)初期位置を設定しておき、動作指令が与えられると、先端が前方に向くように設計することも可能である。

【0082】

また、腕機構27では、基本的には、先端プレート100の曲げ角度を連続的に制御できるように設計するが、段階的にしか変化しないという制御も考えられる。段階的変化の極端な例が2段階変化であり、先端を前に出すか出さないかである。

【0083】

胴体ボックス36の下面に、2本の金属蛇腹管102が、下方に向かうにつれて互いの間隔が狭くなるように、下方に延びて取り付けられる。金属蛇腹管102の先端には、たとえばアルミニウムの薄板からなり、かつ略3角形状の先端プレート104が、3角形の頂角に相当する側が下になるように、取り付けられる。金属蛇腹管102および先端プレート104が、ロボット10の脚部分28のための脚機構29を構成する。

【0084】

脚機構29に金属蛇腹管102を用いているため、ロボット10の脚部分28(図1)を容易に屈曲させることができる。そのため、対話者は、ロボット10を抱っこしたり、隣に座らせたりすることよって、対話者と親密な距離感を持ちながら、操作者と話をすることができる。これにより,対話者は操作者の存在を、ロボット10を通してより強く感じることができる。一例として、ロボット10を通じて操作者と対話する対話者108は、図7に示すように、脚部分28を幾分曲げて、ロボット10を自分のひざの上に抱いてもよい。ただし、ロボット10を対話者の身近に置く態様は、図7のようニ対話者のひざの上に置く態様に限られるものではない。

【0085】

なお、後述の制御装置112(図8)とロボット10の電気回路とを有線で接続する場合には、胴体ボックス36の下面から突出して形成されている有線接続ポート106を用い、その接続線(コード)は外被12に適宜の孔を形成しておき、その孔から外被12の外へだせばよい。

【0086】

図8を参照して、この実施例の遠隔操作システム(以下、単に「システム」ということがある。)110は、ロボット10を含む。ロボット10は先に説明したように、人間のミニマルデザインに基づく外観形状を持ち、腕部分26などのような必要最低限の自由度を備えるロボットである。ロボット10は、遠隔場所で検知した操作者の音声や状態のデータ(音声データ、状態データ)に基づいて、操作者の音声、状態を主としてロボット機構体14の動作によって再現する。そのために、ロボット機構体14に設けられた横首振り用のモータ(図示せず:図4のボックス36の中)、縦首振り用のモータ56、首傾げ用のモータ64、口開閉用のモータ66、目左右変位用のモータ(2つ)76、目上下変位用のモータ86、および腕先端前後変位用のモータ94をそれぞれ制御するための制御装置112が設けられる。この制御装置112は典型的にはパソコンで構成する。

【0087】

なお、制御装置112とロボット10の各モータなどを有線で接続する場合には、図4などに示す有線接続ポート106を用いることは前述のとおりである。無線通信手段で結合されてもよい。さらに、このような制御装置112をロボット10の外被12に内蔵し、あるいは外被12の表面に装着することも考えられる。特に、高齢者がロボット10を日常的に使う場合には、ロボット10と制御装置112とを一体化するほうが好都合である。

【0088】

制御装置112は、インタネットや電話通信回線のようなネットワーク114を介して遠隔操作装置116に接続される。遠隔操作装置116も、パソコンのような汎用のコンピュータであってよい。遠隔操作装置116には、第2スピーカ118、第2マイク120およびモニタ122が接続される。図示は省略するが、当然のことながら、遠隔操作装置116には、キーボードおよびコンピュータマウスのような入力装置が含まれる。

【0089】

図9は図8の制御装置112を詳しく示すブロック図である。この図9を参照して、制御装置112は、第1コンピュータ124および第2コンピュータ126によって構成される。たとえば、第1コンピュータ124がメインのコンピュータであり、第2コンピュータ126がサブのコンピュータである。ただし、処理能力が高ければ、1台のコンピュータで構成することもできる。

【0090】

第1コンピュータ124は、CPU128を含み、CPU128には内部バスを介してメモリ130、通信ボード132、LANボード134およびカメラボード136が接続される。メモリ130は、たとえば、ハードディスク装置(HDD)のような主記憶装置、ROMおよびRAMを含む。

【0091】

カメラボード136は、全方位カメラ138、PTZカメラ140およびロボットカメラ142からのカメラ信号をA/D変換してカメラ信号データとしてCPU128に与え、制御データを主としてPTZカメラ140にパン、チルト、ズームなどの制御データを出力するためのインターフェイスである。

【0092】

全方位カメラ138は、ロボット10すなわち対話者108が存在する部屋ないし場所(区画)に設置され、当該部屋ないし場所の全体(360度)を撮影することができる。全方位カメラ138のカメラ映像に対応する映像データがCPU128に与えられる。CPU128は、映像データに基づいてその場所の状況の変化を検出するのみならず、その画像データを遠隔操作装置116に送信する。遠隔操作装置116は、受信した映像データをモニタ122に出力する。したがって、全方位カメラ138からの映像が、モニタ122に表示され、そのモニタ122を通して操作者は対話者の存在する部屋ないし場所の様子を知ることができる。

【0093】

PTZカメラ140は、操作者の指示に従って、パン(Pan)、チルト(Tilt)およびズーム(Zoom)の各々を制御(調整)することができるカメラである。たとえば、遠隔操作者が、パン、チルト、ズームの指示を入力すると、対応する制御信号(コマンド)が遠隔操作装置116からネットワーク114を介して第1コンピュータ124に与えられる。すると、第1コンピュータ124のCPU128は、そのコマンドに従ってPTZカメラ140を駆動制御する。PTZカメラ140の撮影映像に対応する映像データもまた、CPU128に与えられる。CPU128は、映像データに基づいて対話者108などの状況の変化を検出するのみならず、その映像データを遠隔操作装置116に送信する。遠隔操作装置116は、受信した映像データをモニタ122に出力する。したがって、PTZカメラ140の映像もモニタ122に表示される。モニタ122を通して操作者は対話者108の様子を知ることができる。

【0094】

上では説明しなかったが、ロボット10の外被12の頭部分18(人間でいえば額に相当する位置)に内蔵されて外被12の外を撮影できるロボットカメラ142を設けるようにしてもよい。ロボットカメラ142は、たとえばイメージセンサであり、ロボット10の視覚の一部を構成する。つまり、ロボットカメラ142は、ロボット10から見た映像を検出するために用いられる。この実施例では、ロボットカメラ142の映像(動画ないし静止画)に対応するデータ(映像データ)は、カメラボード136を介してCPU128に与えられる。CPU128は、映像データに基づいて、撮影映像の変化を検出するのみならず、その映像データを、ネットワーク114を介して遠隔操作装置116に送信する。そして、遠隔操作装置116は、受信した映像像データを再生してモニタ122に映像を出力する。したがって、ロボットカメラ144の撮影映像がモニタ122に表示され、モニタ122を通して操作者はロボットカメラ142が取得した対話者108などの様子を知ることができる。

【0095】

通信ボード132は、他のコンピュータ(この実施例では、第2コンピュータ126)とデータ通信するためのインターフェイスである。たとえば、通信ボード132は、後述する第2コンピュータ126の通信ボード148と、RS232Cのようなケーブル(図示せず)を用いて接続される。LANボード134は、ネットワーク114を介して他のコンピュータ(この実施例では、遠隔操作装置116)とデータ通信するためのインターフェイスである。この実施例では、LANボード134は、LANケーブル(図示せず)または無線LANでネットワーク114と接続される。

【0096】

第2コンピュータ126は、CPU144を含み、CPU144には内部バスを介してメモリ146、通信ボード148、モータ制御ボード150、音声ボード152およびセンサボード154が接続される。メモリ144は、たとえば、ハードディスク装置(HDD)のような主記憶装置、ROMおよびRAMを含む。詳細な説明は省略するが、このメモリ146には、遠隔操作装置116から伝えられる、操作者の状態を表す状態データをロボット10の動作として再現するための変換テーブル(図示せず)などが設定されているものとする。つまり、状態データが示す操作者の状態を再生するためには、モータ(図示せず:図4のボックス36の中)およびモータ56、64、66、76、86および94をどの程度どの方向に回転または回動すればよいかモータ制御データに変換するためのテーブルである。

【0097】

ロボット10は前述のように、頭部分に3自由度、口部分に1自由度、目部分に3自由度、左右の腕部分にそれぞれ1自由度、計9自由度が設定されていて、それら9自由度のそれぞれを制御するための9つのモータ(図示せず:図4のボックス36の中)およびモータ56、64、66、76(2つ)、86および94(2つ)と、スピーカ32およびマイク34を含む。モータ(図示せず:図4のボックス36の中)およびモータ56、64、66、76(2つ)、86および94(2つ)は、制御装置112に設けられたモータ制御ボード150に接続される。したがって、CPU144からのモータ制御データに従って、モータ制御ボード150がモータ(図示せず:図4のボックス36の中)およびモータ56、64、66、76(2つ)、86および94(2つ)の回転方向および回転量を制御する。

【0098】

また、ロボット10は前述のようにスピーカ32およびマイク34を含む。CPU144から出力された音声データ(典型的には、遠隔地の操作者の音声)は音声ボード152によってD/A変換されてスピーカ32に与えられる。したがって、スピーカ32は、操作者の音声を出力する。マイク34によって取り込まれた対話者108(図7)の音声は、音声ボード152によってD/A変換されてCPU144に与えられる。

【0099】

ロボット10は、また、外被12の表面の適宜数の場所に装着された1つまたは複数の触覚センサ156を含む。触覚センサないし皮膚センサ156は、たとえばタッチセンサであり、ロボット10の触覚の一部を構成する。つまり、触覚センサ156は、人間や他の物体等がロボット10に触れたか否かを検出するために用いられる。この触覚センサ156からのセンサ信号がセンサボード154を介してCPU144に入力される。したがって、CPU144は、人間や他の物体等がロボット10に触れたことを検出することができる。

【0100】

ただし、触覚センサ156としては、圧力センサを用いることもできる。この場合には、人間や他の物体等がロボット10の肌に触れたか否かのみならず、その触れ方(強弱)を知ることができる。

【0101】

図10に示す遠隔制御装置116も同様にパソコンのようなコンピュータで形成される。遠隔制御装置116はCPU158を含み、CPU158には内部バスを介してメモリ160、LANボード162およびカメラボード164が接続される。メモリ160は、たとえば、ハードディスク装置(HDD)のような主記憶装置、ROMおよびRAMを含む。カメラボード164には操作者カメラ166が接続される。操作者カメラ166は、ロボット10を通して対話者108(図7)と対話する操作者の状態を撮影するもので、それのカメラ信号はカメラボード164を介して、映像データとして、CPU158に入力される。

【0102】

CPU158は、映像データに基づいて、操作者の状態を示す状態データを生成する。詳しくいうと、遠隔操作装置116のCPU158は、操作者カメラ166からの映像データを処理して、まず、たとえば映像中の肌色領域を検出するなどして、操作者の頭部分を検出する。その頭部分の状態が前回検出したものとどのように変化しているかを示す差分データを計算して、その差分データをネットワーク114を通して制御装置112に送信する。たとえば、操作者の頭部分の状態を、図1に示す矢印A、BおよびC方向における変位量の差分データとして検出する。

【0103】

制御装置112のLANボード134からこの差分データが入力され、CPU128および通信ボード132および148を介して、第2コンピュータ126のCPU144に伝えられる。CPU144は、メモリ146に予め設定している前述のような変換テーブル(図示せず)を参照して、頭部分18を図1に示す矢印A、BおよびC方向のそれぞれにおいて、どの方向にどれだけ変位させればよいかを計算し、モータ(図示せず:図4のボックス36の中)およびモータ56ならびに64のモータ制御データを決定し、それをモータ制御ボード150に出力する。そのモータ制御データが示す回転方向および回転量に従ってモータ(図示せず:図4のボックス36の中)およびモータ56ならびに64が制御される。したがって、操作者カメラ166が捉えた操作者の頭部分の状態が、ロボット10の頭部分18によって再現または再生される。つまり、そのときのロボット10の頭部分18の状態は、操作者の頭部分の状態に追従したものとして再現される。したがって、対話者108は、そのような頭部分18の変位を見て、ロボット10上において、操作者の状態を容易に読取ることができる。

【0104】

口部分22についても同様に、遠隔操作装置116のCPU158が操作者の頭部分(肌色部分)中にある、口部分を検出する。そして、口部分の状態が前回検出したものとどのように変化しているかを示す差分データを計算して、その差分データをネットワーク114を通して制御装置112に送信する。たとえば、操作者の口部分の状態を、図1に示す矢印D方向における変位量の差分データとして検出する。

【0105】

制御装置112のLANボード134からこの差分データが入力され、CPU128および通信ボード132および148を介して、第2コンピュータ126のCPU144に伝えられる。CPU144は、メモリ146に予め設定している前述のような変換テーブル(図示せず)を参照して、口部分22を図1に示す矢印D方向において、どの方向にどれだけ変位させればよいかを計算し、モータ66のモータ制御データを決定し、それをモータ制御ボード150に出力する。そのモータ制御データが示す回転方向および回転量に従ってモータ66が制御される。したがって、操作者カメラ166が捉えた操作者の口部分の状態が、ロボット10の口部分22によって再現または再生される。つまり、そのときのロボット10の口部分22の状態は、操作者の口部分の状態を追従したものとして再現される。したがって、対話者108は、そのような口部分22の動きを見て、操作者が対話者に向けて発話していることを容易に認識することができる。

【0106】

目部分も同様である。遠隔操作装置116のCPU158が操作者の頭部分(肌色部分)中にある、目部分を検出する。その目部分の状態が前回検出したものとどのように変化しているかを示す差分データを計算して、その差分データをネットワーク114を通して制御装置112に送信する。たとえば、操作者の目部分の状態を、図1に示す矢印EおよびF方向における変位量の差分データとして検出する。

【0107】

制御装置112のLANボード134からこの差分データが入力され、CPU128および通信ボード132および148を介して、第2コンピュータ126のCPU144に伝えられる。CPU144は、メモリ146に予め設定している前述のような変換テーブルを参照して、目部分24を図1に示す矢印EおよびF方向のそれぞれにおいて、どの方向にどれだけ変位させればよいかを計算し、モータ76(2つ)および86のモータ制御データを決定し、それをモータ制御ボード150に出力する。そのモータ制御データが示す回転方向および回転量に従ってモータ76(2つ)および86が制御される。したがって、操作者カメラ166が捉えた操作者の目部分の状態が、ロボット10の目部分24によって再現または再生される。つまり、そのときのロボット10の目部分24の状態は、操作者の目部分の状態に追従したものとして再現される。したがって、対話者108は、そのような目部分24の変化を見て、ロボット10上において、操作者の表情を容易に読取ることができる。

【0108】

遠隔操作装置116が前述のようにコンピュータである場合、たとえば、マウスなどのポインティングデバイス(図示せず)による入力、あるいはカーソルキー(図示せず)など特定のキー入力などの所定入力操作によって、腕機構27の先端プレート100の前後方向への変位を指示する遠隔操作指令(操作データ)を送ることができる。たとえば、上向きカーソルキーを押すと先端プレート100を前に出す指令を、それに後続して数値を入力すると、水平プレート92に対する角度を指令する操作データを、ネットワーク114を介して制御112に送信することができる。下向きカーソルキーを押すしその後数を入力することによって、先端プレート100を水平プレート92に対して何度に後退させるかと言う操作データを送信できる。ただし、先端プレート100の位置として2つの位置(前か後か)しかない場合には、カーソルキーだけの操作でよい。

【0109】

このような遠隔操作システム110において、遠隔操作装置116から何らかのデータが制御装置112に送信されたとき、そのことをイベントとして、図11の処理が制御装置112によって実行される。ただし、ロボット10のロボット機構体14の制御は主として第2コンピュータ126(図9)が行なうので、図11の処理は第2コンピュータ126すなわちCPU144の動作である。

【0110】

最初のステップS1では、制御装置112の第2コンピュータ126のCPU144は、ネットワーク114および通信ボード132および148を介して入力され、メモリ146に一旦記憶されたデータが、音声データかどうか判断する。音声データは、マイク120で取得した操作者の音声の音声データであり、ステップS1で“YES”の場合、CPU144は、ステップS3において、メモリ146から該当の音声データを読み出して、音声ボード152に入力する。したがって、スピーカ32から、操作者の音声が出力される。

【0111】

ステップS3ではまた、スピーカ32からの上述の発話に同期して口部分22が動作するように、ロボット機構体14の口機構23に含まれるモータ66を制御する。つまり、スピーカ32からの発話に合わせて、口部分22を開閉させる。

【0112】

このようにして、口部分22の開閉動作をスピーカ32からの操作者の音声と同期させることによって、ロボット10を通じて操作者と会話している対話者は、身近において直接、操作者の声をロボット10から聴取することができる。したがって、対話者はロボット10に強く操作者を感じることができる。

【0113】

ステップS1で“NO”の場合、遠隔制御装置116からのデータは、操作者の状態を示す状態データか、腕機構27のための操作データである。

【0114】

操作データである場合、ステップS5において“YES”が判断される。この場合、次のステップS7において、CPU144は、メモリ146に一旦蓄積された操作データを読み出し、その操作データの指令内容を達成するためには、メモリ146内の変換テーブル(図示せず)を参照するなどして、モータ94(2つ)をどの方向にどの程度回転させればよいかという制御データを生成する。制御データは、モータ制御ボード150に与えられる。モータ制御ボード150では、その制御データに従ってモータ94を駆動する。応じて、腕機構27すなわち腕部分26が操作データに従って前後に動く。

【0115】

ステップS5で“NO”を判断したとき、そのときのデータは、操作者の状態を示す状態データ(差分データ)である。したがって、先に詳細に説明したように、CPU144がモータ制御ボード150を通して、ロボット機構体14の必要なモータ(図示せず:図4のボックス36の中)およびモータ56ならびに64、66、76(2つ)および/または86を制御する。これによって、ロボット10にそのときの操作者の状態が再現され、対話者はロボット10に一層強く操作者を感じることになる。

【0116】

なお、発明者の実験によれば、ロボット10自体を操作者と実感するには口部分や頭部分は操作者と同期して状態変化することが必要であった。

【0117】

次に重要な要素は、腕部分26の先端が前後に揺動できることであった。口部分、頭部分と共に腕部分の状態が変化することで、対話者はロボット10上に操作者を一層強く実感できた。

【0118】

目部分の状態を操作者と同期するようにすれば、人間のミニマルデザインを体現した外観を有するだけのロボット10がほぼ完全に操作者と意識するようになった。

【0119】

図12以降はこの発明の他の実施例を示し、図12は図1と同様に、遠隔操作ロボット10の外観の一例を示す図解図であり、図12(A)は正面図、図12(B)は側面図、図12(C)は平面図である。図12実施例の遠隔操作ロボットは次の点において、先の図1実施例の遠隔操作ロボットと異なる。ただし、以下の説明で特に言及しない限り、両者は同一または類似の構造、形状、材質などを持つものと理解されたい。

【0120】

図1実施例では、外被12はシリコーン樹脂製だが、図12実施例では、軟質ポリ塩化ビニル(ソフトビニール)製の外被12を用いる。ただし、図1実施例では頭蓋骨に相当する「殻」はないが、図12実施例では、たとえばABS樹脂からなる頭蓋骨部材170(図18)を用いる。このような頭蓋骨部材170は、図8からよくわかるように、頭部の前半分を形成する前部部材170aと、顎部材170bと、前部部材170aと結合される後部部材170cとを含む。頭蓋骨部材170の前部部材170aと後部部材170cは、取り付けプレート88の両側に設けられた側板174上に、両側に突出するように設けた中空ねじ(中空棒に雌ねじを切ったもの)172(図12‐図15)とボルトまたはビス(図示せず)とによって固定的に取り付けられる。そして、顎部材170bは、前部部材170aの下端両側で結合されることによって、上下に変位可能に前部部材170aに連結される。

【0121】

なお、外被12は頭蓋骨部材170の表面に密着するように被せられるので、頭蓋骨部材170と外被12との間に隙間はなく、したがって、それらの間にウレタン樹脂などからなる詰め物30(図12)は入っていない。

【0122】

また、図1実施例は全長80cm程度であるが、図12実施例は70cm程度と短くした。それに伴って、各部の部品形状も変わっているところもあるが、図12実施例においても、ロボット機構体14の自由度は図1実施例と同様に、9軸である。

【0123】

さらに、図1実施例では、操作者(図示せず)の音声を再生するために胸に相当する部位に1つのスピーカ32を設けていたが、図12実施例では、胸部分のスピーカ32に加え、図12や図14などからよくわかるように、口部分22にもう1つのスピーカ32aを設けた。胴体(胴機構)部分のスピーカ32は、対話者108(図7)が音声を聞き取るのに十分な音量の音声を発生できるだけの大きさのスピーカであるが、口部分22のスピーカ32aは、口機構に収まる大きさのものである。胸部分のスピーカ32は外被12で覆われているので、高域成分が減衰して音がこもった感じに聞こえることがあるため、開口している口部分22に別のスピーカ32aを設けるようにした。このように口部分22にスピーカ32aを設けたこの実施例によれば、スピーカ32aによってスピーカ32が失った高域成分を補償して対話者108にはっきりした音声を伝えることができるだけでなく、先に説明したように、このロボット10によって発話される遠隔の対話者からの音声がスピーカ32aから出力されるので、当該音声が口から聞こえる感じを高めることができるのである。

【0124】

また、図1実施例では喉部分にマイク34を設けたが、この実施例では、頭部両側面の「耳」に相当する部位にそれぞれマイク34aおよび34aを設けた。マイク34aを両耳の部分に設けることにより、ロボット10の機能をより人間の機能に近づけるとともに、マイクで音声を採取できる領域ないし範囲を拡大できるという利点がある。

【0125】

なお、実施例では、マイク34aの大きさは直径8mm程度であり、頭蓋骨部材170(後部部材170c)の両耳部分に穴をあけ、そこに差し込んで固定するように取り付けている。そして、好ましくは、マイク34aおよび34aは前方を向くように斜めに取り付けられ、さらに、マイク34aおよび34aの外側の外被12の部分には貫通孔(図示せず)をあけ、顔前方の外部音、たとえば図7に示すように対話者108に対面したとき、対話者108の声の取り込みを容易にしている。

【0126】

さらに、モータ動作による頭蓋骨部材170の振動の影響を抑えるため、マイク34aは頭蓋骨部材170に直接接しないように、たとえば発泡ウレタン樹脂のような振動遮断部材を介して頭蓋骨部材170に取り付けられればよい。

【0127】

ロボット機構体14の頭部分(頭蓋骨部材170)内部に別のマイクを設置し、その別のマイクで取得した音情報と耳部マイク34aおよび34aで取得した音情報を比較して、モータ動作音を抑制(キャンセル)するようにしてもよい。

【0128】

図1実施例では、カメラ142を「額」の部分に設けてもよい旨説明したが、この実施例では、カメラ142は、図12に示すように、胸部分に設けることとした。たとえば、外被12の顎の下5cm程度の場所に直径6mmていどの孔(図示せず)をあけ、この孔からカメラ142のレンズがのぞくように、外被12の裏側に、カメラ回路基板(図示せず)を接着して固定する。したがって、カメラ142は外被12にだけ固定され、ロボット機構体14には固定されていない。もし、ロボット機構体14に固定すると、外被12が捩れたりしたときにカメラ142が隠れてしまう可能性があるからである。つまり、カメラ142を外被12にだけ固定しておけば、外被12が捩れたとしても、カメラ142がそれにつれて動くだけで、隠れてしまうことはない。

【0129】

さらに、図1実施例では、金属蛇腹管102の先端に先端プレート104が取り付けられ、それによって曲げることができる脚部分を構成したが、図12実施例では、脚部分の強度を大きくするために、脚部分を全体が1枚の板である、脚プレート103だけで脚部分を形成することにした。脚プレート103はたとえばFRPからなる。

【0130】

なお、ロボット機構体14の胴体部分に、図19に示しかつこのロボット10の姿勢を計測する姿勢センサ180を取り付けるようにしてもよい。姿勢センサ180は加速度センサやジャイロセンサでよい。このような姿勢センサ180は図19に示すようにセンサボード154を介して第1コンピュータ124のCPUに接続される。そして、姿勢センサ180からの情報またはデータはネットワーク114を介して操作者に提示されることがある。操作者は姿勢センサの情報またはデータから、対話者108がロボット10をどのように扱っているか知ることができる。

【0131】

さらにまた、姿勢センサ180については,一例として、ロボット10がスタンド等(図示せず)に設置されて待機している状態のところへ、ユーザがやってきてロボット10を持ち上げたら、姿勢センサ180によってそれを感知して(触覚センサ156だけだとスタンドに設置しているときにも反応しているかも知れないので)、遠隔操作装置116(図8)を起動して操作者にユーザが会話を始めようとしていることを知らせる、という使い方ができる。

【0132】

たとえば図20の最初のステップS11において、CPU144は、ロボット10が、図示しない、クレードルのようなスタンドに戻されているかどうか判断する。このステップS11の判断は、たとえばスタンド(図示せず)の該当部分に圧力センサ、光センサなどの任意の検知手段を設け、その検知手段がロボット10を検知しているときは、ロボット10はスタンドに戻されている、と判断できる。

【0133】

ステップS11で“NO”を判断したときには、そのまま処理を終了するが、“YES”を判断したときは、CPU144は、次のステップS13で、姿勢センサ180からの姿勢データに基づいて、ロボット10の姿勢に変化が生じたかどうか判断する。ステップS13で“NO”を判断したときには、そのまま処理を終了する。

【0134】

ステップS13で“YES”が判断されると、続くステップS15で、CPU144は、通信ボード148および132並びにLANボード134を経由して、ネットワーク114へ、遠隔操作装置116を起動するための起動信号を送信する。この起動信号がLANボード162を経てシステム158(図10)に入力される。応じて、CPU158はこの遠隔操作装置116を起動する処理を実行する。そして、たとえば第2スピーカ118(図8)から操作者に、「○○さんがお話ししたいようです。」のような報知をして、先の図8に示すような体勢の対話者との会話を始めることを操作者に促すことができる。

【0135】

なお、上述の2つの実施例ではいずれも、詰め物30として、樹脂ビーズを用いた。しかしながら、この詰め物30は、上述のように立方体や球形の柔軟素材の他、外被12とロボット機構体14との間の隙間の形状に形作ったたとえば発泡ウレタンを用いるようにしてもよい。このように、詰め物30を、隙間の形状とほぼ同じ形状のものとすることによって、隙間を確実に充填することができる。ただし、この場合、詰め物は1つのものではなく、右腕,左腕,胴体(脚も含む)前面,胴体(脚も含む)後面の詰め物を別々にして、詰め物を詰め易く、またロボット機構体14の可動部を動き易くしている。さらに、腕の詰め物が胴体の詰め物と別になっていることにより、腕関節が動き易くなっている。

【符号の説明】

【0136】

10 …遠隔操作ロボット(ロボット)

12 …外被

14 …ロボット機構体

16 …胴体部分

17 …胴機構

18 …頭部分

19 …頭機構

20 …首部分

22 …口部分

23 …口機構

24 …目部分

25 …目機構

26 …腕部分

27 …腕機構

28 …脚部分

29 …脚機構

30 …詰め物

32 …スピーカ

34 …マイク

【技術分野】

【0001】

この発明は、遠隔操作ロボットに関し、特にたとえば、インタネットなどを利用して遠隔場所に存在する人間と音声をやり取りできる、遠隔操作ロボットに関する。

【背景技術】

【0002】

この種の遠隔操作ロボットの一例として、たとえば、非特許文献1において本件発明者が提案した、「アンドロイド」と称する、外観(姿形)が人間に酷似した遠隔操作ロボットがあり、このアンドロイドは、たとえば特許文献1に示すような遠隔操作によって、人間に類似したしぐさ動作を行うことができる。

【0003】

このような遠隔操作ロボットは、その容姿を写した人間(操作者)の代役として適宜場所に置かれる。その状態で、特許文献1のようなシステムを構成し、遠隔場所に存在する操作者の指示に従って、もしくは遠隔操作者の動作を示す動作データに従って、内蔵しているロボット機構が作動して、遠隔操作者の示す動作(振る舞い)を行う。

【0004】

特許文献1の遠隔操作ロボットでは、その場所に存在しない操作者(人間)があたかもその場所に居るかのような実在感を与えることが発明者の実験で確認されている。つまり、遠隔操作ロボットが人間の外観を持っていることは、ロボットとその周囲の人間との融和または調和を図るうえで、重要な意味を持つことが分かった。

【非特許文献1】Ishiguro, H. and Nishio, S. 'Building artificial humans for understanding humans', Journal of Artificial Organs, vol.10, no.3, pp.133-142, 2007

【特許文献1】特開2008-23604号公報[B25J 13/08,A63H 11/00, 3/33, 3/36, 3/40]

【発明の開示】

【発明が解決しようとする課題】

【0005】

しかし、人間に酷似したアンドロイドを製作するためには、その人間の全身を型取りし、その型を用いて、人間の肌に類似した感触を有する材料、たとえばシリコーン樹脂の外被を形成し、その外被内に、多数の自由度(たとえば46自由度)を有するロボット機構をすべて組み込む必要がある。

【0006】

つまり、従来の人間酷似の遠隔操作ロボット、一例としてアンドロイドでは、製作費用が高価になるばかりでなく、多数の自由度の制御のために機構や操作方法が複雑になってしまう。

【0007】

それゆえに、この発明の主たる目的は、新規な、遠隔操作ロボットを提供することである。

【0008】

この発明の他の目的は、製作費用を安価にできる、遠隔操作ロボットを提供することである。

【0009】

この発明のその他の目的は、操作方法を簡単にできる、遠隔操作ロボットを提供することである。

【課題を解決するための手段】

【0010】

本発明は、上記の課題を解決するために、以下の構成を採用した。なお、括弧内の参照 符号および補足説明等は、本発明の把握を助けるために後述する実施の形態との対応関係を示したものであって、本発明を何ら限定するものではない。

【0011】

第1発明は、柔軟素材からなり、人間の胴体に相当しかつ胴体と見える胴体部分と、胴体部分の上にあって人間の頭に相当しかつ頭と見える頭部分と、胴体部分の両側から延びて人間の腕および手に相当しかつ腕および手と見える腕部分と、胴体部分の下端から下方に延びて人間の脚および足に相当しかつ脚および足と見える脚部分とを含む、外被を備え、外被はさらに、頭部分の前面であって、人間の口に相当しかつ口と見える口部分および口部分の上であって、人間の目に相当しかつ目と見える目部分を含み、外被内に収納され、外被の胴体部分、頭部分、腕部分、脚部分、口部分および目部分に対応する位置に形成される、胴体機構、頭機構、腕機構、脚機構、口機構および目機構を含む、ロボット機構体をさらに備え、口機構は口部分を動かすための口駆動手段を含み、目機構は目部分を動かす目駆動手段を含み、さらにロボット機構体と外被との間に設けられる詰め物、音声データに従って音声を出力する第1スピーカ、および周囲の音声を取得する第1マイクを備える、遠隔操作ロボットである。

【0012】

第1発明において、遠隔操作ロボット(10:実施例において相当する部分を例示する参照符号。以下、同様。)は、たとえばシリコーン樹脂などの柔軟素材で作った外被(12)、このような外被(12)内に収納されるロボット機構体(14)、外被(12)とロボット機構体(14)との間に設けられる詰め物(30)、音声データに従って音声を出力する第1スピーカ(32)および周囲の音声を取得する第1マイク(34)を備える。

【0013】

外被(12)は、人間の胴体に相当しかつ胴体と見える胴体部分(16)と、胴体部分(16)の上にあって人間の頭に相当しかつ頭と見える頭部分(18)と、胴体部分(16)の両側から延びて人間の腕および手に相当しかつ腕および手と見える腕部分(26)と、胴体部分(16)の下端から下方に延びて人間の脚および足に相当しかつ脚および足と見える脚部分(28)と、頭部分(18)の前面であって、人間の口に相当しかつ口と見える口部分(22)および口部分(22)の上であって、人間の目に相当しかつ目と見える目部分(24)を含む。

【0014】

ロボット機構体(14)は、外被(12)の胴体部分(16)、頭部分(18)、腕部分(26)、脚部分(28)、口部分(22)および目部分(24)にそれぞれ対応する位置に形成される、胴体機構(17)、頭機構(19)、腕機構(27)、脚機構(29)、口機構(23)および目機構(25)を含む。そのうち、口機構(23)は口部分(22)を動かすための、たとえばモータ(66)を含む口駆動手段を有し、目機構(25)は目部分(24)を動かす、たとえばモータ(76、76、86)を含む目駆動手段を有する。

【0015】

第1発明によれば、遠隔操作ロボットは、人間のミニマルデザインに基づいた外観形状に形成され、口部分や目部分などに最低限の自由度がある。したがって、この発明の遠隔操作ロボットは、一見して人間と分かり、その上で性別や年齢は自由に想像できるので、その遠隔操作ロボットを通じて操作者と対話する対話者は、遠隔操作ロボットを操作者自身と感じることができる。

【0016】

発明者が非特許文献1で提案した「アンドロイド」(人間酷似ロボット)を用い、たとえば特許文献1に記載の遠隔操作システムを利用した実験では、ロボットが酷似させられた被験者(操作者:本人)にロボットと相手(ロボットの近くに存在して被験者とコミュニケーションする人)とを映し出すモニタを見せながら話をしてもらった。そのとき、本人の唇の動きや頭部の動きを画像処理で解析して、インタネットを通じてロボットに伝えて、ロボットの唇や頭部を本人の動きと連動させた。その様子を本人はモニタで確認することによって、ロボットを自分の身体のように感じるようになる。そして、ロボットが誰か(相手)に触られると、被験者(本人)は自らの身体が触られたような感覚を覚える。発明者はこのような現象をこれまでの遠隔操作ロボットの研究によって確認してきた。

【0017】

非特許文献1の「アンドロイド」は発明者自身を酷似させたものであり、このアンドロイドを通じて、発明者自身も上記の現象を実感したところである。

【0018】

これらの実験を通して発明者は、ロボットの容姿が本人に酷似していなくても、対話や動作によって、その人はロボットを自らの身体と感じるようになることが分かった。つまり、本件発明者は、数多くの実験を経験する中で、遠隔操作ロボットは必ずしも本人に酷似した見掛けを持つ必要がない、という確信を得るに至った。

【0019】

そこで、この発明においては、このようにして発明者が得た知見に基づいて、遠隔操作ロボットに、人間のミニマルデザインに基づく外観を持たせることを発想した。「人間のミニマルデザイン」とは、一見して人と分かるが、子供とも年寄りとも、男とも女とも認識できるような、年齢や性別が、見る人によって、どのようにも解釈できる、という人間の形状をいうものとする。

【0020】

この人間のミニマルデザインを体現したのが、上記の外被の形状である。この発明は、このような独特の外観を持ち、かついくつかの自由度を持つので、対話者は遠隔操作ロボット自体の上に対話相手(操作者)を強く実感できるのである。

【0021】

第2の発明は、第1の発明に従属し、腕機構は、腕部分の先端を変位可能にするための変位部材および変位部材を操作データに従って駆動するための駆動手段を含む、遠隔操作ロボットである。

【0022】

第2の発明では、たとえば実施例でいえば先端プレート(100)が変位部材に相当し、モータ(94)を含む駆動手段で変位部材が駆動される。したがって、遠隔操作ロボットを遠隔操作する操作者は、ロボットを通じて対話している対話者に、腕部分の先端の変化によって意思を通じることができる。

【0023】

第3の発明は、第1または第2の発明に従属し、頭機構は、頭部分を少なくとも1つの自由度で変化させるための駆動手段を含む、遠隔操作ロボットである。

【0024】

第3の発明では、頭機構(19)は、たとえばモータ(56,64)を含む駆動手段によって、少なくとも1つの自由度で、実施例では3つの自由度で、頭部分(18)を変化させる。もし、操作者の状態データに従って頭部分(18)が変位するようにすれば、遠隔操作ロボットに操作者の状態が再現されるので、対話者はロボット上に操作者を一層強く実感することができる。

【0025】

第4の発明は、第1ないし第3のいずれかの発明に従った遠隔操作ロボットと、ネットワークを通して遠隔操作ロボットに繋がってそれを遠隔操作するための遠隔制御装置とを含む、遠隔操作システムであって、遠隔操作装置は、操作者の声を取得する第2マイクと、音声を出力する第2スピーカを含み、第2マイクで取得した操作者の声が第1スピーカで出力され、第1マイクで取得した音声が第2スピーカで出力される、遠隔操作システムである。

【0026】

第4の発明では、第1ないし第3のいずれかの発明に従った遠隔操作ロボット(10)と、ネットワーク(14)を通して遠隔操作ロボット(10)に繋がってそれを遠隔操作するための遠隔制御装置(116)とを含む、遠隔操作システム(110)である。遠隔操作装置(116)は、操作者の声を取得する第2マイク(120)と、音声を出力する第2スピーカ(118)を含む。そして、第2マイク(120)で取得した操作者の声が第1スピーカ(32)で出力され、第1マイク(36)で取得した音声が第2スピーカ(118)で出力される。したがって、操作者、対話者ともに強い臨場感のなかで遠隔操作ロボットを通じて対話することができる。

【0027】

第5の発明は、第4の発明に従属し、遠隔制御装置は操作者の状態を検出する状態検出手段、および操作者の状態を表す状態データをネットワークを介して遠隔操作ロボットに送信する状態データ送信手段を備え、口駆動手段および目駆動手段が状態データに従って駆動される、遠隔操作システムである。

【0028】

第5の発明では、状態検出手段としては、実施例の場合、操作者カメラ(166)や、操作者カメラからの映像信号を処理して操作者の状態を検出するCPU(158)で構成される。CPU(158)は操作者の状態を表す状態データをネットワーク(114)を介して制御装置(112)すなわち遠隔操作ロボット(10)に送信する。口駆動手段および目駆動手段が状態データに従って駆動される結果、遠隔操作ロボット(10)において、そのときの操作者の状態が再現される。そのため、遠隔操作ロボットを通して操作者と対話している対話者は、遠隔操作ロボット上に非常に強く操作者を感得できる。

【発明の効果】

【0029】

本件発明者が非特許文献1などで提案した遠隔操作ロボットは、実在人間そっくりの遠隔操作アンドロイドであったが、数々の実験を重ねた本件発明者は、実在人間にそっくりに作らなくとも、遠隔操作ロボットを人間のミニマルデザインに基づいた外観形状にすれば、遠隔操作ロボットを通じて操作者と対話する対話者は、その遠隔操作ロボットを操作者本人と感じることができることを発見した。この発明はこの発見に基づいてなされたものである。

【0030】

この発明によれば、遠隔操作ロボットは、人間のミニマルデザインに基づいた外観形状に形成され、口または目などに最低限の自由度がある。したがって、この発明の遠隔操作ロボットは、一見して人間と分かり、その上で性別や年齢は自由に想像できるので、その遠隔操作ロボットを通じて操作者と対話する対話者は、遠隔操作ロボットを操作者自身と感じることができる。このような人間のミニマルデザインに基づく外観形状はかなり単純化されている。したがって、操作者を対話者に感じさせるために人間に酷似させていた「アンドロイド」と同様に遠隔操作ロボットを操作者と感じさせることができる反面、「アンドロイド」に比べて製作費用を大幅に低減できる。

【0031】

この発明の上述の目的,その他の目的,特徴および利点は、図面を参照して行う以下の実施例の詳細な説明から一層明らかとなろう。

【図面の簡単な説明】

【0032】

【図1】図1はこの発明の一実施例の遠隔操作ロボットの外観の一例を示す図解図であり、図1(A)は正面図、図1(B)は側面図、図1(C)は平面図である。

【図2】図2は図1実施例の遠隔操作ロボットの体表の凹凸をよく表すコンピュータグラフィックスであり、図2(A)は図1(A)に対応し、図2(B)は図1(B)に対応し、図2(C)は図1(C)に対応している。

【図3】図3は図1実施例の遠隔操作ロボットの構造の一例を示す正面図解図である。

【図4】図4は図1実施例のロボット機構の一例を示す、主として正面側を示す斜視図である。

【図5】図5は図1実施例のロボット機構の一例を示す、主として背面側を示す斜視図である。

【図6】図6は図1実施例のロボット機構の一例を示す平面図解図である。

【図7】図7は図1実施例のロボットを通じて操作者と会話する対話者がロボットを抱き上げている状態の一例を示す図解図である。

【図8】図8は図1実施例のロボットを利用する遠隔操作システムの一例を示す概略ブロック図である。

【図9】図9は図8の制御装置を詳細に示すブロック図である。

【図10】図10は図8の遠隔操作装置を詳細に示すブロック図である。

【図11】図11は図8実施例の遠隔操作システムの動作の一例を示すフロー図である。

【図12】図12はこの発明の他の実施例の遠隔操作ロボットの外観の一例を示す図解図であり、図12(A)は正面図、図12(B)は側面図、図12(C)は平面図である。

【図13】図13は図12実施例の遠隔操作ロボットの構造の一例を示す正面図解図である。

【図14】図14は図12実施例のロボット機構の一例を示す、主として正面側を示す斜視図である。ただし、頭蓋骨相当部分は省略している。

【図15】図15は図12実施例のロボット機構の一例を示す、主として背面側を示す斜視図である。ただし、頭蓋骨相当部分は省略している。

【図16】図16は図12実施例のロボット機構の一例を示す平面図解図である。ただし、頭蓋骨相当部分は省略している。

【図17】図17は図12実施例のロボット機構の一例を示す側面図解図である。ただし、頭蓋骨相当部分は省略している。

【図18】図17は図12実施例のロボット機構の一例を示す側面図解図である。

【図19】図19は図12実施例の制御装置を詳細に示すブロック図である。

【図20】図20は図19の制御装置の動作の一例を示すフロー図である。

【発明を実施するための形態】

【0033】

図1および図2を参照して、この発明の一実施例の遠隔操作ロボット(この明細書では、単に「ロボット」ということがある。)10は、全体としては、人間のミニマルデザイン(minimal design)と呼ぶべき見掛け(外観)を持つ。なお、図1では凹凸が分かりにくく、立体感が十分表現できないので、コンピュータグラフィックス技術で作成した図面を参考的に図2として添付している。図1(A)および図2(A)がともに正面を示し、図1(B)および図2(B)が右側面を示し、図1(C)および図2(C)がともに(C)が平面を示している。

【0034】

発明者が非特許文献1で提案した「アンドロイド」(人間酷似ロボット)を用い、たとえば特許文献1に記載の遠隔操作システムを利用した実験では、ロボットが酷似させられた被験者(操作者:本人)にロボットと相手(ロボットの近くに存在して被験者とコミュニケーションする人)とを映し出すモニタを見せながら話をしてもらった。そのとき、本人の唇の動きや頭部の動きを画像処理で解析して、インタネットを通じてロボットに伝えて、ロボットの唇や頭部を本人の動きと連動させた。その様子を本人はモニタで確認することによって、ロボットを自分の身体のように感じるようになる。そして、ロボットが誰か(相手)に触られると、被験者(本人)は自らの身体が触られたような感覚を覚える。発明者はこのような現象をこれまでの遠隔操作ロボットの研究によって確認してきた。

【0035】

非特許文献1の「アンドロイド」は発明者自身を酷似させたものであり、このアンドロイドを通じて、発明者自身も上記の現象を実感したところである。

【0036】

これらの実験を通して発明者は、ロボットの容姿が本人に酷似していなくても、対話や動作によって、その人はロボットを自らの身体と感じるようになることが分かった。つまり、本件発明者は、数多くの実験を経験する中で、遠隔操作ロボットは必ずしも本人に酷似した見掛けを持つ必要がない、という確信を得るに至った。

【0037】

そこで、この発明においては、このようにして発明者が得た知見に基づいて、遠隔操作ロボット10に上述のように人間のミニマルデザインに基づく外観を持たせることを発想した。「人間のミニマルデザイン」とは、一見して人と分かるが、子供とも年寄りとも、男とも女とも認識できるような、年齢や性別が、見る人によって、どのようにも解釈できる、という人間の形状をいうものとする。

【0038】

このような、人間のミニマルデザインを形作っているロボット10の外観は、人間の皮膚に類似した感触を持つ柔軟体、たとえばシリコーン樹脂、ウレタン(発泡)樹脂などの外被12で形成される。外被12の内部には、図3に示すように、ロボット機構体14が内蔵される。

【0039】

なお、この外被12では、顔を完全に左右対称にすることにより、男性にも女性にも見えるという効果を強く与えることを意図している。また、顔の各パーツの大きさの比率(目、鼻、口の大きさや位置)は、人間の大人と同じ程度の比率にしているが、頭部の大きさに対する身長(等身)は子供のものとすることによって、大人にも子供にも見える効果を強調している。

【0040】

この実施例では、ロボット10の大きさは、対話者(ロボット10を感じさせる操作者と対話する者)がたとえばひざの上に抱き上げることができる程度の大きさにされている。人間の身長に相当する大きさは、一例として80cm程度としている。つまり、少し大きめの人形程度の大きさであるため、対話者が高齢者であっても子供であっても、容易に身近に容易に置きながら、操作者と対話できる。ただし、この数値に限定されるものではなく、抱っこしたり、隣に座らせたりすることよって、ロボット10と対話者とが親密な距離感を持ちながら操作者と対話できるようなサイズであれば或る程度の幅は当然設定できる。

【0041】

外被12は、全体として1枚の外被として形成される。外被12は、人間の胴体に相当して、かつ胴体と見える部分(便宜上、「胴体部分」と呼ぶ。)16と、この胴体部分16の上方に配置され、人間の頭に相当して、かつ頭と見える部分(便宜上、「頭部分」と呼ぶ。)18を含む。頭部分18を形成する外被と胴体部分16を形成する外被とは首部分20の外被によって連続している。

【0042】

頭部分18の前面には、人間の口に相当して、かつ口と見える口部分22が形成される。この口部分22は、外被12に形成した裂け目のようなものであり、後述の口機構によって、開閉され得る。ただし、口部分22において外被12に裂け目を形成する必要は必ずしもない。後述の口機構を内蔵するだけでも、口部分22が動くので、ロボット10を見ている人は、口部分22が動いてロボット10が何かをしゃべっているように見える。

【0043】

さらに、頭部分18の前面であって口部分22の上には、人間の目に相当して、かつ目と見える目部分24が形成される。この目部分24は、外被12に形成した孔から露出するものであり、後述の目機構によって、左右上下に変位される。なお、以下の説明では、目部分24や腕部分26のように左右1対のものは、左右区別なく同じ参照番号を用いて示すが、必要があるときには、区別のための添え字「L」または「R」を用いることがある。

【0044】

胴体部分16の両側には、胴体部分16から連続した外被によって、人間の腕および手に相当して、かつ腕および手と見える部分(便宜上、「腕部分」と呼ぶ。)26が外方に突出するように形成される。この腕部分26は、特に図1(C)からよく分かるように、先端が前方に突出するように全体的に湾曲して形成される。これは、子供が「抱っこ」をせがむときなどの腕の形態を模した形状である。当然ながら、このような湾曲を形成する必要は必ずしもない。

【0045】

胴体部分16の下方には、胴体部分16から連続した外被によって、人間の脚および足に相当して、かつ脚および足と見える部分(便宜上、「脚部分」と呼ぶ。)28が下方に延びて形成される。人間の実際の脚は2本あるのに対して、この脚部分28は、図示からよく分かるように、1つの足部分として形成される。これは、ロボット10を遠隔操作する場面においてはたとえば、ロボット10をあいて対話者(相手)のひざの上に抱いた状態などを想定しているので、足が2本なのか1本しかないのかは機能上重要なことではないとの考えによる。なお、ここで対話者とは、ロボット10が自分の分身であると想定している人(上記の例で言えば、被験者(本人)に相当する。)の遠隔操作を通して、その本人と話をする人のことを指す。たとえば、遠隔地に住む家族の1人が操作者であり、他の1人が対話者の場合などが想定されている。

【0046】

なお、実施例では、腕部分26と脚部分28のそれぞれの先端には手や足に相当する形状(指を含む)のものは設けられておらず、単に先細りの形状にされている。これは、ミニマルデザインの考え方による。つまり、手や足の部分がなくても、少なくとも人間に見えればよく、対話の障害にはならない、と言う考えによる。

【0047】

なお、このような一枚物の外被12を1度の成形工程で作ることはできない。そこで、発明者等は、図1(B)に示すように、前部分12aと後ろ部分12bとを別々の工程で作り、前部分12aの端縁と後ろ部分12bの端縁とをたとえば熱溶着によって接続することを考えた。図1(B)の参照番号「12c」がその継ぎ目を示している。ただし、外被12は、上部分と下部分とを別々に作った後、両者を合体させるようにしてもよい。つまり、外被12の作り方は自由である。

【0048】

このような、人間のミニマルデザインを体現した外形を持つ外被12中に、図2‐図4に示す形状、構造を有するロボット機構体14が収納される。外被12には図示しないが、たとえば胴体部分16の後ろ(背中に相当する)にファスナのような開閉手段を設けておき、ロボット機構体14を収納するときそれを開き、その後閉じるようにすればよい。しかしながら、ファスナのように開閉自在とする必要はなく、工場等での製作過程では外被12の一部を開け、ロボット機構体14を収納後は開けられないように閉じてしまうことも考えられる。使用者が容易に開けられるようになっていると、故障や事故の原因になったりする可能性が考えられるからである。

【0049】

ロボット機構体14の詳細は後述するが、図3に示すように、ロボット機構体14のサイズは外被12のサイズよりかなり小さい。したがって、外被12とロボット機構体14との間には介在する何かが必要である。この実施例では、そのような介在物(詰め物)30として、たとえば発泡スチロールまたは発泡ウレタンのような樹脂から作った小径のビーズを用いる。ただし、樹脂ビーズより大きいサイズのたとえば立方体や球形の柔軟素材、たとえば発泡樹脂(たとえばウレタン)を、詰め物30として外被12とロボット機構体14との間に充填するようにしてもよい。

【0050】

詰め物30を用いる理由は、詰め物30がなければ外被12がたるみ、外被12の独特の形状を保持できないため、詰め物30によって外被12に適度な張りを持たせる必要があるからである。他方、この詰め物30をビーズや柔軟素材のものを用いる理由は、詰め物30によって、ロボット機構体14の可動部、たとえば頭機構、口機構、目機構さらには腕機構などの動き(変位)が阻害されないようにするためである。つまり、詰め物30が軟らかいか、変形容易な集合体(ビーズ)である場合には、可動部が動くときの力によって詰め物30が容易に変形できる。

【0051】

しかしながら、図示しないが、外被12を肉厚に形成してロボット機構体14と間に隙間が出ないようにすることも可能である。この場合には、重くなる可能性があるので、軽量化の工夫が必要であろう。

【0052】

なお、図3に示すように、ロボット機構体14の前面には、このロボット10の発話音声を出力するためのスピーカ32や、このロボット10を通じて操作者と会話する対話者の声を拾うためのマイク34が設けられる。実施例では、スピーカ32は胴体部分16の位置に、マイク34は口部分22の位置にそれぞれ設けられるが、それらの位置はこの位置に限定されるものではない。

【0053】

さらに、ロボット機構体14は、図3に示しかつ後に詳細に説明するすように、外被12の胴体部分16、頭部分18、口部分22、目部分24、腕部分26および脚部分28にそれぞれ位置が対応する、胴体機構17、頭機構19、口機構23、目機構25、腕機構27および脚機構29を含む。

【0054】

図2‐図4を参照して、ロボット機構体14は、外被12の胴体部分16に相当する位置に配置されるべき胴体ボックス36を含む。この胴体ボックス36が胴体機構17を形成する。胴体ボックス36は、実施例ではたとえばアルミニウムの薄板をねじによって組み立てたもので、その中に、ロボット機構体14の一部のモータや制御用の電気回路部品などを収納する。或る程度の強度を持たせるためや、電気回路部品をできるだけ周囲の電気ノイズの影響から保護するためにアルミニウムのような金属で胴体ボックス36を形成したが、材料はこれに限定されるものではない。胴体ボックス36は側面5角形であり、前面は山折れ線を挟んで上下のプレートに分離される。前面の上部プレートには第1スピーカ32(図3)を取り付けるための開口38が形成される。

【0055】

胴体ボックス36の天井プレート40の上には、円形の軸受けプレート42がねじなどによって固着される。個々に言及はしないが、この軸受けプレート42より上の位置に設けられる部品が頭機構19を構成することを予め指摘しておく。

【0056】

軸受けプレート42の上には回転プレート44が積層され、回転プレート44のほぼ中央には、天井プレート40を貫通し、軸受けプレート42に設けた軸受け(図示せず)によって支承されたモータ軸46が固着される。したがって、モータ軸46が天井プレート40の真下に設けられているモータ(図示せず:図4のボックス36の中)によって回転されると、それに固着された回転プレート44が、モータ軸46を中心として水平方向(左右方向)に回転される。

【0057】

回転プレート44のモータ軸46周りの回転によって、ロボット10の頭部分18が図1(C)に示す矢印A方向に回転(または回動)する。頭部分18の矢印A方向での回転によって、ロボット10が頭部分18を横に振る動作を表現でき、たとえば否定(“NO”)や嫌がっていることを対話者に伝えることができる。

【0058】

回転プレート44の上面には正面形状がU字形状でかつ側面形状が3角形のアングル50が回転プレート44と一体的に固定され、アングル50の頂角部分において、回転軸52が左右の立ち上がり板に差し渡されて、それぞれに設けた軸受け(図示せず)によって支承される。アングル50の左右の立ち上がり板に挟まれて、平面矩形でかつ各辺に立上がり板が形成されている支持ボックス54が配置される。支持軸52は、両端部において、支持ボックス54の左右辺の立ち上がり板に固着される。回転軸52は、図示しない連結機構、たとえば歯車を介して、支持ボックス54の中に設置されたモータ56のモータ軸に連結される。したがって、このモータ56が回転されると、モータ軸(図示せず)が回転し、このモータ軸から動力を受ける回転軸52が回転され、回転軸52に一体的に固定されている支持ボックス54が回転軸52周りに回転する。

【0059】

支持ボックス54の回転軸52周りの回転によって、ロボット10の頭部分18が図1(B)に示す矢印B方向(前後)に傾動する。頭部分18の矢印B方向での傾動によって、ロボット10が頭部分18を縦に振る動作を表現でき、たとえば肯定(“YES”)やあいづちなどを対話者に伝えることができる。

【0060】

なお、支持ボックス54の前辺の立ち上がり板に、図3に示す第1マイク34を装着するための開口58が形成される。

【0061】

特に図5からよく分かるように、支持ボックス54の上部において、前後辺の立ち上がり板に軸受け(図示せず)によってモータ軸60が軸支され、モータ軸60には、平面矩形でかつ各辺から垂下する立ち上がり(実際には、立ち下り)板が形成されている支持ボックス62の、前後辺の立ち上がり板の下部が固着される。したがって、モータ64が回転されると、支持ボックス62がモータ軸60と一体的に回転する。

【0062】

支持ボックス62のモータ軸60周りの回転によって、ロボット10の頭部分18が図1(A)に示す矢印C方向(左右)に傾動する。頭部分18の矢印C方向での傾動によって、ロボット10が頭部分18によって「首を傾げる」動作を表現でき、たとえば疑問があることや甘えたい感じなどを対話者に伝えることができる。

【0063】

このようにしてロボット機構体14の頭機構19が形成されるが、頭機構19は上述のように3つの自由度を有し、各自由度における変化量を制御するためのモータ(図示せず:図4のボックス36の中)およびモータ56ならびに64が、頭機構19の駆動手段の一例である。

【0064】

ただし、頭機構19が必ず3つの自由度を持たなくてはならないものではなく、自由度を全てなくして頭機構19すなわち頭部分18が動かないようにしてもよい。あるいは、頭機構19にモータ(図示せず:図4のボックス36の中)とそれによって駆動される機構だけを設けて横首振り(図1の矢印A)だけができるようにしてもよく、頭機構19にモータ58とそれによって駆動される機構だけを設けて縦首振り(図1の矢印B)だけができるようにしてもよく、頭機構19にモータ64とそれによって駆動される機構だけを設けて首傾げ(図1の矢印C)だけができるようにしてもよい。あるいは、これら3つの自由度の任意の2つの組み合わせを設定することもできる。

【0065】

さらに、各自由度(矢印A、BまたはC)においては、基本的には、変化量を連続的に制御できるように設計するが、段階的にしか変化しないような制御を採用することもできる。段階的変化の極端な例が2段階変化であり、たとえば、矢印A方向の横首振りであれば、右‐正面‐左だけの変化が想定でき、矢印B方向の縦首振りであれば、上‐正面‐下だけの変化が想定でき、矢印C方向の首傾げでは、右‐正面‐左だけの変化が想定できる。

【0066】

支持ボックス62の前面の立ち上がり板には図4に示すように、口機構23を作動させるためのモータ66が取り付けられ、それのモータ軸68にU字形状のアングル70の左右片が固着される。したがって、モータ66が回転されると、モータ軸68によって、アングル70がモータ軸68周りに回動する。

【0067】

アングル70のモータ軸68周りの回転によって、ロボット10の口部分22が図1(A)に示す矢印D方向(上下)に開閉される。つまり、アングル70は、口部分22において、下口蓋に相当する動きをするものであり、したがって、アングル70が矢印D方向において下方に動くと、口部分22では下唇が押し下げられて、口部分22が開く。アングル70が矢印D方向において上方に動くと、下唇が元に戻って、口部分22が閉じる。このような口部分22の開閉動作、つまりアングル70の上下動動作をスピーカ32(図3)からの音声と同期させることによって、ロボット10を通じて操作者と会話している対話者は、ごく自然に、操作者の声をロボット10から聴取することができる。したがって、対話者はロボット10に強く操作者を感じることができる。なお、一例として、特開2008‐26485号公報に開示されるように、発話を遅延させる一方で音響特徴に基づいて口形状を推定する(第2コンピュータ126によって)ことで、口部分22の動作と発話とを同期させることができる。

【0068】

また、口機構23では、基本的には、口の開度を連続的に制御できるように設計するが、段階的にしか開度を変えないという制御も考えられる。段階的変化の極端な例が2段階変化であり、口を開けるか閉じるかだけである。

【0069】

このようにモータ66およびアングル70が口機構23の主要構成部品であり、特にモータ66は口機構の動きをするもので、口機構の駆動手段の一例である。

【0070】

口機構23の上方に、図1に示す目部分24を構成する目機構25が設けられる。目部分24と同じように、目機構についても左右区別なく説明する。目部分24の左右の眼球72を支持する支持プレート74が設けられる。眼球72はこの実施例では半球形であり、その前面に図1のような黒目が描かれている。支持プレート74の裏面に、モータ76が、各モータ76のモータ軸78が上に向くように、固着される。モータ軸78の先端にはギア80が固着される。このギア80に噛み合うギア82が、ギア80の前方に設けられる。ギア82は、垂直方向下方に延びる回転軸84(図6)に、回転軸84の後ろ側で固着される。回転軸84の前側は眼球72の中心に固着されている。モータ76が回転されてモータ軸78が回転すると、2つのギア80および82の連係によって、回転軸84が回転し、回転軸84に中心が接続されている眼球72は、ギア82の回転方向とは反対方向に回転する。

【0071】

ギア80のモータ軸78周りの回転に応じて、眼球72が回転すると、ロボット10の目部分24が図1(A)に示す矢印E方向(左右)に変位する。つまり、眼球72の黒目が左右に動く。このような目部分24の動きを対話している操作者の目の動きに連動させれば、対話者は、ごく自然に、操作者の表情をロボット10から聴取することができる。したがって、対話者はロボット10にさらに強く操作者を感じることができる。

【0072】

さらに、図6に示すように、2つのモータ76の間においてモータ86が頭部分を形成する取り付けプレート88に固着され、そのモータ86のモータ軸90は水平方向に延び、上記2つのモータ76の一方(図6では左)のモータハウジングの側面に連結される。したがって、モータ86が回転されて、モータ軸90が回転すると、モータ76がハウジングの側面の1点を中心に回動する。モータ76は上述のように支持プレート74に直接固定されている。そのため、モータ76がそのような態様で回動すると、支持プレート74が上下方向に傾動する。

【0073】

モータ86のモータ軸90周りの支持プレート74の回動に応じて、左右の眼球72が一緒に上下方向に変位する。つまり、眼球72の黒目が上下に動く。このような目部分24の動きを対話している操作者の目の動きと連動させれば、対話者は、ごく自然に、操作者の表情をロボット10から聴取することができる。したがって、対話者はロボット10にさらに一層強く操作者を感じることができる。

【0074】

ここまでで目機構25について説明したが、目機構25は上下左右に変位可能にも受けられた眼球72と、その眼球72を上下左右に動かすモータ76および86が眼球駆動手段の一例である。

【0075】

ただし、目機構25が必ず2つの自由度を持たなくてはならないものではなく、自由度を全てなくして目機構25すなわち目部分24が動かないようにしてもよい。あるいは、目機構25にモータ76とそれによって駆動される機構だけを設けて眼球72を左右方向(図1の矢印E)にだけ動くようにしてもよく、目機構25にモータ86とそれによって駆動される機構だけを設けて眼球72を上下方向(図1の矢印F)にだけ動くようにしてもよい。

【0076】

さらに、目機構25では、自由度(矢印EまたはF)においては、基本的には、変化量を連続的に制御できるように設計するが、段階的にしか変化しないような制御も考えられる。段階的変化の極端な例が2段階変化であり、たとえば、矢印E方向であれば、右‐正面‐左だけの変化が、矢印F方向であれば、上‐正面‐下だけの変化が想定できる。

【0077】

胴体ボックス36の裏面には、たとえばFRP(fiberglass reinforced plastics:ガラス繊維強化プラスチック)の水平プレート92が取り付けられる。この水平プレート92は水平方向に延び、図1のロボット10における腕部分26のための腕機構27(図3)の構成部品である。水平プレート92の先端(両端)前面にはモータ94が、モータ軸96が上に向くように、固着される。モータ軸96の先端は口機構のアングル70と同様の形状のアングル98が固着され、アングル98の垂直面には、たとえば水平プレート92と同じ材料の、先端部材としての先端プレート100が固着される。したがって、モータ94が回転されると、モータ軸96周りにアングル98すなわち先端プレート100が前後方向に回動する。つまり、先端部材としての先端プレート100が水平プレート92の両端に前後に変位可能に設けられ、モータ94がその先端プレート100を前後に動かす駆動手段を構成する。

【0078】

先端プレート100のモータ軸96周りの回転によって、ロボット10の腕部分26が図1(C)に示す矢印G方向(前後)に変位する。腕頭部分26の矢印G方向の動きによって、ロボット10は、たとえば「抱っこ」(ハグ)をして欲しいときに子供が手を前に出すしぐさなどを表現でき、たとえば操作者が甘えたい感情を対話者に伝えることができる。

【0079】

このように、腕機構27は、水平プレート92およびこの水平プレート92の先端に前後に変位可能に設けられる先端プレート100などで構成され、モータ94が先端部材の変位駆動手段の一例となる。

【0080】

なお、腕機構27の先端部材の一例である先端プレート100の平面形状は、ロボット10の腕部分26の先端が先細りに形成されているために、それに合うように、略3角形状にされている。ただし、この先端部材は先端プレート100のような平板形状に限られるものではなく、この先端部材はそれが前後に変位することによって外被12の腕部分26の先端を前後に動かすためのものであるので、その機能がはっきできるのであれば、棒形状などのものであってもよい。

【0081】

また、実施例の腕機構27では、図1(C)に示す腕部分26の湾曲形状を表現するために、先端プレート100の先端が前方に突出するように、先端プレート100を、水平プレート92に対して鈍角に傾斜した位置が初期位置(ホーム位置)となるように、アングル98すなわちモータ軸96に取り付けられる。しかしながら、水平プレート92と整列する(面一になる)初期位置を設定しておき、動作指令が与えられると、先端が前方に向くように設計することも可能である。

【0082】

また、腕機構27では、基本的には、先端プレート100の曲げ角度を連続的に制御できるように設計するが、段階的にしか変化しないという制御も考えられる。段階的変化の極端な例が2段階変化であり、先端を前に出すか出さないかである。

【0083】

胴体ボックス36の下面に、2本の金属蛇腹管102が、下方に向かうにつれて互いの間隔が狭くなるように、下方に延びて取り付けられる。金属蛇腹管102の先端には、たとえばアルミニウムの薄板からなり、かつ略3角形状の先端プレート104が、3角形の頂角に相当する側が下になるように、取り付けられる。金属蛇腹管102および先端プレート104が、ロボット10の脚部分28のための脚機構29を構成する。

【0084】

脚機構29に金属蛇腹管102を用いているため、ロボット10の脚部分28(図1)を容易に屈曲させることができる。そのため、対話者は、ロボット10を抱っこしたり、隣に座らせたりすることよって、対話者と親密な距離感を持ちながら、操作者と話をすることができる。これにより,対話者は操作者の存在を、ロボット10を通してより強く感じることができる。一例として、ロボット10を通じて操作者と対話する対話者108は、図7に示すように、脚部分28を幾分曲げて、ロボット10を自分のひざの上に抱いてもよい。ただし、ロボット10を対話者の身近に置く態様は、図7のようニ対話者のひざの上に置く態様に限られるものではない。

【0085】

なお、後述の制御装置112(図8)とロボット10の電気回路とを有線で接続する場合には、胴体ボックス36の下面から突出して形成されている有線接続ポート106を用い、その接続線(コード)は外被12に適宜の孔を形成しておき、その孔から外被12の外へだせばよい。

【0086】

図8を参照して、この実施例の遠隔操作システム(以下、単に「システム」ということがある。)110は、ロボット10を含む。ロボット10は先に説明したように、人間のミニマルデザインに基づく外観形状を持ち、腕部分26などのような必要最低限の自由度を備えるロボットである。ロボット10は、遠隔場所で検知した操作者の音声や状態のデータ(音声データ、状態データ)に基づいて、操作者の音声、状態を主としてロボット機構体14の動作によって再現する。そのために、ロボット機構体14に設けられた横首振り用のモータ(図示せず:図4のボックス36の中)、縦首振り用のモータ56、首傾げ用のモータ64、口開閉用のモータ66、目左右変位用のモータ(2つ)76、目上下変位用のモータ86、および腕先端前後変位用のモータ94をそれぞれ制御するための制御装置112が設けられる。この制御装置112は典型的にはパソコンで構成する。

【0087】

なお、制御装置112とロボット10の各モータなどを有線で接続する場合には、図4などに示す有線接続ポート106を用いることは前述のとおりである。無線通信手段で結合されてもよい。さらに、このような制御装置112をロボット10の外被12に内蔵し、あるいは外被12の表面に装着することも考えられる。特に、高齢者がロボット10を日常的に使う場合には、ロボット10と制御装置112とを一体化するほうが好都合である。

【0088】

制御装置112は、インタネットや電話通信回線のようなネットワーク114を介して遠隔操作装置116に接続される。遠隔操作装置116も、パソコンのような汎用のコンピュータであってよい。遠隔操作装置116には、第2スピーカ118、第2マイク120およびモニタ122が接続される。図示は省略するが、当然のことながら、遠隔操作装置116には、キーボードおよびコンピュータマウスのような入力装置が含まれる。

【0089】

図9は図8の制御装置112を詳しく示すブロック図である。この図9を参照して、制御装置112は、第1コンピュータ124および第2コンピュータ126によって構成される。たとえば、第1コンピュータ124がメインのコンピュータであり、第2コンピュータ126がサブのコンピュータである。ただし、処理能力が高ければ、1台のコンピュータで構成することもできる。

【0090】

第1コンピュータ124は、CPU128を含み、CPU128には内部バスを介してメモリ130、通信ボード132、LANボード134およびカメラボード136が接続される。メモリ130は、たとえば、ハードディスク装置(HDD)のような主記憶装置、ROMおよびRAMを含む。

【0091】

カメラボード136は、全方位カメラ138、PTZカメラ140およびロボットカメラ142からのカメラ信号をA/D変換してカメラ信号データとしてCPU128に与え、制御データを主としてPTZカメラ140にパン、チルト、ズームなどの制御データを出力するためのインターフェイスである。

【0092】

全方位カメラ138は、ロボット10すなわち対話者108が存在する部屋ないし場所(区画)に設置され、当該部屋ないし場所の全体(360度)を撮影することができる。全方位カメラ138のカメラ映像に対応する映像データがCPU128に与えられる。CPU128は、映像データに基づいてその場所の状況の変化を検出するのみならず、その画像データを遠隔操作装置116に送信する。遠隔操作装置116は、受信した映像データをモニタ122に出力する。したがって、全方位カメラ138からの映像が、モニタ122に表示され、そのモニタ122を通して操作者は対話者の存在する部屋ないし場所の様子を知ることができる。

【0093】

PTZカメラ140は、操作者の指示に従って、パン(Pan)、チルト(Tilt)およびズーム(Zoom)の各々を制御(調整)することができるカメラである。たとえば、遠隔操作者が、パン、チルト、ズームの指示を入力すると、対応する制御信号(コマンド)が遠隔操作装置116からネットワーク114を介して第1コンピュータ124に与えられる。すると、第1コンピュータ124のCPU128は、そのコマンドに従ってPTZカメラ140を駆動制御する。PTZカメラ140の撮影映像に対応する映像データもまた、CPU128に与えられる。CPU128は、映像データに基づいて対話者108などの状況の変化を検出するのみならず、その映像データを遠隔操作装置116に送信する。遠隔操作装置116は、受信した映像データをモニタ122に出力する。したがって、PTZカメラ140の映像もモニタ122に表示される。モニタ122を通して操作者は対話者108の様子を知ることができる。

【0094】

上では説明しなかったが、ロボット10の外被12の頭部分18(人間でいえば額に相当する位置)に内蔵されて外被12の外を撮影できるロボットカメラ142を設けるようにしてもよい。ロボットカメラ142は、たとえばイメージセンサであり、ロボット10の視覚の一部を構成する。つまり、ロボットカメラ142は、ロボット10から見た映像を検出するために用いられる。この実施例では、ロボットカメラ142の映像(動画ないし静止画)に対応するデータ(映像データ)は、カメラボード136を介してCPU128に与えられる。CPU128は、映像データに基づいて、撮影映像の変化を検出するのみならず、その映像データを、ネットワーク114を介して遠隔操作装置116に送信する。そして、遠隔操作装置116は、受信した映像像データを再生してモニタ122に映像を出力する。したがって、ロボットカメラ144の撮影映像がモニタ122に表示され、モニタ122を通して操作者はロボットカメラ142が取得した対話者108などの様子を知ることができる。

【0095】

通信ボード132は、他のコンピュータ(この実施例では、第2コンピュータ126)とデータ通信するためのインターフェイスである。たとえば、通信ボード132は、後述する第2コンピュータ126の通信ボード148と、RS232Cのようなケーブル(図示せず)を用いて接続される。LANボード134は、ネットワーク114を介して他のコンピュータ(この実施例では、遠隔操作装置116)とデータ通信するためのインターフェイスである。この実施例では、LANボード134は、LANケーブル(図示せず)または無線LANでネットワーク114と接続される。

【0096】

第2コンピュータ126は、CPU144を含み、CPU144には内部バスを介してメモリ146、通信ボード148、モータ制御ボード150、音声ボード152およびセンサボード154が接続される。メモリ144は、たとえば、ハードディスク装置(HDD)のような主記憶装置、ROMおよびRAMを含む。詳細な説明は省略するが、このメモリ146には、遠隔操作装置116から伝えられる、操作者の状態を表す状態データをロボット10の動作として再現するための変換テーブル(図示せず)などが設定されているものとする。つまり、状態データが示す操作者の状態を再生するためには、モータ(図示せず:図4のボックス36の中)およびモータ56、64、66、76、86および94をどの程度どの方向に回転または回動すればよいかモータ制御データに変換するためのテーブルである。

【0097】

ロボット10は前述のように、頭部分に3自由度、口部分に1自由度、目部分に3自由度、左右の腕部分にそれぞれ1自由度、計9自由度が設定されていて、それら9自由度のそれぞれを制御するための9つのモータ(図示せず:図4のボックス36の中)およびモータ56、64、66、76(2つ)、86および94(2つ)と、スピーカ32およびマイク34を含む。モータ(図示せず:図4のボックス36の中)およびモータ56、64、66、76(2つ)、86および94(2つ)は、制御装置112に設けられたモータ制御ボード150に接続される。したがって、CPU144からのモータ制御データに従って、モータ制御ボード150がモータ(図示せず:図4のボックス36の中)およびモータ56、64、66、76(2つ)、86および94(2つ)の回転方向および回転量を制御する。

【0098】

また、ロボット10は前述のようにスピーカ32およびマイク34を含む。CPU144から出力された音声データ(典型的には、遠隔地の操作者の音声)は音声ボード152によってD/A変換されてスピーカ32に与えられる。したがって、スピーカ32は、操作者の音声を出力する。マイク34によって取り込まれた対話者108(図7)の音声は、音声ボード152によってD/A変換されてCPU144に与えられる。

【0099】

ロボット10は、また、外被12の表面の適宜数の場所に装着された1つまたは複数の触覚センサ156を含む。触覚センサないし皮膚センサ156は、たとえばタッチセンサであり、ロボット10の触覚の一部を構成する。つまり、触覚センサ156は、人間や他の物体等がロボット10に触れたか否かを検出するために用いられる。この触覚センサ156からのセンサ信号がセンサボード154を介してCPU144に入力される。したがって、CPU144は、人間や他の物体等がロボット10に触れたことを検出することができる。

【0100】

ただし、触覚センサ156としては、圧力センサを用いることもできる。この場合には、人間や他の物体等がロボット10の肌に触れたか否かのみならず、その触れ方(強弱)を知ることができる。

【0101】

図10に示す遠隔制御装置116も同様にパソコンのようなコンピュータで形成される。遠隔制御装置116はCPU158を含み、CPU158には内部バスを介してメモリ160、LANボード162およびカメラボード164が接続される。メモリ160は、たとえば、ハードディスク装置(HDD)のような主記憶装置、ROMおよびRAMを含む。カメラボード164には操作者カメラ166が接続される。操作者カメラ166は、ロボット10を通して対話者108(図7)と対話する操作者の状態を撮影するもので、それのカメラ信号はカメラボード164を介して、映像データとして、CPU158に入力される。

【0102】

CPU158は、映像データに基づいて、操作者の状態を示す状態データを生成する。詳しくいうと、遠隔操作装置116のCPU158は、操作者カメラ166からの映像データを処理して、まず、たとえば映像中の肌色領域を検出するなどして、操作者の頭部分を検出する。その頭部分の状態が前回検出したものとどのように変化しているかを示す差分データを計算して、その差分データをネットワーク114を通して制御装置112に送信する。たとえば、操作者の頭部分の状態を、図1に示す矢印A、BおよびC方向における変位量の差分データとして検出する。

【0103】

制御装置112のLANボード134からこの差分データが入力され、CPU128および通信ボード132および148を介して、第2コンピュータ126のCPU144に伝えられる。CPU144は、メモリ146に予め設定している前述のような変換テーブル(図示せず)を参照して、頭部分18を図1に示す矢印A、BおよびC方向のそれぞれにおいて、どの方向にどれだけ変位させればよいかを計算し、モータ(図示せず:図4のボックス36の中)およびモータ56ならびに64のモータ制御データを決定し、それをモータ制御ボード150に出力する。そのモータ制御データが示す回転方向および回転量に従ってモータ(図示せず:図4のボックス36の中)およびモータ56ならびに64が制御される。したがって、操作者カメラ166が捉えた操作者の頭部分の状態が、ロボット10の頭部分18によって再現または再生される。つまり、そのときのロボット10の頭部分18の状態は、操作者の頭部分の状態に追従したものとして再現される。したがって、対話者108は、そのような頭部分18の変位を見て、ロボット10上において、操作者の状態を容易に読取ることができる。

【0104】

口部分22についても同様に、遠隔操作装置116のCPU158が操作者の頭部分(肌色部分)中にある、口部分を検出する。そして、口部分の状態が前回検出したものとどのように変化しているかを示す差分データを計算して、その差分データをネットワーク114を通して制御装置112に送信する。たとえば、操作者の口部分の状態を、図1に示す矢印D方向における変位量の差分データとして検出する。

【0105】

制御装置112のLANボード134からこの差分データが入力され、CPU128および通信ボード132および148を介して、第2コンピュータ126のCPU144に伝えられる。CPU144は、メモリ146に予め設定している前述のような変換テーブル(図示せず)を参照して、口部分22を図1に示す矢印D方向において、どの方向にどれだけ変位させればよいかを計算し、モータ66のモータ制御データを決定し、それをモータ制御ボード150に出力する。そのモータ制御データが示す回転方向および回転量に従ってモータ66が制御される。したがって、操作者カメラ166が捉えた操作者の口部分の状態が、ロボット10の口部分22によって再現または再生される。つまり、そのときのロボット10の口部分22の状態は、操作者の口部分の状態を追従したものとして再現される。したがって、対話者108は、そのような口部分22の動きを見て、操作者が対話者に向けて発話していることを容易に認識することができる。

【0106】

目部分も同様である。遠隔操作装置116のCPU158が操作者の頭部分(肌色部分)中にある、目部分を検出する。その目部分の状態が前回検出したものとどのように変化しているかを示す差分データを計算して、その差分データをネットワーク114を通して制御装置112に送信する。たとえば、操作者の目部分の状態を、図1に示す矢印EおよびF方向における変位量の差分データとして検出する。

【0107】

制御装置112のLANボード134からこの差分データが入力され、CPU128および通信ボード132および148を介して、第2コンピュータ126のCPU144に伝えられる。CPU144は、メモリ146に予め設定している前述のような変換テーブルを参照して、目部分24を図1に示す矢印EおよびF方向のそれぞれにおいて、どの方向にどれだけ変位させればよいかを計算し、モータ76(2つ)および86のモータ制御データを決定し、それをモータ制御ボード150に出力する。そのモータ制御データが示す回転方向および回転量に従ってモータ76(2つ)および86が制御される。したがって、操作者カメラ166が捉えた操作者の目部分の状態が、ロボット10の目部分24によって再現または再生される。つまり、そのときのロボット10の目部分24の状態は、操作者の目部分の状態に追従したものとして再現される。したがって、対話者108は、そのような目部分24の変化を見て、ロボット10上において、操作者の表情を容易に読取ることができる。

【0108】

遠隔操作装置116が前述のようにコンピュータである場合、たとえば、マウスなどのポインティングデバイス(図示せず)による入力、あるいはカーソルキー(図示せず)など特定のキー入力などの所定入力操作によって、腕機構27の先端プレート100の前後方向への変位を指示する遠隔操作指令(操作データ)を送ることができる。たとえば、上向きカーソルキーを押すと先端プレート100を前に出す指令を、それに後続して数値を入力すると、水平プレート92に対する角度を指令する操作データを、ネットワーク114を介して制御112に送信することができる。下向きカーソルキーを押すしその後数を入力することによって、先端プレート100を水平プレート92に対して何度に後退させるかと言う操作データを送信できる。ただし、先端プレート100の位置として2つの位置(前か後か)しかない場合には、カーソルキーだけの操作でよい。

【0109】

このような遠隔操作システム110において、遠隔操作装置116から何らかのデータが制御装置112に送信されたとき、そのことをイベントとして、図11の処理が制御装置112によって実行される。ただし、ロボット10のロボット機構体14の制御は主として第2コンピュータ126(図9)が行なうので、図11の処理は第2コンピュータ126すなわちCPU144の動作である。

【0110】

最初のステップS1では、制御装置112の第2コンピュータ126のCPU144は、ネットワーク114および通信ボード132および148を介して入力され、メモリ146に一旦記憶されたデータが、音声データかどうか判断する。音声データは、マイク120で取得した操作者の音声の音声データであり、ステップS1で“YES”の場合、CPU144は、ステップS3において、メモリ146から該当の音声データを読み出して、音声ボード152に入力する。したがって、スピーカ32から、操作者の音声が出力される。

【0111】

ステップS3ではまた、スピーカ32からの上述の発話に同期して口部分22が動作するように、ロボット機構体14の口機構23に含まれるモータ66を制御する。つまり、スピーカ32からの発話に合わせて、口部分22を開閉させる。

【0112】

このようにして、口部分22の開閉動作をスピーカ32からの操作者の音声と同期させることによって、ロボット10を通じて操作者と会話している対話者は、身近において直接、操作者の声をロボット10から聴取することができる。したがって、対話者はロボット10に強く操作者を感じることができる。

【0113】

ステップS1で“NO”の場合、遠隔制御装置116からのデータは、操作者の状態を示す状態データか、腕機構27のための操作データである。

【0114】

操作データである場合、ステップS5において“YES”が判断される。この場合、次のステップS7において、CPU144は、メモリ146に一旦蓄積された操作データを読み出し、その操作データの指令内容を達成するためには、メモリ146内の変換テーブル(図示せず)を参照するなどして、モータ94(2つ)をどの方向にどの程度回転させればよいかという制御データを生成する。制御データは、モータ制御ボード150に与えられる。モータ制御ボード150では、その制御データに従ってモータ94を駆動する。応じて、腕機構27すなわち腕部分26が操作データに従って前後に動く。

【0115】

ステップS5で“NO”を判断したとき、そのときのデータは、操作者の状態を示す状態データ(差分データ)である。したがって、先に詳細に説明したように、CPU144がモータ制御ボード150を通して、ロボット機構体14の必要なモータ(図示せず:図4のボックス36の中)およびモータ56ならびに64、66、76(2つ)および/または86を制御する。これによって、ロボット10にそのときの操作者の状態が再現され、対話者はロボット10に一層強く操作者を感じることになる。

【0116】

なお、発明者の実験によれば、ロボット10自体を操作者と実感するには口部分や頭部分は操作者と同期して状態変化することが必要であった。

【0117】

次に重要な要素は、腕部分26の先端が前後に揺動できることであった。口部分、頭部分と共に腕部分の状態が変化することで、対話者はロボット10上に操作者を一層強く実感できた。

【0118】

目部分の状態を操作者と同期するようにすれば、人間のミニマルデザインを体現した外観を有するだけのロボット10がほぼ完全に操作者と意識するようになった。

【0119】

図12以降はこの発明の他の実施例を示し、図12は図1と同様に、遠隔操作ロボット10の外観の一例を示す図解図であり、図12(A)は正面図、図12(B)は側面図、図12(C)は平面図である。図12実施例の遠隔操作ロボットは次の点において、先の図1実施例の遠隔操作ロボットと異なる。ただし、以下の説明で特に言及しない限り、両者は同一または類似の構造、形状、材質などを持つものと理解されたい。

【0120】

図1実施例では、外被12はシリコーン樹脂製だが、図12実施例では、軟質ポリ塩化ビニル(ソフトビニール)製の外被12を用いる。ただし、図1実施例では頭蓋骨に相当する「殻」はないが、図12実施例では、たとえばABS樹脂からなる頭蓋骨部材170(図18)を用いる。このような頭蓋骨部材170は、図8からよくわかるように、頭部の前半分を形成する前部部材170aと、顎部材170bと、前部部材170aと結合される後部部材170cとを含む。頭蓋骨部材170の前部部材170aと後部部材170cは、取り付けプレート88の両側に設けられた側板174上に、両側に突出するように設けた中空ねじ(中空棒に雌ねじを切ったもの)172(図12‐図15)とボルトまたはビス(図示せず)とによって固定的に取り付けられる。そして、顎部材170bは、前部部材170aの下端両側で結合されることによって、上下に変位可能に前部部材170aに連結される。

【0121】

なお、外被12は頭蓋骨部材170の表面に密着するように被せられるので、頭蓋骨部材170と外被12との間に隙間はなく、したがって、それらの間にウレタン樹脂などからなる詰め物30(図12)は入っていない。

【0122】

また、図1実施例は全長80cm程度であるが、図12実施例は70cm程度と短くした。それに伴って、各部の部品形状も変わっているところもあるが、図12実施例においても、ロボット機構体14の自由度は図1実施例と同様に、9軸である。

【0123】

さらに、図1実施例では、操作者(図示せず)の音声を再生するために胸に相当する部位に1つのスピーカ32を設けていたが、図12実施例では、胸部分のスピーカ32に加え、図12や図14などからよくわかるように、口部分22にもう1つのスピーカ32aを設けた。胴体(胴機構)部分のスピーカ32は、対話者108(図7)が音声を聞き取るのに十分な音量の音声を発生できるだけの大きさのスピーカであるが、口部分22のスピーカ32aは、口機構に収まる大きさのものである。胸部分のスピーカ32は外被12で覆われているので、高域成分が減衰して音がこもった感じに聞こえることがあるため、開口している口部分22に別のスピーカ32aを設けるようにした。このように口部分22にスピーカ32aを設けたこの実施例によれば、スピーカ32aによってスピーカ32が失った高域成分を補償して対話者108にはっきりした音声を伝えることができるだけでなく、先に説明したように、このロボット10によって発話される遠隔の対話者からの音声がスピーカ32aから出力されるので、当該音声が口から聞こえる感じを高めることができるのである。

【0124】

また、図1実施例では喉部分にマイク34を設けたが、この実施例では、頭部両側面の「耳」に相当する部位にそれぞれマイク34aおよび34aを設けた。マイク34aを両耳の部分に設けることにより、ロボット10の機能をより人間の機能に近づけるとともに、マイクで音声を採取できる領域ないし範囲を拡大できるという利点がある。

【0125】

なお、実施例では、マイク34aの大きさは直径8mm程度であり、頭蓋骨部材170(後部部材170c)の両耳部分に穴をあけ、そこに差し込んで固定するように取り付けている。そして、好ましくは、マイク34aおよび34aは前方を向くように斜めに取り付けられ、さらに、マイク34aおよび34aの外側の外被12の部分には貫通孔(図示せず)をあけ、顔前方の外部音、たとえば図7に示すように対話者108に対面したとき、対話者108の声の取り込みを容易にしている。

【0126】

さらに、モータ動作による頭蓋骨部材170の振動の影響を抑えるため、マイク34aは頭蓋骨部材170に直接接しないように、たとえば発泡ウレタン樹脂のような振動遮断部材を介して頭蓋骨部材170に取り付けられればよい。

【0127】

ロボット機構体14の頭部分(頭蓋骨部材170)内部に別のマイクを設置し、その別のマイクで取得した音情報と耳部マイク34aおよび34aで取得した音情報を比較して、モータ動作音を抑制(キャンセル)するようにしてもよい。

【0128】

図1実施例では、カメラ142を「額」の部分に設けてもよい旨説明したが、この実施例では、カメラ142は、図12に示すように、胸部分に設けることとした。たとえば、外被12の顎の下5cm程度の場所に直径6mmていどの孔(図示せず)をあけ、この孔からカメラ142のレンズがのぞくように、外被12の裏側に、カメラ回路基板(図示せず)を接着して固定する。したがって、カメラ142は外被12にだけ固定され、ロボット機構体14には固定されていない。もし、ロボット機構体14に固定すると、外被12が捩れたりしたときにカメラ142が隠れてしまう可能性があるからである。つまり、カメラ142を外被12にだけ固定しておけば、外被12が捩れたとしても、カメラ142がそれにつれて動くだけで、隠れてしまうことはない。

【0129】

さらに、図1実施例では、金属蛇腹管102の先端に先端プレート104が取り付けられ、それによって曲げることができる脚部分を構成したが、図12実施例では、脚部分の強度を大きくするために、脚部分を全体が1枚の板である、脚プレート103だけで脚部分を形成することにした。脚プレート103はたとえばFRPからなる。

【0130】

なお、ロボット機構体14の胴体部分に、図19に示しかつこのロボット10の姿勢を計測する姿勢センサ180を取り付けるようにしてもよい。姿勢センサ180は加速度センサやジャイロセンサでよい。このような姿勢センサ180は図19に示すようにセンサボード154を介して第1コンピュータ124のCPUに接続される。そして、姿勢センサ180からの情報またはデータはネットワーク114を介して操作者に提示されることがある。操作者は姿勢センサの情報またはデータから、対話者108がロボット10をどのように扱っているか知ることができる。

【0131】

さらにまた、姿勢センサ180については,一例として、ロボット10がスタンド等(図示せず)に設置されて待機している状態のところへ、ユーザがやってきてロボット10を持ち上げたら、姿勢センサ180によってそれを感知して(触覚センサ156だけだとスタンドに設置しているときにも反応しているかも知れないので)、遠隔操作装置116(図8)を起動して操作者にユーザが会話を始めようとしていることを知らせる、という使い方ができる。

【0132】

たとえば図20の最初のステップS11において、CPU144は、ロボット10が、図示しない、クレードルのようなスタンドに戻されているかどうか判断する。このステップS11の判断は、たとえばスタンド(図示せず)の該当部分に圧力センサ、光センサなどの任意の検知手段を設け、その検知手段がロボット10を検知しているときは、ロボット10はスタンドに戻されている、と判断できる。

【0133】

ステップS11で“NO”を判断したときには、そのまま処理を終了するが、“YES”を判断したときは、CPU144は、次のステップS13で、姿勢センサ180からの姿勢データに基づいて、ロボット10の姿勢に変化が生じたかどうか判断する。ステップS13で“NO”を判断したときには、そのまま処理を終了する。

【0134】

ステップS13で“YES”が判断されると、続くステップS15で、CPU144は、通信ボード148および132並びにLANボード134を経由して、ネットワーク114へ、遠隔操作装置116を起動するための起動信号を送信する。この起動信号がLANボード162を経てシステム158(図10)に入力される。応じて、CPU158はこの遠隔操作装置116を起動する処理を実行する。そして、たとえば第2スピーカ118(図8)から操作者に、「○○さんがお話ししたいようです。」のような報知をして、先の図8に示すような体勢の対話者との会話を始めることを操作者に促すことができる。

【0135】

なお、上述の2つの実施例ではいずれも、詰め物30として、樹脂ビーズを用いた。しかしながら、この詰め物30は、上述のように立方体や球形の柔軟素材の他、外被12とロボット機構体14との間の隙間の形状に形作ったたとえば発泡ウレタンを用いるようにしてもよい。このように、詰め物30を、隙間の形状とほぼ同じ形状のものとすることによって、隙間を確実に充填することができる。ただし、この場合、詰め物は1つのものではなく、右腕,左腕,胴体(脚も含む)前面,胴体(脚も含む)後面の詰め物を別々にして、詰め物を詰め易く、またロボット機構体14の可動部を動き易くしている。さらに、腕の詰め物が胴体の詰め物と別になっていることにより、腕関節が動き易くなっている。

【符号の説明】

【0136】

10 …遠隔操作ロボット(ロボット)

12 …外被

14 …ロボット機構体

16 …胴体部分

17 …胴機構

18 …頭部分

19 …頭機構

20 …首部分

22 …口部分

23 …口機構

24 …目部分

25 …目機構

26 …腕部分

27 …腕機構

28 …脚部分

29 …脚機構

30 …詰め物

32 …スピーカ

34 …マイク

【特許請求の範囲】

【請求項1】

柔軟素材からなり、人間の胴体に相当しかつ胴体と見える胴体部分と、胴体部分の上にあって人間の頭に相当しかつ頭と見える頭部分と、胴体部分の両側から延びて人間の腕および手に相当しかつ腕および手と見える腕部分と、胴体部分の下端から下方に延びて人間の脚および足に相当しかつ脚および足と見える脚部分とを含む、外被を備え、

前記外被はさらに、前記頭部分の前面であって、人間の口に相当しかつ口と見える口部分および前記口部分の上であって、人間の目に相当しかつ目と見える目部分を含み、

前記外被内に収納され、前記外被の前記胴体部分、前記頭部分、前記腕部分、前記脚部分、前記口部分および前記目部分に対応する位置に形成される、胴体機構、頭機構、腕機構、脚機構、口機構および目機構を含む、ロボット機構体をさらに備え、

前記口機構は前記口部分を動かすための口駆動手段を含み、

前記目機構は前記目部分を動かす目駆動手段を含み、さらに

前記ロボット機構体と前記外被との間に設けられる詰め物、

音声データに従って音声を出力する第1スピーカ、および

周囲の音声を取得する第1マイクを備える、遠隔操作ロボット。

【請求項2】

前記腕機構は、前記腕部分の先端を変位可能にするための変位部材および前記変位部材を操作データに従って駆動するための駆動手段を含む、請求項1記載の遠隔操作ロボット。

【請求項3】

前記頭機構は、前記頭部分を少なくとも1つの自由度で変化させるための駆動手段を含む、請求項1または2記載の遠隔操作ロボット。

【請求項4】

請求項1ないし3のいずれかに記載の遠隔操作ロボットと、ネットワークを通して前記遠隔操作ロボットに繋がってそれを遠隔操作するための遠隔制御装置とを含む、遠隔操作システムであって、

前記遠隔操作装置は、操作者の声を取得する第2マイクと、音声を出力する第2スピーカを含み、

前記第2マイクで取得した操作者の声が前記第1スピーカで出力され、前記第1マイクで取得した音声が前記第2スピーカで出力される、遠隔操作システム。

【請求項5】

前記遠隔制御装置は前記操作者の状態を検出する状態検出手段、および前記操作者の状態を表す状態データを前記ネットワークを介して前記遠隔操作ロボットに送信する状態データ送信手段を備え、

前記口駆動手段および前記目駆動手段が前記状態データに従って駆動される、請求項4記載の遠隔操作システム。

【請求項1】

柔軟素材からなり、人間の胴体に相当しかつ胴体と見える胴体部分と、胴体部分の上にあって人間の頭に相当しかつ頭と見える頭部分と、胴体部分の両側から延びて人間の腕および手に相当しかつ腕および手と見える腕部分と、胴体部分の下端から下方に延びて人間の脚および足に相当しかつ脚および足と見える脚部分とを含む、外被を備え、

前記外被はさらに、前記頭部分の前面であって、人間の口に相当しかつ口と見える口部分および前記口部分の上であって、人間の目に相当しかつ目と見える目部分を含み、

前記外被内に収納され、前記外被の前記胴体部分、前記頭部分、前記腕部分、前記脚部分、前記口部分および前記目部分に対応する位置に形成される、胴体機構、頭機構、腕機構、脚機構、口機構および目機構を含む、ロボット機構体をさらに備え、

前記口機構は前記口部分を動かすための口駆動手段を含み、

前記目機構は前記目部分を動かす目駆動手段を含み、さらに

前記ロボット機構体と前記外被との間に設けられる詰め物、

音声データに従って音声を出力する第1スピーカ、および

周囲の音声を取得する第1マイクを備える、遠隔操作ロボット。

【請求項2】

前記腕機構は、前記腕部分の先端を変位可能にするための変位部材および前記変位部材を操作データに従って駆動するための駆動手段を含む、請求項1記載の遠隔操作ロボット。

【請求項3】

前記頭機構は、前記頭部分を少なくとも1つの自由度で変化させるための駆動手段を含む、請求項1または2記載の遠隔操作ロボット。

【請求項4】

請求項1ないし3のいずれかに記載の遠隔操作ロボットと、ネットワークを通して前記遠隔操作ロボットに繋がってそれを遠隔操作するための遠隔制御装置とを含む、遠隔操作システムであって、

前記遠隔操作装置は、操作者の声を取得する第2マイクと、音声を出力する第2スピーカを含み、

前記第2マイクで取得した操作者の声が前記第1スピーカで出力され、前記第1マイクで取得した音声が前記第2スピーカで出力される、遠隔操作システム。

【請求項5】

前記遠隔制御装置は前記操作者の状態を検出する状態検出手段、および前記操作者の状態を表す状態データを前記ネットワークを介して前記遠隔操作ロボットに送信する状態データ送信手段を備え、

前記口駆動手段および前記目駆動手段が前記状態データに従って駆動される、請求項4記載の遠隔操作システム。

【図1】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図13】

【図14】

【図15】

【図16】

【図17】

【図18】

【図19】

【図20】

【図2】

【図3】

【図4】

【図5】

【図6】

【図7】

【図8】

【図9】

【図10】

【図11】

【図12】

【図13】

【図14】

【図15】

【図16】

【図17】

【図18】

【図19】

【図20】

【図2】

【公開番号】特開2012−40679(P2012−40679A)

【公開日】平成24年3月1日(2012.3.1)

【国際特許分類】

【出願番号】特願2011−159729(P2011−159729)

【出願日】平成23年7月21日(2011.7.21)

【出願人】(393031586)株式会社国際電気通信基礎技術研究所 (905)

【出願人】(504176911)国立大学法人大阪大学 (1,536)

【Fターム(参考)】

【公開日】平成24年3月1日(2012.3.1)

【国際特許分類】

【出願日】平成23年7月21日(2011.7.21)

【出願人】(393031586)株式会社国際電気通信基礎技術研究所 (905)

【出願人】(504176911)国立大学法人大阪大学 (1,536)

【Fターム(参考)】

[ Back to top ]