Fターム[5L096HA05]の内容

イメージ分析 (61,341) | 認識 (5,606) | 複数イメージを取得し対比するもの (3,468) | 動画像解析 (3,285) | 追尾 (769)

Fターム[5L096HA05]に分類される特許

761 - 769 / 769

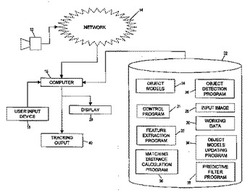

ビデオ画像内でのオブジェクトトラッキング

本発明は、それぞれのマッチング特徴のスケーリングと分散を考慮に入れる、ビデオフレーム内でオブジェクトを追跡するためのオブジェクトトラッキング方法及びシステムを提供する。これは、オブジェクト間の一致を決定するために可能な限り多くのマッチング特徴を使用することができ、このようにして決定されるマッチングの精度を高めることを確実にする一方で、マッチング特徴の選択でのある程度の自由度に備える。オブジェクト間の閉塞を考慮に入れるために並列マッチング手法が使用され、発見的規則が利用される。 (もっと読む)

ヒト被験体におけるストレス、感情および欺瞞を感知するための強力かつ低コストの光学システム

ヒト被験体において選択された感情または心理状況を感知するための方法およびそれに関連する装置である。本技術は、ヒト被験体の顔面イメージを得るために2次元カメラを採用している。次いで、イメージ処理モジュールがイメージをスキャンし、顔面の位置および範囲を決定し、顔面の選択された重要な領域をスキャンする。選択された重要な領域のサイズおよび活動は、被験体の顔の一連のイメージフレームと比較することによってモニタリングされる。また、その領域はトラッキングされ、考えられる被験体の動作に対する補正が行われる。選択された重要な領域の感知されたパラメータは、データベース内に保存されているものと比較される。データベースは、重要な領域の動作を、被験体の多様な感情および心理状況と関連づける。そして、被験体のレポートまたは評価が生成される。  (もっと読む)

(もっと読む)

小さな高速移動物体を追跡するための動きベクトル場の改良

第1の動きベクトル場(MVF1)を第2の動きベクトル場(MVF2)へ変換する変換ユニット(300)が開示される。第1の動きベクトル場は、画像のシーケンスにおける第1画像と第2画像とに基づき、その第1画像とその第2画像との間の時間位置に対して計算される。変換ユニット(300)は:第1画像における未参照ピクセルの第1群を確立する第1の確立手段(302)と;第2画像における未参照ピクセルの第2群を確立する第2の確立手段(304)と;未参照ピクセルの第1群から未参照ピクセルの第2群へ向かう候補動きベクトルのマッチ誤差を計算する計算手段(306)と;そのマッチ誤差を所定のマッチ閾値と比較し、そのマッチ誤差が所定のマッチ閾値未満である場合、第2の動きベクトル場における第1動きベクトルへその候補動きベクトルを割り当てる比較手段(308)とを有する。  (もっと読む)

(もっと読む)

局所的に変形する可能性のある動きを分析するための装置および方法

本発明は、局所的に変形可能な動きを分析するための方法、およびある対象物体の局所的な動きをその全体運動から分離して対象物体の動きを精確に追従するための方法および装置に関する。対象物体はイメージシーケンスとして観察される。この場合、対象物体領域イメージと背景イメージ領域を識別するために、イメージ領域がサンプリングされる。全体運動によって作用の及ぼされる背景イメージ領域を識別するために、識別された背景イメージ領域のうち少なくとも1つの領域の動きが推定される。イメージフレーム中の全体運動を測定するために、複数の背景イメージ領域からの動きが組み合わせられる。対象物体の局所的な動きを測定するために、対象物体イメージ領域において測定された全体運動が補償され、対象物体の局所的な動きが追従される。さらに本発明は、2つのコントロールポイントセット間の相対運動として対象物体の局所的に変形可能な動きを精確に測定するための方法および装置に関する。コントロールポイントセットは、対象物体の内側の輪郭および外側の輪郭として定義される。この場合、コントロールポイントセットの動きが推定され、対象物体の局所的な変形と局所的な動きを表すために相対的な動きが用いられる。  (もっと読む)

(もっと読む)

深度データを用いたビジュアルトラッキング

【課題】深度感知撮像技術を用いたリアルタイムビジュアル画像トラッキングにより、照度不変のトラッキング性能が得られる。深度感知(タイムオブフライト)カメラによって、同じ場面がリアルタイムで深度と色を持つ画像として提供される。深度ウィンドウはシャッター速度を制御してトラッキングする領域を調整する。深度画像データからポテンシャル領域が導き出され、トラッキングする目標物体の周縁部の情報が得られる。数学的に表される輪郭はトラッキングする目的物体をモデリングすることができる。この輪郭とトラッキングする目的物体の周縁部との間の適合度を決定し、深度データに基づいて、トラッキングのための位置情報が得られる。画像トラッキングに基づいて深度センサを用いる用途としては、頭部トラッキング、手のトラッキング、姿勢推定、ロボットの命令画定および、その他の人間とコンピュータの相互関係システムが挙げられる。 (もっと読む)

映像視覚情報を結合してリアルタイムで複数の顔を検出して追跡する顔検出・追跡システム及びその方法

【課題】 入力映像から複数の顔をリアルタイムで検出して追跡できるシステム及びその方法を提供する。

【解決手段】 入力映像から背景映像を除去して動きのある領域を抽出する背景除去部、顔皮膚色モデルから生成された皮膚色確率マップPskin及び全域的確率マップPglobalを利用し、動く領域から顔が位置しうる候補領域を抽出する候補領域抽出部、候補領域からICA特徴を抽出し、学習されたSVM分類器を用いて候補領域が顔領域であるか否かを判断する顔領域判断部及び皮膚色確率マップに基づき、次のフレームで顔の位置する確率を示す方向指向性カーネルにより顔領域を追跡する顔領域追跡部を含むシステム。

(もっと読む)

照明不変の客体追跡方法及びこれを用いた映像編集装置

【課題】 照明不変の客体追跡方法及びこれを用いた映像編集装置を提供する。

【解決手段】 (a)映像で追跡しようとする客体の初期位置を指定する段階と、(b)前記映像の隣接したピクセルのカラー比を考慮したカラーモデリングを行う段階と、(c)前記カラーモデリングの結果に応答して客体追跡のための確率マップを生成する段階と、(d)前記初期の位置及び前記確率マップに基づき前記客体の現在の位置を追跡する段階とを含むことを特徴とする客体追跡方法、及び映像で追跡しようとする客体の初期位置を指定する初期位置指定部と、前記客体及び前記全映像の隣接したピクセルのカラー比を考慮したカラーモデリングを行うカラーモデリング部と、前記カラーモデリング結果に応答して、前記客体の追跡のための確率マップを構成する確率マップ構成部と、前記初期位置及び前記確率マップに応答して前記客体の現位置を追跡する客体追跡部とを備える前記追跡方法を用いた映像編集装置 。

(もっと読む)

画像処理装置および画像処理方法、プログラムおよびプログラム記録媒体、並びにデータおよびデータ記録媒体

【課題】 オブジェクトの抽出等を精度良く行う。

【解決手段】 ユーザに画像が提供され、ユーザが、その画像上の位置をクリックすることにより得られるクリックデータが、動き解析部121に供給される。動き解析部121は、ユーザからの複数のクリックデータに基づいて、ユーザによるクリック位置の動きを解析し、意図解析部123は、その動きの解析結果に基づいて、ユーザの意図を解析する。そして、オブジェクト抽出部125は、そのユーザの意図の解析結果に基づいて、画像データからオブジェクトを抽出する。

(もっと読む)

画像解析システム,画像解析方法および画像解析プログラム記録媒体

【課題】 画像フレーム間における物体間の対応関係に一対多,多対一などの多様性を導入し,安定した物体の追跡と,複数の物体の合体,分離等の状態に関する情報の出力を可能にする。

【解決手段】 映像を構成する各々の画像フレームにおいて対象物が占める画像領域から対象物の位置と大きさを取得する。次に,近接する二つのフレームにおいて検出された対象物について,前のフレームの対象物が後のフレームの対象物へ移動した場合の遷移コストを,二つのフレーム上の対象物の組について計算し,遷移コストから二つのフレーム上の対象物の間の対応関係を分類し,対象物の状態を判定する。以上の対象物の対応関係を,複数の画像フレームからなる映像の区間内の全ての隣接するフレーム間に対して計算した結果の情報を利用して,個々の対象物の移動軌跡を複数の画像フレームに渡って追跡する。

(もっと読む)

761 - 769 / 769

[ Back to top ]